Eingereichte schriftliche Aussage von Marc Morano, Publizist von Climate Depot und ehemaliges Mitglied des Environment & Public Works Committee im US-Senat

Präsentiert auf dem Gipfeltreffen zur Klimaänderung in Fairview, West VA am 30. Mai 2013 – Congressman David B. McKinley, P.E. (WV-01)

Congressional Field Hearing: ‘The Origins and Response to Climate Change’

Skeptiker der globalen Erwärmung gerechtfertigt – die Behauptungen einer vom Menschen verursachten globalen Erwärmung kollabieren

Eingereichte Aussage von Marc Morano – Publizist von Climate Depot

Ich möchte mich bei Kongressmitglied McKinley dafür bedanken, diese Anhörung zur globalen Erwärmung moderiert zu haben. Nur zu selten erlebt man eine Klimadebatte in der Welt, geschweige denn eine ausgewogene Anhörung wie diese. Ich bin kein Wissenschaftler, obwohl ich im Fernsehen manchmal so tue, als sei ich einer  . Mein Hintergrund liegt in der politischen Wissenschaft, was zufälligerweise ein idealer Hintergrund ist, um die Behauptungen hinsichtlich der vom Menschen verursachten globalen Erwärmung zu untersuchen. Ich war leidenschaftlicher Verfechter von Umweltthemen, seit Beginn meiner Laufbahn im Jahre 1991. Ich habe im Jahr 2000 eine „Dokumentation zu den Mythen verfasst, die den Amazonas-Regenwald umgeben“ (hier), und ich war ein voll anerkannter investigativer Journalist, der extensiv über Umwelt- und Energiethemen berichtet hat wie z. B. Entwaldung, gefährdete Spezies, Verschmutzung und Klimaänderung.

. Mein Hintergrund liegt in der politischen Wissenschaft, was zufälligerweise ein idealer Hintergrund ist, um die Behauptungen hinsichtlich der vom Menschen verursachten globalen Erwärmung zu untersuchen. Ich war leidenschaftlicher Verfechter von Umweltthemen, seit Beginn meiner Laufbahn im Jahre 1991. Ich habe im Jahr 2000 eine „Dokumentation zu den Mythen verfasst, die den Amazonas-Regenwald umgeben“ (hier), und ich war ein voll anerkannter investigativer Journalist, der extensiv über Umwelt- und Energiethemen berichtet hat wie z. B. Entwaldung, gefährdete Spezies, Verschmutzung und Klimaänderung.

In meiner Eigenschaft als Kommunikations-Direktor am Environment and Public Works Committee des US-Senats unter James Inhofe war ich Redenschreiber und habe den ausgezeichneten [award-winning] Blog des US-Senats moderiert. Ich habe zum ersten Mal überhaupt im Jahr 2006 einen Skeptic’s Guide To Debunking Global Warming Alarmism der US-Regierung veröffentlicht. Ich war auch Autor des 255 Seiten starken Bericht des Senats über mehr als 700 Wissenschaftler mit abweichenden Meinungen zur globalen Erwärmung. Er wurde zuerst im Jahr 2007 veröffentlicht und jeweils in den Jahren 2008, 2009 und 2010 aktualisiert. Jetzt bin ich der Publizist der preislich ausgezeichneten Website Climate Depot und arbeite täglich mit Wissenschaftlern, die die jüngsten begutachteten Studien und Daten zur Klimaänderung untersuchen.

Die wissenschaftliche Realität lautet, dass sich hinsichtlich fast jeder Behauptung – von A bis Z – der Befürworter der vom Menschen verursachten Klimaängste diese als falsch herausstellen, und in vielen Beispielen bewegen sich die Behauptungen in die entgegen gesetzte Richtung. Die Bewegung der globalen Erwärmung erleidet den wissenschaftlichen Tod durch Tausend Schnitte!

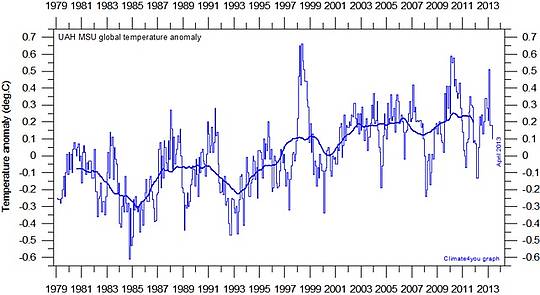

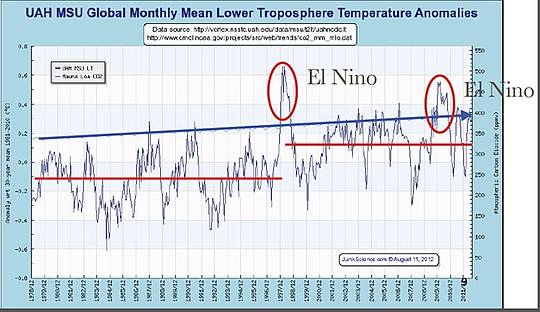

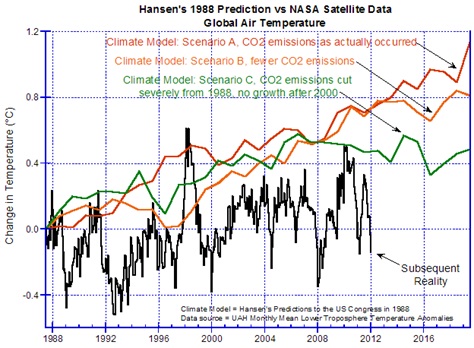

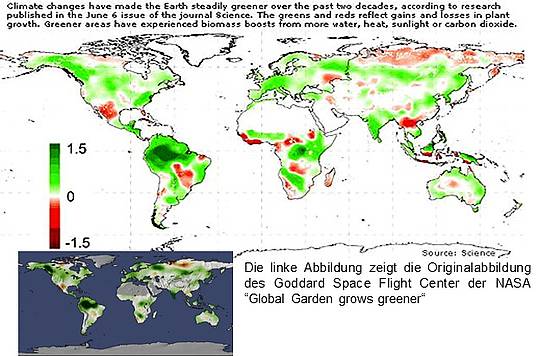

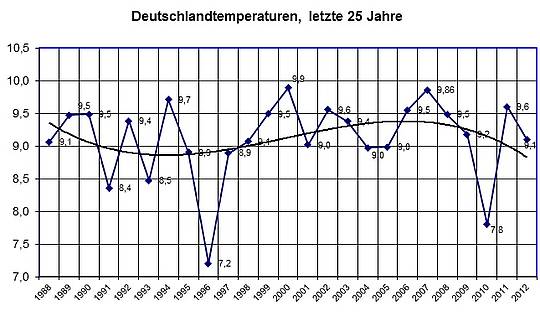

Die globalen Temperaturen sind seit mehr als einem Jahrzehnt gleich geblieben, und in der begutachteten Literatur wird die Größenordnung der zukünftigen Erwärmung herab gestuft. In den USA gab es die längste Periode seit dem Bürgerkrieg, ohne dass ein Hurrikan der Stärke 3 oder stärker auf das US-Festland übergegriffen hätte. Starke F3- oder noch stärkere Tornados nehmen seit den fünfziger Jahren ab. Die globale Ausdehnung von Meereis (beide Pole) liegt gegenwärtig höher als normal. Das Meereis um die Antarktis erreichte 2013 einen neuen absoluten Rekord. Trotz Behauptungen, dass Schnee eine Sache der Vergangenheit sei, ist Schneefall während der kalten Jahreszeit in den letzten Jahren auf ein Rekordniveau gestiegen. Der Anstieg des Meeresspiegels zeigt keine Beschleunigung und verlief seit über einem Jahrhundert völlig gleichmäßig. Dürren und Überschwemmungen sind weder historisch ungewöhnlich noch vom Menschen verursacht, und es gibt keine Beweise dafür, dass wir gegenwärtig irgendwelches ungewöhnliche Wetter haben (hier). Die Zahl der Eisbären, einst das Aushängeschild der Klima-Angstbewegung, liegt bei oder nahe bei einem historischen Hoch. Cholera und Malaria folgen ebenfalls nicht den Vorhersagen der globalen Erwärmung.

Die Mainstream-Medien können das offizielle Narrativ der vom Menschen verursachten globalen Erwärmung nicht länger aufrecht erhalten. Mit dem Fehlen von Erwärmung und dem Scheitern, die Klimadebatte hin zu „extremem Wetter“ zu verschieben (hier) verlieren die Warmisten inzwischen einst überzeugte Teile der Medien bei der Propagierung der menschengemachten Klimaängste. Die Erde folgt einfach nicht den Vorhersagen der globalen Erwärmung, und die neue Studie, in der behauptet wird, dass die gegenwärtigen Temperaturen die „heißesten jemals“ seien, ist in Gefahr der vollen wissenschaftlichen Zurückweisung (hier). Der große Rückzug der Warmisten hat offiziell begonnen.

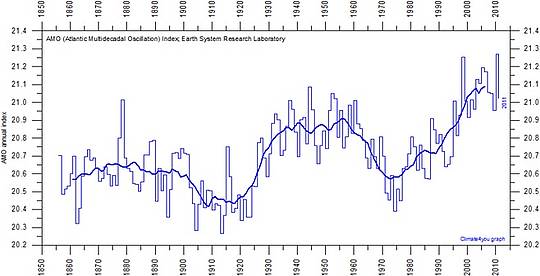

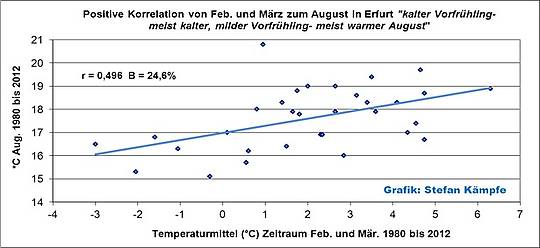

Der Gedanke, dass das CO2 der Schwanz ist, der mit dem Hund wedelt, ist wissenschaftlich nicht länger haltbar. In der begutachteten Literatur finden wir, dass Hunderte Faktoren die globale Temperatur beeinflussen, alles von Ozean-Zyklen und der Neigung der Erdachse bis hin zu Wasserdampf, Methan, Wolken-Rückkopplungen, Vulkanasche – alle diese Faktoren beeinflussen das Klima genauso wie CO2. Neue Studien widersprechen dem uns von unseren SUVs* eingetrichterten einfachen Zusammenhang, dass wir einen sich gefährlich erwärmenden Planeten schaffen. In den Proceedings of the National Academy of Science gab es eine Studie, in der der chinesische Verbrauch von Kohle für das Fehlen der globalen Erwärmung verantwortlich gemacht wird. In einer ironischen Volte behaupten die Befürworter der globalen Erwärmung jetzt, dass uns der Kohleverbrauch vor einer gefährlichen globalen Erwärmung schützt.

[*Ich bin nicht darauf gekommen, was SUV hier heißen soll. Die in Suchmaschinen angebotene Lösung kann es jedenfalls nicht sein. Kann mir evtl. ein Kommentator helfen? A. d. Übers.]

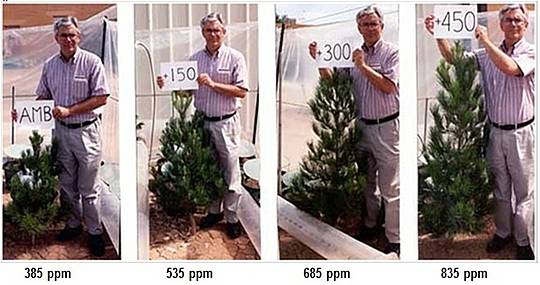

Ein CO2-Gehalt von 400 ppm ist nicht alarmierend

Wissenschaftler weisen darauf hin, dass es buchstäblich Hunderte Faktoren gibt, die über das Klima und die Temperatur der Erde bestimmen – nicht nur CO2. Anerkannte Klimatologen haben erklärt, dass eine Verdoppelung oder sogar Verdreifachung keine wesentlichen Auswirkungen auf das Erdklima oder die globale Temperatur haben würden.

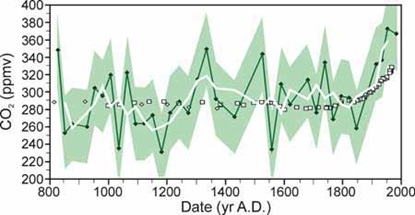

Wissenschaftler merken auch an, dass die Erde geologisch gesehen gegenwärtig „CO2-hungrig“ ist, und dass geologische Aufzeichnungen gezeigt haben, dass es bei CO2-Gehalten von 2000 ppm bis 8000 ppm zu Eiszeiten gekommen war. Unabhängig davon haben andere begutachtete Studien gezeigt, dass Temperaturen auf der Erde ähnlich den heutigen Werten waren mit einem bis zu 20 mal höheren CO2-Gehalt. Und in diesem Jahr kam eine begutachtete Studie zu dem Ergebnis, dass das gegenwärtige CO2-Niveau von 400 ppm übertroffen worden ist – ohne jeden menschlichen Einfluss – und zwar vor 12750 Jahren, als der CO2-Gehalt bis zu 425 ppm betragen haben könnte.

Der an der Princeton University lehrende Physiker Dr. William Happer und der NASA-Astronaut und Geologe Dr. Harrison H. Schmitt schrieben am 8. Mai 2013 im Wall Street Journal: „Dank der zielstrebigen Dämonisierung dieses natürlichen und unabdingbaren atmosphärischen Gases durch Befürworter der regierungsamtlichen Kontrolle der Energieerzeugung beläuft sich das konventionelle Wissen über Kohlendioxid darauf, dass es ein gefährlicher Verschmutzer ist. Das ist einfach nicht der Fall!“

Die UN, der Kongress, Kohlenstoff-Steuern und die EPA können nicht das Wetter kontrollieren!

Die Bewegung ‚war zum Scheitern verurteilt’

Eine Bewegung mit Al Gore als Gesicht an der Spitze – eine der am meisten polarisierenden politischen Gestalten – war zum Scheitern verurteilt. Eine Bewegung, die die von Skandalen geschüttelten Vereinten Nationen – denen das amerikanische Volk zutiefst misstraut – als Brutstätte der Wissenschaft gebraucht, konnte nicht von Dauer sein. Gore und das IPCC der UN sanken inzwischen darauf herab, jeden Sturm, jede Überschwemmung, jeden Hurrikan oder Tornado als Beweis für die vom Menschen verursachte globale Erwärmung anzuführen. Die UN wurden dazu degradiert, sich dafür zu prostituieren, die Menschheit für die globale Erwärmung verantwortlich zu machen. Siehe auch hier und hier.

Aber eine wissenschaftliche Bewegung der Klarheit tritt immer mehr in den Vordergrund: Die UN und der US-Kongress haben nicht die Macht, das Wetter zu regulieren, zu besteuern oder es Gesetzen zu unterwerfen. Siehe hier. Prominente Wissenschaftler fahren fort, den vermeintlichen „Konsens“ in Frage zu stellen. Siehe hier.

Die Bewegung der globalen Erwärmung verliert immer mehr Wissenschaftler, viele davon früher auch Mitglied im IPCC. Siehe hier, vor allem aber auch hier: Schwedischer Top-Klimawissenschaftler sagt, dass die Erwärmung nicht wahrnehmbar ist: „Die Erwärmung der letzten 100 Jahre ist so gering, dass wir sie überhaupt nicht bemerkt hätten, wenn wir keine Klimatologen gehabt hätten, sie zu messen“. Der preislich ausgezeichnete Wissenschaftler Dr. Lennart Bengtsson, einst Mitglied im IPCC: „Wir erzeugen große Angst ohne jede Rechtfertigung“. (hier und hier)

Der ‚Gaia’-Wissenschaftler James Lovelock hat selbst die Kehrtwende vollzogen: „Ich war ein ‚Alarmist‘ hinichtlich der Klimaänderung, ebenso wie Al Gore! Das Problem besteht darin, dass wir nicht wissen, was das Klima macht. Vor 20 Jahren haben wir gedacht, es zu wissen“. (hier)

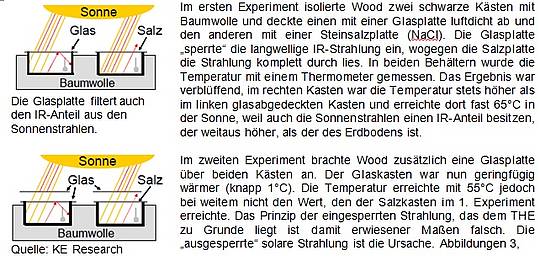

Der Meteorologe Klaus-Eckart Puls (Deutschland) hat ebenfalls die Kehrtwende vollzogen: Er bezeichnet den Gedanken, dass das CO2 das Klima regulieren kann, jetzt als ‚schiere Absurdität‘. – „Vor 10 Jahren habe ich einfach nachgeplappert, was das IPCC uns weisgemacht hat“. (hier)

Außerdem hat der neuseeländische Klimawissenschaftler Chris de Freitas am 1. Mai 2009 enthüllt, dass „Erwärmung und CO2 nur schlecht miteinander korrelieren“. Er fügte hinzu: „Die Auswirkung von CO2 auf die globale Temperatur liegt bereits nahe dem Maximum. Eine weitere Zunahme hätte immer geringere Auswirkungen“. Und weiter: „die gegenwärtige Warmphase … ist nicht beispiellos – Den Forschungsergebnissen bis heute zufolge scheint es so, als sei der Einfluss zunehmenden CO2-Gehaltes auf die globale Erwärmung fast unmerklich ist. Eine zukünftige Erwärmung könnte es geben, aber es gibt keine Beweise dafür, dass sie sehr stark ausfallen wird“. (hier)

Der australische Geologe Dr. Ian Plimer schrieb am 8. August 2009: „Gegenwärtig hungert die Erdatmosphäre nach CO2“. Plimer, Autor des Skeptiker-Buches Heaven and Earth, fügt hinzu: „Während aller Zeiträume gab es keine Korrelation zwischen Temperaturen und CO2. Wenn es keine Korrelation gibt, kann es auch keine Ursache – Wirkung geben!“

Professor Dr. Doug L. Hoffman, Mathematiker, Computer-Programmierer und Ingenieur, schrieb am 24. August 2009: „Es gab Eiszeiten, als der CO2-Gehalt der Erdatmosphäre viele Male höher lag als heute“. Hoffman, der an Umweltmodellen gearbeitet und im Bereich molekulare Dynamik geforscht hat, war Mitautor des Buches The Resilient Earth aus dem Jahr 2009.

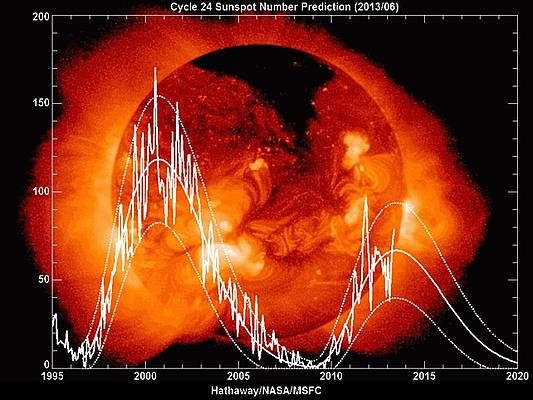

Andere Studien haben gezeigt, dass das Kohlendioxid nicht die Temperaturen auf der Erde kontrolliert, sondern dass das genaue Gegenteil der Fall ist. Siehe die neue Studie über ‚Svensmarks kosmischen Jackpot hier. – Einige Geowissenschaftler möchten den drastischen Wechsel zwische3n heißen und eisigen bedingungen während der letzten 500 Millionen Jahre der Zu- oder Abnahme von Kohlendioxid zuordnen, was sie in komplizierten Wendungen erklären. Laut Svensmark werden die Änderungen durch die Sterne angetrieben, die die Menge des Kohlendioxids in der Luft beeinflussen. Klima und Leben kontrollieren CO2, nicht umgekehrt … Die UK Royal Astronomical Society in London veröffentlicht Svensmarks jüngste Studie.

Viele skeptische Wissenschaftler weisen darauf hin, dass Daten aus Eisbohrkernen zufolge Temperaturänderungen den Änderungen des CO2-Gehaltes vorausgegangen waren. Siehe ‚die Daten aus Eisbohrkernen zeigen eindeutig, dass Temperaturzunahmen generell einer Zunahme des CO2 um viele hundert bis zu einigen tausend Jahren voraus gegangen waren hier.

‘Die Temperatur treibt CO2’

Der Geologe Dr. Robert Giegengack, einst Leiter des Department of Earth and Environmental Science an der University of Pennsylvania, hat sich im Jahr 2007 gegen Ängste vor zunehmenden Auswirkungen des CO2 ausgesprochen, die von Gore und anderen geschürt worden sind. Er schrieb: „Es ist schwer für uns zu sagen, dass das CO2 die Temperatur treibt. Es ist viel leichter zu sagen, dass die Temperatur den CO2-Gehalt treibt“ (LINK). „Der treibende Mechanismus ist genau das Gegenteil von dem, was Al Gore behauptet, sowohl in seinem Film als auch in jenem Buch. Es ist die Temperatur während dieser ganzen 650000 Jahre, die den CO2-Gehalt kontrolliert hat, nicht umgekehrt“. (LINK)

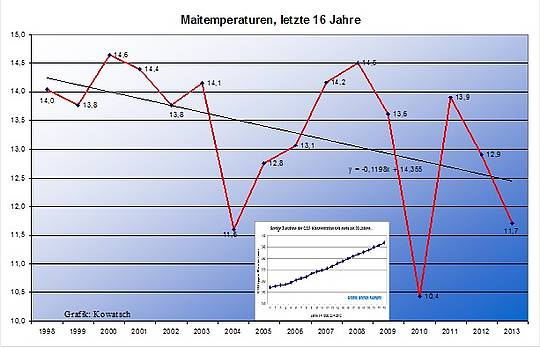

Der Meteorologe Tom Wysmuller: ‚Die gegenwärtige Temperatur und CO2 entkoppeln sich‘ (hier). Selbst wenn man zehn Jahrhunderte zurück geht, gab es keinerlei Zusammenhänge zwischen Temperatur und den CO2-Auswirkungen bzw. dem Fehlen derselben. Von 1000 vor Christus bis zum Jahr 1800, also während einer Periode relativ stabilen CO2-Gehaltes um 280 ppm, fielen die Temperaturen in der Kleinen Eiszeit, um über ein Jahrhundert später wieder zu steigen. Der CO2-Gehalt ging den Temperaturänderungen weder voran noch folgte er ihnen … Das CO2 scheint nur geringe Auswirkungen in BEIDE Richtungen der beobachteten Temperaturen während dieser Periode zu haben … Falls das CO2 wirklich als wesentlicher Treiber der Temperaturen betrachtet wird, führt es einen nicht nachvollziehbaren Eiertanz um diese Zahlen aus‘.

Andere Wissenschaftler stimmen zu:

„Die Kyoto-Theoretiker haben den Karren vor die Pferde gespannt. Es ist die globale Erwärmung, die höhere Niveaus von Kohlendioxid in der Atmosphäre hervorruft, nicht umgekehrt … Eine große Zahl von kritischen Dokumenten, die im Jahre 1995 bei der UN-Konferenz in Madrid eingereicht worden waren, sind spurlos verschwunden. Als Folge war die Diskussion einseitig und stark verzerrt, und die UN haben die globale Erwärmung als eine wissenschaftliche Tatsache erklärt“. Das sagte Andrei Kapitsa, ein russischer Geograph und Forscher antarktischer Eisbohrkerne.

„CO2-Emissionen bewirken absolute keinen Unterschied in irgendeiner Weise … Jeder Wissenschaftler weiß das, aber es zahlt sich nicht aus, das auch zu sagen … die globale Erwärmung als Lokomotive hält die Europäer im Führerstand und die Entwicklungsländer barfuß laufend“. – Dr. Takeda Kunihiko, Vizekanzler des Institute of Science and Technology Research an der Chubu University in Japan.

„Legt man die Gesetze der Physik zugrunde, ist die Auswirkung des menschlichen Beitrags zu den atmosphärischen CO2-Niveaus minimal und nicht unterscheidbar von der natürlichen Variabilität, die zum größten Teil durch den solaren Energieausstoß gesteuert wird“. – Der Atmosphären-Wissenschaftler Robert L. Scotto, der mehr als 30 Jahre Erfahrung als Berater zur Luftqualität hat, arbeitete als ein Manager für einen EPA Superfund contract und ist Mitbegründer von Minnich and Scotto, Inc., einer Beratungsfirma zur Luftreinhaltung. Er war einst auch Mitglied der American Meteorological Society AMS. Scotto ist Meteorologe, der zahlreiche technische Veröffentlichungen und Berichte verfasst oder mit verfasst hat.

„Die vom Menschen erzeugte Energie ist verglichen mit dem allgemeinen Energiebudget so gering, dass sie das Klima einfach nicht beeinflussen kann … Das Erdklima folgt seiner eigenen Geschichte, aber wir können nicht signifikante Trends bei dessen Änderungen festmachen, weil sie viele Millionen Jahre zurück reicht, während das Studium derselben erst vor Kurzem begonnen hat. Wir sind Kinder der Sonne; uns fehlen einfach die Daten, um ordentliche Schlussfolgerungen zu ziehen“. – Das sagte der russische Wissenschaftler Dr. Anatoly Levitin, Leiter des Geomagnetic Variations Laboratory am Institute of Terrestrial Magnetism, Ionosphere und Radiowave Propagation der russischen Academy of Sciences.

Mehr: Special Report: Mehr als 1000 internationale Wissenschaftler bestreiten die Behauptungen zu einer vom Menschen verursachten globalen Erwärmung – und fordern die UN, das IPCC und Al Gore heraus (hier).

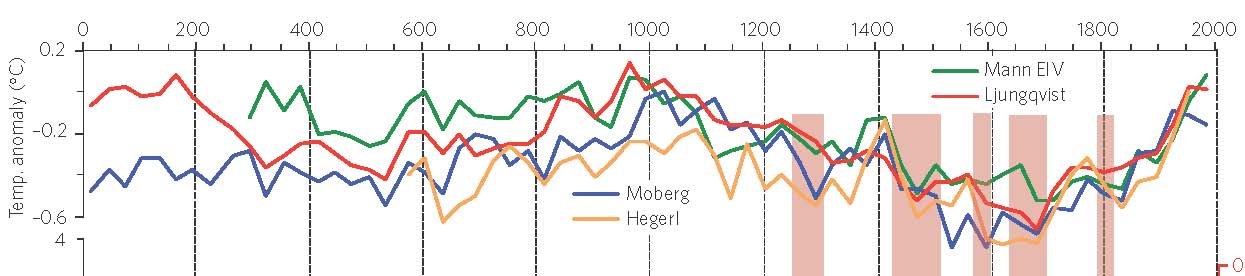

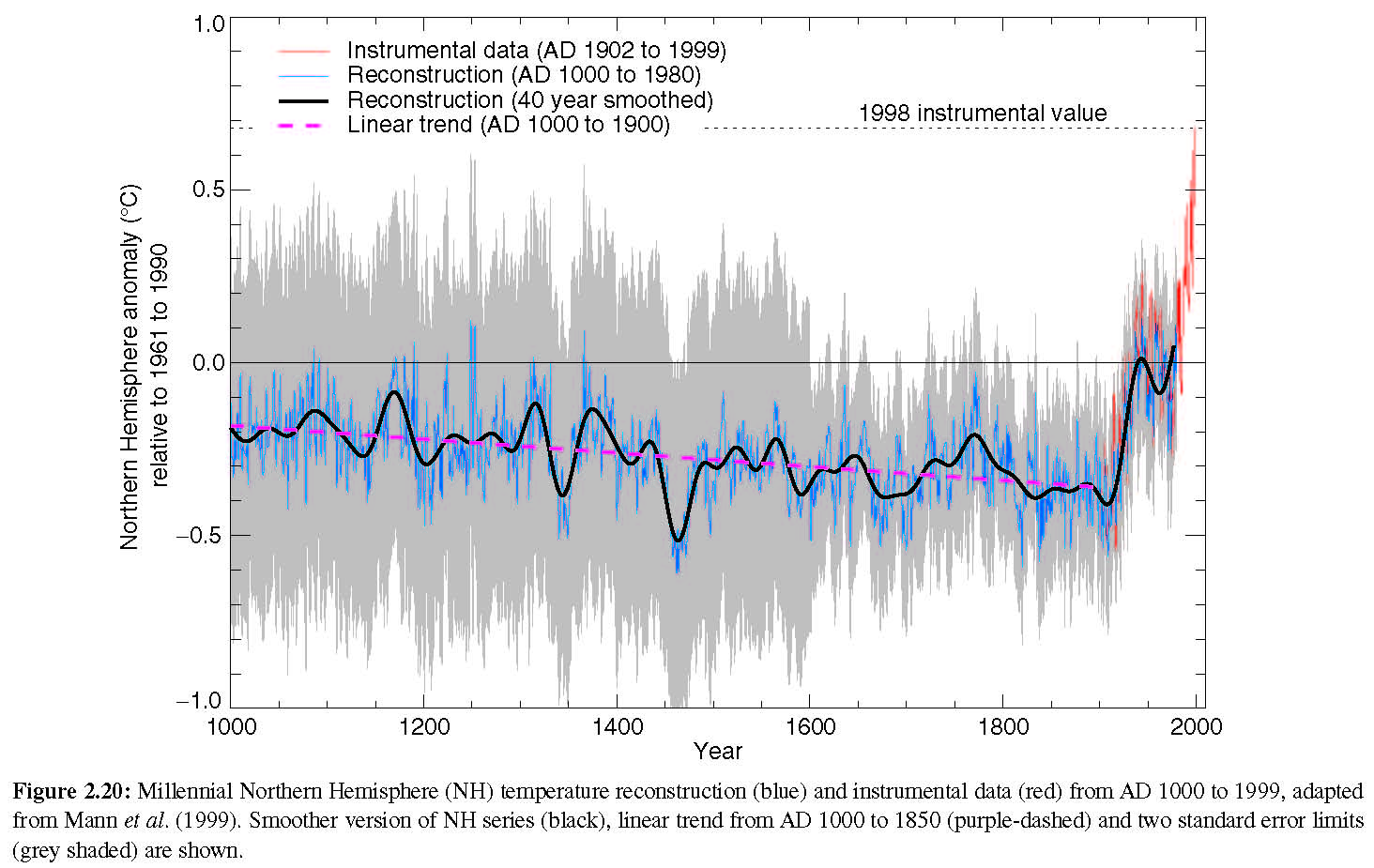

Mehr als 700 Wissenschaftler an 400 Institutionen in 40 Ländern haben begutachtete Studien mit Beweisen präsentiert, dass die Mittelalterliche Warmzeit real war und global aufgetreten ist, und dass es damals wärmer war als heute (hier) – als das CO2-Niveau vermutlich niedriger lag.

Klimatologen: ‚400 ppm sind ein Grund zum Feiern’

Die Klimatologen Dr. Patrick Michaels und Chip Knappenberger erklärten, dass 400 ppm CO2 ein Grund zum Feiern seien. „In manchen Kreisen stieß diese Erklärung auf Bestürzung und Zähneknirschen. Aber die angemessene Reaktion wäre eine Feier“, schrieben Michaels und Knappenberger am 14. Mai 2013.

„Energie aus fossilen Treibstoffen sorgt für etwa 80% der Energieerzeugung in der Welt – ein Wert, der seit 40 Jahren ziemlich konstant ist. Während dieser Zeit hat die globale Bevölkerung um 75% zugenommen, und der globale Energieverbrauch hat sich verdoppelt. Der globale Energieverbrauch pro Kopf hat zugenommen, während der globale Energieverbrauch pro 1000 Dollar des Bruttoinlandproduktes abgenommen hat. Wir verbrauchen mehr Energie, aber wir tun es effektiver. In der entwickelten Welt hat sich die Lebenserwartung seit dem Heraufdämmern der Ära fossiler Energie verdoppelt“, schrieben sie.

„Wie wir kontinuierlich kommentieren (siehe unseren jüngsten Beitrag), zeigt die Wissenschaft immer mehr, dass die Rate der von CO2 induzierten Klimaänderung (und folglich dessen Magnitude zu irgendeinem Zeitpunkt) nicht so groß ist wie allgemein dargestellt. Je niedriger die Rate der Änderung, umso geringer die daraus resultierenden Folgen. Wenn die Rate niedrig genug liegt, wirken die Kohlendioxid-Emissionen insgesamt vorteilhaft. Wir möchten die Leser daran erinnern, dass es nicht die Wärme, sondern die Sensitivität ist, wenn es um Kohlendioxid geht, und die Sensitivität ist offenbar überschätzt worden“, fügten Michaels und Knappenberger hinzu.

„400 ppm Kohlendioxid in der Atmosphäre sollten uns an unseren fortgesetzten Erfolg erinnern, die globale Versorgung mit Energie so auszuweiten, dass der zunehmende Bedarf gedeckt werden kann. Dieser Erfolg führt unvermeidlich zu einer Verbesserung des Lebensstandards und zu einer Reduktion der Verwundbarkeit durch die Launen von Wetter und Klima. 400 ppm ist ein Grund zum Feiern. Eine Welt, die nur durch Feuer erleuchtet wird, ist es nicht“, schlossen sie.

Behauptung der Warmisten: Das letzte Mal, als der CO2-Gehalt so hoch war – stand die Welt damals unter Wasser? Wirklichkeit: Nein, eigentlich nicht – die Eisschilde sind NICHT vor 3 Millionen Jahren geschmolzen, sagen Wissenschaftler (hier). Es ist die Art des Lernens, die die Denkweise der Menschen über das vergangene Klima verändert und was die Zukunft für uns bereit hält.

Die größten Eisschilde der Welt sind wahrscheinlich stabiler als ursprünglich angenommen (hier): Bis heute haben viele Forschergruppen diese Küstenlinie studiert und gefolgert, dass während einer Warmzeit vor drei Millionen Jahren die Eisschilde von Grönland, der Westantarktis und teilweise der Ostantarktis kollabiert sind, was den Meeresspiegel mindestens um 35 Meter hat steigen lassen. Aber die neuen Ergebnisse von Rowley und seinem Team zeigen, dass diese Eisschilde, besonders der ostantarktische Eisschild (der größte der Welt) wahrscheinlich stabiler waren (hier).

Es gibt keine Korrelation zwischen der globalen Meereisbedeckung und CO2: Seit die Erde Hansens Tipping Point von 350 ppm CO2 hinter sich gelassen hat, gab es keinen Trend bei der globalen Meereisausdehnung. Diese Ausdehnung ist sogar derzeit größer als zu der Zeit, als der CO2-Gehalt bei 350 ppm lag. (hier)

Die Schneebedeckung der Nordhemisphäre zeigte eine scharfe Ausweitung, seit der CO2-Gehalt 350 ppm überschritten hat (hier). Rutgers University Climate Lab: Die Ausdehung der schneebedeckten Gebiete auf der Nordhemisphäre von November bis April hat stark zugenommen, seit der CO2-Gehalt Hansens Tipping Point von 350 ppm hinter sich gelassen hat. Es gibt keinen langzeitlichen Trend und keinen irgendwie gearteten Hinweis, dass Schneefall und CO2 auf irgendeine Art und Weise korrelieren.

Die Website Real Science feierte den steigenden CO2-Gehalt und behauptet in einem Artikel vom 11. Mai 2013, dass „die Menschheit mit dem zunehmenden CO2-Gehalt aufblüht“ (hier). Die Aktivisten der globalen Erwärmung behaupten unverdrossen, dass ‚400 ppm CO2 die menschliche Rasse auslöschen werden‘. Die Zahlen zeigen jedoch etwas ganz Anderes, erklärt Real Science mit einer angefügten Graphik.

Washington DC rutscht in die Klima-Astrologie ab

Klar gesagt: ein Mann – Präsident Obama – der erklärt hat, dass ‚sich während seiner Präsidentschaft der Anstieg des Meeresspiegels verlangsamen würde‘ (hier), hat kein irgendwie geartetes Recht zu behaupten, dass er etwas von der Materie versteht, geschweige denn der Wissenschaft in irgendeiner Weise Vorschriften zu machen. – Ein Präsident, der behauptet, dass die Amerikaner an der Wahlurne ‚etwas tun können‘ hinsichtlich Überschwemmungen, Hurrikanen, Dürren und Tornados, spricht nicht für die Wissenschaft.

Die Befürworter der globalen Erwärmung haben im Prinzip erklärt, dass die globale Erwärmung viele Schlechtwetter-Ereignisse zeitigen würde (hier). Und da es immer wieder zu Schlechtwetter-Ereignissen kommt, ist an ‚Beweisen‘ für diese Behauptung kein Mangel. Sie können jedes solches Ereignis als Beweis für die Richtigkeit ihrer Behauptungen anführen. Es gibt inzwischen niemanden mehr, der die Behauptungen zur globalen Erwärmung falsifizieren kann, weil jedes Wetterereignis ihre Einschätzung ‚beweist‘, trotz der Tatsache, dass das gegenwärtige Wetter weder historisch beispiellos noch ungewöhnlich ist. Siehe den neuen Extremwetter-Bericht 2012 hier.

Der IPCC-Wissenschaftler Kevin Trenberth hat gesagt, dass jedes Wetterereignis jetzt durch die globale Erwärmung beeinflusst wird. Sie verwandeln sich selbst in antiwissenschaftliche Aktivisten. Wenn man etwas ohne Beweis behauptet, ist es eine Hypothese – dass es ‚die globale Erwärmung überall gibt‘ – es ist ein religiöses Gefühl. Es ist, als ob man sagt, dass Gott überall ist und dass alles, was man macht, von Gott geführt wird. Das kann man weder beweisen noch widerlegen. Und jetzt sagen sie hinsichtlich der globalen Erwärmung, dass jeder Sturm von der globalen Erwärmung geführt wird … Aber wir wollen einmal auf all die niedrigen CO2-Stürme schauen [the low CO2 Storms] … Ihre Theorie, dass das Wetter irgendwie ungewöhnlich ist und dass wir eine ‚neue Normalität‘ haben, ist nicht nur nicht überzeugend, sondern schlichtweg lächerlich, wenn man sich tatsächlich einmal die harten Fakten anschaut.

Wird eine Kohlenstoff-Steuer Tornados verhindern?! Die US-Senatoren Boxer und Whitehouse sowie andere Aktivisten der globalen Erwärmung sind zu Harlekinen verkommen mit ihren Versuchen, eine Naturkatastrophe in Oklahoma für ihre Zwecke auszuschlachten. Haben Sie kein Anstandsgefühl, verehrte Senatoren? (hier).

Rückerinnerung an 1975: für eine verheerende Tornado-Serie wurde die globale ABKÜHLUNG verantwortlich gemacht (hier).

Senatorin Boxer (Demokraten) macht die globale Erwärmung für Tornados verantwortlich – sie begründet ihren Gesetzentwurf zur Kohlenstoffsteuer mit schlechtem Wetter: „Dies ist Klimaänderung. Wir wurden vor extremem Wetter gewarnt … wir müssen unsere Bevölkerung schützen – Kohlenstoff könnte uns unseren Planeten kosten“. Ein Sonderbericht bei Climate Depot widerlegt die Verbindung zwischen globaler Erwärmung und Tornados (hier)

Wettermacher im Kongress: Die Klima-Astrologin Boxer warnt vor ‚Dürren, Überschwemmungen, Bränden, dem Aussterben von Spezies‘ – falls der Senat das Klimagesetz nicht passieren lässt (11. Juli 2009, hier)

Demokratische Senatorin Boxer: Das Scheitern des Zertifikate-Handels im Jahr 2010 verursachte ‘heißere Tage’ und ‘noch mehr schwere Stürme’ (hier)

Senatorin Boxer: Die globale Erwärmung ‚gefährdet unmittelbar das Leben unserer Enkel‘ (hier)

Klima-Rührseligkeit: Senatorin Debbie Stabenow von den Demokraten im Jahr 2009: ‚die globale Erwärmung erzeugt Volatilität. Ich fühle es, wenn ich fliege. Die Stürme werden volatiler‘ (hier) – Wir zahlen den Preis in Form von mehr Hurrikanen und Tornados.

Das ist nur eine kleine Sammlung von Beispielen, wie Obama und die Demokraten die Klimawissenschaft missbrauchen, um billige Politik durchzusetzen.

Obamas Klima-Astrologe: der ehemalige Energieminister Chu behauptet zu wissen, ‚wie die Zukunft in hundert Jahren von heute an aussieht‘ (hier). – Antwort von Morano: Sollte Chu diese Angst erzeugenden Vorhersagen für das Jahr 2100 nicht lieber auf einer Strandpromenade mit einem vollen Stapel von Tarot-Karten anpreisen?

Obama lässt die Klimawissenschaft in seiner Rede an die Nation 2013 außen vor – die Widerlegung der Behauptungen des Präsidenten zur globalen Erwärmung von Climate Depot Punkt für Punkt (hier) – Antwort von Morano: Herr Präsident, Gesetze des Kongresses, die UN oder die EPA können keine Stürme oder Wetterlagen verändern!

Obama hofft, mit seiner neuen Kampagne den Skeptitzismus zum Schweigen zu bringen, trotz der Tatsache, dass die GOP [= Grand Ole Party, die Republikaner] eine pro-wissenschaftliche Haltung einnimmt, wenn es um die Befürchtungen der vom Menschen verursachten globalen Erwärmung geht. Siehe ‚Lord Christopher Monckton verteidigt die GOP gegen die Angriffe von Obama: Obamas Klima-Video adelt die Mitglieder der GOP, die sagen, wie es wirklich ist – Monckton sagt, dass die GOP hinsichtlich des Klimas den gesunden Menschenverstand walten lässt‘ (hier).

Die unbequeme Wahrheit für Obama lautet, dass er und seine mitlaufenden Demokraten viele völlig ignorante und oftmals komische Behauptungen zur Klimawissenschaft aufgestellt haben. Klar gesagt: ein Mann – Präsident Obama – der erklärt hat, dass ‚sich während seiner Präsidentschaft der Anstieg des Meeresspiegels verlangsamen würde‘ (hier), hat kein irgendwie geartetes Recht zu behaupten, dass er etwas von der Materie versteht, geschweige denn der Wissenschaft in irgendeiner Weise Vorschriften zu machen.

Präsident Obama hat auch behauptet, die „Strahlen der Sonne blockieren zu können, um die globale Erwärmung zu beenden“ (hier). Außerdem stellte er die wissenschaftlich völlig unhaltbare Behauptung auf, dass das Waxman-Markey-Gesetz aus dem Jahr 2009 die globale Temperaturzunahme um bis zu fünf Grad verringern werde! Am 25. Juni sagte Obama: „Ein langzeitlicher Vorteil wäre es, wenn wir unseren Kindern einen Planeten hinterlassen würden, der nicht vier bis fünf Grad wärmer ist“. Aber Obamas eigene Umweltagentur EPA sagt, dass dieses Gesetz das globale CO2-Niveau nicht beeinflussen werde, geschweige denn die globalen Temperaturen.

Obama setzt voll auf Hexerei, wenn er seinen Wählern erzählt, dass sie gegen Dürren und Überschwemmungen und Buschbrände ‚etwas tun können‘ (hier). – Morano von Climate Depot erinnert aber die Wähler: „Gesetze der UN, des US-Kongresses oder der EPA können nicht das Wetter beeinflussen!“

ENERGIE

Kohle ist die ‚moralische Wahl’ – grundlose Klimaängste kapern die US-Energiepolitik

Funktionierende Energieerzeugung (aus Kohle, Erdgas, Öl) wird unterdrückt. Als primäre Energiequellen völlig ungeeignete (Wind, Sonne) werden gefördert.

Kohle und andere auf Kohlenstoff basierende Energieformen waren eine der größten Fortschrittsbringer in der Geschichte unseres Planeten. Ist es verwerflich, sich Wärme, Strom, geringere Kindersterblichkeit und längere Lebenserwartung zu wünschen? Kohle ist die moralische Wahl.

Die USA müssen ‚ethische Energie’ der Konflikt-Energie vorziehen – die Begrenzung von Bohrungen, Bergbau, Pipelines und Energieausbeutung in den USA kann nur zu größerer Abhängigkeit von Konfliktenergie aus Gebieten wie dem Nahen Osten, Venezuela und China führen, wo Menschenrechte und Umweltschutz wenig Beachtung finden.

„Wenn man eine Energiepolitik genau rückwärts gewandt ausführen möchte, sollte man genau das tun … die Führer dieser grünen Unternehmen sind Ideologen, in vielen Fällen Milliardär-Ideologen, die hunderte Millionen Dollar von unserer Regierung bekommen … die Verbraucher müssen das meiste davon tragen, und zwar wegen der schlechten Energiepolitik, die sich aus schlechter Wissenschaft ergeben hat“.

Weiterführende Links:

Feiert! Kohle ist die moralische Wahl für die Armen der Welt! Weltweit werden 1200 neue Kohlekraftwerke in 59 Ländern geplant, drei Viertel davon in Indien und China (hier)

Diese riesige Ausweitung erfolgt trotz der Warnungen von Politikern und Wissenschaftlern, dass sich die rasch steigenden Kohlendioxid-Emissionen verringern müssen … wenn eine Runaway-Klimaänderung vermieden werden soll.

Antwort von Climate Depot: Lachen wir alle über ‚Runaway-Klimaänderung‘. Energiearmut ist ein Todesurteil. Auf Kohle basierende Energien sind eine der größten Befreier der Menschheit in der Weltgeschichte.

Kohle ist die moralische Wahl! In vielen afrikanischen Ländern wird der Bau eines Kohlekraftwerkes die CO2-Emissionen reduzieren (hier)

Wie? Weil es Millionen Familien gibt, die keinen Strom haben und folglich mit Holz oder Dung kochen müssen. Diese Feuer brennen ineffizient und erzeugen nicht nur Kohlendioxid, sondern auch viel Luftverschmutzung, die die Menschen krank macht oder sie sogar sterben lässt. Wenn tausende dieser Feuer durch ein modernes Kohlekraftwerk ersetzt werden, wäre der Gesamteffekt eine verbesserte Luftqualität und weniger CO2 pro Energieeinheit.

Jetzt sehen: Morano von Climate Depot im kanadischen Fernsehen: Stellt Earth Hour ab! Warum feiern wir die Dunklen Zeitalter? Warum feiern wir etwas, das Nordkorea bereits erreicht hat?! (hier)

Morano: Die Leute sollten Earth Hour verabscheuen. Kohlenstoffbasierte Energie ist eine der größten Befreier der Menschheit in der Geschichte unseres Planeten … eine der moralischsten (Energie-)Wahlen, die wir haben, sind heutzutage Kohlekraftwerke in der ganzen Welt … Sowohl Solar- als auch Windenergie sind im Wettbewerb mit fossiler Energie gescheitert. Ihre Schlusslichter sind erloschen, und keine noch so großen Subventionen oder Förderungen können daran etwas ändern (hier)

Chinesische Kohle wird für die globale Erw… ahem, Abkühlung verantwortlich gemacht: Prof. Judith Curry findet statistische Tricks nicht überzeugend … es gab von 2000 bis 2006 keine Zunahme der Aerosole, weder global noch in Ostasien (hier). Prof. Curry: „Die politische Konsequenz dieser Studie scheint zu sein, dass die einfachste Lösung hinsichtlich der globalen Erwärmung darin besteht, die Chinesen zu ermuntern, noch mehr Kohle zu verbrennen, was sie ohnehin vorhaben“.

Begutachtete Studie: Der Verbrauch von Kohle hat uns geholfen, die Welt vor einer gefährlichen globalen Erwärmung zu retten! Robert Kaufmann und Kollegen von der Boston University haben kürzlich eine Studie in den Proceedings of the National Academy of Sciences veröffentlicht, in der die Gründe für den jüngsten Mangel an globaler Erwärmung untersucht werden. Sie kamen zu dem Ergebnis, dass es einfach die natürliche Variabilität ist, verstärkt durch zunehmende Sulfat-Emissionen durch den dramatisch zunehmenden Kohleverbrauch in China (hier).

Eine begutachtete Bestätigung, dass die globalen Temperaturen zwischen 1998 und 2008 nicht gestiegen sind, findet sich hier.

Der Physiker Dr. Lubos Motl: Hat chinesische Kohle zur Abkühlung seit 1998 geführt? Sie zeigt immer noch, wie unglaublich flatterhaft und vorübergehend Mainstream-Meinungen über die Treiber des Klimas sind (hier). – Motl: Plötzlich ist ein alter, Fox News schauender Herr der primäre Grund einer Studie, die eine ganze Dekade von Erwärmung hinweg erklärt durch einen zuvor abgelehnten Mechanismus … der Gedanke, dass die Erwärmungs-Vorhersage wegen der chinesischen Kohle gescheitert sind, ist lediglich eine Randabschätzung; eine unter hunderten anderer möglicher Erklärungen … warum geben diese Leute nicht ehrlich zu, dass sie einfach keine Ahnung haben, was seit 1998 passiert ist und was bis 2020, 2030 oder 2100 passieren wird?

Hintergrundmaterial:

Climate Depot – Bericht über Extremwetter: „Extremwetterereignisse gibt es immer, und es gibt keine Beweise für deren systematische Zunahme. Präsentiert auf der UN-Klimakonferenz in Doha am 6. Dezember 2012.

Der ganze Bericht findet sich hier.

Wissenschaftliche Studien und die Daten stehen gegen die Behauptungen zu Extremwetter. Die jüngsten begutachteten Studien, Daten und Analysen unterminieren die Behauptungen, dass das Wetter „extremer“ oder „beispiellos“ ist. An entscheidenden Stellen halten Behauptungen zu Extremwetter im gegenwärtigen Klima einer genauen Untersuchung nicht stand.

- Todesfälle durch Extremwetter nehmen radikal ab, die globale Aktivität tropischer Wirbelstürme befindet sich auf einem Rekord-Tief, die Häufigkeit starker US-Hurrikane hat abgenommen, die Anzahl von Tornados ist seit den fünfziger Jahren dramatisch zurück gegangen, Dürren sind historisch weder ungewöhnlich noch vom Menschen verursacht, und es gibt keine Beweise, dass gegenwärtig ungewöhnliches Wetter herrscht.

- Extreme: Der Klimatologe Dr. John Christy in einer Aussage vor dem Kongress: „Extremereignisse wie die jüngste Dürre in den USA wird es immer wieder geben, mit oder ohne menschliche Beiträge. – Diese jüngsten US-‚Extreme‘ wurden in früheren Dekaden übertroffen – Die Behauptung von ‚schlimmer als wir gedacht haben‘ in James Hansens Op Ed hält einer genauen Untersuchung nicht stand“.

- Tornados: Ein Klimatologe: “Es gab einen abnehmenden Trend starker und sehr starker Tornados (F3 bis F5) Tornados in den USA seit den fünfziger Jahren – Erwärmung bringt weniger starke Tornados, nicht mehr“ (hier)

- Dürren: Eine Studie im Journal Nature zeigt, dass es hinsichtlich Dürren während der letzten 60 Jahre kaum Änderungen gegeben hat (hier)

- Überschwemmungen: Prof. Pielke Jr.: „Nehmen Überschwemmungen in den USA zu? Die Antwort lautet immer noch nein – eine neue, heute veröffentlichte Studie zeigt, dass Überschwemmungen laut Aufzeichnungen von 85 bis 127 Jahren nicht zugenommen haben“ (hier)

Der ganze Bericht steht bei www.ClimateDepot.com – Morano@ClimateDepot.com – 202-536-5052

Soweit die Aussage von Marc Morano, Publizist von Climate Depot und ehemals Mitglied im Environment & Public Works Committee des US-Senats.

Hier einige Pressestimmen:

Associated Press stellt Climate Depot vor: „Wissenschaftler und Leugner der Klimaänderung treffen in West Virginia bei einer Anhörung des Kongresses aufeinander – Morano in der Debatte: ‚Der Kongress muss den Mut aufbringen, gar nichts hinsichtlich der Regulierung von Kohlendioxid-Emissionen zu tun‘“ (hier): Ein republikanisches Mitglied des Kongresses versucht, allgemeine Gründe für die Klimaänderung zu finden, weil das von fossilen Treibstoffen abhängige West Virginia von gesetzlichen Änderungen der [US]-Bundesregierung direkt betroffen wird. Aber der Konflikt zwischen Wissenschaft und Ideologie, von der der Republikaner David McKinley spricht und der die Diskussion in Washington einfriert, kommt auch nach Fairmont. Marc Morano von Climate Depot sagt, dass der Kongress den Mut haben muss, hinsichtlich der Regulierung von Kohlendioxid-Emissionen gar nichts zu tun. Gleichgesinnte Teilnehmer der Diskussion stimmen dem zu und sagen, dass solche Regulationen die Energiepreise steigen lassen und den Lebensstandard verringern können. – Aber Professor Scott Denning von der University of Colorado sagt, dass die Menschen neue Technologien willkommen heißen, selbst sie teurer sind, so wie sie von Kerzen und Pferden zu Kohle und Strom gewechselt haben. Annie Petsonk vom Environmental Defense Fund sagt, dass Maßnahmen schon lange überfällig sind. Sie sagt, dass Wälder, Wasserreservoire und Leben in Gefahr sind“.

Machen wir uns fertig zum lautstarken Protest! Funken sollten fliegen auf einer vom Kongress gesponserten seltenen 3-stündigen Klimadebatte – in der skeptische Wissenschaftler auf Befürworter der globalen Erwärmung treffen – Morano von Climate Depot ist einer der vorgesehenen Redner (hier). Der Republikaner David B. McKinley hat für eine Podiumsdiskussion in Fairmont mit ausgewiesenen Experten im Bereich der Klimawissenschaft geworben.

Thema: Diskussion über die Ursprünge des und wie man dem Klimawandel begegnet – Wer: Das Büro des republikanischen Abgeordneten David B. McKinley und die West Virginia High Tech Foundation . Dieses Ereignis steht den Medien und der Öffentlichkeit offen.

Noch mehr Berichterstattung in den Medien über die Klimaanhörung des Kongresses: Verschiedene Ansichten zur Klimaänderung (hier) – Dr. John Christy, Professor der Atmosphärenwissenschaft und Direktor des Earth System Science Center an der University of Alabama in Huntsville, der an der Konferenz per Videoschaltung teilnahm, sagte den Zuhörern, dass Temperatur-Wärmerekorde in den USA nicht immer häufiger auftreten. Er sagte, dass gegenwärtige Klimamodelle statistisch sehr falsch liegen können.

Podiumsdiskussion zur Klimaänderung in Fairmont hier.

Ein weiterer Link zu einem Fernsehbericht über diese Diskussion ist hier.

Bericht von Associated Press zu dieser Diskussion (hier): Morano, ein ehemaliger Gehilfe des Klimaskeptizismus und Senator James Inhofe aus Oklahoma bezeichnen die Debatten um die globale Erwärmung als „ein idiotisches Schauspiel der Politik“, das „auf minderwertiger Wissenschaft“ basiert. Der Gedanke, dass Kohlendioxid im Besonderen den Klimawandel antreibt, ist „durch nichts zu rechtfertigen“, argumentierte er. „Wir müssen den Mut haben, nichts zu tun, wenn es um die Regulierung von CO2-Emissionen geht“, erklärte Morano und nannte die auf Kohle basierende Energie „einen der größten Befreier in der Geschichte der Menschheit“.

Myron Ebell, Direktor des Competitive Enterprise Institute: „Die befürworteten politischen Maßnahmen sind wahnwitzig. Wenn man glaubt, dass Energiearmut etwas Gutes ist, sollte man die Kontrolle der Kohlenstoff-Emissionen unterstützen. Aber fast die gesamte Welt stimmt dem nicht zu!“

Der gleich denkende Professor John Christy nennt bezahlbare Energie „die Basis unseres heutigen Lebensstandards“. Ob die Reduktion von CO2-Emissionen das Klima nun beeinflusst oder auch nicht, sagte Christy, er sei sicher, dass die Energiekosten dadurch mit Sicherheit steigen werden. „Ich habe in Afrika gelebt, und ich kann Ihnen versichern, dass das Leben ohne Energie brutal und kurz ist. … Nur weil wir Kohlendioxid erzeugen, sind wir noch keine schlechten Menschen“.

Marc Morano – Climate Depot

Link: http://tinyurl.com/lto2tup

Übersetzt von Chris Frey EIKE