Daher – es ist Zeit für einen Fakten-Check :

(1)

Temperatur: Seit 15 Jahren Ende der Erderwärmung

In den englisch-sprachigen Medien wird das schon seit einigen Jahren offen ausgesprochen, z.B.: "Global warming nonsense gets a true cold shoulder" schreibt The Daily Telegraph[2], oder: "Forget global warming" titelt Daily Mail[3].

Nun hat die skeptische Debatte auch die Medien in Deutschland erreicht[4], z.B. schreibt DER SPIEGEL[5]:

"…. Doch längst hat sich herumgesprochen, dass sich das Klima zuletzt anders entwickelt hat als vorhergesagt: Seit 15 Jahren stockt die Erwärmung, der Aufwärtstrend der globalen Durchschnittstemperatur hat sich seit 1998 nicht fortgesetzt. ‚Der Stillstand hat zu der Annahme geführt, die globale Erwärmung habe aufgehört‘, räumt die Nasa ein."

Oder an anderer Stelle[6]: "Jetzt offiziell: Es gibt keine globale Erderwärmung".

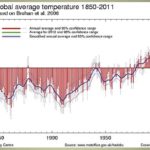

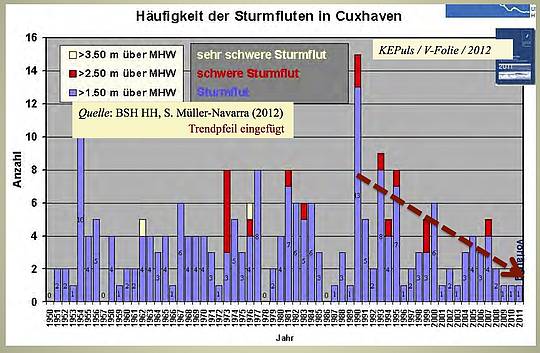

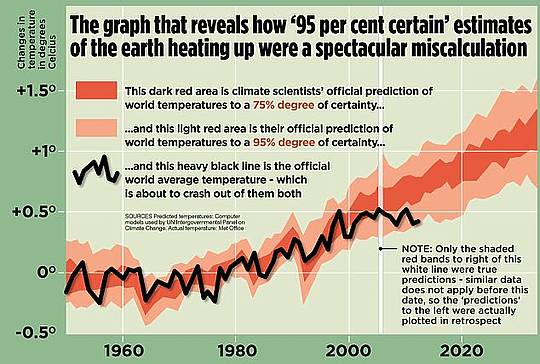

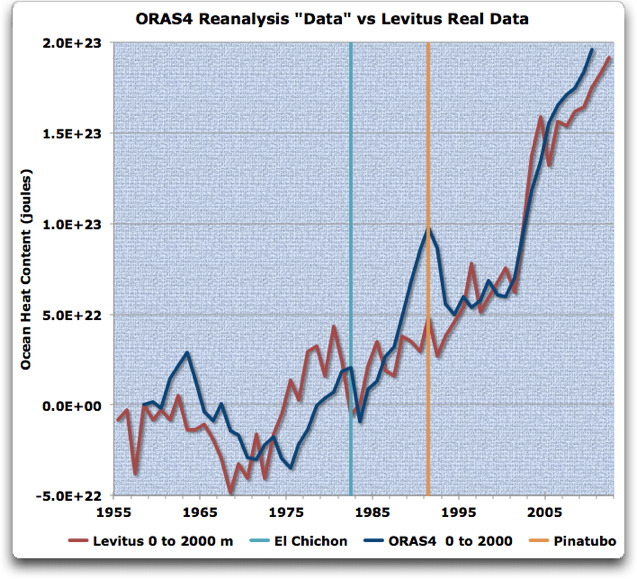

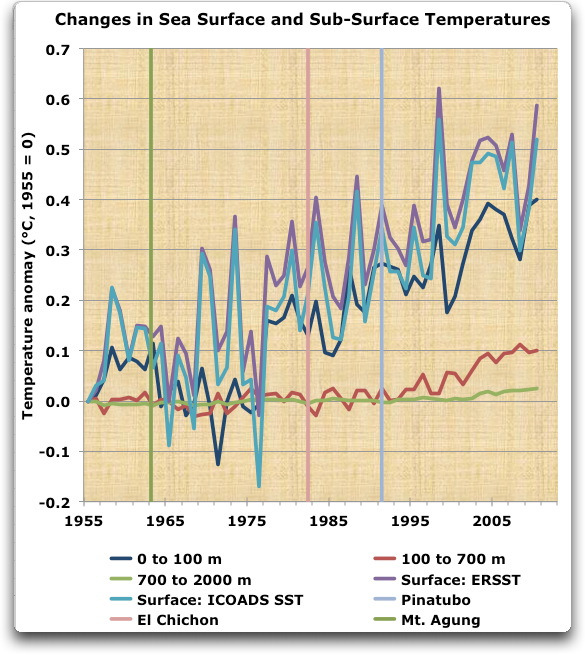

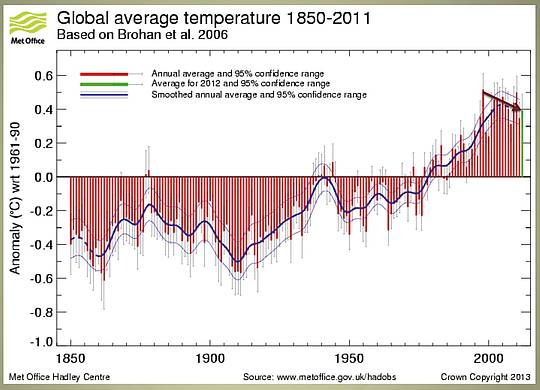

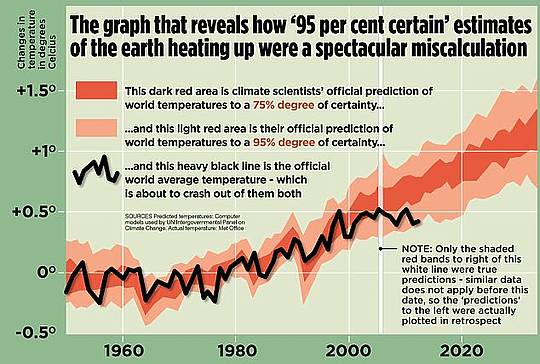

Alle diese Aussagen basieren auf den Temperatur-Auswertungen der IPCC-nahen Institute, wie z.B. in der Abbildung 1.

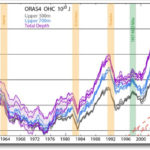

Abbildung 1

Globale Temperatur-Auswertungen des Britischen MetOffice[7] Die blaue Kurve zeigt den übergreifend gemittelten Trend der Temperatur-Kurve zu kühleren Werten, der eingefügte braune Pfeil den Trend der letzten 15 Jahre;

Dazu ist noch anzumerken: Die meteorologischen und klimatologischen Elemente zeigen von Natur aus starke Schwankungen, ein so genanntes "Rauschen". Daher sind auch Schlussfolgerungen zu Trends oder zu Trend-Umkehr statistisch mit einem "Signifikanz-Test" zu prüfen. Dazu wird in dem w.o. zitierten Aufsatz gesagt:

"Bislang meinten Wissenschaftler, vierzehn Jahre ohne weitere Erwärmung seien mit ihren Prognosen in Einklang zu bringen – nicht aber "15 Jahre oder mehr", wie Nasa-Forscher vor vier Jahren im Fachmagazin "Bulletin of the American Meteorological Society" konstatierten." Überträgt man diese NASA-Aussage auf die aktuelle Situation, so liegt die nunmehr seit 15 Jahren andauernde Phase des Erwärmungs-Stops außerhalb des "Rauschens" von Klima und Klimamodellen. Damit wird zugleich die immer wieder propagierte Korrelation mit dem anhaltenden CO2-Anstieg und damit letztlich eine maßgeblich anthropogene Ursache der säkularen Erwärmung des 20. Jahrhunderts in Frage gestellt.

F a z i t:

Der Geophysiker Prof. Larry Bell[8] bringt es in einem Übersichts-Artikel auf den Punkt[9]:

"Das Klima weigert sich hartnäckig, mit den Erwärmungs-Alarmisten zusammen zu arbeiten".

(2)

Meeres-Spiegel: Stetige Verlangsamung des Anstieges

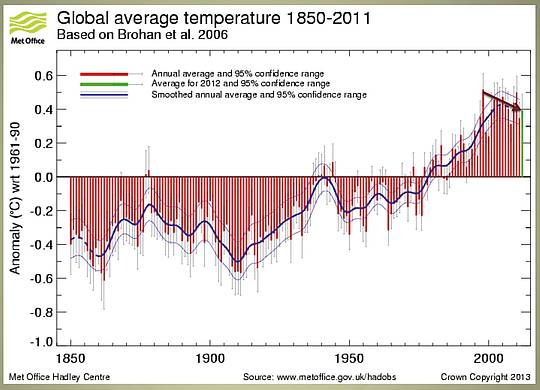

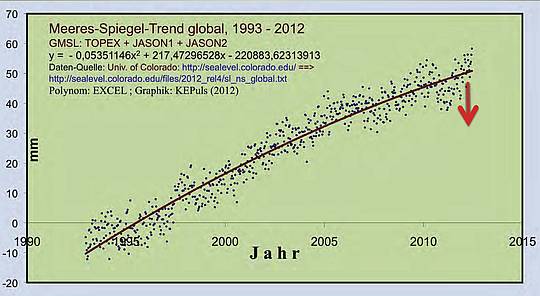

Abbildung 2

Meeres-Spiegel-Trend global ; Satelliten-Messungen[10] 1993 – 2012

Der Anstieg verlangsamt sich (roter Pfeil);

Das in Abbildung 2 dargestellte Ergebnis ist eindeutig: Der seit der letzten Eiszeit schon Jahrtausende währende Meeresspiegel-Anstieg verlangsamt sich global.

Das gleiche Ergebnis zeigen für die Deutsche Nordseeküste die Daten der REKLIM-Studie[11] norddeutscher Forschungs-Institute: "Die Auswertung[12] zeigt: Auch bei den Pegeln gibt es einen zu den Satelliten-Daten vergleichbaren Trend zur Abschwächung des Meeres-Spiegel-Anstieges, und zwar mit einer statistisch recht "robusten" Datenreihe von ca. 160 Jahren ….".

So sagt auch die Landesregierung Niedersachsen[13]:

"Klimawandel nicht bemerkbar: Für einen steigenden Meeresspiegel an Niedersachsens Nordseeküste als Folge des Klimawandels sieht die Landesregierung keine Anzeichen. …. Trend des Anstieges bei unverändert 25 cm je Jahrhundert. Ein schnellerer Anstieg sei nicht zu beobachten."

…und der Landesverband NLWKN[14]

“Allen Diskussionen und Horrorszenarien zum Trotz : Einen wissenschaftlichen Beleg für einen massiven Anstieg des Meeresspiegels für den Zeitraum bis 2100 gibt es nicht.“

Gegen alle diese Fakten textet die regionale Presse[15] immer wieder Schlagzeilen solcher Art: "Versinkt Bremerhaven im Meer?" … untermalt mit einem Bild, auf dem in Bremerhaven gerade mal noch das Hafen-Hotel aus der Nordsee oben heraus schaut. Wo bleiben die Stimmen der etablierten Wissenschaftler, die sich gegen eine solche Hysterie-Formung der Bürger wenden, die so einen Unfug in der Zeitung richtig stellen ?!

(3)

Extremwetter: Weltklimarat IPCC[16] findet keine Trends

Einer "gläubigen" Öffentlichkeit wird von einigen Klima-Forschern, insbesondere aber von den Medien suggeriert[17]: "Die Zahl verheerender Stürme, Regenfälle und anderer wetterbedingter Naturkatastrophen hat sich in Deutschland seit den 1970er Jahren mehr als verdreifacht – und wird auch in Zukunft zunehmen …"

Das ganze Gegenteil zeigen die Messungen und Statistiken der Wetterdienste, in Deutschland wie auch weltweit! Schon der IPCC-Bericht von 2001 findet keine Trends zu mehr Extrem-Wetter[18]:

“Neue Analysen der Änderungen bei lokalen Unwettern (Tornados, Gewittertage, Blitze und Hagel) in einigen ausgewählten Regionen liefern keinen zwingenden Beweis für weitverbreitete systematische langfristige Änderungen“.

Zehn Jahre später, vor der Klima-Konferenz in Durban 2011, erstellte das IPCC sogar einen Sonderbericht (SREX) zum Thema Extrem-Wetter, mit dem gleichen Ergebnis[19]:

"… noch immer können die Forscher einzelne Extremereignisse nicht wirklich auf den menschlichen Einfluss zurückführen…"

Und a.a.O. gibt es eine Fülle weiterer Aussagen, die sehr zur Versachlichung der öffentlich vollkommen überzogenen Katastrophen-Debatte beitragen:

"Der Sonderbericht des IPCC spricht die Unsicherheiten recht klar aus und wird dafür von einigen Klima-Aktivisten bereits scharf angegriffen" … "Wir vergessen in der ganzen Treibhausgas-Debatte, dass Fluten, Stürme und Hitzewellen sich auch ohne den Klimawandel ereignen.“

In einer anderen Übersicht[20] dazu heißt es:

"Über die Entwicklung der meisten anderen Wetterextreme (Anm.: außer Hitze und Dürre) jedoch kann die Wissenschaft keine befriedigenden Aussagen treffen. … Die Einschätzungen beruhen auf Meinungsumfragen unter Experten, sie haben also keine harte wissenschaftliche Basis." … und schließlich a.a.O. :

"Die eigentliche Botschaft lautet: Über die meisten Wetterkatastrophen wissen wir zu wenig, um die Entwicklung vorhersagen zu können."

Es gibt zahlreiche weitere Zusammenstellungen und Übersichten zu Extremwetter-Statistiken, das Ergebnis sieht fast immer so aus[21]:

"Nach 100 Jahren Erderwärmung (bis 1998) finden die Wetterdienstes dieser Erde keine Trends zu mehr Extremwetter. Warum sollte sich das in den kommenden Jahrzehnten ändern, noch zu, wo es seit 14 Jahren nicht mehr wärmer wird? Über das Klima der nächsten 100 Jahre darf weiter spekuliert und auch phantasiert werden, die Natur macht schon jetzt etwas anderes als die Modelle!".

F a z i t :

Es bedarf noch nicht einmal der Analysen der als "Skeptiker" verfemten kritischen Wissenschaftler, um zu erkennen: Es gibt keine Trends zu mehr Extremwetter. Die IPCC-Berichte selber belegen das!

(4)

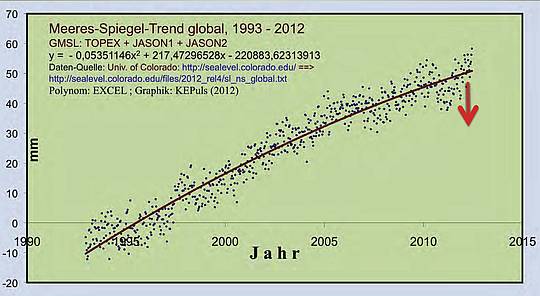

Stürme: Abnehmender Trend bei Hurrikanen und Sturmfluten

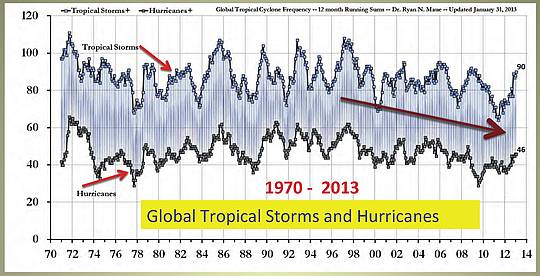

Nicht alle tropischen Stürme entwickeln sich zu Hurrikanen, jedoch: Für beide ist ein abnehmenden Trend seit fast einem halben Jahrhundert dokumentiert, wie die Abbildung 3 zeigt.

Abbildung 3

Trend bei Hurrikanen und Tropischen Stürmen[22] ;

Pfeile und Textfelder eingefügt

Dazu sagt der Forscher Ryan Maue von der Florida State University[23]: "Global Tropical Cyclone ACE does not show an upward trend in communion with global temperatures.”

Hurrikan SANDY wurde in den Medien zum Klima-Signal erklärt. Was jedoch nicht erwähnt wurde[24]: "…erreichte ‚Sandy‘ die Kategorie 2 auf der fünfteiligen Hurrikanskala…", folglich war SANDY ein Wirbelsturm der zweit-niedrigsten Klasse. Eine hohe zerstörerische Wirkung hatte SANDY lediglich dadurch, daß er die Städte der US-amerikanische Ostküste erreichte; etwa einer von zehn Hurrikanen nimmt diese Bahn.

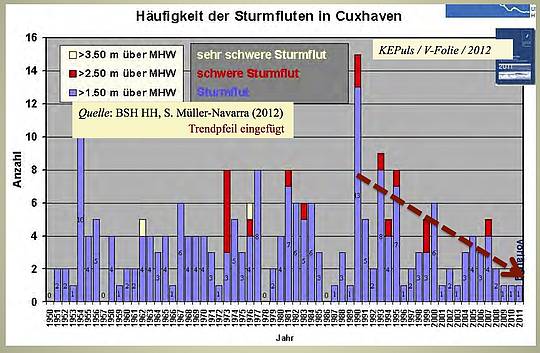

Die Sturm-Frequenz über dem Nordatlantik und der Nordsee zeigt im Zusammenhang mit den Schwingungen der Nordatlantischen Luftdruck-Oszillation NAO eine seit mehr als 100 Jahren bekannte unregelmäßige und bis heute unvorhersagbare Schwingung. Seit etwa 20 Jahren gibt es einen abnehmenden Trend bei Stürmen und Sturmfluten:

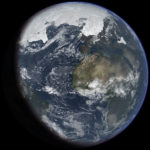

Abbildung 4

Statistik der Sturmfluten in Cuxhaven[25]

(Trend-Pfeil eingefügt)

Dazu schreibt das BSH Hamburg[26]: “Ein generell steigender Trend bei der Häufigkeit und Intensität von Sturmfluten als Vorbote des globalen Klimawandels ist gegenwärtig nicht erkennbar“ … “Schon jetzt sind Küstenschutz und Deiche so ausgelegt, dass sie auch höheren Sturmfluten Stand halten als den bisher eingetretenen“.

… und der Deutsche Wetterdienst sagt[27]: “Es lässt sich für Mittel- und Westeuropa bisher keine langzeitliche Zunahme von Stürmen an Stärke und/oder Häufigkeit nachweisen“

(5)

Mehr Dürren? Nein – Die Wüsten schrumpfen!

Dazu schrieb das Magazin National Geographic[28] in einem Bericht: "Wüstenausdehnung, Trockenheit und Verzweiflung – das ist es, was die Erderwärmung bereit hält für die meisten Teile von Afrika – zumindest das, was wir hören. Die sichtbar werdenden Tatsachen zeichnen eine sehr viel differenzierteres Bild – eines, in welchem steigende Temperaturen eine Wohltat sein kann für Millionen von Afrikanern in den trockensten Gebieten des Kontinents."

…und w.a.a.O.: "Wissenschaftler sehen jetzt Signale, daß die Sahara und die angrenzenden Regionen ergrünen aufgrund zunehmenden Regens."

Das Gleiche berichtet das ZDF in ‚Abenteuer Wissen‘[29] : “…gebräuchliche Vorstellung“ : "… die Wüsten werden wachsen …und die Menschen vor dieser lebensfeindlichen Umwelt fliehen …" …“ Doch dieses Szenario stimmt nicht … Die Sahara nämlich wird feuchter und damit grüner werden als sie heute ist. Beweise dafür liefert die Wüste selbst – mitten in Libyen.“

Soweit der Befund in der Nord-Sahara. Das gleiche positive Bild ergibt sich ganz aktuell in der Südsahara, in der SAHEL-Zone[30]:

"Machtwechsel in der Savanne – Bäume gewinnen die Oberhand über Gräser … Weite Teile der afrikanischen Savanne könnten bis 2100 zu Wäldern werden. Dies geht aus einer Studie des Biodiversität und Klima Forschungszentrums und der Goethe Universität Frankfurt hervor, die heute in ‚Nature‘ veröffentlicht wurde. Die Ergebnisse deuten darauf hin, dass die Düngung durch den steigenden Kohlendioxid-Gehalt in der Atmosphäre in ganz Afrika zu einer dichteren Bewaldung führt, wenn ein bestimmter CO2-Wert überschritten wird … Hierdurch sinkt das Risiko einer Erschütterung des Erdsystems durch einen abrupten Vegetationswandel."

Und nicht nur steigender atmosphärischer CO2-Gehalt wirkt sich über die Photosynthese positiv für das Pflanzenwachstum aus, sondern auch die Niederschläge nehmen in den Trockengebieten zu[31]:

"Die Wüste lebt auf: In den 1980er Jahren war dieser Bereich der Sahara im Nordwest-Sudan noch eine trockene lebensfeindliche Einöde … Der Landstrich ergrünte in diesem Jahrzehnt, weil es deutlich mehr regnete – höchst wahrscheinlich dank der Klima-Erwärmung."

Auch in Deutschland gibt es einen säkularen Trend mit +10% mehr Niederschlägen[32]. Daher ist es verantwortungslos, wenn auch in der regionalen Presse solcherart Schlagzeilen abgedruckt werden[33]: "Mitteleuropa wird zur Wüste, Afrika trocknet völlig aus", und an anderer Stelle[34]: "Aufgrund von Wasserknappheit und Trockenheit kann es zu erheblichen Ernteeinbußen kommen." …so wird von der Presse immer wieder ohne Nachprüfung gegen die Fakten kolportiert, hier der Deutsche Bauernverband.

(6)

Die Arktis schmilzt, die Antarktis legt zu

Genau das wurde kürzlich vom AWI-Forscher Prof. Peter Lemke kurz und klar festgestellt[35]: "Es wurde gemessen, daß das Eis in der Arktis rapide abgenommen hat. Gleichzeitig hat das Eis in der Antarktis zugenommen und die größte Ausdehnung seit mindestens 40 Jahren erreicht."

Während man an den Polen die Fläche der Vereisung mit Satelliten recht genau bestimmen kann, ist die Messung des Eis-Volumens sehr viel schwieriger. Das hängt insbesondere damit zusammen, daß die Eispanzer auf Grönland eine Mächtigkeit von 3 km und auf dem antarktischen Kontinent von 4 km haben. Abschätzungen mit verschiedenen wissenschaftlichen Methoden kommen zu diesem Ergebnis: Das Grönland-Eis verliert an Masse, das Eis auf dem antarktischen Kontinent legt zu[36]:

"Von 2003 bis 2008 hat der Massenzugewinn des antarktischen Eisschildes durch Schneefall den Massenverlust durch Eisabfluss um 49 Gigatonnen pro Jahr (2,5% des Inputs) überstiegen, wie ICEsat Laser-Messungen der Höhe des Eisschildes zeigen konnten."

Die globale Eis-Gesamtbilanz ist eher positiv, denn andernfalls müsste sich der schon Jahrtausende währende Meeres-Spiegel-Anstieg beschleunigen, dieser verlangsamt sich jedoch seit Jahrzehnten (vgl. dazu oben unter "Meeres-Spiegel").

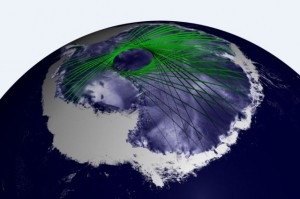

Abbildung 5 / icesat[37]

Die Antarktis: ein riesiger Eisblock, speichert 95% des globalen Süßwassers –

Tendenz: zunehmend; die grünen Linien verbinden Meßpunkte des Satelliten

Neuere Untersuchungen zeigen, daß alle diese Prozesse sehr langsam verlaufen[38]:

"Unsere Daten zeigen, dass es während der Eem-Warmzeit (Anm.: vor 125.000 Jahren) in Nordgrönland bis zu acht Grad Celsius wärmer war als heute“, sagt Projektleiterin Prof. Dorthe Dahl-Jensen von der Universität Kopenhagen. Dass der grönländische Eispanzer auf diesen Temperaturanstieg nicht so empfindlich reagiert habe, wie bisher gedacht, sei die gute Nachricht der Studie." …und w.a.a.O.: "Diese neuen Erkenntnisse sind wirklich aufregend. Sie widerlegen nicht nur alle Schreckensszenarien, denen zufolge der grönländische Eispanzer im Zuge einer Warmzeit im Nu verschwindet. Sie bestätigen zudem Modellrechnungen, die schon vor über einem Jahrzehnt am Alfred-Wegener-Institut gemacht wurden“, sagt Prof. Heinrich Miller, Mitautor der Studie und Helmholtz-Professor für Glaziologie am Alfred-Wegener-Institut."

F a z i t :

Die Arktis schmilzt, die Antarktis legt zu: Eine Katastrophe ist weder das Eine noch das Andere!

(7)

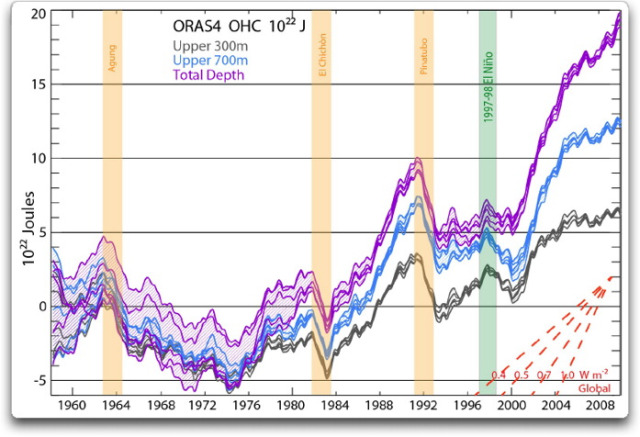

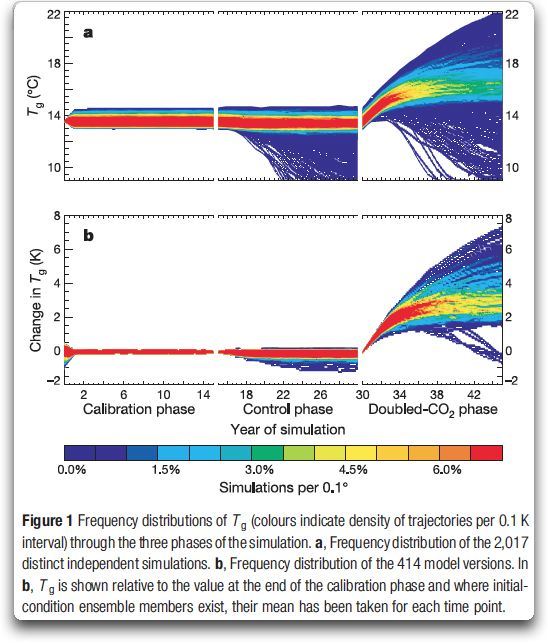

Modelle: Nicht CO2 "ist Schuld", sondern Wasserdampf !

Einige Klima-Institute und IPCC propagieren eine Erderwärmung von 2…5…8 Grad für eine CO2-Verdoppelung. Was jedoch in der Öffentlichkeit nahezu unbekannt ist: Das kann CO2 aus physikalischen Gründen gar nicht leisten, was genau so auch in den Berichten des Weltklima-Rates zu lesen ist[39]:

"Bei ausschließlicher Betrachtung der im Labor messbaren Strahlungswirkung von CO2 ergibt sich eine Klimasensitivität von 1,2 °C. Es existieren jedoch Rückkopplungs-Effekte, darunter im Wesentlichen die Wasserdampf-Rückkopplung, die Eis-Albedo-Rückkopplung und Wolken. Daher liegen die möglichen und als wahrscheinlich angenommenen Werte höher, ein Wert um 3° wird heute als am wahrscheinlichsten angenommen."

Die vom IPCC verwendete Wortwahl "…die möglichen und wahrscheinlich angenommenen Werte…" sagt es ganz klar: Es gibt große Unsicherheiten bei dieser Art Temperatur-Prognosen mit "angenommenen" Verstärkungs-Prozessen – es handelt sich um Hypothesen!

Das bestätigt z.B. der Direktor des Küstenforschungs-Institutes Hamburg, Hans von Storch[40]: "Wir Klimaforscher können nur mögliche Szenarien anbieten; es kann also auch ganz anders kommen" …und von Storch an anderer Stelle[41]:“Klimaforschung ist derzeit in einer postnormalen Situation. Die inhärenten Unsicherheiten sind enorm.“

Genau das zeigen nun auch vorab bekannt gewordene Texte und Abbildungen aus dem neuen IPCC-Bericht 2013/14, was schon jetzt bei den Klima-Alarmisten für einige Aufregung sorgt[42]: "Der durchgesickerten Entwurf von Teilen des 5. Zustandsberichts des IPCC hat die Fachwelt wie auch engagierte Beobachter aufgeschreckt und aufgeweckt. Man sprach sogar von einer ‚Bombe‘."

Im Einzelnen wird dort erkennbar[43] zur Temperatur-Prognose:

"Temperature development depicted in the draft of the coming IPCC AR5….. It is clear to see that the current temperature development lies in the lower range of the IPCC scenarios and that the temperature increase has not accelerated over the last years."

Abbildung 6

IPCC-Temperatur-Prognosen

gegenüber der Realität[44]

…und a.a.O. zur Meeres-Spiegel-Entwicklung:

"Sea level development depicted in the draft of the upcoming IPCC AR 5: The overall range of the four previous IPCC reports is shown along with the actual observed sea level plot (…). Clearly the current sea level rise has not accelerated and is in the lower range of the IPCC scenarios."

(8)

Ernüchterung bei den Klima-Alarmisten

Es wird kein internationales Klima-Abkommen geben. Dabei wird stets unterstellt, daß die außer-europäischen Industrie-Staaten nicht mit machen, weil sie ihre Wirtschaft nicht schwächen wollen. Das spielt eine Rolle. Ein darüber hinaus gehender Aspekt ist jedoch, daß in den großen Wissenschafts-Nationen wie USA, China, Japan, Indien, Russland, Kanada auch Wissenschaftler mit einer klima-realistischen skeptischen Meinung Zugang als Regierungs-Berater haben:

Chinas[45] "… Chefunterhändler Xie Zhenhua sagte gar an Konferenzen: «Es gibt alternative Positionen, die den Klimawandel auf natürliche Prozesse zurückführen. Wir müssen offen bleiben.» …"

…und an anderer Stelle die Züricher WELTWOCHE[46]:

"Es ist Zeit, auf solche nutzlosen Konferenzen zu verzichten. … Es handelt sich um die letzten Zuckungen eines politischen Ansatzes. …. Beschwören viele Staaten dennoch den internationalen Klimaschutz, so nur deshalb, weil sie hoffen, von den in Aussicht gestellten Milliardenzahlungen ein Stückchen abzubekommen."

Realismus und Ernüchterung machen sich breit. Das zeigt auch der soeben in den Kinos angelaufene Film ClimateCrime, wozu es in einer Presse-Mitteilung[47] heißt:

"Eigentlich soll der Klimaschutz ja unsere Erde retten. Doch nun beschleunigt er stattdessen die Zerstörung der letzten Naturgebiete", u.w.a.a.O.: "Abseits großer Konferenzen und schöner Worte dominieren im Klimaschutz zerstörerische Großprojekte."…und w.a.a.O.: "Was derzeit im Namen nicht nur des Klimaschutzes, sondern auch des grünen Wachstums vonstatten geht, würde ich als eine Art Amoklauf gegen die Natur und damit auch gegen den letzten Rest an ökologischer Vernunft bezeichnen. (Niko Paech, Wirtschaftswissenschaftler)“.

(9)

Klima-Schutz = Umwelt-Schutz ??

NEIN ! Dazu sagt z.B. der ehemalige Direktor des Meteorologischen Instituts Berlin, Prof. Horst Malberg[48] : "Saubere Luft zu atmen, sauberes Wasser zu trinken, unbelastete Seen, Flüsse, Ozeane und Erdböden sowie ein intaktes Ökosystem gehören zu den Grundrechten des Menschen. Ein stabiles Klima gehört, wie die Klimageschichte lehrt, nicht dazu."

Noch deutlicher wird der AWI-Vizedirektor Prof. Heinrich Miller[49]:

“Wer von Klimaschutz redet, weckt Illusionen‘, mahnt Miller zu Bescheidenheit, ‚Klima lässt sich nicht schützen und auf einer Wunschtemperatur stabilisieren. Es hat sich auch ohne Einwirkungen des Menschen oft drastisch verändert.‘ Schlagworte wie Klimakollaps oder -katastrophe hält er für irreführend. ‚Das Klima kann nicht kollabieren, Natur kennt keine Katastrophen‘."

Dagegen suggerieren grüne Ideologen und Profiteure von Klimaschutz-Projekten und der Energie-Wende etwas ganz anderes[50]: "Die offensichtlich in Deutschland besonders stark ausgeprägte CO2-Klima-Hysterie wird … durch eine Interessen-Gemeinschaft von Profiteuren ideologisch und materiell vernetzt und durchgesetzt."

Aus diesem Grunde hört man auch fast nie, daß die IPCC-nahen Institute in Deutschland überzogene Katastrophen-Szenarien der Medien korrigieren und versachlichen; man lässt das laufen, es dient dem Geschäft.

Naturwissenschaftlich ist es schier absurd, durch ein paar Drehungen an irgendwelchen

CO2-Stellschrauben ‚ein schön angenehmes stabiles Klima‘ festhalten zu wollen. So ist auch das "2-Grad-Ziel" ist ein politisches Ziel[51]: "Gipfel in L’Aquila (2009) : … Die Staats- und Regierungschefs der acht größten Wirtschaftsmächte haben sich darauf verständigt, dass die Erderwärmung auf zwei Grad Celsius begrenzt werden soll." Fällt es eigentlich niemandem auf? Politiker beschließen, was das Klima zu tun hat! Dazu sagt der Mathematiker und Klimaforscher Prof. Hans von Storch in DIE ZEIT[52]: “Zwei Grad ist eine politische, eine sinnlose Zahl. Ich halte das für Verarschung“.

Hinzu kommt:

Auf eine irrationale Klima-Debatte wird aus politischen und ideologischen Gründen eine abenteuerliche und für die Bürger extrem preis-treibende Energie-Politik drauf gesattelt.

Die Strom-Preise "explodieren", in deren Folge auch andere Kosten und Preise.

Die Politik hat sich einer Pseudo-Wissenschaft namens "Klima-Schutz" bemächtigt. Nicht zu verwechseln damit: Klima-Forschung ist wichtig. Diese sollte aber nicht mit ungesicherten Erkenntnissen als politisch motivierte Basis zum Umbau ganzer Gesellschaften missbraucht werden.

(10)

Zusammenfassung:

Hier genügt es, die Zusammenfassung aus einem umfangreichen Übersichts-Artikel[53] zum Klima-Thema von dem Professor für Physik- und Energie-Forschung, Philip Lloyd[54] von der Universität Kapstadt zu zitieren :

"Die Welt ist etwas wärmer. Das Niveau des Kohlendioxidgehaltes der Atmosphäre nimmt zu. Pflanzen wachsen besser als zuvor wegen dieses höheren Gehalts an CO2 . Der Meeresspiegel steigt mit einer kaum messbaren Rate. Klimatische Katastrophen sind nicht schlimmer als früher. Das Tierreich wird durch das Wachstum einer einzigen Spezies bedrängt, nämlich uns, doch hat dies nichts mit der globalen Erwärmung zu tun. Und das sind die Gründe dafür, dass es ein Klima des Skeptizismus gibt."

Anmerkung:

Eine Kurzfassung dieses Aufsatzes ist im norddeutschen Kultur-Magazin LAUFPASS erschienen: http://laufpass.com/ausgaben/eBook/eBook_0213/flash.html ;

Diese Version ist hier als PDF zum Download angefügt, mit freundlicher Genehmigung des LAUFPASS-Verlages Bremerhaven.

[1] SPON, Report zum Extremwetter;18.11.2011 http://www.spiegel.de/wissenschaft/natur/0,1518,798406,00.html

[2] http://www.dailytelegraph.com.au/news/opinion/global-warming-nonsense-gets-a-true-cold-shoulder/story-e6frezz0-1226258756363 ; February 01, 2012

[3] http://www.dailymail.co.uk/sciencetech/article-2217286/Global-warming-stopped-16-years-ago-reveals-Met-Office-report-quietly-released–chart-prove-it.html#ixzz2EktdPXLP ; 16 October 2012

[4] http://www.eike-klima-energie.eu/news-cache/klima-skepsis-erreicht-auch-die-deutschen-medien/ ; 30.01.2013

[5] SPIEGEL-online

http://www.spiegel.de/wissenschaft/natur/stillstand-der-temperatur-erklaerungen-fuer-pause-der-klimaerwaermung-a-877941.html ; 18.01.2013

[6] Deutsche Wirtschafts-Nachrichten, Umwelt, 08.01.2013

http://deutsche-wirtschafts-nachrichten.de/2013/01/08/jetzt-offiziell-es-gibt-keine-globale-erderwaermung/

[7] http://www.metoffice.gov.uk/hadobs/hadcrut3/diagnostics/global/nh+sh/

[8] http://blogs.forbes.com/people/larrybell/

[9] http://www.forbes.com/sites/larrybell/2013/02/05/in-their-own-words-climate-alarmists-debunk-their-science/

[10] http://sealevel.colorado.edu/

[11] REKLIM, Unser Klima (Hamburg, 2011), S.9, Abb. 2.4

[12] http://www.eike-klima-energie.eu/news-cache/die-meeres-spiegel-versteigerung-pik-institut-bietet-jetzt-1-m-und-mehr/ ; 05.12.2012

[13] NZ, 04.02.2010, S.4

[14] NLWKN, Jahresbericht 2005

[15] Nordsee-Z., 19.05.2012, S.17

[16] Intergovernmental Panel on Climat Change

[17] DIE ZEIT online, 20.03.2012; http://www.zeit.de/wissen/umwelt/2012-03/extremwetter-kongress

[18] IPCC, 2001, TAR-02-2, Chapt. 2.7.4., Summary, S.163-164

[19] DER SPIEGEL, 21.11.2011, Die Krux mit der Katastrophe, S. 156-158

[20] SPON, 18.11.2011, Report zum Extremwetter: Uno versagt bei Aufklärung über Klimawandel;

http://www.spiegel.de/wissenschaft/natur/0,1518,798406,00.html

[21] http://www.eike-klima-energie.eu/news-cache/klima-katastrophe-nun-schon-vor-2099-deutsche-behoerden-wissen-was-im-laufe-des-21-jahrhunderts-beim-extrem-wetter-los-ist/ ; 07.11.2012

[22] http://policlimate.com/tropical/index.html ; (2013)

[23] http://policlimate.com/tropical/index.html

[24] http://www.naturgewalten.de/sandy.htm

[25] BSH HH, S. Müller-Navarra (2012)

[26] Bundesamt für Schifffahrt und Hydrographie, Presse-Mitt. 26.09.2007

[27] G. Rosenhagen: Zur Entwicklung der Sturmaktivität in Mittel- und Westeuropa, promet, Nr.1/2 (2008) S.60

[28] Sahara Desert Greening Due to Climate Change? National Geographic News, July 31, 2009

[29] http://www.zdf.de/ZDFde/inhalt/1/0,1872,1020545_idDispatch:5236912,00.html ; 13.06 2007

[30] http://www.bik-f.de/root/index.php?page_id=32&ID=636 ; 28.06.2012

[31] FOCUS 48 / 2010

[32] www.dwd.de, Klima-Monitoring, lange Reihen

[33] Nordsee-Z., 03.04.2007, S.4

[34] Nordsee-Z., 21.11.2007

[35] NZ, 27.10.2012, S. 20: Seit 1992 waren wir nicht da

[36] http://www.kaltesonne.de/?p=6020 , 12.10.2012

[37] http://kaltesonne.de/wp-content/uploads/2012/09/antarctic_icesat_tracks-300×199.jpg

[38] Alfred-Wegener-Institut, Pressemitteilung , 24.01.2013

[39] WIKIPEDIA zu Wasserdampf-Verstärkung

[40] DER SPIEGEL, 11/2007, S.56

[41] STORCH von, H. ; STEHR, N.: Klimaforschung und Klimapolitik, Nat.Rdsch. H.6 (2010), S. 301-307.

[42] http://www.eike-klima-energie.eu/news-cache/abkuehlung-der-klimakatastrophen-erwaermungs-angst-neues-zum-kommenden-ipcc-ar5/ ; 24.12.2012

[43] http://notrickszone.com/2012/12/22/first-charts-of-ipcc-5-ar-completely-refute-the-alarmist-scenarios-of-master-curve-designer-stefan-rahmstorf/ ; 22.12.2012

[44] http://www.dailymail.co.uk/news/article-2294560/The-great-green-1-The-hard-proof-finally-shows-global-warming-forecasts-costing-billions-WRONG-along.html

[45] WELTWOCHE Zürich, 04.10.2012, S. 41;

[46] WELTWOCHE, 01.12.2011, S. 12

[47] http://riverwatch.eu/allgemein/climate-crimes-in-deutschland, 21.01.2013

[48] H. MALBERG, Beiträge zur Berliner Wetterkarte, 03/11, SO 01/11, 5.1.2011

[49] Bohrer im Eis, DIE ZEIT, 06.06.2007 , S.40

[50] factum 3/2012, S.34, Schwengeler Verlag AG, CH-9442 Berneck

[51] http://www.spiegel.de/politik/ausland/0,1518,635136,00.html

[52] In: DIE ZEIT, 20.08.2009, S.29

[53] http://wattsupwiththat.com/2013/01/18/a-climate-of-scepticism/#more-77781 (18.01.2013) und deutsch:

http://www.eike-klima-energie.eu/news-cache/ein-klima-des-skeptizismus/ (01.02.2013)

[54] http://www.whoswho.co.za/philip-lloyd-3136

Related Files