Hemer and Harris (2003) extrahierten einen Sediment-Bohrkern unter dem Amery-Eisshelf in der Ostantarktis an einer Stelle, die etwa 80 km zum Festland hin verschoben im Vergleich zu seiner gegenwärtigen Lage liegt. Bei der Analyse der Charakteristiken dieses Bohrkerns während der vergangenen 5700 14C Jahre beobachteten die beiden Wissenschaftler einen Spitzenwert einer Fülle von Diatomeen allgemein und einer Masse von Fragilariopsis curta im Besonderen. Deren Parameter sind ihren Worten zufolge „mit größerer Nähe zu einem Gebiet mit primärem Wachstum verbunden wie der Meereiszone“ – zu einer Zeit etwa 750 14C yr B.P. Dies bedeutet, dass die Zeit des maximalen Rückzugs dieses Eisschildes zeitlich eng mit dem historischen Zeitrahmen der MWP zusammenfällt.

Khim et al. (2002) analysierten in gleicher Weise einen Sediment-Bohrkern aus dem östlichen Bransfield-Becken, unmittelbar nördlich der Antarktischen Halbinsel. Sie untersuchten auch Korngröße, den gesamten organischen Kohlenstoffgehalt, die magnetische Empfänglichkeit, den biogenen Siliziumgehalt, die 210Pb-Geochronologie und das Alter nach der Radiokarbon-(14C)-Methode. Alle Daten zeigten ganz klar die Gegenwart der „Kleinen Eiszeit“ und der „MWP, zusammen mit voran gegangenen Klimaereignissen ähnlicher Intensität und Dauer“.

Im gleichen Gebiet des Kontinents arbeiteten auch Hall et al. (2010). Sie schreiben: „Während der letzten 50 Jahre hat sich die Antarktische Halbinsel um etwa 2°C erwärmt“, und dass daraus folgende Brüche im Eis „viele dünne, schmale Eisschilde zerstört haben, die die Antarktische Halbinsel umgeben haben (Cook und Vaughan 2009 nebst Referenzen darin). Daraus folgend fragten sie sich, „ob die gegenwärtige Erwärmung der Antarktischen Halbinsel im Holozän einmalig ist“.

In dem Bemühen, den gegenwärtigen Eisrückzug in einen größeren Zusammenhang zu stellen, haben die drei Forscher „an Organismen reiche Sedimente untersucht, die durch den jüngsten Rückzug des Marr-Eis-Piedmont auf der westlichen Anvers-Insel nahe Norsel Point freigelegt worden sind. „Die Gletscher dort zeigen einen merklichen Rückzug als Folge der gut dokumentierten Erwärmung“. Dort „fanden sie Moos und Meeresmuscheln aus natürlichen Bereichen innerhalb von 26 Metern der gegenwärtigen Eisfront“ und auch „sowohl Schlamm als auch Muschelschalen aus Sedimenten, die in einem Tunnel unter der verbleibenden Eismasse freigelegt worden waren“. Proben daraus wurden mit der Radiokarbon-Methode datiert und die Ergebnisse in Kalenderjahre konvertiert.

Die mit diesen Methoden gewonnenen Ergebnisse konnten sie Schlamm aus den überstrichenen Sedimenten datieren auf Jahre zwischen 707 ± 36 und 967 ± 47 cal. yr B.P., woraus sie schlossen, dass das Eis bei oder hinter der gegenwärtigen Position lag in der Zeit etwa von 700 bis 970 cal. yr B.P. und mindestens zwei früheren Zeiträumen im mittleren und späten Holozän. Dann sagen die drei Forscher in klarer und verständlicher Sprache, dass „der gegenwärtige Zustand reduzierten Eises auf der westlichen Antarktischen Halbinsel nicht ohne Beispiel ist“. Dies ließ für sie eine weitere wichtige Frage aufkommen: „Wie verbreitet war das Ereignis von 700 bis 970 700-970 cal. yr B.P.?“

Die drei Forscher beantworteten die Frage selbst und sagen: (1) „Khim et al (2002) haben ein ausgeprägtes hoch produktives (warmes) Ereignis zwischen 500 und 1000 700-970 cal. yr B.P. gefunden, und zwar in Aufzeichnungen der magnetischen Eigenschaften aus dem Bransfield-Becken“, (2) „Daten aus Moos im Zusammenhang mit der gegenwärtigen Eisgrenze bei den Süd-Shetland-Inseln (Hall 2007) zeigen, dass das Eis zwischen 650 und 825 yr B.P. nicht weiter ausgedehnt war als heute“, (3) „die Beweise für eine reduzierte Eisausdehnung von 700 bis 970 cal. yr B.P. sind konsistent mit Baumringdaten aus Neuseeland, die einen ausgeprägten Spitzenwert der Sommertemperaturen zur gleichen Zeit zeigen (Cook et al. 2002)“ und (5) ihre jüngsten Ergebnisse „sind kompatibel mit Aufzeichnungen der Gletscherfluktuationen im südlichen Südamerika, der kontinentalen Landmasse, die der Antarktis am nächsten liegt (Strelin et al. 2008)“. Im Licht dieser vielen unterschiedlichen Beobachtungen zeigt sich, dass der südlichste Teil der Erde folglich wahrscheinlich eine Periode signifikant verstärkter Erwärmung durchlaufen hat innerhalb des begrenzten Zeitraumes der globalen MWP des Planeten. Und dieses Intervall Wärme ereignete sich, als viel weniger Kohlenstoff und Methan in der Atmosphäre enthalten war als heute.

Aus einer zusätzlichen Studie der Verhältnisse auf der Antarktischen Halbinsel haben Lu et al. (2012) „die erste downcore δ18O-Aufzeichnung [?] konstruiert aus { ikaite hydration waters and crystals} [Ikaite ist die Mineral-Bezeichnung des Hexahydrats von Calziumkarbonat CaCO3·6H2O] von der Antarktischen Halbinsel“, von der sie sagen, dass sie „die Rekonstruktion einer Ikaite-Aufzeichnung mit niedriger Auflösung der letzten 2000 Jahre ermöglicht“. Der Gruppe von neun Forschern aus den USA und UK zufolge ist „Ikaite ein Polymorph aus Calziumkarbonat, das mit Wassermolekülen gebunden ist, die in seinem kristallinen Gitter enthalten sind“, und sie schreiben, dass „Ikaite-Kristalle aus marinen Sedimenten, falls sie bei niedrigen Temperaturen gesammelt und gelagert werden, die Abbindung und ihre intakte Kristallstruktur erhalten, die beide das Potential haben, die Isotopen-Bedingungen vergangener Klimaänderungen zu zeigen“. Was also haben sie festgestellt?

Die Autoren berichten, dass die „Ikaite-Aufzeichnungen qualitativ stützen, dass sowohl die MWP als auch die Kleine Eiszeit bis zur Antarktischen Halbinsel gereicht haben“. Auch stellen sie fest, dass „die jüngsten Kristalle eine Erwärmung relativ zur Kleinen Eiszeit im vorigen Jahrhundert zeigen, möglicherweise als Teil der jüngsten regionalen rapiden Erwärmung“. Aber sie fügen hinzu, dass „dieses Klimasignal seiner Natur nach nicht so extrem ist wie in der MWP“. Das zeigt, dass selbst die dramatische jüngste Erwärmung der Antarktischen Halbinsel diese Region nicht so warm hat werden lassen wie zur Zeit der MWP, als die atmosphärischen CO2-Konzentration um mehr als 100 ppm unter den heutigen Werten lag.

Bei einer Untersuchung einer anderen Region des Kontinents haben Hall und Denton (2002) die Verteilung und Seehöhe von Oberflächen-Ablagerungen kartiert entlang der südlichen Scott-Küste der Antarktis in der Umgebung des Wilson-Piedmont-Gletschers, der parallel zum westlichen Ross-Meer vom McMurdo-Sund nordwärts bis Granite Harbour verläuft. Die Chronologie der Seehöhe der untersuchten Strände wurde bestimmt aus von Hand abgetragenen Proben (Hall und Denton 1999); die Aufzeichnungen halfen zu zeigen, dass kurz vor dem Ende der MWP, „noch 890 14C yr BP“, wie Hall und Denton es beschreiben, „der Wilson Piedmont-Gletscher immer noch weniger ausgedehnt war als heute“. Dies zeigt, dass das Klima zu jener Zeit aller Wahrscheinlichkeit nach merklich wärmer war als derzeit.

Viele Jahre später, aber ebenfalls im Gebiet des Ross-Meeres in der Antarktis, haben Bertler et al. (2011) neue Deuterium-Daten (δD) gewonnen, und zwar aus Analysen der obersten fünfzig Meter eines 180 Meter langen Bohrkerns, der aus der Eisscheide der Victoria Lower-Gletschers in den nördlichsten Trockentälern von McMurdo gezogen worden ist. Diese konvertierten sie zu Temperaturdaten mittels einer Beziehung zwischen Temperatur und Isotopen, die von Steig et al. (1988) entwickelt worden war aus Daten des Taylor Dome-Bohrkerns. Daraus, so berichten Bertler et al., haben sie drei unabhängige Zeiträume in ihren Aufzeichnungen identifiziert: die letzten 150 Jahre der MWP (1140 bis 1287), die Kleine Eiszeit (1288 bis 1807) und die Moderne Zeit (1808 bis 2000). Und hinsichtlich der MWP schreiben sie, dass „es in den McMurdo-Trockentälern während der MWP 0,35°C wärmer war als in der Modernen Zeit, begleitet von wärmeren Bedingungen im Ross-Meer“. Die drei Forscher halten auch fest, dass „ eine Aufzeichnung der magnetischen Besonderheiten aus dem Palmer Deep-Bohrkern (PD92 30MS) ebenfalls wärmere Bedingungen in der MWP stützt, diesmal in der Drake-Passage (Domack und Mayewski 1999)“.

Noon et al. (2003) verwendeten Sauerstoffisotope, die in autogenen Karbonaten erhalten geblieben waren, die man in Frischwasser-Sedimenten des Sombre Lake auf der Signy-Insel (60°43’S, 45°38’W) im Südlichen Ozean gefunden hat, um eine 7000 Jahre lange Historie des Klimas in diesem Gebiet zu konstruieren. Diese Arbeit enthüllte, dass der generelle Temperaturtrend an der untersuchten Stelle nach unten gerichtet war. Von höchstem Interesse für die gegenwärtige Diskussion ist jedoch die Oszillation des Klimas im Millenium-Zeitscale, die sich über weite Bereiche der Aufzeichnung zeigt. Diesem Klimazyklus zufolge war es vor etwa 2000 Jahren – nach einer Lücke von 1000 Jahren in den Daten – auf der Signy-Insel zu der relativen Erwärmung während der letzten Reste der Römischen Warmperiode gekommen, wie es McDermott et al. 2001 auf Basis einer hoch aufgelösten δ18O-Aufzeichnung aus Südwestirland abgeleitet haben. Dann folgte die Kaltzeit des Dunklen Zeitalters, die ebenfalls zeitgleich mit dem auftrat, was McDermott et al. in der Nordhemisphäre gefunden haben. Dem zufolge erscheint die MWP zum gleichen Zeitpunkt und dauerte genauso lange wie in der Umgebung von Irland, wonach die Kleine Eiszeit genau zum gleichen Zeitpunkt wie auf der Nordhemisphäre einsetzte. Und schließlich gibt es Hinweise auf eine Erwärmung zum Ende des vorigen Jahrhunderts, wobei aber noch ein langer Weg zurückzulegen ist, bevor Bedingungen erreicht werden, die mit denen während der MWP vergleichbar sind.

Zwei Jahre später haben Castellano et al. (2005) eine detaillierte Historie des Vulkanismus im Holozän abgeleitet aus den Sulfatansammlungen der obersten 360 Meter im Dome Concordia-Eisbohrkern, der den Zeitraum 0-11,5 kyr BP abdeckte. Danach verglichen sie ihre Ergebnisse für das vergangene Jahrtausend mit denen aus acht antarktischen Eisbohrkernen. Bevor sie das taten, haben sie jedoch die Ergebnisse von jeder Stelle normalisiert, indem sie die verschiedenen Sulfatablagerungen aus Vulkanausbrüchen unterteilt haben durch den Wert, der an dieser Stelle durch den Ausbruch des Tambora im Jahr 1816 aufgetreten ist, um die Differenzen der Ablagerungen von Stellen zu reduzieren, die von Differenzen durch Charakteristiken an den Stellen selbst herrühren. Diese Arbeiten enthüllten, dass die meisten vulkanischen Ereignisse Anfang des letzten Jahrtausends (1000 bis 1500) eine größere Variabilität der normalisierten Sulfat-Ablagerungen an Ort und Stelle zeigten als danach noch beobachtet.

Unter Hinweis auf die Arbeit von Budner und Cole-Dai (2003), die festgestellt hatten, dass „der antarktische Polarwirbel bei der Verteilung vulkanischen Aerosols in der Stratosphäre eine Rolle über dem Kontinent spielt“, sagen Castellano et al., dass die angenommene Intensität und Persistenz des Polarwirbels sowohl in der Tropo- als auch in der Stratosphäre „das Eindringen von Luftmassen auf das antarktische Festland beeinflusst, die das Innere des Kontinents in Kaltzeiten isoliert und in Warmzeiten die Advektion peripherer Luftmassen erleichtert (Krinner und Genthon 1998). Mit dieser Annahme stützen wir die Hypothese, dass die Verteilung vulkanischer Ablagerungen und geographischer Variabilität (mit den höheren Werten in Küstennähe) ein wärmeres Klima in der Antarktis Anfang des vorigen Milleniums reflektiert“, und dass „die Wiederkehr kälterer Bedingungen mit Beginn um das Jahr 1500 die Variabilität vulkanischer Ablagerungen reduziert“.

Bei der Beschreibung der Implikationen dieses Phänomens sagen Castellano et al.: „Dieser Schritt von warm nach kalt könnte ähnlich sein einem Übergang von der MWP zur Kleinen Eiszeit“. Sie verweisen zusätzlich auf Goosse et al. (2004), die von Beweisen in antarktischen Eisbohrkernen via δD und δ18O-Daten „zur Stützung einer MWP-artigen Periode in der Südhemisphäre“ berichten, „verzögert um etwa 150 Jahre hinsichtlich der mittelalterlichen Erwärmung der Nordhemisphäre“. Und die Forscher schließen mit dem Postulat, dass „Änderungen der Variabilität vulkanischer Ablagerungen im Inneren und an den Rändern der Antarktis Folgen des Aufkommens einer MWP-artigen Periode sein könnten, die etwa bis um das Jahr 1500 dauerte“.

Ein Jahr später haben Hall et al. (2006) Haut und Haare (und sogar einige mumifizierte Überreste) von Strandablagerungen gesammelt an verschiedenen Stellen der Küste des Victoria-Landes in der Antarktis, die sie sowohl nach Augenschein als auch mit DNA-Analysen als die Überreste von See-Elefanten identifizierten. Diese Überreste datierten sie mit der Radiokarbon-Methode. Auf diese Weise gewannen sie Daten von 14 verschiedenen Stellen innerhalb des von ihnen untersuchten Gebietes – dass sie beschrieben als „deutlich südlich“ der gegenwärtigen Brutstätten. Das zeigt, dass der Zeitraum, den sie das „See-Elefanten-Optimum“ genannt haben, etwa um das Jahr 600 begonnen hat und um das Jahr 1400 zu Ende gegangen war. Letzteren Zeitpunkt beschreiben sie als „in etwa zeitgleich mit dem Einsetzen der Kleinen Eiszeit in der Nordhemisphäre und mit einem Gletschervorstoß nahe der Terra Nova-Bucht (Victoria-Land).

Bei der Beschreibung der Bedeutung ihrer Ergebnisse sagen die Forscher aus den USA, UK und Italien, dass sie „auf wärmere Klimabedingungen als heutzutage“ hinweisen zu der Zeit und an den Örtlichkeiten der identifizierten Aufenthaltsorte von See-Elefanten, und: „Falls das Ross-Eisschelf diese Periode überstanden hat, wäre es einer Umgebung ausgesetzt gewesen, in der es substantiell wärmer war als heute“, und zwar sowohl während der Römischen Warnzeit als auch während der MWP.

Ein Jahr näher an der Gegenwart haben Williams et al. (2007) Methylchlorid-Messungen (CH3C1) in Luftblasen präsentiert aus einem 300 Meter langen Eisbohrkern, gezogen am Südpol. Er überdeckt den Zeitraum von 160 bis 1860. Bei der Beschreibung ihrer Ergebnisse sagen die Forscher: „die CH3C1-Niveaus waren von 900 bis 1300 um 50 ppt erhöht relativ zu den vorangegangenen 1000 Jahren, was mit der Anomalie des mittelalterlichen Klimas (MCA) zusammenfällt“, und dass sie „während der Abkühlung in der Kleinen Eiszeit (1650 bis 1800) auf ein Minimum geschrumpft waren, bevor sie wieder anstiegen zum derzeitigen atmosphärischen Niveau von 550 ppt“. Unter Verweis auf (Khalil und Rasmussen, 1999 sowie Yoshida et al., 2004), die gesagt haben, dass „heute mehr als 90% der CH3C1-Quellen und die Mehrzahl der CH3C1-Senken zwischen 30°N und 30°S liegen“, sagen sie: „es ist wahrscheinlich, dass vom Klima bestimmte Variationen von CH3C1 Änderungen in tropischen und subtropischen Bedingungen reflektieren“. Sie fahren fort: „Die Variabilität von CH3C1 in Eisbohrkernen während der letzten beiden Jahrtausende zeigt eine positive Beziehung zwischen dem atmosphärischen CH3C1-Gehalt und der globalen (kursiv hinzugefügt) mittleren Temperatur“.

So weit man das aus der graphischen Repräsentation ihrer Daten bestimmen kann, lag der Spitzenwert der von Williams et al. gemessenen CH3C1-Konzentration bei etwa 533 ppt, was innerhalb von 3 Prozent des gegenwärtigen Wertes von 550 ppt liegt und deutlich innerhalb der Bandbreite von 520 bis 580 ppt, die die gegenwärtige Variabilität von Methylchlorid abdeckt. Daher lässt sich schlüssig folgern, dass die mittlere Höchsttemperatur der MCA (in dieser Arbeit als MWP bezeichnet) in der Breite zwischen 30°N und 30°S – und möglicherweise auf dem gesamten Globus – nicht wesentlich unterschiedlich von der mittleren Höchsttemperatur ist, die bislang in der Modernen Warmzeit erreicht worden ist.

In einer abschließenden Studie präsentierte Hall (2007) „Radiokarbon- und geomorphologische Daten, die die Ausdehnung der Collins-Eiskappe auf der Fildes-Halbinsel (King George-Insel in den Süd-Shetland-Inseln 62°10’51″S, 58°54’13″W) im späten Holozän belegen. Sie bieten ihren Worten nach „Informationen über Zeiten der Vergangenheit, als das Klima der Süd-Shetland-Inseln so warm oder wärmer als heute gewesen sein muss“. Diese Aussage basiert auf der Kartographierung von mit dem Eisschild zusammen hängenden Moränen und Gletscherablagerungen und auf Radiokarbon-Datierungen organischen Materials von dort. Hall zufolge zeigen derartige Daten „einen Eisvorstoß nach etwa dem Jahr 650 cal. yr BP (AD ~1300)“, von dem sie annimmt, dass er „in etwa zeitgleich mit der in Europa definierten ‚Kleinen Eiszeit’ stattfand“. Sie sagt auch, dass es „während der letzten 3500 Jahre der einzige Vorstoß war, der über die gegenwärtige Eisgrenze hinaus erfolgte. Dies macht die Kleine Eiszeit in diesem Teil der Welt wahrscheinlich zur kältesten Periode der gegenwärtigen Zwischeneiszeit“. Und die Tatsache, dass „der derzeitige Rand der Eiskappe … immer noch ausgedehnter ist als vor dem Jahr 650 cal. yr BP“, ließ sie vermuten, dass das Klima vor dieser Zeit – was die MWP einschließt – „genauso warm oder wärmer als heute“ gewesen sein könnte.

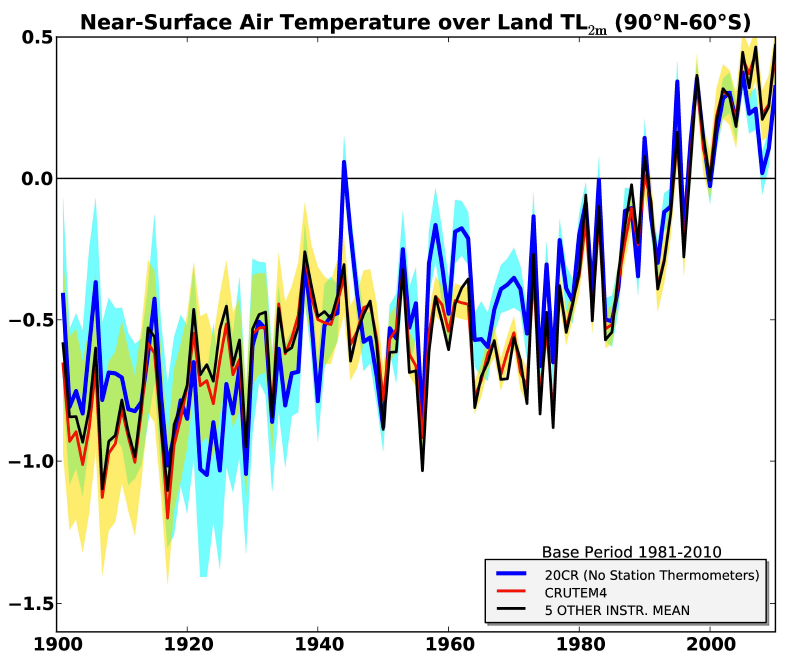

Und diese Schlussfolgerung, zusammen mit den Ergebnissen der anderen hier begutachteten Studien zeigt, dass nichts am gegenwärtigen Temperaturzustand der Erde ungewöhnlich, unnatürlich oder beispiellos ist. Dies zeigt wiederum, dass die historische Zunahme der atmosphärischen CO2-Konzentration überhaupt nichts mit den Begleiterscheinungen der globalen Erwärmung im 20. Jahrhundert zu tun hat.

References

Bertler, N.A.N., Mayewski, P.A. and Carter, L. 2011. Cold conditions in Antarctica during the Little Ice Age — Implications for abrupt climate change mechanisms. Earth and Planetary Science Letters 308: 41-51.

Budner, D. and Cole-Dai, J. 2003. The number and magnitude of large explosive volcanic eruptions between 904 and 1865 A.D.: Quantitative evidence from a new South Pole ice core. In: Robock, A. and Oppenheimer, C. (Eds.), Volcanism and the Earth’s Atmosphere, Geophysics Monograph Series 139: 165-176.

Castellano, E., Becagli, S., Hansson, M., Hutterli, M., Petit, J.R., Rampino, M.R., Severi, M., Steffensen, J.P., Traversi, R. and Udisti, R. 2005. Holocene volcanic history as recorded in the sulfate stratigraphy of the European Project for Ice Coring in Antarctica Dome C (EDC96) ice core. Journal of Geophysical Research 110: 10.1029/JD005259.

Cook, A.J. and Vaughan, D. 2009. Overview of areal changes of the ice shelves on the Antarctic Peninsula over the past 50 years. The Cryosphere Discussions 3: 579-630.

Cook, E., Palmer, J., and D’Arrigo, R. 2002. Evidence for a „Medieval Warm Period“ in a 1100-year tree-ring reconstruction of past austral summer temperatures in New Zealand. Geophysical Research Letters 29: 10.1029/2001GL014580.

Domack, E.W. and Mayewski, P.A. 1999. Bi-polar ocean linkages: evidence from late-Holocene Antarctic marine and Greenland ice-core records. The Holocene 9: 247-251.

Goosse, H., Masson-Delmotte, V., Renssen, H., Delmotte, M., Fichefet, T., Morgan, V., van Ommen, T., Khim, B.K. and Stenni, B. 2004. A late medieval warm period in the Southern Ocean as a delayed response to external forcing. Geophysical Research Letters 31: 10.1029/2003GL019140.

Hall, B.L. 2007. Late-Holocene advance of the Collins Ice Cap, King George Island, South Shetland Islands. The Holocene 17: 1253-1258.

Hall, B.L. and Denton, G.H. 1999. New relative sea-level curves for the southern Scott Coast, Antarctica: evidence for Holocene deglaciation of the western Ross Sea. Journal of Quaternary Science 14: 641-650.

Hall, B.L. and Denton, G.H. 2002. Holocene history of the Wilson Piedmont Glacier along the southern Scott Coast, Antarctica. The Holocene 12: 619-627.

Hall, B.L., Hoelzel, A.R., Baroni, C., Denton, G.H., Le Boeuf, B.J., Overturf, B. and Topf, A.L. 2006. Holocene elephant seal distribution implies warmer-than-present climate in the Ross Sea. Proceedings of the National Academy of Sciences USA 103: 10,213-10,217.

Hall, B.L., Koffman, T., and Denton, G.H. 2010. Reduced ice extent on the western Antarctic Peninsula at 700-907 cal. yr B.P. Geology 38: 635-638.

Hemer, M.A. and Harris, P.T. 2003. Sediment core from beneath the Amery Ice Shelf, East Antarctica, suggests mid-Holocene ice-shelf retreat. Geology 31: 127-130.

Khalil, M.A.K. and Rasmussen, R.A. 1999. Atmospheric methyl chloride. Atmospheric Environment 33: 1305-1321.

Khim, B-K., Yoon, H.I., Kang, C.Y. and Bahk, J.J. 2002. Unstable climate oscillations during the Late Holocene in the Eastern Bransfield Basin, Antarctic Peninsula. Quaternary Research 58: 234-245.

Krinner, G. and Genthon, C. 1998. GCM simulations of the Last Glacial Maximum surface climate of Greenland and Antarctica. Climate Dynamics 14: 741-758.

Lu, Z., Rickaby, R.E.M., Kennedy, H., Kennedy, P., Pancost, R.D., Shaw, S., Lennie, A., Wellner, J. and Anderson, J.B. 2012. An ikaite record of late Holocene climate at the Antarctic Peninsula. Earth and Planetary Science Letters 325-326: 108-115.

McDermott, F., Mattey, D.P. and Hawkesworth, C. 2001. Centennial-scale Holocene climate variability revealed by a high-resolution speleothem δ18O record from SW Ireland. Science 294: 1328-1331.

Noon, P.E., Leng, M.J. and Jones, V.J. 2003. Oxygen-isotope (δ18O) evidence of Holocene hydrological changes at Signy Island, maritime Antarctica. The Holocene 13: 251-263.

Schaefer, J., Denton, G., Kaplan, M., Putnam, A., Finkel, R., Barrell, D.J.A., Andersen, B.G., Schwartz, R., Mackintosh, A., Chinn, T., and Schluchter, C. 2009. High-frequency Holocene glacier fluctuations in New Zealand differ from the northern signature. Science 324: 622-625.

Steig, E.J., Brook, E.J., White, J.W.C., Sucher, C.M., Bender, M.L., Lehman, S.J., Morse, D.L., Waddington, E.D. and Clow, G.D. 1998. Synchronous climate changes in Antarctica and the North Atlantic. Science 282: 92-95.

Strelin, J., Casassa, G., Rosqvist, G., and Holmlund, P. 2008. Holocene glaciations in the Ema Glacier valley, Monte Sarmiento Massif, Tierra del Fuego. Palaeogeography, Palaeoclimatology, Palaeoecology 260: 299-314.

Williams, M.B., Aydin, M., Tatum, C. and Saltzman, E.S. 2007. A 2000 year atmospheric history of methyl chloride from a South Pole ice core: Evidence for climate-controlled variability. Geophysical Research Letters 34: 10.1029/2006GL029142.

Yoshida, Y., Wang, Y.H., Zeng, T. and Yantosea, R. 2004. A three-dimensional global model study of atmospheric methyl chloride budget and distributions. Journal of Geophysical Research 109: 10.1029/2004JD004951.

Last updated 3 April 2013

Link: http://www.co2science.org/subject/m/summaries/mwpantarctica.php

Übersetzt von Chris Frey EIKE

Technische Anmerkung des Übersetzers: Dieser text war zeitweise so wissenschaftlich, dass ich nicht sicher bin, es immer haargenau getroffen zu haben. Vielfach habe ich die Bandwurmsätze in diesem Artikel in mehrere kürzere Sätze aufgeteilt. Ich bitte um Verständnis.

C. F.