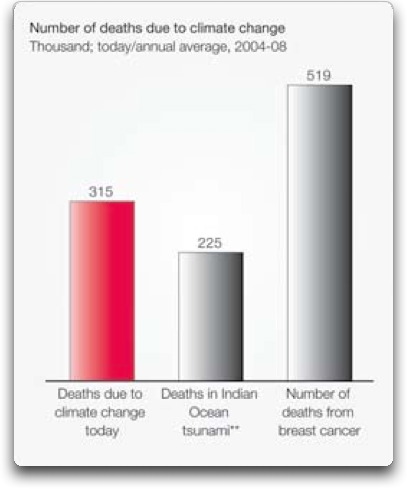

Hier – vorab – die uralte physikalische Erkenntnis, daß zusätzliches CO2 nur noch eine geringfügige Wirkung hat – anhand eines IPCC-Zitates (!)[1] :

“In der idealisierten Situation, daß die Klima-Reaktion auf eine Verdopplung des atmosphärischen CO2 nur aus einer gleichmäßigen Temperaturzunahme besteht, ohne Rückkopplungen … würde die globale Erwärmung nach den Modellen [GCMs] etwa 1,2 °C betragen”

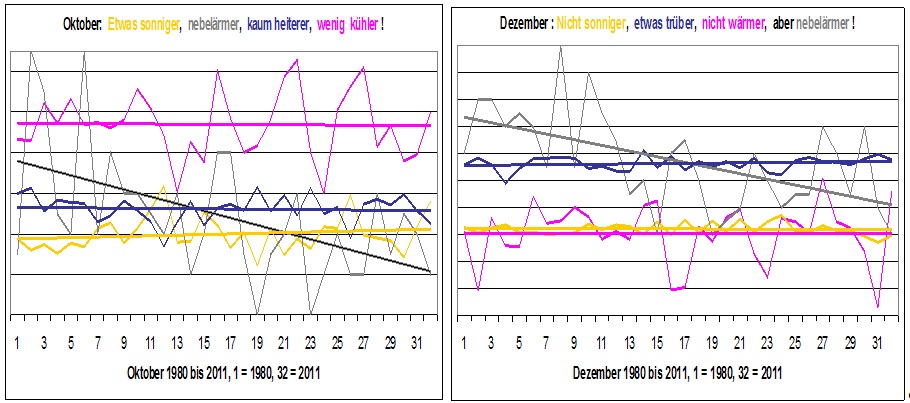

(1) Begriffs-Bestimmung

Wasser-Dampf

Das ist die gasförmige Phase des Wassers. Diese Bezeichnung ist physikalisch unglücklich,weil sie allgemein verwechselt wird mit „Waschküchen-Dampf „, „Wiesen-Nebel“, Wolken … Die vorstehend aufgeführten Erscheinungs-Formen jedoch sind physikalisch etwas ganz anderes, nämlich die flüssige Phase (Aggregat-Zustand) des Wassers in Form von Tröpfchen. Der Durchmesser der Wasser-Tropfen in der Atmosphäre erstreckt sich über einen Bereich von mehr als drei Zehner-Potenzen (μm – mm). Daraus folgt: Auch Nebel und Wolken bestehen aus Wasser-Tröpfchen, sie sind kein Wasserdampf !

Treibhaus-Gase

Es gibt einige (Spuren-)Gase in der Atmosphäre, welche selektiv Infrarot-Strahlung der Erdoberfläche in Linien-Spektren absorbieren, und in den Kugel-Raum wieder abstrahlen, folglich zu 50% Richtung Erde. Damit verzögern … behindern sie teilweise die natürliche Strahlungs-Abkühlung der Erde. Den weit überwiegenden Anteil an diesem Effekt hat der Wasser-Dampf. Die Reihenfolge der Treibhaus-Gase bezüglich ihres Effektes in der Atmosphäre[2]: Wasserdampf 62%, CO2 22%, Ozon(O3) 7%, Lachgas (N2O) 4%, Methan (CH4) 3%.

Das Klima-System

Das Klima-System der Erde besteht aus Atmosphäre, Hydrosphäre (insbes. Ozeane), Kryosphäre (Eis), Biosphäre und Lithosphäre (Gesteine). Bei den Umsetzungen von Energie und Gas im Klimasystem gibt es stets eine Fülle von physikalischen und chemischen Prozessen und Rückkopplungen, die im Detail unüberschaubar sind. Genau d a s ist das Problem der Klima-Modelle, die sich folglich mit einer Vielzahl von Annahmen, Näherungs-Lösungen (Aproximationen), Parametrisierungen etc. behelfen müssen.

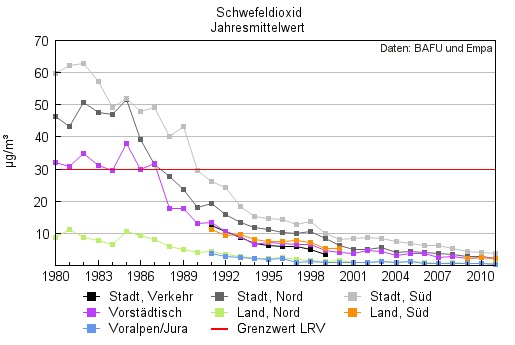

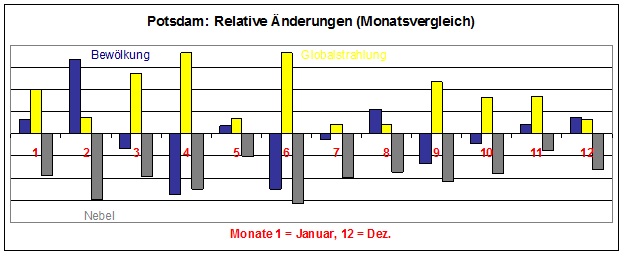

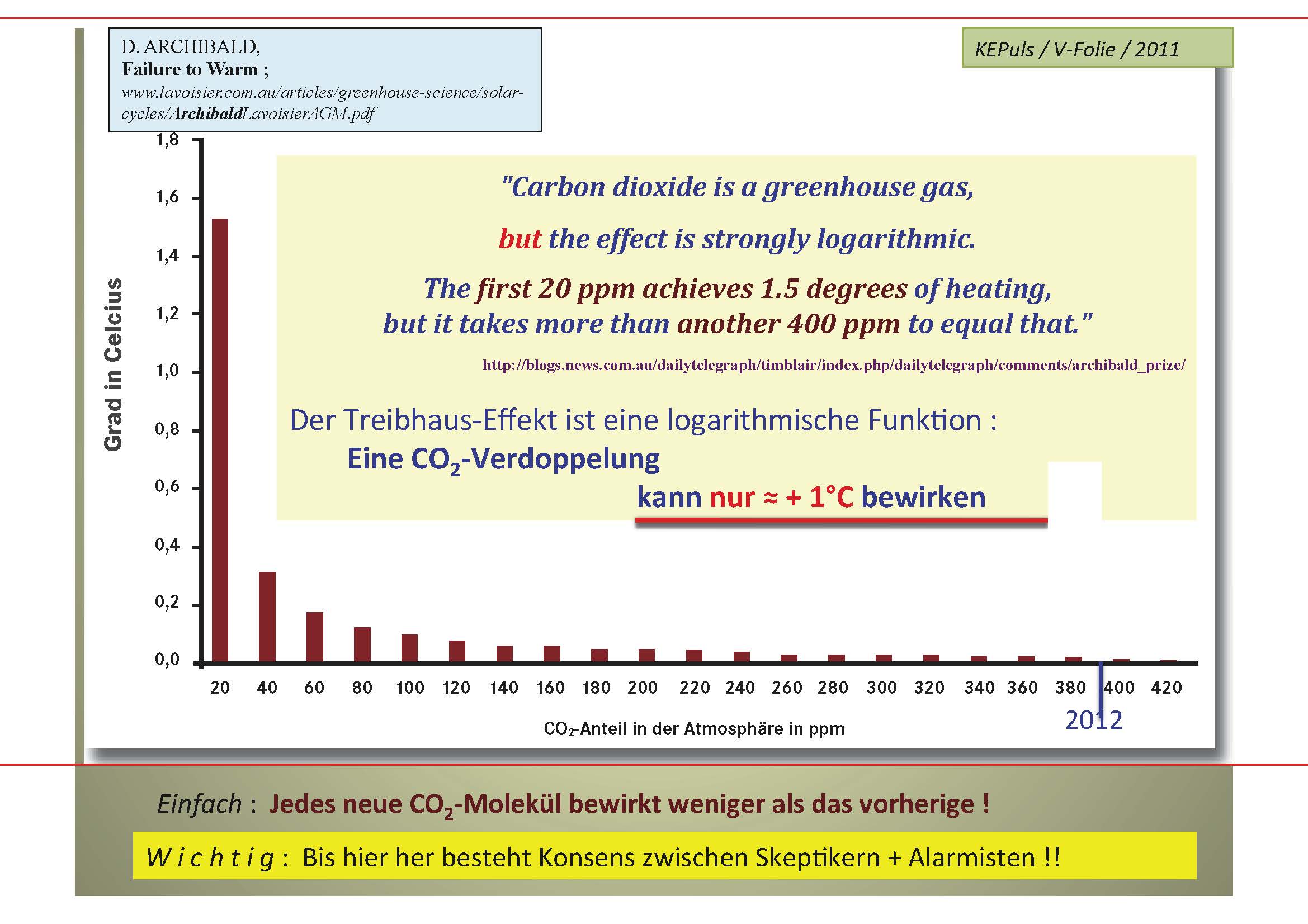

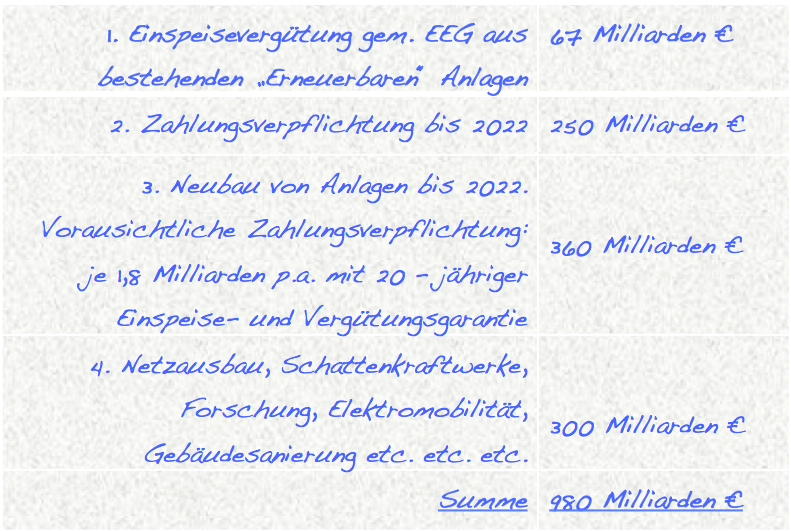

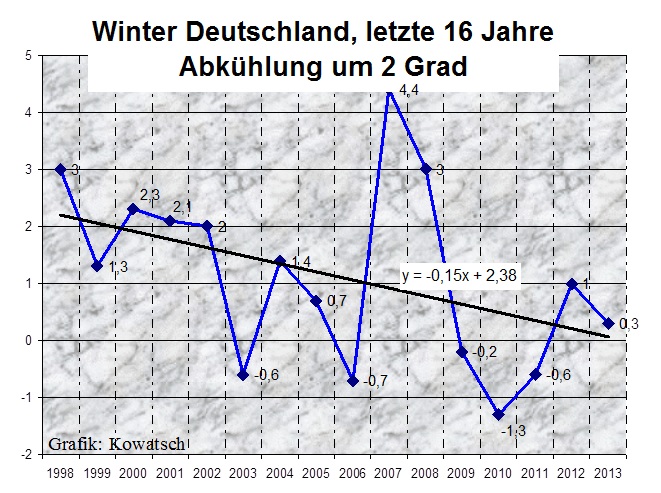

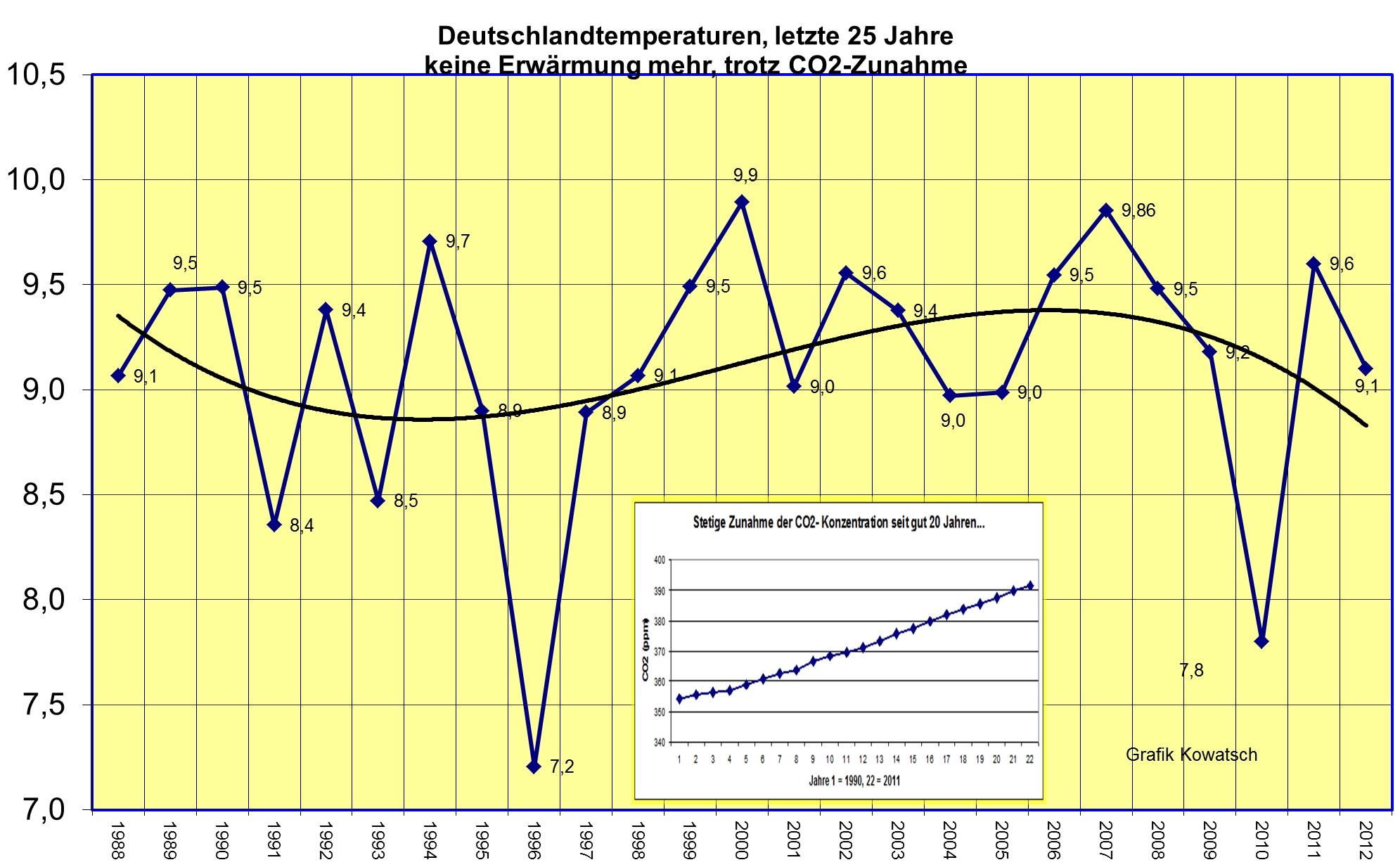

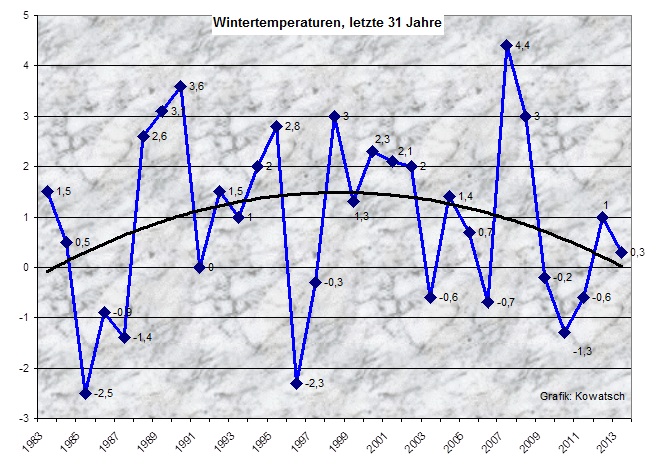

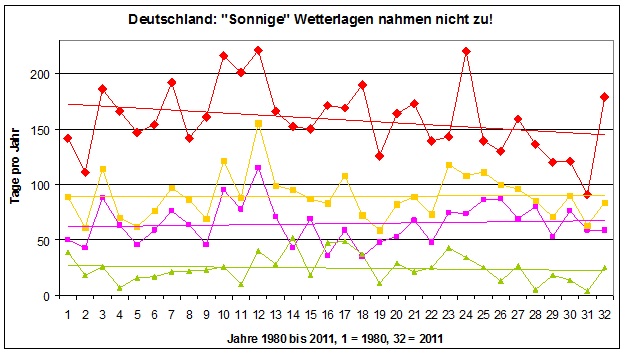

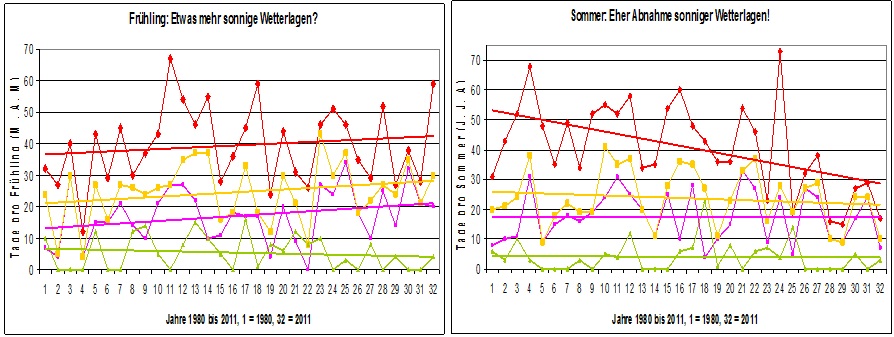

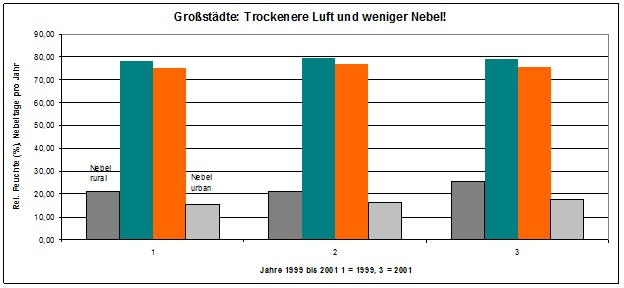

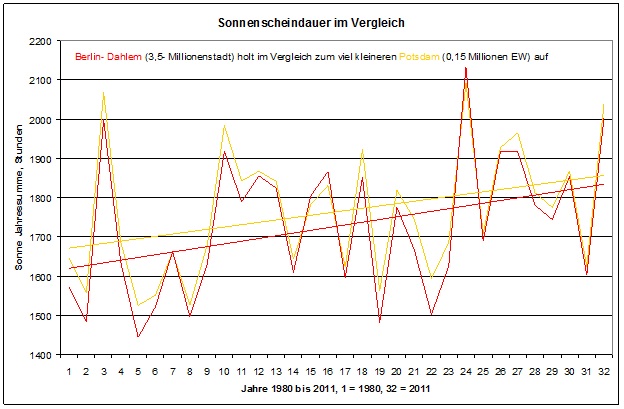

Abbildung 1

Das Klima-System (Graphik KEPuls)

Klimasensitivität

Als Maß für einen abgeschätzten Summen-Effekt von direkter Strahlungs-Wirkung und indirekten Rückkopplungs-Mechanismen im Klima-System wurde die so genannte Klimasensitivität[3] konstruiert. z.B. für CO2:

„Die Klimasensitivität ist eine Größe, die die globale Erwärmung der Erdatmosphäre durch die Wirkung von Treibhausgasen ins Verhältnis zu einer Strahlungseinheit setzt. Man kann sie in °C/(Watt/m²) angeben. Geläufiger ist jedoch die Angabe der Klimaerwärmung bei Verdoppelung der CO2-Konzentration. Das heißt, dass die Durchschnittstemperatur der Erde um diesen Betrag ansteigt, wenn sich die CO2-Konzentration von den vorindustriellen 280 ppm auf dann 560 ppm erhöht. …. Das IPCC gibt in seinem 2007 erschienenen Vierten Sachstandsbericht Werte zwischen 2 und 4,5 °C als „wahrscheinlich“ an. Der beste mittlere Schätzwert liege bei 3 °C …“. …

Diese auch von den Klima-Instituten und dem IPCC verbreitete Definition ist für einen physikalisch weniger gebildeten Leser kaum überschaubar, kaum begreifbar. Sie „vernebelt“ auch von Anfang an, daß die vom IPCC in die Medien transportierten Temperatur-Prognosen von 2…5 Grad auch nicht annähernd alleine durch den Treibhaus-Effekt zu erzielen sind, sondern daß es dazu spekulativer und fragwürdiger und im Detail unbekannter Rückkopplungs-Annahmen bedarf[4]:

„Zur genauen Feststellung dieser Sensitivität gibt es leider kein eindeutiges und allein richtiges Verfahren“

Es handelt sich also bei der „Klima-Sensitivität“ um ein von Anfang an unüberschaubares physikalisches Konstrukt, um eine Hypothese.

(2) WAS kann CO2 ?

Die Treibhaus-Wirkung von CO2 ist aus Labor-Untersuchungen und aus Berechnungen der Wirksamkeit des spektralen CO2-Absorptions-Vermögens hinlänglich bekannt:

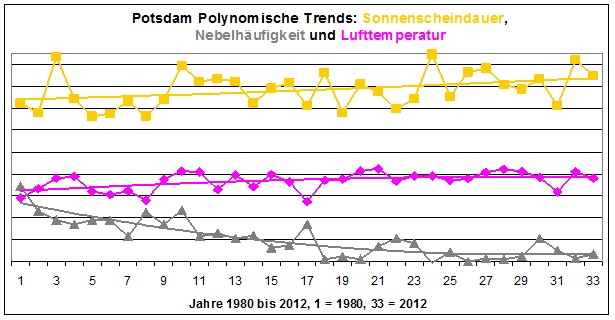

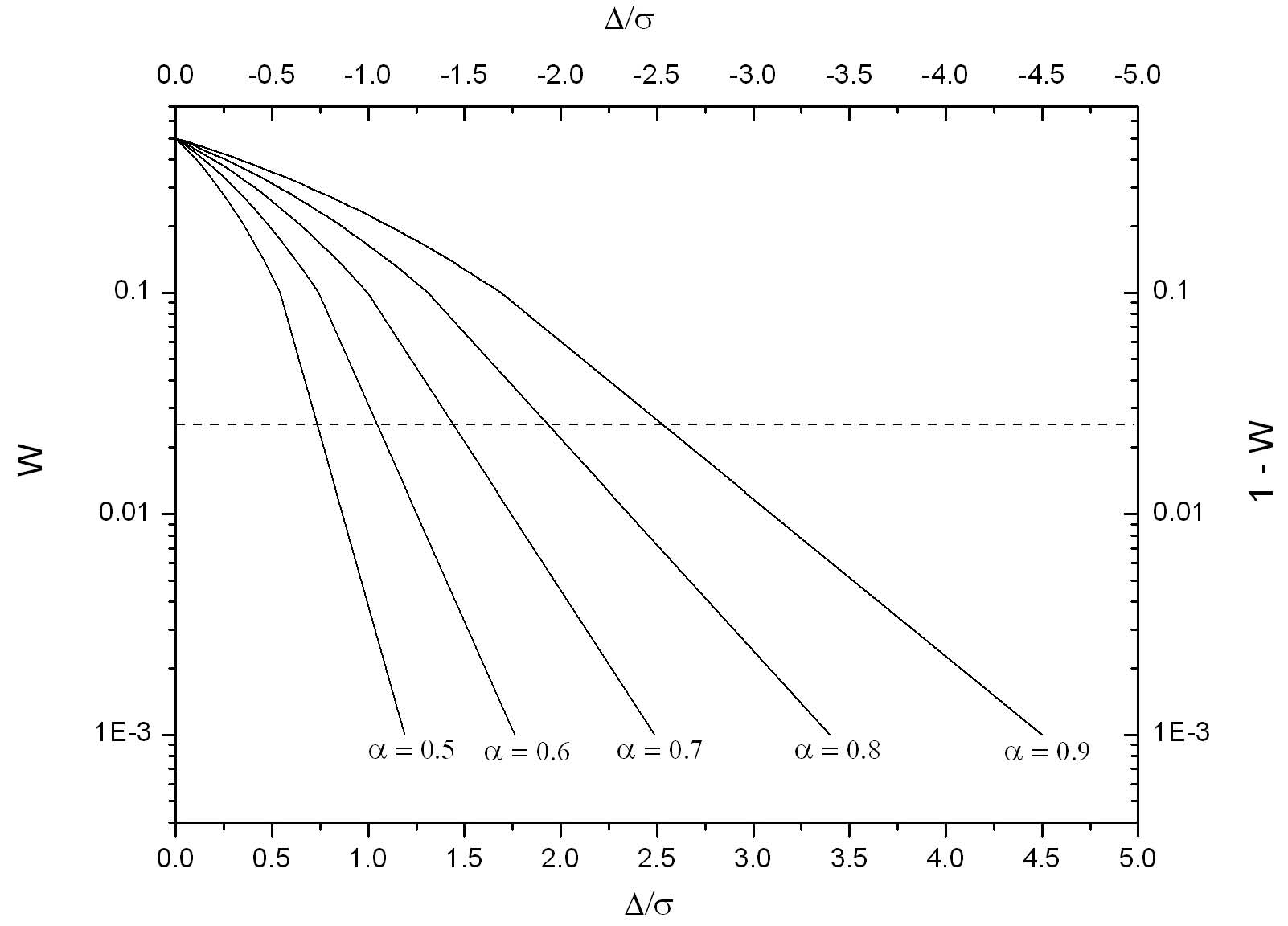

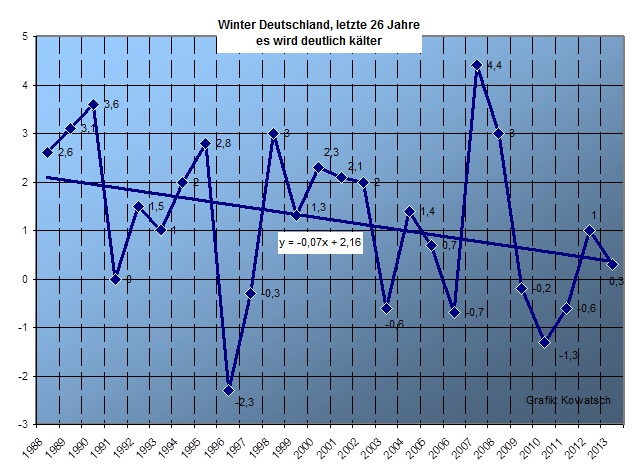

Abbildung 2[5] („…Textfelder eingefügt…“)

Logarithmischer Treibhaus-Effekt

[6]

“ Es gibt bereits so viel CO2 in der Atmosphäre, daß in vielen Spektralbereichen die Aufnahme durch CO2 fast vollständig ist, und zusätzliches CO2 spielt keine große Rolle mehr“,

[7]

„Eine Verdoppelung der Kohlendioxid-Konzentrationen in der Atmosphäre allein (bewirkt) nur eine geringfügige Erhöhung der mittleren bodennahen Temperatur um wenige Zehntelgrade“.

[8]

„In der Mitte des 15-μm-Absorptions-Bereiches hat zusätzliches CO2 nahezu keinen Effekt…“

[9]

„Es gibt bereits soviel CO2 in der Atmosphäre, dass in vielen Spektralbereichen die Aufnahme durch CO2 fast vollständig ist, und zusätzliches CO2 spielt keine große Rolle mehr.”

[10]

„Bei ausschließlicher Betrachtung der im Labor messbaren Strahlungswirkung von CO2 ergibt sich eine Klimasensitivität von 1,2 °C. Es existieren jedoch Rückkopplungs-Effekte, darunter im Wesentlichen die Wasserdampf-Rückkopplung, die Eis-Albedo-Rückkopplung und Wolken. Daher liegen die möglichen und als wahrscheinlich angenommenen Werte höher, ein Wert um 3° wird heute als am wahrscheinlichsten angenommen.“

[11]

„New calculations show that doubling of carbon dioxide (CO2) will increase average global temperature by only about 1F (degrees Fahrenheit) or 0.55C (degrees Centigrade), much less that the range of 2C to 4.5C estimated by the United Nations International Panel on Climate Change (IPCC). These new calculations are based on NASA supported spectral calculations available on the Internet relating to greenhouse gases.“

Bei den in der vorstehend zitierten Literatur genannten CO2-Erwärmungs-Raten von meist unter 1 Grad ist zusätzlich zu berücksichtigen, daß es sich um Berechnungen für eine Atmosphäre ohne Wasserdampf handelt. Eine solche Atmosphäre gibt es jedoch in der Natur nicht. Da sich jedoch die Absorptions-Banden von CO2 und Wasserdampf teilweise überlappen, verringert der Wasserdampf in nicht unwesentlichem Ausmaß das CO2-Treibhaus-Potential noch um etliche Zehntel Grade[12]:

„Wegen des stets vorhandenen Wasserdampfes ist die Wirkung der CO2-Verdoppelung in der Natur aber noch erheblich kleiner.“

Und genau das steht manchmal sogar schon in einer deutschen Zeitung[13]:

„Die Paläoklimatologie liefert immer öfter die entscheidenden Daten und Hinweise, mit denen Unsicherheiten verkleinert und die Schwächen der grobskaligen Modelle gemindert werden – die unvermeidliche „Parametrisierung“ etwa, das Setzen fester Parametergrößen als mathematischer Näherung von kleinskaligen Prozessen, die mit einem vernünftigen Aufwand rechnerisch nicht aufzulösen sind. So wurde in „Science“ (doi: 10.1126/science.1214828) kürzlich gezeigt, dass eine fundamentale Größe aller Prognosen, die Klimasensitivität, bei der Analyse langer Datenreihen tatsächlich etwas geringer ausfällt als bislang geglaubt.“

Genau das sagt auch eine 2013 erschienene Publikation[14] sehr deutlich :

„Global warming less extreme than feared ?“ :

„Policymakers are attempting to contain global warming at less than 2°C. New estimates from a Norwegian project on climate calculations indicate this target may be more attainable than many experts have feared.

Internationally renowned climate researcher Caroline Leck of Stockholm University has evaluated the Norwegian project and is enthusiastic. “These results are truly sensational,”

says Dr Leck. “If confirmed by other studies, this could have far-reaching impacts on efforts to achieve the political targets for climate.”

Zu dem mittlerweile „akten-kundigen“ Erwärmungs-Stop seit 15 Jahren heißt es a.a.O.:

„Temperature rise is levelling off:

After Earth’s mean surface temperature climbed sharply through the 1990s, the increase has levelled off nearly completely at its 2000 level.“

… u.w.a.a.O.:

„According to the … IPCC the climate sensitivity to doubled atmospheric CO2 levels is probably between 2°C and 4.5°C, with the most probable being 3°C of warming.

In the Norwegian project, however, researchers have arrived at an estimate of 1.9°C as the most likely level of warming.“

Diese 1.9°C müssen – nach unten hin – nicht das letzte Wort sein, diese werden nicht das letzte Wort sein.

F a z i t :

Die Treibhaus-Wirkung von zusätzlichem CO2 ist marginal, und liegt im natürlichen Rauschen der Klima-Temperaturen.

(3) Wenn nicht CO2 – wer dann ?

Im zweiten Teil des vorstehend angeführten WIKIPEDIA-Zitats wird schon etwas deutlicher, daß die dramatische „Überhitzung“ der Erdatmosphäre in den Klima-Modellen nicht mit CO2 erzielt werden kann, sondern nur mit hypothetischen Rückkopplungen, wie es in der begutachteten wissenschaftlichen Literatur in Dutzenden von Publikationen auch geschrieben steht ist, z.B.: :

[15]

Da „… die Verdoppelung (von CO2) nur die von den Flanken der Kohlendioxidbanden herrührende Gegenstrahlung erhöhen würde, führt diese Temperaturerhöhung jedoch in der Folge zu einer Vermehrung der Wasserdampfkonzentration in der Atmosphäre, die zu einer wesentlich höheren Zunahme der Gegenstrahlung und damit zu der bekannten angenommenen Erhöhung der Mitteltemperatur um zwei bis drei Grad Celsius führen würde.“

[16]

“In the idealised situation that the climate response to a doubling of atmospheric CO2 consisted of an uniform temperature change only, with no feedbacks operating … the global warming from GCMs would be around 1.2 °C.”

[17]

„Der Wasserdampf-Feedback ist nach wie vor der durchweg wichtigste Rückkopplungseffekt, der die von den allgemeinen Zirkulationsmodellen als Reaktion auf eine CO2-Verdoppelung vorhergesagte globale Erwärmung verursacht“.

Die physikalische Begründung für diese Hypothese ist zunächst durchaus plausibel, mit der folgenden Argumentations-Kette:

[18] „Eine Verdoppelung der Kohlendioxid-Konzentrationen in der Atmosphäre allein (bewirkt) nur eine geringfügige Erhöhung der mittleren bodennahen Temperatur um wenige Zehntelgrade“.

Damit erhöht sich das Aufnahme-Vermögen der Atmosphäre für Wasserdampf[19]:

„Der Sättigungsdampfdruck eines Reinstoffes in einem geschlossenen System ist von der Temperatur abhängig.“

Die Atmosphäre nimmt mehr Wasserdampf auf, weil das o.a. physikalische Gesetz es zulässt;

Der „zusätzliche“ Wasserdampf wiederum erhöht die Lufttemperatur weiter, weil der Wasserdampf das Haupt-Treibhaus-Gas ist;

Dieser Prozeß schaukelt sich auf zu immer höheren Temperaturen;

Die Modelle müssen eine „Bremse“ einbauen, um ein „runaway“ … „running over“ zu vermeiden.

Soweit die Theorie.

Realisiert die Natur diese Hypothese (?)[20] :

„In diesem Kapitel[21] wird weiter argumentiert, dass große positive Rückkopplungen, hauptsächlich durch Wasserdampf, diesen Effekt wahrscheinlich verstärken. Aber während es einen guten Konsens über die 1,2 °C gibt, existiert überhaupt kein Konsens über den Nettoeffekt der positiven Rückkopplungen, wie das IPCC auch offen zugibt.“

F a z i t :

Die Treibhaus-Eigenschaften von CO2 können bei Konzentrations-Verdoppelung in einer realen, also wasserdampf-haltigen Atmosphäre nur etwa ein halbes Grad Erwärmung bewirken. Die Klima-Modelle „benötigen“ für ihre spektakulären Temperatur-Prognosen hypothetische Verstärkungs-Prozesse, allen voran die Wasser-Dampf-Verstärkung. Allerdings – die Natur macht etwas anderes è s.w.unten.

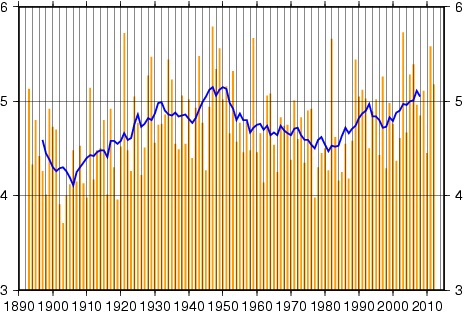

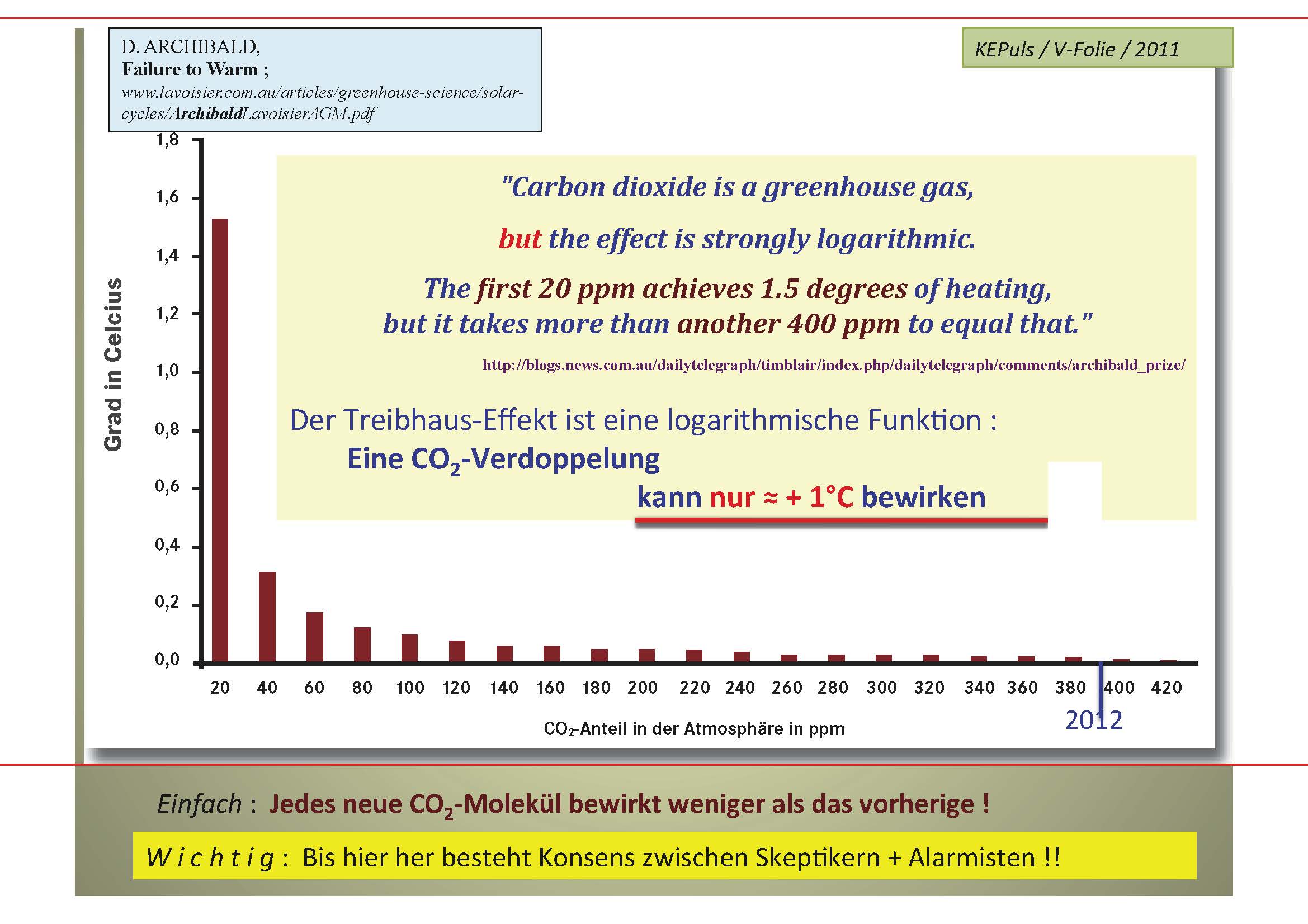

(4) WD in der Troposphäre

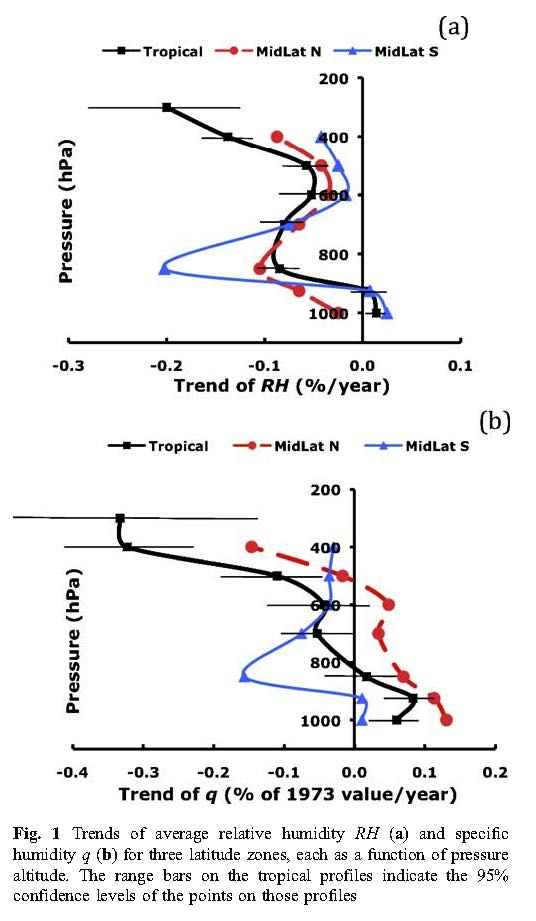

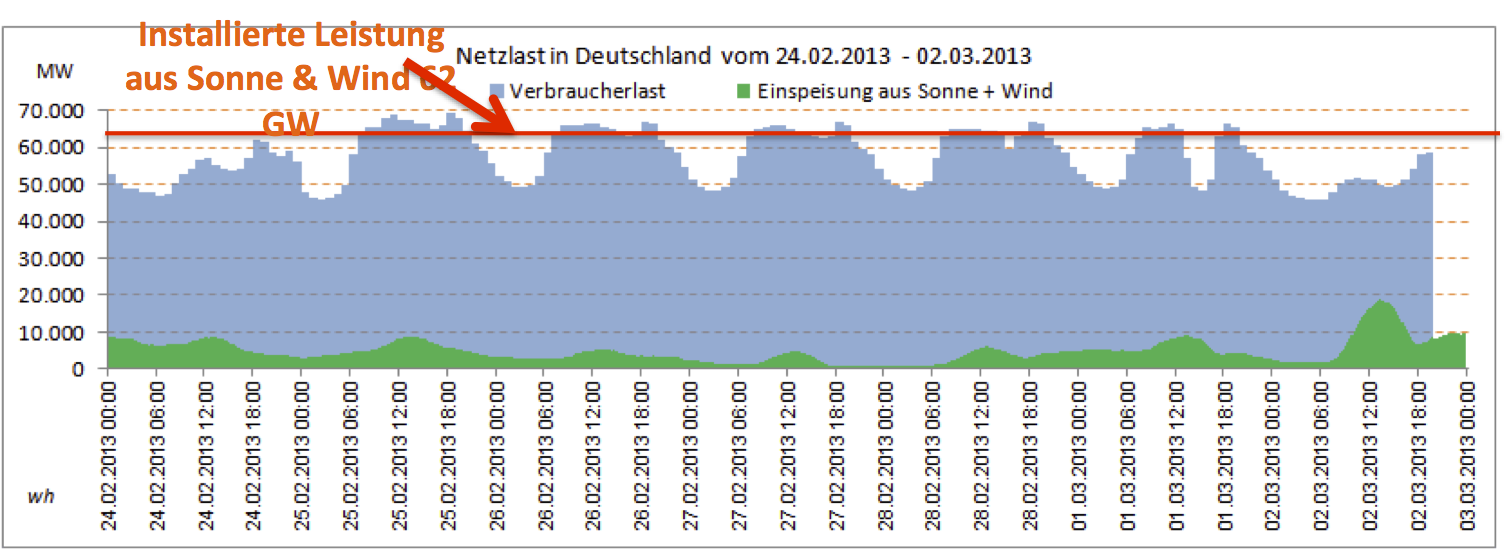

Ein Autoren-Team[22] hat die globalen Daten von Radiosonden („Wetter-Ballone“) ausgewertet, über einen Zeitraum von 35 Jahren: 1973-2007 :

Abbildung 3

Auswertung von Radiosonden 1973-2007

(Paltridge et al. 2009)

Das Ergebnis (a.a.O.) :

„… the face-value 35-year trend in zonal-average annual-average specific humidity q

is significantly negative at all altitudes above 850 hPa (roughly the top of the convective boundary layer) in the tropics and southern midlatitudes and at altitudes above 600 hPa in the northern midlatitudes. It is significantly positive below 850 hPa in all three zones, as might be expected in a mixed layer with rising temperatures over a moist surface.“

Bezüglich der Klima-Modelle sagen die Autoren:

„The upper-level negative trends in q are inconsistent with climate-model calculations …“

… u.w.a.a.O.:

„Negative trends in q as found in the NCEP data would imply that long-term water

vapor feedback is negative …“

Weiterhin:

Die Klima-Modelle rechnen damit, daß die Erwärmung der Tropen dazu führt, daß konvektiv Wärme und Wasserdampf in die obere Troposphäre geführt wird („Hotspot“). Dadurch soll eine erhebliche Verstärkung des Treibhaus-Effektes erfolgen. Meteorologische Messungen widerlegen das[23]:

„Thus, the small OLR (Outgoing Longwave Radiation) feedback from ERBE (Earth

Radiation Budget Experiment) might represent the absence of any OLR feedback; it might also result from the cancellation of a possible positive water vapor feedback due to increased

water vapor in the upper troposphere [Soden et al. , 2005] and a possible negative iris cloud feedback involving reduced upper level cirrus clouds [Lindzen et al. , 2001]“

In dem Buch[24] „CO2 und Klimaschutz“ steht zu den o.a. Publikationen folgende Zusammenfassung:

„Unter der Voraussetzung, daß die von Lindzen et al. sowie von Paltridge et al. mitgeteilten Meßergebnisse und Schlussfolgerungen korrekt sind, bedeutet dies nicht mehr und nicht weniger als das wissenschaftliche Ende einer vom Menschen verursachten Klimakatastrophe.“

F a z i t :

Die Messungen der Wasserdampf-Konzentration in der Troposphäre widersprechen weitgehend den Annahmen und Ergebnissen der Klima-Modelle !

(5) WD in der Stratosphäre

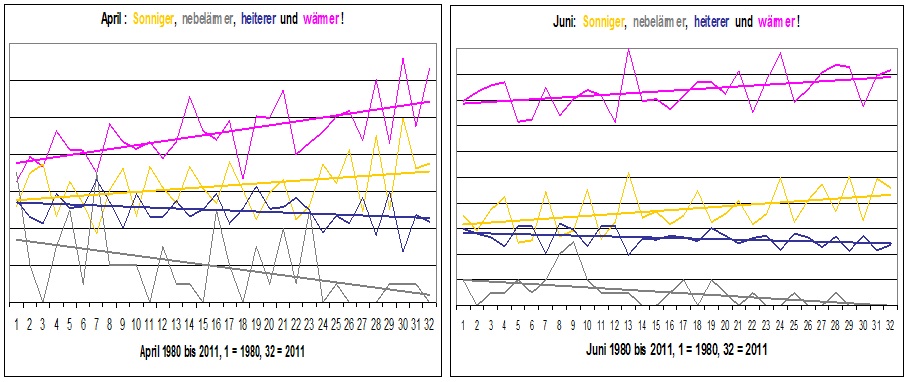

Eine 2010 veröffentlichte Studie[25] auf der Basis von Satelliten-Daten zeigt, daß in der Stratosphäre ein „auf+ab“ des Wasserdampf-Gehaltes gemessen wird:

„Observations from satellites and balloons show that stratospheric water vapor has had its ups and downs lately, increasing in the 1980s and 1990s, and then dropping after 2000.“

Die Ursache dafür ist unbekannt (a.a.O.) : „Since 2000, water vapor in the stratosphere decreased by about 10 percent. The reason for the recent decline in water vapor is unknown.“

Gleichermaßen kompliziert und letztlich unklar sind die Zusammenhänge mit der Stagnation der Global-Temperatur in der Troposphäre (a.a.O.):

„A 10 percent drop in water vapor ten miles above Earth’s surface has had a big impact on global warming, say researchers in a study published online January 28 in the journal Science. The findings might help explain why global surface temperatures have not risen as fast in the last ten years as they did in the 1980s and 1990s.“

Dabei wird auch angemerkt, daß der Wasserdampf in den Klima-Modellen als der bedeutendste „Temperatur-Verstärker“ betrachtet wird:

“Current climate models do a remarkable job on water vapor near the surface. But this is different – it’s a thin wedge of the upper atmosphere that packs a wallop from one decade to the next in a way we didn’t expect,”

Temperatur und Wasserdampf – WER folgt hier WEM ? Die Unsicherheiten erscheinen nach dieser Studie größer, als bisher angenommen :

„The new study used calculations and models to show that the cooling from this change caused surface temperatures to increase about 25 percent more slowly than they would have otherwise, due only to the increases in carbon dioxide and other greenhouse gases.“

…und w.a.a.O.:

„The stratosphere is a region of the atmosphere from about eight to 30 miles above the Earth’s surface. Water vapor enters the stratosphere mainly as air rises in the tropics. Previous studies suggested that stratospheric water vapor might contribute significantly to climate change. The new study is the first to relate water vapor in the stratosphere to the specific variations in warming of the past few decades.“

Wie unsicher alle diese Annahmen und damit letztlich die Klima-Modelle selbst sind, das zeigen auch die Temperatur-Messungen in der oberen Troposphäre und in der Stratosphäre, denn es gibt nach den meteorologischen Messungen der letzten 20 Jahre die von den Klima-Modellen vorhergesagte Effekte dort nicht[26]:

Weder den vorhergesagten „Hotspot“ in der oberen Troposphäre, noch die von den Modellen berechnete langsame Abkühlung der oberen Stratosphäre !

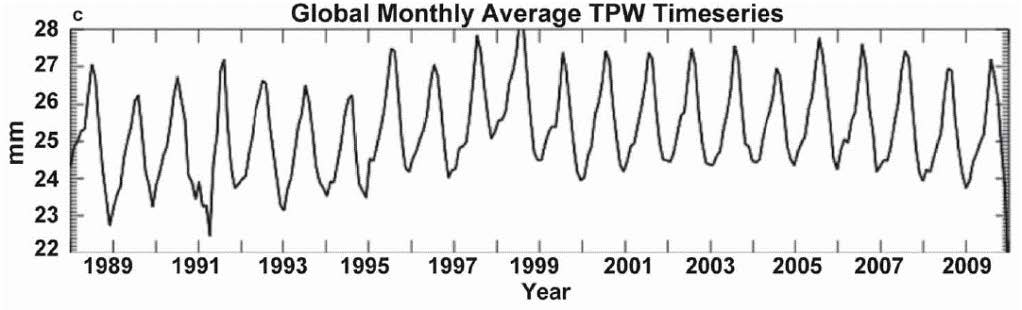

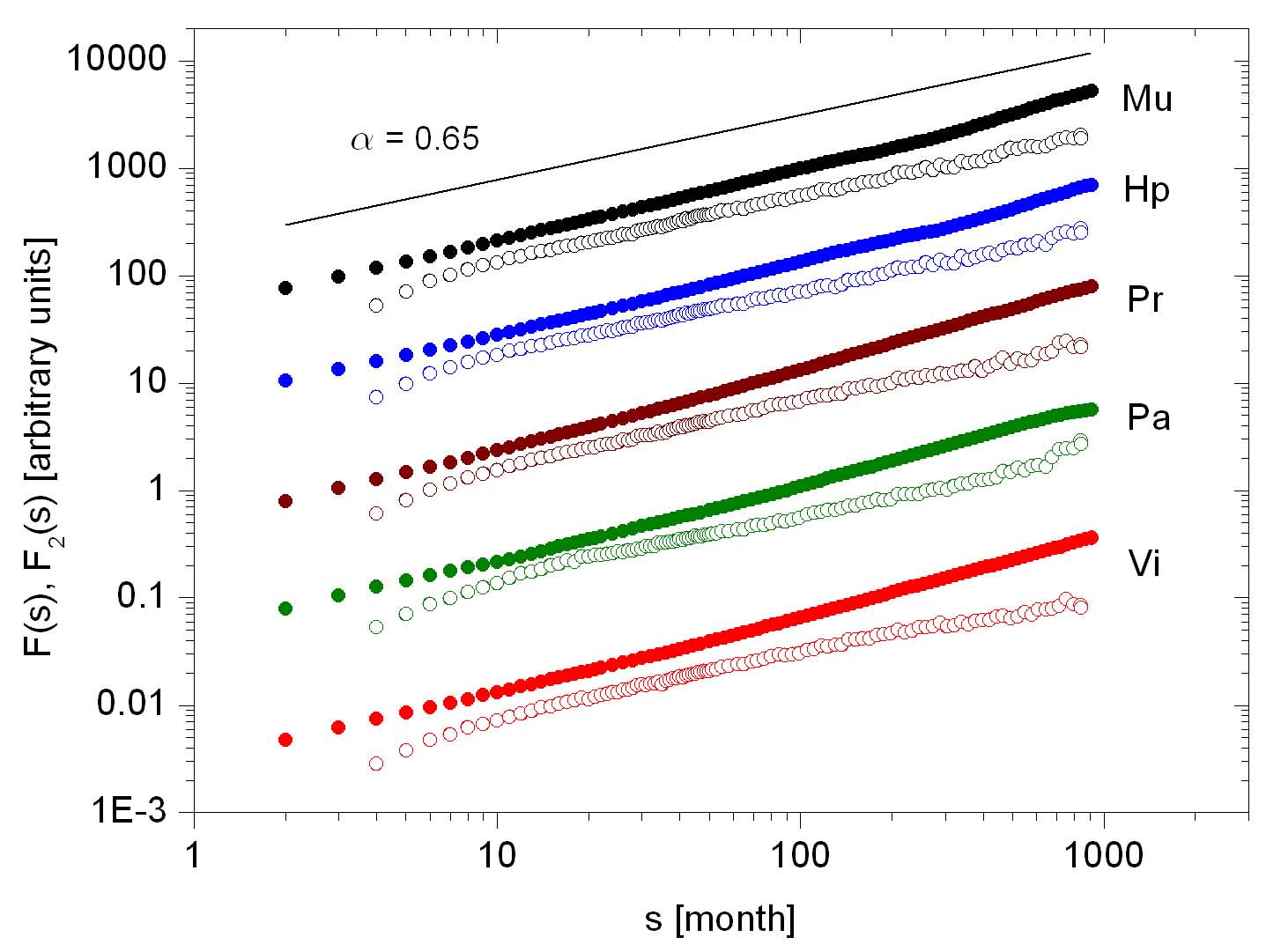

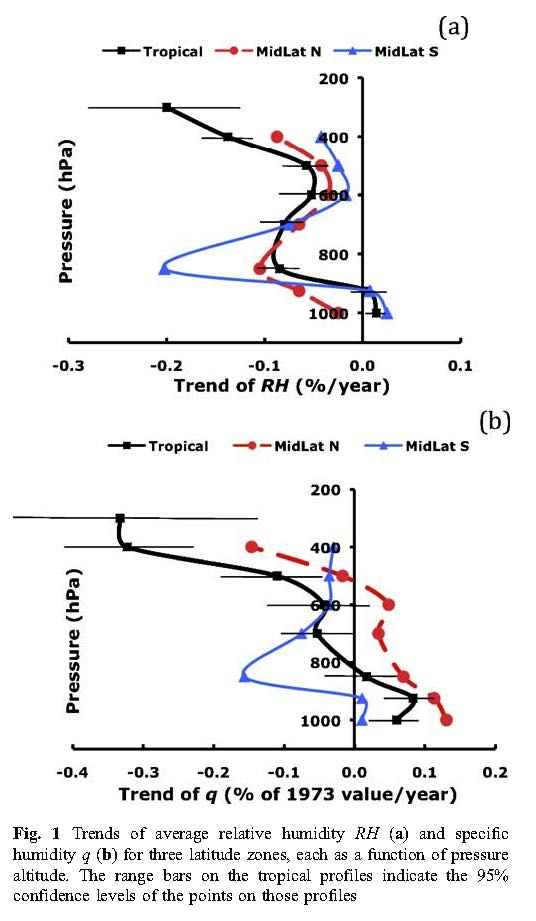

(6) WD in der Atmosphäre – total

In einem NASA-Projekt wird der Total-Wasserdampf-Gehalt der Atmosphäre untersucht[27] :

„The NASA Water Vapor Project (NVAP) dataset is a global (land and ocean) water vapor dataset created by merging multiple sources of atmospheric water vapor to form a global map of total and layered precipitable water vapor.“

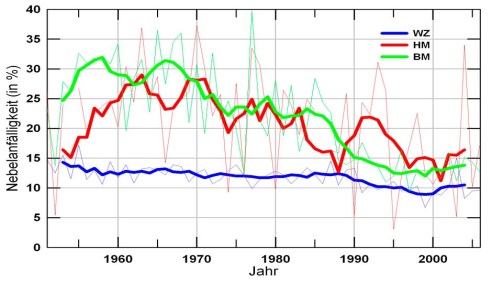

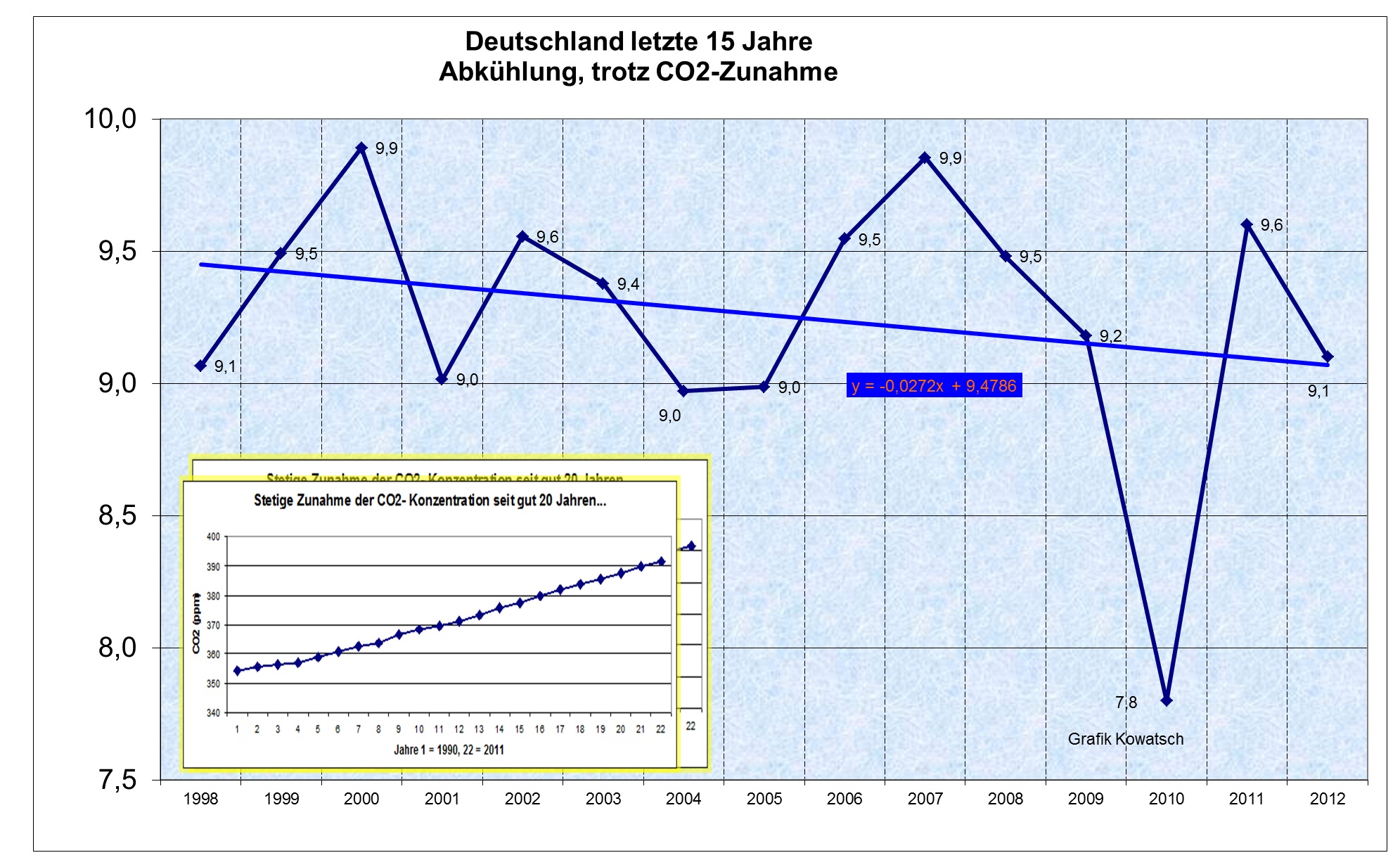

Abbildung 4

Wasserdampfgehalt 1988-2009 in der Atmosphäre;

Vonder Haar et al. (2012), Abbildung nachzitiert nach http://www.kaltesonne.de/?p=4803

In den Schlussfolgerungen ihres Papers schreiben die Forscher:

„Zu diesem Zeitpunkt können wir das Vorhandensein eines robusten Trends in der globalen Wasserdampfentwicklung weder beweisen noch widerlegen.“

In einer Übersicht wird das so zusammen gefasst[28]:

„Während das CO2 die letzten Jahrzehnte lang monoton angestiegen ist, hat der Wasserdampf seit nunmehr 14 Jahren offenbar eine Pause eingelegt und stagniert bzw. fällt sogar leicht ab. Eine Kopplung von CO2 und Wasserdampf ist in dieser Zeit nicht erkennbar. “

Auch weltweite Niederschlags-Messungen der Wetterdienste stürzen diesen Befund:

(7) Global mehr Niederschläge ?

Diesem Thema gibt auch der SREX-Bericht des IPCC vor der Klima-Konferenz in Durban (2011) Raum, worüber DER SPIEGEL[29] wie folgt berichtet:

„Mehr Hitze lässt mehr Wasser verdampfen – ergo mehr Regen. Diese Cocktailparty-Gleichung mag einfach klingen, doch hat sie leider nichts mit dem realen Wettergeschehen zu tun … “ …’Wir finden aber in unseren Messungen keinen Anstieg der Niederschläge‘, klagt Andreas Becker vom Deutschen Wetterdienst (DWD)“.

Dazu ist anzumerken: Beim DWD ist das Welt-Niederschlags-Zentrum der WMO angesiedelt, dort gehen also die weltweit ermittelten Daten zum Niederschlag ein und werden ausgewertet.

Weiter dazu DER SPIEGEL a.a.O.: „Ein Messfehler ? Oder sind die Gleichungen falsch ? ‚Für die Forschung ist das ein großes Rätsel‘, bekennt der Leiter des Weltzentrums für Niederschlagsklimatologie“.

F a z i t :

Die Messungen zeigen, daß es global in der Atmosphäre weder mehr Wasserdampf (vgl. Kap.4-6) noch mehr Niederschläge (Kap.7) gibt.

Dazu passen auch aktuelle Verdunstungs-Messungen :

(8) Wasserverdunstung über Land nimmt ab

Die LVZ Leipzig berichtete[30] 2011 über Forschungs-Ergebnisse des MPI Jena im Rahmen des internationalen Projektes Fluxnet-Initiative[31] wie folgt:

„Bislang gingen Klimaforscher davon aus, dass die Erderwärmung den globalen Wasserkreislauf anheizt. Auf eine Überraschung sind nun Experten des Max-Planck-Institutes für Biogeochemie in Jena gestoßen: Sie ermittelten, dass zwischen 1998 und 2008 der weltweite Trend zunehmender Verdunstung von der Landoberfläche deutlich abgeschwächt oder sogar umgekehrt wurde.“

u.w.a.a.O.:

„…wärmere Luft kann bekanntermaßen mehr Feuchtigkeit aufnehmen. Klimaforscher gingen daher bislang davon aus, dass auf der wärmer werdenden Erde mehr Wasser verdampft.

…. Da sich gleichzeitig die Temperatur der Atmosphäre leicht erhöhte, hat uns die Abschwächung der Verdunstung doch sehr überrascht.“

u.w.a.a.O.:

„Wir lassen ausschließlich die Messdaten sprechen, wenn wir globale Kreisläufe wie etwa den Wasserzyklus untersuchen“, erklärt Reichstein. Die Forscher gehen also nicht wie früher üblich von hypothetischen Klimamodellen aus, um Messwerte zu interpretieren.“

Die hier dargestellten Ergebnisse des Projektes sind eindeutig:

Die Messwerte zeigen eine dekadische Abnahme des Wasserverdunstung, die Modelle behaupten das Gegenteil !

(9) Kritik an der Modellierung der WDV

Es gibt sehr viele namhafte Wissenschaftler, welche die hohe Wichtung der WDV in den Klima-Modellen kritisieren, z.B. :

[32]

Roy W. Spencer, Ph. D. :

“While it seems rather obvious intuitively that a warmer world will have more atmospheric water vapor, and thus positive water vapor feedback, I’ve just listed the first 5 reasons that come to my mind why this might not be the case. ….. At a minimum, I believe the water vapor feedback issue is more complicated than most mainstream researchers think it is.“

[33]

Meteorologie-Professoren H. Kraus und U. Ebel :

„Mit einer Erwärmung der Armosphäre kann auch der Wasserdampfgehalt zunehmen, und man könnte erwarten, daß sich der hydrologische Zyklus intensiviert…; ob sich Folgen wirklich einstellen, läßt sich selbst durch sehr komplexe Modellrechnungen nicht zuverlässig herausfinden.“

[34]

Dr. Miklós Zágoni (Prominent Hungarian Physicist) : „Contrary to the common wisdom, there is no positive H2O-Temperature feedback on global scale; in Earth-type atmospheres uncontrolled runaway warming is not possible…“.

[35]

Walter Cunningham (Astronaut):

„NASA’s Aqua satellite is showing that water vapor, the dominant greenhouse gas, works to offset the effect of carbon dioxide (CO2). This information, contrary to the assumption used in all the warming models, is ignored by global warming alarmists.“

[36]

Prof. Dr. C.O. Weiss (eh. Dir. und Prof. an der PTB):

„Der direkte Einfluss von CO2 auf die Erdtemperatur beträgt nur einen kleinen Bruchteil von 1 Grad Celsius und ist damit praktisch völlig unwichtig. Hierin stimmen fast alle Wissenschaftler überein. Die Alarmmeldungen über Erderwärmung basieren auf ANNAHMEN ( keineswegs Kenntnissen ) über die Wirkung von Wolken. In den Modellen auf die sich die Voraussagen des „Internationalen Ausschusses für Klimawandel“ (IPCC). stützen wird (recht willkürlich) ANGENOMMEN, dass Wasserdampf und Wolken die geringfügigen Temperaturerhöhungen durch CO2 in katastrophaler Weise verstärken, und somit die „Klimakrise“ hervorrufen. …

Obwohl dies die alles entscheidende Frage der Klimaforschung ist, sind zur Klärung dieser entscheidenden Annahmen von Seiten der „offiziellen“ Klimaforschung bisher keine Anstrengungen unternommen worden. Zwar wurden Vergleiche von Modellergebnissen mit Strahlungsmessungen von Satelliten gemacht. Da die Messungen den Modellen aber widersprachen wurden die Ergebnisse ignoriert und behauptet, die Messungen seien nicht ‚verlässlich‘.“

[37]

Clive Best (Physiker, PhD) :

„Es wird gezeigt, dass eine positive lineare Klima-Rückkopplung für kombinierte Wasserdampfeffekte mit dem Schwache-Sonne-Paradoxon unvereinbar ist. Im Besonderen führen Rückkopplungswerte von ~2,0 W/m²K, wie sie die gegenwärtigem GCMs annehmen, zu nichtphysikalischen Ergebnissen hinsichtlich der Solarstrahlung vor einer Milliarde Jahren. Ein einfaches Modell wird beschrieben, wonach erdähnliche Planeten mit großen Oberflächen flüssigen Wassers bei kleinen Änderungen der einfallenden Sonnenstrahlung die Temperatur selbst regulieren können. Das Modell nimmt an, dass sich reflektierende Wolken ausbreiten, während der Treibhauseffekt mit der heller werdenden Sonne abnimmt. Die Gesamtwasserdampf-Rückkopplung des Modells ist stark negativ. Direkte Beweise für die negative Wasserdampf-Rückkopplung finden sich in den Stationsdaten von CRUTEM4, indem man die Temperaturanomalien in ariden Regionen (Wüsten und Polargebiete) mit jenen in feuchten Regionen (hauptsächlich in den Tropen) vergleicht. Alle 5600 Stationen wurden nach der Köppen-Geiger-Klimatologie (9) eingeordnet. Zwei separate Temperaturreihen von 1900 bis 2011 wurden für jedes Gebiet berechnet. Es ergab sich eine klare Differenz der Temperaturanomalien. Unter der Annahme, dass die Ursache der Differenz im atmosphärischen Wasserdampfgehalt zu suchen ist, kann ein Rückkopplungswert von -1,5 ±0,8 W/m²K abgeleitet werden.“

[38]

Universität Bremen :

„Wasserdampfkarte hilft, Klimamodelle zu korrigieren“:

„Ein deutsch-niederländisches Forscherteam hat nach Angaben der Universität Bremen erstmals globale Karten der Isotopenzusammensetzung von Wasser in der unteren Atmosphäre gemessen. Die Messungen des europäischen Umweltsatelliten Enivsat eröffnen die Möglichkeit, heutige Klimamodelle und damit Vorhersagen über Regenmengen und Überschwemmungsgefahren zu verbessern.

Die Wissenschaftler verglichen die Messungen in der Sahelzone und bei Spitzbergen mit Modellrechnungen. Beides Mal waren die Messwerte nicht durch die Modelle reproduzierbar, so die Universität. Dies weise darauf hin, dass der tropische und arktische Wasserkreislauf in den Modellen bisher nicht vollständig korrekt erfasst seien.“

[39]

Prof. Dr. Richard Lindzen: „Das ist physikalisch vollkommen absurd. In der Natur geht eine höhere Verdunstung immer mit mehr Niederschlag einher. Zudem kann eine höhere Verdunstung niemals zu einem höheren Wasserdampfgehalt in Lufthöhen von drei Kilometern führen. Und genau dort ist die kritische Grenze, da Wasserdampf zwischen 3 km und der Tropopause den Treibhauseffekt dominiert.“

[40]

Hans von Storch (Director of Institute for Coastal Research, HH):

„Wir Klimaforscher können nur mögliche Szenarien anbieten; es kann also auch ganz anders kommen“ .

…damit ist das Entscheidende in einem Satz gesagt:

Die Natur macht was Anderes, als die Modelle vorhersagen.

(10) Zusammenfassung

Bei CO2-Verdoppelung in einer realen, wasserdampf-haltigen Atmosphäre beträgt der zusätzliche Treibhaus-Effekt von CO2 auf der Basis von Labor-Messungen nur etwa ½ Grad. Die Modelle der IPCC-nahen Institute erzielen daher die ständig propagierten 2 … 5 Grad globaler Erwärmung nicht mit CO2, sondern mit Verstärkungs-Hypothesen, insbesondere mit der Wasserdampf-Verstärkung. Daraus folgt: Nach der säkularen Erwärmung im 20. Jahrhundert um ca. 0,7 Grad müsste einerseits die Wasserdampf-Gehalt der Atmosphäre schon messbar zugenommen haben, andererseits müsste die Temperatur von Jahrzehnt zu Jahrzehnt beschleunigt ansteigen. Beides wird von den meteorologischen Messungen widerlegt: Weder in der Troposphäre noch in der Stratosphäre sind solche Trends zu beobachten, eher ein leichter Trend zu weniger Wasserdampf, und auch zu weniger Verdunstung am Boden.

Auch stagniert die Global-Temperatur seit 15 Jahren.

==================================================================

Klaus-Eckart Puls, EIKE

—————————————————————————————————————–

[1] IPCC-Rep. (2007), Chapt. 8.6.2.3

[2] SCHÖNWIESE. promet. 1996

[3] Quelle: WIKIPEDIA

[4] http://www.pik-potsdam.de/~stefan/alvensleben_kommentar.html

[5] www.lavoisier.com.au/articles/greenhouse-science/solar-cycles/ArchibaldLavoisierAGM.pdf

[6] P.J. Crutzen (Nobelpreis Chemie); T.E.Graedel: Chemie der Atmosphäre, Spektrum Akad.Vlg,, Berlin, 1993, S.414

[7] H. Hinzpeter, (eh. Leiter MPI HH), promet, 15, Heft 2/3, 1985, S.49)

[8] Quelle: IPCC-Bericht 1994

[9] H. Hug, Die Angsttrompeter, Signum-V., München, 2006

[10] WIKIPEDIA zu Wasserdampf-Verstärkung

[11] Richard J. Petschauer „Carbon Heat Trapping: Merely A Bit Player in

Global Warming“ http://www.junkscience.com/jan08/Global_Warming_Not_From_CO2_20080124.pdf

[12] [Dietze 2001; Carbon Model Calculations, nachzitiert nach: http://www.pik-potsdam.de/~stefan/alvensleben_kommentar.html ]

[13] FAZ, 06.12.2011 : Der kostbare Kaffeesatz in den Klimamodellen

[14]http://www.forskningsradet.no/en/Newsarticle/Global_warming_less_extreme_than_feared/1253983344535/p1177315753918 Published: 24.01.2013

[15] H. Hinzpeter, eh. Dir. MPI HH, promet, 15, Heft 2/3, (1985), S.49

[16] IPCC-Rep. (2007), Chapt. 8.6.2.3

[17] IPCC, Climate Change 2001, Working Group I: The Scientific Basis, Contr.Wok.Gr.I, 3rd Ass.Rep.IPCC, Ch.7.2.1.1).

[18] H. Hinzpeter, (eh. Leiter MPI HH), promet, 15, Heft 2/3, 1985, S.49) ;

[19] WIKIPEDIA; zu: Sättigungs-Dampfdruck

[20] Matt Ridley: Wissenschafts-Ketzerei ; Vortrag bei der Royal Society of the Arts, Edinburgh, 31. Oktober 2011; http://www.science-skeptical.de/blog/matt-ridley-uber-wissenschafts-ketzerei/005957/

[21] IPCC-Rep. (2007), Chapt. 8.6.2.3

[22] PALTRIDGE , ARKING & POOK: Trends in middle- and upper-level tropospheric humidity from NCEP reanalysis data, Theor Appl Climatol, DOI 10.1007/s00704-009-0117-x Springer-Verlag (2009)

[23] Richard S. Lindzen and Yong-Sang Choi ; On the determination of climate feedbacks from ERBE data; Geophys. Res. Lett., VOL. 36, L16705, doi:10.1029/2009GL039628, (2009)

[24] H.-J. Lüdecke: CO2 und Klimaschutz, BOUVIER (2007), S. 105

[25] (Susan Solomon et al.: Stratospheric Water Vapor is a Global Warming Wild Card ; January 28, 2010; http://www.noaanews.noaa.gov/stories2010/20100128_watervapor.html )

[26] http://www.eike-klima-energie.eu/news-cache/temperatur-prognosen-der-klima-modelle-bis-heute-fuer-alle-atmosphaeren-schichten-falsch/ ; 05.10.2012

[27] Vonder Haar et al.: Weather and climate analyses using improved global water vapor observations; Geoph.Res.Lett., doi:10.1029/2012GL052094 ; http://www.agu.org/pubs/crossref/pip/2012GL052094.shtml

[28] http://www.kaltesonne.de/?p=4803 ; 23. Juli 2012

[29] DER SPIEGEL, 21.11.2011, Die Krux mit der Katastrophe, S. 156-158 ;

http://www.spiegel.de/spiegel/print/d-81933589.html

[30] Leipziger Volkszeitung, 10. Juni 2011; Verdunstung ebbt ab – Wissenschaftler analysieren globalen Wasserkreislauf und stoßen auf überraschenden Trend.

[31] http://www.bgc-jena.mpg.de/ ; div. Publ. zu Fluxnet

[32] http://www.icecap.us/ Sep 14, 2010: Roy W. Spencer, Ph. D.: Five Reasons Why Water Vapor Feedback Might Not Be Positive

[33] Kraus, H. u. Ebel, U.: Risiko Wetter, Springer-Verlag, (2007)

[34] in: Marc Morano, Communications Director, Senate Environment and Public Works Committee (EPW) ; Inhofe Staff, Rundschreiben 02.05.2008

[35] W.Cunningham: In Science, Ignorance is not Bliss, Launch Magazin Online ;

http://waltercunningham.com/Ignorance.html

[36] http://www.eike-klima-energie.eu/climategate-anzeige/die-klimasensitivitaet-von-co2/ 22.07.2010 ; u n d

http://www.eike-klima-energie.eu/climategate-anzeige/rueckkopplung-im-klimasystem-der-erde/ 10.08.2010

[37] Evidence for Negative Water Feedback Posted on May 23, 2012 by Clive Best ; deutsch: http://www.eike-klima-energie.eu/news-cache/neue-studie-wasserdampf-rueckkopplung-ist-stark-negativ/ ; 03.06.2012

[38] in: VDI Nachrichten, 18. September 2009, Nr. 38, swe

[39] Prof. Richard Lindzen, Bild der Wissenschaft, 11/1993, S.73

[40] DER SPIEGEL, 11/2007, S.56

ckgang der

ckgang der