Doch was hat es damit auf sich? Einige Fakten:

♦ Methan im Wasser ist normal! Methan ist ein typisches Endprodukt des anaeroben Stoffwechsels und in tieferen Erdschichten, dort, wo auch das Grundwasser ist, gibt es keinen Sauerstoff und anaerobe Bakterien haben beste Lebensbedingungen. Auch In Deutschland gibt es Wasserwerke, die ihr Trinkwasser entgasen müssen, damit es nicht brennt. (Methan in der Trinkwasseraufbereitung)

Hausbrunnen in der US-Provinz haben aber keinen Entgaser…

♦ Es hat sich längst herausgestellt, dass das Phänomen der brennenden Wasserhähne schon auftrat, bevor in der Gegend gefrackt wurde. Bereits 1976 veröffentlichte die Wasserbehörde von Colorado eine Meldung, die von ‘Troublesome amounts of … methane”, sprach, lange, bevor zum ersten mal gefrackt wurde.

♦ Die Behörden konnten mit Isotopen- und Spurengasanalysen nachweisen, dass das Methan aus dem Wasserhahnnicht mit dem Methan aus den Frack-Bohrungen übereinstimmt, sondern vielmehr aus oberflächennahen Kohleflözen stammt, die der Brunnenschacht durchbohrt. Kohle aber ist immer mit ‘Grubengas’ (Methan) vergesellschaftet. Im Bergbau ist das Methan deshalb gefürchtet, denn es verursacht, wenn man nicht aufpasst, die gefährlichen ‘Schlagwetter’-Explosionen.

Die ‘State of Colorado Oil and Gas Conservation Comission’ COGCC hat dazu diesen vernichtenden Kommentar zu ‘Gasland’ veröffentlicht *

♦ …und es gibt ein sehr plausibles Motiv, warum die Bewohner behaupten, das Gas stünde im Zusammenhang mit dem Fracking. Die USA sind das Land der Schadensersatzklagen, wo ein Becher heisser Kaffee, über das Bein geschüttet, einen Kunden zum Millionär machen kann, weil auf dem Becher keine Warnung stand, dass Kaffee möglicherweise heiß sein könnte. Diese Leute haben schlicht und einfach versucht, die Bohrgesellschaft mit einer Lüge zu erpressen!

Schon Jahrzehnte vor dem ersten Frack bekannt: Brennende Wasserhähne. Wieso haben Grüne etwas dagegen, wenn man mit dem Wasser auch heizen kann?

Eine der besten Quellen zu Lüge und Wahrheit ist der Report’Debunking GasLand‘ der IPAA (Independent Petroleum Association of America). Gewiss ist das ein Industrieverband, aber Wahrheit bleibt Wahrheit, egal, wer sie sagt. Dass es die Wahrheit ist, sieht man an nihts deutlicher als an den Angriffen gegen den Report, denn die beschränken sich ausschliesslich auf Vorwürfe des ‘Lobbying’ also auf die ad hominem-Attacke; in heutiger Zeit ist das ein echtes Qualitätsmerkmal, ein klares Eingeständnis,dass der Report in der Sache richtig ist.

In Gasland behauptet der Macher Josh Fox:

(6:05) “Ich wusste nicht, dass das Energiegesetz von 2005, vob Dick Cheney durch den Kongress gepusht, die Öl- und Gasindustrie von den Gesetzen Clean Water Act, tClean Air Act, Safe Drinking Water Act, dem Superfund law und noch ungefähr einem Dutzend anderer demokratischer Umweltschutzgesetze befreit.”

Tatsächlich ist die Öl- und Gasindustrie von keinem dieser Gesetze befreit. Das Gesetz wurde auch nicht vom Republikaner Cheney ‘gepusht’, sondern sogar von 75 oppositionellen Demokraten unterstützt.

(32:34) “Die energy task force und 100 Millionen $ Lobby-Gelder waren entscheidend für die Einführung des ‘Halliburton-Schlupflochs’ im Energiegesetz, das Öl- und Gasgesellschaften erlaubt gefährliche Substanzen unkontrolliert direkt in oder unmittelbar neben Trinkwasserquellen zu pressen.”

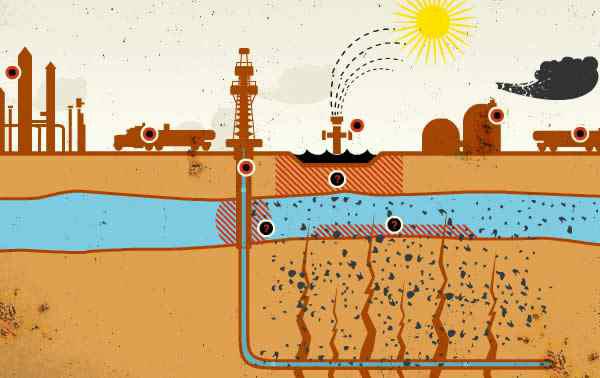

Selbstverständlich ist das ein glatte Lüge. Zwischen der Einpresstelle und dem Trinkwasser liegen tausende Meter solider Fels.

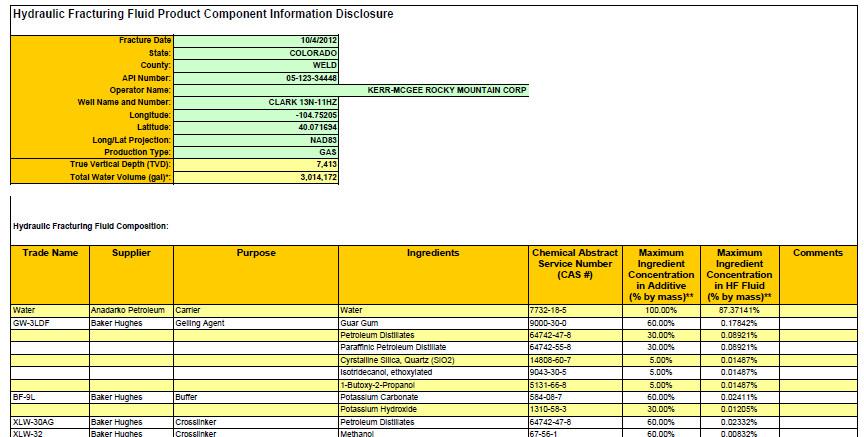

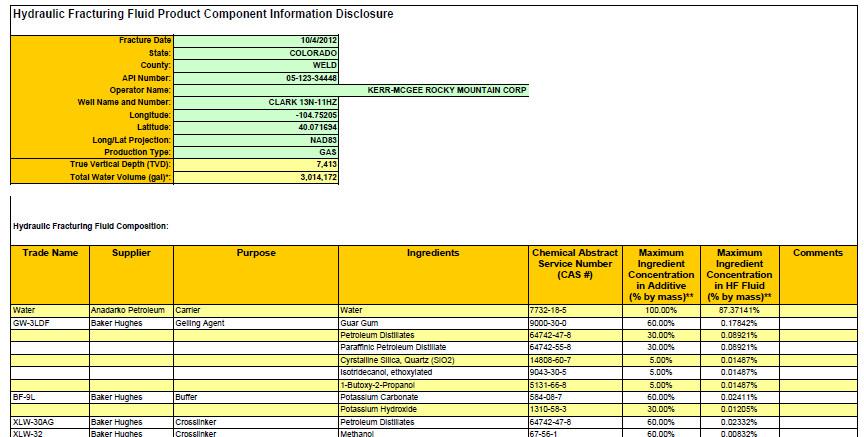

(1:00:56) “Weil Fracking-Chemikalien ‘Betriebsgeheimnisse’ sind, wissen wir nur dank Untersuchungen eines Umweltschützers, was denn da drin ist”

Natürlich sind den Behörden und öffentlichen Stellen alle Chemikalien und Rezepturen genau bekannt und können auf vielen öffentlichen Webseiten von jedermann eingesehen werden:

Solche Datenblätter gibt es für JEDE Frack-Bohrung, sie können bei http://www.fracfocusdata.org/fracfocusfind/ abgefragt werden.

Die bisher in Deutschland verwendeten Fracking-Fluide sind übrigens nicht einmal als ‘Gefahrgut’ oder ‘Umweltgefährdend’ eingestuft. Würde ein Tanklastzug mit dem Zeug an Bord einen Unfall haben, würde die Feuerwehr das Zeug einfach in den Straßengraben spülen, so harmlos ist das: Frack-Technologie bei RWE.

Ja, und so geht das weiter, Lüge auf Lüge,

♦ Von Gasbohrungen, die angeblich geschützten Antilopen den Zugweg versperren (Es gab und gibt die Art dort gar nicht),

♦ Von Trinkwasser-Untersuchungen der EPA, die angeblich durch (gekaufte) Politiker verhindert wurde (Die EPA hat das Wasser untersucht und fand keinerlei Hinweise auf eine Verunreinigung durch Fracking),

♦ Einem Fischsterben, das angeblich durch Fracking-Abwässer verursacht wurde (Ursache war einen Algenblüte, die durch Abwässer einer KOHLENGRUBE ausgelöst wurde)

…und so weiter, und so weiter. Praktisch JEDE Behauptung in diesem Film ist erlogen und zuverlässig widerlegt.

So beschreibt ‘Gasland’ die Gefahr, dass durch das Fracking Gefahrstoffe im Fluid ins Grundwasser gelangen könnten.

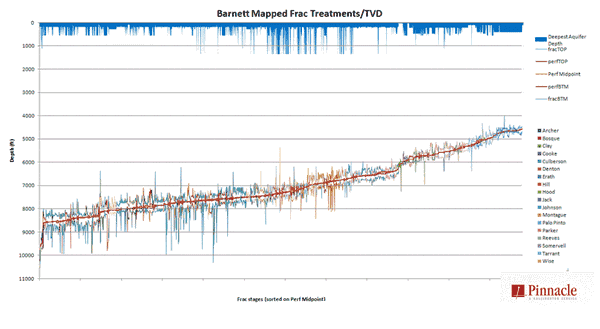

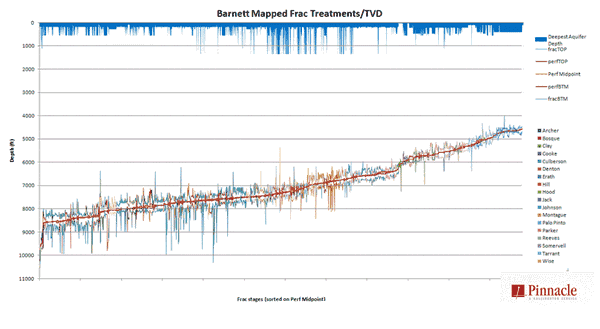

…und so verhalten sich Rißtiefe und Abstand zum Grundwasser tatsächlich, gemessen in Barnett Feld, dem ältesten Fracking-Gebiet: Über tausend Meter solider Fels trennen selbst die tiefsten Brunnen von den Fracking-Spalten. ( http://fracfocus.org/hydraulic-fracturing-how-it-works/hydraulic-fracturing-process ) FracFocus ( http://fracfocus.org/ ) ist übrigens für Englischkundige sehr lesenswert.

Fracking und die EPA

Entgegen dem gründeutschen Hochmut, der ‘Vorreiter’ in Umweltschutzbelangen zu sein, sind wir nur Nachzügler und Plagiatoren.

Die US Environmental Protection Agency (EPA) ist die Mutter der Umweltschutzbehörden. Schon in den 1950er Jahren gab es erste Besorgnisse wegen zunehmender Umweltschäden und 1970 (16 Jahre vor dem deutschen Umweltministerium und 10 Jahre vor Gründung der Partei ‘Die Grünen’) wurde die EPA als Bundesbehörde gegründet und seit 1982 hat sie ein eigenes Ermittlungsbüro, das Office of Criminal Enforcement, Forensics and Training (OCEFT). Seit 1988 haben deren Beamte volle Polizeibefugnisse; davon wagt unser Umweltminister nicht einmal zu träumen.

Insgesamt beschäftigt die EPA 17.000 Mitarbeiter (Das deutsche Bundesumweltministerium nur 814) und hat aktuell ein Budget von 8,7 Milliarden US$ jährlich. Meilensteine, wie die Katalysatorpflicht für KFZ (1975, in Deutschland erst 1984) oder das erste umfassende Umweltschutzgesetz der Welt, der National Environmental Policy Act (1969, in Deutschland erst 1983) kamen aus den USA.

Das Hauptquartier der EPA in Washington DC.

Es ist bemerkenswert, wie diese mächtige Behörde in Deutschland heruntergespielt wird: Im englischen Wiki hat die Druckversion einen Umfang von16 Seiten, in der deutschen nur 4, wobei der erste Untertitel ‘Kritik’ lautet. Die umfangreichen Verdienste werden dagegen mit keinem Wort erwähnt.

Wie kann man glauben, dass so eine mächtige Behörde tatenlos zusehen würde, wie Fracking angeblich das Grundwasser verseuchen würde?

Weil die EPA etwa Angst vor den ‘Konzernen’ hätte? Die EPA hat Big Tobacco nicht nur mit Mut, sondern sogar mit Haß angegriffen und praktisch ruiniert. Sie hatte keine Angst vor General Motors und vor Exxon.

Und sie hat einen sehr klaren Standpunkt zum Fracking:

Erdgas ist eine Schlüsselkomponente für unsere nationale ‘Saubere Energie’-Zukunft. Die USA haben enorme Erdgasreserven die durch Fortschritte beim Horizontalbohren und hydraulischen Fracken marktwirtschaftlich aus Shalegas-Vorkommen gefördert werden können. Der verantwortliche Ausbau der amerikanischen Shalegas-Ressourcen ist von großer Nützlichkeit auf den Gebieten der Wirtschaft, der Versorgungssicherheit und des Umweltschutzes.

Das ist die richtige Einstellung! Wer sagt denn, dass ‘Konzerne’ und Umweltschutz unverträglich sein müssen, wie es in Deutschland schon fester Bestandteil des Öko-Katechismus ist?

Derzeit arbeitet die EPA an einer groß angelegten Studie über den Einfluss des Frackens auf das Trinkwasser. Selbstverständlich gibt es dazu auch umfassende Vorschriften, die im ‘Underground Injection Control Program’ (Kontrollprogramm für die unterirdische Injektion/Verpressung) niedergelegt sind. Es kann überhaupt keine rede davon sein,dass da unkontrolliert gefrackt wird, womöglich gar mit irgendwelchen ‘geheimen’ Zusätzen, wie mancher hier in Deutschland behauptet! Die EPA-Agenten (Mit Polizeibefugnissen ausgestattet!) sind über alles informiert und vor Ort.

Die grösste Besorgnis der EPA ist offensichtlich der Zusatz von Dieseltreibstoff zu den Frack-Fluiden. Aber wer eine Gasquelle anbohrt,hat sowieso eine Menge höhermolekulare Kohlenwasserstoffe als Zugabe,die vom Gasstrom mit nach oben gerissen werden, ein paar Liter Diesel spielen da kaum eine Rolle. Wenn sich die EPA also ausgerechnet darum besonders kümmert, hat sie offensichtlich keine grösseren Sorgen und das ist sehr beruhigend.

Fazit:

Die EPA Ist zuversichtlich, dass Fracking keine Gefahren heraufbeschwört, die über das übliche Maß bei solchen technischen Prozessen hinaus gehen. Bisher gibt es keinerlei Erkenntnisse darüber, dass Grund- oder Trinkwasser großflächige gefährliche oder langfristige Schäden genommen hätten. Allen Verdachtsfällen wird jedoch akribisch nachgegangen. Eine Stellungnahme der EPA-Direktorin Lisa Jackson vor einem parlamentarischen Untersuchungsausschuß 2011:

“I am not aware of any proven case where the fracking process itself affected water.”

“Mir ist kein einziger bewiesener Fall bekannt, bei dem der Fracking-Prozess die Wasserqualität beeinflusst hätte”

Wie viel Gas steckt im Boden?

Die EIA (US Energy Information Administration) hat in einem Report vom Juli 2011 abgeschätzt, wie viel Shalegas und Shaleöl derzeit förderwürdig ist (Das heisst, die zum jetzigen Zeitpunkr bekannten, mit den jetzigen technischen Mitteln erreichbaren und zu derzeitigen Marktpreisen abbauwürdigen Vorhaben): Review of Emerging Resources: U.S. Shale Gas and Shale Oil Plays. Daraus einige Kernpunkte:

Die Shalegas-Produktion im grossen Maßstan setzte erst ein, als die Mitchell Energy and Development Corporation zwischen den 1980er und 1990er Jahren experimentell damit begann die tiefe Shalegaserschliessung im Barnett-Feld in Texas kommerziell zu realisieren. Nachdem der Erfolg der Mitchell Energy and Development Corporation offensichtlich wurde, nahmen weitere Gesellschaften aggressiv am Markt teil, so dass im Jahr 2005 allein das Barnett-Feld jährlich 0,5 Billionen Kubikfuß Erdgas pro Jahr hergab. [ Das sind 15 Milliarden m3. Deutschland fördert pro Jahr 20 Milliarden m3 und verbraucht 100 Milliarden m3] Als die Produzenten die Zuversicht gewonnen hatten, dass sie im Barnett-Feld profitabel arbeiten konnten, was durch Ergebnisse beim Fayetteville-Feld in Arkansas bestätigt wurde, erschlossen sie weitere Felder, einschliesslich Haynesville, Marcellus, Woodfort, Eagle Ford, und anderen.

Obwohl die U.S. Energy Information Administration’s (EIA) in ihrem Nationalen Energiemodell in den Mitt-1990ern begann, die Shalegasresourcen zu berücksichtigen. wurde Shalegas erst in den letzten 5 Jahren als ‘game changer’ für den US Gasmarkt wahrgenommen. Die Ausweitung der Förderung hat die ‘trockene’ Shalegas-Produktion* in den Vereinigten Staaten von 1 Billion Kubikfuß in 2006 auf 4,8 Billionen Kubikfuß oder 23% der gesamten US-Erdgasproduktion in 2010 gesteigert. [Das sind 144 Milliarden m3 oder etwa das 1,5-fache des gesamten deutschen Gasverbrauchs.].

In dem Bericht ist eine umfangreiche Tabelle der derzeitigen Reserven enthalten. Sie werden auf 750 Billionen Kubikfuß geschätzt. Das sind 22,5 Billionen m3 oder genug, um den gesamten Gasverbrauch der USA für 30 Jahre oder den Deutschlands für 225 Jahre zu decken.

Das sind aber, wohlgemerkt, die jetzt vorhandenen Reserven. Selbstverständlich ist das nicht die förderbare Gesamtmenge, die liegt nämlich sehr viel höher – Keine Gesellschaft exploriert noch neue Felder, wenn ohnehin genug Gas für die nächsten Jahrzehnte bekannt ist, das kennen wir ja auch vom Öl.

Vor diesem Hintergrund muss auch die Aussage gesehen werden, dass unter deutschem Boden Reserven für vermutlich 15 Jahre des deutschen Gesamt-Gasverbrauchs liegen. Das ist immer nur die Spitze des Eisbergs.

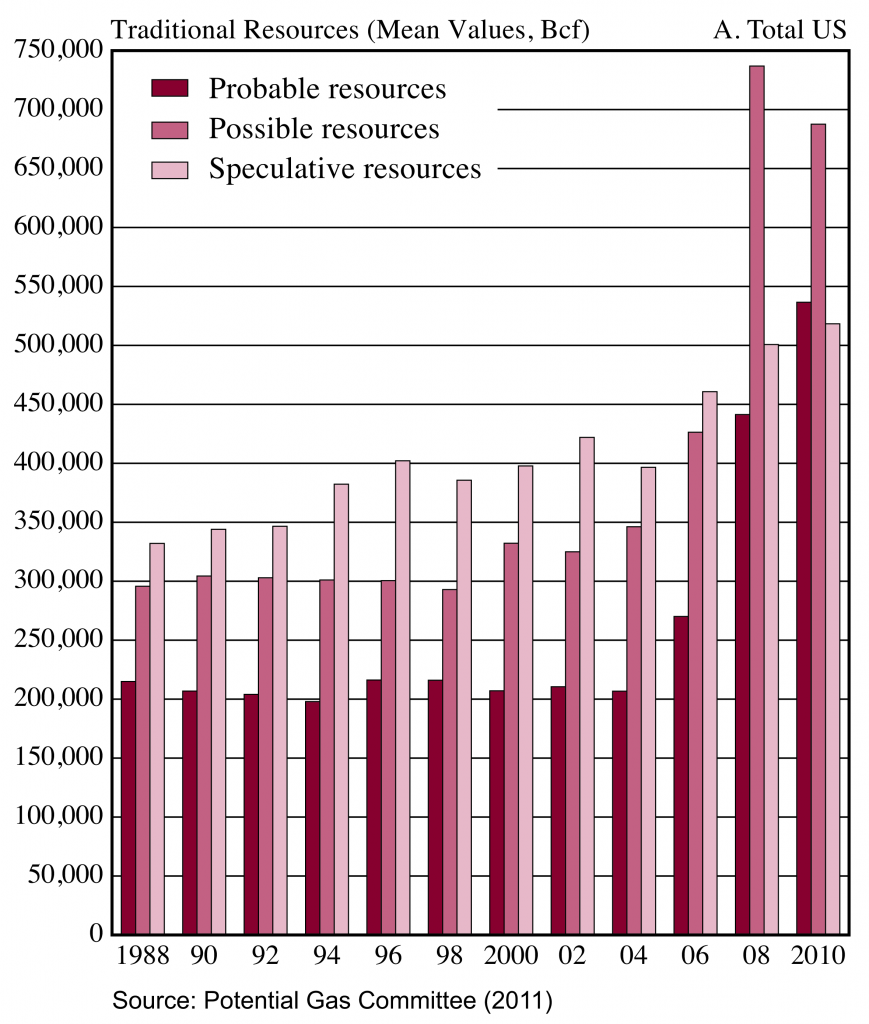

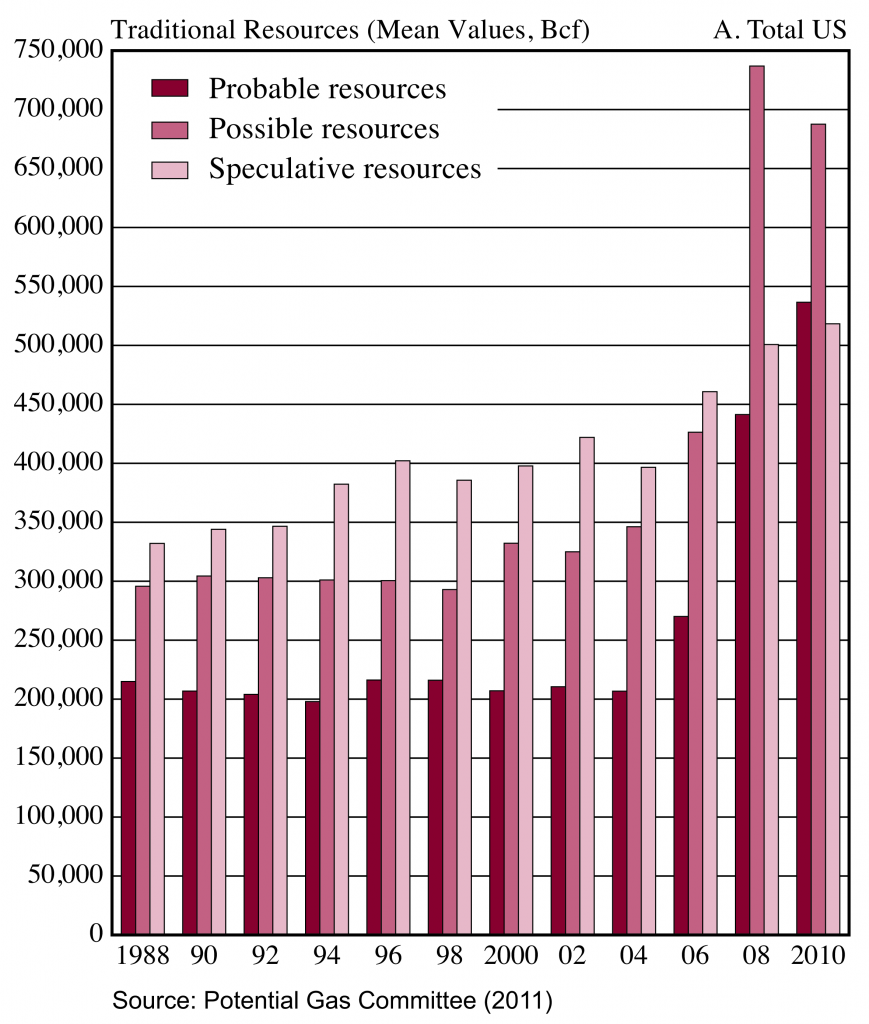

Das Potential Gas Comittee, das mit Fachleuten (keinen ‘Experten’) aus der Petroleumindustrie besetzt ist, widmet sich besonders dieser Frage. Das Komitee schätzt derzeit die Gesamtressourcen auf 1.898 Billionen Kubikfuß, das wäre genug, um die USA 80 Jahre lang vollständig zu versorgen.

Aber auch das ist, wohlgemerkt, eine unvollständige Schätzung, basierend auf heutigen Kenntnissen und dem heutigen Stand der Technik.

Doch meiner Ansicht nach wird das Methaneis aus dem Meer längst der nächste ‘game changer’ sein, bevor das Ende des Shalegas auch nur abzusehen ist.

Und zum Schluß:

…ein Beispiel, wie absurd und auf welchem Niveau selbsternannte Umweltschützer und ‘Experten’ gegen Fracking ‘argumentieren’. Einige Forenbeiträge aus Deutschland:

…Dabei ist es vollkommen gleichgültig ob und wieviel Uran 234, 236 und 238, Cobald, Cäsium, Arsen und tausend andere Giftstoffe der Quarzsand enthält,…

—

Wenn Quarzsand so ungefährlich wäre, wieso gibt es bei den Herstellern folgende Hinweise zu finden

Das starke und/oder längere Einatmen von alveolengängigem Quarzfeinstaub kann zu Staublunge führen; auch als Silikose bekannt. Das Lungenkrebsrisiko ist bei Silikose-Erkrankten erhöht. Die Staubexposition muß gemessen und überwacht werden.

—

Die benötigte Menge an Quarzsand ist gewaltig und beim umladen gelangt eine erhebliche Menge in die Umwelt und damit in die Luft, die wir und unsere Kinder atmen. Und wer es nicht wusste, feiner Quarzsand ist hochgradig Krebseregend wenn er eingeatmet wird! Hochgradig!

…Ja, deshalb stellen wir ja Buddelkisten voller Quarzsand auf die Kinderspielplätze.

———————————————-

* Eine Übersetzung der wichtigsten Absätze:

Biogenes Methan entsteht bei der Zersetzung von organischem Material durch Fäulnis, wie es allgemein in Sümpfen beobachtet wird, oder durch chemische Reduktion von Kohlendioxid. Dieses Methan findet man in einigen flachen wasserführenden geologischen Schichten, die manchmal durch Trinkwasserbrunnen erschlossen werden.

Thermogenes Methan entsteht bei der thermischen Zersetzung von organischem Material. Man findet es in Gesteinen tief in der Erde und es tritt auf, wenn nach Öl oder Gas gebohrt oder gefrackt wird.

…

Durch die Untersuchung von hunderten Gasproben aus Colorado während vieler Jahre kann die COGCC zwischen biogenem und thermogenem Methan aufgrund von Isotopen- und chemischen Analysen unterscheiden.

…

Wie wir zeigen werden, wird im Film ‘Gasland’ in mehreren Fällen fälschlicherweise behauptet, dass Trinkwasserverunreinigungen durch die Öl-und Gas-Bohrungen entstanden sein sollen, während unsere Untersuchungen ergaben, dass dass die fraglichen Brunnen biogenes Methan enthalten, das nicht von solchen Bohrungen stammen kann….

Die zusammenfassende Stellungnahme des COGCC:

Als Antwort auf Befürchtungen bezüglich des Auftretens von Methan in Trinkwasserbrunnen im im Laramie/Fox Hills Aquifer, wurden von uns 28 Brunnen auf einer Fläche von etwa 170 Quadratmeilen untersucht. Es zeigte sich, dass diese Brunnen entweder kein Methan enthalten oder dass das Methan biogenen Ursprungs ist. Keiner der Brunnen (Mit Ausnahme des Ellsworth-Brunnens, der eine Mischung aus biogenem und thermogenem Methan enthielt) enthielt thermogenes Methan.

** ‘Trockenes’ Erdgas ist reines Methan. ‘Nasses’ Erdgas enthält zusätzlich höhermolekulare Anteile wie Ethan und Propan. Das Marcellus Feld, derzeit das mit Abstand grösste, ist sehr ‘nass’, es enthält bis zu 16% Ethan. Ethan ist der Ausgangsstoff für den Kunststoff Polyethylen (PE). Das führte in den USA wegen des besonders billigen Gases bereits zu einem ‘rauschartigen’ Boom der Kunststoffproduktion.

Ein bemerkenswertes Dokument, das ich nur wegen seiner Länge nicht nutzte, verdient dennoch Erwähnung:

STATE REGULATORS ON HYDRAULIC FRACTURING

Stellungnahmen staatlicher Behörden zum hydraulischen Fracken

Alaska Oil and Gas Conservation Commission:

“There have been no verified cases of harm to ground water in the State of Alaska as a result of hydraulic fracturing”

Es gibt keine nachgewiesenen Fälle der Schädigung von Grundwasser im Staat Alaska durch Fracking.

Colorado Oil and Gas Conservation Commission:

“There has been no verified instance of harm to groundwater caused by hydraulic fracturing”

Es gibt keinen bewiesenen Fall einer Grundwasserschädigung durch Fracking.

Indiana Dept. of Natural Resources:

“There have been no instances where the Division of Oil and Gas has verified that harm to groundwater has ever been found to be the result of hydraulic fracturing”

Die Abteilung Öl und Gas konnte in keinem Fall nachweisen, dass es jemals zu einer Schädigung des Grundwassers durch Fracking kam.

Louisiana Dept. of Natural Resources:

We are unaware of any instance of harm to groundwater in the State of Louisiana caused by the practice of hydraulic fracturing

Uns ist kein einziger Fall bekannt, bei dem im Staat Louisiana eine Schädigung des Grundwassers durch Fracking verursacht wurde.

Michigan Dept. of Environmental Quality:

“There is no indication that hydraulic fracturing has ever caused damage to ground water”

Es gibt keinen Hinweis darauf, dass Fracking jemals Schaden am Grundwasser verursacht hätte

Oklahoma Corporation Commission:

“We have no documentation of such an instance”

Uns ist kein solcher Fall bekannt

Railroad Commission of Texas: [Die ‚Eisenbahn-Komission‘ ist in Texas aus historischen Gründen für die Überwachung von Öl- und Gasbohrungen zuständig]

“Though hydraulic fracturing has been used for over 60 years in Texas, our Railroad Commission records do not reflect a single documented surface or groundwater contamination case associated with hydraulic fracturing”

Obwohl Fracking in Texas seit über 60 Jahren angewendet wird, ist uns keine einzige dokumentierte Oberflächen- oder Grundwasserkontamination bekannt, die mit Fracking in Verbindung steht.

South Dakota Dept. of Environment and Natural Resource:

“In the 41 years that I have supervised oil and gas exploration, production and development in South Dakota, no documented case of water well or aquifer damage by the fracking of oil or gas wells, has been brought to my attention. Nor am I aware of any such cases before my time”

In den 41 Jahren in denen ich die Öl- und Gasexploration, -Produktion und -Entwicklung in South Dakota überwachte, wurde mir kein dokumentierter Fall einer Trinkwasserbrunnen- oder Aquiferschädigung durch das Fracken in Öl- oder Gasbohrungen bekannt und es ist mir auch kein einziger Fall bekannt, der vor meiner Amtszeit läge

Wyoming Oil and Gas Conservation Commission:

“No documented cases of groundwater contamination from fracture stimulations”

…kein dokumentierter Fall einer Grundwasserkontamination durch Fracking

Gleichartige Stellungnahmen von Behörden füllen noch mehrere Seiten dieses Dokuments, alle Quellen sind belegt.

Autor Tritium, zuerst erschienen bei Science Sceptical

Ergänzende Informationen:

In den USA erscheint im April 2013 der neue Film vom „Gasland“ Produzenten Josh Fox unter dem Titel: „Gasland II“

„Fracknation“ der neue Film der Gruppe um den Filmemacher Phelim McAleer ist fertig und kann hier erworben werden. Konsequent werden darin die Lügen und Verdrehungen des Films Gasland entlarvt und Zeugen direkt vor Ort befragt. Auch Josh Fox sollte mehrfach befragt werden, wich aber konsequent jeder Antwort aus. Sehen Sie hier den Trailer:

Trailer zum Film „Fracknation“ von Phelim MacAlleer