Bild rechts: CHRISTOPH MORLINGHAUS

Auf der Wasseroberfläche des gemächlich dahin fließenden Kern River, wenig nördlich der Stadt Bakersfield, sind James Elwood schon 1899 Ölflecken aufgefallen. Der Staat befand sich damals mitten in einem Ölboom, und Elwood wollte daran teilhaben. Er aktivierte ein paar Bekannte, besorgte sich ein paar Hacken und Schaufeln, wählte einen sonnengetrockneten Flecken Erde neben den Sickerstellen am Fluss und begann zu graben.

Nach Erreichen von etwa 12 m Tiefe benutzten sie einen Bohrer und kamen einige weitere Dutzend Fuß [ca. 10 m?] hinab. In den Poren des Gesteins Jahrmillionen lang eingeschlossenes Öl begann, in das Bohrloch zu sickern.

Das Ereignis eroberte die Titelseite der Lokalzeitung und brachte andere Prospektoren dazu, zum Kern River zu eilen. Innerhalb eines Jahres wurden 130 Bohrlöcher niedergebracht. Die Bohrer pumpten den schwarzen Dreck an die Oberfläche, wo es barrelweise mit Mauleselskarren abtransportiert wurde. Bis zum Jahr 1904 flossen mehr als 47000 Barrel pro Tag, was fast die gesamte Produktion des Staates Texas ausmachte.

Öl vom Kern River ist besonders dick und zähflüssig mit einer Viskose wie Molasse. Es fließt also nicht einfach. Analysten jener Zeit sagten voraus, dass man wegen dieser Schwierigkeiten bei der Förderung nicht mehr als 10% des gesamten Vorrats fördern könne. Anfang der vierziger Jahre hatten Ölmänner 278 Millionen Barrel aus dem Feld geholt, aber die Produktion war stark rückläufig; das meiste des leicht zugänglichen Öls war weg. Das Kern River-Feld schien dicht davor, effektiv ausgebeutet zu sein.

Abbildung: Pferdekopfpumpen [?] im Kern River-Ölfeld, aus dem fossile Treibstoffe seit über einem Jahrhundert extrahiert werden. (PHOTO: CHRISTOPH MORLINGHAUS)

In den fünfziger Jahren jedoch haben viele der dort aktiven Ölgesellschaften neue Methoden ausprobiert. Sie begannen, „Bottom-Hole-Heaters“ in die Bohrlöcher hinab zu lassen. Mit ihnen kann man mittels heißem Wasser oder Strom das Öl erwärmen, so dass es leichter fließt. Einige Jahre später haben Ingenieure entdeckt, wie man Dampf in den Untergrund bringen kann. Die Ergebnisse waren spektakulär. Innerhalb weniger Jahre produzierte das Kern River-Feld mehr Öl als jemals zuvor. Bis zum Jahr 2007 wuchs es auf einen Vorrat von etwa 2 Milliarden Barrel, was es zu einem der größten Ölfelder in der amerikanischen Geschichte machte.

Die Geschichte von Kern River spiegelt unsere gesamte Erfahrung bei der Geschichte mit dem Öl: Jedes Mal, wenn wir denken, dass es ausgebeutet sei, kommen neue Technologien auf, die uns immer mehr finden lassen. Die weit um sich greifende Furcht von vor einigen Jahren, dass wir uns „Peak Oil“ nähern, hat sich als vollkommen falsch herausgestellt. Von der Arktis bis nach Afrika haben nanotechnologisch aufbereitete Materialien, Unterwasserroboter, 3-D-Sonargeräte, speziell aufbereitete Schmiermittel und Myriaden anderer Fortschritte titanisch große neue Vorräte fossiler Treibstoffe erschlossen, viele davon an unerwarteten Stellen – Brasilien, Australien und – vielleicht am wichtigsten – Nordamerika. „Im Gegensatz zu dem, was die meisten Menschen glauben“, heißt es in einer vor Kurzem erschienenen Studie von der Harvard Kennedy School, „wächst die Kapazität der Vorräte auf so unerwartete Weise, dass es den Verbrauch überflügeln könnte“.

Seit Jahrhunderten bestimmte die sich stets neu zeichnende Landkarte der Gebiete, aus denen die Energie stammt, vieles von dem Charakter unserer Welt. Als die Menschen Walöl für die Beleuchtung ihrer Wohnungen verbrannten, wurde Nantucket zum blühenden Handelszentrum. Kohle sorgte für den Aufstieg von Orten wie Newcastle upon Tyne in UK und Centralia in Pennsylvania – und sorgte für die industrielle und geographische Expansion der USA. Öl half, die Staaten Texas und Kalifornien zu bilden. Seitdem haben fossile Treibstoffe die Entwicklung der Länder auf der ganzen Welt verändert, vor allem im Nahen Osten.

Derzeit wird die Karte, wer Öl und Erdgas verkauft und wer es kauft, radikal umgezeichnet. Noch vor wenigen Jahren machte importiertes Öl fast zwei Drittel des nationalen Verbrauchs in den USA aus; jetzt ist es weniger als die Hälfte. Man erwartet, dass die USA innerhalb einer Dekade Saudi-Arabien und Russland überholen und ihren Titel als der Welt größter Energieerzeuger zurück gewinnen. Länder, die nie über eine erwähnenswerte Energieindustrie verfügt hatten, stehen an der Schwelle, wesentliche Mitspieler zu werden, während etablierte Riesen fossiler Treibstoffe ihre Dominanz in Gefahr sehen. Wir werden Zeuge einer Verschiebung, die wesentliche neue Möglichkeiten – und Gefahren – für individuelle Nationen, die internationale Politik und Wirtschaft sowie den Planeten bereit hält.

Öl ist vielleicht das einzige Produkt, das auf die eine oder andere Weise von nahezu jedermann auf der Welt verwendet wird. Wir sind von ihm weit über unseren Benzinbedarf hinaus abhängig. Öl und Erdgas sind die Rohstoffe für Asphalt, Plastik sowie Chemikalien und Dünger, ohne die die moderne Landwirtschaft kollabieren würde. Wer sagt, dass wir „abhängig“ vom Öl sind in einem Tonfall, als sei das eine schlechte Angewohnheit, die wir bei gutem Willen abstellen könnten, untertreibt den Grad unserer Abhängigkeit gewaltig. Kurz gesagt: Kein Petroleum, keine moderne Zivilisation.

Da ist es keine große Überraschung, dass wir uns praktisch, seitdem wir begonnen haben, das Zeug zu nutzen, Sorgen über die Erschöpfung dieser Stoffe machen. Im Jahr 1922 hat eine regierungsamtliche Kommission vorhergesagt, dass „die Ölerzeugung mit der gegenwärtigen Rate nicht lange aufrecht erhalten werden kann“. Im Jahr 1977 erklärte Präsident Jimmy Carter, dass die Ölerzeugung 1985 ihren Höhepunkt erreichen werde.

Allerdings stellt sich immer mehr heraus, dass das Problem niemals die Menge der Vorräte war, sondern dass es unsere Möglichkeiten waren, diese Vorräte profitabel auszubeuten. Wir Menschen haben während unserer gesamten Geschichte etwa eine Billion Barrel Öl verbraucht. Der Geological Service der USA schätzt, dass immer noch sieben bis acht mal so viel in der Erde steckt. Das verbleibende Öl ist lediglich schwieriger erreichbar und damit teurer. Aber das bringt die unsichtbare Hand des Marktes ins Spiel. Jedes Mal, wenn es für die bekannten Reserven ernst zu werden scheint, steigen die Preise, was wiederum der Auslöser für neue Investitionen in Forschung und Entwicklung ist. Das führt zu raffinierten Technologien, die neue Vorräte erschließen – oftmals an Orten, an denen wir zuvor kaum daran gedacht haben, dort zu suchen.

Auf der riesigen Betonfläche der Schiffswerft in Angra dos Reis in Brasilien fahren Arbeiter auf Fahrrädern durch die Lagerhäuser sowie zwischen den Kränen und Maschinenschuppen umher. Eine 18 Stockwerke hohe, helle gelbe Verladebrücke, leuchtend vor einem bleiern grauen Himmel, gleitet an Stahlgleisen entlang. Die Hügel rings um den Hafen sind wie eine Folie von dichtem grünen Dschungel bedeckt, aber hier unten am Wasser sieht es durch und durch industriell aus, Maschinen arbeiten im unüberschaubar großen Maßstab.

Von einer in den Atlantik hinein ragenden Landebrücke aus klettert Amit Tomar sechs Etagen an einem Gerüst hoch auf das Deck der Cidade de São Paulo, einem rot und schwarz gestrichenen, 1000 Fuß [über 300 m] langen Schiff – groß wie ein umgekippter Wolkenkratzer. An diesem Junitag herrscht dort ein Durcheinander von Arbeitern, die Schrauben festziehen und Rohre verschweißen. Tomar, ein gepflegter Inder mit einem breiten Lächeln und munterem Wesen, ist der zweite Kapitän auf der São Paulo. Die Arbeiter bereiten das Schiff auf etwas vor, das wahrscheinlich seine letzte Mission sein wird.

Die São Paulo stach erstmals 1992 als Öltanker in See – im Grunde ein gigantischer Eimer mit einem hinzu gefügten Motor – und transportierte Rohöl von Hafen zu Hafen. Inzwischen hat die brasilianische nationale Ölgesellschaft Petrobras den Umbau des Schiffes zu einem schwimmenden Industriekraftwerk weitgehend abgeschlossen. Demnächst wird das 1,2 Milliarden Dollar teure Objekt hinausgeschleppt und an einer Stelle etwa 200 Meilen [ca. 320 km] vor der Küste verankert werden. Eine ganze Palette von Rohren an der Seite des Schiffes wird 120000 Barrel Rohöl pro Tag aus einer Tiefe von über 3 Meilen Ozean [fast 5000 m] und unter Felsen und Salz hervor holen.

Abbildung 2: Die schwimmende fossile Treibstoff-Fabrik Cidade de São Paolo auf dem Weg zum Tiefwasser (PHOTO: PETROBRAS NEWS AGENCY)

Ist sie erst einmal verankert, werden Versorgungsschiffe zwei Tage bis zur São Paulo brauchen. Zwischen den Dienstschichten hat die 60 Mann starke Besatzung wenig zu tun außer in ihren spartanischen Unterkünften auszuharren. Außerdem steht ihnen ein fensterloser Raum mit einigen dunklen Ledersofas, ein paar Spielen, einem Fernseher und einer PlayStation3 zur Verfügung.

Tomar hat bis zu 11 Monate auf See unter solchen Bedingungen zugebracht. Dieser Job sollte vergleichsweise einfach sein – sechs Wochen Stress auf dem Schiff und dann sechs Wochen frei. „Auf diese Weise verdienen wir uns eine Fahrkarte der Business-Class, um nach Hause zu fahren“, sagt er. Das ist eine nette Vergünstigung, aber trotzdem immer noch eine ziemlich brutale Pendelzeit. Warum reist er ständig von Indien nach Brasilien und wieder zurück? Tomars Antwort ist klar und direkt: „Wegen des Geldes!“.

Man kann eine Menge davon dieser Tage hier verdienen. Lange Zeit fast bedeutungslos auf dem Welt-Energiemarkt ist Brasilien dabei, zu einem der obersten Erzeuger fossiler Treibstoffe aufzusteigen. Es gibt Milliarden Barrel Öl tief unter seinen Hoheitsgewässern – Öl, das bis vor kurzem gar nicht aufgespürt, geschweige denn zugänglich gemacht werden konnte. Es gibt so viel dort unten, dass der damalige brasilianische Präsident Luiz Inácio Lula da Silva beim ersten Fund ausrief: „Das beweist, dass Gott Brasilianer ist!“.

Falls man durch Funde fossiler Treibstoffe Gottes Staatsbürgerschaft beurteilen kann, dann muss Gott über sehr viele Reisepässe verfügen. Riesige untermeerische Gasfelder wurden in letzter Zeit vor den Küsten von Tansania, Mosambik und anderen verarmten Staaten in Afrika und Südamerika gefunden. Ölgesellschaften schnüffeln von Kuba über die USA bis zum Südchinesischen Meer herum, um noch mehr davon zu finden. Man glaubt, dass sich die Vorräte auf bis zu 200 Milliarden Barrel belaufen.

Ölgesellschaften haben seit Jahrzehnten in Flachwassergebieten gebohrt, aber erst in jüngster Zeit vermochten sie ernsthaft in die Tiefe zu gehen. Im Jahr 1992 gab es im Golf von Mexiko erst eine Bohrung, die tiefer als 5000 Fuß ging [über 1500 m]; im Jahr 2008 waren es 465. Nur drei Jahre nach der Explosion der Deepwater Horizon sind die Bohrungen im Golf in vollem Umfang wieder aufgenommen worden. Von dort stammt fast ein Viertel des Öls für die USA, Tendenz steigend. Rund um die Welt hat sich die Tiefwasser-Ölförderung im vergangenen Jahrzehnt vervierfacht und wirft Millionen von Barrel jeden Tag auf den Markt.

Abbildung 3: Der ehemalige brasilianische Präsident Luiz Inácio Lula da Silva ist glücklich, sich die Hände mit dem neuen Petroleum seines Landes schmutzig zu machen (PHOTO: FELIPE DANA/AP/CORBIS)

Die Auswirkungen von all dem sind in ganz Brasilien erkennbar, aber vielleicht nirgendwo mehr als in Rio des Janeiro. Als wir eine Hochbrücke über die Innenstadt passieren, weist mein Taxifahrer auf ein Palasthotel hin, das gegenwärtig renoviert wird. „Eike!“ sagt er mit einem Grinsen. Das bezog sich auf den Schnellboot-Rennfahrer und ein Playboy-Modell heiratenden Eike Batista. Er hat sich während der letzten paar Jahre von einem halbwegs wohlhabenden Bergbau-Unternehmer zum weltweit an 7. Stelle stehenden reichsten Mann entwickelt, jedenfalls der Forbes-Liste zufolge, und zwar hauptsächlich wegen seiner OGX Petróleo e Gás-Gesellschaft, der größten privaten Ölgesellschaft in Brasilien. Selbst nach einer Reihe jüngster unternehmerischer Rückschläge verfügt er immer noch über ein Vermögen von 13 Milliarden Dollar. Die Renovierung des historischen Hotels Gloria in Rio ist eines seiner Hobby-Projekte.

Am nördlichen Stadtrand von Rio, weit entfernt von den berühmten Stränden der Copacabana, besteht die Landschaft aus Fabriken und Schiffswerften, in denen Männer und Maschinen der Ölindustrie dienend brummen. Gewaltige Bohrplattformen, die zur Reparatur heran geschleppt worden waren, zieren die Küstenlinie. Etwas weiter landeinwärts befindet sich ein flugplatzgroßes Gebäude, das mit seinen gekrümmten Umrissen, den röhrenförmigen Korridoren und dem elfenbeinfarbenem Äußeren aussieht wie eine Mischung aus einer Shopping Mall in Dubai und einer Filmkulisse für Logan’s Run. Das ist das neue, 700 Millionen Dollar teure Hauptquartier von CENPES, dem Forschungszweig von Petrobas. Das Zentrum wurde offiziell im Jahr 2010 eröffnet, jedoch bis auf den heutigen Tag nicht vollständig fertig gestellt. Das oberste Stockwerk, nach allen Seiten offen, um den Wind durchzulassen und freie Sicht auf die Bucht zu gewährleisten, ist für Treffen und Denkpausen in entspannter Atmosphäre gedacht, aber es fehlen immer noch die Möbel. Ist er erst einmal vollendet, wird der Komplex mehr als 100 Laboratorien und etwa 4000 Beschäftigte beherbergen.

Brasilien hat seit den siebziger Jahren Flachwasserbohrungen vor seiner Küsten betrieben. Aber erst im Jahr 2006 sind Erkundungsbohrungen auf die massiven „Presalt“-Reservoire getroffen – benannt nach ihrem Fundort unter einer dicken Salzschicht, die ein verdunsteter prähistorischer Ozean hinterlassen hat.

Petrobas fand die Kohlenwasserstoffe unter dem Presalt dank einer Reihe von Durchbrüchen der seismischen Erkundung. Im Rahmen dieses Prozesses haben Schiffe auf offener See Meilen lange Sensorkabel gezogen, und mit Luftkanonen wurden Schallimpulse ausgesandt. Diese Impulse werden vom Meeresboden reflektiert und treffen auf die Sensorkabel. So entstehen Bilder der verschiedenen Felsschichten in der Tiefe. Jahrelang vermittelte diese Technik nur ein zweidimensionales Bild. Aber in den neunziger Jahren fanden Geophysiker heraus, wie man die Signale aus verschiedenen Winkeln zur gleichen Zeit aussenden konnte. Damit konnten die Ergebnisse in ein dreidimensionales Bild übertragen werden. Während der folgenden Jahrzehnte waren Computer und Software ausgereift genug, um all diese Daten aufzuschlüsseln.

Aber Salz sorgt für zusätzliche Komplikationen. Es verzerrt die rücklaufenden Signale, so dass die Ingenieure bei Petrobras neue Algorithmen zur Kompensation erstellen mussten. Petrobras brauchte mehr als zwei Jahre, um die Informationen der ersten 3D-Seismik-Bilder der Presalt-Felder zu analysieren, um herauszufinden, was dort unten lag.

Inzwischen schätzt die Gesellschaft die Menge der Reserve auf 15 Milliarden Barrel, die in diesem Jahr nur auf diesen Feldern entdeckt worden sind. Die Gesamtmenge unter dem Salz könnte dreimal so hoch sein, eine Reserve, die mit Libyen konkurriert.

Die Verbesserung dieser seismischen Erkundungs-Techniken ist eine der Kernaufgaben von CENPES. Aber das Aufspüren von Öl ist nur die erste Herausforderung. Es nach oben zu bringen ist ebenfalls ein unendlich komplizierter Prozess. Jeder Schritt erfordert intensive Forschung und professionelle Hardware. Wenn man beispielsweise ein tiefes Loch in die Erde bohrt, leistet die Erde Widerstand. Der Weg des Bohrers muss eingefettet werden. Das ausgebohrte Material muss an die Oberfläche befördert werden. Um all das zu bewerkstelligen, stoßen die Bohrer viskose Flüssigkeiten aus, „Mud“ [Schlamm] genannt. Die meisten Muds basieren auf Wasser, aber das kann zum Problem werden, wenn es um Salzeinlagerungen geht: Das umgebende Salz könnte sich im Wasser lösen, so dass das Bohrloch kollabiert. Folglich gibt es bei CENPES ein 20 Personen starkes Team, dass sich nur mit diesem Mud befasst. „Wir sind ständig auf der Suche nach Wegen, um schneller zu bohren“, sagt Rosana Lomba, die freundliche Leiterin des Teams. „Zeit ist Geld – viel Geld“. Die stählernen Arbeitsplatten in ihrem in weiß gehaltenen Laboratorium sind übersät mit Mischmaschinen, die verschiedene Flüssigkeiten austesten und messen. Ihre Mitarbeiter verbringen ihre Tage mit der Optimierung von Formeln – etwas Bariumsulfat hier, um die Dichte zunehmen zu lassen, ein wenig Xanthan-Gummi dort, um die Viskose zu erhöhen – alles, um die optimalen Kombinationen für die bei jedem Bohrloch unterschiedliche geologische Beschaffenheit zu finden.

Das alles ist zu kompliziert und zu teuer, um es von irgendjemandem allein durchführen zu lassen. Auf den meisten Feldern sind Firmenkonsortien zugange. Folgerichtig rollt Brasilien den roten Teppich aus, um Privatunternehmen zu ermutigen, mit Petrobras zusammen zu arbeiten. Nicht weit von der CENPES-Stätte entfernt überwacht die Federal University of Rio de Janeiro einen riesigen neuen Technologie-Park, hauptsächlich eingerichtet zur Energieforschung. In einer Ecke steht das LabOceano, ein 82 Fuß [ca. 25 m] tiefes Hallen-Wasserbecken – der tiefste Ozeansimulator der Welt. Warum so tief? „Weil Brasiliens Öl so tief liegt“, sagt der geschäftsführende Direktor Paulo des Tarso Themistocles Esperança. Die 30 Millionen Dollar teuren Generatoren zur Erzeugung von Wind und Wellen testen, wie sich Boote in Stürmen und Strömungen verhalten, damit sichergestellt ist, dass sie sich nicht von der Ausrüstung am Meeresboden losreißen. Tatsächlich schwimmt auf der Oberfläche des Beckens ein sechs Fuß-Modell eines Produktionsschiffes nach Art der São Paulo. Aber offenbar sind für heute keine Stürme vorhergesagt; stattdessen paddelt ein behelmter Arbeiter in einem Gummiboot heran, der das Modell zwergenhaft wie in einem Omty Python-Cartoon aussehen lässt.

Überall auf dem Gelände wird gebaut und konstruiert. Die größten Ölversorger der Welt – Halliburton, Schlumberger, Baker Hughes – bauen ihren eigenen Forschungszentren. Hier befindet sich die Ausstattung, die die wesentlichen Ölgesellschaften – einschließlich Petrobras – mieten, um die Bohr- und Erzeugungsmaschinerie am Laufen zu halten. Eine der größten ist die in den USA ansässige Firma FMC Technologies, die über eine Fabrik am Stadtrand von Rio verfügt. 1600 Arbeiter fertigen dort an Fließbändern Kontroll-Module und Bohrköpfe. FMC plant, die Fabrik auf ein benachbartes Grundstück auszuweiten und seine Größe zu verdoppeln.

Auch im Technologiepark betreibt FMC eine Einrichtung, so neu, dass man auf den weißen Klinkersteinen des vorgelagerten Parkplatzes noch die Ölreste zählen kann. Im Inneren eines der verwinkelten, modernistischen Gebäude hängt ein sich vom Boden bis zur Decke erstreckendes Foto. Es zeigt nichts als offenen, sonnenbestrahlten Ozean. Unten auf dem Bild prangen die Worte „Our Vision“. „Das gegenwärtige Operations-Schema ist 50 Jahre alt“, sagt Paulo Couto, ein Vizepräsident der Technologie. „Man baut eine schwimmende Stadt in die Mitte des Ozeans, und dann pumpt man Öl hoch genauso wie an Land. Es müssen Energie, Wohnungen, Kanalisation, Nahrung, Hubschrauber und Ausrüstung zur Verfügung stehen. Es ist schwierig und teuer. Hubschrauber stürzen ab. Boote sinken. Es gibt Hurrikane und Unfälle“. Es ist auch ineffizient. Das Rohöl muss bis an die Oberfläche gepumpt werden, und das beigemengte Erdgas, Wasser und Sand müssen separiert und entsorgt werden. FMC möchte all das stattdessen auf dem Meeresboden durchführen. „Unsere Aufgabe ist es, die Stadt am Meeresboden zu errichten“, sagt Couto. Taucher würden in diesen Tiefen keine Minute überleben, daher muss alles von außen gesteuert werden unter Verwendung von Unterwasser-Robotern, um die Ausstattungen zu reparieren. Es klingt waghalsig. Aber gerade im vorigen Jahr hat FMC einen 500 Tonnen schweren Unterwassergenerator zur Trennung von Öl und Wasser installiert, den ersten seiner Art, und zwar über einem der brasilianischen Untersee-Felder. „Wir sind nicht mehr weit entfernt von dieser Vision“, sagt Couto, „vielleicht 15 Jahre“.

Die Ölförderung unter dem Ozean ist natürlich extrem teuer. Nur eine einzige Bohrung kann bis zu 100 Millionen Dollar kosten. Es ist nur sinnvoll, dies in einer Welt zu tun, in der ein Barrel mindestens 50 Dollar einbringt. Bis zum Jahr 2002 waren es gerade mal 20 Dollar.

Aber die Preise sind im vergangenen Jahrzehnt dramatisch gestiegen. Sie lagen während der letzten Jahre im Mittel gut über 80 Dollar pro Barrel. Teils liegt das an der stärker als je steigenden Nachfrage aus den Entwicklungsländern und teils an politischen Faktoren (wie z. B. die Furcht vor ernsten Unruhen infolge der nuklearen Ambitionen Irans im Persischen Golf). Aber der Preisanstieg erfolgt teilweise auch durch eine andere Art Technologie: Computer-Algorithmen, die das Hochfrequenz-Handeln ermöglichen. Er kam weit verbreitet in Mode hinsichtlich der Zukunft von Öl während des vergangenen Jahrzehnts. Kein Geringerer als Rex Tillerson, Chef von ExxonMobil, hat vor dem Kongress im Jahr 2011 gesagt, dass solche Spekulationen der Schlüsselgrund dafür sind, dass die Ölpreise so hoch geblieben sind.

Von der Oberfläche einer Plattform mehrere Etagen über der Prärie von Nord-Dakota dreht ein lärmender, schlammverschmierter 1000-PS-Motor eine Stahlstange so dick wie ein Softball-Schläger in einer endlosen Pirouette. [Softball = eine Vorstufe zum Baseball, oftmals von Kindern im Grundschulalter praktiziert. A. d. Übers.] Die Stange verläuft durch einen 30 Fuß [ca. 9 m] langen Eisenmantel und dann in den Boden. Unter der Erde erstreckt sich die Bohrung etwa zweimal so tief wie die Golden Gate Bridge lang ist.

In einem daneben stehenden Kontrollraum lehnt sich ein beleibter Operator, seinem Helm zufolge namens Chuck, in einem Sessel zurück, der umgeben ist von allen möglichen Monitoren, und überwacht in der Manie eines Spitzen-Videospielers den Bohrprozess. Er erstreckt sich etwa zwei Meilen [ca. 3200 m] senkrecht in die Tiefe und dann eine weitere Meile zur Seite. Er frisst sich jetzt mit einer Geschwindigkeit von 110 Fuß [ca. 33 m] pro Stunde eine zweite Meile weit durch soliden Fels. Das Ziel: Die ganzen Felsen vorzubereiten, um ihn hydraulisch zu brechen – ein unter dem Namen Fracking besser bekannter Prozess.

Fracking ist in der Öffentlichkeit etwa genauso populär wie Kinderspiele, aber es ist in hohem Maße Big Business. Es wird dadurch so viel Erdgas aus Feldern in Texas, Ohio, Pennsylvania und anderswo gefördert, dass der Preis dafür eingebrochen ist, und zwar von über 10 Dollar pro tausend Kubikfuß vor fünf Jahren auf etwa 3,25 Dollar heute.

Mit Fracking kann man auch Öl fördern, was das hauptsächliche Ziel in Nord-Dakota ist. Bis zu 200 neue Bohrungen werden in diesem Staat jeden Monat niedergebracht, um das Bakken-Feld auszubeuten, ein 25 000 Quadratmeilen [ ca. 65000 km²] großer unterirdischer Streifen, der sich bis nach Montana und Kanada erstreckt und Hunderte Milliarden Barrel enthalten kann.

Energieunternehmen wussten schon seit Jahrzehnten, dass Schiefergestein-Formationen wie Bakken riesige Mengen Kohlenwasserstoffe enthalten. Das Problem bestand in deren Förderung. In konventionellen Öl- oder Gaslagerstätten fließen die Kohlenwasserstoff-Moleküle durch Poren im Gestein in ein Loch, etwa so wie Meerwasser in ein Loch im Sand sickert, das man am Strand gräbt. Aber Schieferformationen sind so dicht, dass Öl und Gas darin nicht fließen können.

Die Durchlässigkeit von Felsen wird in einer Einheit mit der Bezeichnung darcy gemessen. Lance Langford, ein untersetzter Texaner, der den Bakken-Aktivitäten des staatlichen norwegischen Unternehmens Statoil vorsteht, sagt mir, dass das typische Gestein, mit dem sich Statoil in seinem Heimatland befasst, eine Durchlässigkeit von 1 darcy aufweist. Statoil gehören inzwischen Hunderte Bohrlöcher in Nord-Dakota. Hier reicht die Durchlässigkeit des Öl enthaltenden Dolomitgesteins im Bakken-Feld bis zu Nanodarcy – buchstäblich Millionen mal weniger durchlässig. „Es ist wie Zement“, sagt Langford. Er zeigt mir eine Probe, einen Zylinder dunkelgrauen Gesteins von der Größe meines Unterarms. Er ist so schwer wie ein Block Schlacke. Wenn ich meine Nase daran halte, kann ich den penetranten Geruch von Kohlenwasserstoffen wahrnehmen.

Eine Bohrplattform von Statoil treibt eine Bohrung in die Erde, so tief wie zweimal die Länge der Golden Gate Bridge. (PHOTO: CHRISTOPH MORLINGHAUS)

Pionierarbeit hinsichtlich Fracking leistete Halliburton – indem es komprimierten Schlamm in Löcher pumpte, um das umgebende Gestein zu brechen und dessen Kohlenwasserstoffe freizusetzen – schon im Jahr 1947. Aber der Nutzen war bei der konventionell vertikalen Technik von damals begrenzt. Im Jahr 2000 hat George Mitchell, ein Energie-Unternehmer in Texas, die Technik entwickelt, mit Hilfe einer Mixtur aus Wasser, Chemikalien und Sand den Schiefer aufzubrechen. Der Sand wird als Stützmittel benötigt, um die Risse offen zu halten – der Druck des umgebenden Gesteins würde sie sonst sofort wieder schließen. Heute verwendet Statoil perfekt runde graue Kügelchen von der Größe von Mohnsamen einer künstlichen, auf Aluminium basierenden Keramik – 2,5 Millionen Pfund davon pro Bohrloch, mit Nachschub aus 40 Fuß [ca. 12 m] hohen Silos, die die Prärie überziehen. Das künstliche Material kostet dreimal so viel wie Sand, hält aber die Risse länger offen.

Mitchells Schlüssel-Innovation freilich war die Kombination von Fracking mit der sich rapide entwickelten Technik horizontalen Bohrens. Anstatt lediglich ein einzelnes Loch in eine Schicht Schiefergestein zu stechen, können die Bohrer jetzt ein Loch horizontal und parallel zu den Schieferschichten bohren und viel mehr Öl und Gas in das Bohrloch strömen lassen.

Die übrige Industrie hat das System sehr schnell übernommen.

Die Firma EOG Resources – besser bekannt unter ihrem früheren Namen Enron – begann im Jahr 2006 mit dem Fracking in Bakken. Seitdem hat sich die jährliche Ölerzeugung in Nord-Dakota fast verfünffacht auf über eine halbe Million Barrel pro Tag. Im vorigen Jahr wurde Alaska überholt, wurde der Staat doch selbst zum zweitgrößten Ölerzeuger. Mehr Schieferöl kommt derzeit nur aus Texas. In Kalifornien liegt ein noch größeres Feld, allerdings haben dort Umweltbedenken – vorerst noch – die Bohrungen nur begrenzt zugelassen. „Der Schieferöl-Boom in den USA ist nicht eine vorübergehende Blase, sondern die wichtigste Revolution im Ölsektor seit Jahrzehnten“, heißt es in der Studie der Kennedy-Schule.

Einen noch größeren Boom verschafft das Fracking der Erdgas-Industrie. Die Erzeugung von Schiefergas belief sich im Jahr 2000 auf 320 Milliarden Kubikfuß; im Jahr 2011 sogar auf 7,8 Billionen. Heimisches Erdgas deckt den Gesamtbedarf der USA inzwischen zu 95%.

All dies führt zu einer ökonomischen Goldmine, die landesweit Hunderttausende Arbeitsplätze schafft (obwohl in den Gebieten, in denen tatsächlich gebohrt wird, nicht immer die erwarteten Vorteile eintreten, wie Lisa Margonelli erklärt “The Energy Debate We Aren’t Having”). Mehr noch, sie könnte die USA dem lange erträumten Ziel näher bringen, energieunabhängig zu werden. Einer Vorhersage der staatlichen Energy Information Administration EIA zufolge werden die Importe von Öl und anderen Energiegrundstoffen bis zum Jahr 2035 auf 13% des Gesamtenergieverbrauchs in den USA zurückgehen. Das ist ein Rückang um 29% im Jahr 2007.

Und der Fracking-Boom fängt gerade erst an. Man schätzt, dass es Ozeane bisher nicht zugänglichen Schiefergases und –öls in Argentinien, China und vielen europäischen Ländern gibt.

Vor dem Houston Reliant Center werden die 80.000 Teilnehmer der Offshore Technology Conference von einer Reihe von 40 Fuß [ca. 12 m] hohen Bohrtürmen begrüßt. Geschmückt mit den Farben und Flaggen vieler Länder sehen die Bohrtürme aus wie eine Reihe einfacher Jahrmarktsattraktionen. Die Flure des Konferenzzentrums füllt inzwischen eine große Ansammlung von Ingenieuren in Polo-Hemden neben Nigerianern in traditionellen Gewändern [dashikis], Unternehmertypen in grauen Anzügen sowie Araber in bodenlangen Gewändern [galabias]. Die riesigen Ausstellungshallen sind angefüllt mit Apparaten von High Tech bis mittelmäßig: empfindliche elektronische Sensoren, Datenverarbeitungs-Software und Ketten mit Gliedern so groß wie mein Kopf. Das Mann-Frau-Verhältnis sieht aus wie etwa einhundert zu eins.

An einem Pult in dem geräumigen Konferenzraum amüsiert sich Uzi Landau offensichtlich. Der lebhafte 69-Jährige – ein ehemaliger Fallschirmjäger, Israels Minister für innere Sicherheit während der zweiten Intifada und derzeit zuständiger Minister für die Infrastruktur in Israel – ist nach Houston gekommen, um die Energieunternehmen der Welt einzuladen, Israel zu helfen, zu einem Zentrum fossiler Treibstoffe zu werden. „Wir sind eine offene Gesellschaft mit einem unabhängigen Justizsystem“, wirft Landau in die Menge, „wir behandeln Frauen mit Respekt. Wir hängen keine Homosexuellen. Wir behandeln alle Dinge genauso wie Sie hier in Houston!“

Die Tatsache, dass Landau einer der Redner auf dieser Konferenz ist, ist ein guter Indikator für den Umbruch in der Industrie fossiler Treibstoffe und die Auswirkungen, die er auf die Geopolitik hat. Ein alter Witz: Moses muss einen falschen Weg eingeschlagen haben, als er seine Leute in das einzige Land des Nahen Ostens führte, in dem es kein Öl gab. Aber jetzt stellt sich heraus, dass der alte Prophet genau wusste, was er tat. Seit 2009 wurden zwei kolossale Erdgasfelder unter israelischen Gewässern entdeckt. Zusammen enthalten sie Billionen Kubikfuß Gas im Wert von Hunderten Milliarden Dollar. Es ist beabsichtigt, mit der Erzeugung in diesem Jahr anzufangen. Und mit Sicherheit gibt es noch mehr davon dort unten, vielleicht viel mehr. „Meine Damen und Herren, dies ist eine Revolution, soweit es Israel betrifft!“

Diese Feststellung scheint richtig. Die Balance der Petro-Macht verschiebt sich in der am meisten mit Öl angereicherten – und politisch unberechenbaren – Region. Und das könnte alle möglichen Dinge auf alle mögliche Weise verändern.

Israels Erdgas-Reichtum bedeutet, dass das Land nicht nur wohlhabender, sondern zum großen Teil auch energieunabhängiger wird. Man stelle sich vor, was das bedeutet. Billigerer Strom würde es für Israel einfacher machen, mehr Entsalzungsanlagen zu bauen, was zur Entspannung seiner chronischen Wasserknappheit führen würde. Diese größere Selbstversorgung könnte bedeuten, dass Israel weniger Anlass hat, gute Beziehungen zu seinen Nachbarn anzustreben, vor allem mit dem sperrigen Freundfeind Ägypten, der bis vor Kurzem einen großen Teil des israelischen Erdgases verbrauchte. Das Gas in Israel verschafft dem Land schon jetzt neue Freunde anderswo: Russland hat Verträge unterschrieben, in israelischen Hoheitsgewässern aktiv zu werden. All dies könnte Israels Abhängigkeit von den USA verringern und damit unseren Einfluss über das Land.

„Energieunabhängig zu sein würde bedeuten, dass Israel sogar noch weniger auf die internationale öffentliche Meinung Rücksicht nehmen muss als ohnehin schon“, sagte der Politikwissenschaftler Michael Ross an der University of California in Los Angeles, ein Experte für die Auswirkungen des Ölreichtums auf die politische Kultur der betreffenden Länder. „Es gibt starke Beweise, dass je mehr Öl- und Gasreichtum ein Land besitzt, umso weniger wird es durch internationale Verträge beeinflusst werden und international eine Rolle spielen“.

Landau verkündet natürlich nur das Best-Case-Szenario, in dem das israelische Gas den Frieden voranbringt. Israel könnte Gas in die Palestinensergebiete, nach Jordanien und andere Nachbarländer exportieren, die für ihre Stromerzeugung schon nach billigerem und saubererem Gas zur Stromerzeugung Ausschau halten. Das könnte die regionale Zusammenarbeit befeuern und die Akzeptanz von Israel erhöhen. Aber die neuen Gasfelder können auch bestehende Konflikte weiter anheizen. Die Palestinenser könnten sich darüber ärgern, israelisches Gas kaufen zu müssen, besonders weil es auch vor dem Gaza-Streifen ein Gasfeld gibt, das sie nicht ausbeuten können. Libanon reklamiert schon jetzt einige der Mittelmeer-Gasfelder für sich selbst, und die Hisbollah hat damit gedroht, israelische Einrichtungen vor der Küste anzugreifen.

Die Ölwirtschaft der Neuen Welt könnte zu dramatischen Veränderungen im gesamten Nahen Osten führen. Die Staaten am Persischen Golf verfügen immer noch über unberührte Reserven – Saudi-Arabien allein über ein Fünftel aller weltweit bekannten Ölvorräte – aber wir brauchen sie nicht so, wie wir es gewöhnt sind. Amerikanische Importe aus der Golf-Region sind in den letzten Jahren eingebrochen; unsere führenden Versorger mit fossilem Treibstoff sind jetzt Kanada und Mexiko. Teils liegt das an der gesteigerten Erzeugung in den USA und teils auch an einer Flutwelle einer weiteren, kürzlich erschlossenen Ressource – die Ölsande im nördlichen Alberta. Inzwischen führt das weltweit neu strömende Öl und Gas zu sinkenden preisen. Das könnte auf einen ernsten Einbruch der Einkommen der Könige und Emire sein, die lange von Gaben der Regierung an die Bevölkerung abhängig waren, um diese daran zu hindern, größere Freiheiten einzufordern nach Art des Arabischen Frühlings.

Tatsächlich könnten die neuen fossilen Treibstoffe der Welt eine ungewisse Zukunft für alle einschlägigen Nationen bedeuten, die gegenwärtig den Markt beherrschen – einschließlich Russland, Venezuela und Iran. „Es liegen große Herausforderungen vor allen vom Öl abhängigen Nationen“, sagt der Management-Direktor von Citigroup Ed Morse, der kürzlich als Mitautor einer Studie gearbeitet hat, in der es um die Auswirkungen des Booms fossiler Treibstoffe in den USA geht – Titel: North America, the New Middle East? (pdf). „Er könnte zu allen möglichen inneren Umbrüchen führen!“

Die Handvoll neu in der globalen Szene fossiler Treibstoffe auftauchenden Mitspieler – Mosambik, Tansania, Papua Neuguinea – sind Joker. Der neue Reichtum könnte ihre Völker aus der Armut führen – oder sie könnten der Versuchung des berühmten „Öl-Fluches“ erliegen und erleben, wie das Geld von korrupten Eliten und explodierenden inneren Konflikten abgezweigt wird.

Oder etwas ganz Anderes könnte passieren. „In diesem Industriezweig liegen die Leute permanent falsch mit ihren Prognosen“, sagt Ross. „In den siebziger Jahren dachte jeder dass die Preise für immer hoch bleiben würden und dass die OPEC der führende Energie-Spekulant der Welt bleiben würde. Das alles ist zerfallen. Dann, in den neunziger Jahren, fielen die Preise und jedermann dachte, sie würden niedrig bleiben“. Soviel dazu.

Die Energieindustrie ist durch so viele komplexe, miteinander in Wechselwirkung stehende Faktoren so berührt, dass langfristige Prognosen genau wie beim Wetter unmöglich sind. Spannungen an vielen Stellen im Nahen Osten könnten sich entladen. China könnte in eine Rezession abgleiten und erleben, wie sein Energieverbrauch abstürzt. Ein weiterer schwerer Unfall im Golf von Mexiko könnte die Tiefwasser-Förderung in den USA zum Erliegen bringen.

Aber eines wissen wir mit Sicherheit: Es ist noch sehr viel fossiler Treibstoff übrig. Und früher oder später werden wir es fördern. Menschen hören nicht auf zu steuern oder Plastik zu benutzen. Die wie Pilze aus dem Boden schießende Mittelklasse in China, Indien und anderswo wollen ihre Autos und Air Condition haben. Der Petroleumverbrauch in China allein hat sich im vergangenen Jahrzehnt verdoppelt, wodurch es zum weltweit zweitgrößten Verbraucher hinter den USA geworden ist. Abgesehen von unvorhergesehenen wirtschaftlichen Schwierigkeiten, wird sich die weltweite Nachfrage nach Energie während der nächsten 20 Jahre um ein Drittel bis zur Hälfte erhöhen – und das meiste dieser Nachfrage wird durch Öl und Gas befriedigt werden. Wind, Sonne und andere erneuerbare Quellen haben noch einen Meilen langen Weg vor sich, bevor sie einen wesentlichen Teil des Weltenergiemix’ ausmachen, und sie haben es schwerer denn je, wettbewerbsmäßig mit Erdgas mitzuhalten, wenn dieses so billig ist.

Was noch mehr zählt ist, dass die Erde noch andere fossile Treibstoffe bereit halt, die wir noch nicht einmal angetastet haben. Regierungen und Unternehmen erforschen eine Anzahl langfristiger Energiequellen. Sie reichen von einem noch nicht ganz ausgereiften Öltyp namens Kerogen bis zu den Methanhydraten im Eis von Alaska.

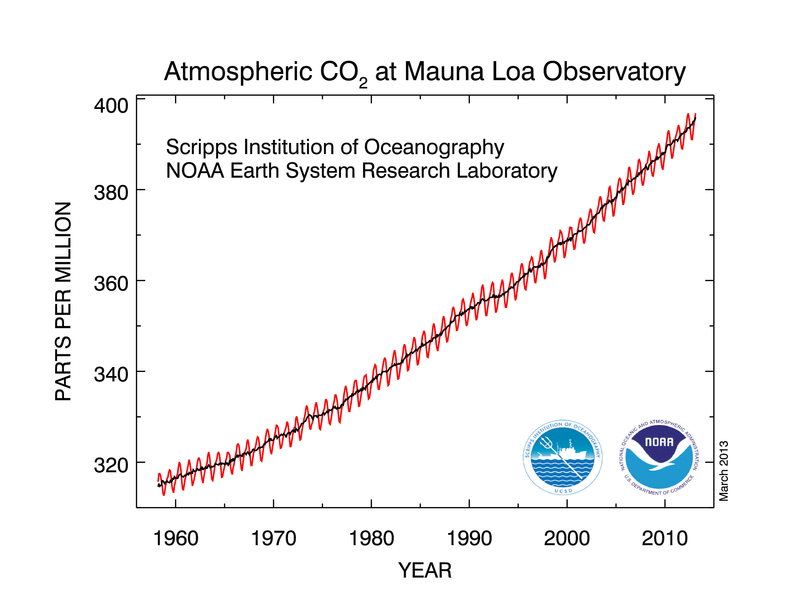

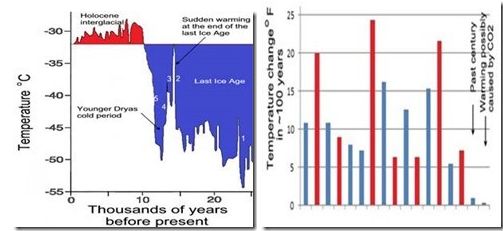

Was uns zur größten aller Unbekannten bringt: was dieses neue Zeitalter für unseren sich rapide erwärmenden Planeten bringt. Mehr verbrannte Kohlenwasserstoffe bedeuten mehr Kohlenstoff in der Atmosphäre und die gesamte sattsam bekannte Litanei der daraus sich ergebenden Katastrophen.

Selbst Industriebosse räumen das ein. „Es gibt genug Öl und Gas, das durchaus bis zum Ende des nächsten Jahrhunderts ausreichend für uns wäre, ohne viele Zweifel“, sagt David Eyton, Leiter der Abteilung Forschung und Technologie bei BP. Das wirkliche Problem, sagt Eyton, liegt darin, dass „wir die Kohlenstoff aufnehmende Kapazität der Atmosphäre überstrapazieren“.

Sind wir also zu einer Zukunft stetig weiter steigender Temperaturen verdammt? Vielleicht. Vielleicht auch nicht. Es gibt nicht nur schlechte Nachrichten: in der entwickelten Welt sind die Treibhausgasemissionen dabei, sich zu stabilisieren, und zwar dank zunehmender Effizienz und einer Verschiebung hin zu saubereren Treibstoffen. In den USA sind die Kohlenstoffemissionen in Verbindung mit Energie seit dem Spitzenwert des Jahres 2005 zurück gegangen. Auch wird erwartet, dass sie während der nächsten zehn Jahre nur sehr wenig steigen. Und sauberer verbrennendes Erdgas beginnt, Öl und Benzin in einigen Industrien und Fahrzeugflotten zu ersetzen.

„Wir leben in einer Welt, in der die Dinge schneller ablaufen als wir erwarten”, sagt Amy Myers Jaffe, geschäftsführende Direktorin für Energie und Nachhaltigkeit an der University of California. „Vielleicht finden wir ein Mittel, uns einen Weg aus der Klimaänderung zu weisen oder den Prozess zumindest zu verlangsamen, so dass wir uns an die Auswirkungen anpassen können. Wenn es eine Sache gibt, die uns die Geschichte der fossilen Brennstoffe zeigt, dann die, dass wir unglaublich gut hinsichtlich der Anpassung sind sowie beim Aufspüren neuer Wege, um Probleme zu lösen, die früher als unlösbar galten.“

Heute wurde nahezu das gesamte Kern River-Feld von Chevron übernommen. Es ist ein schauerlicher Ort, der aussieht wie nach der Apokalypse. 16 Quadratmeilen, die aussehen, als ob sie verbrannt seien und dann von einer hirnlosen Armee von Pferdekopf-Pumpen übernommen worden sind.

Sie sind eine kunterbunte Horde verschiedener Größe und Farben und Jahrgängen. Einige stehen still, andere nicken mit ihren Köpfen in Richtung Erde und fördern jeden Tag um die 80.000 Barrel Öl.

Unter Tage pumpen mit Erdgas betriebene Generatoren Dampf durch eine Batterie von Rohren in Bohrlöcher; randvoll mit Sensoren; die ununterbrochen Daten über Druck, Fließraten und andere unabdingbare Informationen in ein Kontrollzentrum übermitteln. Dort überwachen Techniker alles mit Hilfe von 3-D seismischen Modellen. All dies macht es viel teurer, Öl aus Kern River zu pumpen; die Energiemenge, die zum Hochpumpen eines Barrels Öl erforderlich ist, hat sich seit Einführung der unterirdischen Heizmethoden dramatisch erhöht, jedenfalls einer vor Kurzem erschienenen Studie der Stanford University zufolge. Aber heute besteht der Bedarf hier, und genauso ist es mit den Vorräten. Geologen bei Chevron schätzen, dass es dort unten noch weitere 627 Millionen Barrel Öl gibt.

Auf einer kleinen Anhöhe, die den eigentlichen Fluss überblickt – dessen Ufer die einzigen grünen Flecken in Sichtweite sind – steht ein weiß gestrichenes Monument, das die Stelle markiert, an der James Elwood erstmals vor über einem Jahrhundert Öl gefunden hat. Dieses Bohrloch wurde 1995 eingeebnet. Aber auf beiden Seiten davon, keine 20 Fuß entfernt, pumpen zwei Apparate mit gelben Köpfen Öl aus den tiefsten Tiefen des Bodens, in einem stetigen Auf und Ab, als ob sie niemals damit aufhören würden.

Vince Beiser

Link: http://www.psmag.com/environment/oil-production-peak-oil-fracking-kern-river-north-dakota-brazil-energy-53395/

Übersetzt von Chris Frey EIKE