Es gibt einige ziemlich klare Anzeichen einer wärmeren Welt. Das arktische Eis ist nicht mehr das, was es einmal war [3]. Viele Gletscher ziehen sich zurück [4]. Einige Gletscher – zum Beispiel am Kilimandscharo – schrumpfen, weil die langzeitliche Niederschlagsmenge nicht mehr das ist, was sie vor 150 Jahren war, und nicht, weil es wärmer ist [5]. Andere schrumpfen durch das wärmere Klima.

Der Punkt, in dem die Skeptiker sich von vielen anderen Wissenschaftlern unterscheiden, besteht darin, dass Letztere für die Erwärmung menschliche Aktivitäten verantwortlich machen – im Besonderen durch das Verbrennen fossiler Treibstoffe und der daraus resultierenden steigenden CO2-Konzentration in der Atmosphäre. Die Hypothese lautet, dass das CO2 infrarote Strahlung einfängt, die anderenfalls in den Weltraum entweichen würde. Dies bedeutet, dass ein Teil der von der Sonne einfallenden Energie nicht verloren geht und stattdessen zu einer Erwärmung des Globus‘ führt.

Die Physik, mit der das Kohlendioxid infrarote Strahlung zurück hält, ist gut bekannt [6]. Aber es gibt andere Moleküle in der Atmosphäre, die infrarote Strahlung ebenfalls zurück halten. Wasserdampf ist das vorherrschende „Treibhausgas“ [7]. Nicht so eindeutig ist das Ausmaß, mit dem die zurück gehaltene Energie Erwärmung bringt. Es gibt wunderbare mathematische Modelle, die behaupten zu zeigen, wie es zu der Erwärmung kommt. Unglücklicherweise weisen diese Modelle allesamt identifizierbare Unstimmigkeiten auf, worauf ich später noch eingehe.

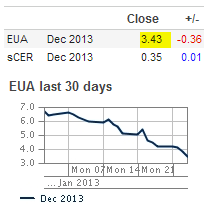

Eine primäre Schwierigkeit der These von der anthropogenen Erwärmung besteht darin, dass nicht bekannt ist, wie viel von der Erwärmung natürlichen Ursprungs ist und wie viel davon dem Kohlendioxid zuzuschreiben ist. Das ist einfach zu illustrieren. Abbildung 1 zeigt die globale Temperaturaufzeichnung, wie sie vom Hadley Center an der University of East Anglia dargestellt wird [8].

Abbildung 1: Globale Temperaturen im Vergleich zum Mittel 1950-1990

Die globale Temperatur ist von 1850 bis 1860 zurück gegangen, dann bis 1880 gestiegen, bis 1910 zurück gegangen, gestiegen bis 1945, zurückgegangen bis 1980, gestiegen bis zum Jahr 2000, wonach sie wieder leicht zurück gegangen ist.

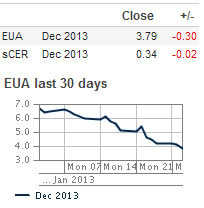

Abbildung 2 zeigt die Aufzeichnung von Kohlendioxid. Sorgfältige Messungen wurden auf dem Mauna Loa in Hawaii seit 1958 durchgeführt [9]. Das vorindustrielle Niveau des CO2-Gehaltes wird übereinstimmend mit etwa 280 ppm angenommen [10]. Abbildung 2 zeigt eine vernünftige Extrapolation der Daten bis hin zu einem Wert von 280 ppm im Jahr 1800.

Abbildung 2: Atmosphärische CO2-Konzentrationen, gemessen und geschätzt..

Es scheint vollkommen vernünftig, dass der gemessene Anstieg die Folge des Verbrauchs fossiler Treibstoffe ist. Abbildung 3 zeigt die jährlichen CO2-Emissionen mit der Zeit [11]. Im Jahr 1900 lagen sie bei knapp 2 Milliarden Tonnen pro Jahr, 1943 bei 5 Milliarden Tonnen. Danach gab es einen Rückgang, und die 5 Milliarden Tonnen wurden erst 1947 überschritten. Danach gab es einen rapiden Anstieg über 10 Milliarden Tonnen 1963, über 15 Milliarden Tonnen 1971, über 20 Milliarden Tonnen 1986 und 30 Milliarden Tonnen 2006.

Abbildung 3: jährliche CO2-Emissionen durch den Verbrauch fossiler Treibstoffe

Der Vergleich der Abbildungen 2 und 3 macht klar, dass der Anstieg des atmosphärischen Kohlendioxids fast mit Sicherheit direkt durch Emissionen fossiler Treibstoffe zustande gekommen ist. Allerdings macht das geringe Niveau der Jahre vor 1945 auch klar, dass der Einfluss der Verbrennung fossiler Treibstoffe vor 1945 sehr klein wenn nicht sogar vernachlässigbar gewesen sein muss. Daher sind die in Abbildung 1 gezeigten Änderungen der Temperaturen vor 1945 größtenteils natürlich. Der zusätzliche CO2-Eintrag durch menschliche Aktivitäten kann bei den Änderungen vor 1945 keine signifikante Rolle gespielt haben.

Wenn wirklich das meiste der Temperaturänderungen vor 1945 natürlichen Ursprungs war, dann ist es sehr schwierig zu bestimmen, wie viel der Temperaturänderungen nach 1945 natürlichen Ursprungs ist und wie viel davon dem zunehmenden CO2-Gehalt zuzuschreiben ist. Da erhebt sich die Frage, wie groß die natürliche Variabilität der Temperatur sein könnte.

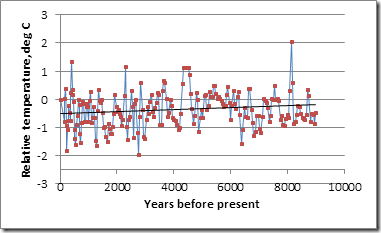

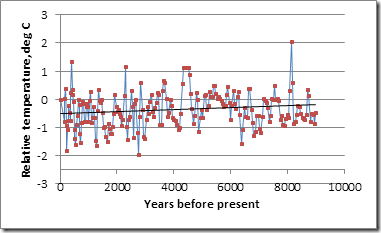

Um diese Frage zu beantworten betrachten wir den Wostok-Eisbohrkern der letzten 9000 Jahre [12]. Der Bohrkern wurde für jeden Meter Tiefe analysiert, wobei jeder Meter im oberen Teil etwa 20 Jahre Akkumulation und in den unteren Schichten etwa 50 Jahre Akkumulation repräsentiert. Während eine solche Punktmessung keine gute Messung der mittleren globalen Temperatur ergeben kann, ermöglicht er eine vernünftige Messung der Änderungen der globalen Temperatur, und es sind ja vornehmlich die Temperaturänderungen, die hier interessieren.

Die entsprechenden Daten zeigt die Abbildung 4. Es gab während der letzten 9 Millenien eine leichte Abkühlung, wie die Linie der kleinsten Quadrate zeigt. Die Daten wurden daher vor der weiteren Analyse trendbereinigt – die mittlere Temperatur an irgendeinem Datum wurde zu der gemessenen relativen Temperatur addiert. Die trendbereinigten Temperaturen waren „normal verteilt“, d. h. es war nichts Anomales oder Verdrehtes darin. Dann wurde die Änderungsrate jeder trendbereinigten Temperatur und der Temperatur 100 ±20 Jahre zuvor berechnet und als Rate pro Jahrhundert ausgedrückt. Die Ergebnisse waren ebenfalls normal verteilt mit einer Standardabweichung von 0,94°C pro Jahrhundert.

Abbildung 4: Relative Temperaturen der letzten 9000 Jahre.

Folglich beträgt die Chance 2 : 1, dass die Temperatur bis zu 1°C pro Jahrhundert aus natürlichen Gründen variieren kann, aber nur eine solche von 1 : 10, dass sie natürlich um mehr als 1,9°C pro Jahrhundert variiert. Zwischen 1900 und 2000 variierte sie um etwa 0,9°C, was folglich innerhalb der Bandbreite der natürlichen Variation liegt. Und das, vereinfacht ausgedrückt, ist der Grund für Skeptizismus hinsichtlich der These, dass Kohlendioxid globale Erwärmung verursacht – es gibt kein klares Signal irgendeines solchen Erwärmungseffektes.

Allerdings behaupten die Befürworter der These von der anthropogenen Erwärmung, über Modelle zu verfügen, die zeigen, wie zusätzliches Kohlendioxid zu einer wärmeren Welt führt [13]. Es gibt massive Probleme mit diesen Modellen, von denen nicht das Kleinste die Tatsache ist, dass die Befürworter behaupten, die Verdoppelung des CO2-Gehaltes der Atmosphäre werde die Temperatur um über 3°C zunehmen lassen. Dies liegt weit oberhalb aller physikalischen Gründe [14]. Es resultiert aus Argumenten über die Auswirkungen von Wasserdampf in der Atmosphäre, von dem angenommen wird, dass er die Auswirkungen zusätzlichen CO2’ verschärft.

Der Verdoppelungseffekt ist bislang unsichtbar. Andere Schätzungen haben ergeben, dass eine Verdoppelung des CO2-Gehaltes die globale Temperatur um weniger als 1°C zunehmen lassen könnte [15]. Die Beweise hierfür formieren sich gerade. Zum Beispiel hat es seit 1945 eine CO2-Zunahme in der Atmosphäre um 40% gegeben, was eine Erwärmung um 1,2°C bewirkt haben müsste, wenn man der These von der Erwärmung um 3°C bei einer Verdoppelung folgt. Abbildung 1 zeigt jedoch, dass die derzeitige Erwärmung in diesem Zeitraum lediglich etwa 0,4°C betragen hat. Hat sich der Globus um 0,8°C abgekühlt, während uns das zusätzliche CO2 gewärmt hat? Das scheint unwahrscheinlich.

Es gibt weitere Gründe, den Modellen zu misstrauen. Zum Beispiel reproduziert Abbildung 5 die Abbildung 10.7 aus dem AR 4 des IPCC [16].

Abbildung 5: Modellvorhersagen globaler Temperaturänderungen: Atmosphäre oben, Ozeane unten

Die Gebiete reichen vom Südpol links bis zum Nordpol rechts. In der Atmosphäre wird die Höhe durch den Luftdruck repräsentiert, mit 1000 hPa auf Meeresspiegel-Niveau und 200 hPa in einer Höhe von 11 km. Die Schraffierung zeigt Gebiete, in denen alle Modelle in engen Grenzen übereinstimmen.

Das besondere Interesse richtet sich auf die ‚Blase’ über dem Äquator in einer Höhe von etwa 200 hPa. In den Jahren 2011 bis 2030 ist sie weniger als 1,5°C über den heutigen Temperaturen am Boden [?]. Bis zum Zeitraum 2046 – 2065 wird eine Erwärmung um 3°C und von 2080 bis 2099 von etwa 5°C erwartet. Folglich müsste es sich in dieser Region um etwa 0,6°C pro Dekade erwärmen, wenn man den Modellen glauben soll.

Während etwa der letzten 60 Jahre sind Instrumente tragende Ballone bis in diese Region aufgestiegen, um Daten für die Wettervorhersage zu gewinnen. Eine Untersuchung der Temperaturaufzeichnungen hat bisher keinerlei Erwärmung gezeigt [17]. Satelliten sind seit Ende der siebziger Jahre in Betrieb, und einige ihrer Sondierungen durch die Atmosphäre hindurch können als mittlere Temperatur bestimmter Regionen interpretiert werden [18]. Die Satelliten zeigen eine sehr geringe Erwärmung – aber nichts auch nur annähernd von 0,6°C pro Dekade.

In der Wissenschaft kann ein einzelnes Experiment ausreichen, um eine Theorie zu bestätigen, falls das Experiment zu einem unerwarteten Ergebnis führt, wie es von der Theorie vorhergesagt worden ist. Die Allgemeine Relativitätstheorie von Einstein im Jahr 1915 musste bis zum Jahr 1019 auf eine experimentelle Bestätigung und die nachfolgende verbreitete Akzeptanz warten. Genauso sollte aber jede Theorie, deren Vorhersagen durch Experimente widerlegt werden, ohne wenn und aber verworfen werden. Im gegenwärtigen Fall hat die These der anthropogenen Erwärmung zu theoretischen Modellen geführt, aber diese Modelle sind experimentell gescheitert. Der Glaube an die anthropogene Erwärmungsthese ist jedoch so stark, dass sich die Modellierer in höchstem Maße sträuben, ihre Modelle zu verwerfen – oder auch nur zu überarbeiten. Das ist einer der gewichtigsten Gründe für Skeptizismus.

Die Anthropogen-These führte auch zu vielen Vorhersagen möglicher Bedingungen in einer wärmeren Welt. Einige davon wie beispielsweise der Einfluss auf die Kryosphäre scheinen ausgetragen zu sein [seem to be borne out]. Allerdings beschreiben die Modelle, die wie vorher schon gesagt hoch verdächtig sind, solche Dinge wie dramatische Änderungen des Niederschlags. Der Beweis ist vernachlässigbar.

Zum Beispiel gibt es eine sehr lange Reihe der Niederschlagsmenge für England und Wales, dargestellt in Abbildung 6 [19]. Es gibt absolut kein Anzeichen für irgendeine Änderung der Niederschlagsverteilung während der letzten 60 Jahre. Während der gesamten Periode lag das 25-jährige Mittel bei 913 ±18 mm. Diese 18 mm sind die maximale Abweichung, nicht die Standardabweichung!

Abbildung 6: eine 240-jährige Aufzeichnung der Niederschlagsmenge.

Ebenso gibt es wiederholte Hinweise darauf, dass der Meeresspiegel infolge des Schmelzens von Eis und der Erwärmung der Ozeane rapide steigen wird (warmes Wasser hat eine geringere Dichte als kaltes Wasser, so dass es ein größeres Volumen einnimmt). Es stimmt, dass der Meeresspiegel steigt, aber man sucht vergeblich nach irgendeinem Beweis, dass er nach 1945 signifikant schneller gestiegen ist als davor. Abbildung 7 zeigt dies, und zwar durch Tidenmessungen in New York, die bis zum Jahr 1858 zurück reichen mit einer Lücke von 1879 bis 1892 [20]. Die Regressionsgerade von 1870 bis 2011 weist eine Steigung von 2,947 mm pro Jahr, diejenige von 1945 bis 2011 eine Neigung von 2, 948 mm pro Jahr auf. Es gab keine signifikante Zunahme der Rate des Meeresspiegelanstiegs in New York während der letzten 140 Jahre.

Abbildung 7: eine 150 Jahre lange Aufzeichnung des Meeresspiegels.

Viele der Befürchtungen hinsichtlich eines Anstiegs des Meeresspiegels sind unbegründet. Ja, der Meeresspiegel steigt langsam. Satellitenmessungen seit Anfang der neunziger Jahre bestätigen eine Anstiegsrate von etwa 3 mm pro Jahr [21]. Allerdings gibt es bereits Abwehrmaßnahmen gegen das Meer. Es ist notwendig, sich gegen Spring- und Sturmfluten und sogar Tsunamis zu schützen. Die bestehenden Gefahren werden in Metern und nicht in Millimetern gemessen. Einer Zunahme des mittleren Niveaus um 3 mm pro Jahr kann man begegnen, wenn man Schutzmauern um eine Reihe von Ziegelsteinen alle 30 Jahre erhöht. Der steigende Meeresspiegel ist keine Bedrohung.

Natürlich gibt es Ereignisse, bei denen sich die Schutzmaßnahmen als ungeeignet erweisen. Das war der Fall beim Hurrikan Kathrina in New Orleans. Viele Jahre zuvor wurde schon berichtet, dass die Deiche einem solchen Ereignis wahrscheinlich nicht standhalten werden. Sie waren alt und ließen Modernisierungen vermissen. Sie haben wie erwartet beim Eintreffen der Sturmflut versagt. Ihr Versagen jedoch hat nichts mit dem Anstieg des Meeresspiegels zu tun, sondern ausschließlich mit fehlenden Schutzmaßnahmen.

Allerdings gibt es wiederholte Hinweise in der Literatur, dass das Versagen der Deiche eine Folge der „Klimaänderung“ sei. Dies illustriert eine Seite der Debatte, die den Skeptizismus verstärkt. Katastrophen, die nichts mit einem sich ändernden Klima zu tun haben, werden der „Klimaänderung“ zugeschrieben als ein Mittel, die Aufmerksamkeit auf die vermeintlichen Katastrophen aufrecht zu erhalten.

Nichts illustriert diesen Aspekt der Debatte besser als die fortgesetzte Betonung von „Extremereignissen“. Ein heftiger Sturm wie kürzlich Sandy, der New York betroffen hat, wird sofort als ein Beweis für die „Klimaänderung“ herangezogen.

Das Wetter war jedoch schon immer variabel. Die Energie jedes natürlichen Phänomens hat eine große Bandbreite. Viele Phänomene wie z. B. die Regenmenge werden am besten durch eine Verteilung beschrieben, die sehr stark verzerrt ist. Solche Verteilungen sind ziemlich wenig eingängig für die Definition, was „extrem“ eigentlich ist.

Das Problem besteht darin zu bestimmen, wie weit die ‚normale’ Bandbreite reicht; eine Bestimmung, die wesentlich dafür ist, ein Ereignis als anomal oder ‚extrem’ zu beschreiben, d. h. dass es außerhalb der normalen Bandbreite liegt. Eine Menge Daten sind erforderlich zur Definition dessen, was ‚normal’ ist, wobei diese Daten über einen langen Zeitraum gesammelt werden müssen. Dieser lange Zeitraum kann länger als die Lebensdauer eines Menschen sein. Falls dem so ist, können nur wenige lebende Individuen wirklich „extreme“ Ereignisse erlebt haben – und ein Ereignis deutlich weniger als extrem kann als ein Extremereignis angesehen werden, obwohl es das gar nicht ist.

Im Falle des Sturms Sandy gab es eine Zustandsbeschreibung der Intensität aller Hurrikane und „außertropischen Stürme“ (ein solcher war Sandy), die auf das US-Festland zwischen 1900 und 2012 übergegriffen haben. Diese Daten zeigt Abbildung 8 [23].

Eine im Jahr 1900 geborene Person würde möglicherweise das extremste Ereignis im Jahr 1936 erlebt haben. Allerdings kann diese Person 106 Jahre alt geworden sein, dann hätte sie zwei noch stärkere Stürme erlebt. Das könnte ihn/sie zu der Überzeugung gebracht haben, dass die Welt immer schlimmer werde. Er/sie hätte natürlich unrecht – die Randstellung von Extremereignissen hätte sie zum Narren gehalten.

Abbildung 8: Index der Stärke von Stürmen, die zwischen 1900 und 2012 auf das US-Festland übergegriffen haben.

Dies illustriert ziemlich gut, wie lange man warten muss, bevor man selbst ein 100-Jahres-Ereignis bestimmen kann – und wie man berechnen kann, ob ein solches Ereignis danach auch in weniger als 100 Jahren noch einmal auftreten kann! Die Statistiken von Extremereignissen sind nicht eingängig, und man braucht sehr lange Zeiträume, um zu bestimmen, ob ein Ereignis extrem ist oder nicht.

Es gab extensive Besorgnisse hinsichtlich von Extremereignissen, teilweise weil fast jeden Tag irgendwo auf dem Globus ein Ereignis eintritt, dass man als ‚Extrem‘ bezeichnen kann. Das IPCC hat dazu einen speziellen Bericht [a special report] herausgegeben [24]. Wohl am besten kann man diesen Bericht als ‚zweideutig‘ beschreiben – eine Reihe sehr vorsichtiger Äußerungen, die auf unterschiedliche Weise interpretiert werden können, abhängig vom eigenen Standpunkt. Die wahrscheinlich beste Methode, das Ausmaß zu messen, mit dem ein Extremereignis wahrscheinlich vom Klimawandel verursacht wird, kommt aus einer Studie über Todesfälle infolge extremen Wetters [25]. Die Ergebnisse zeigt Abbildung 9.

Es wird deutlich, dass die absolute Zahl der Todesfälle pro Jahr seit den zwanziger Jahren des vorigen Jahrhunderts zurückgegangen ist. Relativ gesehen war der Rückgang sogar noch dramatischer, und zwar von einem Spitzenwert von 241 pro Million auf 5 pro Million. Diese niedrige Rate zeigt ganz klar, dass Extremwetter nicht mehr das gleiche Risiko für die Menschen darstellt wie für frühere Generationen.

Abbildung 9: Rate der Todesfälle pro Million Menschen durch Extremwetterereignisse

Es gibt viele Gründe für diesen steilen Abfall. Einer davon ist die erheblich verbesserte Wettervorhersage, so dass man jetzt ausreichend Zeit hat, sich auf das extreme Wetter vorzubereiten. Zweitens ist die Kommunikation hinsichtlich drohenden Extremwetters viel besser geworden. Und schließlich hat die Menschheit durch verbessertes Wissen über extreme Bedingungen gelernt, Strukturen zu entwickeln, um uns vor der Katastrophe zu schützen.

Die finale Angstgeschichte, die aufs Abstellgleis geschoben werden muss, ist die Mär vom Aussterben mancher Spezies als Folge des Klimawandels. Über diese Geschichte berichtet die öffentliche Presse regelmäßig. „‚Die Klimaänderung repräsentiert inzwischen eine genauso große Bedrohung für die Anzahl der auf der Erde lebenden Spezies wie die Veränderung oder Zerstörung von Habitaten‘, sagt Chris Thomas, ein Umweltschutz-Biologe an der University of Leeds in UK. – Die vorhergesagte Bandbreite der Klimaänderung bis zum Jahr 2050 wird 15 bis 35% der 1103 untersuchten Spezies dem Risiko des Aussterbens aussetzen. Es wird erwartet, dass diese Zahlen noch steigen, wenn sie global extrapoliert werden und potentiell mehr als 1 Million Spezies aussterben könnten“ [26].

Allerdings bevorzugt die Wissenschaft Vorhersagen, die man auch verifizieren kann. Eine vor kurzem erschienene Studie kommt zu dem Schluss, dass „es überraschenderweise keine geradlinige Beziehung zwischen lokalem Aussterben und begrenztem Ertragen hoher Temperaturen gibt“ [27]. Tatsächlich folgt dies aus dem gesunden Menschenverstand. Abbildung 10 zeigt die mittleren täglichen Maxima und Minima, die Linien zeigen die höchste bzw. tiefste jemals aufgezeichnete Temperatur, und die untere bzw. obere horizontale Linie reflektiert die jeweilige jährliche Mitteltemperatur in den Jahren 1900 und 2000.

Abbildung 10: Monatliche Temperaturen in einer subtropischen Stadt sowie jeweilige jährliche Mittel der Jahre 1900 und 2000.

Es ist vernünftig zu fragen, wie die relativ kleine Änderung der Mitteltemperatur von Organismen erspürt werden kann, die jedes Jahr Änderungen ausgesetzt sind, die etwa 50 mal größer sind und an die sie sich perfekt angepasst zu haben scheinen.

Der finale Grund für den weiter bestehenden Skeptizismus ist das Verhalten von einigen der Befürworter der These von der Klimaänderung. Das fängt beim IPCC an. Es wurde mehr zu einer politischen als zu einer technischen Institution. Am besten zeigt sich dies in der Veröffentlichung der IPCC-Berichte. Ihr geht jeweils eine Publikation einer Summary for Policy Makers voraus. Die in dieser Summary genannten Schlussfolgerungen unterscheiden sich oftmals von denen des Hauptberichtes und verleihen ihm eine politisch korrekte Ausrichtung auf etwas, das eine leidenschaftslose Übersicht über die wissenschaftliche Literatur sein soll [28].

Der Arbeit des IPCC ist die Tatsache, dass viele der zitierten Arbeiten nicht wissenschaftlich, sondern aus Schriften von Aktivisten reproduziert worden sind, nicht förderlich. Die kanadische Journalistin Donna Laframboise hat dieses Problem detailliert dokumentiert [29].

Zum Beispiel folgt sie der Spur eines relativ unbekannten Professors der Epidemiologie, Anthony McMichael, der 1991 eine Polemik geschrieben hatte, und der Leitautor des Kapitels über Malaria und die gesundheitlichen Auswirkungen der Klimaänderung geworden ist, obwohl es von ihm keinerlei professionelle Publikationen über Malaria gibt und sogar obwohl einige seiner Schlussfolgerungen von Mitgliedern des Panels zurückgewiesen worden sind, die wirklich Experten auf diesem Gebiet waren.

Abschnitte aus dem Buch von McMichael erschienen fast wortgleich im IPCC-Zustandsbericht aus dem Jahr 1995. Dieses führte direkt zu der These, dass die globale Erwärmung für eine Ausbreitung der Malaria sorgen wird. Es gibt keine Beweise, dass dies wahrscheinlich ist, weil Malaria-Ausbrüche Jahrhunderte lang auch aus kalten Gebieten bekannt sind. Mehr noch, man weiß, dass die Ausbreitung von Malaria fast ausschließlich eine Funktion sozialer Bedingungen und öffentlicher Gesundheit ist.

Dem Kampf gegen Malaria wird nicht von denen geholfen, die behaupten, dass die Klimaänderung Teil des Problems ist. Würde man ihnen folgen, würde man sich mehr um den Klimawandel als um Malaria kümmern. Dies illustriert die Gefahr, wenn man eine möglicherweise falsche These zu unkritisch übernimmt – Ressourcen können notwendigen Aktivitäten entzogen werden, die das Leben von Millionen betreffen in der Hoffnung, dass es positive Auswirkungen auf mutmaßliche Risiken hat, die Milliarden betreffen könnten. Bevor man eine solche Entscheidung trifft, muss man wirklich sehr sicher sein, dass die mutmaßlichen Risiken durch das Umverteilen von Ressourcen vermieden werden können.

Ein weiterer Grund für Skeptizismus besteht darin, dass die Debatte über die Klimaänderung einige wesentliche Unstimmigkeiten unter den Wissenschaftlern selbst enthüllt hat. Einige Spieler auf dem Spielfeld der vom Menschen verursachten Klimaänderung haben sich nur als zu menschlich gezeigt bei der Verteidigung des Unhaltbaren. Zum Beispiel haben zwei Wissenschaftler das getan, was Wissenschaftler tun sollten – sie haben die Arbeiten von etwa 200 anderen Wissenschaftlern begutachtet [30]. Sie schreiben, dass:

„Auf der ganzen Welt zeigen zahlreiche Aufzeichnungen, dass das 20. Jahrhundert wahrscheinlich weder die wärmste noch eine extreme klimatische Periode des letzten Jahrtausends gewesen ist“.

Dies stand diametral im Gegensatz zu der These, dass die derzeitige Erwärmung außerordentlich ist. Folgerichtig haben die Gläubigen an den vom Menschen verursachten Klimawandel den Herausgeber des Journals, dass diese Begutachtung abgedruckt hatte, zum Rücktritt gezwungen. Dann gerieten sie außer Rand und Band mit dem Versuch, die Reputation der beiden Autoren zu zerstören. All dies (und noch mehr) wurde enthüllt, als eine Reihe von E-Mails den Weg in eine öffentliche Domain des Hadley Centre an der University of East Anglia gefunden hatte [31].

Die Welt ist etwas wärmer. Das Niveau des Kohlendioxidgehaltes der Atmosphäre nimmt zu. Pflanzen wachsen besser als zuvor wegen dieses höheren Gehalts an CO2 [32]. Der Meeresspiegel steigt mit einer kaum messbaren Rate. Klimatische Katastrophen sind nicht schlimmer als früher. Das Tierreich wird durch das Wachstum einer einzigen Spezies bedrängt, nämlich uns, doch hat dies nichts mit der globalen Erwärmung zu tun.

Und das sind die Gründe dafür, dass es ein Klima des Skeptizismus gibt.

Philip Lloyd, Energy Institute, CPU

Link: http://wattsupwiththat.com/2013/01/18/a-climate-of-scepticism/#more-77781

Übersetzt von Chris Frey EIKE

References

[1] http://wattsupwiththat.com/2010/08/29/gisstimating-1998/ Accessed January 2013

[2]http://wattsupwiththat.files.wordpress.com/2012/07/watts-et-al_2012_discussion_paper_webrelease.pdf Accessed January 2013

[3] http://www.ijis.iarc.uaf.edu/seaice/extent/AMSRE_Sea_Ice_Extent_L.png Accessed January 2013

[4] Paul, F., Kääb, A. and Haeberli, W. Recent glacier changes in the Alps observed by satellite: Consequences for future monitoring strategies, Global and Planetary Change, Volume 56, Issues 1–2, March 2007, Pages 111-122, ISSN 0921-8181, 10.1016/j.gloplacha.2006.07.007.

(http://www.sciencedirect.com/science/article/pii/S0921818106001603) Accessed January 2013

[5] Mölg, T., and D. R. Hardy (2004), Ablation and associated energy balance of a horizontal glacier surface on Kilimanjaro, J. Geophys. Res., 109, D16104, doi:10.1029/2003JD004338.

[6] http://scienceofdoom.com/roadmap/atmospheric-radiation-and-the-greenhouse-effect/ Accessed January 2013

[7] http://www.ncdc.noaa.gov/oa/climate/gases.html Accessed January 2013

[8] http://www.metoffice.gov.uk/hadobs/hadcrut4/ Accessed January 2013

[9] http://co2now.org/Current-CO2/CO2-Now/noaa-mauna-loa-co2-data.html Accessed January 2013

[10] http://www.noaanews.noaa.gov/stories2005/s2412.htm Accessed January 2013

[11] http://cdiac.ornl.gov/trends/emis/glo.html Accessed January 2013

[12] http://www.ncdc.noaa.gov/paleo/icecore/antarctica/vostok/vostok.html Accessed January 2013

[13] Randall, D.A., R.A. Wood, S. Bony, R. Colman, T. Fichefet, J. Fyfe, V. Kattsov, A. Pitman, J. Shukla, J. Srinivasan, R.J. Stouffer, A. Sumi and K.E. Taylor, 2007: Climate Models and Their Evaluation. In: Climate Change 2007: The Physical Science Basis. WG1, Fourth Assessment Report of the Intergovernmental Panel on Climate Change [Solomon, S. et al, (eds.)]. Cambridge University Press, Cambridge

[14] See Randall, D.A. et al, op cit p. 640: “A number of diagnostic tests have been proposed…but few of them have been applied to a majority of the models currently in use. Moreover, it is not yet clear which tests are critical for constraining future projections (of warming). Consequently, a set of model metrics that might be used to narrow the range of plausible climate change feedbacks and climate sensitivity has yet to be developed.”

[15] Spencer, R.W. and Braswell, W.D Potential Biases in Feedback Diagnosis from Observational Data: A Simple Model Demonstration, J Climate 21 5624-5627, 2008 DOI: 10.1175/2008JCLI2253.1

[16] Meehl, G.A., T.F. Stocker, W.D. Collins, P. Friedlingstein, A.T. Gaye, J.M. Gregory, A. Kitoh, R. Knutti, J.M. Murphy, A. Noda, S.C.B. Raper, I.G. Watterson, A.J. Weaver and Z.-C. Zhao, 2007: Global Climate Projections. In: Climate Change 2007: The Physical Science Basis. WG1, Fourth Assessment Report of the Intergovernmental Panel on Climate Change [Solomon, S., et al (eds.)]. Cambridge University Press, Cambridge

[17] Douglass, D. H., Christy, J. R., Pearson, B. D. and Singer, S. F. (2008), A comparison of tropical temperature trends with model predictions. Int. J. Climatol., 28: 1693–1701. doi: 10.1002/joc.1651

[18] Spencer, R.W. and Christy, J.R. 1992: Precision and Radiosonde Validation of Satellite Gridpoint Temperature Anomalies. Part I: MSU Channel 2. J. Climate, 5, 847–857.

doi: http://dx.doi.org/10.1175/1520-0442(1992)005<0847:PARVOS>2.0.CO;2 Accessed January 2013

[19] http://climexp.knmi.nl/data/pHadEWP_monthly_qc.dat Accessed January 2013

[20] http://www.psmsl.org/data/obtaining/rlr.monthly.data/12.rlrdata Accessed January 2013

[21] http://sealevel.colorado.edu/ Accessed January 2013

[22] Fischetti, M. Drowning New Orleans. Scientific American, October 2001, pp34-42

[23] http://rogerpielkejr.blogspot.com/2012/11/us-hurricane-intensity-1900-2012.htmlAccessed January 2013

[24] IPCC, 2012: Managing the Risks of Extreme Events and Disasters to Advance Climate Change Adaptation. A Special Report of Working Groups I and II of the Intergovernmental Panel on Climate Change [Field, C.B. et al (eds.)]. Cambridge University Press, Cambridge

[25] Goklany, I.M. Wealth and Safety: The Amazing Decline in Deaths from Extreme Weather in an Era of Global Warming, 1900–2010. Reason Foundation, Washington DC and Los Angeles, CA, 2011

http://reason.org/files/deaths_from_extreme_weather_1900_2010.pdf Accessed January 2013

[26] http://news.nationalgeographic.com/news/2004/01/0107_040107_extinction.htmlAccessed January 2013

[27] Cahill, A.E, Aiello-Lammens, M.E., Fisher-Reid, M.C., Hua, X., Karanewsky, C.J., Ryu, H.Y., Sbeglia, G.C, Spagnolo, F., Waldron, J.B., Warsi, O. and Wiens, J.J. How does climate change cause extinction? Proc. Royal Soc. B 2012 doi: 10.1098/rspb.2012.1890

http://rspb.royalsocietypublishing.org/content/early/2012/10/15/rspb.2012.1890.fullAccessed January 2013

[28]http://www.publications.parliament.uk/pa/ld200506/ldselect/ldeconaf/12/1207.htmAccessed January 2013

[29] Laframboise, Donna The Delinquent Teenager who was mistaken for the world’s top climate expert. Ivy Avenue Press, Toronto 2011. ISBN: 978-1-894984-05-8

[30] Soon, W. and Baliunas, S. Proxy climatic and environmental changes of the past 1000 years. Climate Research Vol. 23, pp89–110, 2003

[31] http://www.assassinationscience.com/climategate/1/climactic-research-unit-foi-leaked-data.zip Accessed January 2013

[32] http://www.co2science.org/data/plant_growth/plantgrowth.php Accessed January 2013

Related articles

C. F.