Doch das ruft, wie immer, "Umwelt- und Klimaschützer" auf den Plan, denen kein Grund zu naiv, kein Argument zu dumm ist, um diese reiche Energie- Quelle – auch in Deutschland- gleich wieder zu versiegeln. Billige Energie aus diesen Quellen – wie in den USA schon in Massen erschlossen- würde nämlich die "Erneuerbaren" im Vergleich noch unwirtschaftlicher machen. Und sie haben (noch) einigem Erfolg, denn die Tschechen und Franzosen haben Fracking erstmal verboten und die deutsche Regierung hat ein Moratorium verhängt. Andere Länder handeln konsequenter und erschließen sich diesen Zugang zu billiger Energie.

Unser Geologe und Talsperren-Spezialist Karl-Friedrich Ewert zeigt auf, was es mit der albekannten Technologie des Frackings auf sich hat.

Was ist Fracking ?

Als „Fracking“ wird die Methode bezeichnet, Erdgas oder Erdöl aus Schiefer und schiefer-ähnlichen Gesteinen zu gewinnen („Shale gas“), indem man diese Vorkommen anbohrt, unter hohem Druck Flüssigkeiten einpresst, um das ursprünglich dichte Gestein durchlässig zu machen und das in ihnen gespeicherte Gas oder Öl zu mobilisieren, damit es gefördert werden kann. Dieses Verfahren ist in den letzten Jahren bedeutungsvoll geworden – besonders auch deshalb, weil in den USA große Funde solcher Lagerstätten gemacht wurden und ausgebeutet werden. Man verspricht sich dort, bald unabhängig von Importen zu werden. Ähnliche Lagerstätten gibt es weltweit vielerorts, auch in Deutschland.

Warum sind Ölschiefer und Schiefergas bedeutungsvoll?

Erdgas und Erdöl bilden sich aus organischen Substanzen, die nach dem Absterben absinken und im Sediment begraben werden (Abb.1). Wenn unten im Wasser Sauerstoff (O2) fehlt, können die organischen Substanzen nicht verwesen, sondern werden umgelagert zu Kohlenwasserstoffen, z.B. Methan – (CH4).

Im Laufe langer geologischer Zeiten können bis zu vielen Kilometern mächtige Sedimentstapel abgelagert werden. Im Laufe dieser Zeiten ändern sich die Bildungsbedingungen, so dass nacheinander unterschiedliche Sedimentarten übereinander abgelagert werden. Ihr Gewicht übt Druck aus, der die jeweils unterlagernden Sedimente zu Gesteinen verfestigt. Wurden Sande abgelagert, wurden daraus poröse, also durchlässige Sandsteine. Aus feinkörnigen Tonen wurden dichte Tonsteine. Wenn sie Kohlenwasserstoffe enthalten, spricht man von Erdölmuttergesteinen.

Wenn in der Nachbarschaft der Erdölmuttergesteine poröse Gesteine vorhanden waren, konnten Erdöl und Erdgas dort eindringen und damit das Erdölspeichergestein bilden (Abb. 2), aus dem sich die ‚konventionelle’ Erdöllagerstätte entwickeln konnte. Wo die durchlässigen Speichergesteine fehlten, blieben Erdöl und Erdgas im Erdölmuttergestein bis heute gefangen. Wegen ihrer geringen Durchlässigkeit – oder gar Dichtigkeit – müssen sie aufgepresst werden, wenn man das Erdöl oder Erdgas gewinnen will.

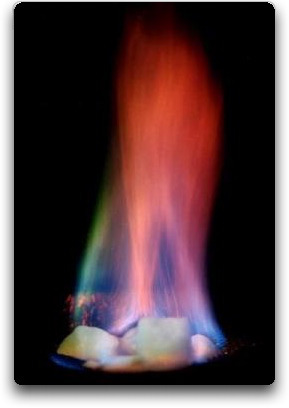

Das Erdölmuttergestein enthält Erdgas und Erdöl, meist in kleinsten Poren, manchmal in kleinen Taschen. Nur wo in Bohrungen – oder Stollen – erdölhaltiger Ölschiefer angetroffen und damit das Öl freigesetzt wird, kann es aussickern, wie Abb. 3 beispielhaft zeigt.

Vermutlich befand sich weltweit nur ein Teil der Erdölmuttergesteine in der Nachbarschaft von porösen Speichergesteinen. Wo das nicht der Fall war – und das ist der wahrscheinlich größere Teil – halten die Erdölmuttergesteine das in ihnen gespeicherte Erdöl und Erdgas gefangen, bilden also eine potentielle Öl- und/oder Gaslagerstätte. Ihr Öl- und Gasinhalt könnte den der konventionellen Lagerstätten übersteigen, ist aber wegen der sehr geringen Durchlässigkeit oder gar Dichtigkeit nicht in der üblichen Weise zu gewinnen – es fließt weder von alleine heraus noch lässt es sich mit Abpumpen gewinnen. Um diese Lagerstätten auszubeuten, wird das Gestein mittels Fracking aufgebrochen. Geotechnische Details dazu werden im Anhang skizziert.

Gefährdung von Grundwasser ?

Unsere Grundwasservorkommen befinden sich in der Regel in Tiefen oberhalb 100 m, während die Gas- und Öllagerstätten in sehr großen Tiefen liegen. Zwischen beiden Bereichen befinden sich in den meisten Fällen dichte wassernichtleitende Gesteinszonen mit Mächtigkeiten von einigen hundert Metern, so dass diese Lagerstätten ausgebeutet werden können. Wo diese Bedingung nicht erfüllt ist, könnte Fracking erst dann eingesetzt werden, wenn Clean Fracking entwickelt wurde und sich als übliche Technologie etabliert hat.

Erfahrungen

Fracking wird in USA seit 1949 praktiziert. In 2008 wurde Fracking in den USA ca. 50.000 mal eingesetzt. Wir haben es also mit einer etablierten Technologie zu tun. Es ist zu erwarten, dass die USA nicht nur von Öl- und Gasimporten unabhängig werden, und außerdem sogar exportieren können. Die Preise für Öl und Gas sind in den USA schon kräftig gefallen

Der Aufwand zur Förderung von Erdgas und Erdöl ist größer als bei der konventionellen Förderung, denn es werden mehr und manchmal auch tiefere Bohrungen benötigt – auch, weil die Reichweite der nutzbaren Lagerstätte in der Umgebung einer Bohrung kleiner ist. Wegen des größeren Technischen Aufwandes ist gegenwärtig die Wirtschaftlichkeit noch geringer, allerdings ist das Entwicklungspotential noch nicht ausgeschöpft.

Beurteilung

Die Gewinnung von Erdöl und Erdgas aus öl- und gashaltigen Tonstein und Schieferton erfordert zwar eine aufwendigere Technik, sollte aber in Anbetracht der Möglichkeit, die Abhängigkeit Deutschlands von Importen zu verringern, nicht versäumt werden. Dabei sollten jene Lagerstätten ausgebeutet werden, die durch ausreichende Barrieren von Grundwasservorkommen getrennt sind. Wirtschaftlichkeitszwänge werden es sehr wahrscheinlich ermöglichen, die Technologie weiter zu entwickeln und dabei zu verbessern.

Anhang: Geotechnische Grundlagen zum Fracking

Der Autor hat „Hydraulic Fracturing“ (HF), wie es zutreffend genannt wird, beim Talsperrenbau kennen gelernt; es beschäftigt ihn seit 1964, also seit ca. 50 Jahren. Der Fels unter einer Staumauer (Staudamm) sollte möglichst dicht sein. Zeigen Untersuchungen, dass er durchlässig ist, wird er abgedichtet, indem man Zementsuspensionen einpresst, die offene Klüfte (Wasserwege) verfüllen sollen. Falls der Einpressdruck zu hoch ist, werden jedoch auch geschlossene Trennflächen (Schicht-, Schiefer- oder Kluftflächen) aufgepresst und wieder injiziert. Damit das vermieden wird, darf der Druck nicht zu hoch sein, denn sonst verursacht die Wiederverfüllung aufgepresster Fugen erhebliche Mehrkosten. Wie die Abbildungen 4 und 5 zeigen, richten sich die jeweils richtigen Drücke nach der Gesteinsfestigkeit. Die zweckmäßigen Drücke werden mittels Wasserdruck-(WD)-versuchen bestimmt (Abb. 4, links).

Das in Abb. 4 dargestellte Gestein enthält weiche Tonsteinlagen, die im Versuch schon bei 3 bar aufgerissen werden, was hier anfangs geschehen ist. Der eingepresste Zement hat infolge HF die ursprünglich geschlossenen (latenten) Schichtflächen geöffnet und die so entstandenen Fugen wurden mit Zement gefüllt. Obwohl mit 3 bar sehr niedrig, hat dieser Druck einen sehr großen Zementverbrauch verursacht und die Abdichtungsmaßnahme enorm verteuert.

Der in Abb. 5 dargestellte Tonschiefer enthält geschlossene Schieferflächen, die wegen der größeren Festigkeit erst bei einem kritischen Druck von 12 bar aufgerissen werden. Wegen dieser Festigkeit bleiben die eingepressten Zementlagen dünn.

Die Lagerstätten liegen zumeist in Tiefen von vielen hundert Metern. Entsprechend tief müssen die Bohrungen sein. Um das Gestein aufzubrechen, wird Wasser eingepresst, wobei der Druck – anders als bei der Abdichtungsinjektion – den kritischen Aufreißdruck deutlich übersteigen muss. Damit sich die aufgepressten Fugen nicht wieder schließen können, wird dem Wasser Sand beigemischt – die Sandkörner setzen sich in den Fugen ab und halten sie geöffnet (Abb. 6).

Außer Sand sorgen dem Wasser zugesetzte ‚Chemische Additive“ dafür, dass die gespeicherten Öl- und Gasmoleküle mobilisiert werden. Wasser, Sand und Additive bilden die „Fracfluide“.

Als Additive wird eine Vielzahl von Chemikalien eingesetzt, je nach den Gesteinsarten und der Aufgabe. Viskositätserhöhung, Schaumbildung, Lösung von Mineralen, etc . z.Zt. kommen noch toxische Komponenten zum Einsatz. Der Ersatz durch nichttoxische Additive wird gegenwärtig erprobt – ‚Clean Fracking’

Früher wurde angenommen, dass die kritischen Drücke, die das Fracking verursachen, mit der Tiefe steigen. Eine systematische Untersuchung an Hand von zahlreichen Beispielen aus praktisch allen Gebirgstypen hat in den letzten Jahren jedoch gezeigt, dass dies nicht der Fall ist [1]. Wie Abb. 7 zeigt, steigen die Drücke nicht mit der Tiefe an.

Literaturhinweise

[1] Ewert F.-K. (2005): The hydrofracturing behaviour of latent discontinuities in rock and its consequences for the successful and economic execution of grouting work. Dam Engineering, Volume XVI, Issue I, P 4 – 65, 42 Figures, 5 Tables; Wilmington Business Publishing Ltd, 2005

F.K. Ewert EIKE

Der Beitrag kann auch als pdf im Anhang heruntergeladen werden.

Weitere links zum Thema von ACHGUT:

Britain could have enough shale gas to heat every home for 1,500 years, according to new estimates that suggest reserves are 200 times greater than experts previously believed. The British Geological Survey is understood to have increased dramatically its official estimate of the amount of shale gas to between 1,300 trillion and 1,700 trillion cubic feet, dwarfing its previous estimate of 5.3 trillion cubic feet.—

Deutsche Energie ‘Experten’: Fracking lohnt sich in Europa nicht – In Europa ist trotz ebenfalls großer Schiefergas-Vorkommen kaum mit einer wirtschaftlichen Ausbeutung dieser Lagerstätten in den kommenden Jahren zu rechnen. Zu diesem Ergebnis kommen deutsche Energieanalysten vom Zentrum für Europäische Wirtschaftsforschung (ZEW) in Mannheim.

gefunden auf Glitzerwasser hier

Und in einem Kommentar auf Science Sceptical schreibt Rudolf Kipp dazu:

Das UBA sprach sich wegen der unsicheren Datenlage dagegen aus, Fracking in Deutschland großtechnisch zu betreiben (hier die damalige Berichterstattung auf SpOn und Welt). Diese Einschätzung erlebte jedoch heftigen Widerspruch von Seiten der Bundesanstalt für Geowissenschaften und Rohstoffe (BGR). In ihrem Gutachten im Sommer letzten Jahres zu unkonventionellen Gasvorkommen in Deutschland fanden sie (wir berichteten damals):

“Die Risiken von Fracking-Maßnahmen im geologischen Untergrund stellen sich im Vergleich zu möglichen Unfällen bei obertägigen Aktivitäten als gering dar. durch standortbezogene Voruntersuchungen können Fracking-Maßnahmen so geplant werden, dass ein unkontrolliertes Entweichen der Fracking-Fluide aus dem unterirdischen Riss in angrenzende Formationen mit sehr hoher Wahrscheinlichkeit ausgeschlossen werden kann.”

In einer Gegendarstellung warfen die Geologen vom BGR dem UBA vor, wissenschaftlich ungenau zu arbeiten und Tatsachen zu ignorieren. Es sei im UBA-Gutachten „durchgängig erkennbar, dass es federführend von Hydrogeologen verfasst wurde, deren Expertise im Themenfeld oberflächennaher Grundwasserleiter liegt“. Beim Thema Fracking gehe es aber um viel tiefere Schichten. Das oberflächennahe Grundwasser, das der Trinkwassergewinnung diene, stehe mit den tiefen Geosystemen, in denen das Gas lagert, „meistens nicht in Verbindung“.

Die unterstellte Gefährdung des Grundwassers wäre demnach weitaus weniger relevant als im Gutachten unterstellt. Außerdem kritisieren die Geowissenschaftler, die UBA-Gutachter machten unzutreffende Aussagen zum Gefährdungspotenzial der Chemikalien, die beim Fracking zum Einsatz kommen. Insgesamt würde der (falsche) Eindruck erweckt, dass generell erhebliche Wissensdefizite über den geologischen Untergrund bestehen.

Update 1 aus ACHGUT (11.2.13).

Beim Kreisparteitag in Lütjensee hat sich die SPD Stormarn gegen die Gewinnung von Erdgas- und Erdöl mit der sogenannten Fracking-Methode ausgesprochen. Mit großer Mehrheit folgten die Delegierten einem Antrag von Sigrid Kuhlwein, Kreistagsabgeordnete aus Ammersbek, die Tiefbohrungen generell und insbesondere auf Stormarner Gebiet abzulehnen. Die Grünen haben bereits eine ähnliche Forderung erhoben.

Unternehmenschefs sehen den Produktionsstandort Deutschland durch die niedrigen Energiepreise in den USA in Gefahr. Sie betragen dort inzwischen nur noch ein Drittel des Niveaus in Deutschland. “Viele Industriekonzerne planen, wegen der niedrigen Energiepreise neue Fabriken nicht mehr in Europa, sondern in den USA zu bauen”, sagte Gisbert Rühl, Chef des Stahlhändlers Klöckner.

Update 2 (12.2.13)

Altmaier fordert strenge Regeln für Gas-Fracking

Während in den USA der Run auf Gasreserven in tiefen Gesteinsschichten losbricht, denkt Bundesumweltminister Altmaier (CDU) über strenge Auflagen und ein eventuelles Verbot des Verfahrens nach. Die FDP warnt derweil vor "ideologischen Vorbehalten".

"Die Welt": …"Peter Altmaier Zitat: "Die Botschaft ist: Wir wollen das Fracking einschränken, wir wollen es nicht ermöglichen." Quelle: http://tinyurl.com/cokju8a

Update 3 (13.2.13):

Um die Beziehungen zwischen Fracking und der Erdölgewinnung detaillierter zu beschreiben, sind einige grundlegende Begriffe zu verdeutlichen: Die als tierisches (=Erdöl) oder pflanzliches (=Erdgas) Ausgangsmaterial zur Ablagerung in Sedimentationsbecken gelangenden Kerogene werden bei allmählich zunehmender Auflast nach für gewöhnlich einigen Jahrmillionen und bei steigenden Formationstemperaturen aus ihren sie begleitenden Muttergesteinen, d.h. Tonen oder Kalken, in die über oder unterlagenden porösen Speichergesteine gepreßt. Erdölgeologisch "migrieren" sie in Speichergesteine. Während die Muttergesteine dicht und nur durch einen marginalen Porenraum von vielleicht 2-8% gekennzeichnet sind, können die Speichergesteine eine Porostiät von bis zu 35% besitzen, so daß die Kohlenwasserstoffe durch konventionelle Aufschlußmethoden gefördert werden können. Der Entölungsgrad liegt hier gewöhnlich nur bei etwa 30%, es sei denn, man erhöht den Entölungsgrad durch den Einsatz von heißem Wasser oder sogar nicht-toxischen Chemikalien, um die durch Adhäsionskräfte an die Kalk- oder Sandkörner gebundenen Kohlenwasserstoffe zu überwinden. In günstigen Fällen kann somit der Entölungsgrad auf etwa 45% oder optimal sogar 50 % gesteigert werden. Unterirdische Hohlkörper, in denen sich ebenfalls Kohlenwasserstoffe sammeln können, gibt es nicht. Es sei denn, man sieht von den sehr porösen Riffkörpern ab, bei denen die Korallen ein festes Gerüst und damit außergewöhnlich große Porenvolumina bilden können. In manchen tektonisch beanspruchten Gebieten sind auch Speicher – und Muttergesteine durch Klüfte, also kleine Risse, gekennzeichnet. Aber auch diese bilden keine Hohlräume, da sie sekundär durch entweder Kalkspat oder Quarz gefüllt sind. Hohlräume gibt es unterirdisch nicht, es sei denn, es liegen außergewöhnliche geologische Bedingungen vor.

Während die konventionellen Bohrtechniken durch vertikale Bohrungen gekennzeichnet sind, die direkt auf die Speichergesteine zielen, folgen bei der Frackingmethode die Bohrungen genau den durch verschiedene tektonischen Bewegungen verstellten Kohlenwasserstoff-führenden Gesteinen und sind hierbei – und das ist das eigentlich Neue an dieser Methode – auf die relativ dichten Muttergesteine gerichtet.

Es sei hier auch auf den irreführenden Begriff "Schiefer" verwiesen, der aus dem Englischen "shale" falsch übersetzt wird. In der Diagenese, der Verfestigung der Sedimente, wird im Deutschen aus einem Ton ein Tonstein, dann ein Schiefer (d. h. das ist der normalerweise bei uns gebräuchliche Dachschiefer, der also geschieferrt ist) und dann bei höchster tektonischer Beanspruchung letzendlich der Gneis. Und bei Kalk geht die Diagenese von diesem über Kalkstein zu Kalkschiefer und dann zu Marmor. Das Fracking zielt also z. Zt. nur auf Tonstein (=shale) oder Kalkstein ab, nie auf den "richtigen" Schiefer.

Autor: Dr. Klaus Jürgen Goldmann; Erdöl-Geologe; EIKE

Update 4

Soeben erschien von PWC eine sehr positive Studie zum Fracking in Deutschland. Die FAZ berichtet daraus:

Schieferöl könnte Deutschland reicher machen

18.02.2013 · Eine neue Studie belegt: Kaum ein Land würde so stark vom Ölfracking profitieren wie die Bundesrepublik. Das größte Förderpotential sehen Experten in Polen. Doch die Methode ist hoch umstritten.

Von MARCUS THEURER, LONDON

.. Deutschland als drittgrößter Profiteur

Deutschland als großes Ölimportland würde vom niedrigeren Weltmarktpreis überdurchschnittlich profitieren, selbst wenn hierzulande auf die Schieferölförderung aus Umweltschutzgründen verzichtet würde. Zwischen 2 und 5 Prozent höher könnte die deutsche Wirtschaftsleistung dadurch zur Mitte des übernächsten Jahrzehnts ausfallen. Von den führenden Volkswirtschaften wäre Deutschland damit nach Schätzung von PwC hinter Indien und Japan der drittgrößte Profiteur einer möglichen Schieferölschwemme. Verlierer wären dagegen vor allem die Mitglieder des Ölförderkartells Opec wie Saudi-Arabien, Nigeria und Venezuela….

Mit Dank an Spürnase Dr. K. Goldmann

Related Files