Alle Parteien sind sich einig. Die DDR läßt grüßen.

Die Verbindung von großspurigen Phantasiezielen und völliger Unfähigkeit der Ministerialbürokratie zur Ablieferung seriöser Arbeit; die zahllosen Fehlentscheidungen und hilflosen Reparaturmaßnahmen, die immer weiter getriebene Planwirtschaft – und alles kritiklos von einem Parlament und einem Bundesrat abgesegnet, dessen Mitglieder nur an Stücken vom Subventionskuchen interessiert sind – führen unweigerlich in eine Wirtschaftskatastrophe, die mit einem Exodus der Industrie und der Verarmung der Bevölkerung einher geht (1). Weil es dagegen – abgesehen von der sächsischen FDP, die hier die Rolle des gallischen Dorfes einnimmt – keine politische Opposition gibt, wird der Karren ungebremst an die Wand gefahren. Die Lage wird sich noch durch den Verlust der schwarz-gelben Mehrheit im Bundesrat weiter verschlimmern, weil nun die rot-grüne Mehrheit alle Versuche der Regierung, irgend etwas Substantielles am EEG abzuändern, abschmettern wird.

Das Fatale an dieser Situation ist die große Einmütigkeit aller politischen Parteien in ihren Bekenntnissen zur Merkelschen Energiewende, die einerseits sehr an das Märchen von des Kaisers neuen Kleidern erinnert, andererseits aber auch an die pflichtgemäßen Kampf- und Siegesparolen und Gelöbnisse in der DDR. Diese Haltung wird von den Medien überwacht, die Abweichler und Gegner der Energiewende an den Pranger stellen. Die regierungsfrommen Bekenntnisse insbesondere aus den Verbänden erreichten einen Tiefpunkt mit der wiederholten Behauptung, die Energiewende sei „unumkehrbar“. Anscheinend haben sich diese Leute von der Demokratie verabschiedet, in der nun einmal alles, was einmal eine Mehrheit beschloß, auch wieder geändert oder auch abgeschafft werden kann. Sie sind zu gehorsamen Befehlsempfängern geworden.

Es gibt keine politische Kraft in Deutschland, die die Kritik an der gegenwärtigen Energiewendepolitik zu ihrem Programm gemacht hat. Oder kennt jemand eine Partei, die z.B. diejenigen Bürger vertritt, die die Nutzung der Kernkraft befürworten ? Ihre Zahl ist beachtlich, wie es eine Befragung der BILD-Zeitungs-Leser am 16.10.2012 zeigte: Auf die Frage „Ökostrom wird immer teurer. Wollen Sie die Atomkraft zurück ?“ antworteten 118.827 Leser mit „Ja“ – das waren 65% der Antworten (2). Verglichen mit der bei allen Meinungsumfragen typischen Zahl der Befragten von ein- bis zweitausend haben wir hier die ein Votum, das mehr als hundertfach so stark ist. Diese Bürger haben aber keine politische Vertretung, denn es gibt keine Partei, die sie wählen könnten.

Weil alle Parteien einstimmig das Loblied der Energiewende singen, ist es auch gleichgültig, welche Regierung in welcher Konstellation ab Herbst 2013 an die Macht kommen wird: Sie würde die jetzige Politik weiter führen; allenfalls noch verschärft, wenn die Grünen wieder das Umweltministerium erhalten sollten, das schon jetzt weitgehend von ihren Vertrauten beherrscht wird.

Deshalb ist es auch aussichtslos, jetzt oder auch später auf Gesetzesänderungen zu hoffen, mit denen die schlimmsten Fehler der bisherigen Energiepolitik revidiert werden könnten. Niemand wird dazu eine Initiative ergreifen. Alle werden sich mit Warten und Gesundbeten begnügen. Wenn erst die Medien von ihrer bisherigen Energiewende-Propaganda auf Kritik umschalten, wird es längst zu spät sein.

Das ist der Grund für das sehr wahrscheinliche Eintreten der Wirtschaftskatastrophe als Endpunkt der Energiewende. Erst nach dem endgültigen, nicht mehr zu leugnenden Bankrott werden die Politiker umschalten: Sie werden sich dann etwa ein Jahr lang mit gegenseitigen Vorwürfen und Schuldzuweisungen beschäftigen. SPD, Linke und Grüne werden dann wie üblich die Multis der Sabotage an der schönen Energiewende beschuldigen..

Ein Sandkastenspiel

Man könnte nun sagen, daß die Deutschen es nicht besser verdient haben. Wenn sie so dumm sind, sich eine solche Politik, die sie arm macht, widerstandslos gefallen zu lassen, dann geschieht es ihnen recht.

Das Ärgerliche daran ist, daß die meisten Leute, die schon heute, aber erst recht in naher Zukunft unter den fatalen Folgen der angstbegründeten, ideologischen Politik leiden müssen, nur die Opfer einer riesigen Manipulation und Falschinformation sind – und daß Armut und Elend eine ungerechtfertigte Strafe für sie sind.

Wie könnte ein Gegenmodell einer fiktiven Opposition zur jetzigen Energiewendepolitik aussehen ?

Ein Sandkastenspiel: Man stelle sich vor, daß es eine Partei gibt, die tatsächlich an die Marktwirtschaft glaubt. Es ist ja nur eine Fiktion. Sie hat auch einmal an die Freiheit des Bürgers geglaubt und lehnte deshalb früher viele staatlichen Zwänge ab, die sich die Bürokraten immer wieder ausdachten. Sie ist klein, schlecht geführt und orientierungslos. Merkwürdigerweise ist sie – zumindest bis gegen Herbst dieses Jahres – sogar als fünftes Rad am Wagen in der Regierung, weiß aber nicht mehr, weshalb. Sie hat brav alles unterschrieben, was ihr die Regierungschefin vorlegte und gehört deshalb auch zu den Energiewende-Unterstützern, ist dabei aber nicht überzeugend, weil eigentlich keiner so recht daran glaubt, es aber auch nicht besser weiß.

Weil sie auf diese Weise der großen Mehrzahl der Bürger ihre Überflüssigkeit vorgeführt hat, wird sie sehr wahrscheinlich nach der großen Wahl als außerparlamentarische Kleinpartei ihr Dasein fristen.

Geben wir ihr die Arbeitsbezeichnung „Liberale Partei“; kurz LP.

Das Sandkastenspiel geht nun von folgenden höchst unwahrscheinlichen Voraussetzungen aus:

1. Der sächsischen LP gelingt es, in der Grundsatzdebatte nach der verlorenen Bundestagswahl 2013, ihre Vorstellungen zur Energiepolitik durchzusetzen.

2. Die Partei hat die Situation analysiert und akzeptiert, daß es keinen Weg geben kann, der die deutsche Energiepolitik in den Zustand von 1990 zurückversetzen würde. Man stellt fest, daß man die „erneuerbaren“ Stromerzeugungsanlagen, die bereits existieren, nicht per Verschrottungsgesetz beseitigen kann, obwohl das für einen erheblichen Teil derselben das Richtige wäre. Man anerkennt ferner, daß man den Irrglauben an die Richtigkeit des weiteren Ausbaus der „Erneuerbaren“ wegen der jahrelangen Manipulation der Bevölkerung nicht mehr heilen kann. Möglich wäre aber ein sehr behutsamer Ausbau der Erneuerbaren unter neuen Bedingungen: Mit Schwerpunkt auf der Wärmeerzeugung und mit einer Stabilisierung der fluktuierenden Wind- und Solarstromeinspeisungen aller Anlagen durch zusätzliche technische Maßnahmen. Ferner die Zurücknahme aller marktfeindlichen und planwirtschaftlichen Instrumente, die der Staat mittlerweile geschaffen hat. Weiterhin die Zurücknahme des Kernenergie-Ausstiegs, womit man ein wunderschönes Gegenprogramm zu allen anderen Parteien hätte.

Wichtige Ziele dieses Programms wären: Wiederherstellung einer zuverlässigen Stromversorgung, drastische Senkung des Strompreises, Beendigung aller teuren Privilegien für Energietechniken, faire Zusammenarbeit mit den Nachbarländern in der Energiepolitik.

Das Programm sollte einen eingängigen Namen erhalten: Vielleicht „Energiewende Light“. Das Protestgeschrei der grünen Medienredaktionen wäre eine willkommene Werbung für die Partei.

Das Programm „Energiewende Light“

Teil 1: Änderungen der bisherigen Energiepolitik

Anm.: Maßnahmen sind in Fettdruck hervorgehoben.

Strompreise

Trotz der berechtigten Kritik an der rasch steigenden EEG-Umlage im Strompreis ist die Hauptsünde der Energiepolitik älteren Datums: Seit Jahren belastet der Staat die Energie in einem immer weiter steigenden Umfang. Über die Folgen hat sich bisher keine der dafür verantwortlichen Regierungen Gedanken gemacht. Die in die Kritik geratene, schnell ansteigende EEG-Umlage ist jedoch nur ein Teil dieser Abschöpfung von Bürger-Kaufkraft und Unternehmensgewinnen.

Nach Schätzung des Bundesverbandes der Energie- und Wasserwirtschaft BDEW entfällt ab 2013 allein 51 % des Strompreises auf Steuern, Abgaben und staatlich verordnete Umlagen (z.B. EEG-Umlage). Dies kostet die Verbraucher über 30 Milliarden jährlich – 7 Mrd. Euro mehr als im Vorjahr. Deshalb ist die dringendste Maßnahme die kräftige Senkung dieser Belastungen: Sie sind um 40% zu reduzieren.

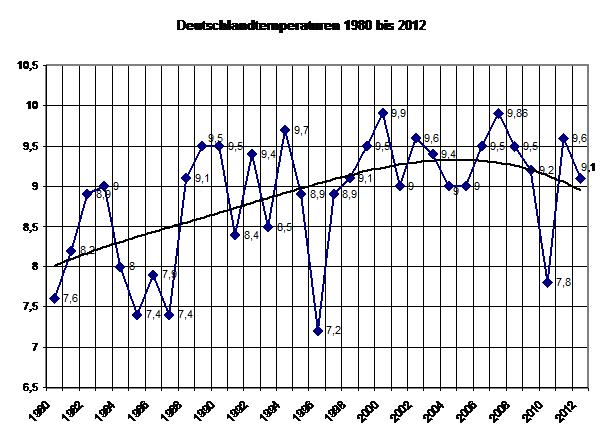

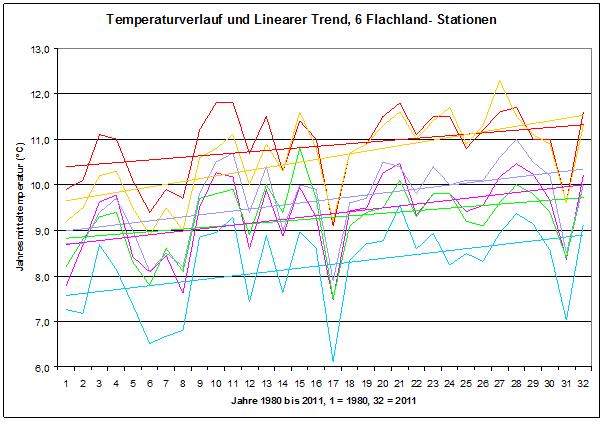

Klimawandel

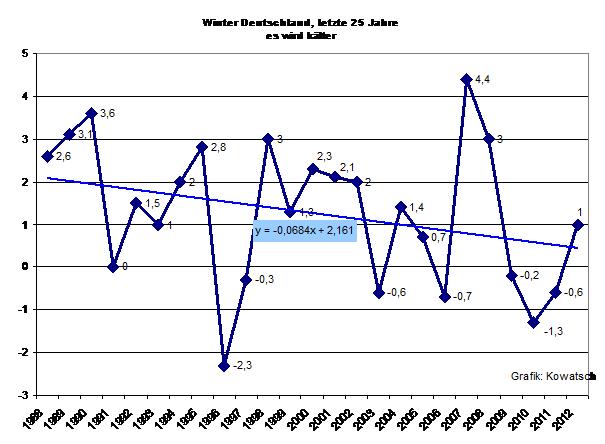

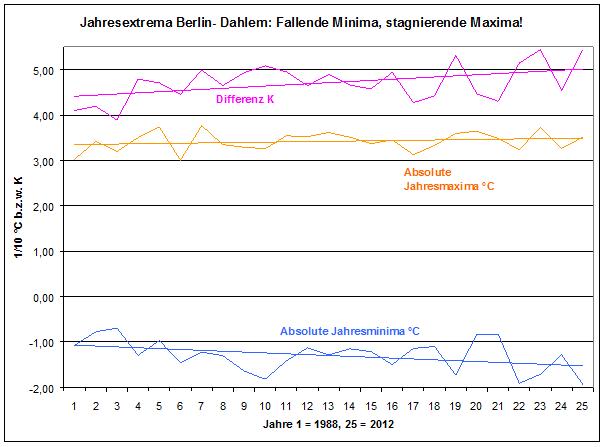

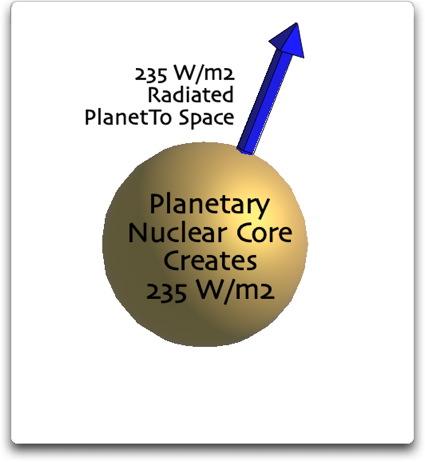

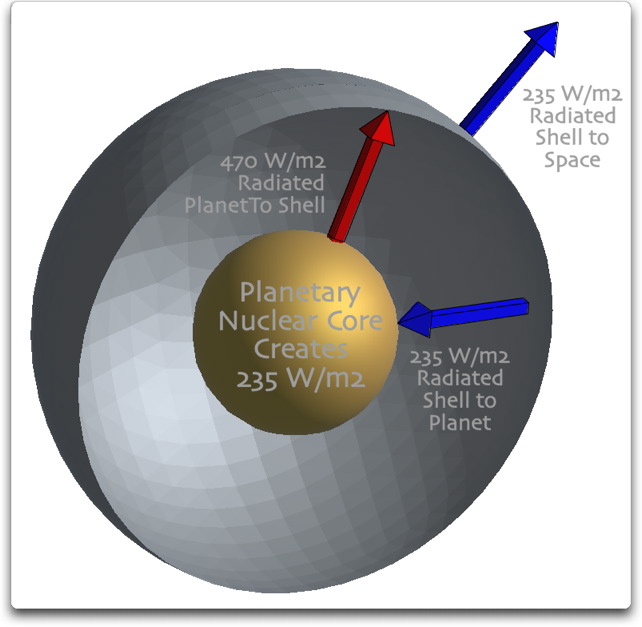

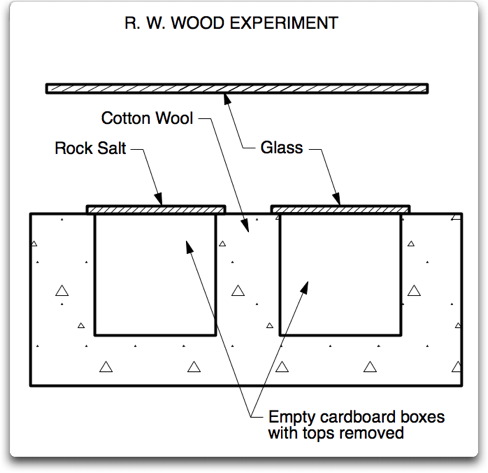

Die Begründung eines angeblich vom Menschen durch seine CO2-Emissionen verursachten Klimawandels und damit der angeblichen Notwendigkeit drastischer CO2-Einsparungen wird angesichts des seit 1998 festgestellten Ausbleibens eines globalen Temperaturanstiegs als widerlegte Theorie fallen gelassen. Damit entfällt das bisherige, wesentliche Argument für die Bevorzugung der sog. Erneuerbaren Energien. Alle direkt dazu dienenden Maßnahmen werden beendet – z.B. der Emissionshandel und technische Maßnahmen wie die Abtrennung und Einlagerung von CO2.

Die weitere Verringerung des Verbrauchs an fossilen Brennstoffen bleibt eine permanente Aufgabe – aber nicht zur Rettung der Welt vor einer nicht drohenden Katastrophe.

Kernkraftwerke

Der rein parteitaktisch betriebene Ausstieg aus der Kernkraft wird rückgängig gemacht. Es wird daher keine weitere vorzeitige Abschaltung von Kernkraftwerken geben. Von den 8 stillgelegten Kernkraftwerken werden 4 sofort wieder in Betrieb genommen; die übrigen nach eventuell noch zweckmäßigen Modernisierungsmaßnahmen ihrer Sicherheitseinrichtungen.

Damit wird die Zerstörung einer bedeutenden, sicheren und kostengünstigen Grundlasterzeugungs-Kapazität unterbunden.

Die Anfang 2011 beschlossenen Laufzeitverlängerungen werden wieder in Kraft gesetzt.

Damit entfällt jede Notwendigkeit, Kraftwerksbetreiber zum Weiterbetrieb unrentabler Kohle- und Gaskraftwerke zu zwingen, wie es die Regierung plant.

Die Bundesregierung beginnt, die Entwicklung fortschrittlicher Reaktortechnologien der 4. Generation zu fördern und tritt der Internationalen Arbeitsgemeinschaft aller anderen Industrieländer, die dieses Ziel verfolgt, bei.

Das Stromnetz

Die Sicherheit und Stabilität der Stromversorgung muß durch erweiterte Eingriffsmöglichkeiten der Netzbetreiber gegen destabilisierende und gefährliche Stromeinspeisungen wieder sichergestellt werden.

Zunächst wird das Kernstück des EEG, die vorrangige Einspeisung der dort genannten sog. Erneuerbaren Stromerzeuger, abgeschafft. Auch die im EEG enthaltene Regelung, daß bei einer Ablehnung der Stromeinspeisung eine Entschädigung gezahlt werden muß, wird gestrichen.

Die Netzbetreiber erhalten das Recht, bei einem die Netzstabilität beeinträchtigenden Überangebot an Strom die Einspeisung von Wind- und Solarstrom abzulehnen. Sie können das ebenfalls tun, wenn durch ein Überangebot an Strom ein Absinken des Börsenpreises unter die Rentabilitätsschwelle von Kohle- oder Gaskraftwerken sowie Pumpspeicherkraftwerken eintritt. Damit wird vermieden, daß durch die ungebremste, chaotisch fluktuierende Stromeinspeisung der „Erneuerbaren“ das Kerngerüst einer stabilen Stromversorgung beschädigt wird.

Eine zweite Voraussetzung ist die Stabilisierung und Vergleichmäßigung der Windstromeinspeisungen durch Stromspeicher (s.u.). Entsprechendes gilt für Photovoltaikanlagen. Damit wird dafür gesorgt, daß der EEG-Strom dann lieferbar ist , wenn der Strom auch gebraucht wird – und nur dann werden die EEG-Vergütungen bezahlt.

Über einen eventuell noch nötigen Netzausbau kann erst entschieden werden, wenn die oben beschriebenen erweiterten Eingriffsmaßnahmen der Netzbetreiber ihre Wirkung erreicht haben, sich die abgeschalteten Grundlastkraftwerke sowie ausreichende Speicher für die schwankenden Einspeisungen im Netz befinden und das Stromversorgungssystem damit sicher und stabil geworden ist.

Dieser dann tatsächlich noch nötige Netzausbau und dessen Verwirklichung ist wiederum eine Voraussetzung für einen weiteren Zubau von Windkraftanlagen mit Speichern.

Ein derartiger, behutsamer Netzausbau würde weder die Bürger auf die Barrikaden treiben, noch hohe Kosten verursachen.

Stromspeicher

Die Regierung hat bei ihrer massiven Förderung der Tageslicht- und Wetterabhängigen und daher für die Stromversorgung prinzipiell ungeeigneten Stromerzeugungstechniken Windkraft und Photovoltaik jahrelang ignoriert, daß von Anfang an – das heißt bereits seit Einführung des EEG – riesige Stromspeicher zum Ausgleich der systembedingten starken Schwankungen des eingespeisten Wind- und Solarstroms erforderlich gewesen wären, die es aber weder damals gab noch heute gibt. Die existierenden Pumpspeicherkraftwerke reichen bei weitem nicht aus. Damit war ein Ausgleich dieser Schwankungen von vornherein ausgeschlossen. Eine Möglichkeit für den Aufbau von Speichern, die endlich das System stabilisieren könnten, gibt es erst seit Kurzem (s.u. Lit.(3)). Eine Verschärfung dieses Problems: Kernkraftwerke, die eine hohe Regelungsfähigkeit ihrer Leistung bieten und zur Netzstabilisierung bestens geeignet sind, wurden und werden seit 2011 abgeschaltet. Gas- und Kohlekraftwerke mußten für den Ausgleich der Schwankungen einspringen, was inzwischen ihre Wirtschaftlichkeit ruiniert. Außerdem steigen mit dieser ständig stark variierenden Betriebsweise Verschleiß und Reparaturanfälligkeit. Die Stabilität des Netzes nimmt weiter ab, aber dennoch wird der auf Kosten der Verbraucher erfolgende Ausbau der unberechenbaren Wind- und Solarstromanlagen – nach wie vor ohne Absicherung durch Speicher – unvermindert fortgesetzt. Damit ist der Weg in die doppelte Katastrophe – die Versorgungssicherheits-Katastrophe und die Stromkostenkatastrophe – vorgezeichnet, wenn nicht sehr bald ein radikaler Kurswechsel erfolgt..

Aus diesem Grunde ist bei der Behandlung der „volatilen“, d.h. unzuverlässigen Wind- und Solarstromerzeuger eine Änderung der Politik erforderlich.

Die Entwicklung verbesserter Stromspeicher wird gefördert. Es werden jedoch keine Stromspeichertechniken mehr in ihrer Entwicklung gefördert, die einen Energieverlust des Gesamtsystems von mehr als 55% aufweisen. Die Wasserstofferzeugung mit Windstrom erfüllt diese Anforderung gerade noch; die Wiederverstromung dieses Gases bedeutet eine Energievernichtung von 70 – 90% und ist damit förderungsunwürdig.

Zur Entwicklung großer Wärmespeicher s.u.

A.) Speicher für Windkraftanlagen

Generell gilt: Netzausbau vor Ausbau der Windkraft. Erst wenn das Stromnetz, an das neue Windkraftanlagen angeschlossen werden sollen, ausreichend dimensioniert ist, wird ein weiterer Zubau gestattet.

Der Zubau von Windkraftanlagen wird zusätzlich von einem gleichzeitigen Zubau ausreichender Stromspeicher abhängig gemacht. Alternativ kann diese Verpflichtung auch durch die Auslands-Akquisition von Stromspeicher-Kapazitäten erfüllt werden. Als ausreichend wird ein Stromspeicher akzeptiert, wenn er die Maximalleistung einer Windkraftanlage 3 Stunden lang speichern kann.

Weil die große Zahl bereits existierender Windkraftanlagen eine permanente Gefährdung der Netzstabilität darstellt, müssen auch diese nachträglich mit ausreichenden Stromspeichern ausgerüstet werden. Dafür wird eine Übergangszeit eingeräumt, innerhalb derer die Netzbetreiber durch Abschaltungsmaßnahmen die Gefährdung der Netzstabilität durch Windkraftanlagen ohne Stromspeicher unterbinden müssen.

Die Betreiber von Windkraftanlagen haben somit die Wahl, entweder ihre Anlagen mit Stromspeichern aufzurüsten, oder beträchtliche Stillstandzeiten hinzunehmen.

Die Stromspeicher wären privat zu finanzieren, allerdings könnten das die Betreiber aus den in diesen Fällen nicht gekürzten Einspeisevergütungen bezahlen.

Seit es konkrete Vorschläge für geeignete Stromspeicher gibt, die ohne größere technisch-wirtschaftliche Risiken in großer Anzahl gebaut werden könnten, ist der beschriebene Weg frei geworden.

(Anm.: Es handelt sich um oberirdische Druckluftspeicher nach den Vorschlägen von U. Dämgen, Fa. Boge Kompressoren, Bielefeld (3) )

B.) Speicher für Solarstromanlagen

Die oben beschriebene Verpflichtung, Windkraftanlagen mit Stromspeichern nachzurüsten, wird auch für existierende große Photovoltaik-Freilandanlagen eingeführt.

Falls Einzelanlagen weiterhin zur Einspeisung des Stroms in das Netz verwendet werden, werden auch hierfür Stromspeicher vorgeschrieben. Für Einzelanlagen werden bereits Batteriespeicher angeboten, die vor allem den Zweck haben, den erzeugten Solarstrom selbst zu nutzen (4). Dies stellt für die Betreiber die Möglichkeit entweder zu einer langsameren, kontrollierten Stromabgabe an das Netz oder den Selbstverbrauch ohne Netzstörung dar.

Mit diesen Nachrüstungen von Stromspeichern für Wind- und Solarstromanlagen muß ein großes Versäumnis der Politik nachgeholt werden, um in der Stromversorgung wieder normale Verhältnisse herzustellen.

Diese unverzichtbare Nachrüstung befördert die Stromerzeugungstechniken Windkraft und Photovoltaik auf ein Kostenniveau, das ihnen zukommt; das sie also tatsächlich von Anbeginn an aufwiesen.

Auf der Positivseite dieser Nachrüstung ist zu vermerken:

– Die Risiken für eine sichere Stromversorgung werden minimiert.

– Die gigantischen Planungen für einen Ausbau des Übertragungsnetzes und auch der Verteilnetze können ad acta gelegt werden – mit allen Vorteilen für die ansonsten betroffenen Bürger.

– Die Stromspeicher wären privat zu finanzieren, allerdings könnten das die Betreiber aus den in diesen Fällen nicht gekürzten Einspeisevergütungen bezahlen.

– Weiterhin würde es nicht mehr nötig sein, zahlreiche neue Gaskraftwerke sowie schneller regelbare Kohlekraftwerke für den Ausgleich der Windstrom- und Solarstrom-Schwankungen zu bauen – die bereits heute wegen ihrer Unwirtschaftlichkeit nur durch neue Subventionen überhaupt realisierbar wären.

– Mit diesen Maßnahmen würde auch von unseren Nachbarländern, die sich bereits gegen den Missbrauch ihrer Stromnetze durch deutschen Überschuß-Ökostrom zur Wehr setzen, ein Alptraum genommen.

Auf der Negativseite für die Betreiber dieser Stromerzeuger steht die Wahl zwischen der Errichtung der erforderlichen Stromspeicher auf eigene Kosten – bei allerdings dann nicht gekürzten Einspeisevergütungen – und einer zunehmend häufigen Abtrennung ihrer speicherlosen Anlagen vom Netz durch die Netzbetreiber bei gleichzeitig gekürzten Einspeisevergütungen.

Spitzenlastkraftwerke

Die Rentabilität von Spitzenlast-Kraftwerken (Gasturbinen, GuD-Kraftwerke) und Pumpspeicherkraftwerken wird durch ihre vorrangige Nutzung sichergestellt – und nicht durch neue Subventionen für die passive „Bereitstellung von Stromerzeugungskapazität“. Siehe dazu die obigen Ausführungen zum Thema „Netzstabilität“.

Das EEG

Das wichtigste für das aufziehende wirtschaftliche Desaster verantwortliche Gesetzesinstrument ist das Erneuerbare Energien Gesetz (EEG). Mit ihm werden spezielle Stromerzeugungstechniken massiv gefördert, von denen die drei wichtigsten – Photovoltaik (PV), Windkraft und Biomassenutzung – entweder völlig unbrauchbar und sogar die Netzstabilität gefährdend (PV und Windkraft) oder durch riesigen Flächenverbrauch umweltschädlich sind (Biomassenutzung zur Stromerzeugung). Mit dem EEG wird einerseits die Stromversorgung destabilisiert und andererseits werden die Bürger und die Wirtschaft durch Zwangsabgaben („Umlagen“) ausgeplündert. Mehrere Teile dieses Gesetzes haben den Zweck, Abwehrmaßnahmen zu unterbinden: So die Anschluß- und Abnahmepflicht für den erzeugten Strom, die Erschwerung von Abschaltungen bei Netzproblemen, die Entschädigungspflicht für die Nichtabnahme von überflüssigem EEG-Strom (Irrsinn in Gesetzesform) und die Abgabe überflüssigen EEG-Stroms zu „negativen Preisen“ – also nicht nur das Verschenken dieses Stroms, sondern die Zuzahlung, damit sich ein Abnehmer findet.

Die aktuellen Vorschläge zur Einführung eines Quotenmodells, nach dem die Netzbetreiber selbst die EEG-Stromeinspeiser mit den gerade niedrigsten Preisen im Rahmen einer vorgegebenen Ökostrom-Gesamtquote auswählen dürfen, sind zwar ein kleiner Schritt zurück in Richtung Marktwirtschaft, aber dennoch unbrauchbar. Denn die Wahl zwischen Solarstrom, Windstrom oder Strom aus Biomasse-gefeuerten Anlagen in Verbindung mit einer Abnahmepflicht einer nach Regierungsplänen viel zu großen Gesamtmenge wäre wegen der untragbaren Probleme, die diese Techniken mit sich bringen, gleichbedeutend mit der Wahl zwischen Pest, Cholera und Typhus.

Nach Novellierung des EEG wäre ein Quotenmodell brauchbar (s.u.).

Das EEG ist zu novellieren

Das Erneuerbare Energien-Gesetz könnte zwar vollkommen abgeschafft werden, aber es wäre politisch klüger, es beizubehalten – allerdings nach dem Ziehen seiner Giftzähne.

Gestrichen wird:

– Die Einspeisungspflicht der Netzbetreiber für angebotenen EEG-Strom

– Die Entschädigung für EEG-Stromanbieter bei Ablehnung der Einspeisung

– Die Zahlung der vollen Einspeisevergütung bei niedrigen Börsenpreisen

Alle bisher festgelegten quantitativen und terminlichen Ausbauziele für die „Erneuerbaren“ sind hinfällig.

Erneuerbare Energietechniken sollen einen behutsam wachsenden Anteil an der Energieversorgung erhalten. Dies betrifft aber nicht alle bisher geförderten Techniken:

Der mit Einspeisevergütungen belohnte Zubau der Photovoltaik-Anlagen wird – mit Ausnahme von Anlagen mit eigenen Stromspeichern – beendet. Alle durch den PV-Bestand in den Verteilungsnetzen ausgelösten Probleme und die Kosten für deren Behebung werden auf die PV-Betreiber umgelegt.

Ein behutsamer Ausbau der Windkraft wird zugelassen. Dazu wurden die Voraussetzungen bereits erläutert (Ausbau nur mit Stromspeichern; Ausbau nur bei Nachweis ausreichender Netzkapazitäten).

Biomassenutzung: Siehe unten.

Auch nach der Novellierung des EEG ist darauf zu achten, daß in keinem neuen Energiegesetz marktfeindliche und planwirtschaftliche Elemente mehr vorkommen dürfen.

In Anbetracht der drohenden Verschandelung der Landschaft durch aufgegebene Windkraftanlagen (wie in den USA) müßte eine Vorsorgefinanzierung für ihren späteren Rückbau aus den Einspeisevergütungen erfolgen.

Vorrang für die Wärme-Bereitstellung mit Solarenergie und Erdwärme

Anstelle des bisherigen Vorrangs der Stromerzeugung durch Windkraft, Photovoltaik und Biogasverstromung wird der Wärmebereitstellung mittels Sonnenenergie und Erdwärme (mittels Wärmepumpen) sowie mittels der von anderen Erzeugern gelieferten Fernwärme durch ein Förderungsprogramm der Vorrang gegeben. Einen Schwerpunkt darin sollten große kommunale Solarwärmekollektoren und -speicher und ihr Anschluß an Nahwärmenetze bilden. Der Schwerpunkt der staatlichen Maßnahmen in diesem Bereich sollte sich auf die Technologieentwicklung, die Kostenverringerung durch automatisierte Großserienfertigung und auf darauf aufbauende große kommunale Pilotprojekte konzentrieren.

Die bereits in Deutschland existierenden Pilotprojekte großer kommunaler Solarwärmeanlagen, die auf frühere Förderprogramme zurück gehen, bewiesen bereits den großen Nutzen dieser Technik, bei der noch beträchtliche Verbesserungspotenziale erschlossen werden könnten. Diesen Projekten ist aber nichts gefolgt, um dieser als rentabel und machbar erkannten Technik zu einem Durchbruch zu verhelfen. Dies sollte nun durch ihre technische Optimierung angegangen werden.

Es ist zu erwarten, daß durch das Erreichen von wesentlich günstigeren Kosten dieser Technik eine dynamische Aufwärtsentwicklung der Solarwärmenutzung einsetzt und daß damit diejenige der sog. Erneuerbaren Energietechniken, die endlich einen beträchtlichen Nutzen für die Verbraucher verspricht, den ihr gebührenden Platz erhält, der ihr bisher durch die exzessive Förderung der Photovoltaik versperrt worden ist.

Bei einem Erfolg wären die positiven wirtschaftlichen Auswirkungen beträchtlich: Mineralöl- und Erdgasimporte könnten deutlich verringert werden.

Auf alle staatlichen Maßnahmen der Ausübung von Zwang oder finanziellen Anreizen gegenüber Hauseigentümern, bestimmte Techniken für die Heizung einzuführen, wird verzichtet.

Biomasse-Nutzung

Die Nutzung von weiteren landwirtschaftlich geeigneten Flächen für Energiepflanzen wird gestoppt. Eine Rückumwandlung von Anbauflächen für Energiepflanzen in landwirtschaftliche Nutzflächen wird begonnen. Absoluten Vorrang für die Biogaserzeugung erhält die Nutzung von Abfällen und Reststoffen wie Restholz, Müll, Gülle etc. ; nur derartige neue Anlagen werden noch zugelassen.

Weitere Förderung von regenerativen Energiequellen

Für den durch ein Quotenmodell gesteuerten weiteren behutsamen Zubau „erneuerbarer“ Energieerzeuger könnten Investitionszuschüsse aus staatlichen Mitteln bereit gestellt werden. Diese Zuschüsse dürfen nicht zur Erzielung von Renditen führen. Einspeisevergütungen entfielen in diesen Fällen.

Für den Fall, daß man Einspeisevergütungen als Förderungsinstrument wählt, werden diese nur noch für maximal 6 Jahre garantiert. Wie oben erläutert, gibt es in diesen Fällen auch keine Bevorzugung bei der Stromeinspeisung und auch keine Entschädigungszahlungen bei Ablehnung der Stromeinspeisung durch die Netzbetreiber. Auch diese Vergütungen sollten nur eine anteilige finanzielle Unterstützung gewährleisten. Auch diese würden so festgelegt, daß durch die Förderung keine Renditen erwirtschaftet werden können.

Den Investoren verbleibt somit ein finanzielles Risiko. Damit würde dem spekulativen Zubau von an sich nicht rentablen Energietechniken ein Riegel vorgeschoben. Führt die weitere technische Entwicklung zu fallenden Investitionskosten und damit zu sinkenden Stromgestehungskosten, würde der Markt die Verbreitung dieser verbesserten Anlagen veranlassen.

Beispiele für künftige Einspeisevergütungen: Neue Windkraft Onshore: 3,5 Cent/kWh. Neue Windkraft Offshore: 5 Cent/kWh. Neue Biomasseanlagen (nur Reststoffe): 4 Cent/kWh.

Neue Photovoltaikanlagen erhalten keine Vergütungen zur Netzeinspeisung mehr; auch keine Investitionszuschüsse. Zur Selbstversorgung der Erzeuger wird eine Vergütung von 3 Cent/kWh festgelegt, was den Gestehungskosten von Kohle- und Kernkraftstrom entspricht.

Für große kommunale Solarwärmeanlagen (Kollektorfelder und Erdspeicher) kämen Investitionszuschüsse in Frage.

Unkonventionelle Erdgasvorkommen

Die Gewinnung von Erdgas aus tiefgelegenen Schichten („Shale Gas“) mit Hilfe des sog. Fracking-Verfahrens in Deutschland muß unter Beachtung umweltschonender Praktiken verstärkt vorangetrieben werden, weil damit eine große nationale Energieträger-Quelle erschlossen werden kann. Der Einsatz dieser neuen heimischen Energiequelle würde vor allem im Wärmesektor (dort auch mit Gasmotor-betriebenen Wärmepumpen sowie Gas-Absorptions-Wärmepumpen) und im Verkehrssektor eine sinnvolle Anwendung finden.

Die Rückkehr zur Marktwirtschaft

Alle Maßnahmen zur Zurückdrängung des freien Marktes, d.h. planwirtschaftliche Maßnahmen werden zurückgenommen. So wird die Überwälzung der Haftungskosten für die Folgen unterbliebener oder verzögerter Netzanbindung von Offshore-Windkraftanlagen beendet. Es gibt keine Verpflichtung zum Weiterbetrieb unrentabler fossiler Kraftwerke. Es gibt keinen Zwang zur Vorhaltung von ansonsten ungenutzten Kraftwerkskapazitäten. Es gibt keine Förderung von Kraftwerksneubauten – diese erfolgen ohne Förderung, wenn die Marktwirtschaft wieder in Kraft gesetzt wird.. Die Wiederinbetriebnahme der abgeschalteten Kernkraftwerke erschließt ohne neue Kosten ein mächtigen Potenzial an kostengünstiger Grundlastversorgung und macht planwirtschaftliche Fehlentwicklungen überflüssig. Es gibt keine Förderung für die Vorhaltung von Speicherkapazitäten, jedoch die Förderung ihrer Technologieentwicklung. Es gibt keine Markteinführungs-Finanzierungen für energietechnische Geräte und Anlagen und ebenso wenig Verschrottungsprämien für diese.

Alle Versuche, den Energieverbrauch durch staatliche Zwangsmaßnahmen zu verringern, unterbleiben, da dies – wie schon immer – weitaus besser vom Markt geregelt wird. Weil die Energiekosten seit jeher einen starken Antrieb für eine rationelle Energieanwendung darstellen, sind alle staatlichen Zwangsmaßnahmen zur Steigerung der Energieeffizienz unnötig.

Durch die Rückkehr zur Marktwirtschaft wird der frühere Zustand der Energiewirtschaft wieder hergestellt, in dem ausschließlich rationale und auf Effizienz abzielende Entscheidungen aller Marktteilnehmer teure Fehlentwicklungen verhindern, wie sie in der jetzigen Situation einer ideologisch begründeten, paralysierenden Staatswirtschaft typisch und unvermeidlich sind.

Teil 2. Maßnahmen in der Administration

Das Bundesumweltministerium BMU verliert alle Zuständigkeiten für Energietechnik und Energiepolitik, also alle in der Unterabteilung E I gesammelten Zuständigkeiten: Energiewende, Strommarkt, Infrastruktur (Netz, Speicher), Solarenergie, Biomasse, Geothermie, Windenergie und Wasserkraft.

Weiterhin verliert das BMU folgende Zuständigkeiten, die in der Unterabteilung E II zu finden sind: Emissionshandel, Energieeffizienz, Wärme- und Kältestrategie im Gebäudebereich, Stromsparinitiative, Europäische Energiepolitik.

Ebenso verliert es die Zuständigkeit für die „Sicherheit kerntechnischer Einrichtungen“ und „Nukleare Ver- und Entsorgung (incl. Endlager)“. Das BMU verliert alle Haushaltsmittel für die zu den genannten Bereichen gehörenden Projekte des BMU.

Entsprechend verliert das dem BMU unterstellte Umweltbundesamt Zuständigkeiten und Haushaltsmittel.

Die Sachverständigenkreise, die die Bundesregierung beraten, sind neu zu besetzen, und zwar nach ausschließlich fachlichen Kriterien. Das betrifft die Klima-, Energie- und Umweltpolitik (SRU), sowie die Reaktorsicherheitskommission.

Die Politik gerät in Panik

Es kam, wie es kommen mußte: Das mit der Energiewende überraschte Volk gab sich zunächst mit den vielversprechenden Ankündigungen einer neuen, heilen Energiewelt zufrieden und wartete ab. Die technischen Details konnte kaum jemand nachprüfen – und Kritik wurde von den grün besetzten Redaktionen ausgeblendet. Aber allen Kritikern war klar, daß sich diese passive Haltung radikal ändern würde, sobald der Pferdefuß der staatlichen Beglückungspläne unübersehbar wurde: Die rasch steigenden Stromkosten.

Das Gewitter braute sich im Herbst 2011 zusammen, als der Termin der Prognose der Übertragungsnetzbetreiber (ÜNB) für die Höhe der EEG-Umlage für 2013 nahte. Nachdem es der Regierung 2011 gelungen war, die ÜNB zu einer offensichtlich falschen EEG-Umlage-Prognose für 2012 zu veranlassen – angeblich drohte damals überhaupt keine Erhöhung, obwohl der dafür verantwortliche Zubau an Windmühlen, Solarpanels und Biogasanlagen rekordverdächtige Höhen erreicht hatte -, mußten die ÜNB am 15.10.12 ihre 2011 unterschlagenen Steigerungsbeträge auf die nun 2012 aufgelaufenen weiteren Erhöhungen aufschlagen, was den Schock noch verstärkte.

Verbraucherschützer kamen nun mit ihren Warnungen vor der „Energiearmut“ zu Gehör; man erinnerte sich an den Beinahe-Blackout im Winter 2011/12 – und alles begleitet von krachenden Pleiten in der deutschen Solarstrom-Zukunftsindustrie. Die Meldungen über die Überwälzung aller Haftungsrisiken der Offshore-Windparkbetreiber auf die Verbraucher und Berichte über den Bürgerwiderstand gegen neue Hochspannungstrassen vor ihrer Haustür taten ein Übriges: Man verstand jetzt, daß die Energiewende ein gigantisches Abkassiersystem war; dazu auch noch laienhaft geplant.

Inzwischen melden Umfragen, daß eine Mehrheit der Deutschen nicht bereit ist, die Energiewende weiter mit steigenden Strompreisen zu finanzieren.

Und nun drohte für das Jahr 2013 das Zusammentreffen zweier besonders unangenehmer Ereignisse: Die Bundestagswahl am 22. September und die wieder Mitte Oktober fällige ÜNB-Prognose zur EEG-Umlage 2014 – und wie man es schon 2012 erlebt hatte, sickert diese Zahl ausreichend rechtzeitig durch: In den Wahlkampf hinein.

Daß es abermals deutlich teurer wird, ist logisch und unvermeidbar; schließlich werden auch die Monate vom Oktober 2012 bis August 2013 die gewohnten kräftigen Zuwachsraten bei den „Erneuerbaren“ zeigen. Das EEG gilt weiterhin und wer jetzt investiert, kann 20 Jahre lang seine Einspeisevergütungen einstecken und eine prächtige Rendite auf Kosten der übrigen Bürger erzielen. Diese Zahlungsverpflichtung akkumuliert sich im Jahre 2015 bereits auf 570 Mrd. Euro (5). Und je hektischer die Diskussion um EEG-Änderungen, desto rascher müssen noch weitere erneuerbare Schäfchen ins 20 Jahre Geld abwerfende Trockene gebracht werden.

Das sind keine guten Aussichten für die Regierung. Die grausame Ironie der Geschichte besteht darin, daß es im Parlament keine einzige Partei gibt, die die Energiewende als Irrtum und Sackgasse ablehnt. Im Gegenteil: Sollte Rot-Grün ab Herbst 2013 regieren, wird das EEG überhaupt nicht mehr angetastet. Dann geht es allein um Bedürftigkeit, Energiebeihilfen, Energieberatung, Sozialrabatte für stromsparende Kühlschränke, kostenlose Stromkontingente für sozial Schwache, Belasten und Bestrafen der großen Energieversorger als Standard-Schurken, Energie-Soli für Reiche, neue Steuern. Dazu die Streichung der meisten Vergünstigungen für die Industrie – in der Hoffnung, daß deren Exodus und die dann anhebenden Gewerkschaftsproteste noch etwas auf sich warten lassen. Daß damit nur eine Umverteilung der steigenden Kosten erreicht wird und die dann noch stärker Belasteten auf die Barrikaden gehen, wird in Kauf genommen. Insbesondere die Grünen haben in dieser Hinsicht eiserne Nerven: Wenn das Volk die Energiewende ablehnt, dann muß es eben gezwungen werden. Wenn auch die SPD – ähnlich wie jetzt die CDU/CSU plus FDP – auf Grund des Widerstands in der Bevölkerung Rückzugsbewegungen einleiten möchte, wird es zu einem harten Konflikt mit den Grünen kommen, die auf ihrem Umbau Deutschlands in einen industriearmen Öko-Modellstaat bestehen, koste es was es wolle.

In dieser Zwickmühle sitzend hat Minister Altmeier am 1. Februar 2013 eine Nebelbombe gezündet. Sie enthält eine Mischung von Täuschungskörpern, echten kleinen Knallfröschen und eben sehr viel Nebel. Am tollsten ist seine gesetzliche Festschreibung der EEG-Umlage. Weil die sie verursachenden Kosten durch den ständigen Zubau neuer Anlagen unvermeidlich steigen, versucht Herr Altmeier hier einen Bluff, dem leider bald nach dem Wahltermin die Luft ausgeht. Adam Riese auszutricksen, klappt auch dieses Mal nicht.

EEG-Anlagenbetreibern einen „Energiesoli“ abzuknöpfen, ist prinzipiell richtig, wird aber große juristische Widerstände auslösen – mit unbekanntem Ergebnis. Das trifft selbstverständlich auch auf einige Punkte des fiktiven Programms Energiewende Light“ zu.

Das Gleiche gilt für den Versuch, bei einem zu starken Zubau die Vergütungszahlungen zu verzögern: Juristischer Krach stünde ins Haus.

Dennoch ist Altmeiers Plan clever: Mit seiner Nebelbombe nimmt er der Opposition etliche Argumente weg. Er will ja keine weiteren Strompreissteigerungen. Er will den ungebändigten Windmühlen- und Photovoltaik-Zubau dämpfen. Wer bitte ist dagegen ? Sein Blick ist auf den Bundesrat gerichtet, der – nun mit rot-grüner Mehrheit – gewiß alles ablehnen wird, was die EEG-Profiteure stört. Aber dann sind für die Regierung und wohl auch für die Medien die SPD und die Grünen am weiteren Anstieg des Strompreises Schuld. Die Absicht ist, dieses Schwarze-Peter-Spiel rechtzeitig vor der Wahl ablaufen zu lassen, weshalb der Minister den August als Termin für diese Gesetzesänderungen nannte.

Schon zeigt die SPD Trefferwirkung: Sigmar Gabriel schlug vor, statt dessen die Stromsteuer – nur ein kleines Stück in der Summe der staatlichen Steuern, Abgaben und Umlagen – zu senken. Das bringt zwar maximal 2 Cent/kWh, wäre aber auch ein Schritt in die richtige Richtung – und ärgert den Finanzminister…

Die Grünen warnten, daß mit Altmeiers Plan die Investoren in „Erneuerbare“ verunsichert würden und mit Zurückhaltung reagierten. Dieser Vorwurf ist ein Lob: Denn damit bestätigen sie dem Minister, daß sein Plan die gewünschte Wirkung hätte. Der Präsident des Fachverbandes Biogas Pellmeyer erklärte: „Für unsere noch junge Branche wäre das eine Katastrophe“. Im krassen Gegensatz dazu zeigte die Windbranche weiterhin großen Optimismus: Sie beabsichtige, 2013 um 23 bis 44 Prozent zu wachsen, teilte der Bundesverband Windenergie mit. Und die Solarstrombranche hofft weiterhin auf EU-Dumpingmaßnahmen gegen chinesische Importe…

In diesem Kasperletheater haben nun alle eine Pritsche in der Hand und schlagen aufeinander ein.

Selbst wenn ein Wunder geschähe und Altmeiers Wundertüte unverändert durch den Bundesrat käme, wäre die Wirkung nur eine leichte Verzögerung weiterer Investitionen in Wind- und Solarstrom – begleitet von ausgiebigen Prozessen – und keine Entspannung der bereits gefährlichen Situation, die durch die längst existierenden Anlagen herbeigeführt worden ist.

Dieses Wunder wird aber nicht geschehen.

Da inzwischen sämtliche Akteure, Nutznießer und Betroffene der Energiewende vollkommen divergierende Interessen haben, was noch von einem ebenso chaotischen Zielwirrwarr bei den Bundesländern und dem Ergebnis der Bundestagswahl überlagert wird, sind sämtliche Prognosen über die Situation am Jahresbeginn 2014 noch unzuverlässiger als Kaffeesatzleserei. Vermutlich wird alles erst noch schlimmer; sehr viel schlimmer.

Die „Energiewende Light“ wird natürlich nicht kommen

Kehren wir zum Phantasieprogramm „Energiewende Light“ als Übungsgerät zurück. Wenn schon politisch nicht durchsetzbar, dann aber bitte konsequent.

Jede einzelne der oben aufgelisteten Änderungen würde – falls als Gesetzesvorschlag eingereicht – auf den erbitterten Widerstand der finanziellen und politischen Profiteure sowie der grün besetzten Redaktionen und aller politischen Mitläufer der Energiewende stoßen.

Das vorgestellte chancenlose Gesamtpaket, das sicherlich noch um etliche Punkte ergänzt werden könnte, ist mit seinen vielen Änderungsvorschlägen und Rücknahmen von bereits erfolgten staatlichen Maßnahmen zumindest dazu geeignet, den unglaublichen politischen und wirtschaftlichen Zerstörungsprozeß zu veranschaulichen, den die Regierungen bereits in der Energiepolitik zu verantworten haben.

Die beschriebenen erforderlicher Veränderungen zurück zu einer funktionierenden und bezahlbaren Energiewirtschaft erscheinen wie ein riesenhafter, abzutragender Problemberg. Dabei ist die dafür gewählte Überschrift „Energiewende Light“ aber nicht einmal ironisch gemeint. Denn auch darin werden die „Erneuerbaren Energien“ – die es übrigens nicht gibt; „regenerative Energien“ wäre korrekt – keineswegs abgeschrieben oder verdammt, sondern sie sollten ihren sinnvollen Platz innerhalb des Energiesystems erhalten – siehe die Ausführungen zum Wärmemarkt.

Das Dilemma der deutschen Energiepolitik beruht auf mehreren Faktoren:

· Ideologen haben es geschafft, durch Angstpolitik gegen konventionelle Energietechniken, verbunden mit unhaltbaren Versprechen in Bezug auf den Nutzen und die angeblich erreichbare Wirtschaftlichkeit der „Erneuerbaren“ die Regierungspolitik in eine desaströse Richtung zu lenken und viele Milliarden an Volksvermögen zu vernichten.

· Weil es hauptsächlich um technische Sachverhalte geht, die von der breiten Mehrheit der Bevölkerung nur unzureichend verstanden werden können, werden technisch-wirtschaftliche Unsinnigkeiten in den staatlichen Maßnahmen nicht sofort erkannt. Widerstand erhebt sich erst, wenn die immer weiter steigenden Kosten der Energiewende die Verbraucher treffen. Dann aber ist ein großer Teil der Schäden bereits angerichtet worden.

· Die Medien vernachlässigen ihre Pflicht zur kritischen Begleitung der Regierungspolitik. Sie verbreiten im Gegenteil irreführende, beschönigende Informationen über die Energiewende und setzen ihre Angstkampagnen gegen Kernenergie, Shale-Gas-Förderung, Kohlekraftwerke und generell CO2-Emissionen (Klimaangst) fort. Den Grund für diese Selbstzensur und Manipulation hat eine Umfrage in Redaktionen zur politischen Selbsteinschätzung ihrer Mitglieder ergeben: 70 Prozent nannten die Grünen.

Änderungen sind jedoch im Gange: Eine stetig stärker werdende Alternative zu den deutschen Zeitschriften und dem Fernsehen stellt das Internet dar. Hier kann jeder die in den Redaktions-kontrollierten Medien unterdrückten kritischen Berichte und Kommentare abrufen. Insbesondere der jüngere Teil der Bevölkerung nutzt diesen Informationskanal immer stärker. Noch ist dieser Anteil am Nachrichtenmarkt nicht dominierend, aber die Entwicklung läuft stetig darauf zu – mit den entsprechenden politischen Wirkungen, wenn die Ideologen die Kontrolle über einen ausreichend großen Teil der Medien verloren haben.

Vielleicht spürt die Politik diese Wirkungen viel eher, als es die fiktive Partei LP mit ihrer noch fiktiveren energiepolitischen Kehrtwendung schaffen könnte.

Die nächste Wende kommt jedenfalls bestimmt.

Quellen:

(1): Günter Keil: „Die Energiewende ist schon gescheitert“, TvR Medienverlag, Jena

2012, ISBN 978-3-940431-32-5

(2): BILD vom 16.10.2012: Atomstrom-Umfrage: http://www.eike-klima-energie.eu/climategate-anzeige/bild-umfrage-buerger-in-grosser-mehrheit-fuer-mehr-kernkraft-oder/

(3): Dr.-Ing. Ulrich Dämgen: „Neuer Entwicklungsansatz bei Druckluftspeichern“, BWK Bd. 65 (2013) Nr.1/2

(4): RWE: „Solarstromspeicher für Haushaltskunden“, BWK Bd. 65 (2013) Nr. 1/2 ;

www.rwe-effizienz.com

(5): http://www.eike-klima-energie.eu/energie-anzeige/ wind-und-sonne-schicken-keine-rechnung-was-uns-kostenlose-energie-wirklich-kostet/

Dr.-Ing. Günter Keil 11.02.2013 Sankt Augustin

Der obige Text kann als pdf im Anhang herunter geladen werden.

Vom Autor ist auch als Buch erschienen „Die Energiewende ist schon gescheitert“

Weitere Beiträge des Autors: Dreizehn und zwei Energiewendemärchen

sowie Der Offshore-Bluff

Related Files