Bild rechts: Eröffnung des GATE LNG-Terminals, eines Joint Ventures von Gasunie und Vopak im September 2011 in Rotterdam © Gate

Lassen Sie uns mit in paar einfachen Tatsachen beginnen:

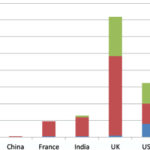

· Im Jahr 2008 haben Shell und ExxonMobil das BEB-Gaspipeline-Netzwerk in Deutschland an die Gasinfrastruktur-Kompanie Gasunie verkauft – Muttergesellschaft des holländischen Übertragungssystems-Operators (Transmission System Operator TSO) GTS.

· Im Dezember 2010 hat die deutsche RWE ihr Gasübertragungs-Netzwerk Thyssengas an den Investmentstruktur-Fond Macquarie Infrastructure and Real Assets verkauft.

· Im Jahr 2011 hat die italienische Öl- und Gasgesellschaft ENI Anteile an zwei Pipelines – TENP und Transitgas, die von der belgisch-holländisch-deutschen Grenze durch die Schweiz nach Italien verläuft – an den TSO Fluxys in Belgien verkauft.

· In diesem Jahr 2012 hat die deutsche Energiekompanie E.on das deutsche Gaspipeline-Netzwerk Open Grid Europe (OGE) an ein Konsortium von Finanzinvestoren unter Leitung von Macquarie verkauft.

Man betrachte diese ersten Stöße eines Erdbebens, das dabei ist, den europäischen Gasinfrastruktur-Markt aufzumischen. Ähnliche Transaktionen werden folgen, da eine Anzahl anderer TSOs einschließlich Net4Gas (tschechische Republik), Eustream (Slowakei) und DESFA (Griechenland) gegenwärtig zum Verkauf stehen.

Was geschieht? Nun, in gewisser Weise, was soll geschehen? Energieriesen wie Shell, ExxonMobil, ENI und E.on, die bei Erzeugung und Verkauf von Gas aktiv sind, verkaufen ihre Infrastruktur-Anteile, was sicherlich durch die ‚nicht verbundenen‘ Forderungen des Third Energy Package der EU ‚ermutigt‘ wird. Der Sinn hinter diesen im Jahre 2009 übernommenen Regelungen ist es, einerseits einen freien Markt zu schaffen, in dem Erzeuger und Versorger von Gas miteinander konkurrieren, und andererseits einen regulierten Markt zu schaffen, in dem unabhängige Infrastruktur-Betreiber ihre Dienste jenen Erzeugern und Versorgern zu gleichen Bedingungen anbieten.

So weit, so gut. Der liberalisierte Gasmarkt besteht und läuft – die Aktivitäten des neuen Handels in Europa wachsen rapide, nationale Märkte werden integriert, noch mehr Beteiligte werden aktiv, die Auswahl für Verbraucher nimmt zu. Das ist es, was die Politiker wollten.

Aber was ist mit diesem anderen ‚Markt’, dem Infrastruktur-Anteil? Wie soll der sich entwickeln? Wie sollen die seit Neuem unabhängigen Infrastruktur-Kompanien ihre Aufgabe erfüllen, die Marktteilnehmer zu unterstützen? Sie sind reguliert, ja. Aber sollen sie im privaten oder öffentlichen Eigentum stehen? National orientiert oder international aktiv? Miteinander kooperieren oder im Wettbewerb stehen – oder beides? All das ist viel weniger klar. Der Gesetzgeber spezifiziert eigentlich nicht, wie seine Erwartungen hinsichtlich der Entwicklung des Infrastruktur-Marktes aussehen. Die EU erwartet, dass die TSOs ‚kooperieren‘, indem sie ‚10-Jahres-Pläne zur Entwicklung des Netzwerkes‘ vorlegen (sowohl regional als auch Europäisch), aber diese Pläne sagen nichts darüber aus, wie der Markt als solcher aussehen soll.

Was möglicherweise nur Wenige vorhergesehen haben, sind die oben erwähnten Übernahmen: Gaspipelines in Deutschland und der Schweiz werden von Kompanien wie Gasunie, Fluxys (die mehrheitlich im öffentlichen Besitz Belgiens befindliche TSO, inzwischen mit einer Minoritäts-Beteiligung eines kanadischen Pensions-Fonds) und Finanzinvestoren wie Macquarie, MEAG (der Investitionsbereich der Versicherungsgesellschaft Münchner Rück) sowie Infinity Investments (eine Tochter der Abu Dhabi Investment Authority) übernommen. Noch einmal: das ist eine Entwicklung, die gerade erst begonnen hat, da immer weitere Energiekompanien dem Beispiel von Shell, ExxonMobil, E.on und ENI folgen und ihre Übertragungs-Netzwerke verkaufen.

Richtige Maßnahme

Dem Strategie-Direktor von Gasunie Hans Coenen zufolge „stehen Shell, ExxonMobil und Gasunie an vorderster Front einer Entwicklung, die den gesamten europäischen Markt übernehmen wird“. Es ist eine logische Konsequenz des Third Package, sagt er. Kompanien wie Shell und Exxon Mobil haben sehr schnell erkannt, dass sie in einem regulierten europäischen Infrastruktur-Markt keine ausreichende Rückkehr des Kapitals erreichen, so dass sie sich entschlossen haben, dieses Geschäft aufzugeben und ihr Kapital anderweitig zu verwenden. „Andere Energiekompanien werden zur gleichen Schlussfolgerung kommen“, sagt Coenen. „Und das bedeutet, dass der Infrastruktur-Markt auch weiterhin neue Gelegenheiten bietet für verschiedene Teilnehmer: spezialisierte Infrastruktur-Kompanien wie uns sowie Finanzinvestoren, die nach einer moderaten, aber stetigen Rate des Rückflusses suchen“.

Tatsächlich musste Gasunie für seine Pioniertätigkeit einen Preis bezahlen. Nach der Übernahme der BEB-Gaspipeline für 2,1 Milliarden Euro hat der deutsche Gesetzgeber die Daumenschrauben an die Tarife gelegt, und zwar auf eine Art und Weise, die vom damaligen Management nicht erwartet worden war. Das machte es für die Kompanie notwendig, den Wert der BEB-Beteiligungen durch erhebliche 1,65 Milliarden abzuschreiben. Das holländische Finanzministerium hat eine unabhängige Untersuchung dieses Verlustes angeordnet. (Zufälligerweise waren Shell und Exxon Mobil zusammen mit dem holländischen Staat Eigentümer von Gasunie, als es noch eine vertikal integrierte Gaskompanie war; sie wurde schon im Jahr 2005 vom holländischen Staat verkauft, als Gasunie aufgeteilt wurde in einen Infrastruktur-Anteil und eine Handelsgesellschaft. Letztere nennt sich jetzt GasTerra und gehört immer noch Shell, ExxonMobil und dem holländischen Staat).

Coenen sagt, was immer man über den Verkaufspreis von BEB sagen kann, „dass es strategisch das Beste war, was man tun konnte. Die Logik der Übernahme steht immer noch außer Frage. Wir waren die erste grenzüberschreitende TSO in Europa. Jetzt folgen andere unserem Beispiel oder denken darüber nach“.

Neuordnung

Was also ist die Logik hinter der Expansion von Gasunie? Diese Frage wird regelmäßig von Kritikern gestellt einschließlich einiger nationaler Parlamentarier, die glauben, dass sich staatseigene Kompanien wie Gasunie nicht an etwas beteiligen sollten, das sie für ‚ausländische Abenteuer‘ halten. Für Gasunie ist es jedoch einfach die Konsequenz der Art und Weise, wie sich der neue, unabhängige Gasinfrastruktur-Markt in Europa entwickelt.

Eine kleine Gruppe internationaler Beteiligter wird sich heraus schälen, die den Ton angeben – sie werden eventuell die Integration des europäischen Gasmarktes ermöglichen“

Im Wesentlichen finden drei grobe Entwicklungen statt:

1) Erstens, die Märkte werden liberalisiert: es gibt keine [an eine Gesellschaft] gebundene Verbraucher mehr, keine Monopol-Verkäufer – jeder kann alles von jedem kaufen.

2) Zweitens, nationale Märkte werden nach und nach in einen einzigen Markt integriert: Sie werden sich nicht länger an nationalen Linien organisieren, sondern regional oder europaweit.

3) Drittens, Kompanien sind frei [in ihren Entscheidungen]: Versorgung/Erzeugung und Infrastruktur werden aufgeteilt und zu separaten Märkten.

In dieser neuen Ordnung entwickelt der Infrastruktur-Markt eine Eigendynamik. Wir können vier Stadien unterscheiden, wie sich die Betreiber der Infrastruktur erwartungsgemäß in dieser neuen Situation verhalten werden.

1) Ihre erste Aufgabe wird es sein, Versorger und Zulieferer in ihren heimischen Märkten mit dem Bau von Gebäuden und Pipelines zu unterstützen, ebenso mit Handelsspielräumen und Speichermöglichkeiten. Außerdem sollen sie generell den Gasmarkt unterstützen durch Ermunterung zu Innovationen und durch die Durchführung von Aufgaben, die die Marktteilnehmer nicht aufnehmen.

2) Zweitens, da die nationalen (‚heimischen’) Märkte verschwinden, kann man von den Betreibern der Infrastruktur erwarten, dass sie ‚dem Markt folgen’ und über ihre nationalen Grenzen hinaus expandieren. In dieser Hinsicht wäre es anomal, wenn nationale Infrastrukturbetreiber einen internationalen Markt füttern: das würde zu Ineffizienz und zu Entscheidungen aus nationalen Interessen führen, anstatt die Aufgabe aus internationaler Sicht anzugehen.

3) Drittens, da sie jetzt international aktiv werden, geraten die Infrastrukturbetreiber zunehmend in Wettbewerb miteinander. Sie konkurrieren um ‚Anteile am Markt’ in der Hinsicht, dass sie versuchen, Gas in ihr System fließen zu lassen.

4) Viertens, dieser Wettbewerb tendiert dazu, von Konsolidierung gefolgt zu werden, da größere Märkte größere Effizienz bieten und sie den Betreibern erlauben, effizienter zu investieren.

Zusammengefasst: Was geschehen wird, ist, wie Coenen es ausdrückt, „eine kleine Gruppe internationaler Akteure wird sich bilden, die den Ton angeben – sie werden eventuell die Integration des europäischen Gasmarktes ermöglichen“.

Wertvolle Angebote

Was Gasunie betrifft, möchte diese Kompanie zu dieser führenden Gruppe gehören. Deren Strategie ist es, die Reichweite ihres in den Niederlanden bestehenden Netzwerkes entlang der Haupttransitrouten nach und in Nordwesteuropa zu vergrößern. „Wir sehen, wie sich eine dominante nördliche Ost-West-Route entwickelt. Dort wollen wir aktiv sein. Wir sind nicht an isolierten Pipelines interessiert. Wir sehen auch die Entwicklung eines regionalen Marktes weiter südlich, aber wir wollen uns auf den Norden konzentrieren“.

Einer der Hauptkonkurrenten von Gasunie ist die belgische TSO Fluxys, obwohl beide Gesellschaften auch miteinander kooperieren. Coenen erklärt, dass von Deutschland nach UK fließendes Gas entweder durch Belgien oder durch Holland geleitet werden kann. „Was wir versuchen ist, attraktive Tarife und Service anzubieten. Hierfür müssen wir unser System im internationalen Maßstab optimieren. Darum haben wir BEB übernommen und nehmen an NordStream teil, ebenso wie an der Balgzand-Bacton-Pipeline von den Niederlanden nach UK. In Kombination mit dem TTF-Handelsschub, den wir entwickelt haben, hoffen wir, auf diese Weise in der Lage zu sein, den Transporteuren die attraktivsten Angebote machen zu können“.

Angesichts dieser internationalen Strategie der Kompanie kann man natürlich fragen, ob es sinnvoll ist, eine Kompanie wie Gasunie im Staatsbesitz zu belassen. Bis zu welchem Grad repräsentiert Gasunie immer noch holländische Interessen? „Genau wegen unseres grenzüberschreitenden Geschäftes können wir den holländischen Interessen effektiv dienen“, erklärt Coenen. Die nationale TSO, die für das Gleichgewicht des Systems verantwortlich ist, ist ein Tochterunternehmen von Gasunie. Und es liegt im Interesse des holländischen Staates, den Durchfluss von Gas durch Holland und zum TTF attraktiv zu machen. Der Gastransit und Spotmärkte erzeugen Einnahmen in Höhe von vielen hundert Millionen Euro pro Jahr für den Staat. Falls die Kompanie Geschäfte an Fluxys oder andere Konkurrenten abgibt, gehen diese Einnahmen verloren“.

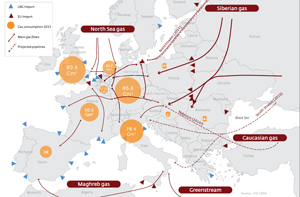

Gas fließt in Europa © Gasunie

Gleichzeitig sagt Coenen, dass Gasunie gerne sehen würde, dass ein privater Investor einen Minoritäts-Anteil an der Kompanie erwerben würde – genauso wie es bei Fluxys der Fall war. Im vorigen Jahr hat der Eigentümer von Fluxys, Publigas, ein Konsortium belgischer Gemeinden, 20% der Anteile der Kompanie an die Caisse de dépôt et placement du Québec verkauft, einem kanadischen Pensionsfond, der auch einen Anteil von 33,5% an der von Belgien nach UK führenden Interconnector-Pipeline hält. „Wenn es gelingt, einen privaten Investor an der Kompanie zu beteiligen“, sagt Coenen, „sieht man die Welt mit anderen Augen. Man wird markt- und international orientierter. Wir glauben definitiv, dass dies für die Kompanie sehr gut ist und daher für die gegenwärtigen Anteilseigner auch“.

Coenen verweist auf die Übernahme des Pipeline-Netzwerkes von OGE durch ein Konsortium privater Investoren: „In Deutschland ist die Beteiligung privater Investoren voll akzeptiert. Es sind 13 Netzwerkbetreiber in Deutschland aktiv. Sie sind an Wettbewerb gewöhnt. Die Menschen dort achten darauf, dass regulierende Rahmenbedingungen und Überwachungsorgane die öffentlichen Interessen adäquat im Blick haben, genau wie in den Niederlanden“.

Wie Gasunie es sieht, muss die Kompanie expandieren, um eine wesentliche Rolle im neuen Infrastruktur-Markt zu spielen. „Die Menschen in Holland fragen sich oft, warum wir das tun. Der Punkt ist, wenn man es nicht tut, wird man Geschäfte verlieren. Und der holländische Marktplatz würde an Bedeutung verlieren – anstatt weiter zu wachsen, wie er das momentan so schön tut. Schließlich liegt das überhaupt nicht im öffentlichen Interesse“. Er verweist auf die Tatsache, dass Gasunie etwa 125 bcm Gas pro Jahr transportiert, obwohl am Markt in Holland nur etwa 40 bcm verbraucht werden.

Die Niederlande waren natürlich in der komfortablen Position, seit nunmehr 50 Jahren sowohl Gaserzeuger als auch Gasexporteur zu sein, aber die Gasvorräte nehmen allmählich ab. In weiteren 20 Jahren wird das Land Gas importieren müssen. Dies ist noch ein weiterer Grund, warum Gasunie im sich jetzt entwickelnden Infrastruktur-Markt seine Position sichern möchte. Coenen: „Leute, die ihre Sicht auf nationale Grenzen beschränken, sehen uns als Monopolist. Aber aus europäischer Sicht sind wir lediglich ein Akteur unter vielen, der sich um Geschäftsanteile bemüht“.

Anreize für Investitionen

Aber nicht nur in den Niederlanden stellen die Leute Fragen. In diesem Stadium ist niemand ganz sicher, wie der europäische Gas-Infrastruktur-Markt in Zukunft aussehen könnte. Die möglicherweise größte Frage ist, wie man einen internationalen, wettbewerbsfähigen Markt schaffen kann, der gleichzeitig vollständig reguliert und vorherrschend immer noch auf nationaler Basis reguliert ist“.

Dies ist ein Punkt, der den Strategen bei Gasunie und anderen Infrastruktur-Kompanien mit Sicherheit Kopfzerbrechen macht. Da die Regulatoren die Tarife festlegen, haben sie das Sagen. Viele im Infrastruktur-Geschäft beklagen, dass die Regulatoren gegenwärtig keine ausreichenden Anreize für Investitionen bieten. Gasunie weiß alles darüber: sie hat sich nicht nur in Deutschland eine blutige Nase geholt, sondern streitet sich auch mit dem holländischen Regulator. Und sie stehen nicht allein. Der Vorsitzende der deutschen Gasgesellschaft Wingas, Gerhard König sagte früher in diesem Jahr, dass mehr Anreize gebraucht werden, um ausreichende Investitionen in die Transport- und Speicherkapazität in Deutschland sicherzustellen. „Derzeit ist es nicht attraktiv, in neue Leitungen für Speicher und Gaskraftwerke zu investieren“, sagte er.

Die schlechte Nachricht für die Infrastruktur-Kompanien lautet, dass unter der jetzigen EU-Gesetzgebung nationale Regulatoren weiterhin für die Festlegung von Tarifen zuständig sind. Die gute Nachricht ist, dass die EU gleichzeitig einen Prozess in Gang gesetzt hat, der zu zunehmender Harmonisierung der Regulationssysteme führen soll. Ein Weg dorthin ist die Schaffung eines ‚Netzwerk-Codes’, nach dem sich alle Marktakteure einschließlich der nationalen Regulatoren richten müssen. Auf diese Weise werden die Aussichten der nationalen Regulatoren, ihrem heimischen Markt ihren Stempel aufzudrücken, zunehmend restriktiv.

Einige Analysten sind sogar davon überzeugt, dass die Internationalisierung und die Konsolidierung unter den TSOs die Harmonisierung stärker voran bringen wird als Netzwerk-Codes und andere regulierende Maßnahmen. Das Management von Gasunie teilt diese Meinung. Wie Paul van Gelder, geschäftsführender Direktor von Gasunie vor kurzem auf einer Gaskonferenz gesagt hat: „Ich glaube, dass unabhängige Infrastruktur-Betreiber maßgeblich dazu beitragen, den europäischen Energiemarkt zu verändern“.

Nichtsdestotrotz kommt man nicht um die Tatsache herum, dass die Regulatoren immer mehr bestimmen, wenn es darum geht zu entscheiden, welche Investitionen in die Infrastruktur vorgenommen werden sollten. In der Vergangenheit haben die TSOs ‚offene Jahreszeiten [seasons]’ abgehalten, bei denen Marktakteure ihr Interesse an neuen Pipelines bekunden konnten. Falls es dabei ausreichende Investitionen gegeben hätte, würde die TSO die Pipeline bauen. In Zukunft kann es sein (obwohl dies Spekulation ist), dass die Regulatoren diesen Prozess übernehmen. Bei der gegenwärtigen Rechtslage können die Transporteure unter bestimmten Bedingungen Investitionen von den TSOs verlangen, wenn sie ein Geschäftsinteresse an der Pipeline belegen können. Sollte die TSO dem nicht folgen wollen, kann der Regulator die TSO dazu zwingen.

Planwirtschaft

Aber Coenen ist davon überzeugt, dass „diese Form der Planwirtschaft“, so unerwünscht diese aus seiner Sicht auch sein möge, die Infrastruktur-Kompanien nicht davon abhalten wird, ihren eigenen Platz unter der Sonne in dem neuen Marktschema zu finden. „Wir machen noch mehr als nur Pipelines bauen“, merkt er an. „Wir investieren auch in die Speicherung, LNG-Terminals und Handelsfreiräume. Wir sehen es als unsere Aufgabe an, den Gasmarkt wachsen zu lassen“.

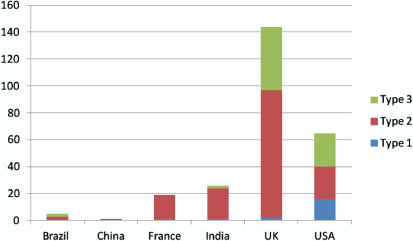

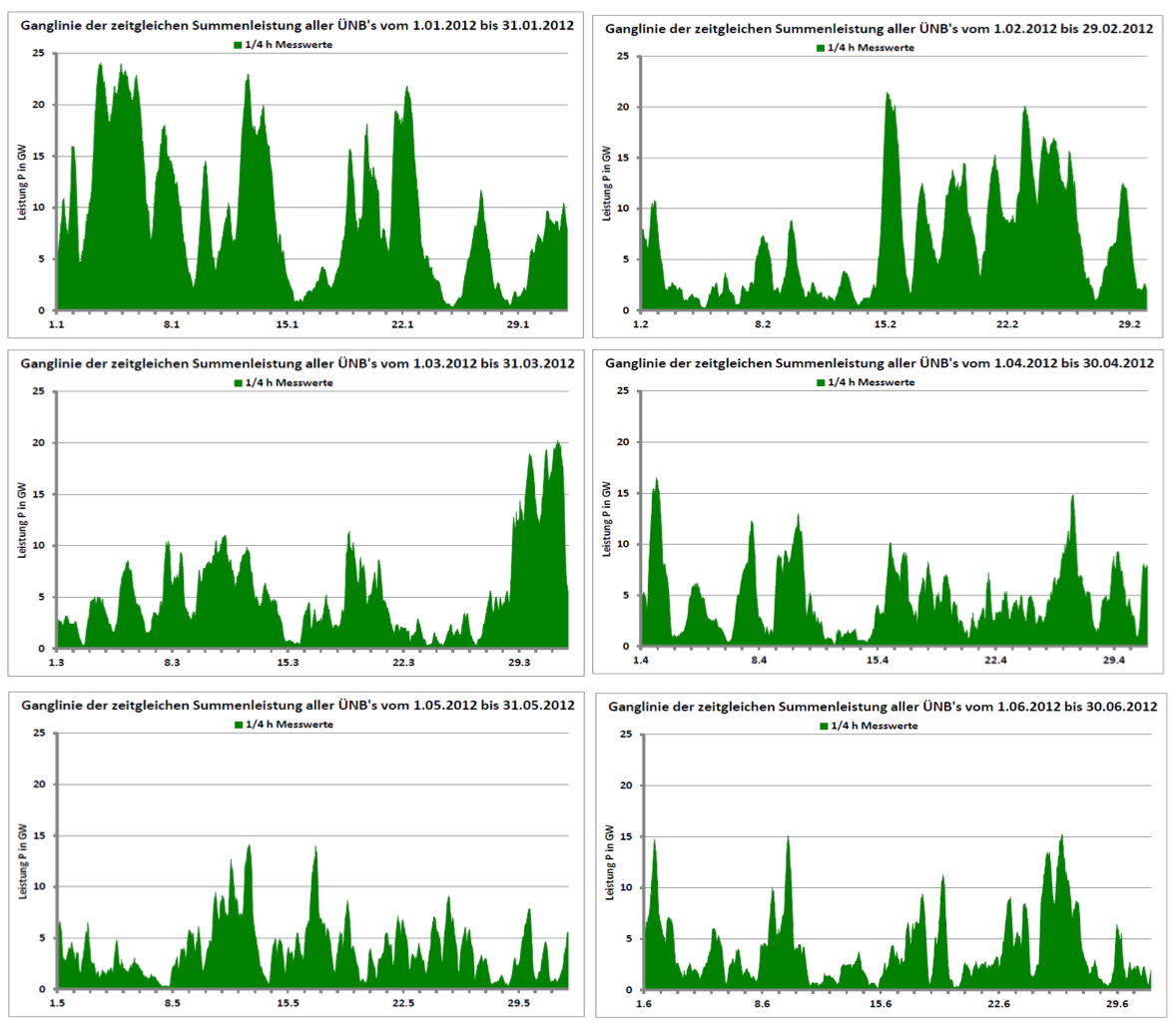

Tatsächlich brennen Gasunie und andere Infrastruktur-Kompanien darauf, die Innovation beim Gasmarkt anzukurbeln. Zum Beispiel haben sich Gasunie, Fluxys und die dänische TSO www.Energinet.dk vor Kurzem geschworen, eine "zu 100% kohlenstoffneutrale Gasversorgung" in ihren Netzwerken bis zum Jahr 2050 zur Verfügung zu stellen. Sie wollen dies erreichen durch Mithilfe bei der Vergrößerung des Biogas-Anteils, durch Investitionen in sog. ‚Power-to-Gas’-Systeme (in welchen überschüssiger Windstrom durch Elektrolyse in Wasserstoff verwandelt wird, welches der Gasversorgung beigemischt wird) und durch das Einrichten eines Gas-Zertifikate-Marktes sowie anderer Dinge.

Gasunie hat zusammen mit anderen Kompanien eine neue LNG-Kette an seinem LNG-Terminal in Rotterdam ins Leben gerufen. Dieses Projekt hat zum Ziel, LNG als Ersatztreibstoff für Diesel für die Schifffahrt und Schwertransporte auf der Straße verfügbar zu machen.

Diese Beispiele zeigen, dass unsere beschauliche neue europäische Gaswelt sich weiterhin auf eine Art und Weise entwickeln wird, die möglicherweise nur Wenige vorhergesehen haben. Infrastruktur-Kompanien wie Gasunie haben sich gebildet, die unvermeidlich die Gelegenheiten nutzen werden, die die neue Marktstruktur bietet und sich daher in ‚mehr als nur TSOs’ transformieren werden.

Coenen zufolge steht eine Kompanie wie Gasunie „ultimativ vor der Wahl: Zuschauer an der Seitenlinie bleiben oder beim Spiel mitmachen und versuchen zu wachsen. Wenn man wächst, gibt es Risiken, aber wenn nicht, besteht das noch größere Risiko, marginalisiert zu werden. Also ist es unsere Aufgabe, effektive Strategien zu entwickeln und die damit einher gehenden Risiken sorgfältig zu bedenken, und uns fortwährend zu verbessern auf der Basis der Evaluierungen und der gelernten Lektionen. Dies ist der Weg, voranzuschreiten und all unseren Anteilsnehmern zu dienen“.

Karel Beckmann

No part of this publication may be reproduced in any form without written consent from the publisher. For inquiries please contact info@europeanenergyreview.eu

Link: http://www.europeanenergyreview.eu/site/pagina.php?email=limburg@grafik-system.de&id_mailing=313&toegang=158f3069a435b314a80bdcb024f8e422&id=3870

Übersetzt von Chris Frey EIKE, mit Dank an Energy Review; Chief Editor Karel Beckmann

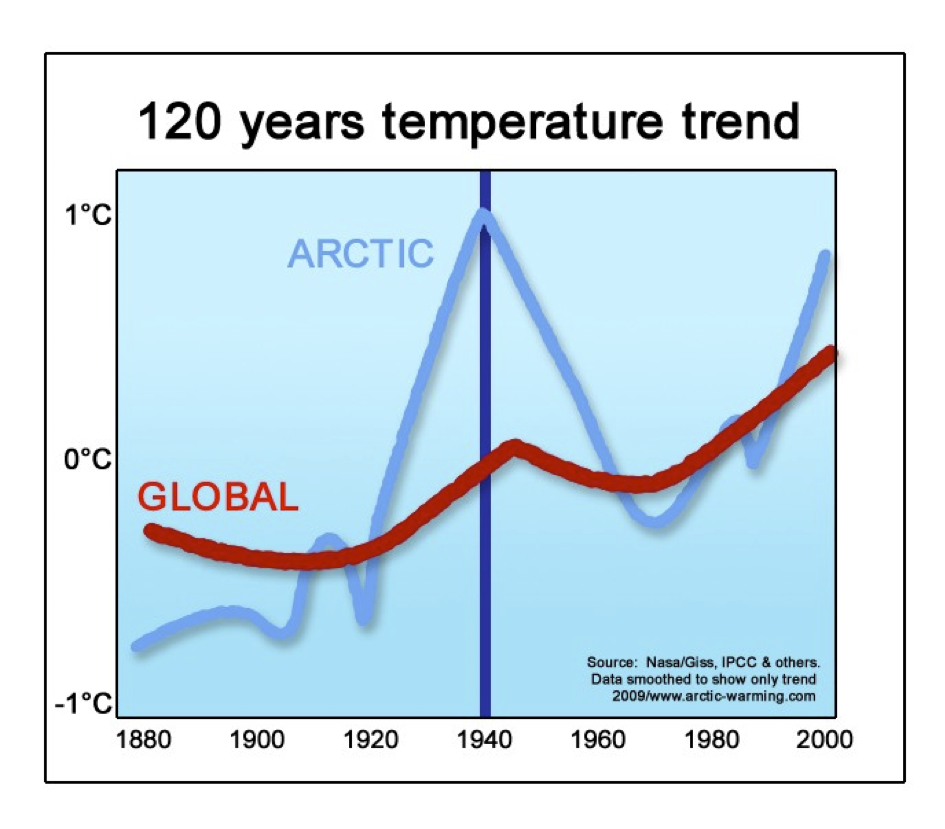

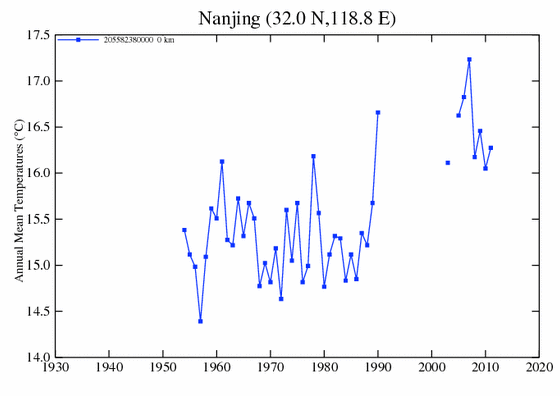

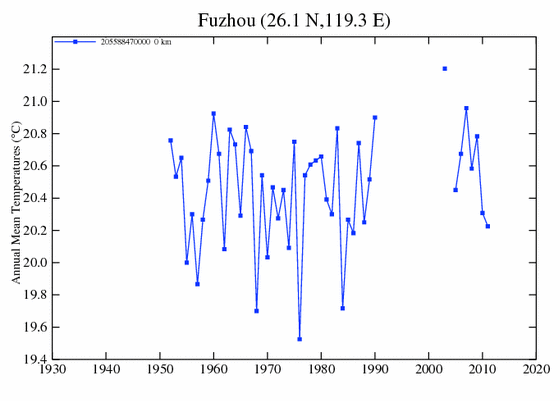

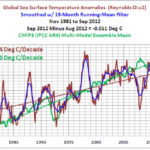

Temperaturschwankungen ausgesetzt ist. Denn genau im Januar 1919 explodierten im hohen Norden die Temperaturen. So einen gewaltigen Temperaturanstieg wurde von der Meteorologie bisher nur dieses eine Mal gemessen und zwar auf Spitzbergen. Man kann es als Klimaknall bezeichnen. Zwischen den Wintermonaten (Jan/Feb) 1917 & 1918 einerseits und der Jahre 1919 & 1920 andererseits liegt eine Differenz von 16°C. Das gilt selbst dann noch, wenn man sich die Winter (D/J/F) der sieben Jahre 1912-1918 und 1919-1925 gegenüberstellt, die einen Sprung noch oben von 10° ergeben.

Temperaturschwankungen ausgesetzt ist. Denn genau im Januar 1919 explodierten im hohen Norden die Temperaturen. So einen gewaltigen Temperaturanstieg wurde von der Meteorologie bisher nur dieses eine Mal gemessen und zwar auf Spitzbergen. Man kann es als Klimaknall bezeichnen. Zwischen den Wintermonaten (Jan/Feb) 1917 & 1918 einerseits und der Jahre 1919 & 1920 andererseits liegt eine Differenz von 16°C. Das gilt selbst dann noch, wenn man sich die Winter (D/J/F) der sieben Jahre 1912-1918 und 1919-1925 gegenüberstellt, die einen Sprung noch oben von 10° ergeben.