Teil 2: „Trittbrettfahrer“ CO2 – Das Phantom der Klimawissenschaft

4. Bleibt noch etwas für CO2 „übrig“?

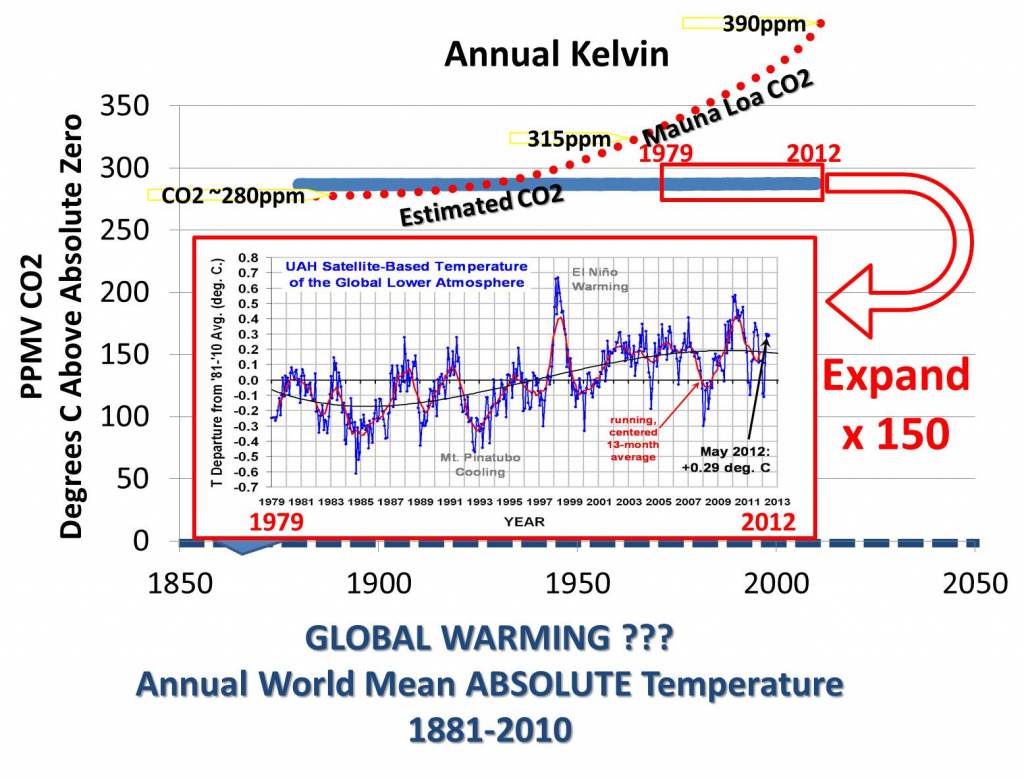

Wir versetzen uns einmal in die Lage der CO2-Anhänger und gehen von der Annahme aus, dass die gesamte Erwärmung Erfurts auf den behaupteten CO2-TE zurückzuführen wäre und suchen nach Korrelationen beider Verläufe seit 1979.

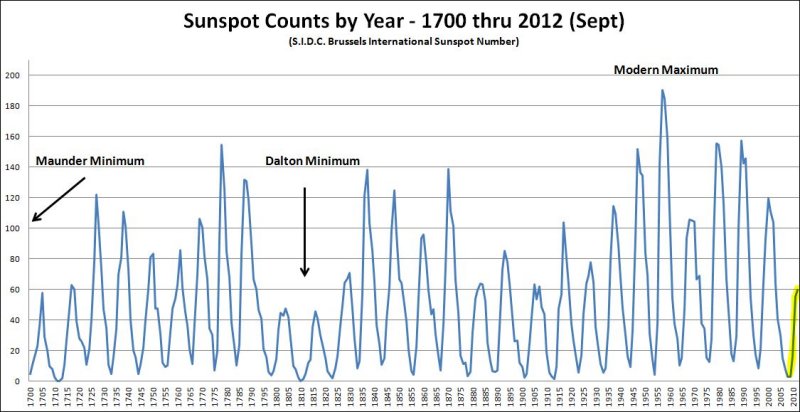

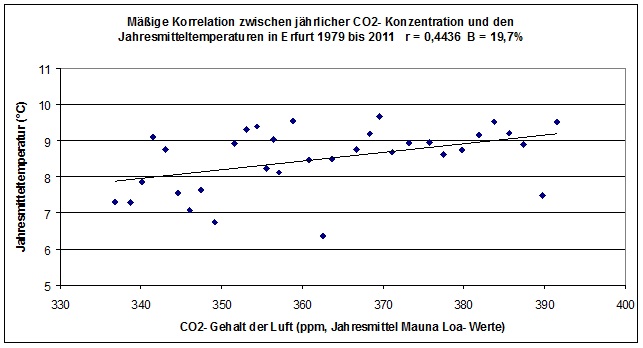

Setzt man die Jahresmittelwerte der CO2- Konzentration, ermittelt am Mauna Loa- Observatorium, zu den Jahresmitteltemperaturen für Erfurt seit 1979 in Beziehung, so kommt immerhin ein mäßiger Zusammenhang heraus:

Abbildung 15

Der positive Zusammenhang überrascht schon deshalb nicht, weil der Langzeittrend (30 Jahre) der Jahresmittelwerte beider Größen angestiegen ist. Handelt es sich also nur um eine „Schein- Korrelation“, oder steckt mehr dahinter? Hierzu ist es notwendig, die Korrelation auch auf kleinen Skalen zu betrachten, da die Lehre von der CO2-basierten Erwärmung eine unmittelbare Ursache-Wirkung-Beziehung fordert und diese postuliert, was z.B. in den Berechnungen nach Stefan & Boltzmann zum Ausdruck kommt. Bereits ein Blick auf den Temperaturverlauf Erfurts für dieses Jahrhundert (wir zeigten ihn eingangs des 1. Teils), lassen Zweifel aufkommen, da seither die Temperaturen fallen, der CO2-Pegel aber beschleunigt ansteigt. So verwundert es nicht, dass unter Physikern die Klimasensitivität von CO2 oder sonstigen sog. Treibhausgase kontrovers diskutiert wird. Sogar ein kühlender C02-TE ist in der Diskussion. Bisher gibt es jedoch keinen wissenschaftlichen Versuchsbeweis zur Bestätigung dieses „CO2-Treibhauseffektes“, so dass deutliche Temperaturveränderungen (Erwärmungseffekte) durch CO2 nicht sehr wahrscheinlich sind.

Viertes Ergebnis: Anhand der obigen Korrelationsbeziehung, wären seit 1979 höchstens 0,25K, Temperaturanstieg in Erfurt durch die Zunahme der CO2- Konzentration verursacht worden- das würde bei (prinzipiell unzulässiger, aber hier mal beispielhaft angewandter) linearer Projektion einem Temperaturanstieg von 0,8K (weniger als 1K!) in 100 Jahren entsprechen. Selbst dieses Ergebnis, das von einem existenten C02-TE ausgeht, der in der Wissenschaft kontrovers debattiert und bisher dort nicht nachgewiesen werden konnte, ist weit entfernt von den Panikvoraussagen mancher Treibhausforscher, deren Vorhersagen um fast das 10-fache höher sind.

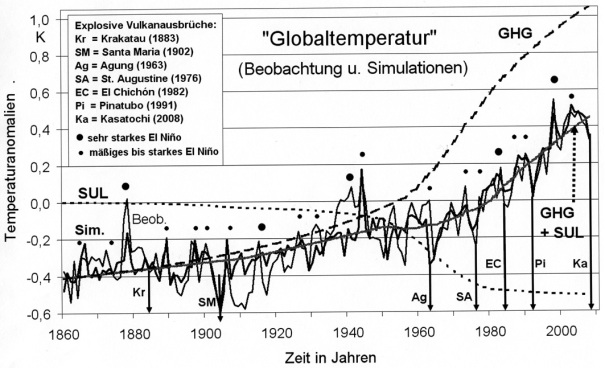

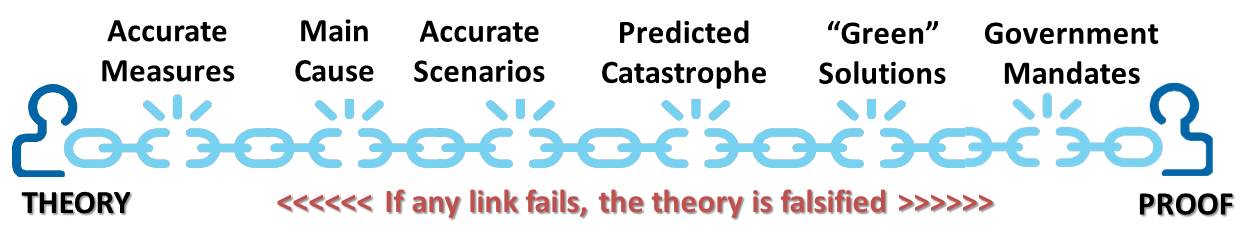

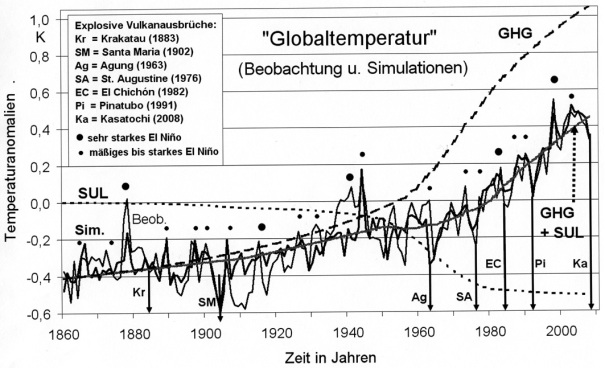

Anmerkung: Häufig wird in Veröffentlichungen die folgende Grafik (Abbildung 15) gezeigt, welche einen erheblichen Einfluss der „Treibhausgase“ auf den Anstieg der globalen Temperatur belegen soll:

Abbildung 16

Simulation (WALTER) der beobachteten global gemittelten

Jahresanomalien 1860–2008 (Referenzperiode 1961–1990) der bodennahen

Lufttemperatur (Beob., dünne Kurve) durch ein neuronales

Treibhausgase (GHG, gestrichelt), Sulfatpartikel (SU, punktiert) und

kombiniert (GHG+SU, grau) sowie Markierung einiger explosiver Vulkanausbrüche

(maximaler Temperatureffekt i.a. ca. 1 Jahr nach Ausbruch)

und El-Niño-Ereignisse

Der entscheidende Mangel bei dieser Darstellung: Zwei ganz wichtige „Verursacher“ des Temperaturanstiegs wurden erst gar nicht in die Untersuchungen mit einbezogen- erstens die Urbanisierungs- und Flächenhaften Wärmeinseleffekte und zweitens solare Effekte, die über die Schwankungen der „Solarkonstante“, oft als „TSI“ (Total Solar Irradiance – Der TSI ist im Grunde eine Mogelpackung, da er „Total“ suggeriert, die Messgeräte in den Satelliten aber nur einen Teil der Sonnenstrahlung erfassen und zwar zwischen 200nm – 2.000 nm Wellenlänge. Gerade die hochvariablen Energiebestandteile der solaren Strahlung, werden gar nicht erfasst!) bezeichnet, weit hinausgehen und beispielsweise unter dem „SVENSMARK- EFFEKT“ zusammengefasst werden. Daher ist der abgeschätzte „GHG- Effekt“ in obiger Grafik deutlich zu groß.

Um die Temperaturen und Wetterlagen in Deutschland und damit auch in Erfurt zu verstehen, muss man sich auf die andere Seite des Globus, in den Pazifik begeben. Die Welt ist ein „Dorf“, nicht nur in unserem Zusammenleben. Seit langem ist bekannt, dass die bekannten El Niño/La Niña-Ereignisse Einfluss auf die Großwetterlagen in Europa haben. Hier sind z.B. die Untersuchungen von Prof. Brönnimann (ETH Zürich, “Pazifik lies Europa erfrieren“) und des MPI für Meteorologie und der University of Cambridge, “Central Pacific El Niño, the “subtropical bridge,” and Eurasian climate“ genannt.

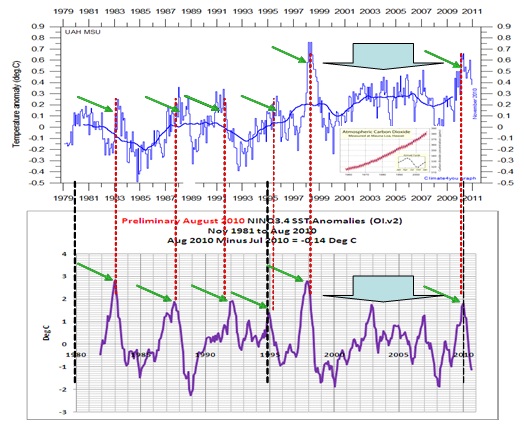

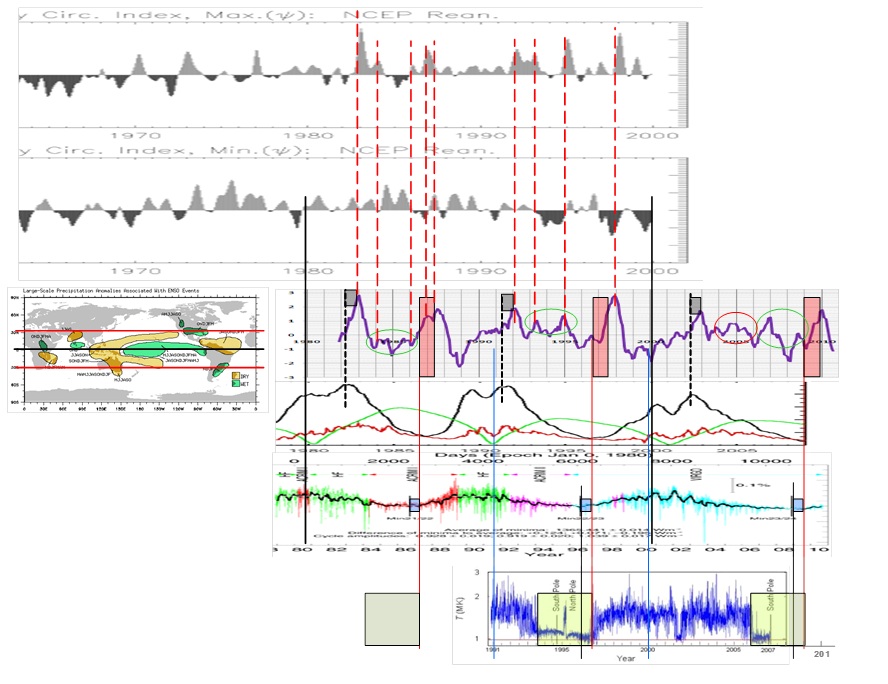

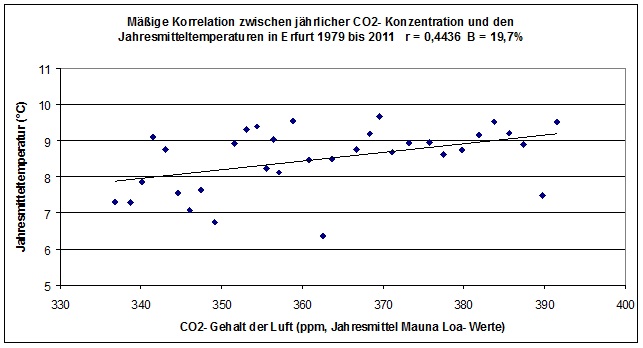

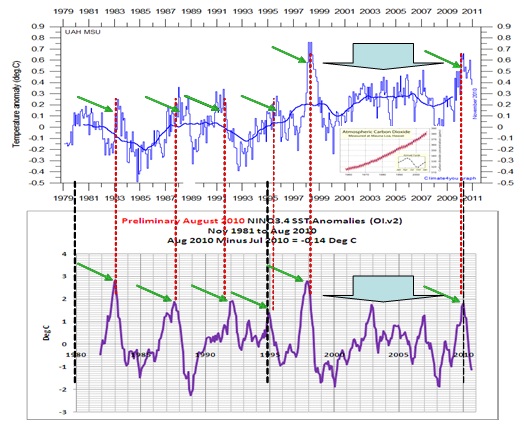

Weiter ist bekannt, wie die globale Mitteltemperatur im Gleichtakt zu El Niño/La Niña-Ereignissen schwankt (folgende Abbildung).

Abbildung 17 oben zeigt die globale Temperaturdatenreihe der letzten 30 Jahre. Die kleine Abbildung zeigt die atmosphärische CO2-Entwicklung nach Mauna Loa. Die Abbildung darunter zeigt die El Niño-Anomalien (El Niño 3.4) der Wasseroberflächentemperaturen. Jede globale Temperaturspitze in den letzten 30 Jahren fällt mit einem El- Niño- Ereignis exakt zusammen und das bei 8 Ereignissen im Betrachtungszeitraum (grüne Pfeile und Blockpfeil). Die schwarzen Linien dienen zur zeitlichen Justierung der Datenreihen. Zur CO2-Entwicklung besteht keine erkennbare Korrelation.

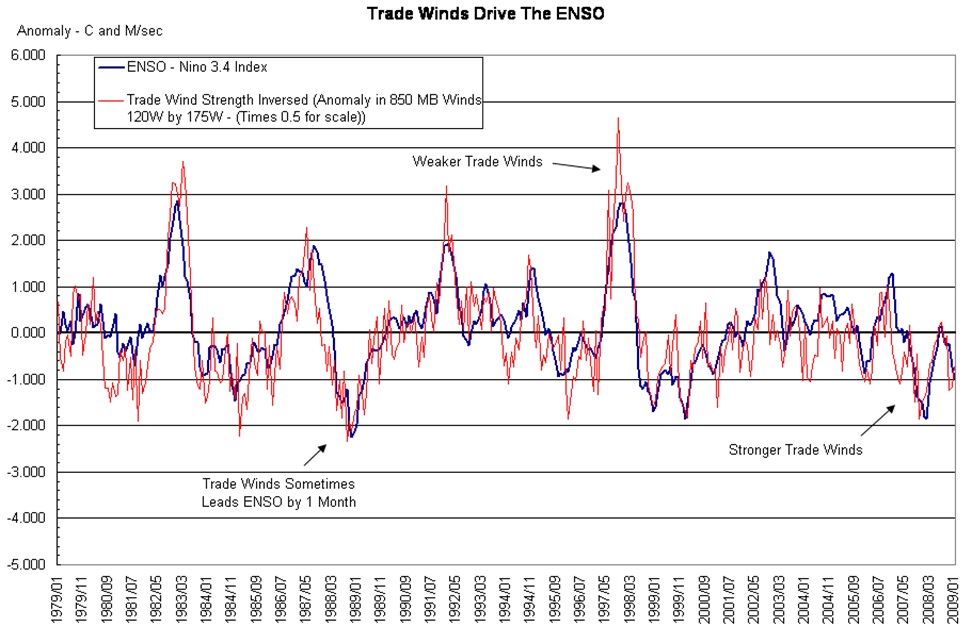

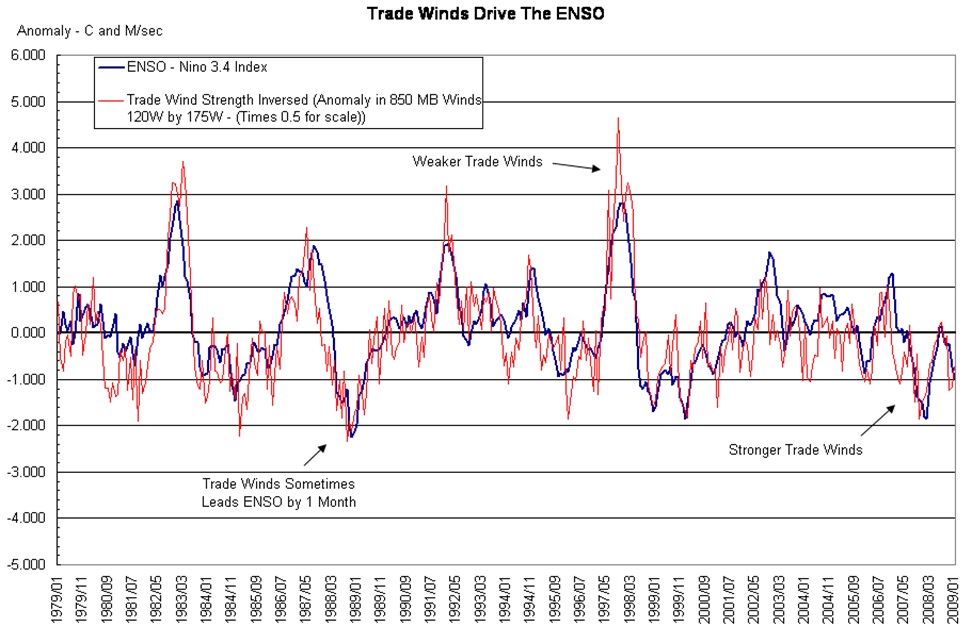

Ebenso ist bekannt, dass El Niño/La Niña-Ereignisse mit der Aktivität der Passatwinde und damit der Ausprägung der Hadley- Zellen zusammen hängen.

Abbildung 18 zeigt die ENSO und die invertierte Windstärke der Passatwinde (Trade Winds). Unschwer ist zu erkennen, dass beide zusammenhängen. Die Passatwinde werden von den Hoch- und Tiefdrucksystemen (neben der Corioliskraft = Erddrehung) bestimmt. Diese wiederum durch die Wolkenbedeckung und dies ist der Ansatzpunkt, wie die Sonne neben ihrer Strahlungsleistung ihren Einfluss auf das irdische Wettersystem umsetzt. Seit Svensmark gibt es eine These, wie die solare Aktivität die Bewölkung beeinflusst. Den Einfluss des Polfeldes (Hale-Zyklus) auf die Wolkenbedeckung wurde bereits gezeigt.

Wie Untersuchungen zeigen, hat sich die Hadley- Zelle im Zeitraum der moderaten Erwärmung zwischen 1979 und 2005 (Anstieg des Hauptsonnenzyklus, des im Mittel 208-jährigen de Vries/Suess-Zyklus – dieser hatte in 2003 sein Maximum und damit die Sonne maximale Aktivität in den letzten 200 Jahren) um 5-8 Breitengrade ausgedehnt und sich dessen Volumen, da auch die Tropopause wegen der erhöhten Konvektion durch die Wärmeflüsse um einige Zehnmeter erhöhte, um ca. 5% vergrößert, D. J. Seidel et al. (2008), ”Widening of the tropical belt in a changing climate“, Nature Geoscience 1, 21-24.

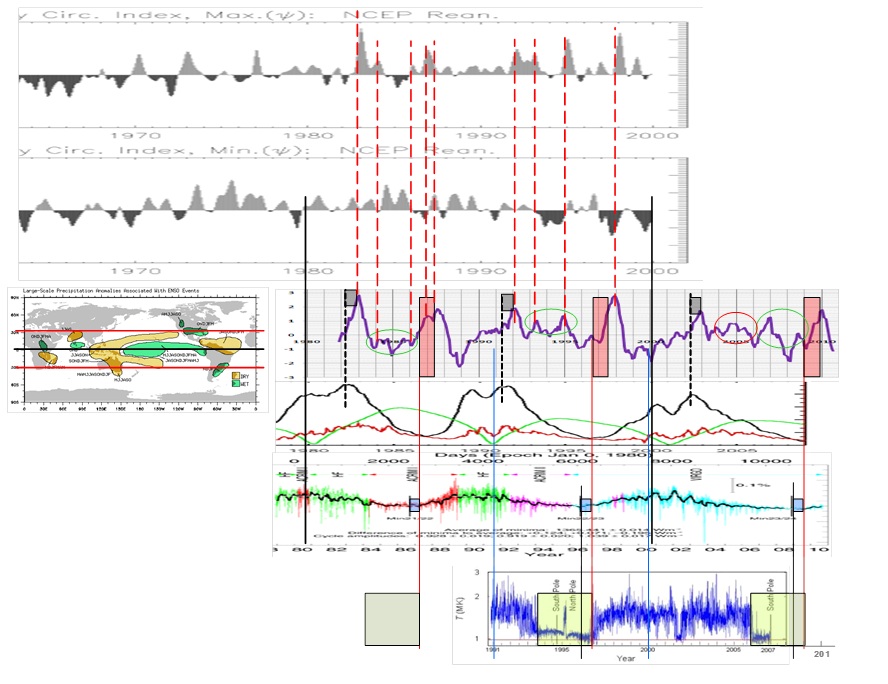

Darüber hinaus fanden Xiao- Wei Quan et al. (“Change of the Tropical Hadley Cell Since 1950“) heraus, dass die Windgeschwindigkeiten in der Hadley- Zelle stark differieren. Werden deren Ergebnisse, mit den solaren Parametern in Verbindung gebracht, ergibt sich folgendes Bild.

Abbildung 19: Wie nicht anders zu erwarten, sind die El Niño- Ereignisse unmittelbar mit der Aktivität in der Hadley- Zelle gekoppelt. Die kleine Abbildung zeigt, wie die Auswirkungen von El Niño um den ganzen Globus zu verzeichnen sind, insbesondere in einem Band von ±30° nördlicher und südlicher Breite, was dem Gebiet der Hadley- Zellen entspricht (kleine Abbildung, oben). Wie die Gesamtabbildung zeigt, ist jeder El Niño einem Hadley- Ereignis direkt zugeordnet (rote gestrichelte Linien) und damit, der solaren Aktivität unmittelbar zuzuordnen. Dazu wird der gezeigte Hadley- Zirkulationsindex verwendet. Dieser wird aus der gemittelten Windgeschwindigkeit der 200 hpa- Höhe, minus der gemittelten Windgeschwindigkeit in der 850 hpa-Höhe gebildet und ist somit ein Maß für die Luftmassengeschwindigkeit und des Luftmassenstroms in der Hadley-Zelle. Die Abbildung zeigt ganz deutlich, dass mit Eintreten eines El Niño-Ereignisses und des entsprechenden solaren Parameters, die Windgeschwindigkeiten in der Höhe zunehmen. Dies ist auch der Schlüssel zu der Erkenntnis, dass die El-Niño-Auswirkungen nicht nur zonal (zwischen ±30° geographischer Breite), sondern global auftreten. Der Grund hierfür ist ein fundamentales physikalisches Gesetz: Der Drehimpulserhaltungssatz.

Drehimpuls

Der Drehimpuls (Einheit: Nms) wirkt bei einer Kreisbewegung in Richtung Zentrum und gibt die Drehachse der Bewegung an. Er steht damit senkrecht zur Ebene, in der sich die Masse bewegt. Der Drehimpuls ist abhängig von der Geschwindigkeit, der Masse, sowie dem Abstand zur Drehachse. Bei Zunahme einer der drei vorgenannten Parameter, wächst der Drehimpuls an. Der Drehimpulserhaltungssatz gibt an, dass der Gesamtdrehimpuls in abgeschlossenen Systemen konstant ist.

Die Wettersysteme der Erde werden in je drei Hauptbänder (jeweils Nord- und Südhalbkugel) eingeteilt:

Hadley- Zelle, links und rechts vom Äquator. Dieser schließt sich die

Ferrel- Zelle an, in der wir leben und der

Polarzelle

Hadley- und Polarzelle sind mit einem ostwärts gerichteten Luftmassenstrom verbunden, wogegen in der Ferrelzelle die Westwinddrift vorherrscht. Sowohl die Ostwinde der Subtropen/Tropen, als auch die Ostwinde der Polargebiete und der Westwind der mittleren Breiten sind mit einem Drehimpuls verbunden. Aus Gründen der Drehimpulserhaltung muss deren Summe Null ergeben.

Verändert sich der Drehimpuls z.B. auf Grund einer Geschwindigkeitszunahme der Luftmassenströmungen in der Hadley- Zelle (siehe vorheriges Chart), so muss dies wegen dem Drehimpulserhaltungssatz Auswirkungen auf die Luftströmungen in den beiden anderen Zellen (Ferrel- und/oder Polar-Zelle) haben. Wird die Geschwindigkeit der Luftströmungen durch ein solares Ereignis in der (oberen) Hadley- Zelle erhöht, so sind (müssen über den Drehimpulserhaltungsssatz) durch die Kopplung über den Drehimpuls auch die anderen Zelle(n) beeinflusst. In der Ferrelzelle sind geringere Drehimpulse, was zu einem ruhigen, kalten Winter führt und somit die Untersuchungen von Prof. Brönnimann und des MPI-M erklären kann.

Zusammenfassung:

Die Ergebnisse zeigen, dass der Einfluss auf unser Wetter/Klima, bis in die heutigen Tage, in erster Linie durch unser Zentralgestirn, die Sonne bestimmt wird. Menschengemachte Einflüsse sind indes vorhanden und treten stark in Erscheinung. Dies sind jedoch nicht die Auswirkungen durch das Ausbringen sog. Treibhausgase wie CO2, sondern die Platzierung der Messstellen an ungeeigneten Orten, sprich, in vom Menschen stark veränderten Landschaften, wie Städten, Großflughäfen oder land- und forstwirtschaftlicher Nutzflächen, also Trockengebieten, die jeglichen Langzeitvergleich der Temperaturen unsinnig machen, sofern sie unberücksichtigt bleiben. Diese Faktoren werden in der wissenschaftlichen Literatur allgemein als Wärmeinseleffekt (WI) oder Urban Heat Island (UHI) bezeichnet. Der immer noch in den Medien hochgehaltene Stab einer THG-basierten Erwärmung ist nicht grundsätzlich auszuschließen. Sofern dieser Einfluss vorhanden ist (Ursache-Wirkung fehlt), ist er mit weniger als 3%-Anteil (weniger als 4 hundertstel °C) an der Gesamterwärmung von 1,3°C vernachlässigbar.

Ausblick

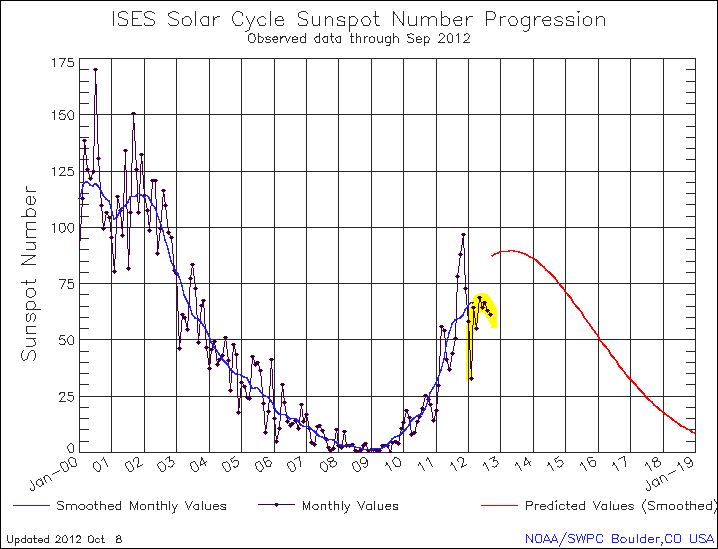

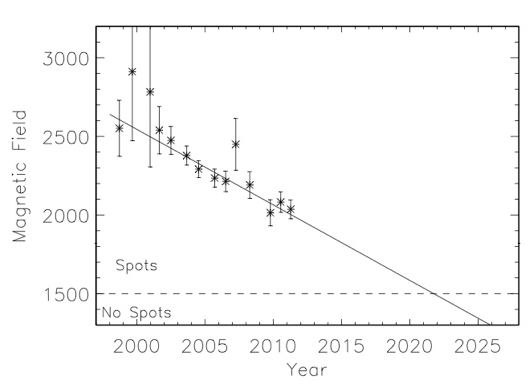

Entgegen den Vorhersagen der auf CO2 basierenden „Klimamodellen“ hat es weder in Erfurt, noch in Deutschland, noch global während der vergangenen 10 bis 15 Jahre einen weiteren Temperaturanstieg gegeben. Diese Stagnation dauert zwar noch nicht lange genug an, um daraus allein mit Sicherheit auf ein generelles Ende des „neuzeitlichen Klimaoptimums“ zu schließen, aber zusammen mit neuen Erkenntnissen über den dominanten Einfluss der Sonne auf das Klima (MALBERG, SVENSMARK, VAHRENHOLT/LÜNING und andere) bringt sie die Vertreter der Theorie einer durch vom Menschen verursachten „CO2- Klimaerwärmung“ zunehmend in Erklärungsnöte.

Schon warnen Experten (z.B.: NASA) vor einer neuen „Kleinen Eiszeit“, infolge der deutlich nachlassenden Sonnenaktivität. Es bleibt nur die Hoffnung, dass auch diese Abkühlungsszenarien zu pessimistisch und übertrieben sind, und die Erkenntnis, dass Klima, trotz neuester wissenschaftlicher Erkenntnisse, nicht über längere Zeiträume vorhergesagt werden kann. Was gesagt werden kann ist, dass Klimawandel ein stetiger Begleiter in der Evolutionsgeschichte ist und wir Menschen nur über die Urbanisierungs- und Flächenhaften Wärmeinseleffekte wesentliche, auf die besiedelten und genutzten Landflächen beschränkte Klimaeinflüsse erzeugen. Die Schreckensszenarien, die zuweilen zu hören sind, entbehren jeder wissenschaftlichen Grundlage.

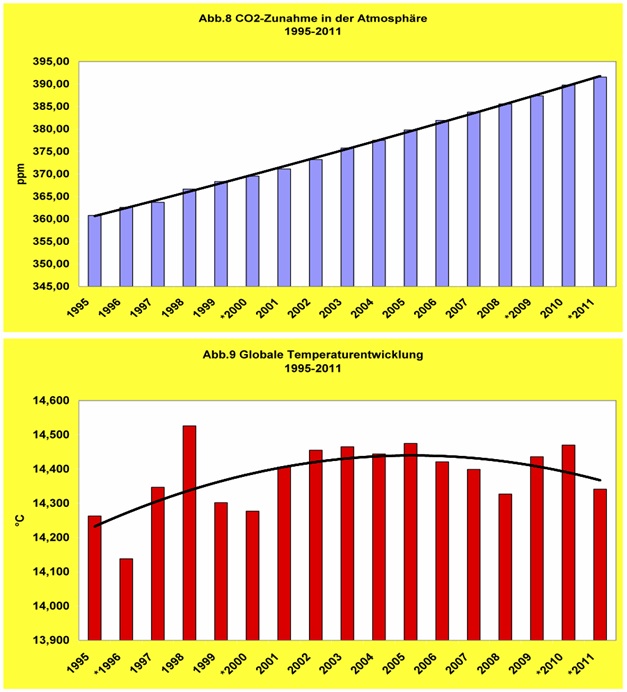

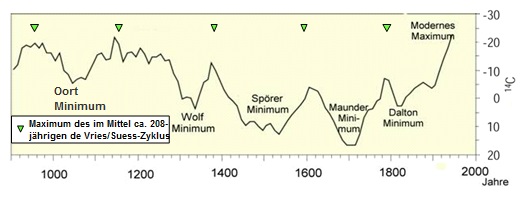

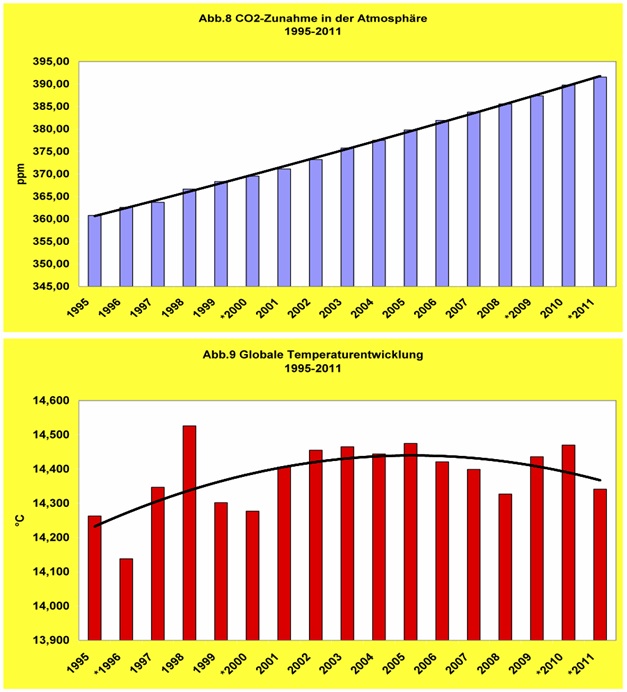

Abbildung 20: Ein Paar, das nicht so recht zusammenpassen will: Während die CO2- Konzentration seit 1995 fast linear gestiegen ist (blaue Säulen in oberer Abbildung), verhält sich die „globale“ Temperatur (physikalisch gibt es keine „Globaltemperatur“, sondern, diese ist ein rein statistischer Wert) gänzlich anders (rote Säulen, aus MALBERG 2012). Inwieweit diese, wie Eisbohrkernuntersuchungen zeigen (Abbildung 21), nach einem Hauptsonnenzyklus (208-jährige de Vriess-Suess-Zyklus, hatte in 2002/2003 sein Aktivitätsmaximum) wieder deutlich fällt, wie NASA und viele andere Forscher es erwarten, muss abgewartet werden, da die inneren Abläufe der Sonne, die ihre Aktivität steuern, zu wenig bekannt sind.

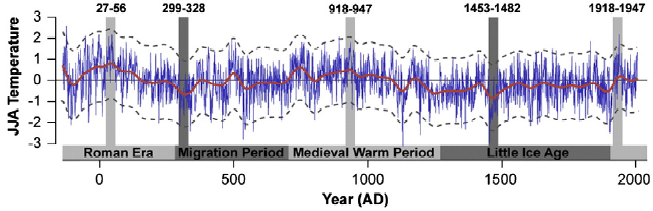

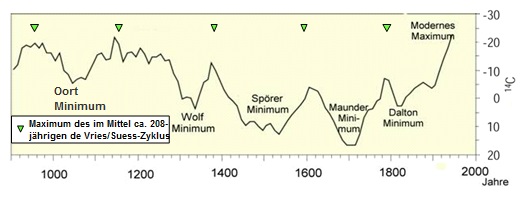

Abbildung 21 zeigt die Kälteperioden der letzten 1.100 (ergänzt nach Quelle: United States Geological Survey, C14-Daten von Reimer et al. (2004)). Die Maxima der Warmperioden korrelieren jeweils mit dem Maximum des de Vries/Suess-Zyklus. Nach jedem Hauptsonnenzyklus fallen die Temperaturen deutlich. Um die Jahrhundertwende im Jahr 2000 hatten gleich drei solare Sonnenzyklen ihr Maximum (deren Maxima fielen zusammen), welche jeweils zusätzlich stark ausgeprägt waren:

– Hauptsonnenzyklus (208-jährige de Vriess-Suess-Zyklus) in 2002/2003

– 36-jährige Brückner-Landscheidt-Zyklus in 2005 (Brückner hat ihn anhand von Klimauntersuchungen entdeckt und der Physiker Landscheidt den Nachweis erbracht, auf was er beruht)

– Magnetische Aktivität im 11-jährigen Schwabe-Zyklus in 2002

Verfasst und zusammengestellt (2012) von

Stefan Kämpfe, Weimar

Josef Kowatsch, Hüttlingen

Raimund Leistenschneider, EIKE

Literatur- und Quellenangaben

Wehry, W. (2009): Mehr Sonnenschein, weniger Nebel und höhere Temperatur- anthropogene Klima- Änderung? Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 47/09 (Sonderbeilage 23/09) vom 09.07.2009

Malberg, H. (2010): Über scheinbare und tatsächliche Klimaerwärmung seit 1850. Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 58/10 (Sonderbeilage 26/10) vom 28.09.2010

Malberg, H. (2012): Über sprunghafte Anstiege von CO2 und globaler Temperatur. Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 09/12 (Sonderbeilage 05/12) vom 31.01.2012

Kämpfe, S. (2012): Zu trockener, warmer, sonniger Herbst 2011 in Thüringen – ungewöhnlich oder einfach nur schön? Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte als Beilage 03/12 (Sonderbeilage 01/12) vom 04.01.2012 und in leicht geänderter Fassung bei www.eike-klima-energie.eu 27.12.2011

Kämpfe, S. (1998): Pflanzen als Klimazeiger- ein Beitrag zur Vegetationsgeografie in Thüringen-. Beilage Nr. 196/1998 zur Wetterkarte des Deutschen Wetterdienstes, Offenbach am Main (liegt nur analog vor)

Koch, H. G. (1953): Wetterheimatkunde von Thüringen. Gustav Fischer Verlag Jena (nur analog vorliegend)

Berliner Wetterkarte e.V (2000 bis 2011): Beiträge zur Berliner Wetterkarte. Klimatologische Übersicht Europa, Monatsausgaben Januar 2000 bis Dezember 2011

Schönwiese, C.-D., Walter, A. (2009): Neue statistische Abschätzungen zur anthropogenen und natürlichen Steuerung des Globalklimas. Bericht in den Mitteilungen der DMG, 01/2009, S. 4-5

Kowatsch, J., Leistenschneider, R. (2010): Der Wärmeinseleffekt (WI) als Antrieb der Temperaturen- eine Wertung der DWD- Temperaturmessstationen. www.eike-klima-energie.eu 04.10.2010

Leistenschneider, R., Kowatsch, J. (2012): Der Wärmeinseleffekt (WI) als maßgeblicher Treiber der Temperaturen. www.eike-klima-energie.eu 20. Januar 2012

Leistenschneider, R., Kowatsch, J. (2012): Der Wärmeinseleffekt (WI) als maßgeblicher Treiber der gemessenen Temperaturen. www.eike-klima-energie.eu 04.08.2012

Peter C. Werner, Friedrich-Wilhelm Gerstengarbe (2010): KATALOG DER GROSSWETTERLAGEN EUROPAS (1881-2009) NACH PAUL HESS UND HELMUT BREZOWSKY 7., VERBESSERTE UND ERGÄNZTE AUFLAGE. PIK Report No. 119

Deutscher Wetterdienst (2010, 2011): Großwetterlagen- Anzahl der Tage. www.dwd.de

Deutscher Wetterdienst (1991 bis 1999): Beilagen zur Wetterkarte des Deutschen Wetterdienstes. Klimatologische Werte für die Jahre und Monate 1991 bis 1999

Deutscher Wetterdienst (2000 bis 2006): WITTERUNGSREPORT und WITTERUNGSREPORT express. Monatshefte Januar 2000 bis Dezember 2006

Deutscher Wetterdienst (Herausgeber): Stadtklima. Hauptschriftleiter M. Schlegel. promet, Jahrgang 9, Heft 4, 1979

http://www.leif.org/research/cloud-cover.png

Meteorologischer Dienst der DDR, Hauptamt für Klimatologie in Potsdam (1979 bis 1990): Monatlicher Witterungsbericht für das Gebiet der Deutschen Demokratischen Republik. Beilage zum Täglichen Wetterbericht. Sonderhefte (Jahresberichte 1979 bis 1990)

Calder, N., Svensmark, H. (2007): The Chilling Stars – A New Theory of Climate Change, übersetzt ins Deutsche von Helmut Böttiger: Sterne steuern unser Klima: Eine neue Theorie zur Erderwärmung. Patmos Verlag, Düsseldorf 2008

Vahrenholt, F., Lüning, S.(2012): Die kalte Sonne. Warum die Klimakatastrophe nicht stattfindet. Hoffmann und Campe, Hamburg 2012

Xiao-Wei Quan et al. “Change of the Tropical Hadley Cell Since 1950“

Standardisierte beziehungsweise normalisierte NAO- Werte Januar 1950 bis Dezember 2011: www.cpc.noaa.gov/

Evan et al. “Arguments against a physical long-term trend in global ISCCP cloud Amounts”

Prof. Brönnimann , ETH Zürich, “Pazifik lies Europa erfrieren“

MPI für Meteorologie und der University of Cambridge, “Central Pacific El Niño, the “subtropical bridge,” and Eurasian climate“

(http://wattsupwiththat.com/2009/02/17/the-trade-winds-drive-the-enso/#more-5702)

American Meteorological Society Journal Online, Volume 13, Issue 5, März 2000

”Length of the solar cycle influence on the relationship NAO-Northern Hemisphere Temperature”, L. Torre, L. Gimeno, M. Tesouro, J. A. Añel, R. Nieto, P. Ribera, R. García, E. Hernández, Geophysical Research Abstracts, Vol. 5, 30-1-2003, European Geophysical Society

United States Geological Survey, C 14-Daten von Reimer et al. (2004)