Die Offshore-Experten von wind:research haben im Juni 2012 in einer Studie, über die die Wirtschaftswoche berichtete (10), ausgerechnet, dass im wahrscheinlichsten Fall 2020 rund 3.000 MW fehlen werden. Bis 2030 würde sich diese Lücke auf 6.000 MW verdoppeln. Im schlimmsten Falle allerdings wären 2020 gerade einmal ca. 3.000 MW auf See installiert – und bis 2020 käme kein einziges Windrad hinzu.

Dieser schlimmste Fall würde nach Einschätzung der wind:research-Experten eintreten, wenn die Übertragungsnetz-Betreiber vor den gewaltigen Kosten der Stromanbindung der Meeres-Windparks kapitulieren. Vor allem fürchteten sie die unbegrenzte Haftung für verspätete Anschlüsse.

Die Offshore-Windkraft heute

Gegenwärtig arbeiten nach offiziellen Berichten folgende Offshoreanlagen:

– alpha ventus (Nordsee): 12 WEA mit insgesamt 60 MW Leistung (4)

– Baltic 1 (Ostsee) : 21 WEA mit zusammen 48,3 MW (4)

– BARD Offshore 1 (Nordsee): bisher 16 WEA mit zusammen 80 MW (3)

– sowie 3 Einzelanlagen in Nord- und Ostsee mit zusammen 12 MW (4)

Das ergäbe bescheidene 200 MW.

Rechnet man die auf BARD Offshore 1 angeblich fertiggestellten, aber nicht angeschlossenen 4 WEA und die 33 begründeten, aber noch leeren Fundamente, die hoffentlich Ende 2013 alle ans Netz angeschlossene Windräder tragen, als "im Bau befindlich" hinzu, dann könnten sich Ende 2013 weitere 185 MW hinzufügen (3). Theoretisch hätte man dann 305 Megawatt Offshore-Strom.

Aber leider nicht 3.000 MW. Mit einer Planung um den Faktor 10 daneben zu liegen, ist nicht sehr vertrauenserweckend.

Eine schlichte Nachprüfung

Die Wirklichkeit, die sich jedoch ergibt, wenn man den Erfolgsmeldungen auf den Grund geht, sieht abermals anders aus.

Rolf Schuster, der die Stromerzeugung der "Erneuerbaren" regelmäßig genauer unter die Lupe nimmt, hat jetzt die Offshore-Stromerträge aus der Nordsee, die der Netzbetreiber Tennet verzeichnete, näher betrachtet.

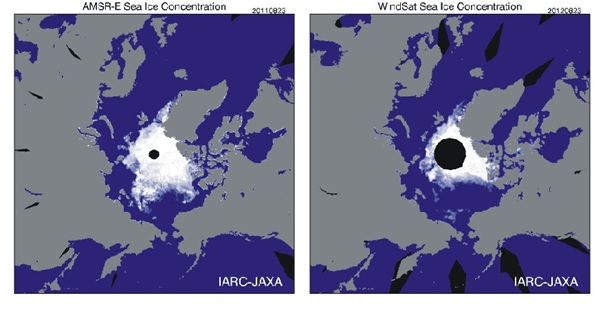

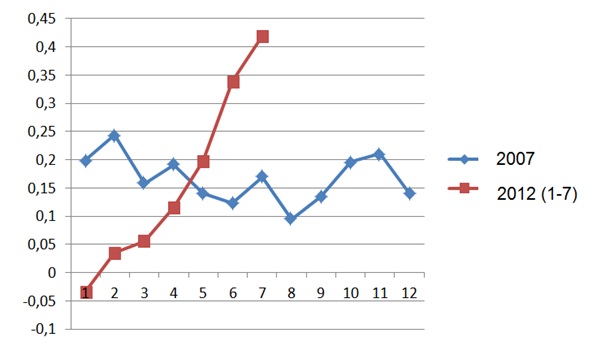

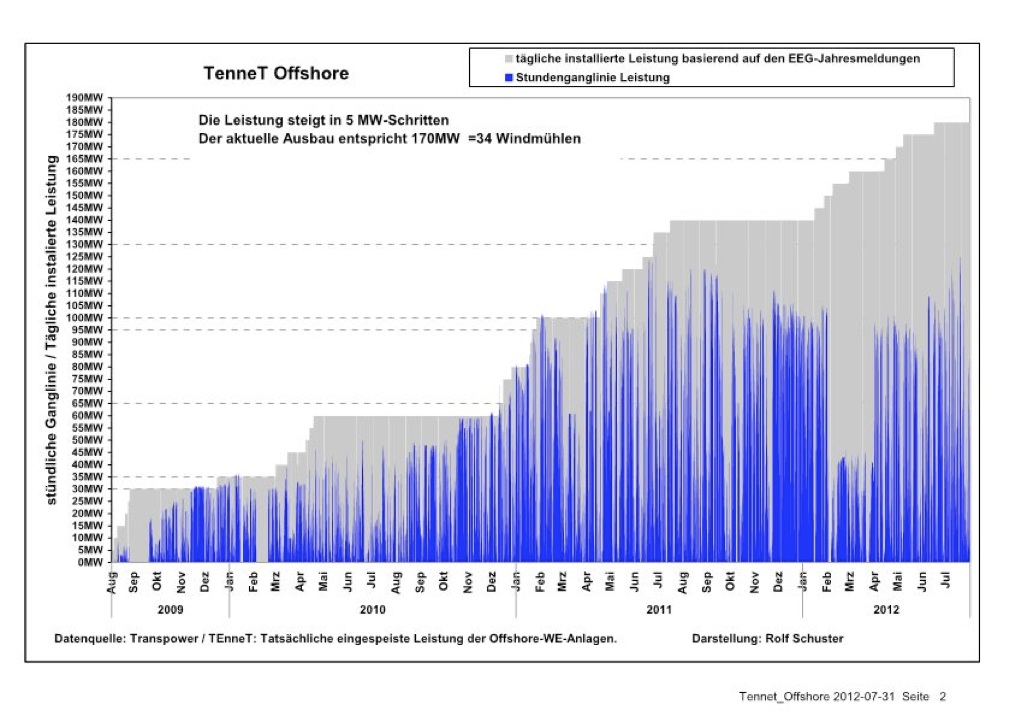

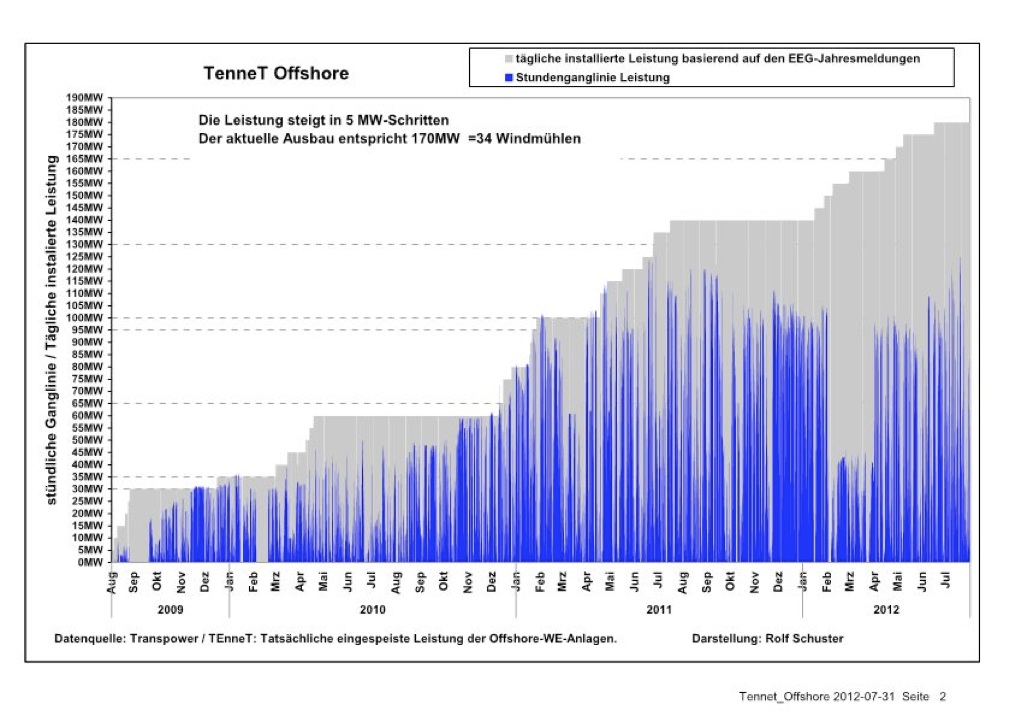

Abb. 1 (1) stellt für den Zeitraum 2009 bis Juli 2012 einerseits die Stundenganglinie der gesamten ins Tennet-Netz gelieferten Nordsee-Offshore-WKA-Leistung dar (blaue Leistungsspitzen) und darüber die zum jeweiligen Zeitpunkt angeblich installierte und verfügbare Gesamtleistung (als graue, treppenförmig ansteigende Fläche). Quelle: Tennet. Darstellung: Rolf Schuster

Diese Grafik ist vielsagend. Zum einen vermittelt sie das typische zerrissene Bild der zeitlichen Windstromerzeugung, das sich wegen der extrem nichtlinearen Abhängigkeit der Windradleistung von der Windgeschwindigkeit (die Leistung steigt und fällt mit der 3. Potenz der Windgeschwindigkeit, fällt somit bei halber Windgeschwindigkeit auf ein Achtel ab) und dem schwankenden Windangebot zwangsläufig ergibt.

Stephan Kohler, der Leiter der bundeseigenen Deutschen Energie-Agentur Dena warnte deshalb, daß man sich "von den gewaltigen Zahlen nicht blenden lassen dürfe", denn "von der hohen installierten Leistung seien gerade einmal sechs Prozent wirklich verlässlich verfügbar".

Weiterhin zeigt Abb. 1, daß es – zumindest bis Juli 2011 – regelmäßig Leistungsspitzen bis auf 100 Prozent der installierten Maximalleistung gab. Das kann man bei Offshore-Anlagen auch erwarten. In jedem Monat gibt es einige Starkwindereignisse, die sehr kurz sein können, die aber dann die bezüglich der Größe von Tiefdruckgebieten räumlich benachbarten Nordsee-Anlagen gemeinsam zu einer kurzen 100%-Leistungsspitze veranlassen. Damit hat man aber zugleich einen Test für die Anzahl der tatsächlich am Netz befindlichen WEA im Vergleich zu der Anzahl der installierten Windräder. Sind alle installierten WEA auch am Netz, müssen die Kurzzeit-Leistungsspitzen mehrfach die Obergrenze (grau) berühren.

Und hier zeigt sich die erste Überraschung: Ab Juli 2011 geschieht das nicht mehr. Die Leistungsspitzen erreichen weiterhin nur maximal 130 MW, obwohl die installierte Leistung laut Tennet-Daten im Juli 2012 angeblich sogar 180 MW erreichte. Das entsprach aber nicht den Tatsachen (s.u.)

Und ein zweiter Effekt zeigt sich deutlich: Im Februar und März 2012 bricht selbst diese stagnierende Leistungsabgabe noch um mehr als 50% ein (s. dazu auch Abb. 2).

Daraus ergeben sich zwei Schlussfolgerungen:

1. Seit Juli 2011 hat es keinen Zubau der nutzbaren Offshore-Windkraft in der

Nordsee gegeben. Und das betrifft offensichtlich allein die im Bau befindliche

Anlage BARD Offshore 1.

Damit stagnierte die Gesamt-Maximalleistung der Nord- und Ostsee-WEA ein

Jahr lang bei 190 MW.

2. Im Februar und März 2012 waren nur noch ca. 45 MW an Nordsee-WEA-Leistung

am Netz. Entweder gab es eine achtwöchige windschwache Periode, die man

dann allerdings auch an Land erlebt hätte (siehe dazu Abb. 2), oder ca. 55 MW

sind ausgefallen, was 11 Windräder zu je 5 MW bedeutet. Welchen der

Windparks das betraf, ist noch nicht bekannt. Diese Nachricht muss uns

entgangen sein; es sei denn, es gab sie nicht.

Während dieser 2 Monate betrug die Gesamt-Maximalleistung aller Offshore-

WEA bescheidene 135 MW.

Erklärungen findet man interessanterweise in einem Bericht über BARD Offshore 1 bei Wikipedia (3). Dort ist im Kapitel "Geschichte" zu lesen:

"Mitte August 2011 waren 19 der 80 Windenergieanlagen aufgestellt, 16 waren am Netz. Im Mai 2012 standen 53 WEA-Fundamente, 20 waren komplett aufgestellt, von denen 16 Strom lieferten."

Zwischen August 2011 und Mai 2012 wurde somit nur eine einzige WEA zusätzlich aufgestellt – und keine einzige WEA wurde in diesem Zeitraum ans Netz angeschlossen. Damit stagnierte die Nordsee-WEA-Leistung bei rechnerisch 60 MW (Alpha Ventus) plus 80 MW (BARD 1; 16 WEA zu je 5 MW), also 140 MW. Aus Abb. 1 ergibt sich 130 MW – eine befriedigende Übereinstimmung.

Und noch etwas wird klar: Die in Abb. 1 von Tennet gelieferten Daten zur angeblich installierten Leistung – die stolz ansteigende Treppenkurve – sind ab Juli 2011 nicht korrekt. Nur ein einziges Windrad kam hinzu – nicht angeschlossen.

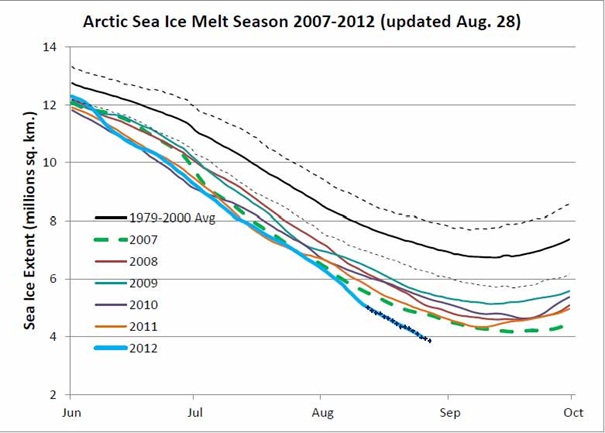

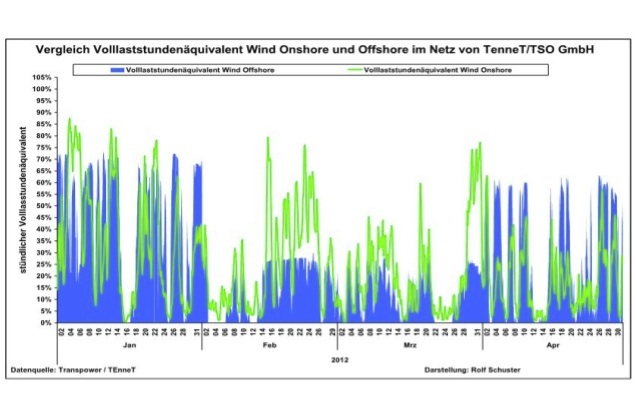

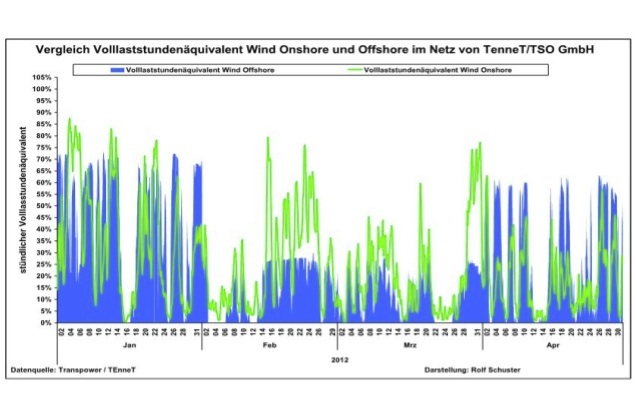

Die in Ziff. 2 aufgestellte Frage wird durch Abb. 2 beantwortet.

Abb. 2: Hier wurden die stündlichen Leistungs-Prozentwerte der Land- und der Nordsee-WEA für den Zeitraum Januar bis April 2012 zusammen dargestellt – Land-Windräder in grün, Offshore-Anlagen in blau. Quelle: Tennet, Darstellung: Rolf Schuster

Außerhalb des Zeitraums Februar und März übersteigen die Offshore-Leistungsspitzen die der Land-Windräder, was zu erwarten ist, denn aus diesem Grunde ist man ja mit der Windkraft auf die See gegangen. Im Februar und März 2012 aber übersteigen die Leistungsspitzen der Land-WEA die der Nordsee-WEA z.T um mehr als das Doppelte – und von Flaute oder Schwachwindperiode in diesen 8 Wochen gibt es keinerlei Anzeichen. Der drastische Leistungseinbruch der Offhore-WEA wurde somit durch den Ausfall von Anlagen verursacht.

Beim Windpark BARD-Offshore 1 gestatten die Daten trotz der schönfärberischen offiziellen Darstellung einen Blick auf die tatsächliche Situation. Dem Netzbetreiber Tennet, der ab Winter 2011/2012 als angeblich Schuldiger an allen Verzögerungen in die Schusslinie mehrerer Mitwirkender im großen Offshore-Spiel geriet, kann in diesem Falle niemand etwas vorwerfen: Nicht existente Windräder kann man nicht ans Netz anschließen.

An diesem Beispiel kann man erkennen, wie man aus objektiven Daten die tatsächlichen Zustände in der Offshore-Windkraft beurteilen kann.

In der Nordsee tut sich weit mehr

Es gibt eine ganze Reihe weiterer Windparkprojekte in der Nordsee, die angeblich durch die zögerliche oder unterbliebene Netzanbindung durch Tennet verzögert wurden und bei denen Schadensersatz-Forderungen erhoben werden. Tennet ist schließlich für die Netz-Anbindung aller in dem von Deutschland kontrollierten und beanspruchten Teil der Nordsee im Bau befindlichen und geplanten Windparks zuständig und verantwortlich. Bei den beklagten Schäden geht es vor allem um ausgebliebene Stromverkaufserlöse. Die seit gut einem halben Jahr vor allem von einflussreichen Windpark-Betreibern betriebene Kampagne, die sich zunächst gegen Tennet und dann aber mit Tennet gegen die Regierung richtete, ist ein Lehrstück für den Umgang der Wirtschaft mit einer Politik, die sich selbst erpressbar machte.

Ein erster Schuldiger ist gefunden: Der Netzbetreiber

Der Ablauf:

Der im Staatsbesitz befindliche niederländische Netzbetreiber Tennet, der im vergangenen Jahr das 11.000 km lange Höchstspannungsnetz von E.on gekauft hat, ist gesetzlich verpflichtet, alle Windparks in der Nordsee anschließen. Für die Anbindung der Windparks an die Stromnetze auf dem Festland haben die Netzbetreiber feste Fristen (31).

Zwölf genehmigte Nordsee-Windparks bzw. deren Antragsteller oder Betreiber besitzen eine Netzanschluss-Zusage von Tennet:

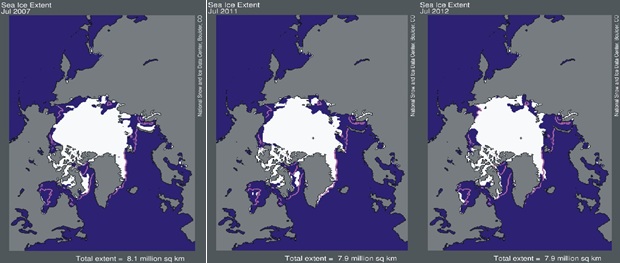

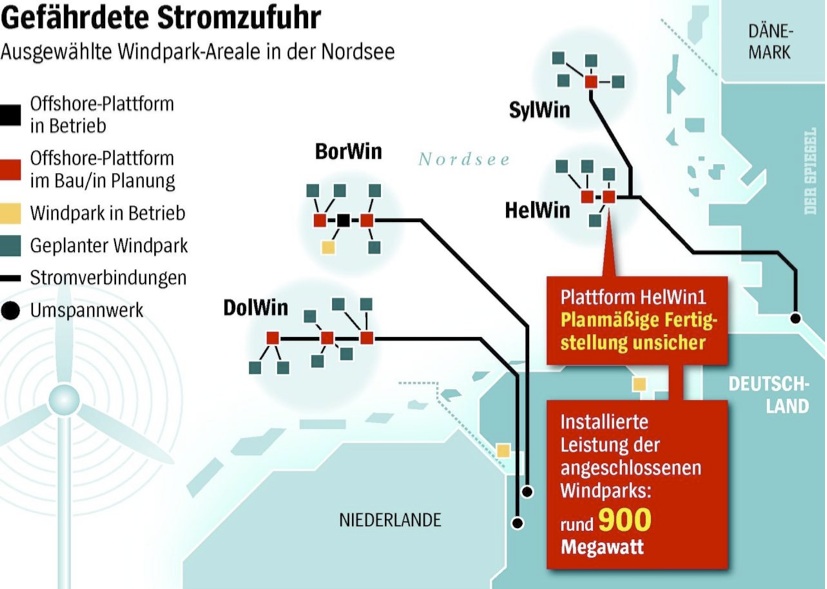

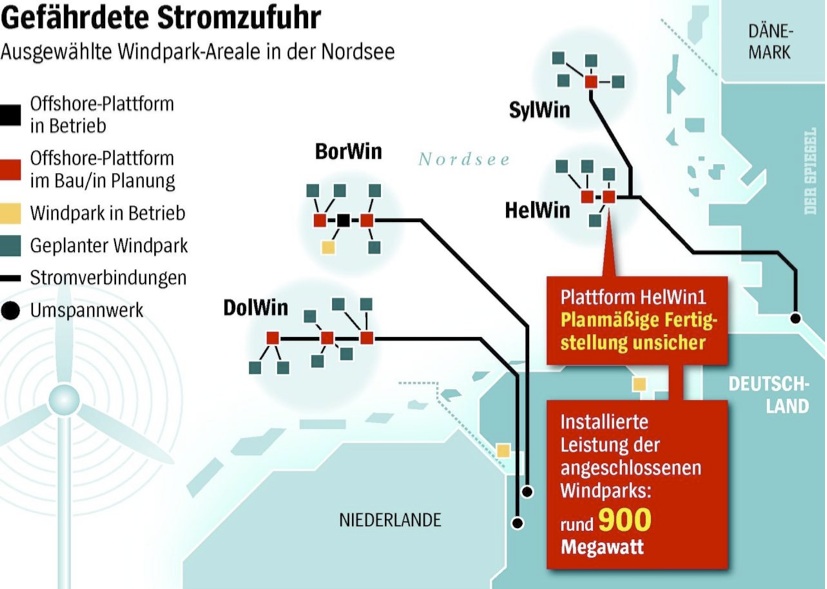

Borkum West II, MEG Offshore, Borkum Riffgrund, BARD Offshore 1, Veja Mate, Global Tech I, Deutsche Bucht, Nordsee Ost, Meerwind, Amrumbank, Dan Tysk und Butendiek. Sieben riesige Umspann-Plattformen, an die alle Windparks angeschlossen werden sollen, sollten errichtet werden: Alpha Ventus, BorWin 1 und 2 (Borkum), HelWin 1 und 2 (Helgoland), SylWin 1 (Sylt) und DolWin 1 (Dollart) – siehe Abb.3. In Betrieb sind Alpha Ventus und BorWin 1; bei drei weiteren ist die Fertigstellung z.T. um 1,5 Jahre verzögert.

Am 22. November 2011 startete Tennet einen ersten Versuchsballon: Er sehe Probleme bei deren Anbindung. Die Errichtung von Anschlüssen sei in der bisherigen Form nicht länger möglich, zitierte die SZ aus einem Brief der Geschäftsführung an Kanzleramt, Umwelt- und Wirtschaftsministerium. Wegen der steigenden Zahl von Anschlussinteressenten "stießen alle Beteiligten an die Grenzen ihrer Ressourcen". Hinzu kämen Probleme bei der Kapitalbeschaffung. Bei allen laufenden Projekten "gingen Planung und Bau nur unter Schwierigkeiten voran". Der Zeitplan könne mangels hinreichender Finanzierung und wegen Schwierigkeiten bei der Beschaffung der Technik nicht eingehalten werden. Wahrscheinliche Verzögerung: ein Jahr.

Eine Tennet-Sprecherin betonte anschließend, alle bestehenden Projekte zum Anschluss von Windparks stünden "völlig außer Frage". Tennet wolle aber mit der Bundesregierung und den am Netzausbau beteiligten Partnern "darüber diskutieren, wie der Anschluss der Anlagen auch in Zukunft geleistet werden könne" (11).

Dieser Brief erreichte die Regierung kurz nachdem die Bundesnetzagentur Anfang November 2011 die Rendite-Obergrenze für die Netzgesellschaften lediglich auf immer noch stattliche 9,05 % gesenkt hatten – und nicht, wie zunächst geplant, auf 8,2 %. "Der Vorwurf, in Deutschland seien Investitionen in die Netze nicht attraktiv, sollten nun endgültig vom Tisch sein", kommentierte der damalige Präsident der Agentur, Matthias Kurth. Verbraucherschützer beklagten, dass die Netzbetreiber ihre Renditen auf Kosten der Verbraucher erhöht hätten.

Kontra gab es umgehend von Tennet: "Eine Rendite von 9,05 % ist im internationalen Vergleich für viele Investoren oft nicht ausreichend", erklärte Tennet- Sprecherin Hörchens. Sie fügte hinzu, daß es schliesslich um 13.000 MW Offshore-Leistung in Nord- und Ostsee sowie um noch einmal 12.000 MW an Land ginge (4).

Möglicherweise ist aber diese Renditebetrachtung eher akademischer Natur. Felix Goedhart, der Vorsitzende der Capital Stage AG, einer Hamburger Investment- und Betreiberfirma von Solar- und Windparks, stellte nüchtern fest: "Zurzeit sind Offshore-Windparks aus Investorensicht völlig unattraktiv. Es ist ratsam, bei Offshore-Wind zu drosseln, Erfahrung zu sammeln und dadurch große Fehler zu vermeiden, um dann in Ruhe die Ausbauziele zu erreichen". Eine Empfehlung, die in Berlin auch Dietmar Schütz, Präsident des Bundesverbandes Erneuerbare Energien, gab: "Wir sollten im Offshore-Bereich die Kurve wesentlich flacher halten und das Ganze von der Kostenseite her betrachten". Wie sich zeigt, denkt die Regierung nicht daran, diesen Ratschlägen zu folgen.

Jetzt ist die Energiewende in Gefahr

In einem Brief vom 6. Dezember 2011 warnte daraufhin RWE die Bundesregierung unvermittelt vor einem Scheitern der Energiewende. Begründung: Die "zeitliche Realisierung von Netzanschlüssen" bei Offshore-Windparks hätte sich "dramatisch verschärft". Der Ausbau des Sektors und damit auch die Ziele der Bundesregierung seien massiv gefährdet. Und. "Wir selbst sind durch diese Entwicklung in eine schwierige Lage geraten" (13). Eine Sprecherin von RWE-Innogy bezifferte den durch die Verzögerung entstandenen Schaden auf einen dreistelligen Millionenbetrag. Eine Schadensersatzklage sei nicht ausgeschlossen.

Die RWE-Vorstände hatten auch gleich einen Vorschlag parat: Die Bundesregierung möge die EEG-Vergütungen für Offshore-Windstrom aus den betroffenen Anlagen erhöhen oder die Dauer dieser Zahlungen verlängern.

Dies ist insofern interessant, als der Energiekonzern bereits in seiner ersten Reaktion auf die ihm nicht vom Staat zugefügten Schäden sofort auch die Stromverbraucher zur Kasse bitten möchte, die bekanntlich die EEG-Vergütungen für Ökostromerzeuger zu bezahlen haben.

Der SPIEGEL stellte dazu fest, daß in Berlin "wenig Bereitschaft bestünde, das nach zähen Verhandlungen verabschiedete Gesetzespaket zum EEG und zu Energiefragen wieder aufzuschnüren". Tatsächlich war die Bundesregierung zu diesem Zeitpunkt zwar erschreckt, aber noch nicht genügend weichgekocht.

"Anpassung der Rahmenbedingungen"

Gegen Jahresende legte Tennet nach: Es verbreitete sich die Nachricht, dass Tennet "bis zu einer Anpassung der Rahmenbedingungen" an die rasante Entwicklung keine weiteren HGÜ-Netzanbindungen (Hochspannungs-Gleichstrom-Übertragung) für Offshore-Windparks mehr in Auftrag gibt. Quasi über Nacht habe es einen Stopp von Investitionen gegeben. Auch der Netzbetreiber hatte jetzt vor allem "bessere Rahmenbedingungen", also Hilfen vom Staat im Auge. Eigentlich eine recht ungewöhnliche Reaktion auf eine schwierige wirtschaftliche Lage, in die man sich schliesslich selbst gebracht hatte. Ob daran eventuell auch weitere Geschäftspartner von Tennet eine Mitschuld traf, wie Tennet es später erklärte, sollte allein zwischen diesen geklärt werden. So funktionierte zumindest bisher die Wirtschaft in Deutschland.

Zu diesem Zeitpunkt war bereits bekannt, daß Tennet in Finanzierungsproblemen steckte. Erst im Juni 2012 erfuhr man Zahlen: Nach eigenen Angaben hätte Tennet bis dahin 6 Mrd. Euro in die deutsche Energiewende investiert und müsste für die noch folgenden Offshore-Netzanschlüsse weitere 15 Mrd. Euro nachlegen.

Auch die Behörden sind jetzt schuld

RWE meldete sich am 10. Januar 2012 mit neuen Vorwürfen. Jetzt hatte man den Bund als neuen Schuldigen im Visier: Die Genehmigungsbehörde Bundesamt für Seeschiffahrt und Hydrographie (BSH) in Hamburg: Beim Bau des Windparks Nordsee-Ost seien langwierige Genehmigungsvorgänge Schuld an der Verzögerung, so der damalige Vorstandsvorsitzende Prof. Dr. Fritz Vahrenholt. Auch für die beiden anderen Energieunternehmen Wind MW GmbH und E.on Climate & Renewables würden die Genehmigungshindernisse in der Netzanbindung der Windparks an der deutschen Küste Probleme bereiten (18).

Noch traten sich die Beteiligten gegenseitig vor das Schienenbein: Die Geschäftsführerin des Offshore-Forums Windenergie, Ursula Prall, erklärte Anfang Februar, "daß das eigentliche Problem darin bestünde, dass die Genehmigungsanträge (beim BSH) so maßlos spät gestellt werden" (4).

Das Vorzeigen der Folterinstrumente für die Regierung: Baustopp

Am 11. Februar 2011 holte dann E.on den großen Hammer heraus und warnte vor einem Baustopp bei allen Hochsee-Windparks – mit der Konsequenz des Scheiterns aller Ausbaupläne der Regierung. Dieses Problem gefährde die Energiewende ganz akut – womit E.on die magische Floskel aussprach.

Die Stromnetzbetreiber kämen mit dem Anschluss der Windparks nicht hinterher, sagte Sparten-Chef Mike Winkel der "Berliner Zeitung". Die Situation sei katastrophal. "Niemand wird weiter investieren, wenn der Netzanschluss so unsicher ist wie derzeit, weder E.on noch andere".

Konkreter Anlass: Der erste große Offshorewindpark Amrumbank West werde von Tennet voraussichtlich erst in 3 Jahren mit dann 15 Monaten Verspätung angeschlossen (12).

Winkel ließ noch einen Rundschlag gegen alle anderen Beteiligten folgen: Die Netzbetreiber hätten sich selbst über- und die Probleme unterschätzt. Zweitens seien die finanziellen Anreize für die Netzbetreiber unzureichend , da ihnen die Regulierungsbehörde Investitionen nicht besonders hoch vergüte (s.o.). (Abgesehen von dem verbalen Fußtritt wird Tennet das sehr gerne gehört haben.)

Drittens schafften es die Lieferanten nicht, die benötigten Kabel herzustellen. Weiterhin beklagte Winkel "ein großes Durcheinander bei den Behörden".

E.oN sucht übrigens inzwischen selbst Hilfe bei Finanzinvestoren für den Windpark Amrum-Bank-West

Nach dem Schlag von E.on in Richtung Bundesregierung legten nun auch RWE und Tennet nach:

dapd meldete in der letzten Februarwoche, daß sowohl Tennet als auch RWE den Ausbau von weiteren Windparkprojekten auf See gestoppt hätten. Beide Unternehmen forderten von der Politik "verlässlichere Rahmenbedingungen".

"Wir werden zunächst nur noch die bestehenden Projekte weiterverfolgen", sagte eine Tennet-Sprecherin. Eine finanzielle Kapazitätsgrenze sei erreicht.

Wie dieses "Weiterverfolgen der bestehenden Projekte" angesichts der massiven Klagen gerade der an bestehenden Projekten Beteiligten praktisch aussehen soll, erklärte sie leider nicht.

Zur RWE-Entscheidung nannte der Finanzchef von RWE-Innogy Hans Bünting die fehlende Rechtssicherheit und fehlende belastbare Regelungen für den Fall eines späteren Netzanschlusses.

Dieser Vorstoß zielte die Haftungsfrage bei Verzögerungen. Offenbar hatte man sich darauf verständigt, daß es für alle Unternehmen besser wäre, wenn der Staat mit anderen "Rahmenbedingungen" für die Haftung die Risiken selbst tragen würde. Die weitere Entwicklung bestätigte das.

Auch die finanziellen Anreize seien unzureichend

Tennet beklagte inzwischen, daß „die finanziellen Anreize für Netzbetreiber unzureichend“ seien – unter Benutzung der gleichen Wortwahl wie E.on-Mann Winkel. Von den laut Energiekonzept der Bundesregierung für Ende 2022 geplanten Windkraftanlagen mit 13.000 MW Leistung in Nord- und Ostsee habe Tennet nun die Anbindung von rund 5.300 MW auf den Weg gebracht. Mehr sei kostenmäßig für ein Einzelunternehmen nicht möglich. Im Klartext: Bitte höhere Renditegarantien (15).

Weil der niederländische Staat als 100-prozentiger Eigentümer der Muttergesellschaft Tennet, die Anfang 2010 das Nord-Stromnetz von E.on (zuvor „Transpower“) übernommen hat, vermutlich nicht mit neuem Kapital die Probleme der deutschen Tochter Tennet TSO GmbH und die deutschen Windkraft-Probleme lösen wollte – zumindest nicht zu diesem Zeitpunkt – , hatte Tennet eine neue Rettungsidee – auf Kosten Dritter:

Eine deutsche Gleichstrom-Netzgesellschaft ?

In einem Brief an Wirtschaftsminister Rösler, über den WELT Online am 20.2.2012 berichtete, schlug Tennet die Gründung einer deutschen Gleichstrom-Netzgesellschaft vor (16), denn Investitionen von 15 Mrd Euro allein für Offshore-Anbindungen seien nicht von einer einzigen Netzfirma zu tragen. Diese sollte aus den 4 großen Übertragungsnetzbetreibern (ÜNB) bestehen: Amprion (früher RWE), Tennet , 50Hertz (Ex-Vattenfall) und EnBW-Netze. Die drei übrigen Netzbetreiber, die sich bereits zusammen mit Tennet seit Wochen in einer „Arbeitsgemeinschaft Beschleunigung Offshore“ im Bundeswirtschaftsministerium mit diesen Problemen beschäftigen, zeigten sich von Tennets Vorpreschen überrascht bis befremdet. Alle wiesen diesen Vorschlag zurück.

„Tennet habe beim Kauf des E.on-Netzes gewusst, welche Aufgaben anstünden“, kommentierte Amprion. "Vor diesem Hintergrund verwundert es, dass sich Tennet nicht in der Lage sieht, die Investitionen zu tätigen", sagte ein Unternehmenssprecher. Eine gemeinsame Offshore-Gesellschaft bringe hier keinen Mehrwert. "Weder ändert sie etwas an den Investitionsbedingungen noch etwas an der Intensität der gemeinsamen Netzentwicklungsplanung".

Diese berechtigte Entgegnung weist auf die tatsächlichen Motive von Tennet hin: Dem niederländischen Staat als alleiniger Eigentümer des Netzbetreibers wurden offenbar die anstehenden Finanzierungsanforderungen – über die man sich dort in der Tat von vornherein nicht im Zweifel sein konnte, wie Amprion nüchtern feststellte – einfach zu unangenehm. Man hätte entweder die Finanzierungsausstattung von Seiten des niederländischen Staates erhöhen müssen, wodurch die Frage aufgetreten wäre, was es die Niederlande angeht, wenn Deutschland seine Offshore-Windkraft in extremer Weise ausbauen will. Oder man hätte sich um externe Investoren bemühen müssen, was man damals offensichtlich noch nicht wollte.

Die marktwirtschaftliche Lösung in einem solchen, durchaus üblichen Fall wäre der Verkauf von Tennet – allerdings unter Hinnahme und Abschreibung eventuell bereits eingetretener Verluste. Der Käufer könnte dann mit frischem Geld weitermachen. Diese normale Lösung gefiel den staatlichen Gesellschaftern anscheinend gar nicht.

Also hat man sich damals offenbar dazu entschieden, Tennet zu behalten, aber nichts mehr zu investieren und statt dessen die deutsche Regierung mit einem Ausbau-Stopp und der Schreckensvision vom Scheitern der Energiewende unter Druck zu setzen, damit sie "die Rahmenbedingungen" ändert.

Die Betreiber der Windparks haben diese Strategie übernommen, da sie davon ebenfalls profitieren können. Wie sich später zeigte, war das sehr wirksam.

Die unschlagbare Idee: Sozialisierung der Schäden

Tennet trug in diesem Brief noch eine zweite Idee vor: Vor weiteren Aufträgen für den Anschluss von Offshore-Windparks müsse es bei der Haftung neue Regeln geben, heißt es in dem Brief. Wo Versicherungen nicht mehr einsprängen müsse eine „Sozialisierung der Schäden“ (wörtlich !) ermöglicht werden. Schöner kann man das Abwälzen der Risiken auf die Steuerzahler und Stromverbraucher nicht ausdrücken.

Diese Schadens-Sozialisierungs-Idee gibt im Übrigen einen Hinweis auf die Einschätzung der Offshore-Risiken durch die Versicherungen. Dort waren offenbar nüchterne Fachleute am Werk, die sich an diesen unberechenbar risikoreichen Aktivitäten nicht beteiligen wollten.

Es sei denn, der Staat nimmt ihnen die Risiken ab, was für Versicherungen der Idealfall wäre – und im Normal-Kapitalismus eigentlich unmöglich. Aber bei der Energiewende ist nichts unmöglich – siehe unten.

Am 2. März meldete sich der Sprecher der Stiftung Offshore-Windenergie, Thorsten Falk, neben einer nüchternen Schilderung der Situation mit Feststellungen, die nicht so ganz in die bislang ausgeführten Rundumschläge gegen die angeblich Schuldigen passten:

Die Behörden seien nicht der Grund für die gemeldeten Verzögerungen.

Und: "Die Investitionen in die Netze sind ein vergleichsweise sicheres Investment, wenn tatsächlich Renditen von bis zu 9 % erreichbar sind".

Die Versicherer melden sich zu Wort

Es dauerte bis Mai, bis sich Vertreter der Versicherungen zu dem Thema zu Wort meldeten. Achim Sandhövel, Chef der Allianz-Klimasparte, erklärte am 10.6.2012 in einem dpa-Interview auf die Frage "Was erwarten Sie, damit institutionelle Investoren wie Allianz in großem Stil in Offshore-Windanlagen investieren ?" : "Der Staat muss Anreize schaffen, damit Stromspeicher gebaut und Leitungen gelegt werden. Manchen Netzbetreibern fehlt das Geld für den Ausbau. Darum sind gesetzliche Rahmenbedingungen eine wichtige Grundlage, damit Private investieren." Und weiter: "Der Gesetzgeber ist vor allem an einer Stelle gefordert: Es ist kaum vorstellbar, dass die Privatwirtschaft alle Risiken schultern kann. Einige Unternehmen mussten wegen der Probleme bei den Offshore-Windparks in den vergangenen Quartalen bereits Rückstellungen in dreistelliger Millionenhöhe bilden. Hier müssen Risiken auf mehrere Schultern verteilt werden…." (19).

Daß eben dafür die Versicherungswirtschaft einschließlich der Rückversicherungen da ist, scheint Herrn Sandhövel nicht zu berühren.

Die aktuelle Situation bei den Versicherungen beschrieb eine Meldung der "Wirtschaftswoche" am 9.6.2012 (20):

Rückversicherer wie Hannover Rück und Munich Re sähen große Risiken für Offshore-Windparks in der Nordsee. "Nehme der Aufbau der Windparks Fahrt auf, könne es schwer werden", wird ein Rückversicherer zitiert. Zwar habe etwa Munich Re einige Policen für Sachschäden gezeichnet. Bei Spezialrisiken wie der Verfügbarkeit von Wartungsschiffen und dem Funktionieren der Windturbinen halte sich der Konzern aber zurück. Man analysiere derzeit die Risiken aus Wind und Wellengang. "Hier brauchen wir noch viel Expertise", zitiert WiWo den Munich Re-Vorstand Thomas Blunck.

Auch andere Versicherer seien vorsichtig. So versichere die Hannover Rück zwar den Windparkbau. Von Betriebsunterbrechungen nach Stürmen oder Kabelschäden lasse sie aber die Finger. Der Wintersturm über der Nordsee gehört zu den größten Risiken der Rückversicherer. "Schlägt der richtig zu, fällt nicht nur eine Anlage aus, sondern gleich eine Vielzahl", sagt einer. Dann könnten die Anlagen zudem lange stillstehen, wenn sie etwa zwischen Oktober und März wegen schlechten Wetters nicht gewartet werden. Schließlich stünden die deutschen Windparks oft mehr als 100 Kilometer vor der Küste.

Die Versicherer haben dramatische Warnungen nicht nötig. Sie kalkulieren berechenbare Risiken genau – und lehnen die Versicherung schlecht kalkulierbarer, hoher Risiken schlicht ab. Sie sind somit in dem gesamten Offshore-Drama die einzigen Mitspieler, die gegen Energiewende-Visionen und –Heucheleien immun sind. Sie können in Ruhe abwarten, ob es den Windparkerrichtern und Netzbetreibern mit ihrer Blockadedrohung gegen die Regierung gelingt, bessere "Rahmenbedingungen" und Haftungsregelungen zu erzwingen. In diesem Falle werden sie neu kalkulieren.

Tennet rechnet ab

Tennet meldete sich noch einmal am 2.5.2012 durch seinen Geschäftsführer Lex Hartmann. Er präsentierte eine Zusammenstellung aller Argumente und Forderungen (21):

– Es gebe einen dramatischen Engpass in den Anschlüssen der Windparks.

– Zugleich gebe es einen wahren Boom an Anträgen für Nordsee-Windparks.

– "Unsere Probleme sind Material, Produktionskapazitäten, enge Zeitfenster für die Arbeiten auf See. Eigentlich braucht man bei solchen Großprojekten Testphasen. Diese Zeit haben wir nicht; wir müssen mit den Projekten sofort anfangen, ohne Lernkurve – um die ehrgeizigen Ziele des Wirtschafts- und des Umweltministers in die Tat umzusetzen.

Anmerkung: Eine schwache Ausrede. Da wir uns nicht in der DDR befinden, hätte Tennet angesichts dieser absehbar unakzeptablen Situation ja auch die Übernahme dieser Arbeiten ablehnen können. Schließlich ist es nicht die Aufgabe eines niederländischen Staatsunternehmens, die "ehrgeizigen" Ziele deutscher Ministerien um den Preis des eigenen Untergangs in die Tat umzusetzen.

– Mit den "richtigen Rahmenbedingungen", für die die Politik sorgen muss, sei das zu schaffen. Nötig sei ein langfristig angelegter Offshore-Plan (Anmerkung: ..den es in der Tat bis heute nicht gibt), die schnelle Klärung der Haftungsfrage und eine Lösung für die künftige Verteilung der nötigen milliardenschweren Investitionen auf "mehrere Schultern". Deshalb die BMU-BMWi-Ankündigung eines Offshore-Netzentwicklungsplans vom Juli 2012 – s.u. und (25))

– "Wir haben uns nicht verschätzt. Uns geht finanziell nicht die Puste aus. Wir haben für die laufenden Projekte bereits 5,5 Mrd Euro ausgelöst. Mehr kann man von einem einzelnen Unternehmen nicht verlangen. Wir gehen von mindestens 15 Milliarden Euro für die Offshore-Anbindungen am Ende aus".

– Es geht vieles durcheinander. Wir benötigen einen langfristigen Plan, wann was wo gebaut werden soll. Was die Bundesnetzagentur für die benötigten Stromleitungen an Land vorlegen will, brauchen wir auch für Offshore – und beides muss miteinander verzahnt sein.

– Unter einem wahren Tsunami von Bau- und Projektanfragen droht die gesamte Branche durcheinender zu geraten.

– Neben einem langfristigen Offshoreplan geht es uns vor allem um Haftungs- und Kapitalfragen.

– (Auf die Frage nach Wunschpartnern): "Das könnte z.B. die Kreditanstalt für Wiederaufbau KfW sein". (Anm.: .also eine staatliche Bank. Wieder ein Ruf nach dem Staat.). Minister Rösler hatte das allerdings schon mehrfach zurückgewiesen.

Interessant war die Mitteilung von Tennet vom 25.06.2012, in der nun auch der Firma Siemens eine erhebliche Mitschuld an Verzögerungen angelastet wurde: Man sei von diesem Generalunternehmer darüber informiert worden, daß es bei der Installation von zwei der vier im Zentrum der Windpark-Cluster liegenden zentralen Stromumspann- und Gleichrichter-Plattformen HelWin alpha (bei Helgoland) und BorWin Beta (bei Borkum) zu neuerlichen Verschiebungen komme.

RWE: Die Regierung muss eine Lösung suchen

Am 24.06.2012 meldete sich der neue RWE-Chef Peter Terium mit der Nachricht, daß sich der Anschluss des Windparks Nordsee Ost noch mehr verzögern wird. Tennet habe mitgeteilt, daß es weitere massive Verzögerungen gebe. Damit sei die Wirtschaftlichkeit des Projektes nordöstlich von Helgoland "extrem gefährdet". Er forderte die Regierung auf, schnellstens eine Lösung des Problems zu suchen und mit den Investoren über einen "wirtschaftlichen Ausgleich" zu reden.

Am 01.07.2012 trat Terium mit einer neuen Idee auf, die er offenbar für eine Drohung hielt: Die aktuellen Probleme könnten der Grund dafür sein, daß in Zukunft möglicherweise ein großer Teil der für deutsche Gewässer geplanten Offshore-Parks vor den Küsten Großbritanniens gebaut würden.

RWE verkündete am 25.07.2012 die Verschiebung seines Investitionsbeschlusses für den 40 km nördlich Juist geplanten Windpark Innogy Nordsee 1 bis mindestens Anfang 2013. Hauptgrund für den Aufschub seien die unklaren Haftungsregelungen im Falle eines verzögerten Netzanschlusses (23). Man verwies auf schlechte Erfahrungen beim Windpark Nordsee Ost (18).

Hiermit erhöhte RWE den Druck für neue, günstigere Haftungsregelungen, ohne dass es bereits Probleme beim Netzanschluss eines noch nicht existenten RWE-Windparks geben konnte. Jetzt kämpfte RWE also für Tennet.

Noch mehr Schuldige

Am 27.06.2012 meldete sich der Windpark-Betreiber Trianel mit der Ankündigung, daß aufgrund von Verzögerungen beim Netzanschluss durch Tennet die Inbetriebnahme seines Windparks Borkum bis zum 2. Quartal 2013 verschieben werde. Aber es gebe noch weitere Gründe: Wegen Produktionsengpässen bei einigen Zulieferern müsse Trianel den gesamten Einrichtungszeitplan neu ausrichten. Auch hänge die Fertigung der 700 Tonnen schweren dreibeinigen Fundamente (Tripods) durch die Weserwind AG deutlich hinter dem Zeitplan. Auch die Fertigstellung der Umspannplattform durch den Hersteller Alstom Grid – gemeint war BorWin Beta; siehe Tennet-Mitteilung vom 25.06. – sei erheblich verzögert (22).

Offensichtlich stimmte Tennets Hinweis auf eine ganze Reihe von Verzögerungs-Ursachen, für die nicht Tennet, sondern andere Unternehmen verantwortlich sind.

Trianel-GF Klaus Horstick verzichtete ebenfalls nicht darauf, die Absicht der Regierung zu begrüßen, im Sommer einen Gesetzesentwurf vorzulegen, der insbesondere die Haftungsfragen löst und den Offshore-Ausbau unterstützt. Was eine gesetzliche Regelung etwas daran ändern könnte, dass Zulieferer ihren Auftrag nicht zeitnah erfüllen, erklärte er leider nicht.

Die Windreich AG durchschlägt den gordischen Knoten

Die letzte Aktion in dieser Reihe von Negativ-Nachrichten, Forderungen und Drohungen geschah am 14.08.2012. Der schwäbische Windpark-Entwickler Windreich AG bezog sich auf die Tennet-Mitteilung von der Verschiebung des Baus der Leitungen für eine Umspann-Plattform – offenbar BorWin 2 – und die Anbindung des geplanten Windparks Deutsche Bucht 94 km nördlich Borkum auf unbestimmte Zeit verschoben (32). Windreich hat daraufhin bei der Bundesnetzagentur einen Antrag auf ein Mißbrauchsverfahren gegen Tennet gestellt – das erste Verfahren dieser Art. Tennet könnte im schlimmsten Fall vor einem Zivilgericht auf Millionen-Schadenersatz verklagt werden (28).

Eine Tennet-Sprecherin verwies darauf, daß man sich trotz der bisherigen Probleme auf einem guten Weg sehe. Besonders hilfreich seien die neuen Haftungsregelungen. Allerdings gibt es diese noch gar nicht – und wenn sie erlassen werden, müssten sie für den vorliegenden Fall bezüglich ihrer Wirksamkeit rückdatiert werden. Aber dies gehörte zur Kategorie "Thema verfehlt".

Denn die Windreich AG hatte einen gordischen Knoten durchschlagen: Zunächst leitete die Bundesnetzagentur das Mißbrauchsverfahren gegen Tennet ein, wie Behördenpräsident Jochen Homann gegenüber der FAZ am 15.08.2012 bestätigte. Für den Netzbetreiber kam es nun aber noch wesentlich schlimmer: "Aus heutiger Sicht ist völlig klar, daß die Bundesnetzagentur Tennet nicht als Übertragungsnetzbetreiber zertifizieren kann. So steht es in unserem Entwurf, den wir zur Konsultation an die Europäische Kommission geschickt haben", sagte Homann. Grund ist die von Tennet selbst bestätigte mangelnde Kapitalausstattung. Dem Unternehmen droht ein Bußgeld von 1 Million Euro, aber weitaus größere finanzielle Folgen könnten sich aus dem laufenden Mißbrauchsverfahren ergeben.

In der FAZ forderte Homann das Unternehmen auf, "ernsthaft nach kapitalstarken privaten Finanzierungspartnern zu suchen".

Die angedrohte Verweigerung der Zertifizierung wäre für Tennet die größte anzunehmende Katastrophe und vermutlich das Ende seiner Aktivitäten in Deutschland.

Während alle anderen von den Verzögerungen betroffenen Windparkerrichter über ein halbes Jahr lang ein wirkungsloses Gejammer von sich gaben und von der Regierung bessere "Rahmenbedingungen", einen "wirtschaftlichen Ausgleich", höhere und länger geltende EEG-Vergütungen und weitere Hilfsaktionen forderten, hat Windreich gehandelt und in wenigen Tagen eine nachhaltige Verbesserung der Situation erreicht, wie sich unmittelbar zeigte.

Die niederländische Regierung lenkt ein: Private Investoren gesucht

Nur zwei Tage nach der Ankündigung in der FAZ sagte der niederländische Wirtschaftsminister Maxime Verhagen nach einem Treffen mit Rösler, seine Regierung sei bereit, zu erlauben, daß das Staatsunternehmen Tennet weitere Investoren in seine Projekte einbeziehe (29). Verhagen erklärte weiter, daß Tennet Deutschland auch mehr Privatkapital für künftige Investitionen akquirieren könne und wolle. "Dagegen hat die niederländische Regierung überhaupt keine Einwendungen".

Dieses Happy End nannte Rösler einen Durchbruch für ein wichtiges Feld der Energiewende. Mit der Klärung von Haftungsfragen (s.o.), die das Kabinett noch im August beschließen soll, sei dann der Weg frei für den dringend notwendigen Ausbau der Windenergie auf See.

Dazu allerdings hatte seine Kollegin Aigner ganz andere Vorstellungen – s.u. (26).

Wirtschaftsminister Rösler sieht sich immerhin in der Frage der bislang fehlenden Investitionen in das Offshore-Stromnetz bestätigt: Er hatte ein staatliches Engagement Deutschlands bei der Netzanbindung und deren Finanzierung etwa über die Staatsbank KfW wiederholt abgelehnt. Er beharrt darauf, daß dies eine Sache privater Investoren sei. Daß dieses Thema damit dauerhaft vom Tisch ist, darf man zumindest hoffe.

Die Front gegen Berlin steht weiterhin

RWE-Teriums Forderung vom 24.06. war die klarste Botschaft an die Regierung. Die Regierung, und nicht etwa die RWE, sollte eine Lösung für das nicht von Berlin verschuldete Problem suchen – und zwar schnellstens. Und abermals die Regierung – und nicht etwa die RWE – sollte mit Investoren über Subventionen für das Versagen der Industrieunternehmen reden, denn nichts anderes meinte der "wirtschaftliche Ausgleich". Zumindest das hat sich nun auf ganz einfache Art erledigt – bis auf die weiterhin aktuelle Forderung nach höheren Renditen für Investoren. Diese werden sich noch damit melden; sie haben gute Karten..

Nach dieser Tennet-Wende wird sich die Interessengemeinschaft der Windparkbetreiber, Netzgesellschaften, Hersteller und Zulieferer, Versicherungen, Lobbyverbände, Hafenstädte, Stiftungen und anderer Beteiligter auf das verbliebene Thema Haftungsregelung konzentrieren. Die gemeinsame Drohung: Entweder die weitgehende Entlastung von allen großen Risiken oder das spektakuläre und schmähliche Ende der im Prinzip großartigen Energiewende.

Die problematische Mixtur: Geringe Erfahrung, Zeitdruck und viel Geld.

Wo in Europa Erfahrungen mit Offshore-Windanlagen existieren, zeigt eine Übersicht:

Seit 1991 wurden in 7 Ländern Europas 40 Offshore-Windparks mit insgesamt 1414 Windrädern (WKA) in Betrieb genommen; die weitaus meisten davon seit 2003. Die Verteilung:

– Großbritannien 624 WKA

– Dänemark 405 "

– Belgien 146 "

– Schweden 94 "

– Finnland 10 "

– Irland 7 ".

Demgegenüber hat Deutschland bisher 2 Offshore-Windparks voll (2009 Alpha Ventus und 2011 Baltic 1) und einen (BARD Offshore 1) 2011 teilweise in Betrieb genommen.

Diese bei unseren Nachbarn über eine lange Zeit und mit sehr vielen Anlagen gesammelten Erfahrungen konnte kein "ehrgeiziges" und mit massiven Subventionen angereichertes Energiewende-Programm innerhalb kürzester Zeit ersetzen. Die sich jetzt häufenden Pannen und Verzögerungen sind daher kein Zufall, sondern die zwangsläufige Folge der inkompetenten Politiker und Ministerien, die das zu verantworten haben.

Wenn Vertreter von Wind- und Stromnetzwirtschaft einen Systemwechsel bei der Errichtung von Offshore-Windparks und bei den zugehörigen Netzanbindungen fordern und wenn das etwa zwei bis drei Jahre vor dem Beginn der Arbeiten auf See geschieht, wäre das zwar knapp, aber wohl gerade so in Ordnung.

Wenn aber genau dies – wie gerade Mitte August 2012 erfolgt -, erst geschieht, wenn bereits die ersten Anlagen gebaut wurden, weitere im Bau und eine Vielzahl weiterer Windparks in der Planung und zum Teil schon genehmigt sind, dann handelt es sich um eine Blamage ersten Ranges für die Regierung und ihre Behörden, die ein gigantisches Investitionsprojekt ganz offensichtlich schlecht durchdacht, unvollständig und unprofessionell vom Zaun gebrochen haben.

Auch für die Industrie, die sich – vom Anblick der Fördersummen geblendet – auf dieses Abenteuer einließ, sind die bisher abgelaufenen Vorgänge alles andere als schmeichelhaft. Wie sich jetzt zeigt, fehlt es vor allem an Erfahrungen, wie oben beschrieben.

Problem-Brennpunkt Umrichter-Plattformen

In einem vorzüglichen Artikel von Jörn Klein in den vdi-nachrichten vom 17.08.2012 (24) wird auf eine große und riskante Lücke in den Standards hingewiesen: Die staatlichen Stellen, die eigentlich rechtzeitig die Standards – also Regelwerke – für Windkraft-Umrichterplattformen zu entwickeln hatten, damit die Hersteller überhaupt auf sicherer Grundlage planen und konstruieren können, haben praktisch bis heute nichts geliefert – während schon fleißig gebaut wird.

Diese großen Bauwerke sind die technischen Herzstücke einer ganzen Gruppe von zugehörigen Windparks. Alle Leitungen einer solchen Windpark-Gruppe führen zu einer dieser Umrichterplattformen; von dieser führt dann ein Gleichstrom-Hochspannungskabel (HGÜ) zum Festland.

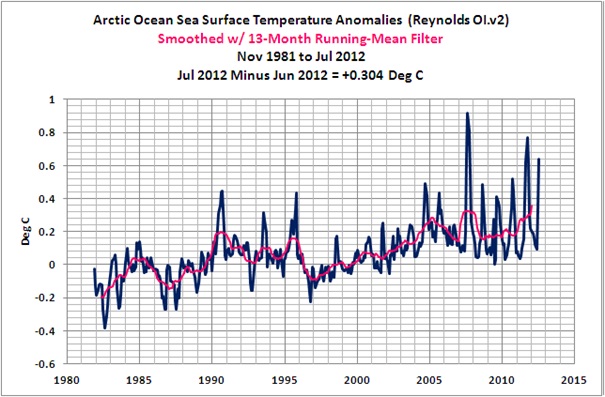

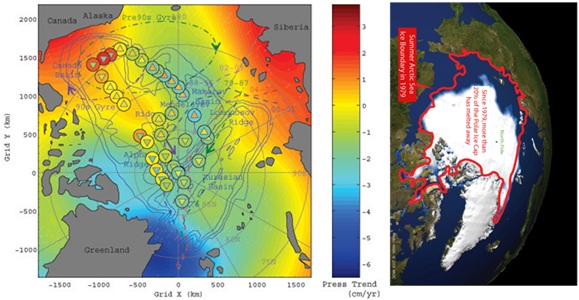

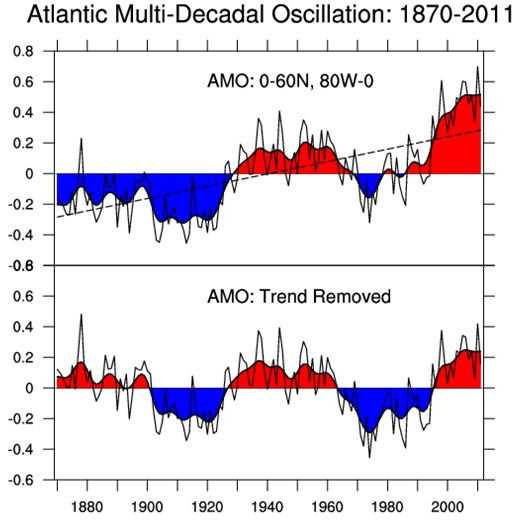

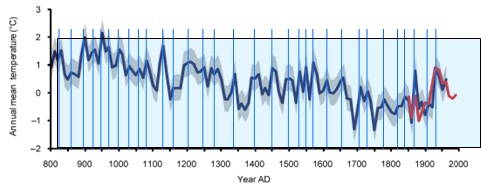

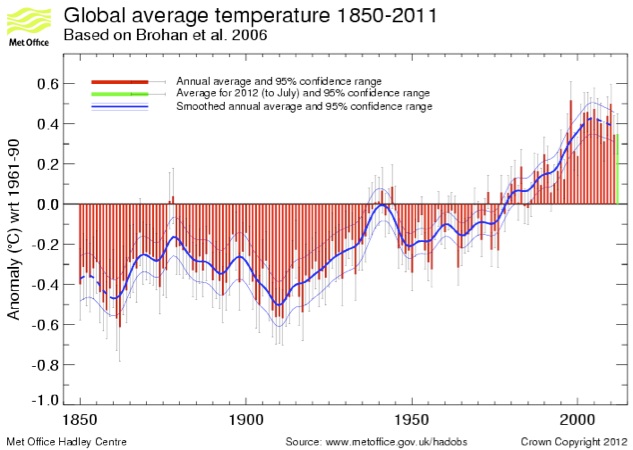

Abb. 3 zeigt die Planung für die Nordsee.

Abb. 3: Ausgewählte Windpark-Areale in der Nordsee. Die geplanten Windparks – die jeweils bis zu 80 Windräder enthalten können – sollen durch Kabel mit Umspann-Plattformen verbunden werden. Dort wird der angelieferte Windstrom zu Hochspannungs-Gleichstrom umgewandelt, der dann mit langen Seekabeln an die Umspannwerke an Land weitergeleitet wird. Quelle: DER SPIEGEL 51/2011.

Siehe auch Tennet-TSO (31).

Die Hersteller behelfen sich in ihrer prekären Situation mit der teilweisen Anwendung der Standards z.B. der norwegischen Öl- und Gasindustrie (Norsok) und auch der internationalen Convention for the Safety of Life at Sea (Solas).

"Hinsichtlich der Regelwerke herrscht einige Verwirrung bei denjenigen, die die Umrichter-Plattformen entwickeln und betreiben", beschreibt Tobias Bublat (Senior Engineer beim Zertifizierer GL Renewables Certifications, einer Tochter des Germanischen Lloyd) die gegenwärtige Situation.

Die Kernzelle aller Genehmigungen im Offshore-Windsektor ist das Bundesamt für Seeschiffahrt und Hydrographie (BSH) in Hamburg. Von dort hört man Klartext: "Bei den Generalunternehmern, die die Umrichterplattformen errichten, ergeben sich Verzögerungen, weil die Unternehmen offenbar keine vereinheitlichenden Technikvorgaben haben – also "Kochbücher" wie die DIN-Vorschriften fehlen", sagt der BSH-Jurist Christian Dahlke. "Manche große Unternehmen sind völlig ahnungslos ins Offshore-Geschäft gestolpert".

Der BSH-Jurist erlebt es immer wieder, dass Plattformen im Bau bereits weit fortgeschritten sind, wenn er endlich die technischen Unterlagen für die beantragte Genehmigung bekommt.

Für die Windräder gibt es einen BSH-Konstruktionsstandard, der die technischen Regelwerke für die drei Phasen Ausführung, Betrieb und Rückbau berücksichtigt. auch die Zertifizierer haben schon vor Jahren Richtlinien für die Zertifikation von Windturbinen aufgestellt. Windrad-Konstrukteure haben also kein Problem.

Für die Umrichterplattformen gibt es das immer noch nicht. Man legt nur die Gleichbehandlung dieser Bauwerke mit dem Turbinenbau nahe – eine klägliche Verlegenheitslösung, die die Plattform-Entwickler im Regen stehen lässt. Hin und wieder hilft vielleicht Norsok. Aber eine riesige Plattform voller Hochspannungsanlagen ist leider keine Ölbohrplattform; die Standards der Öl- und Gasförderer passen und reichen nicht. Die Hersteller müssen improvisieren.

Für BSH-Fachleute wie Christian Dahlke ist es schwer erträglich, eine mehrere hundert Millionen teure Umrichterplattform zu genehmigen, ohne Gewissheit zu haben, daß der Unternehmer dies auch technisch umsetzen kann. Sein Alptraum: Er erhält die Unterlagen für die Genehmigung erst dann, wenn der stählerne Riese gerade voll ausgerüstet die Werft verlässt und zur Position des Windparks geschleppt wird.

Zu diesem Thema passen die Beschwerden von Tennet und Trianel über die Probleme bei den Umrichter-Plattformen HelWin alpha und BorWin Beta (s.o.).

Siemens hatte vier Aufträge für Umrichterplattformen übernommen. HelWin 1 und BorWin II haben bereits 1,5 Jahre Verzögerung. Ein weiteres hinkt dem Zeitplan hinterher. Konzernchef Peter Löscher fand deshalb bei der Vorstellung der Zahlen für das zweite Quartal 2012 im April, als er einen Verlust von 278 Mio Euro erklären mußte, deutliche Worte: Man hätte sich nicht vier Plattformen vornehmen sollen, sondern nur eine. "Wir haben diese Projekte falsch eingeschätzt. Es ist ein hochkomplexer Schiffsanlagenbau. Das ist kein Projekt, das wir mit Fixpreisen und Garantien der zeitlichen Abnahme heute in dieser Art und Weise leisten können" (30). Trotz der roten Zahlen hält Siemens an diesem Geschäftsfeld fest; der einzige Konkurrent ist ABB.

Angesichts der von der Politik geschaffenen Probleme und ihrer ausbleibenden Behebung gibt es mittlerweile harte Beurteilungen: Thorsten Herdan, der Geschäftsführer des VDMA Power Systems, sieht die größten Probleme im Offshore-Bereich. Seine Beurteilung. "Das Vertrauen der Investoren und Hersteller in die Worte der Bundesregierung ist nicht mehr vorhanden".

Ein Netzentwicklungsplan kommt – Jahre zu spät

In einem Eckpunktepapier des BMU und des BMWi vom 08.08.2012 (25) steht am Beginn eine erstaunliche Ankündigung:

"Durch Einführung eines verbindlichen Offshore-Netzentwicklungsplans wollen wir die Errichtung von Netzanbindungen und Offshore-Windparks zukünftig besser miteinander koordinieren. Auf diese Weise schaffen wir für alle Beteiligten mehr Planungssicherheit und stellen den effizienten Ausbau eines Offshore-Netzes sicher".

Mit anderen Worten: Diese am Beginn jeglicher Offshore-Planungen und deren Einbeziehung in die Energiewende-Gesetze stehende Selbstverständlichkeit gibt es bisher überhaupt noch nicht. Und jetzt, nach all´ den Pleiten, Pech und Pannen, fällt der Regierung dieses Manko auf.

Die Kapitulation

Für die Bundesregierung gab es nach den massiven Drohungen bezüglich eines Stopps jeglicher Baumaßnahmen an Offshore-Windparks zwei Möglichkeiten:

Möglichkeit 1 (die marktwirtschaftliche):

Da man in aller Deutlichkeit erkennt, dass die "ehrgeizigen" Ziele beim Ausbau der Offshore-Windkraft mit den vorhandenen Ressourcen – zu denen insbesondere erfahrene Unternehmen, präzise Pläne (s.o.) und brauchbare Standards (s.o.) gehören – nicht in der vorgesehenen Zeit erreichbar sind, entscheidet man sich für ein langsameres und damit auch aussichtsreicheres Vorgehen. Man muss seine Ziele deshalb nicht aufgeben, nur sie realistischer angehen. Die offensichtlichen Drohungs- bzw. Erpressungsversuche, die auf weitgehende Zugeständnisse des Staates hinsichtlich höherer Renditezusagen und Übernahme der Haftungsrisiken hinauslaufen, nimmt man nicht ernst, weil man davon ausgeht, daß die Mehrzahl der beteiligten Unternehmen mit ihren Arbeiten auch ohne Erfüllung der Forderungen fortfahren wird, da die erzielbaren Renditen nach wie vor attraktiv sind. Man fürchtet auch nicht eine kurzfristige Pressekampagne der Drohkulisse-Betreiber, da man auf die Wirkung der Regierungsargumente setzt. Möglichkeit 1 setzt allerdings eine die Marktwirtschaft beachtende und praktizierende Regierung voraus.

Möglichkeit 2 (die staatswirtschaftliche):

Die Regierung kapituliert, weil sie die Verbreitung der Botschaft "Die Energiewende ist gescheitert" mehr fürchtet als die Folgen des Nachgebens.

Wirtschafts- und Umweltministerium haben diese Möglichkeit gewählt. Am 08.08.2012 erklärte der Wirtschaftsminister, dass die Haftungsfrage geklärt sei. Alle Beteiligten hätten sich auf einen zuvor vom Umwelt- und Wirtschaftsministerium skizzierten Eckpunkteplan (25) geeinigt, der beschreibt, wer haften soll, wenn Windräder auf hoher See nicht ans Netz angeschlossen werden können und den Windparkbetreibern dadurch Verluste entstehen. Diese Haftungsregelung solle noch im Sommer 2012 ins Bundeskabinett kommen.

Die geplante Haftungsregelung sieht vor, daß die Windparkbetreiber im Falle einer nicht rechtzeitigen Anbindung oder längeren Leitungsstörung ab dem 11. Tag der Nichteinspeisung einen pauschalierten Schadensersatz in Höhe von 90 Prozent der entgangenen EEG-Einspeisevergütung erhalten. Die Kosten dieses Schadensersatzes soll der Übertragungsnetzbetreiber tragen. Dieser kann diese Kosten aber bundesweit und ohne Zeitverzug über eine Haftungsumlage "wälzen". Und zwar auf die Stromkunden. Nur bei grober Fahrlässigkeit trägt der Netzbetreiber 20 Prozent der Kosten, jedoch maximal 20 Mio Euro pro Schadensfall. Der große "Rest" wird auch dann wieder "gewälzt".

Eine Tennet-Sprecherin erklärte daraufhin, "Das war alles, was wir wollten". Und Wirtschaftsminister Rösler bemerkte in Ergänzung zu seiner o.e. Ankündigung: "Den gesamten Ausbau im Bereich Offshore-Windenergie werden am Ende immer Verbraucher und Verbraucherinnen selber zu tragen haben".

Der Bundesverband der Verbraucherzentralen warnte deshalb vor dem Ausbau von Offshore-Windparks; wie auch schon mehrfach zuvor vor den steigenden Belastungen der Stromkunden durch die Auswirkung des EEG.

Ein Veto-Versuch der Verbraucherschutz-Ministerin

Herr Rösler und Herr Altmaier hatten bei ihren Offshore-Rettungsplänen anscheinend übersehen, daß es auch noch ein Verbraucherschutz-Ministerium gibt, dessen Chefin Ilse Aigner ihren Job ziemlich ernst nimmt. Die von BMWi und BMU geplanten Haftungsregelungen veranlassten sie zu einem vorläufigen Gegenschlag: Sie kündigte ihr Veto an (26).

Die an die beiden Ressortkollegen gerichtete Stellungnahme ließ an Klarheit nichts zu wünschen übrig, auch etwas Sarkasmus würzte den Text. Die entscheidenden Sätze lesen sich wie folgt: Die Leitungen von Umwelt- und Wirtschaftsministerium hätten öffentlich hervorgehoben, "daß die Bezahlbarkeit für die Akzeptanz der Energiewende mehr Gewicht erhalten muß". Und weiter: "Vor diesem Hintergrund sei das Verbraucherministerium über den Referentenentwurf (Anm.: das Eckpunktepapier) "sehr erstaunt" (Anm.: im ministerialen Sprachgebrauch ein schwerer Hammer) , weil er in die entgegengesetzte Richtung zeigt".

"Die Neuregelungen (….) deutlich zulasten des Stromverbrauchers, sind kaum beherrschbar und mit marktwirtschaftlichen Prinzipien nicht zu vereinbaren", betonte Aigners Ministerium.

Rösler meldete sich offensichtlich verärgert mit der Wiederholung der Drohung der Offshore-Lobby, daß dann die ganze Energiewende scheitern werde.

Es ist eine neue Qualität in der politischen Debatte, daß die Kritik an den Auswirkungen der Energiewende auf die Bürger nun im Kabinett angekommen ist, nachdem sich bereits andere CDU-Politiker dazu recht kritisch geäußert hatten. Nur einen Tag darauf kritisierte der NRW-CDU-Landeschef Armin Laschet Merkels Wirtschaftspolitik mit sehr deutlichen Worten; insbesondere schrieb er ihr ins Stammbuch, daß Arbeitsplatzsicherung wichtiger sei als die Energiewende (27).

Am 29.8. war der Aufstand der Ministerin geräuschlos abgesagt: Das Bundeskabinett beschloß die neue Offshore-Haftungsregelung.

Greenpeace nannte es aberwitzig, daß die Regierung eine weitere industriefreundliche Regelung zulasten der Bürger verabschiede. Von Kritik aus irgendeiner der im Bundestag vertretenen Parteien hörte man nichts.

Weitere Anlässe, sich über neue "Wälzungen" von Wendekosten auf die Bürger aufzuregen, stehen zahlreich bevor:

Die gerade angekündigte Abwrackprämie für alte Heizungen; "Investitionsanreize" (sprich: Subventionen) für unwillige Investoren zum Bau neuer Kohle- und Gaskraftwerke, der sich gerade durch die Auswirkungen der Energiewende mit seinem EEG nicht mehr rentiert; Subventionen für Energieunternehmen, damit sie ihre alten, stillzulegenden Kohlekraftwerke modernisieren und weiterlaufen lassen; die gewaltige kommende Kostenwelle für den Netzausbau, der noch gar nicht begonnen hat; die "Wälzung" der Kosten für den Seekabel-Anschluß an norwegische Wasserkraftwerke – die Liste ist unvollständig.

Ferner wird jetzt der überhastete Ausbau der Offshore-Windkraft ungebremst weitergehen und die Zusatzkosten der unvermeidlichen Pannen, Verzögerungen und Schäden wird man ebenso behandeln, wie soeben geschehen.

Ein besonders unangenehmes Datum ist der 15. Oktober 2012, der Tag, an dem die Übertragungsnetzbetreiber jedes Jahr ihre Prognose für die Höhe der EEG-Umlage veröffentlichen müssen. Der enorme Zubau von Photovoltaikanlagen und Windrädern dürfte sich hier entsprechend kräftig bemerkbar machen. Dann wird das Medienthema Energiearmut eine neue Dynamik erhalten. Die Politik geht windigen Zeiten entgegen.

Dr. Günter Keil St. Augustin August/September 2012

Den gesamten Beitrag können Sie auch als pdf Datei im Anhang herunterladen.

Quellen

(1) Transpower/Tennet: Tennet_Offshore 2012-07-31, Stündliche Ganglinie und

tägliche installierte Leistung ; Darstellung: Rolf Schuster

(2) Transpower/Tennet: Vergleich der Vollaststunden-Äquivalente von Onshore- und

Offshore-Wind im Netz von TenneT/TSO GmbH; Darstellung : Rolf Schuster

(3) Wikipedia: "BARD Offshore 1", Stand 2012

(4) Wikipedia: "Offshore-Windparks", 29.07.2012

(4) Eva Mahnke: "Das Nadelöhr auf hoher See", 05.02.2012, www.klimaretter.info/

(5) Thorsten Falk: "50 Monate für einen Netzanschluss", 02.03.2012,

www.klimaretter.info/

(6) BMU-Pressedienst Nr. 097/12: Gemeinsame Pressemitteilung mit dem BMWi:

"Offshore-Netzausbau wird beschleunigt: Rösler und Altmaier legen Vorschlag für

Haftungsregelung und Systemwechsel hin zu einem Offshore-

Netzentwicklungsplan vor", 02.07.2012, www.bmu.de/

(7) ZDF: Michael Braun: "Netzausbau: Der Stromkunde soll mitzahlen", "Windstille

beim Netzausbau", 08.08.2012,

www.zdf.de/ZDF/zdfportal/web/heute-Nachrichten/4672/23782708/978416/

(8) dradio: Philip Banse: "Rösler im Energiewende-Gegenwind", 08.08.2012,

www.dradio.de/dlf/sendungen/wirtschaftundgesellschaft/1834332/

(9) Verena Kern: "Philipp Rösler und der Wind", 08.08.2012,

www.klimaretter.info/politik/hintergrund/11727-roesler-und-der-wind/

(10) Dieter Dürand: "Energiekonzept der Regierung droht Desaster",

Wirtschaftswoche Online, 22.6.2012,

www.wiwo.de/unternehmen/energie/studie-zur-windkraft-

(11) dpa, WELT Online: "Kosten für Offshore-Windparks explodieren", 10.11.2011,

www.welt.de/wirtschaft/energie/article13719620/Kosten-fuer-offshore-windparks

(12) Reuters,dapd, WELT Online: "E.on warnt Deutschland vor Scheitern der

Windkraft", 14.02.2012,

www.welt.de/wirtschaft/energie/article13867570/e-on-warnt-deutschland-vor-

(13) Frank Dohmen, Alexander Jung. "Stress auf hoher See", DER SPIEGEL,

17.12.2011, www.spiegel.de/spiegel/print/d-83180829.html

(14) WELT Online: „E.on warnt Deutschland vor Scheitern der Windkraft“,

14.2.2012, www.welt.de/energie/article13867570/E-on-warnt-Deutschland-vor-

(15) Daniel Wetzel: „Netzbetreiber mit Ausbau auf See überfordert“, WELT Online,

20.2.2012, www.welt.de/dieweltbewegen/article13878199/Netzbetreiber-mit-Ausbau-auf-See-

(17) Institut der deutschen Wirtschaft Köln: „Teurer Offshore-Strom“, Juni 2011,

www.iwkoeln.de/publikationen/iwnachrichten/tabid/123/articleid/24588/default.aspx

(18) Insel Helgoland: "Verzögerung beim Ausbau des RWE Offshore-Windkraftwerk Nordsee Ost",

11.1.2012, www.insel-helgoland.de/?p=2129

(19) Matthias Kamp: "Allianz-Manager fordert Staatshilfen für Windparks", Wirtschaftswoche,

10.06.2012, www.wiwo.de/unternehmen/energie/armin-sandhoevel-allianz-manager-fordert-

staatshilfen-fuer-windparks/6589162.html

(20) Wirtschaftswoche: "Versicherer scheuen Ausfallrisiken von Offshore-Anlagen", 9.6.2012,

www.wiwo.de/unternehmen/versicherer/windenergie-versicherer-scheuen-ausfallrisiken-von-

offshore-anlagen/6720856.html

(21) Andreas Wildhagen: "Keiner investiert so in die Energiewende", Wirtschaftswoche, 02.06.2012,

www.wiwo.de/unternehmen/energie/tennet-chef-lex-hartmann-keiner-investiert-so-in-die-

energiewende/6564130.html

(22) IWR: "Offshore-Windpark von Trianel muss auf Netzanschluss warten", 27.06 2012,

www.iwr.de/news.php?id=21435

(23) Jürgen Flauger, Georg Weishaupt: "RWE stoppt Windkraft-Großprojekt", Handelsblatt,

25.07.2012, www.handelsblatt.com/unternehmen/industrie/neue-energiequellen-rwe-stoppt-

windkraft-grossprojekt/6917606.html

(24) Jörn Klein: "Fehlende Standards für Konverterplattformen verzögern Bau von Offshore-

Windparks". vdi-nachrichten, 17.08.2012.

(25) Gemeinsame Pressemitteilung des BMU mit dem BMWi: "Offshore-Netzausbau wird

beschleunigt: Rösler und Altmaier legen Vorschlag für Haftungsregelung und Systemwechsel

hin zu einem Offshore-Netzentwicklungsplan vor", 02.07.2012, BMU-Pressedienst Nr. 097/12

(26) n-tv: "CSU löst Koalitionskrach aus", 21.08.2012,

www.n-tv.de/politik/csu-loest-koalitionskrach-aus-article7022026.html

(27) SPIEGEL-Online: "Laschet kritisiert Merkels Wirtschaftspolitik", 22.08.2012,

www.spiegel.de/politik/deutschland/nrw-landeschef-laschet-kritisiert-merkels-wirtschaftspolitik-

a-851476.html

(28) manager magazin online: "Missbrauchsverfahren gegen Tennet eröffnet", 15.08.2012,

mhtml:file://GFehlender Netzanschluss Missbrauchsverfahren gegen Tennet eröffnet –

manager magazin-Unternehmen.mht

(29) manager magazin online: "Niederlande duldet private Tennet-Investoren", 17.08.2012,

mhtml:file://GDurchbruch Niederlande duldet private Tennet-Investoren-manager magazin-

Unternehmen.mht

(30) Verena Herb, Deutschlandfunk: "Mit vollem Frust voraus. Siemens und die Windenergie",

www.dradio.de/dlf/sendungen/firmen/1835641/

(31) Tennet-TSO: Offshore-Netzanbindungen, mit interaktiver Nordseekarte,

www.tennettso.de/site/netzausbau/de/offshore-projekte/

(32) INGENIEUR360: "Sündenbock für verzögerte Energiewende", 16.08.2012,

www.ingenieur360.de/allgemeines/suendenbock-fuer-verzoegerte-energiewende/

Related Files

1,

1,  3,

3,