ZEIT Online Journalist Staud kritisiert „Die kalte Sonne“. Was ist dran?

Die Zeit hat sich in der Vergangenheit bereits ausführlich mit unserem Buch „Die kalte Sonne“ auseinandergesetzt. Dabei positionierte sich die Zeitung ganz klar auf der Seite des Weltklimarats und wischte die von vielen Seiten durchaus berechtigte Kritik an dieser UN-Organisation stets eilfertig vom Tisch. Jedes Mal haben wir uns der Diskussion gestellt, die Vorwürfe geprüft und entsprechend entkräftet.

• Kommentierung der ZEIT-Artikel “Störenfritz des Klimafriedens” und “Skeptiker im Faktencheck” (10.2.2012)

• Kommentierung des ZEIT-Online Artikels “Alarmismus its mindestens genauso schlimm wie Skeptizismus” (21.2.2012)

• Kommentierung des ZEIT-Artikels “Beweise bitte!” (23.2.2012)

• Treppenstufen ins Abseits: Wie ‘Die Zeit’ ihre Leser verschaukelt (10.2.2012)

• Die Zeit nahm sich nicht die Zeit, um auf ‘Die kalte Sonne’ zu warten (6.2.2012)

Anfang März 2012 erhielten wir dann endlich die Gelegenheit, den Zeitlesern unsere Argumente zu erläutern:

• Unser Artikel in der ZEIT: “Hier irren die Klimapäpste” (4.3.2012)

Die Reaktion auf den Artikel war erschreckend: Es gab nämlich keine. Offensichtlich waren unsere Argumente schlüssig und man zog es daher vor, sich nicht weiter mit unseren Gegenargumenten zu beschäftigen.

Zu den treibenden Kräften der Zeit-Kampagne gegen unser Buch gehörte damals der freie Journalist Toralf Staud (siehe Foto oben rechts), der interessanterweise regelmäßig für das Greenpeace-Magazin schreibt. Ist mit einem solchen Hintergrund eigentlich eine unvoreingenommene Bewertung der wissenschaftlichen Fakten zu möglich? Hier müssen ernsthafte Zweifel angemeldet werden. Aus seinem Wikipedia-Lebenslauf wird weiterhin klar, dass er offensichtlich keinerlei universitäre naturwissenschaftliche Ausbildung vorzuweisen hat, was jedoch im datenintensiven Klimastreit von großem Nutzen wäre.

Nun ist seit der ersten Diskussionsrunde mit der Zeit ein halbes Jahr vergangen, da meldete sich Staud plötzlich erneut und wollte einen langen Fragenkatalog zu unserem Blog www.kaltesonne.de beantwortet haben. Er plane einen kritischen Beitrag auf Zeit Online und würde uns gerne die Möglichkeit einer Kommentierung von strittigen Punkten geben. Sebastian Lüning beantwortete diese Fragen bereitwillig. Der entsprechende Artikel ist heute (10.8.2012) auf Zeit Online erschienen („Forscher fühlen sich von Klimaskeptiker Vahrenholt instrumentalisiert“), und wir wollen die Vorwürfe von Staud hier diskutieren und prüfen.

Manfred Mudelsee und die Tropfsteinhöhlen im Sauerland

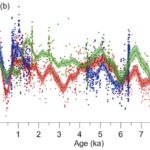

Im Juni besprachen wir in unserem Blog eine Arbeit Manfred Mudelsee, bei der es um die Klimageschichte im Sauerland anhand von Tropfsteinuntersuchungen ging (siehe unser Blogartikel „Mittelalterliche Wärmeperiode und Kleine Eiszeit in Höhlentropfsteinen des Sauerlandes“). Wir berichteten damals, dass es in den untersuchten Höhlen Hinweise auf bedeutende klimatische Schwankungen im 1000er-Jahresmaßstab gibt. Hierbei bezogen wir uns auf eine Abbildung in Mudelsee’s Paper (Abbildung 1). Die beschriebenen Schwankungen sind im Rohdatensatz klar erkennbar.

Abbildung 1: Sauerstoffisotopen-Daten für drei verschiedene Stalagmiten (rot, grün, blau) für die vergangenen 9000 Jahre. Abbildung aus Mudelsee et al. (2012).

Manfred Mudelsee war zudem als Co-Autor an einer anderen Publikation beteiligt (Fohlmeister et al. 2012), in der zum Teil sogar die gleichen Tropfsteine untersucht wurden (siehe unser Blogartikel „Klimatanz in der Bunkerhöhle während der letzten 10.000 Jahre im Takte der Sonne“). In dieser zweiten Studie erklären die Autoren nun kurioserweise genau das, was Mudelsee nun seltsamerweise versucht abzustreiten: Ja, es gibt Klimaschwankungen im Millenniumsmaßstab, genau wie in der Pionierarbeit eines Teams um Gerard Bond aus dem Nordatlantik, wo sie in einem Science-Artikel 2001 explizit beschrieben worden sind und mit solaren Aktivitätsschwankungen in Verbindung gebracht wurden. Zitat aus Fohlmeister et al. (2001, S. 1704):

“Therefore, climatic-related signals from the North Atlantic (e.g. the hematite-stained grains (HSG) record; Bond et al., 2001) and the Bunker Cave delta18O record are expected to show similar variations (Fig. 5). Cold periods as indicated by increased percentages of HSG indeed coincide in most cases with colder phases in Western Germany (high delta18O values in speleothem calcite).”

Frage zur Plausibilität: Wie konnte Mudelsee die Millenniumszyklen-Interpretation im Fohlmeister et al.-Paper explizit als Co-Autor offensichtlich mittragen, während er nun anscheinend nichts mehr davon wissen will? Wie passt dies zusammen? Was steckt wirklich hinter dieser Kritik?

Ebenso mysteriös ist die im Zeit Online Artikel berichtete Reaktion von Jürg Beer, seinerzeit Co-Autor der wichtigen Nordatlantik-Studie des Bond-Teams:

Einer seiner damaligen Mitautoren aber, der Schweizer Umweltphysiker Jürg Beer, sagt zu den Schlussfolgerungen, die Vahrenholt und Lüning aus der Studie ziehen: “Das ist unseriös. Das kann man nicht machen.”

Mit solch einer pauschalen Kritik ist beim besten Willen nicht viel anzufangen. Weder nennt Beer einen plausiblen Grund, warum die Schlussfolgerungen „unseriös“ wären, noch scheint sich Beer an den Text seines eigenen Abstracts zu erinnern, in dem sowohl die Klimazyklik im Millenniumsmaßstab, als auch die Steuerung durch Sonnenaktivitätsschwankungen ausdrücklich genannt sind (aus Bond et al. 2001):

A solar forcing mechanism therefore may underlie at least the Holocene segment of the North Atlantic’s “1500-year” cycle. The surface hydrographic changes may have affected production of North Atlantic Deep Water, potentially providing an additional mechanism for amplifying the solar signals and transmitting them globally.

Wodurch könnte das Erinnerungsvermögen möglicherweise getrübt worden sein? Hat es vielleicht damit zu tun, dass Jürg Beer mittlerweile als Autor am 5. Klimazustandsbericht des IPCC beteiligt ist?

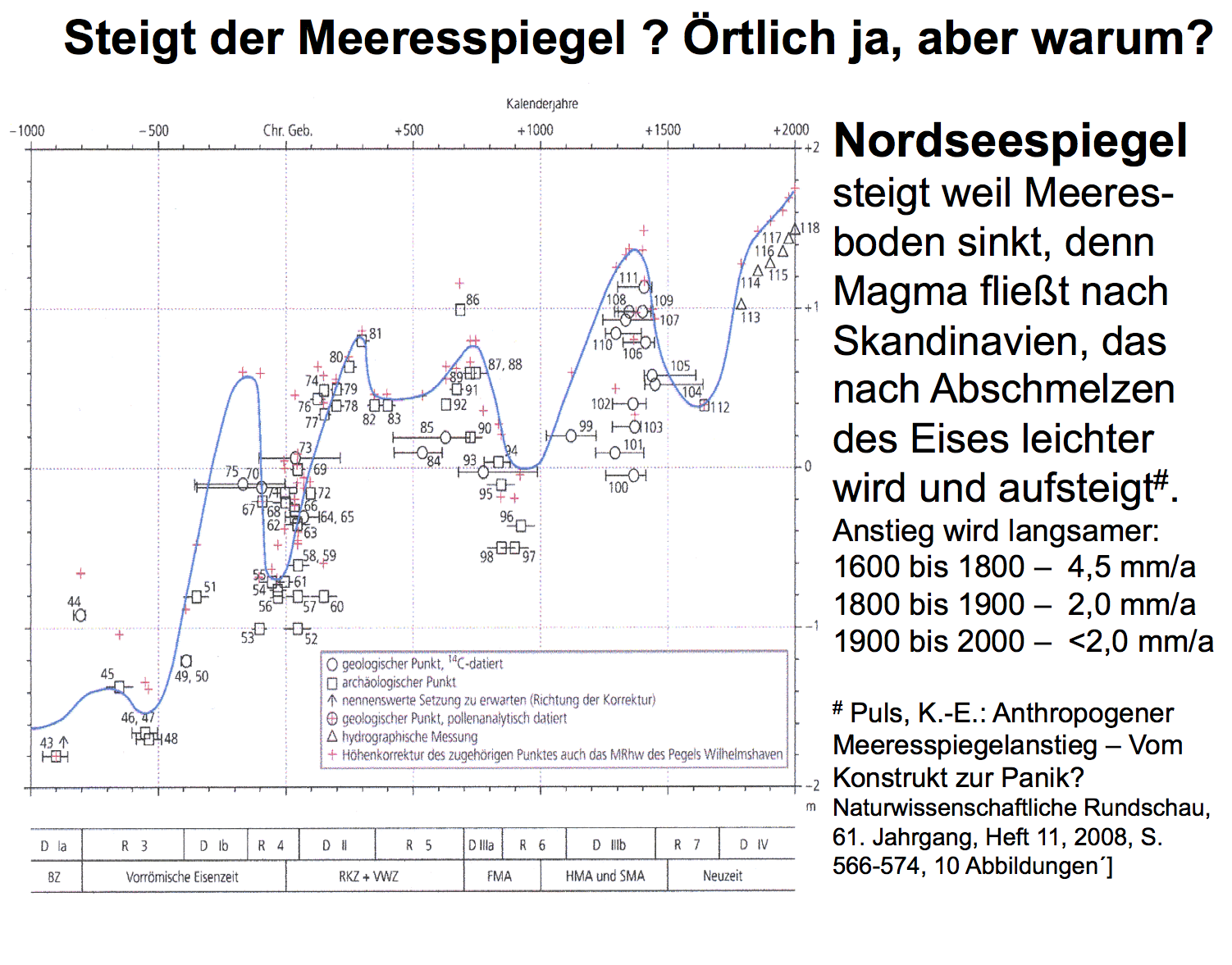

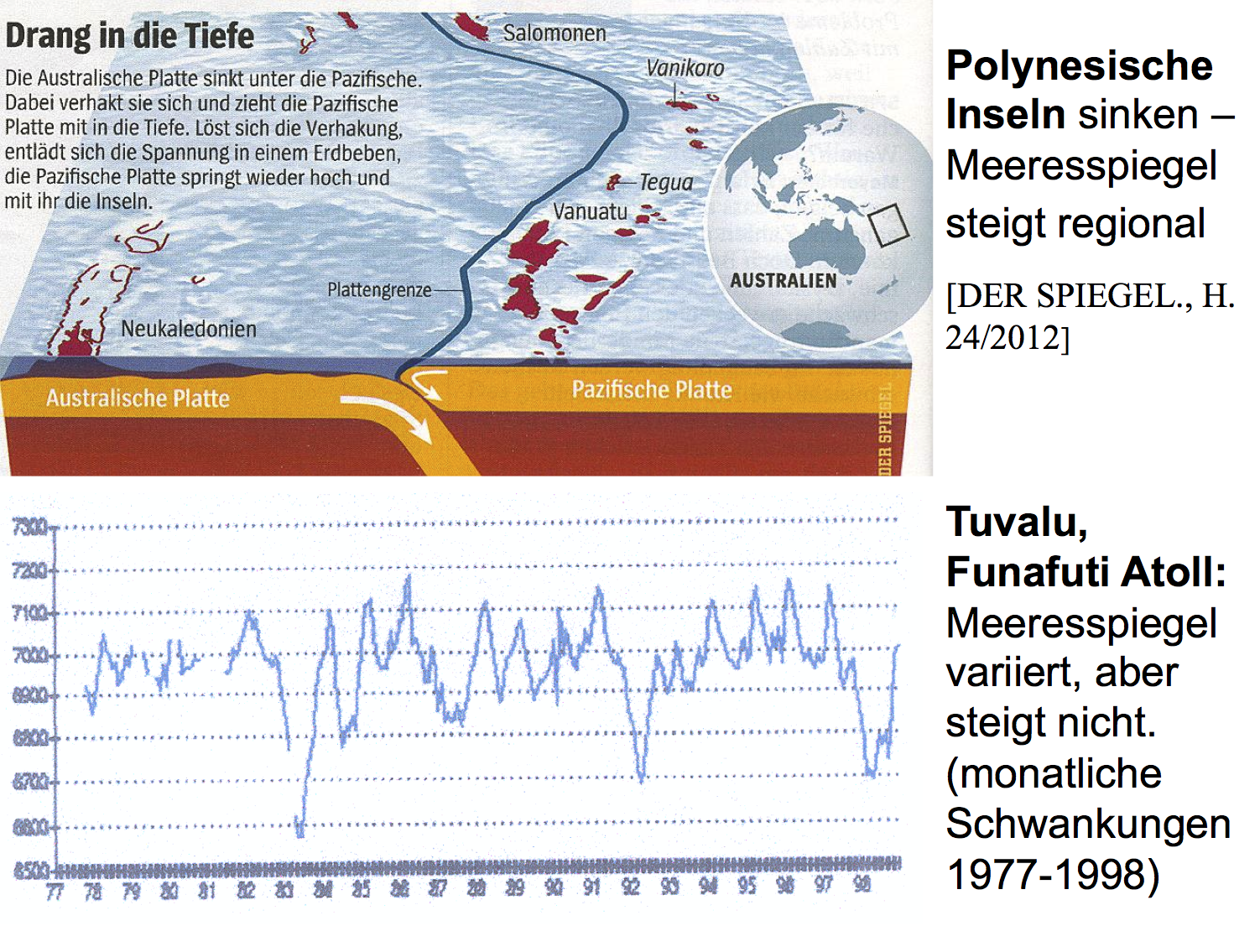

Meeresspiegelanstieg

Dann schwenkt Toralf Staud zur Frage des Meeresspiegelanstiegs um und wirft uns vor, wir hätten Simon Holgate und Jens Schröter falsch zitiert. Dabei übersieht Staud, dass wir uns hierbei auf Äußerungen beziehen, die schwarz auf weiß in einem Spiegelartikel von Axel Bojanowski vom 25.8.2011 stehen:

“Ob wir seit 1993 eine Beschleunigung haben, ist nicht klar”, sagt John Church vom australischen Klimaforschungsinstitut CSIRO. “Ich halte es für unwahrscheinlich, dass sich der Meeresspiegel-Anstieg ausgerechnet in dem Jahr beschleunigt haben sollte, als Satelliten in Dienst gestellt wurden”, ergänzt Simon Holgate, Meeresspiegel-Forscher am National Oceanography Centre in Liverpool.

In der Tat wurden Satellitenrohdaten nachträglich kräftig bearbeitet werden, um die angebliche Beschleunigung des Meeresspiegelanstiegs in den letzten Jahrzehnten zu erhalten (siehe unser Blogartikel „Nachträgliche Korrekturen der Satelliten-Meeresspiegeldaten: Was nicht passt wird passend gemacht?“). Pegelmessungen können interessanterweise die postulierte „Beschleunigung“ des Meeresspiegelanstiegs nicht nachvollziehen (siehe unsere Blogartikel „Beschleunigte Meeresspiegelanstiege gehören schleunigst in die Mottenkiste“ und „Fallstudien aus aller Welt belegen: Keine Beschleunigung des Meeresspiegelanstiegs während der letzten 30 Jahre“).

Auch der Vorwurf, wir hätten Jens Schröter vom Bremerhavener Alfred Wegener Institut falsch zitiert ist schwer nachvollziehbar. Wiederum diente ein Spiegel-Artikel als Vorlage, diesmal von Markus Becker vom 21.6.2011. Damals ging es um eine neue Studie von Stefan Rahmstorf, der einen beschleunigten Meeresspiegelanstieg an der Küste von North Carolina beobachtet haben will (siehe unser Blogartikel „Senat von North Carolina erteilt Rahmstorfs beschleunigtem Meeresspiegel eine Absage“). Becker schrieb damals auf Spiegel Online:

Doch genau das bezweifeln andere Fachleute. Sie sehen ein Hauptproblem der neuen Untersuchung darin, dass sie letztlich nur auf den Funden von der Küste North Carolinas beruht – was für eine Aussage der globalen Entwicklung zu wenig sein könnte. “Diese Studie eignet sich deshalb überhaupt nicht für Vorhersagen”, meint Jens Schröter vom Alfred-Wegener-Institut für Polar- und Meeresforschung.

An dieser Stelle wird besonders gut erkennbar, dass Toralf Staud in der fachlichen Diskussion kaum drinsteckt und mehr Verwirrung als Hilfe zur Klärung leistet. Er zitiert Schröter in seiner Zeit Online-Kritik:

“Es gibt natürlich Landhebungen und -senkungen”, bestätigt Schröter, wenn man ihn anruft. “Aber die können die Beschleunigung des Meeresspiegelanstiegs in den letzten Jahrhunderten nicht erklären.”

Offenbar merkt Staud gar nicht, dass sich die Diskussion nicht um die Beschleunigung des Meeresspiegels „in den letzten Jahrhunderten“ sondrn „vielmehr „in den letzten Jahrzehnten“ dreht. Denn diese ist klar erkennbar und plausibel zu erklären. Während der Kleinen Eiszeit war es so kalt, dass Gletscher und Polkappen ordentlich zulegten und der Meeresspiegelanstieg aus diesem Grunde zum Stillstand kam, zum Teil sogar sinkende Meeresspiegel zu beobachten waren. Im Übergang der Kleinen Eiszeit zur Modernen Wärmeperiode begannen die Eismassen dann wieder zu tauen und der Meeresspiegelanstieg zog wieder an. Bis etwa 1940 nahm die Geschwindigkeit des Anstiegs immer weiter zu, blieb dann aber ab 1940 ziemlich konstant. In den letzten Jahrzehnten ist daher keine weitere Beschleunigung des Meeresspiegelanstiegs mehr zu erkennen, wenn man verlässliche Pegelmessungen heranzieht und die in fragwürdiger Art und Weise „korrigierten“ Satellitendaten“ einmal außen vor lässt.

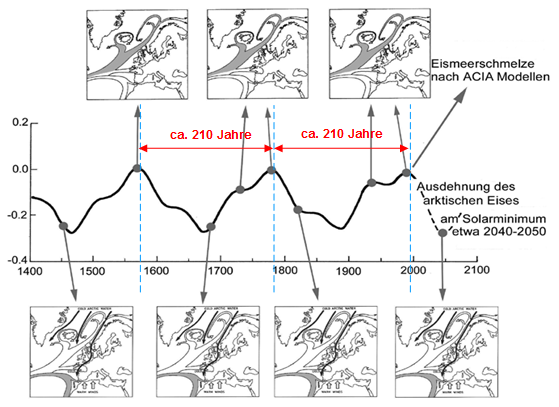

Drohende Sonnenflaute

Staud kritisiert in der Folge die Aussicht, dass die Sonnenaktivität in den kommenden Jahrzehnten bis etwa 2030/2040 abnehmen könnte. Eine solche Entwicklung nimmt die Mehrheit der Astrophysiker als wahrscheinlich an, wie wir ausführlich auf den Seiten 298-308 in unserem Buch „Die kalte Sonne“ darlegen und auch in unserem Blog geschrieben haben.

Wieder verdreht Staud die Situation nach Belieben und schreibt:

In Die kalte Sonne bauen die Autoren ihre Argumentation darauf auf, man könne belastbare Prognosen über die solare Aktivität der Zukunft abgeben. Vahrenholt und Lüning verweisen mehrfach auf Sami Solanki vom Max-Planck-Institut für Sonnensystemforschung. Spricht man mit ihm, sagt er, es sei “völlig unmöglich, über den nächsten elfjährigen Sonnenzyklus hinaus in die Zukunft zu schauen”. Aussagen über mehrere Jahrzehnte, wie Vahrenholt und Lüning sie treffen, könne er “nicht unterstützen”.

Staud übersieht hierbei zwei Dinge. Zum einen zitieren wir Solanki lediglich im Zusammenhang mit seinem Nature Artikel von 2004, in dem er zeigen konnte, dass die letzten Jahrzehnte zu den solar aktivsten der letzten 10.000 Jahre gehörten. Zum anderen steht Solanki mit seiner überaus pessimistischen Sichtweise zur Vorhersagbarkeit ziemlich alleine in der Fachwelt dar. Wenn man die Fachliteratur etwas verfolgt hat, wird dies schnell klar. Staud hat es vorgezogen, den Zeit Online Lesern diesen Sachverhalt vorzuenthalten, obwohl ihm mehr als zehn Literaturzitate zu den entsprechenden Publikationen im Vorfeld des Artikels von Lüning alle zur Verfügung gestellt wurden.

Kosmische Strahlung

Schließlich kritisiert Staud noch unseren Umgang mit den Arbeiten von Benjamin Laken. Im Buch gehen wir auf Seite 258 ausführlich auf eine Arbeit von Laken ein, die den bezeichnenden Titel trägt „Cosmic rays linked to rapid mid-latitude cloud changes“. Hier steckt schon im Titel drin, dass in der Studie offensichtlich ein Zusammenhang zwischen kosmischer Strahlung und Veränderung der Wolkenbedeckung gefunden wurde. Über genau diesen Zusammenhang berichten wir in unserem Buch.

Die Erforschung der Wolkenbildung und der mögliche Einfluss von kosmischer Strahlung befindet sich derzeit in einer heißen Phase. Hier besteht noch viel Forschungsbedarf. Da wundert es nicht, dass in anderen Studien von Laken, der Zusammenhang zwischen den beiden Faktoren nicht nachgewiesen werden konnte. Auf den Seiten 260/261 unseres Buches gehen wir auf diese Diskrepanzen ein und diskutieren basierend auf Diskussionen mit Henrik Svensmark mögliche Fehlermöglichkeiten. Diesen Teil hat Staud offenbar überlesen.

Toralf Staud teilt in seinem Zeit Online Beitrag kräftig aus und verwendet allerlei unschöne Begriffe und Floskeln. Am liebsten hätte er, wenn die zahlreichen Kritiker des IPCC einfach abgeschaltet werden könnten. Zusammen mit Manfred Mudelsee träumt Greenpeace-Magazin-Autor Staud schon davon, dass den unbequemen Klimarealisten einfach der “Anspruch auf Teilhabe am wissenschaftlichen Diskurs” aberkannt werden könnte. Ein netter Gedanke. In Nordkorea und Kuba wäre dieses Vorhaben sicher auch durchführbar.

Der Faktencheck zeigt, dass Stauds Kritik wenig stichhaltig ist. Kann es sich eine ansonsten renommierte Redaktion wie Die Zeit eigentlich leisten, solch einen schwachen und persönlich aggressiven Artikel fachlich weitgehend ungeprüft zu veröffentlichen?

Das Foto oben rechts zeigt Toralf Staud. Quelle: Wikipedia

Zuerst erschienene unter Kritik an der kalten Sonne auf Zeit Online: Was ist dran an den Vorwürfen?

pdf herunter geladen werden

pdf herunter geladen werden