Ich sagte, dass da ein Fehler vorliegen muss. Ich bin nicht weit von diesem Gebiet aufgewachsen, gerade hinter der Grenze zur Tschechischen Republik, und ich werde niemals die endlosen Sommertage vergessen, die ich wegen des ständigen Regens drinnen verbringen musste. In Bayern ist es ähnlich wie in Seattle in den USA oder der Provinz Sichuan in China. Man möchte nie ein Solarkraftwerk in Bayern bauen, aber genau dorthin haben es die Deutschen gepackt. Das Kraftwerk mit einer Spitzenleistung von 10 Megawatt wurde im Juni 2005 in Betrieb genommen.

Und zwar aus dem besten Grund, den es in der Politik gibt: Geld. Willkommen in der Welt neuer erneuerbarer Energien, in der die Subventionen regieren – und die Verbraucher zahlen.

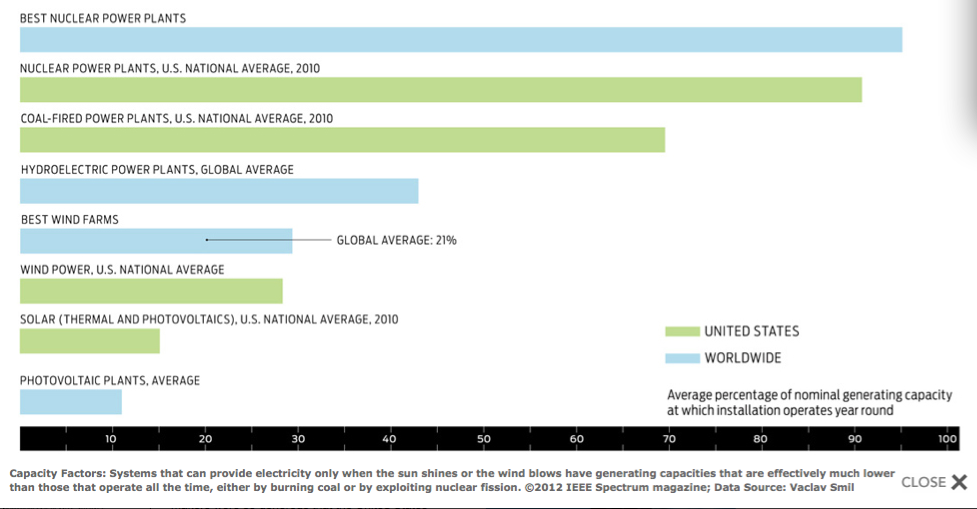

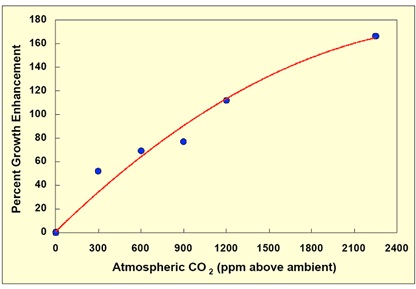

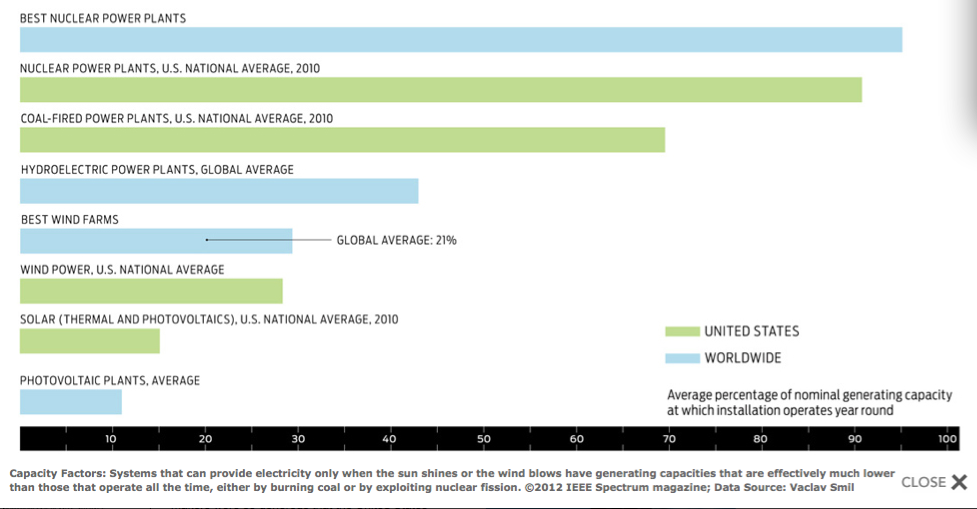

Ohne diese Subventionen könnten die Erneuerbare-Energien-Kraftwerke im Gegensatz zu hydroelektrischen oder geothermischen Kraftwerken nicht mit konventionellen Erzeugern konkurrieren. Dafür gibt es viele Gründe, zuallererst die geringe Kapazität – die meiste Elektrizität, die ein Kraftwerk tatsächlich erzeugen kann geteilt durch das, was es erzeugen könnte bei ständiger voller Auslastung. Der Kapazitätsfaktor eine typischen Kernkraftwerkes liegt bei über 90%; für ein Kohlekraftwerk bei 60 bis 75%. Eine Photovoltaik-Installation kann es nahe 20 Prozent bringen – im sonnigen Spanien – und eine Windturbine, gut aufgestellt auf dem Festland, 25 bis 30 Prozent. Man errichte sie offshore, und sie könnte sogar 40 Prozent erreichen. Um beide der letztgenannten Technologien nutzen zu können, muss man sich aber auch der Notwendigkeit stellen, jeweils vollständig neue Überlandleitungen zu spannen an Orte, wo Sonne und Wind vorhanden sind, ebenso wie der Notwendigkeit, wegen der unsteten Natur der Energie eine sehr variable Spannung zu managen.

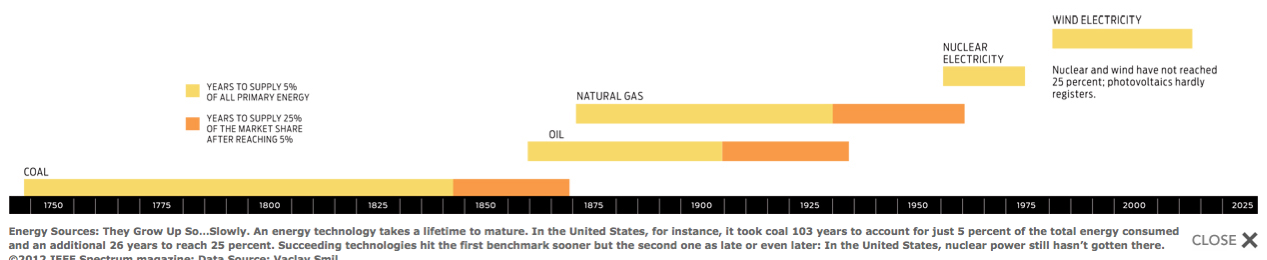

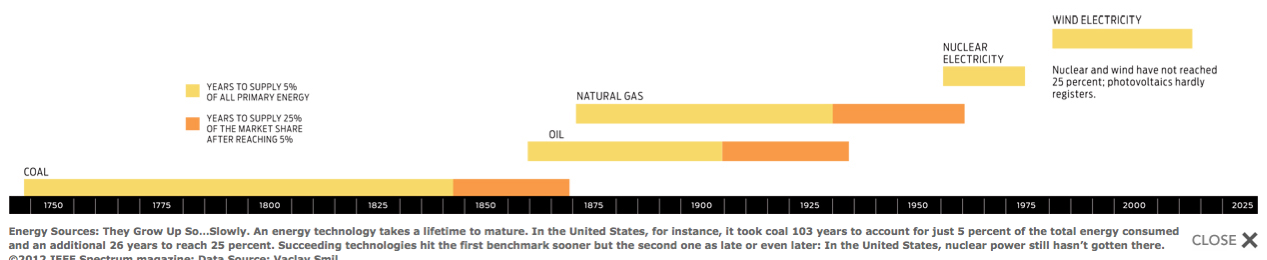

Alle diese Komplikationen sind wohlbekannt, und alle wurden von den Unterstützern der alternativen Energie und der Medien viel zu wenig beachtet. Am schlimmsten jedoch ist, dass man seitens der Antreiber die Zeit nicht berücksichtigt hat, die es braucht, um zu einer neuen Energiequelle überzugehen, egal wie überzeugend die Argumente dafür auch sind.

Ein Beispiel ist der vom früheren Vizepräsidenten Al Gore befürwortete Plan aus dem Jahr 2008, dem zufolge alle fossil betriebenen Kraftwerke in den USA innerhalb eines Jahrzehnts ersetzt werden sollten. Ein weiterer ist Googles Plan, der im Jahr 2008 verkündet und im Jahr 2011 aufgegeben worden war, dem zufolge die Erzeugung mit Kohle bis zum Jahr 2030 ganz aufhören sollte. Alle diese Pläne wurden aber noch übertroffen durch einen Artikel aus dem Jahr 2009 im Scientific American von Mark Jacobsson, einem Bauingenieur-Professor an der Stanford-University, und Mark Delucchi, einem Forscher für das Transportwesen an der University of California. Sie schlugen vor, die Energiewirtschaft in der ganzen Welt bis zum Jahr 2030 auf erneuerbare Quellen zu konvertieren.

Die Historie und eine Betrachtung der technischen Erfordernisse zeigen, dass das Problem viel größer ist als diese Befürworter gedacht hatten.

Was hat sich die deutsche Regierung im Jahr 2004 gedacht, als sie eine Einspeisetarif genannte Subvention angeboten hat, die Investoren bis zu 0,57 Euro pro Kilowattstunde für die nächsten 20 Jahre der Stromerzeugung durch Photovoltaik garantiert? Zu der Zeit lag der Strompreis aus anderen Quellen um 0,20 Euro pro kWh. Zum Vergleich: der mittlere Strompreis in den USA lag im Jahr 2004 bei 7,6 Cent oder 0,06 Euro pro kWh. Angesichts solcher Subventionen ist es kein Wunder, dass der Solarpark in Bayern nur der Anfang eines Booms war, um in ganz Deutschland Solarparks zu errichten. Bis Ende 2011 besaßen die PV-Installationen in Deutschland eine Kapazität von fast 25 Gigawatt, also mehr als ein Drittel der gesamten globalen Kapazität. Subventioniert man irgendetwas nur ausreichend genug, kann es auf den ersten Blick vernünftig aussehen; erst später kommt die Realität ins Spiel. Aufgeschreckt durch die Nachricht, dass die Deutschen den zweithöchsten Strompreis in Europa bezahlen, hat der Bundestag im vergangenen März dafür gestimmt, die verschiedenen Solarsubventionen um bis zu 29 Prozent zu kürzen.

So generöse Subventionen sind in keiner Weise eine deutsche Eigenart. Sie waren in der neuen Welt der erneuerbaren Energien die Norm; lediglich die Ziele unterscheiden sich. Spanien hat die Energieerzeugung durch Wind und PV ebenfalls subventioniert, bevor der Einspeisetarif dort für große Installationen um fast 50 Prozent im Jahr 2010 gekürzt worden war. Die Vorteile Chinas für die dortige Industrie zur Herstellung von Windturbinen waren so gewaltig, dass sich die USA 2010 darüber bei der Welthandelsorganisation beklagt hatten. In den USA haben weder Wind- noch Solarkraftwerke, sondern Biomasse am meisten profitiert – besonders Mais zur Herstellung von Ethanol.

Dem Accountability Office der US-Regierung zufolge kostet den Steuerzahler die Steuer auf die Ethanolherstellung im Jahr 2011 6,1 Milliarden Dollar. Zusätzlich du diesen direkten Kosten kommen noch drei indirekte: einmal Kosten in Zusammenhang mit der Bodenerosion, dem Abfluss von Wasser mit übermäßigem Nitratgehalt durch die Düngemittel (welche im Golf von Mexiko enden und dort in küstennahen Gebieten Todeszonen erzeugen) und die steigenden Lebensmittelpreise, die sich ergeben, wenn der größte Getreideexporteur der Welt 40 Prozent seines Mais’ zur Ethanolherstellung abzweigt. Und die Krone des Ganzen ist, dass der so hergestellte Treibstoff meistens in energieineffizienten Fahrzeugen verbraucht wird.

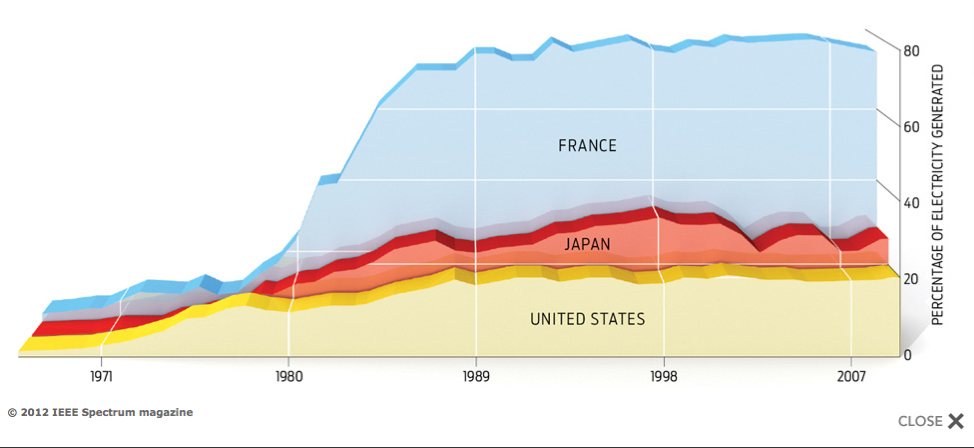

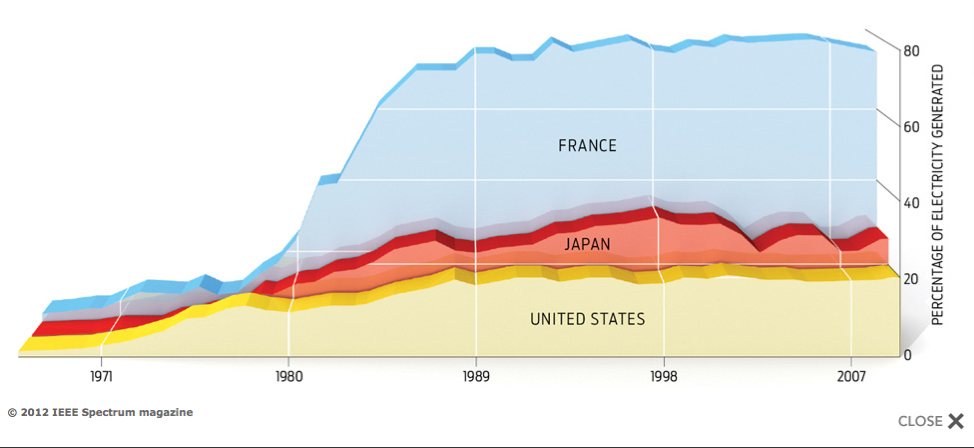

Nun könnte man einwenden [PDF] , dass Subventionen nicht per se schlecht sind; tatsächlich gibt es eine lange Geschichte, wie sie zur Entwicklung neuer Energiequellen eingesetzt worden sind. Die Öl- und Gasindustrie haben von Jahrzehnten mit Steuererleichterungen profitiert, die darauf abzielten, die Erschließung zu stimulieren. Die Kernkraftindustrie ist auf dem Rücken direkter und enormer Unterstützung der Forschungs- und Entwicklungsabteilung [R&D, Research and Development] gewachsen. In den USA hat sie zwischen 1948 und 2007 fast 54 Prozent aller öffentlichen Forschungsgelder empfangen. In Frankreich erhielt sie umfassende Unterstützung der staatlichen Stromerzeugungsgesellschaft. Ohne diese Subvention hätte diese Industrie es bis heute nicht geschafft, mehr als 75 Prozent des französischen Energiemarktes zu beherrschen. Daher müssen wir uns fragen, ob die Subventionen für alternative Energien halten können, was deren Befürworter versprechen.

Bild Kernenergie: eine Energietechnologie, die angeschoben worden ist. Kernkraft war die erste wesentliche neue Energiequelle, die ihre Entwicklung weitestgehend den Investitionen und Subventionen der Regierung zu verdanken hat, wie man an hand der sehr unterschiedlichen Entwicklungen in diesen drei Ländern erkennen kann.

Man mache sich keine Illusionen: sie versprechen viel. Die leidenschaftlichsten Unterstützer von Sonne, Wind und Biomasse führen an, dass diese Quellen fossile Treibstoffe ersetzen können und hoch zuverlässige, nicht verschmutzende, kohlenstofffreie Systeme sind, die nicht teurer sind als die heute billigste kohlebasierte Stromerzeugung, alles in nur wenigen Jahrzehnten. Das wäre schnell genug um zu verhindern, dass der Anstieg des Kohlendioxids in der Atmosphäre von gegenwärtig 394 ppm auf mehr als 450 ppm steigt – einem Wert, ab dem Klimatologen schätzen, dass die globale Temperatur um 2°C steigen wird. Ich wünschte, dass all diese Versprechen wahr werden würden, aber ich glaube stattdessen, dass ich lieber den Glauben auf eindeutige technische Einschätzungen richten sollte.

Das Ganze zu bezahlbaren Preisen zu bekommen ist das am schwierigsten einzulösende Versprechen, betrachtet man die vielen verschiedenen Subventionen und die kreativen Verrechnungstechniken, mit denen seit Jahren alternative und erneuerbare Erzeugungstechnologien untermauert werden. Sowohl die Europäische als auch die amerikanische Wind Energy Association behaupten, dass Windturbinen schon jetzt billiger Energie erzeugen als Kohlekraftwerke, während es die Solarenthusiasten vorziehen, das Beispiel der beeindruckend zurückgehenden Preise für Photovoltaikzellen anzupreisen, um den Eindruck zu erzeugen, dass wir schon bald erkennen, wie staunenswert niedrig die installierten Kosten liegen.

Andere Analysen jedoch weisen die Behauptungen billigen Windstroms zurück, und wieder andere berücksichtigen die Tatsache, dass Photovoltaik-Installationen nicht nur Zellen, sondern auch Rahmen, Stromumwandler, Batterien und Wartung benötigen. Diese damit verbundenen Kosten sind überhaupt nicht rückläufig, und das ist auch der Grund dafür, dass sich die Kosten der heimischen Solarstromerzeugung in den USA seit dem Jahr 2000 nicht grundlegend verändert haben. Zu jener Zeit lag der Preis im nationalen Mittel nahe 40 US-Cent pro Kilowattstunde in sonnigen Gebieten und bei 63,60 Cent in wolkigeren Gebieten. Das ist immer noch erheblich teurer als der Verbrauch fossiler Treibstoffe, der in den USA im Jahr 2011 zwischen 11 und 12 Cent pro Kilowattstunde teuer war. Das Zeitalter dezentraler umfangreicher Stromerzeugung mittels Photovoltaik ist noch nicht angebrochen.

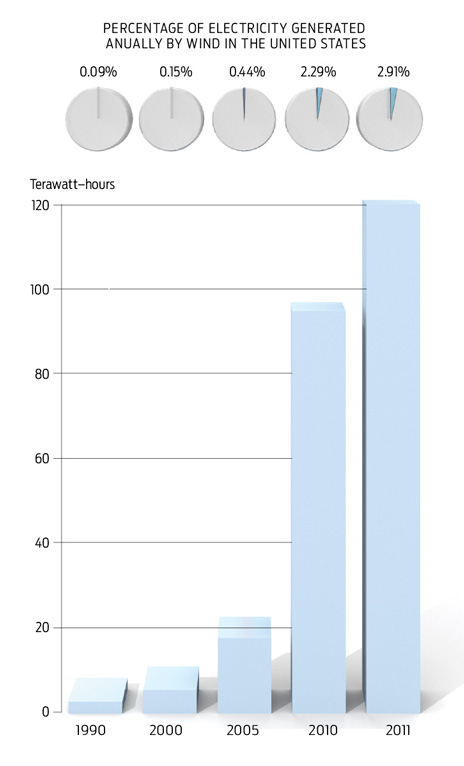

Dann betrachte man die Frage der Größenordnung. Windkraft ist kommerziell weiter als Sonnenenergie, aber mit 47 Gigawatt in den USA Ende 2011 bringt sie immer noch lediglich 4 Prozent der sommers erzeugten Kapazität in diesem Land. Und weil die Kapazitätsfaktoren der Windturbinen in den USA so niedrig liegen, trug der Wind zu weniger als 3 Prozent zur insgesamt erzeugten Elektrizität im Jahr 2011 bei.

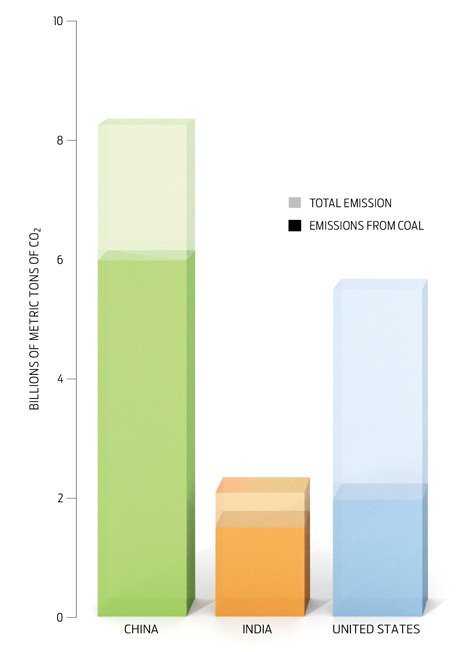

Infographik: Design Bryan Christie; Datenquelle Vaclav Smil: Zwei aufstrebende Mächte, China und Indien, lassen die USA hinsichtlich der Kohlenstoffemissionen hinter sich.

Es dauerte 30 Jahre, – seit dem Einsatz kleiner, moderner Windturbinen im Jahr 1980 – um auch nur diesen geringen Prozentsatz zu erreichen. Zum Vergleich, die Kernkraft erreichte innerhalb von 30 Jahren nach der Einführung 20 Prozent der Gesamtstromerzeugung in den USA, und Gasturbinen 10 Prozent innerhalb von drei Jahrzehnten nach der Inbetriebnahme in den frühen sechziger Jahren.

Projektionen der Stromerzeugung durch Wind in die Zukunft waren irreführend optimistisch, weil sie alle auf der Zunahme von einer sehr geringen Basis ausgingen. Was also ist, wenn die gesamte globale Windkapazität zwischen 2001 und 2011 um das Sechsfache gestiegen wäre? Solche hohen Zuwachsraten sind typisch für frühe Stadien der Entwicklung, besonders wenn – wie in diesem Fall – das Wachstum hauptsächlich durch Subventionen angetrieben worden ist.

Inzwischen gibt es einen neuen Faktor, der die Aussichten für Wind und Sonne verändert: Das Auftauchen umfangreicher Vorräte von Erdgas, dass durch hydraulisches Brechen, oder Fracking, aus Schiefer gewonnen wird. Derzeit ist Fracking außerhalb der USA und Kanada noch nicht üblich, aber es könnte in vielen Ländern in Europa, Asien und Lateinamerika verwendet werden, wo es ebenfalls riesige Vorkommen gibt. Einige Länder wie Frankreich und Deutschland haben die Technologie verbannt, und zwar aus Furcht vor möglichen Auswirkungen auf die Umwelt, aber solche Bedenken begleiten alle neuen Energietechnologien, selbst solche, die überschwänglich für ihre guten Auswirkungen auf die Umwelt angepriesen werden. Und Erdgas kann verwendet werden, um Energie besonders effizient zu erzeugen. Zum Beispiel beuten kombinierte Gaskraftwerke die Abfallwärme der Gasturbine aus, um Dampf zu erzeugen, womit zusätzlich mittels einer Dampfturbine Strom erzeugt werden kann. Was aber noch mehr zählt ist, dass Gasturbinen mit einer Kapazität bis 60 Megawatt innerhalb eines Monats in Betrieb gehen können. Außerdem können sie bequem dort gebaut werden, wo ihr Strom in bereits bestehende Überlandleitungen eingespeist werden kann.

Die Orte, an denen massive Windparks errichtet werden sollen, sind ebenfalls zunehmend umstritten – viele Menschen mögen das Aussehen nicht, lehnen deren Lärm ab oder machen sich Sorgen über deren Auswirkungen auf Zugvögel und Fledermäuse. Dies ist inzwischen sogar für einige Offshore-Projekte zum Problem geworden. Zum Beispiel, ein riesiges Projekt vor der Insel Martha’s Vineyard island in Massachusets, welches das erste Offshore-Windprojekt in den USA sein sollte, liegt seit Jahren wegen der Opposition vor Ort auf Eis. Die Unstetigkeit des Windes macht es schwierig abzuschätzen, wie viel Strom innerhalb weniger Tage erzeugt werden kann, und das Fehlen von Erfahrungen beim Betrieb großer Turbinen führt langfristig zu sogar noch größerer Ungewissheit. Wir müssen einfach abwarten, wie zuverlässig sie während ihrer angenommenen Lebensdauer von 20 bis 30 Jahren sind und wie viel Reparatur- und Wartungskosten anfallen.

Und natürlich kann man Windturbinen nicht nutzen, solange nicht gewährleistet ist, dass sie an ein Netz noch zu bauender Hochspannungsleitungen angeschlossen werden können, ein teures und normalerweise legal herausforderndes Unterfangen.

Unter der Annahme, dass große Windparks in den USA in den Großen Ebenen errichtet werden könnten, wo Wind und Land ausreichend zur Verfügung steht, müssen die Entwickler viele tausend Kilometer Überlandleitungen konstruieren, um diese Windparks mit den wesentlichen Strommärkten an den Küsten zu verbinden. Natürlich ist die Herausforderung der Verbindungen für kleine Länder einfacher (vor allem, wenn sie sich auf ihre Nachbarn verlassen können), was mit ein Grund dafür ist, dass Dänemark führend hinsichtlich der Windkraft geworden ist.

In den USA geht das Problem über den Bau neuer Leitungen hinaus; es ist nötig, diese an ein existierendes Netz anzuschließen, dass schon jetzt angespannt und ungeeignet ist. Der jüngste Bericht zur amerikanischen Infrastruktur, vorbereitet mit den Daten des Jahres 2009 von der American Society of Civil Engineers, erteilt dem heimischen Energiesystem die Bewertung D+ [vergleichbar mit der deutschen Schulnote 4+], hauptsächlich deswegen, weil das Netz relativ alt ist und der Betrieb häufig durch Spitzen hohen sommerlichen Bedarfs angespannt wird [vermutlich wegen der ganzen Klimaanlagen, A. d. Übers.]. Eine Verbesserung dieser Bewertung ist mehr als eine technische Herausforderung, weil Verbesserungen der Infrastruktur oftmals fest verwurzelter politischer Opposition gegenüber stehen – das Nicht-in-meinem-Garten-Syndrom.

In Europa mag es bessere Verbindungen geben, aber hier steht die Hinwendung zu Wind- und Solarenergie anderen Problemen gegenüber. Die ökonomischen Aussichten sind düster, und das wird dessen Fähigkeit, massiv in neue Technologien zu investieren, begrenzen. Selbst Deutschland, die stärkste europäische Wirtschaft und ein großer Faktor bzgl. neuer Energien, hat einen schwierigen Weg vor sich; dort muss man Ersatz für die Kernkraftwerke finden, die man aufgrund der Ereignisse in Fukushima abgeschaltet hat. Das ist keine geringe Herausforderung, wenn Deutschland seine Subventionen für Wind- und Sonnenenergie kürzt und die Wirtschaft einer Rezession nahe steht.

Eingriffe der Regierung sind erforderlich, weil die Chancen schlecht sind, dass irgendein privates Investitionsprogramm umfangreich genug ist, um die Konversion zu neuen Energiequellen zu beschleunigen. Aber selbst Regierungen in den reichen Ländern haben Schwierigkeiten, essentielle Infrastrukturen einzurichten, hauptsächlich wegen wachsender Zweifel. Gründe dafür sind u. A. nicht eingedämmte Gesundheitskosten, Handelsdefizite, nicht wettbewerbsfähige Herstellung und Steuerausfälle. Gleichzeitig haben Subventionen der Regierung für neue Energietechnologien es nicht vermocht, ein oft gemachtes Versprechen einzulösen: Sie haben keine neuen permanenten und gut bezahlte Arbeitsplätze geschaffen, weder in der EU noch in den USA.

Infographik: Design Bryan Christie; Datenquelle: Vaclav Smil Die Windkraft in den USA ist von einer sehr niedrigen Basis schnell gewachsen, und wie die Historie solcher Technologien zeigt, kommt die wirkliche Herausforderung erst später.

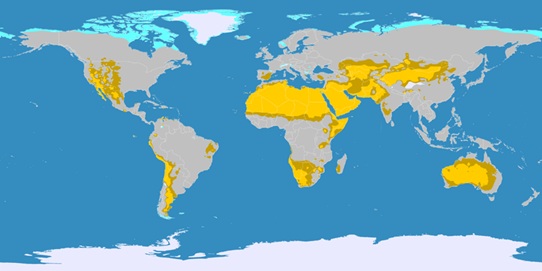

Die ultimative Rechtfertigung für alternative Energie hat die Abschwächung der globalen Erwärmung zum Mittelpunkt: Die Erzeugung von Energie aus Wind, Sonne und Biomasse fügt der Atmosphäre weniger Treibhausgase zu. Aber während diese Treibhausgase globale Auswirkungen haben, muss die Wirksamkeit dieser Einsetzung auch global beurteilt werden. Und dann müssen wir erkennen, dass der Beitrag der westlichen Welt zur Reduktion von Kohlendioxidemissionen durch Wind und Sonne bedeutungslos ist gegenüber der zunehmenden Verbrennung von Kohle in China und Indien.

Die Zahlen sind ernüchternd. Zwischen den Jahren 2004 und 2009 sind in den USA etwa für 28 Gigawatt Windturbinen errichtet worden. Das ist äquivalent mit weniger als 10 Gigawatt Kapazität aus Kohle, legt man die sehr unterschiedlichen Ladefaktoren zugrunde. Während der gleichen Zeit ist in China mehr als 30 mal so viel [PDF] Kapazität aus Kohle installiert worden in riesigen zentralen Kraftwerken, Einrichtungen, die eine erwartete Lebensdauer von mindestens 30 Jahren haben. Im Jahr 2010 allein haben in China die Kohlendioxidemissionen um fast 800 Millionen metrischer Tonnen zugenommen, das entspricht etwa der Gesamtmenge in den USA. Im gleichen Jahr wurden in den USA fast 95 Terawattstunden Strom aus Wind erzeugt, was folglich die Emission von etwa 65 Millionen Tonnen Kohlendioxid verhindert hat. Außerdem wird China bis zum Jahr 2015 weitere Kohlekraftwerke mit einer Kapazität von 200 GW bauen, während in den USA lediglich etwa 30 GW Windkapazität hinzukommen, äquivalent mit weniger als 15 GW Kohlestromerzeugung. Natürlich wird sich die rapide Zunahme der Verbrennung asiatischer Kohle irgendwie mäßigen, aber selbst dann kann die Konzentration von Kohlendioxid in der Atmosphäre nicht unter 450 ppm bleiben.

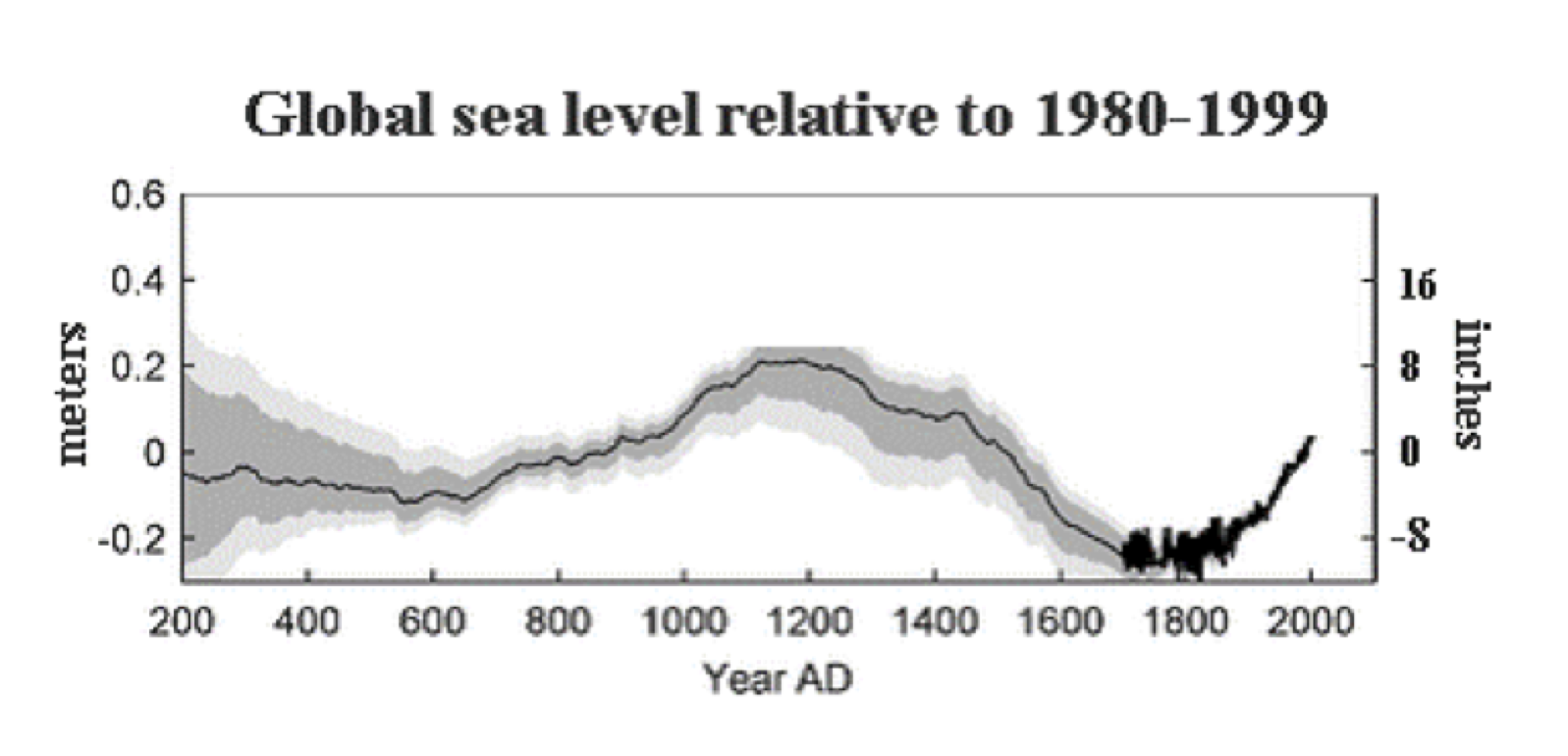

Der vielleicht am wenigsten verstandene Aspekt der Energiewende ist deren Geschwindigkeit. Der Ersatz einer Energieform durch eine andere dauert lange. Strom aus Kernkraft in den USA erzeugte 23 Jahre nach der Inbetriebnahme 10 Prozent des Gesamtstromes, und es dauerte 38 Jahre, bis dieser Anteil auf 20 Prozent gewachsen ist, was im Jahr 1995 der Fall war. Seitdem ist dieser Anteil in etwa gleich geblieben. Stromerzeugung mit Gasturbinen aus Erdgas brauchte 45 Jahre, um einen Anteil von 20 Prozent zu erreichen.

Im Jahr 2025 werden moderne Windturbinen seit etwa 30 Jahren herumstehen, und wenn sie bis dahin nur 15 Prozent der Energieversorgung in den USA decken, würde das ein gewaltiger Erfolg sein. Und selbst die optimistischsten Projekte zur Sonnenkraft versprechen nicht einmal halb so viel. Die Suche nach nicht karbonhaltigen Stromquellen ist sehr wünschenswert, und vielleicht werden solche Quellen irgendwann vorherrschen. Aber dies ist nur möglich, wenn die Planer realistische Erwartungen haben. Der Vergleich mit einem gigantischen Öltanker, so unbequem er ist, passt hervorragend: Ihn zu wenden braucht sehr viel Zeit.

Und das Wenden des auf fossilen Treibstoffen basierenden Energiesystems der Welt ist eine wahrhaft herkulische Aufgabe. Dieses System braucht derzeit jährlich mehr als 7 Milliarden Tonnen Stein- und Braunkohle, etwa 4 Milliarden Tonnen Rohöl und mehr als 3 Trillionen Kubikmeter Erdgas. Dies addiert sich zu 14 Trillionen Watt Energie. Und die Infrastruktur – Kohleminen, Öl- und Gasfelder, Raffinerien, Pipelines, Züge, Lastwagen Tanker, Abfüllstationen Kraftwerke Transformer, Leitungs- und Verteilersysteme sowie hunderte Millionen Benzin, Kerosin, Diesel und Treibstoff verbrauchende Motoren – konstituiert das teuerste und extensivste Netz von Installationen, Netzwerken und Machinen, die jemals in der Welt gebaut worden sind, etwas, das Generationen dauerte und Trillionen Dollar gekostet hat.

Es ist unmöglich, dieses Supersystem in einer oder zwei Dekaden zu ersetzen – oder in fünf, je nachdem. Es mit einer ähnlich teuren und zuverlässigen Alternative zu ersetzen, die auf erneuerbarer Energie basiert, ist eine Aufgabe, die Jahrzehnte langes extensive Hingabe erfordert. Es ist die Arbeit vieler Generationen von Ingenieuren.

Vaclav Smil

Über den Autor

Vaclav Smil, ein angesehener Professor im Department für Umwelt und Geographie an der University of Manitoba, Kanada, datiert den Beginn seines Interesses an diesem Artikel auf seine Studententage an der Prager Carolinum University vor über 50 Jahren. „Im Gegensatz zur gegenwärtig populären Durchsetzung beschleunigter Innovation“, sagt er, „sind die meisten technischen Verbesserungen evolutionär und brauchen Zeit, bis sich ein wirklicher Unterschied zeigt. Folglich halte ich wenig von Behauptungen einer fast sofortigen Transformation irgendeines komplexen Systems“.

Der Originalartikel findet sich auf IEEE Spectrum hier

Übersetzt von Chris Frey EIKE

Die schweizerische Handelszeitung benennt Smil "als einflussreichen Denker der über den Wert der industriellen Forschung, den sinkenden Wohlstand im Westen, den Absturz Chinas – und Mozart" Auskunft gibt. Das Interview hier