Teil 1: Die Fallgruben der Klimawandler – Eine Dokumentation der wichtigsten Fakten für eilige Leser.

Auf der ersten UN-Umweltkonferenz in Stockholm 1972 ging es um Maßnahmen zum Schutze unserer Umwelt. Zwanzig Jahre später, 1992 in Rio de Janeiro wurde der Grundstein für die UN- Klimaverhandlungen gelegt. Es war ein Beginn und man beschloss, solche Konferenzen fortzusetzen, um Maßnahmen zum Schutze des Klimas zu verabreden, denn inzwischen stand der Klimaschutz im Vordergrund: Man glaubte eine globale Erwärmung diagnostiziert zu haben, die vor al-lem durch das Treibhausgas CO2 verursacht würde, und dass es „…um den Planeten zu retten…“ vor allem darauf ankam, die CO2-Emissionen der Industrieländer zu senken. Auf der Konferenz in Kyoto 1997 verabschiedete die Staatengemeinschaft eine Klima-Rahmenkonvention. Man hatte schon vergessen, dass wegen der Abkühlungsphase 1950-1980 in den späten 1970er Jahren noch eine neue Eiszeit befürchtet wurde.

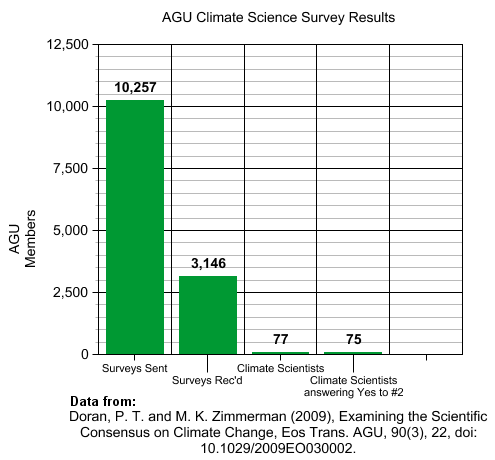

Tatsächlich wurde bis heute nie bewiesen – weil nicht beweisbar – , dass das vom Menschen direkt oder indirekt produzierte CO2 die ihm zugedachte Wirkung hat. Diese Annahme beruht nur auf Modellrechnungen für die künftige Entwicklung der Temperatur. Die Fakten beweisen das Gegenteil, und weil sie für die Propagandisten und Agitatoren des Klimawandels zu Fallgruben werden, verweigert man sich konsequent jeder Diskussion – mit Prognosen kann man schließlich keine Fakten widerlegen. Dem entspricht, dass die Diskussion in den Medien und in der Politik die Fakten ausblendet, denn viele ihrer Interessenten ziehen aus diesem Zeitgeist Nutzen, den sie nicht verlieren wollen.

Die Fakten sind inzwischen so umfangreich geworden, dass ein Vollstudium erforderlich wäre, wollte man sich damit im Detail auseinandersetzen. Um allen, die das Thema für wichtig halten, einen zusammenfassen Überblick zu verschaffen, werden in dieser Dokumentation die Fakten der wichtigsten Komplexe zusammengefasst, nämlich

· CO2 ist die Grundlage des Lebens, ist es auch klimawirksam?

· Temperaturschwankungen oder Klimawandel – was sagen Temperaturmessungen ?

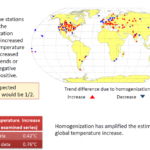

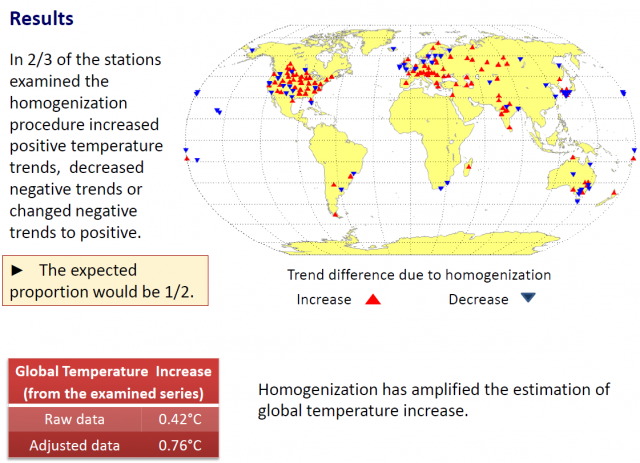

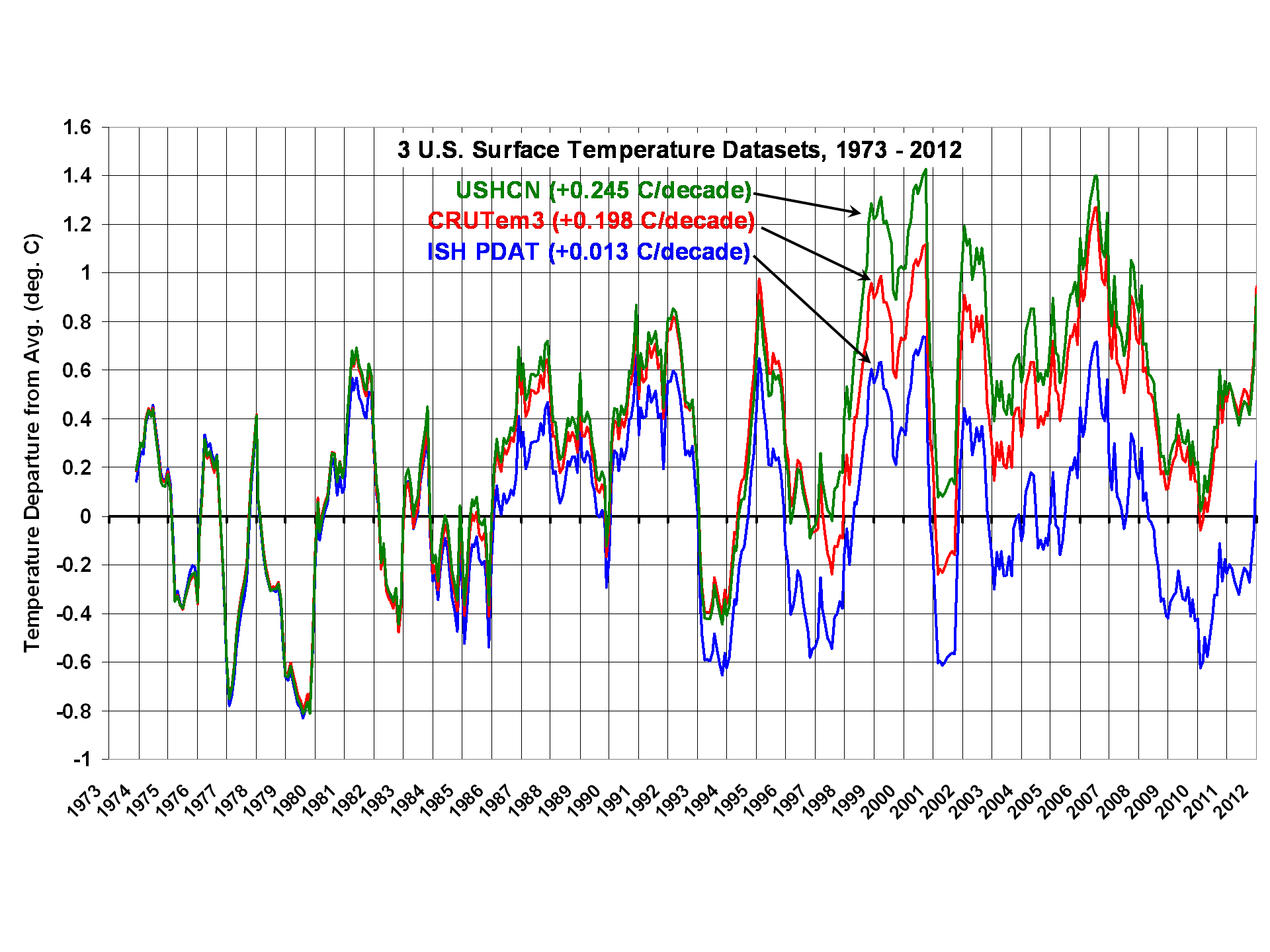

· Warum wurden Temperaturmessungen rückwirkend verändert?

· Schmilzt das Eis der Arktis ?

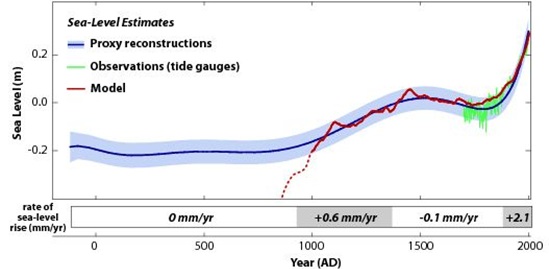

· Steigt der Meeresspiegel ?

· Schmelzen die Gletscher ?

· Gibt es mehr Hochwässer ?

· Was hat das 2°C-Ziel der Politik mit dem Klima zu tun?

Es steht außer Frage, dass wir die Umwelt schützen müssen, aber sicher ist auch, dass wir das Klima nicht beeinflussen können. Wenn man in einigen Jahrzehnten rückblickend die Bemühungen um den ‚Klimaschutz’ beurteilt, wird man erkennen, dass es um die Jahrtausendwende in der Wissenschaft, in den Medien, in der Politik und in der Gesellschaft Aktivisten gab, die glaubten, das seit 4,5 Mrd. Jahren von der Sonne gesteuerte Klima bestimmen zu können. Sie blendeten für ihre Zwecke die Kenntnisse über unsere Erde und unser Sonnensystem aus. Sie gaben für den Glauben an die Gefährlichkeit des CO2, für Klimabürokratie und Klimatourismus Aber-Milliarden aus, die für Umweltschutzmaßnahmen sehr viel nutzbringender eingesetzt worden wären. In ihrem blinden Glauben gingen sie sogar soweit, mit dem CO2 den Grundbaustein ihrer eigenen Nahrungsmittel zu verbannen. Die Menschheit hat sich schon oft verhängnisvollen Irrglauben hingegeben – dieser wird für lange Zeit unübertroffen bleiben, und wie immer wurde er von Teilen der Wissenschaft abgesegnet und von vielen Medien ungeprüft übernommen und einseitig propagiert – auf Kosten der Objektivität, denn andere Meinungen wurden totgeschwiegen oder sogar verleumdet.

(Die Quellenangaben befinden sich entweder direkt in den Abbildungen, oder mit # markiert auf der selben Seite, oder nummeriert 1) im Literaturverzeichnis am Schluss.

I

CO2 – Klimakiller?

1) Klimawirksam oder nicht ?

Goethes „Grau treuer Freund ist alle Theorie“ gilt immer noch, auch für die Frage nach der Wirkung des CO2 auf das Wetter. Die Einen beweisen mit Formeln, dass es nicht wirkt, die Anderen beweisen mit Formeln, dass es zwar wirkt, aber nur in einem so geringen Maße, dass es für das Wetter praktisch unerheblich ist. Was folgt daraus für den pragmatisch urteilenden Laien: wenn Formeln und Worte beider Seiten sich widersprechen statt Gewissheit zu verschaffen, ist der Sachverhalt nicht zu klären. Es gibt für dieses theoretische Problem aber eine praktische Lösung: man bewertet die auf der Erde gemessenen Temperaturen, schließlich findet hier das Wetter statt. Dabei stellt man fest, dass sich in den letzten 50 Jahren die Temperaturen nicht anders entwickelt haben als vor dem Beginn unserer CO2-Emissionen. Also wirkt unser zusätzliches CO2 entweder gar nicht oder nur so wenig, dass es von den Temperaturmessungen noch nicht erfasst wird.

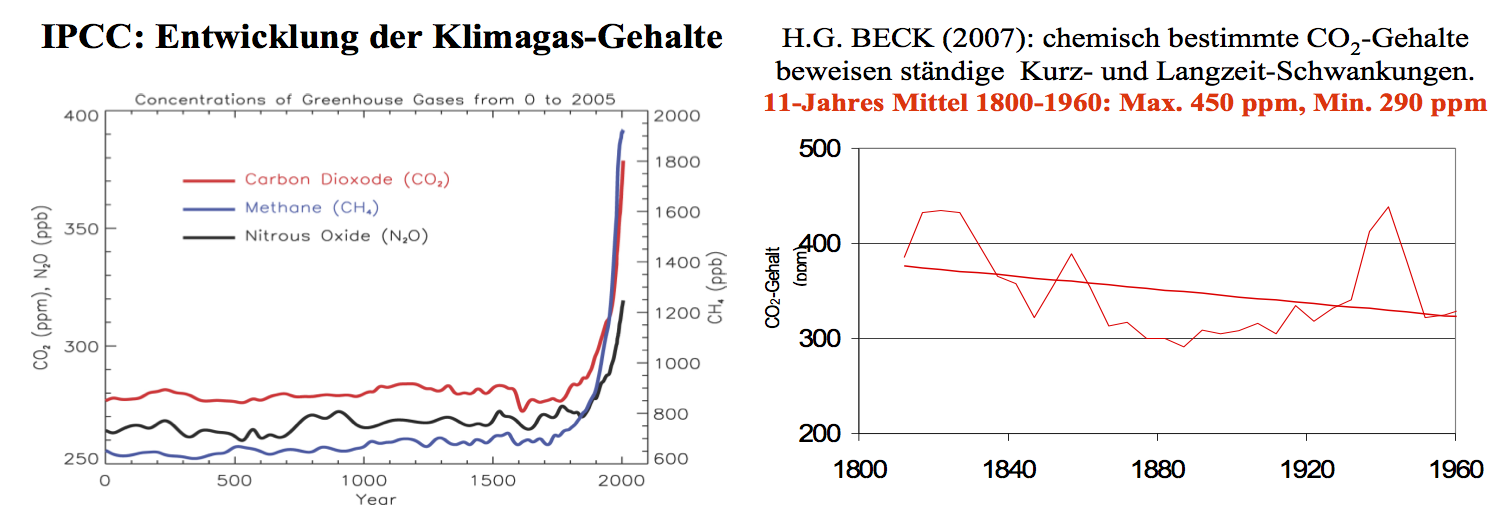

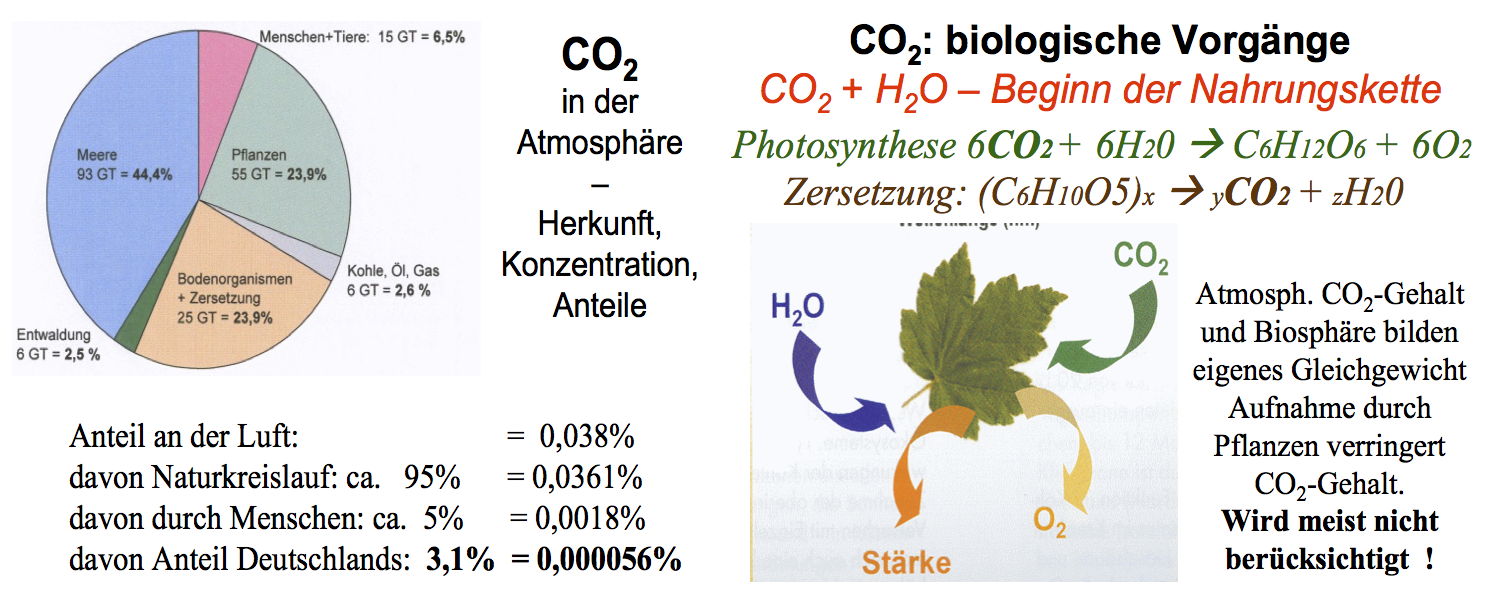

Tatsächlich geht es nur um das von uns erzeugte CO2, denn die Naturkreisläufe wirkten schon immer. Von allen beteiligten Komponenten kennen wir nur den Anteil, den wir seit etwa 1960 hinzufügen – es sind kaum 5%. Das außerdem stets neu in den Kreislauf kommende CO2 anderer Zulieferer kennen wir nicht: die Verwitterung der Gesteine setzt CO2 frei, Vulkane und Förderschlote im Meer liefern ständig unbekannte und zeitlich wechselnde CO2-Mengen, allein der Ätna entlässt täglich 35.000 t. Das CO2 der Meere, der Luft, des Bodens und der Biosphäre tauscht sich gegenseitig aus. Weder diese Kreisläufe noch die CO2-Gesamtmenge und schon gar nicht die Wirkung unseres sehr kleinen Anteiles sind bekannt, fall es sie gibt.

2. Angeblicher Verursacher des angeblichen Klimawandels ?

>> Analysen von Lufteinschlüssen im Eis zeigen:

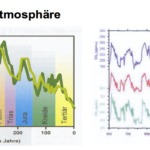

- Die sich ändernden CO2-Gehalte der Atmosphäre waren seit 600 Mill. Jahren zumeist sehr viel höher als heute, was weder der Biosphäre geschadet noch Eiszeiten verhindert hat1).

-

Auch seit 800.000 Jahren variierten die CO2– und CH4-Gehalte (blau bzw. grün) in Abhängigkeit von der Temperatur (rot)2).

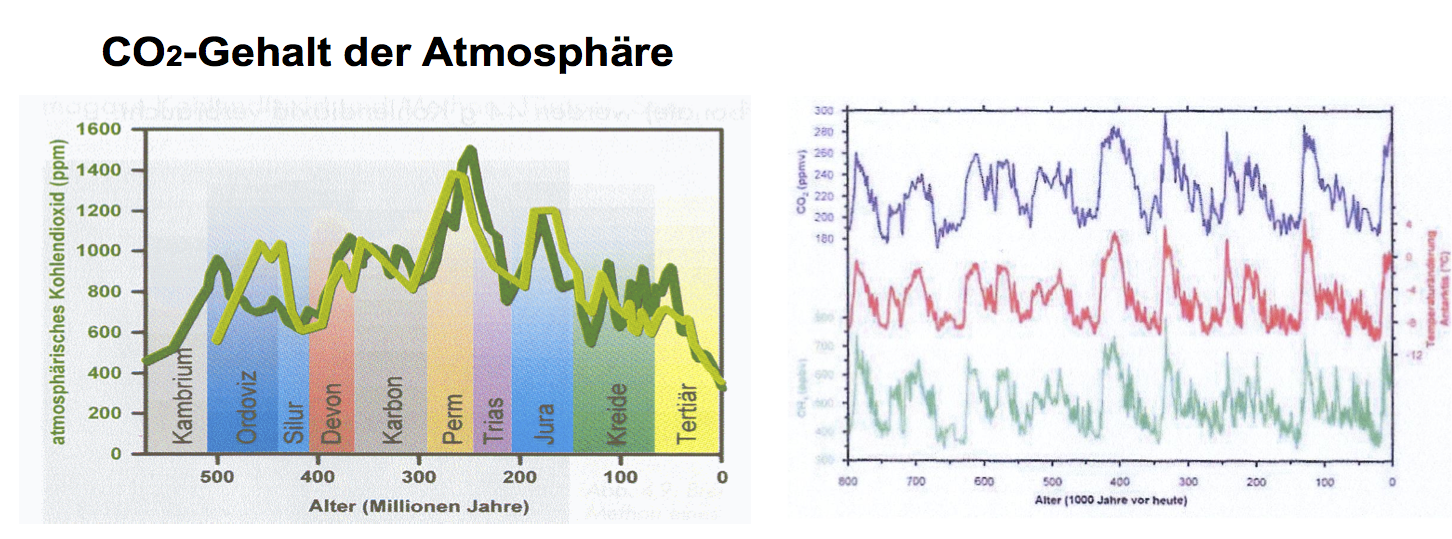

>> Das IPCC nimmt an, der CO2-Gehalt wäre seit 2000 Jahren ungefähr gleich geblieben, lässt aber die seit 1810 verfügbaren chemisch direkt bestimmten Analysenwerte unberücksichtigt. Ihre Auswertung zeigt, dass schon vor 1950 größere CO2-Gehalte gemessen wurden als heute3)

.

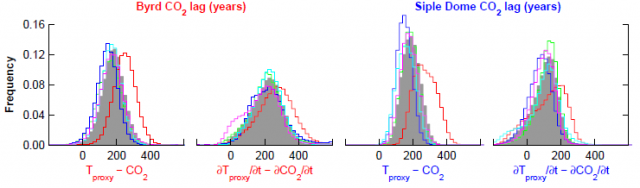

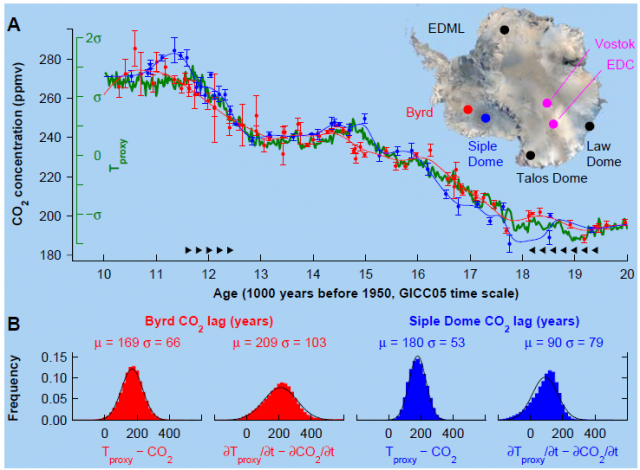

>> Die CO2-Gehalte der Meere, der Atmosphäre und der Biosphäre bilden einen Kreislauf. Wenn die Meere wärmer werden, tritt CO2 in die Atmosphäre über – und umgekehrt. Langfristig variiert CO2 mit der Temperatur, aber wegen der Trägheit der Meere ist der Übertritt stark verzögert.

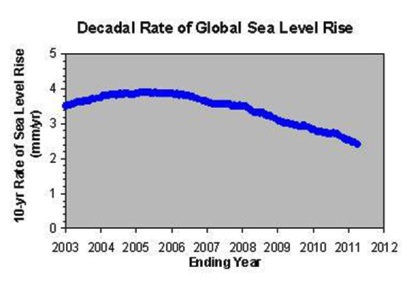

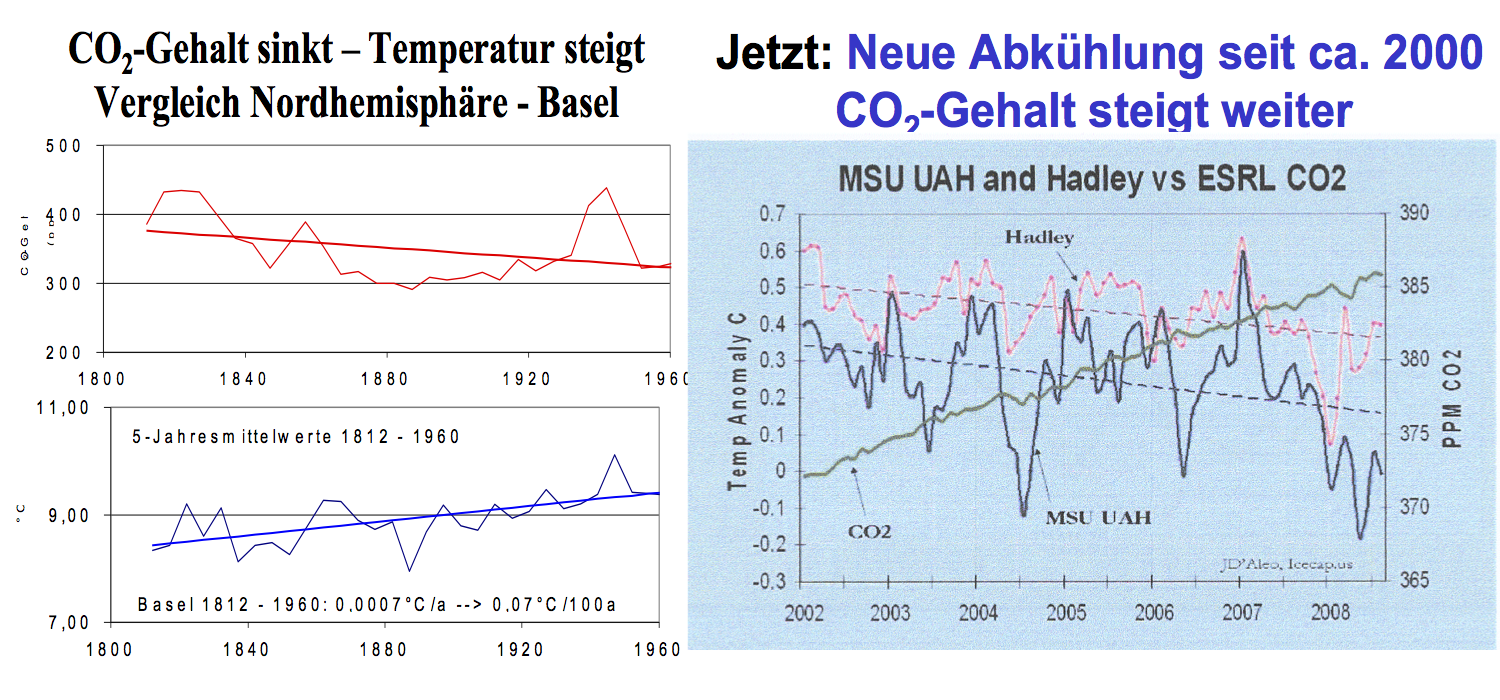

>> Durch die Verzögerung kommt es zu gegenläufigen Entwicklungen: der CO2-Gehalt sinkt noch, obwohl die Temperatur schon wieder steigt (links)3) – und umgekehrt, wie seit 1995, rechts dargestellt seit 2003. Örtliche Einflussfaktoren bewirken regional individuelle Entwicklungen

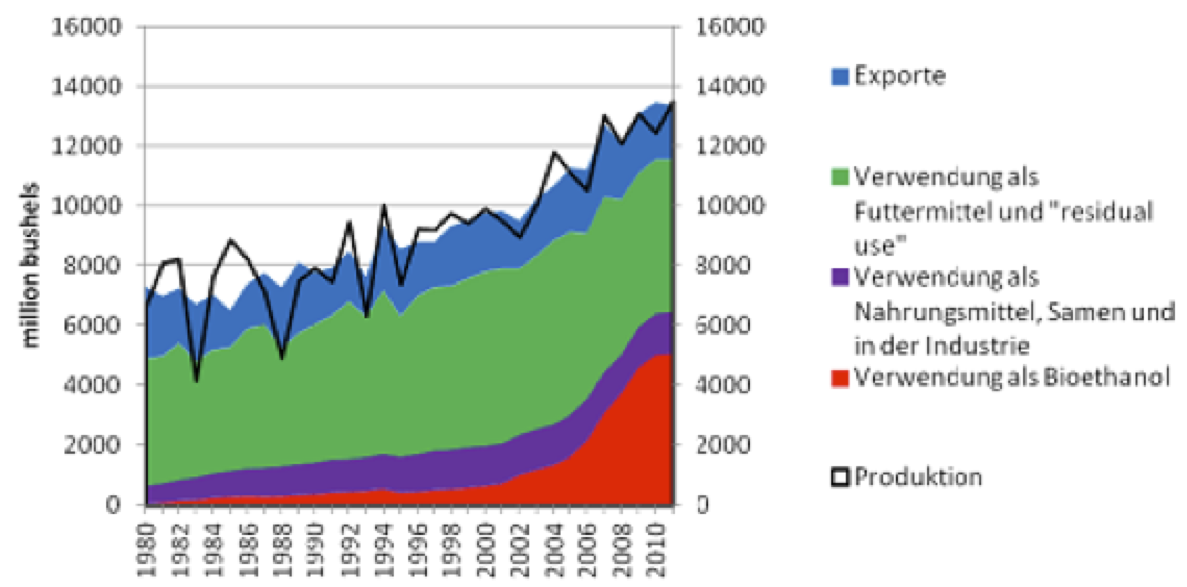

>> CO2 ist ein Spurengas; der anthropogene Anteil am Naturkreislauf beträgt kaum 5%. CO2 ist der Grundbaustein der Nahrungsmittel1) – ohne CO2 kein Leben; mehr CO2 – mehr Getreide

|

|||

|

|

|||

Unser zusätzlicher CO2–Anteil ist als Klimagas irrelevant. Aber um einem Zweck zu dienen, soll die Welt umlernen: CO2 ist schädlich! Dass es schon ohne uns mehr gab, dass es uns ernährt, wird verschwiegen !

II

Temperaturschwankungen oder Klimawandel – und warum?

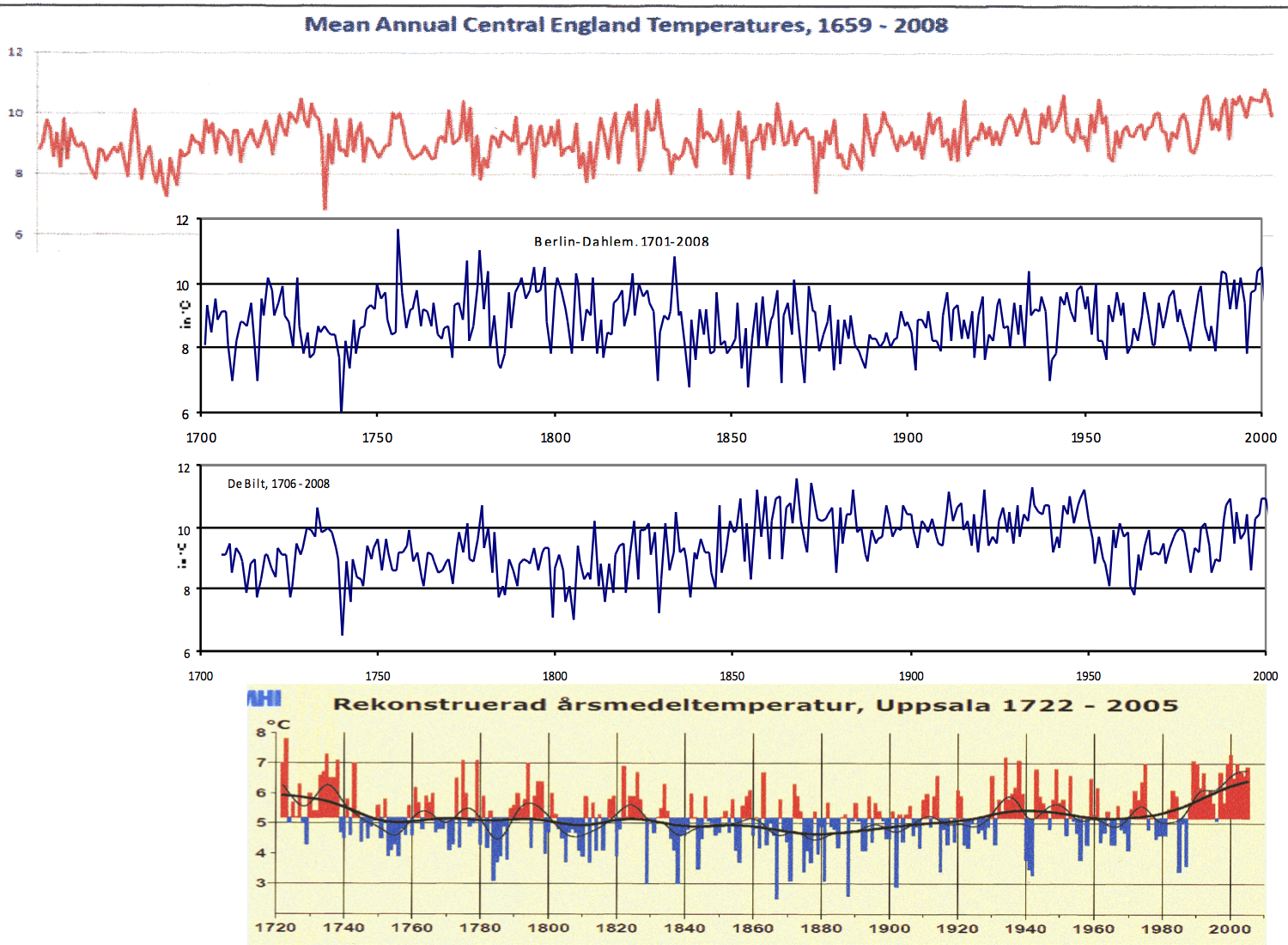

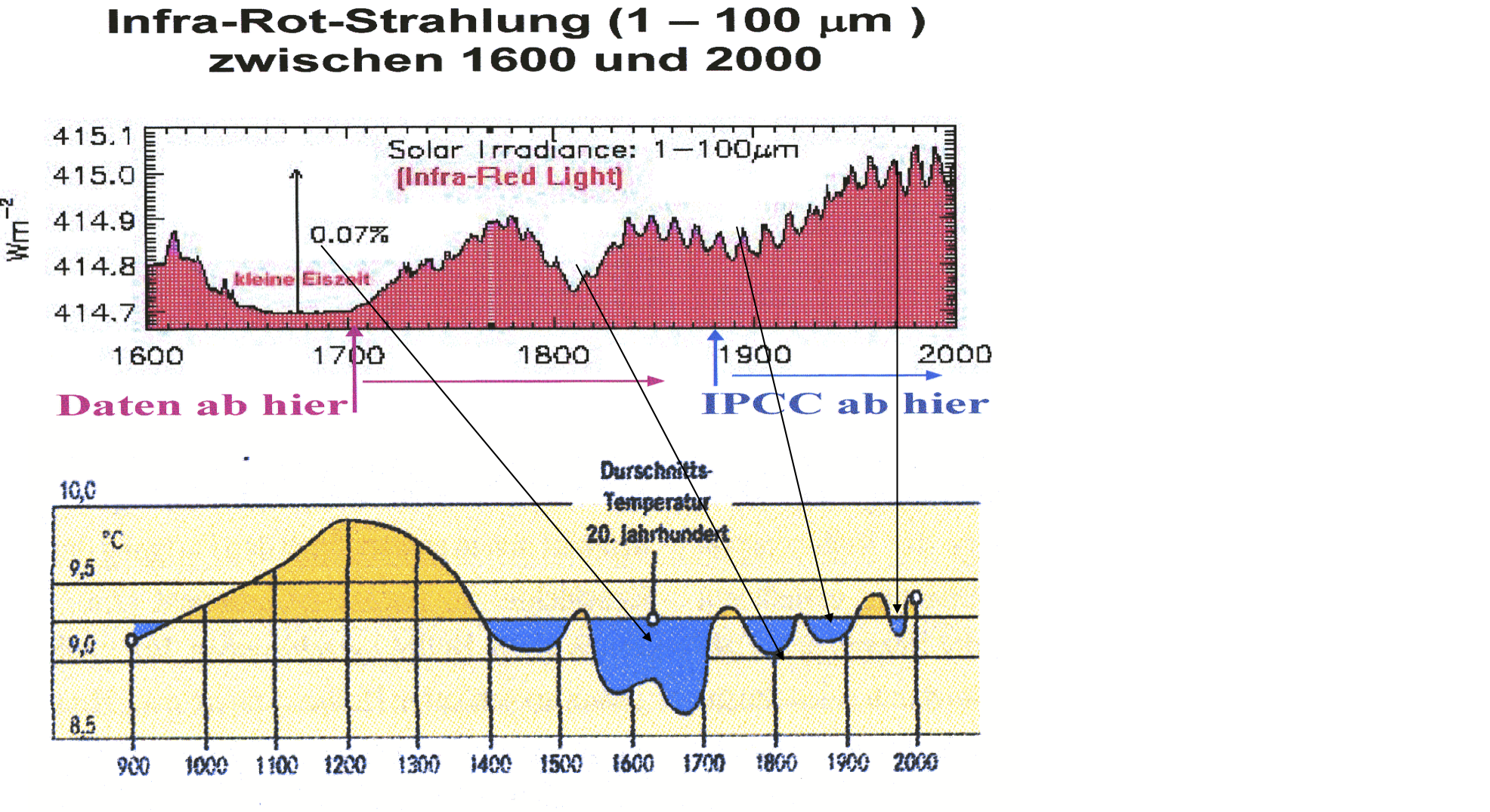

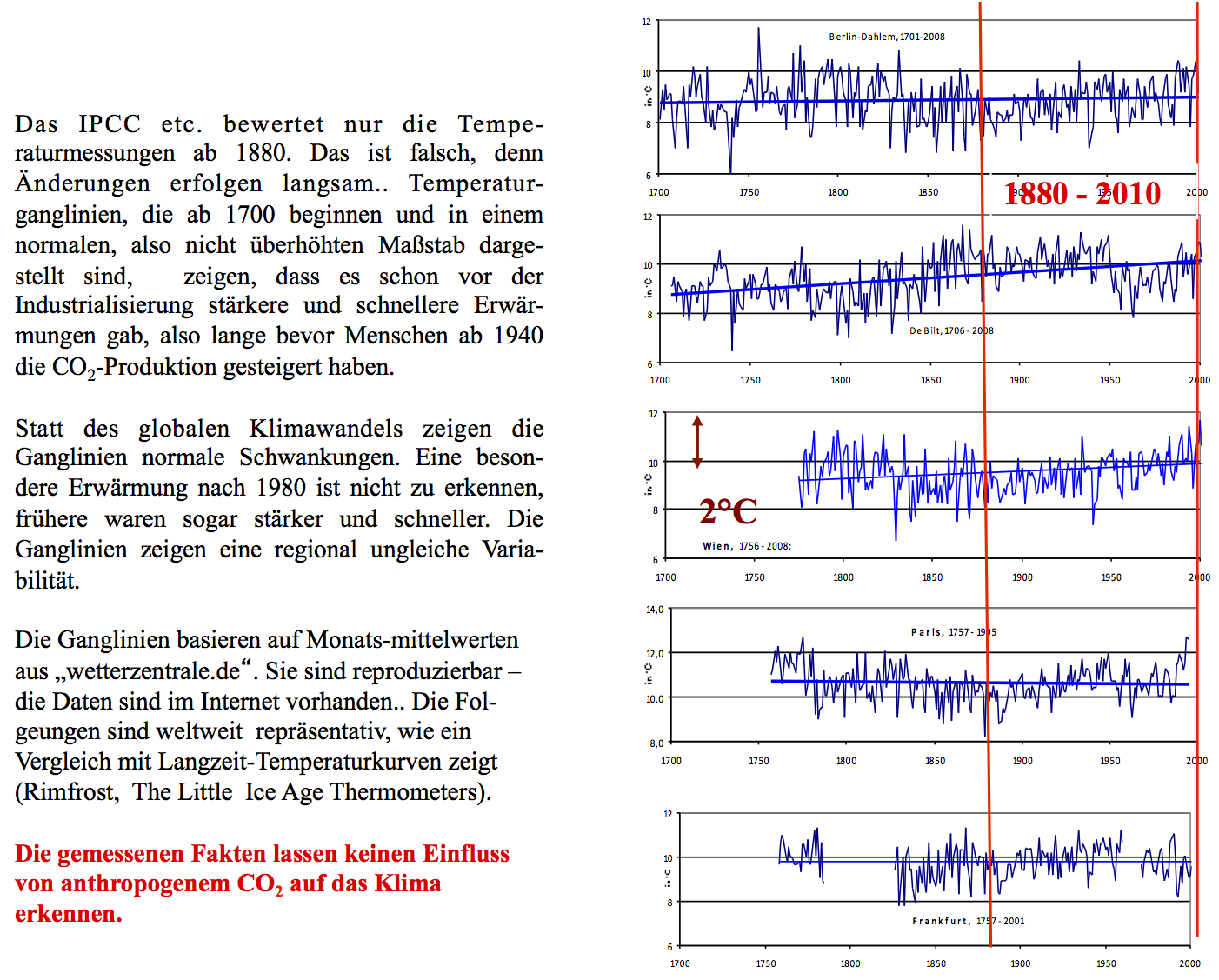

Paläoklimatologen wissen, dass sowohl Temperaturschwankungen von wenigen Zehntel Grad als auch wirkliche Klimawandel von einigen Grad in 100 Jahren normal sind. Wer Temperaturänderungen beurteilen will, muss sie mit früheren vergleichen, d.h. im Rahmen von Langzeitentwicklungen beurteilen – eine Erwärmungsphase alleine liefert noch keinen Maßstab. Die letzten 1000 Jahre waren durch das Mittelalterliche Klimaoptimum, die Kleine Eiszeit – Ackerbau in Grönland, Hunger in Europa – und eine neue Erwärmung gekennzeichnet. Diese Rückerwärmung begann nach 1700, sie wurde zwischenzeitlich von geringer werdenden Abkühlungen unterbrochen. Es ist ungewiss, ob sie schon beendet ist. Jede Analyse hat diese Entwicklung als Teil der Rückerwärmung zu begreifen, und wer den gegenwärtigen Zustand beurteilen will, darf nicht nur die Temperaturdaten der letzten 120 Jahre berücksichtigen, sondern muss auch die Langzeit-Temperaturreihen aus den vergangenen Jahrhunderten bewerten.

Langzeit-Temperaturreihen

Als ab 1654 das erste zuverlässige Thermometer verfügbar war, wurden bald regelmäßig Temperaturmessungen und Aufzeichnungen durchgeführt. Es wurde üblich, Temperaturganglinien darzustellen, die die ständigen Schwankungen und Langzeitänderungen der Temperatur anzeigen. Die älteste Ganglinie ist aus Mittelengland verfügbar, sie beginnt 1659; die zweitälteste beginnt 1701 in Berlin. Bald danach wurden andere Stationen in Betrieb genommen. Heute sind Langzeit-Temperaturreihen in mehreren Internetportalen verfügbar. Schellnhuber et alt. haben nach der Analyse von 95 Stationen weltweit festgestellt, „In der großen Mehrzahl der Stationen haben wir Anzeichen für eine globale Erwärmung der Atmosphäre nicht gesehen“.4) Der Autor hat die Daten von 82 frühen Stationen ausgewertet.5) Davon sind die drei ältesten Ganglinien in Abbildung 1 dargestellt. Sie zeigen beispielhaft, dass schon immer und auch schon vor der Industrialisierung mit seiner anthropogenen CO2-Produktion schnellere und stärkere Erwärmungen und Abkühlungen statt fanden als gegenwärtig. Der Vergleich mit den früheren Jahrhundertern lehrt, dass die Temperaturganglinien auch für das Industriezeitalter keinen nennenswerten menschen-gemachten Einfluss des CO2 auf das Klima anzeigen.

Abbildung 1:

Central England, Berlin und De Bilt, Beispiele für Langzeit-Temperaturreihen von 82 Stationen, weltweit

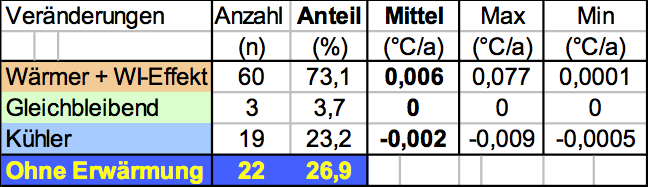

Wie die folgenden Kennwerte zeigen, sind die Änderungsraten klein. Dementsprechend hat kein wirklicher Klimawandel statt gefunden, der Änderungen von einigen Grad erfordert, sondern lediglich Temperaturschwankungen. Auch die sind nur in etwa drei Vierteln der Thermometer-Regionen erfolgt, während sich in den restlichen die Abkühlung fortgesetzt hat. Weiter ist zu bedenken, dass die Temperaturen nur auf etwa 10% der Erdoberfläche gemessen werden, denn in den Ozeanen, Wüsten, Eisflächen, Hochgebirgen, Urwäldern und Sumpfgebieten fehlen Stationen.

Kurzzeit-Temperaturreihen

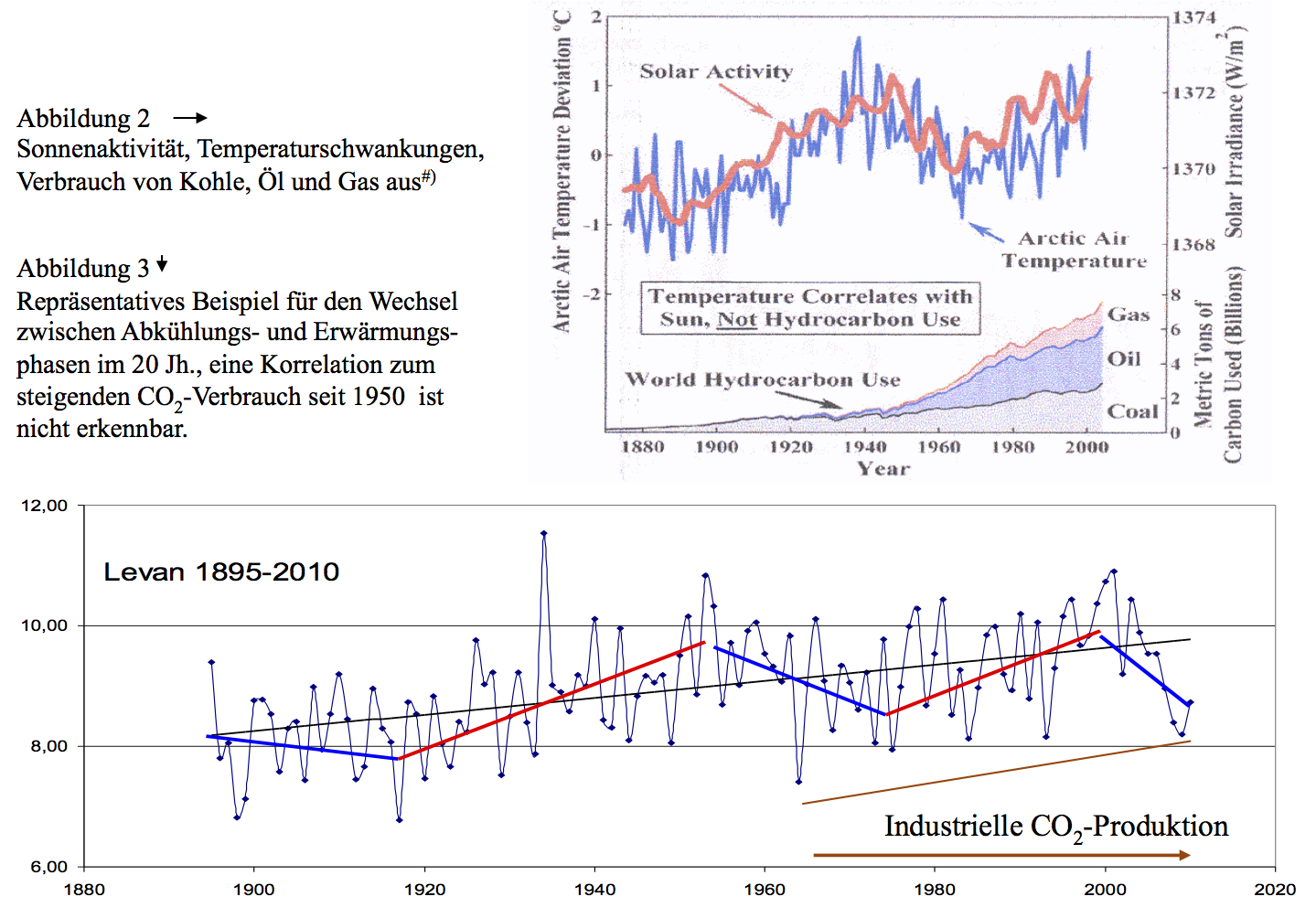

Der Datenpool der NASA enthält Kurzzeit-Temperaturreihen, die 1895 beginnen. Die Daten von 2249 Stationen wurden ausgewertet, denn sie enthalten (fast) lückenlose Datenreihen für die Intervalle 1905-1955, 1955-2005 und 1905-20056). Eine weitere Auswertung der im Jahre 2010 von NASA-GISS angebotenen Daten für den Zeitraum 1895-2010 wurde für die weltweit verfügbaren 1110 Stationen mit lückenlosen Datenreihen durchgeführt. Dabei wurden Ganglinien mit ihren Änderungsraten sowohl für die gesamte Reihe als auch für deren aufeinanderfolgenden Erwärmungs- und Abkühlungsphasen bestimmt, wie Abbildung 3 beispielhaft zeigt. Die insgesamt daraus resultierenden etwa 5500 Ganglinien werden gegenwärtig im zweiten Teil der Auswertung den geographischen Einheiten zugeordnet. Die Ergebnisse dieser Auswertung werden wie folgt zusammengefasst und sind in den Abbildungen 2 und 3 illustriert

- Die Temperatur korreliert mit der Sonnenaktivität, nicht mit der CO2-Produktion.

· Während des 20. Jahrhunderts gab es zwei Erwärmungsphasen; die wirksamste erfolgte zwischen 1920 und 1950, also vor der verstärkten anthropogenen CO2-Produktion.

- Obwohl die durch den Menschen verstärkte CO2-Emmissionen – ca. 5% des natürlichen CO2-Kreislaufes – eine Erwärmung verursacht haben sollen, fand 1950-1980 eine Abkühlung statt.

- Eine weitere Abkühlungsphase begann 1998, sie dauert noch an und wird entgegen der IPCC-Erwartung von 801 Stationen (= 72,2%) registriert.

#) Robinson A.B., Robinson N.E., and Soon W.: Environmental effects of increased atmospheric Carbon Dioxide. Journal of American Physicians and Surgeons, 12/2007, 27 Figures

III

Langzeit-Temperaturmessungen beweisen: die Sonne bestimmt das Klima

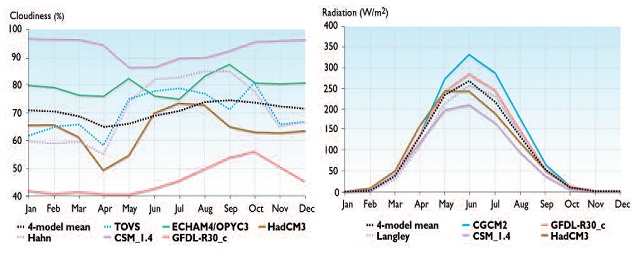

1. ) Änderungen der Sonneneinstrahlung und der Temperaturen

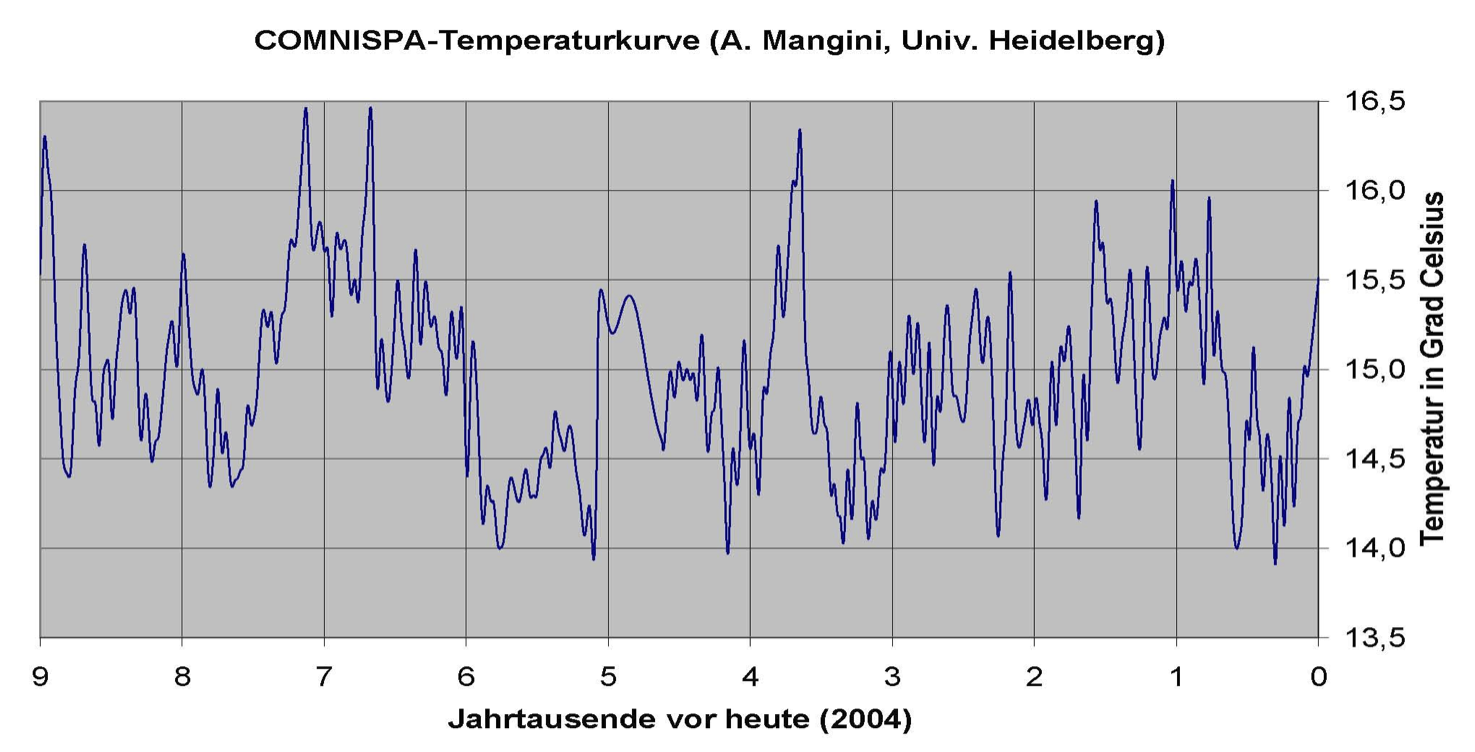

Die zweite Abbildung (Solar Irradiance von 1600 bis 2000) bezieht sich auf den ganz rechten Zeitabschnitt der darüberliegenden Comnispa Kurve (dort -0,4 bis 0)

2.) Globale Mitteltemperaturen im Vergleich zu realen Temperaturganglinien

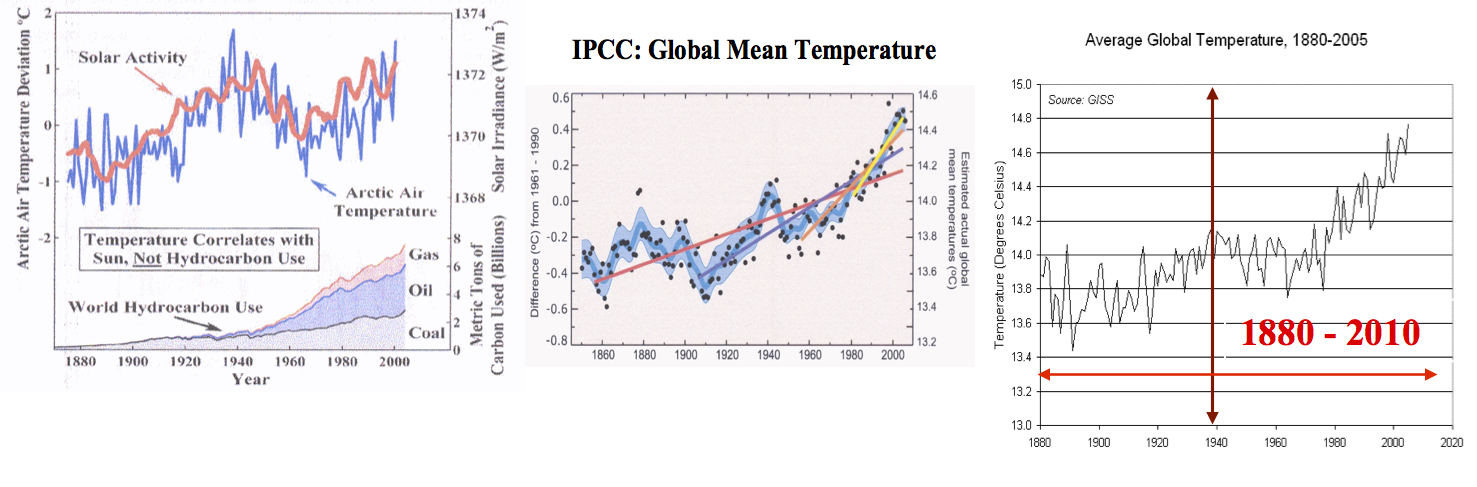

Das linke Diagramm zeigt, dass der verstärkte Verbrauch von Kohle, Öl und Gas erst nach 1940 eingesetzt hat – und damit die industrielle Produktion von CO2. Trotzdem korreliert die Temperatur mit der Sonneneinstrahlung (links). In den Berichten für Politiker zeigt der IPCC die globale Erwärmung mit einem Diagramm, das die Temperatur im überhöhten Maßstab darstellt, was den Eindruck einer dramatischen Erwärmung nach 1980 vermittelt (Mitte); GISS benutzt ein fast ähnliches (rechts). Mit dem folgenden Vergleich wird gezeigt, dass es diese dramatische Erwärmung – oder irgendeine andere besondere Entwicklung – nicht gegeben hat.

|

Ende Teil 1 wird fortgesetzt.

Sehr geehrte Kommentatoren,

es ist wohl nützlich zu wissen, warum mein Beitrag entstand: Die FDP-Fraktion des Sächsischen Landtags hat in Dresden eine Alternative Klimakonferenz veranstaltet – und zwar sehr gut organisiert, sehr gut besucht, sehr gute Vorträge und mit dem Erfolg, dass die Teilnehmer zum Schluss überzeugt sein konnten, dass weder der angebliche Klimawandel noch unsere Urheberschaft "alternativlos" sind, wie dies dogmatisch regierungsamtlich verkündet wird. Es war zu erwarten, dass auch viele Teilnehmer kommen würden, die mit dem Thema nur wenig oder überhaupt noch nicht vertraut sind – und die auch keine Zeit für ein intensives Detailstudium haben. Um ihnen den Einstieg zu erleichtern und um sie vielleicht auch neugierig zu machen, sich selbst weiter damit zu beschäftigen, wurde diese "Dokumentation der wichtigsten Fakten für eilige Leser" – wie eingangs so benannt – zusammengestellt. Wichtig war mir, dass alle Komplexe behandelt werden, wenn auch leider oft nur in zusammengefasster Form, aber doch wohl ausreichend für eine grundlegende Information. Die in Dresden ausgelegten 50 Exemplare waren schnell vergriffen.

Der Beitrag erhebt keinen Anspruch auf Vollständigkeit, das ist auf 15 Seiten nicht möglich. Es erschien auch zweckmäßig, mit fachlichen Details sparsam umzugehen, eine Überfrachtung mit Wissenschaft zu vermeiden, und sich kurz und knapp zu fassen, und darauf zu vertrauen, dass der Leser das wohl richtig interpretieren würde, und dass die Diskussion den Inhalt vervollständigt. Was ja auch geschieht, wie man schon sieht, und wofür sich der Autor jetzt schon bedanken möchte. Dieser Dank gilt vor allem auch an jene, die in mühevoller Arbeit den Beitrag mit seinen vielen Bildern hier bei EIKE in’s Netz stellen.

Es folgt noch ein zweiter Teil. Zum Schluss noch der Hinweis, dass der vollständige Beitrag als pdf-Datei kopiert werden kann; seine Verbreitung ist erwünscht, schließlich sind Klimarealisten ehrenamtlich tätige Überzeugungstäter.

Glück auf,

Friedrich-Karl Ewert

Prof.em. Dr. Friedrich-Karl Ewert EIKE

Den vollständigen Bericht können Sie hier als  pdf herunterladen

pdf herunterladen

Abbildung 1 Das folgende Diagramm (

Abbildung 1 Das folgende Diagramm ( Dateien sowie

Dateien sowie