Buchkritik

Das Buch von Langeheine titelt „Energiepolitik in Deutschland, das Geschäft mit der Angst“ und ist im AtheneMedia-Verlag erschienen. Schon beim ersten Durchblättern fällt die Handschrift des Physikers und Industriemanagers auf: knappe Schilderungen mit den hierzu erforderlichen Zahlenangaben und Wirtschaftlichkeitsberechnungen. Jeder, der einmal längere Zeit in der Industrie tätig war, erkennt hierin einen Stil wieder, dem der Zug zum Wesentlichen eigen ist. So zu schreiben hat natürlich Vor- und Nachteile. Für Leser, die es lieben, vor dem Schlafengehen noch einmal gefällig Dahinfließendes zu sich zu nehmen, um besser in den Schlummer zu fallen, werden nicht ganz so gut bedient. Langeheine fürchtet anscheinend auch nicht die bekannte Verlagsregel, dass jede Formel in einem Buch dessen Auflage um die Hälfte reduziert. Träfe diese Regel zu, stünde es schlecht um den Buchverkauf, denn an mathematischen Formeln – es kommen sogar waschechte Integrale vor – ist kein Mangel.

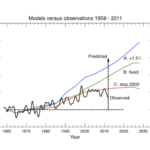

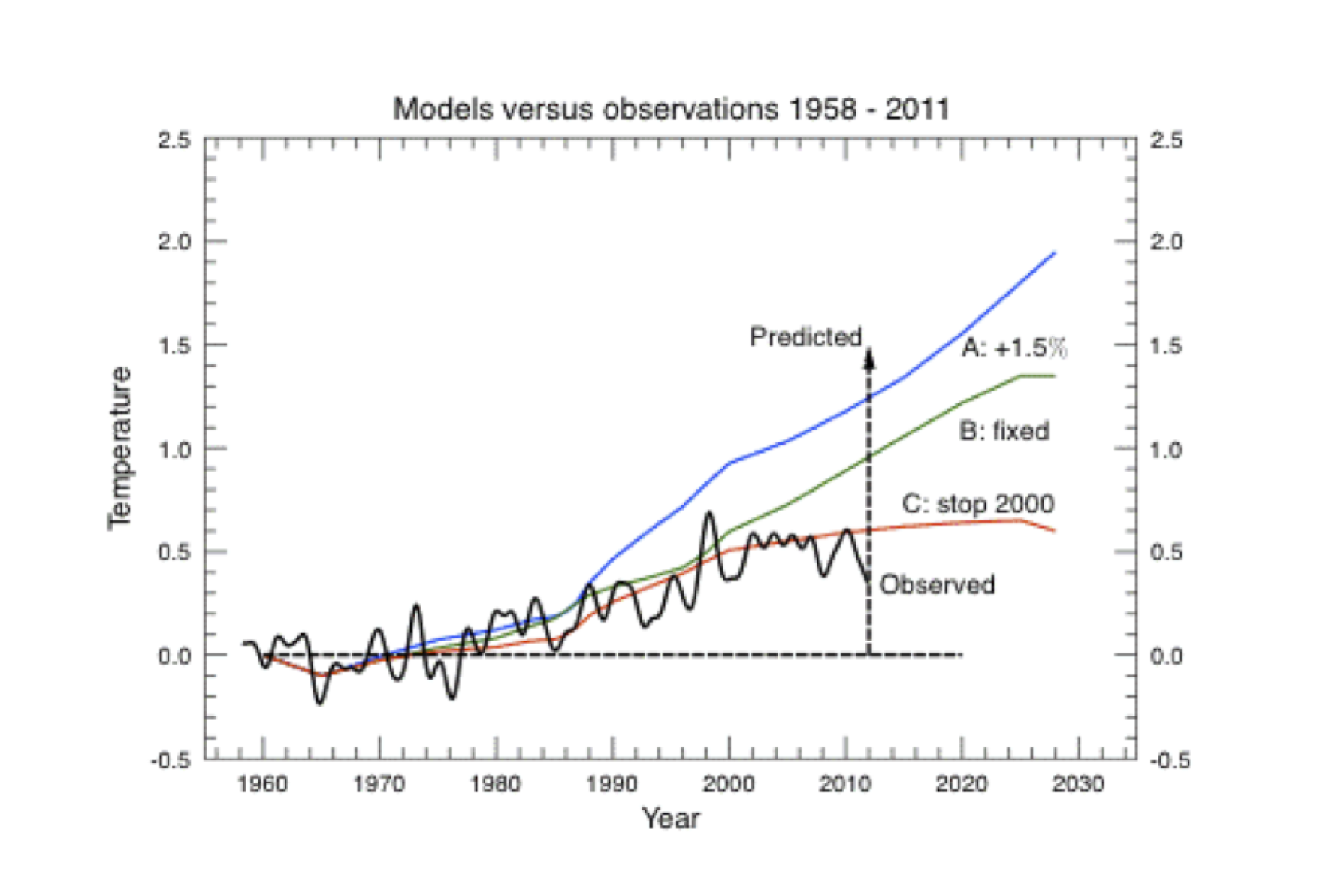

Als Gegenzug erhält der Leser dafür aber sehr viel detaillierte Einblicke und Informationen. So hat beispielsweise die Hauptsektion „Kernenergie-Chancen und Risiken“, die etwa ein Drittel des Buchs ausmacht, dem Kritiker besonders gut gefallen. Ein weiteres Drittel nimmt „Klima, Energie und Politik“ ein. Das erste Drittel „Physik der Atmosphäre“ ist zwar, für sich genommen, interessant, weicht aber ein wenig vom Thema des Buchs ab. Dies ist dann auch das einzige Kapitel, dessen Ausführungen der Kritiker nicht in allen Punkten zustimmen kann. Die Abschnittsüberschrift „Treibhausmodell ade, was nun“ wird sicher manche Kommentatoren des EIKE-Blogs erfreuen und erneut an- bzw. aufregen, die Ausführungen Langeheines entsprechen hier aber nicht dem heutigen wissenschaftlichen Stand der Atmosphärenphysik. Dieser kleine Schwachpunkt täuscht allerdings keineswegs darüber hinweg, dass Langeheines Werk als weiterer Sargnagel einer komplett verfehlten deutschen Energiepolitik brauchbar ist.

Prof. Dr. Horst-Joachim Lüecke

EIKE-Pressesprecher

Und nun die Energie-News von Dr. Langeheine

Deutschland auf dem Weg in die De-Industrialisierung

Trotz Staatsschulden von mehreren Billionen Euro wird in Deutschland der sofortige Ausstieg aus der Kernenergie ohne tragfähige Alternativen vollzogen. Es werden alte und bewährte Energieversorgungssysteme verschrottet, und es wird billigend in Kauf genommen, dass durch die zwangsläufig nötigen doppelten Installationen von Versorgungsanlagen zur Absicherung einer stabilen Stromversorgung und Subventionen für neue technisch nicht ausgereifte, teurere Versorgungssysteme die Belastung der Bevölkerung sowie die Staatsverschuldung weiter steigt. Die schon immer viel zu hohen deutschen Strompreise werden weiter steigen. Bis zum Jahr 2020 ist mit einer Verdoppelung der Stromkosten gegenüber 2004 zu rechnen. Dies wird an der deutschen Wirtschaft nicht spurlos vorüber gehen, der Verlust an Wettbewerbsfähigkeit und Arbeitsplätzen ist abzusehen. In der augenblicklich guten wirtschaftlichen Lage glaubt Deutschland, unabhängig von Entwicklungsprozessen in anderen Teilen der Erde einen ideologisch, fast religiös motivierten Alleingang in der Energiepolitik durchsetzen zu können. Mittelfristig führt dieser Prozess jedoch zu einer De-Industrialisierung des Landes mit unübersehbaren sozialen Verwerfungen.

Der weltweite Energiebedarf steigt unaufhaltsam, wie die Darstellung (s. Titelbild) der Internationalen Energie Agentur aus dem Jahr 2000 zeigt. Er lag 1990 bei 330 EJ (EJ = Exajoule, 1EJ sind 278 Milliarden kWh), stieg bis 2000 auf 417 EJ und erreicht heute einen Wert von ca. 500 EJ pro Jahr. Die jährliche Steigerungsrate beträgt ca. 10 EJ pro Jahr. 2010 stammte die verbrauchte Energie zu 85% aus fossilen Rohstoffen, ca.180 EJ aus Öl, 120 EJ aus Gas, 120 EJ aus Kohle. Ca. 10% kamen aus der Kernenergie und 5% aus sog. erneuerbaren Energien. Die USA verbrauchten im Jahr 2000 97 EJ (23%), China 49 EJ (49%) und Deutschland 14,4, EJ (3,4%) der insgesamt weltweit verbrauchten Energie von 417 EJ. Dabei nehmen die USA mit einem pro- Kopf-Verbrauch von 273 GJ/Jahr die Spitzenstellung ein, während Deutschland und Japan im Mittelfeld bei ca. 180 GJ/Jahr liegen. Bemerkenswert ist der noch relativ geringe Pro-Kopf-Verbrauch von China (38 GJ/Jahr) und Indien (< 24 GJ/Jahr). Hier sind die größten Entwicklungspotenziale für die Zukunft zu erwarten. Wenn China z. B. mittelfristig nur die Hälfte des deutschen Pro-Kopf-Verbrauchs erreicht, erhöht allein China seinen Gesamtverbrauch auf ca. 100 EJ pro Jahr. Das bedeutet eine Verdoppelung des Chinesischen Energieverbrauchs.

Aus den vom Bundesinstitut für Bevölkerungsforschung herausgegebenen Daten ist ein Wachstum der Weltbevölkerung bis 2050 von heute knapp 7 auf 9 Milliarden Menschen zu erkennen. Der größte Zuwachs erfolgt in Asien, gefolgt von Afrika und (Süd-) Amerika. Die Bevölkerung von Europa bleibt danach weitgehend konstant. Zwischen 1990 und 2010 stieg die Weltbevölkerung um ca. 2 Milliarden Menschen. Für jede zusätzliche Milliarde Menschen kann mit einem zusätzlichen Energiebedarf von ca. 100 EJ/ Jahr gerechnet werden. Eine Steigerung der Erdbevölkerung auf 9 Milliarden Menschen im Jahr 2050 bedeutet dann einen Anstieg des Weltenergiebedarfs von jetzt 500 EJ/Jahr auf 800-900 EJ/Jahr. Entsprechend dem Entwicklungstrend werden dann ca.350 EJ aus Öl, 250 EJ aus Gas, 200 EJ aus Kohle kommen.

Der deutsche Investitionsbedarf für den Ersatz von 2,5 EJ durch erneuerbare Energien (18% von 14 EJ) bis zum Jahr 2020 wird vom Bundes-Umwelt-Ministerium und Prognos-Institut auf ca. 200 Milliarden € geschätzt. Um weltweit die zusätzliche Energiemenge von ca. 400 EJ mit erneuerbaren Energien zu erzeugen, sind Investitionen in Höhe von ca. 32 Billionen € erforderlicch, eine Geldmenge, die dem weltweiten Bruttoinlandprodukt entspricht. Das sind gigantische Beträge, und es ist äußerst fragwürdig, ob dieses Geld mittelfristig in Deutschland bzw. weltweit bis zum Jahr 2050 zur Verfügung steht. Unter der Annahme, dass im Jahr 2020 Deutschland seinen gesamten Energieverbrauch nicht steigert, sinkt der deutsche Anteil am weltweiten Energieverbrauch auf 1,5%, ein unbedeutender Wert. Diese Relation allein verdeutlicht die wirtschaftliche Bedeutung der Umstellung auf alternative Energien. Vom deutschen Einfluss auf die weltweite Kohlendioxidemission, wie bedeutsam sie auch immer für das Klima sein mag, braucht man in diesem Zusammenhang nicht zu reden, er ist quasi Null. Eine Volkswirtschaft kann im globalen Wettbewerb nur bestehen, wenn sie über ausreichende und wettbewerbsfähige Energiequellen verfügt. Erneuerbare Energien können dazu mengen- und kostenmäßig keinen Beitrag leisten, wie die nachfolgenden Abschätzungen für unterschiedliche Formen grüner Energien zeigen.

Geothermie:

Der Anteil der elektrischen Stromerzeugung durch Geothermie betrug 2010 weltweit 90 Milliarden kWh. Damit wurden ca. 0,5 % (von ca. 20.000 Milliarden kWh) an elektrischer Energie durch Geothermie erzeugt. In Deutschland lag dieser Beitrag bei 0,01% (60 Millionen kWh von insgesamt ca. 700 Milliarden kWh), also noch um den Faktor 50 unter dem weltweiten Durchschnitt. Allenfalls kann die Geothermie zum Ersatz fossiler Rohstoffe bei der Heizung beitragen, sie erreichte jedoch in dieser Form 2009 in Deutschland auch nur einen Wert von 0,017 EJ oder 0,12% des gesamten deutschen Energieverbrauchs. Geothermieanlagen erfordern besonders in Deutschland hohe Investititonen. Die Kosten für das Geothermiekraftwerk Landau betrugen 21 Mio € für eine abgabefähige Leistung von 3 MW, also ca. 7000 € pro kW. Damit werden pro Jahr ca. 21.000 MWh (Megawattstunden) an elektrischer Energie produziert. Eine Hochrechnung für den Ersatz der aus Kernkraftwerken produzierten elektrischen Energie von ca. 150 TWh (Terawattstunden) führt auf eine Investitionssumme von ca. 150 Miliarden €.

Photovoltaik:

Im Bereich der Photovoltaik kostet heute ein 1 kWp – Modul (kWp = Kilowatt Peak Leistung) mit einer Fläche von 8-10 m² ca. 2000 Euro und erzeugt in Deutschland ca. 1000 kWh pro Jahr. Der Ersatz der Stromerzeugung aus Kernkraftwerken benötigt damit eine Fläche von der Größe des Saarlandes (2300 km²). Das ist ein rein rechnerischer Wert, da die Solarenergie nur ca. 1000 Stunden im Jahr zur Verfügung steht und daher für eine Grundlastversorgung nicht geeignet ist. Um eine kontinuierliche Stromversorgung sicherzustellen, sind langzeitstabile Zwischenspeicher erforderlich. Großtechnisch einsetzbare Speichermöglichkeiten, wie Pumpspeicherwerke fehlen, da in Deutschland aus topographischen Gründen nur eine Kapazität von ca. 40 Millionen kWh installiert ist, die noch dazu nur eine tägliche Nutzungsdauer von 4-8 Stunden erlaubt. Rein rechnerischer Natur ist auch die Investitionsabschätzung von 300 Milliarden € für den Ersatz der Stromerzeugung aus Kernenergie durch die Photovoltaik. Unberücksichtigt dabei ist der erforderliche Ausbau der Pumpspeicherkapazität um einen dreistelligen Faktor! Die Investitionen für die Photovoltaik summierten sich für die Jahre 2000 bis 2010 auf ca. 25 Milliarden €, die Subventionszahlungen (für ca. 27 Milliarden kWh) auf ca. 13 Milliarden Euro. Das ergibt Gestehungskosten von ca. 50Cts/kWh gegenüber 3 Cts/kWh aus konventionellen Anlagen. Dem Steuerzahler wird diese Verschwendungsorgie, die noch dazu extrem unsozial ist, langsam bewusst. Wer ein Hausdach oder eine Wiese besitzt, kann zusätzliche Einnahmen aus installierter Photovoltaik verbuchen, wer keines von beiden hat, muss zahlen. Bereits 600.000 Haushalten wurde der Strom abgeschaltet, weil sie ihre Rechnungen nicht mehr bezahlen konnten, Tendenz steigend. Photovoltaik lieferte 2010 mit ca. 0,1 EJ nur 0,02% des gesamten weltweiten Energieverbrauchs. In Deutschlande wurden 2010 8,3 Milliarden kWh Strom mit Hilfe der Solarenergie hergestellt, das sind 1,3% der gesamten Strommenge oder 0,2% des gesamten Energieverbrauchs. Photovoltaik ist bedeutungslos, zu teuer und technisch problematisch für die Energieversorgung eines Industriestandortes wie Deutschland und birgt enormen sozialen Sprengstoff.

Windenergie:

Windenergie benötigt, wie die Photovoltaik, den Verbund mit anderen Energiequellen oder zusätzliche Speicher für eine konstante Energiebereitstellung. Die Kosten einer Windkraftanlage liegen derzeit bei 900.000 € / 1MW, die Auslastung liegt in Deutschland im Mittel bei 17%, so dass diese Anlage ca. 2000 MWh pro Jahr liefert. Der Ersatz der Strommenge aus der Kernenergie durch Windkraft erfordert damit Investitionen von ca. 65 Millarden €, wieder nur rein rechnerisch, da die Kosten der Speicherwerke nicht eingerechnet wurden. Die weltweit installierte Windenergieleistung betrug 2010 194.400 MW. Bei üblicher 20%iger Auslastung produzieren diese Anlagen ca. 1,4 EJ. (0,3% des Weltenergiebedarfs). Der deutsche Beitrag (27.214 MW) entspricht 0,04% des Weltenergiebedarfs (1% des deutschen Bedarfs) oder mit ca. 40 Milliarden kWh ca. 7% der gesamten jährlichen deutschen Stromerzeugung. In Deutschland sind bereits ca. 25 Milliarden € (900.000€ / 1MW) für diese Technologie investiert worden. Die Subventionszahlung durch die Steuerzahler nach dem Erneuerbaren Energie-Gesetz (EEG) beliefen sich in den Jahren zwischen 2000 und 2010 für ca. 300 Milliarden kWh aus Windenergie auf weitere 25 Milliarden €. Das ergibt Gestehungskosten von ca. 8 Cts/kWh gegenüber 3 Cts/kWh aus konventionellen Anlagen. Für deutsche Verhältnisse ist infolgedessen auch die Windenergie unwirtschaftlich und unterliegt bezüglich der Stabilität und Verfügbarkeit den gleichen Einschränkungen wie die Photovoltaik. Nach dem Abschalten von 8 Kernkraftwerken im Jahr 2011 setzte eine Hochkonjunktur für „fossile“ Back-up-Kraftwerke ein, die ältesten Dreckschleudern wurden als Back-up-Kaltreserve wieder in Betrieb genommen, um einen zeitweise drohenden Black-Out des Netzes zu verhindern. Umweltschutz gerät in den Hintergrund. Der Ausbau der Stromtrassen von der Nordsee nach Süden und die Verstärkung der lokalen Netze für veranschlagte 60 Milliarden Euro (wenn es dabei bleibt!) wird die Notwendigkeit einer Speicherung nicht ersetzen. Auch auf See weht der Wind nicht immer gleichmäßig.

Bioenergie:

Bioenergie ist die über Verbrennung oder Vergärung aus Biomasse (Holz, Mais, Zuckerrüben, Weizen und organische Abfallstoffe, wie Jauche, Mist etc.) gewonnene Energie und wird durch ihren Kohlenstoffgehalt charakterisiert. Die Verfügbarkeit einer Biogasanlage liegt bei 90%, die Investitionskosten für eine 500 kW Anlage betragen ca. 2 Millonen €. Der Ersatz der Strommenge aus der Kernenergie durch Bioenergie erfordert Investitionen von ca. 80 Millarden € und ist damit die kostengünstigste Alternative, da die Zusatzkosten für Speicherwerke entfallen. 2009 wurden in Deutschland 0,87 EJ über Biomasse und Biotreibstoffe erzeugt, das sind ca. 6% des deutschen Primärenergieverbrauchs. Bezüglich der verfügbaren Anbaufläche in Deutschland stößt die Bioenergieerzeugung jedoch an Grenzen. Bei Nutzung der gesamten deutschen Agrarfläche von 17 Mio. ha und einem Nettoenergieertrag von ca. 20 MWh/ha, könnten 1,2 EJ aus der Bioenergie erzeugt werden, das sind 8,3% des deutschen Gesamtenergieverbrauchs. Bioenergie kann aus diesem Grunde zur Versorgungssicherheit nur marginal beitragen, sie steht immer in Konkurrenz zur Nahrungsmittelerzeugung und ist damit ethisch äußerst problematisch. Der Ertrag pro ha für Getreide beträgt in Europa ca. 5000 kg mit einem Energieinhalt von ca. 21.000 kWh. Damit können ca. 25 Menschen ein Jahr lang vom Ertrag eines ha leben (Nahrungsbedarf des Menschen ca. 850 kWh/Jahr). Aus ca. 5000 kg Getreide können 635 l Bioethanol hergestellt werden, mit einem Energieinhalt von 4000 kWh. (6,3 kWh/l). Dies ist eine riesige Verschwendung, da nur ca. 20% des ursprünglichen Energieinhalts weiter einsetzbar sind.

Eine Tankfüllung von 70 l E 10 (7 l Ethanol) verbraucht damit die Nahrungsmittel eines Menschen für 1 Monat. Grüne Energiepolitik bedeutet im Endeffekt: Kein Brot für die Welt, aber Getreide für Sprit.

Zusammenfassend hat der deutsche Verbraucher im Zeitraum zwischen 2000 und 2010 für 450 Milliarden kWh (7% der gesamten Strommenge) 56 Milliarden € an zusätzlichen Vergütungen gezahlt. Das ergibt Gestehungskosten von ca. 12 Cts/kWh gegenüber 3 Cts/kWh aus konventionellen Anlagen. Entscheidend beeinflusst durch die Zusatzkosten des EEG sind die Strompreise für Kleinabnehmer auf 25,5 Cts/kWh gestiegen. 22,8% des Strompreises mit 5,57 Cts/kWh werden für die Netznutzung, 44,2% des Strompreises mit 11,23 Cts/kWh für Steuern und Abgaben und 33% werden für die Stromkosten und Marge der Stromerzeuger mit 8,4 Cts/kWh berechnet. Dabei sind in den 8,4 Cts/kWh Stromkosten und Marge, die in die Kalkulation eingehen, bereits 3,5 Ct/kWh allein auf das EEG zurückzuführen. Heute betragen die Steuern und Abgaben innerhalb des Strompreises damit bereits 135% der Stromkosten und führen zu Steuereinnahmen von privaten Verbrauchern (ca. 30%) von 20 Milliarden € pro Jahr. Die Bundesnetzagentur rechnet mit einer Steigerung der Netzkosten um ca. 1,5 Cts/kWh, einer Verteuerung der Stromkosten durch die erneuerbaren Energien um ca. 4 Cts/kWh in den nächsten 5 Jahren. Bleibt der Staat bei seinen 44,2% Steuern (wir erleben das ja z.Zt. bei den Kraftstoffpreisen), landet der Strompreis bei 35 Cts/kWh, und die Steuereinnahmen steigen auf ca. 30 Milliarden €.

Die Energieumstellung ist ein politisch motiviertes, nicht bis zu Ende geplantes Programm und vorerst ein gutes Geschäft für Spekulanten, Banken und mehr noch, eine hervorragende Möglichkeit, marode Staatshaushalte durch Umwelt- und andere Steuereinnahmen aufzubessern. Bluten müssen der einfache Verbraucher und die mittelständigen Betriebe. Großverbraucher können heute noch Reduktionen der EEG- Belastung beantragen. Ob diese Lastenverteilung noch lange aufrechterhalten werden kann, ist fraglich. Doch eines ist sicher: Weder Geothermie noch Photovoltaik, Windenergie oder Bioenergie können den weltweiten Energiebedarf zu vertretbaren Kosten- und Sozialbedingen decken und werden ohne massive Subvention nur in geographisch ausgefallenen Gebieten ihre Einsatzberechtigung haben. Für Industrienationen wie Deutschland führen sie zur immensen Verteuerung des wichtigsten Rohstoffes, der Energie.

Derzeit meldet die Ökobranche ca. 370.000 Mitarbeiter, davon sind in der Photovoltaik ca. 110.000 und der Windenergie ca. 100.000 Mitarbeiter beschäftigt, mit einem Umsatz von ca. 40 Milliarden Euro pro Jahr. Das sieht auf den ersten Blick wie eine Erfolgsgeschichte aus. Übersehen wird dabei, die Anzahl der Entlassenen und nicht neu Eingestellten sowie die Umsatzverluste dagegen zu rechnen, die in energieintensiven Betrieben weggefallen sind. Die augenblicklich gute gesamtwirtschaftliche Lage in Deutschland überspielt diese Probleme. Die 370.000 Mitarbeiter schaffen demnach einen Umsatz von ca. 100.000 € pro Jahr, eine wahrhaft magere Zahl im Vergleich zu anderen Bereichen der Wirtschaft, in denen das Doppelte dieses Wertes das untere Limit für die Existenz der Firma bedeutet. Spanische Untersuchungen zeigen, dass ein Arbeitsplatz im Erneuerbaren Energie Bereich 2,2 Arbeitsplätze im Privatsektor der Wirtschaft kostet. Nach diesen Untersuchungen hat Deutschland durch die massive Förderung der erneuerbaren Energien bereits 750.000 Arbeitsplätze in anderen Bereichen der Wirtschaft vernichtet. Der langfristig wirksame volkswirtschaftliche Schaden ist kaum zu beziffern. Ganz im Gegenteil zur weitverbreiteten Ansicht, ist die Ökoindustrie keineswegs ein Job-Motor sondern genau das Gegenteil.

Mittlerweile sind 8 weitestgehend kohlendioxidfreie Kernkraftwerke abgeschaltet und der ausfallende Strom wird durch Inbetriebnahme alter Kohle- und Gaskraftwerke, wie durch Importe von ausländischen Kernkraftwerken ersetzt. Statt die aus Gründen der Ressourcenschonung und aus Umweltschutzgründen sinnvolle Reduktion der Energieerzeugung aus fossilen Rohstoffen zu betreiben, werden Ersatzverfahren wie die Photovoltaik oder die Windenergie gewählt, die eine kontinuierliche Begleitung durch konventionelle Anlagen benötigen. Leider wurden diese technischen Randbedingungen der Energiewende von der Ethik-Kommission nicht berücksichtigt, und so kämpft die Bundes-Netzagentur, da wirksame Speichermöglichkeiten für elektrische Energie fehlen, unter Einsatz umweltverschmutzender Kohlendioxidschleudern um die Netzstabilität in Deutschland. Um bei fehlender Speichermöglichkeit die schwankende Leistungseinbringung erneuerbarer Energien auszugleichen, sind für einen Industriestandort wie Deutschland im Hintergrund laufende konventionelle Kraftwerke mit praktisch der gleichen Leistung nötig. Die wildesten Strategien bezüglich Stromspeicher treiben ihr Unwesen und fressen beachtliche Steuergelder, die für Batterieentwicklung, Wasserstoff-Methan-Erzeugung, Pumpspeicherwerke in aufgelassenen Bergwerken und ähnliche Übungen ausgegeben werden. Es sind Verfahren, die vielleicht im Kleinen funktionieren, in der benötigten Größenordnung jedoch nicht einsetzbar sind.

Ob nun zusätzliche Gaskraftwerke oder Pumpspeicherwerke zum Zuge kommen, die Pufferwirkung der stillgelegten Kernkraftwerke muss ersetzt werden. Doppelte Investitionen in die Stromerzeugung sind die Folgen der deutschen Energiewende in der heute aktuellen Festlegung. Damit werden sich die heute schon hohen Stromkosten in Deutschland auch ohne die Subventionen des Erneuerbaren Energie Gesetzes in Richtung Verdoppelung bewegen. Die kürzlich vorgestellte Studie des Karlsruher Instituts für Technologie (KIT) bestätigt diese Annahme. Entsprechende Folgen für den Industriestandort Deutschland sind abzusehen: Trotz wesentlicher Vergünstigungen energieintensiver Unternehmen bei den steigenden Stromkosten, die langfristig bei der gesamten Bevölkerung sicher nicht auf Verständnis stoßen werden, werden sich diese Unternehmen aus Deutschland verabschieden.

Die Energiewende beinhaltet sozialen Sprengstoff, da die Kostensteigerungen vor allem die sogenannten „kleinen Leute“ treffen werden. Angesichts schwindelerregender Schulden und einer globalen Wirtschaftskrise, ist es leichtsinnig und unverantwortlich, wie mit dem Wirtschaftsfaktor Energie in Deutschland umgegangen wird. Da sich Deutschland durch den Ausstieg aus der Kernenergie isoliert, ist es nur eine Frage der Zeit, wann unser Einfluss auf die europäische Energiepolitik verschwindet. Das Argument, erneuerbare Energien könnten sich zu einem maßgeblichen Wirtschaftsfaktor für Deutschland entwickeln und mittelfristig den Exportanteil der Automobilindustrie ersetzen, kehrt sich langsam ins Gegenteil um, wie die poltischen Aktivitäten in Zusammenhang mit der Solarenergie andeuten. Die Zäune um die Schutzzonen müssen erhöht werden, um die fernöstliche Konkurrenz abzuwehren. Quer durch alle Parteien werden diese Aspekte heruntergespielt. Die Wende zu den erneuerbaren Energien hat ihren Preis, und es wird an der Zeit, dass darüber ehrlich berichtet und diskutiert wird. In die gleiche Richtung geht die Frage nach den gesellschaftspolitischen Auswirkungen der Energiewende. Ohne Einschränkung der Mitwirkungsrechte der Bürger wird diese nicht zu erreichen sein. Bürgerbeteiligungen, wie von allen Parteien gefordert und die schnelle Energiewende passen nicht zusammen.

Naturwissenschaftliche und technisch-wirtschaftliche Grundgesetze lassen sich nicht manipulieren, und so sind Umweltschutz/Klimaschutz und Energiewende nach den Vorgaben der Bundesregierung unvereinbar. Trotz Staatsschulden in Billionenhöhe wird der sofortige Ausstieg aus der Kernenergie ohne tragfähige Alternativen vollzogen. Geschickt wird der Tod von 20.000 Japanern durch die Tsunamiwelle in den Hintergrund gedrängt. Eine einseitige Berichterstattung mit nicht zu übertreffenden Schreckensbildern eines zerstörten Kernreaktors dient dazu, den Menschen in Deutschland zu suggerieren, dass eine solche Katastrophe auch bei uns passieren kann und der Ausstieg nach dem Motto "Rette sich wer kann" sofort erfolgen muss. Selbstverständlich birgt die Kernenergie Gefahren, die sich bei unüberlegtem Umgang mit dieser Technik verheerend auswirken können. Der Bau einer Kernkraftanlage mit Notstromversorgung auf Meeresniveau an der Küste eines Erdbeben- und Tsunami-gefährdeten Landes, wie es Japan nun einmal ist, ist in Deutschland undenkbar und war ein extrem leichtsinniger Umgang mit dieser Technik. Gerade Deutschland könnte mit seiner hervorragenden technischen Überwachungs-Organisation ein Vorbild für sichere Kernenergieversorgung liefern. Aber es wird entschieden, alte und bewährte Energieversorgungssysteme zu verschrotten, und es wird billigend in Kauf genommen, dass durch die zwangsläufig nötigen Subventionen für neue technisch nicht ausgereifte und teurere Versorgungssysteme die Staatsverschuldung weiter steigt.

Da geringe Energiekosten einer der ausschlaggebenden Faktoren für eine langfristig erfolgreiche Wirtschaft sind, begibt sich Deutschland durch diese Entscheidung auf den Weg in die De-Industrialisierung mit allen damit verbundenen gesellschaftspolitischen Folgen. Betrachtet man unter diesen Gesichtspunkten die deutsche Energiepolitik, so kommt man zu dem Ergebnis, dass es unverantwortlich war, den schnellen Ausstieg aus der Kernenergie zu beschließen. In einigen Jahren wird man diese aus Angsteinflößung, Populismus, Wahltaktik und Geschäftemacherei geborene Entscheidung als Denkmal kollektiver Dummheit wahrnehmen.

Dr. Jürgen Langeheine für EIKE

Empfehlung der Redaktion:

Lesen Sie zum Thema Kernenergie auch das sachlich unaufgeregte Büchlein "Kernenergie – Gefahr oder Nutzen" von Dr. Helmut Böttcher erschienen in der Reihe Imhof – Zeitgeschichte im Michael Imhof Verlag. ISBN 978-3-86568-703-6

Vortrag dem Modell der „heizenden Treibhausgase“ des IPCC sein Gegenmodell der „kühlenden“ Treibhausgase gegenüber. Er untermauert diese Ansicht durch einen umfassenden Vergleich der realen Materie der Erde (Wasser, Wolken & Gestein & Pflanzen) gegenüber den idealisierten Vorstellungen der Treibhaustheorie mit einer Erde als schwarzem Körper. Bei keiner dieser genannten Elemente kann die grundlegende Stefan-Boltzmann Näherungsgleichung der Temperaturbestimmung als Folge von Strahlungseinwirkung im Strahlungsgleichgewicht plausibel oder gar stimmig angewendet werden. Deswegen müssen die damit erzielten Resultate falsch sein. Hingegen haben die Hauptbestandteile der Atmosphäre, (zusammen rd. 99%) nämlich Stickstoff und Sauerstoff keinerlei Absorptionslinien im Spektralbereich des sichtbaren und unsichtbaren Sonnenlichtes, können also die per Konvektion aufgenommene Wärmeenergie nicht als Strahlung wieder abführen. Ohne die wichtigsten Treibhausgase Wasserdampf und CO2 z.B. würde sich demnach die Atmosphäre stetig aufheizen. Da sie das nicht tut, sorgen die vorhandenen Treibhausgase mit ihrer Absorptions- und Emissionsfähigkeit für die notwendige Abkühlung.

Vortrag dem Modell der „heizenden Treibhausgase“ des IPCC sein Gegenmodell der „kühlenden“ Treibhausgase gegenüber. Er untermauert diese Ansicht durch einen umfassenden Vergleich der realen Materie der Erde (Wasser, Wolken & Gestein & Pflanzen) gegenüber den idealisierten Vorstellungen der Treibhaustheorie mit einer Erde als schwarzem Körper. Bei keiner dieser genannten Elemente kann die grundlegende Stefan-Boltzmann Näherungsgleichung der Temperaturbestimmung als Folge von Strahlungseinwirkung im Strahlungsgleichgewicht plausibel oder gar stimmig angewendet werden. Deswegen müssen die damit erzielten Resultate falsch sein. Hingegen haben die Hauptbestandteile der Atmosphäre, (zusammen rd. 99%) nämlich Stickstoff und Sauerstoff keinerlei Absorptionslinien im Spektralbereich des sichtbaren und unsichtbaren Sonnenlichtes, können also die per Konvektion aufgenommene Wärmeenergie nicht als Strahlung wieder abführen. Ohne die wichtigsten Treibhausgase Wasserdampf und CO2 z.B. würde sich demnach die Atmosphäre stetig aufheizen. Da sie das nicht tut, sorgen die vorhandenen Treibhausgase mit ihrer Absorptions- und Emissionsfähigkeit für die notwendige Abkühlung.