Doch damit nicht genug. Die ungebremste Vorrangeinspeisung dieses Strom schlechter Qualität bewirkt, dass dringend benötige Gas-Pufferkraftwerke, wenn sie denn gebaut werden könnten, sich nicht mehr rechnen. Und, wenn sie denn mal stehen sollten, dann hängen sie ohne Gasanschluss herum, weil die Pipelines fehlen, die aber genauso wenig gebaut werden würden, weil auch sie sich nicht rechnen. Ebenso wie die vielen 100.000 km Hoch- Mittel-und Niederspannungsnetze, die aufgrund dieser ideologisch vorangetriebenen, zerstörerischen Planung, erforderlich würden, um den untauglichen Strom zu den Verbrauchern zu transportieren. Wir berichteten u.a. hier darüber. Hinzu kommt, wie die WiWo genüsslich berichtet, dass Windparks geplant und gebaut werden sollen, "die kein Schwein finanzieren kann", weil die Regierung bei der Verschärfung der Bankenregeln, die Umlenkung kurzfristiger Kredite in langfristige Darlehen kräftig erschwert hat.

Das Wort von der Stromsperre, oder Blackout, jahrzehntelang aus unserem Wortschatz verschwunden, gehört inzwischen zum Standardvokabular, nicht nur der Wirtschafts- und sonstigen Fachjournalisten, sondern auch stramm linker Mainstream- Medien im Fernsehen (ARD Panorama- eine kluge Besprechung hier) oder der Presse.

Dr.–Ing. Günter Keil hat die gefährliche Entwicklung, ihre Ursachen und ihre Folgen in diesem Bericht eingehend analysiert. Seine Bewertung: Die Regierung zappelt jetzt in den selbst gelegten Fallstricken. Die durch ihre Fehler verursachten Probleme werden noch durch neue und stets planwirtschaftliche Fehlentscheidungen zu verzögern versucht, was nur neue Schäden hervorruft und immer das gleiche Resultat ergibt: Die Risiken steigen weiter und die Stromverbraucher müssen es bezahlen.

Die Liste der Fehler wird immer länger:

Man hat die Stromerzeugung zu Lasten der Wärmeerzeugung bevorzugt, dabei auch noch auf unbrauchbare Techniken gesetzt; man hat übersehen, dass die Stromnetze den neuen unnötigen Anforderungen nicht gewachsen sind und Blackouts drohen; man hat erst vor Kurzem begriffen, dass von Anfang an riesige, teure Stromspeicher erforderlich waren, die es aber nicht gibt und auch nicht geben kann. Man hat zu spät begriffen, dass nun – unter Opferung hehrer Klimaschutz-Ziele – viele neue Kohle- und Gaskraftwerke gebaut werden müssten und merkt jetzt, dass auch das durch die Folgen der gesetzlichen Bevorzugung grünen Stroms nicht funktioniert. Man hat den Widerstand der Bürger unterschätzt. Und man hat den dramatischen Kurswechsel von 2011 ohne jede Vorwarnung und Konsultation der stark betroffenen und geschädigten Nachbarländer exekutiert – eine Rücksichtslosigkeit, die sich rächen wird.

Die Regierung war schon lange von allen renommierten Fachleuten und Institutionen vorgewarnt. Kein einziges der heute immer größer werdenden Probleme war unvorhersehbar. Die Frage ist jetzt, wie groß der angerichtete Schaden erst werden muss, wann die Energiewende-Heuchelei aufhört und wie viele Industriebetriebe erst das Land verlassen müssen, bis eine Regierung die Notbremse zieht. Wir können hier nur einige Auszüge bringen und verweisen auf den vollständigen Beitrag im Anhang (als pdf herunterladbar)

Die Energiewende ist schon gescheitert

von Günter Keil

(erweiterte Fassung April 2012)

Man stelle sich vor, dass einem TV-Sender ein Drehbuch über ein politisches Thema angeboten wird, dessen Inhalt sich in Kurzform etwa wie folgt liest:

„In Japan ereignet sich ein furchtbares Erdbeben mit einer gewaltigen Tsunamiwelle, die eine riesige Zahl an Toten zur Folge hat. Auch ein großes Atomkraftwerk an der Küste wird schwer beschädigt. Im fernen Deutschland bricht Panik aus, obwohl in diesem Land die sichersten Reaktoren stehen und weder schwere Erdbeben noch Tsunamis drohen. Die deutsche Regierungschefin – nennen wir sie Frau M. – hat aber eine Idee: Sie will ihren Gegnern endlich das Atomangst-Argument aus der Hand schlagen, mit dem man sie ständig ärgert. Sie will jetzt die Atomenergie einfach abschaffen und verkündet, dass sie nun plötzlich begriffen hätte, dass Atomreaktoren unsicher sind. Das habe sie vorher nicht gewusst. Frau M. ist übrigens Physikerin. Sofort werden acht Kernkraftwerke abgeschaltet, die übrigen dann später. Weil die Reaktorsicherheits-Experten leider erklären, dass die Atomkraftwerke doch sicher sind, beruft Frau M. einen Ethikrat, der gar nicht erst über den Ausstieg diskutieren soll, sondern dem sie gleich die gewünschte Antwort als Frage vorlegt: „Wie kann ich den Ausstieg mit Augenmaß vollziehen…?“ Diesem Ethikrat gehört kein Energieexperte an, jedoch 2 Bischöfe.

Dieser Rat gibt die gewünschte Antwort und dann wird ein Ausstiegs-Gesetzespaket beschlossen, das Parlament und Bundesrat anschließend in Rekordzeit verabschieden. Es herrscht große Angst, denn schon morgen können die Reaktoren explodieren. Jedenfalls genau die, die zuerst abgeschaltet wurden. Die übrigen noch nicht. Der jetzt fehlende Strom wird nun zum großen Teil aus den Nachbarländern importiert: Und das ist wieder überwiegend Atomstrom. Das stört jetzt aber niemanden mehr. Deutschland ist noch einmal davon gekommen. Frau M. nennt es die Energiewende.“

Das Drehbuch wird wegen Unglaubwürdigkeit abgelehnt.

Soweit die Fiktion.

Wie man weiß, hat sich das aber tatsächlich im Frühjahr und Frühsommer 2011 zugetragen (14). Jetzt, wo sich die ersten Auswirkungen zeigen und die Fehler im Gesetzeswerk, in den Methoden ihrer Kaschierung und in der Argumentation der Regierung deutlich hervortreten und nun auch Reaktionen aus dem Ausland vorliegen, kann man eine Diagnose der sogenannten Energiewende versuchen (13, 14, 34, 37, 62, 65, 80)….

…Wie Deutschland seine Solarstrom-Industrie förderte und zugleich ihre härteste Konkurrenz aufbaute

Das Geld, das die Solarzellen kosten, geht zu ca. 60% nach China; Tendenz steigend. Deutschland ist dank seiner übertriebenen Photovoltaik-Zwangsförderung der größte Kunde von Chinas neuen PV-Fabriken. Dort sind die Arbeitsplätze entstanden – mit dem Geld der deutschen Stromverbraucher, die sich keine eigene PV-Anlage leisten können.

China hat diesen gewaltigen Geldstrom für den Aufbau seiner Photovoltaik-Produktion eingesetzt – übrigens mit deutschen Produktionsmaschinen (s.u.), nachdem Deutschland China zuvor mit Millionen beim Aufbau dieser Industrie half (s.u.). – und ist inzwischen der weltgrößte Hersteller, dessen Solarzellen konkurrenzlos billig sind.

Deutschland hat China dabei in dreifacher Hinsicht geholfen und gleichzeitig seine eigene Photovoltaik-Industrie in eine aussichtslose Lage gebracht:

· Mit dem EEG bot sich Deutschland als risikoloses Absatz- und Gewinnparadies für Photovoltaikhersteller an. Jahrelang stellte dieses sonnenarme Land den weltweit größten Absatzmarkt dar. Diese Chance ließen sich die chinesischen Produzenten nicht entgehen.

· Die traditionell starken deutschen Maschinen- und Anlagenbauer lieferten China alle benötigten Maschinen zur Massenproduktion der Solarzellen. Damit verfügt China heute über einen nur drei Jahre alten modernen Maschinenpark – und nutzt ihn. Und nun brechen auch den deutschen Solartechnik-Maschinenbauern die Aufträge weg: Branchenweit ist die Zahl der Aufträge um mehr als die Hälfte zurückgegangen und befindet sich auf dem niedrigsten Niveau seit Mitte 2009 (Wirtschaftswoche). „Man könnte überspitzt sagen, dass die deutschen Maschinenfirmen den deutschen Modulherstellern den Untergang bereitet haben.“ (Heiko Böhmer, GeVestor).

· Den eigentlichen Grund für Chinas besonders raschen Aufstieg als Solarzellen-Weltmacht deckte Ende Februar der SPIEGEL in seiner Nr. 9/2012 auf: In dem Artikel "Peking päppeln" von Alexander Neubacher wird berichtet, wie die Bundesregierung die chinesische Photovoltaik-Industrie mit Millionenhilfen und günstigen Millionenkrediten mit voller Absicht aufrüstete. Das Startkapital von 9 Millionen Euro kam direkt vom Umweltministerium. Es handelte sich absurderweise um Geld aus dem Verkauf von Verschmutzungszertifikaten an die deutsche Industrie, die damit selbst das Aufpäppeln ihrer Konkurrenz finanzieren durfte.

Das weitere Geld kam aus den Entwicklungshilfeetats der Regierung und ihrer Institutionen: Die Entwicklungsbank der staatlichen KfW Bankengruppe gab China 75 Millionen Euro als zinsgünstiges Darlehen, u.a. an die Solarriesen Yingli, Sunergy oder JA Solar, und die Deutsche Investitions- und Entwicklungsgesellschaft DEG (gleichfalls KfW-Tochter) finanzierte gleichfalls den Branchenriesen Yingli Solar. Diese Kredite laufen noch bis Dezember 2013 bzw. September 2013 weiter (64).

Der Wahnsinn hat Methode: Diese Mittel an China sollten laut Broschüren des Bundesumweltministeriums der Förderung der "globalen Klimagerechtigkeit" dienen – und der damit finanzierte Aufbau einer starken chinesischen Solarindustrie war volle Absicht und ein großer Erfolg – allerdings nicht aus der Sicht der deutschen Solarfirmen.

Minister Röttgen ist inzwischen aufgefallen, dass die chinesische Dumpingpolitik "zu einem ruinösen Wettbewerb auf dem Weltmarkt für Photovoltaikanlagen geführt hat" und dass er "eine Preispolitik sehe, die auf die Verdrängung deutscher Unternehmen gerichtet sei", wie er am 23.2.12 erklärte.

Dass die deutschen Kredite zur Finanzierung dieses Verdrängungswettbewerbs weiter laufen, kann annehmen, denn es handelt sich um Verträge.

Frank Asbeck, der Chef des Bonner Solarkonzerns Solarworld, der soeben zusammen mit US-Solarfirmen eine Klage gegen die Dumpingmethoden Chinas eingereicht hat, sollte ihr vielleicht eine neue Richtung geben.

· Wie China im eigenen Land mit ausländischen Herstellern umgeht, musste der Weltmarktführer in Solar-Wechselrichtern, SMA Solar Technology, erfahren. SMA- Vorstandssprecher Urbon: „In den Ausschreibungsverfahren in China kommt kein internationaler Player zum Stich“.

Die Zahlen sind eindrucksvoll – und spätestens seit Mitte 2010 alarmierend.

Anteile an der Solarzellen-Weltmarktproduktion in den 3 letzten Jahren:

Deutschland: 2009: 15,4% ; 2010: 9,7% ; 2011: 6,7%

China: 2009: 38,1% ; 2010: 47,8% ; 2011: 57,3%

Quelle. Bloomberg/FAZ

Das Bonner Marktforschungsunternehmen EuPD Research berichtete im September 2011: „Die Solarzellenproduktion verschiebt sich deutlich nach Asien“, die wichtigsten Länder seien China, Taiwan und Japan.

Besonders rasant verlaufe die Entwicklung in Taiwan: Während dort der Absatzmarkt auf Grund einer Beschränkung des Zubaus auf 70 MW pro Jahr (!) 2011 kaum eine Rolle spielen konnte, zeige die Produktion deutliche Zuwächse. Ein Hauptgrund sei der Eintritt großer Elektronik-Konzerne in den PV-Markt.

Eine bezeichnende Politik: Solarpanels in Massen für den Export produzieren – sie aber im eigenen Land nicht dulden. In Deutschland entsteht durch den Verlust der eigenen Produktion bei weiterhin EEG-geförderten massiven Importen die exakt entgegengesetzte Situation.

Einbrüche in der Solarindustrie

Der durch immense Subventionen in den westlichen Industrieländern künstlich geschaffene Absatzmarkt mit seinen hohen Gewinnen führte inzwischen zu einer extremen Überproduktion und damit zu einem dramatischen Preisverfall, der angesichts der überfüllten Lager noch nicht zu Ende ist: 2006 kostete ein Kilowatt Leistung 5.000 €, heute 2.000 – 2.400 €.

- Branchenexperten schätzen die weltweite Solarzellen-Nachfrage 2012 auf 21.000 MW;

- die existierenden Produktionskapazitäten aber auf 40-50.000 MW.

Man rechnet jetzt mit einer sehr deutlichen Marktbereinigung.

Verluste werden geschrieben, Pleiten und Arbeitsplatzverluste drohen im In- und Ausland. Die Nachrichten vom Winter 2011/Frühjahr 2012:

Der Berliner Solarzellenhersteller SOLON SE ging in die Insolvenz; mitgerissen auch von der Pleite des östereichischen Solarzellenherstellers Blue Chip Energy.

Solar Millenium traf es im Dezember 2011.

Conergy verbuchte 2011 einen Verlust von 80-85 Mio €. Im September 2011 wurde entschieden, die Zellenfertigung in Frankfurt an der Oder einzustellen.

First Solar (USA, s.u.) prüft für seine Werke in Frankfurt-Oder Kurzarbeit.

Der Maschinen-Ausrüster für Solarfabriken Centrotherm, Blaubeuren, erlitt Verluste und kündigt 400 von 1928 Mitarbeitern (weltweit). 80% seiner Umsätze macht das Unternehmen in Asien. Die PV-Hersteller in China, Centhrotherms Kunden, leiden seit 2 Jahren unter Überkapazitäten und streichen ihre Investitionen zusammen.

Q-Cells (Bitterfeld) meldete am 3.4.2011 Insolvenz an. Das Unternehmen wurde bereits in der Ausgabe 35/2011 des AKTIONÄR in dessen „Solar-Todesliste“ aufgenommen. Über die Hälfte des Grundkapitals war Ende 2011 verloren.

Der kanadische PV-Hersteller ARISE meldete für seine deutsche Tochterfirma in Bischofswerda Insolvenz an.

Schott Solar in Alzenau stellte seine Solarzellen-Produktion ein.

Die Sunways AG (Konstanz) hat mit 115,4 Mio € ihren Umsatz in 2011 gegenüber 2010 nahezu halbiert. Die chinesische LDK Solar übernahm ein Drittel der Anteile; die spätere volle Übernahme ist vorgesehen. Auch LDK Solar profitierte von dem Geld, das die Bundesrepublik mit ihrem Kredit der KfW Entwicklungsbank von 75 Mio € , u.a. an den chinesischen Solarkonzernen gab.

Die SunConcept Group (Elz, Hessen) stellte für ihre 7 Gesellschaften Insolvenzantrag. SolarWorld teilte im Februar mit, dass ihr Ergebnis vor Steuern und Zinsen (EBIT) von plus 193 Mio € in 2010 auf minus 233 Mio € in 2011 abgestürzt ist. Im TecDax stand die Aktie am 4.4.2011 bei 2,20 €; vor einem Jahr waren es 11,90€. Vor einem Kauf der Aktie wird in Börsenkreisen gewarnt, jedoch seien die meisten Beobachter der Meinung, dass der Konzern gute Chancen hat, auf lange Sicht als einer der Sieger aus der derzeitigen Konsolidierungswelle hervorzugehen.

Die Solarhybrid AG aus dem Sauerland ging Mitte März 2012 in die Insolvenz (89). RALOS New Energy AG, Michelstadt, stellte Ende Februar Insolvenzantrag.

Diese Aufzählung endet Anfang April 2012.

Am 21.2.2012 meldete die Börse, dass der deutsche Technologie-Aktienindex TecDax davon profitiert, dass von ehemals 9 deutschen Solarunternehmen nur noch 3 im TecDax stünden (83). Nur eins dieser Unternehmen stellt noch selbst PV-Zellen her, die anderen liefern Produktionsanlagen bzw. Elektronik.

Das Bild ist nicht durchweg düster: Der Marktführer in Solar-Dünnschichtzellen First Solar eröffnete im November 2011 sein zweites deutsches Werk in Frankfurt/Oder. Gut geht es der Firma aus Tempe/Arizona allerdings nicht (s.u.). Die PV-Maschinenbauer werden diversifizieren; sie müssen nicht ausschließlich Produktionsmaschinen für diese eine Produktklasse fertigen. SolarWorld überlebt voraussichtlich (s.o.). Und der Wechselrichter-Hersteller SMA erwartet bessere Zeiten ab 2013.

Sehr drastisch bewertete E.on-Technologie-Vorstand Prof. Klaus-Dieter Maubach – gewiss kein Photovoltaik-Freund – auf dem „Bloomberg New Energy Finance Summit“ in New York die Aussichten der deutschen Solarstrombranche: Deutschlands Solarindustrie werde in den kommenden 5 Jahren angesichts des Wettbewerbs aus China „verschwinden“. Nicht ein einziger Arbeitnehmer werde dann noch bei den deutschen Solarunternehmen arbeiten, denn dann seien alle pleite, wird Maubach zitiert (89).

Die wachsenden Probleme der Solarstrombranche sind keineswegs auf Deutschland beschränkt:

Solar-Pleiten in den USA

In den USA häufen sich Solar-Pleiten:

Im September 2011 ging der Solarkonzern Solyndra, den noch vor einem Jahr Präsident Obama besucht und als ein perfektes Beispiel das Wachstum mit sauberen Energien und für neugeschaffene, hochbezahlte Jobs gelobt hatte, bankrott und entließ alle 1.100 Mitarbeiter. Ein vom Energieministerium DoE garantierter Kredit über 535 Millionen US-$ ist verloren (49).

Die Aktien von Evergreen Solar, die noch 2009 bei 12 US-$ lagen; sind heute noch 10 Cent wert. Evergreen beantragte im August 2011 die Insolvenz.

Der Marktführer First Solar, der einst einen Marktwert von fast 6 Milliarden Dollar besaß, erlebte seit Januar 2011 einen Kursverlust von 48 %. Verglichen mit 2008 betrug der Kursverlust über 90 %.

Sunpower, das ebenfalls zu den größeren Unternehmen gehört, erlebte seit 2007 einen Kurssturz von fast 95 %. Im Herbst 2011 dauerten die Verluste bereits über drei Quartale an. Es existieren langfristige Schulden von mehr als 500 Mio Dollar und Gesamtverbindlichkeiten, die gegen 1 Milliarde Dollar gehen.

Auch die Firmen Spectrawatt, SES und Stirling Energy wurden in den vergangenen Monaten vom Markt gefegt.

Auch die italienische Regierung wurde aktiv: Sie zog den Termin der Beendigung der Förderung von PV-Freiflächenanlagen auf Ende Januar 2012 vor. Eine Ausnahmeregelung betrifft im Bau befindliche Anlagen.

Bis vor einigen Jahren war Spanien noch der grösste Solarmarkt der Welt. 2011 wurden dann nur noch 400 MW an PV-Leistung zugebaut (72). „Was heute ein Energieproblem ist, könnte ein finanzielles Problem werden“, sagte Industrieminister Jose Manuel Soria am 27.1.2012 in Madrid. Die Regierung erließ an diesem Tage ein Dekret, das Subventionen für neue Wind-, Solar-, Co-Feuerungs- und Müllkraftwerke stoppte. Soria erklärte weiter, dass Wasserkraft- oder Kernkraftwerke nicht mit neuen Abgaben belastet würden. „Wer wird jetzt noch nach diesem Dekret in den Sektor der erneuerbaren Energien investieren ?“, fragte der Chef der Lobby-Gruppe Fundacion Renovables, Javier Breva.

Selbst die chinesischen Firmen JA Solar und Sunergy werden zur Gruppe gefährdeter Solarunternehmen gerechnet (Bewertung der Schweizer Bank Sarasin).

Deutsche Tageszeitungen meldeten: Anleger flüchteten Ende 2011 „in Scharen aus Papieren der Solarbranche.“

Die grünen Jobs verschwinden wieder

In den westlichen Industrieländern spricht kaum noch jemand von der Solarindustrie als einer Zukunftsindustrie oder Jobmaschine – mit Ausnahme von Bundesumweltminister Röttgen, der anlässlich der Vorstellung der Förderkürzungen am 23.2.2012 wörtlich erklärte: „Die Photovoltaik ist eine Erfolgsgeschichte. Sie könnte zum Exportschlager werden.“

Die tatsächliche Marktentwicklung trifft jetzt diejenigen Arbeitsplätze, die nach grünen Plänen eigentlich an die Stelle der Jobs in der konventionellen Energiewirtschaft treten sollten (29). Die staatlich verkündete Behauptung war stets, dass es sich um hochqualifizierte, sog. Hightech-Arbeitsplätze handeln würde, was nicht den Tatsachen entsprach. Noch wird in deutschen Forschungsinstituten an der Photovoltaik gearbeitet und daran wird sich voraussichtlich nichts ändern.

Aber schon länger wird kritisiert, dass die deutschen Photovoltaikfirmen selbst nicht genügend Geld in die Forschung investiert haben, sondern im Vergleich zu anderen Technik-Branchen sogar besonders wenig. Das beschleunigte ihren Niedergang. Dass Bundesumweltminister Röttgen im Januar betonte, „er wolle ein Überleben der (Photovoltaik-) Technologieführerschaft in Deutschland“, kann sich also nur noch auf die Arbeiten in Forschungsinstituten beziehen, nicht aber auf die Unternehmen, die sein eigenes Ministerium mit der großzügigen Starthilfe für Chinas Solarfirmen dem vorauszusehenden Untergang preisgegeben hat.

Weil die Herstellung der Solarzellen dank der großzügigen deutschen Finanzhilfen weitgehend nach China abgewandert ist, verbleiben in Deutschland mittelfristig nur noch Jobs in der Produktion von begleitender Elektronik (z.B. Wechselrichter, Netztrenngeräte) und in der Montage. Diese Elektronik ist jedoch noch leichter zu kopieren, als die Herstellungstechnologie der PV-Zellen; das trübt die Aussichten.

Das ständig wiederholte Argument über die „Erneuerbaren“ als Jobmaschine verliert nicht nur bei der Photovoltaik seine Glaubwürdigkeit. Ohne weitere Dauersubventionen hätte nur ein Teil von ihnen Bestand – z.B. in der Bioenergie, bei den Kraft-Wärmekopplungs-Anlagen und der Erdwärmenutzung sowie selbstverständlich bei der Wasserkraft.

Die Photovoltaik ist damit für die Welt keineswegs eine überholte Stromerzeugungstechnik – als eine prosperierende Industriebranche für Deutschland und auch für andere westliche Industrieländer kommt sie aber nicht mehr in Frage.

Technisches Unverständnis und Beratungsresistenz ließ Politiker lange an die Illusion von einer blühenden Solarindustrie glauben; dabei hätte man bereits vor 10 Jahren ohne Schwierigkeiten erfahren können, dass diese Technologie niemals in einem Hochlohnland gehalten werden konnte.

Dass dies dermaßen schnell ging, hat die Bundesregierung mit der Aufbauhilfe für Chinas Solarfirmen selbst verursacht. Es ist vermutlich kein Trost für die deutschen Solarfirmen, dass sie auf dem Altar deutscher regierungsamtlicher Klimaretter geopfert wurden.

Das Rheinisch-Westfälische Institut für Wirtschaftsforschung RWI hat berechnet, dass die gesamten Subventionen für die Photovoltaik mittlerweile die 100-Mrd-Euro-Grenze überschritten haben. Wie man jetzt feststellt, hat dieser enorme Aufwand im Gegensatz zu den politischen Visionen keine nachhaltigen positiven Arbeitsplatzeffekte bewirkt (18)……

…….9. Neue Kohle- und Gaskraftwerke – der Rettungsanker, der nicht greift

Mitte Dezember 2011 berichtete der SPIEGEL dass der für die Energiepolitik zuständige Bundeswirtschaftsminister Philipp Rösler „stärker als bisher geplant in zusätzliche Kohle- und Gaskraftwerke investieren“ wolle. Gemeint war wohl, dass sein liberal geleitetes und früher die Marktwirtschaft hoch haltendes Ministerium entsprechende Investitionen mit Zuschüssen fördert, wie sie bereits gefordert werden.

Laut SPIEGEL sei in einem BMWi-Papier von „circa 17 neuen Großkraftwerken bis zum Jahr 2022“ die Rede. Weiter hieße es dort: „Fossile Kraftwerke sind essenziell für eine sichere Energieversorgung“, denn diese müssten die wegfallenden Atomkraftwerke ersetzen und die schwankende Stromerzeugung aus Wind und Sonne ausgleichen.

Dem widersprach sofort der unzuständige aber intensiv mit dem Segen der Kanzlerin Energiepolitik betreibende Bundesumweltminister Norbert Röttgen, der die Existenz von Engpässen in der Erzeugungskapazität bestritt. Bei Kraftwerkskapazitäten gebe es bis 2020 „kein Problem.“ Es dürften nur die bereits beantragten oder im Bau befindlichen Kohlekraftwerke in Betrieb gehen.

Röttgen bezeichnete Warnungen vor einem „Blackout“ ebenso als Horrorszenario wie jene vor explodierenden Strompreisen.

Damit hat man ein halbes Jahr nach Verkündung der Energiewende ein zutreffendes Bild von der Arbeit der Regierung an ihrer Umsetzung.

Der Bundesverband der Energie- und Wasserwirtschaft BDEW ersetzte nun die widersprüchlichen Streitereien aus Berlin durch ein im Oktober 2011 veröffentlichtes Gutachten (6):

· Der BDEW schätzt, dass bis 2030 etwa 33.000 MW an fossilen Kraftwerken (Kohle und Gas; Öl ist unwesentlich) vom Netz gehen, weil sich der Betrieb nicht mehr lohnt oder Bestandskraftwerke am Ende ihrer Lebensdauer sind. In diese Zahl sind bereits die bis dahin geplanten Neubauten von 12.000 MW eingerechnet.

Anschließend hatte die Bundesnetzagentur in ihrem Monitorbericht 2011 (9) eine Auflistung für den Zu- und Rückbau von Steinkohle-, Braunkohle- und Erdgaskraftwerken präsentiert, soweit es heute sicher bzw. geplant ist:

· „Bundesweit wird bis 2022 ein Rückbau von ca. 29.500 MW

dargebotsunabhängiger (d.h. unabhängig von Wind, Wetter, Tageslicht…)

Erzeugungskapazität erwartet. Hierin sind die bereits 2011 stillgelegten 8 KKW

mit insgesamt 8.400 MW enthalten.

Neben den derzeit im Bau befindlichen 12.900 MW wird demnach der Zubau von

weiteren 16.600 MW Kraftwerksleistung benötigt, um den Rückbau bis 2022

auszugleichen. Hierbei ist es wichtig, dass es sich um neue, zusätzliche

Kraftwerksleistung handelt, die nicht durch den Rückbau stillzulegender

Kraftwerksblöcke am gleichen Standort reduziert wird.

Bislang liegt erst für Kraftwerksprojekte mit 1,400 MW eine behördliche

Genehmigung vor.

Weitere 10.600 MW befinden sich noch im Genehmigungsverfahren.“

· Durch die Stilllegung von 5 Kernkraftwerken fehlen in Süddeutschland etwa 3.000 MW. Erst 2013 und 2014 wird durch die Fertigstellung von 2 Steinkohlekraftwerken ein Zubau um ca. 1.700 MW in Süddeutschland erwartet.

Aber: „In Süddeutschland übersteigen die erwarteten Rückbauzahlen der Kraftwerke deutlich die aktuellen Plandaten für die Zubauten“.

Die Folge: „Gegenüber der Situation vor dem Kraftwerksmoratorium der Bundesregierung bleibt die Lage in Süddeutschland auch nach Fertigstellung der derzeit im Bau befindlichen größeren Kraftwerksprojekte ernst und risikobehafteter als vorher.

· „ Wie die Daten zeigen, wird sich die Erzeugungssituation in Süddeutschland 2012 voraussichtlich nicht signifikant verändern. Demnach ist davon auszugehen, dass im Winter 2012/13 eine zum Winter 2011/12 vergleichbare Erzeugungssituation vorliegen wird“. Die Erzeugungssituation in Süddeutschland bleibe auch nach Fertigstellung zweier Steinkohlekraftwerke angespannt. Siehe auch Kap. 9.

· „Die im Monitoring 2010 bereits festgestellten Verzögerungen bei 11 größeren Kraftwerksprojekten haben sich 2011 noch einmal vergrößert. Zudem reduzierte sich das Gesamtvolumen von dargebotsunabhängigen Kraftwerksprojekten innerhalb eines Jahres um 18% bzw. rund 7.300 MW.“

Die Zahlen für Süddeutschland (Kraftwerke Frankfurt am Main und südlicher) aus dem Monitoringbericht::

· 2011: Steinkohle: keine Änderung

Erdgas. + 684 MW

Kernkraft: – 4.947 MW; Saldo 2011. Abnahme um 4.263 MW

· 2012: Steinkohle: – 293 MW

Erdgas: + 92 MW; Saldo 2012: Abnahme um 201 MW

· 2013: Steinkohle: + 847 MW

Erdgas: 0; Saldo 2013: Zunahme um 847 MW

· 2014: Steinkohle: +845 MW; -406 MW

Erdgas: 0; Saldo 2014: Zunahme um 439 MW.

· 2014-2020: Kernkraft: – 3.961 MW

Steinkohle: – 655 MW

Weitere: – 114 MW; Saldo 2014-2020: Abnahme um 4.713 MW

· 2021-2022: Kernkraft: – 4.008 MW; Saldo 2021-2022: Abnahme um 4.008 MW

Diese geschätzten Zahlen enthalten ab 2014 die weiteren, noch stillzulegenden Kernkraftwerke in Süddeutschland:

Ø Grafenrheinfeld – 1.275 MW, zum 31.12.2015

Ø Grundremmingen B – 1.284 MW, zum 31.12.2017

Ø Philippsburg 2 – 1.402 MW, zum 31.12.2019

Ø Grundremmingen C – 1.288 MW, zum 31.12.2021

Ø Neckar II – 1.310 MW, zum 31.12.2022

Ø Isar 2 – 1.410 MW, zum 31.12.2022.

Diese Stilllegungen würden ein zusätzliches, heute noch nicht einmal geplantes Kohlekraftwerks-Neubauprogramm erfordern. Weshalb es bereits heute große Schwierigkeiten beim Erreichen der heutigen Neubaupläne gibt, wird unten erläutert.

Betrachtet man die Art der heute im Bau befindlichen und derzeit geplanten neuen Kraftwerke, so kann man dem Monitorbericht entnehmen, dass von den im Bau befindlichen Kraftwerken 82% der Kraftwerksleistung durch Kohlekraftwerke und nur 18% durch Erdgaskraftwerke erbracht werden. Ende 2013 sollen dann insgesamt 73% der Neubaukapazität neue Kohlekraftwerke und 27% Gaskraftwerke sein. Hier musste die Regierung sämtliche Bekenntnisse zum sogenannten Klimaschutz über Bord werfen, denn es ist eine Binsenweisheit der Kraftwerkswirtschaft: Wenn man kaum Wasserkraft hat und dann auch noch seine Kernkraftwerke abschaltet, dann muss man eben Kohlekraftwerke bauen. Es sei denn, man hat sehr billiges Erdgas oder Erdöl. Beides haben wir nicht.

Diese Neubauaktivität und die Neubauplanung fossil gefeuerter Kraftwerke zeigt deshalb sehr klar – abseits von allen Sonntagsreden – die Wirklichkeit der Energiewende: Die gesamte stillgelegte Erzeugungskapazität der deutschen Kernkraft muss durch Kohle und Gaskraftwerke ersetzt werden, die allein eine sichere Grundlasterzeugung bieten, wie sie von der Industrie und von den Verbrauchern benötigt wird. – egal, wie viel Wind- oder Solarstromanlagen am Netz hängen. Wenn Wind und Sonne dann Strom liefern, müssen die Kohle- und Gaskraftwerke heruntergefahren, aber natürlich nicht abgeschaltet werden, da sie in kurzer Zeit wieder benötigt werden könnten. Das macht sie unrentabel, weshalb die Investoren mit Recht kein Interesse mehr an Neubauten haben: Ein Teufelskreis.

Die Einsparung von Kohle bzw. Erdgas während dieser Leerlaufperioden ist verständlicherweise gering, weshalb auch der positive Effekt des Wind- und Solarstroms für die Umwelt ebenso gering ist. Dieses System mit vielen Milliarden Euro der Stromverbraucher aufzubauen war daher eine gigantische Fehleinschätzung – eine Mischung aus Unwissenheit und Ideologie.

Die beste Lösung wäre deshalb, einfach alle Wind- und Solarstromanlagen abzuschalten. Aber dann hätte man ja keine Energiewende mehr.

Die Gewissheit, dass die Kernkraftabschaltung exakt die beschriebenen „fossilen Konsequenzen“ haben musste, bestand in der Energiewirtschaft von Anfang an – und die hier präsentierte Neubautätigkeit und –Planung zeigt, dass es auch genau so geschieht. Diese Planung geschieht aber nicht etwa hinter dem Rücken der Bundesregierung, diese ist vielmehr die planende und treibende Kraft hinter dieser Entwicklung. Soviel zur Ehrlichkeit in der Energiepolitik.

Aus dem Monitoringbericht könnte man schließen, dass etwa Ende 2014 das von der Abschaltung der 8 Kernkraftwerke gerissene Versorgungsloch- wenn alles gut geht – wieder aufgefüllt sein wird. Wie es dann nach dem Abschalten der übrigen Kernkraftwerke weitergehen soll, wird nicht behandelt. Eine neue große Kohlekraftwerks-Neubauaktion wäre dann fällig.

Aber auch die bis 2014 präsentierten Zahlen täuschen aus drei Gründen:

Grund Nr.1:

Die vorgestellten Planzahlen sind möglicherweise zu optimistisch.

Die Bundesnetzagentur führt dazu in ihrem Bericht folgendes aus:

„Derzeit befinden sich bundesweit ca. 12.900 MW dargebotsunabhängige (=Kohle-, Gas; Biomasse) Kraftwerkskapazitäten in Bau, die voraussichtlich bis 2014 fertig gestellt sein werden. Hier gibt es jedoch Unwägbarkeiten wie die Kesselproblematik. So führt der Einsatz von Kesseln mit der neuartigen, hochtemperaturbeständigen und druckfesten Stahllegierung T24 (7 CrMo VTiB 10 10) zu techn. Problemen.

Bei mehreren im Bau befindlichen Kohlekraftwerken hat dies bereits zu Verzögerungen bei der geplanten Inbetriebnahme geführt.

Von den insgesamt im Bau befindlichen Kraftwerksprojekten (Anm.: Kohle, Gas) haben 18 Projekte mit insgesamt 12.300 MW eine Kapazität von jeweils mindestens 100 MW. Gegenüber den Daten aus dem Monitoring 2010 lassen sich davon für elf Projekte Verzögerungen bei dem geplanten Zeitpunkt der kommerziellen Inbetriebnahme feststellen. Bei sechs Projekten (5.000 MW) beträgt die Verzögerung ein Jahr, bei vier Projekten (2.900 MW) zwei Jahre und bei einem Projekt (1.100 MW) drei Jahre. Die bereits im Monitoring 2010 festgestellten Verzögerungen haben sich damit gemäß der Monitoringdaten 2011 noch einmal vergrößert. Zudem ist das Gesamtvolumen der Investitionsvorhaben bei diesen Kraftwerken rückläufig. So reduzierte sich das Gesamtvolumen innerhalb eines Jahres um knapp 18 Prozent bzw. rund 7.300 MW“.

Grund Nr.2:

Die Situation in Süddeutschland (siehe oben).

Grund Nr.3:

Gegen den Bau neuer Kohlekraftwerke gibt es ebenso wie gegen neue Hochspannungstrassen massiven Widerstand durch Umweltverbände (75) und Bürgerinitiativen – siehe unten sowie Kapitel 14.

Dass diese in den Prognosen der Bundesnetzagentur und des BDEW

ersichtliche bedenkliche Kapazitätslücke künftig entstehen und auch aus heutiger Sicht nicht geschlossen werden kann, liegt an dem schon in

zahlreichen Berichten erläuterten sehr plausiblen Desinteresse der

potenziellen Investoren an neuen Kohle- und Gaskraftwerken.

Auch für dieses Desinteresse gibt es gute Gründe:

Die stetig ansteigende gesetzlich vorgeschriebene Zwangseinspeisung von stark schwankendem Wind- und Solarstrom in die Netze zwingt konventionelle Kraftwerke zu immer häufigerem Herauf- und Herunterfahren ihrer Leistung. Eben das wünscht sich die Regierung zum Ausgleich dieser Schwankungen – aber eben das senkt die Betriebsstunden der Kraftwerke, verhindert ihr gleichmäßiges Fahren mit konstanter Leistung und erhöht den Verschleiß. Es wird weitaus weniger Strom erzeugt und verkauft, als es die Anlagen erlauben: Sie sind dann unrentabel, weshalb es keinen Sinn macht, sie zu bauen.

Dazu schreibt der BDEW in seinem Gutachten „Flexibilisierung“ vom 11.10.11 mit erstaunlicher Offenheit (90):

„…in 2020 werden noch immer 80 % der heutigen konventionellen Kraftwerke benötigt. Diese werden als Back-up-Systeme bei unzureichender Erzeugung von EE-Strom (d.h. Strom aus „Erneuerbaren“) vorgehalten. Sie weisen jedoch eine gegenüber der heutigen Situation um durchschnittlich 40 % geringere Auslastung auf. Ein wirtschaftlicher Betrieb wäre unter den gegebenen Rahmenbedingungen nicht gesichert bzw. benötigt entsprechende Preisspitzen. Ein marktgetriebener inländischer Ausbau der technisch erforderlichen Kraftwerkskapazität zur Gewährleistung der Versorgungssicherheit ist unter den aktuellen Rahmenbedingungen nicht gesichert. Er erfordert langfristig wirksame und marktbasierte Anreize, die von der Politik zugelassen werden müssen“.

Damit ist eine weitere Subventionsaktion angekündigt – und sie wird kommen, wie Minister Röslers Bemerkung bereits andeutet (s.o.) – denn sie passt sich logisch in die verhängnisvolle Kette von Fehlentscheidungen ein, die beginnend mit der grundsätzlichen Fehlentscheidung, die das Erneuerbare Energien-Gesetz darstellt, in einer immer weiter gehenden Reihe schädlicher und stets teurer

Reparaturmaßnahmen den eingeschlagenen Irrweg ohne Rücksicht auf Verluste fortsetzen.

Selbstverständlich würden auch diese Subventionen – hier liebevoll „Preisspitzen“ und „Anreize“ genannt – wiederum allein den Stromverbrauchern aufgebürdet.

Weiteres dazu im Kapitel 16 mit der Auflistung der Ursachen für weitere

Strompreis-Steigerungen. Auch im Kap. 12 über die Energie-Planwirtschaft

haben diese Überlegungen ihren passenden Platz gefunden.

Ein weiterer Grund, die von der Regierung geschätzten – und besonders gut regelbaren – Gaskraftwerke gerade nicht zu bauen, liegt in den sehr hohen Gaspreisen und den langfristigen Lieferverträgen, die diese Preise zementieren. Derartige Investitionen sind daher noch unattraktiver als solche in neue Kohlekraftwerke.

Aber nicht nur Investoren zögern beim Neubau fossiler Kraftwerke: Mindestens ebenso wirksam ist der Widerstand von Umweltverbänden und Bürgerinitiativen: Allein in NRW sind drei Neubauprojekte gestoppt bzw. verzögert: Das EON-Kraftwerk Datteln wurde vom NRW-Oberverwaltungsgericht gestoppt, ebenfalls das Trianel-Kraftwerk Lühen; für beide fordert der Bund für Umwelt und Naturschutz BUND das Ende. Das Trianel-Steinkohlekraftwerk Krefeld wurde nach heftigen Protesten der Umweltschützer aufgegeben – eventuell wird stattdessen innerhalb von 6 Jahren ein Gaskraftwerk gebaut. Und der neue Block 10 des STEAG-Kraftwerks Walsum wird wegen technischer Probleme erst drei Jahre später ans Netz gehen.

In Planung befinden sich laut BDEW Kohlekraftwerke mit rund 12.000 MW.

„Projekte mit noch einmal dieser Leistung wurden in den letzten Jahren vor allem wegen öffentlicher Proteste aufgegeben“. Das heißt: „Der notwendige Investitionsbedarf ist bei weitem nicht durch die Planungen gedeckt.“

(M. Hüther, IWKöln, Handelsblatt 16.3.11)…..

…..10. Die Stromnetze werden an die Grenzen ihrer Belastbarkeit getrieben

Bereits vor dem Kernenergie-Moratorium, dem dann die permanente Abschaltung der 7+1 Kernkraftwerke und schließlich noch das Gesetzespaket der Energiewende folgte, hatte die rot-grüne und die schwarz-gelbe Regierung mit dem EEG eine stetig zunehmende Belastung und Destabilisierung des elektrischen Übertragungs- und Versorgungsnetzes verursacht. Mit der KKW-Abschaltung wurde dann dem Versorgungssystem ein besonders schwerer Schlag versetzt, der es an das Limit seiner Leistungsfähigkeit und Stabilität brachte.

Die rechtzeitigen Warnungen der Bundesnetzagentur ließen an Deutlichkeit nichts zu wünschen übrig:

Bereits in ihrem kurz vor der KKW-Abschaltung veröffentlichten jährlichen Routine-Bericht „Bericht zur Auswertung der Netzzustands- und Netzausbauberichte der deutschen Elektrizitätsübertragungsnetzbetreiber (Anm.:ÜNB)“(4) vom 14.3.201 hatte die Bundesnetzagentur wichtige Informationen zum bereits damals unbefriedigenden Zustand des Netzes veröffentlicht:

Die Netzagentur warnte darin, dass die deutschen Stromnetze „derzeit am Rande der Belastbarkeit beansprucht“ werden. Dies sei die direkte Folge massiver Verzögerungen beim Bau neuer Stromleitungen, so die Behörde. Nur durch massive Investitionen auf allen Ebenen des Netzausbaus könne das hohe Niveau der Versorgungssicherheit in Deutschland auch weiterhin gewährleistet werden.

„Diese Berichte der ÜNB zeigen einen Investitionsbedarf in ganz erheblichem Umfang auf. Die Gründe …..liegen vor allem in der Integration erneuerbarer Energien – sowohl Wind als auch Photovoltaik -, verbunden mit der gesetzlich vorgegebenen Anschluß- und Abnahmepflicht (EEG). Die Bundesnetzagentur konstatiert erhebliche Verzögerungen bei der Realisierung von Netzausbauvorhaben der ÜNB.

Gründe hierfür liegen überwiegend in den langwierigen Raumordnungs- und Planfeststellungsverfahren und einer fehlenden Akzeptanz in der Bevölkerung“ (siehe auch Kap. 14).

♦ Die Hälfte von 24 besonders wichtigen Ausbauprojekten, die im August 2009 als vordringlich eingestuft wurden, verzögere sich.

♦ Der Zeitverzug bei diesen 12 Projekten liege zwischen 1 und 4 Jahren.

♦ Erst 214 km von insgesamt 1807 km seien bislang fertiggestellt.

Dieser Bericht lag somit der Regierung und den Parlamentariern bereits zu Beginn der Kernkraft-Abschaltungsdebatte vor und seine Aussagen wurden durch die folgenden Berichte vom 11.4.2011 und vom 27.5.2011 noch wesentlich verschärft – sämtlich vor dem Kabinettsbeschluss zum Energiewende-Gesetzespaket und natürlich auch vor dem Inkrafttreten dieser Gesetze.

Liest man die „Fortschreibung des Berichts der Bundesnetzagentur zu den Auswirkungen des Kernkraftwerks-Moratoriums auf die Übertragungsnetze und die Versorgungssicherheit“ vom 27. Mai 2011 (2), dann kann man die sträfliche Leichtfertigkeit, mit der die Regierung und dann das Parlament die Gesetze zur Energiewende beschlossen haben, nicht fassen. Bereits der erste Bericht zum Moratorium vom 11.4.2011 (1) enthielt massive Kritik an der Abschaltung der Kernkraftwerke (7+1) und eindrucksvolle Erklärungen zu den unvermeidlichen schädlichen Auswirkungen.

Regierung und Parlamentarier hatten selbst nach der Veröffentlichung des Fortschreibungsberichts (2) noch 4 Wochen Zeit bis zu ihrer überhasteten Vorlage der Gesetzentwürfe an den Bundesrat am 24. Juni.; und dann verblieb immer noch genügend Zeit bis zu dem Tag, an dem der Bundestag diese Gesetze beschloss – das war der 8. Juli 2011.

Niemand kann also behaupten, er hätte die massiven Warnungen der Bundesnetzagentur nicht rechtzeitig gekannt. Die Wahrheit ist daher, dass sowohl Regierung als auch die Abgeordneten diese Berichte kannten – und bewusst dagegen handelten. So wie sie auch den Bericht der Reaktorsicherheitskommission kannten, der den deutschen Kernkraftwerken eine hohe Sicherheit bescheinigte.

Sie folgten stattdessen den Empfehlungen der Ethikkommission.

Man wusste beizeiten, was kommen würde

Die von der Bundesnetzagentur präsentierten Feststellungen und Voraussagen werden hier zusammengefasst:

· „Die historisch einmalige zeitgleiche Abschaltung von 5.000 MW Leistung und das längerfristige Fehlen von 8.500 MW Leistung bringen die Netze an den Rand ihrer Belastbarkeit.“

· „Die Übertragungsnetzbetreiber (ÜNB) sind daher gezwungen, das Marktergebnis durch gesteigerten Einsatz ihrer Handlungsinstrumente wie… Eingriffe in den Kraftwerkseinsatz…zu korrigieren. Damit wird das eigentlich anzustrebende, wettbewerblich strukturierte Marktergebnis durch einen mehr oder weniger zentral gesteuerten planerischen Ansatz ersetzt (Anm.: siehe auch Kapitel 4 und 12: Planwirtschaft). Das ist energiewirtschaftlich zweifelhaft, ökonomisch ineffizient und ökologisch schädlich…..

Das erhebliche netztechnische Problem, das mit dieser Marktkorrektur verbunden

ist, besteht darin, dass das genannte Maßnahmenpaket eigentlich für

Ausnahmesituationen wie Ausfälle von Kraftwerken oder Leitungen gedacht ist,

nunmehr aber oft bereits für den Normalfall eines intakten Netzes nahezu

vollständig ausgeschöpft wird und damit bei zusätzlichen unerwarteten Notfällen

nicht mehr zur Verfügung steht. Damit steigt das Risiko der Nichtbeherrschbarkeit

von Störungsfällen im Netz deutlich an.“

· „(Weiterhin) gilt die Aussage, dass sich das Risiko im Winterhalbjahr bei der dann typischerweise höheren Netzbelastung durch höhere Stromnachfrage sowohl im Inland wie im Ausland und der signifikant niedrigeren Photovoltaikerzeugung nochmals deutlich erhöht.“

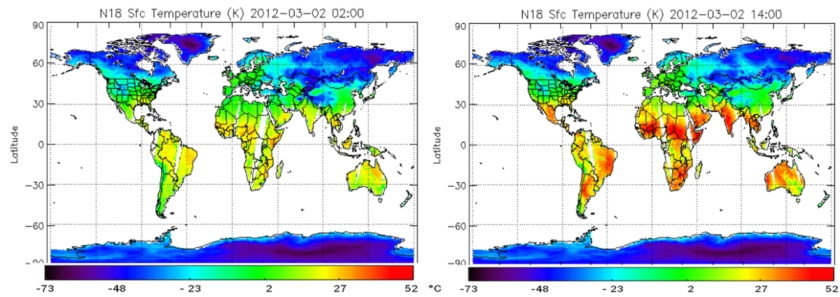

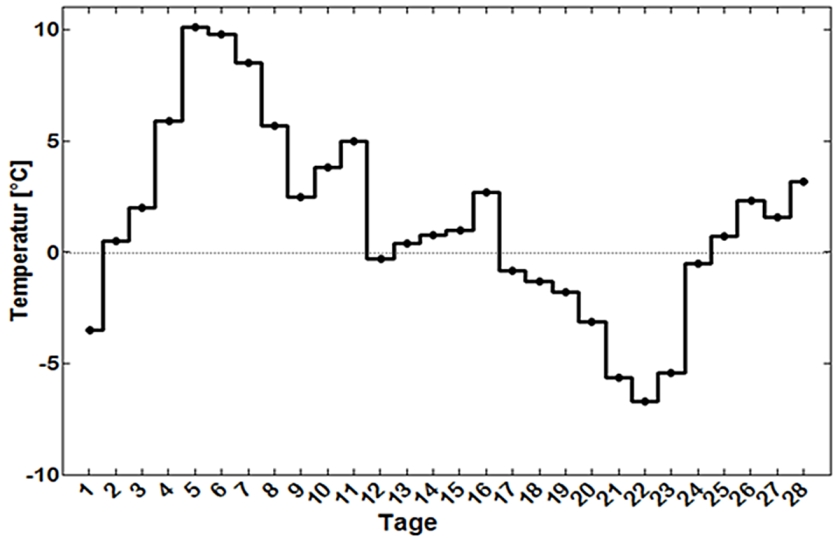

· „Das Einspeiseverhalten aus Photovoltaik-Anlagen und Windenergie im Zeitraum vom 11.3. bis 8.5.2011 sind in Grafiken dargestellt. Sie verdeutlichen das enorme Potential zur Lastdeckung, das erneuerbare Energien schon heute haben. In der Spitze erreicht dies bis zu 28.000 MW. Die Grafiken verdeutlichen allerdings auch, dass diese Leistung nicht gesichert zur Verfügung steht, sondern regelmäßig auch völlig entfällt.

Diese Einspeisungsschwankungen sind tatsächlich noch größer: Ende November

2011 teilte der Leiter Politik und Märkte bei der RWE Innogy Holger Gassner mit,

dass allein im ersten Halbjahr 2011 enorme Schwankungen der verfügbaren

Windkraftkapazitäten von 23.000 MW und der Photovoltaikleistung von 13.000

MW beobachtet wurden.

· „Der fluktuierenden Einspeisung stehen derzeit und mittelfristig keine auch nur annähernd ausreichenden Speicherkapazitäten gegenüber. Gegenwärtig sind in Deutschland Pumpspeicher mit einer Leistung von etwa 7.000 MW und Entladezeiten von einigen Stunden in Betrieb…Die gesamte verfügbare Speicherkapazität beträgt derzeit etwa 40.000 MWh (Megawatt-Stunden). Zum Vergleich: Im Mai 2011 betrug der Stromverbrauch im Schnitt an einem Tag rund 1.440.000 MWh (Anm.: Also das 36-fache).

· „Die Erwartung einer stärkeren Belastung durch die Abschaltung der 7+1 Kernkraftwerke der Nord-Süd- und der Ost-West-Trassen in Gestalt verstärkter Lastflüsse im Übertragungsnetz hat sich bestätigt. Insbesondere in Zeiten von Starkwind werden häufiger Sicherheitseingriffe …erforderlich.“

· „Die veränderte Netzbelastung durch die Abschaltung der 7+1 Kernkraftwerke hat bereits zu Verzögerungen bei geplanten Wartungs- und Instandhaltungsarbeiten im Übertragungsnetz geführt, da viele Arbeiten nur bei wenig oder unbelasteten Netzen durchgeführt werden können. ..Mit weiteren Verzögerungen muss gerechnet werden….

Bedingt durch die höhere Netzlast ist auch bei Netzausbaumaßnahmen mit

Verzögerungen zu rechnen. Es ergibt sich die paradoxe Situation, dass durch das

Moratorium ein Mehr an Transportkapazitäten erforderlich wird und gleichzeitig

Netzumbau- oder Netzverstärkungsmaßnahmen aufgrund der erhöhten

Netzbelastung nicht mehr wie geplant durchgeführt werden können.“

· „Durch das Moratorium entstehen sowohl in der Rhein-Main- und in der Rhein-Neckar-Region als auch im Raum Hamburg große Probleme bei der Spannungshaltung.“

· „Auch nach wiederholter Analyse besteht sowohl im Sommer 2011 als auch im Winterhalbjahr 2011/2012 in kritischen Last-/Erzeugungssituationen gerade noch ein ausreichendes erzeugungsseitiges Versorgungssicherheitsniveau. Ein etwaiger Puffer für zusätzliche Stilllegung von Kraftwerkskapazitäten besteht nicht.“

· „Es ist sinnvoll, Kraftwerke aus der Kaltreserve zurückzuholen und wieder in einen kurzfristig einsatzfähigen Zustand zu versetzen.“ (Anm.: Das wären natürlich in erster Linie die hier nicht gemeinten abgeschalteten Kernkraftwerke – technisch problemlos, politisch undenkbar).

· „Die Übertragungsnetzbetreiber haben bestimmte, besonders risikobehaftete Szenarien… durchgerechnet. Zu diesen Szenarien zählen:

a) Der Fall eines Starklast-Tages im Sommerhalbjahr, bei dem zusätzlich zum Moratorium eine Vielzahl von Kraftwerken wegen Revision nicht am Netz ist.

b) Der Fall eines Starklast-/Starkwind-Tages im Winterhalbjahr.

c) Der Fall eines Starklast-Tages mit sehr geringer EEG-Einspeisung im Winterhalbjahr.

d) Der Fall eines Starklast-Tages mit sehr geringer Einspeisung im Winterhalbjahr verbunden mit dem Ausfall einer hoch belasteten Nord-Süd-Leitung.

Diese Szenarien sind für das Netz äußerst kritisch. Die Szenarien a) und b) erscheinen …gerade noch beherrschbar. Die Szenarien c) und d) sind nach derzeitiger Kenntnislage die kritischsten und bedürfen daher der intensiven weiteren Prüfung und möglicherweise weitergehender…..Maßnahmen….

Im Falle d) bleibt die Lage riskant, da bei einem möglichen Hinzutreten weiterer Umstände (z.B. Kraftwerksausfall, Ausfall eines weiteren Betriebsmittels) eine Leitungsbelastung von 140 % und mehr aufträte, die wegen des kaskadenartigen automatischen Auslösens der Schutzeinrichtungen nicht mehr beherrschbar wäre.“ (Ende des Zitats).

· Mehrfach wird auf die Beeinflussung der Netze der Nachbarländer durch die auf deutscher Seite ergriffenen Maßnahmen kritisch eingegangen. Diese Passagen werden im Kapitel 15 zitiert.

Ende November 2011 legte dann die Bundesnetzagentur ihren „Monitorbericht 2011“ vor, der zahlreiche weitere bemerkenswerte Aussagen enthielt (9):

· „Insgesamt konnte festgestellt werden, dass die derzeitige Situation im Netzbereich zwar beherrschbar ist, jedoch geht sie mit einer erhöhten Eingriffshäufigkeit der Netzbetreiber in den Systembetrieb einher. Nach wie vor ist die Netzinfrastruktur im Elektrizitätsbetrieb jedoch sicher und stabil.“ Anmerkung: Diese Aussage geschah kurz vor den äußerst kritischen Situationen in den darauf folgenden Winterwochen.

· „Das …hohe Niveau der Versorgungssicherheit mit Elektrizität kann zukünftig nur durch massive Investitionen auf allen Netzebenen gewährleistet werden.“

„Das Energieleitungsausbaugesetz EnLAG benennt 24 Projekte, die vorrangig zu realisieren sind. Zwei dieser Projekte wurden fertig gestellt. Bei 12 der 24 EnlAG-Projekte sind deutliche Verzögerungen im Genehmigungs- und Realisierungsplan zu beobachten, so dass die jeweils vorgesehene Inbetriebnahme teilweise um mehrere Jahre überschritten wird.

Etwa 214 km von 1807 km an neu zu errichtenden Trassen sind bislang fertig

gestellt“.

Von 149 insgesamt bis 2014 vorgesehenen Ausbaumaßnahmen (Anm.: an existierenden Trassen) unterläge Mitte 2011 die Hälfte – d.h.73 Projekte – Verzögerungen. Dementsprechend dokumentierten auch die gemeldeten Investitionsdaten „erneut die erheblich hinter den Planungen zurückbleibende Realisierung von Neu- bzw. Ausbauvorhaben der Übertragungsnetze (Anm.: der Höchstspannungsnetze)“.

· Gründe für die Verzögerungen seien:

„Verzögerungen im behördliche Genehmigungsverfahren – beispielsweise auf

Grund von Widerstand der lokalen Bevölkerung; Klagen gegen

Planfeststellungsbeschlüsse; Lieferengpässe, technische Gründe..“.

· Zu den Verteilernetz-Betreibern: Diese hätten „die Option, auch EEG-Anlagen herunterzuregeln, wenn die Erzeugung aus erneuerbarer Energie vom Netzbetreiber nicht abgenommen werden kann, weil kein konventionelles Kraftwerk mehr zum Ausgleich heruntergeregelt werden kann“. „Im Jahr 2010 ist die durch das Herunterregeln entstandene Ausfallarbeit von EEG-Anlagen im Vergleich zum Jahr 2009 insgesamt um über 70% angewachsen. Dies zeigt die weiter steigenden Herausforderungen, denen die Netze (Anm.: alle Netzebenen) im Hinblick auf den rasanten Zuwachs der erneuerbaren Energien bereits jetzt, insbesondere aber in den nächsten Jahren, ausgesetzt sein werden“.

· Die Kommentierung der Strompreisentwicklung durch die Bundesnetzagentur wird im Kapitel 16 zitiert.

Die Politik entdeckt das regionale Verbundnetz

Bereits lange vor dem Abschalten der 7+1 KKW hatten sich die Probleme aufgetürmt:

Mit den nicht vom Markt, sondern durch die Zwangssubvention des EEG kräftig wachsenden Installationen von Windrädern und Photovoltaikanlagen entstanden zwei Probleme, die die Große Koalition überhaupt nicht und die Schwarz-Gelbe Regierung erst nach massiven Warnungen der Netzbetreiber ernst nahmen:

Problem Nr.1: Zum einen bemerkte man schließlich, dass der größere Teil der Windstromanlagen in Norddeutschland liegt, wo man aber deren Strom nicht brauchen kann. Anders in Süddeutschland, wo es nach der Abschaltung mehrerer der dortigen Kernkraftwerke durchaus einen Bedarf gäbe – wenn es dafür ausreichend dimensionierte Nord-Süd-Höchstspannungsleitungen gäbe. Was nicht der Fall ist.

Problem Nr.2: Zum anderen bemerkte man bis zum Oktober 2011 nicht, dass es auch noch ein zweites gravierendes Netzproblem gibt: Im weitaus größeren regionalen Verteilungsnetz, das technisch nur für die Versorgung der Abnehmer, keineswegs aber für die stark schwankende Stromaufnahme aus vielen dezentralen Windparks und Photovoltaikanlagen (s.u.) und die Weiterleitung dieses Stroms in das Höchstspannungsnetz ausgelegt ist (20).

Zum Problem Nr. 1: Für eine bessere Abnahme des Windstroms wünscht die Regierung bereits bis 2020 den Bau von 3000 km neuen Höchstspannungsleitungen von Nord- nach Süddeutschland. Der ehemalige Wirtschaftsminister Brüderle legte am 21.3.2011 „Eckpunkte für den Stromnetzausbau“ vor: „Es würden etwa 3.600 km neue Leitungen benötigt."

Die Deutsche Energie-Agentur Dena rechnet jedoch mit erforderlichen 4.450 km an zusätzlichen Höchstspannungsleitungen und die parlamentarische Staatssekretärin im BMU, Katherina Reiche, nannte kürzlich 4200 km. Weil die abgeschalteten Kernkraftwerke zuvor ganz wesentlich zur Stabilisierung des Netzes beigetragen hatten, das mit der schwankenden Ökostromproduktion zu kämpfen hat, – sie können Leistungsschwankungen am schnellsten von allen Kraftwerken durch massives Gegensteuern ausgleichen (das sog. Lastfolgemanagement) – mussten zuletzt immer häufiger Windparks zwangsweise abgeschaltet werden. Allein 2010 gingen dadurch ca. 150 Millionen kWh verloren.

Auch die Anbindung der neuen Offshore-Windparks an das Netz an Land gerät in Turbulenzen: Soeben warnte der Netzbetreiber Tennet, der in Norddeutschland das E.ON-Stromnetz übernahm, die Bundesregierung in einem Brandbrief vor Engpässen (siehe Kap. 6).

Wie die Bürger auf die Aussicht auf den geplanten massiven Ausbau der Hochspannungstrassen reagieren, wird in Kap. 14 näher beschrieben. Der bremsende Einfluss der vielen Bürgerinitiativen wird von den Netzbetreibern jedenfalls als noch ernster betrachtet, als die langen Genehmigungszeiträume.

Aber auch einer eingespielten Maschinerie für die Illumination des Bildes einer vollkommen auf „erneuerbaren“ Energiequellen beruhenden Zukunft passiert hin und wieder ein Fehler – bzw. kommt versehentlich ein Stückchen Wahrheit ans Licht:

Das Bundesumweltministerium BMU hat am 3.5.2011 den „Entwurf des Erfahrungsberichts 2011 zum Erneuerbare-Energien-Gesetz“ veröffentlicht. In diesem stehen auf Seite 38 und 39 bemerkenswerte, fast resignierende Sätze:

„Es muss davon ausgegangen werden, dass der Netzausbau auch künftig nicht in dem erforderlichen Maß vorankommen wird.“ (Im o.e. Fortschreibungsbericht der Bundesnetzagentur (2) kann man die Gründe nachlesen.)

Und weiter heißt es:

„Obwohl sich die betroffenen Netzbetreiber bemühten, die bestehenden Netzengpässe im Verteilnetz zu überwinden, stieg die durch das Einspeisemanagement abgeregelte Strommenge (Anm.: Das heißt: die abgelehnte Grünstrom-Aufnahme ins Netz) aus Windenergieanlagen von 2004 bis 2009 auf das 7-fache an. Einzelne Netzausbaumaßnahmen an kritischen Stellen im Netz könnten große Wirkung entfalten und diesen Trend abschwächen. Dennoch dürfte das Einspeisemanagement mit zunehmendem Ausbau der erneuerbaren Energien weiter an Bedeutung gewinnen, weil es zunehmend zu Netzengpässen kommen wird.“

Zum Problem Nr. 2: Wie im Kap.6 „Solarstrom..“ beschrieben, treten Netzprobleme keineswegs nur im Hochspannungsnetz auf, das mit dem Transport der Windstrom-Schwankungen nicht fertig wird, sondern sie zeigen sich zunehmend auch in den unteren Spannungsebenen. Dafür sind die immer zahlreicher werdenden Photovoltaikanlagen, insbesondere Solarparks, aber auch Windparks im Binnenland verantwortlich, die mit ihren wetterabhängigen Schwankungen das nicht für Tausende von Stromeinspeisern ausgelegte regionale Netz in Schwierigkeiten bringen (20).

Man kämpft jetzt mit dem „50,2 Hertz-Problem“, der abrupten, massenhaften Selbstabschaltung der Photovoltaikanlagen bei Netzüberlastung durch zu hohe Einspeisung. Diese Sicherheitseinrichtung ist vorgeschrieben und sehr vernünftig. Nur hat die Regierung übersehen, dass sie sich damit ein neues Problem einhandelt, wenn eine riesige Anzahl von PV-Anlagen, mit der kein vernünftiger Mensch im sonnenarmen Deutschland je rechnen konnte, das gleichzeitig tut.

Die nun notwendige technische Nachrüstung aller PV-Anlagen mit automatischen Meß- und Abschaltgeräten sowie die mit Gewissheit auch hier künftig praktizierte Entschädigung der PV-Betreiber für den nicht gelieferten Strom würde wohl unweigerlich wieder den Stromverbrauchern aufgebürdet werden.

Als notwendige Abhilfe gilt deshalb der Ausbau nicht nur der höchsten, sondern auch der unteren Spannungsebenen mit ihren Netzen und der Einsatz von Ortsnetztransformatoren.

Dazu gab es endlich auch eine Zahl – und zwar eine sehr hohe: Katherina Reiche, parlamentarische Staatssekretärin im BMU, erklärte Ende November 2011 auf einem VDI-Kongress, dass das Netz „massiv umgebaut“ werden müsse. „Beim Höchstspannungsnetz seien 4200 km, bei den Verteilnetzen 200.000 km in moderner Netztechnik nötig.“

Sie reagierte damit vermutlich auf eine im Auftrag des Bundesverbandes Windenergie angefertigte Studie der Ecofys Germany GmbH, in der ein folgenschwerer Satz steht (eigene Ergänzungen in Klammern):

„Die Ausfallarbeit durch Abregelung (d.h. Abschalten der Wind- und Solarstrom-Einspeiser) aufgrund von Netzengpässen im Übertragungsnetz (Höchstspannungsnetz mit 380 oder 220 Kilovolt; Länge 35.000 km) ist bislang noch wesentlich kleiner als die Ausfallarbeit aufgrund von Netzengpässen im (1,7 Millionen km großen) regionalen Verbundnetz.“

Das Hauptproblem für die Netzstabilität liegt also bei den sehr viel größeren Verteilnetzen: Diese bestehen aus dem regionalen Hochspannungsnetz HV (100 oder 60 kV mit 77.000 km); dem Mittelspannungsnetz MS (30 – 3 kV mit 500.000 km) und dem Niederspannungsnetz NS (400 oder 230 Volt mit über 1 Million km) – und die zusammen sind in der Tat riesenhaft. (Daten von Verivox).

Ausgerechnet im März 2011, dem Monat des Kernkraftmoratoriums, legte der BDEW ein Gutachten zum „EEG-bedingten Ausbaubedarf des Verteilungsnetzes“ vor (20), in dem sowohl für das Energiekonzept 2020 der Bundesregierung vom 28.9.2010 (23) als auch für das BMU-Leitszenario 2020 (21) die notwendigen Ausbaumaßnahmen behandelt wurden. Erforderlich sei:

- Nach dem Energiekonzept 2020:

- HS: 350 km

- MS: 55.000 km

- NS: 140.000 km

…..mit Gesamtkosten zwischen 10 und 13 Mrd. Euro;

- Nach dem BMU-Leitszenario 2020:

- HS: 650 km

- MS: 140.000 km

- NS: 240.000 km

…..mit Gesamtkosten zwischen 21 und 27 Mrd. Euro.

Diese Ausbaukosten des Verteilungsnetzes (MS + NS) kämen somit noch zu den Ausbaukosten des Höchstspannungsnetzes (= Übertragungsnetz) hinzu.

Der Verband kommunaler Unternehmen VKU forderte deshalb in einer Erklärung vom 17.11.2011 die Politik und die Regulierung auf, ihren Blick auf diese 1,7 Mio km der Stromverteilnetze zu richten und nicht nur auf die knapp 35.000 km der Höchstspannungs-Übertragungsnetze, denn mehr als 80% der Anlagen der „Erneuerbaren Energie“ waren 2009 an die unteren Verteilnetze angeschlossen und haben diesen die Probleme gebracht..

Der VKU rechnet für einen derartigen Ausbau und die Integration der dezentralen Energieversorgung in den Verteilnetzen mit 25 Mrd € bis 2030. Darin seien die Kosten des Umbaus zur vielseitigen Mess- und Steuerbarkeit (Smart Grids) noch nicht einmal enthalten.

Auswirkungen auf den Strompreis sind unausweichlich.

Peinlich für die Regierung: Im neuen Energieleitungsausbau-Gesetz EnLAG sind nur die Höchstspannungs-Trassen des Übertragungsnetzes vorgesehen. Es ging den Gesetzesmachern nur um die Durchleitung des Windstroms von Nord nach Süd. Die Gefährdung der Stabilität des weitaus größeren Verteilnetzes durch die vielen unkontrollierten Stromerzeuger hatte man übersehen.

Die Zuverlässigkeit der Stromversorgung verringert sich systematisch

Während die Bundesregierung – im Gegensatz zu ihrer Bundesnetzagentur – die anwachsende Bedrohung der Netzstabilität herunterspielt – Röttgen bezeichnete solche Warnungen unlängst als Horrorszenario – wächst in der Industrie eben diese Sorge. Nicht aus Freude an Horrorszenarien, sondern aus konkreten Erfahrungen im Jahre der Energiewende 2011.

Das Handelsblatt berichtete am 29.12.2011 über die sinkende Qualität der Stromversorgung: „Mit der beschleunigten Energiewende kommt es bereits heute zu bedenklichen Qualitätsverlusten bei der Stromversorgung“, wird Volker Schwich, der Vorstandsvorsitzende des Verbandes der Industriellen Energie- und Kraftwirtschaft (VIK) zitiert. Die Stabilität komplexer Produktionsprozesse sei bedroht – lange bevor die Allgemeinheit einen Blackout bemerkt. Kurze Unterbrechungen im Millisekundenbereich und Frequenzschwankungen führten jetzt häufiger als früher zu Problemen.

In einem Brandbrief an den Präsidenten der Bundesnetzagentur M. Kurth listet eine Tochterfirma des norwegischen Norsk-Hydro-Konzerns, der als drittgrößter Aluminiumhersteller der Welt in Deutschland an 14 Standorten Unternehmen der Al-Primärproduktion betreibt, die Probleme aus den Instabilitäten auf. Man beobachte „seit Juli 2011 eine beunruhigende Häufung aus Netz- und Frequenzschwankungen.“

In dem Schreiben werden die 5 wesentlichsten Fälle aus den vergangenen Monaten aufgelistet, die zu teuren Schäden geführt hätten. Die steigende Zahl der netzbedingten Produktionsbeeinträchtigungen sei beunruhigend. Eine solche Häufigkeit von Zwischenfällen habe es in den vergangenen Jahrzehnten nicht gegeben.

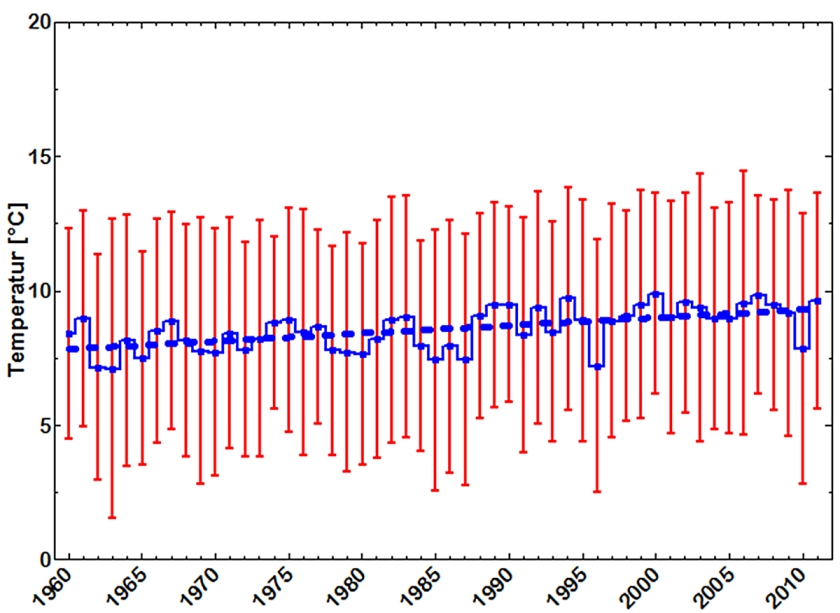

Die Bundesnetzagentur, die über die Netzstörungen eine Statistik führt, berücksichtigt aber nur ungeplante Unterbrechungen, die länger als 3 Minuten dauern. Der sich daraus ergebende Index (SAIDI) sieht deshalb optisch gut aus.

Er berücksichtigt aber aus der Sicht der Industrie nicht die sich häufenden und wachsende Probleme verursachenden Störungen von weniger als 3 Minuten Dauer.

In der kurzen Debatte um die Energiewende war die Zuverlässigkeit der Stromversorgung ein zentrales Thema. Heinz-Peter Schlüter, der Aufsichtsratsvorsitzende und Eigentümer von Trimet-Aluminium, hatte in den Anhörungen der Ethik-Kommission „Sichere Energieversorgung“ vor den unausweichlich auf die Industrie zukommenden Problemen gewarnt: Mit dem Wegfall einer zuverlässigen Stromversorgung verliere er seine Existenzgrundlage.

„Nur vier Stunden ohne Stromversorgung und die Produktionsanlagen meines Unternehmens wären irreparabel zerstört“, hatte Schlüter gewarnt.

Die Töpfer-Ethik-Kommission beeindruckte das nicht.

Der Winter 2011/2012: Noch einmal Glück gehabt

Die Bundesnetzagentur nannte in ihrem Bericht (2) die Region Hamburg als besonders bedroht. Dort reagierte man: Im November 2011 bereitete sich Hamburg auf die Möglichkeit eines totalen Stromausfalls im Winter 2011/2012 vor, wie WELT Online am 21.11.2011 berichtete.

Der Netzbetreiber 50Hertz arbeite an einem Notfallplan und verhandle bereits mit großen Stromverbrauchern über eine Abschaltung. Olivier Felix von 50Hertz: „Eine solche Situation kann eintreten, wenn im Winter bei Hochdrucklagen keine Windenergie erhältlich ist und zusätzlich das KKW Brokdorf unerwartet abgeschaltet werden muss.“ Vor nicht allzu langer Zeit gab es in dieser Region noch die KKW Stade (wird abgerissen), Brunsbüttel und Krümmel (sind stillgelegt). Deren Leistung fehlt nun.

Diese Sorge ist sehr berechtigt, wie die folgenden Meldungen zeigten:

Die Stabilität des deutschen Stromnetzes konnte im Dezember 2010 zum Teil nur dank Nachbarschaftshilfe aus Östereich aufrechterhalten werden. Bereits am 8. und 9. Dezember musste der Netzbetreiber Tennet erstmals auf die von der Bundesnetzagentur für Stromengpässe festgelegte sog. Kaltreserve zurückgreifen. Dafür musste unter anderem ein altes Öl-Kraftwerk bei Graz wieder ans Netz gebracht werden. „Die Netzsituation ist nach wie vor angespannt“, betonte damals ein Sprecher der Bundesnetzagentur.

Wie erwartet, trieb die Eiseskälte zu Beginn des Monats Februar 2012 den Strombedarf in Frankreich enorm in die Höhe – am 7.2. belief er sich auf 100.500 Megawatt. Frankreich war wie in jedem Winter auf Stromimporte aus Deutschland angewiesen, was offenbar auch dieses Mal problemlos funktionierte, denn es gab zunächst nur selbstzufriedene offizielle Kommentare.

Das führte zu triumphierenden Pressemeldungen, nach denen diese Situation ein Beweis dafür wäre, dass die abgeschalteten deutschen Kernkraftwerke sowieso überflüssig gewesen seien. „Bitter für die Atomlobbyisten“ sei das.

Nach Angaben der deutschen Energiekonzerne sei aber auch in Deutschland zu dieser Zeit der Strompreis auf 16 Cent/kWh angestiegen, weil sogar alte und teure Ölkraftwerke Strom produzieren mussten. „Fakt ist, dass man derzeit nur auf Sicht fährt“, kommentierte RWE-Chef Großmann bereits damals.

Es dauerte 5 Wochen, bis die Wahrheit endlich ans Licht kam:

Denn die Bundesnetzagentur veröffentlichte erst Mitte Februar 2012 die wahre Schreckensmeldung: Nur die Notreserven hätten im Zeitraum vom 6. Bis zum 9. Februar das Netz vor dem Blackout gerettet. „Es war sehr, sehr ernst“, hieß es am 16.2 in der Aufsichtsbehörde (lt. VDI-nachrichten vom 17.2.).

Folgendes war demnach geschehen: Wegen der Rekord-Nachfrage nach Strom von bis zu 100.000 Megawatt in Frankreich und auch eines in Deutschland hohen Verbrauchs bei extremer Kälte schnellte der Börsen-Strompreis am Spotmarkt für kurzfristige Einkäufe in die Höhe; teils zu über 350 € für die Megawattstunde. Der Run auf die knappen Strom-Ressourcen führte dazu, dass Notreserven herangezogen werden mussten – und dieses Anzapfen der Notreserven drohte das Netz in die Nähe des Zusammenbruchs zu bringen. „Das Verlassen auf diese Regelleistung wird in der Politik und der Industrie als riskantes Vabanquespiel bezeichnet“ (T. Federico, GF des Beratungsunternehmens Energy Brainpool).

Inzwischen meldete sich auch der Chef der Industriegewerkschaft Bergbau, Chemie, Energie (IG-BCE) Michael Vassiliades. Er sagte am 5.2.12: „Wir brauchen einen doppelten Schutz vor Preis- und Frequenz-Schwankungen im Netz, die wirtschaftlich nicht mehr tragbar sind“. Alles andere sei fahrlässig. (Diese Aussagen im Detail s. Kap.8).

Zur Erinnerung: Der geplante riesenhafte Ausbau des Stromnetzes ist nur eine Folge der Fehlentscheidung, die Windkraft ebenso wie die Photovoltaik so lange übermäßig durch Subventionen zu fördern, bis deren gewaltige Schwankungen und ihr unvorhersehbar auftretender Überschuss zu einer Bedrohung der Netzstabilität wurde. Ohne diese Fehlentscheidung und ohne die Abschaltung der 8 Kernkraftwerke hätte das Netz weiterhin völlig ausgereicht.

Wenn unsere Nachbarländer dem Beispiel Polens, das keinen grünen Spitzenstrom mehr hereinlassen will, folgen sollten, bricht das deutsche Stromnetz durch die selbst verschuldeten Störungen, die dann nicht mehr exportiert werden können, möglicherweise bei jedem Sturmtief zusammen. (Siehe Kap. 16 „Energiewende bedroht die Nachbarländer.“)

Doch die Geldvernichtung im Namen der Umwelt geht weiter: Die Regierung subventioniert Wind- und Solarstrom weiterhin mit dem EEG und bekämpft anschließend mit weiteren Milliarden die eben dadurch verschärften Probleme….

….16. Für Industrie und Bürger wird es immer teurer – die "Energiearmut" wächst

Es ist eine eiserne Regel der Marktwirtschaft, die auch für Ideologen, Weltverbesserer oder Zwangsbeglücker gilt: Verstöße gegen die Prinzipien der Wirtschaftlichkeit werden durch Preiserhöhungen bestraft. Die deutsche Energiepolitik insbesondere der letzten und der gegenwärtigen Regierung führt exakt zu diesem Ergebnis.

Das stärkste Werkzeug zum Umwandeln einer Marktwirtschaft in eine Planwirtschaft ist seit dem Jahre 2000 das Erneuerbare-Energien-Gesetz (EEG).

Es ist nach wie vor in Kraft.

Der durch das EEG bewirkte Zuwachs an Windkraft-, Photovoltaik- und Biogasanlagen, deren Stromerzeugung von den Netzbetreibern vorrangig angenommen und mit den bekannten hohen Einspeisevergütungen bezahlt werden muss, führt zu beständig steigenden Strompreisen, weil diese Kosten auf die Verbraucher abgewälzt werden dürfen. Alle Preissteigerungen für Mineralöl- und Gaslieferungen werden durch die hohen Steuern noch verstärkt. Deutschlands Energiesteuern und –abgaben zählen bekanntlich zu den höchsten in Europa:

– Die gesetzlich verursachten Belastungen des Strompreises in Form von Abgaben und Steuern stiegen 2011 auf 46%.

– Die darin enthaltene, stetig ansteigende EEG-Umlage betrug 2011 3,530 Cent/kWh zusätzlich 0,67 Cent/kWh MWSt und lag damit bereits bei 17% Anteil am Haushaltsstrompreis.

– Bei Industriebetrieben, die die volle EEG-Umlage entrichten müssen, ist der relative Anteil aufgrund des geringeren Preisniveaus für Industriekunden noch höher: Dieser Anteil am Strompreis liegt 2011 für einen mittelspannungsseitig versorgten Industriebetrieb bei 26% (90).

Eine Umverteilung zu Lasten der privaten Haushalte

Wie ernst diese Situation für die energieintensiven Industrien – Chemie, Papierindustrie, Düngemittelindustrie, Glaswerke, Stahlwerke, Baustoffindustrie, Aluminiumhersteller, Metallverarbeitung – bereits geworden ist, ist der Regierung bereits durch Wirtschaftsverbände und Gewerkschaften klar gemacht worden.

Der SPIEGEL brachte vor kurzem unter dem Titel „Ofen aus“ einen sehr kritischen Bericht über die Wirkung der Energie-Preissteigerungen auf die Unternehmen – mit konkreten Beispielen zu Oettingers Vorhersage (63).

Die Reaktion der Regierung war bezeichnend: Der Staat verzichtet keineswegs auf seine vielfältigen Steuern und Abgaben auf den Strompreis, die ihn hier dermaßen teuer machen. Er verteilt die Lasten einfach um.

Ein Entlastungs-Instrument dafür ist die o.g. am 28.7.2011 geänderte Verordnung (StromNEV), die unauffällig im Konvoi anderer Energiewende-Gesetze versteckt und die von der Presse erst nach einem Vierteljahr entdeckt wurde.

In dem für Laien praktisch unlesbaren Juristenchinesisch verbirgt sich im §19 ein Goldesel: Unternehmen mit einem hohen Verbrauch werden fast komplett von den Netzgebühren befreit – und auch noch rückwirkend für das laufende Jahr.

Unternehmen, die mindestens 7000 Stunden jährlich am Stromnetz hängen und mehr als 10 Millionen kWh Strom verbrauchen, müssen gar keine Netzgebühren mehr bezahlen.

Bereits ab einem jährlichen Stromverbrauch von 100.000 kWh sinken die Netzkosten deutlich, so dass Tausende Unternehmen nicht den vollen Preis zahlen müssen.

Die dadurch von den Unternehmen gesparten Netzkosten werden voll auf den Strompreis umgelegt – also von den Verbrauchern bezahlt. Geschätzt wird, daß die Strompreise allein durch diese Netzkostenermäßigung um 0,75 bis 1,0 Cent / kWh steigen könnten. Pro Haushalt mit ca. 4000 kWh Jahresverbrauch wären das bis zu 40 Euro mehr.

Und noch eine zweite Entlastung gab es: „Stromintensive Unternehmen des produzierenden Gewerbes mit einem Jahresstromverbrauch von mehr als 100.000 MWh (Megawatt-Stunden) sowie einem Stromkostenanteil an der Bruttowertschöpfung von mehr als 20 Prozent….gelten als privilegierte Letztverbraucher und müssen grundsätzlich nur eine begrenzte EEG-Umlage in Höhe von 0,05 Cent/kWh auf ihren Stromverbrauch entrichten“ (90).

„Die Industrie zu entlasten und allein die Kleinverbraucher die Zeche zahlen zu lassen, ist eine Dreistigkeit, die bisher ohne Beispiel ist,“ zitierte die „Frankfurter Rundschau“ Verbraucherschützer Holger Krawinkel.

Aber das ist das durchgängige Prinzip bei der Energiewende. Sie beruht schließlich ganz wesentlich auf der Schröpfung der Bürger durch ihre Zwangsbeglückung mit zu teurer Energie. Mit dieser fortgesetzten Umverteilung zu Lasten der kleinen Leute dürften die Warnungen des Energiekommissars vor dem Ende des sozialen Friedens Wirklichkeit werden.

Auf die Bürger kommen aber noch eine Reihe neuer Kosten zu:

■ Die Folgen des Erneuerbare-Energien-Gesetzes.

Die folgenden Angaben stammen aus der Veröffentlichung vom 15.10.2010 der 4 Übertragungsnetz-Betreiber (ÜNB), die per Gesetz verpflichtet sind, jeweils am 15.10. eines Kalenderjahres die EEG-Umlage – das sind die durch das EEG verursachten Mehrkosten, die den Endverbrauchern aufgebürdet werden – für das folgende Jahr zu ermitteln:

„Die ÜNB haben…auf Basis von Prognosen unabhängiger Gutachter für 2011 eine EEG-Einspeisevergütung in Höhe von 16,7 Mrd. € ermittelt. (Anm.: Davon gehen unglaubliche 8,38 Mrd. € an die Photovoltaik-Betreiber, die aber nur klägliche 1,9% der deutschen Stromerzeugung beisteuern.)

Der prognostizierte Gegenwert des eingespeisten Stroms liegt bei 4,7 Mrd. €.

Zusätzlicher Differenzbetrag (aus 3 Quartalen von 2010): 1,1 Mrd. €.

Insgesamt werden somit rund 13 Mrd. € über die EEG-Umlage refinanziert.“

Dies ist die Summe, die die Endverbraucher zusätzlich für den grünen Strom aufzubringen haben.

„Wie die 4 ÜNB mitteilen, bedeutet dies im Jahre 2011 eine Belastung von

3,530 Cent pro kWh.

Für das Jahr 2010 betrug die EEG-Umlage 2,047 Cent pro kWh.“

Das ist eine Steigerung von 73% in nur einem Jahr.

Das bedeutet für einen Haushalt mit einem Jahresverbrauch von 2500 kWh:

- 88 € Mehrkosten durch das EEG im Jahre 2011

- gegenüber 51 € im Jahre 2010.

Wesentlich interessanter ist aber die Vorhersage für 2012:

Die Bundeskanzlerin hatte noch im Sommer 2011 erklärt: „Die EEG-Umlage soll nicht über ihre heutige Größenordnung hinaus steigen. Heute liegt sie bei etwa 3,5 Cent / kWh.“ Umweltminister Röttgen versprach das Gleiche.

Für 2012 hatte die Bundesnetzagentur anschließend angekündigt, dass die EEG-Umlage bei 3,6 Cent / kWh liegen werde.

Nun zeigt die neue Prognose der Netzbetreiber vom 15.10.2011 für das Jahr 2012, „dass die Bandbreite der Ökostrom-Umlage zwischen 3,66 und 4,74 Cent / kWh liegen wird.“

Auch die Deutsche Energie-Agentur Dena widersprach Anfang Dezember: „Es wird nicht gelingen, die EEG-Umlage auf etwa 3,5 Cent pro Kilowattstunde zu begrenzen,“ sagte Dena-Chef Stephan Kohler der „Frankfurter Rundschau“.

Laut Kohler ergeben Dena-Berechnungen, dass die Umlage 2013 bereits knapp unter 4 Cent und 2020 bei 5 bis 5,5 Cent liegen wird. Für einen 3-Personen-Haushalt bedeutet das ca. 210 Euro Mehrkosten.

Im Januar 2012 lagen der Strompreis um 3 % und der Gaspreis mit 6,7 % über dem Preis des Vorjahres, wie das Statistische Bundesamt mitteilte.

■ Die Mieter trifft die Energiewende doppelt:

Das Gesetz zur Energieeinsparung in Gebäuden hat sich zu einer ernsten finanziellen Bedrohung für die Mieter entwickelt. Denn zu den ständig steigenden Stromkosten kommt im Falle einer Energiesanierung eines Miethauses eine kräftige Mieterhöhung hinzu. „Mieter zahlen für die Energiewende drauf“, sagte Mieterbundchef Bernhard von Grünberg dem Bonner Generalanzeiger.

Nach geltendem Recht können Vermieter elf Prozent der Modernisierungskosten auf die Jahresmiete aufschlagen. Im Schnitt steigt die Miete nach einer Energiesanierung um 2,40 € pro qm, die Energieersparnis aber beträgt nur 50 Cent. „Die Miete steigt real um 1,90 € pro Quadratmeter,“ rechnet Grünberg vor.

Der NRW-Mieterbund lehnt den Kabinettsentwurf der Mietrechtsreform des Bundes mit der weiterhin enthaltenen 11-Prozent-Kostenumlage auf die Mieten ab.

Die Wohnungsgesellschaft LEG hat in Ratingen festgestellt, dass viele Rentner wegen der gestiegenen Heizkosten ihre Heizung nicht mehr einschalten.

Inzwischen wird die Forderung nach Sozialtarifen für einkommensschwache Verbraucher erhoben und von der Politik – noch – abgelehnt.

■ Weitere Strompreiserhöhungen drohen durch die 2011 beschlossenen Energiewende-Pläne sowie durch die Umsetzung einiger bereits 2010 eingeleiteter Vorhaben :

· Die Abschaltung von 8 Kernkraftwerken entzog dem europäischen Stromverbund schlagartig 9000 MW Grundlast. Der Strompreis stieg sofort an der Börse. Schätzungen belaufen sich auf +20% – und nicht nur für Deutschland. Die Netzbetreiber – s.o. – konnten das bei ihrer Prognose vom Oktober 2010 noch nicht einbeziehen.

· Eine große Zahl von energieintensiven Unternehmen hat – unbemerkt bei der Verkündung der Energiewende – von der Regierung eine weitgehende Befreiung von den Netzentgelten zugestanden erhalten. Mit der Überwälzung der dort eingesparten Kosten wieder auf die Endverbraucher. Auch das kommt noch hinzu.

· Falls der riesenhafte geplante Ausbau des Höchstspannungsnetzes tatsächlich in Gang kommt – vieles spricht dagegen – dann werden alle damit verbundenen Kosten auf den Strompreis draufgepackt.

· Der Ausbau von Windkraft – speziell die teure Offshore-Windkraft – und von Photovoltaik und Biogaserzeugung geht unvermindert weiter. Nur bei der Photovoltaik voraussichtlich langsamer, aber wegen ihrer hohen Kosten weiterhin preistreibend. Damit steigt die EEG-Umlage weiter.

· Es ist zu erwarten, dass die Regierung in Anbetracht der Unwilligkeit der Kraftwerksbetreiber, neue Gaskraftwerke zu bauen, dies mit Steuergeldern und Steuerermäßigungen anregt, da sich Gaskraftwerke als einzige fossile Kraftwerke der Sympathie der Regierung erfreuen. Leider ist der von ihnen erzeugte Strom wegen der hohen Gaspreise sehr teuer. Dann zahlen die Bürger wieder mehr.

· Falls es der Regierung wider Erwarten gelingen sollte, Zugang zu norwegischen Wasserkraftwerken als Speicher für Überschuss-Windstrom zu erlangen, wird Windstrom teurer. Dann steigt die EEG-Umlage.

· Es ist zu befürchten, dass die weiter zunehmende und in der Fläche verteilte Photovoltaik die bereits sichtbaren Netzprobleme in der regionalen Mittelspannungs-Ebene derart verschärft, dass zusätzlich zu den ohnehin geplanten 3000 oder 4400 km Hochspannungstrassen noch ein starker Ausbau der regionalen Stromleitungen nötig wird. Diese Netze sind nicht auf viele Einspeiser ausgelegt, die Sonnenlicht-abhängig je nach Wetterlage kurzfristig extreme Leistungsspitzen erzeugen können. Die Verbraucher werden das dann ebenfalls zu bezahlen haben.

· Weil sich lt. BDEW wegen der Außerbetriebnahme älterer fossiler Kraftwerke und der geringen Neubau-Aktivität bis zum Jahr 2030 eine Erzeugungslücke von ca. 33.000 MW auftun wird, wird dort über „neue Mechanismen und ein anderes Marktdesign für die Strompreisfindung“ diskutiert. Eine Option seien „Kapazitätsmechanismen“. Im Klartext: Mit einer zusätzlichen Vergütung sollen Investitionen für die „Vorhaltung von Erzeugungsleistung“ – also den Bau von dann zumeist stillstehenden Kraftwerken, die bei Engpässen einspringen können – angeregt werden. Diese Investitionen unterbleiben heute logischerweise wegen der durch das EEG verursachten zunehmenden wirtschaftlichen Unattraktivität von Kraftwerksneubauten (6).

In dieselbe Kerbe schlägt die Bundesnetzagentur (9):

Weil in Süddeutschland, das bereits besonders hart von der Abschaltung von

Kernkraftwerken betroffen ist, künftig (bis 2022) sogar mehr Kraftwerke außer

Betrieb gehen werden, als neue auch nur geplant sind, wird vorgeschlagen, „über

Allokationsanreize (= vornehme Bezeichnung für Subventionen) für den Neubau

von Kraftwerksleistung nachzudenken.“

· Der BDEW scheint auch in Anbetracht der von ihm erwarteten Unrentabilität von Kraftwerksneubauten – sie würden zu 40% der Zeit still stehen – die Hoffnung auf ausreichend Neubauten zur Netzstabilisierung aufgegeben zu haben (6): Es schlägt deshalb vor, die am Ende ihrer im Durchschnitt 40-jährigen Lebensdauer stillzulegenden Altkraftwerke unbedingt weiter zu betreiben – natürlich mit umfangreichen Reparaturen, Nachrüstungen und Modernisierungen. Dies könnte „bei entsprechenden ökonomischen Rahmenbedingungen“ – also Subventionen – „einen substanziellen Beitrag zur Deckung des Bedarfs an Kraftwerkskapazität liefern“. Wer das dann bezahlen darf, ist klar.

· Eine deutliche Warnung vor den dramatischen Folgen des steigenden Strompreises für Deutschland gab es mehrfach im Jahre 2011 von EU-Energiekommissar Günther Oettinger. Hohe Energiekosten gefährdeten nicht nur den Wirtschaftsstandort, sondern auch den sozialen Frieden, wenn ein Teil der Menschen die Stromrechnung nicht mehr bezahlen könne. "Ich bin überrascht, wie gedankenlos die Entwicklung der Strompreise hingenommen wird“, sagte Oettinger. Deutschland zähle weltweit zu der Spitzengruppe bei den Strompreisen.

· Weil der Offshore-Windpark-Netzanbinder in Schwierigkeiten geraten ist, ertönt auch aus dieser Richtung der Ruf nach noch mehr Staatsgeld: Der in Finanzierungsproblemen steckende Netzbetreiber Tennet, der gesetzlich zum Anschluss aller Windräder in der Nordsee verpflichtet ist, hatte eine Idee: In einem Brief an den Bundeswirtschaftsminister schlug er vor, dass es „vor weiteren Aufträgen für den Anschluss von Offshore-Windparks bei der Haftung neue Regelungen geben müsse“. Denn: „Wo Versicherungen nicht mehr einsprängen, müsse eine „Sozialisierung der Schäden“ (!) ermöglicht werden“ (85). Treffender kann man es nicht ausdrücken.

Auch der Energiekonzern E.on, der unter Verweis auf die Verzögerungen durch Tennet dramatisch „Deutschland vor Scheitern der Windkraft“ warnte (86), kritisierte, dass „die finanziellen Anreize für die Netzbetreiber unzureichend“ seien. Die Regulierungsbehörde müsste daher Investitionen „höher vergüten“.

· Die Errichter von Offshore-Windparks haben ebenfalls bereits schmerzliche Erfahrungen mit großen Kostensteigerungen und Verzögerungen gemacht. Der Anlagenbauer Bard aus Emden, der den bisher größten Windpark in der Nordsee vor Borkum errichtet, ist in Finanzierungsschwierigkeiten geraten. Sollten derartige Kostensteigerungen den Unternehmen untragbar erscheinen, genügt vermutlich die Ankündigung, den Bau der Windparks einzustellen, um zusätzliche Steuermittel locker zu machen (87).

· Die Offshore-Windkraft bringt auch neue Förderungskandidaten hervor: Birger Nicolai schrieb im Dezember 2011: „Das Rennen um öffentliche Gelder droht aus dem Ruder zu laufen: Selbst Häfen wollen sich den Umbau ihrer Kaianlagen vom Staat bezahlen lassen“ (87).

Energiearmut droht