Hans von Storch und Nico Stehr sehen es als falsch an, den Eindruck zu erwecken, als seien die naturwissenschaftlichen Grundlagen des Klimaproblems im Wesentlichen gelöst.[2]

Die beiden letztgenannten sind nicht die einzigen „Wissenschaftler“, die „tendenziösen“ „öffentlichen“ Verlautbarungen misstrauen. Aber nicht die Quantität von Wissenschaftlern entscheidet über die Gültigkeit einer Hypothese/Theorie, sondern die Falsifizierbarkeit. Nur im Falle der Erfüllung dieser Voraussetzung kann eine einheitliche Vorhersage erzeugt und eine eindeutige Bedeutung der Daten aus einem Klimamodell hergeleitet werden.[3] Daten sollten also jederzeit und von jedermann überprüft werden können, ja zumindest einsichtig und nachvollziehbar sein. Szenarien auf der Grundlage einer These eines Treibhauseffektes und Unsicherheiten z.B. über die Wolkenbildung repräsentieren keine geschlossene wissenschaftliche Klimatheorie, sondern sind so etwas wie Studier- und Abschätzungsobjekte. Das gilt auch für die Heranziehung von sogenannten Paläo-Proxythermometrie-Daten, um die Vergangenheit der Oberflächentemperatur der Erde aufzuhellen; ihre Brauchbarkeit muss mindestens eingeschränkt werden.[4

Wie komplex das Gedankenobjekt „Klima“ oder gar das „globale Klima“ [5] ist, worunter die Gesamtheit meteorologischer Vorgänge in der Erdatmosphäre mitsamt seinen prozessualen Einflüssen verstanden wird, zeigen die unterschiedlichen Modelle, die man sich davon macht.

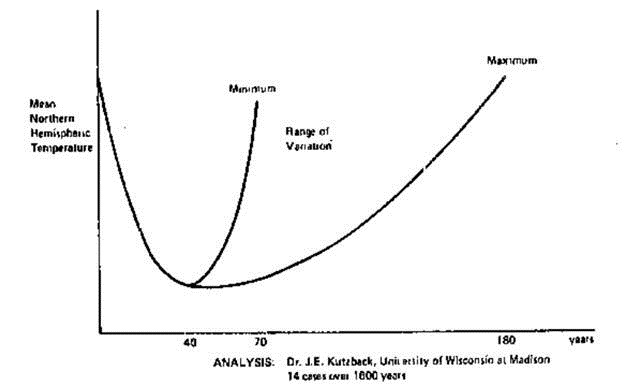

Sicher ist eines: die solaren Energie-Einträge zur Erde schwanken periodisch und sind von daher berechenbar. Gleichzeitig steigt die Erkenntnis, dass die in der Erdkruste verborgenen Energie-Vorräte nicht nur endlich, sondern mit unterschiedlichem wirtschaftlichem Aufwand nutzbar sind. Schon aus einem drohenden „Aus“ der Gewinnung solcher (fossilen brennbaren) Rohstoffe ist bei den Menschen eine Vorsorge für die Zeit danach verständlich. Aus der irdischen und der geschichtlichen Vergangenheit wissen wir zudem, dass das Leben bestimmende Klima den tierischen Warmblütern nicht immer günstig, ja sogar zeitweise für die Menschen existenzbedrohend war. Auch ist bekannt, dass es Warm- und Hitzezeiten für gewisse Regionen der Erde gab, die Flüsse versiegen und Wasser verdunsten, die Oberfläche austrocknen ließ und die Menschen zum Wandern ais ihrer „Heimat“ zwang. Es galt nunmehr, solche Ereignisse zu vermeiden, falls dazu der Mensch in der Lage ist.

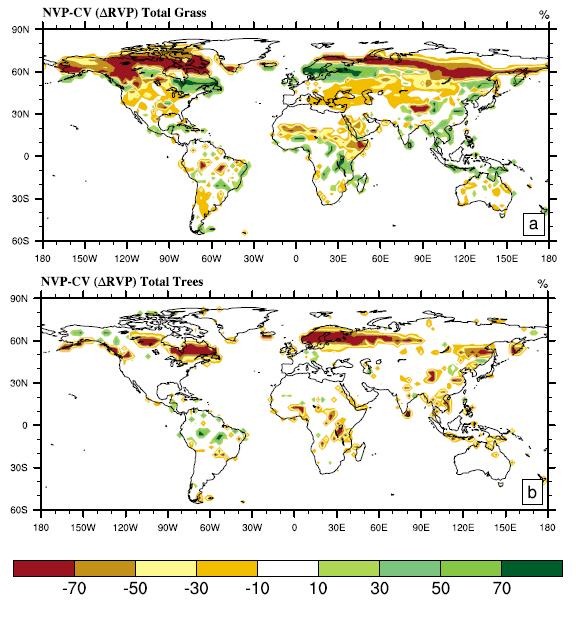

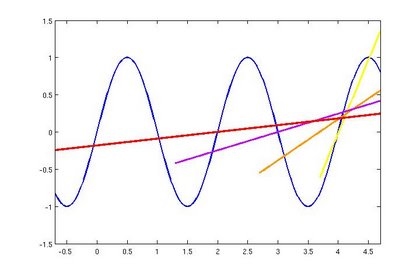

Nicht ungewöhnlich war und ist es, wenn der Mensch sich der ihm umgebenden Natur bemächtigt und sie radikal ausnutzt; so holzte er zügellos die Baumbestände ab für Bauten und zum Holzverfeuern. Mit zunehmendem Bedarf wurden solche Verhältnisse dramatischer, besonders, wenn der Verbrauch rasant steigt. Da scheint die Überlegung naheliegend, dass solches Handeln gestoppt werden muss, wobei zwei Dinge aufeinander stoßen: das energetisch bedingte[6] Erschöpfen der Vorräte und die damit in Verbindung gebrachte klimatische Erwärmung. Anders ausgedrückt: das Produkt der Verbrennung kohlenstoffhaltiger Vorräte zu Kohlendioxid, erkenntlich an deren Verbrauch und deren Emission in die Atmosphäre[7]. Nun fehlen nur noch der Gedanke und auch der Nachweis, dass durch die Annahme, dass Kohlendioxid zur Intensivierung des Energieeintrages in die für den Menschen wichtige Atmosphärenschicht ursächlich für die Bedrohung der menschlichen Existenz ist. Dazu könnten die Wärmestrahlungsgesetze dienen, da eigentlich ohne eine Sonnenstrahlung kein Leben auf der Erde möglich ist. Der Prozess des energetischen Austausches der beteiligten System-Elemente Sonne, Erde und die der Atmosphäre ist aber global weder gesamtheitlich bekannt noch (messtechnisch) quantifizierbar, weshalb man zu vereinfachten Vorstellungen übergeht, d.h. die Schwankungen einerseits durch Mittelwert-Bildung[8] und andererseits durch idealisierte Gang-Charakteristiken zu ersetzen.[9] Obwohl die meßtechnischen Daten für eine statistische Auswertung ungenügend sind, nutzt man weltweit eine Temperatur-Verteilung der an 2m-Höhe gebundenen bodennahen Temperaturen.[10]

Dass in verschiedenen Regionen der Erde die Wolkenerscheinungen wichtiger Bestandteil des Klimas sind, ist bekannt; die sichtbare Ansammlung von Wasser in der Atmosphäre in den Strahlungsaustausch-Prozess ein. Aber auch hier wissen wir wenig; die Forschung versucht, in der Niederschlagsphysik die sich abspielenden Prozesse zu verstehen[11] und die Wiederholbarkeit von irregulären Niederschlags-Prozessen zu erfassen. Ähnliches ist von der Dynamik der Luftmassen-Bewegungen, die verantwortlich für den Gastransport sind, zu sagen. Um z.B. Zirkulationsmodelle global praktisch anwenden zu können, muss man daher verschiedene Annahmen treffen, um die numerische Modellierung weiter voran zu treiben.

Insgesamt kann man sagen, dass für eine genauere Prognose die dazu existierenden Schätz-Daten noch nicht ausreichen, um sicheres Vertrauen in die Verkündungen auf Basis des jetzigen Wissensstandes zu wecken, zumal die verschiedenen Prozessverknüpfungen[12] z.T. nur erahnt werden. Maßgebend ist nicht das erforschte Detailwissen, sondern infolge der Datenlücken der Vermutungsgrad, wie diese mit Annahmen ausgefüllt werden. [13]

Ein deutliches Zeichen für die anzuwendende Vorsicht gibt da die Beschränkung einer Übernahme von Ausbreitungsmodellen in die technische Normung und Gesetzgebung.[14] Die Ausbreitung von Luftschadstoffen muss schließlich meßteschnisch real ermittelt werden.

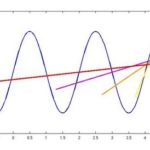

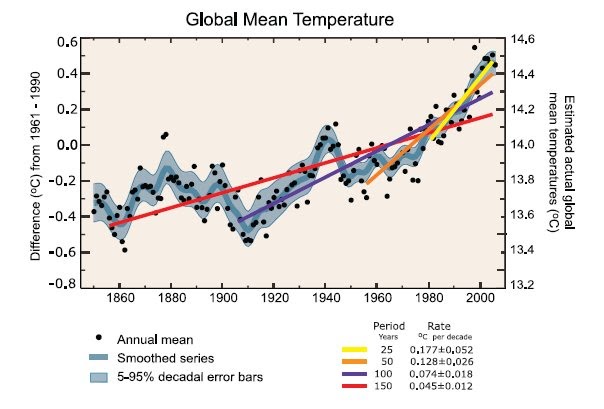

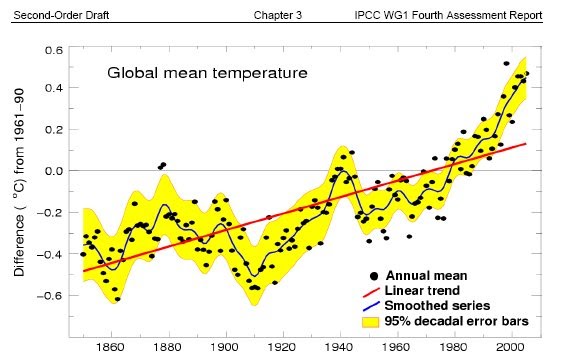

Wenn man die atmosphärischen Prozesse mathematisch darstellen und damit die Gesundheit der Hypothesen prüfen will, muss man den Umfang auf verfügbare und zugleich zuverlässige Daten reduzieren, muss man bei der Berechnung Einschränkungen vornehmen und bei Datenlücken womöglich einen Verlauf rekonstruieren[15]. Diesen Vorgang muss man komplett angeben, sonst handelt man sich den Vorwurf inkorrekter Veröffentlichung ein. So gehören insbesondere die globale (bodennahe gemittelte) Temperatur aus Daten inhomogen verteilter Messstationen[16] und der Kohlendioxid-Gehalt in der Atmosphäre zu diesem Daten-Ensemble[17]. Beide Daten sind inkonstant, sie werden laufend in neuen Zuständen angetroffen, weshalb man sich trotz der durch Messung und Auswertung vorhandenen Aussage-Risiken deren relevante Daten über Mittelungen[18] zu beschaffen versucht. Hierzu benutzt man Prozess-Vorstellungen und Erscheinungen der Häufigkeit (Histogramme) in der Annahme, es gäbe reguläre Verteilungen von einzelnen Prozess-Parametern[19] und seltene Ereignisse wie Vulkan-Ausbrüche usw. könne man vernachlässigen. Beim Wetter scheint es offenbar (nur angenähert) genaue Wiederholvorgänge über der Zeit[20] zu geben, weshalb man eine Langzeit-Statistik bei der Voraussage zukünftiger Verhältnisse zu Hilfe nehmen muss.[21] Dabei muss berücksichtigt werden, dass das Messen und die zu messende (physikalische) Größe als eine Veränderliche im Klima-Prozess mit Streuungen behaftet sind. Es gibt höchstens Wahrscheinlichkeitsaussagen auf Basis von unsicheren historischen Daten.[22]

Da die Zeitreihen nicht lückenlos und wissenschaftlich nicht gleichvertrauenswürdig sind, aber für eine vernünftige Vergleichsbasis eine längere Beobachtungsperiode angesetzt werden muss, einigte man sich international auf eine Zeitbasis von 30 (nichtüberlappenden) Jahren. Es bedarf aber keiner weiteren Erläuterung, dass weder der dynamische Prozess in seinen Antrieben noch in der sich ständig wechselnden Verteilung der Luftmassen und ihrer Bestandteile (z.B. Wolken) hinreichend bekannt sind und (voll) verstanden werden noch diese Vorgänge meßtechnisch ausreichend sicher verfolgt werden können. Der Klimatologe Roger A. Pielke senior hält den Top-down-Fokus des IPCC, eine von globalen Modellen ausgehende Betrachtung generell wie auch eine auf Treibhausgase verengte Perspektive für falsch.[23] Die IPCC Szenarien sind als Momentaufnahmen des Erkenntnisprozesses zu betrachten. Zwischen den Veröffentlichungen ändert sich sowohl der Forschungsstand durch neu gefundene Zusammenhänge als auch die Realität durch unvorhergesehene Entwicklungen.

Für die Änderungen des Wetters gibt es zahlreiche Indizien und in Übertragung und Erweiterung davon des globalen Klimas, jedoch wird gerade hier und grundsätzlich ein Anspruch höherer Aussagekraft als früher erhoben, als die Menschen das Geschehen mit ihren Sinnen ohne Instrumente beobachteten und seit jeher ungewohnte Naturereignisse[24] nach der Dramatik für sie bewerteten. Heute nennt man den Ausdruck Extremereignisse, deren spezielle Ursachen man zwar nicht kennt, aber in Zusammenhang mit menschlichen Aktivitäten bringt und auch so deuten kann.[25] Die Klimaforschung stochert nicht im Dunklen. Wir sind so weit, dass wir anhand von Szenarien brauchbare Aussagen über künftige Veränderungen machen können. Das Kernproblem bleibt:

wie realistisch sind die Szenarien[26] und wie weit vermag der Mensch in den Klima-Prozess tatsächlich zu seinen Gunsten einzugreifen, eine zumindest teilweise philosophische Frage.

Es gibt verschiedene Strategien, mit denen politische Gewalten (Regierungen), einerseits unsere Kenntnisse über das Klima-System zu verbessern und andererseits möglichen Negativ-Einflüssen (für den Menschen schlechthin) zu begegnen. Die mit Klimamodellen mögliche Vorhersage des Klimas ist nur relativ, da solche Prognosen von der Wahl der Randbedingungen abhängen, im aktuellen Fall von der weiteren Entwicklung der Emission der „Treibhausgase“ über einen Zeitraum von vielen Jahrzehnten. Quantitativ sind Klimamodelle Beschreibungen und Ausdruck des Standes der Klimatheorie.[27] Nun stellen die globalen Klima-Modelle erhöhte und andersartige Ansprüche an die zu leistenden Voraussetzungen für eine Aussage-Wertigkeit[28] als z.B. für eine Meso-Klima. Und es geht

nicht nur um Möglichkeiten aus dem Resultat eines Szenarium, sondern um eine Gewissheit richtigen Handelns, die mit ökonomisch weittragenden (ökonomischen) Lasten auf die Menschen verbunden ist und die Menschheit in eine andere Zukunft transformiert.

Um eine solche Gewissheit zu erlangen, ist die Prüfung kritischer Klima-Daten unerlässlich, z. B. der globalen Referenz-Temperatur im Vergleich. Aus der Meteorologie sind bodennahe Luft-Temperaturen in 2 m Höhe bekannt, in der Vorstellung einer Erwärmung geht man von einer Abstrahlung der Oberflächen-Bestandteile Richtung Weltraum aus und vernachlässigt den Erdwärmestrom aus dem Erdinnern sowie den dieses geringen Temperaturgradienten. Über dem hohen Wasserflächenanteil besteht eine verringerte Meßdaten-Dichte. Derzeit werden die Daten der Messstationen gleichbehandelt, obwohl unzweifelhaft die strenge Vergleichbarkeit keineswegs durchgängig gewährleistet[29] scheint, die Mess-Stellen nicht immer in ein gleichförmiges Raster-Netz passen und die Zusammenfassung zu einem Ensemble sowie der zeitlichen Mess-Abstände zu einem „Mittelwert“ problembehaftet sind.[30] Die Repräsentativität ist eine sehr wichtige Forderung von Probenehmern und Statistikern.[31]

Über die Betrachtung der Daten-Zeitreihen, z.B. der globalen monatlichen Mitteltemperaturen kann man durch Regressionsanalyse z.B. einen linearen Trend einer Erwärmung bestimmen, ohne ein Mindestmaß an Bestimmtheit oder auch Angabe von Streuungsmaßen (Konfidenzintervallen) zu fordern, dann sollte man aber auch die mögliche Fehlerhaftigkeit bekunden. Gerade bei Mehrfach-Mittelungen hintereinander können wichtige Informationen herausfallen, so dass man mit Daten operiert, die nur scheinbar geeignet sind, großartige Schlüsse daraus abzuleiten.[32] Es muss daher eine Steigerung der Vertrauenswürdigkeit der globalen Temperatur-Daten im gesamten Mess- und Auswerteprogramm vorgenommen werden, um einem vorbehaltlosen Gebrauch zustimmen zu können. Die Rückschlüsse aus Proxydaten wie Eisbohrkernen sind auf Grund ihrer Probenahme nicht immer einwandfrei.[33]

Die Hypothese einer Erwärmung auf Grund eines anthropogenen Anteils von CO2 an der leichten globalen Erwärmung ist bisher nicht hinreichend bewiesen.[34] Es gibt bestenfalls Indizien, deren Bedeutungen jedoch stark umstritten sind. Man könnte auch folgern, dass wirtschaftspolitische Maßnahmen, die sich auf die CO2-Hypothese stützen, nicht ausreichend begründet sind.

Es scheint niemand genau angeben zu können, wie hoch tatsächlich der anthropogene Anteil an der jeweiligen CO2-Anreicherung und deren Verteilung in der globalen Atmosphäre ist, er könnte nur einige Prozent betragen, da einerseits die CO2-Bilanzen auf unzureichendem Datengemenge beruhen und andererseits von zu wenig vertrauenswürdigen Daten stammen.[35]

Das aber wiegt schwer, denn mit der z.Zt. geringen Zahl an Messdaten in der Atmosphäre selbst[36] kann man nicht von einer Bestätigung einer CO2-Hypothese sprechen.

Die Hochrechnung von Emissionsdaten bei unsicherer statistischer Ermittlungsbasis bestätigt lediglich eine gefühlsmäßige Einschätzung, dass der Wohlstands-Hunger laufend auch ein Verlangen nach mehr Energie-Verbrauch hervorruft. Würden alle Menschen auf der Erde auf hohem Wohlstands-Niveau leben, müssten die Schätzungen über den Zeitpunkt des Endes fossiler kohlenstoffhaltiger Vorräte korrigiert werden. Aber das ist eine philosophisch-politische Frage. Bis jetzt ist jedenfalls die von der Politik und Wissenschaftlern geforderte CO2-Emissions-Minderung durch staatliche Vorgaben nach den vorliegenden Einzeldaten ausgeblieben. Offenbar stoßen verschiedene Interessen aufeinander und – es werden nicht überall der Klimazustand und dessen anthropogene Änderung gleich bewertet.

Somit gilt festzustellen:

Es wird ein hoher Aufwand für die Enträtselung des globalen Klimas durch die Wissenschaft getrieben – und dieser wird staatlich stark gefördert. Wir wissen jedoch nicht, wie lange wir noch auf den weitgehend aufgeklärten Zustand warten müssen. Und es gilt, diejenigen Wissenschaftler, die sich nicht der in den Medien hoch begünstigten Angst-Macherei anschließen und kritisch sind einzubinden. Die zuweilen polemischen Anwürfe an diese Gruppe „zielloser Skeptiker“ sind unter Wissenschaftlern eigentlich unüblich und sie sind des Kulturniveaus und einer höheren Diskussionskultur unwürdig.

Ich bin dankbar für die schärfste Kritik, solange sie nur sachlich bleibt.

Otto von Bismarck (1815-1898).

Dr.Ing. A. Rabich, Dülmen für EIKE

Der Autor war Umweltpreisträger auf der Hannover Messe wegen Forschungsarbeiten an einen Drall-Brenn-Reaktor mit der TU Clausthal-Zellerfeld und Initiator für Normen und gesetzliche Regelungen für PCB. Sowie u.a. Obmann eines Arbeitskreises Konstruktion im Verein Deutscher Ingenieure, Düsseldorf, später von weiteren Arbeitskreisen usw.. REFA-Industrial-Engineer, Darmstadt (Arbeitsstudien/analysen) und promovierte 1977 zum Dr.-Ing. TH/FU Berlin Verfahrenstechnik

[1] http://de.wikipedia.org/wiki/Kontroverse_um_die_globale_Erwärmung 08.05.2012:17.57

[2] siehe Zitat 17 in Fußnote 1.

[3] Frank, Patrick. http.//wattsupwiththat.com/2012/03/27/nese-when-is-purported-science-not-science/’nire.60214 dort auch weitere Literaturstellen. www.eike-klim-energie-eu/news-cache/nese-wann-ist-angebliche-Wissenschaft-keine-Wissenschaft-mehr? (Übersetzung von Chris Frey)

[4] Pat Frank, Quelle und Literatur-Bezüge in (deutscher Übersetzung): www.eike-klima-energie.eu/news-cache/stellvertreter-prox-methodik-fuehrt-zu-Pseudowissenschaft 11.05.2012

[5] http://de.wikipeida.org/wiki/Klima, Klimabegriff.

[6] und stoffliche.

[7] darauf basiert die heutige Erkenntnis über den sich verändernden atmosphärischen Gehalt an CO2.

[8] Typisches Beispiel hierfür ist die Unterschiedlichkeit von Temperatur-Meßzeiten (und deren Abstände) und der Daten, bei drei Meßzeiten ist der Wert des Mittels ein anderer als über Stunden oder sogar kontinuierlich. Dazu kommen die (historischen) Änderungen der Meßzeiten und des Meldens.

[9] Singularitäten können für Prognosen nicht benutzt werden. Hupfer, 2006, S. 68. Über Gegenstrahlung siehe: http://de.wikipedia.org/wiki/Atmosphärische-Gegenstrahlung. Hier noch „Treibhausgase“, obwohl es keine die Ähnlichkeit mit einem Treibhaus erforderliche Schicht nicht gibt.

[10] die Temperaturen sind unter Nutzung des mittleren vertikalen Temperaturgradienten auf Meeresniveau reduziert worden. Hupfer, 2006, S. 69, Abb.3.22 und 3.23

[11] es gibt beachtliche Fortschritte in der detaillierten und parametrisierten Modellierung der Wolken- bzw. Niederschlagsmikrophysik in allgemeinen Wolkenmodellen. Hupfer, 2006, S. 102, Abschnitt 5.6 und S. 113, mittlere jährliche Niederschlagshöhe 1931-1961, Abb.5.14

[12] verschiedentlich Rückkoppelungsprozesse genannt. Was nun die „beste Schätzung“ anbelangt, ist Vorsicht angebracht, siehe hier: Hupfer, 2006, S. 300

[13] Ein deutliches Zeichen gibt da die beschränkte Übernahme von Ausbreitungsmodellen in die technische Normung und Gesetzgebung. Die reale Ausbreitung muss schließlich meßteschnisch ermittelt werden.

[14] in der Bundesrepublik TA Luft, BImschG u.a. Der Normungsausschuß wählte aus. siehe http://de.wikipedia.org/wiki/Ausbreitungsrechnung.

[15] es gibt eine nicht näher quantifizierbare Unsicherheit aus der gedanklichen Vorstellung wie es sein könnte.

[16] www.dwd.de/bvbw/appmanager/bvbw/dwdww.Desktop; globale Durchschnittstemperatur

[17] Kohlendioxid entsteht bei vollständiger Verbrennung kohlenstoffhaltiger Brennstoffe. Siehe hierzu:

http://cdiac.ornl.gov/ftp/ndp030/global.1751_2008.ems Hier ausgewählte Produktionszweige.

[18] hierzu zählen Unsicherheiten der Messung (http://de.wikipedia.org/wiki/Messunsicherheit ) inkl. der zeitlichen und örtlichen Unsicherheiten (Gebiets- bzw. Raum-Mittelungen) sowie der Elimination von Ausreißern, der Unterstellung von Verteilungstypen der Daten und der Zulässigkeit von Messwerten innerhalb der inhomogen verteilten – und womöglich nicht gleichwertigen – Meßstationen über den Landmassen und der nicht geschlossenen Ermittlung über/unter Wasser-Oberflächen. Die Aussage-Ergebnisse der einzelnen Institutionen sind wegen der unterschiedlichen Verwertung der Messdaten nicht identisch, z.B. NCDC, GISS u.a. (USA) bzw. anderer Forschungs-Institutionen. – Die Überprüfung der Schätz-Methode wird gesondert durchgeführt.

[19] Zweynert, Ulrike. Möglichkeiten und Grenzen bei der Modellierung von Nährstoffeinträgen auf Flußgebietsebene. Dissertation. Techn. Universität Dresden. 2008. Hier Abweichungen der Idee beim Messen. www.qucosa.de/recherche/frontdoor/?tx_slubopus4frontend[id]=60

[20] beim Messen der Temperatur werden keine Mehrfach-Messungen vorgenommen, es wird unterstellt, dass die Temperatur stabil ist, die Änderungsgeschwindigkeit in Stunden wird nicht berücksichtigt.

[21] besonders beim globalen Klima kommt noch die Bedingung hinzu, dass die Daten auch gleichwertig über der Zeit sein müssen; eine lediglich plausible Ausfüllung von Datenlücken mindert den Aussage-Wert. Daran leiden auch Rückwärtsrechnungen mit Klima-Modellen, siehe: www.aaplet-magic.com/backcastingag.htm (Thayer Watkins). als Überprüfmethode ohne Korrekturen/Anpassungen.. Vgl. hierzu: Leistenschneider – Kowatsch. www.eike-klima-energie.eu/climagate-anzeige/klimaerwaermung-in-Deutschland-nicht-nachweisbar Hier wird jedoch Hohenpeißenberg mit seinem Temperaturverhalten dargestellt, ein Verhalten, dass für das umliegende Land jedoch schon sehr früh von den Fachleuten als nicht repräsentativ bezeichnet und deshalb korrigiert wurde.

[22] bei der Vielzahl von Daten ist eine einheitliche Unbestimmtheit [Unschärfe] nicht quantifizierbar. Das hindert nicht, den anthropogenen Anteil der Schad-Verursacher in einem Treibhausgas (nicht Wasserdampf, eher CO2) zu vermuten, obwohl die Repräsentanz gerade der atmosphärischen Bestandteile schwach in Daten ist. Schönwiese, C.-D. Der aktuelle Stand der Klimaproblematik. Globaler und regionaler Klimawandel. www.geo.uni-frankfurt.de/lau/PDF_Dateien/SW-KLIA17-_Klimastudie-Chem_-2_pdf.pdf Juli 2010.

Hierzu die historische Darstellung äußerer Einflüsse/Wetter-Landwirtschaft. In: Rabich, Adalbert. Herda, Geschichte vom Dorf Herda. GRIN-Verlag. 2006 u. Regionalgeschichte des Gerstunger Beckens. GRIN.2010

[23] siehe Fußnote 1, Aussagekraft und Korrektheit der Szenarien des IPCC. Dort auch Zitat 107.

[24] als Beispiele: Eis- und Warmzeiten, Sturmfluten, Überschwemmungen, Dürreperioden, Hunger

[25] Becker, DWD, Vortrag am 25.11.2010 (Deutsches Klima-Konsortium, Berlin, 22.11.2010). und: Schreiber, Klaus-Jürgen. Nachweis geführt: Klimawandel verändert auch Wetterlagen. Klima-Pressekonferenz des DWD am 03.05.2012 in Berlin, darin: Hauptwindsysteme verlagern sich zu den Polen. mehr regenreiche Tiefdruckgebiete über Mitteleuropa usw. – Extremereignisse sind aus den Häufigkeitsverteilungen in Abhängigkeit der Standardabweichung vom Mittelwert definiert. Sie werden für das Abschätzen der Größe des Risikos als Produkt aus Eintrittswahrscheinlichkeit und Schaden [sicherheitswissenschaftlich] benutzt. Die Aussagen über die Eintrittswahrscheinlichkeiten gelten für ein großes Datenkollektiv. Schönwiese, C.-D. Extremereignisse aus meteorologisch-statistischer Sicht. promet 34(2008)1/2 S. 61-65

[26] Szenarien dienen je nach Simulations-Annahmen zum Studium, Prognosen geben Zukunfts-Zustände ab. Szenarien liefern eine Bandbreite von Möglichkeiten. www.hydrologie.unibe.ch/projekte/Klimaszenarien_fuer-hydrologische-impaktstudien_in_der_schweiz.pdf 2011

[27] Hupfer, Peter – Wilhelm Kuttler (Hrsg.). Witterung und Klima. Wiesbaden: B.G. Teubner. 2006 S. 294

[28] zu unterscheiden: Richtigkeit.

[29] Lage der Meßstationen, Einflüsse lokaler Einstrahlungen usw.

[30] www.scirp.org/journal/PaperInformation.aspx?paperID=9233 2011. G. Kramm – Dlugli.

[31] siehe: Rasemann, W. – A. Rabich – K. Volk. Bibliografie Probenahme und Qualitätssicherung bei Stoffsystemen. Bd. I (2001), II (2003) und III.(2006). IQS Freiberg. – + in: Handbuch Probenahme. 2009.

[32] z.B. zum Treibhauseffekt. Loock, Ehrenfried. www.tsch.de/ehrenfried-look/webfolder/index.html 17.08.2008

http://climaterealistics.com/index.php?id=8073 http://principia-scientific.org/publications/Experiment_on_Greenhouse_Effect.pdf

[33] Rabich, Adalbert. Das Klimaproblem. e-book. ISBN 978-3-640-24354-9. München: GRIN-Verlag. 2008.

[34] http://lv-twk.oekosys.tu-berlin.de/project/lv-twk/02-intro-3-twk-c.htm Kehl, H. Die Klimadebatte.

[35] vgl. hierzu die Ausführungen über die Raster-Interpolationen beim Niederschlag. Maier, Ute – Gerhard Müller-Westeroser. Verifikation klimatologischer Rasterfelder. Berichte DWD Nr. 235. ISBN 978-3-88148-450-3/2010. Man kann nicht ohne weiteres interpolieren oder „homogenisieren“. Aus diesem Grunde müssen alle Mittelwert-Ermittlungen besonders sorgfältig analysiert und geprüft werden. Für Temperatur: Eckhard Schulze. 2012. www.eike-klima-energie-eu/news-cachew/wie-kann-man-eine-mittlere-‚globaltemperatur-ermitteln-was-die-statistiik-verlangt-und-verschweigt Schulze Temperatur Statistik.pdf Literaturquellen.

[36] Die Daten (Keeling-Kurve) sind solche, denen man unterstellt, dass sie repräsentativ sind. Bewiesen ist das jedoch keineswegs. Siehe die Bemerkung schon zur Temperatur, wo noch wesentlich mehr Meßpunkte vorhanden sind, unter: Why do global and hemispheric temperature anomales differ from thos quotes in the IPCC asessment and the media? www.cru.uea.ac.uk/cru/data/temperature