..Letzteres ist allerdings teuer und würde den Preis des umweltfreundlichen Stroms signifikant erhöhen. Ein Verschwinden des Atommülls würde andererseits keinen Gegner der Atomenergie von seinem Glauben abbringen. Es gibt analog der chemotoxischen Abfälle zahlreiche Wege den anfallenden Atommüll zu entsorgen. Der heutzutage am häufigsten gegangene Weg ist es diese Abfälle in geologisch sicheren Formationen in Salz, Ton, oder Granit zu lagern. Der Artikel geht auch auf die Alternativen, wie das Lagern in der Wüste, im Meer, oder im ewigen Eis, ein. Verfahren die eleganter und günstiger sind.(sehen Sie hier die  Vollversion des nebenstehenden offenen Briefes)

Vollversion des nebenstehenden offenen Briefes)

Einleitung

Derzeit werden jährlich 200.000 to Arsen, Zyanid, Dioxin und Furanhaltiger Giftmüll im ehemaligen Kalisalzbergwerk Herfa-Neurode eingelagert(14). Große Mengen giftiger Filterstäube, z.B. aus Kohlekraftwerken, werden als Bergversatz in Kohlezechen endgelagert (13). Filterstäube und Kohleasche können neben diversen Giften auch bis zu 200ppm Uran enthalten. In China ist die Urangewinnung aus den Hinterlassenschaften mehrerer Kohlekraftwerke geplant. (4) Langfristig, d. h. in der Nachbetriebsphase ist das Gefährdungs-Potenzial der radioaktiven Abfälle bzw. Endlager niedriger als das der chemotoxischen Abfälle bzw. einer UTD (Untertagedeponie)….. Es besteht eine Diskrepanz zwischen dem tatsächlichen Risiko und der Risikowahrnehmung in der Öffentlichkeit. Aus Strahlenschutzpraxis (15)

Es ist nur ökologisch (irrational) zu erklären, warum der Atommüll ein derartiges mediales Aufsehen genießt. Ausgerechnet die geringen Mengen an Atommüll werden seitens der Ökologen als unlösbares Problem (wobei Sie mögliche Lösungen blockieren), dargestellt. Nüchtern betrachtet ist die Müllentsorgung ein Vorteil für die Kernenergie. Aufgrund der enormen Energiedichte des Brennstoffs ist das Müllproblem wesentlich geringer als bei Kohle, Wind und Sonne.

1. Anfall hochradioaktiver Abfälle in Kernkraftwerken

Ein typisches Leichtwasserkernkraftwerk, ein Druckwasserreaktor, ist mit etwa 100 to leicht angereicherten Uran (Oxid) beladen. Die Spaltung von 1g 235Uran erzeugt ca. 22000 KWh entsprechend der Verbrennung von 2700 kg Kohle(2). In einem Jahr erzeugt ein derartiges Kraftwerk bei 33% Wirkungsgrad 10.000 GWh Strom. Dabei wird 1100 kg Uran und im Reaktor erbrütetes Plutonium gespalten. Jeweils nach einem Jahr wird z.B. knapp 1/4 des Brennstoffs (Abbrand 50,55 MWd/kg) ausgetauscht. Die Zusammensetzung des ausgetauschten Brennstoffs* kann wie folgt aussehen:

20,9 to Uran, entsprechend 23,6 to Uranoxid, Isotopenzusammensetzung z.B. 0,68% U235, 0,58% U236, Spuren U234, Rest 238U*

240 Kg Plutonium, entsprechend 272 Kg Plutoniumoxid, Zusammensetzung: 3% Pu238, 50% Pu239, 26% Pu 240, 13% Pu241 u. 8% Pu242*

|

Atommuell teilweise nutzbar

|

|

1100 Kg Spaltprodukte incl. Sauerstoff (Oxide) davon

830 Kg Stabile Spaltprodukte, z.B. 24 Kg Molybdän 95 (Keine Radioaktivität)

39 Kg Caesium137, Halbwertszeit 30,2J, Strontium90 Halbwertszeit 28,1J, Jod

24 Kg Technetium,

30 Kg langlebige Spaltprodukte

|

Als Brennstoff in Brütern nutzbar

|

|

29 Kg Transurane (Minore Actinide), davon. 15,5 Kg Neptunium Np237, 7,4 Kg Americium Am 241, 5,6Kg Am 243, Curium *(Mit schnellen Neutronen spaltbar, bzw. in schnellen Brütern nutzbar)

*Gem. einer ICP-MS Analyse Mittelwert mehrerer Brennstäbe aus einem Druckwasserreaktor, mit 4% Anfangsanreicherung und 50,55 MWd/Kg mittlerer Abbrand

Zu dem oben genannten hochradioaktiven Abfall kommen 50 m3 (konditioniert) leicht u. mittel-radioaktive Abfälle, wie gebrauchte Kittel, Handschuhe, aber auch 9to (Erläuterung e) Strukturmaterial, in erster Linie Brennstabhüllen, hinzu.

2. Reduzierung des Atommülls durch weitere Nutzung als Kernbrennstoff

Eine sehr elegante Möglichkeit mehr Energie aus dem Kern-brennstoff, bzw. weniger Atommüll je erzeugter KWh (Ener-gieeinheit) zu gewinnen ist der DUPIC (Direct Use of used PWR fuel in CANDU reactors) Prozess. CANDU (CANadian Deuterium Uranium) Reaktoren werden mit dem wesentlich effektiveren Schwerwasser moderiert. Dadurch kann dieser Reaktortyp mit für Leichtwasserreaktoren bereits abgebranntem Brennstoff betrieben werden. Candu Reaktoren sind in Kanada, Indien, Rumänien, Korea und China im Einsatz. Der Abbrand der Brennstäbe erhöht sich um etwa 20%, oder 10 – 12 MWd/Kg. Hierzu müssen die hochradioaktiven Brennelemente in einer geeigneten Anlage auf die Brennstoffkonfiguration des CANDU Reaktors konvertiert werden (Erläuterung g). Umfangreiche Tests dieses Verfahrens werden derzeit in China und anderen Ländern durchgeführt (30).

3. Reduzierung des Atommülls durch Wiederaufarbeitung (Recycling)

Langlebige Radioaktive Stoffe wie Uran, Thorium kommen in der Natur häufig vor und strahlen nur geringfügig. Kurzlebige radioaktive Stoffe zerfallen größtenteils bereits im Reaktor. Problematisch sind, wie man auch aus der obigen Darstellung erkennen kann die radioaktiven Stoffe mit Halbwertszeiten von mehreren Jahren bis zu 1 Mio. Jahre. Plutonium ist sehr giftig, radioaktiv und hat (z.B.239Pu) eine Halbwertszeit von 24000 Jahren. Das bedeutet es ist als Abfall sehr schwierig zu entsorgen. Andererseits ist 239Pu ein wertvoller Brennstoff in Kernkraftwerken. Deshalb ist es geboten den genutzten Brennstoff wieder aufzuarbeiten. Die abgebrannten Brennstäbe enthalten etwa 96% Uran und Plutonium, die als wertvolle Brennstoffe wiederverwertet werden können.

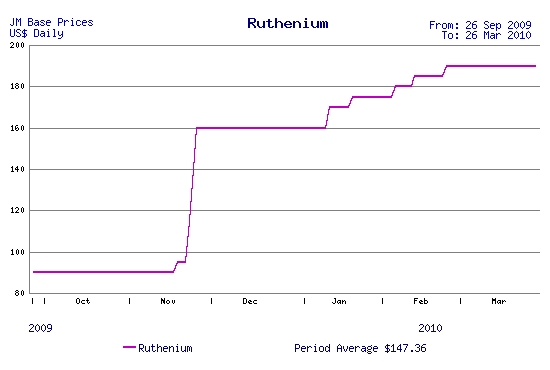

|

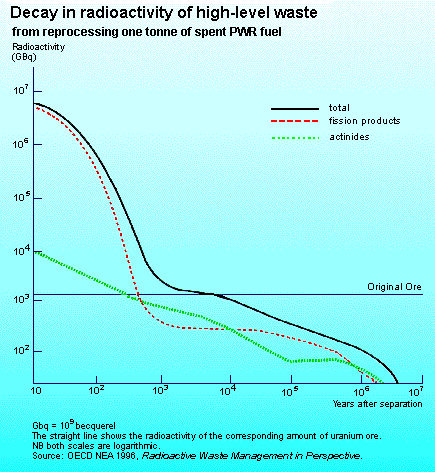

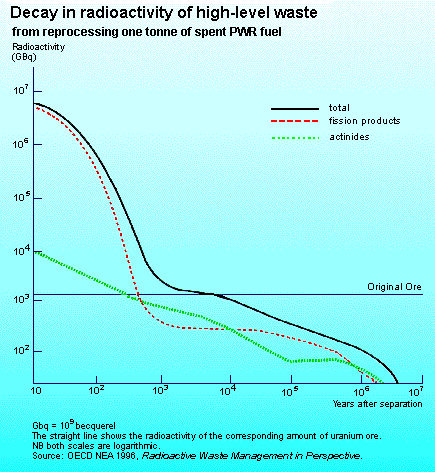

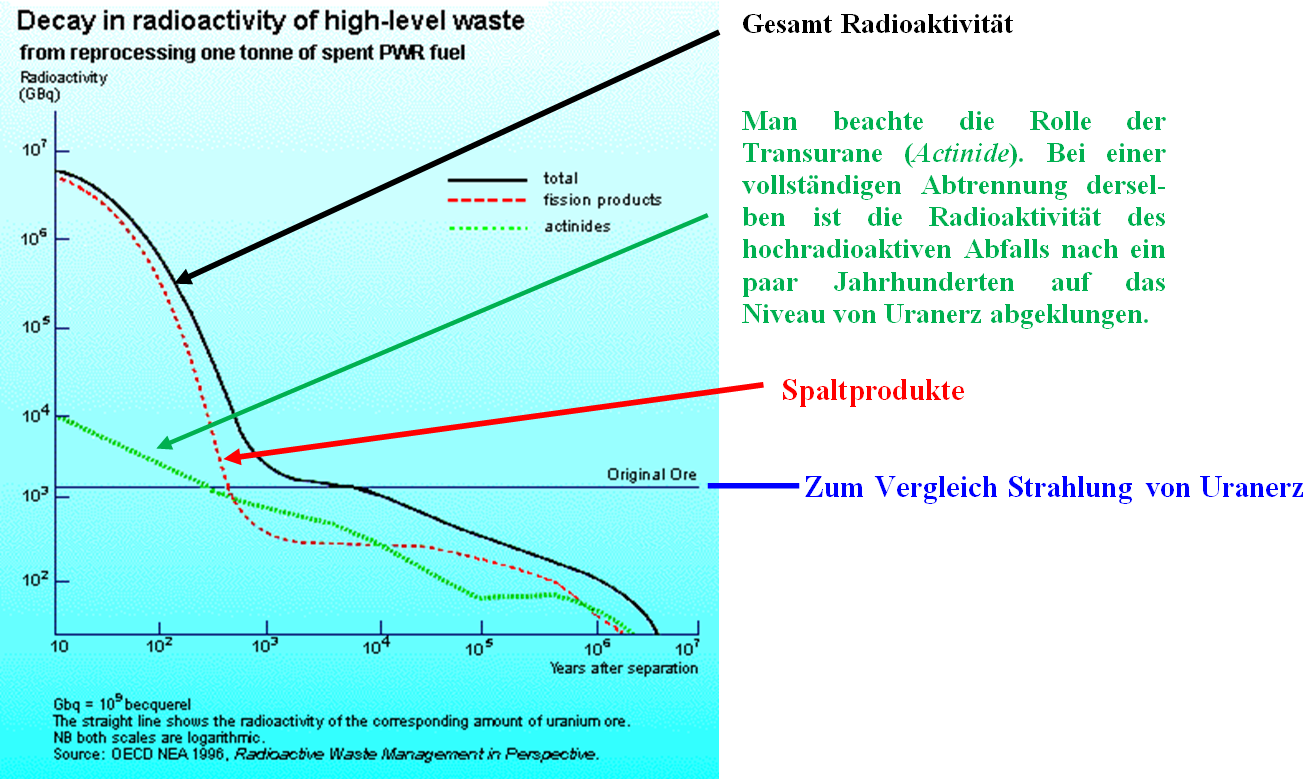

Das Bild zeigt die Radioaktivität abgebrannten Kernbrennstoffs. Es unterscheidet sich von der obigen Analyse.

|

Es verbleibt 1100 Kg hochradioaktiver Müll der nach einigen Jahrhunderten (bei Abtrennung der Actinide) auf das Niveau von Natururan abgeklungen ist und etwa 10m3 Betriebsabfälle aus der Wiederaufbereitung. In Deutschland wurde die Wiederaufarbeitung von Minister Trittin aus ökologischen (=irrationalen) Gründen verboten. Ein erheblicher Teil der Atommüllproblematik beruht auf dieser ökologischen Entscheidung

|

|

|

|

|

|

|

Die Bilder Links zeigen die Abfüllung einer Mischung aus Borsilikatglas versetzt mit hochradioaktivem Müll in der Wiederaufbereitungsanlage in La Hague, sowie einen der verwendeten Edelstahlbehälter in denen diese Masse eingeschmolzen wird

|

|

|

|

|

Radioaktivität der Reststoffe aus der Wiederaufbereitung

Man beachte die Rolle der Transurane (Actinide). Bei einer vollständigen Abtrennung derselben ist die Radioaktivität des hochradioaktiven Abfalls nach ein paar Jahrhunderten auf das Niveau von Uranerz abgeklungen.

4. Mögliche Nutzung der verbleibenden Reststoffe aus der Wiederaufbereitung

4a. Extrahieren und Nutzung der Reststoffe

Gem. einer ICP-MS Analyse von mehreren Brennstäben aus einem Druckwasserreaktor, 4% Anfangsanreicherung und einem mittleren Abbrand von 50,55MWd/Kg Abbrand kann man auf 25 to Brennstoff bezogen, in dem nach der Abtrennung des Urans und Plutoniumoxids verbleibenden 1100 kg Restabfall folgende Spaltprodukte erwarten:

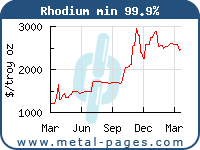

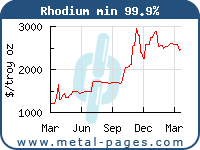

Rh 103 13,4 kg Rhodium ist eines der wertvollsten Elemente der Welt, Der Preis beträgt etwa 65.499€/kg (19). Neben dem 103Rh kommt auch ein radioaktives Rhodium Isotop in Spuren vor, das jedoch mit einer Halbwertszeit von 39 Tagen bereits vor einer möglichen Wiederaufarbeitung zerfallen ist und eine Nutzung nicht behindert.

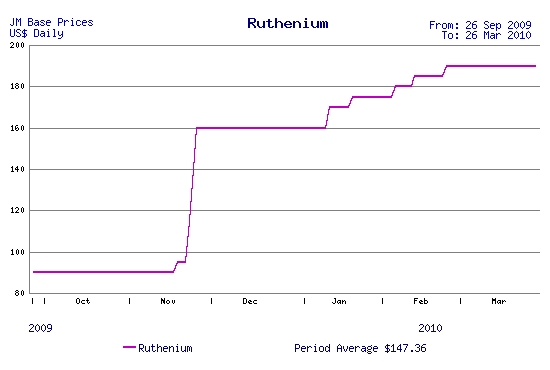

Ru 101 25 kg. Ruthenium, Preis 4540 €/kg (29) ist gleichfalls ein sehr seltenes teures Metall. Durch Verunreinigung mit Spuren des radioaktiven 106Ru, mit einer Halbwertszeit von 373 Tagen, kann man dieses erst nach einigen Jahren nutzen.

Ag 109 1,4 kg, Preis 535 €/kg (27) nicht radioaktives Silber.

Sm 149,150,151,152. Gilt als seltene Erde. 151Sm hat eine Halbwertszeit von 90 Jahren und verhindert durch radioaktive Verunreinigung eine Nutzung des Samariums.

Tc99 24 kg, Preis 83.000$/kg (20) Technetium wird dringend als Radiopharmaka benötigt. Als Tracer wird es in die Blutbahn gespritzt und lagert sich in schwerzugänglichen Organen an Krebszellen an. Derzeit wird überlegt aufgrund der Knappheit desselben neue spezielle Reaktoren zum erbrüten dieses Isotops zu errichten (16). In der Wiederaufbereitungsanlage Sellafield wird das anfallende 99Tc teils gewonnen. Eine Produktion im Bereich mehrerer to aus der Wiederaufbereitung abgebrannten Kernbrennstoffs würde einerseits den Preis für 99Tc massiv einbrechen lassen, andererseits eine Behandlung für viele Menschen erschwinglich machen und diesen helfen.

Sr90 Radioaktiv, Strontium wird in Radionuklidbatterien als Stromquelle genutzt

Nd 143, 145, 148 Gesamtmenge der Isotope 54 Kg. Der Preis von 68 €/Kg (26) bietet begrenzten Anreiz für eine Nutzung. Die Isotope des Neodyms sind stabil, oder haben sehr lange Halbwertszeiten im Bereich 1015 Jahren. Neodym wird in Hochleistungsmagneten genutzt

Ein paar weitere Isotope können z.B. in der Messtechnik, zum Einsatz kommen. Aus den Stellitrollen der SWR lassen sich 60Co Strahlenquellen fertigen (1) mit denen Gewürze, Obst und Gemüse haltbarer gemacht werden.

Russland berechnet für die Wiederaufbereitung abgebrannten Kernbrennstoffs aus ausländischen Reaktoren, z.B. Bulgarien, 620$/Kg (18). In La Hague, Frankreich werden ausländischen Kunden, z.B. Italien, 1000 €/kg berechnet. (22). Gewonnen werden in der Wiederaufbereitung das Uran und das Plutonium. Bei einem Pu Gehalt des verbrauchten Brennstoffs von 1% ergibt sich bei einem Uranpreis von 66 €/Kg, (17) und einem Faktor von 200 für das Reaktorplutonium, 10g x 200 = 2 Kg Uran, einen Wert für den wieder gewonnenen Brennstoffs von etwa 198 €/Kg. Das bedeutet dass die Wirtschaftlichkeit der Wiederaufbereitung derzeit von den Kosten der vermiedenen Atommüllentsorgung abhängt. Die Extrahierung seltener Elemente aus Atommüll steckt in den Kinderschuhen. Die Weiterentwicklung hin zu einer besseren Wirtschaftlichkeit und der besseren Nutzung aller Reststoffe, ist unbedingt erforderlich um die Wiederaufbereitung von Kernbrennstoff wirtschaftlich attraktiver zu machen.

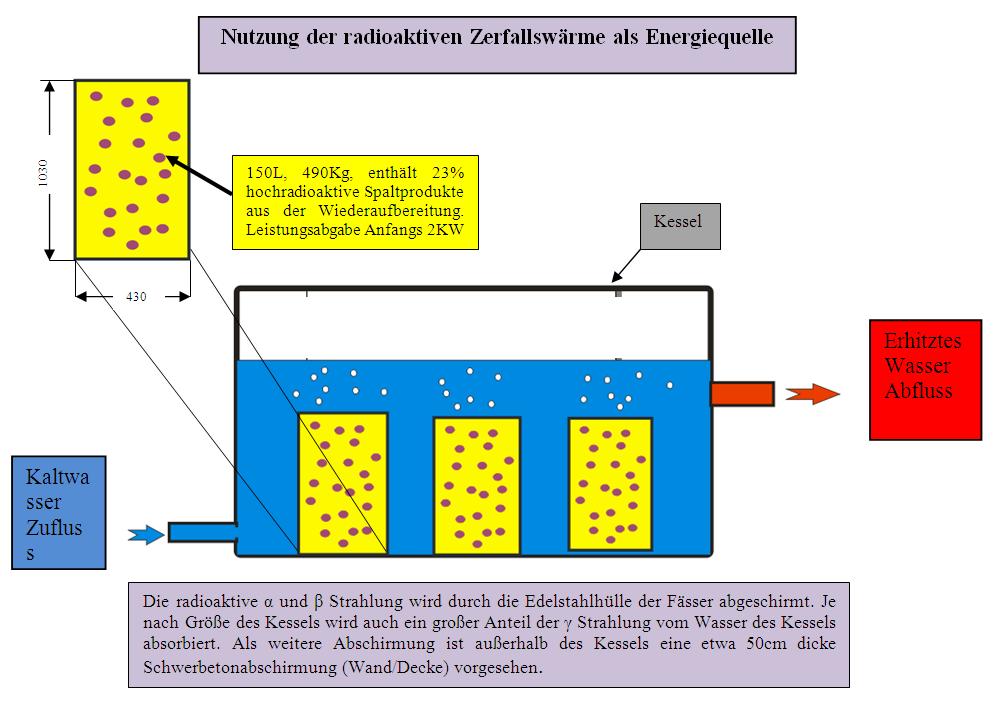

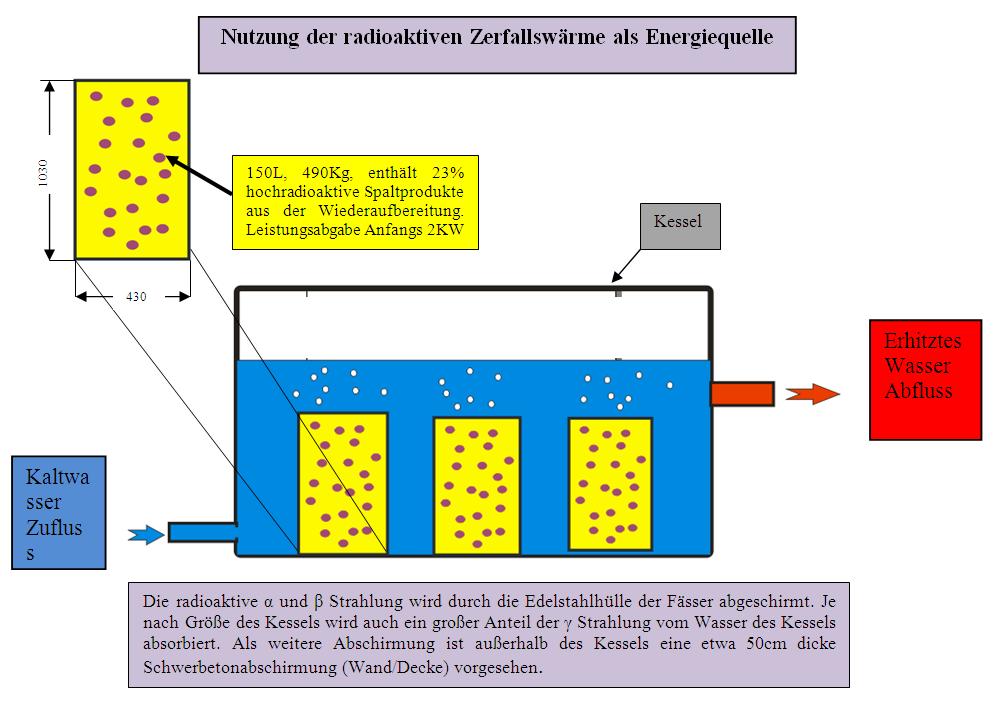

4b. Nutzung hochradioaktiver Abfälle als Wärmequelle

Eine wesentliche Eigenschaft des hochradioaktiven Abfalls ist dessen starke Wärmeabgabe.

Ein Block hochradioaktiven Abfalls aus der Wiederaufarbeitung (4J nach der Entnahme aus dem Reaktor) in Frankreich hat einen Durchmesser von 430mm, einen Inhalt von 150L, wiegt 490 Kg und enthält ca. 23% hochradioaktive Abfälle (77% Glasanteil) die in Borsilikatglas eingeschmolzen und mit Edelstahl ummantelt sind. Ein derartiger Block gibt direkt nach der Wiederaufarbeitung bis zu 2 KW Wärme ab (21). Blöcke hochradioaktiven Atommülls können für mehrere Jahre als Energiequelle in anderen nuklearen Einrichtungen, beispielsweise in Anreicherungsanlagen zur Erhitzung des UF6, dienen, oder auch für Polarstationen, Militärstützpunkte und Inseln genutzt werden, bis die Radioaktive Wärme weitgehend abgeklungen ist.

|

Die größte Herausforderung ist es bei einer derartigen Nutzung sicherzustellen dass der Müll nicht durch Gotteskrieger gemopst und zur Herstellung schmutziger Bomben verwandt wird. Der Gedanke an eine derartige Nutzung wurde in den 70er Jahren im Kernforschungszentrum Karlsruhe erwogen. Er wurde jedoch aufgegeben, da eine derartige Energiequelle nicht wirtschaftlich (a) konkurrieren kann, wenn der Müll mit riesigem Aufwand, dem atomrechtlichen Verfahren ausgesetzt, mit staatlich geduldetem Ökologen-Polizisten Prügelspiel (b) zugestellt wird.

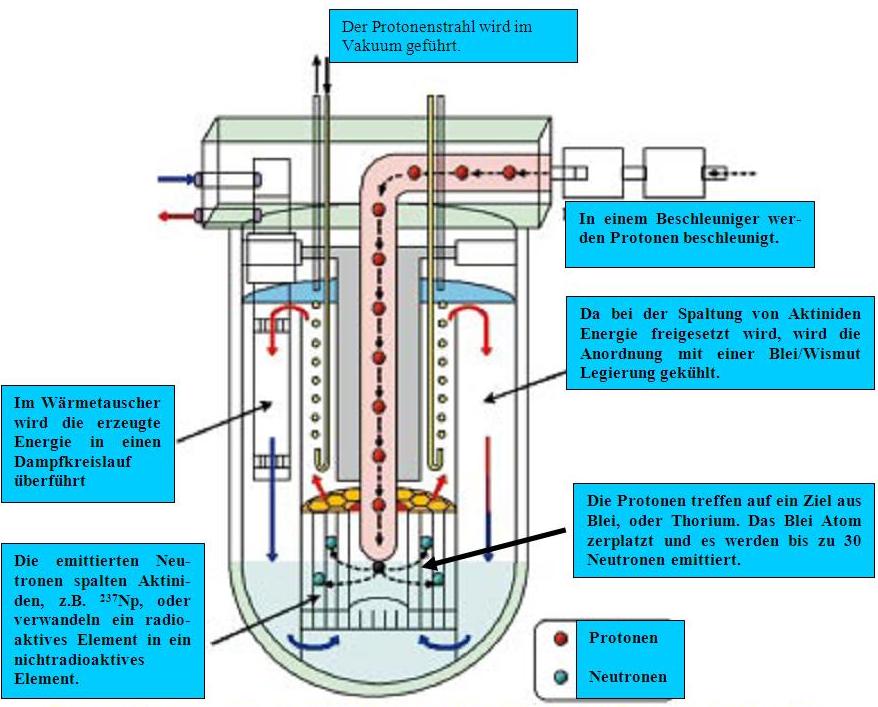

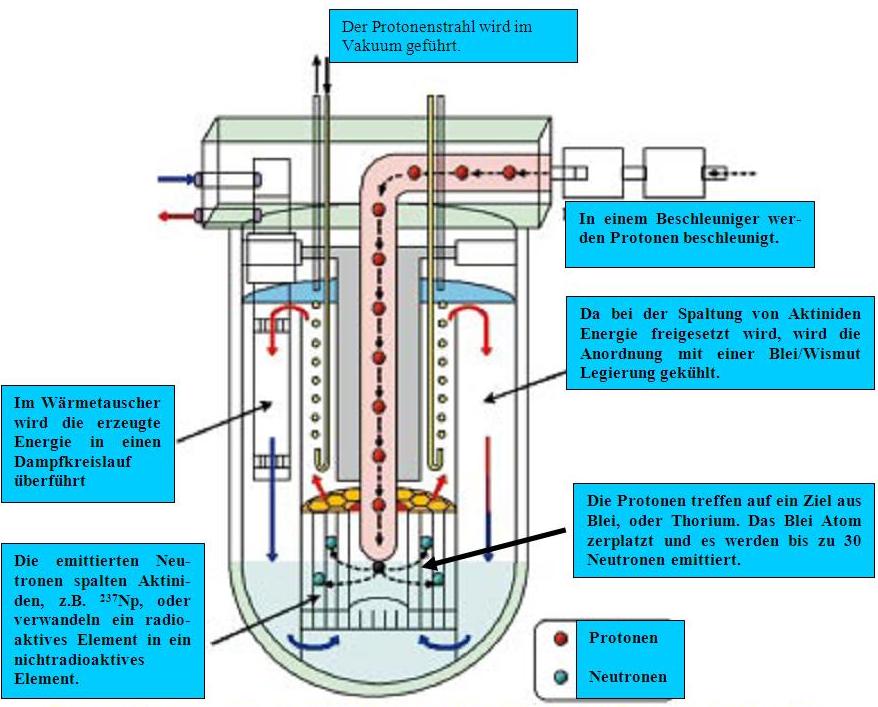

5. Deaktivierung des Atommülls durch Mutation der Actinide und Spaltstoffe in nichtradioaktive Elemente

Grundsätzlich kann man die radioaktiven Spaltprodukte und Actiniden in die einzelnen Elemente auftrennen und die kritischen Elemente durch Neutronenbeschuss in nichtradioaktive Stoffe verwandeln. Die Transurane (Minore Actinide), die aufgrund ihrer langen Halbwertszeiten die größte Herausforderung bei dem aus der Wiederaufbereitung verbleibenden atomaren Restmüll darstellen, lassen sich in der Wiederaufbereitung abtrennen.

Grundsätzlich kann man die radioaktiven Spaltprodukte und Actiniden in die einzelnen Elemente auftrennen und die kritischen Elemente durch Neutronenbeschuss in nichtradioaktive Stoffe verwandeln. Die Transurane (Minore Actinide), die aufgrund ihrer langen Halbwertszeiten die größte Herausforderung bei dem aus der Wiederaufbereitung verbleibenden atomaren Restmüll darstellen, lassen sich in der Wiederaufbereitung abtrennen.

Ein schneller Brüter mit seiner hohen Dichte schneller Neutronen ist ideal geeignet um die in Leichtwasserreaktoren gebildeten Actinide (Transurane), als Brennstoff zu nutzen. Es gibt Studien bei dem neuem Konzept des SCWFR Reaktors, der sich durch einen hohen Brutfaktor auszeichnet, Targets aus Minoren Actiniden einzubringen (8).

Eine anderer Weg die Minoren Aktinide zu deaktivieren und diese gleichzeitig als Brennstoff zu nutzen sind Beschleuniger, s. Abbildung.

Der Gedanke der Nutzung der Neutronen eines Kernreaktors zur Deaktivierung von Spaltprodukten, oder Neutronen aus einem Neutronenbeschleuniger, s.o. zur Deaktivierung radioaktiver Spaltprodukte ist machbar, ist jedoch sehr aufwendig und eine Verschwendung die der ökoreligiösen Diskussion geschuldet ist.

Es ist eine sehr teure Lösung eines fiktiven Problems. Ein Verschwinden des Atommülls würde keinen Jünger der Ökoreligion von seinem Glauben abbringen.

6. Endlagerung des radioaktiven Mülls

a.Versenken des Atommülls im Meer:

Eine Möglichkeit leicht und mittelradioaktiven Atommüll preisgünstig zu deponieren ist diesen im Meer zu versenken. Die Weltmeere enthalten 66 Mrd. to radioaktives Kalium40 und 4 Mrd. to radioaktives Uran (Erläuterung h), Thorium, Tritium und viele andere radioaktive Stoffe. Man kann sich leicht ausrechnen das die Menschen die Weltmeere nicht mit den geringen Mengen Atommüll verseuchen können wie sie durch Kernkraftwerke entstehen. Die Engländer hatten bis 1982 den anfallenden Atommüll im Meer versenkt. Auch die Russen haben z.B. ausgediente Atom U-Boote im Weißen Meer versenkt. Derzeit wird lediglich flüssiger Atommüll im Meer entsorgt. Die natürliche Radioaktivität des Meeres von 12 Bq/l (6) kann sich jedoch örtlich erhöhen, wenn dieser unachtsam eingeleitet wird. So wurde einst in der Britischen Wiederaufbereitungsanlage Sellafield der flüssige radioaktive Müll über ein Rohr ins nahe Meer eingeleitet. Im Umfeld der Einleitung ist die Radioaktivität noch Heute höher.

b.Vergraben des Atommülls in der Wüste

Der Kernforscher und Physiknobelpreisträger Heisenberg schlug einst vor den Atommüll mit 3 m Erde zu bedecken. Wenn man dies in der Wüste ohne besondere Grundwasserströme vornimmt, z.B. in einer Senke, ist dies unproblematisch. Der Wüstensand bedeckt den Atommüll innerhalb weniger Jahre m-dick. Ein Vorteil liegt darin das der Atommüll in einigen 100 Jahren ohne großen Aufwand wieder ausgegraben werden kann und dann Rhodium, Ruthenium und andere Materialien kostengünstig gewonnen werden können. Schwierig ist jedoch die politische Situation in vielen Wüstenstaaten. Terroristen könnten diesen Müll zum Bau schmutziger Bomben nutzen. Verschwörungsgerüchte könnten die politischen Führungen der Länder destabilisieren. Die Nutzung der Wüsten in politisch stabilen, nichtökoreligiösen Ländern ist ein preisgünstiger, sinnvoller Weg. In diesem Sinne kam in den 80er Jahren eine chinesische Delegation nach Deutschland, die neben einigen Porzellanlöwen auch das Angebot hinterließ den Deutschen Atommüll gegen gutes Geld in der Wüste Gobi abzulagern.

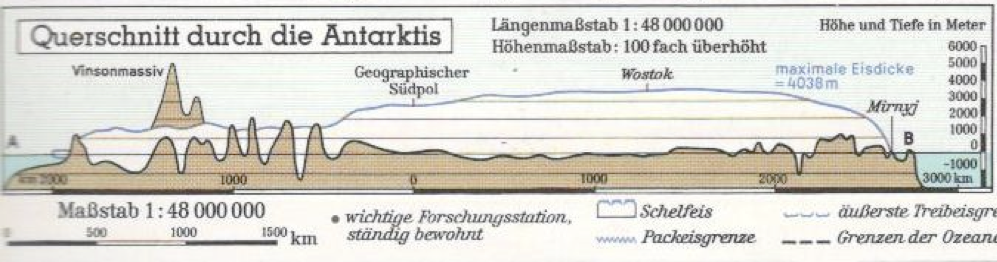

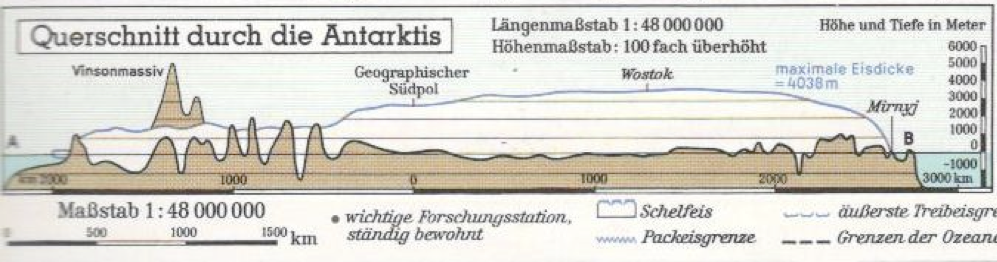

c. Deponieren des Atommülls im ewigen Eis

Die radioaktive Zerfallswärme lässt die Atommüllkokillen durch das Eis bis zum felsigen Untergrund des antarktischen Kontinents gleiten.

Die Antarktis ist mit einem bis zu 4000m dicken Eispanzer versehen. Sofern man den stabil verglasten, mit Edelstahl ummantelten, hochradioaktiven Müll (der Eisdruck ist enorm) dort verbringt, wird dieser sich durch seine Wärme mit abnehmender Geschwindigkeit und Radioaktivität durch den Eispanzer schmelzen und irgendwann auf den Fels treffen. Diese Alternative ist elegant und preisgünstig.

Die inländische Durchschnittstemperatur der Antarktis beträgt -55C°. Das antarktische Inlandeis wird auch bei einer signifikanten Erwärmung der Erde durch eine eventuelle Klimaänderung nicht schmelzen. Möglicherweise wird der Kontinent durch die Kontinentaldrift im Laufe von Millionen Jahren an einen wärmeren Platz der Erde wandern.

Die radioaktive Zerfallswärme des Atommülls ist viel zu gering und die Wärmeleit- fähigkeit des Eises zu gut um das Antarktische Inlandeis zu schmelzen (f).

Derzeit ist die Nutzung der Antarktis durch den Antarktisvertrag verboten. Eine Alternative zur Antarktis könnte der Inlandsgletscher Grönlands darstellen.

d. Deponierung des Atommülls Untertage

Das Bild zeigt die Untertage Atommülldeponie WIPP (USA)

Die meisten Länder haben sich entschieden ihren Atommüll unter Tage in geologisch stabilen Gebieten in Granit, Ton oder Salz zu lagern. Derzeit sind 16 (7) atomare Endlager in Betrieb. Dem in Deutschland geplanten und seit Jahrzehnten blockierten Atommüllager in Gorleben ist die WIPP Anlage in New Mexico (23) (USA) am Ähnlichsten.

In einem Salzstock in New Mexiko wird seit 1999 der hoch-radioaktive Abfall militärischer Einrich-tungen deponiert. Un-tertagedeponien sind Das Bild zeigt die Untertage Atommülldeponie WIPP (USA) teurer und weniger elegant als die oben genannten Verfahren. Stabile Salzstöcke ermöglichen allerdings einen idealen Abschluss der radioaktiven Abfälle von der Biosphäre über geologische Zeiträume hinweg.

In Dukovany (Bild links) werden heutzutage die Leicht- und Mittelradioaktiven Abfälle Tschechischer KKW endgelagert. Verglichen mit Asse aus den 60er Jahren, wo der Atommüll tief unter den genutzten Grundwasserschichten liegt, ist dieses eher ungünstiger zu bewerten.

In Dukovany (Bild links) werden heutzutage die Leicht- und Mittelradioaktiven Abfälle Tschechischer KKW endgelagert. Verglichen mit Asse aus den 60er Jahren, wo der Atommüll tief unter den genutzten Grundwasserschichten liegt, ist dieses eher ungünstiger zu bewerten.

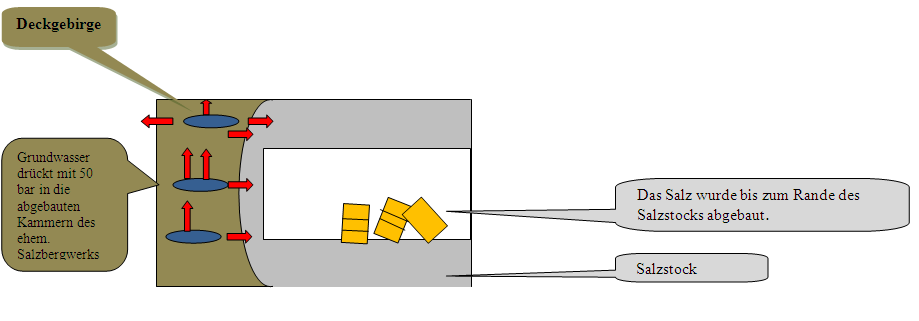

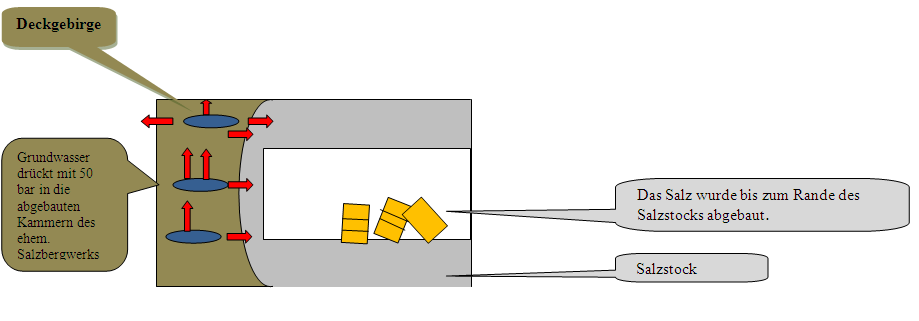

Das Versuchsatommüllendlager Asse setzte im Umfeld der 60er Jahre Maßstäbe (c). Im Vergleich zur vielfach üblichen Deponierung des Leicht- und Mittelradioaktiven Mülls in Betonwannen, z.B. Frankreich, CSR, ist Asse auch nach heutigen Maßstäben eher übertrieben. Allerdings ist auch Asse nicht perfekt. Aus wirtschaftlichen Gründen wurde einst der Salzabbau bis an die Ränder des Vorkommens betrieben. Von außerhalb des Salzstocks drückt das Grundwasser mit ca. 50 bar. Die Hohlräume üben keinen Gegendruck aus. Dadurch sickert etwas Wasser in das ehemalige Salzbergwerk. Es wird von 12m³/Tag geschrieben.

Dies ließe sich allerdings beheben indem man die Hohlräume mit weiteren Abfällen verfüllt, oder einfach flutet wie man dies mit vielen ehemaligen Salzbergwerken getan hat. Letztere Maßnahme hätte zur Folge, dass sich das Wasser im Salzstock mit Salz sättigt und dann als Salzlauge stabil bleibt. Durch ein Auffüllen, oder Fluten des Salzstocks entfällt die Druckdifferenz und der Salzstock kann dann die gebrauchten Kittel und Handschuhe für geologische Zeiträume einschließen. Die meisten Salzstöcke Deutschlands bergen Laugeneinschlüsse die beispielsweise in Gorleben seit 240Mio Jahren stabil sind. Entscheidend ist, dass keine nennenswerte Wasserbewegung stattfindet die Salz aus dem Salzstock spült und diesen im Negativfall auflöst. Der Salzstock in Gorleben wurde noch nicht genutzt. Insofern entfällt diese Thematik.

Horst Trummler (Vandale)

Der Beitrag kann als pdf im Anhang herunter geladen werden.

www.oekoreligion.npage.de

Erläuterungen

Solarmüll

Auf dem Gelände der kürzlich verkauften Antec Solar Energy AG in Arnstadt lagern 600 Tonnen Sondermüll. Wie Holger Wiemers von der Landesentwicklungsgesellschaft auf Anfrage von MDR 1 RADIO THÜRINGEN sagte, handelt es sich um 35.000 defekte Solar-Module. Diese müssten in einer Sonderdeponie eingelagert werden, weil sie mit giftigem Kadmium beschichtet seien (10). Die Produktion einer derartigen Solarzellenfabrik beträgt 1/100 eines KKWs ausgedrückt als Peakleistung. Da die Durchschnittserzeugung weniger als 10% der Peakleistung beträgt und eine Solarzelle wahrscheinlich etwas mehr als 20 Jahre betrieben werden, kann man das Verhältnis des Problemmülls auf 1/5000 schätzen. (9).

Anbei Bilder der Giftmülluntertagedeponie Herfa-Neurode in der jährlich etwa 200.000 to Giftmüll (alle Kernkraftwerke zusammen 20 to/a nach einer Wiederaufbereitung) endgelagert werden. Darunter PCB-haltige Transformatoren (z.B. Windmühlen), Filterstäube aus Kraftwerken (11), oder arsenhaltige Abfälle (7)wie sie z.B. bei der Herstellung von Solarzellen auftreten..

a. Die technisch notwendigen Einrichtungen wie ein im Vergleich zu Heizöl größerer Kessel und eine 50cm Betonabschirmung gegenüber der Gammastrahlung ließen sich leicht aus der Brennstoffeinsparung finanzieren.

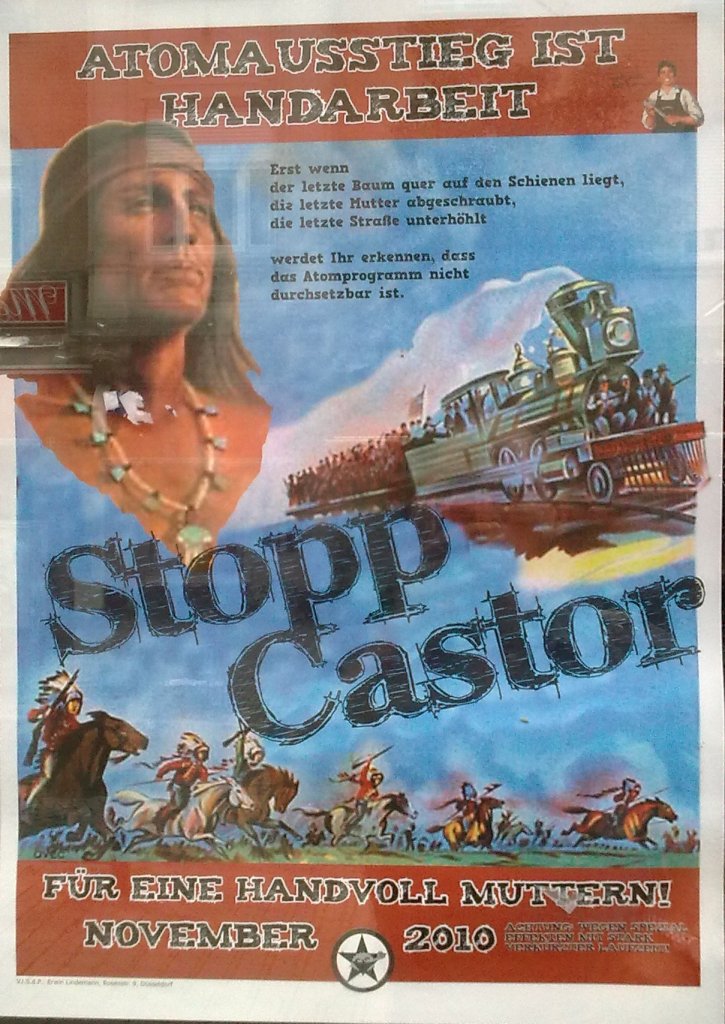

b Sofern der Staat die Prügelspiele nicht gewollt hätte, hätte man ernsthaft gegen die Organisatoren wie Grüne, BUND usw. als kriminelle Vereinigungen ermitteln können. Regelmäßig wurden Polizeiführer abgesetzt die zu hart mit den Ökologen umgingen.

|

Es wird zur Zerstörung von Schienen und Straßen aufgerufen.

|

|

Das Plakat hing an einer von der Stadt Frankfurt finanzierten Einrichtung

|

|

Sofern es sich nicht um geduldete/geförderte linke Kräfte handeln würde, würde man derartige Organisationen analog Rocker, oder NP.. juristisch bekämpfen.

|

c Asse wurde als Atommüllversuchsendlager für Leicht- und Mittelradioaktiven Müll 1967 in Betrieb genommen, zu einem Zeitpunkt als man chemotoxische Abfälle schlicht vergraben hat, bzw. ganz andere Maßstäbe an die Entsorgung angelegt hat. Aufgrund dessen, daß man Salz bis nahe an den Rand des Salzstocks abgebaut hatte, mußte mit Laugeneinbrüchen gerechnet werden. Dies war bereits in den 60er Jahren bekannt (28). Durch geschickte Skandalisierung (Eine Ameise zum Elefanten aufblasen) ist Asse zum Spektakel geworden anhand dessen die Endlagerung zum Problem erklärt wird.

d Allein der Materialaufwand für die Stromerzeugung aus Windkraftanlagen vs. Kernenergie beträgt ein 37-faches, s. Artikel CO2 Bilanzen.

e. Ausgehend von einem Außendurchmesser v. 9,5mm und einer Brennstabwandstärke von 0,65mm (EPR) ergibt sich bei Dichten von Zirkaloy von 6,5g/cm3 und Uox von 10,4 ein Gewichtsverhältnis von mU/mZ = (8.22 x 10.4)/(6.5 x (9.52 – 8.22) = 4.67. Sofern man die Endstücke, Abstandhalter usw. Hinzufügt erhält man ein Verhältnis von 3:1

f. Wenn man die aus der Wiederaufbereitung stammenden Reststoffe von 400 Kernkraftwerken aus 50 Betriebsjahren in einem Gebiet von 500 x 500Km ablagert, entsprechend 1000 MW Wärmeabgabe (das Abklingen der Radioaktivität und der Wärme ist hierbei nicht berücksichtigt), so ist dies verglichen mit der Sonneneinstrahlung von 55W/m2 und dem natürlichen Erdwärmestrom (Hauptanteil ist der radioaktiver Zerfall im Erdinnern) von 63mW/m², entsprechend 13.750.000 MW vernachlässigbar. Die Eisoberfläche der Antarktis strahlt mehr Wärme in den Weltraum ab, als ihr zugeführt wird.

g. Für den DUPIC Prozess ergeben sich 3 Optionen:

· Die genutzten hochradioaktiven Brennelemente werden zerlegt, die Brennstäbe in 50cm lange Stücke geschnitten und wiederum verschlossen. (25) Üblicherweise enthalten die Brennstäbe eine Feder um die Brennstofftabletten im Brennstab zu positionieren und ein Spaltgasplenum um einen Überdruck zu vermeiden. Somit erscheint mir fraglich ob dieser Prozess so funktioniert. Dieser Prozess, obwohl einfach , erfordert aber auch Investition in eine geeignete Anlage.

· Die genutzten Brennelemente werden zerlegt, der hochradioaktive Brennstoff von den Brennstabhüllen befreit, zu Pulver gemahlen, mit Sauerstoff erhitzt um einen Teil der Spaltprodukte zu entfernen und wiederum zu Tabletten gepresst, in Brennstäbe gefüllt und daraus Brennelemente gefertigt. Dieser Prozess wird in einer Zusammenarbeit von AECL Kanada und der Ukraine entwickelt. (12) Der Prozess erfordert Investitionen in eine geeignete Anlage.

· Die genutzten Brennelemente werden in einer Wiederaufbereitungsanlage in kochender Salpetersäure zersägt, der Brennstoff löst sich in Salpetersäure auf. Uran und Plutonium werden in TBT gebunden und der von Spaltprodukten befreite Brennstoff zur Fertigung von neuen Brennelementen genutzt. Auf die Trennung von Pu und Uran, wie im Purex Verfahren üblich, kann verzichtet werden. Dieser Wiederaufbereitungsprozess ist erprobt, jedoch sehr teuer! (s. Artikel Wiederaufbereitung!)

h. Radioaktive Substanzen im Meerwasser

Gem. Wikipedia http://de.wikipedia.org/wiki/Meer ergibt sich das Volumen der Weltmeere zu 1338 Mrd. km³

Gem. Wikipedia http://de.wikipedia.org/wiki/Kalium die durchschnittliche Konzentration von Kaliumionen bei 399,1 mg K+/kg = 408,4 mg K+/l. Der Anteil des 40K beträgt 0,012 %. Daraus ergibt sich:

1,338 x 10exp12 Mrd to x 408 x 10exp-6 Kg K x 0.12 x 10 exp-3 = 65,5 Mrd to 40k

Uran hat einen Anteil von 3mg/m3 im Meerwasser resultierend in = 4 Mrd. to Uran.

Der Anteil an Thorium, Radium, Rhadon, wurde nicht berücksichtigt.

Verwendete Quellen:

1. Homepage Fa. Hoefer & Bechtel

2. Kernenergie u. Kerntechnik Lothar Lüscher

3. Abbildung aus "Will time heal every wound?" (Monitor 17), Swedish Environmental Protection Agency. (Das Buch ist über Miljobokhandeln erhältlich)

4. Referat Prof. Horst Michael Prasser ETH Zürich gehalten am 29.05.08 in Lausanne

5. Uran limitierender Faktor für die Kernenergie Ohnemus Gronau 2006

6. Umweltradioaktivitaet. und Strahlenbelastung BMU Jahresbericht 2001 * gem. Diesem Bericht liegt die Radioaktivität des Meerwassers bei 12 Bq/l.

7. Wikipedia

8. CORE DESIGN ANALYSIS OF THE SUPERCRITICAL WATER FAST REACTOR Dissertation von Dr. Ing. Magnus Mori

9. Gegenwärtig verfügt die Antec Solar Energy AG am Produktionsstandort Arnstadt über 10 Megawatt (MW) Produktionskapazitäten. Der thüringische Standort bietet

www.solarserver.de/solarmagazin/artikelmai2005.html – 36k – Im Cache – Ähnliche Seite

10. http://www.mdr.de/mdr1-radio-thueringen/nachrichten/5616073.html 26. Juni 2008, 18:44 Uhr

11. http://www.ks-entsorgung.com/standorte/neurode.cfm. Homepage Zugriff vom 23.11.08

12. http://www.world-nuclear-news.org/C-Canadian_technology_agreement_with_Ukraine-3005084.htmlCanadian technology agreement with Ukraine

xx

13. Köster, S.: Relevante Abfallströme für eine Immobilisierung, Tagungsband des 15. Aachener Kolloquiums Abfallwirtschaft im Dezember 2002

14. http://www.sueddeutsche.de/wissen/647/301644/text/ SZ Wissen 12/2006 (20.10.2006)

15. Strahlenschutzpraxis (Zeitschrift) Ehrlich, Dietrich/ Schulze, Hartmut/ Schlagwort(e)Endlagerung konventionelle Abfälle radioaktive Abfälle Heft/Jahr4/2003Seite/Seitenzahl61/5

16. Mangel an medizinisch verwendbaren Isotopen

17. http://www.uxc.com/review/uxc_Prices.aspx UxC Nuclear Fuel Price Indicators (Delayed) Zugriff v.25.02.2010 , Preis U3O8 66,16 €/Kg

18. http://www.world-nuclear.org/info/inf87.html World Nuclear Organization Nov08

19. http://www.metal-pages.com/metalprices/

Zugriff 26.03.2010

1 tr Oz = 31,1g → 1 kG Rhodium 88424$ = 65499 €

20. http://en.wikipedia.org/wiki/Technetium 18.02.09

21. FZKA6651 Forschungszentrum Karlsruhe, Wissenschaftliche Berichte, Endlagerrelevante Eigenschaften von hochradioaktiven Abfallprodukten, Bernhard Kienzler, Andreas Loida, 2001 S64 des Dokuments

22. Areva Pressemitteilung 09.05.07 http://www.areva.com/servlet/news/pressroom/pressreleases/cp_07_05_2007-c-PressRelease-cid-1177488959131-p-1140584426338-en.html

23. Homepage von WIPP http://www.wipp.energy.gov/ U.S. Department of Energy

4021 National Parks Highway Carlsbad, New Mexico 1-800-336-WIPP Zugriff 16.08.09 Atommüllendlager der USA für den in militärischen Anlagen anfallenden hochradioaktiven Müll, als Pilot Plant deklariert.

24. http://www.lahague.areva-nc.com/areva-nc/liblocal/docs/download/Usine%20de%20la%20hague/LH-usine-la-hague-DT-6-en.pdf

25. Processing of Used Nuclear Fuel, WNA, oct 09, http://www.world-nuclear.org/info/inf69.html

26. http://www.metal-pages.com/metalprices/neodymium/

Zugriff 22.10.2010

95$/Kg = 68 €/Kg

27.Silber .de http://www.silber.de/silberpreis.html

28. http://www.strom-magazin.de/strommarkt/endlager-papst-moegliches-absaufen-der-asse-schon-lange-bekannt_27208.html

06.11.2009, 14:21 Uhr

"Endlager-Papst": Mögliches Absaufen der Asse schon lange bekannt

29. http://www.ebullionguide.com/price-chart-ruthenium-last-6-months.aspx Zugriff 26.03.2010 190$/oz entspricht 4540 €/Kg

30. WNN News 24.03.2010 http://www.world-nuclear-news.org/ENF-Chinese_reactor_trials_Candu_fuel_reuse-2403101.html

Related Files

Vollversion des nebenstehenden offenen Briefes)

Vollversion des nebenstehenden offenen Briefes)

Grundsätzlich kann man die radioaktiven Spaltprodukte und Actiniden in die einzelnen Elemente auftrennen und die kritischen Elemente durch Neutronenbeschuss in nichtradioaktive Stoffe verwandeln. Die Transurane (Minore Actinide), die aufgrund ihrer langen Halbwertszeiten die größte Herausforderung bei dem aus der Wiederaufbereitung verbleibenden atomaren Restmüll darstellen, lassen sich in der Wiederaufbereitung abtrennen.

Grundsätzlich kann man die radioaktiven Spaltprodukte und Actiniden in die einzelnen Elemente auftrennen und die kritischen Elemente durch Neutronenbeschuss in nichtradioaktive Stoffe verwandeln. Die Transurane (Minore Actinide), die aufgrund ihrer langen Halbwertszeiten die größte Herausforderung bei dem aus der Wiederaufbereitung verbleibenden atomaren Restmüll darstellen, lassen sich in der Wiederaufbereitung abtrennen.

In Dukovany (Bild links) werden heutzutage die Leicht- und Mittelradioaktiven Abfälle Tschechischer KKW endgelagert. Verglichen mit Asse aus den 60er Jahren, wo der Atommüll tief unter den genutzten Grundwasserschichten liegt, ist dieses eher ungünstiger zu bewerten.

In Dukovany (Bild links) werden heutzutage die Leicht- und Mittelradioaktiven Abfälle Tschechischer KKW endgelagert. Verglichen mit Asse aus den 60er Jahren, wo der Atommüll tief unter den genutzten Grundwasserschichten liegt, ist dieses eher ungünstiger zu bewerten.

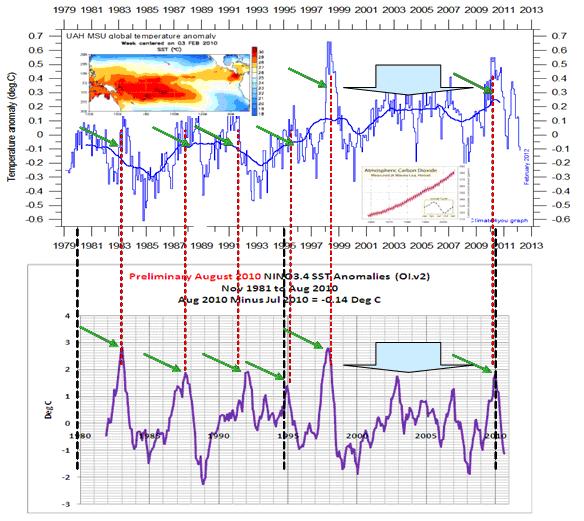

Abbildung 13 zeigt nochmals den in Abbildung 5 gezeigten gemittelten, globalen Temperaturgang und dazu den El Ni

Abbildung 13 zeigt nochmals den in Abbildung 5 gezeigten gemittelten, globalen Temperaturgang und dazu den El Ni