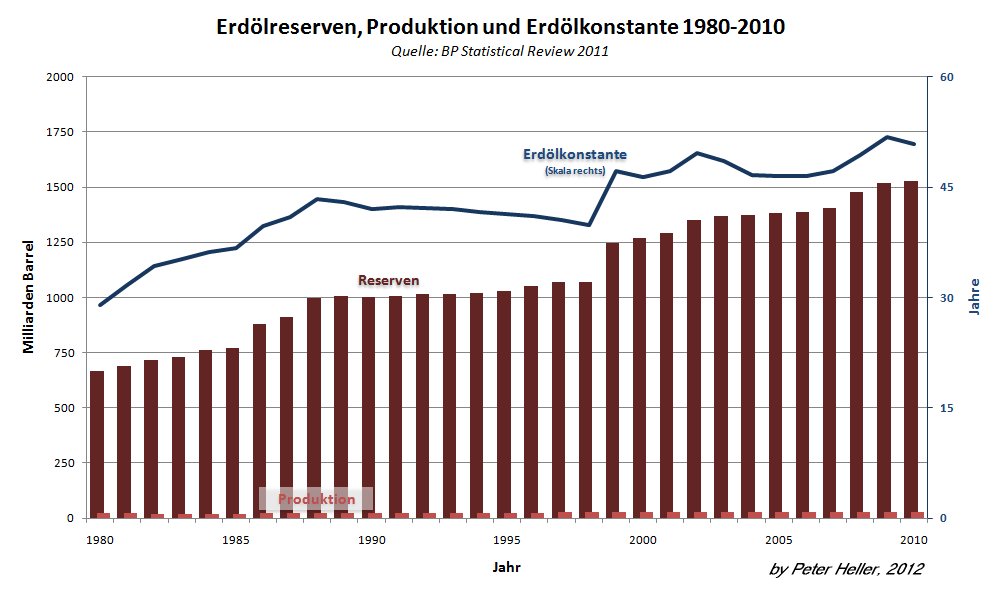

Teil 2: Wie die Wettersysteme allein durch die Sonne angetrieben werden

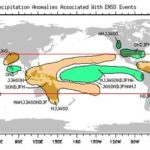

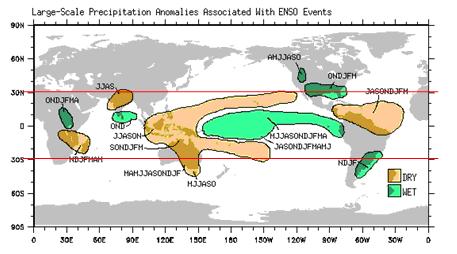

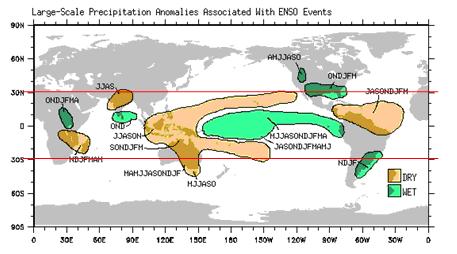

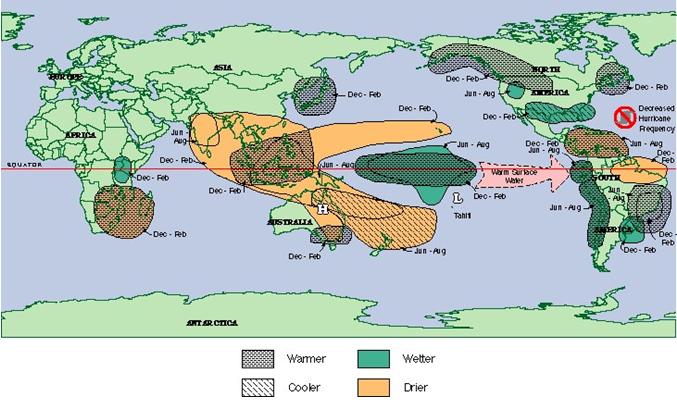

Abbildung 14 (Quelle: www.elnino.info) zeigt die von El Niño betroffenen Gebiete weltweit. Die Monate, in denen diese Auswirkungen stattfinden, sind mit deren Anfangsbuchstaben aufgeführt (z.B. bedeutet OND "Oktober-November-Dezember"). Deutlich ist eine Konzentration zwischen 30° nördlicher und südlicher Breite zu verzeichnen. Dies sind die Einflussgebiete der Passatwinde. Warum dies so ist, gleich mehr.

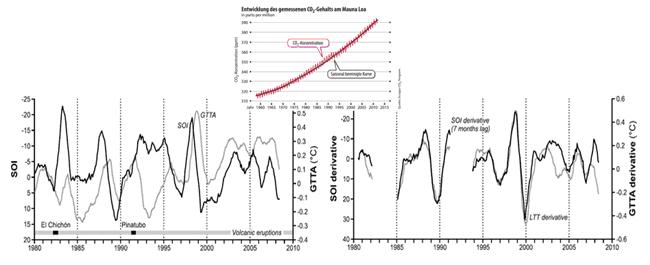

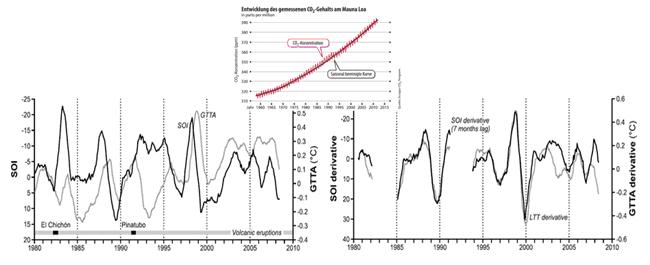

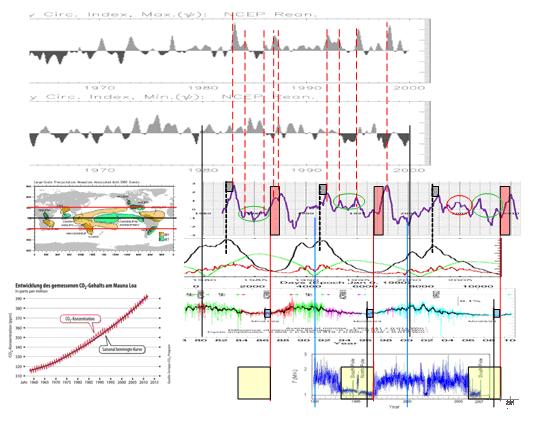

Wissenschaftler aus Australien und Neuseeland (Prof. Robert M. Carter von der James Cook University in Australien) haben in ihren Untersuchungen den Zusammenhang zwischen der ENSO-Schwingung (El Niño/Southern Oszillation) und dem Weltklima bereits aufgezeigt, wenn auch nicht den Grund dazu erkannt. Sie veröffentlichten ihre Studie, die auf gut erfassten Messdaten der vergangenen 50 Jahre zurück griff, im "Journal of Geophysical Research". Ihr Ergebnis: Je stärker der jeweilige El Niño war, desto deutlicher stieg in der Folge die globale Temperatur an, was auch Abbildung 13 überdeutlich zeigt.

Die Forscher geben an, dass ca. 70% der zuletzt beobachteten Erwärmung auf die El Niño-Tätigkeit zurück zu führen ist (Anmerkung: Wie der Autor zeigte und noch zeigen wird, sind dies 100% – Prof Marotzke muss mit seinen über 90% auf THG wohl auf einem anderen Planeten und in einer anderen Welt zu Hause sein, in der Welt der Computerspiele, in der alles möglich ist und in der sich auch das PIK eingerichtet hat). Es habe sich gezeigt, dass etwa 6 Monate nach einem El Niño-Ereignis die globalen Temperaturen, je nach Stärke des El Niño anstiegen. Blieben dagegen El Niño-Ereignisse über längere Zeit aus, soll dies zu einem globalen Rückgang der Temperaturen geführt haben. Die folgenden Abbildungen geben den Zusammenhang wieder.

Abbildung 15 links zeigt den SOI (Southern Oscillation Index, dunkle Linie) und die GTTA (Global Tropospheric Temperature Anomalies, helle Linie). Deutlich sind die Einflüsse der starken Vulkaneruptionen des El Cichon und Pinatubo zu erkennen, durch die die Globaltemperaturen zeitweise zurückgingen. Deutlich zu sehen, dass außerhalb der Vulkanereignisse eine hohe Korrelation gegeben ist. In der rechten Abbildung sind diese Einflüsse bereinigt. Quelle: McLean, de Freitas, Carter, ”Influence of the Southern Oscillation on tropospheric temperature”, Journal of Geophysical Research Atmospheres. Keine der Zeitreihen hat auch nur im entferntesten einen Zusammenhang mit der atmosphärischen CO2-Konzentration.

Die Forscher gehen weitgehend von natürlichen Ursachen der globalen Temperaturtrends aus.

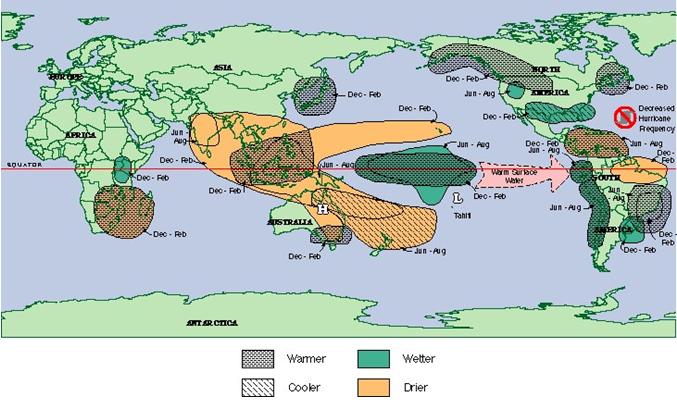

Abbildung 16: Die "Enso" (El Niño und Südliche Oszillation) genannte Schwingung hat Auswirkungen auf die Großwetterlagen weltweit (Abbildung, Quelle: South Carolina State Climatology Office). Die als ENSO benannte natürliche Schwingung hat über den pazifischen Raum Auswirkungen auf die Globaltemperaturen, Nord- und Südamerikas, Afrikas und Europas. Wissenschaftler des MPI-M und der Universität von Cambridge (UK) hatten herausgefunden, dass auch ein Zusammenhang zwischen El Niño-Ereignissen und dem Winterverlauf in Deutschland besteht, Davide Zanchettin, Hans-F. Graf, “Central Pacific El Niño, the “subtropical bridge,” and Eurasian climate“ (Journal of Geophysical Research, Vol. 117, Do1102, 10 PP., 2012, doi: 10.1029/2011JD016493).

Über dem tropischen Atlantik ruft El Niño Luftströmungen hervor, die der Bildung starker Wirbelstürme entgegenwirken. So ist denn auch in La Niña-Jahren (das Gegenteil von El Niño), die Hurrikantätigkeit ausgesprochen niedrig. Warum dies so ist, später mehr.

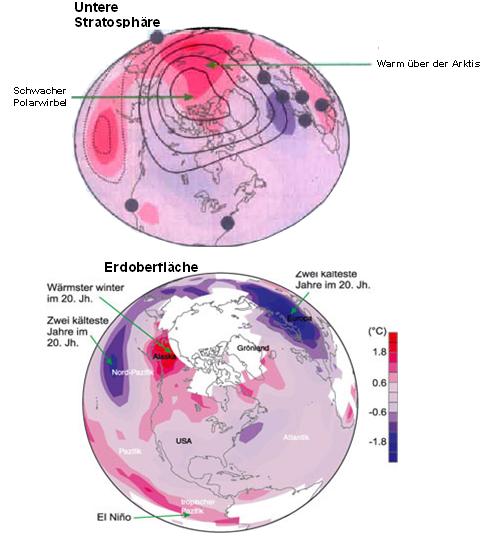

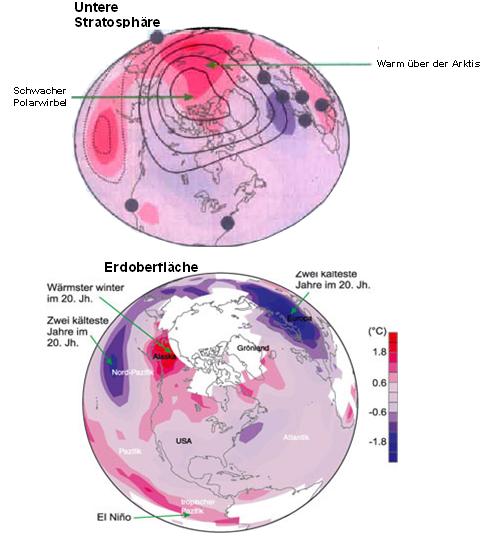

Bereits die Untersuchungen der ETH Zürich, Prof. Dr. Brönnimann, zeigen Auswirkungen auf Europa, (S.d.W. 03/05, “Pazifik ließ Europa frieren“). Er hat anhand von Untersuchungen nachgewiesen, dass in den 40er Jahren des 20. Jahrhunderts über mehrere Jahre eine ungewöhnlich hohe Temperaturschwankung vorlag, die auf El Niño-Ereignissen beruhte. Aus alten meteorologischen Messdaten konnte er die atmosphärischen Verhältnisse auf der Nordhalbkugel zu Beginn der 1940er Jahre rekonstruieren. Die Temperaturanomalien sind in folgender Abbildung vom ihm aufgetragen.

Abbildung 17 zeigt die Temperaturabweichungen gegenüber dem Durchschnittswert der Jahre 1961 – 1990 für die untere Atmosphäre (unten) und die Stratosphäre (oben), gemittelt von Januar 1940 – Februar 1942. Die Abbildungen dokumentieren eine großräumige Klimaanomalie, die mit einer ungewöhnlich dicken Ozonschicht verbunden ist. Die Farbskala gibt die Temperaturdifferenzen im Vergleich zu einem Referenzwert an (Grafik: Prof. Brönnimann). In der Stratosphäre (oben) ist die Luft über der Arktis wärmer, der Polarwirbel schwächer und die Ozonschicht dicker als üblich. Auch das Klima auf der Erdoberfläche war außergewöhnlich: Extreme Kälte in Mittel- und Osteuropa, mildes Wetter in Alaska und frostige Kälte im Nordpazifik. Prof. Brönnimann fand heraus, dass das El Niño-Ereignis einen schwachen Polarwirbel auslöste, der für die große Kälte verantwortlich war. Warum dieser schwache Polarwirbel entstehen musste, später mehr.

Sheffield et al. (2009) fanden heraus, dass große Dürren mit der ENSO (El Niño Southern Oszillation) und den nordpazifischen und atlantischen Meeresoberflächen-Temperaturen (SSTs) zusammenhängen. Der Zusammenhang mit der ENSO wird durch eine Studie über den Südwesen der USA durch McCabe et al. 2010 belegt. Warum dies so ist, wird noch anhand der sich ändernden Windsysteme bei einem El Niño-Ereignis erklärt.

Prof. Malberg (ehem. Institutsleiter Meteorologie der Freien Universität Berlin) fand heraus, dass die Änderungen in den Globaltemperaturen unmittelbar mit El Niño/La Niña-Ereignissen gekoppelt sind, “La Niña – El Niño und der solare Einfluss: Die Klimaentwicklung 1950 – 2008“.

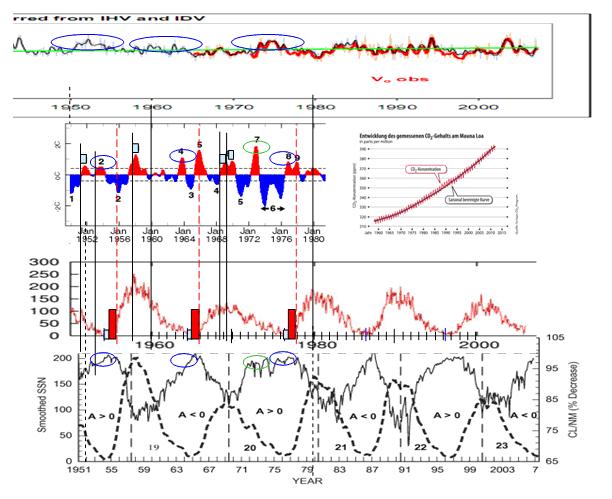

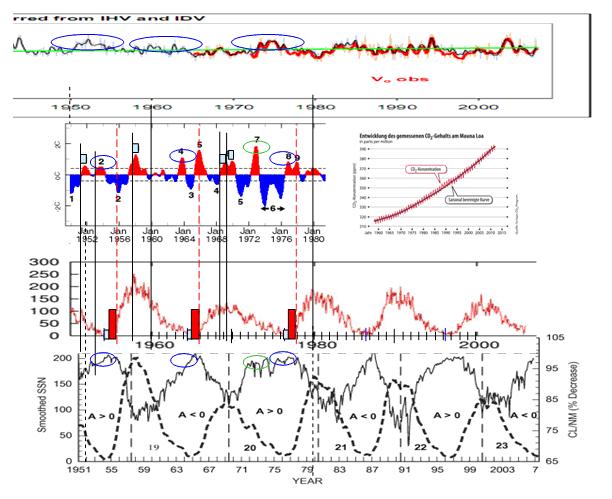

In Abbildung 10 (Teil 1) hatte ich Ihnen belegt, wie alle El Niño-Ereignisse im Betrachtungszeitraum und damit die ermittelten globalen Temperaturen durch 3 Sonnenparameter ausgelöst und bestimmt werden. Da in wissenschaftlichen Untersuchungen oft 2 Klimaperioden von je 30 Jahren betrachtet werden, möchte ich dies an dieser Stelle nicht versäumen.

Abbildung 18 zeigt oben, die Sonnenwindstärke, darunter den El-Niño 3.4 der NOAA ab 1950 und den Schwabe-Zyklus der Sonne. Dazu, die atmosphärische CO2-Konzentration, die ohne Zusammenhang zu El Niño-Ereignissen ist. Ganz unten, das Polarfeld der Sonne (durchgezogene Linie) ab 1951, Quelle: Ahluwalia und Ygbuhay, “Is there an instrumental drift in the counting rate of some high latitude neutron monitors?“ Auch im Zeitraum von 1951 – 1980 fallen alle El-Niño-Ereignisse mit der Sonnenaktivität zusammen:

1) Dem Einschalten der Koronaturboheizung, wenn deren Temperatur verdoppelt wird

2) Nach jedem Maximum im magnetischen solaren Zyklus.

3) Dem Polarfeld der Sonne (Maximum = blaue und grüne Ovale)

Die Messdaten belegen in eindrucksvoller Weise, dass die globalen Temperaturen natürlichen Schwankungen, den El Niño-Ereignissen unmittelbar folgen. Mit CO2 oder einer angeblichen anthropogenen Erwärmung hat dies nichts zu tun. Mit dem vorliegenden Nachweis, dass alle El Niño-Ereignisse im Betrachtungszeitraum von 1951 bis 2010 durch die solare Aktivität unmittelbar ausgelöst werden, ist der wissenschaftliche Beweis abgerundet, dass die Erwärmung (und Abkühlung seit Beginn dieses Jahrhunderts) einzig auf die Sonne zurückzuführen ist.

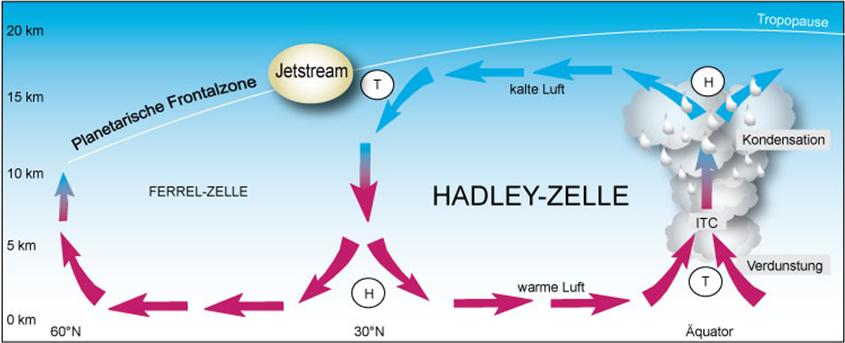

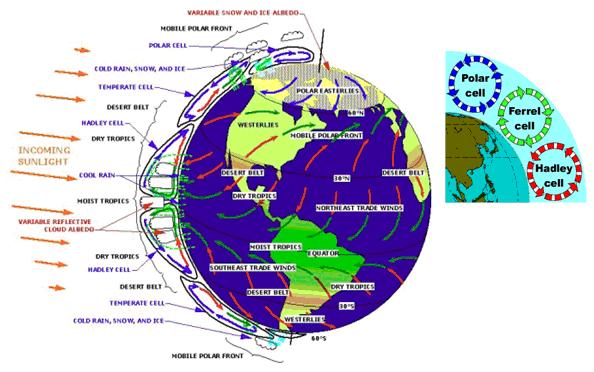

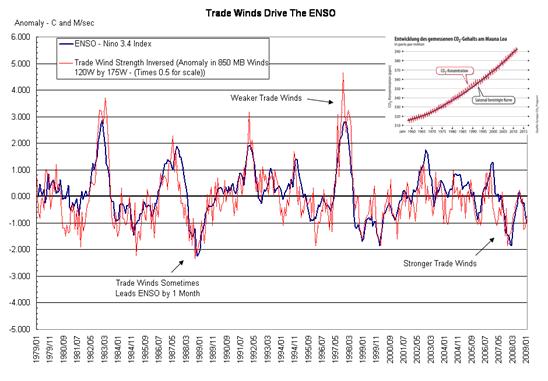

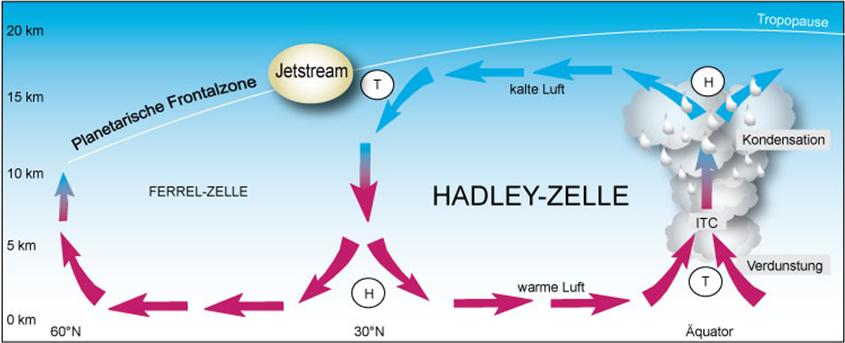

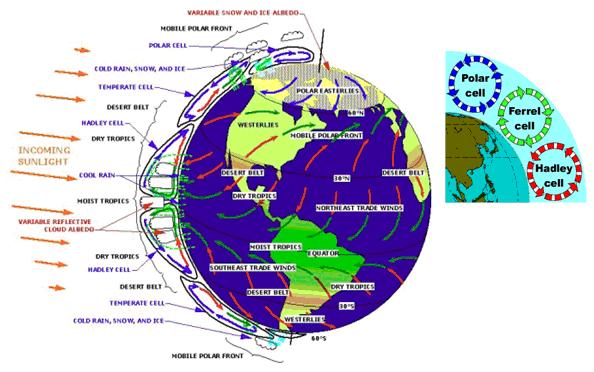

Bleibt noch die Frage zu klären, wie die gezeigte Sonnenaktivität ihren Einfluss sozusagen umsetzt und auf welchen physikalischen Grundprinzipien dieses basiert. Hier geben die Antwort, die Passatwinde (englisch: Trade Winds), also die Großraumwetterlage, die durch die Hadley-Zellen bestimmt wird. Die Passatwinde sind ein beständiges Windsystem, welches sich auf beiden Seiten des Äquators bis zum 24 Breitengrad ausbildet. Es liegt damit im Bereich der Hadley-Zellen und unterteilt sich in den Nordost-Passat (Nordhalbkugel) und in den Südost-Passat (Südhalbkugel). In der Wissenschaft ist unstrittig, dass die Passatwinde durch die Sonne entstehen und ihre Ausbildung und Stärke von der Sonnenscheindauer und Stärke abhängt. Durch erwärmte, aufsteigende Luftschichten (Tiefdruckgebiet entlang der innertropischen Konvergenzzone) die an der Tropopause vom Äquator weg strömt und ca. 30° Nord oder Süd wieder zu Boden fällt (Hochdruckgebiet) entsteht ein Druckgefälle, wodurch sich Ausgleichströmungen zwischen den Hoch-/Tiefdruckgebieten bilden. Durch die Corioliskraft werden sie entsprechend abgelenkt.

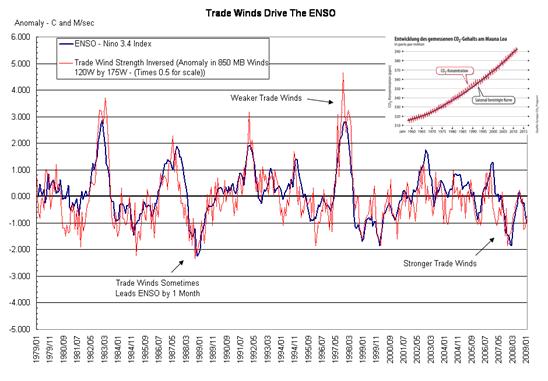

Abbildung 19 (http://wattsupwiththat.com/2009/02/17/the-trade-winds-drive-the-enso/#more-5702) zeigt die ENSO und die invertierte Windstärke der Passatwinde (Trade Winds). Unschwer ist zu erkennen, dass beide zusammenhängen. Die Passatwinde werden von den Hoch- und Tiefdrucksystemen (neben der Corioliskraft = Erddrehung) bestimmt. Diese wiederum durch die Wolkenbedeckung, sowie den Luftströmungen und dies ist der Ansatzpunkt, wie die Sonne neben ihrer Strahlungsleistung ihren Einfluss auf das irdische Wettersystem umsetzt. Unnötig zu erwähnen, dass auch hier der atmosphärische CO2-Pegel (kleine Abbildung) irrelevant für die Windereignisse ist.

Da die Passatwinde Ausdruck der Hadley-Zellen sind und diese in einem Band zwischen ±30° um den Globus verlaufen, wird der unmittelbare solare Einfluss auf die Hadley-Zellen untersucht.

Die Hadley-Zelle ist ein wesentlicher Bestandteil der atmosphärischen Zirkulation. Sie entsteht durch die meridional unterschiedliche Sonneneinstrahlung und dem daraus resultierenden Energietransport von den Tropen zu den Polen. Diese thermisch angeregte Zirkulation reicht jedoch im ersten Schritt nur bis zum 30-Breitengrad, weil dort die Strahlungsenergie deutlich zu fallen beginnt (Abbildung 22). Die daraus entstehende Hadley-Zelle ist als globale (verläuft um den ganzen Globus) Vertikalzirkulation zwischen dem Hochdruckgürtel der Subtropen und der äquatorialen Tiefdruckrinne ausgebildet. Die Hadley-Zelle kann näherungsweise als ein in sich abgeschlossenes System betrachtet werden.

Abbildung 20: Über der ITCZ (innertropischen Konvergenzzone) steigt aufgrund der Konvektion warme und feuchte Luft auf, wobei dort ein Tiefdruckgebiet entsteht. Die Luft expandiert, kühlt dabei ab, was zur Wolkenbildung führt. Durch die Corioliskraft wird die Luft abgelenkt. Im Bereich des Subtropenhochdruckgürtels sinkt die kalte und trockene Luft (schwerer) ab, wodurch am Boden ein Hochdruckgebiet entsteht. Die sich dabei erwärmende Luft nimmt über den Ozeanen große Mengen an thermischer Energie in Form von fühlbarer und latenter Wärme (Luftfeuchte) auf und fließt als Nord/Ost-Passat zum Äquator zurück. Der übrige, meridionale Energietransport findet über die sich anschließenden Zellen durch horizontale zyklonale (entgegen dem Uhrzeigersinn drehende) und antizyklonale (mit dem Uhrzeigersinn drehende) Zirkulation statt. In der Ferrel-Zelle wird die Energie durch die Westwinddrift abgeführt. Diese entsteht aus thermodynamischen Gründen wegen des Temperaturgegensatzes der Luft von ca. 20 K zwischen 30° und 60°-Breite.

Wie Untersuchungen zeigen, hat sich die Hadley-Zelle im Zeitraum der moderaten Erwärmung zwischen 1979 und 2005 (Anstieg des Hauptsonnenzyklus) um 5-8 Breitengrade ausgedehnt und sich dessen Volumen, da auch die Tropopause wegen der erhöhten Konvektion durch die Wärmeflüsse um einige Zehnmeter erhöhte, um ca. 5% vergrößert, D. J. Seidel et al. (2008), ”Widening of the tropical belt in a changing climate“, Nature Geoscience 1, 21-24.

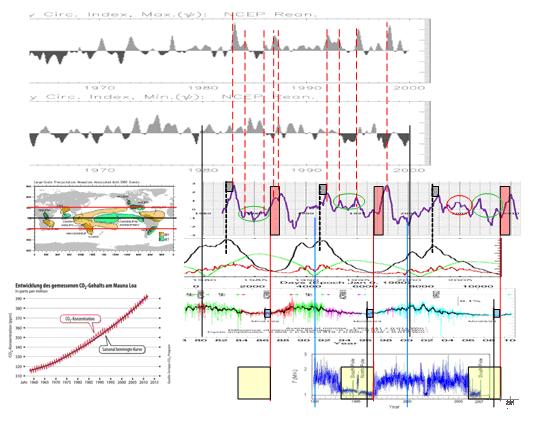

Xiao-Wei Quan et al. “Change of the Tropical Hadley Cell Since 1950“, untersuchten die Hadley-Zellen anhand des Hadley-Zirkulations-Index. Dies ist die Abweichung vom Mittel der zonalen Meridiangeschwindigkeit in der 200 hpa-Höhe minus des Mittels der zonalen Meridiangeschwindigkeit in 850 hpa-Höhe und steht für die Luftströmungen in der Hadley-Zelle (folgende Abbildung, obere Zeitreihe, Y-Achse = 1010 kg/s).

Abbildung 21: Wie nicht anders zu erwarten, sind die El Niño-Ereignisse unmittelbar mit der Aktivität in der Hadley-Zelle gekoppelt (obere Zeitreihe). Wie bereits gezeigt, sind die Auswirkungen von El Niño um den ganzen Globus zu verzeichnen, insbesondere in einem Band von ±30° nördlicher und südlicher Breite, was dem Gebiet der Hadley-Zellen entspricht (kleine Abbildung, oben). Wie die Gesamtabbildung zeigt, ist jeder El Niño einem Hadley-Ereignis direkt zugeordnet (rote gestrichelte Linien) und damit, wie bereits bewiesen, der solaren Aktivität unmittelbar zuzuordnen. Der Hadley-Zirkulations-Index wird aus der gemittelten Windgeschwindigkeit der 200 hpa-Höhe, minus der gemittelten Windgeschwindigkeit in der 850 hpa-Höhe gebildet und ist somit ein Maß für die Luftmassengeschwindigkeit und des Luftmassenstroms in der Hadley-Zelle. Die Abbildung zeigt, dass mit Eintreten eines El Niño-Ereignisse und des entsprechenden solaren Parameters, die Windgeschwindigkeiten in der Höhe zunehmen und in den unteren Schichten abnehmen. Dies ist auch der Schlüssel zu der Erkenntnis, dass die El-Niño-Auswirkungen nicht nur zonal (zwischen ±30° geographischer Breite), sondern global auftreten. Auch hier spielt CO2 keine Rolle. Die zonalen Energieströme zeigt Abbildung 22.

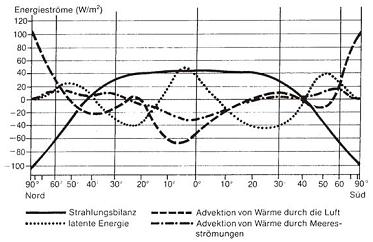

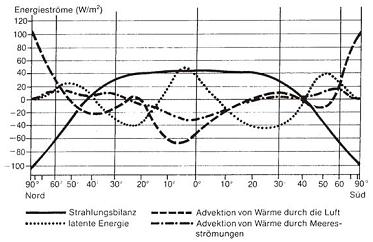

Abbildung 22 zeigt das Jahresmittel der Energieflüsse der Atmosphäre in Abhängigkeit von der geographischen Breite nach Häckel, 1990. Neben der Strahlungsbilanz dominieren die Flüsse von sensibler und latenter Wärme (Luftfeuchte). Die Advektion von Wärme durch die Luft, verhindert die Auskühlung der Pole. Gut zu sehen, wie Energie meridional transportiert wird, Quelle: Häckel, 1990, “Meteorologie“.

Abbildung 22 zeigt das Jahresmittel der Energieflüsse der Atmosphäre in Abhängigkeit von der geographischen Breite nach Häckel, 1990. Neben der Strahlungsbilanz dominieren die Flüsse von sensibler und latenter Wärme (Luftfeuchte). Die Advektion von Wärme durch die Luft, verhindert die Auskühlung der Pole. Gut zu sehen, wie Energie meridional transportiert wird, Quelle: Häckel, 1990, “Meteorologie“.

Aus dem Energietransport zwischen der Hadley-Zelle und den nördlichen Breiten, bzw. dem Luftmassenstrom über die Hadley-Zelle zu den nördlichen Breiten wird ersichtlich, dass El-Niño-Ereignisse über den Bereich der Hadley-Zelle Einfluss auf das Wettergeschehen haben, wie dies aus den Untersuchungen von Prof. Brönnimann und des MPI-M, sowie Prof. Malberg hervorgeht. Der Grund dafür liegt im Drehimpulserhaltungssatz.

Abbildung 23 zeigt das Druckverteilungsmuster und die Windverhältnisse der bodennahen Troposphäre. Im Absinkbereich der Hadley-Zelle bilden sich Hochdruckgebiete, wodurch dort trockenes Klima vorherrscht. So liegen in ihrem Bereich die Wüstengebiete der Erde. Durch die Passatwinde fließt ein stetiger Rückstrom (Oststrom) in Richtung Äquator. In der IPCZ fließt daher ein schwacher Ostwind. In der Westwinddrift der Ferrel-Zelle fließen die Frontensysteme der Tiefdruckgebiete nach Osten und zwar entlang des Polarfrontjet, an dem sich fortwährend Tiefdruckgebiete bilden. An der sich angrenzenden Polar-Zelle entsteht an der absinkenden schweren Kaltluft ein Hochdruckgebiet. Zwischen dem Druckgradient und der Corioliskraft bildet sich dort ein Gleichgewicht, welches einen schwachen Ostwind verursacht. Sowohl die Ostwinde der Subtropen/Tropen, als auch die Ostwinde der Polargebiete und der Westwind der mittleren Breiten sind mit einem Drehimpuls verbunden. Aus Gründen der Drehimpulserhaltung muss deren Summe Null ergeben.

Drehimpuls

Der Drehimpuls (Einheit: Nms) wirkt bei einer Kreisbewegung in Richtung Zentrum und gibt die Drehachse der Bewegung an. Er steht damit senkrecht zur Ebene, in der sich die Masse bewegt. Der Drehimpuls ist abhängig von der Geschwindigkeit, der Masse, sowie dem Abstand zur Drehachse. Bei Zunahme einer der drei vorgenannten Parameter, wächst der Drehimpuls an. Der Drehimpulserhaltungssatz gibt an, dass der Gesamtdrehimpuls in abgeschlossenen Systemen konstant ist.

Verändert sich z.B. der Drehimpuls auf Grund einer Geschwindigkeitszunahme der Luftströmungen in der Hadley-Zelle, wie im Hadley-Zirkulations-Index zu sehen, so muss dies wegen dem Drehimpulserhaltungssatz Auswirkungen auf die Luftströmungen in den beiden anderen Zellen (Ferrel- und/oder Polar-Zelle) haben. Wird die Geschwindigkeit der Luftströmungen durch ein solares Ereignis in der (oberen) Hadley-Zelle erhöht (bei einem El Niño-Ereignis), so sind durch die Kopplung über den Drehimpuls auch die anderen Zelle(n) beeinflusst. In der Ferrel-/Polarzelle stellen sich geringere Drehimpulse ein, was zu einem ruhigen, kalten Winter führt (siehe Untersuchungen von Prof. Brönnimann und des MPI-M). Jetzt wird auch sichtbar, warum sich ein schwächerer Polarwirbel ausbilden muss. Der Drehimpulserhaltungssatz lässt gar nichts anderes zu. Auch, dass Dürreperioden in den USA mit der ENSO verbunden sind. Die Winde in der oberen Troposphäre des Westwindgürtels, sowie der Polarfrontjet werden wegen der Verringerung des Drehimpulses und der damit verbundenen geringeren Luftmassenbewegung schwächer.

Da die Hadley-Zelle zeitlich begrenzt als geschlossenes System betrachtet werden kann, gilt für das geschlossene System der Energieerhaltungssatz. D.h., aufgrund der Trägheit und des Energieerhaltungssatzes muss eine Erhöhung der Windgeschwindigkeiten in der Höhe (Hadley-Zirkulations-Index) mit einer zeitlich begrenzten Verringerung der Windgeschwindigkeiten in niedriger Höhe verbunden sein, wodurch bei einem solaren Ereignis, dass zeitlich verzögert und zwar zu festen Zeiten, zu einem El Niño führt, die Passatwinde erschlaffen und den El-Niño damit erst auslösen. Ein El Niño-Ereignis wird bekanntlich durch die Erschlaffung der Passatwinde ausgelöst! Da die Hadley-Zelle jedoch mit der Ferrel-Zelle im Energieaustausch steht, wird die Energiezunahme, die ein solares Ereignis auslöst (und die Xiao-Wei Quan et al. gemessen haben, ohne jedoch zu wissen, auf was diese Änderungen im einzelnen beruhen, sie also auslöst), über diesen und den Jetstream wieder abgebaut, wodurch sich die „normalen“ Bedingungen wieder einstellen und die Passatwinde wieder an Kraft gewinnen und das El Niño-Ereignis zu Ende geht.

Aufgrund Naturbeobachtung und dem Anwenden physikalischer Grundgesetze lassen sich sowohl die Wettersysteme, El Niño-Ereignisse, als auch der global ermittelte Temperaturgang beschreiben. THG werden für nichts dergleichen benötigt und kommen folglich in der Betrachtung nicht vor, da weder Auswirkungen zu erkennen, noch nachweisbar sind. THG werden zur Erklärung nicht benötigt, mehr noch, sie widersprechen der tatsächlichen Beobachtung. Sie scheiden damit als Verursacher einer Klimabeeinflussung gänzlich aus!

Wir sollten uns in der Wissenschaft wieder mehr mit der Natur und ihrer Beobachtung befassen, wie dies durchgehend bis zur Treibhausgashysterie noch der Fall war. Denn, wie Einstein dies so treffend beschrieb: “Unsere Theorien sind freie Schöpfungen des menschlichen Geistes, und wir können nie sicher sein, dass sie die wirklichen Verhältnisse zutreffend darstellen.“ Die Richtigkeit einer Theorie vermag nur die Naturbeobachtung zu liefern. Entweder in Experimenten oder im „Labor“ der Natur selbst. Deutschlands bekanntester Naturforscher ist Alexander von Humboldt. Ein weiterer Vertreter ist Charles Darwin. Ihre Verdienste für die moderne Wissenschaft sind unbestritten.

Heute haben teilweise bezahlte Hasardeure das Regiment übernommen, die sich in Palästen abschotten und mit der modernen Glaskugel, den sog. Supercomputern, versuchen, Theorien zu beweisen. Gelingt dies nicht oder liefert die Natur gar die Beweise, die die Theorie stürzen, so wird durch Tricks oder gar Fälschungen versucht, die Theorie und damit das eigene Sein zu retten. All dies, mit enormen Geldsummen, unseren Steuermitteln, realisiert. Eine Schande für die Politik, wie im Namen sog. THG Unsummen an Steuergeldern und Vermögen verpulvert werden. Dass sich die deutsche Presse von einem investigativen Journalismus schon vor Jahren verabschiedete, verwundert angesichts der dort herrschenden naturwissenschaftlichen Blindheit nicht. Wegen der dortigen ideologischen Verblendung auch nicht, dass Lobbyisten aus NGO´s oder dem industriellen „Grünen Komplex“ (oftmals ein und dasselbe) unzensiert und ungeprüft ihre Lobbyvorstellungen unters Volk streuen und Lüge und Betrug als vermeintliche "Wahrheit" verkaufen. Angesichts der verbreiteten Desinformationen und Fälschungen möchte der Autor seinen Artikel denn auch mit einem Zitat des früheren Präsidenten der Max Planck Gesellschaft, Prof. Dr. Hubert Markl abschließen:

“Es ist nicht zu bestreiten, dass es auch in der Wissenschaft – häufiger als uns Wissenschaftlern lieb ist – Lug und Trug gibt, nicht nur fahrlässige Schlamperei, sondern wirklich absichtlichen Betrug.“

Raimund Leistenschneider – EIKE

Teil 1 finden Sie hier

Der vollständige Beitrag ist im Anhang als pdf herunter ladbar

Related Files

hier.

hier.