Das war eine absichtliche Untertreibung. Ich habe mich intensiv damit befasst zu sehen, ob der kalifornische Entwurf ökonomisch jemals irgendeinen Sinn erfüllen würde. Der Durchlauf der Ergebnisse durch mein einfaches Modell bestätigte, was viele schon lange geargwöhnt haben, womit aber bis jetzt nur wenige gerechnet haben: zu versuchen, unsere Emissionssünden zu vermindern, ist einer kostenineffektivsten Wege überhaupt, das Geld der Steuerzahler in die Tonne zu treten.

Ich habe die Kosten des kalifornischen Schemas in Höhe von 182 Milliarden Dollar multipliziert und die damit verbundenen Abschwächungsmaßnahmen nicht mit dem Faktor 10, sondern 2,5 zugrunde gelegt – ein Viertel der wirklichen Gesamtkosten während eines Jahrzehnts. Der Grund dafür, dass ich die festgestellten Kosten der kalifornischen Politik in dieser Hinsicht nur durch vier geteilt habe, ist die Kritik von Einigen an der Studie, aus der ich die Kosten in Höhe von 182 Milliarden Dollar abgeleitet habe – Varshney und Tootelian 2012 – in der die Kosten übertrieben worden seien.

Ich hätte wirklich eine minimale zwischenzeitliche Diskontrate von mindestens 5% anbringen sollen, was die Kosten auf 410 Milliarden Dollar drückt. In den aktualisierten Graphiken, die ich in diesem Beitrag vorstelle, habe ich diese Diskont-Rate korrekt einbezogen.

Mein Modell ist einfach und schließt Kosten und Vorteile außerhalb der CO2-Problematik aus: anders als bei anderen, aus der Literatur bekannten Methoden zähle ich als Vorteil der Abschwächung die Kosten, die wir durch die Verhinderung klimabezogener Schäden durch die Erwärmung einsparen im Vergleich zu den Kosten, die sich ergeben, wenn wir nicht sofort gegen das CO2 vorgehen.

Hinsichtlich der Vorteilsseite der Kosten habe ich ebenfalls intensiv versucht, nachsichtig mit jenen zu sein, die die Abschwächungsmaßnahmen vorschlugen. Ich habe die allgemein übertriebenen Schätzungen der Vermögensverluste durch Tatenlosigkeit zugrunde gelegt, die sich im Stern-Report über die wirtschaftlichen Folgen der Klimaänderung finden.

In Kürze sagt Stern, falls die anthropogene Erwärmung des 20. Jahrhunderts 3°C beträgt, was die zentrale Projektion des IPCC ist, würden die Kosten der klimabezogenen Schäden 0 bis 3% des Bruttoinlandproduktes [englisch: GDP] betragen (tatsächlich sagt er, „jetzt und für immer“, aber das ist keine ökonomische Analyse: es ist politische Angeberei! Margaret Thatcher würde sagen: „Don’t be silly, dear!”).

Also wäre der von Stern geschätzte Verlust an Wohlstand auf Grundlage der anthropogenen 3°C im Mittel von 0 bis 3%, d. h. 1,5% des GDP im 21. Jahrhundert. Auch dies sollte über das 10 Jahre lange bestehen dieses Schemas mit 5% diskontiert werden, was während dieser Periode 1,27% des GDP ausmachen würde.

Nun ist es allerdings so, dass ich angesichts der Fehler, der Übertreibungen und des Scheiterns der IPCC-Dokumente nicht einen Moment lang glaube, dass wir irgendetwas ähnlich der 3°C-Erwärmung bis zum Jahr 2100 sehen werden. Selbst das IPCC erwartet lediglich die Hälfte davon, oder 1,5°C, die es bis 2100 als Folge des von uns in diesem Jahrhundert emittierten CO2 geben soll. Es sind also lediglich diese 1,5°C, die man mit Maßnahmen zur CO2-Verringerung wahrnehmbar beeinflussen könnte.

Diese 1,5°C sind das Maximum der Erwärmung im 21. Jahrhundert, die wir verhindern könnten, selbst wenn wir im Jahr 2000 sämtliche CO2-Quellen geschlossen hätten. Die restlichen 1,5°C – etwa die Hälfte davon durch Gase ohne CO2 und die Hälfte der bereits aufgrund unserer Emissionen in der Vergangenheit eingetretenen Erwärmung – wird sich auf jeden Fall ereignen, egal welche Maßnahmen wie jene in Kalifornien man ergreift.

Auf dieser Grundlage sollte man die Vorteile aus den von Stern geschätzten 1,27% des eingesparten GDP halbieren. Aber wir wollen – wieder wohlwollend – einmal davon ausgehen, der Vorteil wäre bei Verhinderung der gesamten durch CO2 getriebenen Erwärmung im 21. Jahrhundert wirklich 1,27% des GDP.

Sollte das Modell die Möglichkeit berücksichtigen, dass der Zertifikatehandel in Kalifornien Gelegenheiten für zunehmende Arbeitsplätze schafft? Ich denke nicht. Wie es bei Friedland Multiple heißt: jeder Arbeitsplatz, der durch Subventionen geschaffen wird, zerstört zwei andere Arbeitsplätze unter den Steuern zahlenden Klassen; und einem kürzlichen schottischen Bericht zufolge zerstört jeder mit Mitteln des Steuerzahlers geschaffene „grüne Arbeitsplatz“ fünf andere Arbeitsplätze anderswo.

Warum hat Intel verkündet, es werde niemals wieder eine Fabrik in Kalifornien bauen? Warum wurde die Ölförderung aus Monterey Shale seit 1990 um mehr als ein Drittel gekürzt, obwohl die nachgewiesenen Reserven zugenommen haben? Warum hat es ein nahezu totales Moratorium bei Öl- und Gasbohrungen vor der kalifornischen Küste seit nunmehr 40 Jahren gegeben?

Warum beträgt die Arbeitslosigkeit in Kalifornien 11% – die zweithöchste Rate in den USA nach Nevada? Warum gibt es in der Bauwirtschaft eine Arbeitslosenrate von 50%, die im Gegensatz zu Vorteilen aus der Umrüstung von Gebäuden mit „grüner“ Technologie steht?

Warum weist der Staatshaushalt 2012/2013 ein Defizit von 6 Milliarden Dollar aus? Warum klafft in Kalifornien eine Finanzlücke von 200 bis 250 Milliarden Dollar in der Renten- und Pensionskasse, und wie soll man die Renten weiter zahlen können, wenn das so weiter geht?

Warum sind Sacramento Bee zufolge 50 000 hoch spezialisierte Kalifornier (ein Drittel der Gesamtzahl) in nur zwei Jahren geflüchtet? Warum haben sich 2011 doppelt so viele Firmen wie 2010 aus Kalifornien zurückgezogen? Warum sind Globalstar, Trizetto und eEye in nur einem Monat des vorigen Jahres geflüchtet? Warum sind Boeing, Toyota, Apple, Facebook, DirecTV, Hilton Hotels und Thomas Bros. Maps alle geflüchtet?

Es wäre falsch, alle diese Entscheidungen zur Flucht als direktes Ergebnis des kalifornischen Zertifikatehandels zu bezeichnen, und das habe ich auch nicht getan. Die Wahrheit ist, dass Kalifornien – lange dominiert von fest verwurzelten, hart linken Gewerkschaften und einer offen marxistischen Gesetzgebung – schon jetzt der bei Weitem am wenigsten industriefreundliche US-Bundesstaat ist. Der Zertifikatehandel wird die Lage noch erheblich verschlimmern. Die Wagen rollen schon in Richtung Osten: schon bald werden sie zu einer Sturzflut werden.

Wie ich in Sacramento den Gesetzgebern als Erstes erklärt habe, ist das erklärte Ziel ihres Zertifikatehandels, den CO2-Ausstoß in Kalifornien in dem Jahrzehnt seiner Gültigkeit um 25% zu vermindern. Aber die kalifornischen Emissionen betragen nur 8% der Gesamtemissionen in den USA, die wiederum 17% der Weltemissionen ausmachen.

Selbst wenn also der Zertifikatehandel so erfolgreich wäre, wie es seine Schöpfer gerne hätten, würden nur etwa 0,34% der globalen Emissionen – ein Drittel eines Prozentes – eingespart. In diesem Vergleich ist nichts, was auch nur ansatzweise kontrovers wäre, außer dass offenbar noch niemand vorher darauf hingewiesen hatte. Die Minen der Gesetzgeber waren versteinert, als ich ihnen das klarmachte.

Weil nur ein so kleiner Teil der globalen Emissionen durch das System eingespart werden würde, zeigen schon einfache, auf den zentralen Vermutungen des IPCC basierende Rechnungen, wie viel Erwärmung es in diesem Jahrhundert geben wird (was ich der Einfachheit halber jetzt mal als korrekt ansehe). Als Ergebnis der gesamten und erfolgreichen Operation des Schemas wird der CO2-Anteil bis zum Ende dieser Dekade von 410 ppmv auf – em – 409,93 ppmv fallen.

Die Verringerung des anthropogenen Strahlungsantriebs würde folglich weniger als 0,001 Watt pro Quadratmeter betragen, und die damit verminderte Erwärmung – warten Sie, warten Sie – atemberaubende 0,001°F (höchstens). Jawohl, weniger als ein Tausendstel Fahrenheit globaler Erwärmung würde verhindert – zu einem Preis in Höhe von 410 Milliarden Dollar selbst nach Anbringung eines Diskontsatzes.

Ist das ein Handel für die jetzt schon überbesteuerten, überregulierten Einwohner von Kalifornien? Wir berichten – Sie entscheiden!

Es ist wichtig zu verstehen, warum Maßnahmen, den CO2-Ausstoß abzuschwächen, immer unbezahlbar sein werden. Erstens, wie das kalifornische Beispiel zeigt, verändern lokale Abschwächungsmaßnahmen die globale CO2-Konzentration nicht messbar. Daher ist der anthropogene Strahlungsantrieb kaum verändert.

Also wird der Versuch Kaliforniens, die globale Erwärmung anzuhalten, nur eine so geringe Abkühlung zeitigen – im aktuellen Beispiel von weniger als einem Tausendstel Grad Fahrenheit – dass kein modernes Instrument oder Methode das feststellen kann. Selbst wenn das kalifornische Schema zu einem Schnitt von 25% der Emissionen im Staat führen würde (was es nicht wird), hätte der Staat keine Möglichkeit zu messen, dass er hinsichtlich des Bewirkens einer globalen Abkühlung erfolgreich war.

Nun könnten Sie einwenden, wie es einige Kommentatoren zu meinem Vortrag vor den kalifornischen Gesetzgebern getan haben, dass natürlich Kalifornien mit einem Alleingang kaum etwas bewirken würde. Jeder muss also Kalifornien folgen und so viele Wirtschaftszweige wie möglich schließen. Lassen Sie uns diese unattraktive Option einmal bewerten.

Ein wenig grundlegende Mathematik wird zeigen, dass die Kosten zur Verminderung der globalen Erwärmung um 1 Grad Fahrenheit durch weltweite Maßnahmen genauso spektakulär kostenineffektiv sind wie in Kalifornien, nahe 640 Trillionen Dollar – ziemlich viel mehr als eine ursprüngliche Schätzung von 454 Trillionen Dollar, weil ich so großzügig mit den Werten der Klimasensitivitätsparameter im Zeitraum von Jahrhunderten gewesen bin.

Sein Wert sollte 0,4 Kelvin pro Watt pro Quadratmeter nicht übersteigen, während ich großzügig den Parameter von 0,5 Kelvin pro Watt pro Quadratmeter übernommen hatte, wie er implizit im IPCC-Bericht 2007, Seite 13, Tabelle SPM.3. steht.

Alles zusammengefasst würden die Kosten für die Verminderung der Erwärmung um ein Drittel Grad Fahrenheit, was das IPCC als Erwärmung in dem Jahrzehnt der Laufzeit dieses Schemas annimmt, und falls jemand so lächerlich kostenineffektive Maßnahmen übernehmen würde, etwa 25 000 Dollar pro Kopf der Weltbevölkerung betragen, oder ein Drittel des globalen GDP während eines Jahrzehnts. Das wären 26 mal die Kosten, die entstehen könnten, wenn wir gar nichts zur Verhinderung der Erwärmung tun würden.

Ich habe absichtlich sehr vorsichtige Annahmen in meiner Präsentation vor der Versammlung in Sacramento gemacht, und ich habe den Legislatoren gesagt, dass Aktionen nur 11 mal so viel Kosten würden wie keine Aktionen. Aus mehreren Gründen erwarte ich, dass die Kostenineffektivität des kalifornischen Schemas (das in keiner Weise untypisch für solche Maßnahmen ist) deutlich schlimmer ausfallen wird als aus irgendwelchen meiner oben präsentierten Folien hervorgeht.

Zunächst ist es überhaupt nicht wahrscheinlich, dass das Schema hinsichtlich einer Abschwächung der kalifornischen Emissionen um 25% erfolgreich sein wird. Die Schemata der EU und von Neuseeland haben die Emissionen nicht um einen Deut verringert, und das Schema der EU bricht – zum vierten Mal hintereinander – zusammen, da die Kosten für das Recht, eine Tonne CO2 zu emittieren, unter 8 Dollar gefallen sind. Vor einigen Tagen gab es wieder einen deutlichen Rückgang, und – wenn es so weitergeht wie bisher – könnte es enden wie der inzwischen gescheiterte Kohlenstoffhandel in Chikago, wo der Preis unter 10 Cent pro Einheit gefallen war.

Nun haben natürlich die Diktatoren der EU [!] die Macht, den Umfang der Zertifikate künstlich zu verknappen, um die Preise in die Höhe zu treiben. Das ist der Grund, warum der Zertifikatehandel kein – ich wiederhole: kein – Instrument des Marktes ist. Es ist der Wunschtraum jedes Tyrannen und der Alptraum aller Geschäftsleute. Deswegen verlassen immer mehr emissionsintensive Branchen Europa und werden demnächst die Flut der schon jetzt aus Kalifornien flüchtenden Industrien verstärken.

Aus diesen und vielen anderen Gründen tendiert mein Modell dazu, die Abschwächung der Erwärmung zu übertreiben, die irgendwelche CO2-Reduktionen hervorrufen könnten, und auch dazu, die Kostenineffektivität zu untertreiben. Zum Beispiel geht das IPCC von einer Verweildauer des CO2 in der Atmosphäre von 50 bis 200 Jahren aus: Falls das so sein sollte, wird es kaum irgendeine Abschwächung im 21. Jahrhundert geben.

Auch legen meine Zahlen nahe, dass jede politisch getriebene Maßnahme zur Reduktion der CO2-Konztentration sofort stattfindet, obwohl sie wahrscheinlich schrittweise zwischen dem Start- und dem Endjahr erfolgt. Dies würde die Abschwächung jenes Jahres halbieren und die Kostenineffektivität verdoppeln. Wenn die zentralen Projektionen des IPCC (auf denen meine Berechnungen basieren) die Erwärmung weiterhin so übertreiben, die sich aus einer vorausgesetzten Zunahme der CO2-Konzentration in der Atmosphäre ergibt, könnte die Kosteneffektivität noch geringer sein als gezeigt.

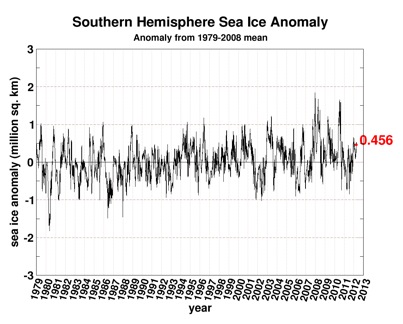

Bisher gab es seit dem Jahr 2001 überhaupt keine Erwärmung mehr. Tatsächlich gab es neuesten Daten des Hadley Centers und der CRU an der UEA zufolge seit vollen 15 Jahren keine statistisch signifikante Erwärmung mehr.

Natürlich sind solche Perioden stagnierender Temperatur ziemlich oft in den Aufzeichnungen zu finden. Sie bedeuten nicht, dass es keine weitere Erwärmung in Zukunft geben wird. Aber sie drücken die Rate der Erwärmung, welche nicht einmal in der Nähe der ungerechtfertigten zentralen alarmistischen Schätzungen des IPCC liegt.

Die CO2-Emissionen steigen derzeit nach dem A2-Szenario des IPCC, die Zunahme der CO2-Konzentration war ein Jahrzehnt lang nahezu linear. Sie könnte bis zum Jahr 2100 deutlich unter der Hauptschätzung des IPCC von 700 ppmv liegen.

Der von mir verwendete Klimasensitivitätsparameter gilt im Zeitmaßstab eines Jahrhunderts: daher ist ein kleinerer Koeffizient für den von den Studien betrachteten Zeitraum angemessen (der Tatsache geschuldet, dass längerzeitliche Temperaturrückkopplungen sich noch nicht ausgewirkt haben). Konsequenterweise würde eine geringere Abschwächung der Erwärmung die Kosteneffektivität weiter reduzieren.

Und schließlich ignorieren meine Berechnungen alle verpassten Gelegenheiten, von Ressourcen zur Abschwächung der globalen Erwärmung abzulenken. Allerdings können es sich die schon jetzt der industriefeindlichen Volksrepublik Kalifornien entfliehenden Industrien nicht leisten, solche vitalen Überlegungen zu ignorieren. Dies ist der Grund, warum jedes Individuum und jede Firma, die bereit sind zu gehen, bereits gegangen sind.

Die hier gezeigten Graphiken sind absichtlich sehr vereinfacht, aber es ist nichtsdestotrotz eine sehr erhellende Methode, die zentralen klimatologischen Projektionen des IPCC mit den Standards ökonomischer Techniken zu kombinieren, um nicht spezialisierten politischen Entscheidungsträgern leicht zu ermöglichen, eine halbwegs verlässliche Abschätzung der Kosten und Vorteile von Maßnahmen vorzunehmen, die die CO2-Emissionen vermindern.

Meine Methode ist in zweierlei Hinsicht einmalig. Erstens hat vorher noch niemand die Klimatologie des IPCC mit ökonomischen Methoden so direkt kombiniert. Zweitens erlaubt es diese Methode zum ersten Mal, selbst lokale politische Maßnahmen zu evaluieren und mit konkurrierenden Maßnahmen anderswo zu vergleichen.

Falls jemand eine Kopie dieser Studie haben möchte, in der die Methode erklärt und die Gleichungen begründet werden, kontaktieren Sie mich bitte (monckton@mail.com) Ich übermittle sie Ihnen sehr gerne und begrüße Ihre Kommentare. Ich kann sie noch nicht posten, weil ich nach der Präsentation dieser Gedanken auf der Dritten Santa Fe-Klimakonferenz im vorigen November aufgefordert worden bin, die Studie einem Fachjournal zur Veröffentlichung zu übermitteln, und die endgültige Fassung geht gerade an die Begutachter.

Einer meiner noblen Freunde hat mir erzählt, dass er die Analyse dem obersten wirtschaftlichen Berater des Finanzministeriums in UK übermittelt habe. Jedoch kann man dort nicht allzu viel tun, weil die britische Umweltpolitik jetzt von den nicht gewählten Kommissaren in Brüssel festgelegt wird. Seine Botschaft an die Mandarine: „Wie man in Londoner Versicherungskreisen sagt: Wenn der Versicherungsbeitrag die Kosten des Risikos übersteigt, versichern Sie sich nicht!“

Angesichts der ausufernden Kosten für die Abschwächung (man betrachte nur all diese Wagen, die die außerordentlich nutzlose Überregulierung und Über-Besteuerung in Kalifornien verlassen) erhebt sich die Frage, ob man überhaupt versuchen soll, die CO2-Emissionen abzuschwächen.

Aus wirtschaftlicher Sicht ist das Fazit brutal einfach und vollkommen klar. Maßnahmen zur CO2-Abschwächung, die preiswert genug sind, um bezahlbar zu sein, entpuppen sich als ineffektiv, und Maßnahmen, die effektiv sind, sind unbezahlbar.

Christopher Monckton; Viscount of Brenchley

Link: http://wattsupwiththat.com/2012/04/04/why-mitigating-co2-emissions-is-cost-ineffective/

Übersetzt von Chris Frey EIKE

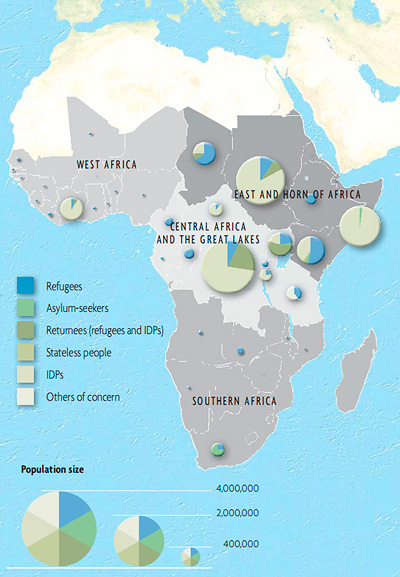

(Geisler/Sousa: From Refuge to Refugee, the African Case. 2000)

(Geisler/Sousa: From Refuge to Refugee, the African Case. 2000)