Folgen des Klimawandels in den USA bleiben aus

von Craig Loehle, PhD

In vielen Regierungsberichten von NASA, NOAA, EPA, USFWS, USFS, USDA und weiteren Behörden steht, dass die Folgen des Klimawandels in den USA bereits zu bemerken wären. Darüber wird geschrieben im Zusammenhang mit der Erhaltung gefährdeter Arten, Waldzustandsbeurteilungen, zukünftiger Wasserverfügbarkeit, Katastrophenplanung, Landwirtschaftspolitik usw. Ich habe viele solche Berichte gelesen, die sich oft auf das IPCC berufen oder das amerikanische Global Change Research Program (Programm zur Erforschung der globalen Veränderungen).

Normalerweise bleiben die Beurteilungen vage, wenn es um die Einzelheiten zukünftiger schlimmer Zustände geht, im allgemeinen wird auf das Ansteigen extremer Ereignisse verwiesen. Trotzdem werden solche schlimmen Zustandsbeschreibungen als Leitlinien für die Politik benutzt

Die USA verfügen über die besten Daten und sie sind ein großes Land. Sind wirklich schlimme Auswirkungen des Klimawandels zu beobachten?

Im Folgenden beschäftige ich mich mit den Indizien, die häufig vorgebracht werden, um die Behauptungen zu stützen und ich werde sie anhand der Fachliteratur überprüfen. Der wahre Sachverhalt ist weit davon entfernt, alarmierend zu sein.

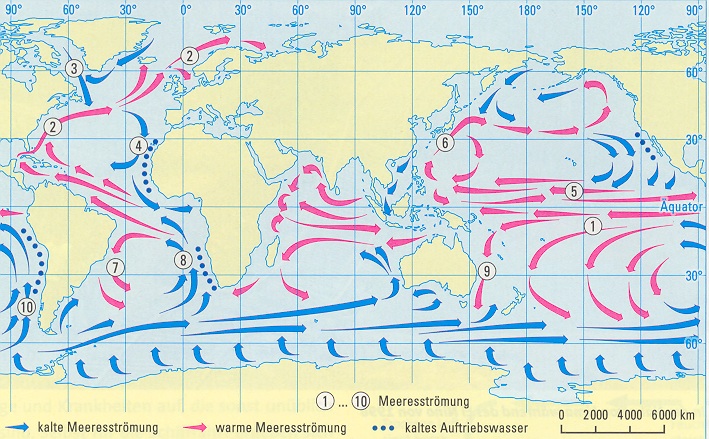

Versauerung der Meere

In einem Regierungsentwurf hieß es, das der pH-Wert der Meere um 0,1 Einheiten abgenommen hätte (mehr in Richtung “sauer”), und dass dies ein 30%iger Anstieg seit 1750 sei.

Weil pH eine logarithmische Skala ist, ist die Abschätzung von prozentualen Zunahmen problematisch: Eine Veränderung von 0.1 Einheiten kann nicht eine 30%ige Veränderung bedeuten, wie behauptet wurde. Ein ernsthafter, nicht im Bericht angesprochener Einwand ist, dass Langzeitaufzeichnungen für pH-Werte des Meeres nicht existieren. Deshalb ist das Vorkommnis einer Veränderung von 0.1 Einheiten bezweifelbar, die Spreizungsbreite der Gewissheit für eine solche Schätzung wäre zweifelsohne sehr groß. Außerdem sind tägliche, jahreszeitliche und jährliche pH-Fluktuationen an jedem beliebigen Punkt in einer Größenordnung von ±0.3 pH Einheiten oder darüber (Middelboe and Hansen 2007; Pelejero et al. 2005).

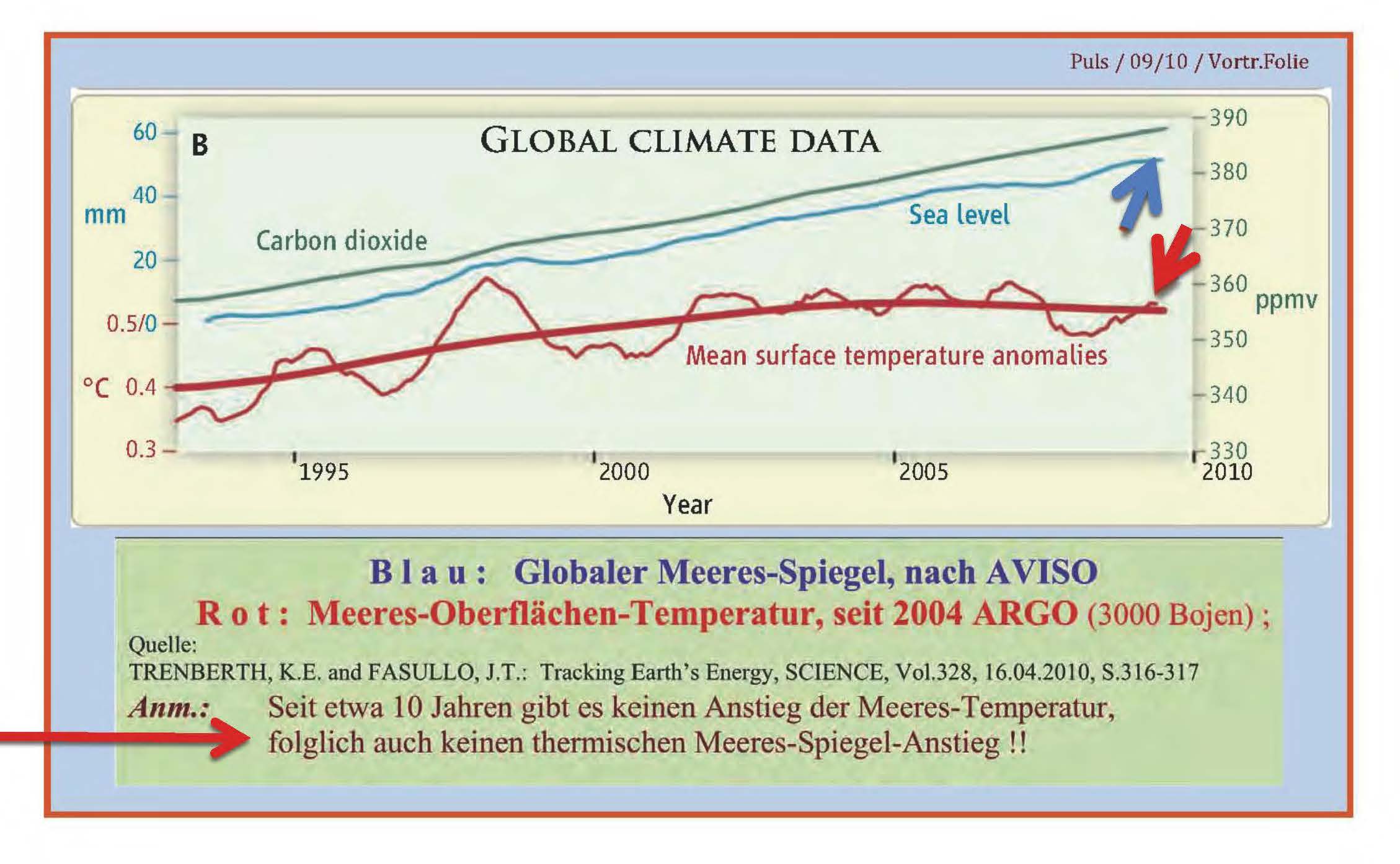

Meeresspiegel-Anstieg

Einige Berichte behaupten, dass der Meeresspiegel-Anstieg eine Gefahr für die natürlichen Lebensräume der Vereinigten Staaten wäre. Andere konzentrieren sich auf die Risiken für entwickelte Gebiete. Dem Intergovernmental Panel on Climate Change (IPCC) zufolge steigen die Temperaturen wegen der menschlichen Aktivitäten seit 1980, die Schätzungen des Anstiegs der Meeresspiegel zeigen aber einen Anstieg seit etwa 1870 (früheste Aufzeichnungen) mit nahezu linearer Zunahme und ohne ein Zeichen von Beschleunigung. Der Meeresspiegel-Anstieg von 1870 bis 1980 ist wahrscheinlich nicht menschlich verursacht.

In einem Bericht steht, dass das IPCC einen Anstieg des Meeresspiegels von 0,4 m bis 2 m bis 2090 projiziert, aber der vierte IPCC-Bericht [AR4] macht diese Behauptung nicht, er gibt eine bestmögliche Schätzung von 0,28 bis 0,43 m an. Die jüngsten Anstiegsraten (http://sealevel.colorado.edu) mit einem 3,1 mm/Jahr Langzeit-Trend oder 0,31 m in 100 Jahren ohne Anzeichen einer “Beschleunigung,” stehen nur im Einklang mit der niedrigsten IPCC-Projektion. Tatsächlich wurde sogar eine Verlangsamung der Anstiegsrate festgestellt (Houston and Dean 2011). Beispiele für Papiere, die Meeresspiegel-Anstiege unterhalb der Bandbreite der IPCC-AR4-Projektionen sehen, sind: Bouwer (2011), Chu et al. (2010), Czymzik et al. (2010), Xie et al. (2010).

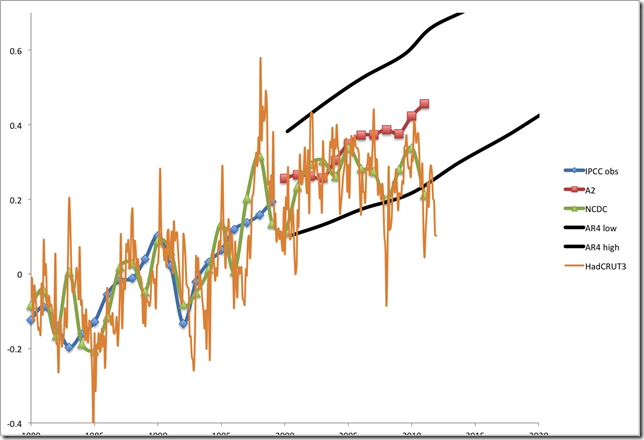

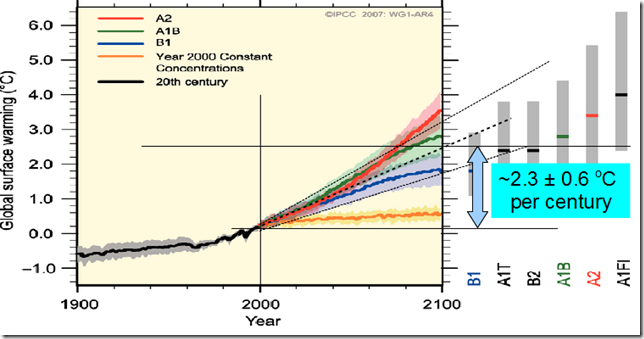

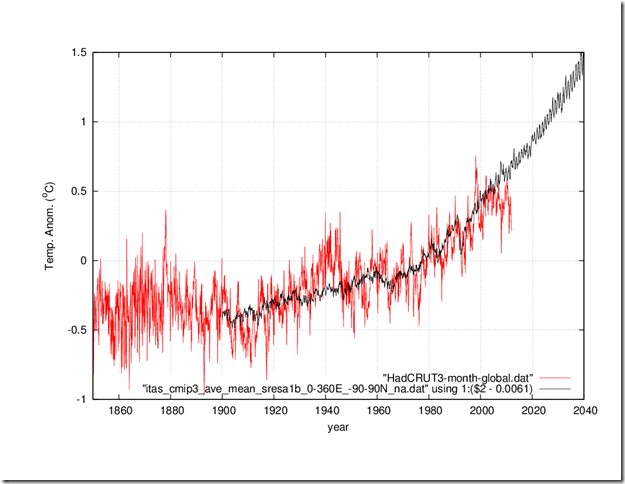

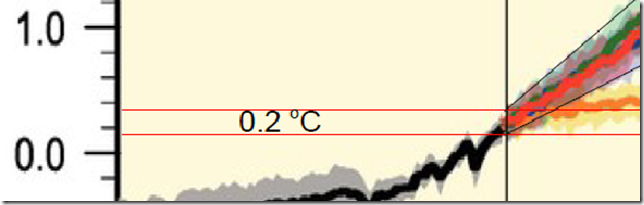

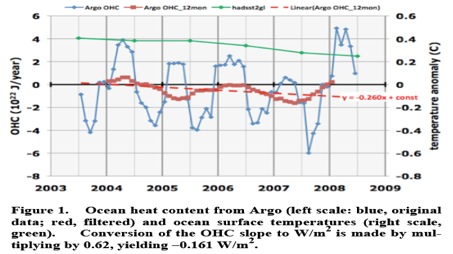

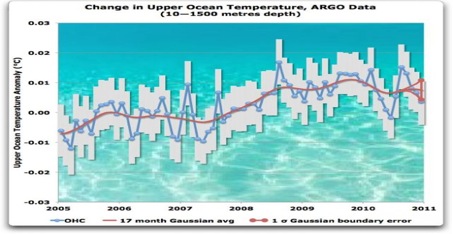

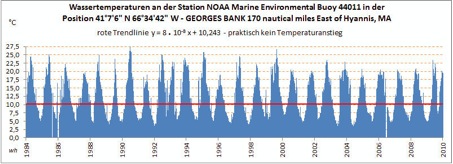

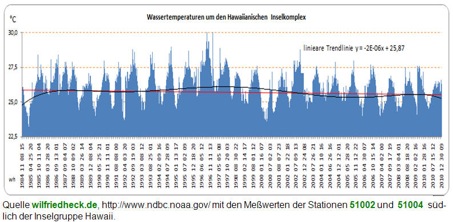

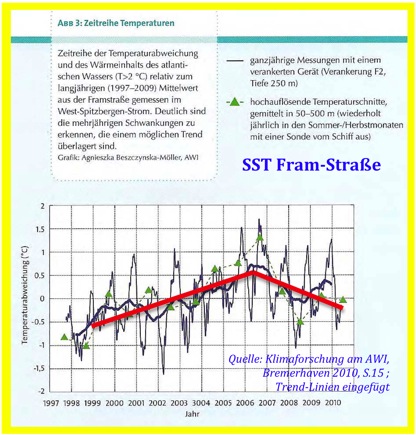

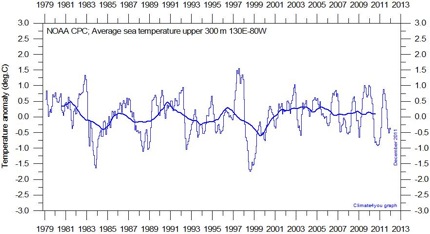

Temperatur-Anstieg

Regierungsamtliche Berichte melden, dass die US-Temperaturen seit 1961 um 2°F seit 1961 angestiegen seien. Schlussfolgerungen über das Aumaß des Temperatur-Anstiegs hängen aber stark vom Beginn-Datum der Berechnung ab. Zufällig erzeugt das Beginn-Datum 1961 den beunruhigendsten Anstieg. Dem steht ein Zeitraum von 1938 bis 2011 entgegen, wo kein Anstieg in den USA stattfand. Das gleiche gilt für die Veränderungen der Meeresoberflächen-Temperaturen. Sie ist auf natürliche Klima-Schwankungen zurückzuführen (e.g., Wyatt et al. 2011), die eine warme Periode in der Mitte des 20. Jh. verursachten und eine kalte Periode in den 1960ern.

Überschwemmungen

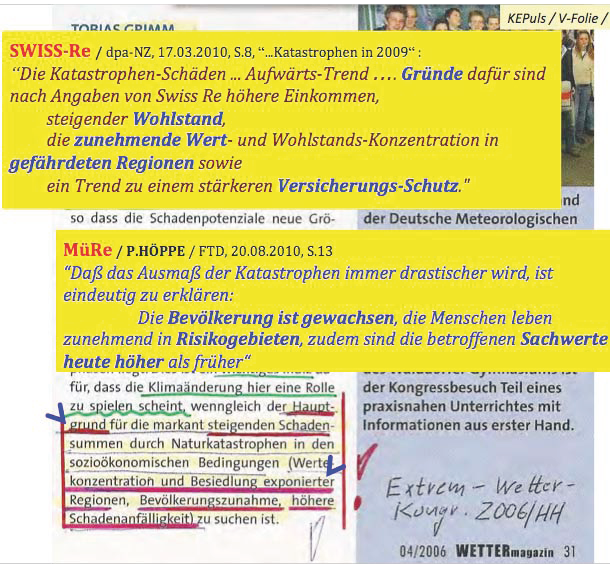

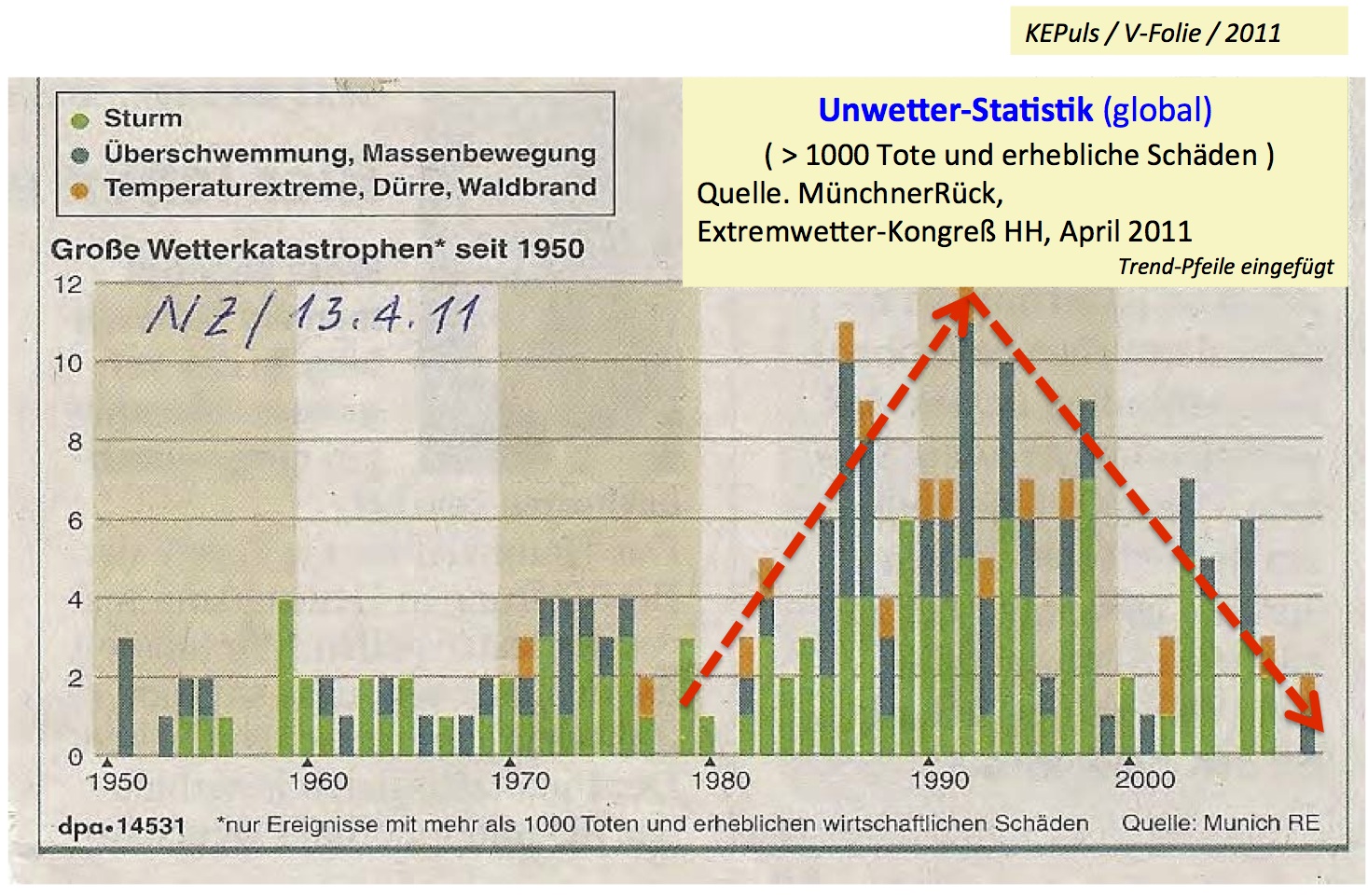

Berichte behaupten, dass Überschwemmungen zunähmen. Aber in den Daten ist das nicht zu erkennen. Hirsh und Ryberg (2011) haben gezeigt, dass es in keinem Gebiet der USA einen Trend hin zu stärkeren Überschwemmungen gibt, eine geringe Abnahme im Südwesten fand statt. Arrigoni et al. (2010) zeigten, dass der Klimawandel in den nördlichen Rocky Mountains seit 59 Jahren die Gewässereinzugsgebiete nicht beeinträchtigt hat, obgleich die Veränderungen durch die Lebensräume des Menschen die Unterschiede zwischen hohen und niedrigen Fluss-Mengen vermindert haben. Kundezewicz et al. (2005) haben in einer umfassenden Analyse von 195 langen Serien von täglichen Flussmengenaufzeichnungen die Hypothese einer Zunahme der täglichen Maxima verworfen. Der ansteigende Trend bei der Zunahme der Überschwemmungsschäden kann vollständig auf die steigende Bevölkerungsanzahl und deren Wohlstand zurückgeführt werden.

Häufigkeit regionaler Dürren

Berichten zufolge nehmen regionale Dürren nach Häufigkeit und Schwere zu. Typisch ist jedoch, dass solche Behauptungen in den Berichten mit keinerlei zuverlässigen Daten unterfüttert werden. Dürren sind schwierig zu charakterisieren, die entsprechenden Methoden sind mit der Zeit immer komplexer geworden. Die Abgrenzung eines Dürre-“Gebietes” ist extrem subjektiv und es gibt keine Standardmethoden dafür, auch keine standardisierten Daten.

Die Niederschlagsdaten und die Daten über Dürren scheinen nicht die Behauptung zunehmender Dürren-Häufigkeit und Stärke zu stützen. Sie deuten eher in die Richtung, dass die Dürre-Muster komplex sind. Es gab z. B. eine 5%ige Zunahme im Gesamtniederschlag in den USA, aber keine Zunahme der Trockenheit. Sheffield et al. (2009) fanden heraus, dass große Dürren mit der ENSO (El Nino Southern Oszillation) und den nordpazifischen und atlantischen Meeresoberflächen-Temperaturen (SSTs) zusammenhängen. Der Zusammenhang mit der ENSO wird durch eine Studie über den Südwesen der USA durch (McCabe et al. 2010) belegt. Weltweit waren die Mitt-1950er die Jahre mit der höchsten Anzahl von Dürren, die Mitt-1970er bis 1980er hatten die niedrigsten Vorkommens-Zahlen. Das ist kein einfacher, zunehmender Trend. Wieder ist die Festlegung der Mitt-1970er als Beginn-Datum die Ursache für die Herausbildung eines falschen zunehmenden Trends.

Heftige Gewitter-Ereignisse

Auswerteberichte behaupten, dass extrem heftige Gewitter zunähmen, obgleich Berichte über zunehmende Heftigkeit der Gewitter in keinem Regierungs-Archiv zu finden oder dokumentiert sind. “Gewitter” ist noch nicht einmal in der Klimatologie ein wohldefiniertes Objekt.

Es gibt offensichtlich seit geraumer Zeit eine Zunahme von Tornados. Aber die Verbesserungen in der Radar-Qualität und Beobachtungsüberdeckung während der vergangenen Jahrzehnte führen zu einem Entdeckungshäufigkeits-„Fehler“, weil immer mehr kleinere Tornados erkannt und aufgezeichnet werden. Darüberhinaus haben verbesserte Schutzvorkehrungen und Katastrophen-Maßnahmen zu häufigeren Meldungen und der Auslösung von Maßnahmen auch bei kleineren Stürmen geführt. Wenn man nur die Kategorien F4 und F5 zählt, die relativ konsistent entdeckt und aufgezeichnet werden, dann hat es keinen Trend währen der vergangenen 100 Jahre gegeben (Balling and Cerveny 2003).

Hurrikane

Angeblich nimmt die Stärke der Hurrikane zu. Das ist wahrscheinlich auf die verbesserte Bereichsabdeckung und Auflösung durch Satelliten zurückzuführen. Sie hat zu einer genaueren Erfassung und Erkennung der Stunden geführt, in denen ein Sturm maximale Stärke hat. Eine Studie, die die Entdeckungsmöglichkeiten in den verschiedenen Zeiträumen berücksichtigt (Vecchi and Knutson 2011) findet keinen Trend bei den Atlantik-Hurrikanen von 1878 bis 2008. Auch Studien über Hurrikane, die zum Festland zogen (Balling and Cerveny 2003), zeigen keinen Trend. Der letzte cat 3+ Hurrikan, bei dem das „Hurrikan-Auge“ über die kontinentalen USA zog, kam 2005 vor.

Brände

Bericht legen nahe, dass wärmere Temperaturen und sich verändernde Niederschlagsmuster zu mehr Bränden führten und deren jahreszeitliches Vorkommen veränderten. Indianer und frühe Europäische Siedler haben das Feuer extensiv genutzt. In Gebieten, die der landwirtschaftlichen Nutzung zugeführt wurden, (z. B. die Great Plains [im mittleren Westen]) gibt es fast kein Brände mehr. In einigen Wäldern im Westen gibt es mehr brennbare Masse als vor 200 Jahren.

Auch unter Berücksichtigung der Landschaftsveränderungen hat niemand eine Veränderung von Brandmustern in den USA feststellen können, die auf den Klimawandel zurückgeführt werden könnte. Die größten historischen Brände fanden im Westen vor rund 100 Jahren statt. Menschliche Tätigkeiten (Veränderungen der brennbaren Massen, mehr Entzündungsquellen, Brandstiftung) haben dagegen klar dokumentierte Wirkungen auf das Ausmaß von Bränden, wie auch die Politik des „Brennen-lassens“ im Westen, wie sie erst seit ein paar Jahrzehnten verfolgt wird.

Algenblüten

In Berichten steht, dass bösartige Algenblüten in marinen Ökosystemen häufiger, stärker und weiter verbreitet seien. Der Klimawandel ist nur ein Faktor, der bösartige Algenblüten hervorrufen kann, daneben ist der zunehmende Nährstoff-Eintrag wichtig.

Es gibt keine Veranlassung, Trends von Algenblüten dem Klimawandel zuzuschreiben. Auch hier besteht eine verbesserte Entdeckungswahrscheinlichkeit durch die seit Jahren zunehmende Verbesserung der Satelliten-Aufzeichnung.

Veränderungen der Ökosysteme

Es gibt Studien, die Reaktionen der Biota “im Einklang” mit der Erwärmung zeigen. Aber die meisten Veränderungen sind tatsächlich positiv. Negative Auswirkungen dagegen werden hypothetisiert (z. B. die „Phänologie“ könnte unterbrochen werden.) Aber Veränderungen im Vogelzug und bei den Nistzeiten deuten in Richtung von Anpassung und nicht in Richtung einer beunruhigenden Situation.

Die Studien zeigen eine weltweite Zunahme der primären Netto-Vermehrung während der vergangenden 50 – 100 Jahre, mit wenigen lokalen Ausnahmen (Alcaraz-Segura et al. 2010; Bellassen et al. 2011; Jia et al. 2009; Kohler et al. 2010; Lin et al. 2010; Nemani et al. 2003; Tian et al. 2010). Das wird auf ansteigenden CO2-Gehalt und zunehmende Temperaturen zurückgeführt. Wenn die Erwärmung seit der Kleinen Eiszeit zu ansteigender Netto-Vermehrung führt, wird es schwierig, sie als problematisch hinzustellen.

Schlussfolgerung

Die Behauptung, dass schlimme Auswirkungen des Klimawandels in den USA “bereits“ festgestellt werden könnten, ist völlig subjektiv, hypothetisch und ohne Beweise.

Referenzen

Aitken, S.N., Yeaman, S., Holliday, J.A., Wang, T., and Curtis-McLane, S. 2008. Adaptation, migration or extirpation: climate change outcomes for tree populations. Evolutionary Applications 1:95 111.

Alcaraz-Segura, D., Chuvieco, E., Epstein, H.E., Kasischke, E.S., and Trishchenko, A. 2010. Debating the greening vs. browning of the North American boreal forest: differences between the satellite datasets. Global Change Biology 16:760 770.

Anagnostopoulos, G.G., Koutsoyiannis, D., Christofides, A., Efstradiadis, A., and Mamassis, N. 2010. A comparison of local and aggregated climate model outputs with observed data. Hydrological Sciences Journal 55:1094 1110.

Arrigoni, A.S., Greenwood, M.C., and Moore, J.N. 2010. Relative impact of anthropogenic modifications versus climate change on the natural flow regimes of rivers in the northern Rocky Mountains, United States. Water Resources Research 46:W12542; doi:10.1029/2010WRO09162.

Balling, R.C., and Cerveny, R.S. 2003. Compilation and discussion of trends in severe storms in the United States: Popular perception v. climate reality. Natural Hazards 29(2):103 112.

Bellassen, V., Viovy, N., Luyssaert, S., LeMarie, G., Schelhaas, M.-J., and Ciais, P. 2011. Reconstruction and attribution of the carbon sink of European forests between 1950 and 2000. Global Change Biology 17:3274 3292.

Bouwer, L.M. 2011. Have disaster losses increased due to anthropogenic climate change? Bulletin of the American Meteorological Society 92:39 46.

Chu, P.-S., Chen, Y.R., and Schroeder, T.A. 2010. Changes in precipitation extremes in the Hawaiian islands in a warming climate. Journal of Climate 23:4881 4900.

Cole, K. 1985. Past rates of change, species richness and a model of vegetational inertia in the Grand Canyon, Arizona. American Naturalist 125:289 303.

Cole, K.L. 2009. Vegetation response to early Holocene warming as an analog for current and future changes. Conservation Biology 24:29 37.

Cwynar, L.C., and Spear, R.W. 1991. Reversion of forest to tundra in the central Yukon. Ecology 72:202 212.

Czymzik, M., Dulski, P., Plessen, B., von Grafenstein, U., Naumann, R., and Brauer, A. 2010. A 50 year record of spring‐summer flood layers in annually laminated sediments from Lake Ammersee (southern Germany). Water Resources Research 46:W11528; doi:10.1029/2009WR008360.

Hirsch, R.M., and Ryberg, K.R. 2011. Has the magnitude of floods across the USA changed with global CO2 levels? Hydrological Sciences Journal doi:10.1080/02626667.2011.621895.

Houston, J.R., and Dean, R.G. 2011. Sea-level acceleration based on U.S. tide gauges and extensions of previous global-gauge analyses. Journal of Coastal Research doi:10.2112/JCOASTRES D 10 00157.1.

Jia, G.J., Epstein, H.E., and Walker, D.A. 2009. Vegetation greening in the Canadian arctic related to decadal warming. Journal of Environmental Monitoring 11:2231 2238.

Kohler, I.H., Poulton, P.R., Auerswald, K., and Schnyder, H. 2010. Intrinsic water-use efficiency of temperate seminatural grassland has increased since 1857: An analysis of carbon isotope discrimination of herbage from the Park Grass Experiment. Global Change Biology 16:1531 1541.

Kundzewicz, Z.W., Graczyk, D., Maurer, T., Pinskwar, I., Radziejewski, M., Svensson, C., and Szwed, M. 2005. Trend detection in river flow series: 1. Annual maximum flow. Hydrological Sciences Journal 50(5):797 810.

Lin, D., Xia, J., and Wan, S. 2010. Climate warming and biomass accumulation of terrestrial plants: A meta-analysis. New Phytologist 188:187 198.

Loehel, C. 1998. Height growth rate tradeoffs determine northern and southern range limits for trees. Journal of Biogeography 25:735 742.

Loehle, C. 2000. Forest ecotone response to climate change: sensitivity to temperature response functional forms. Canadian Journal of Forest Research 30:1632 1645.

Loehle, C. 2003. Competitive displacement of trees in response to climate change or introduction of exotics. Environmental Management 32:106 115.

Loehle, C. 2011. Criteria for assessing climate change impacts on ecosystems. Ecology and Evolution doi:10.1002/ece3.7.

Loehle, C., and LeBlanc, D.C. 1996. Model-based assessments of climate change effects on forests: a critical review. Ecological Modelling 90:1 31.

Masek, J.G. 2001. Stability of boreal forest stands during recent climate change: Evidence from Landsat satellite imagery. Journal of Biogeography 28:967 976.

McCabe, G.J., Legates, D.R., and Lins, H.F. 2010. Variability and trends in dry day frequency and dry event length in the southwestern United States. Journal of Geophysical Research 115:D07108; doi:10.1029/2009JD012866.

Middelboe, A.L. and Hansen, P.J. 2007. High pH in shallow-water macroalgal habitats. Marine Ecology Progress Series 338: 107-117

Morin, X., Lechowicz, M.J., Augspurger, C., O’Keefe, J., Viner, D., and Chuine, I. 2009. Leaf phenology in 22 North American tree species during the 21st century. Global Change Biology 15:961 975.

Nemani, R.R., Keeling, C.D., Hashimoto, H., Jolly, W.M., Piper, S.C., Tucker, C.J., Myneni, R.B., and Running, S.W. 2003. Climate-driven increases in global terrestrial net primary production from 1982 to 1999. Science 300:1560 1563.

Noble, I.R. 1993. A model of the responses of ecotones to climate change. Ecological Applications 3:396 403.

Payette, S. 2007. Contrasted dynamics of northern Labrador tree lines caused by climate change and migration lag. Ecology 88:770 780.

Pelejero, C., Calvo, E., McCulloch, M.T., Marshall, J.F., Gagan, M.K., Lough, J.M. and Opdyke, B.N. 2005. Preindustrial to modern interdecadal variability in coral reef pH. Science 309: 2204-2207

Schliep, E. M., Cooley, D., Sain, S.R., and Hoeting, J.A. 2010. A comparison study of extreme precipitation from six different regional climate models via spatial hierarchical modeling. Extremes 13:219 239.

Sheffield, J., Andreadis, K.M., Wood, E.F., and Lettenmaier, D.P. 2009. Global and continental drought in the second half of the twentieth century: Severity-area-duration analysis and temporal variability of large-scale events. Journal of Climate 22:1962 1981; doi:10.1175/2008JCLI2722.1.

Stephens, G. L., L’Ecuyer, T., Forbes, R., Gettlemen, A., Golaz, J.-C., Bodas-Salcedo, A., Suzuki, K., Gabriel, P., and Haynes, J. 2010. Dreary state of precipitation in global models. Journal of Geophysical Research 115:D24211.

Tian, H., Chen, G., Liu, M., Zhang, C., Sun, G., Lu, C., Xu, X., Ren, W., Pan, S. and Chappelka, A. 2010. Model estimates of net primary productivity, evapotranspiration, and water use efficiency in the terrestrial ecosystems of the southern United States during 1895-2007. Forest Ecology and Management 259:1311 1327.

Tinner, W., Bigler, C., Gedye, S., Gregory-Eaves, I., Jones, R.T., Kaltenrieder, P., Krähenbühl, U., and Hu, F.S. 2008. A 700-year paleoecological record of boreal ecosystem responses to climatic variation from Alaska. Ecology 89:729 743.

Vecchi, G.A. and Knutson, T.R. 2011. Estimating annual numbers of Atlantic hurricanes missing from the HURDAT database (1878-1965) using ship track density. Journal of Climate 24:1736 1746; doi:10.1175/2010JCLI3810.1.

Wertin, T.M., McGuire, M.A., and Teskey, R.O. 2010. The influence of elevated temperature, elevated atmospheric CO2 concentration and water stress on net photosynthesis of loblolly pine (Pinus taeda L.) at northern, central and southern sites in its native range. Global Change Biology 16:2089 2103.

Williams, J.W., Tarasov, P., Brewer, S., and Notaro, M. 2011. Late Quaternary variations in tree cover at the northern forest-tundra ecotone. Journal of Geophysical Research 116:G01017.

Woollings, T. 2010. Dynamical influences on European climate: An uncertain future. Philosophical Transactions of the Royal Society A 368:3733 3756.

Wyatt, M.G., Kravisov, S., and Tsonis, A.A. 2011. Atlantic Multidecadal Oscillation and Northern Hemisphere’s climate variability. Climate Dynamics doi:10.1007/s00382 011 1071 8.

Xie, B., Zhang, Q., and Wang, Y. 2010. Observed characteristics of hail size in four regions in China during 1980–2005. Journal of Climate 23:4973 4982.

Original hier.

Übersetzung: Helmut Jäger, EIKE

aus. oder

aus. oder  so, oder

so, oder  so, oder

so, oder  so, oder

so, oder  so

so gibt:

gibt: h i e r:

h i e r: