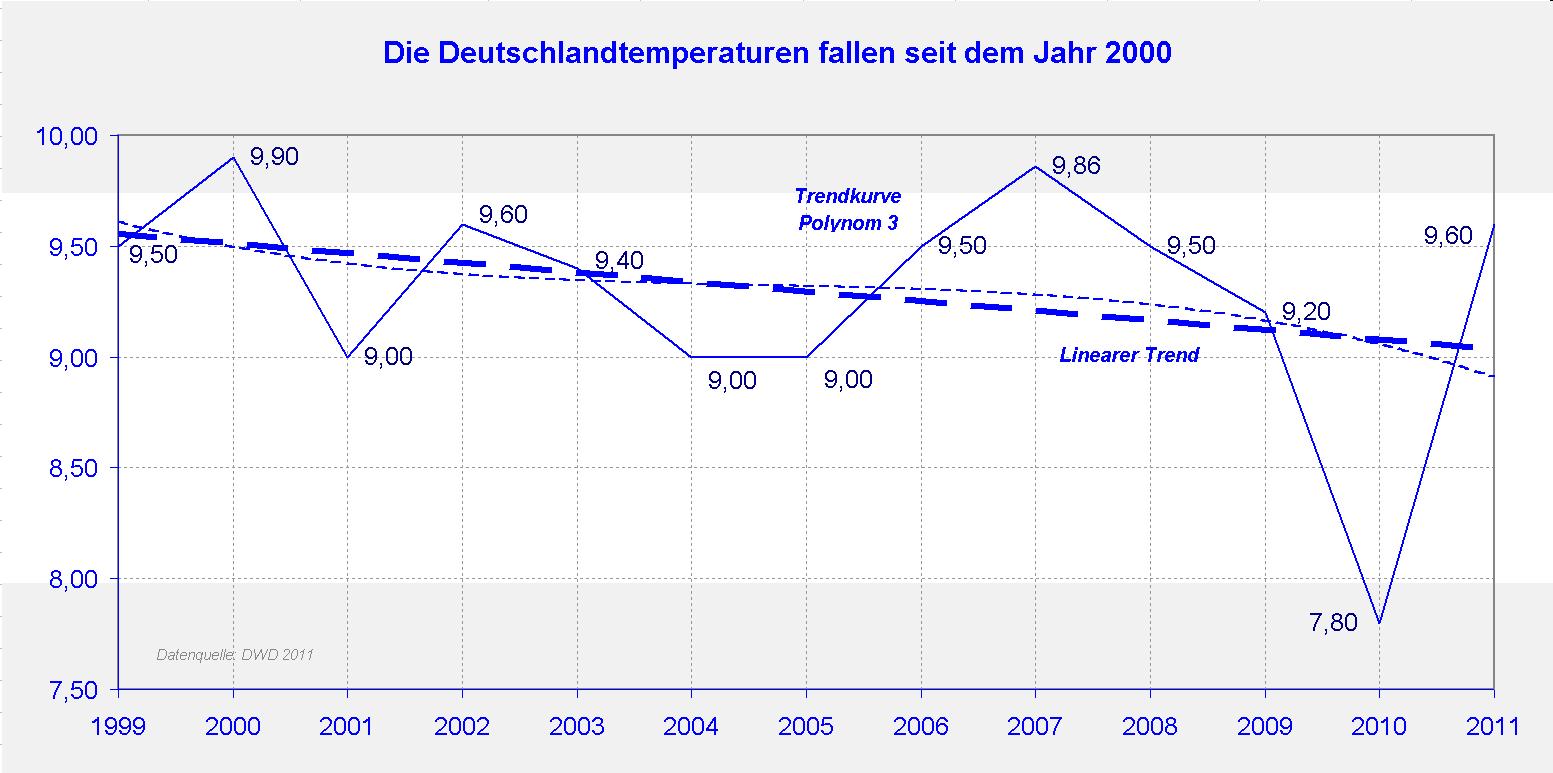

Harmonische Klimamodelle im Vergleich mit den generellen Klima-Zirkulationsmodellen des IPCC

Hiermit möchte ich in Kürze meine jüngste Veröffentlichung präsentieren. Damit setze ich meine Forschungen über die Bedeutung natürlicher Klimazyklen und ihre Einwirkung auf Klimaänderungen fort:

Nicola Scafetta, “Testing an astronomically based decadal-scale empirical harmonic climate model versus the IPCC (2007) general circulation climate models” Journal of Atmospheric and Solar-Terrestrial Physics (2011).

http://www.sciencedirect.com/science/article/pii/S1364682611003385

Dazu gibt es hier eine .pdf-Version als Broschüre.

Die wesentlichen Ergebnisse dieser neuen Studie werden hier als Höhepunkte zusammengefasst:

1) Die Klimamodelle des IPCC (CMIP3) können beobachtete dekadische und multidekadische Klimazyklen nicht reproduzieren.

2) Äquivalente Zyklen finden sich unter den primären Oszillationen des Sonnensystems.

3) Es wird eine Korrektur der projizierten anthropogenen Erwärmung für das 21. Jahrhundert vorgeschlagen.

4) Ein vollständiges empirisches Modell wird entwickelt, um Klimaänderungen für einige Jahrzehnte ab 2000 vorherzusagen.

5) Das Klima wird wahrscheinlich bis etwa 2030/2040 stabil bleiben, wonach eine Erwärmung von 0,3°C bis 1,2°C bis zum Jahr 2100 erfolgt.

Allerdings erfordert die wissenschaftliche Methodik, dass ein physikalisches Modell zwei einfache Bedingungen erfüllen muss: es muss physikalische Beobachtungen reproduzieren und vorhersagen können. Daher ist es vollkommen legitim in der Wissenschaft zu prüfen, ob die vom IPCC übernommenen Computer-GCMs die erforderlichen wissenschaftlichen Tests bestehen, das heißt in unserem Fall, ob diese Modelle den Temperaturverlauf des 20. Jahrhunderts ausreichend rekonstruieren und als Konsequenz, ob man diesen Modellen wirklich hinsichtlich ihrer Projektionen für das 21. Jahrhundert vertrauen kann. Fällt die Antwort negativ aus, ist es vollkommen legitim, nach fehlenden Mechanismen zu suchen und/oder nach alternativen Methoden.

Eine der größten Schwierigkeiten der Klimawissenschaft, soweit ich das sehe, ist die Tatsache, dass wir die Verlässlichkeit einer Klimatheorie oder eines Computermodells nicht mit kontrollierten Labortests überprüfen können. Wir können auch nicht das Klima anderer Planeten zum Vergleich heranziehen. Wie leicht könnte es sein, die anthropogenen Auswirkungen auf das Klima quantifizieren, wenn wir einfach das Klima eines anderen Planeten untersuchen, der mit Ausnahme der Menschen mit der Erde identisch ist! Aber diesen Luxus haben wir nicht.

Unglücklicherweise können wir eine Klimatheorie oder ein Computermodell nur gegen die verfügbaren Daten testen, und wenn sich diese Daten auf ein komplexes System beziehen, ist es wohlbekannt, dass selbst eine auf den ersten Blick kleine Diskrepanz zwischen Modellergebnissen und Daten massive physikalische Probleme enthüllen kann.

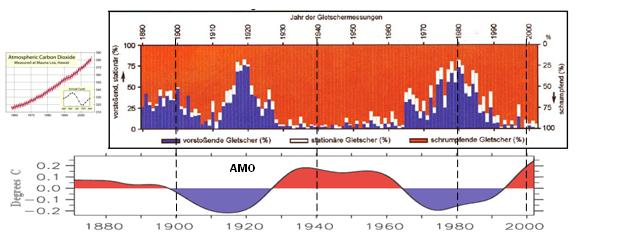

In einigen meiner früheren Studien, zum Beispiel hier (2011), hier (2010), zusammen mit Loehle hier (2011) und hier (2011) haben wir dargestellt, dass die globalen Temperaturaufzeichnungen mit Thermometern, die es einigermaßen zuverlässig seit 1850 gibt, nahelegen, dass das Klimasystem mit zahlreichen astronomischen Oszillationen, z. B. in der Sonnenaktivität, heliosphärischen Oszillationen aufgrund der Planetenbewegungen und in Mondzyklen schwingt und/oder synchron verläuft.

Die bekanntesten Zyklen, die in den Aufzeichnungen der globalen Temperatur erkennbar sind, haben Perioden von 9,1 Jahren, 10 bis 11 Jahren, etwa 20 Jahre und etwa 60 Jahre. Der 9,1 Jahre lange Zyklus scheint mit solaren/lunaren Tidenzyklen zusammen zu hängen, wie ich auch in dieser Studie zeigen werde, während die anderen drei Zyklen solare/planetarische Zyklen zu sein scheinen, die direkt mit dem Orbits von Jupiter und Saturn in Beziehung stehen. Andere Zyklen mit allen Zeitscales sind ebenfalls präsent, aber nicht Gegenstand dieser Studie.

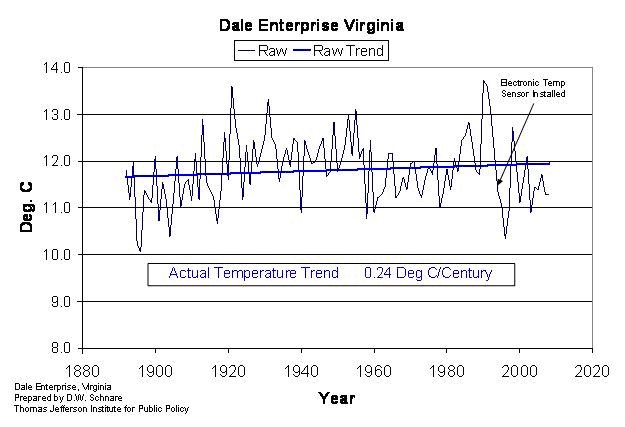

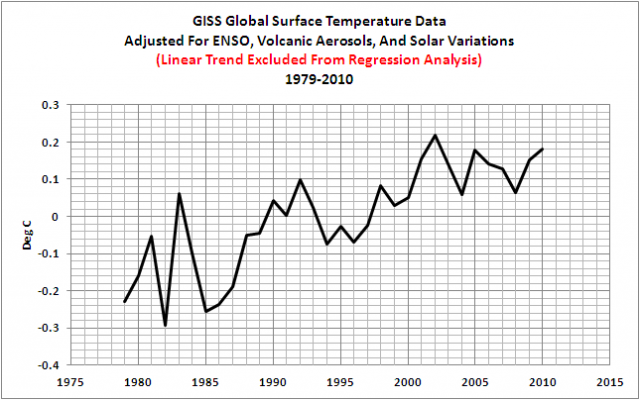

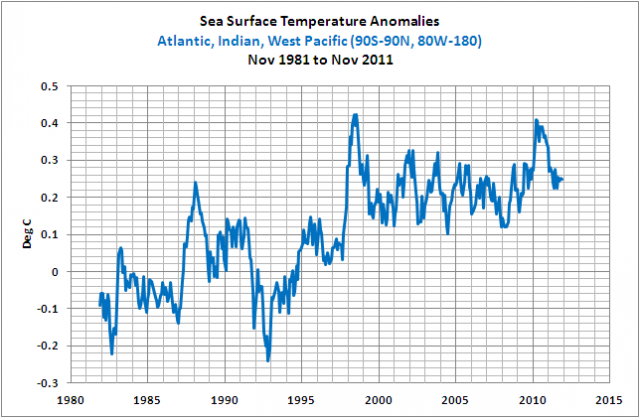

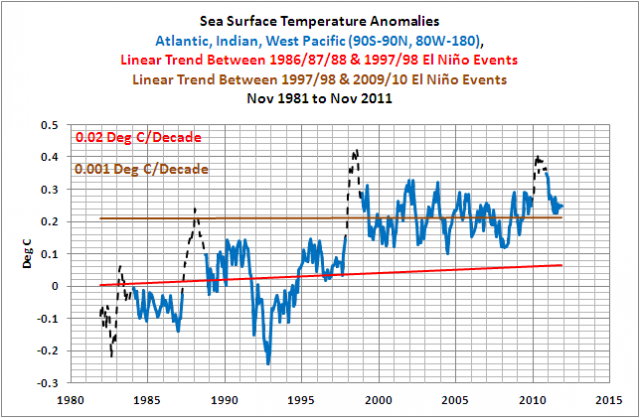

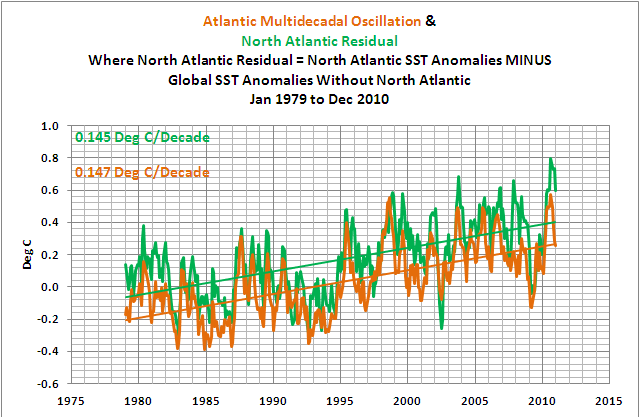

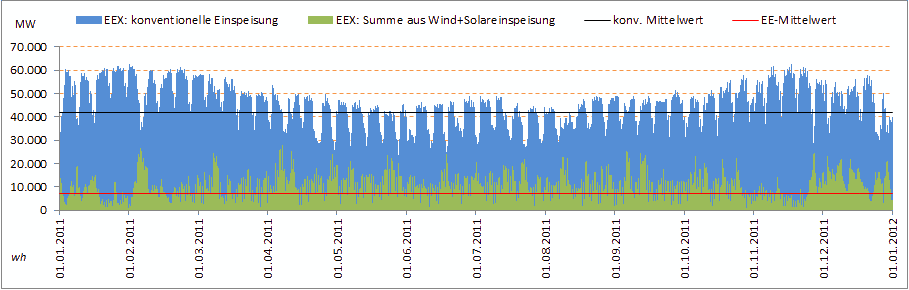

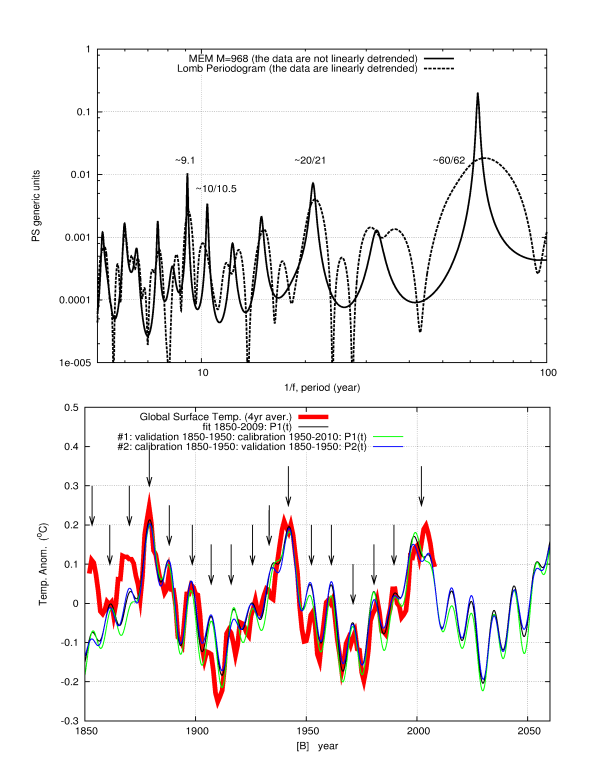

Die obigen vier wesentlichen Periodizitäten können leicht aus den Temperaturaufzeichnungen abgelesen werden, und zwar mit Methoden alternativer Analysen von Leistungsspektren [?], wie die Abbildung unten zeigt:

Abbildung 1

Sich ähnelnde dekadische und multidekadische Zyklen wurden in zahlreichen klimatischen Proxy-Modellen Jahrhunderte und Jahrtausende lang beobachtet, was ich in den Referenzen unten erwähnt habe, obwohl die Proxy-Modelle wegen der manchmal großen Divergenz von der Temperatur sehr sorgfältig untersucht werden müssen.

Der untere Teil der Abbildung beleuchtet einen 60-Jahres-Zyklus der Temperatur (rot), welcher klar hervortritt, wenn man den Erwärmungstrend aus den Daten herausrechnet und die schnellen Fluktuationen herausfiltert. Die schwarzen Kurven erhält man mittels harmonischer Modelle auf dekadischer und multidekadischer Basis, kalibriert auf zwei sich nicht überlappende Zeiträume: 1850 bis 1950 und 1950 bis 2010, so dass sie gegenseitig überprüft werden können.

Obwohl die diese Zyklen hervorrufende Abfolge physischer Mechanismen nach wie vor unklar ist, können die gefundenen Zyklen sicher von einem rein geometrischen Standpunkt aus als Beschreibung der dynamischen Entwicklung des Klimasystems angesehen werden. (In früheren Beiträgen von mir habe ich erklärt, dass die verfügbaren Klimadaten eine astronomisch bedingte Variation der Bewölkungsmenge nahe legen, die kleine Oszillationen der Albedo zur Folge haben mit der Konsequenz, dass auch die Temperatur am Boden oszilliert und mit ihr die Ozeane).

Offenbar können die harmonischen Komponenten der Klimadynamik empirisch modelliert werden, auch ohne detaillierte Kenntnis der zugrunde liegenden Physik, genauso wie man auch die Gezeiten des Ozeans mit einfachen harmonischen Bestandteilen rekonstruieren und vorhersagen kann, wie Lord Kelvin im 19 Jahrhundert erkannte. Leser sollten sich klarmachen, dass Kelvins harmonisches Modell wahrscheinlich das einzige geophysikalische Modell ist, das seine guten Vorhersagemöglichkeiten bereits unter Beweis gestellt hat und das man deswegen in Maschinen zur Vorhersage der Gezeiten implementiert hat. Details siehe http://en.wikipedia.org/wiki/Theory_of_tides#Harmonic_analysis

In meiner Studie habe ich die gleiche Kelvin’sche Annäherung eingebaut, und zwar auf zweierlei Art:

- durch abchecken, ob die GCMs des IPCC die entdeckten globalen Temperaturzyklen geometrisch reproduzieren können;

- und durch abchecken, ob ein harmonisches Modell für Klimavorhersagen benutzt werden könnte. Ein Vergleich der beiden Methoden findet sich ebenfalls in der Studie.

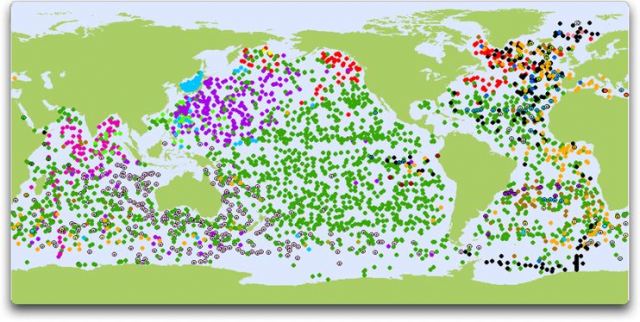

Ich habe alle verfügbaren Klimamodellsimulationen des 20. Jahrhunderts mit dem Program for Climate Model Diagnosis and Intercomparison (PCMDI) gesammelt, hauptsächlich aus den Jahren 2005 und 2006, und diese archivierten Daten ergeben Phase 3 des Coupled Model Intercomparison Project (CMIP3). Dieses kann man sich hier herunterladen.

Die Studie enthält einen großen Anhang mit Bildern aller GCM-Modellläufe und ihrem Vergleich mit der globalen Temperatur, beispielsweise von der Climatic Research Unit (HadCRUT3). Ich fordere alle nachdrücklich auf, sich die zahlreichen Abbildungen in diesem Anhang mal anzusehen, um ein Gefühl für die Leistung dieser Modelle bei der Rekonstruktion des beobachteten Klimas zu bekommen, welche nach meiner Ansicht für alle Zeiträume ziemlich dürftig ist.

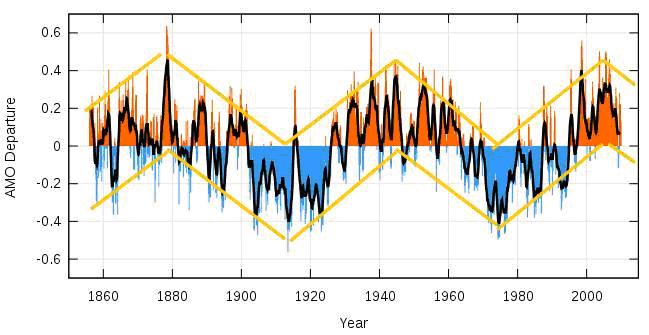

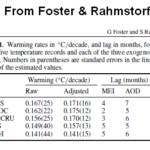

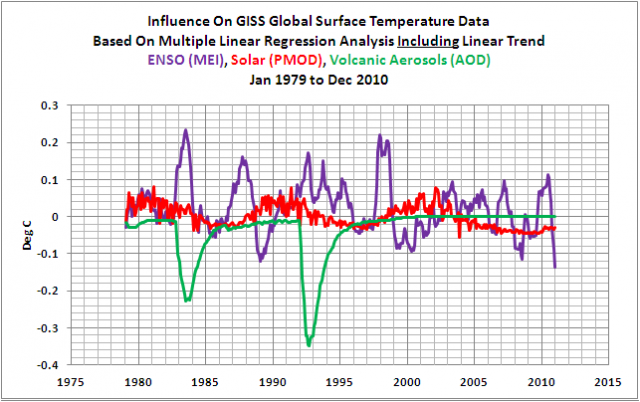

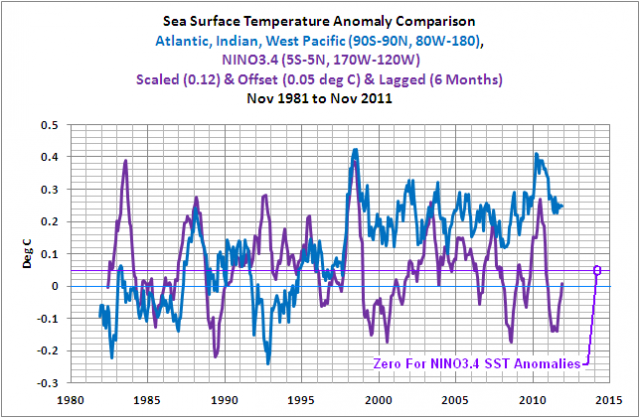

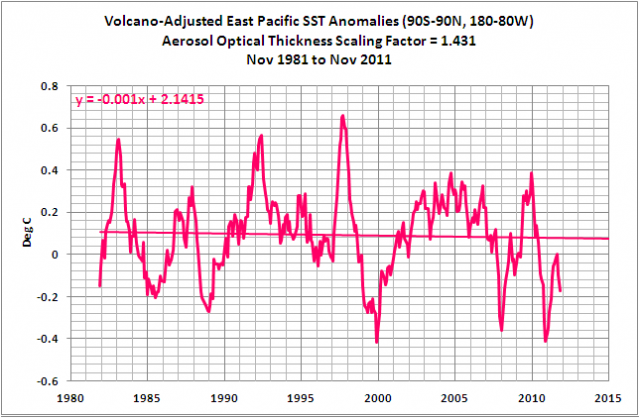

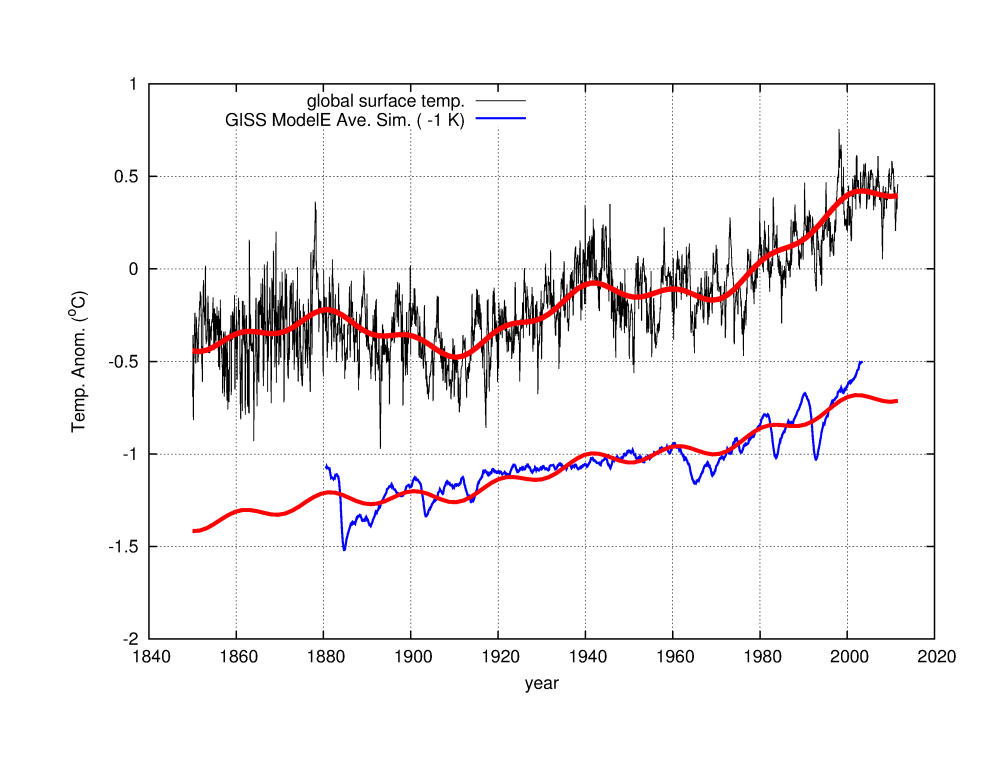

In der Abbildung unten zeige ich nur mal als Beispiel die Aufzeichnungen von HadCRUT3 gegen die Simulation vom GISS-ModelE für die globale Temperatur von 1880 bis 2003 unter Verwendung aller Antriebe, die man sich hier herunterladen kann.

Abbildung 2

Der Vergleich zeigt klar die erhebliche Diskrepanz zwischen der Modellsimulation und den Temperaturdaten. Qualitativ ähnliche Diskrepanzen sind typisch und finden sich in allen vom IPCC übernommenen GCMs.

Obwohl ein gewisser Erwärmungstrend in den Modellen zum Ausdruck kommt, der mit den Beobachtungen übereinzustimmen scheint, ist die Modellrechnung tatsächlich nicht in der Lage, die zyklische Dynamik des Klimas zu reproduzieren, aus der sich ein etwa 60-jähriger Zyklus ergibt mit Wärmespitzen um 1880, 1940 und 2000. Diese Verteilung wird außerdem durch den synchronisierten 20-jähringen Temperaturzyklus unterstrichen.

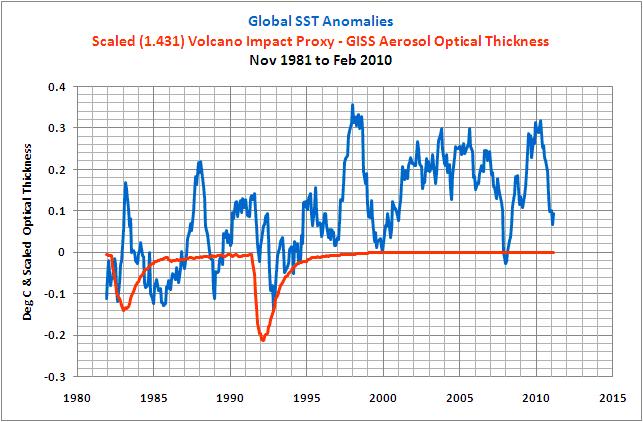

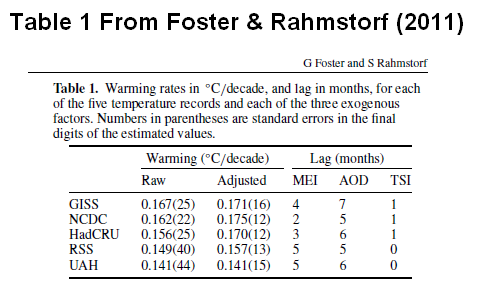

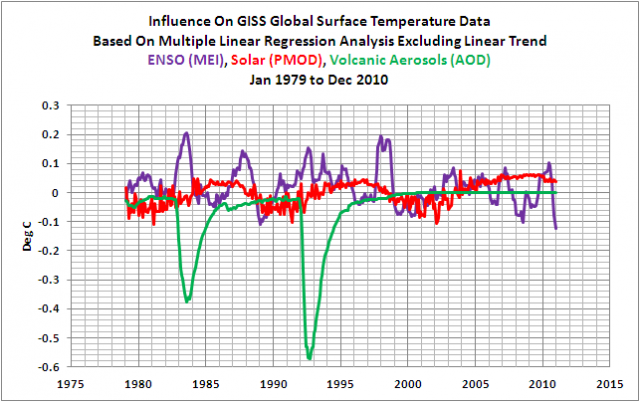

Das GISS ModelE zeigt auch große Ausschläge aufgrund von Vulkanausbrüchen, die in den Temperaturaufzeichnungen ziemlich schwer auszumachen sind. Tatsächlich zeige ich im Anhang die Signatur des GISS ModelE für den vulkanischen Antrieb allein im Vergleich zur gleichen Signatur, die man mit zwei vorgeschlagenen empirischen Modellen erhält, die den vulkanischen Antrieb direkt aus den Temperaturdaten selbst extrahieren..

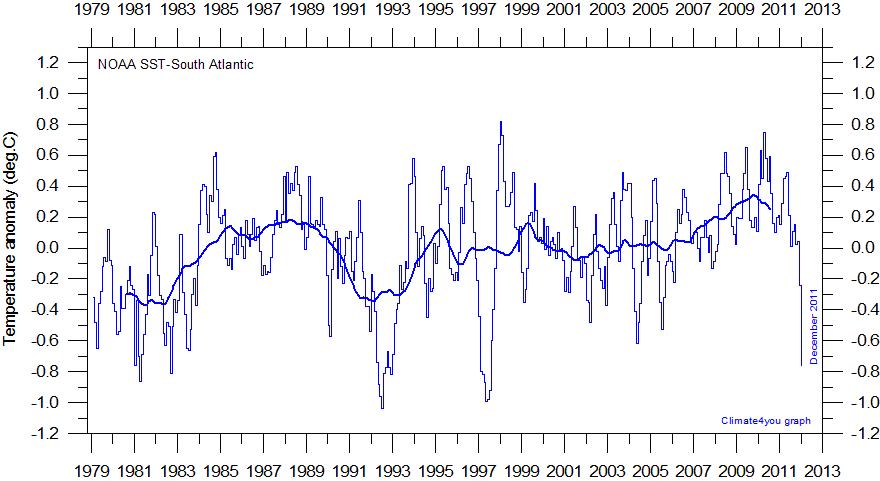

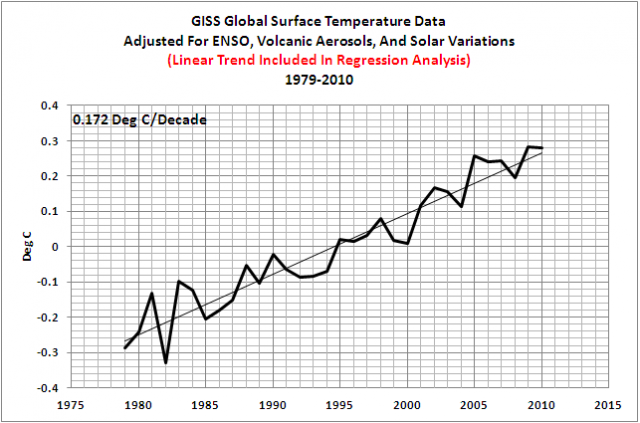

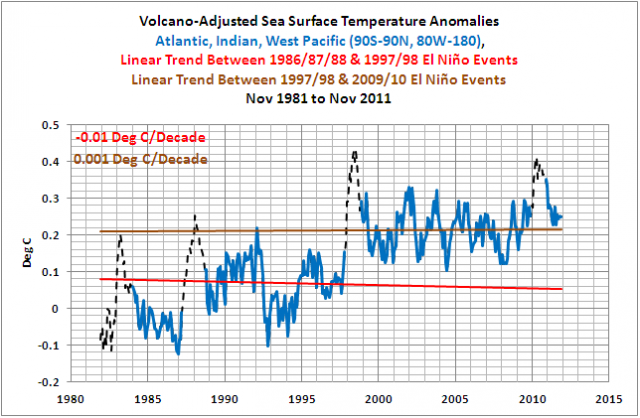

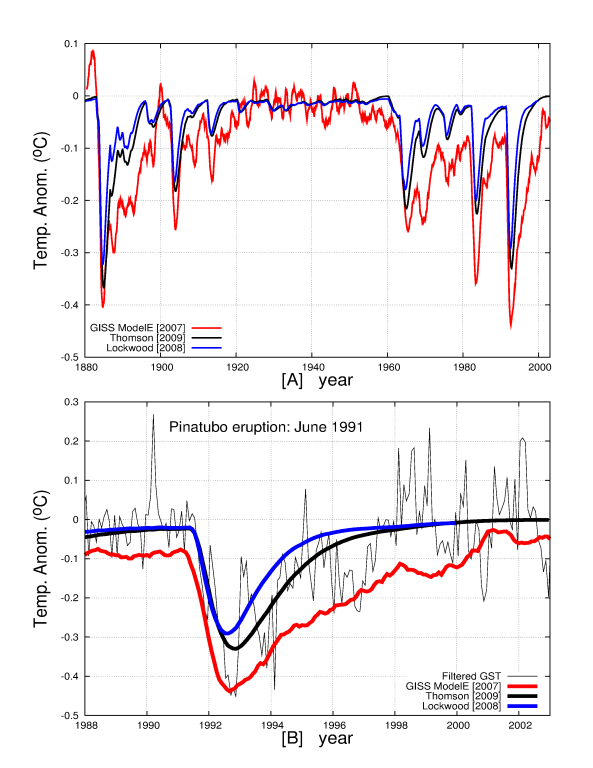

Abbildung 3

Die Abbildung zeigt eindeutig, dass das Modell GISS ModelE das kühlende vulkanische Signal erheblich überschätzt. Das gilt auch für die anderen GCMs, wie die Abbildungen im Anhang zeigen. Dieser Umstand ist ziemlich bedeutend, wie ich weiter unten zeigen werde. Tatsächlich gibt es Versuche, Klimavariationen durch Betonung der Auswirkung vulkanischen Aerosols zu rekonstruieren, aber das Fehlen vulkanischer Spitzen in den Temperaturaufzeichnungen zeigt, dass der vulkanische Effekt schon jetzt überschätzt wird.

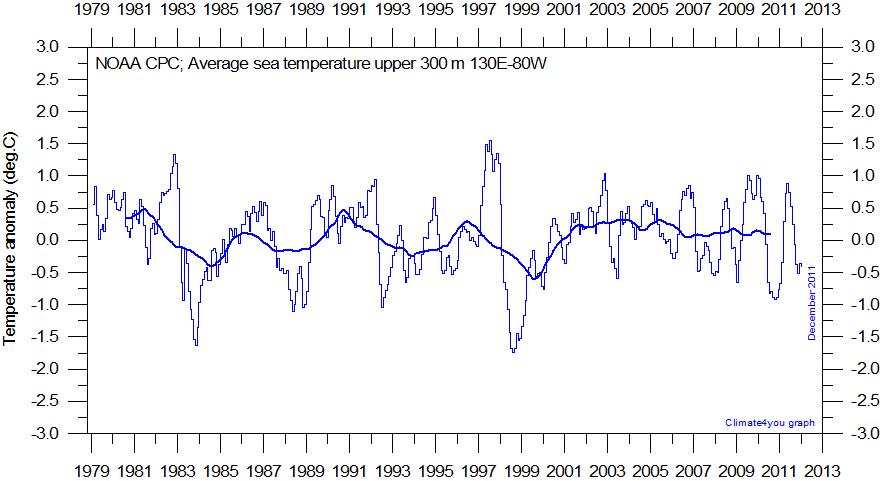

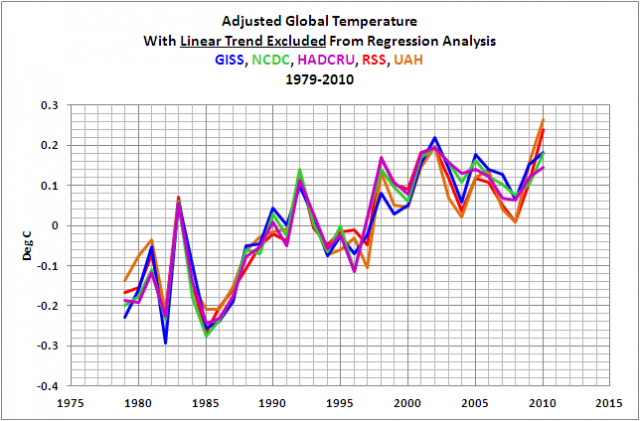

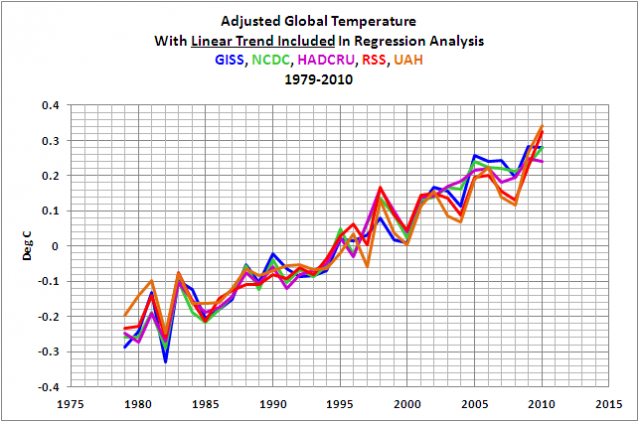

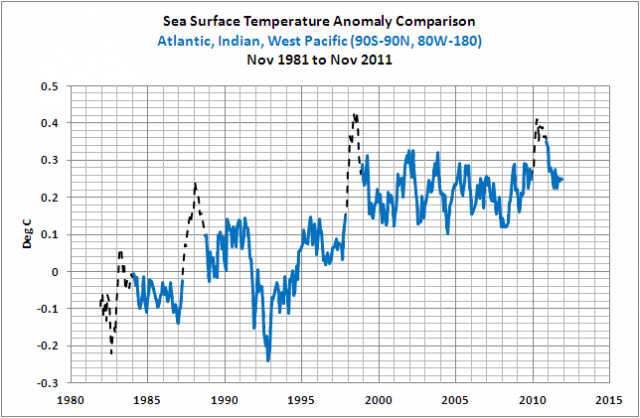

In jedem Falle konzentriert sich die Studie darauf festzustellen, ob die 2007 vom IPCC übernommenen GCMs die in den Temperaturaufzeichnungen gemessenen zyklischen Modulationen reproduzieren. Mit einem einfachen, auf vier Zyklen basierendem Regressionsmodell (etwa 9,1; 10; 20 und 60 Jahre) plus einem steigenden Trend, der geometrisch durch quadrierte Abweichungen der Temperatur dargestellt werden kann, habe ich in der Studie gezeigt, dass alle vom IPCC übernommenen GCMs darin scheitern, die beobachteten Temperaturzyklen sowohl im dekadischen als auch im multidekadischen Zeitscale zu reproduzieren.

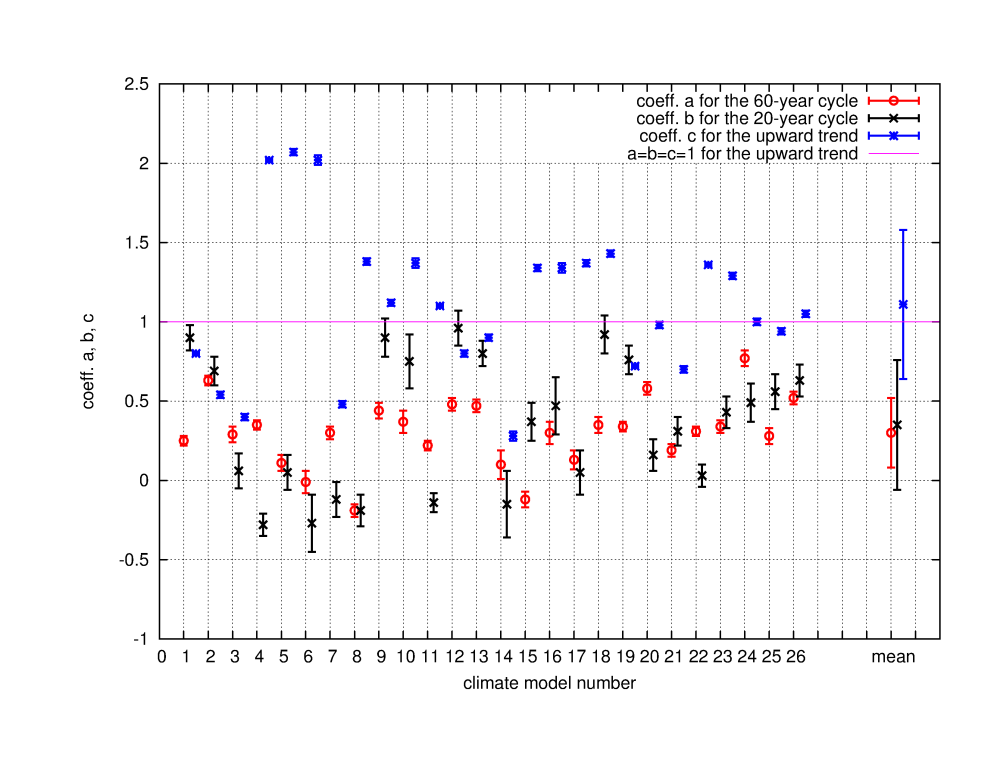

Abbildung 4

Die obige Abbildung beispielsweise beschreibt die Koeffizienten „a“ (für den 60-jährigen Zyklus) und „b“ (für den 20-jährigen Zyklus), wie sie von allen Modellläufen der GCMs des IPCC gezeigt werden. Sie sind einfach auf der Abszisse durchnumeriert. Werte von „a“ und „b“ nahe 1 würden darauf hinweisen, dass die Modellsimulation die korrespondierenden Temperaturzyklen gut abbildet. Wie aus der Abbildung hervorgeht (und aus den Tabellen in der Studie) scheitern alle Modelle damit in ziemlich großem Umfang.

Die Schlussfolgerung ist eindeutig, einfach und geradlinig: alle vom IPCC übernommenen GCMs scheitern daran, die in den globalen Temperaturaufzeichnungen gemessenen dekadischen und multidekadischen dynamischen Modulationen korrekt zu reproduzieren, folglich reproduzieren sie auch nicht die Dynamiken des Klimas. Offensichtlich ist die Behauptung „Die Wissenschaft ist sich einig“ falsch. Tatsächlich fehlen in den Modellen wichtige physikalische Mechanismen, die Klimaänderungen antreiben und die auch immer noch ziemlich mysteriös sein können, und von denen ich glaube, dass sie letztendlich astronomische Ursachen haben, wie ich in meinen anderen Studien ausführlicher erklärt habe.

Aber nun, was können wir mit dieser physikalischen Information jetzt anfangen?

Es ist wichtig sich klarzumachen, dass die „die-Wissenschaft-ist-sich-einig“ – Behauptung eine notwendige Vorbedingung ist, um irgendein physikalisches System effizient mit einem analytischen Computermodell laufen zu lassen, wie es die GCMs mit dem Klimasystem machen wollen. Wenn sich die Wissenschaft nicht einig ist, ist jedoch eine solche Aufgabe nicht effizient und theoretisch unmöglich. Zum Beispiel kann ein Ingenieur keine funktionierende elektronische Anlage bauen (Telefone, Radios, Fernseher, Computer) oder eine Brücke oder ein Flugzeug, wenn einige der notwendigen physikalischen Prozesse unbekannt wären. Normalerweise arbeiten Ingenieure nicht mit teilweise bekannter Wissenschaft. In der Medizin zum Beispiel behauptet niemand, die Leute mit Hilfe einer Art physiologischem GCM zu heilen! Und die GCM-Modellierer sind im Wesentlichen Computeringenieure und keine Klimawissenschaftler.

In der theoretischen Wissenschaft kann man jedoch versuchen, das o. g. Problem zu überwinden, wenn man andere Arten von Modellen benutzt, nämlich empirisch/phänologische Modelle, die selbst ihre Grenzen haben, aber auch zahllose Vorteile. Man muss lediglich geeignete Extrahierungen vornehmen und die in den Daten selbst enthaltenen Informationen verwenden, um die beobachteten Dynamiken zu modellieren.

Nun, in der Studie habe ich die aus den Daten abgeleiteten geometrischen Informationen verwendet, um zwei Dinge zu machen:

- Ich schlage eine Korrektur des angebotenen anthropogenen Erwärmungseffektes auf das Klima in dem harmonischen Modell vor

- Ich implementiere den oben genannten anthropogenen Erwärmungseffekt in das harmonische Modell, um eine angenäherte Vorhersage für die globale Temperatur im 21. Jahrhundert zu erzeugen, und zwar mit den gleichen Emissionsprojektionen wie das IPCC.

Bezüglich des ersten Punktes müssen wir eine feinsinnige Begründung übernehmen. Tatsächlich ist es nicht möglich, die natürliche und die anthropogene Komponente im beobachteten Erwärmungstrend seit 1850 (etwa 0,8°C) durch die Verwendung eines harmonischen Modells, kalibriert mit den gleichen Daten, weil aus 161 Jahren Aufzeichnungen höchstens ein 60-jähriger Zyklus gut bestimmt werden kann, voneinander zu trennen. Für noch längere Zyklen ist das nicht möglich.

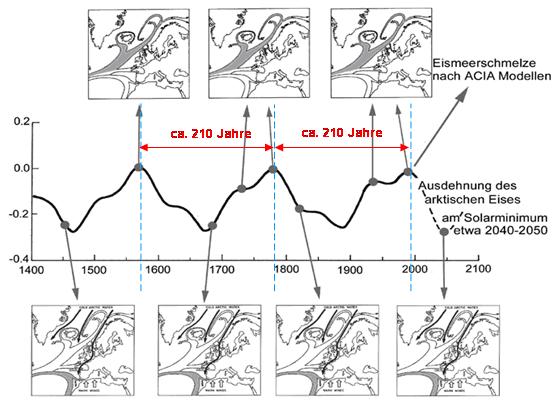

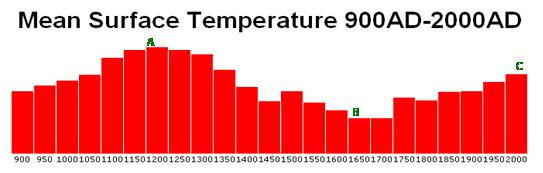

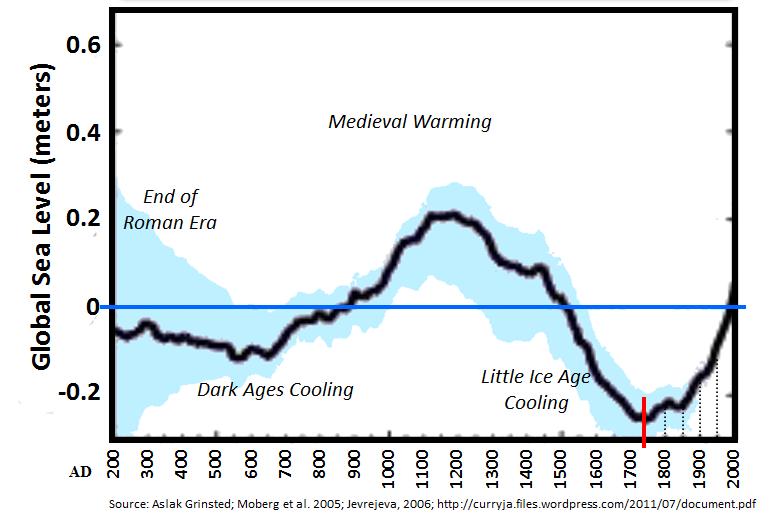

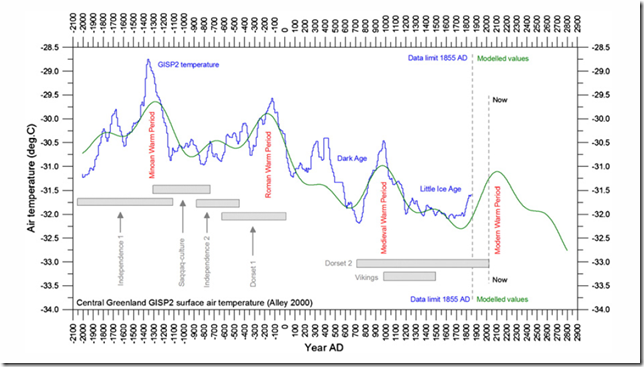

Was zahlreiche Studien einschließlich einiger von mir (zum Beispiel hier) wirklich gezeigt haben ist, dass dieser Erwärmungstrend von 1850 bis 2010 Teil eines Jahrhunderte/Jahrtausende langen Zyklus’ sein kann, der auch für das Römische Klimaoptimum, die Dunklen Zeitalter, das Mittelalterliche Klimaoptimum und die Kleine Eiszeit verantwortlich war.

Die folgende Abbildung 5 von Hulum et al. (2011) vermittelt eine Ahnung davon, wie dieser Jahrhunderte/Jahrtausende lange Zyklus auftauchen kann, wenn man versucht, ein viele Jahrtausende langes natürliches Proxy-Modell für die Temperatur in Zentralgrönland zu rekonstruieren.

Abbildung 5

Allerdings ist eine akkurate Modellierung der Jahrhunderte/Jahrtausende langen Zyklen gegenwärtig nicht möglich. Die Frequenzen, Amplituden und Phasen sind nicht präzise bekannt, weil sich die Proxy-Modelle für die Temperatur untereinander ziemlich unterscheiden. Für diese Studie wollen wir im Wesentlichen nur reale Temperaturdaten verwenden, und diese beginnen 1850, was offensichtlich ein zu kurzer Zeitraum ist, um so lange natürlichen Zyklen zu extrahieren.

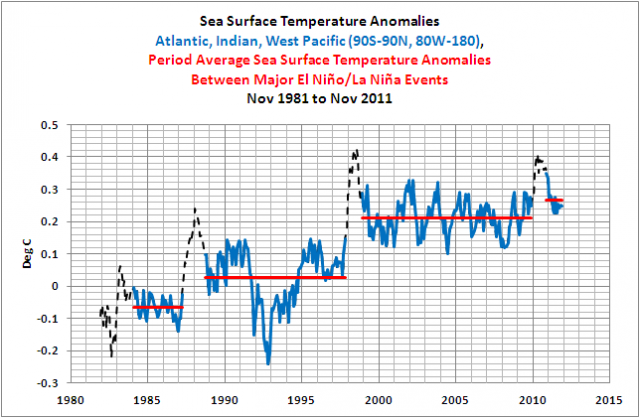

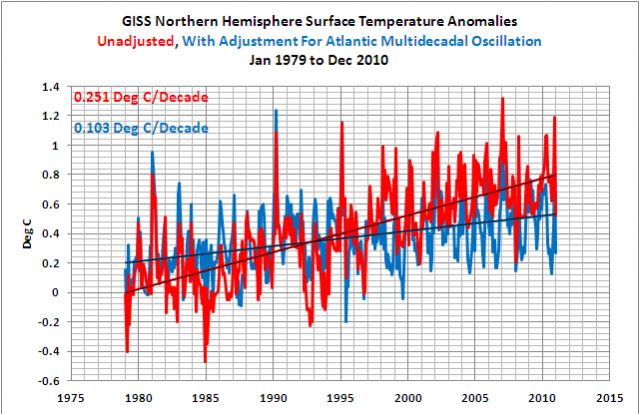

Um weiterzukommen, habe ich eine auf dem 60-jährigen Zyklus basierende Strategie übernommen, wobei eine Amplitude von etwa 0,3°C geschätzt wurde, wie der obere Teil der Abbildung 6 zeigt:

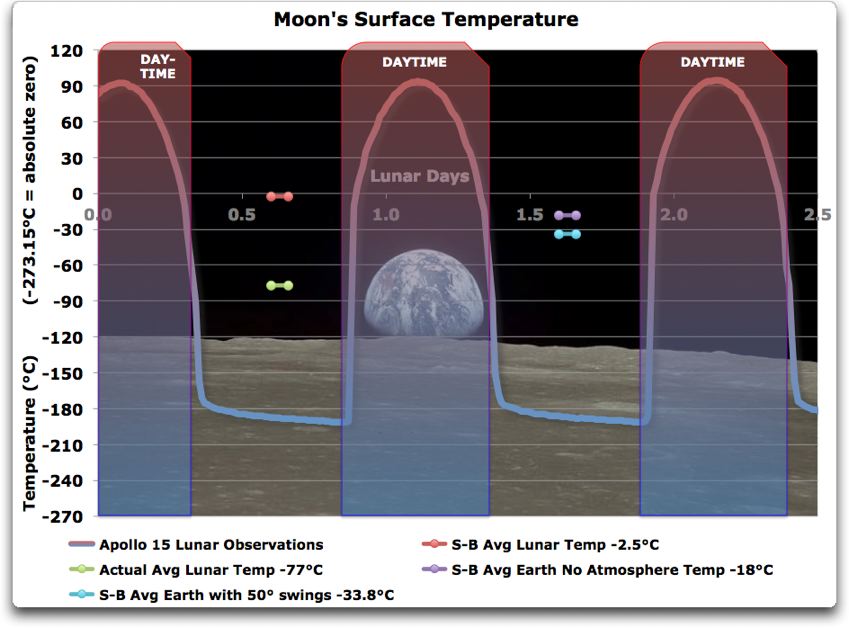

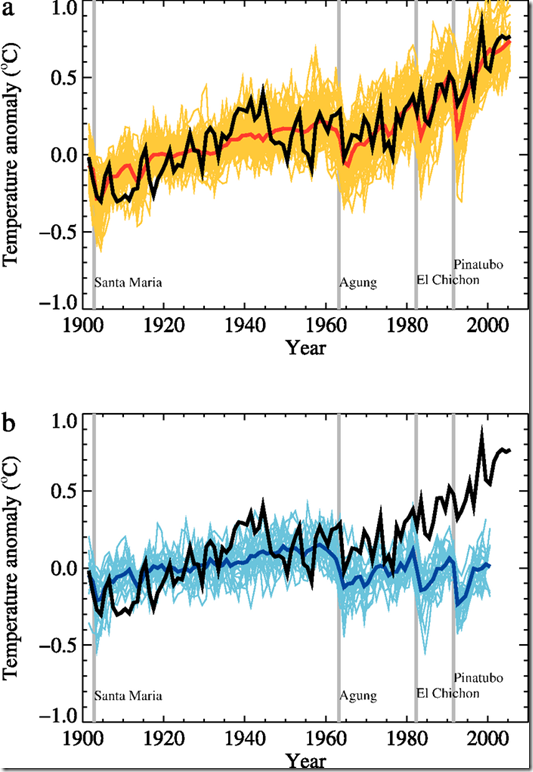

Die IPCC-Abbildungen 9.5a und 9.5b sind gut geeignet, um die Argumentation zu verstehen, sind doch diese beiden Abbildungen bei den AGW-Vertretern teils sehr populär. Diese beiden Abbildungen folgen hier:

Abbildung 6

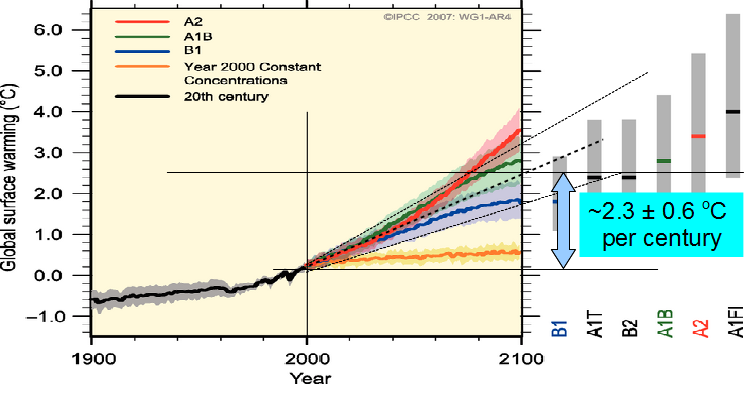

Teil b der obigen Abbildung zeigt, dass die Temperatur dem IPCC zufolge ohne anthropogenen Antrieb von 1970 bis 2000 um 0,0 bis 0,2°C hätte zurück gehen müssen, und zwar infolge vulkanischer Aktivität. Nur das Hinzufügen anthropogener Antriebe (siehe Teil a) kann die von 1970 bis 2000 beobachtete Erwärmung um 0,5°C produziert haben. Folglich wird behauptet, dass diese anthropogenen Antriebe einen Temperaturanstieg von 0,5°C bis 0,7°C innerhalb von 30 Jahren erzeugt haben. Diese Erwärmung wird dann in den GCMs des IPCC auf das gesamte 21. Jahrhundert ausgeweitet mit einem Erwärmungstrend von 2,3°C pro Jahrhundert, wie es in der Abbildung SPM5 des IPCC unten zum Ausdruck kommt:

Abbildung 7

Aber unser Vertrauen in diese Abschätzung des IPCC zum anthropogenen Wärmeeffekt wird direkt durch das Scheitern dieser GCMs in Frage gestellt, die 60-jährige natürliche Modulation zu reproduzieren, die für eine Erwärmung von mindestens 0,3°C von 1970 bis 2000 verantwortlich ist. Als Konsequenz sollte bei Berücksichtigung dieser natürlichen Variabilität der anthropogene Wärmeeffekt nicht über 0,2°C bis 0,4°C liegen anstatt der vom IPCC behaupteten 0,5°C bis 0,7°C.

Dies bedeutet, dass der anthropogene Erwärmungseffekt auf ein Maximum zwischen 0,5°C und 1,3°C pro Jahrhundert reduziert werden muss, und zwar seit 1970 bis etwa 2050 unter Berücksichtigung der gleichen IPCC-Emissionsprojektionen, die in der Studie beschrieben werden. Dieses Ergebnis in der Studie wird auch erreicht durch Berücksichtigung vieler Möglichkeiten einschließlich der Tatsache, dass die Abkühlung durch vulkanische Aktivitäten offensichtlich in den GCMs überschätzt wird, wie wir oben gesehen haben, und ein Teil der übrigen Erwärmung von 1970 bis 2000 könnte immer noch von anderen Faktoren verursacht sein wie den städtischen Wärmeinseleffekt oder der Landschaftsverbrauch.

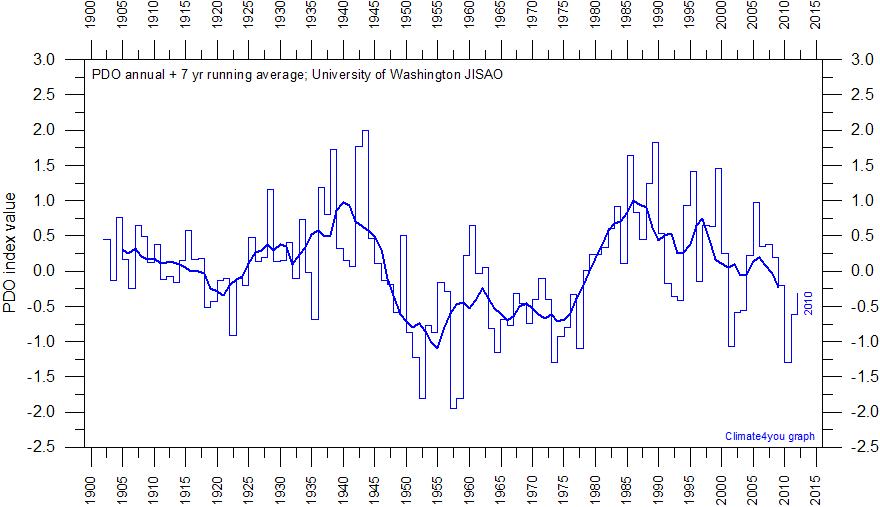

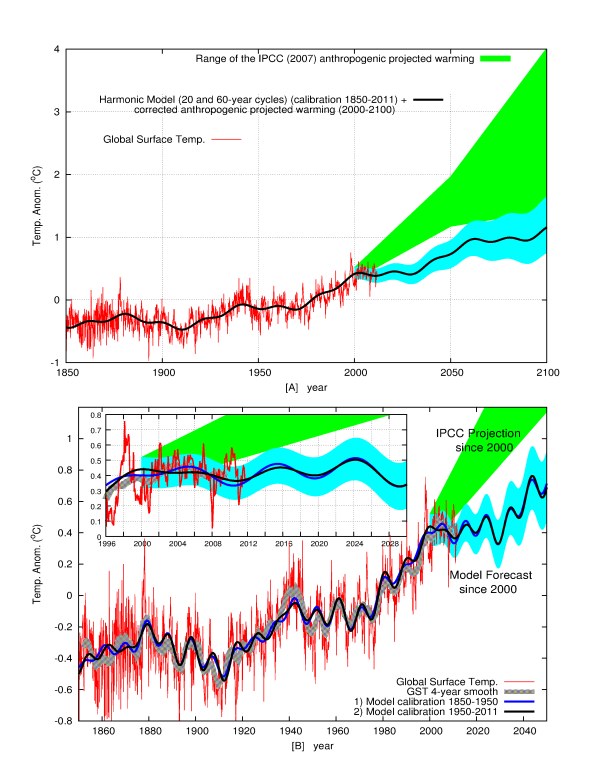

An dieser Stelle ist es möglich zu versuchen, eine vollständige Vorhersage des Klimas seit 2000 abzugeben, die sich aus den vier entdeckten dekadischen und multidekadischen Zyklen plus den korrigierten anthropogenen Erwärmungstrend ergeben.

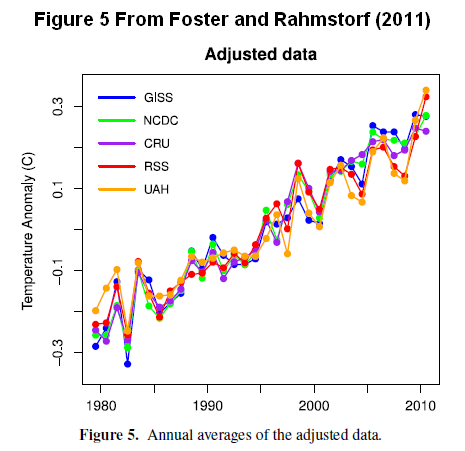

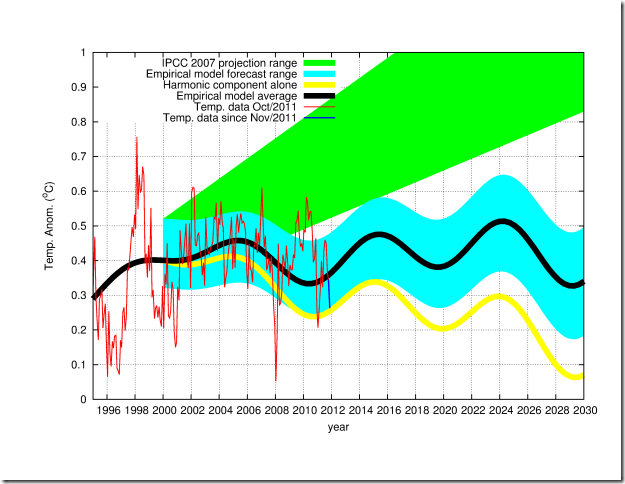

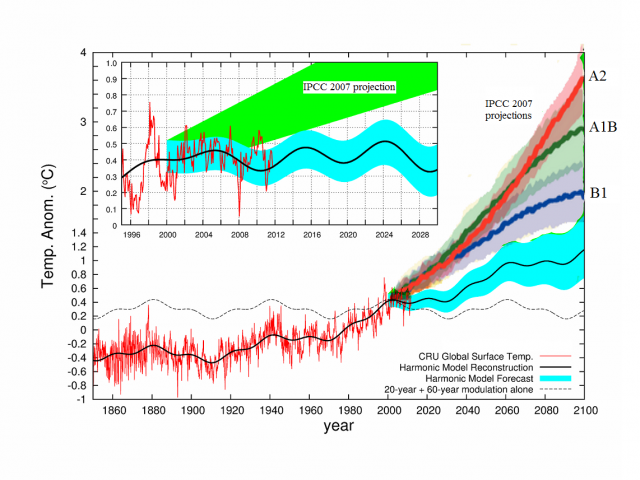

Abbildung 8

Die Abbildung zeigt eine vollständige Klimavorhersage meines empirischen Modells im Vergleich zu den IPCC-Projektionen seit 2000. Es ist offensichtlich, dass mein vorgestelltes Modell viel besser mit den Daten übereinstimmt als die IPCC-Projektionen, wie auch andere Tests in der Studie zeigen.

Mein vorgestelltes Modell zeigt zwei Kurven: Eine ist kalibriert auf den Zeitraum 1850 bis 1950 und der andere auf den Zeitraum von 1950 bis 2000. Es ist offensichtlich, dass beide Kurven gleichermaßen die Klimavariabilität von 1850 bis 2011 in dekadischen/multidekadischen Zeitscales gut rekonstruieren, da die graue Linie Höhepunkte glättet mit einem mittleren Fehler von nur 0,05°C.

Das vorgeschlagene empirische Modell würde nahelegen, dass die gleichen, vom IPCC projizierten anthropogenen Emissionen eine globale Erwärmung von 0,3°C bis 1,2°C bis 2100 verursachen würden, im Gegensatz zu den vom IPCC projizierten 1,0°C bis 3,6°C. Meine vorgeschlagene Schätzung schließt auch eine zusätzliche mögliche Abkühlung aus, die von Jahrhunderte/Jahrtausende langen Zyklen abgeleitet werden können.

Einige implizit enthaltene Konsequenzen dieses Ergebnisses ist, dass zum Beispiel der Ozean viel weniger steigen dürfte, sagen wir mal ein Drittel (etwa 12,5 cm) bis 2100, als was vom IPCC projiziert worden ist, und wofür wir möglicherweise nicht unsere Wirtschaft zu zerstören brauchen bei dem Versuch, CO2-Emissionen zu reduzieren.

Wird sich meine Vorhersagekurve hoffentlich für mindestens ein paar Jahrzehnte bewähren? Nun, mein Modell ist keine „kristallene Orakelkugel“. Genau wie bei den ozeanischen Zyklen können zahlreiche andere natürliche Zyklen in allen Zeiträumen im Klimasystem wirksam sein und interessante Interferenzen und eine komplexe Dynamik erzeugen. Andere nichtlineare Faktoren können ebenfalls vorhanden sein, und plötzliche Ereignisse wie Vulkanausbrüche können immer die dynamische Verteilung eine Zeitlang unterbrechen. Also kann das Modell sicher noch verbessert werden.

Vielleicht ist das von mir vorgeschlagene Modell aber auch nur eine weitere Illusion, das wissen wir noch nicht sicher. Was man tun kann, ist die Forschung fortzusetzen und zu verbessern und eventuell Monat für Monat neue Temperaturdaten hinzufügen, um zu sehen, wie sich die vorgeschlagene Vorhersage macht, wie es in der Abbildung unten argestellt ist:

Abbildung 9

Die obige Abbildung zeigt einen verglichen mit der Studie aktualisierten Graph, wobei die Temperaturaufzeichnung im Oktober 2011 endet. Hinzugefügt ist die Temperatur vom November 2011 in blau. Die monatlichen Temperaturdaten stammen von hier.

Die empirische Vorhersagekurve (schwarze Kurve, gebildet aus der harmonischen Komponente plus dem vorgeschlagenen anthropogenen Erwärmungstrend) zeigt bisher gute Übereinstimmung mit den Daten. Ok, es ist nur ein Monat, könnte man einwenden, aber tatsächlich startet das ausgewählte Vorhersagemodell bereits im Januar 2000!

Zum Vergleich, die Abbildung zeigt in gelb die harmonische Komponente aus den vier Zyklen allein, was interpretiert werden kann als die untere Grenze der natürlichen Variabilität, basierend auf den gleichen vier Zyklen.

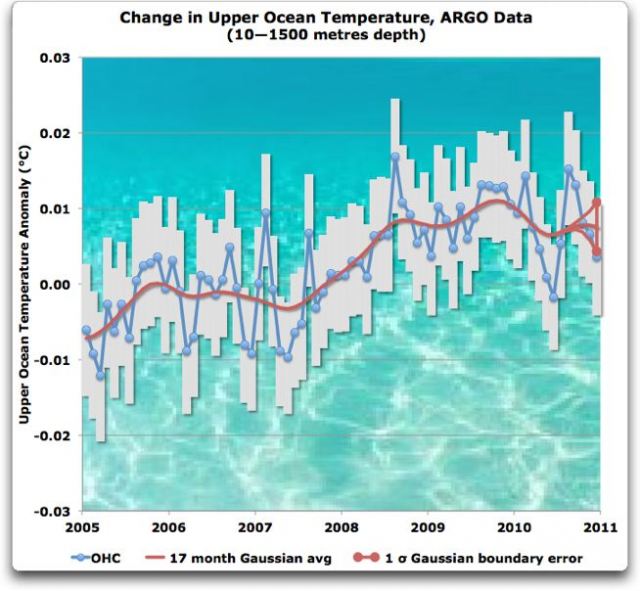

Abbildung 10

Schlussfolgernd lässt sich sagen, dass das hier vorgestellte Modell sicher ein vereinfachtes Modell ist, das möglicherweise noch verbessert werden kann, aber schon jetzt sieht es so aus, als würde es alle vom IPCC übernommenen GCMs wie z. B. GISS ModelE übertreffen. Alle diese Modelle bringen es nicht fertig, die beobachteten dekadischen und multidekadischen Zyklen zu rekonstruieren. Außerdem haben sie bei der Vorhersage der Temperaturentwicklung seit 2001 versagt.

Es ist offensichtlich, dass ein Klimamodell für jedwede zivilen strategischen Ziele nützlich wäre, aber nur, wenn es in der Lage ist, die Klimaentwicklung zumindest auf dekadischer/multidekadischer Basis vorherzusagen. Die traditionellen GCMs sind mit diesem Ziel bisher gescheitert, wie diese Studie zeigt.

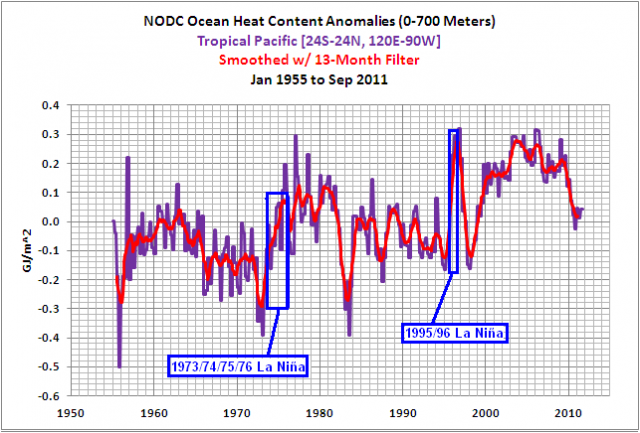

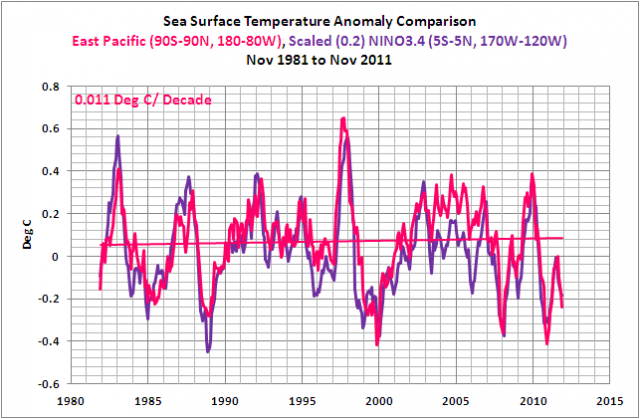

Die Versuche mancher Klimamodellierer in jüngster Zeit, den Fehlschlag ihrer GCMs hinsichtlich des fast konstanten Klimas der letzten 10 Jahre zu erklären und zu lösen, sind sehr unbefriedigend für irgendwelche praktischen und theoretischen Ziele. Tatsächlich lauten einige der vorgeschlagenen Lösungen: 1) eine vermutete Unterschätzung der abkühlenden Wirkung kleinerer Vulkanausbrüche (Solomon et al., Science 2011) (während der Vulkaneffekt in den GCMs schon jetzt offensichtlich überschätzt wird!) oder 2) eine hypothetische chinesische Emission von Aerosolen (Kaufman et al., PNAS 2011) (die jedoch seit 2005 wahrscheinlich zurückgeht!), oder 3) ein 10-jähriges „rotes Rauschen“, eine unvorhersagbare Fluktuation des Klimasystems, angetrieben durch eine Fluktuation im Wärmegehalt der Ozeane (Meehl et al., NCC 2011) (die sich jedoch in den Modellsimulationen erst 2055 und 2075 einstellen soll!)

Offensichtlich können diese GCMs die Klimaänderung nur „a posteriori“ „vorhersagen“, das heißt beispielsweise, wenn wir wissen wollen, was mit diesen GCMs von 2012 bis 2020 passiert, müssen wir erstens bis 2020 warten und die GCMs dann mit physikalischen ad hoc-Erklärungen anpassen, einschließlich sogar einer Berufung auf einem unvorhersagbaren „roten Rauschen“ bei der Fluktuation des ozeanischen Wärmegehaltes und im Strömungssystem (laut Modell 2055 und 2075!), um zu versuchen, die Daten während Perioden mit Datenlücken zu erklären, die der projizierten anthropogenen Erwärmung durch GHGs widersprechen!

Sollte dies tatsächlich die Lage sein, ist es wirklich unmöglich, Klimaänderungen für wenigstens einige Dekaden vorherzusagen. Der praktische Nutzen dieser Art von GCMs ist begrenzt und potentiell sehr irreführend, weil das Modell eine 10-jährige Erwärmung vorhersagen kann, während das „rote Rauschen“ der Dynamik des Klimasystems die projizierte Verteilung komplett verändert!

Tatsache ist, dass die obigen ad hoc-Erklärungen in Konflikt zu stehen scheinen mit der Dynamik des Klimasystems, wie es seit 1850 offensichtlich ist. Tatsächlich legt diese Dynamik eine wesentliche multipel-harmonische Komponente beim Klima nahe, deren Ursache wahrscheinlich astronomischen Ursprungs ist (Sonne + Mond + Planeten), obwohl dies physikalisch noch nicht vollständig verstanden ist. Diese Komponente kann auch das Klima nach 2000 ziemlich befriedigend erklären, wie die obigen Abbildungen zeigen (selbst unter Verwendung meines Modells, kalibriert von 1850 bis 1950, das sind mehr als 50 Jahre vor der beobachteten Aufzeichnungslücke seit 2000!)

Vielleicht kann es eine neue Art von Klimamodell, zumindest teilweise auf einer empirischen Rekonstruktion des Klimas, konstruiert aus empirisch bestimmten natürlichen Zyklen, wirklich besser, hätte bessere Vorhersagemöglichkeiten und das als Folge nützlicher für die Gesellschaft sein könnte als die gegenwärtig vom IPCC übernommenen GCMs.

Braucht man also eine Art kopernikanische Revolution in der Forschung zur Klimaänderung, wie auch Alan Carlin vorgeschlagen hat?

Ich persönlich glaube, dass es dringend notwendig ist, mehr in wissenschaftliche Methoden alternativ zu den traditionellen GCMs zu investieren und auch allgemein mehr in die reine Klimaforschung, und nicht nur in die GCM-Forschung, wie es bisher war aufgrund der falschen Behauptung, dass solche Investitionen in die reine Wissenschaft nicht mehr nötig sind, weil sich „die Wissenschaft schon einig ist“.

Bezüglich des anderen allgemeinen AGW-Slogans, demzufolge die gegenwärtigen Mainstream-AGW-Wissenschaft nicht mehr in Frage gestellt werden kann, weil sie auf einem sog. „wissenschaftlichen Konsens“ beruht, möchte ich nachdrücklich anregen, dass jeder diesen Beitrag von Kevin Rice liest, und zwar auf dem Blog Catholibertarian mit dem Titel “On the dangerous naivety of uncritical acceptance of the scientific consensus”.

Nicola Scafetta, “Testing an astronomically based decadal-scale empirical harmonic climate model versus the IPCC (2007) general circulation climate models” Journal of Atmospheric and Solar-Terrestrial Physics (2011).

http://www.sciencedirect.com/science/article/pii/S1364682611003385

http://scienceandpublicpolicy.org/reprint/astronomical_harmonics_testing.html

Abstract:

Wir vergleichen den Aussagegehalt eines kürzlich vorgeschlagenen empirischen Klimamodells, das auf astronomischen Schwingungen im Vergleich zu allen gegenwärtig verfügbaren und vom IPCC verwendeten CMIP3-Klimamodellen zur allgemeinen Zirkulation (GCM) basiert, um den Verlauf der globalen Temperatur während des 20. Jahrhunderts zu interpretieren. Das vorgeschlagene astronomische empirische Klimamodell nimmt an, dass das Klima in Resonanz steht oder synchronisiert ist mit einer Reihe von natürlichen Schwingungen, die in früheren Studien (Scafetta 2010b, 2011b) mit dem Sonnensystem und den Planetenbewegungen assoziiert worden sind, dominiert zumeist von Jupiter und Saturn. Wir zeigen, dass die GCMs die wesentlichen dekadischen und multidekadischen Oszillationen der globalen Temperaturaufzeichnungen von 1850 bis 2011 nicht reproduzieren können. Im Gegenteil hat sich herausgestellt, dass das vorgestellte harmonische Modell (welches hier Perioden von 9,1; 10-10,5; 20-21; 60-62 Jahren nutzt) dies sehr gut kann, und es wird gezeigt, dass es in der Lage ist, die Klimaoszillationen von 1950 bis 2011 vorherzusagen unter Verwendung der Daten von 1850 bis 1950, und umgekehrt. Es wird gezeigt, dass der 9,1-jährige Zyklus wahrscheinlich zusammenhängt mit einer dekadischen Sonne/Mond-Tidenoszillation, während die anderen drei Zyklen synchron mit solaren und heliosphärischen planetarischen Oszillationen laufen. Wir zeigen, dass die Behauptung der GCMs des IPCC, dass nämlich die gesamte Erwärmung von 1970 bis 2000 anthropogen induziert worden ist, irreführend ist wegen des Scheiterns der GCMs, die 20- und 60-jährigen Klimazyklen zu reproduzieren. Schließlich zeigen wir, wie die Gegenwart dieser großen natürlichen Klimazyklen benutzt werden kann, um den vom IPCC projizierten Erwärmungstrend für das 21. Jahrhundert zu korrigieren. Wenn dieser korrigierte Trend mit natürlichen Zyklen kombiniert wird, zeigen wir, dass die Temperatur während der nächsten 30 Jahre nicht signifikant zunehmen wird, hauptsächlich wegen der negativen Phase des 60-jährigen Zyklus’. Wenn multisäkulare [?] natürliche Zyklen (welche einigen Autoren zufolge signifikant zu der beobachteten Erwärmung von 1700 bis 2010 beigetragen haben und die zu einer zusätzlichen natürlichen Abkühlung bis 2100 beitragen können) ignoriert werden, würden die gleichen vom IPCC projizierten anthropogenen Emissionen eine Erwärmung um etwa 0,3°C bis 1,2°C bis 2100 ergeben, im Gegensatz zu den IPCC-Projektionen von 1,0°C bis 3,6°C Erwärmung. Die Ergebnisse dieser Studie belegen frühere Behauptungen, dass die relevanten physikalischen Mechanismen, die die beobachteten Klimazyklen erklären können, in den gegenwärtigen GCMs immer noch fehlen und dass Klimaänderungen in multidekadischen Zeiträumen astronomisch induziert sind und in erster Näherung vorhergesagt werden können.

Von Dr. Nicola Scafetta

Übersetzt von Chris Frey für EIKE