Vergangen oder aktuell? Der SPIEGEL warnte 1974 und 1977 vor einer drohenden Kaltzeitkatastrophe

So ist es erheiternd – schließlich ist momentan Narrenzeit – zwei ehemalige Berichte des SPIEGEL über eine drohende globale Abkühlungskatastrophe zu lesen. Sie sind im Internet abgreifbar hier und hier. Man genieße diese Artikel, auf die uns unser Leser Winfried Klein aufmerksam machte.

Aber: ist nicht schließlich die Wissenschaft heute viel weiter als vor 40 Jahren? Schaut man sich den Zustand der aktuellen Klimaforschung an, die inzwischen bekanntlich das platte Gegenteil der damaligen Abkühlungsbefürchtungen vertritt, entstehen Zweifel. Die im Folgenden skizzierten beiden Hauptmerkmale der modernen Klimaforschung – Zyniker sprechen von „postmoderner Forschung“ – sprechen für sich.

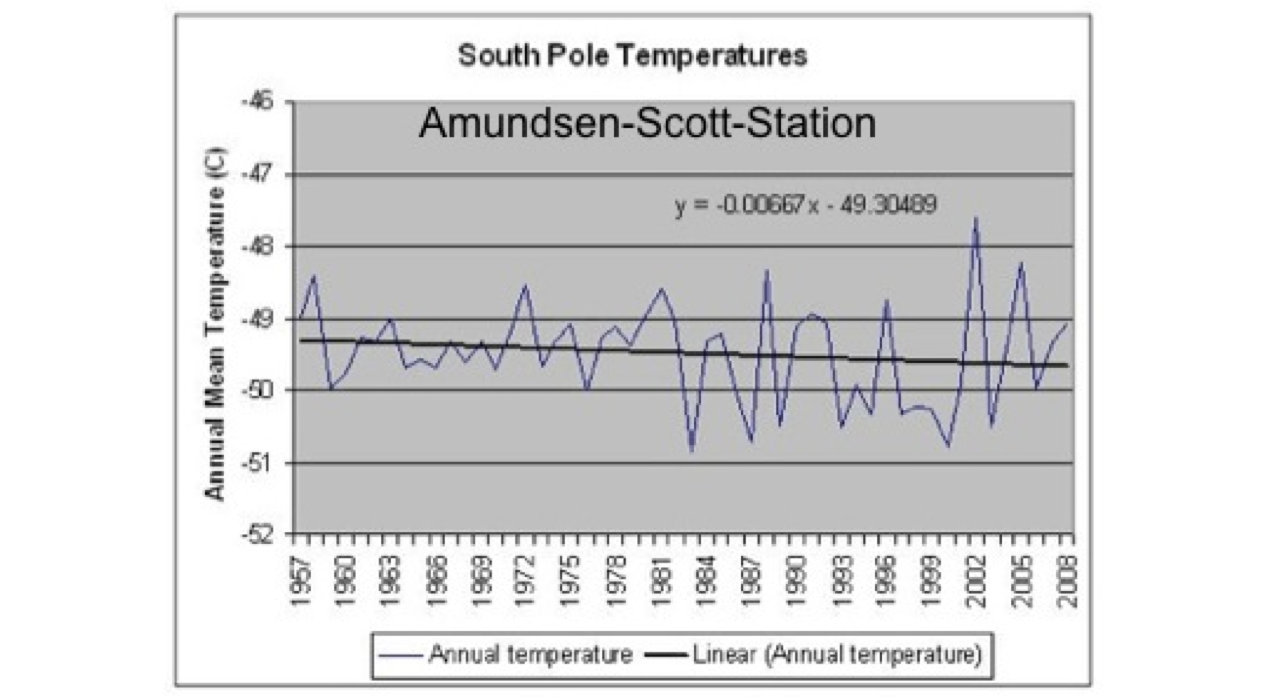

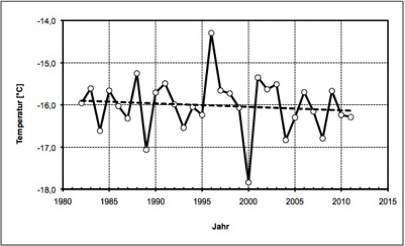

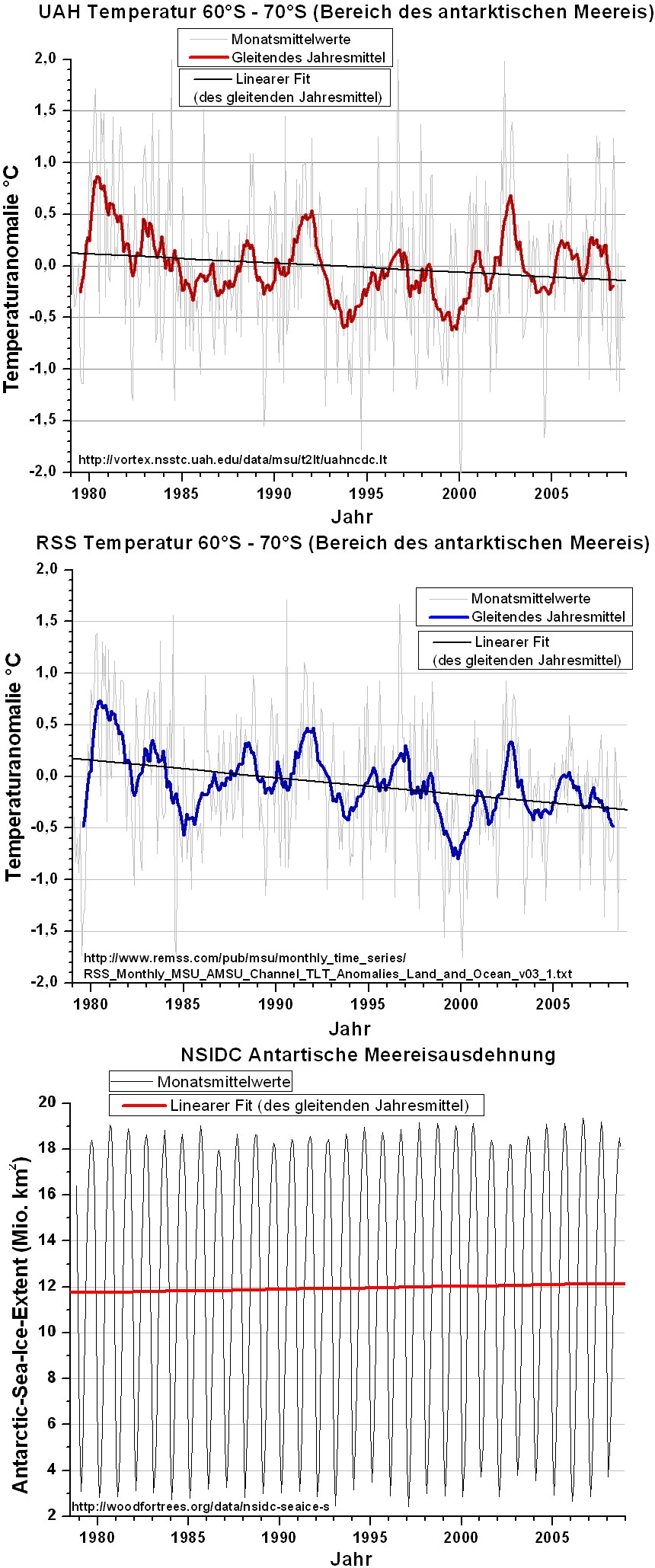

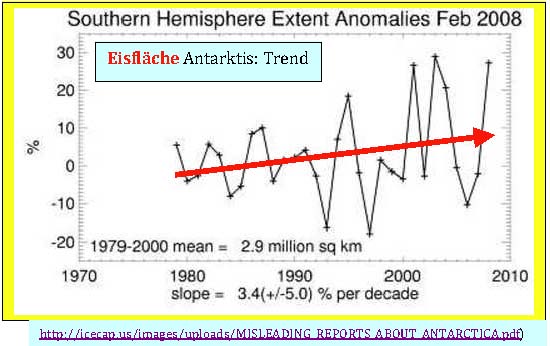

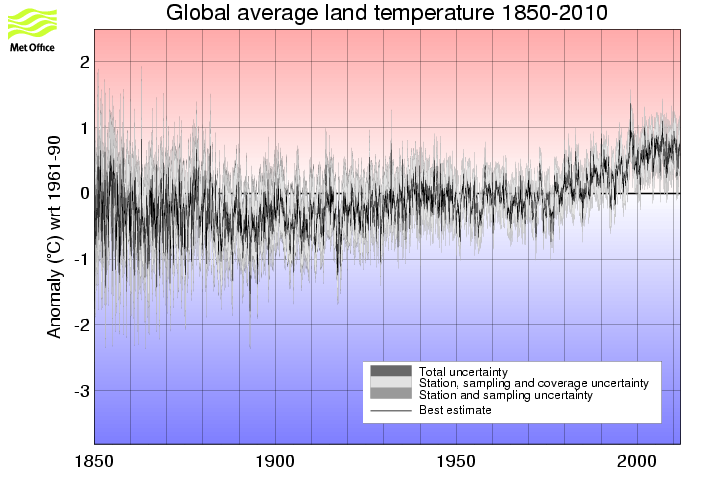

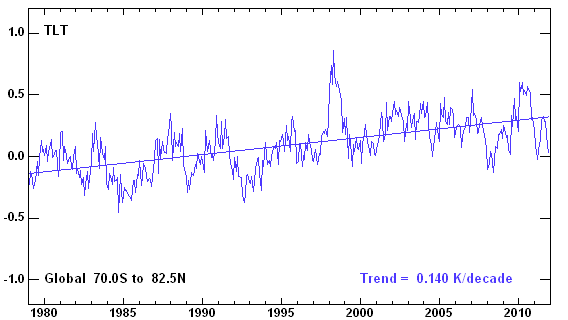

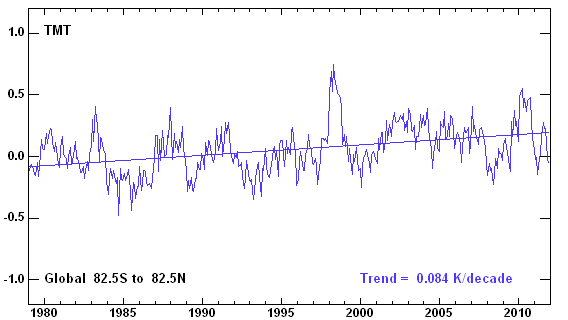

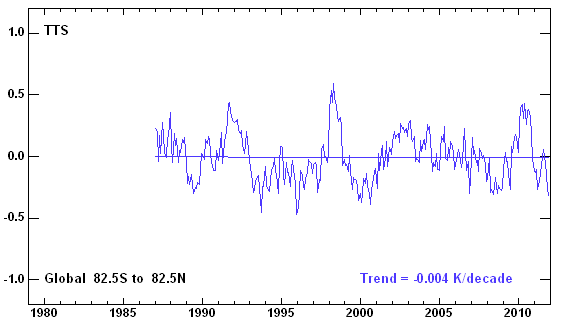

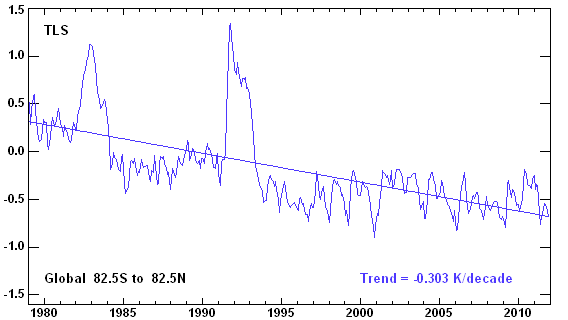

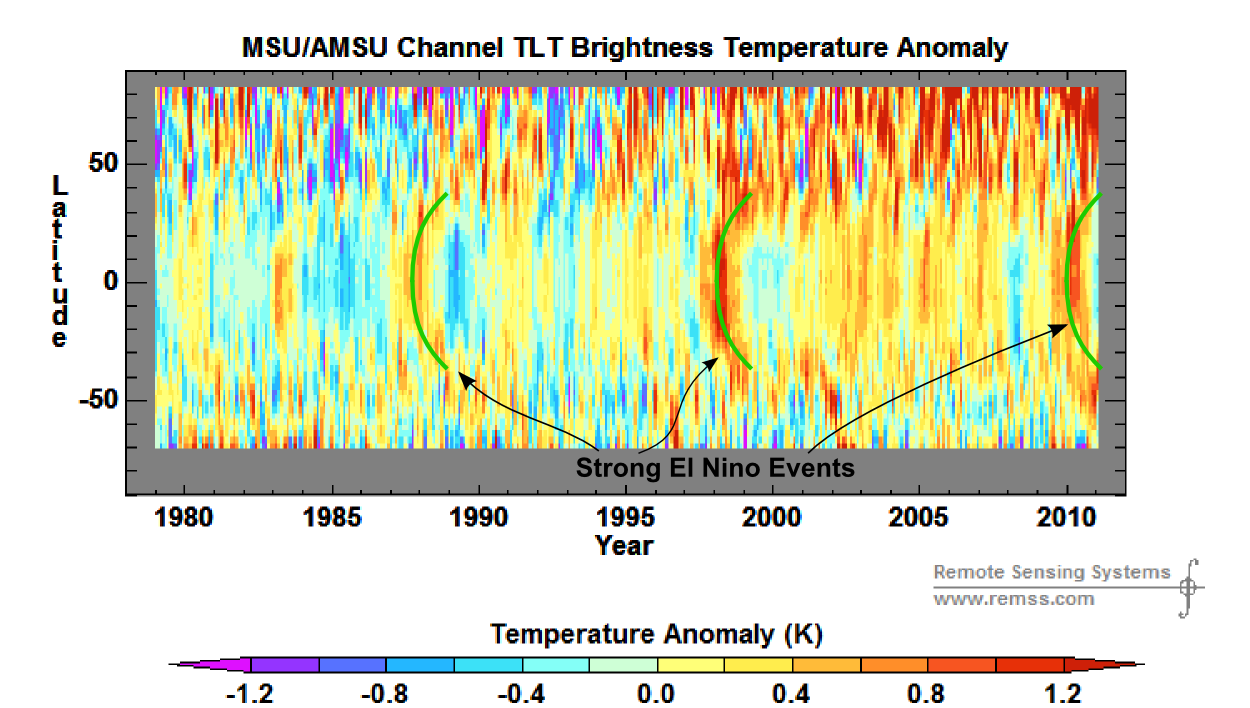

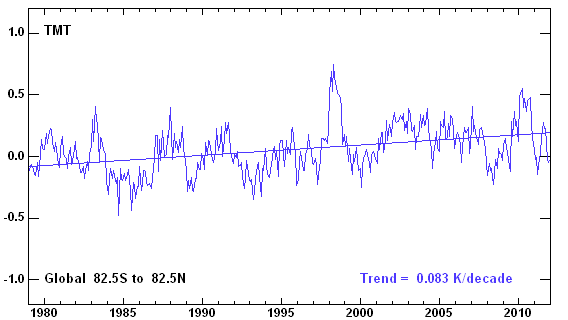

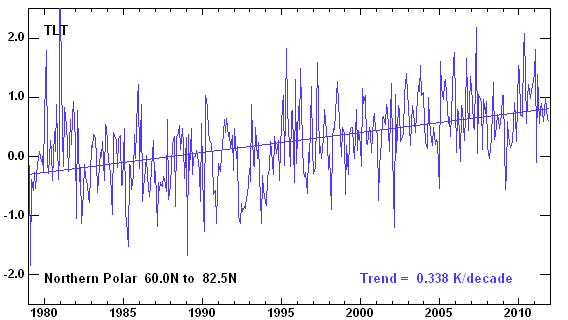

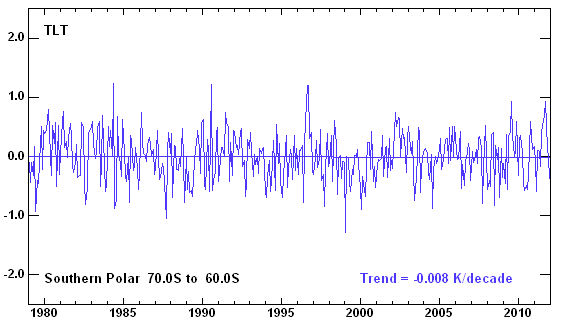

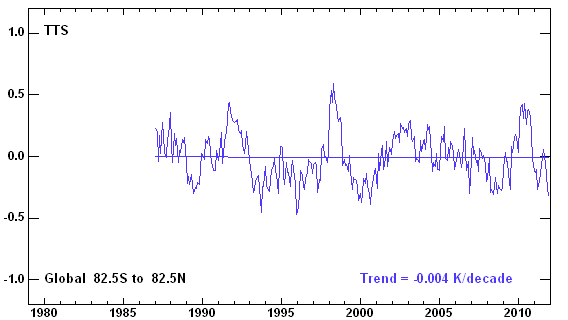

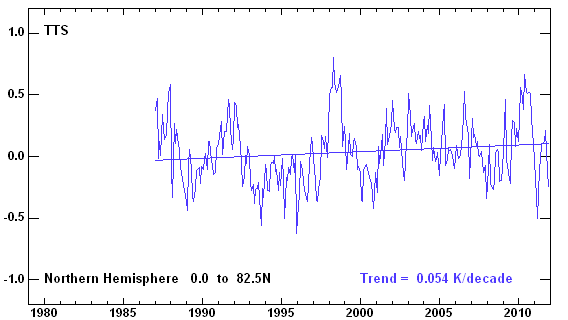

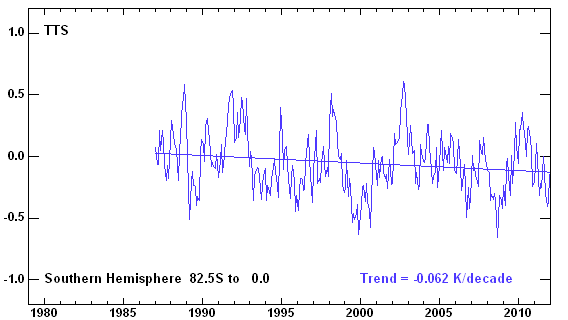

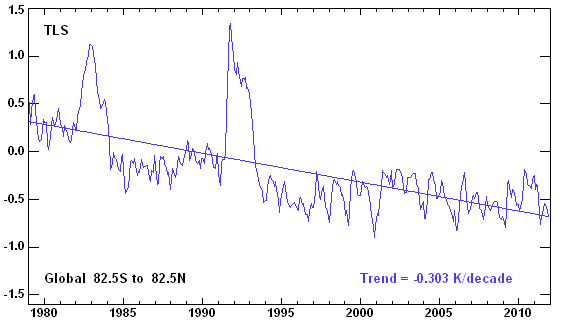

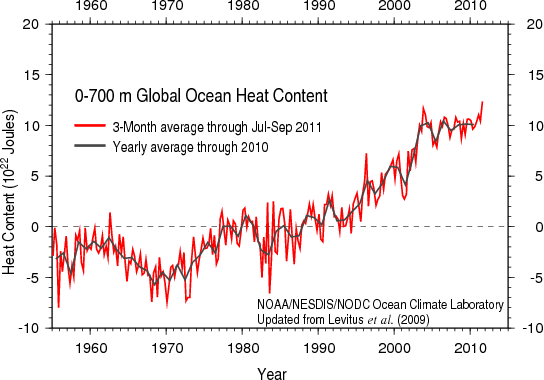

An erster Stelle ist eine bereits als grenzenlos zu bezeichnende Modellhörigkeit zu nennen. Ist diese ein Akt der Verzweiflung, weil der unsere Atmosphäre erwärmende Einfluss des anthropogenen CO2 nicht direkt messbar ist? Erwärmung durch zunehmendes CO2 muss es zwar aus guten physikalischen Gründen geben (auch Dr. Link zusammen mit dem Autor haben hierüber publiziert), aber insbesondere in Temperaturreihen der Atmosphäre ist dieser zu schwache Effekt bis heute partout nicht aufzufinden.

Dieser für die Katastrophenanhänger höchst ärgerliche Sachverhalt, den man zwar den Medien, nicht aber den Fachleuten vorenthalten kann, wird in der Fachliteratur als das „attribution and detection problem“ bezeichnet – eine Formulierung, die für sich spricht. Auch der Autor, zusammen mit Dr. Link und Prof. Ewert haben sich an diesem „Attribution und Detection-Problem“ versucht, aber außer einem relativ schwachen, unnatürlichen Erwärmungstrend unbekannter Ursache keine „smoking gun“ auffinden können.

Für Wissenschaftler sind solche „Negativergebnisse“ Normalität, für die berichtende Presse aber unbefriedigend. Doch zurück zu den Klimamodellen. Sie sind zweifellos wertvolle Hilfsmittel für Detailfragen. Man tut ihnen indes Unrecht, mehr zu verlangen. Sie können weder die großen dekadalen Oszillationen, noch den El Nino vorhersagen, sie können ohne massive Korrekturen die Klimavergangenheit nicht beschreiben und sie wissen nichts über den Feedback-Faktor. Auf solchen Modellen und Vorhersagen „erster und zweiter Art“ beruht also das so viele Menschen ängstigende Drohgebäude einer gefährlichen globalen Erwärmung. Zweifellos gibt es konkretere Gefahren für die Menschheit!

An zweiter Stelle endlich ist der desaströse Zustand der heutigen Klimaforschung zu nennen. Von einer objektiven Geisteshaltung, sachlichen Beurteilung oder gar fairen wissenschaftlichen Diskussion ist sie inzwischen meilenweit weit entfernt. Die Szene ist vielmehr dominiert von Advocacy-Klimatologen, die grob gegen die wissenschaftliche Ethik und das Ockham-Prinzip verstoßen. Über den Skandal der durchgesickerten CRU-Mails wurde vielfach berichtet. Offiziell gab es bislang nur „Freisprüche“, was sich aber noch ändern kann, denn der Fundus an belastendem Material scheint noch nicht ausgeschöpft. Wir wollen auf diese unerfreulichen Vorgänge hier nicht weiter eingehen. Entscheidend ist, dass einflussreiche Forscher eine von der Politik offenbar gewünschte Linie in einer Weise unterstützen, die mit wertfreier Forschung nichts mehr gemein hat. Neben offensichtlichen Betrügern gibt es noch die Advocacy-Forscher, die konsequent das Ockham-Prinzip ignorieren. Dieses für die moderne Naturwissenschaft wichtigste Paradigma besagt, dass zur Erklärung eines Naturphänomens zuerst einmal die bekannten Gesetzmäßigkeiten heranzuziehen sind, bevor man eine (unnötige) neue Theorie aufstellt oder ein fragwürdiges Modell verwendet.

Zwei stellvertretende Beispiele: Die Eisbohrkern-Analysen der Vostok-Station in der Antarktis zeigen einen engen Zusammenhang zwischen globalen Mitteltemperaturen und CO2-Konzentrationen. Hat daher in der Vergangenheit das CO2 die Globaltemperaturen gesteuert? Bei besserer Zeitauflösung der Reihe klärt sich das Rätsel: die CO2-Konzentrationen hinken den Temperaturen grob um 1000 Jahre hinterher (hier und hier). Dem Prinzip von Ockham fogend findet man: Bei zunehmender Erwärmung wird aus den Weltmeeren mehr CO2 ausgegast, und da ein Weltmeer grob 1000 Jahre braucht, um sich vollständig umzuwälzen – ist der Nachhinken-Effekt bestens erklärt. Nicht für die wissenschaftlichen Anhänger der CO2-Katastrophe! Hier werden verwickelte Rückkoppelungs-Klimmzüge gemacht, um in umgekehrter Richtung einen maßgebenden CO2-Einfluss zu „retten“. Da dies im beschriebenen Fall kaum möglich ist, ignoriert man schließlich das einfachste Argument.

Ein weiteres Anschauungsbeispiel bot sich dem Autor kürzlich beim Autoradio hören. Eine Reporterin berichtete sichtlich besorgt, dass infolge des Klimawandels die Starkregenfälle in Deutschland zunehmen würden. Ein bekanntes deutsches Klimainstitut (leider ist der Name des Instituts beim Autofahren untergegangen, der Autor meint das AWI oder das Kieler Institut gehört zu haben) hätte es zweifelsfrei an Hand von Modellrechnungen belegt. Das besagte Institut erarbeite nunmehr an Hand seiner Modelle Szenarien und Schutzmaßnahmen gegen Überschwemmungsereignisse an deutschen Flüssen, Schutzmaßnahmen gegen Überschwemmungen sind immer gut, den Kollegen sei dieses Zubrot gegönnt. Ist aber auch die wissenschaftliche Begründung gut? Der Laie als Hörer ist vielleicht beeindruckt, auch der Fachmann?

Immerhin belegt inzwischen sogar das IPCC in seinem jüngsten Extremwetterbericht von 2011 keine Extremwetteränderungen, die über die bisher als natürlich beobachtete Variabilität hinausgehen. Nur – schon wieder Modelle! – in fernerer Zukunft gäbe es eine vermutete Zunahme, es wird die Jahreszahl 2100 genannt. Lassen wir diese unrealistischen Modellspielereien jetzt besser beiseite!

Es gibt aber auch von kompetenter Stelle Entwarnung. Die Persistenzanalyse von Niederschlagsreihen zeigt für weltweit alle Messungen, dass diese Reihen „kein Gedächtnis“ haben. Im Klartext: Ihr Auftreten und ihre Heftigkeit ist zufällig. Gäbe es im 20. Jahrhundert infolge irgendeines anthropogenen Effekts eine Veränderung dieses Zustands, hätte man es in den unzähligen Autokorrelationsanalyse von Niederschlagsreihen sehen müssen. Nichts! Die Wissenschaftler des hier in Rede stehenden Instituts haben in ihrer Modellbegeisterung diese grundlegende Arbeit übersehen, EIKE leistet daher Hilfestellung. Auf S. 83 der grundlegenden Arbeit von Kantelhardt findet sich das zugehörige Kapitel über die Autokorrelation von Niederschlagsreihen.

Die modellhörigen Forscher hätten sich aber auch nur in der Vergangenheit kundig zu machen brauchen. Aus der mittelalterlichen Warmzeit sind keine ungewöhnlichen Niederschlagsereignisse tradiert. Im Gegenteil: in den heissen Sommers dieser Zeit waren Rhein und Donau fast ausgetrocknet. So konnte die Regensburger Steinbrücke in der trockenen Donau gebaut werden und zu Köln überquerten die Leute zu Fuss den Rhein. Es wäre daher interessant zu erfahren, was die modernen Modelle zu den damaligen Zuständen sagen.

Für den an Details weniger interessierten Leser zum Abschluss eine Zusammenfassung:

Der Unterschied zwischen CO2 als katastrophaler Gefahr oder einem für das Pflanzenwachstum wünschenswerten Naturgas der Photosynthese, dessen geringfügige anthropogene Erwärmungswirkung für die Menschheit erwünscht ist, liegt ausschließlich in fragwürdige Klimamodellen. Nur wenn man diesen glaubt, sind kostspielige Vermeidungsmaßnahmen erforderlich, deren Kosten dann dem wirklichen Naturschutz verloren sind. Politik und die sie unterstützenden Advocacy-Wissenschaftler sind für eine Entscheidung keine Hilfe. So wurde von einem wissenschaftlichen Institut, dem Potsdamer Institut für Klimafolgenforschung (PIK) ein 2 °C Ziel „erfunden“, das die Fachliteratur nicht kennt und ausschließlich politischer Natur ist. Der Direktor dieses Instituts (Prof. Schellnhuber) gibt Zeitungsinterviews, die mit den Resultaten seiner wissenschaftlichen Veröffentlichungen – um es vorsichtig auszudrücken – nur schwer in Zusammenhang zu bringen sind (im summary der Arbeit nachzulesen). Statt den Messungen und der Klimahistorie Priorität einzuräumen, greift man zu fragwürdigen Modellen, die ihre Zuverlässigkeitsnachweis bislang schuldig geblieben sind.

Prof. Dr. Horst-Joachim Lüdecke

EIKE-Pressesprecher

report &

report &  press release here or see files attached (remark: Downloads of .doc pressrelease with SAFARI seems not to work, FIRFOX workfs fine)

press release here or see files attached (remark: Downloads of .doc pressrelease with SAFARI seems not to work, FIRFOX workfs fine)