Provoked scientists try to explain lag in global warming

Es gibt einige interessante Aussagen von Klimawissenschaftlern in dem Artikel, die einen großen Grad an Unsicherheit hinsichtlich des Klimasystems zeigen, sowie der menschlichen Rolle dabei, selbst unter den Klimawissenschaftlern, die eng mit dem IPCC verflochten sind. Der lange Artikel konzentriert sich auf die Frage:

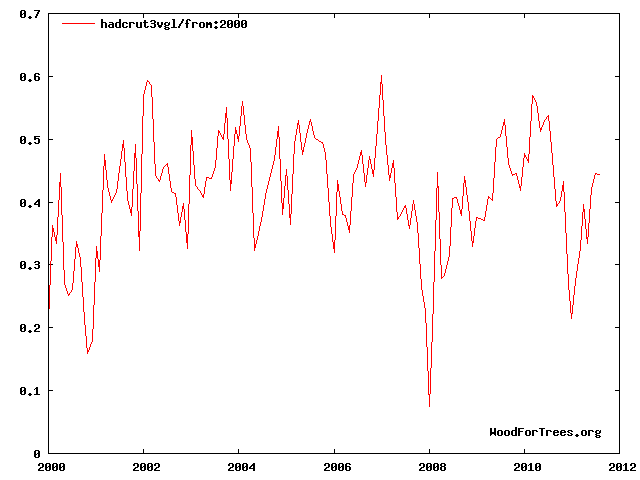

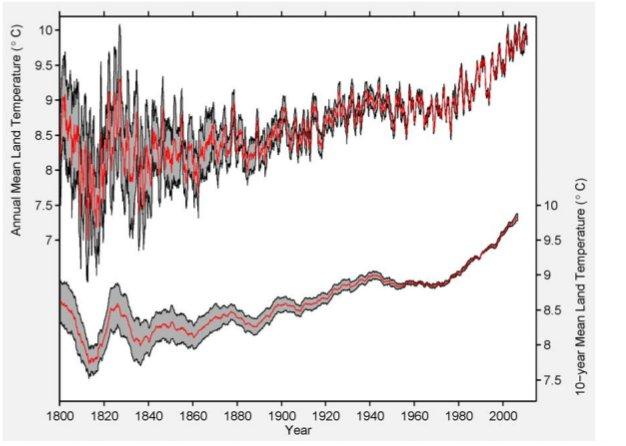

„Warum ist der Temperaturanstieg des Planeten während des letzten Jahrzehnts trotz stetig steigenden CO2-Gehaltes zum Stillstand gekommen?”

Interessante Zitate und Texte (neu arrangiert, um die zitierten Personen in eine Reihe zu beklommen; man sollte den ganzen Artikel lesen [hier nicht übersetzt]) schließen ein (Hervorhebungen von Paul Voosen):

Von John Barnes

(Sein Spezialgebiet ist die Messung des stratosphärischen Aerosols):

„Schaut man auf das vergangene Jahrzehnt und die globale Temperatur, so ist diese nicht gestiegen“, sagte Barnes. „Es gibt eine große Streuung dabei. Aber die (Klima-)Modelle gehen nach oben. Und das muss erklärt werden! Warum ist es nicht wärmer geworden?“

Barnes hat 20 Jahre lang einsame Wache geschoben (am Mauna Loa-Observatorium in Hawaii). Er fuhr Abend für Abend die kurvenreiche, mit Schlaglöchern übersäte Straße hinauf in sein von der Regierung betriebenes Büro und wartete auf das große Ereignis [the big one]. Seine Spezialität sind Messungen des stratosphärischen Aerosols, reflektierende Partikel aus Vulkanausbrüchen, von denen man weiß, dass sie den Planeten kurzzeitig abkühlen. Nur die gewaltigsten Vulkanausbrüche sind imstande, Emissionen über die Wolken hinaus zu blasen, dachten die Wissenschaftler, und so wartete Barnes auf seine Zeit, nachdem er den Laser errichtet hatte.

Bis auf den heutigen Tag hat es seit 1991 keinen großen Vulkanausbruch mehr gegeben! 1991 erfolgte der Ausbruch des Pinatubo auf den Philippinen, was zu einer Abkühlung der Erde um ein halbes Grad während einiger Jahre führte. Doch Barnes dokumentierte diese Ruhe unablässig und konnte so das Hintergrundniveau der Partikel in der Stratosphäre identifizieren. Und dann, als er vor vier Jahren in seinem Labor saß, nicht weit von dem Ort entfernt, wo Charles Keeling zuerst Messungen des steigenden atmosphärischen CO2-Gehaltes durchführte, fand Barnes etwas Komisches in seinen Aufzeichnungen zum Aerosol.

Barnes beklagt sich über die verwirrende Komplexität, all die kleinen Antriebe des Klimas voneinander zu trennen. Es machte Carles Keelings sorgfältige Arbeit, den steigenden CO2-Gehalt zu identifizieren, vergleichsweise zu einer sehr einfachen Angelegenheit.

„Es ist wirklich subtil”, sagte er. „Es ist schwierig zu bestimmen, wie viel von den Ozeanen aufgenommen wird, weil die Ozeane Einiges von der Wärme aufsaugen. Und an vielen Orten sind die Messungen einfach nicht genau genug. Wir haben Satelliten, die den Energiehaushalt messen können, und doch gibt es hier noch Hypothesen. Es gibt Hypothesen über die Ozeane, weil wir keine Vielfalt von Messungen von den Ozeanen haben“.

Von Jean-Paul Vernier

Vor fünf Jahren veränderte ein Ballonaufstieg über dem Sand der Sahara das Leben von Jean-Paul Vernier.

Der Ballon stieg über dem in der Hitze gebackenen Sand von Niger auf, ausgerüstet um Aerosole einzufangen, das Gemisch aus natürlichen und anthropogenen Partikeln, die in die Atmosphäre entwichen waren. Der Ballon stieg über die Wolken und in die Stratosphäre. Dort erwartete Vernier klaren Himmel zu finden; schließlich hatte es seit mehr als einem Jahrzehnt keine Eruption wie vom Pinatubo mehr gegeben. Aber er lag falsch. In einer Höhe von 12 Meilen [ ca. 19 km] fand der Ballon eine Ladung [a lode = im Bergbau eine Ader oder ein Flöz. Eine andere Übersetzung konnte ich nicht finden. A. d. Übers.] von Aerosolen.

Vernier hatte eine Scheibe des Trends gefunden, den Barnes auf dem Mauna Loa in Hawaii entdeckt hatte. Es war erstaunlich. Woher könnten diese Wärme reflektierenden Aerosole stammen? Vernier war sich nicht sicher, aber Barnes und sein Team wagten eine Vermutung, als sie ihr Ergebnis verkündeten. Es war ihrem Vorschlag zufolge die rapide zunehmende Industrialisierung in China, die sie so hatte zunehmen lassen.

Ein französischer Wissenschaftler, der am Langley Research Center der NASA in Virginia arbeitete, um Aerosole zu studieren, nämlich Vernier, bediente sich wie Barnes eines Lasers, um die Existenz dieser blöden Aerosole zu verstehen. Aber er verwendete keinen auf dem Erdboden installierten Laser, sondern einen aus dem Weltraum.

Im gleichen Jahr wie die Ballon-Messkampagne in Niger hat die NASA einen mit Laser ausgestatteten Satelliten gestartet mit dem Ziel, Aerosole über den Wolken zu messen. Vernier und seine Kollegen vermuteten mit einer Portion Scharfsinn, dass sie den Laser mit der Bezeichnung CALYPSO dazu bringen könnten, auch klare Angaben zur Stratosphäre zu liefern. Die Datenlawine des Satelliten war chaotisch – zu viel Rauschen nach Barnes’ Geschmack, als er sich das ansah – aber viele Jahre später konnte Vernier sie deuten. Er hatte eine Antwort gefunden.

Zuallermeist schienen die Aerosole nicht aus China zu kommen!

Von Kevin Trenberth

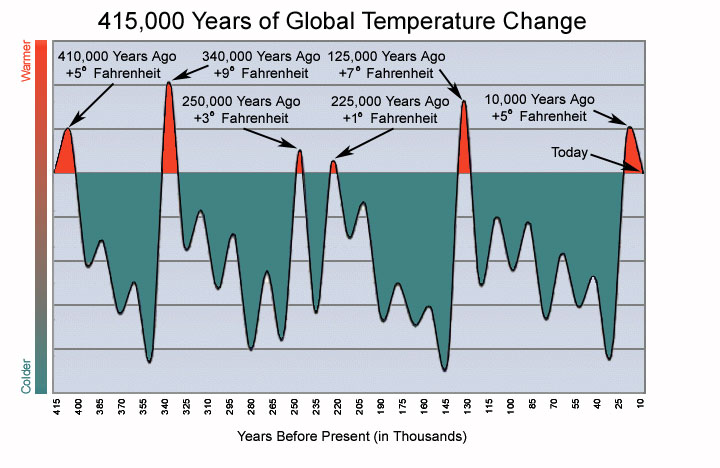

Die Lücke (in der Erwärmung) kam nicht unerwartet. Variabilität beim Klima kann steigende Temperaturen vorübergehend unterdrücken, wobei jedoch vor dieser Dekade die Wissenschaftler nicht genau wussten, wie lange solche Pausen dauern könnten. In jedem Fall ist eine Dekade ein zu kurzer Zeitraum, um etwas über menschliche Auswirkungen auf das Klima zu sagen. In einem demnächst veröffentlichten Papier sind 17 Jahre das Mindeste.

Einigen Wissenschaftlern reichte es, die Lücke der natürlichen Variabilität des Planeten zuzuschreiben. Die Temperatur wird bald wieder steigen. Getrieben durch das immer dicker werdende Tuch, das durch die Treibhausgase über die Erde geworfen wird. Die Leute werden das vergessen.

Aber für andere war diese einfache Antwort ein Fehlschlag. Falls die Wissenschaftler den Stillstand auf die natürliche Variabilität zurückführen, stehen sie vor dem Problem, präzise zu erklären, wie diese Variationen funktionieren. Ohne Beweise sind ihre Statements nicht besser als die unbegründeten Theorien der Skeptiker im Internet.

„Das hat mich immer bewegt“, sagte Kevin Trenberth, Leiter der Abteilung Klimaanalyse am National Center for Atmospheric Research. „Natürliche Variabilität ist kein Grund. Man muss sagen, welcher Aspekt der natürlichen Variabilität“.

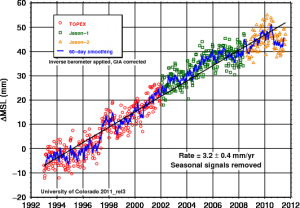

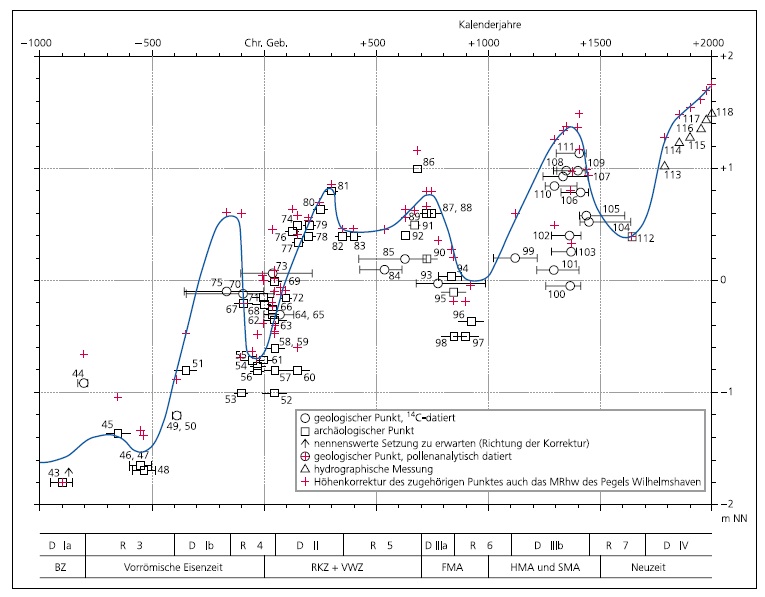

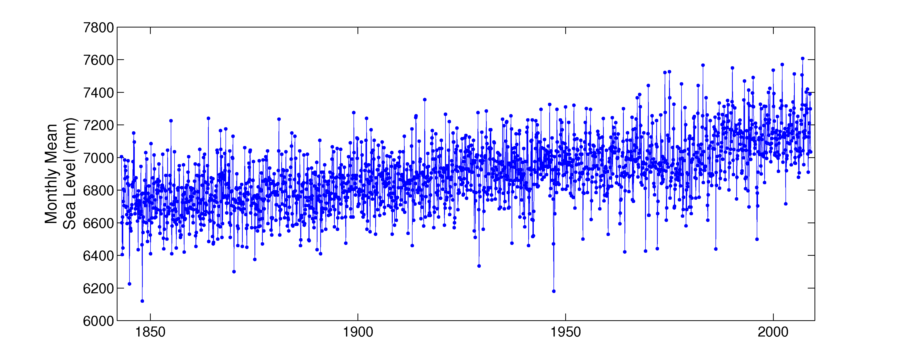

Bis zum Jahre 2003 gab es unter den Wissenschaftlern ein tragbares Verständnis darüber, wohin die gefangene Wärme der Sonne ging; sie wurde reflektiert durch steigende Meeresspiegel und steigende Temperaturen. Seitdem hat die Wärme in den oberen Schichten der Ozeane jedoch kaum zugenommen, und der Meeresspiegelanstieg hat sich verlangsamt, während Satellitendaten über Ein- und Ausstrahlung – dem Energiehaushalt der Erde – ergaben, dass jede zunehmende Menge an Energie von außen auf dem Planeten eingefangen werden müsste. (Einige Wissenschaftler stellen in Frage, sich zu sehr auf die Satellitendaten zu verlassen, seit die beobachtete Energie drastisch nach unten korrigiert werden muss, vorgegeben durch die Klimamodelle). Unter der Voraussetzung, dass dieser Haushalt angeblich solare Zyklen und Aerosole berücksichtigt, fehlte etwas.

Wohin war die Wärme gegangen? Trenberth hat diese Frage immer wieder wiederholt.

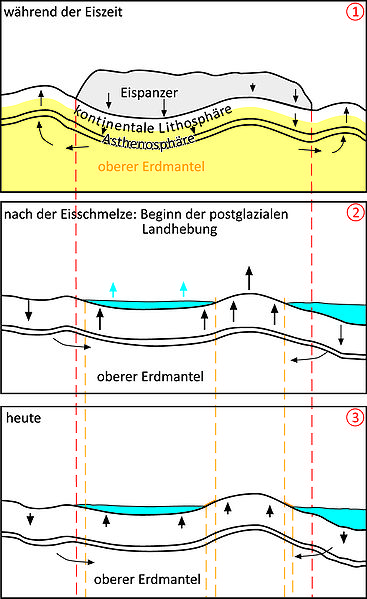

Vor kurzem, in Zusammenarbeit mit Gerald Meehl und anderen, schlug Trenberth eine Antwort vor. In einer im September veröffentlichten Studie stellten sie ein Klimamodell vor, das Jahrzehnte lange Pausen beim Temperaturanstieg simulierte, und die damit verbundene fehlende Energie könnte damit zusammenhängen, dass die Wärme in die tiefen, kalten Ozeane sinkt, bis über eine Tiefe von 2000 Fuß [ca. 600 m] hinaus. Das Team verwendete ein neues Modell, das für den nächsten UN-Bericht zum Klima erstellt worden ist. Anders als die Modelle in der Vergangenheit kommt die Variabilität im Pazifik gut zum Ausdruck, was „wichtig zu sein scheint“, sagte Trenberth.

Während eines La Niña-Ereignisses bedeuten die kälteren Wassertemperaturen im Pazifik geringere konvektive Aktivität – weniger tropische Stürme usw., weniger Wolken und damit mehr Sonne“, sagte er. „Die Wärme verschwindet im Ozean, wird aber durch die Meeresströmungen weilweit verteilt. Damit tragen ironischerweise kältere Bedingungen zu größerer Wärmeabscheidung bei“.

Es ist eine überzeugende Illustration, wie die natürliche Variabilität, zumindest in diesem Modell, den Einfluss der zunehmenden Treibhausgase für ein Jahrzehnt oder länger überkompensieren kann, sagen mehrere Wissenschaftler. Jedoch ist die Suche nach einer Antwort einem prominenten Forscher zufolge – Hansen von der NASA – überflüssig.

Und zwar weil es nach Hansen keine fehlende Energie gibt.

Trenberth stellt in Frage, ob die ARGO-Messungen stabil genug sind, um definitiv zu bestätigen, was Hansen entwirft. Er hatte viele Diskrepanzen unter den Datenanalysen gesehen, und es gibt immer noch „fehlende und irrige Daten und Anpassungen“, sagte er. Die ARGO-Messungen sind wertvoll, fügte er hinzu, aber sie sind noch nicht da.

Von Susan Solomon

co-chairs der Working Group 1 of the Intergovernmental Panel on Climate Change.[2

„Das Faszinierendste für mich an dieser vergangenen Zehn-Jahres-Periode war, dass es die Leute nachdenklich gemacht hat hinsichtlich der dekadischen Variabilität, und zwar viel mehr als vorher”, sagte Susan Solomon, eine Atmosphärenchemikerin und frühere Leitautorin eines Berichtes der UN zum Klima während einem kürzliche Besuch am MIT. „Und das kann nur gut sein. Es gibt keine silberne Kugel. In diesem Falle sind es vier oder fünf Stückchen einer Silber-Schrotladung“.

Solomon hat gezeigt, dass die Menge an Wasserdampf in der Stratosphäre zwischen 2000 und 2009 um 10 Prozent abgenommen hat. Dieser Rückgang, entweder hervorgerufen durch natürliche Variabilität – möglicherweise im Zusammenhang mit El Niño – oder als Rückkopplung der Klimaänderung, hielt vermutlich 25% der Erwärmung durch Treibhausgase zurück, die es sonst gegeben hätte. (Einige Wissenschaftler haben angemerkt, dass diese Schätzung sehr hoch ist). Jetzt scheint eine andere Dynamik die Hauptrolle über den Wolken zu übernehmen.

In einer in diesem Sommer veröffentlichten Studie haben Solomon, Vernier und andere aus diesen unterschiedlichen Fakten gefolgert, dass diese Aerosole einen Abkühlungstrend um 0,07°C während der letzten Dekade gebracht haben. Ähnlich wie beim Wasserdampf gibt es keine einzelne Antwort, sondern es war nur ein kleiner Mitspieler. Dies ist die Art von geringen Einflüssen, die in künftigen Klimamodellen mit berechnet werden muss, sagt Santer von Livermore.

Solomon war überrascht, Verniers Arbeit zu sehen. Sie erinnerte sich an den Ausbruch des Soufrière und dachte bei sich, „dass dieser es niemals bis in die Stratosphäre schaffen würde“. Mit dem neuen Wissen änderte sich diese Erkenntnis rasch. „Man kann sehen, das all diese kleinen Eruptionen, von denen wir angenommen hatten, dass sie keine Rolle spielen, eben doch von Bedeutung sind“, sagte sie.

Von Jim Hansen

Diese Entdeckungen sorgen dafür, dass die größten Namen unter den Wissenschaftlern ihre Meinung ändern.

"Tatsächlich könnte die größte Ausbeute der Jagd nach der Energie darin bestehen, dass die Forscher den reflektiven Effekt der Luftverschmutzung chronisch unterschätzen“, sagte Jim Hansen von der NASA, Leiter des GISS.

Jüngste Daten haben ihn gezwungen, seine Ansichten über die Menge der von der Sonne kommenden, in den Ozeanen gespeicherten Energie zu ändern, die den Planeten erwärmt. Stattdessen, sagt er, hat die Luftverschmutzung aus der Verbrennung fossiler Treibstoffe direkt und indirekt die Treibhauserwärmung maskiert, und zwar mehr, als jeder gedacht hatte.

Es war in „keiner Weise beeinflusst durch die unsinnigen Behauptungen der Gegner”, sagte Hansen. „Dies sind fundamentale Dinge, auf die sich die Wissenschaft immer konzentriert hat. Das Problem bestand im Fehlen (wissenschaftlicher) Beobachtungen“.

Hansen von der NASA bestreitet, dass die Einwände der Skeptiker die Klimawissenschaftler dazu gebracht hat, den Einfluss der Sonne auf das Klima zu ignorieren. Sein Team, sagt er, „hat immer den solaren Antrieb basierend auf Beobachtungen und Judiths Schätzungen für die Zeit vor genauen Messungen mit einbezogen“.

„Dies hier macht die Sonne noch etwas wichtiger, weil die solare Variabilität das Ungleichgewicht in der planetarischen Wärmebilanz moduliert”, sagte Hansen. „Aber der solare Antrieb ist zu schwach, das Ungleichgewicht negativ zu machen, d. h. solare Variationen werden keine globale Abkühlung verursachen“.

„Unglücklicherweise ändern sich der solare Antrieb und der stratosphärische Wasserdampfgehalt, wenn wir uns auf das vulkanische Aerosol konzentrieren, es handelt sich um einen Fall, einen Schlüssel im Licht von Straßenlampen zu suchen“, sagte Hansen. „Was wir tun müssen ist, auf den Antrieb des troposphärischen Aerosols zu schauen, aber das liegt nicht unter der Straßenbeleuchtung.“

„Ich habe den Verdacht, dass es eine Zunahme des Aerosols im Zuge eines rasch steigenden Kohleverbrauchs während der letzten 5 Jahre oder so gegeben hat”, sagte er. „In den Gebieten, wo man das erwartet, gibt es semi-quantitative Beweise dafür. Unglücklicherweise besteht das Problem darin, dass wir das Aerosol nicht genau genug messen können um zu bestimmen, wie es wirkt und wie es sich verändert.“

Noch grundlegender, die ARGO-Daten haben Hansen veranlasst, sein Verständnis darüber, wie das Klima funktioniert, auf grundlegende Weise zu ändern, eine Änderung, die er in einer bestimmt kontrovers aufgenommenen Studie ausführt, die später in diesem Jahr veröffentlicht werden soll.

Seit Jahrzehnten ist den Wissenschaftlern bekannt, dass der größte Anteil der durch die Treibhausgase zurück gehaltenen Wärme in die Ozean geht, nicht in die Atmosphäre. Als Ergebnis, sagen sie, würde sich die Erde selbst dann erwärmen, wenn die Emissionen morgen gestoppt werden könnten, weil die Atmosphäre danach trachtet, den Ausgleich mit der Wärme im Ozean zu suchen. Oder, wie Hansen einwarf, diese Extraerwärmung würde „in der Pipeline“ stecken mit Auswirkungen, die Jahre über Jahre auf der Lauer liegen. Aber wie viel Wärme genau in der Pipeline ist, hängt davon ab, wie effektiv die Wärme in den Ozeanen durchmischt wird.

Hansen glaubt, jetzt eine Antwort zu haben: Im Vergleich zu den ARGO-Daten und einer Studie zu den Spuren, die demnächst durch mehrere NASA-Wissenschaftler veröffentlicht werden wird, haben alle diese Klimamodelle übertrieben, wie effizient die Ozeane die Wärme verteilen. Diese Einhelligkeit dieser effizienten Durchmischung könnte aufgrund verschiedener Abstammungen in ihrem Code herrühren. Wie auch immer, es bedeutet, dass die Klimamodelle die Energiemenge beim Klima überschätzt haben, und zwar in ihrem Trachten danach, die stattfindende Erwärmung mit effizienten Ozeanen passend zu machen. Sie haben ein Problem gelöst, das gar nicht existiert.

Auf den ersten Blick kann dies leicht wie eine gute Nachricht klingen, aber das ist es nicht.

Eine weniger effiziente Durchmischung würde unter gleichen Bedingungen bedeuten, dass weniger Wärme ‚in der Pipeline’ steckt“, sagte Hansen. „Aber es impliziert auch, dass der negative Antrieb durch das Aerosol möglicherweise größer ist, als viele Modelle annehmen. Also ist der faustische Aerosolhandel möglicherweise ein größeres Problem als ursprünglich angenommen.“

Von John Daniel

(ein Forscher am Earth System Research Lab der NOAA)

Als der Rekord 1998 aufgetreten war, kamen die Wissenschaftler ins Stocken. Das passiert oft angesichts hoher Temperaturen. Sie interpretieren zu viel da hinein, sagte John Daniel, ein Forscher am Earth System Research Lab der NOAA.

„Wir machen einen Fehler, jedes Mal, wenn die Temperatur steigt, implizieren wir, dass es an der globalen Erwärmung liegt”, sagte er. „Wenn man jedes Mal dabei eine große Sache daraus macht, sollte man auch jedes Mal eine große Sache daraus machen, wenn die Temperatur zurück geht.“

Von Ben Santer

Seit einer Dekade ist es genau das, was passiert. Skeptiker machen übertriebene Behauptungen über die „globale Abkühlung“ und meinen seit 1998. (Als ein repräsentatives Beispiel, vor zwei Jahren nannte der Kolumnist George Will 1998 den „Gipfel“ der Erwärmung). Wissenschaftler mussten die Verteidiger spielen, sagte Ben Santer, ein Klimamodellierer am Lawrence Livermore National Laboratory.

"Diese Diskussion über die Nicht-Erwärmung seit 1998 hat die Leute denken lassen, über das warum nachzudenken und das warum zu verstehen“, sagte Santer. „Aber es brachte die Leute auch dazu, diese falschen Behauptungen zu korrigieren“.

Susans Zeug ist besonders wichtig”, sagte Santer. „selbst wenn man das hypothetisch perfekte Modell hat, wenn man die falschen Antriebe eingibt, wird man eine falsche Antwort bekommen!“

Von Judith Lean

Die Antwort auf die Lücke liegt Judith Lean zufolge komplett in den Sternen. Oder besser, in einem Stern.

Erst vor Kurzem haben sich Klimamodellierer gefragt, wie die 0,1 Prozent das Weltklima über Dekaden lange Zeiträume beeinflussen kann. (Den besten Schätzungen zufolge führt das zu Temperaturänderungen von 0,1°C). Davor, um den Komiker Rodney Dangerfield zu zitieren, hat Lean zufolge die Sonne keinerlei Aufmerksamkeit erfahren. …

Klimamodelle haben bei der Abbildung des zyklischen Einflusses der Sonne auf das Klima versagt, und das „hat zu dem Gefühl geführt, dass die Sonne außen vor ist“, sagte Lean. „Und sie müssen absolut beweisen, dass sie außen vor ist“.

Lean zufolge ist die Kombination von vielen La Niñas und dem solaren Minimum, das ausgehend von einem Maximum 2001 im Jahre 2008 ungewöhnlich lange dauerte, alles, was gebraucht wird, um die zunehmende Erwärmung durch steigende Treibhausgaskonzentrationen zu kompensieren. Da die Sonne inzwischen aber wieder aktiver geworden ist, nimmt Lean an, dass die Temperaturen parallel zur Sonnenaktivität steigen mit einem Maximum 2014.

Dieser konsistente Trend hat Lean veranlasst, einen für einen Klimawissenschaftler seltenen Schritt zu tun: Sie machte eine Kurzfristvorhersage. Bis 2014 nimmt sie einen Anstieg der globalen Temperatur um 0,14°C an, getrieben durch den menschlichen Einfluss und die Sonne.

Von Graeme Stephens

Während der vergangenen Dekade hatten Wissenschaftler zum ersten Mal Zugang zu verlässlichen Messungen der ozeanischen Tiefenwärme, bis hinab zu 5000 Fuß [ca. 1500 m] unter dem Meeresspiegel, und zwar durch das ARGO-Beobachtungsnetz, einer Sammlung tausender automatischer Bojen, die alle paar Tage in der Wassersäule auf und ab schwimmen. Dies brachte Hansen zu der Schlussfolgerung, dass die Energiebilanz, um kurz technisch zu werden, 0,6 Watt pro Quadratmeter betragen würde und nicht 1 Watt pro Quadratmeter, wie einige angeführt haben.

(Vor kurzem hat die Satellitengruppe, die die Energiebilanz misst, das Bild revidiert zu jetzt 0,6 Watt, was Graeme zufolge mit Hansens Schätzung übereinstimmt.) Graeme ist Leiter der Cloudsat-Mission bei der NASA. Es legt nahe, dass es keine fehlende Energie gibt. Trenberth widerspricht dieser Analyse, und es ist wahrscheinlich eine Frage der im Gange befindlichen Debatte).

Von Robert Kaufmann

Im vergangenen Sommer hat Robert Kaufmann, ein BU-Geograph, Wellen geschlagen, als er eine Modellstudie veröffentlicht hat, in der es hieß, dass die fehlende Erwärmung vollständig auf El Niño und den zunehmenden Ausstoß von Sulfaten durch Kohleverbrennung in China zurückgeführt werden kann. Während die von Kaufmann benutzten Graphiken auf der Kohleverbrennung des Landes basieren und nicht auf aktuellen Emissionen – ein großer Punkt der Ungewissheit – erkannten viele Wissenschaftler einen gewissen Wahrheitsgehalt in seinen Hypothesen.

Von Martin Wild

Während der achtziger und neunziger Jahre dominierte die rasche Abnahme der Luftverschmutzung in den USA und Europa die Trends der weltweiten Aerosole. Während diese Emissionen im Westen weiter abnehmen, hat die Kohleverbrennung in Asien stark zugenommen. Die Welt wird dadurch nicht dunkler, sondern es ist so, dass sie nicht noch heller wird.

„Es ist kein allgemeiner Trend mehr”, sagt Martin Wild, ein leitender Autor der nächsten UN-Beschreibung des Klimazustands am Swiss Federal Institute of Technology, Zürich. Aber, fügt er hinzu, „es passt sehr gut zu der Energieerzeugung mit Kohle. Für mich ist es ziemlich erhellend, dass es so gut passt. Aber es kann immer noch Zufall sein“.

Von Daniel Jacobs

Die Ergebnisse von Kaufmann könnten nicht mehr lange relevant sein. Seit 2006 hat China begonnen, Filter in seine Kohlekraftwerke einzubauen, obwohl es jedoch unsicher ist, wie oft diese Filter funktionieren, selbst nachdem sie installiert worden sind. Aber die Veränderung kommt, sagte Daniel Wild, ein Atmosphärenchemiker an der Harvard University.

„Die Sulfatquellen haben sich eingependelt, weil sie begonnen haben, ernstzunehmende Emissionskontrollen in ihren Kraftwerken einzuführen“, sagte Jacob. „Das ist interessant! Schaut man auf künftige Emissionsszenarien des (nächsten UN-Klimaberichtes), sieht man die So2-Emissionen fallen wie ein Stein, selbst in den kommenden Jahrzehnten. Hauptsächlich deshalb, weil China etwas gegen das Problem der beeinträchtigten öffentlichen Gesundheit unternehmen muss“.

Am Ende des Artikels wird die sich entwickelnde Debatte selbst unter diesen Wissenschaftlern beleuchtet.

…Viele der Wissenschaftler, die sich mit der Erwärmungslücke befassen, haben gegensätzliche Ansichten – und tauschen sie in einer kameradschaftlichen und gelehrten Art und Weise aus. Judith Lean, die Solarwissenschaftlerin, findet Kaufmanns Arbeit nicht überzeugend und missbilligt die unnötige Kritik an China. Kaufmann moniert in Solomons Studien zur Stratosphäre fehlende Beweise. Hansen und Trenberth können sich nicht über einen Haushalt einigen.

Es erscheint atemberaubend, dass in einigen Jahren ein neuer Konsens für den nächsten UN-Bericht zur Klimaänderung zustande kommt. Aber er wird zustande kommen, und unter der Oberfläche werden wie immer die aufwühlenden Theorien und Rivalitäten lauern, die Fragen, das Wasser auf die Mühlen des wissenschaftlichen Lebens.

Kann also am Ende irgendjemand explizit benennen, was zu der Erwärmungspause geführt hat?

„Alle diese Dinge tragen zu der relativ gedämpften Erwärmung bei“, sagt Santer in Livermore. „Die Schwierigkeit besteht darin, den Anteil der verschiedenen Beiträge herauszufinden. Das kann man nicht ohne systematisches Modellieren und Experimentieren tun. Ich hoffe, dass jemand das macht“.

Barnes für seinen Teil würde es gefallen herauszufinden, ob einige der Aerosole, die er in der Stratosphäre gefunden hatte, tatsächlich von der chinesischen Kohleverbrennung stammen. Es ist schwierig, das herauszufinden, aber er hofft, dass es geschehen könnte.

“Vielleicht, können wir es herausfinden, wenn sich die Kohleverbrennung verdreifacht”.

Autor Paul Voosen:

Link zum ausführlichen Artikel: http://www.eenews.net/public/Greenwire/2011/10/25/1

Link zu diesem Artikel im Original: http://www.klimaskeptiker.info/index.php?seite=einzelmeldung.php?nachrichtid=1987

Übersetzt von Chris Frey für EIKE