Sehen wir uns ein paar Aspekte näher an und beginnen mit einfachen Beispielen:

- * Astronomie ist Wissenschaft – Astrologie ist eine Pseudowissenschaft

- * Evolution ist Wissenschaft – Kreationismus ist eine Pseudowissenschaft

- * Molekularbiologie ist Wissenschaft – Homöopathie ist eine Pseudowissenschaft

- * Impfungen sind Wissenschaft – die Angst vor MMR-Impfungen ist Pseudowissenschaft

- * Sauerstoff ist Wissenschaft – Phlogiston war Pseudowissenschaft

- * Chemie ist Wissenschaft – Alchemie war Pseudowissenschaft

Können Sie mir so weit folgen? Noch ein paar Beispiele. Dass der Earl of Oxford Shakespeare geschrieben haben soll ist Pseudowissenschaft. Genauso der Glaube daran, dass Elvis noch immer lebt, Diana durch den MI5 umgebracht, JFK vom CIA getötet wurde und die Anschläge vom 9.11. von Insidern verübt worden sind. Gleiches gilt für Geister, UFOs, Telepathie, das Umgeheuer von Loch Ness und so ziemlich jedes paranormale Phänomen. Entschuldigen Sie dass ich das gerade an Halloween sage, aber so ist nun einmal meine Meinung.

Drei mehr kontroverse Beispiele. Aus meiner Sicht war das meiste was Freud gesagt hat Pseudowissenschaft. Das gilt auch für die meisten, wenn auch nicht alle, Aspekte des Biolandbaus. Und nach bestimmten Definitionen gilt das auch für religiösen Glauben. Und zwar für die ausdrückliche Forderung es gäbe Wahrheiten, die durch etwas anderes als Untersuchungen und Experimente gefunden werden könnten.

Jetzt kommt ein Punkt, der mir eine Offenbarung beschert hat: Kornkreise.

Es war für mich völlig offensichtlich als ich dieses Phänomen zuerst untersuchte, dass die wahrscheinlichste Erklärung für Kornkreise ist dass diese von Menschen gemacht sind. Ich habe einige selbst angefertigt um zu beweisen wie einfach das geht.

Das war lange bevor Doug Bower und Dave Chorley eingestanden hatten dass sie die ganze Sache nach einem Abend in der Kneipe ins Rollen gebracht haben. Jede andere Erklärung – Kraftfelder, außerirdische Raumschiffe, Plasmawirbel oder Kugelblitze – war Mumpitz. Das Gesamte Feld der Cereologie ["Wissenschaft" von den Konrkreisen"] war Pseudowissenschaft, wie man beim Kontakt mit den bizarren Gestalten welche sie praktizieren leicht feststellen konnte.

Stellen Sie sich einmal meine Überraschung vor als ich heraus fand, dass ich ein Ketzer war, und dass ernsthafte Journalisten, die nicht für Boulevardzeitungen, sondern für das Science magazine und für Channel 4 Dokumentationen arbeiteten, das Argument der Cereologen schluckten, es wäre äußerst unplausibel, dass alle Kornkreise durch Menschen gemacht wären.

Dabei lernte ich Lektion Nummer 1: Die umwerfende Leichgläubigkeit der Medien.

Man muss nur ein ‘ologie’ an seine Pseudowissenschaft anhängen und sofort bringt man Journalisten dazu, als Propagandisten für einen aufzutreten.

Ein Team von Channel 4 tat etwas nahe liegendes. Sie ließen einige Kornkreise von Studenten anfertigen und fragten dann einen Cereologen ob diese ‘authentisch’ wären oder ob es sich um ‘Schabernack’ handelte, das heißt von Menschen gemacht. Er versicherte ihnen sie könnten nicht von Menschen gemacht worden sein. Als sie ihm erzählten, dass sie die Kreise selbst in der Nacht zuvor angefertigt hatten war er völlig vor den Kopf gestoßen. Es war großes Fernsehen. Und trotzdem übernahm der Produzent, er wurde später Minister unter Tony Blair, gegen Ende der Sendung den Standpunkt der der Cereologen: “Selbstverständlich sind nicht sämtliche Kornkreise Schabernack”. – Wie bitte? Gleiches passierte nachdem Doug und Dave zugaben, dass sie die Urheber waren. Die Leute glaubten einfach weiter. Sie tun es noch heute.

Lektion Nummer 2: Entlarvung perlt von der Pseudowissenschaft ab wie Wasser vom Gefieder einer Ente

In der Medizin habe ich gelernt, dass die Unterscheidung zwischen Wissenschaft und Pseudowissenschaft nicht immer einfach ist. Das wird auf wunderbare Weise in einem ganz außergewöhnlichen Roman Touching Distance von Rebecca Abrahams illustriert, der auf einer realen Geschichte eines Medizin-Häretikers aus dem 18. Jahrhundert basiert, Alec Gordon aus Aberdeen.

Gordon war ein echter Pionier der Idee, dass Kindbett-Fieber durch die Mediziner selbst übertragen wurde und dass Hygiene die Lösung darstellte. Er machte diese Entdeckung lange vor Semmelweiss und Lister. Aber er wurde ignoriert. Er wird in Abrahams’ Roman nicht als der reine rationale Held dargestellt, sonder als ein mit Mängeln behafteter Mensch, ein nachlässiger Ehemann und ein Sonderling mit seltsamen Ideen, wie der gefährliche Besessenheit seine Patienten zur Ader zu lassen. Er war in einem Moment ein Pseudowissenschaftler, und ein Wissenschaftler im Nächsten.

Lektion Nummer 3. Wir alle können beides sein. Newton war ein Alchemist.

Wie die Antiseptik begannen viele wissenschaftliche Wahrheiten als Ketzerei und mussten harte Kämpfe zur Akzeptanz gegen fest verwurzeltes etabliertes Wissen durchfechten, welches uns heute als irrational erscheint. Die Kontinentaldrift ist so ein Beispiel. Barry Marshall wurde nicht nur ignoriert, sondern verunglimpft als er anfangs behauptete, dass Magengeschwüre durch ein bestimmtes Bakterium verursacht werden. Säurehemmende Medikamente waren für die Pharmaindustrie sehr profitabel. Letztendlich bekam er den Nobelpreis.

Erst kürzlich erhielt Daniel Shechtman den Nobelpreis für die Entdeckung der Quasi-Kristalle. Er hat die meiste Zeit seiner Karriere damit verbracht als Sonderling geschmäht zu werden. “Man warf mich aus meiner Forschergruppe. Man sagte mir, ich würde sie mit dem was ich äußerte blamieren.”

Das ist Lektion Nummer 4: Ketzer haben manchmal auch recht.

Was Pseudowissenschaften aufrecht erhält ist die Bestätigung ihrer Befangenheit [confirmation bias]. Wir suchen nach Beweisen und begrüßen solche, die unsere Theorie bestätigen. Wir ignorieren solche Beweise oder stellen diese in Frage, die unserer Theorie widersprechen. Uns allen passiert das ständig. Es ist nicht so, wie wir oft annehmen, dass dies nur unseren Gegnern widerfahren würde. Es passiert mir und es passiert Ihnen. Es würde übermenschliche Anstrengungen erfordern, damit es einem nicht passiert. Es ist jene Kraft welche Mythen am Leben erhält, Verschwörungstheorien bestehen lässt und ganze Bevölkerungsgruppen seltsamen Aberglauben anhängen lässt. Bertrand Russel brachte es vor vielen Jahren auf den Punkt:

“Wenn ein Mensch mit Fakten konfrontiert wird, welche seinen Instinkten widersprechen, wird er diese eingehen prüfen, und falls die Beweislage nicht überwältigend ist, wird er sich weigern daran zu glauben. Sollte er anders herum etwas erfahren, was ihm einen Grund liefert seinen Instinkten zu glauben, wird er dies beim geringsten Hinweis akzeptieren.”

Lektion Nummer 5: Achten Sie bei sich und bei anderen genau darauf, ob eine Sache vielleicht doch nur Ihre vorgefertigte Meinung bestärkt.

Zu diesem Thema gab es in jüngster Zeit einige gute Bücher. Michael Shermers The Believing Brain, Dan Gardners Future Babble und Tim Harfords Adapt sind Erkundungen über die Kraft der vorgefertigten Meinung. Was mir dabei am meisten Unbehagen bereitet ist Gardners Fazit dass Wissen einen davor nicht schützt. Tatsächlich ist es so, dass man, je mehr man über eine Sache weiß, umso befangener an diese herangeht. Das Expertentum selbst gibt einem erst die Werkzeuge an die Hand, die Bestätigung für das zu suchen woran man ohnehin glaubt.

Experten sind schlechter darin, die Zukunft vorherzusehen als Nicht-Experten. Philip Tetlock machte dazu ein aufschlussreiches Experiment. Er erfasste die Meinungen von 284 Experten – Politikern, Wissenschaftlern, Ökonomen und Journalisten – und erhielt so 27.450 unterschiedliche spezifische Beurteilungen über die Zukunft, und er wartete ab, ob diese sich bewahrheiten würden. Die Ergebnisse waren ernüchternd. Die Experten waren nicht besser als ‘Schimpansen die Pfeile warfen’.

Der Club of Rome machte auf dem Buchrücken seines Mega-Bestsellers Die Grenzen des Wachstums im Jahr 1972 folgende Vorhersage:

Wird dies die Welt sein, für die Ihre Enkel Ihnen danken werden? Eine Welt, in der die Industrieproduktion auf Null zurückgegangen ist. Wo die Bevölkerung einen katastrophalen Rückgang erlebt hat. Wo die Luft, das Meer und das Land bis zur Auslöschung verseucht sind. Wo die Zivilisation eine ferne Erinnerung ist. Dies ist die Welt, welche die Computer vorhersagen.

“Wissenschaft ist der Glaube an die Ignoranz der Experten” sagte Richard Feynman.

Lektion Nummer 6: Verlasse Dich nie auf den Konsens der Experten über die Zukunft. Zukunftsforschung ist Pseudowissenschaft.

Mit Hilfe dieser sechs Lektionen werde ich jetzt in ein Thema eintauchen, bei welchem beinahe alle Experten nicht nur überzeugt sind die Zukunft vorhersagen zu können, sondern auch absolut sicher sind ihre Gegner wären Pseudo-Wissenschaftler. Es handelt sich um ein Thema, bei dem ich jetzt ein Häretiker bin. Ich glaube hierbei ist die etablierte Sicht überwuchert von der Pseudowissenschaft. Das Thema ist der Klimawandel.

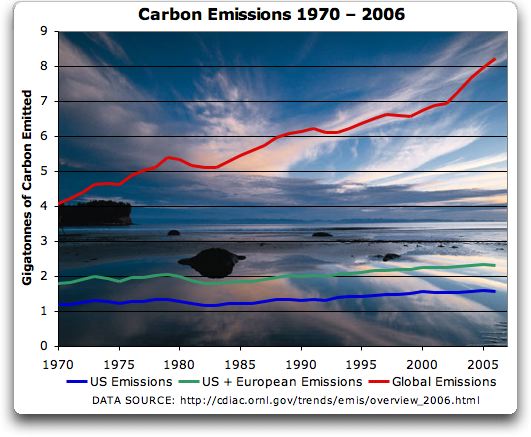

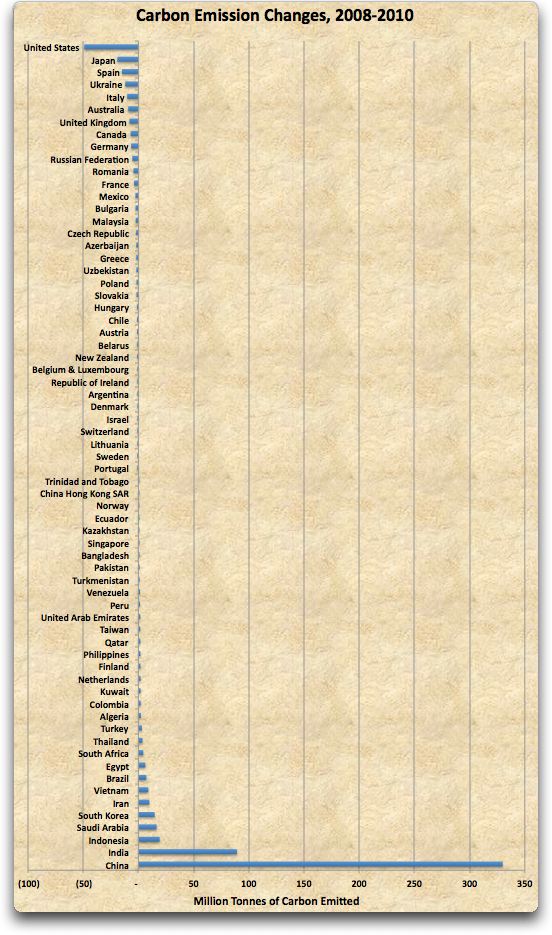

Bevor Sie jetzt alle zu den Ausgängen strömen, und ich weiß dass dies die übliche Reaktion auf Vorträge hier an der RSA [Royal Society of the Arts] ist, welche nicht der üblichen Sicht auf den Klimawandel folgen – ich sah, was bei Björn Lomborg im letzten Jahr beim Prince Philip Vortrag passierte – lassen Sie mich etwas klarstellen. Ich bin kein ‘Leugner’. Ich akzeptiere voll und ganz, dass CO2 ein Klimagas ist. Das Klima ist wärmer geworden und der Mensch ist sehr wahrscheinlich zumindest zum Teil dafür verantwortlich. Als vor kurzem eine Studie veröffentlicht wurde die aussagte, dass 98% der Wissenschaftler an die globale Erwärmung glaubten, sah ich mir die gestellten Fragen an und stellte fest, dass ich nach dieser Definition zu den 98% gehöre, obwohl ich selbst niemals das Wort glauben benutze. Genauso hat eine aktuelle Studie aus Berkeley, welche schloss, dass die Oberfläche der Kontinente sich in etwa so stark erwärmt hat, wie man es bislang angenommen hat, für mich nichts verändert.

Was ist also das Problem?

Das Problem ist, dass man all die Grundannahmen der Physik der Treibhausgase akzeptieren, und trotzdem folgern kann, dass die Bedrohung durch eine gefährlich großen Erwärmung so unwahrscheinlich ist dass man sie vernachlässigen kann. Wohingegen die Gefahr einer realen Bedrohung durch die Politik der Vermeidung eines Klimawandels bereits so beängstigend groß ist, dass die vorgeschlagene Lösung des Problems sich als weit schlimmer erweist, als die eigentliche Bedrohung jemals sein kann. Oder, wie ich es einmal ausgedrückt hab: “Wir ziehen uns eine Schlinge um den Hals, um ein Nasenbluten zu stoppen.”

Ich denke auch, dass die Klimadebatte eine massive Ablenkung von weit mehr drängenden Umweltproblemen darstellt, wie etwa invasive Arten oder der Überfischung der Meere.

Ich war nicht immer ein ‘Verharmloser’ [lukewarmer].

Zur Mitte der 2000er Jahre führte eine Darstellung im besonderen dazu, dass ich meine Zweifel über den gefährlichen durch Menschen gemachten Klimawandel über Bord warf: Der Hockeyschläger. Dieser zeigte klar und deutlich, dass etwas noch nie dagewesenes passierte. Ich kann mich genau erinnern wie ich das Bild zuerst auf einer Konferenz sah und dachte: “Aha, jetzt haben wir endlich eine wirklich klare Datenlage die zeigt, dass die heutigen Temperaturen sowohl in der Höhe, als auch in der Rate des Anstiegs, beispiellos sind.” Und es war im Nature Magazine veröffentlicht.

Nur, ist diese Darstellung heute durch die Arbeit von Steve McIntire und Ross McKitrick vollständig als Fälschung entlarvt worden. Ich empfehle Ihnen sehr Andrew Monfords sorgfältiges und absolut lesenswertes Buch The Hockey Stick Illusion zur Lektüre.

Dies ist nicht der Ort, um ins Detail zu gehen, aber kurz gesagt ist das Problem beides, ein mathematisches und ein empirisches. Dar Graph stützt sich außerordentlich auf fehlerhafte Daten – speziell ausgewählte Baumringe von Borstenkiefern [bristlecone pines] – und auf spezielle Methoden der Hauptkomponenten-Analyse, die jegliche Art von Daten sehr stark in eine Hockeyschläger-Form zu bringen tendiert. Und wenn ich sage ‘sehr stark’ dann meine ich um den Faktor 390.

Dies hatte einen großen Einfluss auf mich. Dies war der Moment als jemand mir sagte, sie haben den Kornkreis in der Nacht zuvor erschaffen. Schließlich gab es, abgesehen vom Hockeyschläger, keinen Beweis, dass das Klima sich auf irgend eine Art gefährlich schneller verändert, als in der Vergangenheit, als es sich auf natürliche Art verändert hat.

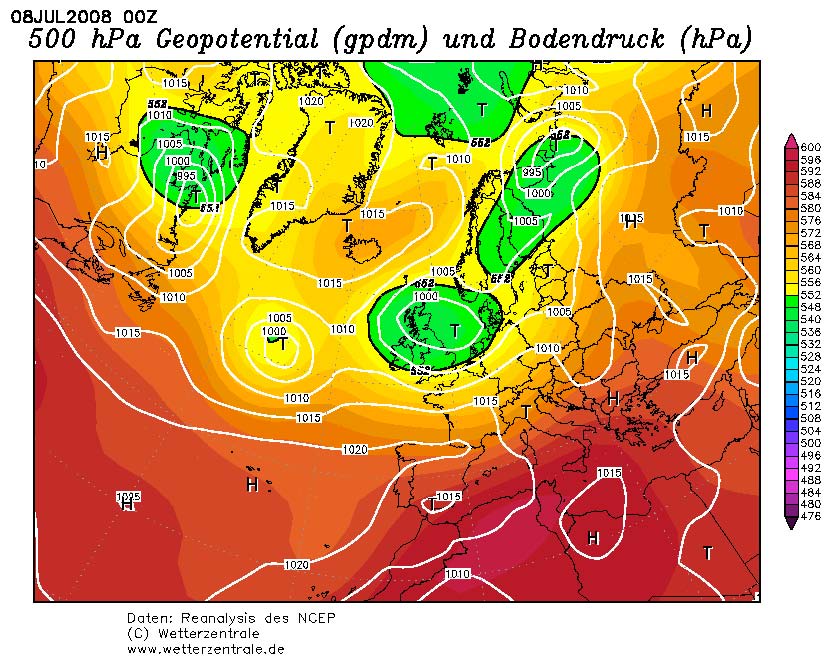

- * Es war im Mittelalter wärmer als heute und der Klimawandel in Grönland verlief damals um einiges schneller.

- * Stalagmiten, Baumgrenzen und Eisbohrkerne bestätigen alle, dass es vor 7.000 deutlich wärmer war als heute. Belege aus Grönland legen nahe, dass das Meer in der Arktis zumindest teilweise im Sommer zu der Zeit eisfrei war.

- * Der Meeresspiegel steigt heute mit einer ungefährlichen Rate von etwa 30 cm in 100 Jahren und die Geschwindigkeit nimmt ab.

- * Grönland verliert sein Eis mit einer Geschwindigkeit von von etwa 150 Gigatonnen pro Jahr, was 0,6% pro Jahrhundert entspricht.

- * Es gab keine nennenswerte Erwärmung der Antarktis, mit Ausnahme der antarktischen Halbinsel.

- * Die Methan-Konzentration in der Atmosphäre nimmt kaum zu.

- * Die Intensität und Frequenz tropischer Stürmen haben in den letzten 20 Jahren abgenommen, nicht zugenommen.

- * Die Wahrscheinlichkeit an einer Trockenheit, einer Überflutung oder an einem Sturm zu sterben ist global gesehen heute 98% niedriger als noch in den 1920ern.

- * Malaria hat nicht zu- sondern abgenommen, während die Welt sich erwärmt hat.

Und so weiter. Ich habe es über und über geprüft, aber ich finde keine Daten – im Gegensatz zu den Modellen – welche zeigen dass Veränderungen noch nie dagewesen wären, oder dass diese auch nur annähernd ein echte Bedrohung darstellen würden

Zweifellos gibt es eine Reihe von Menschen die denken “Wie sieht es mit jenem Faktor aus”. Nun, sollten sie eben jenen Faktor aufzeigen können der zeigt, dass Sie einen gefährlichen Anstieg von irgend etwas gefunden haben, dann erzählen Sie mir davon. Als ich diese Frage einem gestandenen Regierungswissenschaftler stellte, antwortete er mit dem Paläozen-Eozän-Temperatur-Maximum. Dabei handelt es sich, einfach ausgedrückt, um eine wenig verstandene warme Episode vor etwa 55 Milllionen Jahren von unklarer Länge, einem unklaren Ausmaß und aus unklaren Gründen.

In der Zwischenzeit sehe ich überall vorgefertigte Meinungen an jeder Stelle der Klimadebatte. Hurrikan Kathrina, den Kilimandscharo, das Aussterben der Goldkröte – alles herangezogen als Beweise für den Klimawandel. Ein schneereicher Dezember und der BBC erklärt uns, das wäre nur Wetter; eine Flut in Pakistan oder eine Trockenheit in Texas hingegen ist die Art Wetter wovon wir in Zukunft mehr erwarten können. Eine Theorie die so flexibel ist, dass sie jedes Ereignis erklären kann, ist in der Tat eine pseudowissenschaftliche Theorie.

Um die Auswirkungen von vorgefertigter Beurteilung in Aktion erleben zu können muss man nur die Climategate E-Mails lesen. Diese Dokumente haben meinen Glauben an die wissenschaftlichen Institutionen untergraben. Es ist schon schlimm genug, dass die E-Mails unzweifelhaft Wissenschaftler dabei gezeigt haben, wie sie sich bei der selektiven Datenauswahl [cherry-picking] abgesprochen, das System der Begutachtung [peer-review] untergraben, Herausgeber von Zeitschriften eingeschüchtert haben und Anfragen aus dem Weg gegangen sind, die nach dem Gesetz hätten beantwortet werden müssen [freedom of information requests]. Was noch schlimmer für einen Wissenschafts-Groupie wie mich ist, ist die Tatsache dass so ziemlich der ganze Rest der Wissenschaftsgemeinschaft dieses Handeln in Ordnung fand. Sei haben im Wesentlichen mit den Schultern gezuckt und gesagt: “Ja, schlimme Sache, aber so sind Jungs nun mal…”

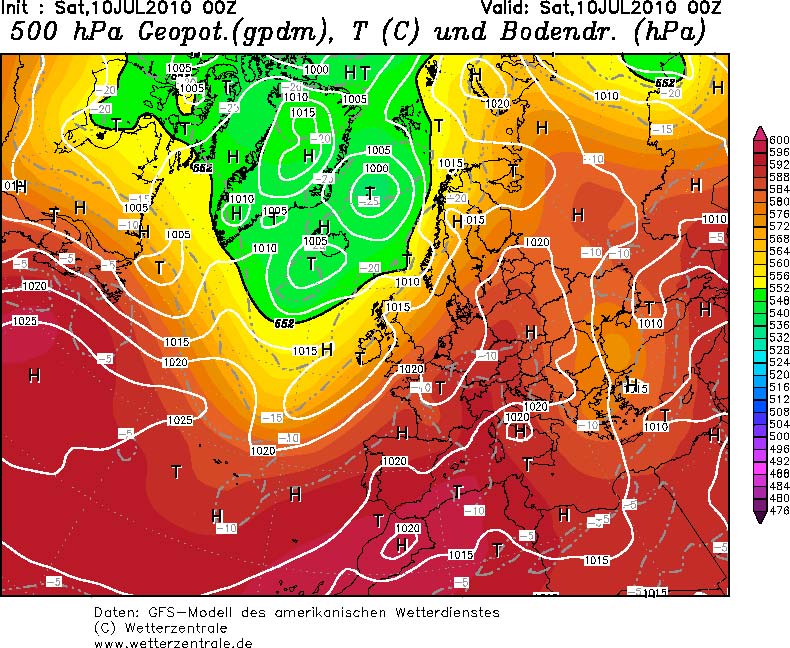

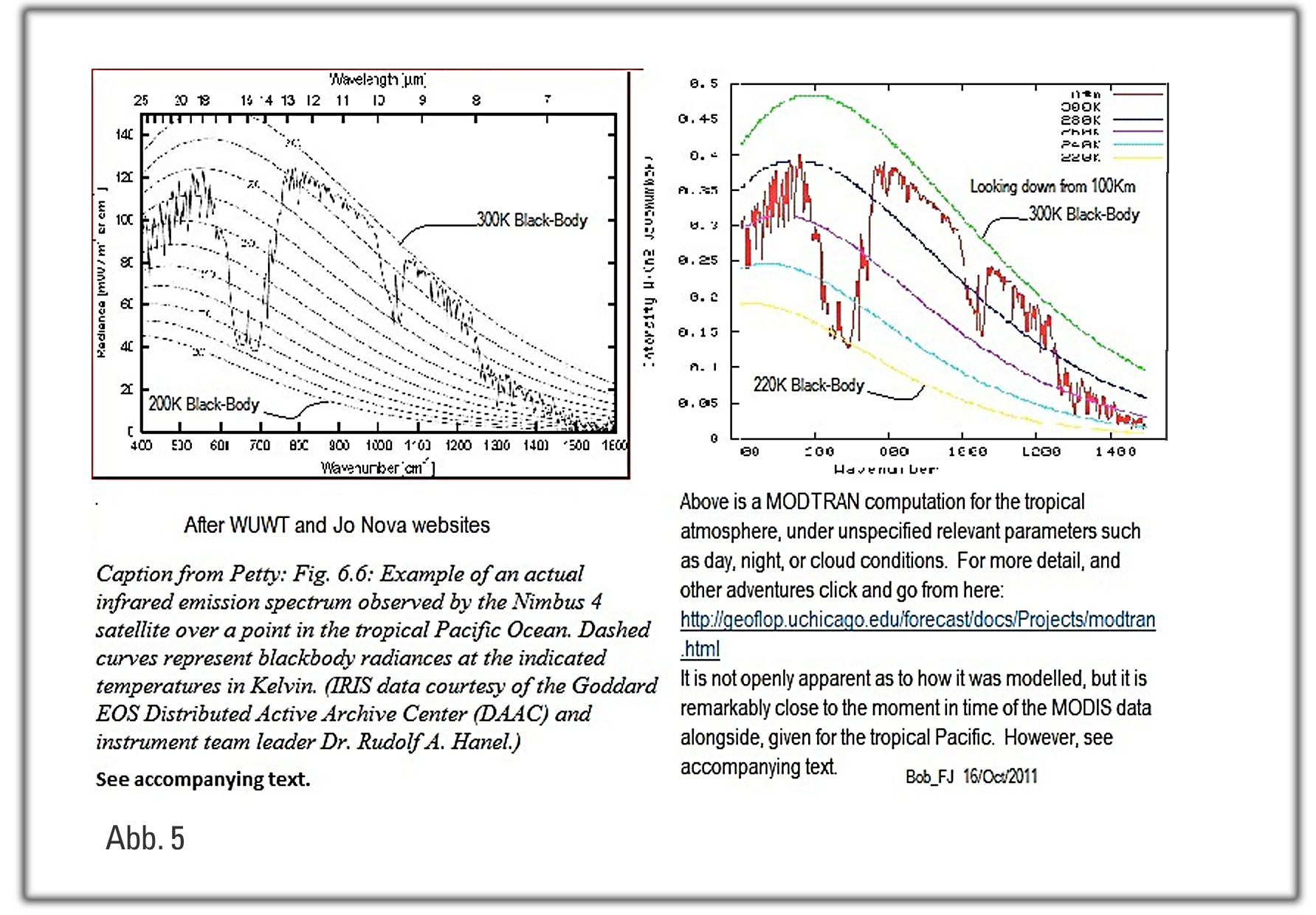

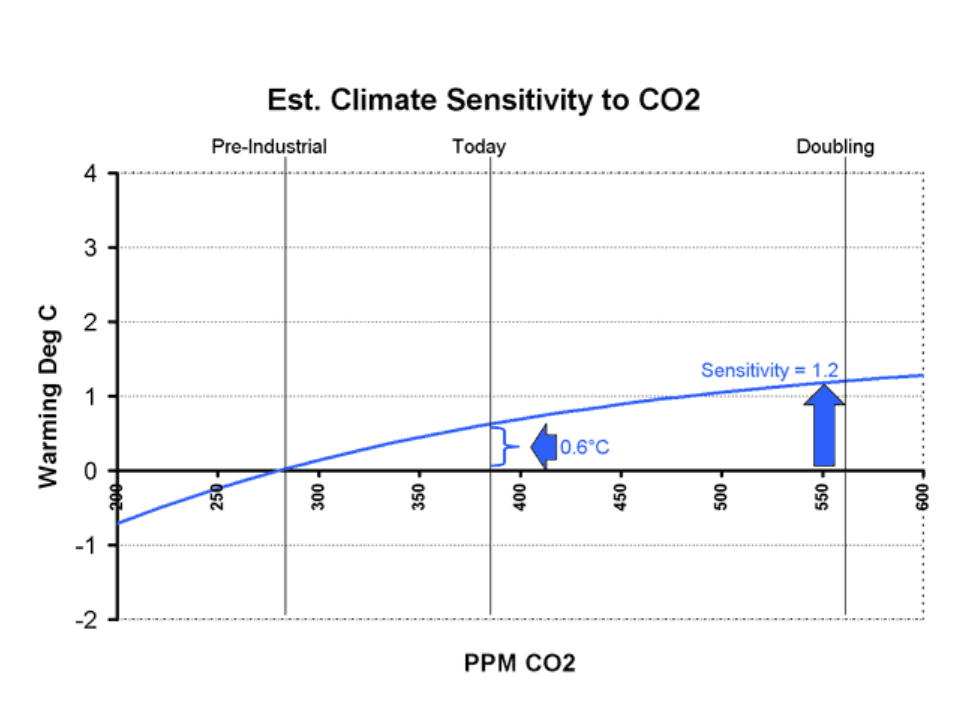

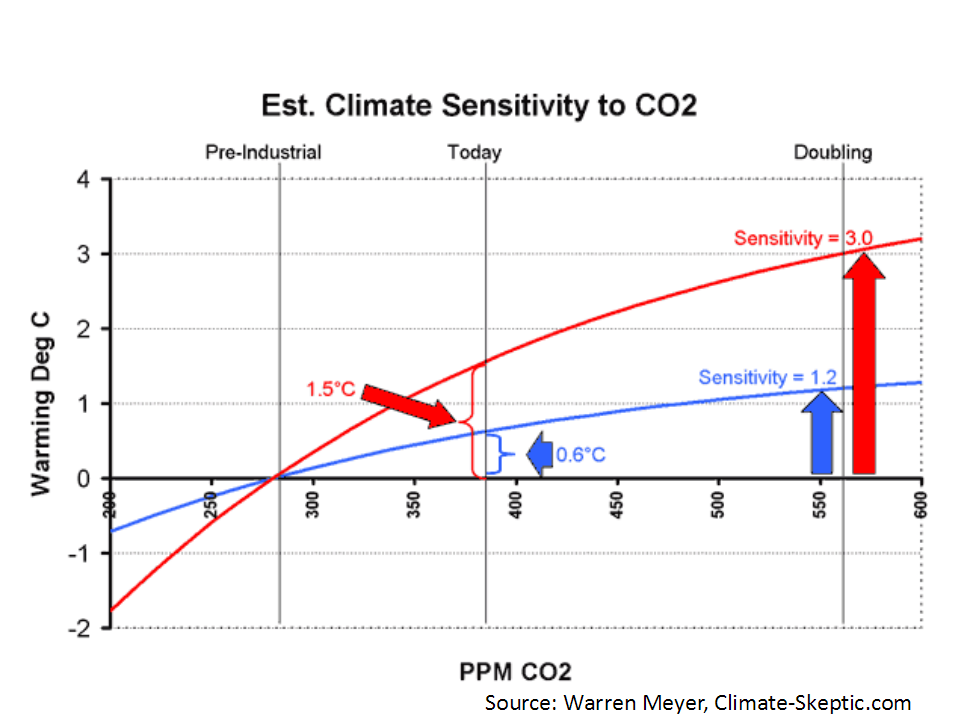

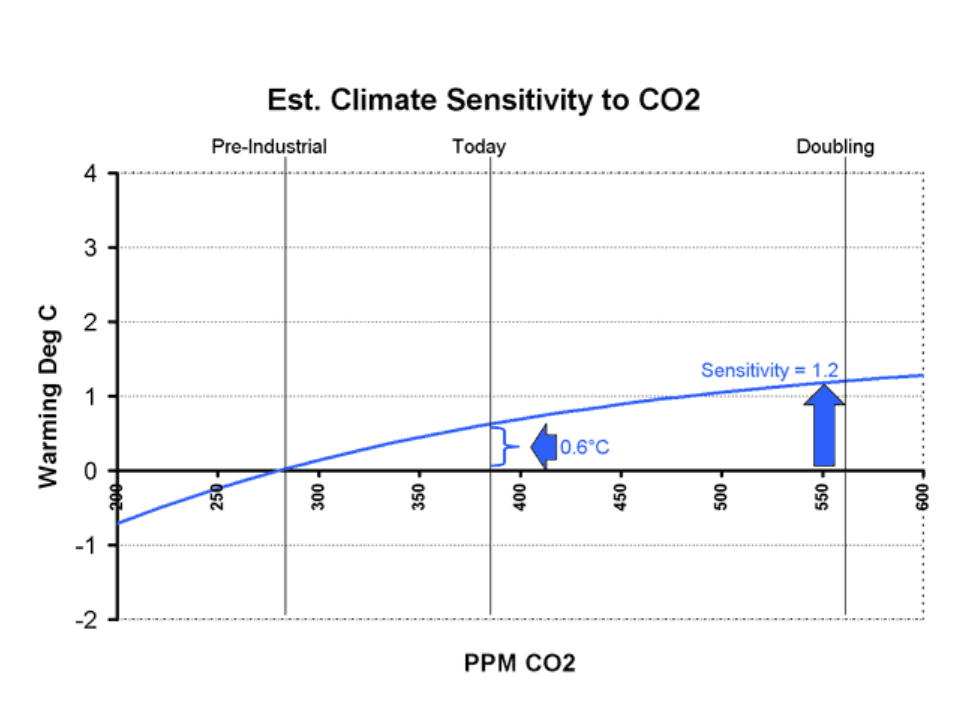

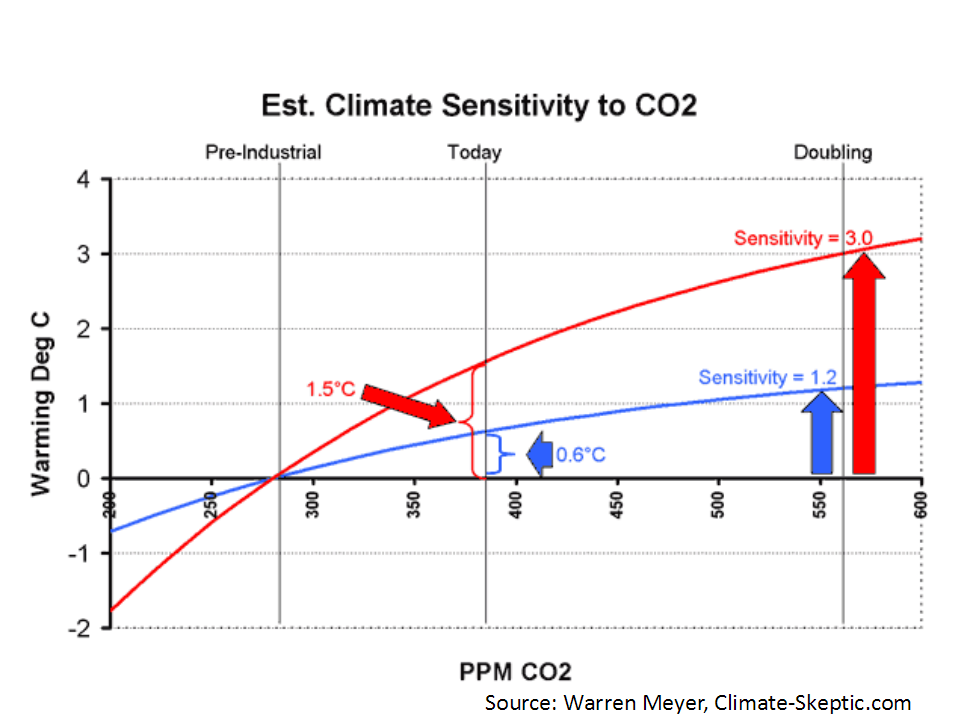

Und es gibt auch überhaupt keinen theoretischen Unterbau dafür, dass wir eine gefährliche Zukunft erwarten müssen. Der ganz zentrale Aspekt dabei ist die Klimasensitivität: Um wie viel kann man erwarten dass es wärmer wird, wenn man den CO2-Gehalt verdoppelt. Hierüber gibt es zumindest so etwas wie einen Konsens. Er lautet: 1,2 Grad Celsius. Das IPCC hat es in seinem letzten Bericht folgendermaßen ausgedrückt:

“In der idealisierten Situation dass die Klima-Reaktion auf eine Verdopplung des Atmosphärischen CO2 nur aus einer gleichmäßigen Temperaturzunahme besteht, ohne Rückkopplungen (…) würde die globale Erwärmung nach den Modellen [GCMs] etwa 1,2 °C betragen”

“In the idealised situation that the climate response to a doubling of atmospheric CO2 consisted of a uniform temperature change only, with no feedbacks operating…the global warming from GCMs would be around 1.2°C.”

Paragraph 8.6.2.3

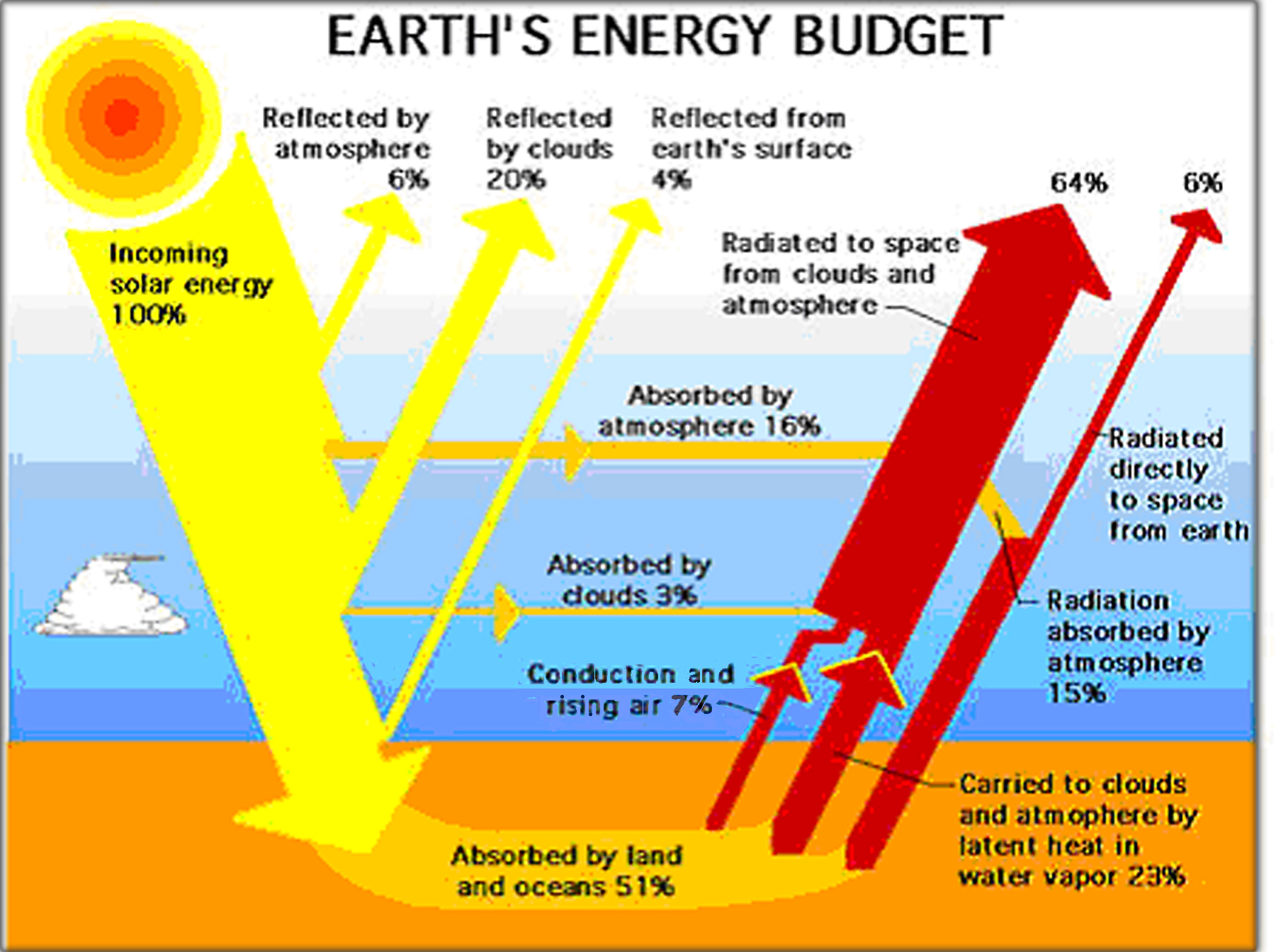

In diesem Kapitel wird weiter argumentiert, dass große positive Rückkopplungen, hauptsächlich durch Wasserdampf, diesen Effekt wahrscheinlich verstärken. Aber während es einen guten Konsens über die 1,2 °C gibt, existiert überhaupt kein Konsens über den Nettoeffekt der positiven Rückkopplungen, wie das IPCC auch offen zugibt.

Wasserdampf kann auch zu Wolken werden, und ob Wolken in der Praxis den Treibhauseffekt verstärken oder abdämpfen bleibt zweifelhaft.

Man kann also sagen es gibt einen Konsens über ein wenig globale Erwärmung, aber es wäre falsch zu sagen, es gäbe einen Konsens über eine gefährliche globale Erwärmung.

Die Klimasensitivität könnte harmlose 1,2 °C betragen, wovon wir die Hälfte bereits erreicht haben, oder es könnte weniger sein, wenn die Rückkopplungen negativ sind, oder es könnte mehr sein, wenn die Rückkopplung positiv sind.

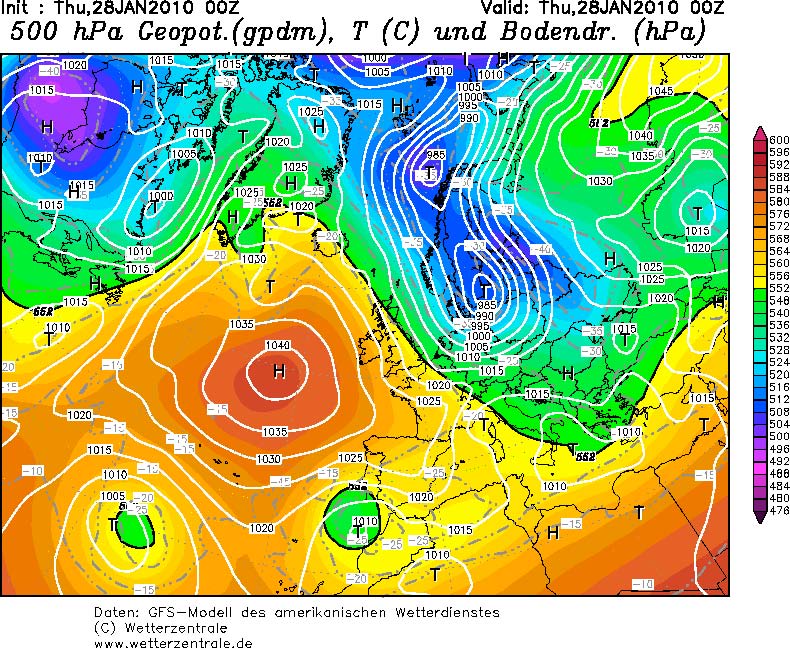

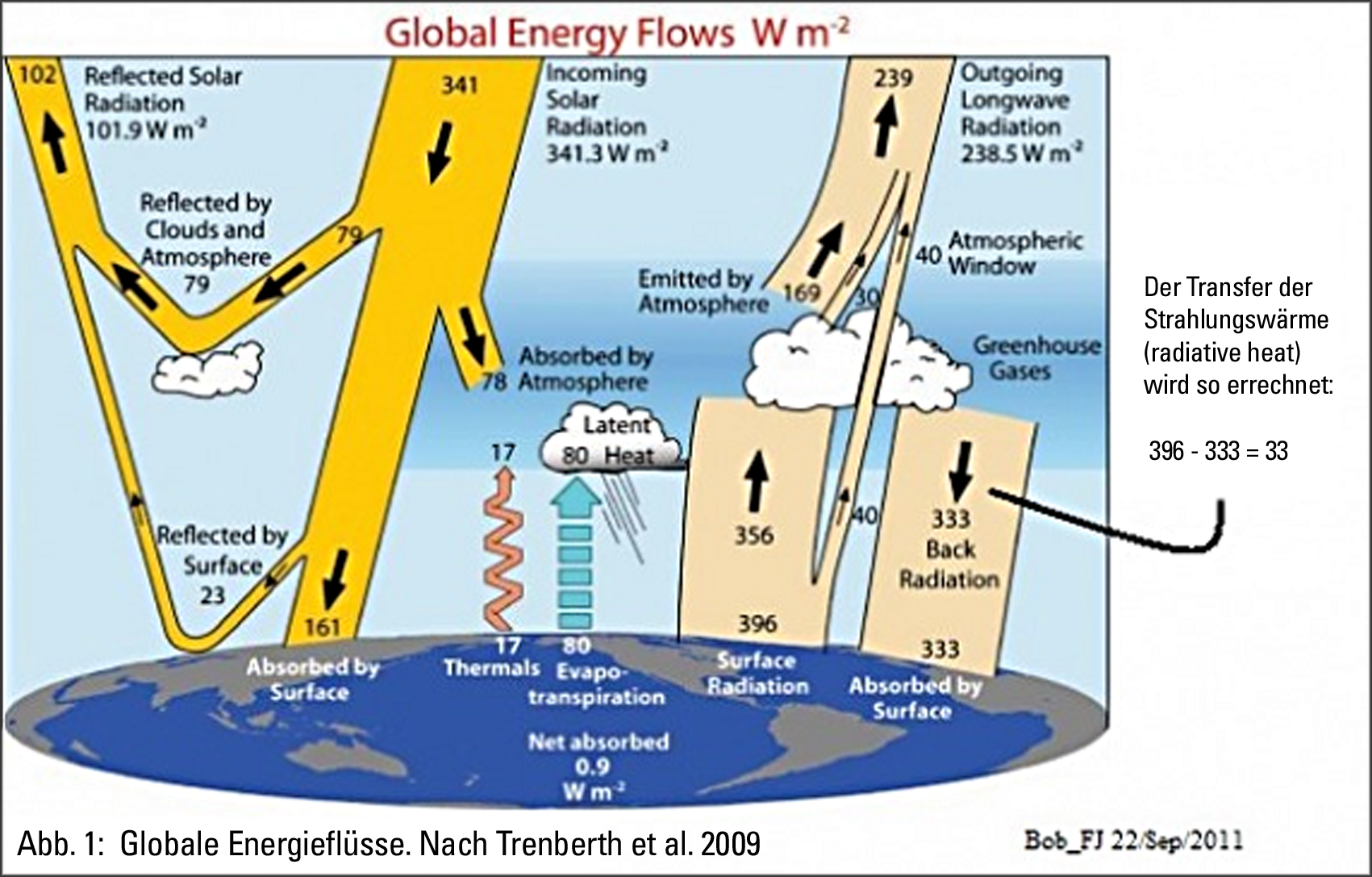

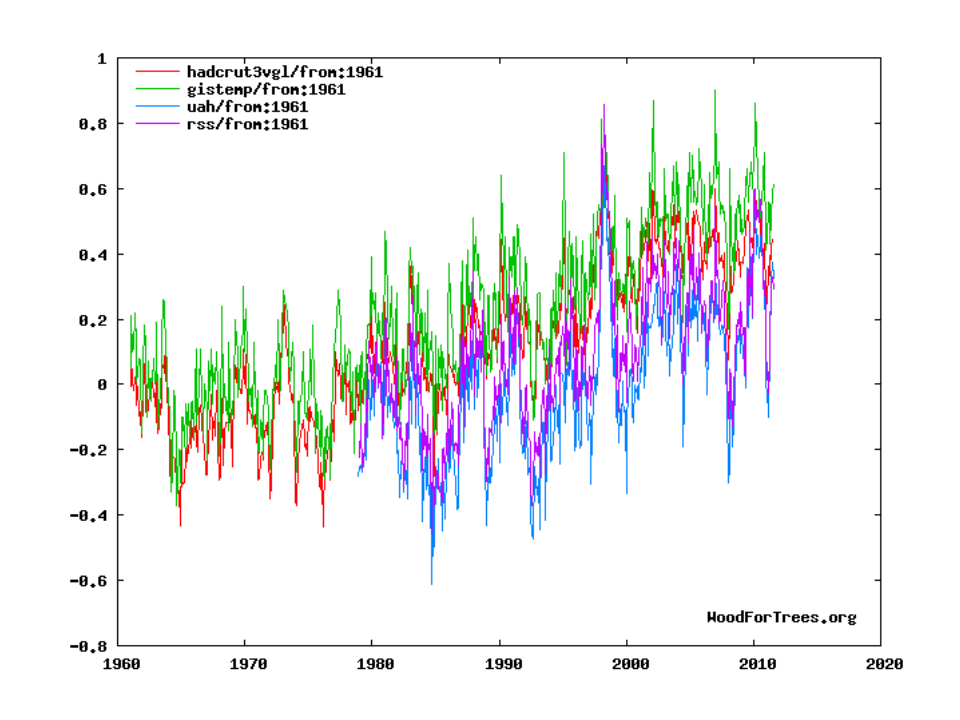

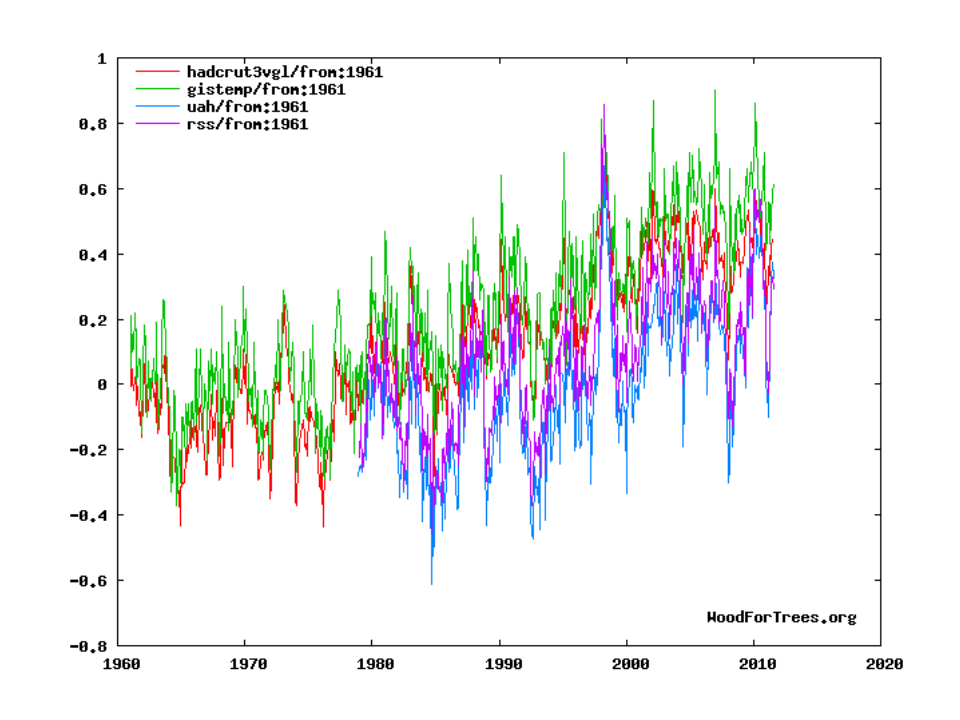

Was sagen uns die empirischen Belege? Seit 1960 hatten wir im Groben ein Drittel der Verdopplung von CO2 erfahren, also müssten wir bereits etwa die Hälfte der Treibhaus-Erwärmung erleben, die wir von einer Verdopplung zu erwarten hätten. Das ist elementare Arhitmetik bei der Annahme, dass die Kurve einen logarithmischen Verlauf hat.

Wenn man jetzt den Messungen der Globaltemperatur durch Thermometern glaubt (die rote und die grüne Linie), hatten wir in diesem Zeitraum etwa 0.6 °C Erwärmung, mit einer Steigerungsrate von weniger als 0,13 °C pro Jahrzehnt; und etwas weniger wenn man den Satellitenmessungen glauben schenkt (die blaue und die violette Linie).

Wir sind also auf der Spur für 1,2 °C. Wir befinden uns demnach auf der blauen, nicht auf der roten Linie.

Erinnern wir uns, dass Jim Hansen von der NASA uns 1988 erzählt hat, dass wir 2-4 °C Erwärmung in 25 Jahren zu erwarten hätten. Wir haben etwa ein Zehntel davon gesehen. Wir befinden uns sogar unterhalb des Wertes den das IPCC 1990 für Null weitere Emissionen angenommen hat.

Aber, sagt uns der Konsens, Schwefelemissionen haben die Erwärmung reduziert und so die Auswirkungen verzögert. Oder die Ozeane haben die überschüssige Wärme aufgenommen. Keine dieser nachträglich getroffenen Erklärungen passt zu den Daten: die südliche Hemisphäre hat sich in den letzten 30 Jahren nur halb so stark erwärmt wie die nördliche Hemisphäre.

Und die Zunahme des Wärmegehalts der Ozeanen hat sich verlangsamt, wenn nicht sogar im letzten Jahrzehnt ganz aufgehört. Im Gegensatz dazu erscheinen mir manche Argumente der Ketzer als ein Ausbund an Wissenschaft wie sie sein sollte: transparent, hinterfragend und nachprüfbar.

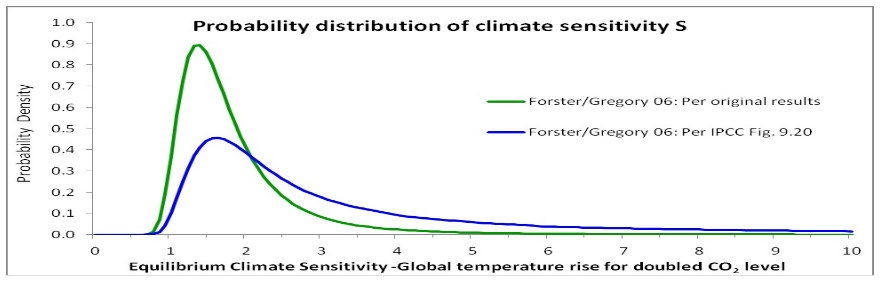

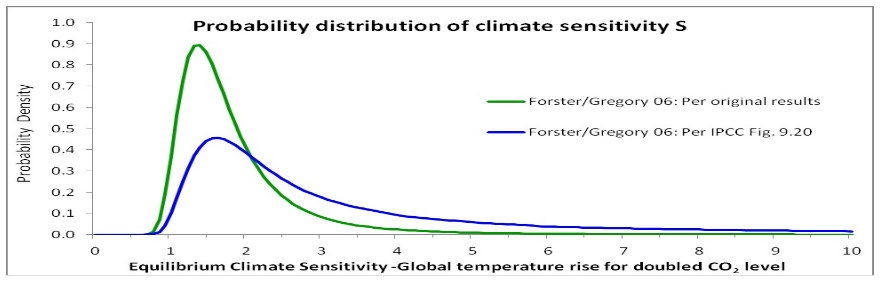

Zum Beispiel hat sich in diesem Jahr ein hartnäckiger Britischer Mathematiker namens Nic Lewis mit der Frage der Klimasensitivität beschäftigt und dabei herausgefunden, dass die einzige rein empirische Abschätzung der Sensitivität welche vom IPCC zitiert wird, mit Hilfe einer unzulässigen mathematischen Operation verändert wurde, wodurch die Kurve am Ende zur höheren Temperatur hin dicker gemacht wurde.

Dadurch wurde rechnerisch die Wahrscheinlichkeit höherer Temperaturen auf Kosten von niedrigeren Werten erhöht. Wenn man dies korrigiert ist die theoretische Wahrscheinlichkeit einer Erwärmung um mehr als 2,3 °C in der Tat sehr klein.

Wie sämtliche anderen Fehler im IPCC Bericht, einschließlich der berüchtigten Annahme dass alle Gletscher im Himalaya im Jahr 2035 anstatt im Jahr 2350 verschwunden wären, überhöht auch dieser Fehler die Folgen einer potenziellen Erwärmung. Es kann kein Zufall sein dass all diese Fehler nur in eine Richtung zeigen sollen.

Die Quelle für den Fehler bei den Himalya Gletschern war ein nicht begutachteter WWF-Bericht. Und dieser erschien in einem Kapitel bei dem zwei koordinierend leitende Autoren und ein Gutachter als wissenschaftliche Berater des WWF-Klimazeugen-Panel fungierten. Man sollte sich ebenfalls ins Gedächtnis rufen, dass der Fehler mit den Gletschern durch Gutachter angemahnt wurde, welche man jedoch ignorierte. Und dass Rajendra Pachauri, der Chef des IPCC, die Kritiker als Betreiber von Voodoo Wissenschaft abgetan hat.

Journalisten sagen gern, dass der IPCC Bericht ausschließlich auf begutachteter [peer-reviewed] Literatur beruhen würde. Rajendra Pachauri selbst hat 2008 noch diese Behauptung aufgestellt:

“…wir führen eine Begutachtung über den Klimawandel durch die auf begutachteter Literatur beruht, daher muss alles was wir uns ansehen und in unserer Begutachtung berücksichtigendie Glaubwürdigkeit von begutachterten Publikationen tragen, wir gebe3n uns nicht mit weniger zufrieden.”

“…we carry out an assessment of climate change based on peer-reviewed literature, so everything that we look at and take into account in our assessments has to carry [the] credibility of peer-reviewed publications, we don’t settle for anything less than that.”

Das ist eine ‘Voodoo-Behauptung’. Die Gletscher-Behauptung war nicht begutachtet, genauso wenig waren es die Abänderungen in der Funktion zur Klimasensitivität, welche Lewis entdeckt hat. Die Journalistin Donna Laframboise fand in der ganzen Welt Freiwillige die ihr halfen zu ermitteln, wie oft das IPCC nicht-begutachtete Literatur genutzt hatte. Ihr Ergebnis war: “Von den 18.531 Quellen in der Klimabibel von 2007 fanden wir 5.587 – satte 30% – die nicht-begutachtet waren.”

Und trotzdem ist selbst das Aussprechen von Dingen wie diesen heute gleichzusetzen mit Ketzerei. Aufzustehen und etwa innerhalb einer Universität oder innerhalb des BBC zu sagen, man würde nicht glauben die globale Erwärmung wäre gefährlich, erzeugt eine Art Reaktion, als stünde man im Vatikan und würde sagen man glaube nicht dass Gott gut ist. Glauben Sie mir, ich habe es ausprobiert.

Spielt das überhaupt eine Rolle?

Nehmen wir einmal an ich hätte Recht, und das Meiste was heutzutage in der Mainstream Klimawissenschaft durchgeht ist durchsetzt von Pseudowissenschaft, gestütz von vorgefertigten Meinungen, abhängig vom Wunschdenken, ausgestettet mit einen Freibrief durch eine voreingenommene Berichterstattung und auf dogmatische Weise intolerant anderen Auffassungen gegenüber. Macht das einen Unterschied? Schließlich gibt es doch Pseudowissenschaft und das Bestätigen vorgefertigter Meinungen genauso gut auch bei den Klima-Ketzern.

Ich sage Ihnen warum es eine Rolle spielt. Die Alarmisten haben die Macht über unser aller Leben übergeben bekommen, die Ketzer haben dies nicht. Bedenken Sie dass Großbritanniens einseitiger Climate Change Act nach offiziellen Angaben die gebeutelte britische Wirtschaft 18,3 Milliarden Pfund pro Jahr für die nächsten 39 Jahre kosten soll, und dass damit eine unmessbar kleine Veränderung beim CO2-Gehalt erreicht werden soll.

Wenigstens überziehen die Skeptiker nicht die Hügel in Schottland mit nutzlosen, teuren, lediglich manche Herzöge subventionierenden Windturbinen, dessen Herstellung die Umwelt in der inneren Mongolei verpestet und dessen Betrieb seltene Greifvögel wie etwa den Gänsegeier tötet .

Wenigstens können Kornkreis-Gläubige nicht unsere Stromrechnung beinahe verdoppeln und die Armut durch hohe Treibstoffpreise vergrößern während die Arbeitsplätze nach Asien verlegt werden, um ihrem Fetisch zu huldigen.

Wenigstens haben Kreationisten den BBC nicht überzeugt, dass eine ausgewogene Berichterstattung nicht mehr länger notwendig ist.

Wenigstens haben Homöopathen nicht teure Brennwertkessel hergestellt, welche bei kaltem Wetter nicht mehr funktionieren, wie es John Prescott im Jahr 2005 getan hat.

Wenigstens haben Astrologen nicht Millionen von Menschen in echten Hunger getrieben, wodurch im letzten Jahr nach einer konservativen Schätzung vermutlich 192.000 gestorben sind, indem sie 5% der Welt-Getreidernte in Treibstoffe umwandeln.

Deshalb spielt es eine Rolle. Uns wurden einige sehr schmerzhafte Therapien verordnet. Daher müssen wir sicher sein, dass der Patient wirklich einen Hirntumor hat, und nicht vielleicht nur Nasenbluten.

Das Zepter der Macht an die Pseudowissenschaft zu übergeben hat eine sehr unglückliche Geschichte.

Denken Sie etwa an die Eugenik. Um 1910 war sich eine gewaltige Mehrheit der Wissenschaftler und anderer Intelektueller darin einig, dass der Gedanke einer Kontrolle der Reproduktion, etwa damit arme, behinderte oder dumme Menschen davon abgehalten werden könnten Kinder zu haben, nicht nur praktikabel wäre, sondern eine Notwendigkeit von großer Dringlichkeit darstellt.

“Es gibt heute keine begründbare Entschuldigung den Fakten ins Gesicht zu sehen”, sagte George Bernhard Shaw, “dass nichts außer der Religion der Eugenik unsere Zivilisation vor dem Verhängnis retten kann, welches alle vorherigen Zivilisationen zerstört hat.” Um Haaresbreite, und hauptsächlich wegen des mutigen liberalen Parlaments-Abgeordneten Josiah Wedgewood, hat Großbritannien damals der Eugenik-Bewegung keine Macht gegeben in die Gesetzgebung einzugreifen. In Deutschland war das anders.

Oder denken Sie an Trofim Lysenko, einem pseudowissenschaftlichen Sonderling mit der seltsamen Idee dass Pflanzen dazu trainiert werden könnten zu tun, was man von ihnen möchte, und dass die Genetik nach Mendel Quatsch wäre. Seine Ideen wurden zur offiziellen wissenschaftlichen Religion der Sowjetunion und töteten Millionen. Seine Kritiker, wie der Genetiker Nikolai Vavilov, endeten tot im Gefängnis.

Gehe ich zu weit damit, dass ich solche Vergleiche anstelle? Ich glaube nicht. James Hansen von der NASA sagt, dass Verantwortliche in Ölgesellschaften wegen Verbrechen gegen die Menschheit angeklagt werden sollten. (Bedenken Sie dass dies der Mann ist, der für einen der angeblich unabhängigen Datensätze zur Globaltemperatur verantwortlich ist.) John Beddington, der höchste wissenschaftliche Berater in Großbritannien, sagte dieses Jahr das wir genau wie wir “deutlich intolerant gegen Rassismus” sind, genauso “deutlich intolerant gegenüber Pseudowissenschaft” sein sollten. Und damit meinte auch alle Formen von Klimawandel-Skeptizismus.

Die Ironie bei der Sache ist, dass ein Großteil der grünen Bewegung als ketzerische Dissidenten begonnen haben. Greenpeace hat sich entwickelt von einer Gruppe welche die orthodoxe Sicht auf genetisch veränderte Pflanzen in Frage stellte und glaubte dass man der Royal Society nicht trauen sollte, zu einer Institution die fordert dass ketzerische Gedanken bezüglich des Klimawandels heute ignoriert werden sollten, und dass die Royl Society auf keinen Fall falsch liegen kann.

Wo wir gerade bei Greenpeace sind

wussten Sie dass das gesamte Jahresbudget von Greenpeace, WWF und Friends of the Earth weltweit im letzten Jahr mehr als eine Milliarde Dollar betrug? Manchmal fragen mich die Leute, was der Anreiz für Wissenschaftler sein sollte, den Klimawandel übertrieben darzustellen. Aber sehen Sie nur die Unmengen an Geld welches jenen zur Verfügung steht, die das machen. Es kommt von Kampagnenorganisationen, von Regierungen und von großen Konzernen. Es war kein Skeptiker der den stellvertretenden Chefredakteur von News of the World nach der Climategate-Affäre als PR-Berater eingestellt hat, es war die University of East Anglia.

Im Kontrast dazu würden Wissenschaftler und die meisten Mainstream Journalisten ihre Karriere riskieren, würden sie einen skeptischen Standpunkt einnehmen. So dogmatisch ist der Konsens heute. Einzig in Internet Blogs wird heute die Flamme der Häresie noch am Leben erhalten und wird der investigative Journalismus betrieben, von dem die Medien vergessen haben wie er funktioniert.

In Amerika ist es Anthony Watts, der mit einer Graswurzel-Bewegung die Fehler in den Temperatur-Messstationen ausfindig gemacht hat und der wattsupwitthat.com betreibt. In Kanada betreibt der Mathematiker Steve McIntire, der Stück für Stück die erschreckende Geschichte des Hockeyschlägers ans Licht brachte, den Blog climateaudit.org. Hier in Großbritannien haben wir Andrew Monford, der akribisch den Schwindel hinter den Untersuchungen welche die Cliamtegate Affäre reinwaschen sollten, aufgedeckt hat, mit seinem Blog bishophill.net. In Australien wird der Blog joannenova.com von der ehemaligen Fernseh-Wissenschaftsjournalistin Joanne Nova betrieben, die in mühevoller Kleinarbeit die gewaltigen Geldbeträge zur Stützung des Alarmismus zurückverfolgt hat.

Das besondere an den Ketzern, die ich hier erwähnt habe ist, dass jeder einzelne von ihnen das in seiner Freizeit macht. Sie arbeiten für sich und erhalten höchstens Almosen für ihre Arbeit. Es gibt keinen riesigen Sumpf aus Geld von der Ölindustrie für Skeptiker.

Zusammenfassend möchte ich sagen,

dass ich eine Menge Zeit mit dem Thema Klima zugebracht habe. Ich hätte mich auch damit befassen können welche Fette gesund sind oder ob die Gene oder die Umwelt den Charakter eines Menschen prägen. Mein Hauptargument ist, dass ähnlich wie in der Religion, die institutionalisierte Wissenschaft heute und in allen Zeiten von der Verlockung heimgesucht wird, eine bereits vorgefasste Meinung zu bestätigen. Mit erschreckender Leichtigkeit verwandelt sie sich in Pseudowissenschaft, selbst dann – oder gerade wenn – sie sich in der Hand von einer Expertenelite befindet. Das passiert im speziellen bei Zukunftsvorhersagen und wenn ein Übermaß an Förderung vorhanden ist. Wissenschaft braucht Ketzer.

Ich danke Ihnen vielmals für Ihre Aufmerksamkeit.

Matt Ridley

Die Übersetzung besorgte Rudolf Kipp; zuerst erschienen bei Science Sceptical

Dr. Matt Ridleyist in britischer Zoologe und Autor populärwissenschaftlicher Bücher. Seine bekanntesten Werke sind The Rational Optimist, When Ideas have Sex (Deutsch: Wenn Ideen Sex haben: Wie Fortschritt entsteht und Wohlstand vermehrt wird), Genome: The Autobiography of a Species in 23 Chapters (Deutsch: Alphabet des Lebens. Die Geschichte des menschlichen Genoms) und The Origins of Virtue: Human Instincts and The Evolution of Cooperation (Deutsch: Die Biologie der Tugend. Warum es sich lohnt, gut zu sein).

The Rational Optimist – Homepage von Matt Ridley

When Ideas have Sex – Vortrag von Matt Ridley bei TED

Angus Millar Lecture 2011 – Scientific Heresy

Die Links im Text stammen nicht von Matt Ridley, sondern wurden von mir nachträglich hinzugefügt. Ich möchte damit denjenigen Lesern, die nicht so tief in der Klimadebatte stecken, die Möglichkeit geben in die angerissenen Themenkomplexe etwas tiefer einzusteigen. Natürlich spiegeln die von mir ausgewählten Verweise vorrangig meine Sicht der Dinge wider. Daher sollte sich jeder Leser ausdrücklich ermuntert fühlen, die unerschöpflichen Informationsquellen des Internets zu nutzten, um sich sein eigenes Bild zu machen.

ÄHNLICHE BEITRÄGE (AUTOMATISCH GENERIERT):

Über das Dahinschmelzen der Klimakampagne

Not Evil Just Wrong – Weltpremiere eines unbequemen Films

Gott Globus – Umweltschutz als neue Weltreligion