Untersuchung der Mechanismen zur Festsetzung der Kohlenstoffsteuer

Hier folgt ein Hinweis: Die Welt hat sich seit 1680 in einem Erwärmungstrend befunden, seit den Tiefen der Kleinen Eiszeit. Es hat sich seitdem stetig erwärmt, etwa ein halbes Grad pro Jahrhundert. Innerhalb dieses Trends gab es 25 bis 30 Jahre mit Erwärmung, denen 25 bis 30 Jahre einer moderaten Abkühlung folgten. Wir befinden uns gerade am Ende einer Erwärmungsperiode, die 1975 begonnen hatte, und so stehen die Chancen gut auf eine moderate Abkühlung für die kommenden paar Jahrzehnte. Aber es gab keine SUVs im Jahre 1680! Menschliche CO2-Emissionen waren vor 1850 winzig, fast alle erfolgten nach dem 2. Weltkrieg und ein Viertel seit 1998. Und doch war der Erwärmungstrend im 18. und 19. Jahrhundert genauso stark wie im 20. Jahrhundert.

Die Theorie einer anthropogenen globalen Erwärmung hält nicht einmal einer oberflächlichen Beweisaufnahme stand. Es bedarf Gläubiger, um die überwältigenden Beweise von deren Unhaltbarkeit zu ignorieren oder zu leugnen. Die Gläubigen müssen durch eine massive Propaganda dazu gebracht werden, gewisse Dinge nicht zu bemerken und jeden zu ignorieren und zu beschimpfen, der auf diese Dinge hinweist.

Tatsächlich gibt es bislang keinen einzigen Beweis, dass die globale Erwärmung hauptsächlich anthropogenen Ursprungs ist. Zig Milliarden Dollar wurden bereits ausgegeben, um danach zu suchen.

Klimawissenschaftler geben gerne zu, dass es keinen direkten Beweis dafür gibt, dass die Erwärmung durch unser Kohlendioxid verursacht wird. Statt dessen sagen sie, dass unser Wissen darüber, wie das Klima funktioniert, in ihren Klimamodellen steckt, und dass die Klimamodelle sagen, dass die Erwärmung anthropogen verursacht ist.

Modelle gleichen logischerweise jemandem, der Zahlen ausstanzt und Summen mit einem Taschenrechner bildet – Modelle sind Berechnungen, keine Beweise. Das Problem liegt darin, dass die Modelle viele Abschätzungen und Hypothesen darüber enthalten, wie die Dinge vor sich gehen, und einige davon sind falsch.

Hier kommen vier Beweisstücke, dass die Klimamodelle fundamental fehlerhaft sind

Erstens haben sie eine Reihe von Aufzeichnungen mit erheblich übertriebenen Temperaturanstiegen. Den Angstmythos vor der globalen Erwärmung hat James Hansen bei seiner Präsentation 1988 vor dem US-Kongress begonnen, und wenn man seine Vorhersagen mit den tatsächlich eingetretenen Werten verglich, zeigte sich, dass der aktuelle Temperaturanstieg nur etwa ein Drittel der Größenordnung seiner Vorhersage ausmachte. Man erinnere sich, es hieß, die „Wissenschaft ist eindeutig“ [science is settled] seit den frühen achtziger Jahren, und die heutigen Modelle sind im Wesentlichen auch heute das, was sie damals waren.

Weiterhin haben Hansens Modelle den Temperaturanstieg vorhergesagt, falls menschliche CO2-Emissionen nicht drastisch reduziert werden würden, beginnend 1988, so dass das atmosphärische CO2-Niveau im Jahre 2000 überhaupt nicht mehr steigen würde. Aber in Wirklichkeit ist die Temperatur gar nicht in dem Maße gestiegen. Dies beweist, dass die Modelle keine Ahnung von den Auswirkungen von Kohlendioxid auf die Temperatur der Welt haben.

Hansens Klimamodellvorhersagen von 1988

Zweitens sagen die Klimamodelle vorher, dass sich die Ozeane erwärmen. Saubere Messungen der Ozeantemperatur gibt es aber erst seit 2003 mit dem ARGO-System. In diesem System taucht eine Boje rasch bis 2000 m ab, um dann langsam wieder nach oben zu steigen. Während dieses Aufstiegs misst sie die Temperatur und übermittelt die Daten via Satellit an die Zentrale. Dreitausend ARGO-Bojen führen diese Messungen weltweit konstant durch. Sie sagen, dass sich die Temperatur der Ozeane seit 2003 praktisch nicht verändert hat. Und wieder sieht die Realität ganz anders aus, als die Klimamodelle vorgeben.

ARGO-Bojen messen den Wärmegehalt der oberen 700 m in den Ozeanen der Welt.

Drittens, die Klimamodelle prophezeien eine bestimmte Verteilung der atmosphärischen Erwärmung während Erwärmungsperioden. Im Besonderen ist die bekannteste Änderung, die sie vorhersagen, eine Erwärmung in einer Höhe von etwa 10 km über den Tropen, dem sog. „Hot Spot“. Aber seit den sechziger Jahren wurden die Temperaturen in der freien Atmosphäre mit Wetterballonen gemessen, und Millionen dieser Wetterballone sagen, dass es in der jüngsten Erwärmungsperiode von 1975 bis 2001 nicht einmal ansatzweise einen solchen Hot Spot gegeben hatte. Diese Hot Spots sind tragender Bestandteil ihrer Theorie, weil es ein Beweis für die zusätzliche Verdunstung und die Verdickung der Wasserdampfschicht wäre, die etwa zwei Drittel der Erwärmung in den Klimamodellen verursachen sollte – Das Kohlendioxid selbst trägt nur zu einem Drittel zur Erwärmung bei, wird aber in den Modellen durch den Wasserdampf modifiziert. Aber in Wirklichkeit gibt es keinen Hot Spot, daher keine Modifizierung, weshalb die Modelle die Temperaturzunahme so übertrieben haben.

Die Klimamodelle simulieren einen Hot Spot, der den Radiosondenaufstiegen zufolge vollständig fehlt.

Datenquelle: Das US Climate Change Science Program aus dem Jahr 2006, Teil E von Abbildung 5.7 auf Seite 116. Die Daten stammen von Millionen Radiosonden (Wetterballonen) seit den sechziger Jahren. Es gibt keine anderen Daten aus dieser Zeit, und wir können keine Daten zur atmosphärischen Erwärmung sammeln, solange die Erwärmung nicht wieder einsetzt. Das sind die einzigen Daten, die es gibt.

Quelle der Modellvorhersage: Jedes Klimamodell, beispielsweise aus dem 4. IPCC-Zustandsbericht, 2007, Kapitel 9, Seite 675.

Erklärung: Der Hot Spot in den Modellen entsteht durch eine Verdickung der Wasserdampfschicht während der globalen Erwärmung, wenn mehr Wasser verdunstet und warme, feuchte Luft die kalte trockene Luft in der Höhe verdrängt. Diese Verdickung sorgt für 2/3 der Erwärmung in den Modellen. Aber da es in Wirklichkeit keinen Hot Spot gibt, übertreiben die Modelle den Temperaturanstieg mindestens um den Faktor 3.

(Übrigens wurde dies schon Mitte der neunziger Jahre bekannt, so dass die Theorie der anthropogenen globalen Erwärmung schon damals hätte verworfen werden sollen. Aber es waren zu viel Geld, Bürokratie, Ideologie, Handelsprofite und Erneuerbare im Güterzug, um diesen zu stoppen.)

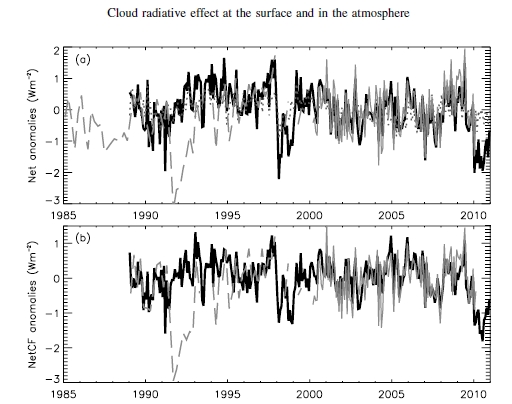

Viertens, Satelliten haben die Ausstrahlung der Erde gemessen und herausgefunden, dass die Erde mehr Wärme abstrahlt, wenn die Atmosphäre wärmer ist und weniger Wärme in den Monaten, in denen die Erde kühler ist. Wer hätte das gedacht? Aber die Klimamodelle sagen genau das Gegenteil, dass nämlich die Erde weniger Wärme abstrahlt, wenn die Atmosphäre wärmer ist, weil die Wärme zu stark zurückgehalten wird (positives Feedback). Und wieder stehen die Klimamodelle drastisch im Gegensatz zur Realität.

Ausstrahlung der Erde (vertikale Achse) im Verhältnis zur Wassertemperatur (horizontale Achse), wie sie vom ERBE-Satelliten (oben links) gemessen worden sind und wie sie von 11 Klimamodellen „vorhergesagt“ worden waren (alle anderen Graphen). Quelle: Lindzen and Choi 2009, Geophysical Research Letters Vol. 36.

Dies sind unabhängig voneinander vier Beweisstücke, dass die Klimamodelle fundamental fehlerhaft sind. Jedes einzelne von ihnen widerlegt per se die Theorie der anthropogenen globalen Erwärmung. Es gibt noch andere, komplexere Beweise. Man erinnere sich, es gibt hingegen bislang keinen einzigen Beweis, dass die Menschen die globale Erwärmung verursachen. Wenn also die Klimamodelle falsch sind, ist es die Theorie auch.

Lassen Sie mich jetzt erklären, wie verhindert wird, dass der Betrug ans Licht kommt

Der Trick besteht darin, dass sie niemals einen alarmistischen Klimawissenschaftler schicken, um einem sachkundigen Kritiker zu antworten.

Um ihre Theorie in der Öffentlichkeit zu verteidigen schicken die Alarmisten typischerweise Leute wie Tim Flannery oder Tony Jones, die fast nichts davon wissen, wie Klimamodelle funktionieren. Wenn sie dann mit Beweisen konfrontiert werden, sagen diese Gläubigen sofort „Aber die Klimawissenschaftler sagen…“. Sie argumentieren mit der Autorität. Das ist die gleiche Struktur, mit der der Streit zwischen Galileo und dem Papst zelebriert worden ist – Beweise auf der einen Seite und massive politische und religiöse Autorität auf der anderen Seite. Man beachte, der Papst hatte auch auf seiner Seite „Wissenschaftler“, tatsächlich sogar in überwältigender Mehrheit, und sie bildeten den „Konsens“. Es ist einfach, mit so viel Geld und Macht einen Konsens zu fabrizieren.

Alarmistische Wissenschaftler treten öffentlich auf, aber niemals in einer Situation, bei der sie mit bohrenden Fragen oder Kritik von irgendjemandem konfrontiert werden, der etwas von Modellrechnungen versteht. Sie haben seit Jahrzehnten jede wirkliche Diskussion in der Öffentlichkeit vermieden – diese Alarmisten wurden niemals zur Verantwortung gezogen, und sie mussten niemals Leuten antworten, die die Probleme um ihre Theorie kannten. Sie mussten sich auch niemals einer Anhörung stellen, einer Untersuchung, einer königlichen Kommission oder selbst einem kritischen Interview – und doch werden sie mit Megadollars bezahlt und beauftragt, dem Rest von uns zu erzählen, wie wir zu leben haben.

Die alarmistischen Klimawissenschaftler der Regierung sagen, dass sie lediglich das wiedergeben, was in den wissenschaftlich begutachteten Zeitschriften veröffentlicht worden ist. Aber diese Decke wurde lautstark im Klimagate-Skandal von 2009 zerblasen, wurde doch dabei mit ihren eigenen Worten enthüllt, dass sie die Journale unter Druck setzen, irgendwelche kritischen Artikel nicht zu bringen. Darum fahren sie immer weiter fort mit ihrem wissenschaftlich begutachtet – es ist ihr Mechanismus, Kritik außen vor zu lassen.

Die Klimawissenschaftler und ihre gläubigen Anhänger sind übrigens mehr als glücklich, wenn sie mit unwissenden Kritikern diskutieren dürfen – mit Kritikern, die wissen, dass irgendetwas nicht stimmt, aber nicht das Hintergrundwissen haben, um Modelle zu verstehen oder die Schwachpunkte der Alarmisten zu erkennen. Für die Klimawissenschaftler ist es eine reine Freude, wissender und viel „wissenschaftlicher“ gegenüber vereinter Kritik zu sein, weil ihnen das das Gefühl gibt, echte Wissenschaftler und keine Scharlatane zu sein, und weil es eine großartige PR für ihren Fall ist.

All das trägt sehr religiöse oder mittelalterliche Züge. Galileos Fall führte zur Aufklärung, bei der der Beweis über die politische Autorität triumphierte. In aufgeklärten Gesellschaften müssen die Leute nichts glauben, nur weil einige politische oder religiöse Autoritäten es sagen – der Beweis bestimmt, was wahr ist und was nicht.

Aber hinsichtlich des Klimas kehrt unsere Gesellschaft die Aufklärung um und gleitet zurück in das Mittelalter. Sicher haben wir Smart Phones, aber unsere Mittel, die Wahrheit zu bestimmen, fielen zurück auf politische Autoritäten und ihre willfährigen Wissenschaftler, die erklären, was wahr ist, Beweise leugnen und die Ungläubigen verunglimpfen.

Es wird schlimmer. Nicht nur, dass wir die Werte der Aufklärung umkehren, sondern auch, dass wir uns deindustrialisieren. Diese betrügerischen Künstler, geführt von diesen technologischen Blödmännern, den Grünen, wollen, dass wir unsere billigen und verlässlichen Energiequellen schließen und zu unzuverlässigen und schwankenden Windmühlen zurück gehen. Wie im Mittelalter wären wir von der Gnade des Windes abhängig und müssten Muskelkraft einsetzen, wo immer es möglich ist. Diese Leute bezeichnen sich selbst als „progressiv“, was eine total krankhafte Parodie der Wahrheit ist, wie alles andere zu diesem Thema auch.

Diese Korruption muss ein Ende haben! Wir haben wiederholt nach einer unabhängigen Kommission [a Royal Commission] in der Wissenschaft gerufen, bevor irgendwelche Aktivitäten gestartet worden sind, wurden aber natürlich ignoriert.

Also rufe ich jetzt nach einer Diskussion

Professor Andy Pitman ist der führende Klimawissenschaftler in Australien. Etwa 20 PhD-Studenten arbeiten für ihn; er verfügte über Millionen Dollar an Forschungsgeldern und hielt eine Menge prestigeträchtiger Positionen im Klima-Establishment. Er lehnte es vor kurzem ab, mit William Kininmonth zu diskutieren, und zwar auf die übliche Art und Weise „Ich diskutiere nicht mit Leuten, die nicht an die Gravitation glauben!“ Kininmonth war 12 Jahre lang Vorsitzender des National Climate Centre in Australien und arbeitete 38 Jahre lang im australischen Bureau of Meteorology.

Also, Andy, komm und debattiere mit uns! Ihre Seite sagt, dass die Beweise für die anthropogene globale Erwärmung überwältigend sind, also sollte es Ihnen ein Leichtes sein. Wo liegt das Problem? Der australische Steuerzahler [und natürlich auch die Steuerzahler hierzulande, A. d. Übers.] schauen sehr genau auf Sie, weshalb Sie sich ohne Weiteres ab und zu mal erklären sollten.

Die Regierung und die ALP [die australische Labour Partei] könnten solche Diskussionen sehr interessant finden. Wie ich in der Zeitschrift The Australian schon 2008 geschrieben hatte:

“Was wird im nächsten Jahrzehnt passieren, wenn die globalen Temperaturen nicht weiter steigen? Die Labor-Regierung ist drauf und dran, absichtlich unsere Wirtschaft zu ruinieren, um Kohlenstoffemissionen zu reduzieren. Wenn sich die Gründe später als Unsinn herausstellen sollten, werden die Wähler lange Zeit keine weitere Labor-Regierung wählen. Wenn ans Licht kommt, dass der Kohlenstoffbetrug schon 2008 bekannt war, wird die ALP als kriminell fahrlässig oder ideologisch dumm gehalten werden, weil sie keinen Durchblick gehabt hatte“.

Dr David Evans

Dr. David Evans wirkte vollzeitlich im Australian Greenhouse Office von 1999 bis 2005 und teilzeitlich im Department of Climate Change von 2008 bis 2010, wo er [die Wirkung des] australischen Kohlenstoffs auf Pflanzen, Trümmer, Mulch, Boden und Wälder sowie landwirtschaftliche Produkte modellierte. Evans ist Mathematiker und Ingenieur mit sechs Universitätsgraden einschließlich eines PhD der Stanford University.

Link zum Original: hier

Übersetzt von Chris Frey für EIKE