Teil 3: Dynamisches Sonnensystem – die tatsächlichen Hintergründe des Klimawandels

Teil 1 – Die Sonne bestimmt den Temperaturgang

Teil 2 – Die Sonne, der faszinierende Stern

Teil 3 – Sonnenflecken und ihre Ursachen

Teil 4 – Die Sonnenatmosphäre, Korona, Heliosphärische Stromschicht,

interplanetares Magnetfeld

Teil 5 – Die variable Sonne

Teil 6 – Der Einfluss der Sonne auf unser Wetter/Klima

Teil 7 – Der Einfluss der Sonne auf die Wolkenbedeckung über Svensmark hinaus

Teil 8 – Zukünftige Temperaturentwicklung und deren Schwankungen

Teil 3 – Sonnenflecken und ihre Ursachen

Der magnetische Zyklus wird Hale-Zyklus (der Astronom George Hale maß Anfang des 20. Jahrhunderts erstmals Magnetfelder in den Sonnenflecken) genannt und beträgt 22,1 Jahre. Dies ist der eigentliche Zyklus der Sonnenfleckenaktivität. Fleckengruppen setzen sich aus nordmagnetischen und südmagnetischen Flecken zusammen, die bipolar angeordnet sind (Abbildung 27).

Abbildung 27 zeigt, die bipolare Anordnung der Sonnenflecken.

Während eines 11-jährigen Zyklus (Schwabe-Zyklus: 8 – 15 Jahre) laufen bei der Rotation der Sonne entweder die Nordpole oder die Südpole ständig voraus. Das Hale Polaritätsgesetz besagt, dass Sonnenflecken in bipolaren Gruppen auftreten, in denen der führende Fleck die gleiche Polarität hat wie die Hemisphäre, in der er auf tritt. Nach 11 Jahren kehrt sich diese Polarität um. Es vergehen also zwei 11-jährige Zyklen, bis die gleiche Anordnung wieder erscheint. Wie aus Untersuchungen bekannt, zeichnet sich der Hale-Zyklus auf der Erde z.B. deutlich ab in der Lufttemperatur Mittelenglands und im Dürre-Index der U.S.A. ab (http://www.ldeo.columbia.edu/edu/dees/V1003/lectures/culture_climate/).

Der renommierte Astrophysiker H.W. Babcock (Gold Medal of the Royal Astronomical Society) hat 1961 die Dynamotheorie, zum Verständnis der Sonnenflecken und Magnetfelder erstellt.

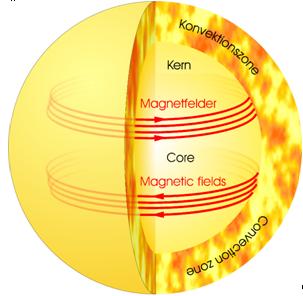

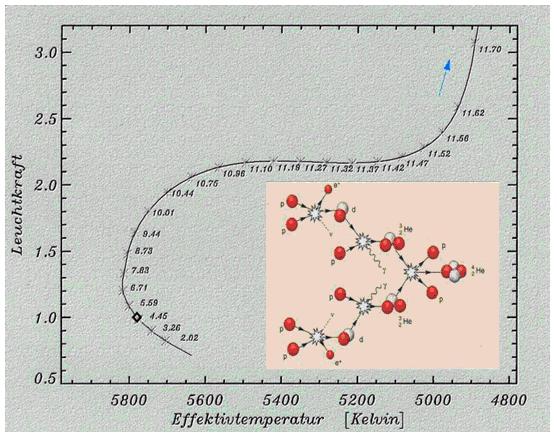

Abbildung 28: Zu Beginn des Zyklus (Sonnenminimum) bipolares Magnetfeld und vertikale Feldlinien in großer Tiefe. Die differentielle Rotation (Äquator: 25 Tage, Pol: 36 Tage, Konvektionszone: 27 Tage) „wickelt“ die Feldlinien um die Sonne. Die Feldstärke wird dadurch verstärkt. Starke Flussröhren steigen auf und bilden dadurch die Sonnenflecken. Dass zu Beginn globale poloidale Feld wird toroidal. Am Ende des Zyklus neutralisieren sich die am Äquator entgegen gesetzten Felder.

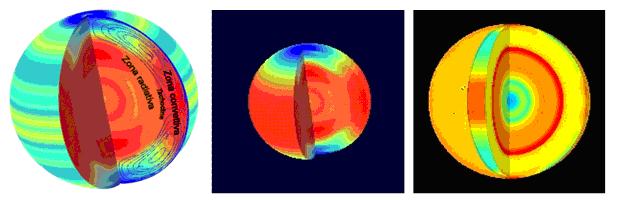

Wie beim Magnetfeld der Erde, muss neben der Eigenrotation eine elektrisch leitende Schicht vorhanden sein. Diese ist das Sonnenplasma, welches eine hohe Leitfähigkeit aufweist. Die Magnetfelder entstehen in der Konvektionszone, in der die Energie nicht durch Strahlung, sondern durch Konvektion (daher der Name) transportiert wird. Diese Materieströmungen wirken wie ein natürlicher Dynamo, in dem ein Teil der Strahlung in magnetische Energie gewandelt wird.

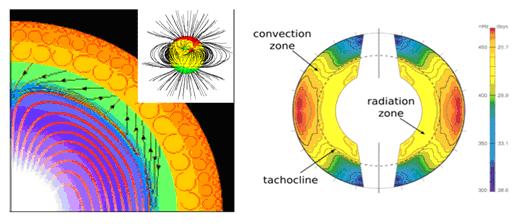

Abbildung 29: Das Magnetfeld wird vom Sonnen-Dynamo durch einen kreisförmigen elektrischen Fluss, tief im Innern der Sonne angetrieben. Das Innere der Sonne, welches nicht direkt beobachtbar ist, lässt sich durch die ständigen Sonnenbeben ermitteln. Dabei zeigte sich, dass deren Inneres, also die Strahlungszone (15,6 Mio.°C) fast wie ein starrer Körper rotiert. Sie deckt ca. 70% des Sonnendurchmessers ab und rotiert mit einer Umlaufzeit von knapp 27 Tagen. Die äußere, sog. Konvektionszone (2 Mio.°C) ist viel turbulenter und rotiert nicht nur unterschiedlich zur inneren Zone, sondern auch über die Breitengrade. Am Äquator beträgt die Umlaufzeit 25,4 Tage, während sie an den Polen mit 36 Tagen deutlich länger ist. Hierdurch kommt es zu komplexen magnetischen Wechselbeziehungen, wobei die Grenzschicht für die Magnetfelder der Sonne, eine entscheidende Rolle spielt.

Die Grenzschicht der starren Rotation (Kern) zur dynamischen Rotation (Konvektionszone) wird Tachocline genannt. Sie liegt ca. 200.000 km unter der Sonnenoberfläche, hat eine Dicke von ca. 30.000 km (Abbildung 30) und gilt als Ursprung des variablen Sonnendynamos. In ihr werden durch die Anwesenheit des inneren Magnetfeldes Ströme in den tieferen Schichten der Konvektionszone erzeugt, deren Schichten mit unterschiedlichen Geschwindigkeiten rotieren. Durch diese Interaktion kommt es nach den Gesetzen der Magnetohydrodynamik (beschreibt das Verhalten von elektrisch leitenden Fluiden, die von magnetischen und elektrischen Feldern durchdrungen werden) teils zu Abschwächungen des resultierenden Magnetfeldes und teils zu deutlichen Verstärkungen. Es entsteht dabei ein komplexes Muster von auf und abwärtsgerichteten Feldern, wobei die abwärtsgerichteten Felder durch das starke innere Feld geblockt werden.

Abbildung 30: Die starre Strahlungszone der Sonne erzeugt bei Rotation im Plasma ein stabiles, gleichförmiges Magnetfeld (rote Linien), welches sich einzig durch die Variationen in der Eigenrotation (betragen bis zu 5%) ändert. Darüber befindet sich die Tachocline (grün, überhöht dargestellt). An dieser Grenzschicht werden aus dem Plasma wieder vollständige Atome mit Kern und Elektronen. Sie zeigt eine deutliche Scherrotation. Die Magnetfelder werden hier, je nach Fließgeschwindigkeit und Stoffzusammensetzung unterschiedlich abgelenkt, wobei die abwärts gerichteten Felder durch das starke innere Magnetfeld geblockt und umgelenkt werden. Die aufwärtsgerichteten Felder gelangen in die turbulente Konvektionszone, erlangen dort Abschwächung oder Verstärkung (je nach Höhe und Richtung des Stromflusses) und gelangen zur Sonnenoberfläche. Die kleine Abbildung zeigt toroidales und poloidales Feld. Die rechte Abbildung zeigt die Lage der Tachocline und die unterschiedlichen Fließgeschwindigkeiten in der Konvektionszone vom Äquator bis zum Pol.

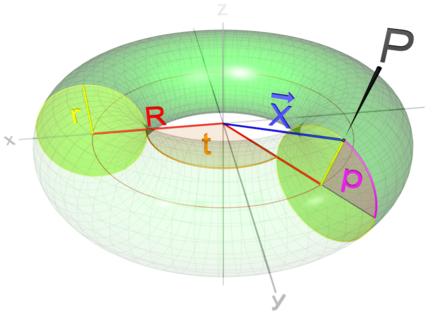

Abbildung 31: Durch die vorherig gezeigten differentiellen Fließrichtungen bilden sich die beiden Hauptkomponenten des Sonnenmagnetfeldes, die sog. toroidalen (in Richtung des Torus, das durch die differentielle Rotation entsteht) und die poloidalen (in Richtung zum Pol, der sog. “Alpha-Effekt“) Magnetfeldkomponenten. Beide bestimmen die solare Variabilität. Letzterer entsteht aus Turbolenzen im toroidalen Magnetfeld. Links ist schematisch ein Torus gezeigt, mit einer toroidalen Komponete „t“ und einer poloidalen Komponente „P“.

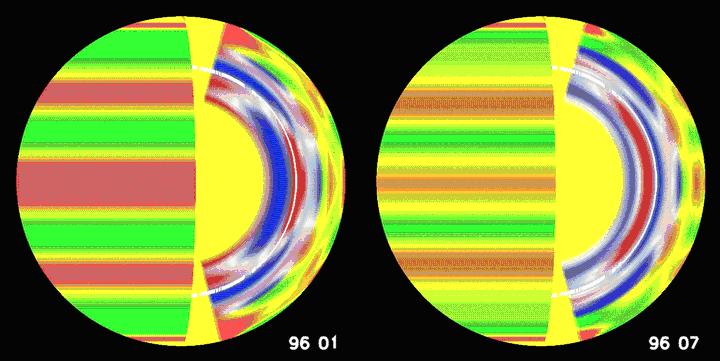

Abbildung 32a: Fließgeschwindigkeiten der Sonne. Deutlich ist beim Vergleich der Abbildungen (zu unterschiedlichen Zeiten ermittelt) zu erkennen, dass sowohl in der Sonne, als auch auf der Sonnenoberfläche, die Fließgeschwindigkeiten ständig variieren, was zu unterschiedlichen Magnetfeldern führt. In der Abbildung sind langsam fließende Regionen blau und schnell fließende rot dargestellt, wogegen auf der Sonnenoberfläche rot für langsamere und grün für schnellere Regionen verwendet wurde. Quelle: (http://soi.stanford.edu/results/2001_MDI_sr_review/).

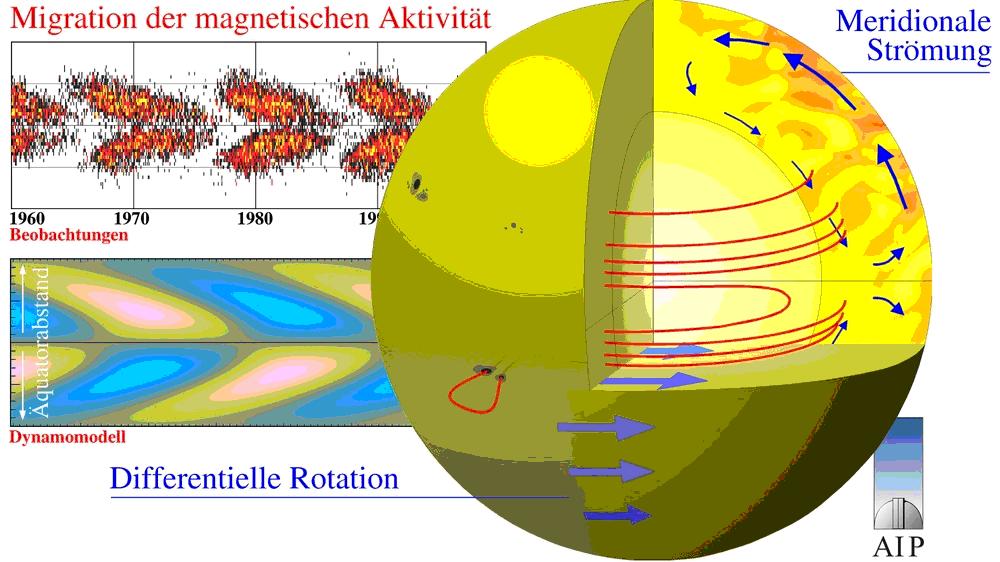

Die beschriebenen magnetischen Prozesse entstehen letztlich aus der Wechselwirkung des Magnetfeldes mit der Plasmaströmung in der Konvektionszone, wobei die Scherströmung in der Tachocline und unteren Kovektionszone eine wichtige Rolle spielt. Magnetfeldlinien werden durch die Scherströmung aufgewickelt und das Magnetfeld verstärkt. Der erhöhte magnetische Druck verringert den Gasdruck und die Dichte in der magnetischen Schicht. Aufgrund des Auftriebs steigt magnetischer Fluss in Form von Magnetfeldschläuchen durch die Konvektionszone nach oben. Bricht ein solcher Schlauch durch die Sonnenoberfläche, bilden die Durchstoßpunkte bipolare Magnetfeldkonzentrationen, die sich als Sonnenflecken zeigen. Konvektion, differenzielle Rotation und unterschiedliche Fließgeschwindigkeiten erzeugen dabei ein komplexes Fließmuster, sowohl in Rotations-, als auch in Nord-Süd-Richtung. Die letzteren Bewegungen gelten als Ursache für die 11-jährige Polaritätsumkehr im Schwabe-Zyklus.

Abbildung 32b: Wie in der Erde, erzeugt die gemeinsame Wirkung von Konvektion und differentieller Rotation komplexe Magnetfelder im Innern, die die Sonnenoberfläche an unterschiedlichen Stellen gebündelt durchdringen, wobei die Sonnenflecken entstehen. Der Sonnendynamo bildet dabei zwei Fleckenbänder mit unterschiedlicher magn. Polarität, gleichermaßen auf der Nord- und Südhalbkugel, parallel zum Äquator aus (oben links). Mit geeigneten Strömungsmodellen kann der Transport dieser Magnetfeldgürtel (Convoyer-Belt) erklärt und somit das Modell überprüft werden (unten links). Quelle: Astrophysikalisches Institut Potsdam

Der Astrophysiker Dr. Theodor Landscheidt (Schroeter Institute for Research in Cycles of Solar Activity Nova Scotia, Kanada) hat diese Theorie weiter entwickelt. Die Basistheorie geht davon aus, dass die Dynamik des magnetischen Sonnenfleckenzyklus von der Rotation der Sonne angetrieben wird. Dabei wird der Eigendrehimpuls berücksichtigt, der an die Rotation der Sonne um ihre Achse anknüpft. Ein weiterer Drehimpuls ist der Bahndrehimpuls, der mit der sehr unregelmäßigen Bahnbewegung der Sonne um das Massenzentrum des Planetensystems zusammen hängt.

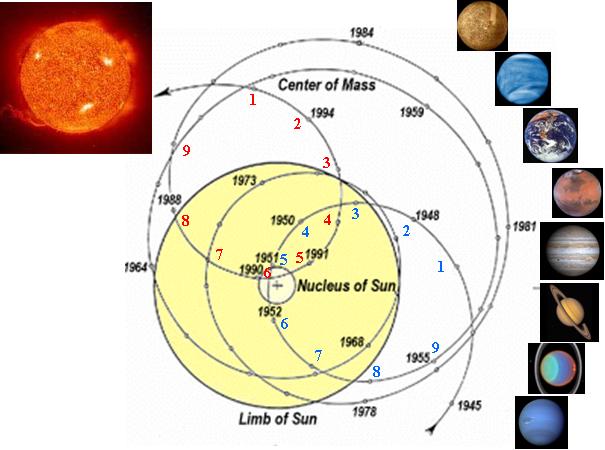

Wäre z.B. Jupiter der einzige Planet im Sonnensystem, so befände sich der Massenschwerpunkt ständig außerhalb des Sonnenkörpers, und zwar durchschnittlich 46.000 km oberhalb der Sonnenoberfläche. Aber auch der Beitrag, den Saturn, Uranus und Neptun zur Lage des Massenzentrums relativ zum Sonnenzentrum leisten, ist ganz beträchtlich. Dabei wirkt sich merklich aus, ob die Planeten im sonnennächsten oder sonnenfernsten Punkt stehen. Je weiter der Planet dabei von der Sonne entfernt ist, desto stärker zieht er den Massenschwerpunkt zu sich heran.

Abbildung 33 zeigt, wie der Masseschwerpunkt des Sonnensystems im Lauf der Jahre wandert. Dies wird durch die räumliche Verteilung der Massen der Riesenplaneten Jupiter, Saturn, Uranus und Neptun gesteuert. Die kleinen Kreise zeigen den Masseschwerpunkt. Zu sehen sind die relativen ekliptikalen Positionen von Massenzentrum und Sonnenzentrum für die Jahre 1945 – 1995 in heliozentrischer Sicht. Die gelbe Scheibe stellt die Sonne dar. Es ist leicht verständlich, dass sich durch Verlagerung des Drehimpulses, der mit der Wanderung des Massenschwerpunktes einhergeht, die Sonne moduliert wird, was sich in einer veränderten Energieabgabe auswirkt. Die blauen und roten Zahlen stehen jeweils für einen engen Zyklusumlauf (siehe Abbildung 35). Ergänzt nach Quelle: Dr. Theodor Landscheidt, Schroeter Institute for Research in Cycles of Solar Activity Nova Scotia, Kanada (kleine Photos: NASA).

Die Grundschwingung der Sonne um das Massenzentrum des Sonnensystems ist daher neben dem Eigendrehimpuls der Sonne ein weiteres Hauptkriterium für die kurzfristigen Energieschwankungen der Sonne, die sich auf der Erde in Klimazyklen auswirken. Beide basieren, bzw. bauen auf der Dynamotheorie auf, die besagt, dass die Dynamik des magnetischen Sonnenfleckenzyklus von der Rotation der Sonne angetrieben wird.

Die Erweiterung zur klassischen Dynamotheorie besteht darin, dass dort zusätzlich der dynamische Bahndrehimpuls berücksichtigt ist, der mit der sehr unregelmäßigen Bahnbewegung der Sonne um das Massenzentrum des Planetensystems zusammenhängt, was vorrangig durch die vier großen Gasplaneten verursacht wird. Der Unterschied zwischen Massezentrum der Sonne selbst (ruhiger Pol) und Massezentrum des Sonnensystems beträgt zwischen 0,01 und 2,19 Sonnenradien.

Das Minimum liegt an, wenn Jupiter auf der einen Seite und Saturn, Uranus und Neptun ihm im Planetenorbit gegenüber stehen. Das Maximum, wenn alle Gasplaneten in Konjunktion stehen. Zwischen diesen Extremen entwickelt sich ein komplexes Schwingungsmuster, was durch die Gravitationskräfte und den Bahndrehimpuls moduliert wird. Der flüssige Sonnenmantel und die Sonnenoberfläche werden dadurch bildhaft durchgeknetet, wodurch das magnetische Feld, die magnetische Stärke und die Energieabgabe der Sonne beeinflusst werden. Der Betrag des Bahndrehimpulses zum Eigendrehimpuls der Sonne kann bis zu 25% betragen. Wogegen der Eigendrehimpuls der Sonne relativ stabil ist, kann sich der Bahndrehimpuls auf das 40-fache der Ausgangswerte verändern. Es bietet sich daher nach Landscheidt an, den hoch variablen Bahndrehimpuls mit veränderlichen Phänomenen auf der Sonne (z.B. Flecken, Fackeln, Änderung der Rotationsgeschwindigkeit) in Verbindung zu bringen, bzw. dies zu untersuchen.

In unregelmäßigen Zeitabständen werden Änderungen der äquatorialen Rotationsgeschwindigkeit der Sonne von mehr als 5% beobachtet (die Sonne rotiert nicht gleichmäßig um ihre Achse), die mit Änderungen der Sonnenaktivität einhergehen, da sich hierdurch durch den Dynamoeffekt das magnetische Feld der Sonne ändert.

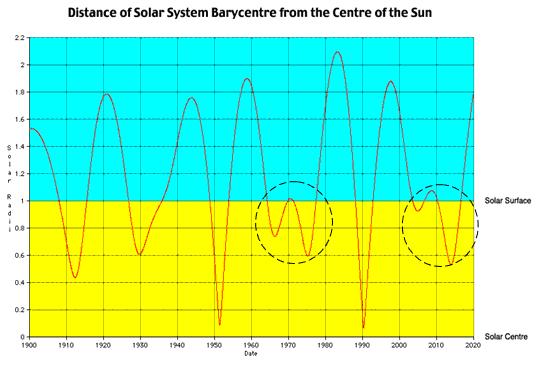

Abbildung 34 zeigt den Verlauf des Masseschwerpunkts des Sonnensystems von 1900 – 2020, Quelle: Solar System Dynamics Group, Jet Propulsion Laboratory Pasadena (http://users.qld.chariot.net.au/~carls/ephemerides/SSB_1900-2019.htm). Deutlich ist eine 20-Jahres-Schwingung erkennbar, deren Extrema mit der Aktivität der Sonne im Schwabe-Zyklus korreliert. Auffallend ist weiter, dass 1970 die Schwingung gering ausfiel – der entsprechende Sonnenzyklus (20) war schwach und 2009 die Schwingung ebenfalls klein ist, was einen schwachen 24. Sonnenzyklus erwarten lässt, zumal beide aus dem Grundmuster herausfallen.

Da die großen Gasplaneten, welche die Schwingung der Sonne um das Massenzentrum steuern, über 99% des Gesamtdrehimpulses im Sonnensystem verfügen, ergibt sich daraus, dass die Spin-Bahn-Kopplung, die Kopplung zwischen Bahnbewegung und Rotation, für die Änderung in der Rotationsgeschwindigkeit zumindest mit verantwortlich ist. Die Sonne bewegt sich durch die von ihr ausgestoßene Materie und ihre eigenen magnetischen Felder, was zu Änderungen in der Rotationsgeschwindigkeit führt.

Die Dynamik der beschriebenen Sonnenschwingung um das Massenzentrum lässt sich quantitativ durch die zeitliche Änderung des Bahndrehimpulses ausdrücken. Bei seinen Untersuchungen stieß Dr. Landscheidt auf folgendes Muster, das den Fingern einer großen Hand gleicht.

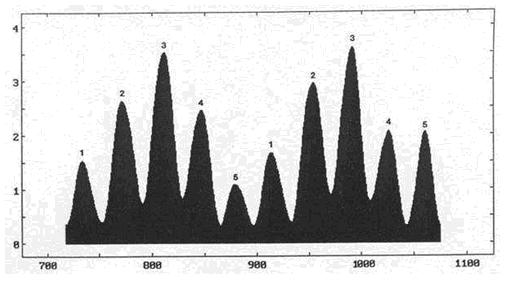

Abbildung 35 gibt die 9-jährige (siehe Abbildung 33) laufende Varianz (Quadrat der Standardabweichung, also die quadratischen Abweichungen vom Mittelwert) des Bahndrehimpulses wieder. Auf der Ordinate ist die relative Änderung des Drehimpulses L und auf der Abszisse die Zeit aufgetragen. Das Bild zeigt deutlich, dass die Änderung des Bahndrehimpulses durch eine fünfzählige Symmetrie geprägt ist. Dieses Muster wird durch die relative Stellung der großen Gasplaneten moduliert und ist nach den Kepplerschen Planetengesetzen konstant. Die Zykluszeit eines großen Fingers beträgt im Mittel 35,8 Jahre.

Bereits im 16. Jahrhundert wies der Engländer Francis Bacon, einer der geistigen Gründervater der modernen Naturwissenschaften, der auf die eingehende Naturbeobachtung setzte, auf einen 35- bis 40jährigen Zyklus in Holland hin, in dem feucht-kühle und warm-trockene Abschnitte aufeinander folgten.

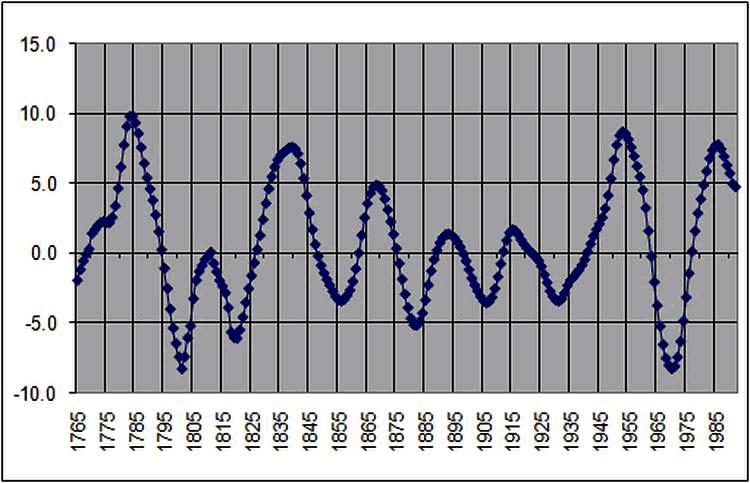

Der Physiker, Geograph und Meteorologe Prof. Eduard Brückner (“Klimaschwankungen seit 1700“, Geographische Abhandlungen 14 (1890), 325) entdeckte diesen Zyklus 1887 neu. Er wies nach, dass zahlreiche klimatische Phänomene, die in den verschiedensten Gebieten der Erde erscheinen, synchronisiert sind und einem Zyklus von im Mittel 35 Jahren folgen. Er ging schon damals von einem Zusammenhang mit der Sonnenaktivität aus. Die folgende Abbildung zeigt den Brückner-Zyklus.

Abbildung 36: Der Brückner-Zyklus stellt eine Oberschwingung in der solaren Aktivität dar. Die Anzahl der Sonnenflecken und damit die Aktivität der Sonne schwanken um einen Mittelwert. Stärkere Aktivitätsphasen wechseln sich im Rhythmus von ca. 35 Jahren ab. Die Abbildung zeigt die Abweichung in der Sonnenfleckenzahl im Zeitraum von 1750 – 2000, Quelle: (http:// garymorris93.cwahi.net/weather/solar_ variations.html).

Aus der Abbildung zeigt sich, dass im Betrachtungszeitraum von 1750 – 2000 die Zykluslänge zwischen 27 und 38 Jahren variiert. Die Schwankungen in der Energieabgabe der Sonne, die im 35-jährigen Brückner-Zyklus sichtbar werden, haben unmittelbare Auswirkungen auf das Klima der Erde, wie Abbildung 37 zeigt.

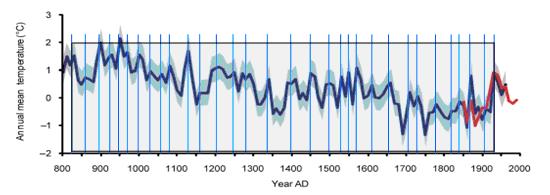

Abbildung 37: Quelle: Fredrik Charpentier Ljungqvist, Stockholm University, “A regional approach to the medieval warm period and the little ice age“, zeigt Temperaturschwankungen aus Eisbohrkerndaten in Grönland (blau) und von Messungen an der Westküste Grönlands (rot) im Zeitraum von 800 – 2000 (grau: Standartabweichung). Man sieht ein heftig gezacktes Muster, in dem sich relative Minima und relative Maxima abwechseln. Werden z.B. die Maxima gekennzeichnet (blaue Linien), sind im Betrachtungszeitraum 31 volle Perioden von ca. 850 – 1935 abgebildet. Daraus ergibt sich eine mittlere Zykluslänge von exakt 35 Jahren, was der Länge des Brückner-Zyklusses entspricht. Temperaturspitzen wechseln sich im Mittel alle 35 Jahre ab.

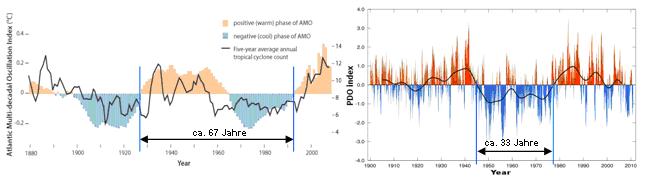

Auch in den mit am wichtigsten Klimaparametern, wie der AMO (Atlantik Multidekaden Oszillation) und der PDO (Pazifische Dekaden Oszillation, beide zeigen die Abweichungen in der Meeresoberflächentemperatur) zeichnet sich deutlich der im Mittel 35-jährige Brückner-Zyklus ab. Mit der AMO bestimmt er unmittelbar die arktische Eisbedeckung, wie noch gezeigt wird und das Wetter und Klima in Mitteleuropa.

Abbildung 38 links, Quelle: Dr. Landsea, zeigt die AMO-Schwingung, mit einer positiven und negativen Phase von im Mittel 33,5 Jahren. Abbildung rechts (NOAA) zeigt die PDO mit der negativen Phase von 33 Jahren.

Dr. Landscheidt schreibt zu der in Abbildung 33 gezeigten 9-jährigen Varianz: “Die 9-jährige laufende Varianz habe ich deshalb gewählt, weil die stärker gekrümmten Umläufe der Sonne mit einer Zykluslänge von 9 Jahren sich als besonders interessant erwiesen haben.“ Mit anderen Worten heißt dies, dass andere, längere Umläufe nicht das markante Muster einer großen Hand ergeben, also die quadratische Abweichung vom Mittelwert anders, weniger zyklisch aussieht. Insgesamt stellt dies natürlich schon seine Ergebnisse etwas in Frage, weil sie nicht allgemeingültig sind oder, können sie gar nicht allgemeingültig sein?

Bei den Untersuchungen Dr. Landscheidts geht es darum, Veränderungen in der magnetischen Aktivität und damit der Leistungsabgabe der Sonne zu erkennen und diese zuordnen zu können. Für Untersuchungen gilt generell, je stärker ein System auf Eingabeänderungen reagiert, also seine Ausgangsgrößen von der Eingangsgröße abhängig sind, umso sensibler ist das System und umso exakter kann es als Ganzes auf Veränderungen beobachtet und damit bewertet werden. Sind die Ausgangsgrößen nur gering von den Eingangsgrößen abhängig, so nähert sich dieses System immer mehr seinem stabilen Zustand. Dies heißt, die Trägheit, die eine der Grundlagen des stabilen Zustands ist, verhindert eine exakte Zuordnung der Ausgangsgröße (hier der solaren Energieabgabe) zu der Eingangsgröße (hier die Änderung der inneren Aktivität der Sonne).

Da aber die Änderung in der Fließgeschwindigkeit der Plasmamassen im Sonnenmantel umso höher ist, je „enger“ die Umläufe des Massezentrums sind – beruht auf der Winkelbeschleunigung in einer Kreisrotation und des Induktionsgesetzes – umso stärker ist der Ausschlag in der Ausgangsgröße des Systems. Soll untersucht werden, wie Änderungen in der Massenströmung der Plasmaströme, die letztendlich die Magnetfeldänderungen hervorrufen, die Energieabgabe der Sonne steuern, so muss zwangsläufig die geringste laufende Varianz, also die 9-jährige Varianz betrachtet werden, weil nur sie in der Lage ist, das exakteste Bild in der Änderung der Ausgangsgröße von der Eingangsgröße abzubilden.

Dr. Landscheidt geht auf die Frage seiner Wahl zur Varianz nicht näher ein, sondern gibt nur allgemein an, dass diese “besonders interessant erwiesen haben“. Evtl. wusste er gar nicht, warum gerade diese so interessant sind und nur diese, so interessant sein können.

Die Länge des Zyklus der “Großen Hand“ in Landscheidts Untersuchungen beträgt 178,8 Jahre. Auffällig ist, dass der Gleißberg-Zyklus etwa halb so lang ist wie der Zyklus der “Großen Hand“. Die Zykluszeit fällt zusammen mit der Konstellation der Planeten Jupiter, Saturn, Uranus und Neptun zur Sonne. Die Zyklen der “Großen Finger“ weisen eine durchschnittliche Länge von 35,8 Jahren auf und sind mit der Sonnenaktivität verknüpft. So fallen sie mit den Maxima und Minima des Gleißberg-Zyklus zusammen und ermöglichen erstmals dessen langfristige Vorhersage.

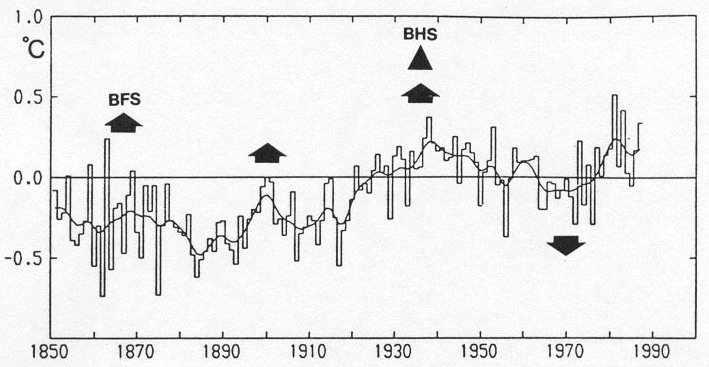

Abbildung 39 aus den Untersuchungen Dr. Landscheidts zeigt die jährlichen Mitteltemperaturen von 1850 – 1987 an der Erdoberfläche der nördlichen Hemisphäre nach P. D. Jones. Die Nullphasen der Großen Finger (BFS) sind durch Pfeile angezeigt. Die Nullphase einer hierarchisch übergeordneten Großen Hand (BHS) ist durch ein Dreieck gekennzeichnet. Diese hat einen Phasensprung ausgelöst. Vor BHS fallen die BFS mit Maxima der geglätteten Temperaturkurve zusammen, danach mit Minima, was nicht anders sein kann, wird in Betracht gezogen, dass durch die Veränderungen im Massenschwerpunkt solare Zyklen mit zunehmender und abnehmender Aktivität verbunden sind. Während ansteigender Sonnenaktivität werden die Massen im Sonnenmantel mit jedem Nulldurchgang BFS beschleunigt. Nach jedem BHS wird der Einfluss der Planeten entgegengesetzt zur Fließrichtung der Massen im Sonnenmantel. Dies bewirkt, dass bei BFS die vorhandene Fließrichtung am stärksten abgebremst wird und damit die solare Aktivität am stärksten reduziert wird, was sich in einem Temperaturminimum auf der Erde auswirkt. Nach zwei Zyklen der großen Hand ist die Geschwindigkeit der inneren Massen Null (der erste beschleunigt und der zweite bremst ab) und das System wird erneut in Gang gesetzt. Ein neuer Sonnenzyklus beginnt. Der nächste Temperaturtiefpunkt ist nach Dr. Landscheidt um 2007 zu erwarten. Anmerkung: Dies ist zwischenzeitlich für 2008 eingetreten.

Die theoretische Erklärung, warum die Planeten und mit ihnen ihr Bahndrehimpulsmoment die solare Aktivität beeinflussen, liegt an der relativen Änderung des Massenschwerpunkts des Sonnensystems zur Sonne und deren Schwerpunkt, wodurch Relativkräfte zwischen den beiden Schwerpunkten und der Sonnenmassen entstehen, die die internen Fluidströme der Sonne beschleunigen, bzw. abbremsen. Dadurch entsteht eine Beschleunigung, bzw. Abbremsung der Sonnenrotation, die wiederum auf die internen Fluidströme rückwirkt. Es entsteht also ein hoch-dynamisches rückgekoppeltes System. Vergleichbar ist dies mit dem System Erde/Mond (entgegen dem Sonnensystem sind hier nur zwei Partner aktiv), wie der Mond über seine relative Position zur Erde, die Gezeitenkräfte auslöst und mit Ihnen die Erdrotation beeinflusst.

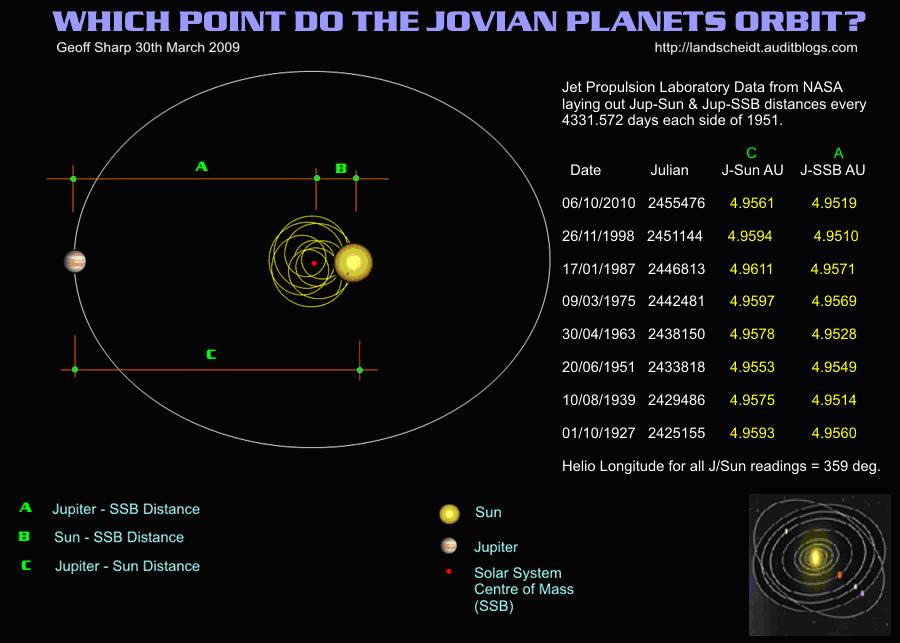

In Abbildung 40 (vergleichbar zum Zwei-System: Erde/Mond) ist das System Sonne/Jupiter (massereichster Planet) dargestellt und die Änderung der SSB (Solar System Barycenter).

Abbildung 40: Das Jet Propulsion Laboratory fand anhand von NASA-Messungen heraus, dass es eine Periodizität zwischen Jupiter und dessen Abstand zum Massezentrum des Sonnensystems (SSB) gibt. Diese liegt bei ca. 11,8 Jahren und stimmt somit sehr gut mit der mittleren Länge (11,1 Jahre) des Schwabe-Zyklus überein.

Beim Bahndrehimpuls müssen neben Jupiter, jedoch noch die anderen Planeten, insbesondere die (weiteren) großen Gasplaneten, Saturn, Neptun und Uranus betrachtet werden, deren Einflüsse, die des Jupiters entweder verstärken (Konjunktion) oder abschwächen (Opposition), so dass sich hieraus, nach den keplerschen Planetengesetzen, ein zeitliches Muster zwischen maximalem Einfluss und minimalem Einfluss der Planeten auf die Sonne einstellt. Nach Theodor Landscheidt hat dieses Muster, wie bereits dargelegt, eine Länge von ca. 180 Jahren.

Anhand der Beeinflussung auf das SSB und dessen Rückwirkung auf die Sonne, ergibt sich nach Landscheidt die folgende Abschätzung für die Intensität der nächsten Sonnenzyklen.

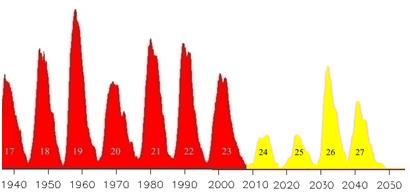

Abbildung 41 zeigt die nach den Modellen von Dr. Landscheidt ermittelten nächsten Sonnenzyklen (gelb). Es sieht gegenwärtig so aus, dass er mit dem 24. Sonnenzyklus Recht hat. Aus der Datenreihe geht hervor, dass es spürbar kälter wird und bis mindestens in die 2030-Jahre kalt bleibt. Quelle: http://landscheidt.auditblogs.com/

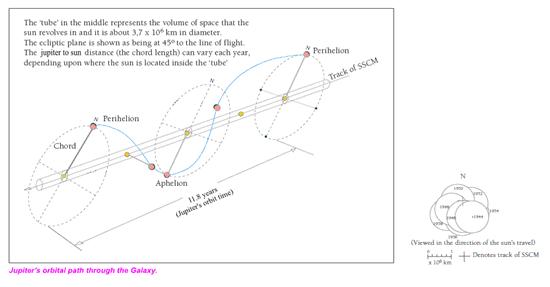

Wie bereits geschildert, führt die Sonne keine konstante Bewegung durch, sondern sie wackelt sozusagen im Orbit durch einen imaginären Schlauch, welcher einen Durchmesser von ca. 3,7 Mio. km aufweist.

Abbildung 42 zeigt die Jupiter- und Sonnenbahn im Orbit, Quelle: Alexander et al., Journal of the South African Institution of Civil Engineering, vol. 49, Page 41, June 2007. Die kleine Abbildung zeigt die unterschiedlichen Positionen der Sonne in diesem (imaginären) Schlauch.

Dr. Landscheidt untersuchte weiter, inwieweit sich mit seiner Methodik noch feinere Unterschiede in der Bahndrehimpulsänderung der Sonne zeigen, sich also deren Abweichungen vom Mittel noch feiner ausbilden lassen, als die bereits gesehenen großen Finger mit einer Zykluslänge von 35,8 Jahren. Hierzu wählte er 1/3 von 9, also eine dreijährige Varianz. Die folgende Abbildung zeigt das Ergebnis.

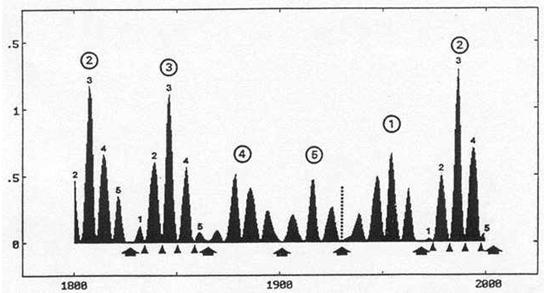

Abbildung 43 zeigt die 3-jährige laufende Varianz (Quadrat der Standardabweichung, also die quadratischen Abweichungen vom Mittelwert) des Bahndrehimpulses, wieder im Zeitraum von 1800 – 2000, Quelle: Dr. Landscheidt. Es bildet sich hier ebenfalls ein Fingermuster aus. Diese werden mit „Kleinen Fingern“ bezeichnet. Die kleinen Pfeile stellen Nulldurchgänge dar. Die großen Pfeile Nulldurchgänge eines "Großen Fingers", was bedeutet, dass eine "Kleine Hand" identisch mit der zeitlichen Länge eines "Großen Fingers" ist. Die gepunktete Linie zeigt den Sprung einer "Großen Hand" (BHS) und die Zahlen sind die Durchnummerierung der "Kleinen Hände", wobei die Zahlen in der Mittelposition angeordnet sind. Die Zykluslänge der "Kleinen Finger" beträgt im Mittel 7,2 Jahre.

In den die Nullphasen der Zyklen "Kleiner Finger" (wie der "großen Finger") wird die zeitliche Änderung des Bahndrehimpulses der Sonne Null. Da der Bahndrehimpuls Einfluss auf die Rotationsgeschwindigkeit der Sonne hat, muss sich dies auf die magnetische Aktivität der Sonne auswirken.

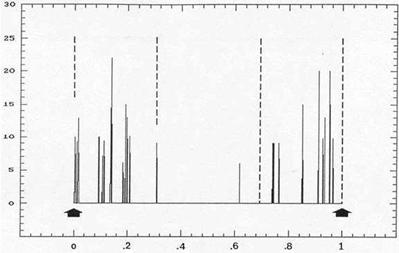

Abbildung 44 zeigt die Verteilung starker Röntgenstrahlungsflares (X≥6) zwischen den Nulldurchgängen "Kleiner Finger" (Pfeile) im Zeitraum von 1970 – 1992. Deutlich ist zu sehen, dass sich die energetischen Sonneneruptionen auf die Zeiten unmittelbar vor und nach dem Zyklus "Kleiner Finger" der Varianz Bahndrehimpuls konzentrieren, Quelle: Dr. Landscheidt. Dies sollte Einfluss auf das Wettergeschehen haben und sich der Zyklus dort wieder finden.

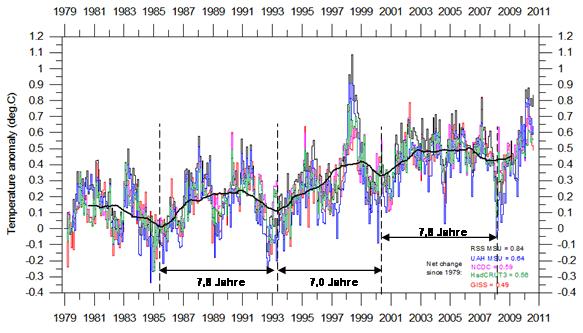

Abbildung 45 zeigt die globale Temperaturentwicklung im Zeitraum von 1979 – 2011. Der geglättete Kurvenverlauf zeigt eine Periode von im Mittel 7,5 Jahren (http://www.climate4you.com/GlobalTemperatures.htm). Dies ist exakt die Periodenlänge nach Dr. Landscheidt und bestätigt, dass seine Überlegungen richtig sind und sich die von ihm gefundenen Zusammenhänge zur Sonnenaktivität unmittelbar im Klimageschehen auf der Erde niederschlagen.

Raimund Leistenschneider – EIKE

Teil 4a in Kürze

Übersicht über alle Teile:

Teil 1 – Die Sonne bestimmt den Temperaturgang

Teil 2 – Die Sonne, der faszinierende Stern

Teil 3 – Sonnenflecken und ihre Ursachen

Teil 4a – Die Sonnenatmosphäre, Korona, Heliosphärische Stromschicht,

interplanetares Magnetfeld

Teil 4b – Die Sonnenatmosphäre, Korona, Heliosphärische Stromschicht,

interplanetares Magnetfeld

Teil 6 – Der Einfluss der Sonne auf unser Wetter/Klima

Teil 7 – Der Einfluss der Sonne auf die Wolkenbedeckung über Svensmark hinaus

Teil 8 – Zukünftige Temperaturentwicklung und deren Schwankungen

Die oben abgebildete Grafik zeigt die offizielle mittlere Deutschlandtemperatur wie sie der DWD noch bis vor kurzem veröffentlichte. Sie zeigt eine deutliche Abkühlung seit 2000.

Die oben abgebildete Grafik zeigt die offizielle mittlere Deutschlandtemperatur wie sie der DWD noch bis vor kurzem veröffentlichte. Sie zeigt eine deutliche Abkühlung seit 2000.