Teil 4 – Die Sonnenatmosphäre: Die Korona

Die Korona ist die äußere Atmosphäre der Sonne. Sie ist die Ursprungsregion des Sonnenwindes und reicht weit in den interplanetaren Raum. Sie ist die äußere Schicht der Sonne. Die Sonnenatmosphäre besteht aus mehreren Sektionen.

An der ca. 5.800 K heißen Sonnenoberfläche, der Photosphäre, schließt sich die etwa 10.000 km-dünne Chromosphäre an (Abbildung 46), die ihren Namen vom haarfeinen farbigen Kranz um die Sonne während einer Sonnenfinsternis hat (Abbildung links). Die rote Farbe kommt vom Ly-α Übergang des Wasserstoffs. Die Farbe verrät, dass es sich um eine kühle Region der Atmosphäre handelt. Nach Wedemeyer et al, 2004, liegt die Temperatur zwischen 3.000 K und 1.800 K und wird durch akustische Wellen, deren Energie durch Dissipation in thermische Energie gewandelt wird, erzeugt.

Über der Chromosphäre schließt sich die Übergangsregion an, die die Korona von der Chromosphäre trennt.

Abbildung 47 zeigt eine Aufnahme des Satelliten TRACE (Transition Region and Coronal Explorer) von der Übergangsregion im UV-Bereich. Aufgrund ihrer hohen Temperatur geben Beobachtungen im sichtbaren Bereich keinen Aufschluss über ihre Vorgänge. Die Übergangsregion stellt den Übergang (daher der Name) dar, von gravitations-gebundenen und durch Gasdruck und Fluiddynamik bestimmten Prozessen, hin zu überwiegend durch magnetisch, dynamische Kräfte (Magnetohydrodynamik) bestimmten Vorgänge dar. Ihre Höhe lässt sich daher nicht eindeutig bestimmen und variiert. Sie stellt die Grenzschicht der Helium-Ionisation dar.

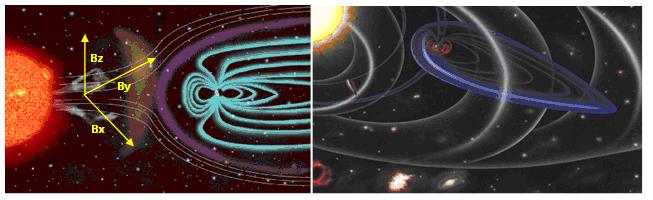

Der Übergangsregion schließt sich die Korona an. Sie besteht aus einem magnetischen Plasma, dass durch das starke Magnetfeld der Sonne in weiten Teilen beeinflusst wird. Die Korona ist stark strukturiert und ist bei einer Sonnenfinsternis als weiß strahlender Kranz (daher der Name) gut sichtbar. Je nach Aktivität der Sonne erstreckt sie sich mehrere Millionen km weit ins All.

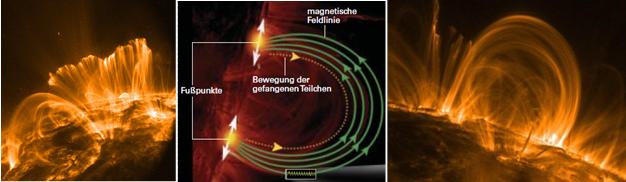

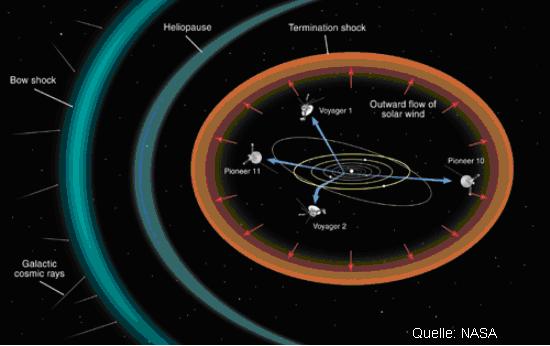

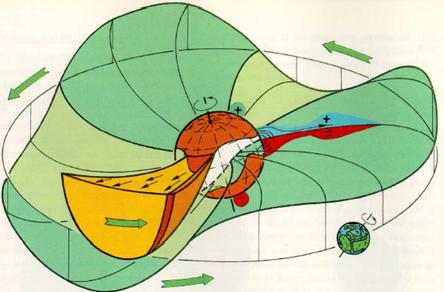

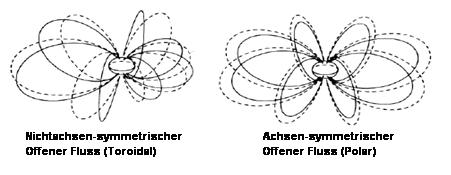

Durch ihr elektro-magnetisch leitendes Plasma ist in der Korona viel magnetische Energie gespeichert. Über den Gebieten mit starker Aktivität bilden sich schleifen- und röhrenartige Magnetstrukturen zu Magnetfeldbögen, mit in sich geschlossenen Feldlinien aus, in denen das Plasma konzentriert ist. Dazu im Gegensatz, die koronalen Löcher über den Polen, die offene Magnetregionen darstellen und deren Feldlinien bis an die Grenzen der Heliosphäre reichen.

Abbildung 48 zeigt Photosphäre, Chromosphäre, Übergangsregion (Transition region) und Korona. Dazu im Röntgenlicht strahlende Magnetfeldbögen mit eingeschlossenem Plasma und ein koronales Loch (Open flux tube), aus dem das Plasma ungehindert entweicht. Abbildung 49 zeigt, warum in der Korona magnetische Effekte dominieren und ihre Heizung auf magnetische Ursachen zurückzuführen ist.

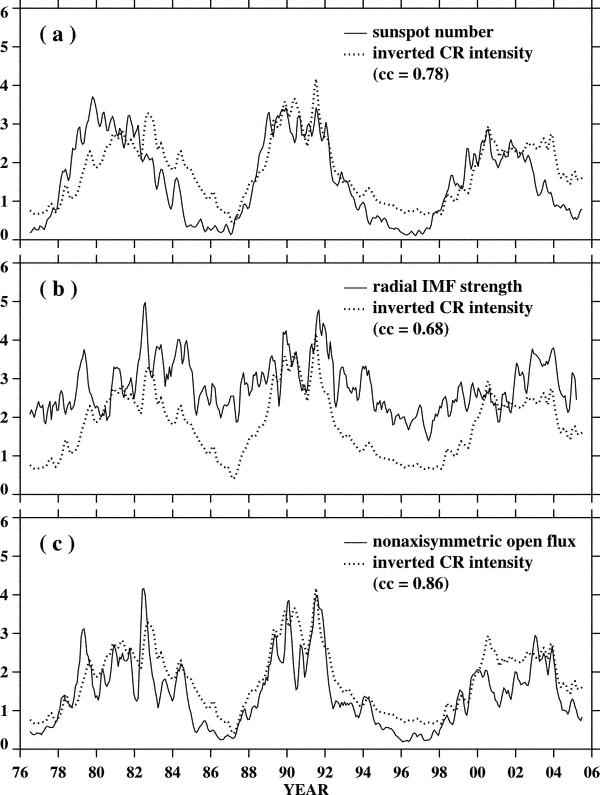

Abbildung 49: Die Eigenschaft eines Plasma wird durch das “Plasma-Beta“ (β) ausgedrückt. β ist das Verhältnis von thermischem Druck und magnetischen Druck. Die Photosphäre, sowie der Sonnenwind werden durch das Plasma bestimmt, wogegen in der Korona der Einfluss des Plasmas abnimmt und magnetische Effekte an Einfluss gewinnen. Dies ist z.B. ein Grund, warum die magnetische Aktivität und die Sonnenfleckenaktivität nicht synchron laufen. Die Koronaaktivität wird durch mehr bestimmt, als nur durch Sonnenflecken.

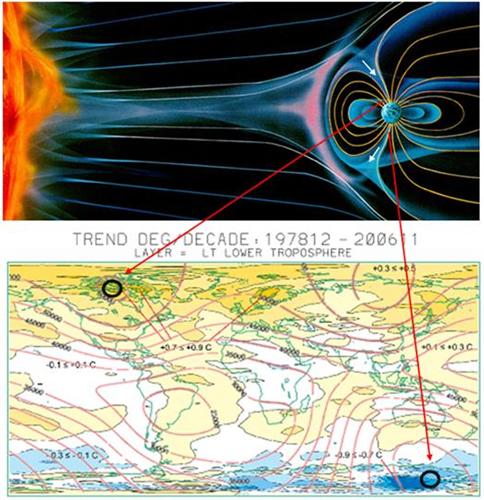

Wie noch gezeigt wird, spielen koronale Löcher eine wichtige Rolle beim Verstehen der solaren Auswirkungen auf die Erdatmosphäre, die Wolkenbildung und damit auf unser Wetter.

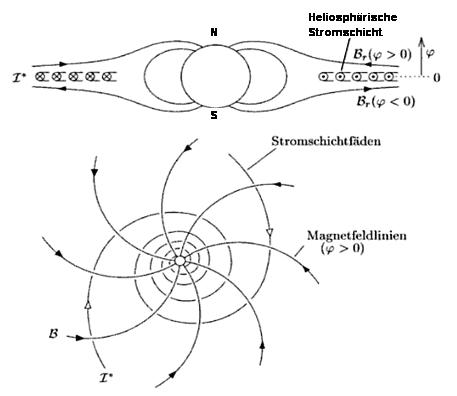

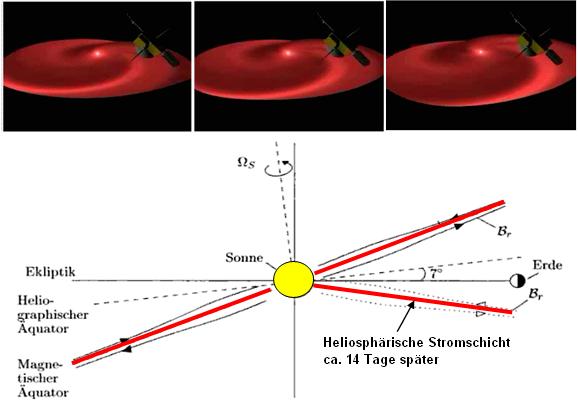

Koronale Löcher werden sichtbar, wenn die Sonne mit Filtern betrachtet wird, die ausschließlich Röntgen und extremes UV-Licht (UVC) der Sonne durchlassen. Dann werden dunklere Gebiete in der Korona sichtbar. Dabei handelt es sich um Gebiete, mit einer um bis zu dem Faktor hundert reduzierten Teilchendichte in der Korona, die auf Grund der geringeren Teilchendichte kälter sind und damit auf den Aufnahmen dunkler erscheinen. Im sichtbaren Spektrum der Sonne sind sie unsichtbar, daher musste die Wissenschaft bis zum Beginn des Satellitenzeitalters zu Beginn der 1960-Jahre (Venussonde Mariner 2, 1962) warten, um sie zu dokumentieren. Der Astronom Julius Bartels hatte sie bereits 1932 aus Beobachtungen von wiederkehrenden magnetischen Regionen, sog. M-Regionen (Stärke-Klassifizierung, M=magnetisch), nach einer Sonnenrotation von 27 Tagen (Carrington-Rotation) abgeleitet.

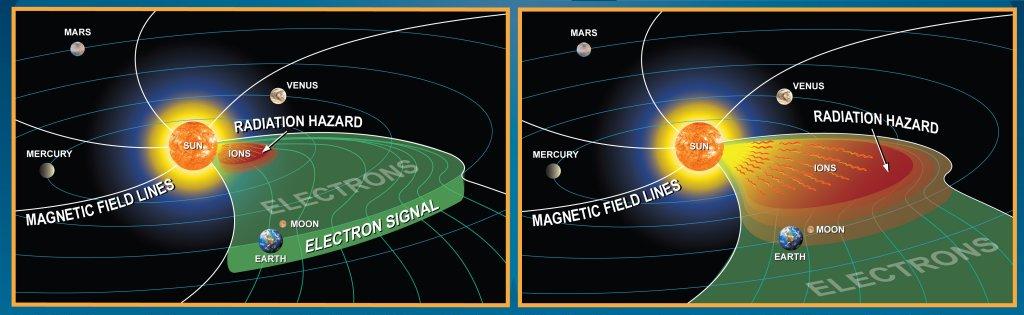

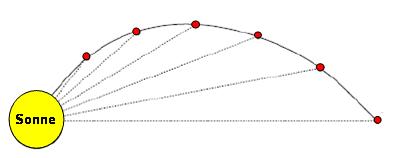

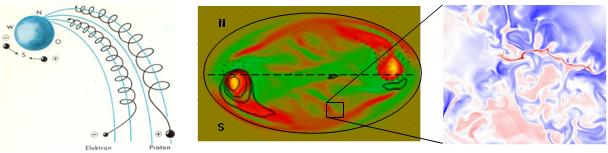

Abbildung 50: Auf koronalen Löchern stehen die Magnetfeldlinien nahezu senkrecht und weichen über die Planetenbahnen hinaus bis an die Grenze der Heliosphäre. Entlang dieser Magnetlinien bewegen sich Protonen und Elektronen schraubenförmig aufwärts. Aufgrund ihrer unterschiedlichen Polarität entgegen gesetzt zueinander. Da die Partikel wegen der geringen Dichte und der senkrecht stehenden Magnetfeldlinien ungehindert die Sonne in Richtung Weltall verlassen, ist die Teilchengeschwindigkeit aus den koronalen Löchern mit mehr als 800 km/s weitaus höher, als der Sonnenwind aus den aktiven Zonen der Sonne. Während aus der Sonnenoberfläche austretende Magnetfeldlinien aus aktiven Gebieten, z.B. Sonnenflecken, auf kurzen Strecken wieder auf die Sonne treffen und die Teilchen dadurch wieder zur Sonne zurück beschleunigt werden, treten die Teilchen aus einem koronalen Loch sämtlich ins Weltall.

Koronale Löcher sind sehr stabil und können mehrere Sonnenrotationen anhalten. Während im Sonnenminimum koronale Löcher sich meist in Polnähe befinden, befinden sie sich mit zunehmender Sonnenaktivität im Äquatorbereich der Sonne. Diese entstehen dort immer dann, wenn Bereiche gleicher magnetischer Polarität nahe zusammen liegen. Dadurch werden die Magnetfeldlinien in den Grenzbereichen gestreckt und stehen nicht mehr in einem Bogen über der Sonnenoberfläche, sondern senkrecht, wodurch das Plasma als schneller Sonnenwind entweicht.

In der Abbildung 51 links zeichnen sich während des Sonnenminimums (NASA, 12.09.1997) deutlich die beiden koronalen Löcher über den Polen der Sonne ab. In der Abbildung Mitte ist ein ausgeprägtes transäquatoriales koronales Loch während dem solaren Maximum zu sehen (SOHO, 08.01.2002) und in der Abbildung rechts der Feldlinienverlauf aus einem koronalen Loch.

Wegen der Dipolcharakteristik des solaren Magnetfeldes im Sonnenminimum, befinden sich koronale Löcher (CH) während des Abklingens des solaren Zyklus und während dem Minimum in Polnähe und ihr Auftreten ist deswegen (Dipol) insgesamt stärker ausgeprägt. So entstehen CH-getriggerte CME im solaren Minimum. Während dieser Zykluszeiten stellen koronale Löcher den Hauptfaktor für die Beeinflussung des irdischen Magnetfeldes, der Ionosphäre und der geladenen Teilchen in den unteren Atmosphärenschichten, bis in die Troposphäre. Sie erreichen dort dieselben Auswirkungen, wie hochenergetische Sonnenflares. Dies hängt damit zusammen, dass sehr viele Teilchen die koronalen Löcher verlassen können, wodurch es am Ort des Geschehens zu einer starken Verringerung der Teilchendichte kommt und am Ort der Wirkung (z.B. Erdatmosphäre), wegen dem erhöhten Teilchenfluss, zu entsprechend großen Auswirkungen.

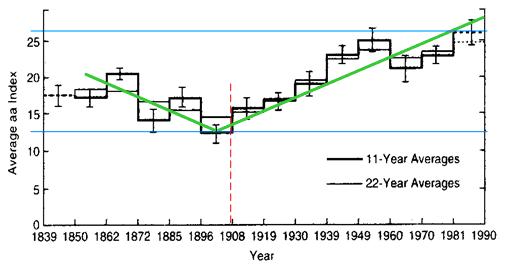

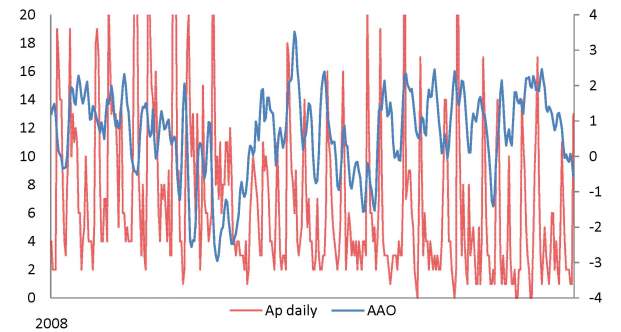

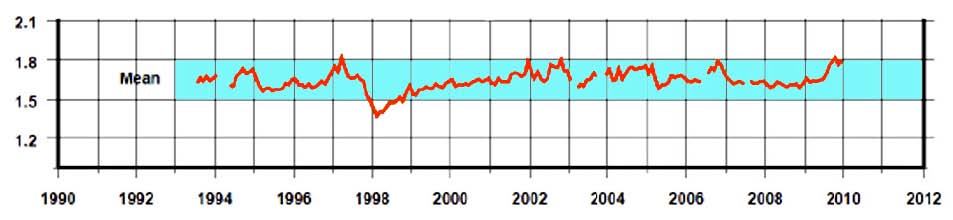

Abbildung 52 zeigt die Auswirkungen des schnellen Sonnenwindes aus koronalen Löchern und im Vergleich, die des langsamen Sonnenwind aus aktiven Zonen auf den geomagnetischen Ap-Index der Erde im Sonnenminimum, Quelle: Bothmer (Institut für Astrophysik, Uni Göttingen) und Büchner (MPS), “Physikalische Grundlagen des Weltraumwetters – Der Sonnenwind“. Deutlich ist erkennbar, dass der schnelle Sonnenwind die Hauptursache für die Änderungen im Ap-Index darstellt und damit die Hauptursache für elektro-magnetisch bedingte Einflüsse in der Erdatmosphäre ist. Während der langsame Sonnenwind kaum Spuren hinterlässt, sind diese beim schnellen Sonnenwind nicht zu übersehen.

Die Korona wirkt also wie ein riesiger Teilchenbeschleuniger, der unablässig geladenes Plasma ins Weltall und damit in Richtung Erde ausstößt. Wegen der hohen Koronatemperatur gibt es kein Druckgleichgewicht zwischen ihrem Plasma und dem Weltall, wodurch ständig Materie in Form von Sonnenwind abströmt und auf der Erde Auswirkungen verursacht.

Man könnte nun davon ausgehen, dass mit zunehmender Höhe in der Sonnenatmosphäre die Temperatur abnimmt. Dies ist jedoch nicht der Fall. Das ionisierte Gas wird sprungartig auf fast 2 Mil. Kelvin erhitzt. Es muss demnach einen separaten Heizmechanismus geben, der die Korona auf die hohen Temperaturen aufheizt. Hierauf wird auf den nächsten Abschnitten eingegangen.

Abbildung 53 links (Yang et al., 2009, “Response of the solar atmosphere to magnetic field evolution in a coronal hole region”) zeigt den Temperaturgradienten von der Sonnenoberfläche und ihrer Atmosphäre. Dazu die beobachteten Wellenlängen in Angström und das zugehörige Isotop. Mitte das koronale Magnetfeld im solarem Minimum und rechts im solarem Maximum, Quelle: (http://rst.gsfc.nasa.gov/Sect20/A5a.html).

Abbildung 54 links zeigt die Korona im Minimum des Schwabe-Zyklus und die Abbildung rechts im Maximum. Sehr gut zeichnen sich im Strahlenkranz der Korona die magnetischen Feldlinien ab, in denen das Plasma gefangen ist und deren Bahnen es folgt. In der linken Abbildung ist das Dipolfeld der Sonne stark ausgeprägt, während es im Maximum nahezu vollständig verschwunden ist.

Wie Abbildung 54 bereits zeigt, wird die Korona sehr stark von der Sonnenaktivität beeinflusst. Abbildung 55, Quelle: (http://soi.stanford.edu/ results/SolPhys200/Poletto/index.html), zeigt die Korona zwischen solarem Minimum und solarem Maximum von 1996 – 2001 und dazu die Sonnenfleckenzahl. Mit zunehmender Sonnenaktivität nimmt die Strahlungsleistung der Korona beständig zu, was am Strahlenkranz um die Sonne gut zu sehen ist. Die kinetische Gastemperatur des Plasmas steigt sprunghaft von 1 Mil. Kelvin im Sonnenminimum auf nahezu 2 Mio. Kelvin, nachdem ein neuer solarer Zyklus beginnt. In aktiven Regionen können die Korona-Temperaturen auf über 10 Mio. Kelvin ansteigen. Es liegt daher nahe, die Korona unmittelbar in Relation zu Klimaereignissen auf der Erde zu setzen.

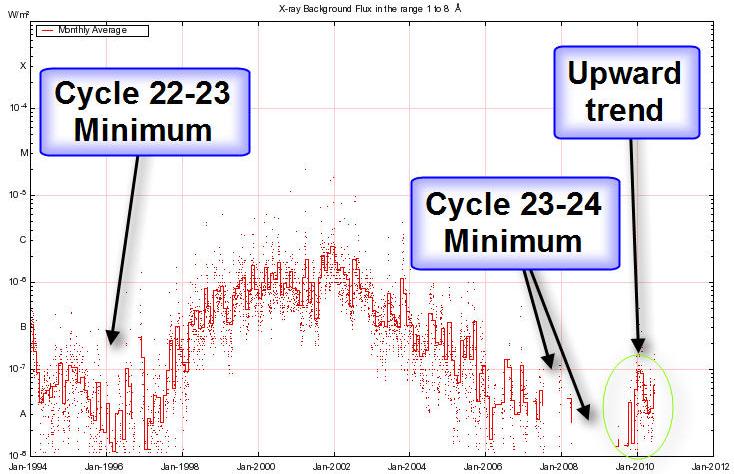

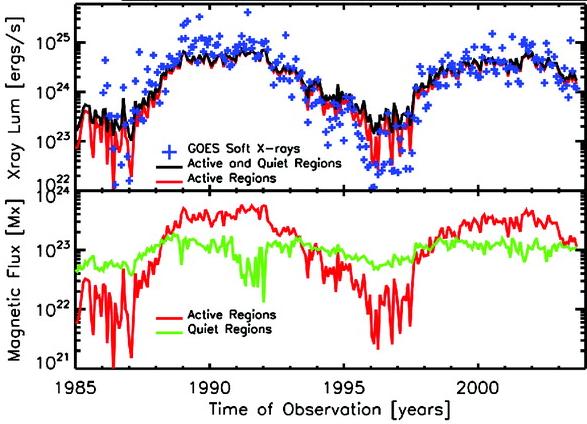

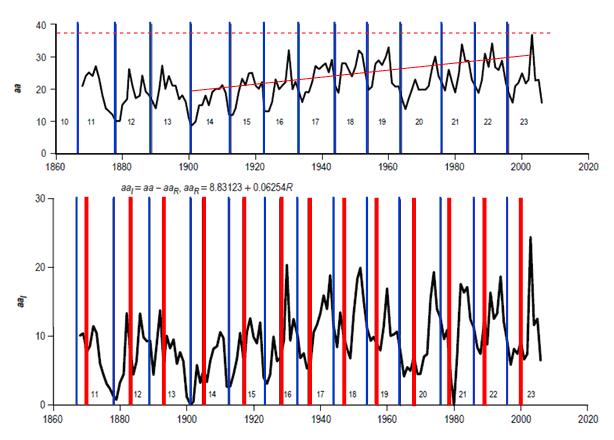

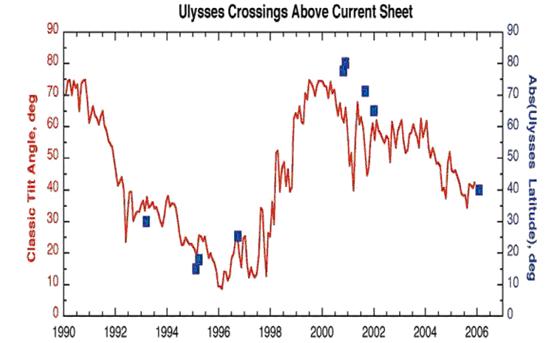

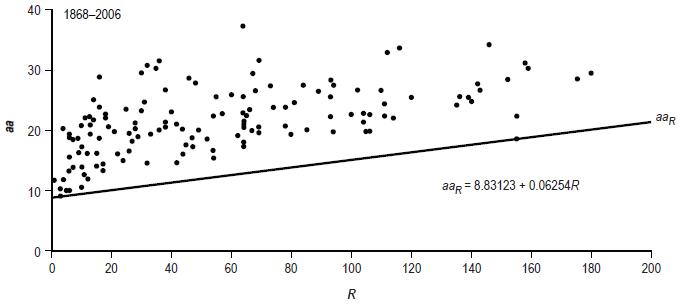

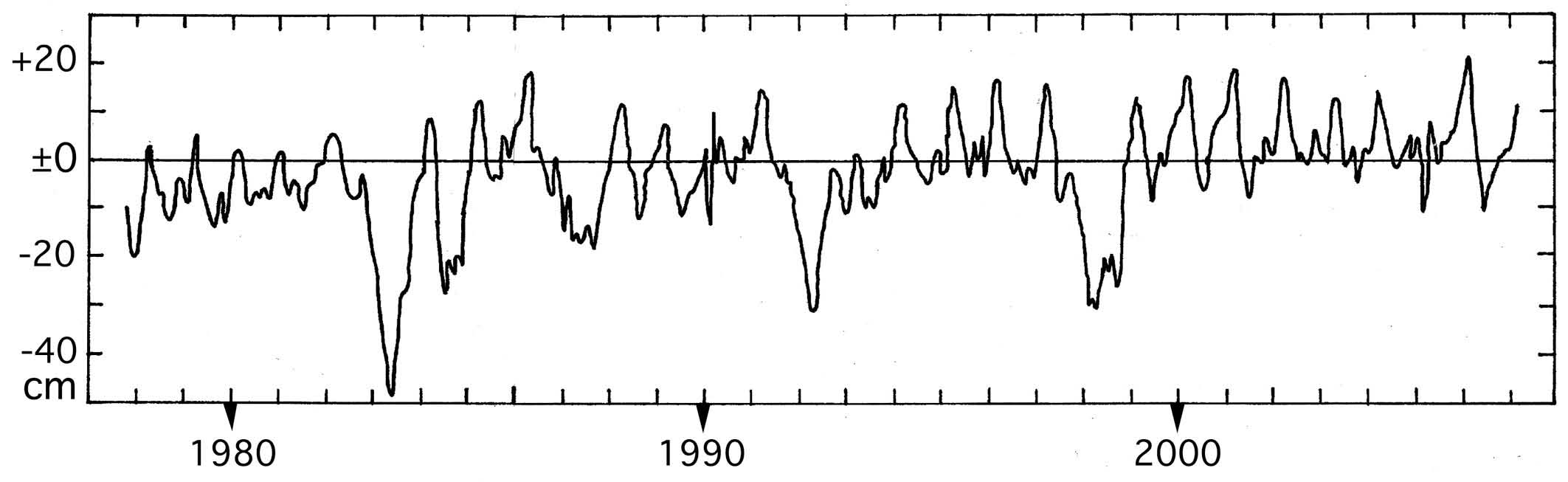

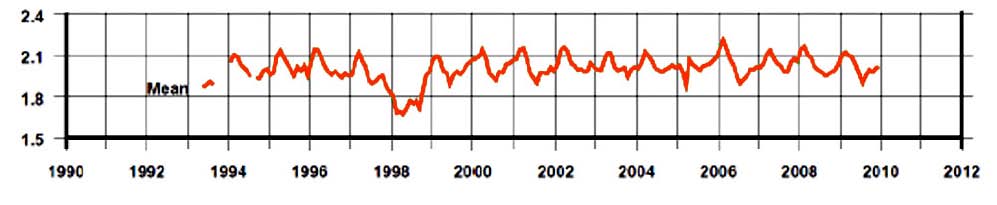

Auf Grund ihrer hohen Temperatur erreicht das Plasma einen Energieinhalt, der nicht durch die Gravitation der Sonne ausgeglichen werden kann. Da es auch keinen Druckausgleich zu dem interstellaren Medium gibt, expandiert die Korona in den Weltraum, wodurch der Sonnenwind entsteht. Da die Koronatemperaturen mit mehreren Millionen Kelvin nur im Röntgen- und extremen UV-Bereich strahlen, sind deren direkte Beobachtungen nur aus dem Weltall möglich, so dass Datenreihen nur für die letzten Jahrzehnte bestehen. Abbildung 56 zeigt die Schwankungen der Koronatemperatur über die Sonnenzyklen 22 und 23.

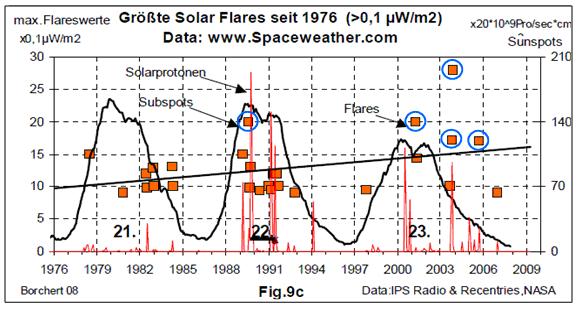

Abbildung 56, Quelle: (http://rst.gsfc.nasa.gov/Sect20/A5a.html), zeigt die Koronatemperatur im Zeitraum 1991 – 2007, aufgenommen mit SWICS (Solar Wind Ion Composition Experiment) der Sonnensonde Ulysses. Auffällig ist im Minimum in 1995 ein plötzlicher Temperaturanstieg nach oben. Der Autor geht davon aus, dass es sich dabei um das exakte Ende des 22. Sonnenzyklus handelt. Dieser Peak findet sich erstaunlicherweise in invertierter Form im Maximum des darauffolgenden Zyklus gegen Ende 2002. Er fällt zusammen mit dem Maximum der magnetischen Aktivität (siehe Untersuchungen von Wilson & Hathaway in der Fortsetzung) und dem Maximum des Hauptsonnenzyklus, dem im Mittel 208 jährigen de Vries-Suess-Zyklus (rote Pfeile). Der Autor geht weiter davon aus, dass zwischen den beiden Zeitblöcken (rot und blau hinterlegte Flächen) und der plötzlichen Max/Min, ein exakter Zusammenhang besteht, der Prognosen über die zukünftige Sonnenaktivität deutlich präziser ermöglicht, als dies gegenwärtig durch die Modelle von Hathaway (NASA) der Fall ist.

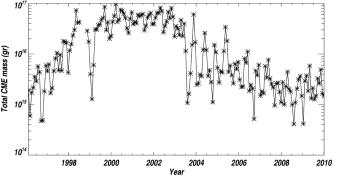

Was könnte nun der Grund für dieses sonderbare Verhalten der Sonne sein, einmal die Koronaheizung im Minimum kurz anzuschalten und einmal, im Maximum genauso plötzlich wieder kurz auszuschalten? Der Grund auf kleinen Skalen (Tage/Wochen) liegt in der Sonnenheizung, auf die in den nächsten Abschnitten noch näher eingegangen wird. Keine der gängigen Sonnenparameter, weder die Sonnenfleckenzahl, noch der TSI, ebenfalls nicht die Zeitreihe der koronalen Massenauswürfe CME, weder die IMF, auch keine ihrer Komponenten, auch nicht der Non-axixymmetric Open Flux, noch der Sonnenwinddruck zeigen zu besagten Zeitpunkten Anfang 1995 und Ende 2002 Auffälligkeiten.

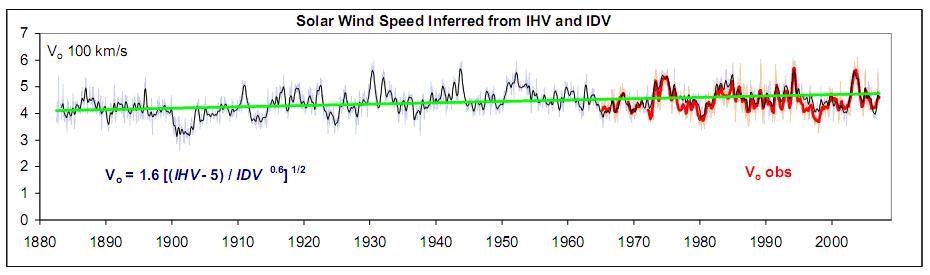

Einen Hinweis könnte jedoch die Zeitreihe der Sonnenwindgeschwindigkeit geben.

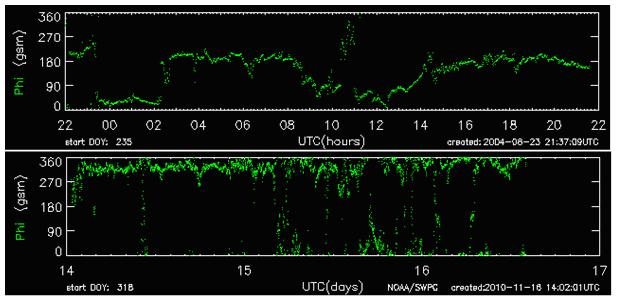

Abbildung 57 zeigt die Sonnenwindgeschwindigkeit (Ausschnitt aus Quelle: http://www.leif.org/research/files.htm). Deutlich ist erkennbar, dass zu beiden Zeitpunkten ein deutlicher Anstieg (Peak) zu verzeichnen ist.

Verbunden mit der Kenntnis, dass der schnelle Sonnenwind aus den koronalen Löchern kommt, zeichnet sich ab, dass die Ursache und die Lösung auf großen Skalen in den polaren Löchern in der Korona zu suchen ist.

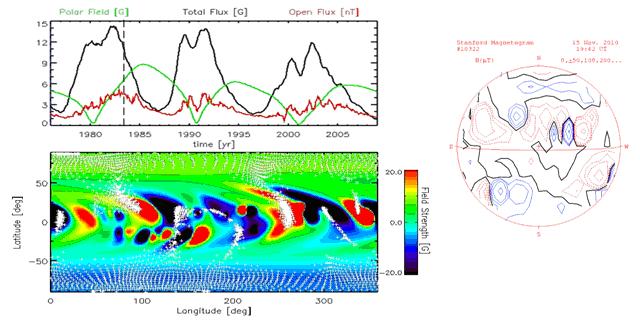

Abbildung 58 zeigt die magnetischen Aktivitätszyklen (http://www.mps.mpg.de/projects/solar-mhd/research_new.html). Grün ist das Polare Magnetfeld der Sonne abgebildet. Zum Jahreswechsel 1994/1995 liegt das Maximum und zu Beginn 2002 ihr Minimum (blaue Linien). Zu beiden Zeitpunkten dreht also das polare Feld.

Eine theoretische Erklärung für die plötzlichen Spitzen im Verlauf der Koronatemperatur sind Flussänderungen und dadurch ausgelöste Induktionsvorgänge in der Konvektionszone der Sonne. Kommt eine elektrisch leitfähige Masse zum Stillstand und wechselt anschließend ihre Fließgeschwindigkeit, so wird nach der Lenzschen Regel ein Induktionsvorgang ausgelöst, der einen magnetischen Strom erzeugt, der sich letztendlich in einer Energieabgabe äußert. Bei Elektromotoren wirkt sich der Effekt durch einen starken Stromanstieg aus, wenn der Rotor blockiert. Der Peak markiert aus Sicht des Autors den exakten Zeitpunkt der Flussumkehr und damit den Beginn des neuen Sonnenzyklus. Der plötzliche Peak in der Mitte des solaren Zyklus ist der umgekehrte Fall.

Solange sich elektrisch leitfähige Massen in einem rotierenden Magnetfeld in Relativgeschwindigkeiten zueinander bewegen, so lange wird durch Induktionsvorgänge (im Innern der Sonne zirkulieren Ströme von 1.000 Milliarden Ampere) die magnetische Aktivität, die durch das innere Magnetfeld der Sonne vorgegeben ist, verstärkt. Haben die Massen nun relativ zueinander gleiche Geschwindigkeiten, so bricht exakt in diesem Moment die Induktion zusammen, was zur plötzlichen Abschwächung der magnetischen Ströme und damit des Magnetflusses führt und die Koronazusatzheizung sozusagen abstellt. Als Zusatzheizung ist der Mechanismus zu verstehen, der die Koronatemperatur nach einem Sonnenminimum auf ihren doppelten Wert anhebt. Dabei handelt es sich um magnetische Wechselströme, die magnetische Wellen verursachen, sog. Alvén-Wellen, sowie Nano-Flares (später im Text).

Wie sich die Strahlungsleistung und damit Energieabgabe der Korona im 20. Jahrhundert änderte, zeigt die folgende Abbildung.

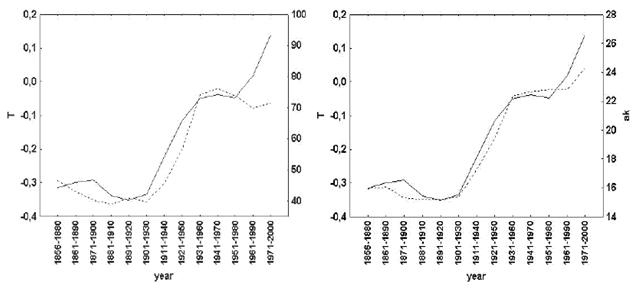

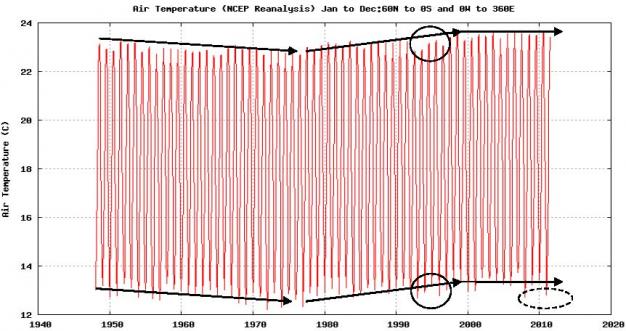

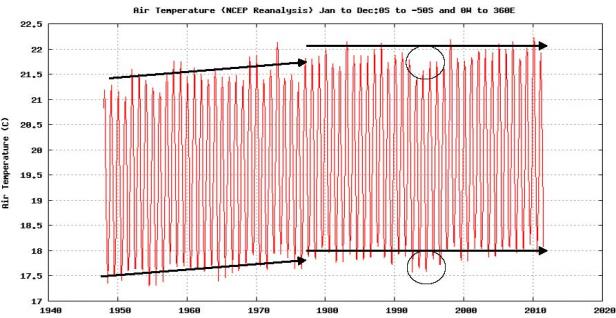

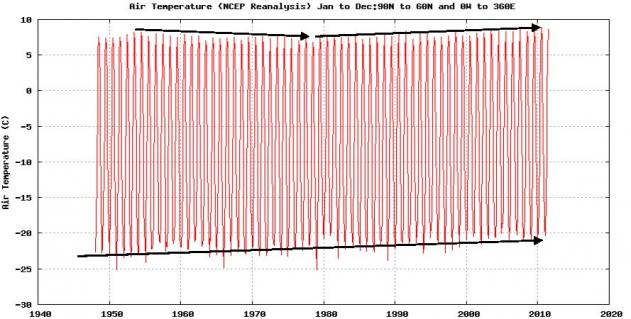

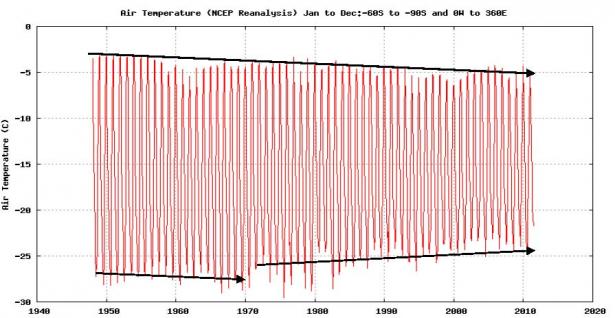

Abbildung 59 links (Quelle: http://www.ngdc.noaa.gov/stp/SOLAR/solarda3.html) zeigt die gesamte Strahlungsleistung der Korona von 1938 – 1995 in W/sr, mit r = 2.800 MHz Radio flux. Deutlich ist zu sehen, dass parallel zum (leichten) Temperaturanstieg auf der Erde, die Strahlungsleistung der Korona stark (25%) ansteigt. Hierbei handelt es sich um die tatsächliche Strahlungsleistung und nicht, wie beim TSI, um die Strahlungsleistung eines kleinen Wellenlängenbereiches (TSI = 200 nm – 2.000 nm). Die NASA beweist damit, dass die Sonne bis zum ausgehenden 20. Jahrhundert immer aktiver wurde. Die rechte Abbildung zeigt die globale Temperaturentwicklung nach Jones.

Koronaheizung

Wie wird nun die Korona so viel heißer wie die Photosphäre? Ein Grund ist natürlich deren geringere Dichte. Bei gleicher Dichte wie in der Photosphäre wäre die Korona keine 2 Millionen Kelvin heiß. Bei der Koronaheizung wirken im Wesentlichen zwei Mechanismen, die beide auf magnetischen Ursachen beruhen, die, die in die Korona reichenden Magnetfelder auslösen, die ständig im leitfähigen Plasma elektrische Ströme induzieren.

Einigkeit in Fachkreisen besteht darüber, dass die heiße Korona nur durch eine zusätzliche Heizung bestehen kann. Eine aussichtsreiche Erklärung ist die Heizung an elektrischen Stromschichten. Diese bilden sich im unteren Bereich der Korona, wo sich das äußerst komplexe Magnetfeld der Sonne sprunghaft ändert. Gemäß den Gesetzen des Elektromagnetismus wird in solchen Stromschichten Energie freigesetzt, mit der die Korona geheizt wird.

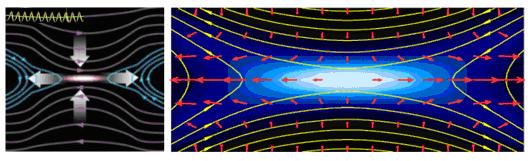

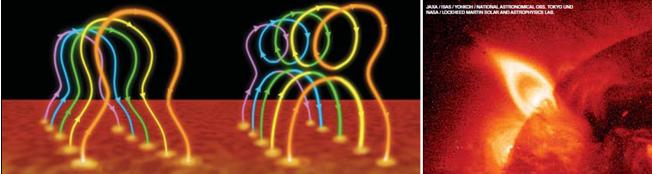

Die Energie muss aber letztendlich in Wärme umgewandelt werden. Hierfür kommen zwei Prozesse in Frage, Alfvén Wellen und Nanoflares. Der Beweis gelang 1998 durch TRACE, das beobachtete, wie ein starker Flare in benachbarten Bögen Wellen auslöste, worauf die Bögen hin und her schwangen. Die Dämpfung erfolgte dabei Millionen-mal schneller, als von der Theorie vorhersagt. Waleri M. Nakariakow et al. (St. Andrews-Universität, Schottland) konnten damit zeigen, das magneto-hydrodynamische Wellen ihre Energie an die Korona übertragen können.

Alfvén Wellen

Seit langem ist durch Beobachtungen bekannt, dass sich in der Sonnenatmosphäre magneto-akustische Wellen ausbreiten. Jedoch ist deren Energie zu gering, um die Koronaheizung zu erklären, zumal deren Energie bereits in der Chromosphäre abgegeben wird.

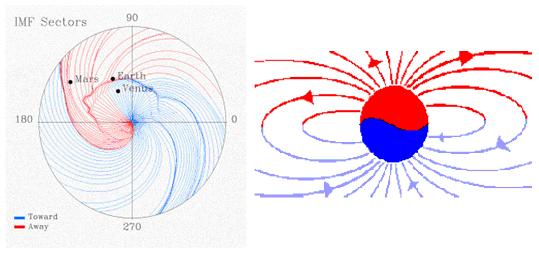

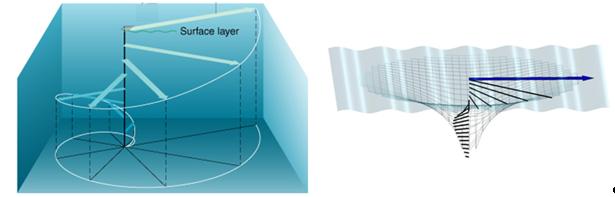

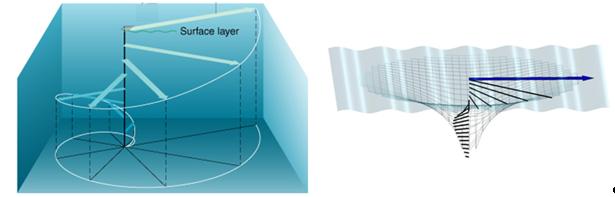

In den magnetischen Flussröhren, die aus der Sonnenoberfläche austreten, entstehen oszillierende Torsionsschwingungen. Dabei handelt es sich um Ionen-Zyklotronwellen, die eine spezielle Form von magnetischen Schwingungen, Alfvén Wellen (schwedischer Physiker und Astronom Hannes Olof Gösta Alfvén, der sie 1938 theoretisch begründete) auslösen. Alfvén Wellen sind niederfrequente Oszillationen von Ionen in einem magnetischen Feld. Die Bewegung der Ionen führt dabei zu einer Störung des Magnetfelds und erzeugt auf diese Weise eine Rückstellkraft, die für die Aufrechterhaltung der Schwingungen sorgt. Alfvén-Wellen breiten sich dispersionslos (Wellenlänge ohne Einfluss auf Ausbreitungsgeschwindigkeit) in Richtung des Magnetfelds aus.

Abbildung 60: Alfvén-Wellen sind sich schnell bewegende Störungen entlang der Magnetfeldlinien in der Sonnenkorona, die Energie nach außen transportieren. Ihre Existenz in der Heliosphäre war seit längerem bekannt, doch noch nicht beobachtet worden, weil Alfvén-Wellen sehr schwer zu entdecken sind, da sie keine großen Fluktuationen in der Sonnenkorona auslösen, wie z.B. bei anderen Wellen üblich. Des Weiteren sieht es so aus, dass sich die Wellen immer mit derselben Geschwindigkeit fortzubewegen, weswegen sie schwer zu detektieren sind. Üblicherweise werden Wellen durch eine Geschwindigkeitsänderung entdeckt. Die Abbildung links (Quelle: National Center for Atmospheric Research) zeigt sich ausbreitende Alfvén Wellen entlang magnetischer Feldlinien in der Korona. Mit einer Ausbreitungsgeschwindigkeit (Phasengeschwindigkeit) von 4.032 km/s sind sie sehr schnell und transportieren ihre Energie entsprechend in die Korona, was z.B. die schnellen Zykluswechsel in der Korona-Temperatur von SWICS erklären würde.

Einem Team um den Sonnenphysiker David B. Jess (University of Belfast), „Alfvén Waves in the Lower Solar Atmosphere“, Science 323, 1582 (2009) gelang es, die Existenz von Alfvén Wellen anhand von Phasenverschiebungen nachzuweisen.

Abbildung 61 links zeigt anschaulich, wie durch die Oszillation von Plasma in einer magnetischen Flussröhre Alfvén Wellen entstehen. In den hellen Flächen der Abbildung rechts gelang es Jess et al. 2009, Alfvén Wellen direkt nachzuweisen. Die Messungen zeigten in der Wasserstoff-Alpha-Linie (oder Lyman-alpha-Linie) periodische Oszillationen der Linienbreite, die nach der Theorie Alfvén Wellen verursachen, weil Alfvén Wellen Torsionsschwingungen in magnetischen Flussröhren erzeugen, die simultan Blau- und Rotverschiebungen erzeugen, was in den hellen Gebieten beobachtet wurde.

Abbildung 62 zeigt die Lyman-Serie. Sie ist eine Abfolge von Spektrallinien des Wasserstoffatoms im Ultraviolettbereich zwischen ca. 91-121 nm. Die Alpha-Linie hat mit 121,6 nm die größte Wellenlänge. Die Lyman-Spektrallinien werden von Astronomen für die Untersuchung von Sternen verwendet und gehen auf den amerikanischen Physiker Theodore Lyman zurück, der sie 1906 entdeckte.

Anhand ihrer Berechnungen kommen die Forscher zu dem Ergebnis, dass die so transportierte Energie ausreichend ist, die Koronatemperatur zu begründen. Dass Magnetfelder für die Koronaheizung eine Schlüsselrolle spielen, liegt nahe, denn dort, wo sie am stärksten sind, ist die Korona am heißesten. Wie bereits geschildert, zeigt die Korona eine starke thermische Struktur.

Abbildung 63 (NASA) zeigt die Korona im extremen Ultraviolett (EUV). Die rote Farbe (über den aktiven Regionen) entsprechen Temperaturen von 2 Mio. Kelvin und mehr, grün ca. 1,5 Mio. Kelvin und blau ca. 1 Mio. Kelvin. Die hellen weißen Flecken weisen ein Gemisch aller Temperaturen auf, was auf die Newtonsche Farbmischung zurückgeht. Am Nordpol ist ein koronales Loch sichtbar, das in blau strahlt, also relativ kühl ist. Die Abbildung zeigt die Sonne im Jahr 1999, während ihrer aktiven Phase im 23. Sonnenzyklus. In den aktiven Regionen, in denen das Magnetfeld mit 100 Gauss ca. 10-mal höher wie in der übrigen Korona ist, sind die Temperaturen am höchsten, was den Zusammenhang zwischen Temperatur und Magnetfeld offenkundig werden lässt.

Nano-Flares

In den eingangs geschilderten Stromschichten liegen Magnetfeldlinien unterschiedlicher Polarität sehr eng zusammen. Komplexe plasmaphysikalische Prozesse können zur Neuverbindung (Rekonnexion) dieser Magnetfeldlinien führen, wobei große Energiemengen explosionsartig freigesetzt werden, die geladenen Teilchen beschleunigt und aufheizen. Doch auch diese Theorie konnte nicht durch Beobachtungen bestätigt werden, da die Genauigkeit der benutzten Messmethoden nicht ausreicht, um das Magnetfeld in der unteren Korona zu messen.

Abbildung 64: Magnetfelder der Sonne werden bereits seit gut 100 Jahren mit Magnetographen, die den Zeeman-Effekt benutzen, gemessen. Dieser Effekt besagt, dass sich in Anwesenheit eines Magnetfeldes die Spektrallinien in zwei oder mehr Linien mit etwas unterschiedlichen Wellenlängen aufspalten, was gleichzeitig mit Polarisation verbunden ist. Die Abbildung 64 zeigt einen Sonnenfleck mit zugehörigem Spektrum und Linienaufspaltung. Die senkrechte dünne Linie stammt vom Spektrographenspalt des Messgerätes.

Aus deren Aufspaltung kann das magnetische Feld gemessen werden. Beobachtungen der Korona (Magnetfeldstärke mit ca. 10 Gauss ist dafür zu gering) sind damit noch nicht gelungen, da die Aufspaltung der Spektrallinien, die sie ausstrahlt, für die heutige Messtechnik zu gering ist.

Durch die eingangs geschilderte Rekonnektion, was etwa so viel wie Kurzschluss bedeutet, kommt es, genau wie bei einem elektrischen Kurzschluss, zu einer explosionsartigen Entladung und damit zu einer explosionsartigen Freisetzung von Energie, wodurch Sonnenflares ausgelöst werden. Deren Energieinhalt liegt bei ca. 6 x 1025 Joule. Zu den bekannten, weil direkt beobachteten Flares kommt es auf kleinen Einheiten zu Mikro- bzw. zu noch kleineren Nanoflares, die wiederum magnetische Wellen aussenden. Deren Energie liegt bei ca. 1017 – 1019 Joule, was der Energie von 1.600 – 160.000 Hiroschimabomben entspricht.

Abbildung 65 (Wedemeyer-Böhm et al., 2008, “Coupling from the Photosphere to the Chromosphere and the Corona“) zeigt aus der Sonne austretende Magnetfeldlinien (network), in denen es durch Rekonnektion zu Nanoflares kommt, die wiederum Alfvén Wellen auslösen, die bis in die Korona reichen. Durch die Granulation der Sonnenoberfläche, das auf-und Absinken von Materie durch Konvektion um einige Kilometer, werden akustische Wellen (shock waves mit einer Periode von 5 Minuten) ausgelöst, die die Chromosphäre heizen. Zwischen den Magnetfeldern unterschiedlicher Polarität bilden sich Stromschichten (current sheets) aus, die zeitlich stark fluktuieren.

Durch die Freisetzung hochenergetischer Energie in Form von Röntgenstrahlung und UV-Strahlung wird das Koronaplasma mit Energie versorgt und die Temperatur der Korona dadurch erhöht. Wogegen Flares vorwiegend in aktiven Regionen der Sonne auftreten, sind Nano- und Microflares auch in ruhigeren Gebieten der Sonne vorhanden.

Diese Mikroflares verursachen seismische Wellen, die die Sonnenoberfläche durchziehen (Abbildung 66, Quelle: NASA). Ein Forscherteam um Robert Lin (University of California in Berkeley) werteten dafür über 10.000 Mikroflares aus und konnten dabei zeigen, dass aufgrund ihrer hohen Anzahl, diese einen starken Einfluss auf das Sonnenwetter haben, Quelle: (http://www.sciencedaily.com/releases/2003/07/030721084713.htm).

Abbildung 66: Die Bildsequenz zeigt den Ausbruch eines Mikroflares und dadurch verursacht, die Ausbreitung seismischer Wellen auf der Sonnenoberfläche und wie ein Materiejet aus der Sonne herausschießt.

Dass Nano- und Mikroflares die entscheidende Ursache (weitere Forschungsarbeiten sind notwendig, dies zu erhärten) für die Koronaheizung sind, hat ein Team um den Astrophysiker James Klimchuk, vom Laboratorium für solare Physik des Goddard Space Flight Center der NASA, erhärtet “Nanoflares heizen Sonnenkorona auf“ (scinexx vom 19.08.2009).

Abbildung 67: Das Falschfarbenphoto eines Nanoflares (Quelle: NASA/ Goddard Space Flight Center) zeigt dessen Temperaturprofil. In den blauen Regionen steigt die Temperatur auf 10 Millionen Kelvin. Durch die Messungen der japanischen Sonnensonde Hinode konnte nachgewiesen werden, dass Nanoflares Strahlungsausbrüche mit Temperaturen von bis zu 10 Millionen Kelvin erzeugen.

Wodurch werden Micro- und Nanoflares ausgelöst? Die Erklärung sind die sog. “Bright Points“. Dabei handelt es sich um zahlreiche, nur 100 km große helle Punkte, die durch kleine Magnetfeldkonzentrationen hervorgerufen werden. Es wird angenommen, dass sie Überreste von Flecken darstellen oder lokal durch magnetokonvektive Vorgängen entstehen. Das letztere dürfte nach Ansicht des Autors die Ursache sein, sonst wären im Fleckenminimum nicht noch hunderttausende zu erkennen.

Abbildung 68: Bei den gegen Ende des 20. Jahrhunderts entdeckten “Bright Points“ (Pfeile) handelt es sich um Magnetfeldröhren. Dass diese im Gegensatz von z.B. Sonnenflecken heller, also heißer als ihre Umgebung sind, liegt zum einen daran, dass bei Sonnenflecken die unterdrückte Konvektion überwiegt, weil die zu heizende Fläche mit dem Quadrat, die Fläche der heißen Wände aber nur linear mit dem Durchmesser zunimmt.

Bright Points weisen eine erheblich geringere Massendichte als ihre Umgebung aus. Dadurch blickt man durch die Röhre in tiefere, heißere Schichten der Sonne. In den Magnetfeldröhren wird der magnetische Druck stark verstärkt. Dieser muss durch einen verringerten Druck im Plasma ausgeglichen werden, damit die Region im Druckgleichgewicht bleibt und nicht zusammenfällt. Wegen der hervorragenden Wärmeleitfähigkeit des Materials kann dies nicht durch Abkühlung, sondern nur durch eine Verringerung der Plasmadichte erreicht werden. Dadurch wird das Plasmapaket leichter und erhält eine Auftriebskraft. Die folgende Abbildung gibt einen Größenvergleich der Bright Points wieder.

Abbildung 69 links zeigt drei Bright Points auf der Sonnenoberfläche und dazu ihre Helligkeitsintensität. Rechts ist das magnetische Profil desselben Raumabschnittes abgebildet. Deutlich ist zu sehen, dass in den Bright Points die magnetische Feldstärke sehr stark erhöht ist, wodurch der Beweis erbracht ist, dass es sich um magnetische Flussröhren handelt. In beiden Abbildungen sind als Größenvergleich die Umrisse Deutschlands zum Vergleich eingezeichnet, Quelle: MPG, 05.11.2010,

Aufgeheizt werden die Magnetfeldröhren neben der induktiven, magnetischen Erwärmung durch die umliegenden heißen Wände. Die stetige Energiezufuhr und die dadurch gespeicherte Energie könnten beim Zerfall der Magnetfeldröhren, wenn kein Druckgleichgewicht mehr aufrechterhalten werden kann, zu Ausbrüchen und damit zu Mikroflares, bzw. zu Nanoflares führen. Ähnlich beim Zusammenbruch eines Sternes, der durch magnetische Prozesse getrieben wird. Die folgende Abbildung zeigt, wie durch Rekonnektion in zeitlich kurzer Abfolge ein Mikroflare ausgelöst wird.

Abbildung 70: Die Bildsequenz, Quelle: ”X-ray Imaging & Spectral Statistics of Small Solar Flares Observed with RHESSI”, Iain G. Hannah et al. Space Sciences Laboratory, University of California, Berkeley (http://www.mssl.ucl.ac.uk/www_solar/seminars_files/Presentations/Hannah_20070425.pdf) zeigt, wie durch magnetische Rekonnektion (links und Mitte) ein Mikroflare (rechts) ausgelöst wird. Dabei geht die Rekonnektion der höheren Energie, der der niederen Energie voraus (Mitte).

Durch die kleinsten bekannten solaren Einheiten (Gebilde), die Bright Points, wird die Temperatur der Korona maßgeblich bestimmt. Zu diesem Ergebnis kommt das Forscherteam um Prof. Solanki (MPS), das dies anhand von Daten der Sonde “Sunrise“ beweisen konnte “SUNRISE enthüllt magnetische Grundbausteine der Sonne“, Max Planck Gesellschaft, 05. November 2010. Sie sollten darüber hinaus auch für die in Abbildung 56 gezeigte Regelung der Korona-Temperatur verantwortlich sein. Also das Zuschalten der „Koronaturboheizung“, wenn die Koronatemperatur von 1 Mil. Kelvin im solaren Minimum, auf annähernd ihren doppelten Wert ansteigt.

Wo entstehen die Bright Points? Die Antwort gibt die folgende Abbildung.

Abbildung 71 links zeigt die Granulation der Sonnenoberfläche als netzartige Struktur. Diese Granulen haben eine Ausdehnung von einigen tausend Kilometern. Man erkennt zwischen den Granulen kleine helle Punkte. Abbildung rechts zeigt als Vergrößerung einige Granulen und dazwischen, gut erkennbar (Pfeile), die Bright Points. Beide Photos, Quelle: (http://www.physorg.com/news161972205.html).

Warum entstehen die Bright Points nur zwischen den Granulen? Die Antwort wurde bereits auf den vorherigen Seiten (indirekt) gegeben. Sie liegt in der bewegten Sonnenoberfläche.

In den Granulen steigt heißes Plasma nach oben. In den vorigen Abbildungen gut an der helleren Farbe in der Granulenmitte zu erkennen. Dieses Plasma erfährt an der Sonnenoberfläche eine Abkühlung, wodurch es schwerer wird und absinkt. Dies kann es aber nicht in den Granulen, weil dort das heiße Plasma von unten aufsteigt, sondern nur an ihren Rändern. Zu erkennen an der dunkleren Farbe an den Granulenrändern. Durch diesen Effekt kommt es zu einem beständigen brodeln der Sonnenoberfläche. Durch die Relativbewegung von elektrisch leitfähigen Materialien (Plasma) an den Granulenrändern werden Induktionsvorgänge ausgelöst, die zu örtlichen magnetischen Strömen, bzw. zu Magnetfeldern führen. Die Bewegungsenergie des Plasmas wird in magnetische Energie gewandelt.

Durch den magnetischen Fluss ist der magnetische Widerstand in diesen Zonen gemäß dem Hopkinsonschen Gesetz (Um = Rm . Ф, Ф = magnetischer Fluss) reduziert und dadurch die magnetische Leitfähigkeit erhöht. Die Magnetfelder aus der Konvektionszone der Sonne suchen sich aus dem Sonnenmantel (Konvektionszone) den Weg des geringsten Widerstandes, genau wie elektrische Ströme. Dies ist zwischen den Granulen. Sind nun die, auf Grund der Relativbewegung entstehenden magnetischen Felder zwischen den Granulen phasengleich, also richtungsgleich zu den aus der Sonne austretenden Magnetfeldern, findet eine Verstärkung statt, wodurch der magnetische Widerstand weiter reduziert wird. Dies sollten die Bereiche sein, in denen die Bright Points entstehen. Es sind die Bereiche des geringsten magnetischen Widerstands. In ihnen tritt das Magnetfeld der Sonne verstärkt an die Oberfläche.

Das MPS ermittelte die Feldstärke in den Bright Points mit bis zu 1.800 Gauss, was der 3.000-fachen Stärke des Erdmagnetfeldes entspricht. Ihre Temperatur liegt um ca. 1.000°C höher als in ihrer nichtmagnetischen Umgebung (The Astrophysical Journal Letters, 723, L127 – L189). Weiter konnten die Wissenschaftler erstmals die Helligkeit der Bright Points im UV-Bereich bestimmen. Diese ist etwa fünf Mal stärker als in der Umgebung. Tino Riethmüller vom MPS: „Nur so ist es möglich, den Beitrag der hellen Flecken zu den Helligkeitsschwankungen der Sonne abzuschät-zen“. Ein Seitenhieb an die Adresse der tendenziösen Arbeit von Spruit et al., die anhand von Helligkeitsuntersuchungen herausgefunden haben wollen, dass die Sonne seit 50 Jahren nicht aktiver geworden sei. Nun, zu der Aussage war Henk Spruit bei seinen Untersuchungen in 2006 noch gar nicht in der Lage und sein Endergebnis ist somit in die berühmte Tonne zu werfen.

Da die Erdatmosphäre die UV-Strahlung in der Stratos- und oberen Troposphäre fast vollständig absorbiert, spielt dieser Teil des Sonnenlichts eine wesentliche Rolle bei der Erwärmung der oberen Luftschichten und somit auf das Klima- und Wettergeschehen der Erde.

Diese magnetischen Flussröhren, die sich optisch als Bright Points abbilden, sind mit knapp 100km Durchmesser die kleinsten bekannten Einheiten des solaren Magnetfeldes. Sie sind auf Grund der sich über die gesamte Sonnenoberfläche erstreckenden netzartigen Struktur der Granulen auch in den ruhigen Gebieten der Sonne zu finden. Wie noch gezeigt wird, ist das Polare Feld der Schalter, der die Koronaturboheizung ein, bzw. abschaltet.

Abbildung 72: Die Bilderserie (Quelle: ”Microflare Activity Driven by Forced Magnetic Reconnection” D.B. Jess et al.) zeigt, wie aus zwei Bright Points (weiße Kreise) ein Mikroflare (Abbildung rechts) ausgelöst wird. Grün ist die neutrale Linie zwischen den entgegen gesetzten magnetischen Polen.

Wie steuern die Vorgänge in der Konvektionszone der Sonne die Bright Points? Letztendlich wird Bewegungsenergie im Plasma in magnetische Energie gewandelt, wobei es keine einheitliche Bewegungsrichtung, sondern überlagerte Bewegungen gibt. Den Hinweis zur Antwort geben die folgenden Abbildungen, Quelle: NASA.

Abbildung 73: Nach den Vorstellungen und Beobachtungen der NASA wird im Conveyor Belt das Plasma an der oberen Konvektionszone zu den Polen transportiert. Die Plasmaflüsse bestehen aus einem nördlichen und einem südlichen Teil. An den Polen sinkt Plasma in die Tiefe und wird zum Äquator transportiert. Entgegen der vereinfachten Darstellung der NASA (Hathaway) handelt es sich nicht um ein zusammenhängendes Gebilde, sondern es besteht wegen der unterschiedlichen Temperaturen und damit unterschiedlichen Dichte in der 200.000 km-starken Konvektionszone aus mehreren Schichten (kleine Abbildung). Links ist der Magnetfeldfluss und dessen Verstärkung an den Polen, durch sinkendes Plasma dargestellt.

Laut NASA benötigt das Plasma im Convoyer Belt für einen Umlauf ca. 40 Jahre. Wegen der größeren Dichte und dem geringeren Radius sind die Radialbeschleunigungen an der unteren Konvektionszone, also an der Unterseite des Conveyor Belt geringer als in den oberen Zonen, so dass im Plasma unterschiedliche Driftströmungen entstehen, an deren Grenzschichten turbulente Reibung auftritt.

Nach der Potentialtheorie von Gauß kann ein flüssiges Medium nur dann eine Gleichgewichts-figur (beschreibt in der Astronomie einen flüssigen, stabilen Aufbau von Sternen, bei denen die inneren Grenzflächen, die jeweiligen Niveauflächen und die Oberfläche im Gleichgewicht aller Kräfte sind) ausbilden, wenn alle seine Niveauflächen jeweils die gleiche Dichte aufweisen. Eine Störung dieses Gleichgewichts, z.B. durch die Temperatur, Gravitation oder Magnetfelddichte hat seitliche oder vertikale Plasmabewegungen zur Folge, weil Plasmateilchen verschiedener Dichte nicht nebeneinander bleiben können. Dies bewirkt eine Korkenzieherströmung, ähnlich wie in einer Ekman-Spirale und dadurch, eine Auftriebskomponente im Plasma. Das schnellere Plasma in den höheren Schichten zieht das darunter liegende, langsamere Plasma durch Reibung mit. Im Gegensatz zur Ekman-Spirale treibt nicht der Wind die Korkenzieherströmung (dort ist es das Meerwasser), sondern auf der Sonne, die zur Oberfläche zunehmenden Plasmageschwindigkeiten.

Abbildung 74: Ähnlich einer Ekman-Spirale kommt es im Sonnenplasma auf Grund der höheren Oberflächenströmung zu einer Korkenzieherströmung, die eine aufwärts gerichtete Komponente aufweist. Während auf dem Meer der Wind das Wasser durch Reibung hinter sich herzieht (was sich in den jeweiligen Grenzschichten im Wasser fort setzt), zieht die oberste (schnellere) Plasmaschicht die unteren durch Reibung hinter sich her. Die Corioliskraft lenkt das Plasma auf der Nordhalbkugel nach rechts und auf der Südhalbkugel nach links ab, wodurch die in der vorherigen Abbildung gezeigten unterschiedlichen Fließrichtungen des nördlichen- und südlichen Convoyer-Belt entstehen. Aufgrund der Corioliskraft dreht dabei die Richtung des Geschwindigkeitsvektors immer mehr nach rechts (nördliche Halbkugel).

An den Grenzschichten der “Korkenzieherströmung“ kommt es durch die Bewegungen im elektrisch leitfähigen Plasma zu örtlich stark ausgebildeten Magnetfeldern, die die Keime für Sonnenflecken sind. Da nördliches und südliches Convoyor-Belt über die Corioliskraft miteinander gekoppelt sind, kommt es zu der paarweise Ausbildung von Sonnenflecken mit einmal südlicher und einmal nördlicher Polarität. Je stärker die Korkenzieherströmung (mitziehen) ist, desto stärker die magnetische Aktivität und damit die Ausbildung von Sonnenflecken.

Da nach Dr. Landscheidt die Planeten und die Änderung des solaren Baryzentrums den Aktivitätszyklus der Sonne (mit) triggern, wäre dies eine Erklärung, warum es bei bestimmten Planetenkonstellationen zu solaren Aktivitätszyklen kommt. Durch den Antrieb der äußeren Plasmaschichten durch die Planeten kommt es zu einer Verstärkung der solaren Strömung, vorzugsweise in den oberen Sonnenschichten, was wiederum eine Verstärkung der Driftströmungen, damit der turbulenten Reibung und letztendlich der Korkenzieherströmung bewirkt und damit zu verstärkten Sonnenflecken führt.

Wegen der Viskosität sind in zähen Flüssigkeiten (tiefere Sonnenschichten) die Plasmateilchen stärker aneinander gebunden und damit unbeweglicher. Die innere Reibung ist dort stärker. Daher sollten Sonnenflecken vorzugsweise in den oberen Schichten der Sonne entstehen, weil hier die Plasmateilchen beweglicher und daher die Induktionsvorgänge größer sind.

Sollten die Angaben der NASA hinsichtlich der Umlaufzeit von ca. 40 Jahren zutreffen, käme es in der halben Zeit, also ca. alle 20 Jahre zu einem Richtungswechsel der Flussgeschwindigkeit, was nichts anderes darstellt als eine Polumkehr des Magnetfeldes. Die Polumkehr steht für den Hale-Zyklus der Sonne, dessen Länge beträgt im Mittel 22 Jahre, was mit den Beobachtungen der NASA am Convoyer-Belt im Einklang steht.

Abbildung 75: (Y. B. Du and P. Tong, J. Fluid Mech., 2000) zeigt Turbulenzen in konvektiven Strömungen, wie sie auch auf der Sonne durch aufsteigendes heißes Material entstehen (in der Abbildung sind wärmere Bereich grün/blau codiert). Zu diesen konvektiven Turbulenzen kommen auf der Sonne die Turbulenzen*) aufgrund der unterschiedlichen Umlaufgeschwindigkeiten im Plasma.

*) Zur mathematischen Beschreibung der Strömung in Fluiden dient die Eulersche Bewegungsgleichung, die Kontinuitätsgleichung und die Navier-Stokes-Gleichung für die Berücksichtigung der Reibung.

Abbildung 76, Quelle: UCAR, “Extended solar minimum linked to changes in Sun’s conveyor belt”, Mausumi Dikpati et al. vom 12.08.2010 (http://www2.ucar.edu/news/2354/extended-solar-minimum-linked-changes-sun-s-conveyor-belt) zeigt rechts die analysierte Fließrichtung, Fließgeschwindigkeit und Ausdehnung der Plasmaflüsse (Hauptrichtung) im Convoyer-Belt während dem 23. Sonnenzyklus. Dazu links zum Vergleich, die Plasmaflüsse während eines (vergleichsweise) kurzen solaren Zyklus. Da der Rücktransport des Plasma im 23. Zyklus länger war (rechts), ist davon auszugehen, dass der Hinflus auch länger ist, weil die Teilbereiche in der Konvektionszone noch miteinander verbunden sind, so dass der 24. Zyklus (jetzt längerer Weg für Hinflus zum Pol) lang und aktivitätsschwach ausfällt. Erst wenn sich die Teilbereiche wieder trennen, erhöht sich die magnetische solare Aktivität, d.h. es gibt dann immer zwei sehr schwache Zyklen. Dies würde z.B. die zwei schwachen Zyklen im Dalton-Minimum erklären. Bleiben hingegen die Bereiche länger miteinander verbunden, fallen die weiteren Sonnenzyklen aus, wie zuletzt im Maunder-Minimum.

Anhand dieser Theorie hat das Convoyer-Belt in einem langen Sonnenzyklus eine ausgedehntere Form, als in einem kurzen Sonnenzyklus und braucht dadurch länger für einen Umlauf und die Polumkehr, die einen neuen Sonnenzyklus einläutet, findet später statt. Da sich dadurch auch die innere Reibung erhöht, weil die Massen deutlich größer sind, wird der nächste Sonnenzyklus entsprechend der niederen Umlaufgeschwindigkeit des Plasmas schwächer ausfallen.

Insbesondere die Aufteilung des Convoyer-Belt in zwei Haupteinheiten während eines kurzen Sonnenzyklus erklärt auch, warum kurze Sonnenzyklen stärker als lange Zyklen sind. Die Umlaufgeschwindigkeit ist wegen der geringeren Masse größer und der Drehimpuls ist größer, ähnlich einem Eiskunstläufer, der seine Geschwindigkeit dadurch erhöht, indem er seine Arme an den Körper heranzieht. Hier sind die „Arme“, die Weite des Convoyer-Belts.

Die Aufteilung des Convoyer-Belts in 2 (in Abbildung 76 links sind zwei dargestellt) oder gar mehr Einheiten bestimmt die Stärke und Dauer des Sonnenzyklus, wobei die magnetische Aktivität zu beiden Seiten des Sonnenäquators umso stärker ist, je schneller die Plasmafließgeschwindigkeit ist. Sie steuert die Induktionsvorgänge im elektrisch leitfähigen Plasma, sowie den Magnetfluss. Über die Corioliskraft sind beide Felder (nördliche und südliche Sonnenflecken) direkt miteinander gekoppelt.

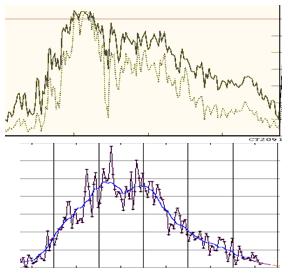

Die folgende Abbildung zeigt, wie die Aktivität der Mikroflares (Anzahl), die durch Umwandlung von Bewegungsenergie in magnetische Energie und anschließender Rekonnektion der Magnetfelder ausgelöst werden, synchron zum Sonnenzyklus verläuft.

Abbildung 77 zeigt die Anzahl der Mikroflares von 2002 – 2007, Quelle: ”X-ray Imaging & Spectral Statistics of Small Solar Flares Observed with RHESSI”, Iain G. Hannah et al. Space Sciences Laboratory, University of California, Berkeley. Das Maximum lag zum Jahreswechsel 2002/2003 und fällt mit der magnetischen Aktivität der Sonne zusammen und läuft der Sonnenfleckenaktivität ca. 2 Jahre nach. Deutlich ist zu sehen, dass mit abnehmender solarer Aktivität auch die Mikroflares abnehmen. Allerdings ist die Koronatemperatur Schwellwert-gesteuert. Was ist der Schalter für dieses Verhalten?

Zur Beantwortung der Frage muss zuerst geklärt werden, inwieweit der maßgebliche Heizmechanismus, die Nanoflares ebenfalls von der solaren Aktivität abhängen und, inwieweit, entgegen gesetzt zu den Mikroflares, diese über die gesamte Sonnenoberfläche auftreten.

Abbildung 78 (Quelle, siehe oben) zeigt die Verteilung der beobachteten Mikroflare über die Breiten- und Längengeraden. Während diese über die Längengeraden gleichmäßig verteilt sind, sind sie, wie die Sonnenflecken, vorzugsweise auf beiden Seiten des Äquators anzutreffen. Die Temperatur der Mikroflares lag dabei zwischen 10 und 16 Millionen Kelvin.

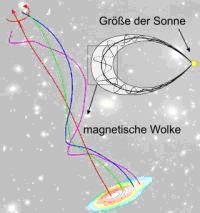

Zur Beantwortung wird ein Sonnenphänomen herangezogen, welches auf den vorherigen Seiten schon oft zu sehen war, aber noch nicht explizit angesprochen wurde. Es sind die Protuberanzen der Sonne. Dabei handelt es sich um kühle Materiewolken in der Sonnenatmosphäre, die Magnetfeldlinien folgen und oft eine bogenförmige Form ausweisen.

Sie sich vor der Sonnenoberfläche als mattes Gebilde ab, welches Filament genannt wird. Protuberanzen sind die größten Gebilde auf der Sonne. Die meisten sind jedoch klein.

Abbildung 79 zeigt die Sonne im ultravioletten Bereich am 30. März 2010. Links oben ist eine große, bogenförmige Protuberanz zu sehen. Über den ganzen Sonnenball sind kleine Protuberanzen verteilt, die wie zerzauste Watte in die Korona reichen. Die roten Bereiche sind mit bis zu 60.000 Kelvin vergleichsweise kühl, wogegen die grünen und blauen Bereiche Temperaturen größer 1 Million Kelvin aufweisen, Quelle: SDO/AIA. SDO (Solar Dynamics Observatory) ist die im Februar 2010 gestartete NASA-Sonnensonde und AIA (Atmospheric Imaging Assembly) ist das Messinstrument, welches die Vorgänge in der Sonnenatmosphäre aufzeichnet. Darüber hinaus trägt die Sonde das Messsystem HMI (Helioseismic and Magnetic Imager), mit dem Vorgänge im Sonneninnern aufgezeichnet werden und das Messsystem EVE (Extreme Ultraviolet Variability Instrument) zur Beobachtung der sehr kurzwelligen (<150 nm) UV-Strahlung.

Was haben nun kühle Protuberanzen, mit heißen Nanoflares zu tun, die als Koronaheizung gelten? Beide folgen Magnetfeldlinien der Sonne und in beiden wird Materie entlang der Magnetfeldlinien durch ein magnetisches Feld beschleunigt. Bei Nanoflares muss es darüber hinaus zu einer magnetischen Rekonnektion, mit explosionsartig freigesetzter Energie kommen. Eine Rekonnektion kann grundsätzlich überall dort auftreten, wo die magnetischen Feldlinien konzentriert werden und nicht unmittelbar ins Weltall entweichen. Also alle Stellen auf der Sonne, mit Ausnahme von solaren Löchern, da dort die Feldlinien ungehindert ins Weltall entweichen.

Wie das MPS ermittelte, sind die Ausgangszellen für Nanoflares die Bright Points auf der Sonne, die überall dort entstehen, wo die Sonnenoberfläche eine netzartige Struktur aufweist. Dies ist die gesamte Sonnenoberfläche. In ihr kommt es durch Konvektion und der größeren Umlaufgeschwindigkeit der oberen Konvektionszone zu einem ständigen Auftrieb von Plasma, welches bei Abkühlung an der Oberfläche, wieder absinkt.

Sollen Nanoflares die Hauptursache der Koronaheizung sein, müssen Bright Points mit der solaren Aktivität variieren, d.h. bei aktiver Sonne muss die Anzahl von Bright Points auf der Sonnenoberfläche stark zunehmen und zwar, setzt die Koronaturboheizung ein, sprunghaft zunehmen. Die folgende Abbildung zeigt die Anzahl von Bright Points bei ruhiger Sonne.

Abbildung 80 zeigt magnetische Bright Points auf der ruhigen Sonne vom September 2007, Quelle: (http://apod.nasa.gov/apod/ap100416.html). Der weiße Balken kennzeichnet eine Länge von 5.000 km.

Da MBPs erst 1999 entdeckt wurden, gibt es derzeit noch keine Zeitreihe über ihr Auftreten im Schwabe-Zyklus (dem Autor sind keine bekannt), so dass sich anhand von Einzelaufnahmen, an die Antwort, inwieweit sie direkt proportional zur solaren Aktivität auftreten, herangetastet wird. Hier wird die Arbeit von R. Ishikawa et al., 2007 “Relationship between magnetic foot points and G-band bright structures“ herangezogen. Aus der Arbeit stammen die folgenden Abbildungen.

Abbildung 81 zeigt den Bereich zwischen zwei Sonnenflecken am 09. Juli 2005 bei aktiver Sonne. Der Rechteckbereich wird in der Arbeit auf MBPs untersucht.

Abbildung 82 links zeigt den markierten Ausschnitt aus der vorherigen Abbildung zwischen zwei Sonnenflecken, also einer aktiven Region. In der Abbildung rechts wurden die MBPs eingetragen. Es zeigt sich, dass deren Anzahl gegenüber der Abbildung auf der vorherigen Seite (ruhige Sonne) stark erhöht ist. Nach vorsichtiger Schätzung um den Faktor 2. Arcsec ist die Winkeleinheit (1/3600°) des beobachteten Radius der Sonnenoberfläche. Bei einem Sonnendurchmesser von 1.391.400 km sind 1 arcsec ≈ 1.200 km.

Die Datenvergleiche deuten darauf hin, dass in aktiven Regionen der Sonne und dann auch allgemein bei aktiver Sonne, die Anzahl der MBPs deutlich ansteigt. Der Autor geht davon aus, dass mit Beginn eines solaren Zyklus, wenn die Koronaturboheizung sozusagen einschaltet und die Koronatemperatur nahezu verdoppelt wird, MBPs und damit Nanoflares sprunghaft ansteigen.

Wissenschaftler der Universität Göttingen um Prof. Eberhard Wiehr und Prof. Burkart Bovelet ist es gelungen, die Anzahl der kleinräumigen magnetischen Gebilde auf der gesamten Sonnenoberfläche zu bestimmen, “The quiet Sun’s magnetic flux estimated from Ca II H bright inter-granular G-band structures“, Astronomy & Astrophysics, DOI: 10.1051/0004-6361:200809717. Die Forscher nutzten für ihre Untersuchungen das blaue Licht des Kohlen-wasserstoff-Moleküls (CH) und das violette Licht des einfach ionisierten Kalziums (Ca+). In deren Spektralbereichen leuchten die kleinen Magnetfeldgebiete heller als ihre Umgebung.

Abbildung 83 links zeigt das Magnetogramm der Sonne während dem Aktivitätsmaximum im 23. Zyklus und daneben während dem Minimum im November 2007. Die magnetische Aktivität ist als hell (Nordpol)/dunkel (Südpol)-Schema abgebildet. Während dem Minimum zeigt sich eine feinkörnige Struktur. Das Rechteck zeigt das Beobachtungsgebiet, Quelle: scinexx vom 05.09.2008.

Abbildung 84 stammt von der frei zugänglichen Homepage von Prof. Wiehr und wurde während des Sonnenminimums in 2007 aufgenommen, Text: “Der 108000 km mal 85000 km grosser Ausschnitt der Sonnenscheibenmitte im im Lichte der H-alpha Linie; mit den rund 3000 identifizierten kleinräumigen Magnetgebieten, die im G-band hellen (‚bright points‘) sind blau, die schwachleuchtenden, bisher kaum zu identifizierenden gelb markiert. Die blauen finden sich an den Fusspunkten der dunklen H-alpha-Fibrillen, die die Netzwerkraumränder markieren, die gelben auch im Inter-Netzwerk.“

Die Forscher kommen anhand der Hochrechnung des beobachteten Gebiets auf die gesamte Sonnenoberfläche auf mindestens 660.000 magnetische Objekte im solaren Minimum, wobei die Anzahl deutlich höher sein kann. Liegen Regionen unterschiedlicher magnetischer Polarität sehr nahe beieinander, so löschen sie sich gegenseitig aus, bzw. liegen unter der Nachweisgrenze des MDI-Messsystem (Michelson Doppler Imager).

Noch nicht beantwortet ist die Frage, warum bei einem Wechsel des polaren Feldes, zum einen, der neue Sonnenzyklus beginnt, die Koronaturboheizung eingeschaltet wird und zum anderen, das Maximum im solaren Zyklus erreicht ist und dann die Sonnenaktivität zurückgeht?

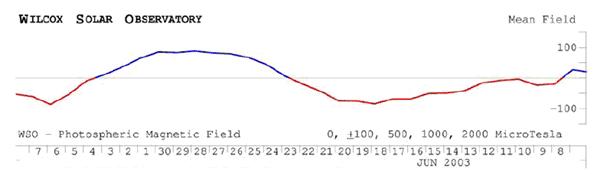

Abbildung 85 zeigt das Polarfeld (grün) und den Total Flux (schwarz) der Sonne von 1976 – 2009, Quelle: MPG. An den blau gestrichelten Linien dreht jeweils das Polarfeld. Dazu hat der Autor die Zeitabstände markiert, nach denen der solare Zyklus dreht. Wie zu sehen, dreht der solare Zyklus jeweils nach exakten Zeiten und zwar nach ca. 1 ½ Jahr. Dreht beispielsweise das Polarfeld in Max, so beginnt im Betrachtungszeitraum immer nach 1 ½ Jahren der neue Sonnenzyklus. Wechselt dagegen das Polarfeld im Minimum, so erreicht der solaren Zyklus jeweils nach ca. 1 ½ Jahren sein Maximum und beginnt dann zu fallen.

Inwieweit hat das Polarfeld Einfluss auf die Koronaturboheizung und damit letztendlich auf die solare Aktivität schlecht hin? Ist sie auch zeitgesteuert, wie beim Total Flux des Schwabe-Zyklus? Aus rein theoretischen Gründen sollte sie, da die Koronaheizung von den kleinsten magnetischen Einheiten, den MBPs und Nanoflares abhängt, nicht zeitgesteuert, sondern, über die Fließgeschwindigkeit im Plasma, schwellengesteuert sein. Diese theoretische Betrachtung soll anhand der obigen Abbildung des Polarfeldes überprüft werden.

Abbildung 86 oben, Polarfeld nach MPG. Mitte, der TSI nach PMOD mit den Trennlinien zwischen den Zyklen und darunter die Koronatemperatur. Da diese Zeitreihe erst 1991 beginnt, wurde sie über den Zeitraum rekonstruiert, wobei die Zeitblöcke (grüne Rechtecke) in denen die Koronaturboheizung auf low ist, gleich gehalten wurden. Die roten Linien geben den Zeitpunkt an, an denen jeweils die Koronaturboheizung einschaltet. Die schwarzen Linien den Zeitpunkt, an denen das Polarfeld im Maximum dreht.

Aus Abbildung 86 wird ersichtlich, dass es keinen zeitlichen Zusammenhang (rote Rechtecke) zwischen Polarfeld (überschreiten Maximum) und dem einschalten der Koronaturboheizung gibt. Die Zeitspanne variiert im Betrachtungszeitraum zwischen 1 ¼ und 3 Jahren. Wird dagegen der Schwellwert betrachtet, wann die Datenreihe des Polarfeldes jeweils die rote Linie, die für den Zeitpunkt des Einschaltens der Koronaturboheizung steht, schneidet, so ist festzustellen, dass jeweils nach demselben Hub (Höhe – weiße, schmale Rechtecke) die Koronaturboheizung einschaltet. Wie sind diese Erkenntnisse in die Vorgänge in der Konvektionszone einzuordnen?

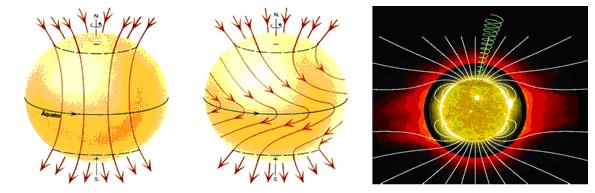

Abbildung 87 links zeigt die Sonne im solaren Minimum und gut sichtbar, das magnetische Dipolfeld und Polarfeld der Sonne. Abbildung Mitte zeigt Stärke (farbcodiert) des Toroidalfeldes und Feldlinienverlauf des Polarfelds der Sonne (Quelle: “Understanding the Space Environment with GOES-R Solar and Space Environment Data”, Hill/Singer et al.) und rechts ist das solare Magnetfeld im Sonnenmaximum zu sehen und wie dort das Polarfeld verschwunden ist, was mit der Datenreihe des Polarfeldes von der MPG übereinstimmt.

Die Abbildungen auf der vorherigen Seite zeigen deutlich, dass das Polarfeld sozusagen der Schalter ist, mit der die solaren Aktivität im Schwabe-Zyklus ein- bzw. ausgeschaltet wird, sowie die Koronaturboheizung ein- und ausgeschaltet wird. Aus was besteht dieser Schalter? Hierzu ist es notwendig, nochmals die Abbildung 76 zu betrachten.

Ist das Polarfeld im Maximum (ruhige Sonne), so ist die Dynamik im Conoyer-Belt (Konvektionszone), die für die variable magnetische Sonnenaktivität verantwortlich ist, am geringsten, so dass sich das Dipolfeld und Polarfeld der Sonne entfalten kann, da es nur wenig aus der magnetischen Aktivität des Toroidalfeldes überlagert ist. Beginnen sich die Plasmamassen im Convoyer-Belt zu beschleunigen, nimmt das Toroidalfeld der Sonne wieder zu, was zur Schwächung des Polarfeldes führt. Durch die Bewegung elektrisch leitfähiger Massen, werden Ströme induziert, die in der Sonne bis zu 1.000 Milliarden Ampere betragen.

Diese Ströme tragen große Magnetfelder mit sich, wobei die Stromstärke direkt proportional zur Geschwindigkeit ist. Ab einem bestimmten Bewegungswert kommt es zu einem Lawineneffekt – die Ströme lösen schlagartig magnetische Induktionsvorgänge aus, die dazu führen, dass der im Convoyer-Belt gespeicherte Magnetfluss über die MBPs aus der Sonnenoberfläche austritt. Da die MBPs die Regionen sind, in denen durch Relativbewegungen zwischen den Granulen, der magnetische Fluss erhöht und der magnetische Widerstand bereits reduziert ist, tritt an diesen Stelle das Magnetfeld aus, wodurch sich schlagartig die MBPs und damit die Aktivität der Nanoflares erhöht und die Korona ihre Temperatur verdoppelt. Die magnetische Energie kann nicht weiter im Plasma der Konvektionszone gespeichert werden und sucht sich den Weg über den geringsten magnetischen Widerstand an die Oberfläche.

Bei den in der Zeitreihe der Koronatemperatur zu sehenden gegenläufigen Spitzen könnte es sich um Mitzieheffekte in der unteren Zone des Convoyer-Belts handeln (folgende Abbildung).

In der Abbildung 88 der Koronatemperaturdatenreihe sind die beiden entgegen gesetzten Phasen mit einem Pfeil gekennzeichnet. Hier verhält sich die Koronatemperatur genau entgegen gesetzt zu ihrem Zyklus. Dies ist jeweils nach Max und Min (rote und blaue Linie) im Polarfeld und zwar in exakten Zeitabständen dazu. Da die beiden darauf folgenden Zeitabschnitte exakt identisch sind (graue Rechtecke) geht der Autor davon aus, dass es sich dabei um Mitzieh- und Bremseffekte der oberen und unteren Konvektionszone handelt.

Wie bereits behandelt, haben obere und untere Zone im Convoyer-Belt unterschiedliche Geschwindigkeiten, wobei die untere Schicht langsamer ist, wodurch die obere, der unteren vorauseilt. Dadurch entstehen Turbolenzen und ein uneinheitliches Fließbild im Plasma, ähnlich der folgenden Abbildung.

Abbildung 89 zeigt eine Kármán-Wirbelstraße. An einem Hindernis (links) wird die laminare Strömung gebrochen, dadurch kommt es zu links und rechtsdrehenden Wirbeln, die immer mehr Turbolenzen nach sich ziehen (S.d.W. 04/09, S. 79). In der Konvektionszone handelt es sich nicht um feste Hindernisse, sondern um Plasmamassen unterschiedlicher Geschwindigkeit, ähnlich wie auf dem Gasplaneten Jupiter.

Abbildung 90: Der große rote Fleck des Jupiters, bei dem es sich um einen gewaltigen atmosphärischen Wirbelsturm handelt, wirkt auf die umfließenden Luftmassen wie ein Hindernis, an dem sich eine Kármán-Wirbelstraße ausbildet. Zu diesen in der Fließmasse befindlichen Turbolenzen, mit ihren unterschiedlichen Richtungsvektoren, kommt es an den Umkehrpunkten der Hauptfließrichtungen (Polen) unweigerlich dazu, dass die Bewegungsvektoren der beiden Schichten entgegen stehen. Dies ist immer kurz nach einem Wechsel im polaren Feld der Fall. Als Folge kommt es zu einem „Kurzschluss“ in den Induktionsvorgängen (schlagartige Änderung der Stromrichtung). Eine schlagartige Flussänder-ung, die dies als Folge hat, führt immer zu einem Induktionsvorgang in entgegen gesetzter Richtung (Lenz´sche Regel), was die Ausschläge kennzeichnen. Sind danach die elektrischen Hauptstromflüsse wieder gleich, wird der vorherige Zustand wieder eingenommen.

Einen wesentlichen Faktor zum Verstehen der solaren Aktivität und damit des Erdklimas stellt also die Korona, die äußere Sonnenatmosphäre dar. Das Verständnis der Sonne ist somit die Voraussetzung zum Verständnis des irdischen Klimas, wie noch gezeigt werden wird. Der Einblick in die Grundlagen dient dazu, die Aktivitätsschwankungen der Sonne verstehen zu können und damit den alleinigen Einfluss der Sonne auf unser Klima.

Die Sonne ist ein komplexes, hoch dynamisches Gebilde, so dass die im Vorwort erwähnte IPCC-Einstufung, ihre Aktivität wäre in den letzten Jahrzehnten, gar den letzten beiden Jahrhunderten (fast) statisch, absurd ist. Zu der hohen Dynamik in der Sonnenkorona, kommen weitere dynamische Prozesse, die in der Fortsetzung behandelt werden.

Raimund Leistenschneider – EIKE

Fortsetzung Teil 4b in Kürze

Übersicht über alle Teile:

Teil 1 – Die Sonne bestimmt den Temperaturgang

Teil 2 – Die Sonne, der faszinierende Stern

Teil 3 – Sonnenflecken und ihre Ursachen

Teil 4a – Die Sonnenatmosphäre, Korona, Heliosphärische Stromschicht,

interplanetares Magnetfeld

Teil 4b – Die Sonnenatmosphäre, Korona, Heliosphärische Stromschicht,

interplanetares Magnetfeld

Teil 5 – Die variable Sonne

Teil 6 – Der Einfluss der Sonne auf unser Wetter/Klima

Teil 7 – Der Einfluss der Sonne auf die Wolkenbedeckung über Svensmark hinaus

Teil 8 – Zukünftige Temperaturentwicklung und deren Schwankungen

![]()