Der CO2-Gehalt der Luft war in der geologischen Vergangenheit oft sehr viel höher als heute. Das war für die Biosphäre gut, denn CO2 ist der Grundbaustoff der Nahrungsmittel. Und weil das so ist, sollten wir einen weiteren CO2-Anstieg – so er dann stattfände – nicht fürchten sondern begrüßen: er würde das Pflanzenwachstum verstärken, was die Ernährung von immer mehr Menschen erleichtern wird. Was aber tun wir? CO2, der neben dem Wasser wichtigste Lebensbaustein, wird geächtet und durch Regierungsbeschluss und Absegnung durch das Parlament mittels CCS-Technologie unter die Erde verbannt, wodurch für das Leben auf der Erde ein erhebliches Gefahrenpotential entsteht. Der Treibhauseffekt, den der Mensch angeblich mit seiner CO2-Produktion verstärkt und damit den Klimawandel verursacht, wird von der Politik als Selbstverständlichkeit behandelt. Die Wissenschaft soll davon mehrheitlich überzeugt sein, und es sei nur eine Minderheit, die ihn aus wirtschaftlichen Interessen bestreite. Diesen falschen Behauptungen muss widersprochen werden.

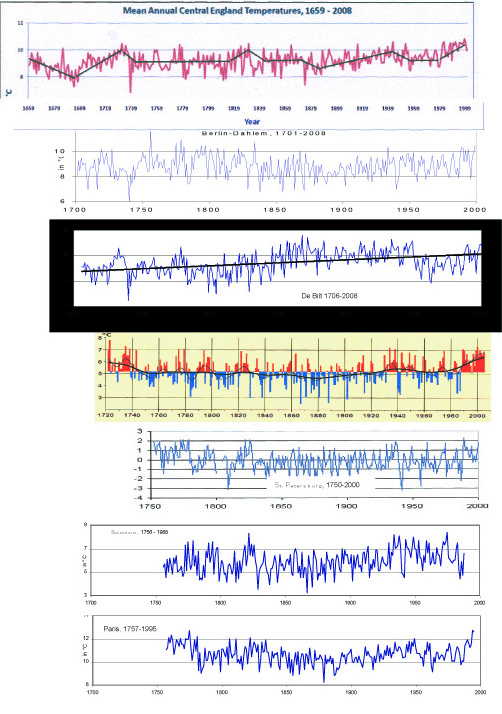

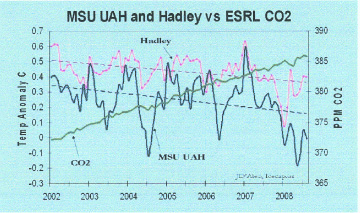

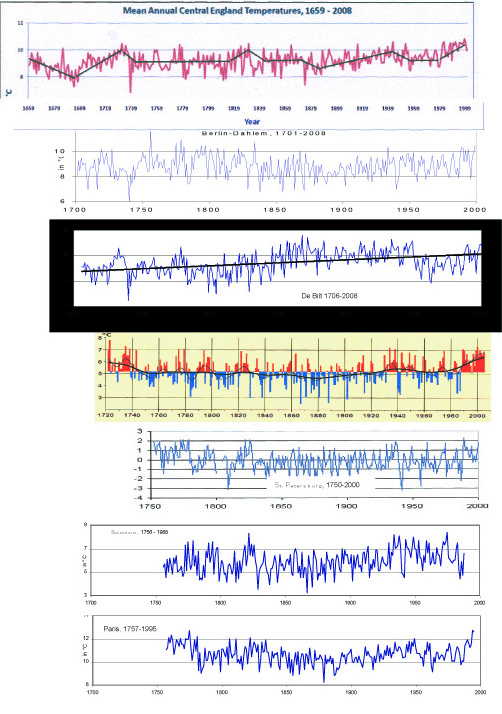

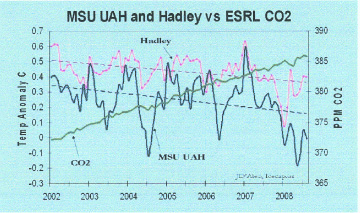

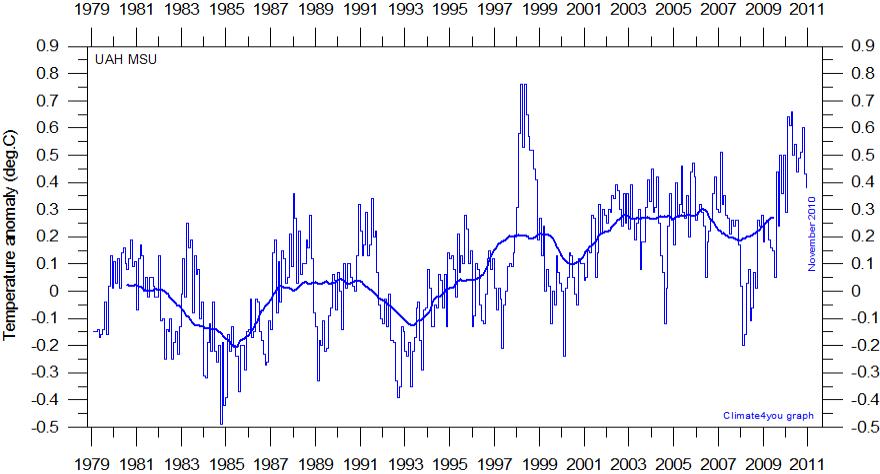

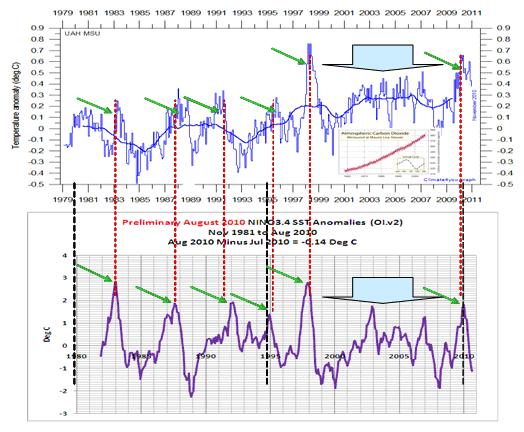

Wenn anthropogenes CO2 mittels verstärktem Treibhauseffekt die Erderwärmung beschleunigen würde, müsste man das auf der Erde merken und messen können. Man kann es nicht, wie die Fakten belegen: Die Ganglinien der realen Temperaturmessungen in Anlage 1 demonstrieren beispielhaft, dass die Erwärmungen im vorindustriellen Zeitalter zum Teil stärker waren und schneller erfolgten als seit 1950, als wir begannen, mehr Kohle, Öl und Gas zu verbrennen und damit CO2 zu produzieren und in die Luft zu entlassen. Statt einer verstärkten Erwärmung, die das CO2 hätte bewirken sollen, folgte bis 1980 eine Abkühlung, die sich nach einer ca. 15 Jahre andauernden zwischenzeitlichen Warmphase schon ab etwa 1998 wieder fortsetzt. Die Mehrheit der Stationen meldet eine neue Abkühlung, der CO2-Gehalt steigt gegenwärtig trotzdem noch an (Anlage 2). Dass die Wissenschaft mehrheitlich von dem Modell – mehr CO2 beschleunigt die Erwärmung, die wiederum lässt den CO2-Gehalt weiter steigen – überzeugt ist, stimmt nicht, wie man mit den Stichwörtern CO2-Lüge oder Klimaschwindel oder Klimalüge schnell ergoogeln kann. Die Medien unterstützen mit Bildern diesen Zeitgeist nach Kräften: Grauer Smog über Städten, weiße Wolken aus Kühltürmen, schwarzer Rauch aus Schornsteinen sollen die Gefahr CO2 illustrieren! CO2 ist bekanntlich unsichtbar und geruchlos! Wir atmen CO2 ständig ein und aus – kann man es sehen? Nur Fehlanzeige oder bewusste Indoktrination?

Wer als interessierter Laie die öffentliche Diskussion zur Bedeutung des CO2 für unser Klima verfolgt, muss den Eindruck gewinnen, als hätte es einen großen Anteil an der Atmosphäre und wäre außerordentlich wirksam. Er ist in der Regel überrascht, wenn ihm die Zusammensetzung der Luft erläutert wird, dass sie nämlich zu 78% aus Stickstoff und 21% aus Sauerstoff besteht, und dass CO2 neben den anderen Spurengasen nur einen sehr kleinen Anteil hat. In der geologischen Vergangenheit war der Anteil von CO2 wesentlich größer, und unabhängig davon wechselten Warm-, Kalt- und Eiszeiten miteinander ab. Der CO2-Gehalt ist variabel und nimmt gegenwärtig zu: für 2011 wird sein Anteil mit 0,039 % (= 390 ppm) angegeben. Er ändert sich von Natur aus immer, weil die oberirdischen Vulkane und untermeerischen Förderschlote mal mehr, mal weniger CO2 liefern, weil die Ozeane mal mehr, mal weniger absorbieren oder wieder emittieren, und weil die Pflanzen und Tiere der Biosphäre je nach dem sich immer ändernden Klima mal mehr, mal weniger aufnehmen, um sich zu ernähren und nach ihrem Absterben durch die Verwesung wieder in die Luft entlassen.

CO2 befindet sich in einem Naturkreislauf, der gegenwärtig ca. 210 Gt/a C (Gt/a C – Gigatonnen Kohlenstoff im Jahr) beinhaltet. An diesem Kreislauf ist auch der Mensch durch seine Ernährung und Atmung – und seit einigen Jahrzehnten auch durch seine Industrie – beteiligt, und zwar mit etwa 10 Gt/a C, kaum 5% der vorgenannten Gesamtmenge. Der Anteil Deutschlands an den 5% beträgt derzeit ca. 3%, mit abnehmender Tendenz.

Die CO2-Konzentration der Luft wächst gegenwärtig jährlich mit ca. 0,0002% (2 ppm). Sie stammen teils aus unseren Emissionen, teils aus natürlichen Quellen, wie schon erwähnt. Der CO2-Gehalt der Luft und der Ozeane unterliegt mehreren Gleichgewichten: beispielsweise tritt CO2 aus den Ozeanen in die Atmosphäre über, oder wird von einer wachsenden Biosphäre zusätzlich aufgenommen – oder freigesetzt. Diese Zustandsänderungen erfolgen mit unterschiedlich langer Verzögerung: wenn sich die Ozeane in vielen Jahren erwärmen, beginnt ihre Entgasung nach Jahrzehnten, und es braucht Jahrhunderte, bis sich das neue Gleichgewicht eingestellt hat. Diese Änderung wirkt sich auf andere Gleichgewichte aus – was bedeutet, dass praktisch nie ein Endzustand erreicht ist und immer „alles fließt“. Alle diese Prozesse können in diesem Rahmen nicht detailliert erläutert werden.

Wir kennen nur den CO2-Anteil, den wir selbst in die Luft entlassen, aber was wann daraus wird und was zusätzlich aus anderen Quellen hinzukommt oder von Verbrauchern wieder aufgenommen wird, ist unbekannt. Dazu ein Beispiel: Sehr viele Pflanzen und Tiere über und im Wasser sind mit CO2 unterversorgt – beispielsweise liegt das Optimum für Weizen bei ca. 1000 ppm; wenn also die Atmosphäre CO2 aufnimmt, kommt es seinem Wachstum zu Gute – und wird der Luft wieder entzogen. Gegenwärtig emittiert allein der Ätna täglich ca. 35.000 Tonnen CO2; wie viel das vor 100 Jahren war, ist unbekannt, und ob diese Menge zukünftig abnimmt oder zunimmt, ist nicht voraussagbar. Der Ätna ist gegenwärtig zwar der produktivste CO2-Lieferant, aber es gibt oberirdisch viele andere und auf dem Ozeanboden noch sehr viel mehr davon.

Die wechselvolle Erd- und Klimageschichte ist 4,5 Milliarden Jahre alt. Aus geologischer Sicht kann man nur staunen, wie schon Änderungen weniger Jahre Klimaforscher ermuntern, Modelle zu entwickeln, Berechnungen anzustellen und Voraussagen zu wagen – nicht nur zum CO2-Haushalt der Erde. Leider bleiben solche Szenarien keine akademischen Übungen, sondern werden publiziert, um von den Medien und der Politik propagandistisch instrumentalisiert zu werden.

Nach der Empfehlung des IPCC und des WBGU soll die Globaltemperatur um nicht mehr als 2°C ansteigen, anderenfalls wären Klimakatastrophen nicht mehr zu verhindern. Die Fakten beweisen, dass dieses ‚2°-Ziel’ der Politik „unsinnig“ ist, wie schon 2009 die Leiter des Geoforschungszentrums Potsdam, des Alfred-Wegener-Instituts Bremerhaven und des Senckenberg-Museums Frankfurt/Main (Prof. Dr, Hüttl, Prof. Dr. Lochte, Prof. Dr. Moosbrugger) als führende geowissenschaftliche Forschungsinstitute Deutschlands in einem gemeinsamen Interview begründet und geurteilt haben.

Es ist wichtig zu wissen, dass CO2 nicht schädlich oder gar giftig ist, wie oft zu lesen und zu hören ist – und wie Schulkinder lernen müssen. Tatsächlich ist CO2 so wenig giftig wie Wasser; es ist nur schwerer als Luft, und in einer CO2-gefüllten Mulde fehlt, wie unter Wasser, die Luft zum Atmen. Wasser kann man sehen, und man nimmt sich in acht. Das CO2 ist jedoch unsichtbar, und in abflusslosen Mulden kann es eine Todesfalle sein. Deshalb gibt es Erstickungsunfälle, nicht selten mit schlimmen Folgen, wie Anlage 3 zeigt: ein CO2-Ausbruch forderte in Kamerun 1700 Todesopfer. CO2-Ausbrüche können sehr gefährlich sein, und deshalb ist die CCS-Technologie äußerst riskant, vor allem natürlich in dicht bewohnten Gebieten.

Wie fehlgeleitet der WBGU handelt, wird klar, wenn man sich mit der Frage ‚Dekarbonisierung‘ – ‚Entkohlenstoffung‘ seriös befasst. Beim WBGU scheint keiner zu wissen – oder nicht berücksichtigen zu wollen, dass

1) unsere CO2-Produktion nur wenige Prozent des natürlichen CO2-Kreislaufes ausmacht, dass

2) CO2 die Grundlage des Lebens auf der Welt ist: mittels Photosynthese produzieren die Pflanzen aus CO2 und Wasser den Grundbaustoff aller Nahrungsmittel, und Pflanzen und viele Tierarten benötigen CO2, um Holz und Skelette bilden zu können, so wie auch unser Körper zu 9% aus Kohlenstoff besteht; dass

3) der CO2-Gehalt der Atmosphäre in der geologischen Vergangenheit sehr viel höher war als heute, was der Biosphäre gut bekommen ist; dass

4) es trotz dieser sehr viel höheren CO2-Gehalte Eiszeiten gegeben hat, deren Gletscher bis zum 38. Breitengrad reichten, dass sich

5) die Produktivität unserer Pflanzenwelt, einschließlich der Getreidesorten, mit einem höheren CO2-Gehalt der Atmosphäre verbessert, weshalb Treibhäuser mit CO2 begast werden, dass

6) die Annahme, der Klimawandel werde durch uns verursacht, nie bewiesen wurde bzw. nicht beweisbar ist und nur auf Klimasimulationsmodellen beruht, während die realen Temperaturmessungen klar das Gegenteil beweisen – wie die genannten Temperaturganglinien.

Der vom WBGU vorgeschlagene Weltklimavertrag basiert folglich auf einem Phantom. Dass völlig unrealistische Modelle nicht zum ersten Mal die Politik bestimmt haben, und dass Wissenschaftler diese schon zu allen Zeiten begründet und verteidigt haben, ist nicht neu – oft aus Existenzgründen, und nicht selten aus Eigennutz. Die bisherigen Diktaturen wurden auf diese Weise installiert – was sie angerichtet haben, ist bekannt. Die Realisierung eines Weltklimavertrages würde ebenfalls eine Diktatur erfordern – und der WBGU fühlt sich im Namen Deutschlands unbeschadet der von uns zu verantwortenden Katastrophen berufen, ihn zu konzipieren und der Weltöffentlichkeit über den UN-Sicherheitsrat anzudienen? Und diese Aktivitäten werden noch mit öffentlichen Geldern bezahlt!

Auf diesem Erkenntnishintergrund müssen die Gutachten des WBGU eingeordnet werden. Zum vorgeschlagenen Weltklimavertrag mit dem Ziel einer Dekarbonisierung könnten Zyniker sagen, diese Empfehlung ließe sich am leichtesten mit einem totalen Boykott der Nahrungsaufnahme erreichen – was allerdings ohne wesentlichen Effekt auf das Klima bliebe, denn selbst ein kollektiver Selbstmord der Erdbevölkerung würde die CO2-Bilanz der Erde nicht fühlbar beeinflussen.

In der Tat: beim Lesen der „Zusammenfassung für Entscheidungsträger“ wird besonders der durch Diktaturen sensibilisierte Leser von blankem Entsetzen gepackt. Haben die für geowissen-schaftliche Fragestellungen überwiegend unsachverständigen Mitglieder des Beirates die Konsequenzen des Weltklimavertrages zuende gedacht? Der Text lässt das nicht erkennen. Prof. Schellnhuber, der Vorsitzende des Beirates, hat in der Physical Review als Ergebnis seiner wissenschaftlichen Auswertung und Analyse von Klimadaten richtigerweise festgestellt, dass Anzeichen für eine Erwärmung der Atmosphäre nicht gefunden wurden – was impliziert, dass auch das CO2 bedeutungslos ist; Quelle und Zitat sind als Anlage 4 beigefügt. Auf welchem ethisch-moralischen Konzept und auf welcher Seriosität basiert dieser Beirat, wenn der Vorsitzende das Gegenteil seiner Arbeitsergebnisse zum Fundament seiner geopolitischen Schlussfolgerungen macht, d.h. das Phantom CO2 benutzt, um das Leben der Menschheit zu organisieren. Orientiert sich Herr Schellnhuber an Karl Marx?: „Die Philosophen haben die Welt nur verschieden interpretiert, es kommt darauf an, sie zu verändern“. Nach diesem Gebot ist für Veränderungen eine Ideologie zuständig, und deren Vertreter haben diese Entwicklungskette zu realisieren: „Die Partei organisiert den Klassenkampf und die Revolution – Im Besitz der Macht hat die Partei immer Recht, bestimmt, was Wissenschaft ist, und lässt ihr Politbüro den Aufbau einer humanen Gesellschaft planen.“

Für die Länder in einem ‚Sechstel der Erde’ wurde dieses Gesellschaftsmodell zwischen 1917 und 1950 Realität; der Versuch, für die Menschen eine bessere Welt zu schaffen, schlug fehl – die triste Praxis ist noch in Nordkorea zu besichtigen. Wo sich dagegen die Welt nach dem Prinzip Versuch und Irrtum in Wissenschaft, Technik und Wirtschaft entwickeln konnte, durften immer mehr Menschen zu einigermaßen akzeptablen Bedingungen leben – nicht ohne Fehler und Ungerechtigkeiten, aber ohne planende Instanz und Reglementierung, und vor allem ohne Gestapo und KZ und ohne KGB und GULAG. Hat die Bundesregierung als Auftraggeber des WGBU noch nicht verstanden, dass es höchste Zeit ist, die auf dem Phantom CO2-Einfluss gegründeten schlimmen Empfehlungen dahingehend zu prüfen, ob sie mit dem Grundgesetz vereinbar sind? Der WBGU wird aus öffentlichen Mitteln bezahlt, hat der Auftraggeber keine Pflicht zu kontrollieren? Da die Bundesregierung umsetzt, was IPCC und PIK einflüstern, besteht die Sorge zu recht, sie könnte auch seine Vorschläge zur Neuorganisierung der Welt befolgen. In diesem Falle wäre Artikel 20 des Grundgesetzes involviert, und hier besonders der Absatz 4:

(1) Die Bundesrepublik Deutschland ist ein demokratischer und sozialer Bundesstaat.

(2) Alle Staatsgewalt geht vom Volke aus. Sie wird vom Volke in Wahlen und Abstimmungen und durch besondere Organe der Gesetzgebung, der vollziehenden Gewalt und der Rechtsprechung ausgeübt.

(3) Die Gesetzgebung ist an die verfassungsmäßige Ordnung, die vollziehende Gewalt und die Rechtsprechung sind an Gesetz und Recht gebunden.

(4) Gegen jeden, der es unternimmt, diese Ordnung zu beseitigen, haben alle Deutschen das Recht zum Widerstand, wenn andere Abhilfe nicht möglich ist.

Warum wurde überhaupt eine durch den Treibhauseffekt des CO2 ausgelöste Erderwärmung angenommen? Zur Erinnerung: Wissenschaftler befürchteten während einer Abkühlungsphase in den späten 1970er Jahren noch eine neue Eiszeit! Wenige warme Sommer reichten aus, die Meinung zu ändern. Plötzlich wurde ein globaler Klimawandel befürchtet. Nur weil der Weltklimarat (IPCC) und bei uns das Potsdam Institut für Klimafolgenforschung (PIK) die Temperaturdaten erst ab 1860 berücksichtigten und die älteren Daten nicht zur Kenntnis nahmen, kam man wegen eines angeblich schnelleren Temperaturanstieges im 20. Jahrhundert auf den Gedanken, es gäbe eine vom Menschen verursachte ‚Erderwärmung’. Schon die Wahl dieses Begriffes demonstriert die eklatante Unkenntnis geophysikalischer Grundlagen: unter der Erdoberfläche steigt die Bodentemperatur, und je nach Klimaregion ist in wenigen 10 Metern Tiefe unter unserem Boden die mittlere Jahrestemperatur erreicht. Von dort wird es mit zunehmender Tiefe wärmer, und zwar mit durchschnittlich 3°C je 100m. Bis zum Mittelpunkt der Erde sind es dann noch 6378 km. Was immer CO2 bewirken kann – eine ‚Erderwärmung’ mit Sicherheit nicht.

Wie schon gesagt: Die Klima- und CO2-Geschichte der Erde ist 4,5 Mrd. Jahre alt. Wer die Entwicklung des Klimas auf der Grundlage der Daten von nur 130 Jahren beurteilt, kennt entweder die Klimageschichte nicht, vor allem die der letzten 1000 Jahre, oder handelt zweckbestimmt. Alte Wetterberichte, die 994 beginnen, verzeichnen für das Mittelalter besonders viele sehr heiße Jahre. Einige Beispiele (aus Das schöne Allgäu, Heft 4, 2007):

1185 – War der Winter so mild, dass im Mai das Getreide und im August der Wein reif waren.

1186 – Im Januar standen die Gärten in schönster Blüte, im Februar trugen die Apfelbäume

Früchte. Das Getreide reifte im Mai und im August die Trauben.

1229 – War wiederum ein sehr milder Winter. Zu Weihnachten blühten die Veilchen

1241 – Wurden im März bereits Kirschen auf den Märkten feilgeboten.

Bekanntlich wurde in dieser Zeit in Grönland Ackerbau betrieben und waren die Alpengletscher stark zurückgetaut. Weltweit war weniger Wasser im Eis gespeichert und der Meeresspiegel war einige Meter höher, was trockengefallene Korallenriffe beweisen: sie konnten bis zum früher höheren Meeresspiegel wachsen, reichen heute aber in vielen Regionen der Erde bis einige Meter darüber hinaus, weil sich der Meeresspiegel infolge globaler Abkühlung absenkte. Im Mittelalter war es also deutlich wärmer als in den letzten Jahrhunderten, einschließlich Gegenwart.

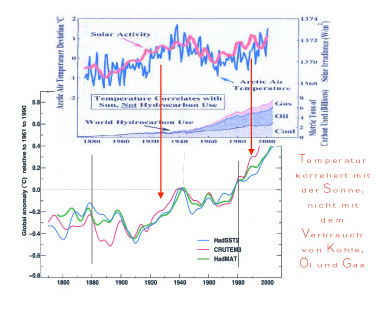

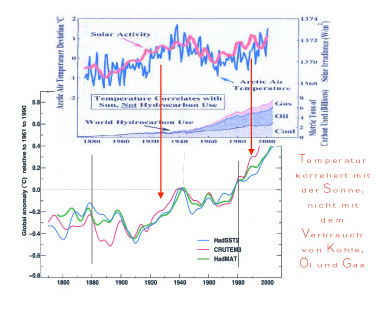

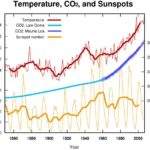

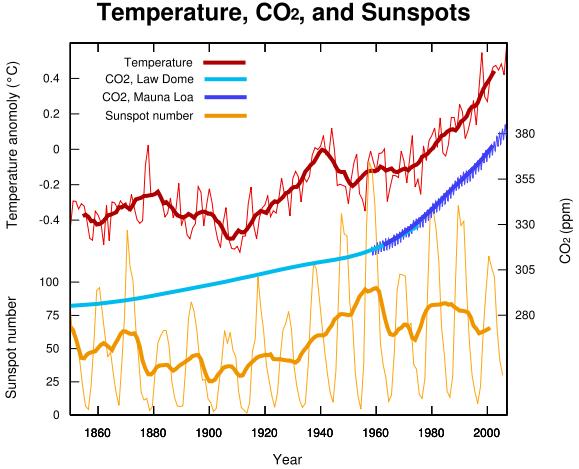

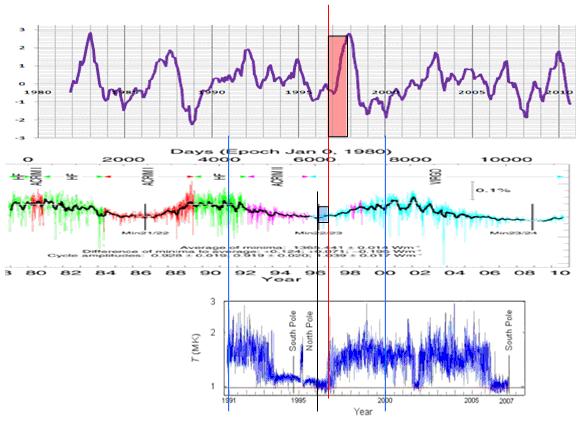

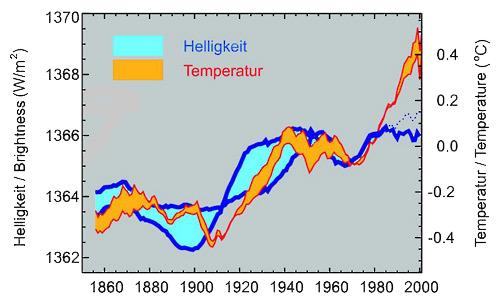

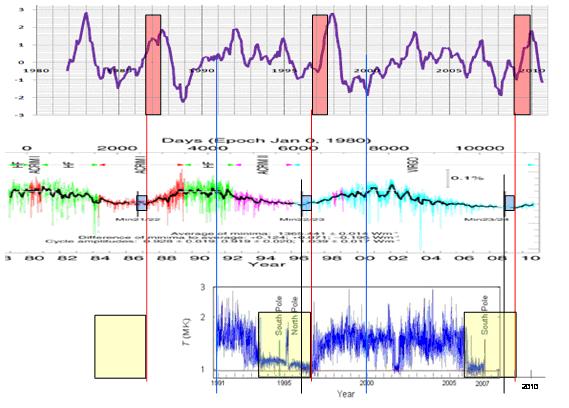

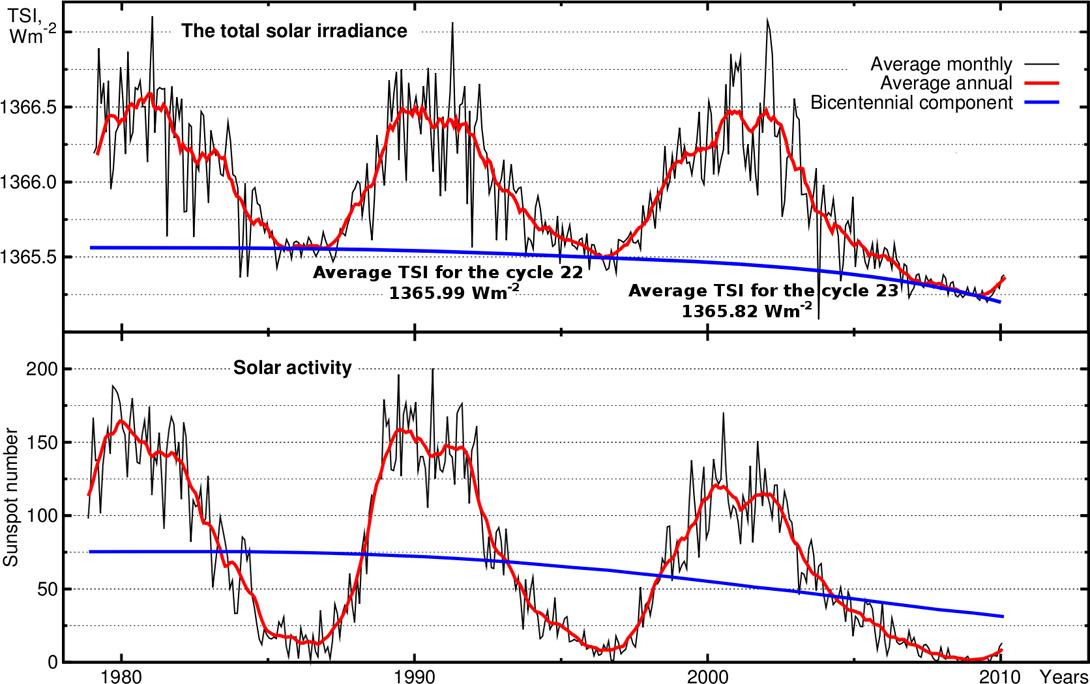

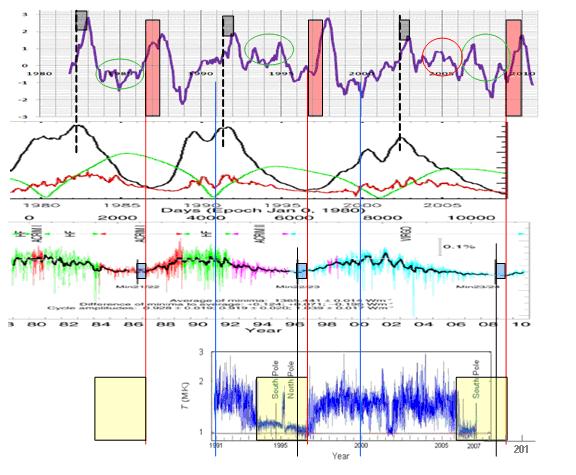

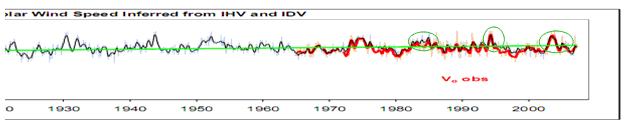

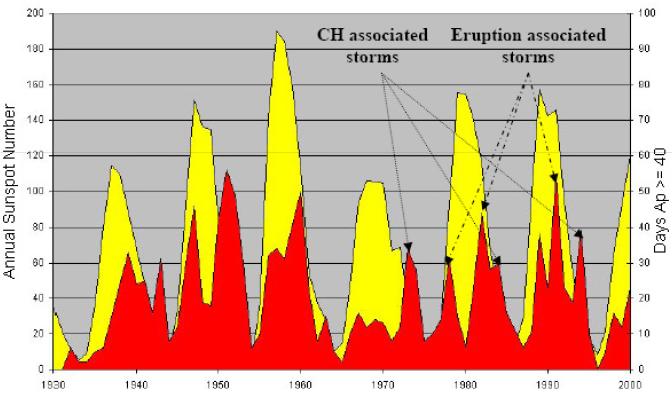

Mit exakten Messungen der Temperatur wurde 1659 begonnen. Die Langzeit-Temperaturreihen, die 1659 beginnen, zeigen wechselweise aufeinanderfolgende Abkühlungs- und Erwärmungsphasen von wenigen bis einigen Zehntel Grad an, wie die Beispiele in Anlage 1 zeigen. Ein wirklicher Klimawandel ist nicht zu erkennen, denn dazu müssten die Unterschiede mindestens einige Grad betragen. Die Temperaturschwankungen waren in der vorindustriellen Zeit oft stärker und erfolgten schneller, und damals spielte das von uns Menschen und der Industrie in die Luft entlassene („anthropogene“) CO2 noch keine Rolle. Außerdem: Die markante Erwärmungsphase zwischen 1920 und 1950 fand vor der vom Menschen verursachten Produktion von CO2 statt. Da die Ursache immer der Wirkung vorangeht, ist bewiesen, dass „unser CO2“ als Klimafaktor unbedeutend ist. Die Anlage 5 zeigt die der wechselnden Solaraktivität folgende Temperaturentwicklung und den Beginn des verstärkten Verbrauchs von Kohle, Öl und Gas; bei der Interpretation dieser Darstellung ist der unterschiedliche Maßstab der beiden Temperaturachsen zu berücksichtigen – die scheinbar starke Erwärmung im unteren Teil der Grafik wird dadurch erheblich kleiner.

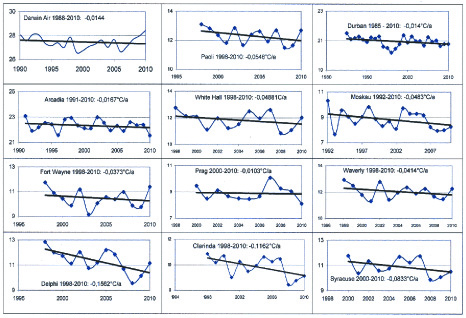

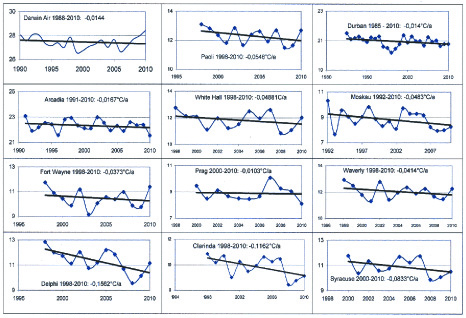

Das letzte Jahrzehnt war nicht das wärmste seit Beginn des Industriezeitalters, wie PIK behauptet, denn zwischen 1995 und 2005 hat in den meisten Regionen der Erde eine neue Abkühlungsphase begonnen, die noch andauert und zum Teil sehr kräftig ausfällt, wie die in Anlage 6 dargestellten Beispiele bezeugen.

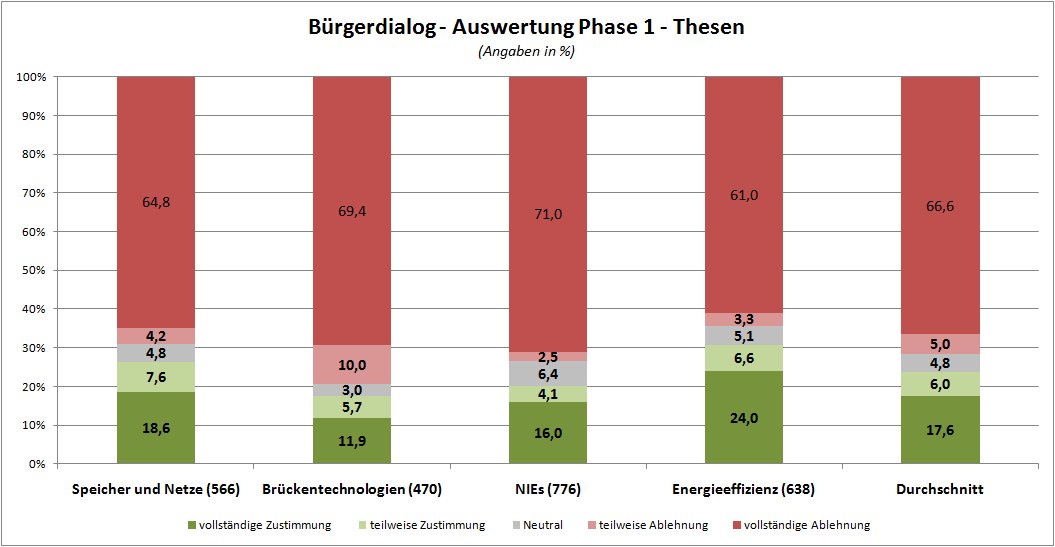

Ein vom Menschen verursachter Klimawandel wird nicht – wie in den Medien dargestellt – nur von einer Minderheit bestritten. Die Wirklichkeit ist umgekehrt. Es ist die absolute Mehrheit, die den Klimawandel bestreitet. In Deutschland weiß das allerdings kaum einer, weil selektiv und tendenziös berichtet wird. Dafür zwei Beispiele. ‚Selektiv’: 2009 fand in New York mit ca. 800 Teilnehmern, u.a. dem Tschechischen Staatspräsidenten und anerkannten Wissenschaftlern, eine Internationale Konferenz der Klimarealisten statt – bei uns konnte man darüber weder aus der Presse noch aus dem Radio oder Fernsehen irgend etwas erfahren, es wurde totgeschwiegen. ‚Tendenziös’: Die öffentlich-rechtlichen Medien gefallen sich vielmehr darin, mit Horrorszenen einen vom Menschen verursachten Klimawandel zu suggerieren, zuletzt noch z. B. die „Neue Westfälische“. Sie überschreibt am 13.07.2011 ihren Hauptartikel auf Seite 2: „Die Natur schlägt teuer zurück“ und illustriert das auf einer Weltkarte mit Erdbeben, Tsunami, Überschwemmungen etc. Damit schlägt die Natur nicht zurück, denn Erdbeben etc. verursachen weder wir noch das Klima – der Vulkanausbruch auf der indonesischen Insel Sulawesi demonstriert das gerade. Dass Schäden, auch Versicherungsschäden, größer werden, ist eine Folge der wachsenden Bevölkerung, falscher Besiedlung und Bauweisen und haarsträubender Umweltschäden. Dagegen lassen sich z. B. mit einem angemessenen Deichbau Opfer vermeiden, auch in Pakistan.

Dem aufmerksamen und kritischen Beobachter drängen sich demgegenüber wirtschaftliche Interessen der Agitatoren für Klimawandel und Klimaschutz auf. Das IPPC hat in einem seiner frühen Berichte festgestellt, dass das Wetter ein nicht-linearer chaotischer Prozess ist, der keine Voraussagen für die Entwicklung des Klimas erlaubt. Das stimmt! Demzufolge erforschen IPCC, PIK und andere Institutionen die zukünftigen Folgen von etwas, was man nicht voraussagen kann. In logischer Konsequenz dieser Erkenntnis hätten diese Institutionen ihre Tätigkeit einstellen müssen. Statt dessen blüht die Erstellung von Computer-Szenarien – eine dem Computer-Zeitalter angepasste Art von Alchemie. Wer hat davon Vorteile? Klimawandel-Bürokratie und Klimawandel-Forschung sind Institutionen, die mit Voraussagen für eine nichtvoraussagbare Zukunft dafür sorgen, dass ihnen die Arbeit nicht ausgeht, mit der sie auf Kosten der Steuerzahler gut leben. In den letzten Jahrzehnten hat man gelernt, dass man im Wege des Klimawandel-Konferenztourismus auf komfortable und einträgliche Weise die Welt kennen lernen kann. Und schließlich hat sich eine Industrie etabliert, die mit sog. Klimaschutz gut verdient.

Das von der EU wie ein Staatsziel beschlossene CCS-Projekt beruht also auf einem Phantom, denn erstens gibt es den globalen Klimawandel nicht, und zweitens hat das CO2 auf das Klima keinen merkbaren Einfluss – jedenfalls lassen die aus den Langzeit-Temperaturreihen hergestellten Ganglinien keinen Einfluss erkennen – oder: die gegenwärtige Temperaturentwicklung unterscheidet sich nicht von der in der vorindustriellen Zeit (Anlage 1). Das CCS-Projekt ist also völlig unnütz, und auch noch kontraproduktiv: Es ist unnütz, weil es keine Wirkung haben kann; und es ist kontraproduktiv, weil es nicht zur besseren Nutzung der Primärenergien führt, sondern im Gegenteil die nutzbare Energieausbeute der Kohle- und Gaskraftwerke verringert, denn die Abtrennung und Verflüssigung des CO2 sowie der Bau von Leitungen und Anlagen ist aufwendig. Was aber noch wichtiger ist und entscheidend sein sollte, ist sein mögliches Risikopotential: Wenn man CO2 mit dem beabsichtigten hohen Druck von 250 bar in geschichteten Fels einpresst, können durch den Druck noch geschlossene Schicht- und Kluftflächen aufgepresst werden (Anlage 7). Das CO2 steigt dann bis zur Erdoberfläche auf, tritt dort aus und kann sich in Geländemulden sammeln, weil es schwerer als Luft ist. Das ist gefährlich, denn CO2 ist geruchlos, wird deshalb nicht bemerkt und kann zu Erstickungsunfällen führen. Eine andere Gefahr besteht, wenn man es in großen Mengen – anders machte der technische Aufwand keinen Sinn – in einen Felsuntergrund mit einer dichten Zwischenschicht einpresst. Es könnte zwar zunächst nicht entweichen, würde aber den Spannungszustand und damit die Stabilität gegen Erdbeben verändern. Schließlich kann das Grundwasser chemisch beeinträchtigt werden, wenn das CO2 in ein chemisch reagierendes Gestein eingepresst wird. Das CCS-Projekt ist nur dann anwendbar, wenn man das CO2 in entleerte Erdgaslagerstätten gepumpt werden kann.

Der CO2-Gehalt der Atmosphäre war erdgeschichtlich gesehen selten so niedrig wie gegenwärtig. Warum soll also ein etwas höherer CO2-Gehalt schädlich sein? So wie jetzt schon Treibhäuser mit CO2 begast werden, wäre ein größerer CO2-Gehalt der Atmosphäre wünschenswert, um das Pflanzenwachstum zu fördern, denn immer mehr Menschen brauchen mehr Nahrungsmittel, und für ihre Bildung benötigt die Pflanze CO2 – das Klima wird dadurch nicht verändert. Wir müssen die Umwelt schützen, das Klima wird von der Sonne bestimmt!

Die in Deutschland beschlossenen und noch konzipierten Maßnahmen zum angeblichen Klimaschutz und die völlige Umgestaltung der Energiewirtschaft kosten Hunderte von Milliarden – und wahrscheinlich mehr – niemand kann das heute zuverlässig abschätzen. Sie sind bar jeder sachlich begründbaren Vernunft. Das globale Klima können wir nicht schützen, das bestimmt seit 4,5 Mrd. Jahren die Sonne. Was wir aber dringend brauchen und erreichen können – und müssen, ist Umweltschutz! Und darin sollte investiert werden – beispielsweise in erdbebensichere Bauweisen, Deichbau gegen Überschwemmungen, die Vermeidung der Bebauung von Hanglagen, die bei größeren Niederschlägen instabil werden und ganze Siedlungen abrutschen lassen, die geordnete Aufforstung von gerodeten Urwäldern, oder die Verbesserung der Wasserversorgung für Trockengebiete – Wasser hat die Erde genug, seine Aufbereitung und Bereitstellung sind möglich, wenn auch teuer. Alle diese Arbeitsfelder schaffen überall Arbeitsplätze. Wir haben genug richtige und wichtige Aufgaben, in die zu investieren sich lohnt – und die sind erforderlich. Klimaschutz und CO2-Verpressung sind sinnlose Maßnahmen, denn sie verbessern nichts und sind kontraproduktiv, denn sie verschwenden Geld, das den nötigen Maßnahmen entzogen wird und sie deshalb verhindert.

Prof. Dr. F-K. Ewert EIKE

Zum Schluss noch zwei Zitate zum Thema:

Die gefährlichste Weltanschauung ist die Weltanschauung derjenigen, die sich die Welt nicht angeschaut haben. (Alexander von Humboldt)

Natur! Wir sind von ihr umgeben

und umschlungen – unvermögend,

aus ihr herauszutreten, und

unvermögend, tiefer in sie hineinzu-

kommen. …….

Wir leben mit ihr, und sind ihr fremde.

Sie spricht unaufhörlich mit uns, und

verrät uns ihr Geheimnis nicht.

Wir wirken beständig auf sie,

und haben doch keine Gewalt über sie.

(Johann Wolfgang von Goethe)

Anlage 1: Beispiele Temperaturganglinien: Mittelengland, Berlin, De Bilt, Uppsala St.Petersburg, Stockholm, Paris

Anlage 2: Der CO2-Gehalt der Atmosphäre steigt trotz Abkühlung weiter

Anlage 3: Beispiele für kleine CO2-Ausgasungen und große CO2-Ausbrüche

Anlage 4: Auszüge aus einer von Prof. Schellnhuber als Mitautor publizierten Arbeit

PHYSICAL REVIEW E 68, 046133 ~2003!

Power-law persistence and trends in the atmosphere: A detailed study of long temperature records

J. F. Eichner,1,2 E. Koscielny-Bunde,1,3 A. Bunde,1 S. Havlin,2 and H.-J. Schellnhuber4

1Institut für Theoretische Physik III, Universität Giessen, D-35392 Giessen, Germany

2Minerva Center and Department of Physics, Bar Ilan University, Ramat-Gan, Israel

3Potsdam Institute for Climate Research, D-14412 Potsdam, Germany

4Tyndall Centre for Climate Change Research, University of East Anglia, Norwich NR4 7TJ, United Kingdom

~Received 12 December 2002; published 28 October 2003!

We use several variants of the detrended fluctuation analysis to study the appearance of long-term persistence

in temperature records, obtained at 95 stations all over the globe. Our results basically confirm earlier studies. We find that the persistence, characterized by the correlation C(s) of temperature variations separated by s days, decays for large s as a power law, C(s);s2g . For continental stations, including stations along the coastlines, we

find that g is always close to 0.7. For stations on islands, we find that g ranges between 0.3 and 0.7, with a maximum at g 50.4. This is consistent with earlier studies of the persistence in sea surface temperature records where g is close to 0.4. In all cases, the exponent g does not depend on the distance of the stations to the continental coastlines. By varying the degree of detrending in the fluctuation analysis we obtain also information about trends in the temperature records.

~iii! In the vast majority of stations we did not see indications for a global warming of the atmosphere. Exceptions

are mountain stations in the Alps [Zugspitze (D), Säntis (CH), and Sonnblick (A), where urban warming can be excluded. Also, in half of the islands we studied, we found pronounced trends that most probably cannot be attributed to urban warming. Most of the continental stations where we observed significant trends are large cities where probably the fast urban growth in the last century gave rise to temperature increases.

Anlage 5: Sonnenaktivität, Temperaturschwankungen und Verbrauch von Öl und Gas im 20. Jahrhundert.

Anlage 6: Neue Abkühlung nach 1990, repräsentative Auswahl

Anlage 7: Aufpressen von Schicht- und/oder Kluftflächen, Einlagerung von Flüssigkeiten oder Gasen, im dargestellten Fall wurden geschlossene Schieferflächen bei einem Druck von 10 bar aufgepresst und dann mit Zementsuspension verfüllt; CO2 soll mit ca. 250 bar eingepresst werden

Related Files

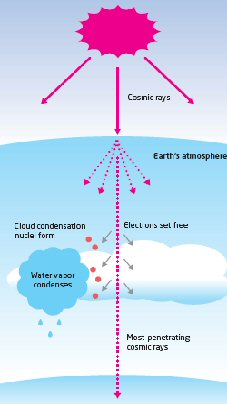

Das Logo des Experiments, das Akronym „Cosmic Leaving Outdoor Droplets” implizierte immer ein starkes Interesse an Svensmarks Hypothese. Und die Rolle der Galaxie und der Sonne werden berücksichtigt.

Das Logo des Experiments, das Akronym „Cosmic Leaving Outdoor Droplets” implizierte immer ein starkes Interesse an Svensmarks Hypothese. Und die Rolle der Galaxie und der Sonne werden berücksichtigt.