Signifikanz

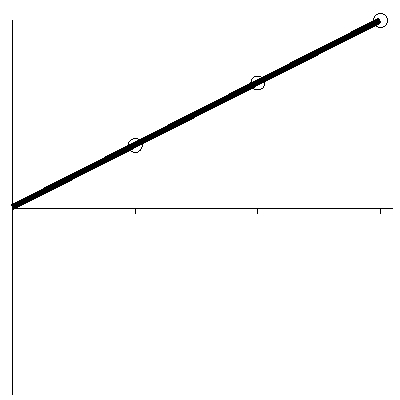

Betrachten Sie den Verlauf der globalen Temperatur in Abbildung 1, die die Daten der NASA verwendet. Zunächst könnte es offensichtlich scheinen, dass der Graph eine Zunahme der Temperatur anzeigt. Tatsächlich sieht die Geschichte etwas anders aus, wie wir jetzt sehen werden.

Abbildung 1 rechts: Zeitreihe der globalen Mitteltemperatur.

Stellen Sie sich vor, Sie werfen zehn mal eine Münze. Falls jedes Mal der Kopf oben liegt, würden wir einen signifikanten Beweis dafür haben, dass die Münze keine richtige Münze ist. Stellen Sie sich nun vor, die Münze wird nur dreimal geworfen. Falls jetzt wieder dreimal der Kopf oben liegt, würden wir keinen signifikanten Beweis für die Fehlerhaftigkeit der Münze haben: Dreimal Kopf kann jederzeit zufällig vorkommen.

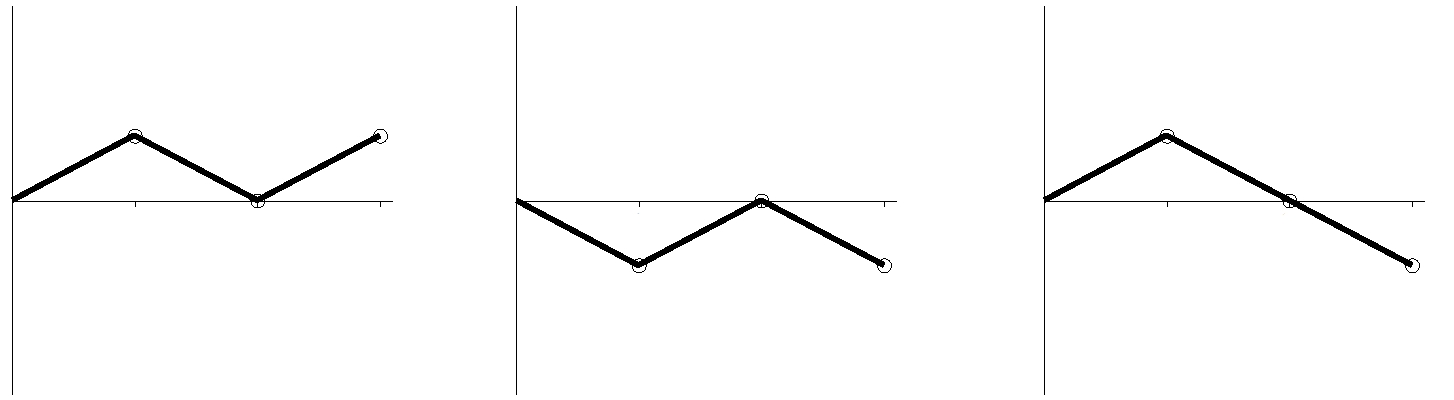

Abbildung 2: Münzwürfe: K, Z, K (links); Z, K, Z (Mitte); K, Z, Z (rechts)*

*head and tail [H, T] ist das typische entweder-oder im englischen Sprachraum, wenn es um das Losen mit Münzen geht. Hier wird dafür die gängige deutsche Bezeichnung Kopf und Zahl (K, Z) verwendet. A. d. Übers.]

In Abbildung 2 besteht jeder Graph aus drei Teilen: jedes Segment steht für je drei Münzwürfe. Falls die Münze Kopf zeigt, zeigt der Graph aufwärts, zeigt sie Zahl, zeigt er abwärts. In Abbildung 2 zeigt der Graph links Kopf, Zahl, Kopf; der mittlere Zahl, Kopf, Zahl und der rechte Kopf, Zahl, Zahl.

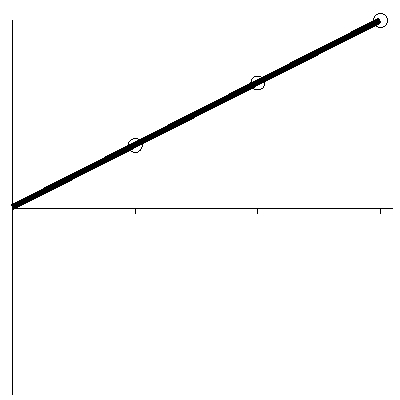

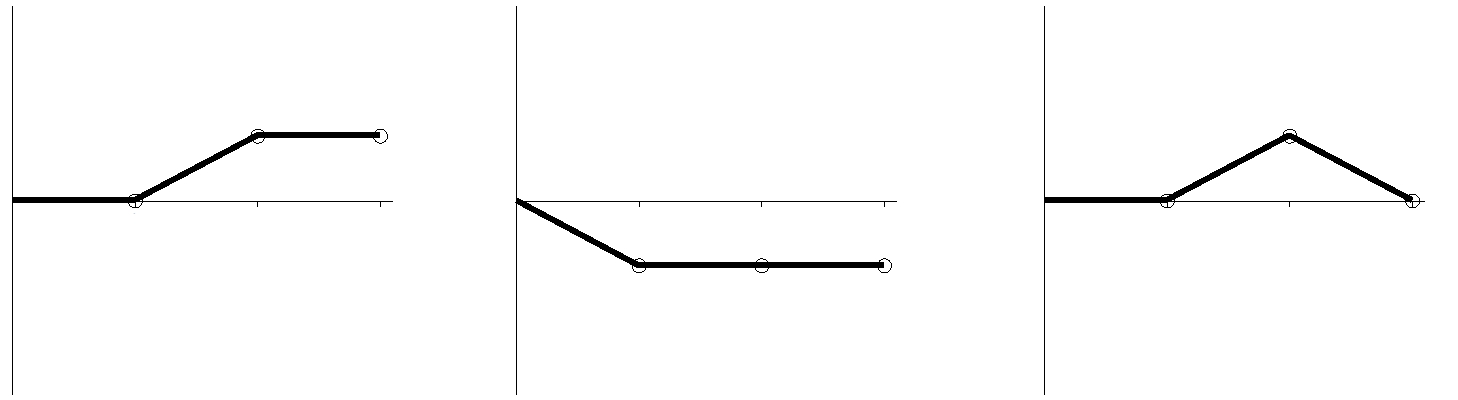

Abbildung 3: Münzwürfe: K, K, K

Betrachten Sie jetzt Abbildung 3. Auf den ersten Blick könnte es so aussehen, als ob der Graph eine Zunahme zeigt. Dieser Graph illustriert jedoch Kopf, Kopf, Kopf. Dreimal Kopf ist kein signifikanter Beweis für etwas anderes als Zufall. Ein Statistiker würde sagen, dass, obwohl Abbildung 3 eine Zunahme zeigt, diese Zunahme „nicht signifikant“ ist.

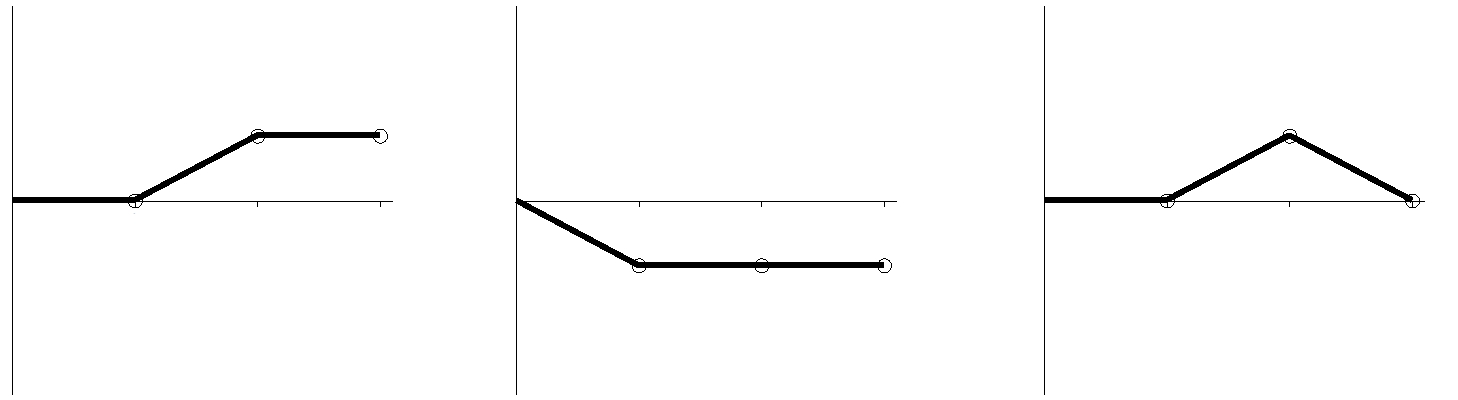

Nehmen Sie jetzt an, dass wir an Stelle der Münzen einen normalen sechsseitigen Würfel werfen. Zeigt sich die 1, wird eine abwärts führende Linie gezeichnet, bei einer 6 eine aufwärts führende Linie. Sollten die 2, 3, 4 oder 5 geworfen werden, wird eine Linie waagerecht gezeichnet. Wir werfen jeden Würfel dreimal. Beispiele zeigt Abbildung 4.

Abbildung 4: gewürfelte Ziffern 3, 6, 3 (links); 1, 5, 2 (Mitte); 4, 6, 1 (rechts)

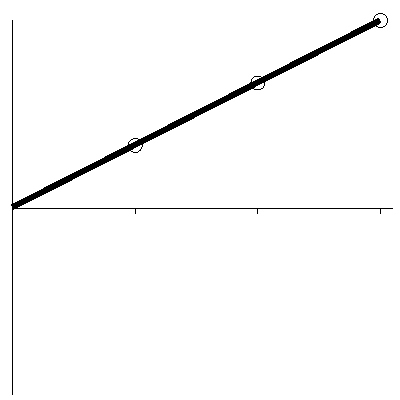

Als nächstes betrachte man Abbildung 5, die dreimal eine 6 gewürfelt repräsentiert. Dieses Ergebnis würde zufällig nur einmal in 216 Fällen auftreten und stellt so einen signifikanten Beweis dar, dass der Würfel nicht normal rollt. Das heißt, die Zunahme in Abbildung 5 ist signifikant.

Abbildung 5: gewürfelt 6, 6, 6

Die Abbildungen 3 und 5 sehen identisch aus. In Abbildung 3 ist die Zunahme nicht signifikant, und in Abbildung 5 ist sie es. Diese Beispiele verdeutlichen, dass wir nicht durch bloßes Betrachten bestimmen können, ob eine Linie eine signifikante Zunahme zeigt. Vielmehr müssen wir etwas über den Prozess wissen, der zur Erstellung der Linie geführt hat. In der Praxis kann dieser Prozess sehr kompliziert sein, was die Abschätzung schwierig macht.

Betrachten Sie nochmals den Graph in Abbildung 1 oben rechts. Wir können nicht durch bloßes Anschauen des Graphen sagen, ob die globale Temperatur signifikant zunimmt. Mehr noch, der Prozess zur Erzeugung dieses Graphen – das Klimasystem der Erde – ist extrem kompliziert. Folglich wird es schwierig zu beurteilen sein, ob es eine signifikante Zunahme gibt oder nicht.

Zeitreihen

Dies führt uns zum statistischen Konzept einer Zeitreihe. Eine Zeitreihe ist jede Reihe von Messungen in bestimmten regelmäßigen Zeitabständen. Beispiele sind Folgende: Die Preise der Börse in New York bei Handelsschluss an jedem Tag, die tägliche Höchsttemperatur in London, die jährliche Menge der Weizenernte in Kanada. Ein weiteres Beispiel ist die mittlere globale Temperatur eines jeden Jahres.

In der Analyse einer Zeitreihe lautet eine der grundlegenden Fragen, wie man abschätzen kann, ob sich eine gegebene Reihe signifikant aufwärts (oder abwärts) bewegt. Die Mathematik einer Zeitreihenanalyse stellt uns einige Methoden zur Beantwortung dieser Frage zur Verfügung. Als erstes müssen wir zusammentragen, was wir über die Zeitreihe wissen. Zum Beispiel können wir feststellen, dass die Reihe immer dann einen Schritt nach oben macht, wenn eine bestimmte Münze Kopf zeigt, und dass die Reihe drei Schritte nach oben enthält, wie in Abbildung 3. Als nächstes müssen wir einige Berechnungen auf der Basis dessen, was wir festgestellt haben, durchführen. Zum Beispiel, wir berechnen die Wahrscheinlichkeit, dass eine Münze drei mal hintereinander Kopf zeigt, mit ½ × ½ × ½ = ?, d. h. es ergibt sich eine Wahrscheinlichkeit des Eintreffens von 12,5%. Daraus schließen wir, dass die drei Schritte nach oben in der Reihe der Münzwürfe gut und gerne als Zufall betrachtet werden – und folglich, dass die Zunahme in Abbildung 3 nicht signifikant ist.

Ganz ähnlich müssen wir, um festzustellen, ob die globale Temperatur signifikant zunimmt, zunächst festlegen, was wir über die Temperaturreihe wissen. Was wissen wir über die Reihe? Unglücklicherweise nicht genug, um eine brauchbare Zeitreihenanalyse durchzuführen. Also müssen wir über die Reihe einige Hypothesen machen und unsere Analyse dann auf der Basis dieser Hypothesen durchführen. Dies wird von den Zeitreihenanalysten vorgeschlagen. Solange die Hypothesen sinnvoll sind, können wir zuversichtlich sein, dass die Schlussfolgerungen aus unserer Analyse vernünftig sind.

Die IPCC-Hypothese

Die grundlegende Institution, wenn es um die globale Erwärmung geht, ist das IPCC. Der jüngste Bericht des IPCC zur wissenschaftlichen Basis der globalen Erwärmung wurde 2007 veröffentlicht. In Kapitel 3 werden Überlegungen zur globalen Temperaturreihe wie in Abbildung 1 angestellt. Die wesentliche Schlussfolgerung dieses Kapitels lautet, dass die Zunahme der globalen Temperatur extrem signifikant ist.

Um diese Schlussfolgerung zu ziehen, musste das IPCC eine Annahme über die Reihe der globalen Temperatur machen. Diese Annahme ist als „AR1“-Annahme bekannt (aus dem statistischen Konzept der „Autoregression erster Ordnung“). Die Annahme lautet neben Anderem, dass nur der gegenwärtige Wert in einer Zeitreihe eine direkte Auswirkung auf den nächsten Wert hat. Für die globale Temperaturreihe bedeutet dies, dass die Temperatur dieses Jahres Auswirkung auf die Temperatur des nächsten Jahres hat, nicht aber die Temperatur der Jahre zuvor. Zum Beispiel, falls die letzten Jahre extrem kalt waren, würde dies keine Auswirkungen auf die Wahrscheinlichkeit haben, dass es im nächsten Jahr kälter als im Mittel zu erwarten sein wird. Also scheint die vom IPCC gemachte Annahme intuitiv nicht plausibel zu sein.

Es gibt Standardchecks, um (teilweise) zu testen, ob eine Zeitreihe zu einer gegebenen statistischen Annahme passt. Ist dies nicht der Fall, müssen alle Schlussfolgerungen, die auf dieser Annahme basieren, als unbegründet betrachtet werden. Zum Beispiel, wenn die Signifikanz der Zunahme in Abbildung 5 aufgrund der Annahme berechnet worden wäre, dass die Wahrscheinlichkeit der Aufwärtsbewegung eins zu zwei anstatt eins zu sechs betragen würde, würde dies zu einer unrichtigen Schlussfolgerung führen. Im Kapitel des IPCC fehlt jedoch jeder Hinweis, dass solche Checks durchgeführt worden waren.

Mit anderen Worten, die Hypothese des IPCC besteht einfach aus einer Ankündigung. Von der Wissenschaft nimmt man an, dass sie auf Beweisen und Logik basiert. Dass das IPCC keinerlei Beweise oder Logik präsentiert, die seine Hypothese untermauern, ist eine ernste Verletzung grundlegender wissenschaftlicher Prinzipien.

Mehr noch, Standardchecks zeigen, dass die globale Temperaturreihe nicht mit der Hypothese des IPCC konform geht; ein solcher Check wird in einer separaten Sektion unten beschrieben. Folglich basiert die Behauptung, dass die Zunahme der Temperatur signifikant ist – immerhin die grundlegende Schlussfolgerung eines zentralen Kapitels des IPCC-Berichtes – auf einer untragbaren Hypothese. Allgemeiner, Das IPCC ist damit gescheitert, zu zeigen, dass die globale Temperatur signifikant steigt! [Hervorhebung im Original]

Diese Probleme sind auch nicht nur auf das IPCC beschränkt. Das Climate Change Science Program (CCSP) der USA, welches den Kongress berät, veröffentlichte seinen Bericht über Temperaturänderungen im Jahre 2006. Dieser Bericht beruft sich auf die gleiche unmögliche Hypothese wie im Kapitel des IPCC-Berichtes.

Nichts hiervon ist Meinung. All dies sind nicht diskutierbare Tatsachen. Und es gilt für jede Erwärmung – ob nun verursacht von der Natur oder vom Menschen. Solange keine Forschungen durchgeführt werden, eine angemessene Hypothese zu finden, kann keine Schlussfolgerung über die Signifikanz von Temperaturänderungen gezogen werden.

Mr. Keenan führte früher mathematische Forschungen und solche über den Finanzhandel an der Wall Street und in London; seit 1995 forscht er unabhängig, Er unterstützt den Umweltschutz und die Energiesicherheit.

Eine unmögliche Hypothese

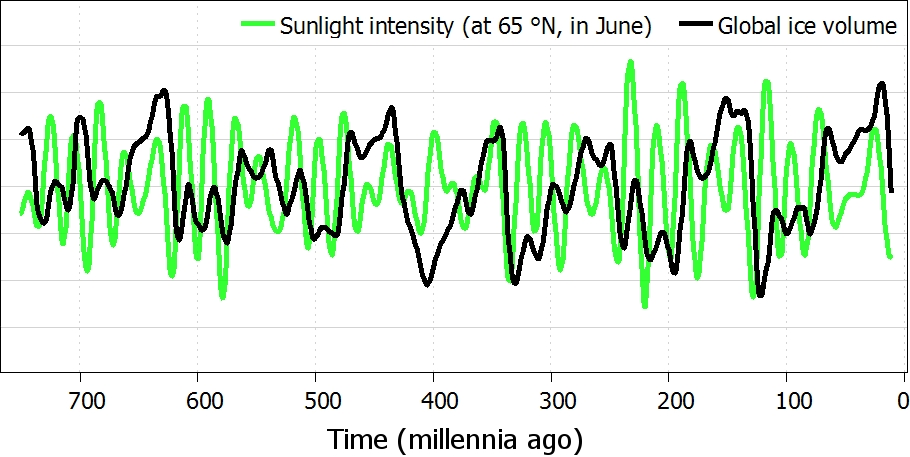

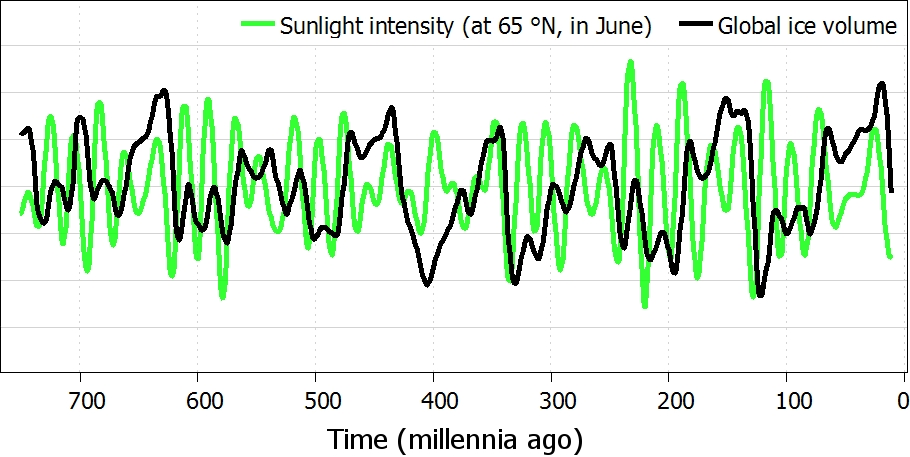

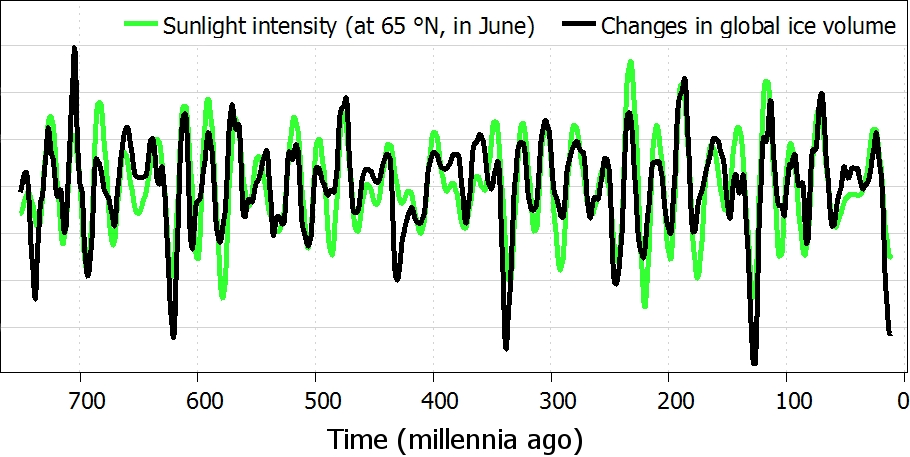

Abbildung 6: Intensität des Sonnenlichts (invers) und globale Eismenge.

Änderungen

Viele Jahrtausende lang waren die wichtigsten Fluktuationen im Klima der Erde durch die Eiszeiten bestimmt. Die Eiszeiten werden durch natürliche Variationen des Erdorbits um die Sonne hervorgerufen. Jene Variationen des Orbits verändern die Intensität des sommerlichen Sonnenlichts. Einige relevante Daten zeigt Abbildung 6: die schwarze Linie repräsentiert die Menge des globalen Eises, und die grüne Linie repräsentiert die Intensität des Sonnenlichts in der Nordhemisphäre (wo die Auswirkungen am größten sind). Man beachte, dass die Ähnlichkeit zwischen beiden Linien nur sehr schwach ist.

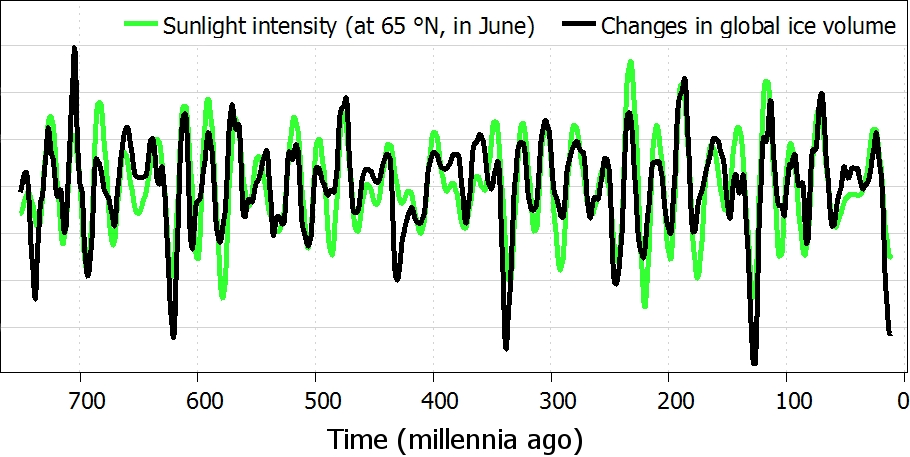

Abbildung 7: Intensität des Sonnenlichts (invers) und Veränderungen der globalen Eismenge

Warum ist die Ähnlichkeit so schwach? Um zu verstehen, was hier vor sich geht, müssen wir die Veränderungen der globalen Eismenge betrachten. Zum Beispiel, falls die Eismenge zu verschiedenen Zeiten 17, 15, 14, 19, … beträgt, und wenn man davon die jeweils folgenden Mengen subtrahiert; 2, 1, -5, … Die schwarze Linie in Abbildung 7 zeigt die Veränderungen der Eismenge, während die grüne Linie wie zuvor die Intensität des sommerlichen Sonnenlichts zeigt. Jetzt ist die Ähnlichkeit beider Linien groß. Dies ist ein ausgezeichneter Beweis dafür, dass die Eiszeiten durch orbitale Variationen verursacht wurden (dafür gibt es auch noch andere Beweise).

Ein Zusammenhang zwischen Eiszeiten und orbitalen Variationen wurde erstmals 1920 ins Spiel gebracht, und zwar durch den serbischen Astrophysiker Milutin Milankovitch. Um diesen Vorschlag zu untersuchen, sind Daten über die Eismenge in vergangenen Millenien unabdingbar; diese Daten wurden 1976 verfügbar. Und doch dauerte es bis zum Jahr 2006, bis Wissenschaftler die Veränderungen der Eismenge betrachteten. Mit anderen Worten, die Wissenschaftler brauchten 30 Jahre Denkzeit, um die erforderliche Subtraktion durchzuführen, um die schwarze Linie in Abbildung 7 zu erhalten. Während dieser drei Dekaden analysierten die Wissenschaftler den Vorschlag von Milankovitch auf der Basis von Kurven wie in Abbildung 6, und sie überdachten eine Palette von Gedanken, um zu versuchen, die schwach ausgeprägte Similarität zwischen den beiden Linien zu erklären.

Alternative Hypothesen

Dieses Vorgehen warf eine Frage auf: In Bezug auf die globale Temperatur, was passiert, wenn wir die Änderungen analysieren anstatt die Temperaturen selbst? Es stellt sich heraus, dass es dann eine offensichtliche Alternative zu den Hypothesen des IPCC gibt. Wie gut ist diese neue Hypothese im Vergleich zu der des IPCC? Eine allgemein übliche Methode, Hypothesen zu vergleichen, ist die Durchführung eines Verfahrens, das die Statistiker „AICc“ nennen (Akaike Information Criterion with correction). Diese Methode zeigt, dass die Alternative so viel besser ist als die des IPCC, dass wir daraus folgern, dass die Hypothese des IPCC untragbar ist. Das heißt, das IPCC machte den gleichen Fehler wie diejenigen Wissenschaftler, die 30 Jahre lang versuchten, den Vorschlag von Milankovitch zu verifizieren: Sie betrachteten nicht die Veränderungen in einer Reihe.

Mit der alternativen Hypothese ist die Zunahme der globalen Temperatur nicht signifikant. Wir wissen jedoch nicht, ob die alternative Hypothese selbst vernünftig ist – vielleicht gibt es noch bessere Hypothesen. Die Abschätzung, wie viel Gültigkeit die alternative Hypothese hat, sind Studien vonnöten. Es gab Studien, die alternative Hypothesen untersuchten und damit unterschiedliche Schlussfolgerungen über die Daten zogen. Der IPCC-Bericht erwähnt solche Studien, jedoch ohne anzuerkennen, dass die Stichhaltigkeit auf der Auswahl der Hypothese beruht – oder dass die Auswahl schwierige Forschungen erforderlich macht.

Link: http://www.informath.org/media/a42.htm

Anmerkungen

Was das IPCC-Kapitel über die globale Temperaturzunahme sagt

Der Zustandsbericht des IPCC aus dem Jahr 2007 enthält ein Kapitel mit der Überschrift: “Observations: surface and atmospheric climate change” [etwa: Oberfläche und atmosphärische Klimaänderung] (darin bezieht sich „Oberfläche“ auf die Erdoberfläche, d. h. wo Menschen wohnen). Dieses Kapitel präsentiert die globalen Temperaturmessungen, dargestellt in Abbildung 1. Die Hauptschlussfolgerung dieses Kapitels steht gleich fett gedruckt im ersten Satz. Sie lautet: „die globale mittlere Temperatur an der Erdoberfläche ist um 0,74°C ± 0,18°C gestiegen, wenn man sie mit einem linearen Trend über die letzten 100 Jahre abschätzt (1906 bis 2005)“. (Hier bedeutet “0.74°C ± 0.18°C”, dass das IPCC zu 90% sicher ist, dass der Temperaturanstieg in einem Bereich zwischen 0,56°C und 0,92°C pro Jahrhundert liegt). Ein Trend, der mit so großer Sicherheit so hoch über der Nulllinie liegt, ist extrem signifikant.

Eine NON- AR1– Hypothese die im IPCC-Kapitel verworfen wird

Im Jahre 2005 haben zwei Wissenschaftler im U.S. Geological Survey, T. A. Cohn und H. F. Lins einen Forschungsartikel veröffentlicht, der eine andere Hypothese als die AR1-Hypothese untersuchte. Dem Artikel zufolge lässt sich sagen, falls diese andere Hypothese gültig ist, ist die Zunahme der globalen Temperatur nicht signifikant. Der Artikel von Cohn & Lins wird im IPCC-Kapitel erwähnt, aber nur in einem einzigen Absatz in einem Anhang (§3.A). In dem Absatz wird anerkannt, dass „die statistische Signifikanz der … Trends des AR1 überschätzt worden sein könnten“. Dann wird behauptet, dass andere Hypothesen als die mit AR1 berechneten nicht übernommen werden sollten, weil „die Ergebnisse von den benutzten (Hypothesen) abhängen, und komplexere (Hypothesen) nicht so transparent sind, und es mangelt ihnen oft an physikalischem Realismus“. Der erste Teil, dass die Ergebnisse von den gewählten Hypothesen abhängen, ist korrekt, aber offensichtlich kein Grund, sich auf AR1 zu verlassen. Der zweite Teil hinsichtlich komplexerer Hypothesen könnte in einigen Fällen zutreffen (abhängig davon, welche Hypothese man verwendet). Der dritte Teil hinsichtlich der physikalischen Realität ist eine wichtige Sache. Eine Hypothese ist physikalisch realistisch, wenn sie mit unserem Verständnis über das Wirken physikalischer Vorgänge übereinstimmt. Hier folgt ein Beispiel einer unrealistischen Hypothese: nämlich die Hypothese, dass sich eine geworfene Münze immer auf und ab in einer perfekten geraden Linie durch die Luft bewegt. Der IPCC-Bericht stellt keine Betrachtung darüber an, ob seine Hypothese physikalisch realistisch ist: dies ist ein Manko des Berichtes. Die Angelegenheit wurde jedoch in einem Forschungspapier 2008 mit den Mitautoren G. A. Schmidt (NASA-Klimatologe) und dem führenden Alarmisten M. E. Mann betrachtet (beide Hauptbefürworter der globalen Erwärmung). In dem Papier finden sich starke Argumente, dass das AR1 physikalisch unrealistisch ist und dass irgendeine andere Hypothese verwendet werden muss. Dies bedeutet, dass die Behauptung des IPCC im Anhang, andere auf physikalischem Realismus beruhende Hypothesen zu vermeiden, schwer in die Irre führt.

Ob die Hypothese von Cohn & Lins angemessen ist, ist unbekannt (obwohl sie 2007 einige Unterstützung von Koutsoyiannis & Montanan erhalten hat). Das IPCc nennt jedoch höchst dubiose Gründe dafür, jene Hypothese zurückzuweisen.

Andere Hypothesen, die im IPCC-Bericht erwähnt werden

Einige andere Hypothesen als die in AR1 werden kurz in einem späteren Kapitel des IPCC-Berichtes erwähnt, in §9.4.1. Die entscheidende Frage jedoch – welche Hypothese man auch immer verwendet, sie muss gerechtfertigt sein – wird nicht angesprochen. Dass die Signifikanz mit einigen Hypothesen verschwinden kann, wird nicht angedeutet.

Was das Wissenschaftsprogramm der Klimaänderung (CCSP) zur Hypothese im AR1 sagt

Der CCSP-Bericht behauptet, dass AR1 „eine Hypothese enthält, die eine gute Näherung für die meisten Klimadaten darstellt”. Die Behauptung wird ohne jeden Beweis, Argumentation oder Verweise auf andere Arbeiten erhoben. Tatsächlich werden Methoden, die Behauptung zu testen – und welche beweisen, dass die Behauptung falsch ist – schon in Einführungskursen über Zeitreihen gelehrt: siehe die Bibliographie.

[Die folgenden Details stellen eine technische Beschreibung dar und werden daher nicht mit übersetzt. Im Original sind dazu auch zahlreiche Links anzuklicken. A. d. Übers.]

Douglas J. Keenan

Keenan betrieb früher mathematische Forschung für den Finanzmarkt an der Wallstreet und in der City of London. Seit 1995 arbeitet er unabhängig. Er unterstützt Umweltbwegungen und Energiesicherheit

Übersetzt von Chris Frey für EIKE

Link: http://www.informath.org/media/a41/b8.pdf

Einige statistische Details (nicht übersetzt)

The annual global temperature data was downloaded via http://data.giss.nasa.gov/gistemp/ on 2010-11-17. The available data was for years 1881–2009. It is given as differences from the mean, in hundredths °C. (The mean used in Figure 1 is from NASA’s Earth Fact Sheet; the accuracy of that mean is irrelevant for the analysis herein.)

The IPCC and the CCSP use slightly different methods to fit a straight line to the temperature data. The CCSP uses ordinary least squares, and then finds approximate confidence intervals assuming that the residuals conform to AR(1). The IPCC uses generalized least squares and REML, assuming AR(1). The difference between the two methods is negligible; using ML instead of REML also makes negligible difference: see the R session below.

Herein, the IPCC/CCSP model is compared, via AICc, to a driftless ARIMA(3,1,0) model.

> # Assign the annual global temperature data (source: NASA)

> gistemp<- ts(c(-21, -26, -27, -32, -32, -29, -36, -27, -17, –

39, -28, -32, -33, -33, -25, -14, -11, -26, -16, -8, -15, -25, –

30, -35, -24, -19, -39, -33, -35, -33, -34, -32, -30, -15, -10, –

30, -39, -33, -20, -19, -15, -26, -22, -22, -17, -2, -15, -13, –

26, -8, -2, -8, -19, -7, -12, -5, 7, 10, 1, 4, 10, 3, 9, 19, 6, –

5, 0, -4, -7, -16, -4, 3, 11, -10, -10, -17, 8, 8, 6, -1, 7, 4,

8, -21, -11, -3, -1, -4, 8, 3, -10, 0, 14, -8, -5, -16, 12, 1, 8,

19, 26, 4, 25, 9, 4, 12, 27, 31, 19, 36, 35, 13, 13, 23, 37, 29,

39, 56, 32, 33, 47, 56, 55, 48, 63, 55, 58, 44, 57), start=1881)

> # Show that the three methods give essentially the same result

> library(nlme) # nlme contains gls

> ols<- lm(gistemp ~ time(gistemp)); coefficients(ols)

(Intercept) time(gistemp)

-1134.0286319 0.5820159

> gls.REML<- gls(gistemp ~ time(gistemp), cor=corARMA(p=1,q=0), method="REML"); coefficients(gls.REML)

(Intercept) time(gistemp)

-1137.7531478 0.5842142

> gls.ML<- gls(gistemp ~ time(gistemp), cor=corARMA(p=1,q=0),

method="ML"); coefficients(gls.ML)

(Intercept) time(gistemp)

-1137.362997 0.583983

> phi<- coefficients(arima(resid(ols), order=c(1,0,0),

include.mean=FALSE))[1] # for the CCSP confint approximation

> ci.ccsp<- coefficients(ols)[2] + sqrt((1+phi)/(1-phi))*

(coefficients(ols)[2] – confint(ols)[c(4,2)])

> ci.ccsp; confint(gls.REML)[c(2,4)]; confint(gls.ML)[c(2,4)]

[1] 0.4612661 0.7027656

[1] 0.4596008 0.7088276

[1] 0.4677889 0.7001771

> # Check AICc of IPCC/CCSP model and driftless ARIMA(3,1,0)

> calcAICc<- function(aicx,n,k) aicx+(2*k*(k+1))/(n-(k+1))

> arima310z<- arima(gistemp, order=c(3,1,0)) # uses drift zero

> calcAICc(AIC(gls.ML), length(gistemp), 1+0+3)

[1] 964.7413

> calcAICc(AIC(arima310z), length(gistemp), 3+0+1)

[1] 951.0372

> exp((951.0372-964.7413)/2)

[1] 0.001057286

Bibliography [annotated]

Burnham K.P., Anderson D.R. (2002), Model Selection and Multimodel Inference (Springer). [The standard reference for AIC (Akaike Information Criterion) and similar; strongly recommends AICc; §2.6 and §8.6 discuss how to interpret differences in AICc values.]

Cohn T.A., Lins H.F. (2005), “Nature’s style: naturally trendy”, Geophysical Research Letters, 32, L23402; doi:10.1029/2005GL024476. [Dismissed by Trenberth et al.]

Cowpertwait P.S.P., Metcalfe A.V. (2009), Introductory Time Series with R (Springer). [Presents what its title says; §4.6.3 gives argumentation for using AR4 without a trend for global temperature measurements; see also Shumway & Stoffer.]

Foster G., Annan J.D., Schmidt G.A., Mann M.E. (2008), “Comment on "Heat capacity, time constant, and sensitivity of Earth’s climate system" by S. E. Schwartz”, Journal of Geophysical Research, 113, D15102; doi:10.1029/2007JD009373. [A research paper by some leading global-warming scientists, arguing against AR1 for global temperatures.]

Koutsoyiannis D., Montanari A. (2007), “Statistical analysis of hydroclimatic time series”, Water Resources Research, 43, W05429, doi:10.1029/2006WR005592. [One of the few research articles that discusses non-AR assumptions (see also Cohn & Lins).]

NASA (2010), GISS Surface Temperature Analysis, http://data.giss.nasa.gov/gistemp/. [Has the annual global temperature measurements used herein: see section “Statistical details”.]

R Development Core Team (2010), R: A Language and Environment for Statistical Computing (Vienna: R Foundation for Statistical Computing). [R is standard statistical software, used in the section “Statistical details”; it is free, via www.R-project.org.]

Roe G. (2006), “In defense of Milankovitch”, Geophysical Research Letters, 33, L24703; doi:10.1029/2006GL027817. [The first research paper to present a proper elucidation of the link between ice ages and orbital cycles; source of Figures 6 and 7.]

Shumway R.H., Stoffer D.S. (2011), Time Series and Its Applications—With R Examples (Springer). [An introductory text, more advanced than that of Cowpertwait & Metcalfe; Example 2.5 argues that it is better to consider changes in global temperatures than to use a linear trend; set problems 3.33 and 5.3 elaborate on that.]

Trenberth K.E., Jones P.D., Ambenje P., Bojariu R., Easterling D., Klein Tank A., Parker D., Rahimzadeh F., Renwick J.A., Rusticucci M., Soden B., Zhai P. (2007), “Observations: surface and atmospheric climate change”, Climate Change 2007: The Physical ScienceBasis (editors—Solomon)

S., Qin D., Manning M., Chen Z., Marquis M., Averyt K.B., Tignor M., Miller H.L.) Chapter 3 (Cambridge University Press). [The chapter of the Fourth Assessment Report by the IPCC that treats surface climate; this is the chapter that is the source for the IPCC (2007) claim that global temperatures are increasing at 0.74°C ± 0.18°C per century; Appendix A describes statistical methods.]

Wigley T.M.L. (2006), “Statistical issues regarding trends”, Temperature Trends in the Lower Atmosphere (editors—Karl T.R., Hassol S.J., Miller C.D., Murray W.L.) Appendix A (Washington D.C.: U.S. Climate Change Science Program). [Describes the statistical method used for the CCSP trend analysis.]

Acknowledgements

For discussions on drafts, I thank David R. Anderson, David L. Banks, David Henderson,

Olavi Kärner, Demetris Koutsoyiannis, Richard S. Lindzen, A.W. Montford, and Gerard Roe.

—Douglas J. Keenan

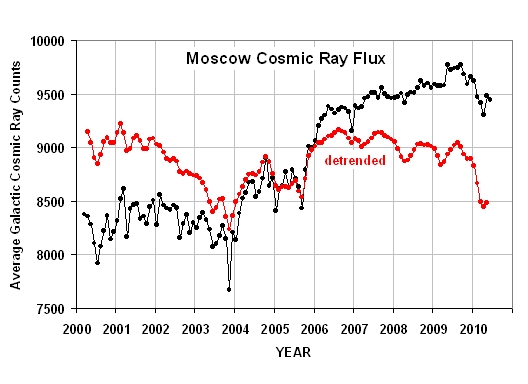

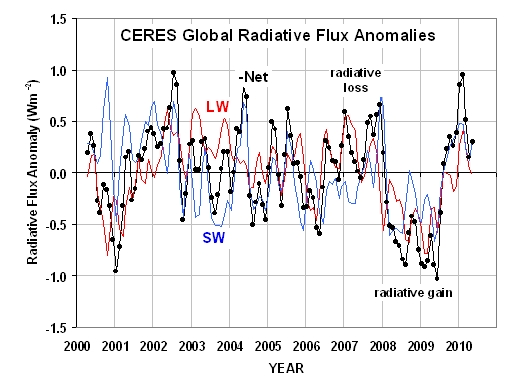

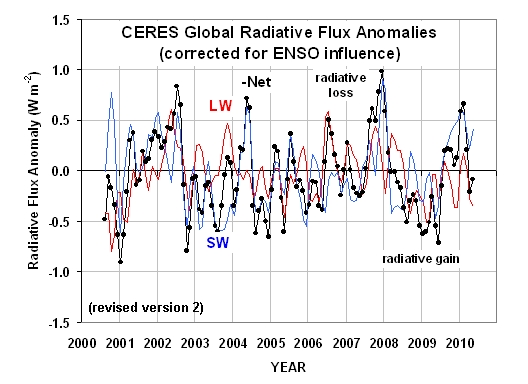

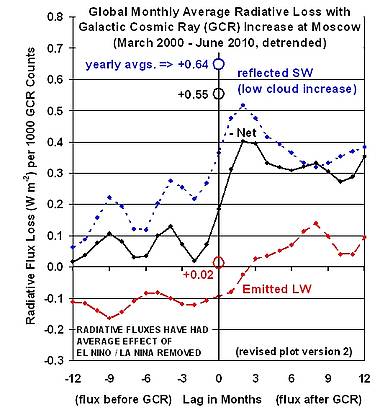

welche die Variationen des im globalen Mittel reflektierten Sonnenlichts (SW), die emittierte infrarote Strahlung (LW) und Net [?] zeigt (welches die geschätzten Ungleichgewichte der gesamten absorbierten Energie durch das Klimasystem ist, nach der Anpassung der Variationen der gesamten Solarstrahlung TSI). Man beachte, dass ich die Variationen im Negativen von Net geplottet habe, was angenähert gleich ist mit Variationen von (LW + SW).

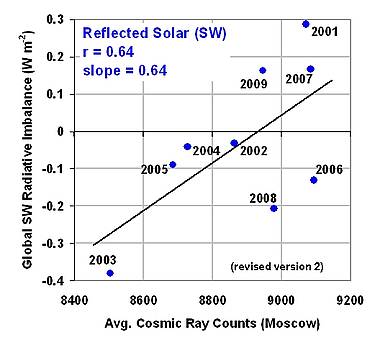

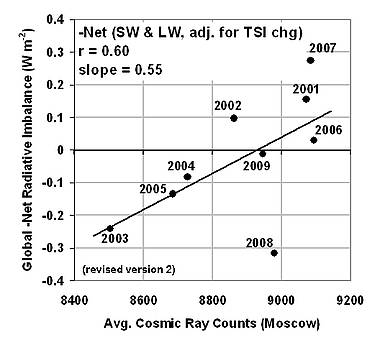

welche die Variationen des im globalen Mittel reflektierten Sonnenlichts (SW), die emittierte infrarote Strahlung (LW) und Net [?] zeigt (welches die geschätzten Ungleichgewichte der gesamten absorbierten Energie durch das Klimasystem ist, nach der Anpassung der Variationen der gesamten Solarstrahlung TSI). Man beachte, dass ich die Variationen im Negativen von Net geplottet habe, was angenähert gleich ist mit Variationen von (LW + SW). Schließlich führte ich Regressionen an verschiedenen zeitlichen Verschiebungen zwischen den GCR-Reihen, den LW, SW und Net-Strahlungsflüssen durch. Die Ergebnisse folgen hier:

Schließlich führte ich Regressionen an verschiedenen zeitlichen Verschiebungen zwischen den GCR-Reihen, den LW, SW und Net-Strahlungsflüssen durch. Die Ergebnisse folgen hier:

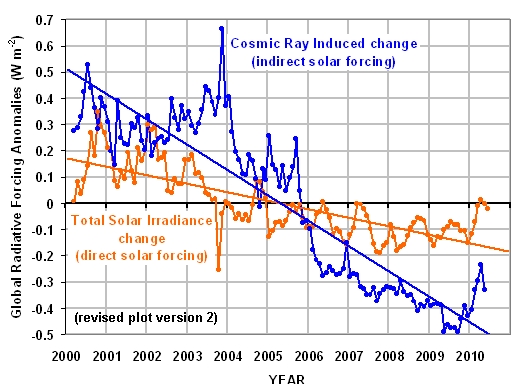

Ebenso ist der geschätzte Antrieb durch kosmische Strahlung dargestellt, wie er aus Änderungen von Monat zu Monat des originalen Datensatzes der Moskauer Serie resultiert, berechnet durch Multiplikation dieser monatlichen Änderungen in Höhe von 0,55 Watt pro Quadratmeter pro 1000 Zählern der Änderung der kosmischen Strahlung.

Ebenso ist der geschätzte Antrieb durch kosmische Strahlung dargestellt, wie er aus Änderungen von Monat zu Monat des originalen Datensatzes der Moskauer Serie resultiert, berechnet durch Multiplikation dieser monatlichen Änderungen in Höhe von 0,55 Watt pro Quadratmeter pro 1000 Zählern der Änderung der kosmischen Strahlung.