Sind wir der massenhaften Installation von Windkraftanlagen hilflos ausgeliefert?

Das Gespräch führte Wolfgang Müller EIKE. Die Aufzeichnung entstand im März 2011.

Alle Videos von EIKE finden Sie hier

Das Gespräch führte Wolfgang Müller EIKE. Die Aufzeichnung entstand im März 2011.

Alle Videos von EIKE finden Sie hier

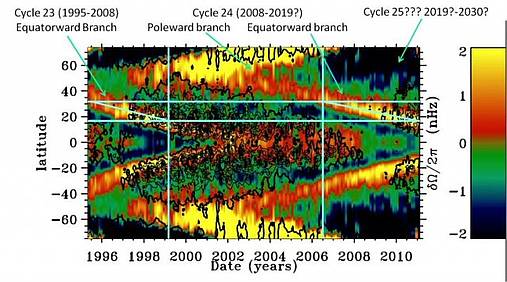

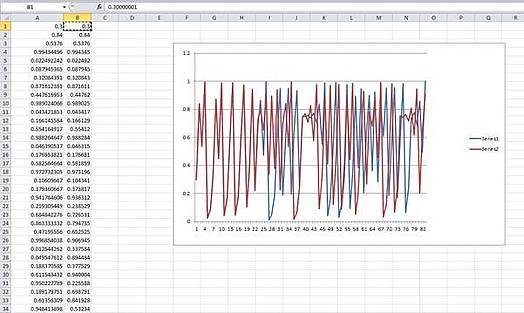

Darstellungen von „Jetstreams“ (siehe untere Abbildung) unter der Sonnenoberfläche nach geografischer Breite über der Zeit zeigen den überraschenden Stillstand des solaren Zyklen-Mechanismus. Neue Jetstreams bilden sich typischerweise bei etwa 50 Grad Breite (wie 1999 auf der Darstellung) und sie sind mit dem 11 Jahre nachfolgenden Sonnenzyklus verbunden. Die Bildung neuer Jetstreams für ein zukünftiges solares Maximum von 2018 – 2020 war 2008 erwartet worden, sie sind bislang aber noch nicht aufgetaucht. Das deutet auf einen verspäteten oder ausfallenden Zyklus Nr. 25 hin.

Die Wissenschaftler am Sonnenobservatorium „Solar Observatory (NSO)“ und beim Forschungslabor der U.S.-Luftwaffe „Air Force Research Laboratory (AFRL)“ meinen, dass ein ausbleibender Jetstream, schwächer werdende Sonnenflecken und verlangsamte Aktivität nahe den Polen eine Ruheperiode andeuten, obwohl die Aktivität zum ersten Mal seit Jahren wieder zunimmt.

Während sich der derzeitige Zyklus Nr. 24 auf sein Maximum zu bewegt, deuten voneinander unabhängige Studien über das Sonneninnere, die sichtbare Oberfläche und die Korona darauf hin, dass der kommende 11jährige Sonnenfleckenzyklus Nr. 25 sehr schwach oder überhaupt ausfallen wird.?Die nachfolgenden Erkenntnisse sind auf dem Jahrestreffen der Sonnenphysik-Abteilung der amerikanischen Astronomischen Gesellschaft (AAS) angekündigt worden. Das Jahrestreffen fand in der Woche vom 12. – 16. Juni 2011 an der New Mexico State University in Las Cruces statt.

http://astronomy.nmsu.edu/SPD2011/

“Das ist sehr ungewöhnlich und unerwartet,” sagte Dr. Frank Hill, Co-Direktor des Solar Synoptic Network NSO, “Aber die Tatsache, dass drei völlig unterschiedliche Beobachtungsrichtungen der Sonne in die gleiche Richtung zeigen, ist ein starkes Anzeichen dafür, dass sich der Sonnfleckenzyklus zur Ruhe begibt.”

Sonnenfleckenanzahl und die Sonnenaktivität steigen und fallen etwa alle 11 Jahre, das ist die Hälfte des magnetischen Sonnenintervalls, während dessen sich die magnetischen Pole umkehren. Daraus ergibt sich sofort die Frage, ob die Verminderung einem zweiten Maunder-Minimum vorausgeht, einer 70jährigen Periode von 1645-1715 mit nahezu keinen Sonnenflecken.

Hill ist Leitautor eines der drei Papiere, die auf dem Jahrestreffen präsentiert wurden. Anhand der Daten der Global Oscillation Network Group (GONG) von sechs über die ganze Welt verteilten Beobachtungsstationen überträgt die Forschergruppe Schallschwingungen der Sonnenoberfläche, die durch die Sonne laufen, in Modelle der inneren Sonnenstruktur. Eine ihrer Entdeckungen ist eine von Ost nach West gerichtete zonale Strömung innerhalb der Sonne, die „torsionale Schwingung“ genannt wird. Sie beginnt in mittleren Breiten und wandert zum Äquator hin. In jedem Zyklus stimmt die Breite dieser Strömung mit dem Gebiet der Bildung neuer Sonnenflecken überein. So wurde auch die Verspätung des derzeitigen Zyklus Nr. 24 vorausgesagt.

“Den Beginn der zonalen Strömung für Zyklus 25 hätten wir jetzt erwartet,” erklärte Hill, “aber wir sehen keine Anzeichen dafür. Das deutet darauf hin, dass der Beginn des Zyklus 25 sich bis 2021 oder 2022 verzögern könnte, oder vielleicht ganz ausfallen wird.“

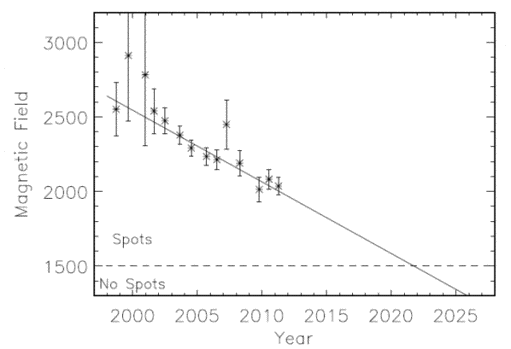

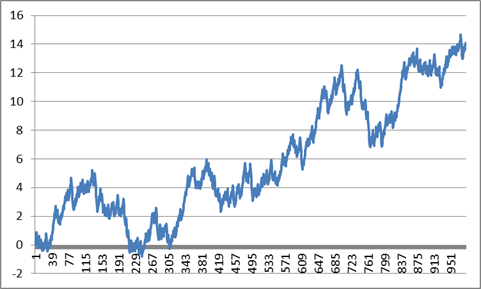

Abbildung Die durchschnittliche Magnetfeldstärke in der Sonnenflecken-Umbra fällt seit über einem Jahrzehnt ständig ab. Der Trend umfasst die Sonnenflecken der Zyklen 22, 23 und des gegenwärtigen Zyklus 24.

In einem zweiten Papier meinen Matt Penn und William Livingston, einen Langzeitschwächetrend bei der Stärke der Sonnenflecken entdeckt zu haben. Sie sagen voraus, dass die im Zyklus 25 auf der Sonne aufbrechenden Magnetfelder so schwach sein werden, dass kaum Sonnenflecken gebildet werden, wenn überhaupt welche. Flecken entstehen, wenn starke röhrenförmige Magnetflüsse aus dem Inneren hervorbrechen und verhindern, dass kühleres Gas zurück ins Sonneninnere strömt. In typischen Sonnenflecken hat das Magnetfeld eine Stärke von 2.500 bis 3.500 Gauß ?(Das Erdmagnetfeld hat weniger als 1 Gauß an der Oberfläche). Die Feldstärke muss mindestens 1.500 Gauß erreichen, um einen dunklen Fleck zu bilden.

Penn und Livingston haben Sonnenfleckendaten von über 13 Jahren benutzt, die vom McMath-Pierce Teleskop auf dem Kitt Peak in Arizona stammen, und sie haben entdeckt, dass die durchschnittliche Feldstärke im Zyklus 23 und nun im Zyklus 24 um 50 Gauß/Jahr abgenommen hat. Sie haben auch beobachtet, dass die Temperaturen der Flecken angestiegen sind, wie für derartige Veränderungen im Magnetfeld zu erwarten war. Wenn sich der Trend fortsetzt, wird die Feldstärke unter die 1.500 Gauß-Schwelle sinken und die Sonnenflecken werden zum großen Teil verschwinden, weil das Magnetfeld nicht mehr stark genug ist, um die konvektiven Kräfte auf der Sonnenoberfläche zu überwinden.

Bei der Auswärtsbewegung hat Richard Altrock, Leiter beim Air Force Korona-Forschungsprogramm „NSO Sunspot“, Neu Mexiko, eine Verlangsamung des Drangs zu den Polen beobachtet (“rush to the poles”), einer raschen Polwärtsbewegung der Magnettätigkeit in der schwachen Sonnenkorona. Altrock hat Beobachtungen aus vier Jahrzehnten mit dem 40-cm koronografischen Teleskop in Sunspot benutzt.

“Der Schlüssel zum Verständnis dieser wunderbar feinen Korona-Erscheinungen ist, dass diese tatsächlich mächtigen robusten Strukturen aus dem Inneren der Sonne kommen,“ erklärte Altrock. „Änderungen in der Korona spiegeln Veränderungen aus der Tiefe der Sonne.“

Altrock benutzte ein Photometer, um Eisen aufzuzeichnen, das auf 2 Millionen Grad C aufgeheizt war. Wenn es der Hälfte seiner Elektronen beraubt ist, wird es leicht vom aufsteigenden Magnetismus von der Sonne konzentriert. Einem wohlbekannten Muster folgend beginnt Sonnenaktivität etwa bei 70 Grad Breite zu Beginn eines Zyklus, mit dem Altern des Zyklus bewegt sich die Aktivität äquatorwärts. Gleichzeitig schieben neue Magnetfelder die Überreste des alten Zyklus bis zu 85 Grad polwärts.

“Während der Zyklen 21 bis einschließlich 23 ereignete sich das solare Maximum, als der Drang zu den Polen die durchschnittliche Breite von 76 Grad erreichte,” sagte Altrock. “Zyklus 24 fing spät und langsam an, und er könnte nicht stark genug sein, einen Drang zu den Polen zu erzeugen, was auf ein schwaches solares Maximum im Jahr 2013 hindeuten würde, wenn überhaupt eins stattfindet. Wenn der Drang zu den Polen nicht eintritt, stellt das ein schreckliches Dilemma für die Theoretiker dar, weil es heißen würde, dass das Magnetfeld von Zyklus 23 nicht vollständig aus den Polarregionen verschwände. (Diesen Kraftakt vollbringt der Drang zu den Polen). Wer weiß, was die Sonne dann machen wird.”

Alle drei Forschungsrichtungen deuten an, dass der bekannte Sonnenfleckenzyklus für eine Weile ausgeschaltet ist.

“Wenn wir recht haben,” schloss Hill, “könnte dies das letzte solare Maximum gewesen sein, das wir für mehrere Jahrzehnte gesehen haben. Alles würde davon beeinflusst, die Weltraumerkundung wie auch das Erdklima.“

# # #

Aus einer offiziellen Pressemitteilung des Southwest Research Institute Planetary Science Directorate mit der AAS (Amerikanische Astronomische Gesellschaft).

Diese Forschungsergebnisse sind auf dem kürzlichen Treffen der AAS/SPD vorgestellt worden: Zitiert nach:16.10: “Large-Scale Zonal Flows During the Solar Minimum — Where Is Cycle 25?” by Frank Hill, R. Howe, R. Komm, J. Christensen-Dalsgaard, T.P. Larson, J. Schou & M. J. Thompson.17.21: “A Decade of Diminishing Sunspot Vigor” by W. C. Livingston, M. Penn & L. Svalgard.18.04: “Whither Goes Cycle 24? A View from the Fe XIV Corona” by R. C. Altrock.

Quelle: Southwest Research Institute Planetary Science Directorate http://www.boulder.swri.edu/

Ergänzendes Bildmaterial: http://www.boulder.swri.edu/~deforest/SPD-sunspot-release/

Anthony Watts: Den Originalartikel finden Sie hier

Die Übersetzung besorgte Helmut Jäger EIKE

Ich bin sehr enttäuscht über den abwärts führenden Weg, dem die AMS während der letzten 10 bis 15 Jahre mit ihrer Propagierung der Hypothese von der anthropogenen globalen Erwärmung (AGW) gefolgt ist. Die Gesellschaft hat ganz offiziell eine Position übernommen, mit der viele unserer Mitglieder in der AMS nicht überein stimmen. Wir glauben, dass die Menschen wenig oder gar keinen signifikanten Einfluss auf das globale Klima haben, und dass die zahlreichen globalen Zirkulationsmodelle (GCMs) sowie die vier IPCC-Zustandsberichte keine realistisch genauen Projektionen der Zukunft zur Verfügung stellen. Dass die AMS diese Position einnimmt, mit der so viele Mitglieder nicht notwendigerweise übereinstimmen, zeugt mehr von einer politischen als von einer wissenschaftlichen Agenda.

Der geschäftsführende Direktor der AMS Keith Seitter sowie die anderen höher gestellten Funktionäre der AMS und der Rat haben nicht die wissenschaftliche Reife und Weisheit gezeigt, die wir von den Führern der AMS erwarten. Ich stelle in Frage, ob sie überhaupt wissen, wie weit die AMS bereits vom richtigen Weg abgekommen ist, seit sie eine so dümmliche Pro-AGW-Haltung eingenommen hat.

Die Amerikanische Meteorologische Gesellschaft AMS wurde 1919 gegründet als eine Organisation, die sich dem wissenschaftlichen Fortschritt zu den Themen Wetter und Klima verschrieben hat. Sie war ein herausragender Leuchtturm, um neues Verständnis über atmosphärische und ozeanische Vorgänge zu fördern. Aber dieses starke positive Bild wird nun als Folge der Kapitulation des AMS-Vorstands vor den Klimamodellierern sowie den externen Umwelt- und politischen Gruppen immer mehr getrübt, wollen sie doch die derzeitige Haltung der AMS zu AGW dazu missbrauchen, ihre eigenen speziellen Interessen durchzusetzen. Die Effektivität der AMS als eine objektive wissenschaftliche Organisation wird in großem Umfang kompromittiert.

Wir Mitglieder der AMS haben es zugelassen, dass eine kleine Gruppe von Administratoren in der AMS, Klimamodellierer und Sympathisanten der Erwärmung durch CO2 die internen Vorgänge unserer Gesellschaft zur Unterstützung der AGW-Politik steuert, ohne Rücksicht darauf, was unsere hoch dekorierten Mitglieder denken mochten. Diese kleine organisierte Gruppe von AGW-Sympathisanten hat unsere Gesellschaft wirklich gekapert [Hervorhebung im Original, ebenso wie alle Folgenden].

Die AMS sollte als Moderator der wissenschaftlichen Diskussion um das Für und Wider der AGW-Hypothese fungieren und nicht nur die eine Seite der Medaille übernehmen. Die AMS hat eine offene und ehrliche wissenschaftliche Debatte der AGW-Hypothese nicht so zugelassen, wie es eigentlich der Fall sein sollte. Warum haben sie sich vor einer offenen Diskussion bei einem so bedeutenden Thema gedrückt? Man hat mir gesagt, dass die Amerikanische Ökonomische Gesellschaft [the American Economic Society] sich nicht einseitig bei einer kontroversen wirtschaftlichen Diskussion auf eine Seite festlegt, sondern hauptsächlich dabei hilft, eine Diskussion über das Für und Wider am Leben zu halten. Dies sollte auch bei der AMS so sein, ist es aber nicht.

Inzwischen hat sich herausgestellt, dass die Vorhersagen zur künftigen Klimaentwicklung, die James Hansen 1988 vor dem US-Kongress abgegeben hatte, nicht im Geringsten der Wirklichkeit entsprachen. Er kann nicht erklären, warum es während der letzten 10 bis 12 Jahre keine signifikante globale Erwärmung gegeben hat.

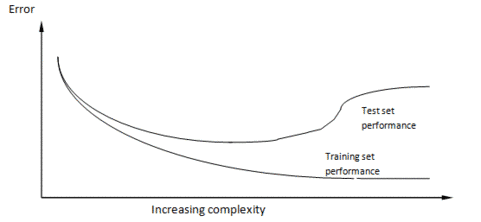

Viele von uns Mitgliedern der AMS glauben, dass die beobachtete moderate globale Erwärmung natürlichen Ursprungs ist und zurückgeführt werden kann auf multidekadische und jahrhundertelange Änderungen der globalen Zirkulation in den Ozeanen der Welt aufgrund wechselnden Salzgehaltes. Diese Änderungen haben nichts mit der CO2-Zunahme zu tun. Die meisten der GCM-Programmierer haben kaum Erfahrung in praktischer Meteorologie. Sie verstehen einfach nicht, dass die stark chaotische Natur des ozeanisch-atmosphärischen Klimasystems die Festlegung auf bestimmte Ausgangswerte, auf denen die numerische Klimavorhersage fußt, nicht zulässt. Die Simulationen der GCMs scheitern in mindestens zwei fundamentalen Dingen:

Die freie Fahrt der Modellierer. Es ist überraschend, wie lange die GCMs in der Lage waren, mit ihren unrealistischen Modellierungen davon zu kommen. Eine Erklärung ist, dass sie in erheblicher Weise durch Senator/Vizepräsident Al Gore und andere Politiker unterstützt worden sind, die über drei Jahrzehnte lang versucht haben, aus der Zunahme des CO2 politisches Kapital zu schlagen. Ein anderer Grund ist, dass die vielen Umwelt- und politischen Gruppen (einschließlich der Main-Stream-Medien) darauf versessen waren, die Ergebnisse der GCMs als Rechtfertigung dafür zu benutzen, ihre eigenen speziellen Interessen unter dem Banner der globalen Erwärmung voranzutreiben. Eine dritte Erklärung ist, dass sie nie durch Begutachter herausgefordert worden sind, die offensichtlich die Möglichkeiten erkannt haben, ähnlich hohe Forschungsgelder gewährt zu bekommen, wenn sie es Hansen und den ersten GCM-Modellierern einfach nachmachen.

Ich nehme an, dass es während der nächsten 15 bis 20 Jahre aus natürlichen Gründen zu einer moderaten globalen Abkühlung kommt. Sie wird ähnlich verlaufen wie die schwache globale Abkühlung zwischen den frühen vierziger und den mittleren siebziger Jahren. Dabei muss darauf hingewiesen werden, dass der CO2-Gehalt auch während dieser früheren Abkühlungsperiode gestiegen ist, ganz im Gegensatz zur behaupteten Beziehung zwischen CO2 und Temperatur.

Eine erwartete Abkühlung während der nächsten 15 bis 20 Jahre wird es (nach meiner Ansicht) wegen der gegenwärtig sehr starken MOC geben, die sich während der vergangenen eineinhalb Jahrzehnte etabliert hat und die sich noch ein paar Jahrzehnte lang fortsetzen dürfte. Ich erkläre mir die generelle globale Erwärmung der letzten eineinhalb Jahrhunderte (seit dem Beginn der industriellen Revolution) als Ergebnis einer viele Jahrhunderte langen Verlangsamung der ozeanischen MOC. Die Zunahme des CO2-Gehaltes dürfte nur einen kleinen Bruchteil (0,1 bis 0,2°C) zu der seit 1850 beobachteten Erwärmung um etwa 0,7°C beigetragen haben. Natürliche Prozesse waren zum größten Teil verantwortlich für den größten Teil der Erwärmung der letzten eineinhalb Jahrhunderte.

Diskussion. Die AMS ist die bedeutendste aller wissenschaftlichen Gesellschaften unserer Nation, haben doch ihre Mitglieder höchste wissenschaftliche und technische Erfahrung in Meteorologie und Klima. Sie sollte führend dabei sein, die Behauptungen der AGW-Befürworter und ihrer skeptischen Kritiker zusammen zu bringen. Unser aus dem Angelsächsischen abgeleitetes Gesellschaftssystem basiert auf dem Gedanken, dass der beste Weg zur Wahrheitsfindung darin besteht, gegensätzliche Ansichten eines fortwährenden Ereignisses in einer offenen Diskussion vor einer unparteiischen Jury zu diskutieren. Nichts dergleichen geschah in punkto AGW. Anstatt solche Treffen zu einer freien und offenen Debatte über die grundlegende Physik und die Wahrscheinlichkeit einer anthropogen verursachten Klimaänderung zu organisieren, haben die Führer der Gesellschaft (mit Rückendeckung durch die AGW-Enthusiasten in der Gesellschaft) beschlossen, in vollem Umfang den Klimamodellen zu vertrauen und offene Diskussionen über dieses Thema absichtlich vermieden. Ich weiß von keiner durch die AMS gesponserten Konferenz, auf der die AGW-Hypothese offen und frei diskutiert worden wäre. Lange Zeit habe ich mir ein Forum gewünscht, um meinem Skeptizismus hinsichtlich der AGW-Hypothese Ausdruck zu verleihen. Im Rahmen der AMS ergab sich keine einzige solche Gelegenheit. Versuche, meine skeptischen Ansichten zu veröffentlichen, gestalteten sich äußerst schwierig. In einer der Ablehnungen wurde behauptet, dass ich zu weit vom Denken des Main Stream entfernt sei. In einer anderen hieß es, dass meine Gedanken schon jetzt diskreditiert seien. Eine Reihe weiterer AGW-Skeptiker berichtete mir von ähnlichen Erfahrungen.

Die Klimamodellierer und ihre Unterstützer leugnen den Bedarf einer offenen Debatte der AGW-Frage mit der Begründung, dass das Thema bereits durch die Modellergebnisse eindeutig entschieden ist. Sie kamen zu dieser Ansicht, weil sie wissen, dass die Physik ihrer Modelle und die lange Dauer ihrer Vorhersageperioden vermutlich einer sachkundigen und unparteiischen Begutachtung nicht standhalten würden. Sie lehnen einfach die Diskussion in dieser Angelegenheit ab. Um die Kritik abzuwehren, haben sie sich auf eine generelle Verunglimpfung jener zurückgezogen, die die AGW-Hypothese nicht unterstützen. AGW-Skeptiker werden manchmal sogar als nicht länger glaubwürdige Wissenschaftler abgestempelt (wie ich selbst). Skeptiker werden oft als Werkzeuge der Ölindustrie diffamiert. Seit einer ganzen Reihe von Jahren läuft eine Art McCarthyismus gegen AGW-Skeptiker.

Jüngste AMS-Preisträger. Seit dem Jahr 2000 hat die AMS folgende AGW-Befürworter oder –Sympathisanten mit dem jährlich höchsten Preis (die Rossby Research Medal) ausgezeichnet: Susan Solomon (00), V. Ramanathan (02), Peter Webster (04), Jagadish Shukla (05), Kerry Emanuel (07), Isaac Held (08) und James Hansen (09). Die zweithöchste Auszeichnung (Charne Award) ging an die AGW-Befürworter und –Sympathisanten: Kevin Trenberth (00), Rich Rotunno (04), Graeme Stephens (05) Robert D. Cess (06), Allan Betts (07), Gerald North (08), Warren Washington und Gerald Meehl (09). Und die anderen Rossby- und Charney-Preisträger während dieser zeit sind nicht als Kritiker der AGW-Hypothese hervorgetreten.

Die Verzerrung in Richtung AGW innerhalb der AMS ist so tief verwurzelt, dass es für weithin bekannte und etablierte Wissenschaftler (aber AGW-Skeptiker) fast unmöglich ist, eine Auszeichnung durch die AMS zuerkannt zu bekommen, egal wie grundlegend oder brillant ihre Forschungen sind – Wissenschaftler wie Fred Singer, Pat Michaels, Bill Cotton, Roger Pielke, Sr., Roy Spencer, John Christie, Joe D’Aleo, Bob Balling, Jr., Craig Idso, Willie Soon und viele andere.

Was die Meteorologen vor Ort sagen. Mein (jahrelanger) Austausch mit einem großen Teil von AMS-Mitgliedern (die ich im Zuge meiner Vorhersage der Hurrikansaison und anderer Aktivitäten getroffen habe), die einen erheblichen Teil ihrer Laufbahn in den meteorologischen Bereichen Beobachten und Vorhersagen verbracht haben, hat darauf hingewiesen, dass die Mehrheit von ihnen der These, dass die Menschen der Hauptgrund für die globale Erwärmung seien, nicht zustimmen. Diese Meteorologen vor Ort sind zu erfahren und zu klug, um durch die Lobby der Klimamodellierer und der mit ihr verbundenen Propagandisten hereingelegt zu werden. Ich vermute, dass die AMS eine Übersicht über seine Mitglieder erstellt, die derzeit mit aktuellen Wetter- und Klimadaten arbeiten, um festzustellen, wie viele von ihnen damit übereinstimmen, dass die Menschen der Hauptgrund der globalen Erwärmung sind und dass die höchste Auszeichnung der AMS (die Rossby Research Medal) 2009 an James Hansen ging.

Globale Umweltprobleme. Es gibt keine Zweifel daran, dass die Weltbevölkerung immer mehr zunimmt und dass die zunehmende Industrialisierung viele Umweltprobleme erzeugt hat, und zwar hinsichtlich Luft- und Wasserverschmutzung, industrielle Vergiftungen, überflüssiger Landschaftsverbrauch sowie hunderte andere menschengemachte Umweltstörungen. Aber all diese anthropogenen Umweltprobleme verschwinden nicht durch drastische Anstrengungen, die CO2-Demissionen zu reduzieren. CO2 ist kein Verschmutzer, sondern Dünger. Die Menschheit braucht fossile Energie, um seinen industriellen Standard zu halten und um ihren Lebensstandard zu erweitern, so dass sie in der Lage ist, diese Nicht-CO2-Umweltprobleme besser zu handhaben. Es scheint bei vielen Leuten ein Missverständnis darüber zu bestehen, dass durch die Reduzierung des CO2-Ausstoßes die drängendsten Umweltprobleme gelöst werden können. Dem ist nicht so!

Man muss sich daran erinnern, dass fortschrittliche Industriegesellschaften mehr für die globale Umwelt tun als ärmere Gesellschaften. Durch die massenhafte Reduktion der CO2-Emissionen und erheblich steigenden Kosten für die dann erforderlichen erneuerbaren Energien wird der Lebensstandard unserer Nation abnehmen, und wir werden eben nicht mehr in der Lage sein, viele unserer Umwelt-, politischen und sozialen Probleme zu lösen.

Erreichen einer ausgewogenen Sichtweise zu AGW. Um zu verstehen, was wirklich im Hinblick auf die AGW-Frage geschieht, muss man jetzt eine Verbindung zwischen der AMS, den Main-Stream-Medien und der Grundlinie wissenschaftlicher Journale herstellen. Meistens wurden sie dazu gebracht, die AGW-Hypothese zu akzeptieren und ganz allgemein gegen jeden vorzugehen, der nicht zustimmt, dass AGW nach dem Nuklearkrieg das ernsteste langfristige Problem für unsere Gesellschaft ist.

Um irgendeine Art einer ausgewogenen Hin-und-her-Diskussion zum Thema AGW zu bekommen, muss man die vielen Blogs betrachten, wobei es sowohl Befürworter als auch Skeptiker hinsichtlich AGW gibt. Diese Blogs sind die einzige Quelle für eine echte offene Debatte zur Gültigkeit der AGW-Hypothese. Hier findet die echte Wissenschaft in Bezug auf AGW statt. Während der letzten Jahre sorgte die Masse der Gegenbeweise, wie sie in diesen Blogs präsentiert wird, dafür, dass die Stimmung für die AGW-Hypothese zu kippen beginnt. Angesichts der Tatsache, dass die Erde sich nicht so erwärmt, wie es die GCMs simuliert hatten, verliert die amerikanische Öffentlichkeit allmählich den Glauben an die früheren Behauptungen von Gore, Hansen und die vielen anderen AGW-Befürworter.

Vorhersage. Die AMS wird in künftigen Jahren so beurteilt werden: sie hat törichterweise ihre große wissenschaftliche Reputation für politische und finanzielle Zwecke geopfert. Ich bin sicher, dass sich Hunderte unserer älteren verstorbenen AMS-Mitglieder in ihren Gräbern umdrehen angesichts dessen, was aus ihrer und unserer großen Gesellschaft geworden ist.

Gastbeitrag von Bill Gray, Professor Emeritus, Colorado State University, seit über 50 Jahren AMS-Mitglied, ausgezeichnet mit dem Charney Award.

Übersetzt und mit einer Einführung versehen von Chris Frey für EIKE

Link: http://wattsupwiththat.com/2011/06/16/on-the-hijacking-of-the-american-meteorological-society-ams/

Link zum Brief von Hal Lewis: hier

Der Tag, an dem Angela Merkel die Sonnenenergie nach Nordvorpommern brachte, begann trübe und wolkenverhangen. Die Bundeskanzlerin war trotz enger Terminlage in ihren Wahlkreis gefahren, um im Orte Grimmen an der Trebel den Bau des größten Solarparks von Mecklenburg-Vorpommern auf den Weg zu bringen. Dass sich die Sonne bei dem symbolträchtigen ersten Spatenstich im Oktober vergangenen Jahres partout nicht zeigen wollte, tat Merkels guter Laune ebenso wenig Abbruch wie die Tatsache, dass die 30 480 Solarmodule auf der 19 Hektar großen Fläche allesamt den Stempel "Made in China" tragen sollten. "Der Solarpark ist eine Zukunftsinvestition", sagte die Regierungschefin unverdrossen und stach den rot lackierten Spaten in die bröckelige Tonerde: "Wir sind auf dem Weg in das Zeitalter erneuerbarer Energien.

Bei ihrer Unterstützung für die Solarwirtschaft weiß die Bundeskanzlerin die Mehrheit der Bevölkerung hinter sich. Sonnenstrom ist die Wunschenergie Nummer eins für die Deutschen, das ergab in der vergangenen Woche eine Umfrage, die der Wirtschaftsverband führender Public-Relations-Agenturen in Deutschland (GPRA) mit den Marktforschern von TNS Emnid veröffentlichte. Danach messen 99 Prozent der Befragten "der Sonnenenergie eine besonders hohe Wichtigkeit für die zukünftige Energieversorgung in Deutschland" bei. Die Sonne sei "aus Sicht der Verbraucher die wichtigste Energiequelle der Zukunft – noch vor Wasserkraft und Windkraft", heißt es im Ergebnis der Umfrage. Weniger als die Hälfte der Befragten glaubten dagegen noch an eine wichtige Rolle der Kohlekraftwerke, nur ein Fünftel an Atomkraft. "Die deutsche Bevölkerung hat die Energiewende längst vollzogen und vertraut regenerativen Energiequellen", lautet das Fazit des GPRA-Präsidiummitglieds Uwe Kohrs. Angesichts der derzeit diskutierten Kürzungspläne für Solarsubventionen müssten "Politik und Energieversorger aufpassen, dass sie nicht alles Restvertrauen verspielen."

Wissenschaftler aber reiben sich verwundert die Augen angesichts solcher Vorstellungen über die Struktur der deutschen Energieversorgung. Atom- und Kohlekraftwerke decken heute noch drei Viertel des deutschen Strombedarfs. Solarmodule tragen tatsächlich erst drei Prozent zur Bedarfsdeckung bei. Schon der Beitrag der Windenergie übertrifft den der Solaranlagen um ein Vielfaches – für einen Bruchteil der Kosten. Die Solarenergie kostet die Verbraucher Jahr für Jahr hohe Milliardenbeträge, verteuert den Klimaschutz, lässt sich nicht wirtschaftlich speichern und fällt in mehr als der Hälfte des Jahres fast komplett aus. Auch industriepolitisch ist die Solarförderung ein gewaltiger Schuss in den Ofen: Bereits mehr als 70 Prozent der in diesem Jahr in Deutschland verbauten Solarmodule stammen aus Asien.

Die Nachteile der solaren Energieversorgung im schattigen Deutschland sind aus wissenschaftlicher Sicht so eklatant, dass der Sachverständigenrat für Umweltfragen, ein hochkarätiges Beratergremium der Bundesregierung, dazu rät, den Ausbau der Fotovoltaik nicht mehr weiter zu forcieren, sondern im Gegenteil in sehr engen Grenzen zu halten. Der Flensburger Umweltwissenschaftler Olav Hohmeyer, ein Mitglied des Sachverständigenrats, fordert, die derzeitige solare Ausbaurate um mindestens 85 Prozent zurückzuschrauben, auf nur noch 500 bis 1000 Megawatt pro Jahr. Dabei ist der Sachverständigenrat durchaus kein natürlicher Feind erneuerbarer Energien: In anderen Gutachten zeigt das Professorengremium Wege auf, wie Ökostrom bis 2050 den kompletten deutschen Energiebedarf decken kann, verzichtet dabei aber lieber auf ein Übermaß an Sonnenenergie.

Die Forscher stehen mit ihrer Meinung nicht allein. Das Rheinisch-Westfälische Institut für Wirtschaftsforschung (RWI) sagt wegen des "Hype um die Fotovoltaik" in Deutschland einen "weiter anschwellenden Kosten-Tsunami" voraus. Das RWI, das zu den renommiertesten deutschen Wirtschaftsforschungsinstituten gehört, schlägt angesichts der deutschen Defizite bei Stromspeichern, Stromleitungen und der mangelhaften Vernetzung mit den europäischen Nachbarn deshalb sogar ein mehrjähriges Moratorium für erneuerbare Energien vor, um "die Förderanreize für diesen Zeitraum auszusetzen". Auch der unabhängige Energieexperte Sven Bode vom Arrhenius Institut für Energie- und Klimapolitik in Hamburg stellt offen die Frage, "ob die Förderung der Fotovoltaik nicht bereits heute vollständig eingestellt werden sollte".

Doch danach sieht es ganz und gar nicht aus: Die Fraktionen der Regierungsparteien wollen sich Morgen über die Novelle des Erneuerbare-Energien-Gesetzes verständigen und dabei auch die Vergütungssätze für die unterschiedlichen Ökostrom-Arten festschreiben. Schon jetzt ist absehbar, dass es zu keinen nennenswerten Abstrichen bei den Solarsubventionen kommen wird. Vorgesehen ist im derzeitigen Gesetzentwurf lediglich, dass die Einspeisevergütung um jeweils drei bis vier Prozentpunkte sinkt, wenn der Grenzwert von 3500 Megawatt um 1000 Megawatt überschritten wird. Dass dies ausreicht, die solare Kostenexplosion zu beenden, glaubt kaum ein Marktbeobachter.

Der Wirtschaftsflügel der Unionsfraktion im Bundestag ist dabei schon bereit, die richtigen Konsequenzen zu ziehen: Er will den Fotovoltaik-Zubau in Deutschland – wie in anderen Ländern längst üblich – durch einen festen "Ausgabendeckel" begrenzen. Thomas Bareiß, der die Energiepolitik der CDU/CSU-Fraktion koordiniert, will mit dieser Forderung auch in die Koalitionsgespräche im Bundestag gehen, denn: "Was sich hier abzeichnet, ergibt energiewirtschaftlich keinen Sinn und ist sozialpolitisch verantwortungslos."

Doch Bareiß hat Zweifel, ob sich die Position des Wirtschaftsflügels der Union in den Koalitions- und Fraktionsgesprächen noch durchsetzen wird. Auch die anderen Wirtschaftspolitiker der Fraktion glauben nicht, dass sie bei der eigenen Parteiführung und beim Koalitionspartner FDP durchdringen.

Warum die Bundesregierung den Subventionsirrsinn jetzt nicht beendet, ist offensichtlich. Zu groß ist die Sorge der Partei- und Regierungsspitzen, vor den anstehenden Landtags- und Bundestagswahlen vom ökologischen Mainstream der Bevölkerung abgestraft zu werden. Nach außen hin wolle die Bundesregierung nach der Abschaltung der Kernkraftwerke eben nicht nur als "Ausstiegspartei" wahrgenommen werden, formuliert es ein hoher Beamter des Bundeswirtschaftsministeriums: "Ebenso wichtig ist es zu zeigen, dass man auch in etwas einsteigt." Und die Kappung von Solarsubventionen – wie sinnvoll sie inhaltlich auch immer sein mag – "passt da eben nicht ins Bild".

Folge dieses politischen Populismus dürfte sein, dass auch in den kommenden Jahren jeweils mehr als die Hälfte der vom Verbraucher zu zahlenden Ökostrom-Milliarden an die Solarindustrie fließen wird – und hier wiederum zum weitaus größten Teil an die asiatischen Modul- und Zellen-Hersteller. Während die Solarlobby in der Öffentlichkeit behauptet, die Bundesregierung würde bei ihrer Energiewende die Windkraft bevorzugen, sprechen die Zahlen eine völlig andere Sprache: Nach der offiziellen Statistik des Bundesumweltministeriums wurden im vergangenen Jahr rund 19,5 Milliarden Euro für die Errichtung von Fotovoltaik-Anlagen in Deutschland ausgegeben, jedoch nur 2,5 Milliarden für die deutlich ergiebigere Windkraft. Während die installierte Leistung der Solarmodule 2010 um 7500 Megawatt zunahm, wuchs die angeblich bevorzugte Windkraft lediglich um 1500 Megawatt. Ein Missverhältnis, das sich nach den Zubauprognosen in diesem Jahr weiter verfestigen dürfte.

In ihrem "Energiekonzept" hatte sich die Bundesregierung im vergangenen Jahr noch das Ziel gesetzt, den Anteil erneuerbarer Energien bis 2020 von heute 17 auf dann 30 Prozent zu erhöhen. Nach der Reaktorkatastrophe von Fukushima und der Abschaltung mehrerer deutscher Atomkraftwerke wurde der zu erreichende Ökostrom-Anteil jetzt auf "mindestens 35 Prozent" heraufgesetzt. So steht es im Entwurf des Erneuerbare-Energien-Gesetzes, das Ende kommender Woche vom Bundestag in zweiter und dritter Lesung verabschiedet werden soll. Doch viele Ökonomen und nicht wenige Bundestagsabgeordnete fragen sich inzwischen, wie die beschleunigte "Energiewende" innerhalb von zehn Jahren gelingen soll, wenn die Förderpolitik für Ökostrom dem luxuriösen Motto "Vom Teuersten das Meiste" folgt. Müsste man angesichts des Zeitdrucks und der knappen Mittel nicht die effizientesten Techniken am stärksten fördern?

Dass die "Energiewende" eher zu einer "Sonnenwende" zu werden droht, hat viel damit zu tun, dass die einseitige Argumentation der Solarlobby öffentlich kaum je hinterfragt wird. Aber halten die wichtigsten Argumente einer Überprüfung stand?

"Die Sonne schreibt keine Rechnung": Angesichts der realen Kosten für Verbraucher und Volkswirtschaft bekommt das beliebte Lobbyistenwort einen fast zynischen Beiklang. Strom aus Solarmodulen, die im Jahre 2005 montiert wurden, wird 20 Jahre lang mit 50,23 Cent pro Kilowattstunde vergütet. Dieser Wert übersteigt den Börsenwert für Elektrizität um das Zehnfache. Die Stromnetzbetreiber sind verpflichtet, den Solarstrom, wie anderen Ökostrom auch, vorrangig einzuspeisen und mit dem gesetzlichen Fixpreis zu bezahlen. Die gewaltige Differenz zum eigentlichen Marktwert wird über die Stromrechnung auf alle Verbraucher abgewälzt.

Zwar wurde die Einspeisevergütung in mehreren Schritten gesenkt – auf heute rund 28 Cent pro Kilowattstunde. Doch weil der Preisverfall bei Solarmodulen noch drastischer war, können Investoren noch immer Traumrenditen auf Kosten der Verbraucher erzielen. Während ein Tagesgeldkonto derzeit kaum 2,5 Prozent abwirft, können Besitzer von Solardächern völlig risikolos jährlich sechs bis acht Prozent Gewinn einstreichen, gesetzlich garantiert über 20 Jahre lang. Kein Wunder, dass die Zahl der Fotovoltaik-Anlagen Jahr für Jahr exponentiell auf inzwischen mehr als 800 000 mit einer Gesamtleistung von rund 17 000 Megawatt angewachsen ist. Zum Vergleich: Ein Atomkraftwerk hat ungefähr 1000 Megawatt Leistung.

Die Frage, welche Nettokosten von den Verbrauchern zu schultern sind, hat in der Vergangenheit einigen wissenschaftlichen Streit ausgelöst. Das Rheinisch-Westfälische Institut für Wirtschaftsforschung hat die Strommengen aller bis Ende 2010 installierten Solarmodule mit ihren Einspeisetarifen summiert und um den eigentlichen Marktwert des Stroms bereinigt. Ergebnis: Allein für die bis Ende letzten Jahres verbauten Module wird der deutsche Verbraucher mit reinen Subventionskosten oder "Solarschulden" von real 81,5 Milliarden Euro belastet, die er über einen Zeitraum von zwanzig Jahren abzustottern hat.

Mit diesem gewaltigen Entzug an volkswirtschaftlicher Kaufkraft zahlt der Bürger für eine Stromquelle, die in jeder Nacht und mit Einbruch der dunklen Jahreszeit ihren Beitrag zur Stromversorgung fast völlig einstellt und durch andere Kraftwerke ersetzt werden muss. Obwohl die Solarenergie in diesem Jahr nur etwa 20 Prozent des gesamten Ökostrom-Aufkommens in Deutschland stellt und lediglich drei Prozent des gesamten Strombedarfs deckt, verschlingt sie 55 Prozent der gesamten Ökostrom-Beihilfen nach dem EEG.

Sogar die "Agentur für Erneuerbare Energien", ein in Berlin ansässiges Lobbybüro der Ökobranche, hielt das Kosten-Nutzen-Verhältnis des Solarstroms nach den RWI-Berechnungen für so schlecht, dass man das "Wuppertal Institut für Klima, Umwelt und Energie" im vergangenen Jahr mit einem Gegengutachten beauftragte. Man könne die "Horrorzahlen des RWI so nicht stehen lassen", hieß es dazu. Nötig sei endlich "eine seriöse Diskussionsgrundlage". Und tatsächlich: Das Gutachten der Wuppertaler fiel für die Ökolobbyisten wunschgemäß aus. In einer Pressekonferenz im Oktober vergangenen Jahres erklärte das Wuppertal Institut, man habe in den RWI-Berechnungen mehrere Rechen- und Bewertungsfehler gefunden, unter anderem bei der Diskontierung zukünftiger Werte. Fazit des Wuppertal Instituts: Die Subventionskosten des Solarstroms seien in Wahrheit 42 Prozent niedriger als vom RWI behauptet.

Das allerdings ließen die Essener Wissenschaftler nicht auf sich sitzen und überprüften ihrerseits die Berechnungen aus Wuppertal. Ihr Ergebnis publizierte das RWI in einer mehrseitigen Streitschrift mit dem Titel "Eine unbequeme Wahrheit": Die Wuppertaler hatten sich demnach selbst verrechnet und in ihren Formeln versehentlich doppelt abgezinst. Um diesen Fehler bereinigt, ergab die Kalkulation der Öko-Gutachter fast dieselbe "Horrorzahl", die zuvor vom RWI berechnet worden war. "Die vom RWI ermittelte Größenordnung der Kosten der deutschen Solarstromförderung wird durch die Wuppertal-Studie nolens volens bestätigt", resümieren die angegriffenen Wissenschaftler aus Essen zufrieden.

Wenn der Solarausbau vom Bundestag in der kommenden Woche nicht gedeckelt wird, steigen die Solarkosten innerhalb kürzester Zeit sogar auf einen dreistelligen Milliardenbetrag. Nach Berechnungen des RWI kämen bis 2020 für die deutschen Verbraucher weitere 42 Milliarden Euro Kosten hinzu. Dies allerdings auch nur unter der konservativen Annahme, dass der Solarzubau ab 2012 auf 3500 Megawatt jährlich begrenzt werden kann. Es könnte auch noch doppelt so teuer werden, wenn es bei der bisherigen Zubaurate bleibt.

Die Förderung der Solarbranche ist längst so hoch, dass sie den Bundeshaushalt völlig überfordern würde. Mehr als sieben Milliarden Euro überweisen die deutschen Verbraucher in diesem Jahr wohl an die Besitzer von Solaranlagen. Das übersteigt den Etat des Bundesumweltministeriums von 1,6 Milliarden Euro um fast das Vierfache. Die Summe, die von allen Bundesministerien zusammen in diesem Jahr für Energieforschung ausgegeben wird, beträgt mit 700 Millionen Euro nur ein Zehntel der Solarförderung.

Der Wissenschaftliche Beirat des Bundeswirtschaftsministeriums warnt angesichts der "riesigen Subventionen" bereits vor einem "gewaltigen Umverteilungsprogramm". Es wäre mit einem Volumen von mehr als 100 Milliarden Euro tatsächlich die größte soziale Umverteilung von unten nach oben, die je von einer sozialdemokratischen Regierung mit ausgelöst wurde. Denn die Milliardenlast zahlt der Mieter mit seiner Stromrechnung, den Ertrag streicht der tendenziell wohlhabende Solardach- also Immobilienbesitzer ein. Allein zu Jahresbeginn 2011 erhöhte sich die EEG-Umlage zur Förderung des Ökostroms in einem einzigen großen Schritt um 70 Prozent auf 3,53 Cent pro Kilowattstunde. Der Kostensprung, der den Strompreis für Privathaushalte um rund zehn Prozent verteuerte, war fast ausschließlich auf den Fotovoltaik-Zubau zurückzuführen.

Die Kosten der Solarförderung mit denen der Kernenergie zu vergleichen und so zu relativieren, ist ein beliebtes Argument von Solarfreunden. Tatsächlich sind die Beihilfen für beide Technologien gar nicht mehr so weit von einander entfernt. In einer Studie zur staatlichen Förderung von Atomkraft kommt Greenpeace zu dem Ergebnis, dass die staatlichen Forschungsgelder für die Nukleartechnik bis 2010 real – also in Preisen des Jahres 2010 – rund 55 Milliarden Euro betrugen. Insgesamt gaben die öffentlichen Haushalte für die Atomkraft bislang sogar 203,7 Milliarden Euro aus, heißt es in der Greenpeace-Berechnung. Eine hohe Zahl, die auch dadurch zustande kommt, dass selbst "die Vorteile der Atomenergie durch den Emissionshandel" als Kostenpunkt angesetzt wurden – und eine Reihe weiterer fragwürdiger Posten, zum Beispiel die "Sanierungskosten des sowjetischen Uranerzbergbaus in Wismut".

Tatsächlich kommen die Solarkosten den von Greenpeace errechneten Atom-Subventionen schon recht nahe. Denn der Ausbau der Verteilnetze in den Kommunen, der wegen des Solarbooms nötig wird, kostet Experten zufolge allein schon rund 30 Milliarden Euro zusätzlich. Kommt es zum erwarteten Ausbau des Solarstroms, addieren sich Subventionen und Netzausbaukosten bis 2020 ebenfalls schon auf 150 Milliarden Euro. Noch nicht eingerechnet sind dabei die indirekten volkswirtschaftlichen Kosten, die durch die so ausgelösten Strompreissteigerungen entstehen, wie etwa Produktionsverlagerungen ins Ausland oder Arbeitsplatzabbau.

Kommt es also nicht zu einer effektiven Ausbaubremse für Fotovoltaik, dürften die Solar-Kosten in absehbarer Zeit denen der Kernenergie gleichen. Einziger Unterschied: Atomkraftwerke haben für dieses Geld den Strombedarf der größten europäischen Volkswirtschaft 40 Jahre lang rund um die Uhr zu einem Viertel gedeckt. Solarenergie deckt derzeit nur drei Prozent des Strombedarfs und kann nach Angaben des Bundesverbandes Solar auch im Jahr 2020 nur maximal neun Prozent zur Bedarfsdeckung beitragen, wie es in der "PV-Roadmap" des Verbandes heißt. Dabei ist freilich zu berücksichtigen, dass der Beitrag der Solar-Technologie in jeder Nacht und während langer Wintermonate fast auf null sinkt und dann komplett von einem weiteren, "doppelten" Kraftwerkspark ersetzt werden muss, dessen enorme Kosten in der Rechnung ebenfalls noch nicht berücksichtigt sind.

Setzt sich die Solarlobby mit ihren Subventionswünschen politisch durch, dürfte im Jahr 2020 eine installierte Leistung von 70 Gigawatt Sonnenenergie am Netz sein. Dieses Ziel hat die Branche in ihrer "PV-Roadmap" selbst ausgegeben. Allerdings beträgt die gesamte Stromnachfrage Deutschlands im Schnitt nur 60 Gigawatt. Schon in zwei oder drei Jahren werden Solar- und Windkraftanlagen gemeinsam an einigen Tagen im Sommer, zur hellen Mittagszeit, phasenweise deutlich mehr Strom produzieren, als überhaupt nachgefragt wird. Wegen des gesetzlichen Einspeisevorrangs für Ökostrom müssten während dieser Stunde alle anderen Atom- Kohle- und Gaskraftwerke nicht nur gedrosselt, sondern komplett abgeschaltet werden.

Weil das mit enormen Kosten und technischen Risiken verbunden ist, bleibt als Alternative nur, den überschüssigen Strom an ausländische Abnehmer zu "verschenken". Die jüngsten Erfahrungen am Strommarkt zeigen allerdings, dass ausländische Abnehmer deutschen Ökostrom noch nicht einmal geschenkt haben wollen – sie nehmen ihn nur gegen Zuzahlung ab. Das hat in den letzten Monaten bereits mehrmals zum Effekt "negativer Strompreise" an der Europäischen Energiebörse geführt.

Die Besitzer großer Pumpspeicherkraftwerke wie etwa Österreich oder die Schweiz profitieren in diesen Stunden doppelt vom deutschen Ökowunder: Zunächst lassen sie sich die Abnahme des zur Unzeit produzierten deutschen Stroms teuer bezahlen. Dann kassieren sie für dieselben Kilowattstunden ein zweites Mal, wenn sie die gespeicherte Energie aus ihren Pumpspeichern ablassen und als teuren Spitzenlaststrom nach Deutschland zurückverkaufen.

Die absehbare temporäre Überproduktion von Wind- und Solarstrom führt zu einem weiteren, bislang ungelösten Problem: Welcher Sauberstrom muss für den anderen im Netz Platz machen, wenn doch beide eigentlich gesetzlichen Einspeisevorrang genießen? Regeln dafür sind auch in der jetzigen EEG-Novelle noch nicht enthalten. Ökonomen plädieren zwar dafür, dass in Zeiten der Überproduktion der billigere Windstrom den teureren Solarstrom verdrängen sollte. Doch RWI-Experte Frondel fürchtet, dass es wohl eher die leicht regelbaren Windparks sein werden, die in einer solchen Situation abgestellt werden, "da das Abschalten einer großen Zahl an kleinen, dezentralen Fotovoltaikanlagen mit großem Aufwand verbunden sein dürfte." Teuer verdrängt billig: Für die Verbraucher dürfte das anbrechende Solarzeitalter noch einige Überraschungen bereit halten.

Dass Solarstrom "dezentral" produziert wird, stellt der Lobbyverband der Branche gern als Vorteil heraus, ohne allerdings zu erklären, worin eigentlich genau dessen Wert liegt. "Ob Einfamilien-, Mehrfamilien- oder Mietshaus: Jeder kann investieren, profitieren und sich künftig selbst versorgen", wirbt der Bundesverband Solarwirtschaft (BSW) dieser Tage in ganzseitigen Zeitungsanzeigen unter dem Titel "Solarstrom – ein Gewinn für alle". Das Argument appelliert an das unterschwellige psychologische Bedürfnis vieler Menschen nach Autarkie und Unabhängigkeit.

Allerdings bleibt Autarkie mit Solarenergie eine teure Illusion. Denn Tatsache ist, dass Solaranlagen in diesen Breitengraden nur an 875 Stunden der 8760 Stunden eines Jahres ihre Volllast erreichen. In der übrigen Zeit herrscht Nacht, schlechtes Wetter oder Winter. An neun von zehn Stunden sind Solardachbesitzer darauf angewiesen, Strom aus dem Verbundnetz zu beziehen, wie jeder andere auch.

Dennoch lautet ein Argument der Solarbranche, die dezentrale Stromerzeugung stärke auch die Wertschöpfung in den Kommunen. Fragt man vor Ort einmal nach, ist die Begeisterung der Stadtwerke über den Fotovoltaikboom allerdings begrenzt. Zum Beispiel im nordrhein-westfälischen Froendenberg im Kreis Unna. Die Stadtwerke Froendenberg sind ein Traditionsbetrieb, der schon vor 100 Jahren damit begann, mit einem Wasserkraftwerk in der Ruhr Strom zu produzieren. Auch heute noch ist der Betrieb, der 22 000 Einwohner in 14 Ortsteilen versorgt, dem Ökostrom gegenüber aufgeschlossen: Es gibt neun Windräder, drei Laufwasserkraftwerke und 340 Fotovoltaik-Anlagen in der Stadt. Nur die Tatsache, dass die Dächer überall mit blauen Modulen belegt werden, treibt Bernd Heitmann, dem Geschäftsführer der Stadtwerke, die Sorgenfalten auf die Stirn. "Fotovoltaik hat die unangenehme Eigenschaft, dass alle Anlagen bei Sonneneinstrahlung zeitgleich ans Netz gehen", sagt er. "Das erzeugt einen plötzlichen Spannungshub, der im Verteilnetz nur in begrenztem Umfang vorhanden sein darf."

Mit ihren 340 Fotovoltaik-Anlagen haben die Froendenberger bereits 5,6 Megawatt ans Netz gebracht. Dabei liegt der Strombedarf in der Region, etwa an Feiertagen, oft nur halb so hoch bei rund 2,5 Megawatt. So musste Heitmann etwa 25 Anträge auf Netzanschluss neuer Solaranlagen bereits ablehnen, weil dies sein Leitungsnetz in einigen Außenbereichen überlastet hätte.

Um dem Solar-Problem Herr zu werden, müsste das kleine Stadtwerk allein 12 bis 13 Millionen Euro in den Ausbau der Leitungsnetze vor Ort investieren. "Das entspricht der Höhe unseres gesamten Eigenkapitals", sorgt sich Heitmann. Weil die Kosten des Netzausbaus vom örtlichen Netzbetreiber zu tragen sind, müssten die Stadtwerke ihre Netznutzungsentgelte erhöhen, um die Investition tragen zu können. "Das könnte sich zum Standortnachteil für unsere Stadt auswachsen", glaubt Heitmann. Aus Sicht des Stadtwerke-Chefs, "stimmt die Verhältnismäßigkeit nicht, wenn wir hier 12 Millionen Euro investieren müssen, damit 30 Leute dann ein paar Tausend Euro mit Solarstrom verdienen."

An dem Tag im vergangenen Oktober, als Bundeskanzlerin Angela Merkel den Grundstein für den größten Solarpark Mecklenburg-Vorpommerns legte, brauchte Deutschland den ganzen Tag über knapp 50 Gigawattstunden Strom. Die 17 Gigawatt installierter Solarleistung in Deutschland hätte davon einen Gutteil decken können – wenn denn die Sonne geschienen hätte. Tatsächlich aber quälte sich die Solarleistung an diesem Tag nur ganz kurz am Mittag mal über die 2-Gigawatt-Grenze, um schon bald nach 16 Uhr gegen null abzutauchen. 88 Prozent der installierten Solarleistung an diesen Tag blieben ungenutzt, und die ungeliebten fossilen Kraftwerke mussten die Versorgung übernehmen.

Ganz anders die Situation am vergangenen Pfingstsonntag. Da lag der Strombedarf Deutschlands feiertagsbedingt bei lediglich 28 Gigawatt. Zugleich brannte diesmal die Sonne und die Solaranlagen speisten den ganzen Tag über mehr als sechs Gigawatt Strom ein. Als die Sonne über Mittag am höchsten stand, deckte Solarstrom mit zehn Gigawatt Leistung allein mehr als ein Drittel des gesamten deutschen Bedarfs. Es wäre schön gewesen, wenn der relative Solarstrom-Überschuss von Pfingsten hätte gespeichert werden können für die dunkle Jahreszeit – oder zumindest für die kommende Nacht. Doch Speichertechnologien stehen in der geforderten Größenordnung auch nicht ansatzweise zur Verfügung. Nach Berechnungen des Beratungsunternehmens Boston Consulting Group (BCG) liegt die derzeitige Speicherkapazität Deutschlands bei gerade einmal sieben Gigawatt. Um das schwankende Aufkommen von Wind- und Solarstrom mithilfe von Speichern ausgleichen zu können, müsste die Speicherkapazität bis 2025 vervierfacht werden.

Die billigste Art, dies zu tun, wäre der Bau von Pumpspeicherkraftwerken. Ein temporärer Überschuss von Ökostrom wird dabei dazu genutzt, Wasser bergauf in eine Talsperre zu pumpen. Bei Windflaute oder nächtlichem Ausfall des Solarstroms kann das Wasser in Röhren zu Tal rauschen und dabei eine Turbine zur Stromproduktion antreiben. Aber das größte deutsche Pumpspeicherkraftwerk Goldisthal hat gerade mal eine Leistung von einem Gigawatt. Viel zu wenig, um in der dunklen Jahreszeit Solarausfälle ausgleichen zu können.

Die Größenverhältnisse beschreiben die Wissenschaftler Sven Bode und Helmuth Groscurth vom Hamburger Arrhenius-Institut: Um eine Woche lang ohne Wind, Fotovoltaik und ohne konventionelle Kraftwerke auszukommen, bräuchte man nach ihrer Modellrechnung 1260 Pumpspeicherkraftwerke vom Typ Goldisthal. "Abgesehen davon, dass es in Deutschland dafür keine Standorte mehr gibt", schreiben die Autoren Bode und Groscurth, "wären die Kosten für eine Kilowattstunde astronomisch, da die meisten dieser Anlagen nur für einige Stunden im Jahr betrieben würden."

Auch die Batterien von Elektroautos können als Puffer für das schwankende Ökostromaufkommen noch lange nicht dienen. Da ein Elektrosmart im Schnitt nur 40 Kilowattstunden Strom speichern kann, wären nach den Berechnungen des Arrhenius-Instituts "250 Millionen dieser Fahrzeuge erforderlich, um ausreichend Strom für Deutschland für eine Woche zu speichern".

Der Sachverständigenrat für Umweltfragen, ein Beratergremium der Bundesregierung, schlug kürzlich in einem Sondergutachten vor, die norwegischen Wasserkraftwerke als Speicher für deutschen Ökostrom zu nutzen. Allerdings geben die Dimensionen dem Projekt eher visionären Charakter. So liegt heute erst ein Kabel in der Nordsee zwischen Norwegen und den Niederlanden. Dieses NorNed-Kabel hat eine Kapazität von 600 Megawatt. Bei einer annähernden Vollversorgung Deutschlands mit Ökostrom, wie sie die Bundesregierung bis 2050 erreichen will, müssten die Kabelkapazitäten laut Sondergutachten aber auf 70 000 Megawatt mehr als verhundertfacht werden, damit die Lichter auch nachts und bei Windflaute nicht ausgehen. Da aber schon die Baukosten des NorNed-Kabels 600 Millionen Euro betragen haben, ist nicht ganz klar, wer die Baukosten tragen könnte.

Der Plan wird dadurch erschwert, dass sich schon das NorNed-Kabel nur refinanzieren lässt, weil die Preise für Elektrizität im Strommarkt Skandinavien stets deutlich vom übrigen Europa abweichen. Das erlaubt den Kabelbetreibern Handels- oder Arbitragegeschäfte, um die Baukosten wieder hereinzuholen. Diese Finanzierungsmöglichkeit wird aber in dem Maße eingeschränkt, in dem weitere Seekabel hinzukommen. Denn durch den intensiveren Stromverbund würden sich die Elektrizitätspreise zwischen Skandinavien und dem Rest Europas tendenziell angleichen. Norwegen würde auf diesem Wege geradezu das höhere deutsche Strompreisniveau "importieren". Die Finanzierung der Seekabel auf diesem Wege wäre nicht mehr möglich. Ohnedies ist es unsicher, ob die Norweger ihre Flusstäler als Speicher für deutschen Ökostrom überhaupt zur Verfügung stellen würden – zumindest ohne dafür einen üppigen Preisaufschlag zu verlangen.

Andere Methoden sehen vor, Strom in Form von Druckluft in unterirdischen Kavernen zu speichern. Doch sie sind mit hohen Wirkungsgrad-Verlusten verbunden und sind schon aus geologischen Gründen nur begrenzt einsetzbar. Blei- oder selbst Lithium-Ionen-Akkus, wie sie von einigen Solarfirmen bereits angeboten werden, lassen die ohnehin verheerende Kostenbilanz der Solartechnik völlig aus dem Ruder laufen. Dass in absehbarer Zeit genügend wirtschaftlich nutzbare Speicher für Ökostrom zur Verfügung stehen, ist damit nicht zu erwarten.

Bundesumweltminister Norbert Röttgen (CDU) erhofft sich aus der ökologischen Energiewende vor allem ein Programm zur wirtschaftlichen und technischen Erneuerung und einen "Jobmotor" für Deutschland. Insbesondere in der Solarwirtschaft sieht der Minister eine neue Hightech-Industrie heranwachsen. Die Solarsubventionen dienen aus seiner Sicht dazu, den "Technologievorsprung" und die "Marktführerschaft" der deutschen Solarindustrie zu sichern. Lassen sich Solarsubventionen also wenigstens industriepolitisch begründen?

Die Zahlen ernüchtern: Der globale Marktanteil deutscher Solarzellen-Hersteller hat sich innerhalb des letzten Jahres von 15,4 auf 9,7 Prozent fast halbiert. Im gleichen kurzen Zeitraum hat sich der Weltmarktanteil Chinas um ein Viertel auf 48 Prozent gesteigert. Gefördert mit günstigen Darlehen der chinesischen Staatsbanken kaufen die chinesischen Hersteller wie Yingli, Suntech oder JA Solar gleich ganze Produktionslinien modernster westlicher Technologie in großem Stil ein. Die Qualität der asiatischen Solarzellen steht deshalb der von deutschen Anbietern in nichts nach, wie unabhängige Testlabors bestätigen.

Kein Wunder: Wie aus der "PV-Roadmap"-Studie des Solar-Bundesverbandes hervorgeht, investieren die deutschen Hersteller lediglich 2,5 Prozent ihres Umsatzes für Forschung und Entwicklung. Erstaunlich wenig für eine vorgebliche "Hightech-Branche". Im Maschinenbau oder in der Automobilindustrie liegt die F+E-Quote mindestens doppelt so hoch zwischen fünf und acht Prozent des Umsatzes. Da in China im Vergleich zu den deutschen Fabriken auch gleich große Stückzahlen gefertigt werden, ergeben sich Kostenvorteile, mit denen die deutsche Solarindustrie längst nicht mehr mithalten kann. Von den im letzten Jahr in Deutschland verbauten Solarmodulen stammten bereits 70 bis 80 Prozent von asiatischen Herstellern. Bislang völlig unbekannte Firmen wie etwa Yingli Solar treten inzwischen als Sponsor des Erstliga-Klubs Bayern München selbstbewusst in Erscheinung. Andere bereiten die Übernahmen deutscher Wettbewerber vor, wie die geplante Übernahme des Konstanzer Herstellers Sunways AG durch die chinesische LDK Solar beweist. Sogar Maschinenbauer und Ausrüster von Solarfabriken, eigentlich eine Domäne deutscher Ingenieurskunst, werden bereits von ausländischen Konkurrenten aufgekauft. Erst im Mai hatte Roth & Rau aus Hohenstein-Ernstthal, eines der wenigen deutschen Unternehmen auf der globalen Top-10-Liste der Solarfabrik-Ausrüster, dem Übernahmeangebot der Schweizer Firma Meyer Burger zugestimmt. Was Bundesumweltminister Röttgen besonders nachdenklich stimmen sollte: Ausgerechnet die erfolgreichsten Solarfirmen mit dem stärksten Marktwachstum wie etwa Meyer Burger stammen aus Ländern, die selbst überhaupt kein eigenes Einspeisegesetz für Ökostrom haben.

Der größte deutsche Anbieter Solarworld arbeitet zwar noch profitabel. Auf der Liste der 20 größten Solarzellen-Hersteller der Welt ist der deutsche Marktführer allerdings schon nicht mehr vertreten. Dort dominieren jetzt Chinesen. Auf der gesamten Top-20-Liste findet sich überhaupt nur noch ein deutsches Unternehmen, Q-Cells. Doch der einst weltweit führende Solarkonzern ist auf Platz neun abgerutscht, Tendenz fallend. Für die ersten drei Monate des laufenden Geschäftsjahres musste Q-Cells-Chef Nedim Cen gerade einen Verlust über 41 Millionen Euro ausweisen. Seither kursieren auch im Falle von Q-Cells Gerüchte um eine feindliche Übernahme.

Dieser Trend ist – gerade mit Blick auf Arbeitsplätze in Deutschland – besonders misslich, weil die Zell- und Waferfertigung den eigentlichen "Hightech"-Teil der Solarproduktion darstellt, wohingegen das Zusammensetzen der Zellen in gerahmte Module eher dem "Medium- oder Lowtech"-Bereich zuzuordnen ist. Doch in der deutschen Branche herrscht stillschweigendes Einvernehmen über die Tatsache, dass Solarzellen in Deutschland nicht mehr wirtschaftlich zu produzieren sind. In dieser Woche war es Holger von Hebel, Chef der Firma Bosch Solar, der ankündigte, die nächsten großen Solarfabriken mit tausenden Arbeitsplätzen in Malaysia und den USA zu bauen. Wolfgang Hummel von der Hochschule für Technik und Wirtschaft (HTW) in Berlin, der den Solarmarkt seit Jahren intensiv verfolgt, glaubt: "Im Bereich der Solarzellen- und Modulproduktion ist kein weiterer Aufbau von Arbeitsplätzen in Deutschland mehr zu erwarten."

Damit hat Hummel vermutlich recht. Zwar wirbt die Solarlobby stets mit den 133 000 Arbeitsplätzen, die durch eine Kappung der Solarförderung gefährdet wären. Doch den Mythos vom angeblichen "Jobmotor" Solarindustrie hat die Branche selbst entzaubert: In ihrer eigenen "PV-Roadmap" gibt die Branche zu, dass von den 133 000 Arbeitsplätzen nur ein Bruchteil – lediglich 18 000 – in der eigentlichen Fotovoltaik-Produktion angesiedelt sind. Die Zahl von Solar-Arbeitsplätzen im Handwerk ist mit 39 000 demgegenüber mehr als doppelt so hoch. Weitere 64 000 Solar-Arbeitsplätze werden in den nicht weiter definierten Bereichen "Vorleistungen" und "Sonstiges" verortet.

Angesichts dieser Zahlenverhältnisse scheinen die zweistelligen Milliardensubventionen weniger dem Aufbau eines "Jobmotors" der Hightech-Industrie zu dienen als vielmehr einem arbeitsmarktpolitischen Strohfeuer im Handwerk. Dass sich daran allzu viel ändert, ist wenig wahrscheinlich: Sogar nach den Zielen, die sich die deutsche Solarbranche selbst steckt, soll die Zahl der Arbeitsplätze bis 2020 nicht nur nicht wachsen, sondern sogar leicht zurückgehen.

Als die Parteivorsitzenden von CDU, CSU und FDP am 23. Oktober 2009 zur Beratung ihres Koalitionsvertrages zusammenkamen, lag ein Vorschlag der Unionsarbeitsgruppe "Wirtschaft" auf dem Tisch, die schon damals ausufernden Solarsubventionen bereits zum 1. Januar deutlich um 30 Prozent zu senken. Als Angela Merkel, Horst Seehofer und Guido Westerwelle den Koalitionsvertrag tags darauf der Öffentlichkeit präsentierten, fand sich der Vorschlag der Abgeordneten darin nicht wieder. Nur unbestimmt, ohne festes Datum und Mengenangabe, stand dort, die Regierung wolle "im Dialog mit der Solarbranche" darüber reden, wie "eine kurzfristige Überförderung vermieden werden" könne.

Szenebeobachter sehen in der Verwässerung des Unionsvorschlags einen Erfolg des damaligen FDP-Vorsitzenden Guido Westerwelle. Denn Westerwelles Wahlkreis ist Bonn, wo der größte deutsche Solarkonzern Solarworld AG seinen Sitz hat. Solarworld-Chef Frank Asbeck stand nach Beobachtung mehrerer an den Koalitionsverhandlungen Beteiligter damals in regem SMS-Austausch mit seinem erklärten "Freund" Westerwelle. So dürfte es wohl auch kein Zufall sein, dass der Bundesverband der Solarwirtschaft (BSW) auch heute noch auf seiner Homepage unter dem Kapitel "Politikberatung" seine eigene Lobbyarbeit preist und dies unter der Überschrift "Ohne starke Lobby keine solare Energiewende" ausgerechnet mit einem Foto des Bundesaußenministers Guido Westerwelle dekoriert.

"Tag für Tag sind engagierte und kompetente Streiter des Verbandes auf den Fluren von Bundestag und Ministerien in Berlin unterwegs", heißt es in dem Abschnitt, in dem der BSW seine eigenen Lobbyerfolge feiert. "Die Politikberater des BSW-Solar" hätten schon "im Juni 2008 auch die Neu-Novellierung des EEG im Sinne der Branche positiv mitgestalten können." Erzielt wurden diese Erfolge mit einem außergewöhnlich hohen Etat für politische Arbeit: Der Bundesverband der Solarwirtschaft leistet sich in Berlin immerhin 29 hauptamtliche Mitarbeiter. Zum Vergleich: Die angeblich so mächtige Lobby-Organisation der deutschen AKW-Betreiber, das "Deutsche Atomforum" beschäftigt in der Hauptstadt lediglich 13 Mitarbeiter, Sekretariat und Buchhaltung schon miteingerechnet.

Doch auch Einzelunternehmen der Branche betreiben auf eigene Kosten politische Landschaftspflege. Dabei sind nicht alle Parlamentarier so ehrlich wie der Bonner SPD-Abgeordnete Ulrich Kelber, der auf seiner Homepage als "gläserner Abgeordneter" selbst zugibt, in den Jahren 2007, 2008 und 2009 jeweils Spenden in Höhe von 25 000 Euro von der Solarworld AG aus seinem Bonner Wahlkreis erhalten zu haben. Dies zusätzlich zu einer Spende über 15 000 Euro von "First Solar" im Jahre 2009. Allerdings betont der stellvertretende Fraktionsvorsitzende Kelber, durch die Gelder in seiner Arbeit nicht beeinflusst worden zu sein. Kelber ist in der SPD-Fraktion unter anderem für den Schwerpunktbereich Umwelt zuständig und ist Mitglied der "Arbeitsgruppe Energie".

Auch die IBC Solar AG aus Bad Staffelstein erklärt auf Nachfrage, dass sie "die politische Arbeit in Deutschland über Parteigrenzen hinweg unterstützt". IBC hatte unter anderem Bundeskanzlerin Merkel dafür gewinnen können, den ersten Spatenstich beim Bau des Solarpark Grimmen in Mecklenburg-Vorpommern zu setzen, den IBC errichtet und mit chinesischen Solarmodulen bestückt hatte. Als IBC in der vergangenen Woche den Baubeginn für den Solarpark "Jura" in Oberfranken feierte, war es mit CSU-Chef Horst Seehofer ebenfalls hohe politische Prominenz, die hier kamerawirksam den ersten Spatenstich setzte.

Das politische Engagement von IBC ist breit gestreut: "Die im Bundestag vertretenen Parteien CDU, CSU, SPD, FDP sowie Bündnis 90/Die Grünen wurden und werden von uns unterstützt", gibt die Firma Auskunft. Dabei halte man sich "strikt an die gesetzlichen Vorgaben", und knüpfe "in keinem Fall Bedingungen an die von uns getätigten Spenden". Wenn es im Zusammenhang mit Parteispenden zu Kontakten mit Abgeordneten komme, dann nur um die Zahlungmodalitäten abzustimmen, "nicht aber – und darauf legen wir großen Wert – um Einfluss auf die Entscheidungen dieser Mandatsträger zu nehmen."

Das klingt nach einem geradezu selbstlosen Engagement. Allerdings ergibt eine stichprobenartige Anfrage beim Schatzmeister der FDP, dass die Firma IBC Solar die Spendenempfänger relativ gezielt auswählt. "Im Jahr 2010 sind zwei Spenden in Höhe von jeweils 5000 Euro an den Kreisverband Dortmund sowie an den Kreisverband Regensburg verbucht", gibt FDP-Sprecher Wulf Oehme Auskunft. Dortmund ist der Wahlkreis von Michael Kauch, der als umweltpolitischer Sprecher der FDP-Bundestagsfraktion jetzt auch an der Verabschiedung der EEG-Novelle mitwirkt. Kurz vor den jetzt anstehenden parlamentarischen Gesprächen hatte sich Kauch für eine stärkere Kürzung, aber gegen eine feste "Deckelung" der Solarsubventionen ausgesprochen, wie sie etwa vom Wirtschaftsflügel der CDU gefordert wird. Der andere IBC-Spendenempfänger, der FPD-Kreisverband Regensburg, ist der Wahlkreis von Horst Meierhofer, dem stellvertretenden Vorsitzenden des Ausschusses für Umwelt, Naturschutz und Reaktorsicherheit im Bundestag.

Auch auf europäischer Ebene sind Solar-Lobbyisten erfolgreich: So gelang es etwa der Firma First Solar im vergangenen Jahr, bei der EU-Kommission in Brüssel eine Ausnahmegenehmigung für die Verwendung des krebserregenden Nervengifts Kadmium in der Verbindung Kadmiumtellurid zu erwirken.

Obwohl die EU-Kommission mit ihrer sogenannten RoHS-Richtlinie eigentlich die industrielle Verwendung giftiger Schwermetalle wie Quecksilber oder eben Kadmium zum Schutz von Mensch und Umwelt komplett untersagen wollte, machte sie dann für die Solarbranche doch eine Ausnahme. Die besonders günstigen und leistungsfähigen Solarmodule der Firma First Solar enthalten nach Angaben vom vergangenen Jahr pro Stück etwa sieben Gramm der toxischen Schwermetallverbindung. Nach Erkenntnissen der unabhängigen Initiative "Lobbycontrol" gab First Solar im Jahre 2009 für Lobbyarbeit in Brüssel zwischen 100 000 und 150 000 Euro aus. Dass First Solar im Kampf gegen das Kadmium-Verbot "mit problematischen Mitteln vorgegangen ist", sei "nicht auszuschließen", heißt es in dem Dossier der unabhängigen Initiative weiter.

Solarstrom gilt als "saubere" Energie, die klimaschädliche, fossile Kraftwerke verdrängt. Doch für Solarenergie gilt dasselbe wie für alle Ökostromvarianten: Unter dem Dach des Europäischen Emissionshandelssystems führen sie lediglich dazu, dass Emissionen verlagert, aber nicht vermieden werden.

Der Mechanismus wird von Vertretern der Ökostrom-Branche zwar immer wieder angezweifelt, gilt aber im Grundsatz als unwiderlegt. Denn im Kampf gegen die Kohlendioxid-Emissionen in Deutschland und Europa ist seit 2005 der sogenannte Emissionshandel das erste Mittel der Wahl. Wirtschaftssektoren bis hinunter zum einzelnen Kraftwerk bekommen eine streng begrenzte Menge an Emissionszertifikaten zugeteilt. Das sind Gutscheine, die für den Ausstoß von jeweils einer Tonne Kohlendioxid (CO2) berechtigen. Anlagenbetreiber, die weniger CO2 ausstoßen als geplant, können überzählige Zertifikate am freien Markt verkaufen. Dieses System setzt marktwirtschaftliche Kräfte für den Klimaschutz frei und erzeugt "Preissignale", die dafür sorgen, dass die Investitionen der Unternehmen zuerst in die günstigsten und effizientesten Umwelttechnologien fließen.

Durch Subventionen für bestimmte Ökostrom-Techniken wird der Emissionshandel als marktwirtschaftlich konzipiertes Klimaschutzinstrument jedoch ausgehebelt. Denn der Solarausbau sorgt zwar für weniger CO2-Emissionen in Deutschland, doch zugleich fallen dadurch in gleichem Umfang die Preise für Emissionszertifikate an der Börse. Das führt dazu, dass "Vermeidungsmaßnahmen in anderen Sektoren nicht ergriffen werden, weil es kostengünstiger ist, stattdessen Zertifikate zu kaufen", beschreiben die Wissenschaftler des Essener Wirtschaftsinstituts RWI die Wirkung: Andere Industriesektoren im europäischen Ausland "weisen folglich höhere Emissionen auf und gleichen so die Emissionseinsparungen, die im deutschen Stromerzeugungssektor durch das EEG ausgelöst werden, gänzlich aus." Im Ergebnis, so die Ökonomen, "ergibt sich lediglich eine Emissionsverlagerung". Der "Nettoeffekt" jeglicher Ökostrom-Subventionen sei, jedenfalls solange das europäische Emissionshandelssystem existiert, genau "null".

Zudem stellt die Fotovoltaik die bei Weitem teuerste Art des Klimaschutzes dar. Wissenschaftler der Internationalen Energieagentur (IEA) oder des RWI haben errechnet, wie viel es kostet, den Ausstoß von jeweils einer Tonne des Treibhausgases Kohlendioxid aus einem fossilen Kraftwerkspark durch den Einsatz verschiedener Ökostrom-Techniken zu verhindern. Ergebnis: Die CO2-Vermeidungskosten der Fotovoltaik lagen zuletzt bei rekordverdächtigen 648 Euro je Tonne. Denselben Klimaschutzeffekt würde man mit Windkraft schon für 69 Euro pro Tonne erzielen. Die Tatsache, dass an der Europäischen Strombörse in Leipzig Emissionsgutscheine für nur 16 Euro pro Tonne gehandelt werden, weist darauf hin, dass die Fotovoltaik als reines Klimaschutzinstrument sogar rund 40-mal teurer ist als die günstigste derzeit verfügbare CO2-Vermeidungstechnik.

Die Subventionierung gerade der teuersten CO2-Vermeidungstechnik aber "konterkariert das Prinzip des Emissionshandels, den Treibhausausstoß dort zu verringern, wo es am kostengünstigsten ist", stellt Manuel Frondel, Leiter des Kompetenzbereichs Umwelt und Ressourcen des RWI fest. Fazit: Welche Gründe es für die Subventionierung von Solarstrom auch immer geben mag: Klimaschutz gehört eher nicht dazu.

Obwohl also fast kein Argument der Solar-Befürworter einer kritischen Überprüfung standhält, droht der Solarzubau weiterzugehen. Denn weil die Preise für Solarmodule dank der chinesischen Billiganbieter allein im ersten Halbjahr 2011 um rund 30 Prozent gefallen sind, bleibt es für Investoren in Deutschland ein äußerst lukratives Geschäft, sich Solarzellen aufs Dach zu setzen. So sagen die Anlageexperten der Investmentbank Morgan Stanley voraus, dass in diesem Jahr erneut die Leistung von 6500 Megawatt auf deutsche Dächer geschraubt werden wird. Und die Credit Suisse erwartet sogar einen Zubau von 7500 Megawatt Solarleistung. Das ist fast die Menge, die im bisherigen Rekordjahr 2010 aufgestellt wurde. Und es wird noch mehr: Branchenbeobachter erwarten, dass Deutschland im kommenden Jahr mit einer wahren Flut von Billig-Solarmodulen überschwemmt wird, weil andere große Abnehmerländer wie Tschechien oder Italien ihre Solarförderung bis dahin drastisch zurückfahren wollen. Deutschland aber, das als einziges Land übrig bleibt, das Solarenergie weiter in unbegrenzter Höhe und Menge fördert, dürfte dann den größten Teil der Weltproduktion an Modulen geradezu aufsaugen. Nach inoffiziellen, aber gleichlautenden Schätzungen aus Kreisen des Bundesumwelt- und des Bundeswirtschaftsministeriums könnte so im kommenden Jahr erneut mindestens 10 000 Megawatt Solarkraft hinzukommen. Eine gewaltige Überkapazität, die den Spielraum für die Förderung anderer, effizienterer Ökostromarten stark einschränkt, und damit die Chancen für eine nachhaltige ökologische Energiewende zu vertretbaren Kosten verringert. Denn falls die Wirtschaftspolitiker der Unionsfraktion kommende Woche mit ihrer Forderung nach Deckelung der Solarausgaben scheitern sollten, ist die Messe erst einmal gelesen, glaubt ein Kenner der Solarszene: "Dann wird es wohl bis weit nach der nächsten Bundestagswahl 2013 dauern, bis man sich wieder mit dem Thema beschäftigt und endlich jemand die Notbremse zieht."

Daniel Wetzel aus "Die Welt am Sonntag" vom 26.6.11

mit freundlicher Genehmigung

Mit Dank an Prof. Löschke. Aufgenommen am 26.6.11

1. Im Kapitel 8 von der Sonne, die keine Rechnung schickt, habe ich eine eingehende .Erläuterung der produktionstechnischen Gründe für die Übernahme des Photovoltaikmarktes durch chinesische Hersteller eingefügt. Leser hatten angesichts der Preissenkungen in letzter Zeit etwas Unverständnis bezüglich meiner Aussage geäußert, daß die technologische Entwicklung weitgehend ausgereizt sei. Die Ergänzung erläutert die Gründe dafür.

2. Das Kapitel Ökostrom fehlte mir eigentlich von Anfang an. Es gehört ja zu den skurrilsten Auswüchsen des grünen Gutmenschentums, das von cleveren Geschäftemachern ausgenützt wird. Eine Recherche der Angebote und eine gründliche Betrachtung der Randbedingungen (EEG) hat mich nun veranlasst, doch ein längeres Kapitel dazu zu schreiben, wobei es einige Überraschungen gab, die Ökostrom-Kunden wohl nicht gefallen werden. Das ist nun Märchen Nr. 14. Deshalb habe ich den Titel so geändert, daß er weitgehend dem alten ähnelte.

3. Ein Teil des Schlußwortes eignete sich eigentlich besser als Anfangssequenz des Artikels. So geschehen.

Hier können Sie jetzt das 14. Energiewendemärchen lesen:

Viele Deutsche meinen es gut und geben Geld aus, um die Welt ein bißchen besser zu machen. Das ist natürlich anzuerkennen. Aber freigiebig locker gemachtes Geld lockt gewisse Leute an, die es gerne hätten, ohne die damit verbundenen Wünsche ernst zu nehmen. Schon länger fließt etliches Geld aus Deutschland über den Atlantik, um dort zum Beispiel eine Patenschaft für eine Fledermaus in Nicaragua, einen Ara in Brasilien oder ein paar Quadratmeter Regenwald in Costa Rica zu finanzieren. Manches davon mag seriös sein, aber seit längerem hat sich in Übersee für das treuherzige, unkritische Finanzieren gut gemeinter Projekte der böse Begriff "Stupid German Money" (Deutsches Idiotengeld) eingebürgert.

Auch in Deutschland selbst kann man zum Beispiel durch seine Stromrechnung die Heimat angeblich etwas grüner machen, vorausgesetzt, man kauft bei einem der zahlreichen Anbieter "Ökostrom". Als Techniker ist man von diesen Vorgängen zunächst verwirrt, denn eins ist absolut klar: Aus der Steckdose eines jeden Kunden kommt überall der gleiche Strom, über dessen Quellen man sich erst am Jahresende ein Bild machen kann, wenn bilanziert wird, welche Erzeuger wieviel Strom eingespeist haben.

Für 2010 sah dieser Strommix folgendermaßen aus:

Kernenergie 22%, Erdgas 14%, Braunkohle 24%, Steinkohle 19%, Wind 6,2%, Wasserkraft 3,2%, Biomasse 5,6%, Photovoltaik 2%, Sonstige (Müll, Öl, Grubengas; Klärgas) 5%.

Die im EEG genannten "Regenerativen" (s.u.) haben also zusammen knapp 20%.

Wie sehen nun die Ökostrom-Angebote aus ? Und was steckt tatsächlich dahinter ?

Variante A ist das Angebot, Wasserkraftstrom aus Deutschland zu liefern. Das bieten mehrere Stromversorger an. Einer dieser Anbieter schreibt: "In jedem Fall erhalten Sie ohne CO2-Emissionen produzierten Strom aus 100% Wasserkraft mit TÜV Nord-Zertifikat. Sie bestimmen, welcher Strom für Sie persönlich produziert wird. Aber nicht nur das: Sie sorgen dafür, daß der Anteil von Ökostrom im gesamten Netz immer größer wird."

Bewertung: Die beiden ersten Sätze sind irreführend und haben mit der Realität nichts zu tun. Der dritte Satz würde nur dann eine Winzigkeit Wahrheit enthalten, wenn sich dieser Anbieter verpflichtet hätte, seine Gewinne selbst in neue Anlagen der regenerativen Energieerzeugung zu investieren. (Siehe Variante D). Davon ist aber in seiner Werbung nicht die Rede.

Daß der Kunde den vom Anbieter gekauften Wasserkraftstrom komplett erhält, ist schon physikalisch unmöglich. Ebenfalls unmöglich ist aber sogar, daß durch diesen Kauf der gläubige Ökostromkunde oder auch irgendein anderer Stromkunde auch nur eine Winzigkeit mehr regenerativen Strom an seiner Steckdose ankommen sieht.

Das verhindert nämlich das Erneuerbare Energie-Gesetz (EEG). Es bestimmt, daß die öffentlichen Netzbetreiber verpflichtet sind, sämtliche von den im EEG genannten Erzeugern (Wasserkraftwerke; Biomassekraftwerke; Geothermiekraftwerke; Windkraftanlagen; Photovoltaikanlagen; Stromerzeuger mit Deponiegas, Klärgas und Grubengas) produzierten Strommengen vorrangig – und das heißt restlos – gegen die gesetzlich festgelegte Vergütung anzukaufen. Anschließend müssen sie diesen Strom an einer Strombörse vermarkten.

Das bedeutet: Sämtlicher in Deutschland erzeugter regenerativer Strom wird qua Gesetz den Produzenten abgekauft – nichts bleibt an ungenutzten Kapazitäten übrig, deren Strom man noch extra als Ökostrom ankaufen und weiterverkaufen könnte.

Ebenso unmöglich ist es, daß der Ökostromkunde "selbst bestimmt, welcher Strom für ihn persönlich produziert wird." Er bekommt wie alle anderen Verbraucher, die nichts extra bezahlen, z.Zt. knapp 20% Ökostrom – und kein bißchen mehr.

Variante B: Wenn der Ökostrom nicht aus Wasserkraft, sondern angeblich aus anderen im EEG genannten regenerativen Quellen in Deutschland kommt, gilt das oben Gesagte genau so.

Variante C: Ein Anbieter schreibt: "Es ist garantiert kein Atomstrom." Und: "Unser Strom aus erneuerbaren Energiequellen in Norwegen wird aus Wasserkraft gewonnen. Aus 100% Wasserkraft."

Bewertung: Abermals gilt das oben zu der Unmöglichkeit der Beeinflussung des Strommixes an der Steckdose des Ökostromkunden Gesagte. Selbstverständlich erhält auch dieser Kunde seine ca. 20% regenerativ erzeugten Strom – und Wasserkraft hat daran (s.o.) ihre 3,2%. Deutsche Wasserkraft, selbstverständlich.

Das EEG-Argument gilt in diesem Falle nicht, denn es wird ja in Norwegen Strom eingekauft. Das klingt zwar besser, ist es aber auch wieder nicht. Norwegen hat viel Wasserkraft, aber nicht genug davon. Das hat zwei Konsequenzen: Zum einen brauchen und verbrauchen die Norweger ihren Wasserkraftstrom selbst. Und weil das nicht reicht, importieren sie Strom aus Schweden – und zwar Kernkraftstrom.

Kaufen Ausländer wie der deutsche Ökostromanbieter den norwegischen Wasserkraftwerken Strom ab, fehlt dieser im dortigen Netz. Weil die Wasserkraftwerke wegen des deutschen Käufers auch nicht mehr als ohne ihn produzieren, ist der Umweltnutzen dieses Geschäfts Null. Es muß nur mehr Kernkraftstrom in gleicher Menge importiert werden. Und weil man im norwegischen Netz genau wie im deutschen einen Strommix hat – in diesem Falle Wasserkraftstrom und schwedischen Kernkraftstrom – , ist auch in dem nach Deutschland gelieferten Ökostrom doch zusätzlicher Atomstrom dabei – der sich dann im deutschen Netz mit dem deutschen Atomstrom vereinigen würde, wenn das bei Strom überhaupt ginge. An der Steckdose des Kunden ist wieder "garantiert" 22% Atomstrom entnehmbar.

Ob der deutsche Ökostrom-Aufkäufer die Norweger zu einem weiteren Ausbau ihrer Wasserkraft veranlassen kann, ist eine gute Frage. Aber nur wenn genau das der Fall wäre, hätte es einen Einfluß auf den Strommix im norwegischen und deutschen Netz.

Variante D: Der Ökostromanbieter erklärt verbindlich, daß er seine Gewinne in neue Anlagen der regenerativen Energieerzeugung investieren wird. Dies finden die Umweltverbände gut, denen die anderen Varianten verständlicherweise wohl weniger überzeugend vorkommen.

Aber auch hierbei scheint der Umweltnutzen nur marginal zu sein: Es sind ja nicht die vom Kunden überwiesenen Ökostromkosten gemeint – der Löwenanteil davon geht an die vom EEG begünstigten Einspeiser, dann gibt es noch Verteilungskosten etc. – sondern nur die Gewinne, sofern sie anfallen. Außerdem befinden sich die Ökostromanbieter dann auf einem durch das EEG (d.h. durch die Zwangsabgaben der Verbraucher) recht lukrativ gewordenen Markt, in dem sich kapitalkräftige Investmentgesellschaften, EVU´s, Kommunen und andere Geldgeber tummeln. Der Einfluß der Ökostromanbieter, hier noch Zusatzkapazitäten zu errichten, die man überhaupt quantitativ bemerkt, dürfte überschaubar sein.

Dennoch haben die Ökostromkunden in unserem Wirtschaftssystem eine Wirkung, wenn auch eine nicht von ihnen beabsichtigte:

Ihre Nachfrage nach regenerativ erzeugtem Strom bewirkt an den Strombörsen, an denen der Übertragungsnetzbetreiber seinen teuren EEG-Strom verkaufen muß, einen Preisanstieg. Den Netzbetreiber, der diesen Strom ursprünglich bei den Wasserkraftwerken und den anderen EEG-begünstigten Erzeugern ankaufen mußte, freut das, denn er zahlt beim Ökostrom immer kräftig zu, weil der Strompreis-Erlös an den Börsen viel niedriger liegt als der gesetzlich festgelegte Ankaufspreis. Jetzt bekommt er also etwas mehr Geld an der Börse und seine Verluste, die er auf alle Stromkunden umlegen darf, sinken etwas.

Das Ökostromgeschäft führt somit zwar nicht zu mehr Ökostrom, – weder bei der Erzeugung noch beim Verbraucher – entlastet aber RWE, E.ON & Co. finanziell. Solche Wege nimmt die Entwicklung, wenn gutgemeinte Fördermechanismen auf Marktwirklichkeit stoßen.

Eigentlich müßte nun gemäß der Marktlogik auch der Endverbraucher-Strompreis etwas sinken. Aber mächtige Kräfte wirken in die entgegengesetzte Richtung: Die Stillegung preisgünstiger Grundlast-Kernkraftwerke, der Ersatz ihrer Strommengen durch teureren Importstrom, die Errichtung teuer produzierender schneller Gaskraftwerke für den Ausgleich der Solar- und Windkraft-Schwankungen, der riesenhaft geplante Ausbau des Höchstspannungsnetzes, der weiter gehende gewollte Ausbau der „Erneuerbaren“, deren Strom teuer angekauft und ins Netz eingespeist werden muß…

Wenn man es freundlich ausdrücken will, dann ist die deutsche Ökostrom-Liebe eine sympathische Liebhaberei. Diese Bezeichnung ist genau so gemeint, wie es die Finanzämter auch meinen, wenn sie das Tun der Steuerzahler einschätzen.

Die deutsche Angstpolitik ist nun Wirklichkeit. Für eine Hoffnung auf eine Rückkehr zu einer realistischen Politik besteht für mehrere Jahre kein Anlaß. Erst nachdem massive Schäden eingetreten sind, die sich politisch auszuwirken beginnen, könnte es zu einer Rückbesinnung kommen, allerdings wohl nicht innerhalb der zur Zeit im Bundestag vertretenen Parteien.

Daß sich ein führendes Industrieland ohne real existierende Probleme nur aus Angst selbst wirtschaftlich ruiniert, ist in der Geschichte einzigartig.

Der Autor hat nicht die Hoffnung, mit seinen Zeilen noch irgend etwas an diesem Prozeß aufzuhalten; das wäre realitätsfern. Das mußte nur einfach aufgeschrieben werden, damit es jemand liest. Tatsächlich ist es kein Artikel , sondern ein Nachruf.

Dr. Günter Keil im Juni 2011

Die vollständigen dreizehn und ein Energiemärchen können Sie komplett als Anhang lesen

„Der Gerichtshof weist darauf hin, dass er keine bestimmte Sichtweise der komplizierten Streitfragen im Zusammenhang mit Kohlendioxid-Emissionen und Klimawandel befürwortet“, heißt es in der mit 8 zu 0 Stimmen gefällten Entscheidung, die von der gefeierten Liberalen des Gerichtshofes, Richterin Ruth Bader Ginsburg, verkündet wurde.

Die Entscheidung des Gerichts unterstrich, dass die amerikanische Umweltagentur (EPA) selbst „bestätigt hat, dass nicht alle Wissenschaftler in der Beurteilung der Folgen des globalen Temperaturanstiegs übereinstimmen“, und schlug vor, dass die Leser „Ansichten in Opposition“ zu dem konventionellen Wissen betrachten sollten. Das Gericht schlug im Einzelnen als Lektüre vor, was der hervorragende Wissenschaftler Freeman Dyson von der Princeton University im Magazin New York Times am 29. März 2009 geschrieben hatte.