Welche Komponenten hat diese Politik?

1. Ein klarer Bezug auf die Wissenschaft, wie sie der Arbeit des IPCC zu entnehmen ist. Durch die anthropogenen CO2-Emissionen ist der Anteil des CO2 in der Atmosphäre von 280 ppm in der vorindustriellen Zeit auf heute 400 ppm gestiegen und wird sich bei dieser Rate in diesem Jahrhundert auf 550 ppm verdoppeln.

2. Dieser Anstieg des CO2-Gehaltes ist der Hauptgrund für die Zunahme der Temperatur um 0,7°C während des vergangenen Jahrhunderts. Bei unveränderten Bedingungen wird die Temperatur während der nächsten 50 Jahre um 1 bis 1,5°C und um 3°C bis zum Ende dieses Jahrhunderts steigen.

3. Sollte die Temperatur um mehr als 2°C steigen, wird dies eine Reihe widriger Konsequenzen haben, als da wären steigender Meeresspiegel, zunehmende Stärke von Stürmen, Ernteschäden, die Ausbreitung von Krankheiten usw.

4. Um den Temperaturanstieg auf 2°C zu begrenzen, müssen die CO2-Emissionen halbiert werden, und weil die entwickelten Länder den Löwenanteil zum CO2-Gehalt beitragen, müssen diese ihre Emissionen um 80% reduzieren. Unter Berücksichtigung des Wirtschaftswachstums bedeutet dies, dass jede Einheit des Bruttoinlandproduktes nur etwa 5% des heutigen CO2 erzeugen darf.

Die Regierung von UK hat in den Verhandlungen zu einem Klimavertrag für diese Position geworben, aber weil es keinerlei Einigung gab (eine wirklich bindende Begrenzung scheint so ziemlich vom Tisch zu sein), hat man eigene Grenzen gesetzt.

Die Regierung von UK hat mit dem „Climate Change Act” (etwa: Gesetzentwurf zur Klimaänderung) 2008 eine mächtige Basis geschaffen. Die Eröffnungsklausel enthält bereits eine bindende Vorschrift:

„Es ist die Pflicht des Staates (Secretary of State) sicherzustellen, dass der allgemeine Kohlenstoffausstoß im Jahre 2050 um 80% unter dem des Jahres 1990 liegt.“

Im Gesetzentwurf wird des Weiteren eine Kommission zur Klimaänderung ins Leben gerufen, deren Arbeit darin bestehen soll, 5-Jahres-Ziele festzulegen, um das letztendliche Ziel zu erreichen. Außerdem soll sie dem Parlament Bericht erstatten, ob die ergriffenen Maßnahmen wirklich zum Ziel führen.

Eine große Vielfalt von Maßnahmen wurde eingerichtet. Auf der Ebene der EU gibt es Absichten, bis 2020 den CO2-Ausstoß um 20% zu reduzieren, verbunden mit dem Angebot, im Rahmen eines internationalen Abkommens auch eine Reduzierung um 30% anzustreben, sowie eine Option, 15% der Energie aus erneuerbaren Quellen zu erzeugen. Die EU hat auch einen Zertifikatehandel eingeführt mit der Abkürzung EUETS, und will eine vorgeschriebene Quote von Biodiesel für den Verkehr einführen.

In UK wurden noch diverse andere Methoden in Kraft gesetzt.

· Die Abgabe zur Klimaänderung; die Verpflichtung zur Reduzierung des Ausstoßes von Kohlenstoff; steigende Tarife, Ziele für die Windenergie, die Option, das CO“ aus Kohlekraftwerken abzuscheiden und unterirdisch zu lagern, und die Änderungen der Planung, die Kernkraft noch schneller durch Anderes zu ersetzen.

· Außerdem stehen Vorschläge für eine Kohlenstoffsteuer sowie eine grüne Kampagne zur Steigerung der Energieeffizienz im Raum.

Es wird nicht einfach nur die großen Energieverbraucher treffen, die ihren Ausstoß reduzieren müssen, sondern auch jede Firma, groß oder klein, und jeden Haushalt.

Aber es gibt da eine unbequeme Wahrheit, und es ist nicht die gleiche unbequeme Wahrheit wie aus dem Film von Al Gore. Die wirklich unbequeme Wahrheit ist, dass diese gesamte Struktur auf sehr tönernen Füßen steht.

Man kann bei dieser Agenda drei Ebenen ausmachen:

· Erstens, die reine Wissenschaft, d. h. die Beziehung zwischen CO2 und Temperatur

· Zweitens, die realen Folgen eines gegebenen Temperaturanstiegs bzgl. Meeresspiegel, Regenmengen, Dürren usw.

· Drittens, falls diese Auswirkungen zutreffen, was kann die Politik tun?

Diesen drei Ebenen entsprechen die drei Arbeitsgruppen im Aufbau des IPCC.

Was als Konsens beschrieben wird, ist in Wirklichkeit kein Konsens. Es gibt tief greifende Kontroversen auf jeder dieser drei Ebenen. Lassen Sie uns zunächst die Wissenschaft betrachten. Die Sicht des IPCC wurde mit dem Hockeyschläger dargestellt. Während der vergangenen tausend Jahre soll demnach die Temperatur nur in einem schmalen Bereich geschwankt haben, eher noch mit einer leicht abwärts gerichteten Komponente. Aber seit der Industrialisierung hat der Ausstoß von CO2 drastisch zugenommen mit der Folge eines ebenso drastischen Anstiegs der globalen Temperatur, die sog. Anthropogene Globale Erwärmung AGW.

Diese Darstellung wurde von zahlreichen Seiten in Frage gestellt:

· Wurde der historische Temperaturverlauf richtig beschrieben? Viele Wissenschaftler glauben, dass in den späteren Berichten des IPCC die Variationen der letzten 1000 Jahre fälschlich geglättet worden waren, indem die Mittelalterliche Warmperiode (1000 bis 1350), die von der Kleinen Eiszeit (1350 bis 1850) und der daran anschließenden Wiedererwärmung der letzten 150 Jahre gefolgt wurde, unterschlagen worden sind. Diese alternative Darstellung deutet darauf hin, dass unser Klima schon lange vor den gegenwärtigen Veränderungen des CO2-Gehaltes hoch variabel gewesen ist. Die ersten Berichte des IPCC trugen diesem Umstand noch Rechnung, doch war das natürlich den AGW-Gläubigen ein Dorn im Auge, von denen einer in einer e-mail schrieb: „Wir müssen die Mittelalterliche Warmperiode los werden!“

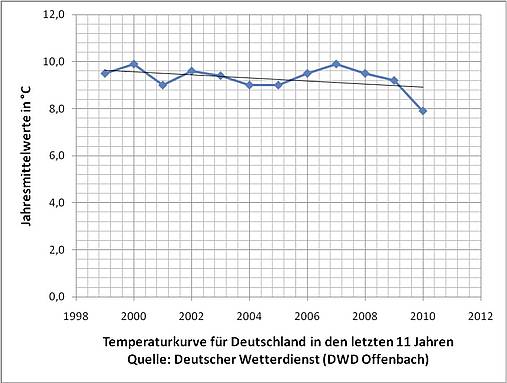

· Selbst die Historie der letzten 150 Jahre enthält eine Menge Probleme. Während dieser Zeit ist die globale Temperatur um 0,7°C gestiegen. Aber anders als der Anstieg des CO2-Gehaltes, der recht gleichmäßig verlaufen war, gab es hierbei markant unterschiedliche Phasen. Die Temperatur war von 1900 bis 1940 rapide gestiegen, zu einer Zeit, als der CO2-Gehalt gering war. Dem folgte ein geringer Temperaturrückgang von 1940 bis 1970, und zwar trotz der Tatsache, dass der CO2-Gehalt in dieser Zeit schon ziemlich stark angestiegen ist. Zwischen 1970 und den späten neunziger Jahren stiegen sowohl der CO2-Gehalt als auch die Temperatur deutlich, aber während der letzten 12 Jahre hatte die Temperatur auf diesem hohen Niveau verharrt [obwohl der CO2-Gehalt in gleichem Maße weiter stieg]. Falls der CO2-Gehalt wirklich so bedeutsam ist, wie die Theoretiker der AGW behaupten, warum machte die Temperatur den Anstieg des CO2-Gehaltes nicht mehr mit? Hierdurch wird immer offensichtlicher, dass man andere Faktoren ins Spiel bringen muss, besonders die Sonne und die Art und Weise, mit der Wärme in den Ozeanen gespeichert wird und verteilt ist. Daher ist völlig ungeklärt, welchen Anteil die natürlichen Treiber und welchen AGW hat.

· Prinzipiell muss man aber nach der Klimasensitivität schauen, damit meine ich den Koeffizienten zwischen CO2 und Temperatur. Niemand bestreitet, dass das CO2 Treibhauspotential hat. Ein Kubikmeter Luft mit einem CO2-Gehalt von 550 ppm wird mehr Wärme zurückhalten als einer mit 280 ppm. Aber die meisten Wissenschaftler werden zustimmen, dass eine Verdoppelung des CO2-Gehaltes allein keinen Temperaturanstieg um 3°C oder mehr ergeben wird, wie es in den Modellrechnungen des IPCC heraus kommt. Der reine Effekt aus einer CO2-Verdoppelung liegt wahrscheinlich näher bei 1°C. Woher kommen also die höheren berechneten Werte?

· Sie stammen aus dem Wasserdampf, von dem vermutet wird, dass der Gehalt in der Atmosphäre zunimmt, und das er ein viel stärkeres Treibhausgas ist als CO2. Eine wärmere Atmosphäre enthält mehr Wasserdampf. Aber heißt das automatisch, dass dies einen positiven, d. h. verstärkenden Effekt haben muss? Nicht notwendigerweise. Mehr Wasserdampf bedeutet auch mehr Wolken. Wolken haben eine isolierende Wirkung, reflektieren aber auch Sonnenlicht zurück in den Weltraum (Albedo). Darum ist es an wolkigen Tagen auch kühler. Der Endeffekt geht also in beide Richtungen.

· Die Modellrechnungen des IPCC haben das starke positive Feedback vermutet, aber nicht bewiesen. Aber dieser teil der Wissenschaft wird immer noch sehr wenig verstanden.

Zusammenfassung dieses Teils der Diskussion:

· Die globale Temperatur ist seit dem frühen 19. Jahrhundert angestiegen, jedoch viel langsamer, als der Anstieg in Zukunft ausfallen soll. Es gab eine Periode starken Anstiegs von 1970 bis zu den späten neunziger Jahren, doch ist diese Zeitspanne zu kurz, um daraus den Verlauf bis zum Ende dieses Jahrhunderts zu extrapolieren. In der ersten Dekade dieses Jahrhunderts sind wir weit hinter die Rate zurückgefallen, die eine Erwärmung um 3°C zur Folge hat, was annähernd vier mal so schnell wie die historische Rate wäre.

· Der CO2-Gehalt ist nur während der letzten 60 Jahre signifikant gestiegen, während der Anstieg der Temperatur Fluktuationen aufweist.

Ich kann die zweite Ebene der Arbeit des IPCC sehr schnell abhandeln. Nach meiner Ansicht wurde hier die schäbigste Arbeit getan. [Es gab] eine Menge dramatischer Behauptungen über den Meeresspiegel, Eis, Ernteerträge, das Aussterben von Tier- und Pflanzenarten, festgemacht am Beispiel der Eisbären. Es hat sich gezeigt, dass vieles davon aus Material kommt, das nicht wissenschaftlich begutachtet worden war, also aus der sog. grauen Literatur. Und schlimmer noch, es stammt teilweise sogar aus Materialien, die von grünen NGO’s zur Verfügung gestellt wurden. Es gab fortwährend Rosinenpickerei (cherry picking), Übertreibungen, Überbewertung von Extrema und das Fehlen jeder Hinweise auf die positiven Auswirkungen. Im Großen und Ganzen hat die Menschheit immer von den Warmzeiten profitiert. Pflanzen wachsen schneller und nehmen mehr CO2 auf in einer Atmosphäre, die wärmer und feuchter ist sowie einen höheren CO2-Gehalt aufweist. Kälte fordert mehr Opfer als Wärme. Der Hauptgrund für die zunehmende Schadenssumme durch Wetterextreme ist das Bebauen und Bewohnen von Gebieten, die anfällig für solche Extremwetterereignisse sind. Die Befürchtungen über eine Ausbreitung von Malaria sind längst diskreditiert.

Wenden wir uns nun der dritten Ebene zu, der Politik.

· Das erste Problem besteht darin, dass die Politik überwiegend auf der ‚warmistischen’ Sichtweise basiert. Viele, wie z. B. Ingenieure, glauben, dass der Anpassung viel zu wenig Aufmerksamkeit zukommt, d. h. besser vorbereitet zu sein auf das, wohin auch immer die Summe natürlicher Kräfte und CO2 uns führen, auf- oder abwärts. Diese warmistische Sichtweise der Welt kann erklären, warum wir auf kalte Winter so wenig vorbereitet waren, eines Phänomens, dass gut mit dem 11-jährigen solaren Zyklus korreliert, bei dem die Sonnenflecken ein extremes Minimum aufweisen.

· Das Hauptproblem der Politik in UK liegt in der Einseitigkeit. Unser Gesetzentwurf zur Klimaänderung legt uns Pflichten auf, egal was andere Länder tun oder nicht tun. Das UK, das nur etwa 2% des weltweiten Bruttosozialproduktes produziert, hat allein nur einen minimalen Effekt auf die globale Erwärmung. Wenn wir die Dekarbonisierung zu drastisch angehen, etwa durch Anhebung des Preises für Kohlenstoff durch diverse Maßnahmen, werden wir einer doppelten Gefahr ausgesetzt. Energieintensive Industriezweige werden abwandern, und wenn die Klimapessimisten recht haben, werden wir dann immer noch den Preis für die Anpassung zahlen müssen, z. B. durch eine Verstärkung unserer Abwehr von Überflutungen. Nach meiner Ansicht sollten wir uns nur auf diese Dinge konzentrieren, die eindeutig positiv wirken und die wir nicht bedauern werden. Und davon gibt es viele. Die restliche Agenda sollten wir nur als Teil internationaler Aktivitäten verfolgen. Genau zu diesem Punkt gibt es derzeit in der EU heftigen Streit. Der Klimakommissar möchte die ambitionierteren 30% Reduktion festlegen, selbst bei Fehlen irgendeines Vertrages, und der Energiekommissar ist strikt dagegen.

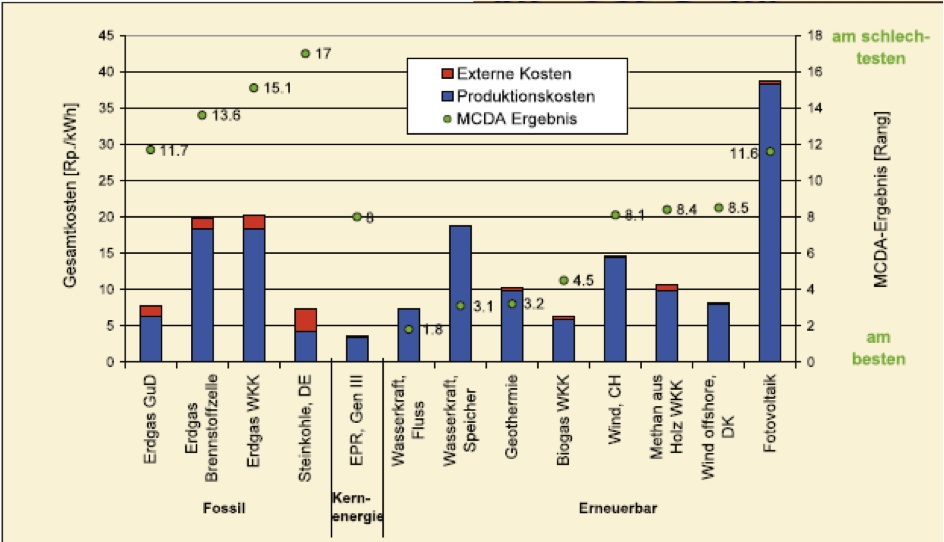

Der wirtschaftlichen Logik nach müsste sich die Politik nach den Kosten pro Tonne eingesparten CO2 richten und dann den Preis der einzelnen alternativen Maßnahmen durchgehen, und zwar beginnend mit den effektivsten. Oder, was auf das Gleiche hinausläuft, man setzt einen Preis für Kohlenstoff fest und lässt den Markt entscheiden, welche der verschiedenen Technologien – Gas, Kohle mit CCS [Abscheiden von CO2], Gezeiten, Energieeffizienz usw. sich schließlich durchsetzt.

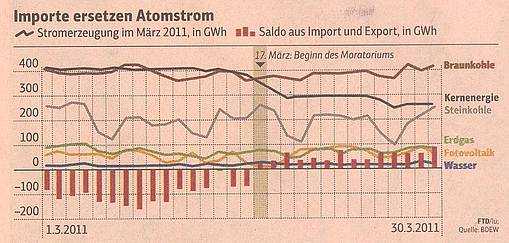

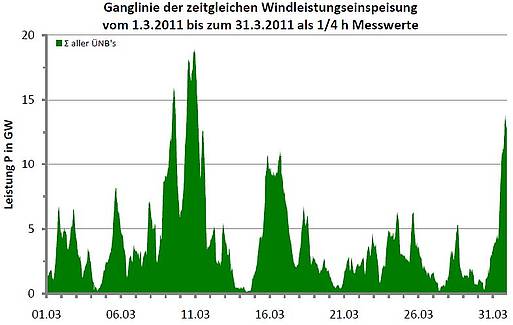

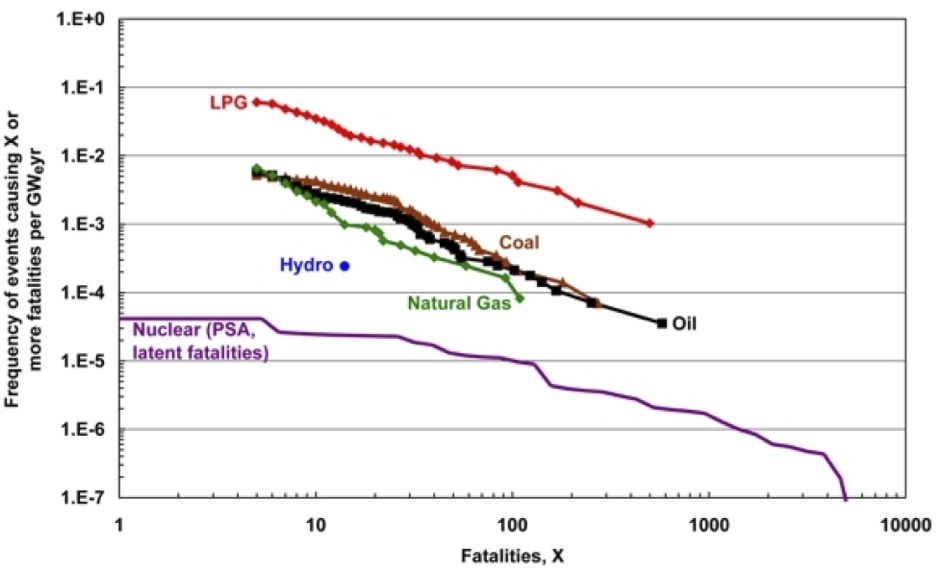

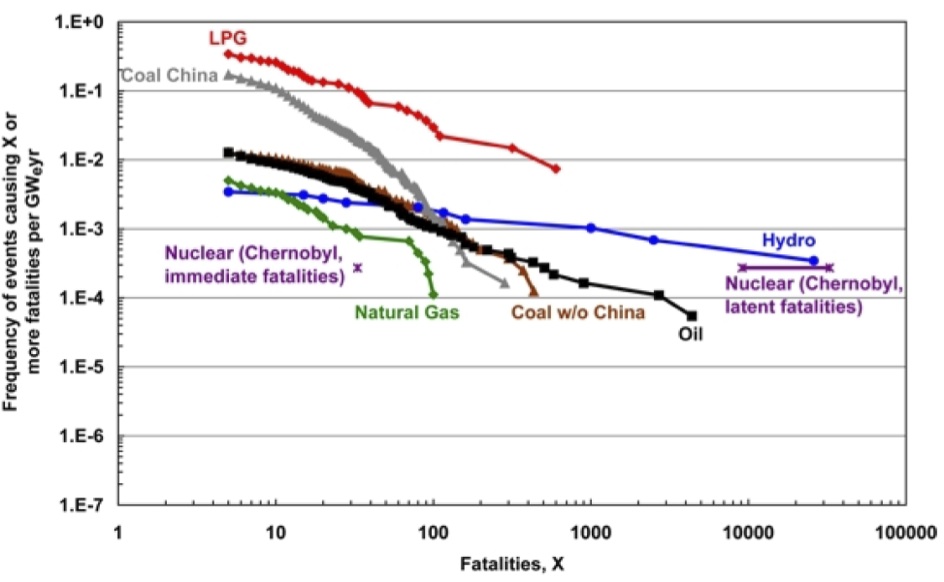

Aber die EU-Verordnung bzgl. der Erneuerbaren ist die Ablehnung dieser Logik. Einer ganz bestimmten Technologie, besonders Wind, hat man einen garantierten Marktanteil zu einem garantierten Preis eingeräumt, ohne Rücksicht darauf, wie wettbewerbsfähig dies ist. Die gegenwärtige Förderung der Windkraft ist reiner Irrsinn. Die Kosten pro kwh hierfür liegen wesentlich höher als andere Quellen mit geringem CO2-Ausstoß, wie z. B. der Kernenergie, wenn man die Verfügbarkeit und die Kosten berücksichtigt, die entstehen, wenn man das Netz auf alle Verbraucher ausdehnt. Es herrscht eine fortwährende Konfusion zwischen der installierten Kapazität der Windkraft und deren tatsächlichem Ergebnis, welches etwa 25 bis 30% der Kapazität beträgt. Dann ist da noch das Problem, dass große Kälte in UK häufig mit sehr geringer Windgeschwindigkeit einher geht.

Ursprünglich stand man in diesem Land der Kernenergie feindlich gegenüber, heute bestenfalls noch halbherzig. Der Staatssekretär beim DECC [Department of Energy and Climate Change] hat die Kernenergie als versucht, getestet und gescheitert erklärt. Es kann sein, dass die Kernkraft in UK historisch nicht so erfolgreich war wie sie hätte sein können, aber sie hat seit 50 Jahren etwa 20% unserer Energie zur Verfügung gestellt, zuverlässig, wettbewerbsfähig und sicher. Nur 20 Meilen vor unserer Küste hat Frankreich über 2/3 seines Stromes mit Kernkraftwerken erzeugt und betrachtet dies als großen Erfolg. Wir können einfach noch nicht sagen, ob man daraus generell etwas lernen kann, oder ob man 40 Jahre alte Anlagen in seismisch aktiven Gebieten betreiben kann.

Der Mechanismus der Einspeisevergütungen entwickelt sich rasch zu einem Skandal. Die Glücklichen, denen ein Haus gehört, das groß genug ist, um Solarpaneele zu montieren, oder die über genügend Land für einen Windpark verfügen, haben eine Vergütung von 30 bis 40 p (Pence) pro kwh erhalten, welche für nur 11 p gehandelt wird. Der Verlust wird ausgeglichen durch eine Abgabe auf Firmen und Haushalte. Es ist erstaunlich, dass die Liberalen, welche so immense Bedeutung auf Fairness legen, auf diesem Auge der Umverteilung von den Armen zu den Reichen blind sind, beläuft sich dies doch auf Milliarden Pfund pro Jahr. Falls Sie in einem Glashaus in Lambeth sitzen, haben Sie nicht viel Gelegenheit, Ihre Nase da hinein zu stecken.

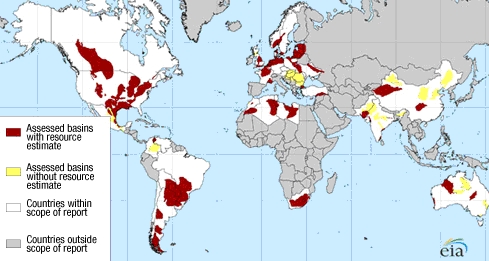

Es gibt eine wesentliche neue Entwicklung, nämlich die Einführung neuer Bohrtechniken, die es ermöglicht, Gas aus Schiefer zu gewinnen. Dies hat die Möglichkeiten der geographischen Verfügbarkeit von Gas erheblich erweitert, zu einer massiven Erhöhung der Gasvorräte geführt sowie zu einer Loslösung des Gaspreises vom Ölpreis. Gas hat den Vorteil, dass es nur halb so viel CO2 erzeugt wie Kohle. Also stehen wir vor dem glücklichen Umstand, dass wir eine Menge Kohle durch die Verbrennung von Gas ersetzen können, womit einmal die Energiepreise, zum anderen die CO2-Emissionen deutlich reduziert werden, wenngleich dies auch nicht zu einer vollständigen Dekarbonisierung führt, wie es von manchen angedacht wird. Sicher sind die Alternativkosten der Erneuerbaren gestiegen und vielleicht auch der Preis für Kernkraft.

Eine andere Verteidigung der AGW-Agenda besteht im Argument der sog. grünen Jobs, d. h. wir sollten die Vorhut bilden, grüne Technologien einzusetzen, so dass wir die Vorteile genießen, wenn wir diese Technologie als Erste zur Verfügung stellen können. Meine Sicht der Dinge ist einfach. Wenn sich eine neue Technologie ohne massive Subventionen durchsetzen kann, sollten wir darauf bauen. Aber wenn eine Technologie nur mit Hilfe von Subventionen am Leben gehalten werden kann, improvisieren wir nur und sollten die Schaffung von Arbeitsplätzen nicht auf so tönerne Füße stellen.

Zusammenfassung bzgl. der Politik

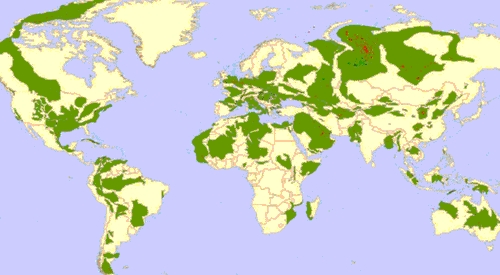

Wir sollten uns auf die Maßnahmen konzentrieren, die wir später nicht bereuen müssen, und welche die Produktivität verbessern und nicht den Lebensstandard verschlechtern. Dazu gehört nach meiner Lesart die Entwaldung zu beenden, die Energieeffizienz unserer Häuser und unserer Fahrzeugflotte zu erhöhen (obwohl die Auswirkung einer größeren Energieeffizienz darin bestehen könnte, dass die Reduzierung des CO2-Ausstoßes begrenzt ist, weil durch billigere Energiepreise mehr verbraucht wird), Investitionen in die Kernkraft, weniger Verschwendung von Energie und, falls wir CCS-Maßnahmen durchführen und die Wirtschaftlichkeit dafür erst noch hergestellt werden muss, sollten wir eher in Gas- als in Kohlekraftwerke investieren. Das enthält auch weniger Sonnen- und Windkraft sowie ein Ende der Produktion von Biokraftstoff.

Lassen Sie mich schließen mit in paar Bemerkungen zur Soziologie und Politik des AGW-Phänomens. Erstens gibt es da eine Änderung in der Natur der Wissenschaft. Große Gestalten der Vergangenheit wie Galileo und Darwin waren keine hoch bezahlten Professoren, empfingen keine großen Forschungszuwendungen und wurden nicht mit Ehren überhäuft. Sie wurden allein durch Neugier getrieben und waren darauf vorbereitet, gegen das Establishment zu verstoßen. Heutzutage haben unsere Umweltwissenschaftler Jobs und Forschungsgelder sowie Gelder für Feiern und Reisen. Dann gab es ein peinliches Scheitern der Größen bei der Royal Society, die eigentlich der Hüter wissenschaftlicher Integrität sein sollte, getreu ihrem Motto „Nullius in verba“, d. h. niemand hat das letzte Wort. Statt dessen wurden sie zu Aktivisten, die Unsinn von sich gaben wie die Behauptung, dass die Wissenschaft sich einig sei, und die versäumt haben, die Klimagate-Affäre rigoros aufzuklären.

Es gibt derzeit viele eigennützige Interessen der grünen Agenda, seien es Unterstützer, Zulieferer der grünen Technologie oder jene, die Vorteile aus den wirtschaftlichen Möglichkeiten ziehen. Es sind nicht gerade die Zulieferer der traditionellen Technologie zur Energieerzeugung, die Positionen haben, die es zu verteidigen gilt.

Die unkritische Anpassung an die grüne Agenda durch die Konservativen hat ihnen geholfen, durch die Blau-ist-grün-Botschaft einen Weg aus dem schlechten Image der Partei zu finden.

Es gibt einen strukturellen Fehler beim IPCC. Weit entfernt davon, aus der Arbeit von 2500 Wissenschaftlern einen Konsens zu destillieren, gibt es etwa 40 bis 50 im Zentrum, die eng zusammen arbeiten, als Kollegen, Schüler, Lehrer, Begutachter der Arbeiten des jeweils anderen. Sie haben es geschafft, eine sehr einfache AGW-Botschaft zu definieren und haben dafür gesorgt, dass alternative Stimmen zum Schweigen gebracht worden sind. Die Medien haben in ihrer Rolle als kritische Beobachter versagt und haben sich in dieses Gruppendenken eingebracht. Es blieb der Blogosphäre vorbehalten, eine Plattform für andere Standpunkte zur Verfügung zu stellen.

Woher kommt dieser religiös anmutende moralisierende Ton? Er kann zurück verfolgt werden bis zum 3. Kapitel Mose. Der Mensch wurde im garten Eden geboren in einem Zustand der Unschuld, hat dann aber seine Umwelt zerstört und muss nun dafür Buße tun und für seine Sünden zahlen.

Schlussfolgerungen:

Wir müssen erkennen, dass es schon immer Veränderungen unseres Klimas gegeben hat. Wir müssen die dafür verantwortlichen natürlichen Kräfte viel mehr in unsere Analysen einbringen, als sie daraus zu entfernen.

Wir wurden Zeuge eines Erwärmungstrends während der letzten 150 Jahre, aber diese Erwärmung verlief nicht geradlinig aufwärts. Gegenwärtig befinden wir uns auf einem Plateau. CO2 hat höchstens einen kleinen positiven Beitrag geleistet.

Unser Verständnis der Rolle des Wasserdampfes ist immer noch begrenzt und reicht nicht aus, um das Gewicht zu rechtfertigen, das wir darauf legen.

Wir brauchen eine vielschichtigere Annäherung an dieses Problem und mit Sicherheit eine gemäßigtere.

Mit den Worten von Tschechiens Präsident Klaus:

„Es ist völlig unakzeptabel, alle Interpretationen der Klimaänderung und der globalen Erwärmung auf eine einzige Variable zu konzentrieren, CO2, und auf den kleinen Anteil davon, den das anthropogen produzierte CO2 hat“.

Von unseren Politikern brauchen wir mehr Rationalität, weniger Emotion und weniger Religiosität; und ein Ende der alarmistischen Propaganda sowie der Versuche, uns und unsere Kinder zu ängstigen. Außerdem wollen wir, dass die Politiker mehr auf unsere nationalen Interessen achten und weniger danach, globale Evangelisten zu sein.

Schließlich brauchen wir von unseren Wissenschaftlern mehr Bescheidenheit und eine Rückkehr zur Tradition wissenschaftlicher Neugier und Herausforderung. Wir brauchen mehr Offenheit und Transparenz, und sie müssen aufhören, anders Denkende auszugrenzen. Und sie müssen die wirklich unbequeme Wahrheit akzeptieren – nämlich dass unser Verständnis der Natur keinesfalls die Gewissheit rechtfertigt, mit der die AGW-Weisheiten verbreitet werden.

Andrew Turnbull, März 2011

Lord Turnbull war Permanent Secretary des Environment Department von 1994-98; Permanent Secretary to the Treasury von 1998-2002, Cabinet Secretary und Vorsitzender des Home Civil Service 2002-05. Er ist derzeit Mitglied im House of Lords und des Board of Trustees der GWPF.

Link: http://www.thegwpf.org/opinion-pros-a-cons/2711-lord-turnbull-the-really-inconvenient-truth.html

Übersetzt von Chris Frey für EIKE