In der letzten Ausgabe des LAUFPASS[1] wurden erste gesellschaftliche und politische Aspekte von Geo-Engineering aufgezeigt. Ergänzend werden in Folgendem nun die naturwissenschaftlichen Gesichtspunkte der einzelnen Geo-Projekte dargestellt und bewertet.

Definition WIKIPEDIA[2]: “Der Begriff Geo-Engineering bezeichnet technische Eingriffe in geochemische oder biogeochemische Kreisläufe, etwa um die Klimaerwärmung oder die Versauerung der Meere zu bremsen.“

Mittlerweile gibt es eine umfangreiche Literatur zu dem Thema, mit einem genau so umfangreichen Katalog vorgeschlagener Maßnahmen, von denen die wesentlichen hier vorgestellt und bewertet werden sollen.

Der Heiz-Strahler Sonne …

… erwärmt unsere Erde. Der weit überwiegende Teil der Sonnen-Strahlung erreicht auf direktem und indirektem Wege (Streuung) die Erdoberfläche. Diese erwärmt sich, und gibt fühlbare Wärme (Wärmeleitung) an die bodennahen Schichten der Troposphäre ab. Die Abkühlung erfolgt auf dem gleichen Wege – durch Wärme-Leitung und auch Abstrahlung.

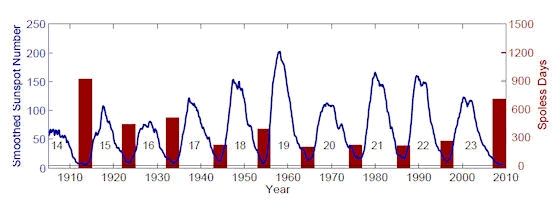

Nun hat die Natur einige Möglichkeiten auf Lager, die an der Erdoberfläche ankommende Strahlungs-Energie zu verändern: Variationen der Sonnen-Aktivität, Staubeintrag in die Atmosphäre durch Vulkane und Sandstürme, in selteneren Fällen Staub- und Wassereintrag durch Meteor-Einschläge, langzeitige Veränderungen der globalen Bewölkung, ….

Was die Natur vormacht, das glaubt nun auch der Mensch mit Geo-Engineering zu beherrschen, um aktiv in die Gestaltung unseres Klimas einzugreifen. Das Motto dazu lautet neuerdings : “Wir müssen durch Geo-Egineering unser Klima retten, um der anthropogenen CO2-Erderwärmung gegen zu steuern!“

Schwefel+Staub in die Atmosphäre

Aus der älteren und jüngeren Klima-Geschichte[3] ist bekannt, daß von Vulkanen in die Stratosphäre geblasene Aerosole und Gase dort zu Veränderungen des Strahlungs- und Energiehaushaltes führen. Eine wesentliche Rolle spielt dabei auch Schwefeldioxid, das durch Oxidation in Aerosole, nämlich Sulfate[4] umgewandelt wird. Ein Teil der eingestrahlten Sonnenenergie wird durch diese stratosphärischen Aerosole reflektiert, ein anderer Teil wird absorbiert. Letzteres führt zu einer Erwärmung der Stratosphäre, beides zusammen zu einer Abkühlung der bodennahen Luftschichten (Troposphäre) aufgrund dort erfolgender Strahlungs-Minderung.

Wahrscheinlich war es der Chemiker Paul Crutzen[5], der als erster einen ausführlichen Ansatz für entsprechende menschliche Eingriffe publizierte: Schwefel-Dioxid oder Sulfate in die hohe Atmosphäre einbringen. Dort sollen sich – analog zum Vulkanismus – zusammen mit Wassermolekülen viele feine Tröpfchen und letztlich ein dünne globale Wolke bilden, die Sonnen-Strahlung abfängt (Reflektion und Absorption).

Daraus entwickelte die US-Firma Intellectual Ventures[6] neuerdings die Idee, mit Hilfe eines 25 km langen, ballon-getragenen Schlauches Schwefel nach oben zu pumpen, oder Schornsteine von schwefel-emittierenden Fabriken unmittelbar mit Schläuchen in die Stratosphäre zu verlängern.

Noch weiter gehende Ideen entwickelte der Meteorologe Alan Robock[7] von der amerikanischen Rutgers University: „Wir haben noch keine solche Technologie, aber die Leute denken über eine Flugzeug-Flotte nach, die regelmäßig in die untere Stratosphäre fliegt, um dort das Gas auszusprühen. Eine andere Idee wären Ballons, die mit Helium und Schwefeldioxid gefüllt sind und die man dann oben einfach platzen lässt. Möglich wäre vielleicht auch Artillerie: also Geschosse, die Projektile in die Stratosphäre jagen. Oder man baut einen Turm am Äquator, 20 Kilometer hoch, von dem aus man das Gas hinaussprüht.“??

Doch selbst Robock bleibt kritisch (a.a.O.) : “

Wenn man eine Stratosphären-Wolke geschaffen hat, weiß man noch lange nicht, wie sich diese Maßnahme wirklich auswirkt…“ und weiter “… Diese Maßnahme ist also sehr gefährlich, denn man kann sie nur prüfen, wenn man sie schon zur Anwendung gebracht hat.“??

Das allerdings sehen auch andere Wissenschaftler[8] so: „Der Plan ist beängstigend, weil er unerwartete Folgen haben kann.“

Schirme + Spiegel im All …

… sind eine andere Variante, in der oberen Atmosphäre Strahlung abzufangen.

So will der Astronom Roger Angel von der University of Arizona im Weltall einen Sonnenschirm aufspannen, genauer gesagt eigentlich 16 Billionen Sonnenschirm’chen. Sein Plan sieht vor, daß an genau dem Punkt zwischen Sonne und Erde, an dem sich die Anziehungskraft der beiden Himmelskörper gegenseitig aufhebt (dem so genannten Lagrange-Punkt), eine Armada von hauchdünnen Siliziumscheiben schwebt (Abbildung1). Die 60 Zentimeter breiten Plättchen sollen in Päckchen zu je einer Million mit zwei Kilometer langen Spezialkanonen ins All geschossen werden. Um die beabsichtigte Schattenwirkung zu erzielen, müssten 20 solcher Kanonen im Abstand von fünf Minuten zehn Jahre lang solche Platten-Container ins All feuern. Auch der verstorbene Physiker Edward Teller, der „Vater der Wasserstoffbombe“, hatte schon die Idee[9], Millionen kleiner Aluminiumballons in der Stratosphäre schweben zu lassen, um Sonnenstrahlung zu reflektieren und abzuschirmen.

Kritiker sind entsetzt[10]: “Mit etwas so entscheidendem und wenig erforschten wie der Sonnenstrahlung herumzuspielen, könnte dramatische und unvorhergesehene Konsequenzen für das Klima auf der Erde haben, warnen sie“.

Abbildung 1: Spiegel im Weltraum

http://www.capital.de/politik/:Interaktive-Infografik–Geoengineering-Weltklima-selbstgemacht/100027692.html

Reflektorbälle im Meer

Was oben gehen soll, das kann man vielleicht auch unten machen:

Andere Forscher[11] schlugen analog zu den stratosphärischen Experimenten schon Mitte der 1960-er Jahre vor, die tropischen Ozeane mit High-Tech-Müll zu pflastern: Milliarden von reflektierenden Objekten, Tischtennisbällen vergleichbar, sollten die Energie der Sonnenstrahlen von der Wasseroberfläche ins All zurückschicken.

Vielerlei Problemen treten dabei auf, denn auch Kunststoffe altern und veralgen[12]: “Schwimmende Plastikteile werden von den unterschiedlichsten Meeresorganismen besiedelt, die auf diese Weise über weite Strecken in neue Habitate einwandern und unter Umständen als Neozoen bzw. Neophyten erheblichen Schaden anrichten können.“ Von besonderem Interesse bei der hier erörterten Geo-Egineering-Variante ist ein physikalischer Effekt: Die sich derart verändernden Plastik-Oberflächen werden physikalisch schwarz, reflektieren weniger und absorbieren mehr Strahlung. Dann tritt nach einiger Zeit das Gegenteil von dem ein, was beabsichtig ist: Erderwärmung statt Abkühlung!

Versprühen von Meerwasser in die Atmosphäre

Eine große Flotte von Glasfaserbooten[13] soll auf den Ozeanen mit Hilfe von wind-getriebenen Turbinen kontinuierlich Meereswasser in die Atmosphäre sprühen (Abbildung 2). Ziel dabei: Es werden für die Beschleunigung und Verstärkung von Wolkenbildung Milliarden von Kondensations-Kernen (Salz) sowie Wasser und damit potentiell auch Wasserdampf in die Troposphäre geblasen. Wolken in der unteren Atmosphäre wirken abkühlend auf die unteren Luftschichten , im Wesentlichen aufgrund der Reflektion von Sonnenstrahlung an der Wolken-Oberfläche. Auch so soll einer weiteren Erderwärmung entgegen gewirkt werden.

Unbekannt und damit auch unkalkulierbar sind dabei die Auswirkungen auf das Wetter. Die Methode erinnert an die jahrzehnte-langen Versuche der Wetter-Beeinflussung, insbesondere der “Regenmacher“. Alle diese Versuche wurden allerdings wegen weitgehender Erfolglosigkeit weltweit eingestellt. Einer der letzten Versuche dieser Art wurde von den Chinesen anläßlich der Olympischen Spiele 2008 durchgeführt – ohne erkennbare Wirkung.

Wenn nun jedoch in einem solchen wie oben geplanten “Groß-Versuch“ über riesige Flächen der Ozeane derart in den atmosphärischen Wasserhaushalt eingegriffen wird, so erscheinen unkalkulierbare Folgen für das Wetter möglich.

Abbildung 2 : Meerwasser-Versprühung

http://www.capital.de/politik/:Interaktive-Infografik–Geoengineering-Weltklima-selbstgemacht/100027692.html

Ozean-Oberfläche aufwirbeln

Konzept und Ziel eines solchen globalen Experimentes werden im Wissenschaftsteil der BZ[14] anhand einer Publikation im Fachmagazin Nature so beschrieben:

“Der Chemiker James Lovelock von der University of Oxford und der Astrophysiker Christopher Rapley, Direktor des Londoner Science Museum, wollen das Klima retten, indem sie die Ozeane dazu anregen, mehr CO2 aufzunehmen. Ihr Konzept erläutern sie im Fachmagazin Nature. Lovelock und Rapley planen, zehn Meter dicke Röhren im Ozean zu installieren, die von Schwimmkörpern an der Oberfläche gehalten werden und hundert bis zweihundert Meter senkrecht in die Tiefe reichen. Am oberen Ende jeder Röhre pumpt ein Klappventil, das von der Wellenenergie des Meeres angetrieben wird, das Wasser heraus. Auf diese Weise soll nährstoffreiches Wasser aus der Tiefe an die Oberfläche gepumpt werden. Tiefere Wasserschichten enthalten nämlich Phosphate, Nitrate und Silikate – alles Substanzen, die an der Oberfläche fehlen. Das nach oben gepumpte Wasser löst dort wie ein Dünger eine Algenblüte aus, hoffen die Forscher. Algen verbrauchen beim Wachsen das Kohlendioxid der Luft. Wenn sie absterben, sinkt auch der von ihnen aufgenommene Kohlenstoff mit in die Tiefe. Auf diese Weise könnten der Atmosphäre schon bald große Mengen CO2 entzogen werden, schreiben Lovelock und Rapley.“

Aber es gibt auch Kritik (a.a.O.): “Andere Wissenschaftler bezweifeln allerdings, dass die Methode tatsächlich funktionieren würde. Zu ihnen gehört der Meeresbiologe Ulf Riebesell vom Kieler Leibniz-Institut für Meeresforschung IFM-Geomar. Zwar räumt er ein, dass die tieferen Wasserschichten jene Nährstoffe enthielten, die an der Oberfläche zu einer Algenblüte führen könnten. Aber in dem Wasser, das nach oben gepumpt wird, befindet sich auch gelöstes Kohlendioxid, erläutert er. Gelangt das Wasser an die Oberfläche, dann entweicht das Klimagas in die Luft. Nach Ansicht Riebesells würde die Methode von Lovelock und Rapley allerdings den natürlichen Kohlenstoff-Kreislauf nicht durchbrechen, sondern ihn nur beschleunigen: Die absterbenden Algen bringen den Kohlenstoff in die Tiefe, dort werden die Organismen zersetzt, das entstehende CO2 löst sich, wird nach oben gepumpt und so weiter. ’Das ist ein Nullsummenspiel’, sagt der Biologe.“

Gedanklich ein ähnlicher Ansatz ist die

Meeres-Düngung zwecks Algen-Wachstum

An der Grenzfläche zwischen Atmosphäre und Ozeanen (“Meeres-Oberfläche“) wird u.a. ständig CO2 ausgetauscht – in beiden Richtungen. Schiffe streuen nun Mineralien in die oberen Schichten der Meere, zum Beispiel Eisen-Sulfat. Diese regen das Algenwachstum an, was zu einem Entzug von CO2 aus dem Wasser und letztlich auch aus der Atmosphäre führt.

Nach bio-chemische Umsetzungen nehmen die Algen das CO2 als Sediment mit auf den Meeresgrund, und sollen auf diesem Wege CO2 dem natürlichen Kreislauf entziehen, um den Treibhaus-Effekt zu vermindern.

Ein solches Experiment namens “LOHAFEX“ wurde vom Alfred-Wegener-Institut (AWI) durchgeführt. Dazu berichtet das AWI[15] : “Das LOHAFEX-Team … war von Januar bis März 2009 auf dem Forschungsschiff POLARSTERN unterwegs und verwendete zehn Tonnen gelöstes Eisensulfat, um eine Fläche von 300 km2 im Zentrum eines Ozeanwirbels zu düngen. Binnen zwei Wochen entstand eine Phytoplanktonblüte im eisenreichen Wasser, die danach – trotz einer weiteren Düngung – nicht mehr zunahm.“ … und weiter a.a.O.: “Die Biomassen von anderen großen Phytoplanktonarten, die in Küstengewässern häufig Blüten erzeugen, wurden durch den Wegfraß der großen Zooplanktonbestände, vor allem der Ruderfußkrebse, in Schach gehalten. … Daher kann angenommen werden, daß die Eisendüngung unter den angegebenen Bedingungen nicht zur erhöhten Einlagerung von Kohlenstoff im Ozean führt.“

Die Nordseezeitung[16] brachte es auf den Punkt: “Als Waffe im Kampf gegen den Klimawandel dürfte der Eisendünger damit wohl ausgedient haben.“

Ohnehin hatte es im Vorfeld des LOHAFEX-Experimente erhebliche Proteste von Umwelt-Organisationen gegeben, die dazu führten, daß das Bundes-Umwelt-Ministerium[17] in einer Presse-Mitteilung noch während des laufenden Experimentes die Genehmigung durch das BMBF massiv kritisierte: “International ist der Ansatz der Meeresdüngung höchst umstritten, da die Wirksamkeit der Methode fraglich ist. So weisen sowohl der Interstaatliche Rat zum Klimawandel (IPCC) als auch der Wissenschaftliche Beirat für Globale Umweltveränderungen (WBGU), das gemeinsame wissenschaftliche Beratungsgremium des BMBF und des BMU, in ihren Gutachten wiederholt darauf hin, dass die Risiken der Meeresdüngung im Hinblick auf die mittelbaren Folgen für die Meeresökosysteme schwer abzuschätzen sind und lehnen diese daher ab. Entgegen den Angaben des BMBF, dass das Projekt reine Grundlagenforschung darstelle, wurde der Projektleiter des AWI in einem „Spiegel“-Interview damit zitiert, dass die Einwände gegen die Eisendüngung “weggefegt“ würden, wenn die Ohnmacht gegenüber dem Klimawandel sichtbar würde.

Damit setzt sich der verantwortliche Projektleiter des AWI für dieses Experiment in einen klaren Widerspruch zum Bundesforschungsministerium. Das Plädoyer des AWI-Projektleiters zur Meeresdüngung hat maßgeblich zu der kritischen internationalen Reaktion beigetragen. Auch in indischen Medien wird das Projekt teilweise als Einstieg in einen lukrativen Milliardenmarkt gesehen. Für das BMU ist es ein fataler Ansatz, den Klimawandel durch ein Herumdoktern an unseren Meeresökosystemen aufhalten zu wollen. Dieses unwissenschaftliche Denken hat unmittelbar in die Klimakrise geführt und taugt nicht zu ihrer Lösung. Einig sind sich BMU und BMBF, daß Eisendüngung kein Instrument der Klimapolitik werden darf. Hier gilt es nun, diese Grundhaltung auch dem AWI zu vermitteln und nicht in Indien oder anderswo auf der Welt die Vision eines Zukunftsmarktes „Meeresdüngung“ aufkommen zu lassen“… das war’s dann wohl mit ’Kohlenstoff gab ich für Eisen’.

Kalkung der Meere

Neuerdings gibt es eine neue Variante der Klimahysterie: Die “Versauerung der Meere“.

Der Säuregrad von Wasser wird mit dem pH-Wert definiert, wobei es sich um den negativen Exponenten der Wasserstoff-Ionen-Konzentration handelt: pH 6,9 und weniger ist “sauer“, 7 ist neutral und ab 7,1 basisch. Nun heißt es neuerdings in der wissenschaftlichen Literatur[18] und auch in allen Medien : “Die Ozeane werden immer sauerer …. So ist der pH-Wert im Oberflächen(!)-Ozean seit Beginn der industriellen Revolution um 0,1 Einheiten gefallen …“ – und zwar angeblich von 8.2 auf 8.1 (Abb.2 a.a.O.).

Dazu muß man wissen:

(1) Von einem ganzzahligen pH-Wert zum nächsten ändert sich die H-Ionen-Konzentration um eine Zehnerpotenz, eine Zehntel Einheit ist also keine dramatische Änderung,

(2) Ob pH 8,2 oder 8,1 – von “sauer“ kann unter chemischen Aspekten überhaupt keine Rede sein, denn wir liegen in jedem Falle um mehr als eine Zehnerpotenz oberhalb von “neutral“ (pH7) im basischen Bereich,

(3) Es ist meist ausdrücklich von den Ozean-Oberflächen die Rede, was sich in Tiefen von mehreren Kilometern ändert, das ist nahezu unbekannt,

(4) Die Ozeane überdecken rund 350 Mill. km2 der Erde, und sind im Mittel ca. 4 km tief. So war es früher wie heute sowohl an der Oberfläche als auch in der Tiefe nur stichprobenartig möglich, diesen pH-Wert zu messen. Da mutet es schon mehr als fragwürdig an, wenn nun neuerdings pauschal über eine “Ozean-Versauerung“ spekuliert wird.

(5) Der pH-Wert der Meere differierte schon immer je nach Breitengrad ganz erheblich, und zwar zwischen 7,8 und 8,2[19]. In den Nordmeeren ist der pH-Wert am höchsten, dort wird CO2 absorbiert: hohe Löslichkeit im kalten Wasser. Am Äquator ist er am niedrigsten, dort wird CO2 emittiert: geringere Löslichkeit im warmen Wasser. Die Meeresströme tragen ebenfalls zur Ungleichverteilung bei.

Zusammenfassend darf man den Physik-Professor Horst-Joachim Lüdecke[20] zitieren: “Die Werte <7 kennzeichnen den saueren und die Werte >7 den basischen Bereich. Meerwasser ist mit seinem Wert von 7.9-8,25 basisch, von ’Versauerung’ zu reden ist daher blanker Unsinn.“

Trotzalledem: Eine neue Variante von Klima-Ängsten wird geschürt.

D a z u “muß“ angeblich sofort gehandelt werden. Und das will man auch unverzüglich, indem man die Ozeane kalkt:

Kalk (Kalzium-Oxid) soll in die Ozeane eingebracht werden, wo daraus in Verbindung mit Wasser Kalziumhydroxid (Löschkalk) entsteht. Dieser wiederum verbindet sich mit dem im Wasser gelösten Kohlendioxid und bildet Karbonatsalze, die letztendlich als Sediment zum Meeresgrund absinken. Wie sich das alles auf die angeblich bedrohte Fauna und Flora in den Meeren auswirkt, das ist allenfalls hypothetisch bedacht. Möglicherweise fängt mit der Kalkung die Bedrohung erst an.

Dazu schreibt der FOCUS[21] : “So zeigten Berechnungen einiger US-Forscher, welche Anstrengungen die Kalkung der Ozeane erfordern würde, die der Londoner Tim Kruger vorschlägt. Dafür würden 1000 bis 1500 Kubikkilometer Kalkstein benötigt, was ungefähr dem Volumen des Mars-Mondes Deimos entspricht oder auf der Erde den Dolomiten. Um diese Menge abzubauen, müßten 333 000 mittelgroße Kalksteinbrüche ein Jahr lang arbeiten. Blieben 50 Jahre Zeit, um die Aufgabe zu vollenden, brauche es immer noch 6700 Steinbrüche. Dies sei nicht im Entferntesten möglich, schlußfolgern sie, zumal viel Kalkstein auch für andere Zwecke gebraucht werde.“

CO2 unter die Erde : CCS

Die meisten Geo-Klima-Experimente sind noch Theorie, aber eines wird bereit erprobt: CO2 abscheiden, komprimieren, verflüssigen und in die Erde zu verpressen. Dieses Verfahren wird als “Carbon Capture and Storage – CCS“ bezeichnet. Dazu werden geeignete geologische Schichten (“Formationen“) unter der Erde gesucht – für sogenannte “CO2-Endlager“. Der Übergang zwischen gasförmigem und flüssigem CO2 (“kritischer Punkt“)[22] liegt bei rund 30°C + 74bar. Um auf der sicheren Seite zu ein, soll bei einem Druck von bis zu 250 bar verpreßt werden. Das birgt Risiken:

Durch den hohen Druck kann es über dem CO2-Lager zu Verwerfungen, Rissen, Sickerungen, Ausgasungen … kommen. Bei Ausgasungen gibt es erhebliche Gefahren. Zunächst: Bei Konzentrationen unter 0,1% (1000 ppm) und folglich auch dem derzeitigen atmosphärischen Wert von knapp 400 ppm (0,04%) gibt es keinerlei gesundheitlich Gefahren. Das traf auch in den vergangenen 800.000 Jahren zu, als die CO2-Konzentration zwischen 180 und 280 ppm schwankte, wobei im Auf+Ab der Eis- und Warmzeiten CO2 der Temperatur folgte[23], und nicht – wie oft behauptet – umgekehrt.

Die ausgeatmete Luft enthält übrigens 4000 ppm (0,4%) CO2[24], folglich die 10-fache CO2-Konzentration der eingeatmeten Luft! Gesundheitliche Probleme entstehen erst bei dem etwa 100- bis 1000-fachen der eingeatmeten atmosphärischen CO2-Konzentration:

“ Eine Anreicherung in der Luft von 5 % führt zur Bewußtlosigkeit, ein Anteil von 8 % innerhalb kurzer Zeit zum Tode.“[25] Es gibt andererseits Hinweise[26], daß bei langzeitiger Einwirkung bereits unter 10.000 ppm (unter 1%) Probleme für Lebewesen eintreten können.

An anderer Stelle in der Fachliteratur[27] heißt es dagegen: Kohlendioxid ist ein nicht brennbares und nicht explosives Gas, das schwerer als Luft ist (Anm.: ca. 1,5-mal), in höheren Konzentrationen die menschliche Gesundheit gefährdet und erst bei Luft-Gehalten von 20% und mehr zum Tode führt“. Letztlich geht es darum: Alle diese Konzentrationen können erreicht werden, wenn CO2 aus Endlagern unkontrolliert an die Erdoberfläche austritt und sich bei wind-schwachen Wetterlagen in Tälern und Mulden sammelt:“… dann allerdings besteht für ganze Bevölkerungen die Gefahr durch Erstickungstod, vor dem Flucht dann nicht möglich ist.“[28] Ein solches Ereignis trat m August 1986 am Nyos-See in Kamerun auf: Etwa 1700 Menschen und viele Tiere kamen zu Tode[29].

Die Gefahr der Fehleinschätzung selbst bei gutachterlich zunächst als unbedenklich eingestuften CO2-Lagerstätten ist jedoch mittelfristig noch viel größer[30]: “Zu den Gefahren einer Technologie addieren sich Risiken durch fehlerhaftes Vorgehen, menschliches Versagen oder gewinnorientierte Risiko-Abschätzung. Man sollte aus dem ’Fall Asse’ schlußfolgern, daß Vorhersagen über potentielle Gefahren sich nach Jahrzehnten oft als falsch erweisen können.“

Abb. 3

Demo in Südtondern (Schleswig-Holstein)

http://www.shz.de/nachrichten/top-thema/article//ccs-entwarnung-in-schleswig-holstein-1.html

Daher gibt es zunehmend Widerstand gegen derartige Endlager[31]: “Im vergangenen Jahr hat er (Anm.: Reinhard Hassa/VATTENFALL) zunehmend Gegenwind gespürt. Nachdem RWE angekündigt hatte, Speicher in Schleswig-Holstein errichten zu wollen, formierte sich zunächst der Bürgerprotest, dann entzog die CSU im Bundestag dem fertigen Gesetzentwurf ihre Zustimmung … Ministerpräsident Harry Carstensen (CDU) warnte davor, das kostenlose CO2-Klo der Republik zu werden.“

Auch an anderen geplanten CCS-Standorten scheiterte die Planung von CO2-Endlagern am gemeinsamen Widerstand von Bevölkerung und Kommunalpolitikern, so in Brandenburg (FAZ a.a.O.) und im Cuxland[32].

Auch die bisherigen Erfahrungen in anderen Ländern[33] mit CCS lassen nichts Gutes ahnen: “Erfahrungen vermittelt das Sleipner-Ölfeld in der Nordsee. Seit 1996 werden jährlich eine Million Tonnen CO2 hineingepumpt. Seither breitet sich die Gaslache unterirdisch aus und wandert mit einem Meter pro Tag seitwärts … Der Druck im Boden hat sich über die Injektionsstelle hinaus deutlich erhöht. Dadurch können … haarfeine Risse im Erddeckel entstehen. Es gibt keinen unterirdischen Speicher, der zu hundert Prozent dicht ist. Man muß sich mit möglichen Leckagen auseinander setzen.“

Projekt schwarze Erde

Zunächst ein Zitat aus dem FOCUS-Magazin[34]: “Die Kritik am Machbarkeitswahn hindert die Forscher nicht, immer wieder neue Ideen zur Planetengestaltung zu entwickeln. Der neueste Vorschlag lautet ’Terra preta’ (portugiesisch = „schwarze Erde“) …“. Im weiteren berichtet der FOCUS darüber, daß die Briten Craig Sams und Dan Morrell weltweit auf 2,5% der Ackerflächen schnell wachsende Hölzer anbauen wollen, um diese dann zu verschwelen und die Holzkohle in den Boden einzubringen. Dadurch soll ein erheblicher Teil des bei der Fotosynthese gebundenen CO2 im Boden gebunden werden. Dieses Verfahren wollen die beiden genannten Initiatoren sowohl in der Grafschaft Sussex als auch im südamerikanischen Belize erproben. Für diese Idee hatte auch bereits der NASA-Forscher Jim Hansen bei Präsident Obama geworben.

Der FOCUS (a.a.O.) zieht folgendes Resumè: “Daß Plantagenhölzer wie Eukalyptus einen enormen Wasserverbrauch haben, die lokalen Ökosysteme verändern, heimische Arten verdrängen und die Plantagen biologisch verarmen, ficht die Erdingenieure nicht an – vom Erhalt der Primärwalder ganz zu schweigen. Wiederum wird der Irrsinn solcher Ideen deutlich.“

Physikalisch gibt es für das Projekt noch weitere kontra-produktive Effekte:

(1) Wälder wirken wegen erhöhter Strahlungs-Absorption “erwärmend“,

(2) Beim Verbrennen der Wälder wird (neben CO2) Wärme erzeugt,

(3) Eine “Schwarze Erde“ vermindert die Strahlungs-Reflektion der Erde (Albedo), mit der Folge: “Global Warming“ !

Luft-CO2 in Zement binden

Diese Idee entwickelte der Chemiker Brent Contstantz[35] von der kalifornischen Stanford University. Dabei soll CO2 aus Kraftwerks-Abgasen durch Meerwasser geleitet werden, wo nach chemischen Umsetzungen Karbonate entstehen. Nach Abschätzungen von Brent Constantz wird pro Tonne Karbonat eine halbe Tonne CO2 gebunden. Dann wird der Karbonat-Schlamm getrocknet und zu Zement verarbeitet. Bis 2010 soll die erste Anlage dieser Art in Betrieb gehen. Schon die derzeitige konventionellen Zement-Produktion erfordert bekanntermaßen einen aberwitzigen Energieverbrauch. So darf man gespannt in, wie die Energie-Bilanz und damit die wahre CO2-Bilanz bei dem neuen Verfahren ausfällt.

Kontroverse Debatte

Die Erde ist kein Labor, sondern unser unersetzbarer Lebensraum. GEO-Experimente können zuvor nicht im Labor ausprobiert werden, sondern stets wird unmittelbar der “Ernstfall“ geprobt – bei negativem Ausgang gibt es kein “ZURÜCK“ !!

So sieht das z.B. auch Prof. Gerhard Schulze[36]: “Im Klimadiskurs betrachten einige Diskurs-Teilnehmer die Erde als reparaturbedürftige Maschine, die sie durch Geo-Engineering wieder in Ordnung bringen wollen: von allen guten Geistern verlassene Klimaklempner, die Vulkanausbrüche simulieren und Partikel in die Atmosphäre schleudern würden, um die Temperatur zu senken.“

Oder der Physik-Professor Knut Löschke[37]: “Anstatt … Milliarden und Abermilliarden zu verschwenden, um CO2-Abgase in Bergbaustollen zu vergraben … braucht es etwas anderes: Eine Rückkehr zur wissenschaftlichen und … politischen Vernunft. … Denn eines ist sicher: Es wird herauskommen, daß die natürlichen und permanenten Veränderungen des Klimas nicht wesentlich von unserem CO2-Eintrag abhängig sind, und daß alle darauf bauenden Argumente und Folgerungen falsch sind.“

Und die Süddeutsche Zeitung[38]: “ … befindet sich Geoengineering auf dem besten Weg, um Spielball einzelner Staaten oder finanzkräftiger Organisationen zu werden.“

Das alles hindert Prof. Schellnhuber[39] (PIK), einen der Haupt-Alarmisten der Klima-Debatte nicht, den STAR-WARE zu propagieren:“…darüber debattieren, ob man nicht eine Art Star-Ware gegen den Klimawandel führen muß , also massives Geo-Engineering betreiben … Einbringen von Schwefelladungen in die Stratosphäre, massive Eisendüngung der Ozeane und vieles mehr … am Krieg gegen den Klimawandel wird bereits gearbeitet.“

F a z i t :

Hier genügt es, eine zusammenfassende Wertung des FOCUS[40] anzuführen :

“Weiter drohen politische Verwerfungen … Wer soll die Hände am Thermostaten der Erde haben? Es ist unwahrscheinlich, daß sich die Welt auf ein optimales Klima einigen kann. Was geschieht, wenn es Russland ein wenig wärmer haben will, Indien aber ein paar Grad kühler? Ganz zu schweigen von den zusätzlichen Treibhausgas-Emissionen durch die massenhaften Flugzeugstarts, die auch an den Erdölreserven der Welt zehren. Andere Forscher lassen an solchen Projektideen kein gutes Haar. Die Pläne, das Erdklima nach eigenem Gutdünken zu gestalten, seien größenwahnsinnig und vermutlich gar nicht durchführbar. Zudem wisse niemand, wie sich solche Eingriffe auf die Ökosysteme des Planeten auswirken.“

Dipl. Meteorologe Klaus E. Puls EIKE.

[1] Hack the Planet; LAUFPASS Nr.25 (2010), S.6-7

[2] Wikipedia: Geo-Engineering

[3] Bengtsson, L.: promet, H.4 (2004), S.191

[4] P. Bissolli, Natw.Rdsch., H.9 (1997), S.343

[5] CRUTZEN, P.: Albedo Enhancement by Stratospheric Sulfur Injections, Zschr. Climatic Change, 2006

[6] Wikipedia

[7] http://www.dradio.de/dlf/sendungen/forschak/1115602/

[8] http://www.spiegel.de/spiegel/0,1518,425979,00.html

[9] http://www.geo.de/GEO/technik/60186.html

[10] http://sciencev1.orf.at/science/news/109319

[11] http://www.geo.de/GEO/technik/60186.html

[12] Plastikmüll in den Weltmeeren, Natw.Rdsch. H.8 (2010), S.425, Abb.2

[13] Steven Levitt, Stephen Dubner: Superfreakonomics. Harper Collins, New York 2009

[14] http://www.berlinonline.de/berliner-zeitung/archiv/.bin/dump.fcgi/2007/0927/wissenschaft/0020/index.html

[15] Das Eisendügungsexperiment LOHAFEX, AWI-Report 2008/2009, S. 46-50

[16] NZ, 23.03.09, S.20, Polarstern kehrt aus Antarktis zurück

[17] http://www.bmu.bund.de/pressearchiv/16_legislaturperiode/pm/42974.php

[18] Naturw.Rdsch., H.11 (2008), S. 597-580

[19] CD Römpp Chemie Lexikon, Version 1.0, Stuttgart/New York, Georg Thieme Verlag, 1995

[20] Prof.Dr.H.-J.Lüdecke: CO2 und Klimaschutz, Bouvier (2010), S.126

[21] FOCUS, 30.01.09, Kann Technik den Planeten retten?

http://www.focus.de/wissen/wissenschaft/odenwalds_universum/frage-von-angela-schultes-kann-technik-den-planeten-retten_aid_365431.html

[22] (http://de.wikipedia.org/wiki/Kritischer_Punkt_Thermodynamik)

[23] http://www.geocraft.com/WVFossils/stomata.html

[24] A. Nitsch: Klimawandel, CO2-Ausstoß und die öffentliche Meinung, Neue Landwirtsch., 5/2009, S.56

[25] http://www.kugelerde.de/jgs_db.php?action=show&eintrags_id=13169&katid=70

[26] Dr. Albrecht Nitsch, Bremervörde, pers.Mitt., 2010

[27] Natw.Rdsch., H.8 (2010), S.417

[28] Prof. Dr. C.O. Weiß:>Rückkopplung im Klimasystem der Erde; http://www.eike-klima-energie.eu/news-anzeige/rueckkopplung-im-klimasystem-der-erde/

[29] http://www.kugelerde.de/jgs_db.php?action=show&eintrags_id=13169&katid=70

[30] Im Untergrund herrscht keine Sicherheit, Umwelt-Magazin WATERKANT, Sandstedt, H.1 (2009), S. 8-10

[31] FAZ, 01.04.2010, S.12, “Alles unter die Erde“

[32] SoJourn. 24.01.2010, S.15: CO2-Lager abgewendet, EON darf im Cuxland nicht suchen

[33] S. Haszeldine, Univ. Edinburgh, sowie GFZ Potsdam in Handelsblatt: Unterirdische Klimaretter, 18.02.2010, S.20,

[34] FOCUS, 30.01.09, Kann Technik den Planeten retten?

http://www.focus.de/wissen/wissenschaft/odenwalds_universum/frage-von-angela-schultes-kann-technik-den-planeten-retten_aid_365431.html

[35] FOCUS, 30.01.09, Kann Technik den Planeten retten?

http://www.focus.de/wissen/wissenschaft/odenwalds_universum/frage-von-angela-schultes-kann-technik-den-planeten-retten_aid_365431.html

[36] G. Schulze, Schriftenreihe VONTOBEL-Stiftung, Nr. 1920, Krisen, Zürich, 2010, S.41

[37] Gefährliches Nichtwissen, FTD, 02.07.2010

[38] SZ, 5./6.06.2010, Wer verstellt den globalen Thermostaten?

[39] “Manchmal könnte ich schreien“ ; DIE ZEIT, Nr.14, 26.03.09, Dossier S.17

[40] FOCUS, 30.01.09, Kann Technik den Planeten retten?

http://www.focus.de/wissen/wissenschaft/odenwalds_universum/frage-von-angela-schultes-kann-technik-den-planeten-retten_aid_365431.html

Related Files

ppt Vortrag

ppt Vortrag

ppt Datei

ppt Datei