Anzeichen der globalen Abkühlung

Seit etwa 2 Dekaden wird uns dringend nahe gelegt, gegen die beispiellose globale Erwärmung vorzugehen, anderenfalls es zu einem heißen und feurigen Ende der Welt kommt. Und doch, das Gegenteil scheint der Fall zu sein.

Der gesamte Planet hat seit 1998 aufgehört, sich zu erwärmen und, noch signifikanter, begann sich seit 2003 abzukühlen. Anstatt die Menschen vor kälterem Wetter während der nächsten 30 Jahre zu warnen, wird immer noch das Märchen hochgehalten, dass man eine beispiellose Erwärmung erwarten müsse. Völker und Regierungen werden gedrängt, total in die falsche Richtung aus den falschen Gründen zu gehen – und zu einem potentiell horrenden Preis.

Man schaue sich nur an, was in Großbritannien los war. Vor zehn Jahren erzählte man den Briten, dass sie ausschließlich mit einer globalen Erwärmung rechnen müssten und Schnee ein Ding der Vergangenheit wäre. Tatsächlich passierte genau das Gegenteil, und zwar gleich während drei aufeinanderfolgenden Wintern. Dieser Winter hat die gesamte Nation für einen ganzen Monat, nämlich Dezember 2010, in seinem eisigen Klammergriff gehalten.

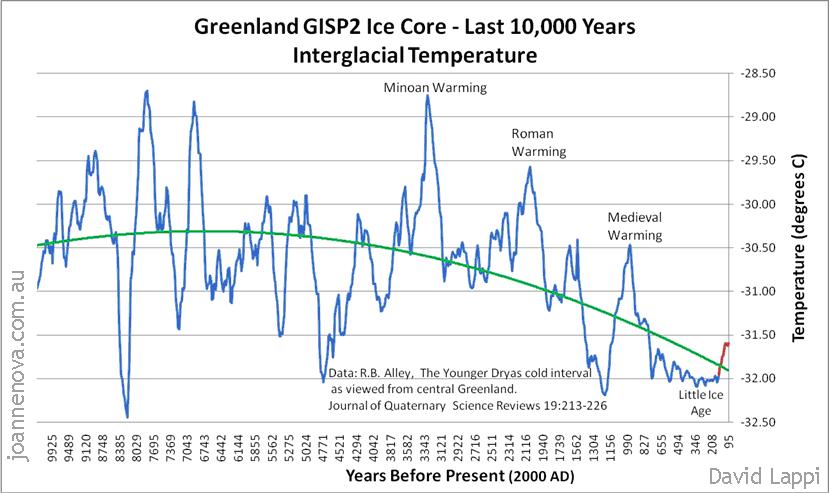

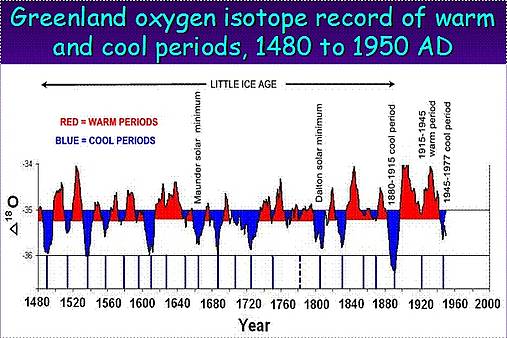

Perioden mit Erwärmung und Abkühlung in der Vergangenheit.

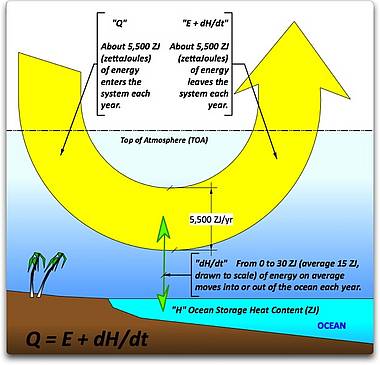

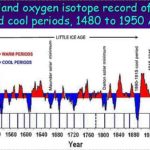

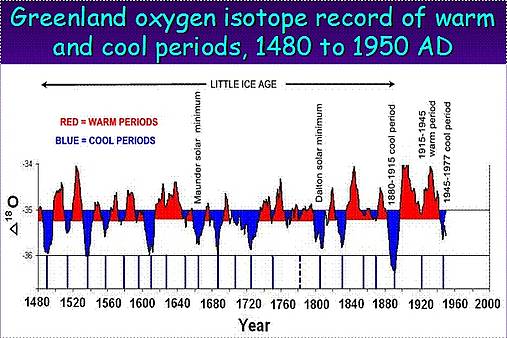

Alternierende Perioden mit wärmerem und kälterem Wetter haben uns seit Beginn von Klimaaufzeichnungen begleitet. Einige der vergangenen kälteren Perioden waren schlimmer als andere, wie das Sporer-, Maunder- und Dalton-Minimum. Professor Don Easterbrook hat das hier dargestellt, siehe Abbildung 1:

Abbildung 1

Easterbrook sagte auch:

- „Klimaänderungen in geologischen Zeiträumen zeigten während der letzten 500 Jahre eine regelmäßige Verteilung alternierender Erwärmung und Abkühlung mit einer Periode von 25 bis 30 Jahren“.

- „Es gibt eine starke Korrelation zwischen solaren Veränderungen, der PDO, Gletschervorstößen und –rückzügen, und das globale Klima gestattet uns, eine damit konsistente Verteilung in die Zukunft zu projizieren“.

- Man erwarte eine globale Abkühlung während der nächsten 2 bis 3 Dekaden, die sich viel schlimmer auswirken wird als jede Erwärmung.“

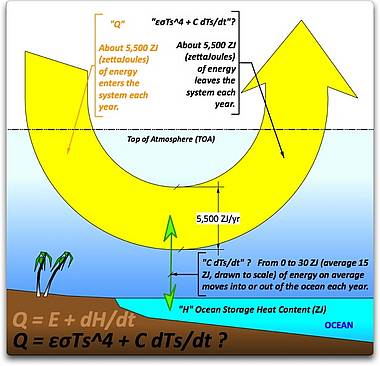

Abbildung 2 zeigt die Art der Abkühlung, die Professor Easterbrook in Zukunft erwartet:

Abbildung 2

Quelle: http://www.iceagenow.com/Looming_Threat_of_Global_Cooling.htm

oder in Deutsch hier.

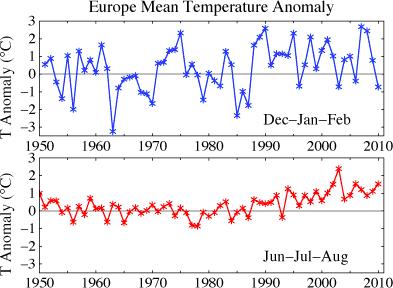

Also, warum sind IPCC und AGW so still hinsichtlich der Möglichkeit einer globalen Abkühlung? Weil das IPCC niemals den Auftrag hatte, alle Gründe der Erwärmung zu untersuchen – sondern ausschließlich die anthropogene Komponente davon. Inzwischen kommen andere Wissenschaftler zu dem Ergebnis, dass der anthropogene Anteil an der Erwärmung verschwindend gering im Vergleich zu natürlichen planetarischen Faktoren ist. Das IPCC sagt Folgendes über das in Europa zu erwartende Klima:

„Die jährlichen Mitteltemperaturen in Europa werden wahrscheinlich schneller steigen als das globale Mittel. Am stärksten wird die Erwärmung in Nordeuropa im Winter, im Mittelmeergebiet im Sommer ausfallen. Die niedrigsten Wintertemperaturen in Nordeuropa werden wahrscheinlich rascher steigen als die Mitteltemperatur des Winters, und die höchsten Sommertemperaturen werden wahrscheinlich schneller steigen als die Mitteltemperatur im Sommer in Zentral- und Südeuropa.“

Die letzten Winter haben gezeigt, dass das Gegenteil zutrifft. Lassen Sie uns einen Blick auf die letzte Periode (von 26 Jahren) kälteren Wetters in Europa werfen (Jahre 1962 bis 1987) sowie auf die häufigsten Klimavariablen während dieser Periode:

Welches waren die allgemeinen Klimafaktoren in der letzten Kaltperiode in Großbritannien und Europa?

Eine Analyse der Temperatur im Winter der letzten Kälteperiode in Zentralengland zeigt, dass die Temperatur in 20 der 26 Winter unter dem Mittelwert von 4,8°C lag. Während dieser 20 Jahre war die AO (Arktische Oszillation) in 90% aller Fälle negativ (18 Jahre), die AMO war negativ in 85% (17 Jahre), die NAO zu 65% (13 Jahre) und die PDO in 45% der Zeit (9 Jahre).

Hieraus kann man folgern, dass das Auftreten negativer oder kalter AO, AMO und NAO signifikant kältere Winter zur Folge hat, und das diese kälteren Winter gehäuft auftreten – etwa in 2 von 3 Fällen während der Kaltperiode. Das Signal der ENSO war ähnlich gut verteilt: 5 Jahre mit La Nina, 8 Jahre mit El Nino und 7 neutrale Jahre. Es scheint, dass Jahre mit einem El Nino häufiger mit einer negativen AO korreliert, was dazu führt, dass kalte Arktikluft südwärts vorstoßen kann (wie im Winter 2009/2010).

Was sagt das Met Office über die globale Abkühlung?

Das Met Office sagt, das seine Dekade der Abkühlung möglich ist, aber nur einmal alle 8 Jahrzehnte. Und so hat es seine Karten bereits verspielt, weil die jüngste Dekade 2001 bis 2010 keinen Temperaturtrend mehr zeigte. Daraus folgt, dass es nach seiner Prognose keine weitere Periode der Abkühlung oder auch nur trendfreie Perioden während der nächsten 8 Jahrzehnte geben wird. Um die vom Met Office prognostizierte Erwärmung um 4°C bis 2060 zu bekommen, müsste die gegenwärtige Erwärmungsrate 18 mal höher sein als heute (unter Nutzung der Daten aus WOOD FOR TREES.)

Was hat es mit dem warmen Jahr 2010 auf sich?

Es ist trivial, dass es während eines starken El Nino wie im Jahr 2010 besonders warm ist. Das Jahr 1998 war ebenfalls ein solches warmes El Nino-Jahr. Es sind natürliche Ursachen, die Temperatur in El Nino-Jahren nach oben treiben. Und doch hat es statistisch keine Erwärmung seit 1995 mehr gegeben. Auch gab es 4 El Nino-Ereignisse während der letzten 9 Jahre. Dies ist häufiger als in der Vergangenheit, als diese Ereignisse nur alle 4 bis 7 Jahre aufgetreten waren. Acht der 10 letzten Jahre wurden durch das natürliche Phänomen El Nino beeinflusst. Daraus folgt, dass der Hauptgrund für die warme Dekade und den milden Winter 2010 in Kanada bei El Nino und der PDO liegt. Dies hat nur sehr wenig mit der globalen Erwärmung oder der Zunahme der Emissionen von Treibhausgasen zu tun.

Für Kanada gilt: wenn man die El Nino-Winter der Jahre 2003, 2005, 2007 und 2010 ausschließt, hat die Temperatur im Winter tatsächlich während der letzten 10 Jahre abgenommen, verglichen mit dem Mittelwert der Periode 1948 bis 2010, und zwar von 2,5°C im Jahre 2000 bis 0,3°C im Jahre 2009, dem letzten sehr kalten Winter. In einigen Gebieten wie den Prärieprovinzen und den Nordwest-Territorien gab es sogar einen Rückgang der Wintertemperatur von 2006 bis 2009 um 7,1°C.

Was steckt hinter unserem sich ändernden Klima?

Die Antwort scheint in der natürlichen Variabilität der ENSO-Ereignisse zu liegen, ebenso wie in den regelmäßigen Änderungen im Pazifischen Ozean und der Oberflächentemperatur im Nordatlantik, wie sie sich aus PDO und AMO ergeben, Änderungen der Arktischen Oszillation AO, vulkanischer Aktivität und solaren Zyklen. Lassen Sie uns auf die jüngere Geschichte dieser tatsächlichen Klimamacher zurück blicken.

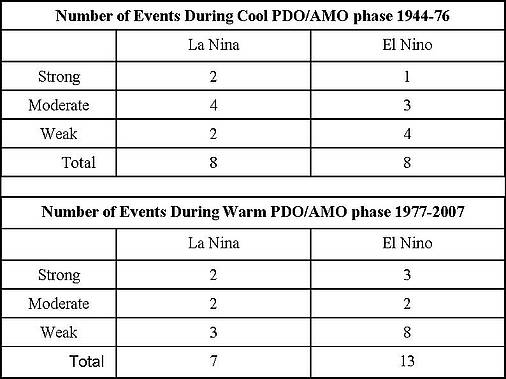

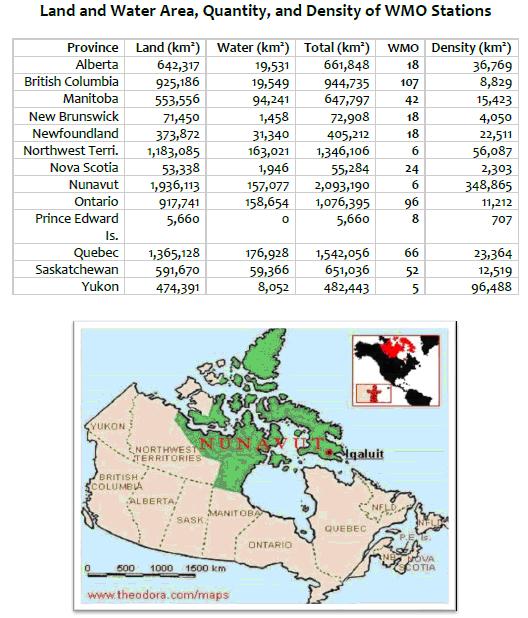

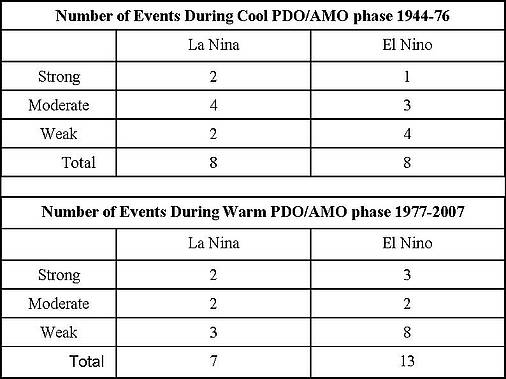

Tabelle 1

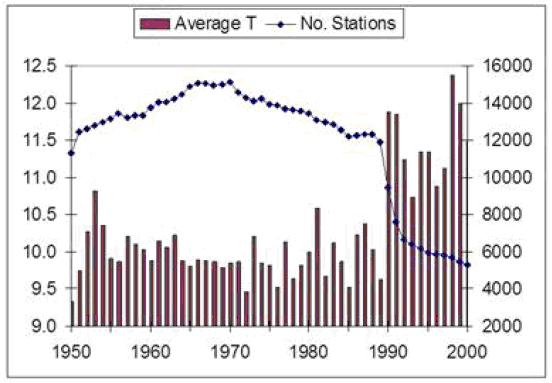

Welchen Einfluss haben die ENSO-, PDO- und AMO-Zyklen?

Während der negativen bzw. kalten Phasen von PDO und AMO gibt es mehr La Nina-Ereignisse als während der positiven Phasen. Dies trägt zu mehr kalten Wintern und kälteren Jahren während einer negativen PDO bei.

Während positiver oder warmer Phase von PDO und AMO treten signifikant häufiger El Nino-Ereignisse auf. Dies ist der Grund für eine stärkere Erwärmung, wenn die PDO positiv ist.

Die globale Erwärmung war das Ergebnis eines nahezu simultanen Auftretens der warmen bzw. positiven Phase der PDO und der AMO. Die PDO ist eine Folge von ENSO-Ereignissen im Pazifik. Beide Effekte können ihre Ursache teilweise oder ganz in Zyklen der Wassertemperatur und einer Zirkulation in den Ozeanen haben, die man MOC oder Meridional Overturning Circulation [etwa: Meridionale Umwälzung] nennt und die durch alle großen Ozeane fließt.

Die gegenwärtige negative oder kalte Phase der PDO und das La Nina-Ereignis sind der Grund für all das kalte Wetter in jüngster Zeit. Die La Nina-Ereignisse könnten direkt zu der Überschwemmung am Red River [in den USA] im Jahre 2009 sowie zu den jüngsten Überschwemmungen in Australien und Brasilien beigetragen haben. Die typischen Auswirkungen von AMO und PDO auf das Klima in Nordamerika zeigt diese Studie: http://www.pnas.org/content/101/12/4136.full.pdf+html.

Ein anderer Schlüsselfaktor, der demnächst (in 1 bis 4 Jahren) zur globalen Abkühlung an der kanadischen und US-Ostküste, der Westküste Europas und der Arktis beitragen wird, ist die Abkühlung des Nordatlantik im Zuge der Atlantischen Multidekadischen Oszillation AMO. Diese Abkühlung begann nach dem Jahr 2005. Aber die AMO wird durch ENSO-Zyklen beeinflusst, vor allem El Nino-Ereignissen. Daher kam es zu einer kurzen Warmphase der AMO im Jahr 2010. Die Klimageschichte zeigt, dass die globale Abkühlung am stärksten war, wenn sich sowohl die PDO als auch die AMO beide in ihrer negativen oder kalten Phase befanden, wie von 1964 bis 1976 und dann wieder von 1916 bis 1923. Die AMO befand sich in ihrer positiven oder warmen Phase seit 1994. Deren Zyklus lässt sich nicht so gut vorhersagen wie der 60-jährige Zyklus der PDO, aber in jüngerer Zeit folgte die AMO der PDO mit einer Verzögerung von etwa 20 Jahren.

Deren Zyklen waren ziemlich variabel. Während des letzten Zyklus‘ befand sie sich für 30 Jahre (von 1964 bis 1994) in ihrer negativen oder kalten Phase, und ihr Zyklus scheint mit der MOC und den Änderungen der Atlantischen Thermohalinen Zirkulation (THC) [?] zusammen zu hängen. Es gibt eine ganze Reihe von Abschätzungen, wann sie wieder negativ wird. Meine beste Schätzung ist etwa das Jahr 2015, basierend auf den am häufigsten in der Vergangenheit aufgetretenen Intervallen von 20 Jahren und dem kälteren Wasser, das die MOC aus den Südlichen Ozeanen unterstützt [?]. Sobald sie tatsächlich negativ wird, dürfte die globale Temperatur bis etwa zum Jahr 2030 weiter zurückgehen, die Arktis wird sich weiter abkühlen und das arktische Meereis sollte wieder zunehmen.

Welches sind die jüngsten Beweise für globale Abkühlung?

· Die PDO trat im September 2007 in ihre negative und abkühlende Phase (möglicherweise noch für die nächsten 20 bis 30 Jahre)

· Die AMO hat ihren Höhepunkt überschritten und begann im Juli 2010 abzunehmen. Es wird vermutet, dass diese Abkühlung bis 2015 andauern wird.

· Der SOI war sehr positiv (um +20) seit dem Juli (was 5 bis 7 Monate später zu kaltem Wetter führt)

· AO und NAO befinden sich immer häufiger im stark negativen Bereich (die AO hat einen rekordverdächtigen negativen Wert von -4,266 im Februar 2010 und fast -5 im Dezember 2010 erreicht)

· Die solare Aktivität verharrt nahe dem minimalen Niveau

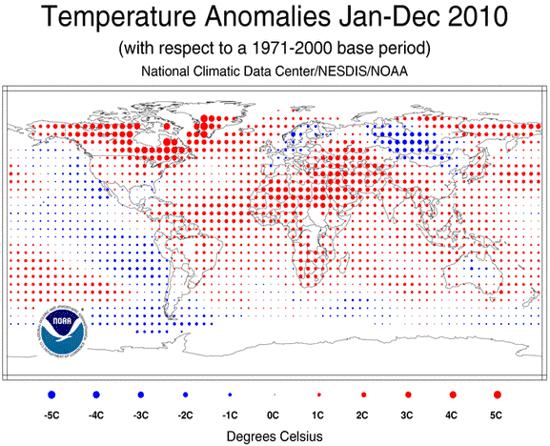

· Die meisten globalen Anomalien der Temperatur zeigten 2010 eine Abkühlung

· Die Wassertemperatur der Ozeane (SST) geht zurück

· Der Anstieg des Wärmegehalts der Ozeane ist in den letzten 6 Jahren zum Stillstand gekommen (mit einer signifikanten Abnahme des Wärmegehalts im Nordatlantik)

Abkühlung des Weltklimas

· In Europa und Asien gab es drei kalte Winter hintereinander (neue Kälterekorde gab es 2010 in vielen Gebieten)

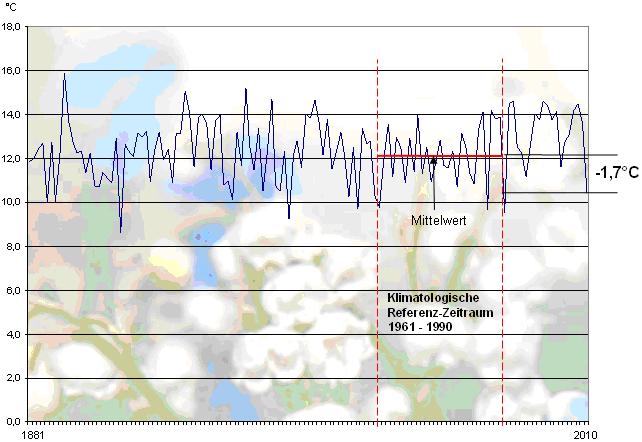

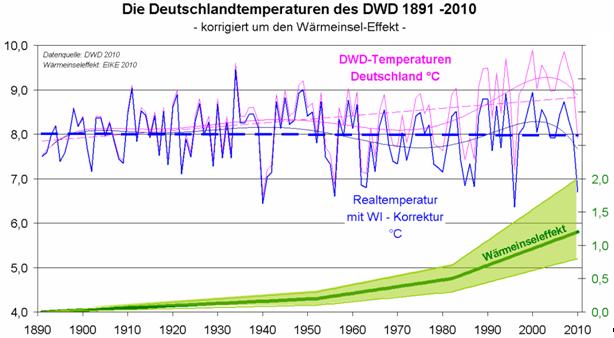

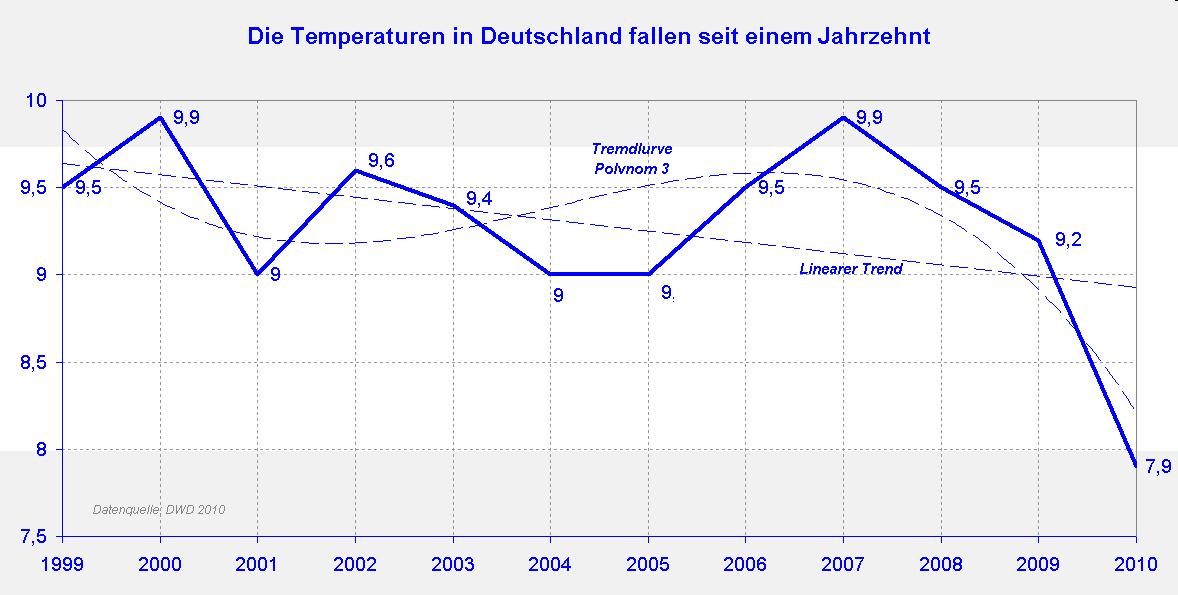

· Die jährlichen Mitteltemperaturen in Europa (Festland) sind seit 2007 zurückgegangen.

· In Großbritannien sind die Mitteltemperaturen seit 2006 zurückgegangen, also seit 4 Jahren.

· 2010 war das kälteste Jahr in Zentralengland (8,83°C) seit 1986 oder seit 14 Jahren (8,74°C)

· Die Wintertemperaturen in Großbritannien gingen seit 2007 zurück (4 Jahre). Während der letzten beiden Winter kam es dort zu einer Rekordkälte.

· Die Mitteltemperaturen in Nordamerika begannen seit 2006 abzukühlen.

· Die Winter in Kanada wurden seit 2001 immer kälter (ausgenommen Jahre mit einem El Nino).

· In den USA gab es 2010 einen der schlimmsten Winter (an 15. Stelle seit 1895), trotz eines El Nino

· Rekordschneemengen und neue Kälterekorde gab es im Dezember 2010

· In Schweden war der kälteste Dezember seit 110 Jahren aufgetreten.

· In Großbritannien war der Dezember 2010 der kälteste seit 120 Jahren

· In Deutschland war es der kälteste Dezember seit 41 Jahren

· In Irland war es der kälteste Dezember seit 129 Jahren, also seit 1881

Ähnliche Kälterekorde gab es im Mittleren Osten, auf der koreanischen Halbinsel, in der Karibik, den USA sowie in Nordwestkanada, China und Indien.

Ausdehnung der Schneedecke

- Im Jahr 2010 gab es auf der Nordhemisphäre die größte Fläche winterlicher Schneebedeckung seit dem Winter 1978/79 (2008 war es die dritthöchste seit 1967).

- 2010 gab es die größte winterliche Schneedeckenausdehnung seit 1967, und die Ausdehnung nahm seit 2006 immer mehr zu

- 5 der 11 ausgedehntesten Schneebedeckungen in Eurasien traten seit 2003 auf (2003 war es die zweithöchste seit 1967)

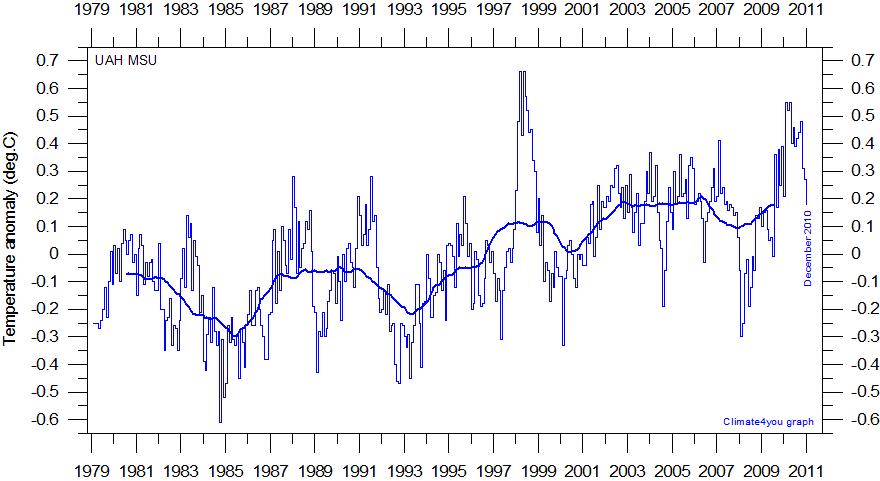

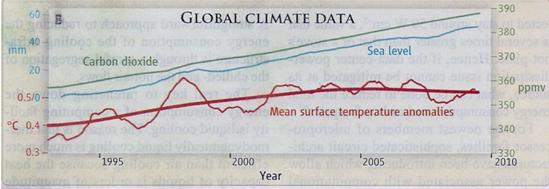

Was passiert mit den Abweichungen der globalen Mitteltemperatur?

Betrachten wir einige Fakten zur gegenwärtigen Anomalie der globalen Mitteltemperatur.

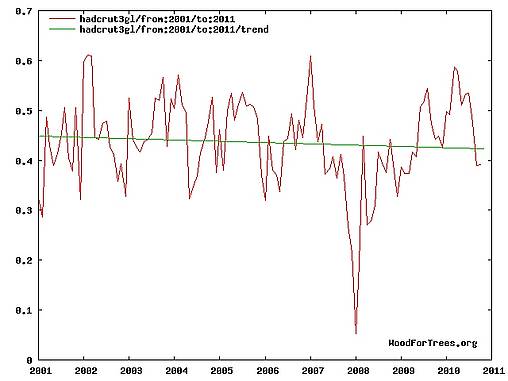

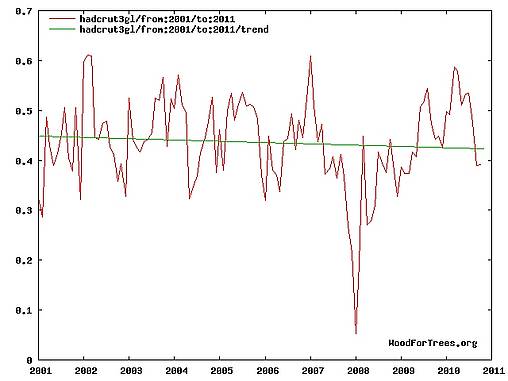

Abbildung 3

Die globale Temperaturanomalie nach HADCRUT 3GL GLOBAL in Abbildung 3 ist seit nunmehr zehn Jahren gleich geblieben und hat tatsächlich im letzten Quadrant um 0,0026°C pro Jahr abgenommen [Original: is actually decreasing at least square trend slope of -0.0026 C per year. [Ohne Gewähr, dass diese Übersetzung korrekt ist! A. d. Übers.] Das IPCC prognostizierte eine Zunahme um 0,21°C pro Jahrzehnt (+0,0021°C pro Jahr) für jedes der beiden nächsten Jahrzehnte (seit 2000). Es prognostizierte eine Anomalie von 0,6°C bis 2010. Der tatsächliche Wert liegt bei 0,392°C und zeigt fallende Tendenz.

Irgendetwas scheint in der Wissenschaft des IPCC fundamental falsch zu sein. Seine Prognosen und die tatsächlichen Temperaturen verlaufen entgegen gesetzt, trotz der Änderungen des CO2-Gehaltes, und das schon nach der ersten Dekade dieser seiner Vorhersage.

Hier folgen die globalen Mitteltemperaturen aus 4 verschiedenen Datensätzen (von Januar 2001 bis Oktober 2010, also die letzten 118 Monate – Wood for trees):

HADCRUT 3GL – 0.0026 C pro Jahr

RSS: + 0.0034 C pro Jahr

GISS: + 0.0080 C pro Jahr

UAH: +0.0093 C pro Jahr

Mittel + 0.0044 C pro Jahr

Kann irgendein geistig gesunder Mensch eine Temperaturänderung von vier Tausendstel Grad feststellen und dies auf dem ganzen Globus messen? Dies zeigt, wie absurd der Alarmismus der globalen Erwärmung inzwischen geworden ist! [Hervorhebung dieses Satzes vom Übersetzer!]

Die historische Globale mittlere Temperaturanomalie (GMTA) lässt sich am besten mit einer linearen Komponente eines Anstiegs mit einer mittleren Rate von 0,0059°C pro Jahr seit 1880 oder einer solchen von 0,0045°C pro Jahr, wenn man 150 Jahre zurück geht, verdeutlichen, und zwar nach den Darstellungen des IPCC plus einer OSZILLIERENDEN Komponente, die einen sinusartigen Effekt mit einer Amplitude von 0,3°C hat. Diese beiden Anomalien addieren sich und erzeugen gemeinsam einen Zyklus von 60 Jahren, und zwar alternierend mit einer Abkühlung von 0,42°C und einer Erwärmung um 0,77°C, beides jeweils innerhalb von 30 Jahren.

Diese Verteilung wird verschiedentlich modifiziert durch kurzfristige Temperaturzu- und -abnahmen infolge von ENSO-Zyklen (El Nino wirkt erwärmend und La Nina abkühlend), großen Vulkanausbrüchen (VE 4+) plus jedweder Änderungen der Solaraktivität. Diese kurzfristigen Störungen können signifikant sein (bis zu +/-0,4 bis 0,5°C außerhalb des Gleichungsmodells [?]).

Wie lauten die Vorhersagen der AGW für die Zukunft?

Vorhersage des IPCC: 2,4 bis 6°C bis zum Jahr 2100, oder 0,02 bis 0,6°C pro Jahr, also 4 bis 13 mal so hoch wie die gegenwärtige beobachtete Rate des Anstiegs.

Vorhersage des Met Office: 4°C bis 2060 oder 0,08°C pro Jahr (18 mal so hoch wie die gegenwärtige beobachtete Rate des Anstiegs).

Was projizieren die nicht der AGW-Bewegung angehörenden Wissenschaftler?

Es gibt eine wachsende Zahl von über 30 verschiedenen internationalen Klimawissenschaftlern, Akademikern, Meteorologen, Klimaforschern und Ingenieuren, die auf diesem Gebiet geforscht haben und die nicht den Vorhersagen einer noch nie da gewesenen Erwärmung von AGW und IPCC zustimmen, und die für die nächsten 1 bis 3 Dekaden kälteres Wetter annehmen. Einige sind sogar Unterstützer von AGW, stimmen aber nicht der projizierten Erwärmung für die nächste Dekade zu (siehe http://notrickszone.com/2010/12/28/global-cooling-consensus-is-heating-up-cooling-over-the-next-1-to-3-decades/ – auf Deutsch hier). Jeder Autor begründet hier, warum er von einer bevor stehenden globalen Abkühlung während der nächsten 10 bis 30 Jahre ausgeht. Diese Autoren beschreiben die natürlichen Faktoren, die das zukünftige Klima beeinflussen können, vor allem die Auswirkungen möglicher reduzierter Sonnenzyklen. Damit befasst sich der Autor dieses Beitrags jedoch nicht, weil der Beitrag sonst viel zu lang ausfallen würde.

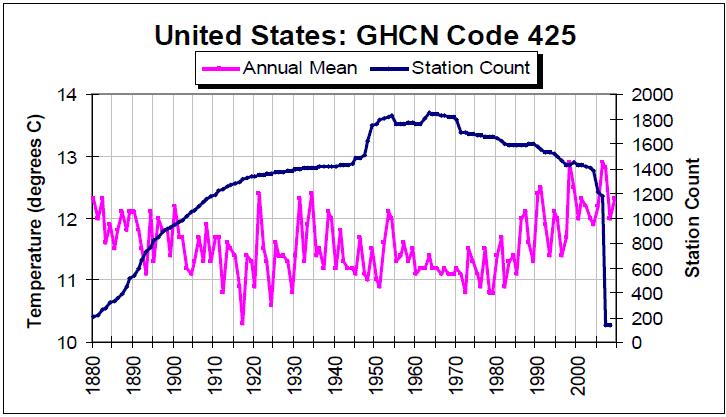

Welche Schlüsse lassen sich aus planetarischen Zyklen der Vergangenheit ziehen?

Der Höhepunkt der jüngsten Warmphase lag zu Anfang dieses Jahrzehnts. Inzwischen könnte ein 30 Jahre dauernder kalter Zyklus begonnen haben, der zu einer Temperaturabnahme um 0,42°C bis zum Jahre 2030 führen wird. Es wird sicher noch einige warme El Nino-Jahre geben, aber der allgemeine Trend wird kälter sein als während der letzten 30 Jahre. Basierend auf der kälteren Anomalie von 0,06°C bis 2030 werden die Temperaturen ähnlich wie in den späten siebziger und frühen achtziger Jahren des 20. Jahrhunderts sein. Die Temperaturanomalie von Hadcrut3 betrug im September 2010 0,391°C und könnte noch auf 0,16°C bis 2020 zurückgehen bis zu einem Wert von etwa 0,06°C bis 2030. Die Projektion des IPCC lautet dagegen, dass die Temperaturanomalie bis 2020 auf etwa 0,8°C steigen soll. Diese beiden unterschiedlichen Projektionen, also die Vorhersage aufgrund natürlicher planetarer Zyklen und die Vorhersagen des IPCC, laufen rapide immer weiter auseinander.

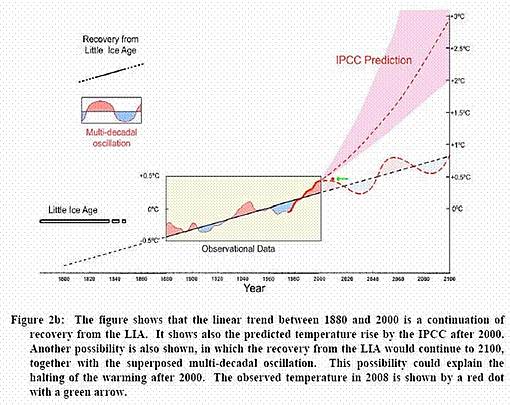

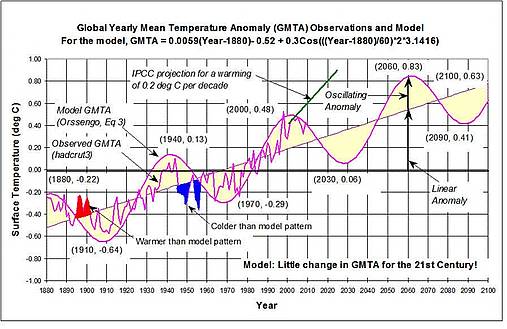

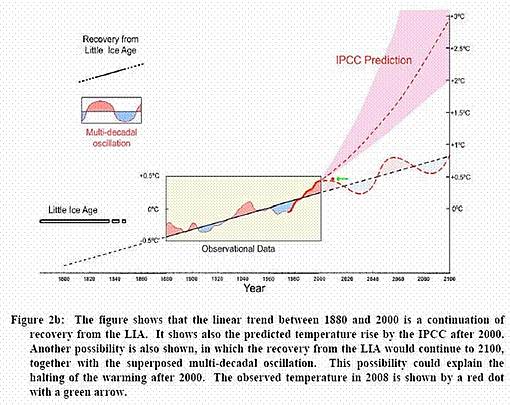

Abbildung 4 zeigt eine Graphik der globalen Temperaturanomalie sowohl in der Vergangenheit als auch projiziert in die Zukunft. Sie wird präsentiert von Syun-Ichi-Akasofu (Gründungsdirektor und Physikprofessor am International Arctic Research Center, University of Alaska):

Abbildung 4

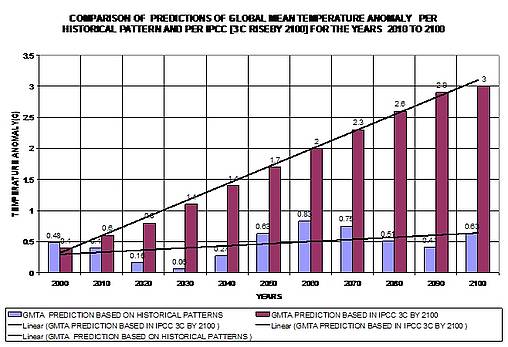

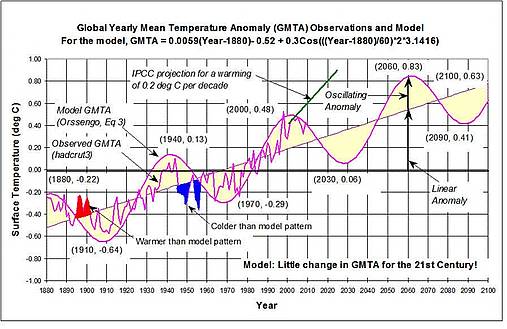

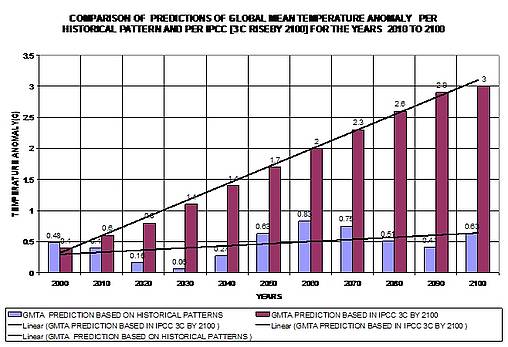

Die Abbildung 5 unten stammt aus einer Studie mit dem Titel Predictions of Global Man Temperatures & IPCC Projections (etwa: Vorhersagen der globalen mittleren Temperaturen & Projektionen des IPCC) [Achtung! Der Titel scheint im Original einen Schreibfehler zu enthalten! Gemeint ist vermutlich nicht Global Man Temperature, sondern Global Mean Temperature! A. d. Übers.] von Girma Orssengo, die zuvor auf WUWT gepostet worden war. Dabei handelt es sich um ein simples mathematisches Modell, das auf der Global Mean Temperature Anomaly (GMTA) von Hadcrut3 basiert. Die Gleichung oder das Modell ist aus keinen anderen messbaren Parametern abgeleitet als den aktuellen globalen Temperaturanomalien der Vergangenheit. Obwohl es nicht aus irgendeiner Physik abgeleitet worden war und ihr weder Energiemechanismen noch physikalische Gegebenheiten zugrunde liegen, ist es in gewisser Weise doch ein recht informativer Graph. Er basiert auf aktuellen empirischen Daten der Vergangenheit (hadcrut3) seit 1880.

Es gibt keine Garantie, dass irgendeine Zukunftsprojektion dieses Graphen je wirklich eintreten wird (es gibt aber auch keinen Beweis dafür, dass die gegenwärtigen Computermodelle von AGW noch irgendwie glaubwürdig sind). Jedoch kann der unten stehende Graph trotzdem nützlich sein. Er ähnelt dem “poor man’s “global temperature model [?] und besagt Folgendes:

- Der Graph ist ein allgemeiner Indikator des Klimatrends in der Vergangenheit (geht der Zyklus demnächst abwärts oder aufwärts?)

- Es gibt einen 60-jährigen Klimazyklus mit jeweils 30 Jahren Erwärmung, der 30 Jahre der Abkühlung folgen, und der sich regelmäßig alle 60 Jahre wiederholt.

- Vor dem Jahr 2100 könnte es demnach noch zwei Zyklen mit Abkühlung geben, die die Erwärmung durch Treibhausgase marginal erscheinen lassen und deutlich überkompensieren.

- Wahrscheinlich ist der Graph im Kurzfristzeitraum (die nächsten 10 bis 30 Jahre) nützlicher und genauer.

- http://noconsensus.files.wordpress.com/2010/04/image2.jpg

Abbildung 5

Abbildung 6 zeigt einen Graphen mit den möglichen zukünftigen Anomalien der GMTA pro Jahr, indem er die HISTORISCHEN NATÜRLICHEN PLANETARISCHEN ZYKLEN zeigt [Hervorhebung im Original] und das mittlere, vom IPCC projizierte Szenario einer Erwärmung um 3,0°C bis 2100. Einige andere Szenarien des IPCC zeigen einen Temperaturanstieg in der Größenordnung zwischen 2,4 und 5,3°C bis 2100, was eine sogar noch steilere Rate des Temperaturanstiegs [pro Jahr] bedeuten würde.

Abbildung 6

Siehe die Studie von Girma Orssengo für mehr Details des VORHERSAGEMODELLS von GMTA und der zugrunde liegenden Gleichung, und auch besonders die Abbildung 3 auf Seite 4, die den Verlauf der GMTA während der Jahre 1880 bis 2100 zeigt. Viele der Informationen zum GMTA stammen aus dieser Studie, die auf WUWT gepostet wurde: http://wattsupwiththat.files.wordpress.com/2010/04/predictions-of-gmt.pdf.

Warum es im 21. Jahrhundert eine geringere Erwärmung als im vergangenen 20. Jahrhundert geben könnte (Zitat aus dem oben erwähnten Papier von Girma Orssengo)

…das 20. Jahrhundert begann, als sich die oszillierende Anomalie gerade 1910 in ihrem Minimum befand mit einer GMTA von -0,64°C, und endete mit dem Maximum um das Jahr 2000 mit einer GMTA von 0,48°C. Das ergibt eine große globale Erwärmung von 0,48 + 0,64 = 1,12°C. Diese große Erwärmung resultierte aus dem seltenen Vorkommen von zwei Erwärmungsphasen von jeweils 0,77°C, aber nur einer Abkühlungsphase von 0,44°C. Daraus ergibt sich eine globale Erwärmung um 2*0,77-0,42=1,12°C.

Im Gegensatz zum 20. Jahrhundert wird es laut Abbildung 3 nahezu keine Änderung der GMTA im 21. Jahrhundert geben. Der Grund hierfür liegt darin, dass das Jahrhundert zu der Zeit begann, als sich die oszillierende Anomalie gerade im Maximum befand, und zwar um das Jahr 2000 mit einer GMTA von 0,48°C. Es wird im Minimum enden, also um das Jahr 2090 mit einer GMTA von 0,41°C. daraus resultiert eine vernachlässigbare Größenordnung von -0,07°C. Diese vernachlässigbare Änderung ergibt sich aus dem seltenen Ereignis, dass es zwei Abkühlungsphasen mit jeweils 0,42°C und nur einer Erwärmungsphase mit 0,77°C gibt.

Erwähnenswert ist, dass keine der auf planetarischen Zyklen basierenden Vorhersagen eine Temperaturzunahme von 2 bis 4 oder gar 6°C simuliert, wie es die Vorhersagen des Met Office und des IPCC tun. Diese auf planetarischen Zyklen basierenden Vorhersagen von Prof. Easterbrook und Prof. Syun-Ichi Akasofu gehen von einer Erwärmung von weniger als 1°C bis 2100 aus, ähnlich dem, was im vergangenen Jahrhundert geschehen war.

Auch Dr. Roy Spencer von der University of Alabama und Professor R. Lindzen vom MIT [Massachusetts Institute of Technology] glauben, dass der Temperaturanstieg bis zum Ende dieses Jahrhunderts lediglich etwa 1°C ausmacht.

Zusammenfassung

Während der nächsten 10 bis 30 Jahre wird es eher zu kälterem Wetter kommen als zu einer nie da gewesenen Erwärmung. Dies heißt nicht, dass es in allen der nächsten 10 bis 30 Jahre kälter ist, da es nach wie vor einige warme El Nino-Jahre geben wird, aber der generelle Trend der nächsten 2 bis 3 Dekaden dürfte kälter ausfallen und nicht eine nie da gewesene Erwärmung zeigen, wie es AGW behauptet.

Es gibt niemandem auf diesen Planeten, der genau sagen kann, wie das Klima in einem Jahr oder in einem Jahrzehnt und schon gar nicht in 100 Jahren aussehen wird. Dieser Artikel sollte zeigen, dass es andere Möglichkeiten der Entwicklung des Klimas gibt, die nicht notwendigerweise eine größere Reduktion der CO2-Emissionen erforderlich machen. Eine andere Version der Klimavorhersage, die auf natürlichen planetarischen Zyklen basiert, scheint viel wahrscheinlicher, wird die Erde viel mehr betreffen und viel schneller kommen als eine noch nie da gewesene Erwärmung. Einige Winter könnten sehr streng sein, so wie in den späten siebziger Jahren. Die tatsächlich beobachteten Anzeichen aus der realen Welt zeigen, dass die Option der Abkühlung in vielen Teilen der Welt bereits begonnen hat.

Matt Vooro, P. Eng

Die Option der globalen Abkühlung ist auch Thema dieser Beiträge:

– http://www.iceagenow.com/

– http://www.appinsys.com/GlobalWarming/GW_TemperatureProjections.htm

– http://isthereglobalcooling.com/

– http://notrickszone.com/category/cooling/

– http://wattsupwiththat.com/

– http://thegwpf.org/the-climate-record/2269-freezing-winters-in-europe-could-be-the-norm.html

von Matt Vooro

Link: http://notrickszone.com/2011/01/22/signs-of-strengthening-global-cooling/

Übersetzt von Chris Frey für EIKE

Anmerkung des Übersetzers: Einige wenige [gekennzeichnete] Passagen dieses Textes habe ich inhaltlich nicht verstanden und quasi im ‚Blindflug‘ übersetzt. Ich bitte um Nachsicht! Vermutlich haben diese Passagen aber keinen Einfluss auf den Gesamtzusammenhang dieses Beitrags.

Unabhängig davon – selten habe ich einen Text gesehen, der so anschaulich die gesamte Faktenlage auf den Punkt bringt wie dieser Beitrag von Matt Voroo! Das leuchtet selbst Laien ein!

An zwei Stellen bezieht sich der Beitrag auf Arbeiten von Prof. Easterbrook, dessen Arbeiten eventuell umstritten sind. Bevor aber sich die Diskussion darauf einschießt, sei hier angemerkt, dass seine Arbeiten hier bestenfalls am Rande eine Rolle spielen und als eine von vielen zitiert werden.

Ederer

Ederer