Ich möchte folgendes Zitat aus dem jüngsten Papier von Dr. Kevin Trenberth als Aufhänger für meinen Beitrag benutzen (auch hier):

„Gesetzt den Fall, die globale Erwärmung ist „eindeutig“, um den Bericht des IPCC von 2007 zu zitieren, sollte die Null-Hypothese jetzt umgekehrt werden, das heißt die Beweislast sollte bei denen liegen, die sagen, dass es keinen Einfluss des Menschen (auf das Klima) gibt.“

Die “Null-Hypothese” ist in der Wissenschaft die Bezeichnung dafür, etwas zu etablieren, was nicht wahr ist. Zum Beispiel, falls Ihre Hypothese lautet, dass der Luftdruck das Pflanzenwachstum beeinflusst, lautet die Null-Hypothese, dass der Luftdruck keine Auswirkung auf das Pflanzenwachstum hat. Wenn man einmal beide Hypothesen hat, kann man erkennen, welche Hypothese sich durch Beweise erhärtet.

In der Klimawissenschaft lautet die AGW-Hypothese, dass die menschlichen Treibhausgasemissionen signifikante Auswirkungen auf das Klima haben. Als solche lautet die Null-Hypothese, dass diese Emissionen nicht signifikant das Klima beeinflussen, dass also die Klimavariationen das Ergebnis natürlicher Prozesse sind. Diese Null-Hypothese möchte Doktor T gerne umkehren.

Wie Steve McIntyre oft bemerkt hatte, muss man bei diesen Leuten wirklich darauf achten, unter welchem der drei Hütchen das Kügelchen liegt. Haben Sie bemerkt, wie das Kügelchen in obigem Zitat von Dr. T von einem Hütchen unter ein anderes gerollt wurde? Schauen wir noch einmal genau!

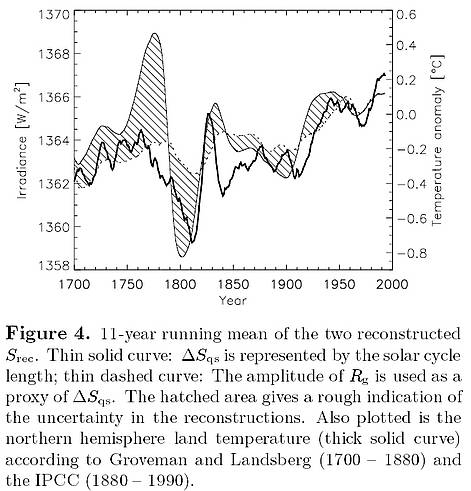

Der erste Teil von Trenberths Feststellung stimmt. Es gibt eine allgemeine Übereinstimmung, dass der Globus sich während der letzten drei Jahrhunderte oder so erwärmt hat. Da also die Erwärmung mehrere Jahrhunderte lang dauerte, lautet die offensichtliche Null-Hypothese hier, dass das halbe Grad Erwärmung im 20. Jahrhundert die Fortsetzung irgendeines langzeitlichen Trends ist.

Aber das macht Dr. Trenberth hier nicht. Achten Sie auf das Kügelchen. Er hat sanft die richtige Aussage des IPCC, „die globale Erwärmung ist eindeutig“, auf clevere Weise auf einen anderen Gedanken aufgepfropft, indem er sagt, dass „daraus also folgt, dass die Menschen das Klima beeinflussen“, und zwar so, dass man nicht einmal die Nahtstelle erkennt.

Das Kügelchen befindet sich bereits unter dem anderen Hütchen. Er hat implizit gemeint, dass das IPCC gesagt hätte, dass die Wissenschaftler „eindeutig“ gezeigt haben, dass die Menschen der Grund für schlechtes Wetter sind, und falls ich das nicht als Glaube akzeptiere, ist es mein Job zu beweisen, dass wir nicht schuld an den Überschwemmungen in Brisbane sind.

Also, damit Sie jetzt nicht glauben, dass das IPCC eigentlich gemeint hat, dass „die Menschen der Grund sind”, als es sagte, die globale Erwärmung sei „eindeutig“, folgt hier die vollständige Aussage aus dem vierten Zustandsbericht des IPCC Summary For Policymakers (2007):

Die Erwärmung des Klimasystems ist eindeutig und inzwischen bewiesen durch Messungen der Zunahme der globalen Luft- und Wassertemperatur, verbreitetem Schmelzen von Schnee und Eis und einem steigenden globalen Meeresspiegel.

Neben der Ungenauigkeit wegen des Fehlens eines Zeitrahmens ist das im Allgemeinen wahr, aber es sagt nichts darüber, dass die Menschen dafür verantwortlich sind. Also missinterpretiert er die Ergebnisse des IPCC total (obwohl er selbst geholfen hat, sie zu schreiben, also kann es kein Missverständnis sein), um seiner Argumentation Vorschub zu leisten. Das IPCC hat nichts von dem gesagt, was er meint.

Man muss den Stil lieben, einfach durch einen kategorischen Imperativ zu proklamieren, dass seine Sicht der Dinge die einzig Richtige der längsten wissenschaftlichen Debatte in modernen Zeiten ist. Und was ist der einzige „Beweis“ für diese Behauptung? Es ist die eindeutige Tatsache, dass Phil Jones und Michael Mann und Caspar Amman und Gene Wahl und all die anderen guten Kerle des IPCC ihm zustimmen. Das heißt, Dr. Ts Rechtfertigung dafür, die Null-Hypothese umzukehren liegt darin, dass der IPCC-Bericht, den Dr. T zu schreiben geholfen hat, mit Dr. T übereinstimmt. Das ist rekursiv genug, um den Wurm Ouroboros neidisch werden zu lassen… [Der Wurm Ouroboros: ein sich selbst in den Schwanz beißender Wurm als philosophisches Sinnbild des ewigen Werdens und Vergehens. Näheres kann man googeln, gehört hier aber absolut nicht zum Thema. A. d. Übers.]

Und das IPCC sagt nicht nur einfach, es ist wahr, sondern “eindeutig”. Ich glaube, nur die einfache Wahrheit wäre für diese Knaben (guys) nicht wissenschaftlich genug. Statt dessen ist es eine „eindeutige“ Wahrheit. Hier folgt, was „eindeutig“ meint (Hervorhebung vom Autor):

eindeutig: Adjektiv: erlaubt keinerlei Zweifel oder Missverständnisse; es gibt nur eine Bedeutung oder Interpretation, und diese führt nur zu einer einzigen Schlussfolgerung („Eindeutiger Berweis“).

Beachten Sie, wie geschickt Dr. T seinen Satz formuliert hat. Nach dem Terminus „globale Erwärmung“ führt er das Wort „eindeutig“ ein, was bedeutet, dass wir nur eine Schlussfolgerung ziehen können. Dann, in der zweiten Hälfte des Satzes, ordnet er die „eindeutige“ Gewissheit der Schlussfolgerung seiner eigenen merkwürdigen Schlussfolgerung zu, dass nämlich die normalen Regeln der Wissenschaft umgekehrt werden sollten zugunsten von… nun, wir wollen keine Haarspalterei betreiben. Er behauptet, dass die normalen wissenschaftlichen Regeln umgekehrt werden sollten zugunsten von Dr. Kevin Trenberth, dem IPCC und jene, die ihn und das IPCC unterstützen. Vielleicht aber auch nur ein Zufall.

Die Aussage von Dr. Trenberth, die gewöhnliche Null-Hypothese (die da bekanntlich lautet, das alles, was wir in der Natur beobachten, natürlich ist) umzukehren ist ebenso Unsinn wie die Anführung des IPCC-Berichtes, dass die Erde sich erwärmt, als Beweis. Allerdings ist es kein bedeutungsloser Unsinn. Es ist schädlicher, heimtückischer und gefährlicher Unsinn. Er möchte, dass wir basierend auf seiner Denkweise Milliarden von Dollar ausgeben, und er hat clever zwei Aussagen verknüpft, um seinem Ziel näher zu kommen.

Ich sehe ein, dass Dr. T eine wissenschaftliche Hypothese hat. Diese Hypothese, allgemein die „AGW-Hypothese“ genannt, lautet, wenn [der Anteil von] Treibhausgasen zunimmt, folgt die Temperatur, und nichts anderes ist von Belang. Die Hypothese sagt, dass die Treibhausgase der Hauptthermostat des Globus‘ sind; alles andere mittelt sich mit der Zeit heraus; nichts kann das langzeitliche Klima mehr beeinflussen als die Treibhausgase, nichts anderes ist erkennbar, und darum, Leute, folgt mir! Die Regel der Treibhausgase, OK?

Welches eine interessante Hypothese ist, aber es mangelt schmerzhaft an Beweisen, sowohl theoretisch als auch nach tatsächlichen Beobachtungen. Teilweise liegt dies natürlich daran, dass die AGW-Hypothese fast keine Angriffsfläche für Feststellungen oder Vorhersagen bietet, die sie falsifizieren können. Diese Schwierigkeit der Falsifikation der Hypothese, so nützlich dies für die Befürworter vielleicht auch ist, schließt unvermeidlich auch die Schwierigkeit ein, die Hypothese zu beweisen oder zu stützen.

Außerdem gibt es inzwischen eine ganze Reihe von stichhaltigen und mit Sicherheit plausiblen wissenschaftlichen Einwänden gegen zahlreiche Teile der Hypothese. Sie reichen von der Natur und den Anzeichen der Antriebskräfte, die man berücksichtigt oder nicht berücksichtigt hatte, bis zur Existenz natürlicher thermostatischer Mechanismen.

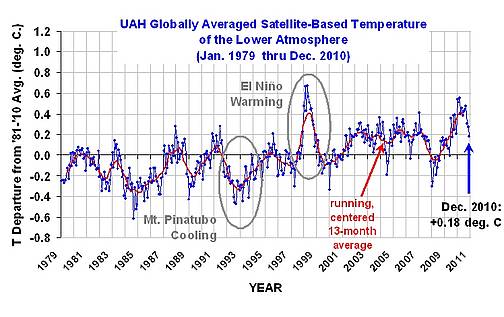

Schließlich müssen wir auch noch das generelle Scheitern hinzufügen, wie wenig gehaltvoll die Vorhersagen der Modelltricksereien zugunsten der AGW-Hypothese sind. Es gab keinerlei Beschleunigung des Meeresspiegelanstiegs. Es gibt keinerlei Klimaflüchtlinge. Die Vorhersage des Klimamodells mit der Berücksichtigung des Ausbruchs des Pinatubo lag meilenweit daneben. Anzahl und Stärke der Hurrikane hat nicht wie vorhergesagt zugenommen. Und, Dr. T, erinnern Sie sich an die Korallenatolle und Bangladesh, die durch das bevorstehende Thermageddon hinweggeschwemmt werden sollen und wovor Sie und das IPCC uns gewarnt haben? Bangladesh und die Atolle vergrößern sich beide, anstatt sich zu verkleinern. Man versprach uns eine Erwärmung um zwei, vielleicht drei Zehntelgrad pro Jahrzehnt in diesem Jahrhundert, wenn wir unsere teuflische, kohlenstoffverliebte Lebensweise nicht ändern. Bisher haben wir nicht eine einzige Sache geändert, und wir haben … nun … null Zehntel eines Grades im ersten Jahrzehnt dieses Jahrhunderts gesehen.

Daraus folgt, dass die Zählkarte mit den Beweisen für die AGW-Hypothese wirklich schlecht aussieht. Ich sage nicht, dass das Spiel aus ist, dass AGW Unsinn ist; das überlasse ich Dr. T. Ich sage lediglich Folgendes: nach einem Vierteljahrhundert unbegrenzter Subventionen, Teraflops von Computerleistung, hunderttausenden Stunden, die graduierte Studenten und Wissenschaftler aufgewendet haben, mit voller Unterstützung durch die Medien und Universitätsfachbereichen, die Hypothese zu unterstützen, haben die Befürworter der AGW immer noch nicht mit vielen Beweisen aufgrund von Beobachtungen aufwarten können, jedenfalls im Verhältnis zu der investierten Zeit und dem Geld. Dies sollte Ihnen einen Hinweis geben, warum sich Dr. T mit den Spielregeln befasst. Wie ein altes Gesetz der Anwälte sagt, wenn man die Fakten nicht bestreiten kann, bestreite man das Gesetz (die Spielregeln), und wenn auch das nicht geht, schlage man auf den Tisch und proklamiere seine Unschuld…

Indem Dr. T in seinem Papier zwei Aussagen zu einer zusammenheftet, beteuert er seine Unschuld und schlägt vor, dass wir die Regeln des gesamten Spiels umschreiben … ich lache mich über meiner Tastatur kaputt über die Unverfrorenheit dieses Mannes. Wenn er und seine Ideen nicht so gefährlich wären, wäre es wirklich lustig.

Sehen Sie, Dr. T, es tut mir so leid, dass ich Ihnen diese schlechte Nachricht überbringen muss, aber das Spiel ist schon viel zu weit fortgeschritten, als dass Sie die Regeln noch ändern können. Hier sind die Regeln von 2011, die ulkigerweise denen von 1811 ähneln:

Erstens müssen Sie beweisen, dass ein Aspekt des gegenwärtigen Klimas historisch anomal oder ungewöhnlich ist. Soweit ich weiß hat das bisher niemand gekonnt, einschließlich Sie selbst. Daher ist das Spiel in ernster Gefahr, noch bevor es richtig begonnen hat. Wenn Sie mir nicht zeigen können, wo sich das Klima aus seiner natürlichen Bahn entfernt hat; wenn Sie mir den Punkt nicht nennen können, wo sich das Klima gegenwärtig anomal oder ungewöhnlich verhält, was nützen da Ihre Erklärungen, warum sich vermutlich das Klima in irgendeine mysteriöse Ecke manövriert hat, die Sie nicht identifizieren können?

(Dies ist natürlich genau das, was Dr. T durch eine Änderung der Regeln gewinnen würde, und es kann mit seinem Wunsch nach dieser Änderung zusammenhängen. Mit so wenigen Beispielen, die seine Position stützen, nachdem ein Vierteljahrhundert nach solchen Beispielen gesucht worden war, ist es sicherlich eine Versuchung, die Regeln zu ändern… aber ich schweife ab).

Aber vielleicht, Dr. T, haben Sie ja schon eine solche Anomalie des Klimas gefunden, die nicht mit einer natürlichen Variation erklärt werden kann und dies lediglich noch nicht öffentlich gemacht.

Falls Sie doch Beweise für ungewöhnliches Verhalten des Klimas haben, müssen Sie zweitens beweisen, dass diese Anomalie mit menschlichen Aktionen erklärt werden kann. Und, Dr. T, Sie können nicht einfach so etwas sagen wie

„Willis, das IPCC sagt, Sie müssen beweisen, dass das, was viele Generationen als ‚natürlich‘ bezeichnet haben, auch wirklich natürlich ist“.

Es gibt auch einen verborgenen technischen wissenschaftlichen Begriff dafür. Man nennt das „schummeln“, Dr. T, und in besseren wissenschaftlichen Kreisen runzelt man die Stirn darüber…

(Nebenbei – das Herausziehen von Variablen aus einem frisierten Computermodell und die dann folgende stolze Verkündigung, dass das Modell ohne die fehlenden Variablen nicht funktioniert, heißt nicht, dass man den menschlichen Einfluss auf das Klima bewiesen hat. Es bedeutet einfach nur, dass man das Modell einfach nur so getrimmt hat, dass es historische Aufzeichnungen mit allen Variablen reproduziert, mit dem unvermeidlichen Ergebnis, dass dies nicht funktioniert, wenn man nur einen Teil der Variablen hernimmt. Also keine Bestätigung für diese Behauptung.)

Drittens müssen Sie Ihre Arbeit verteidigen, und zwar nicht nur durch die weichen Fragen der von Ihnen speziell ausgewählten Begutachter, die „wissen, was sie sagen müssen“, um Ihre Arbeit in wissenschaftlichen Zeitschriften zu veröffentlichen. 2011 sind wir komischerweise zu den Regeln des 19. Jahrhunderts zurück gegangen, dem öffentlichen Marktplatz für Ideen – mit dem einzigen Unterschied, dass der heutige Marktplatz der Ideen elektronischer Natur ist und Menschen nicht mehr von Podien herab oder in den Hallen der Royal Society in London sprechen. Wenn Sie Ihre Arbeit nicht öffentlich verteidigen, wird es einfach – man wird Ihnen nicht glauben. Und nicht nur von mir. Andere Wissenschaftler beobachten, überlegen und bewerten.

Dies bedeutet nicht, dass Sie nun jedem Idioten antworten müssen. Aber es bedeutet sehr wohl, falls Sie es ablehnen, ernste wissenschaftliche Fragen zu beantworten, dass die Leute diese Ablehnung bemerken. Sie müssen bemerkt haben, wie eine solche Ablehnung, wissenschaftliche Fragen zu beantworten, die wissenschaftliche Glaubwürdigkeit der Website RealClimate vollständig zerstört hat. Nun, sie sind Ihre Freunde, also haben Sie es vielleicht nicht bemerkt. Falls das so ist, sollten Sie es aber bemerken, hier ist ein Beispiel (PDF, 147K). Das Weglaufen vor ernsthaften wissenschaftlichen Fragen, wie es auf RealClimate praktiziert wird, lässt Sie blass aussehen, egal ob sie blass sind oder nicht.

Und immer müssen Sie Ihre Arbeit zeigen. Sie müssen Ihre Daten archivieren. Sie müssen Ihre Computeralgorithmen offenlegen. Sie müssen alles, was Ihre Behauptungen und Annahmen stützt, dem brutalen Scheinwerferlicht einer öffentlichen Untersuchung unterziehen.

Dr. T, ich fürchte, Sie müssen sich an die Gezeitenwende gewöhnen, dies ist nicht die Klimawissenschaft Ihres Vaters. Unter dem Strich steht, dass wir nicht länger gewillt sind, Ihnen zu vertrauen. Sie können in den Akashic Records [*] publizieren, und ich würde Ihnen kein Wort glauben, bis ich selbst alle Texte und Graphiken schlüssig nachvollziehen kann. Es tut mir leid, das sagen zu müssen, aber mit den Tätigkeiten von Ihnen und Ihren Kollegen haben Sie das Vertrauen der Öffentlichkeit verwirkt. Sie haben Ihre Glaubwürdigkeit verspielt, Dr. T, und Sie haben sie bisher nicht wieder erlangt.

Weitere Aktivitäten, wie Ihr jüngster Versuch, die Regeln der Wissenschaft umzuschreiben, helfen überhaupt nicht. Das gilt auch für Ihren Versuch, uns zu überzeugen, wie gut Sie aussehen, nur weil Sie mit einem Mäntelchen feinster englischer Weißwaschungen durch die „Untersuchungen“ von Climategate eingekleidet sind. Haben Sie nie die Lektion aus der Watergate-Affäre gelernt, dass das Vertuschen viel mehr Schaden anrichtet als das Vergehen selbst?

Dr. T, Sie hatten eine gute Zeit, Sie wurden gefeiert und geehrt, aber der Tag der Abrechnung ist gekommen und vorbei. Wie es in einem gewissen Buch heißt, Sie und die anderen, nicht angeklagten Verschwörer wurden gewogen und für zu leicht befunden. An dieser Stelle haben Sie zwei Möglichkeiten – entweder Sie akzeptieren das alles und machen dort weiter, oder Sie machen sich nur darüber lustig. Ich würde Ihnen wärmstens Ersteres empfehlen, aber alles, was ich sehe, ist, dass Sie Letzterem folgen.

Sie wollen das Vertrauen der Öffentlichkeit zurückgewinnen, für sich selbst und für die Klimawissenschaft? Das wird nicht einfach sein, aber es kann gelingen. Hier folgt meine Kurzliste mit den dafür notwendigen Schritten für Sie und den anderen Klimawissenschaftler des Mainstream.

· Hören Sie damit auf, der Öffentlichkeit den Unsinn von der völligen Übereinstimmung in der Wissenschaft zu verkaufen! Die Klimawissenschaft ist eine neue Wissenschaft; es gibt nicht einmal Übereinstimmung darüber, ob die Wolken erwärmend oder abkühlend wirken; wir wissen nicht, ob es Wechselwirkungen wie bei einem Thermostat gibt, die bestimmte Temperaturen vorzugsweise vor anderen erhalten. Oder, Dr. T, wie Sie an Tom Wigley schrieben:

„Wie kommt es, dass Sie nicht übereinstimmen mit einer Feststellung, die besagt, dass wir nicht einmal entfernt wissen, wo die Energie verschwindet oder ob die Wolken sich verändern und den Planeten heller machen. Wir sind nicht einmal nahe daran, den Energiehaushalt auszubalancieren. Die Tatsache, dass wir nicht erklären können, was im Klimasystem passiert, macht jeden Gedanken an Geo-engeneering ziemlich hoffnungslos, da wir niemals in der Lage sein werden, zu sagen, ob das Erfolg hat oder nicht! Es ist eine Schande!“

Quelle: email 1255550975

Merkwürdig! Ihrem Freund schreiben Sie nachdrücklich, dass wir nicht einmal entfernt wissen, wohin die Energie verschwindet oder wie man den Energiehaushalt ausbalanciert. Und doch sagen Sie in der Öffentlichkeit, dass wir genug wissen, den höchst außerordentlichen Schritt zu tun, die Null-Hypothese umzukehren… noch einmal, wie passt das zusammen?

An diesem Punkt gibt es nicht viel in der Klimawissenschaft, das „eindeutig“ ist, außer, dass sich das Klima immer ändert.

· Versuchen Sie nicht, die Spielregeln mitten im Spiel zu verändern! Es lässt Sie verzweifelt aussehen, ob Sie das nun sind oder nicht.

· Hören Sie auf, Leute „Leugner” zu nennen! Meine Güte, nach den vielen Fragen wäre das nichts als reine Höflichkeit und Freundlichkeit; wo sind Ihre Manieren? Es lässt Sie mürrisch und unzivilisiert aussehen, ob Sie das nun sind oder nicht.

· Hören Sie auf, der öffentlichen Diskussion Ihrer Arbeit aus dem Weg zu gehen! Sie fordern uns auf, Milliarden von Dollar auf der Basis Ihrer Schlussfolgerungen auszugeben. Wenn Sie sich nicht die Mühe machen, diese Schlussfolgerungen zu verteidigen, belästigen Sie uns nicht damit. Die öffentliche Ablehnung Ihrer Milliarden-Dollar-Behauptungen lässt es so aussehen, als ob Sie sie nicht verteidigen können, egal ob das nun so ist oder nicht.

· Hören Sie auf, das Kügelchen unter den Hütchen zu verschieben! Sie glauben offensichtlich, dass wir blind sind, und Sie glauben ganz klar, dass wir uns nicht an Ihre Äußerung erinnern, dass wir vom Klimasystem nur sehr wenig verstehen. Machen Sie sich frei von dem Gedanken, dass Sie es mit Narren oder Idioten zu tun haben, und machen Sie es sofort! Wie ich auf meine Kosten herausgefunden habe, meine wissenschaftlichen Behauptungen in das grausam grelle Licht des Internets zu stellen ist wie Schach spielen mit [dem Schachcomputer] Deep Blue… individuelle Prozessoren haben unterschiedliche Möglichkeiten, aber mit Sicherheit wird man jeden Fehler in meinen Gedanken bloß stellen. Zu viele Leute schauen von zu vielen Seiten auf meine Gedanken, als da etwas durch die Lappen gehen könnte. Alles andere als absolute Ehrlichkeit gegenüber dem gesamten Gedächtnis und dem gesamten Wissen des Internets lässt sie aussehen wie einen Dummkopf oder einen Hochstapler, ob Sie das nun sind oder nicht.

· Schreiben Sie wissenschaftliche Studien, die nicht um Wörter wie „möglicherweise“ oder „denkbar“ oder „könnte“ kreisen. Ja, möglicherweise können alle Wassermoleküle in meinem Glas Wasser zur gleichen Zeit nach oben steigen, und es ist denkbar, dass ich einen Megagewinn in der Lotterie bekomme, und ich könnte immer noch Third Base für die New York Yankees [eine Baseballmannschaft; ‚Third Base’ siehe die Spielregeln im Internet, gehört hier aber auch absolut nicht zum Thema. A. d. Übers.], aber all das sind müßige Spekulationen, die keinen Platz in wissenschaftlichen Untersuchungen haben. Nennen Sie uns Tatsachen, nennen Sie uns Ungewissheiten, aber verschonen Sie uns mit Zeug wie „dies erhöht die Möglichkeit, dass dies bis 2050 zur totalen Auflösung aller Bindungen zwischen den Atomen kommen könnte…“ Ja, vielleicht könnte es das. Was soll das, soll ich jetzt ein Lotterielos kaufen?

· Hören Sie auf, die pathetischen Lieferanten falscher Prophezeihungen zu belobigen! Vielleicht habt ihr Klimafritzen es nicht bemerkt, aber Paul Ehrlich war kein visionäres Genie. Er war ein Gescheiterter, dessen einziges außerordentliches Talent darin bestand, apokalyptische Vorhersagen zu machen, die niemals eingetroffen sind. In keinem Berufsfeld hätte er seinen Job länger als eine Minute nach dem Kollaps seiner ersten lächerlichen Vorhersage gehabt, in der er in den achtziger Jahren von weit verbreiteten Hungerrevolten und weltweiten Todesopfern einer globalen Hungersnot sprach… aber in den Akademien ist er trotz der Wiederholung seiner ursprünglichen „wir-werden-alle-verbrennen-und–zugrunde-gehen, das-Ende-der-Welt-ist-nahe“-Vorhersagen, ohne dass diese auch nur annähernd eingetroffen sind, immer noch Professor in Stanford. Nun ist das nach dem Reglement verständlich, denn man kann ihn nicht feuern, nur weil er ein erfolgloser Untergangsprophet ist. Aber er tritt auch als führender Denker der AGW und öffentlicher Repräsentant in Erscheinung, was mir vollkommen schleierhaft ist.

Seine Serie vorhergesagter globaler Katastrophen, die niemals auch nur ansatzweise eintrafen, wird nur von den unnachahmbaren Zusammenbrüchen der Prophezeihungen seiner Frau Anne sowie von seinen Kohorten John Holdren und Stephen Schneider übertroffen. Ich fürchte, ich werde so etwas nie noch einmal erleben. Hören Sie auf, diese als Ihre Sprecher zu benutzen, es steigert nicht das Vertrauen in Ihre Behauptungen.

· Genug der Angst erzeugenden Szenarien, jetzt schon! Sie lassen Sie sowohl als Ewiggestrigen und als hysterisch erscheinen, ob Sie das nun sind oder nicht.

· Prangern Sie wissenschaftliche Vergehen an, wo und wann immer Sie sie sehen! Dies ist kritisch für die Wiederherstellung des Vertrauens. Ich kann Klimawissenschaftler, die alle möglichen Ausflüchte suchen, nicht mehr sehen. Die überwältigende Stille der AGW-Wissenschaftler zu diesen Dingen ist einer der (leider sehr zahlreichen) Gründe, warum die Öffentlichkeit den Klimawissenschaftlern zu Recht nicht vertraut. Sie müssen Ihr eigenes Haus absolut aufräumen, um das öffentliche Vertrauen zu gewinnen, keiner kann Ihnen das abnehmen. Und sprechen Sie laut! Wir können Sie nicht hören!

· Hören Sie auf, immer wieder Ihre Unschuld und die Ihrer Freunde zu beschwören! Es lässt sie alle schuldig aussehen, ob Sie das nun sind oder nicht… und seit die Klimagate-e-mails eindeutig mehr für „schuldig“ sprechen, macht es Sie ebenso unversöhnlich wie schuldig. Ob Sie das nun sind oder nicht.

· HÖREN SIE AUF, DINGE ZU VERSTECKEN!!! Übergeben Sie ihre höchst privaten Daten und Ihren geheimsten Geheimcomputer direkt ihren ärgsten Feinden, und warten Sie ab, ob diese Löcher in Ihre Gedanken bohren können. Wenn sie es nicht können, gehen Sie als freier Mann nach hause. Das ist echte Wissenschaft, und nicht das Verstecken von Daten und das Verbiegen der Regeln des IPCC zu Ihrem Vorteil.

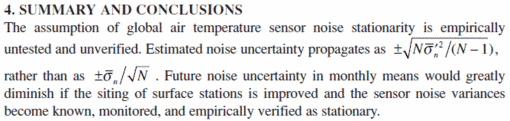

· Bekennen Sie die wirklichen Ungewissheiten! Die Fehlbehandlung der Ungewissheiten in den Berichten des IPCC und das Unterschätzen echter Ungewissheiten in der Klimawissenschaft im Allgemeinen ist ein Skandal!

· Verschrotten Sie das IPCC! Es ist seinen Weg gegangen! Glauben Sie wirklich, dass es nach Veröffentlichung des nächsten Berichtes des IPCC auch nur die geringste Veränderung in der Debatte geben wird, egal was darin steht? Es gab vier IPCC-Berichte hintereinander, jeder einzelne alarmistischer als der vorige. Sie haben die Unterstützung jeder Umweltorganisation gehabt. Sie hatten Milliarden von Dollar zur Verfügung; Al Gore allein gab 300 Millionen Dollar aus für die Werbung und die Befürwortung. Sie hatten 25 Jahre lang Zeit, ihr Anliegen zu vertreten, mit riesigen Ressourcen und Supercomputern und ganzen Regierungen auf Ihrer Seite, und Sie verlieren dennoch die öffentliche Debatte… nach all dem, glauben Sie wirklich, dass ein neuer IPCC-Bericht daran irgendetwas ändern wird?

Falls es ein weiteres, politisch motiviertes Fest der Irrtümer wie der letzte ist, glaube ich das nicht. Und was hat das mit einer ehrlichen Arbeit im Bereich der Wissenschaft zu tun? In keinem Falle wird der nächste Bericht des IPCC auch nur eine einzige Diskussion auslösen, selbst wenn es ehrliche Wissenschaft wäre. Auch hier, Dr. T, gibt es nur Sie selbst und Ihre Freunde, die Sie dafür verantwortlich machen können! Sie haben das IPCC benutzt, um schlechte Wissenschaft wie den Hockeyschläger durchzupeitschen, Ihre Freunde haben das IPCC missbraucht, um Arbeiten zu verändern, die vorher bereits abgesegnet worden waren, und um Arbeiten zurückzuhalten, die sie nicht mochten. Sie haben nicht Ihre Quellen kontrolliert, so dass dumme Irrtümer als alleinige Wahrheit proklamiert wurden, es ist alles eine Sache der Aufzeichnungen.

Nach Climategate, nach den Enthüllungen, dass das IPCC Propaganda-Pamphlete des WWF wie echte wissenschaftliche Studien behandelte, und nach Pachauris aberwitziger Behauptung, dass die Aufdeckung des Irrtums bzgl. der Gletscher des Himalaya „Voodoo-Wissenschaft“ sei – nach all dem, glauben Sie wirklich, dass jemand selbst mit nur einer funktionierenden Gehirnhälfte immer noch glaubt, dass das IPCC irgendeine neutrale Institution der Klimawissenschaft ist, auf deren Stehgreif-Verkündigungen man sich verlassen kann?

Wenn Sie wirklich davon ausgehen, dass die Leute all das noch glauben, sollten Sie mehr hinausgehen. An diesem Punkt vertrauen die Leute dem IPCC nicht mehr als Ihnen und Ihren Freunden. Ein weiterer IPCC-Bericht wird von der einen Seite glatt ignoriert, von der anderen Seite als unfehlbare Wahrheit behandelt werden. Wie soll das irgendjemandem helfen? Vergessen Sie das IPCC, es ist eine bedeutungslose Einrichtung, und kehren Sie zur Wissenschaft zurück!

Das sind meine kostenlosen Ratschläge an Sie, Dr. T, und ich bin sicher, dass es jeden Penny wert ist, den Sie dafür bezahlen würden. Sehen Sie, ich denke nicht, dass sie ein böser Mensch sind. Bedauerlich für Sie, aber glücklich für uns – Sie wurden von den bösen Buben, die ihre Hände in den Honigtöpfen hatten, eingefangen. Und, für uns alle tragischerweise – Sie wurden verführt durch die „Korruption aus noblen Gründen“. Hallo, das ist nichts, wofür Sie sich schämen müssten, es ist mir auch passiert; Sie sind nicht der Erste, der glaubt, dass die Ehrenhaftigkeit der Gründe unsaubere Machenschaften rechtfertigt.

Aber nach all dem beteuern Sie Ihre Unschuld und sagen, dass Sie und Ihre Freunde nichts Falsches getan haben? Es tut mir leid, Dr. T, die Jury befasst sich bereits damit, und sie wurde weder durch die Ehrenhaftigkeit Ihres Falles abgelenkt, noch durch die eindeutige Tatsache, dass Sie und Ihre Freunde durch andere Freunde von Ihnen so weiß wie frischer Schnee gewaschen wurden… Statt dessen bewerteten sie Ihre e-mails, in denen Sie Dinge wie diese sagen:

„In dieser Hinsicht glaube ich nicht, dass man das alles ignorieren kann, wie es Mike (Mann) als Option vorgeschlagen hat, aber eine Antwort sollte versuchen, diese Kerle als faul und inkompetent sowie als unfähig hinzustellen, eine so große Datenbasis zu konstruieren.

Tatsächlich haben sich die Technologie und die Möglichkeiten der Datenbearbeitung weiter entwickelt, und nicht alles wurde gespeichert. Daher lautet mein kleiner Vorschlag, ihre Motive tatsächlich als verleumderisch darzustellen und ein wenig Gegenrhetorik einzubringen. Sie als faul hinzustellen, und dass sie nichts Besseres zu tun haben, scheint mir eine gute Sache zu sein.

Quelle: email 1177158252

Ja, das ist die Fahrkarte, das ist es, wie ein echter Wissenschaftler seine wissenschaftlichen Behauptungen verteidigt…

Link: http://wattsupwiththat.com/2011/01/15/unequivocal-equivocation/

Willis Eschenbach; Übersetzt von Chris Frey für EIKE

Bemerkung des Übersetzers: Alle der zahlreichen Hervorhebungen in diesem Text finden sich auch im Original, mit der einzigen Ausnahme der Bemerkungen des Übersetzers in [eckigen] Klammern.

* Akasha-Chronik bezeichnet in Teilen der Esoterik, vor allem in der „modernen“ (anglo-indischen) Theosophie und in der Anthroposophie, die Vorstellung eines übersinnlichen „Buchs des Lebens“, das in immaterieller Form ein allumfassendes Weltgedächtnis enthält. Es existieren auch ältere Vorstellungen eines solchen „Weltgedächtnisses“ (so im Neuplatonismus, in der christlichen Überlieferung[1] und in der vor-modernen Esoterik), der Begriff „Akasha-Chronik“ (engl. akashic records) ist in dieser Form jedoch modern-theosophischen Ursprungs. Im deutschen Sprachraum wurde er vor allem durchRudolf Steiner geläufig. Esoteriker wie Steiner und neuerdings auch Wahrsager nahmen bzw. nehmen für sich in Anspruch, in der Akasha-Chronik „lesen“ zu können.

Reaktion von Trenberth: er bearbeitet seine Rede und lässt das Wort „Leugner“ aus

Geposted am 16. January 2011 von Anthony Watts

Also, dies passiert, weil ich heute Mittagsruhe gehalten habe. Ich bin regelmäßig durch Dr. Trenberths Manuskript auf der Website der AMS gegangen, und natürlich, während ich mich der Ruhe hingab, hat er (oder irgendjemand) das Mauskript geändert. Natürlich hat Steve McIntyre aufgepasst und stellt die Änderungen heraus. Gut für ihn.

Für jene, die wünschen, das Original zu untersuchen, habe ich es hier gespeichert.

Und hier folgen nun einige der Änderungen, die Steve McIntyre gefunden hat:

==============================================================

Steve schreibt:

Dieser Beitrag wurde Trenberth und/oder der AMS offensichtlich zugespielt, und sie haben daraufhin die Originalversion von Trenberths Präsentation gelöscht und sie durch eine veränderte Version ersetzt, ohne die Änderung bekannt zu geben.

Die veränderte Version nimmt sich der meisten Probleme an, die sich in dem ursprünglichen Beitrag auf CA [Climate Audit] ergeben haben. Hier folgen diese Probleme und Trenberths Änderungen:

Ursprünglich hatte Trenberth festgestellt:

Wissenschaftler machen Fehler und oft Näherungen, die die Gültigkeit ihrer Ergebnisse begrenzen. Sie diskutieren regelmäßig mit Kollegen, die zu anderen Ergebnissen kommen. Diese Diskussionen folgen den normalen Prozeduren wissenschaftlicher Untersuchungen.

Die korrigierte Version:

Hasselmann (2010) stellt des Weiteren fest, dass Wissenschaftler Fehler machen und oftmals Näherungen vornehmen, die die Gültigkeit ihrer Ergebnisse begrenzen. Sie diskutieren regelmäßig mit Kollegen, die zu anderen Ergebnissen kommen. Diese Diskussionen folgen den normalen Prozeduren wissenschaftlicher Untersuchungen.

Trenberth über die Taktiken im Umgang mit den „Leugnern” im Original:

Es ist wichtig, dass Klimawissenschaftler lernen, wie man den Strategien der Leugner begegnet, die einen aus dem Konzept bringen wollen.

Die korrigierte Version:

Es ist wichtig, dass Klimawissenschaftler lernen, wie man den Strategien der Leugner begegnet, die einen aus dem Konzept bringen sollen (Hasselmann 2010). Mit Ihnen über die Wissenschaft zu diskutieren ist eine Herangehensweise, die nicht zu empfehlen ist.

Er bleibt bei den Dingen, die ihn wahrscheinlich in Schwierigkeiten bringen, aber er lässt die Beleidigungen fallen.

Steve schreibt:

Trenberth sandte keinen Kommentar an Climate Audit, in dem er uns dankte dafür, dass wir ihm ermöglicht haben, das Problem vor seiner aktuellen Präsentation zu entschärfen, oder in dem er sich anderweitig auf der Website der AMS bedankte, wo die Änderungen vorgenommen wurden.

=================================================================

Sind Sie ehrlich genug, jemandem zu danken, der Ihnen geholfen hat, Dr. Trenberth?

Lesen Sie alles darüber hier auf Climate Audit.

Stellen Sie sicher, sich bei Steve McIntyre zu bedanken! Ich sage es hier zuerst:

Dr. Trenberth schuldet Herrn McIntyre großen Dank [a dept of gratitude] dafür, dass er eine peinliche und möglicherweise lästige akademische Untersuchung abgewendet hat. Das Allermindeste, was er tun könnte, wäre einen Kommentar auf Climate Audit zu hinterlassen.

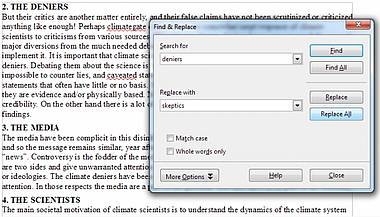

Falls Dr. Trenberth die öffentliche Interpretation seiner Integrität ernst nimmt, sollte er nach meiner Meinung den aggressiven Ausdruck „Leugner“ durch das Wort „Skeptiker“ ersetzen. Es ist in Microsoft Word ganz einfach mit der „Suchen-und-Ersetzen-Funktion“. Es dauert 10 Sekunden:

Dr. Trenberth, sehen Sie unten, wie einfach es in Word geht:

Da Dr. Trenberth im Original seine eigene e-mail-Adresse auf der Website der AMS öffentlich gemacht hat…

ClimategateThoughts4AMS_v2 (PDF)

*Briefe an den Autor: Kevin E. Trenberth, NCAR, PO Box 3000, Boulder, CO 80303.

Email: trenbert@ucar.edu

…und weil er ein mit Steuergeldern bezahlter Beamter der USA ist, fordere ich alle Amerikaner, die sich durch den fortgesetzten Gebrauch dieses Wortes angegriffen fühlen, auf, ihm an die angegebene Adresse zu mailen und ihn höflich zu bitten, diese einfache Änderung vorzunehmen.

IMHO [IMHO, „In My Humble/Honest Opinion“, „Meiner unmaßgeblichen/bescheidenen/ ehrlichen Meinung nach“] gehört es nicht zur Freiheit der Wissenschaft, Schimpfworte zu benutzen. Er weiß, was man in diesem Falle tun muss, wir wollen nur sicherstellen, dass er auf sich selbst hört.

– Anthony Watts

Link hierzu: http://wattsupwiththat.com/2011/01/16/trenberth-reacts-edits-speech-to-fix-copying-leaves-deniers/

Ebenfalls übersetzt von Chris Frey

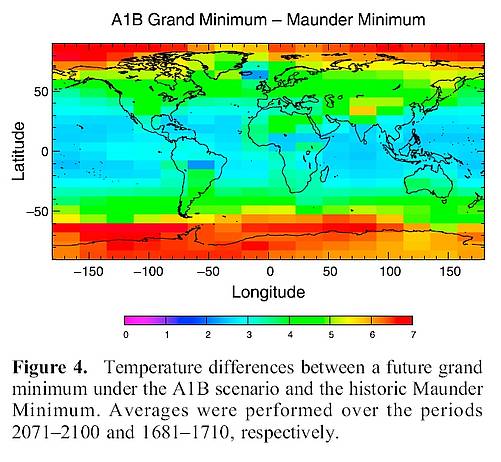

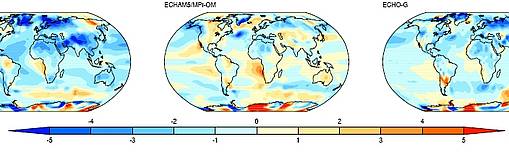

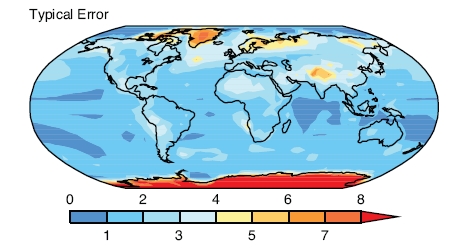

Das ist nicht ganz neu, denn im Report „Wie verlässlich sind Klimamodelle“ konnte man schon sehen, dass in einigen Modellen die Antarktis eisfrei war. Zur Erinnerung:

Das ist nicht ganz neu, denn im Report „Wie verlässlich sind Klimamodelle“ konnte man schon sehen, dass in einigen Modellen die Antarktis eisfrei war. Zur Erinnerung:

…

…