Lord Monckton: In Cancun hat der Westen abgedankt!

Die 33-seitige Note (FCCC/AWGLCA/2010/CRP.2) der “Ad-Hoc Working Group on Long-Term Cooperative Action under the Convention” mit dem Titel Possible elements of the outcome – Note by the Chair (Mögliche Ergebniselemente – Note des/der Vorsitzenden) sagt alles. Oder nichts, wenn man nicht den komplexen, obskuren Jargon versteht. Alle UNFCCC-Dokumente der Cancuner Konferenz und besonders die Note „Possible elements of the outcome“ sind in der sogenannten “transparenten Unverständlichkeit” entworfen. Die Dokumente sollen unverständlich sein, damit uns nachher gesagt werden kann, dass sie die ganze Zeit öffentlich zugänglich gewesen sind – worüber wollen wir uns also beschweren?

Die Note ist nicht sehr lang, ich will die Hauptpunkte zusammenfassen:

Finanzen:

Der Westen wird gemeinsam $100 Milliarden pro Jahr bis 2020 in einen namenlosen neuen UNO-Fonds einzahlen. Um diese Summe an die Zunahme des BSP zu koppeln, darf sich der Westen verpflichten, 1,5 % des BSP jährlich an die UNO zu zahlen. Das ist mehr als doppelt so viel wie die 0,7 % des BSP, welche die UNO dem Westen als Enwicklungshilfe für das vergangene halbe Jahrhundert empfahl. Mehrere hundert Klauseln in der Note des/der Vorsitzenden werden den Staaten des Westens riesige finanzielle Kosten auferlegen.

Das Sekretariat der Welt-Regierung:

Nicht dem Namen nach, aber ansonsten wird das Sekretariat der UNO-Konvention zu einer Weltregierung werden, die Hunderte von globalen, übernationalen, regionalen, nationalen und sub-nationalen Bürokratien direkt steuern wird. Es wird die große Summe des Geldes der Steuerzahler erhalten, die deutlich erkennbar nur vom Westen an die Dritte Welt bezahlt werden soll, damit sie sich an die widrigen Folgen eines eingebildeten (und imaginären) „Klimawandels“ anpassen kann.

Bürokratie:

Hunderte neuer sich überschneidender Bürokratien, die an das Weltregierungs-Sekretariat berichten, werden dessen Macht und Möglichkeiten stark ausweiten. So wie es die Europäische Union mit ihrer Methode macht, bei der Durchsetzung des Willens eines nicht gewählten Kommissars gegen die ächzenden Völker des verdunkelten europäischen Festlandes, werden sich die Beamten als Diener eines Großreiches des Sekretariats fühlen und dessen Ukasse und Diktate durchziehen, ohne Rücksicht auf den politischen Willen der Nationalstaaten.

Viele der neuen Bürokratien sind als “Aufbauhilfe für Entwicklungsländer” getarnt. Das hat nichts mit den sich entwickelnden Volkswirtschaften oder Industrien der ärmeren Staaten zu tun. Es bedeutet in Wahrheit die Einrichtung von Hunderten von Büros in vielen Staaten der Erde, die nur dem Sekretariat verantwortlich sind. Wer das bezahlt?

Sie natürlich, lieber Steuerzahler.

Babylon, Byzanz, das spätere Osmanische Reich, die schreckliche Bürokratie Nazi-Deutschlands, das riesige Reich der 27.000 Papierschieber bei der Europäischen Union: das muss man alles zusammenaddieren und mit 100 multiplizieren, um dann immer noch nicht auf die schiere Größe, die Kosten, die Macht und die Wirkmöglichkeit der neuen Ableger des Sekretariats zu kommen.

Zusätzlich zu den neuen Bürokratien in jedem der 193 Mitgliedstaaten der Konvention wird es

ein Anpassungsrahmengremium geben, ein Anpassungsgremium für die am wenigsten entwickelten Länder, ein Anpassungskomitee, Regionale Netzwerkzentren, ein Internationales Zentrum zur Verbesserung der Anpassungsforschung, nationale Anpassungsinstitutionen, ein Gremium zur Klärung von Annahmen und Bedingungen für Ansprüche aus Verminderungen nationaler Treibhausgasemissionen, ein Verhandlungsgremium für die Zielwerte zusammengefasster Emissionsverminderungen und nationaler Ziele, ein Büro zur Überarbeitung der Richtlinien für nationale Mitteilungen, eine Multilaterales Büro für den Mitteilungsprozess, ein Gremium für Fortschritte bei der Entwicklung von Modalitäten und Richtlinien für das Erfüllungsverfahren, eine Registratur angemessener nationaler Schadensminderungsaktionen in entwickelten Ländern, ein Gremium für die Überwachung des Verständnisses für die Verschiedenartigkeit von eingereichten Schadensminderungszielen und benötigter Hilfe, ein Gremium zur Entwicklung von Modalitäten für die Registrierung von geeigneten nationalen Modalitäten von Schadensminderungsaktionen, ein Büro für Internationale Konsultation und Analyse; ein Büro zur Leitung eines Arbeitsprogramms für die Entwicklung von unterschiedlichen Modalitäten und Empfehlungen; ein Netzwerk von Büros der Entwicklungsländer für nationale strategische Waldaktionspläne; ein Netzwerk nationaler Wald-Referenz-Emissionsmengen und/oder Wald-Referenzemissionsgremien; ein Netzwerk nationaler Waldüberwachungssysteme; ein Büro für das Ackerbau-Arbeitsprogramm zur Verbesserung der Umsetzung von Artikel 4, Para. 1c der Konvention zur Berücksichtigung des Paragrafen 31; einen oder mehrere Mechanismen zur Einrichtung eines auf dem Markt beruhenden Ansatzes zur Verbesserung und Beförderung der Kostenwirksamkeit der Schadensminderungsaktionen; ein Forum zur Auswirkung der Durchführung von Antwortmaßnahmen; ein Arbeitsprogramm zur Untersuchung der Auswirkung des Umsetzungsmechanismus der Antwortmaßnahmen; ein Gremium zur Überprüfung des finanziellen Hilfsbedarfs der Entwicklungsländer bei der Bekämpfung des Klimawandels und der Auswahl von Optionen zur Mobilisierung dieser finanziellen Hilfen; ein Fonds zusätzlich zum Kopenhagen „Green Fond“; ein Interim-Sekretariat für die Entwurfsphase des neuen Fonds; ein neues Gremium zur Unterstützung der Mitgliederkonferenz beim Ausüben ihrer Funktionen in Bezug auf den Finanziellen Mechanismus; ein Gremium zum Starten eines Prozesses zur weiteren Definition der Rollen und Funktionen dieses neuen Gremiums zur Unterstützung der Mitgliederkonferenz beim Ausüben seiner Funktionen in Bezug auf den Finanziellen Mechanismus; ein Leitendes Technologiekomitee; ein Klimatechnologiezentrum und Netzwerk; ein Netzwerk von nationalen, sektoralen und Internationalen Technologiezentren, Netzwerken, Organisationen und Initiativen; Partnerschaftszentren für das Vorwärtsbringen von Nord-Süd, Süd-Süd und trilateralen Partnerschaften mit der Aussicht zur Ermutigung kooperativer Forschung und Entwicklung; einen Expertenworkshop für die Durchführungsmodalitäten des Technologiemechanismus; eine internationale Versicherungseinrichtung; ein Arbeitsprogramm-Gremium für Strategien und positive Anreize in Fragen der Reduzierung von Emissionen infolge der Entwaldung und der Waldschäden in Entwicklungsländern; ein Gremium zur Umsetzung eines Arbeitsprogramms über die Auswirkung der Umsetzung von Antwort-Maßnahmen; und ein Gremium zur Entwicklung von Modalitäten für die Operationalisierung des Arbeitsprogramms über die Auswirkung der Umsetzung von Antwort-Maßnahmen.

Die Machtbefugnis der Weltregierung:

Das Sekretariat soll die Nationalstaaten nicht nur einladen dürfen, sondern sie auch zur Einhaltung ihrer Pflichten aus der Klimawandel-Konvention zwingen können. Die Nationalstaaten müssen angewiesen werden können, große Mengen von Informationen zu erheben, zusammenzustellen und zu übermitteln, in der Art und Weise, wie es das Sekretariat und seine waschsende Zahl von untergeordneten Gremien vorgeben. Sie werden neue Befugnisse erhalten, um Informationen zu verifizieren, zu überprüfen und auf der Grundlage dieser Überprüfung den Nationalstaaten zu sagen, was sie dürfen und was nicht.

Ständiges Wachstum:

Das Verb “verbessern” (enhance) wird mindestens 28 Mal in seinen verschiedenen Formen in der Note des/der Vorsitzenden gebraucht. Ähnliche Verben, z. B. „verstärken“ (strengthen) und “ausweiten” (extend), sowie Adjektive wie “vergrößert” (scaled-up), “neu” (new) und “zusätzlich” (additional) werden ebenso häufig benutzt, besonders in Bezug auf die finanzielle Ausstattung zu Lasten der westlichen Steuerzahler. Wenn alle in der Note vorgeschlagenen “Verbesserungen” durchgeführt würden, erreichten die Kosten leicht ein Jahresbudget von über $100 Milliarden (oder die zu diesem Zwecke genannten 1.5% des BSP), die die Note für den Westen für das nächste Jahrzehnt erwähnt.

Schutzrechte für Erfindungen:

Patentinhaber, besonders auf dem Gebiet der Klimawandels und seiner Abmilderung, sollen verpflichtet werden, die Gewinne aus ihrer Erfindungskraft den Entwicklungsländern zu übergeben, ohne dass sie Lizenzeinnahmen erhalten. Das wird nirgendwo explizit in der Note des/der Vorsitzenden gesagt, doch Technologietransfer wird etwa 20 Mal im Entwurf genannt, was nahelegt, dass diese ausdrückliche Regelung aus dem gescheiterten Kopenhagener Vertrag vom 15. 9. 2009 übernommen werden soll.

Versicherung:

Das Sekretariat schlägt eine so starke Einmischung in die Geschäfte des weltweiten Versicherungsmarktes vor, dass der freie Markt dort aufhört mit den üblichen negativen Konsequenzen für jeden auf diesem Markt Tätigen.

Der freie Markt:

Der gescheiterte Kopenhagener Vertragsentwurf wollte die neue “Steuerung” so einrichten, dass sie die Macht gehabt hätte, die Regeln aller vormals freier Märkte zu bestimmen. Es würde keine freien Märkte mehr geben. In Cancun sagt die Note des/der Vorsitzenden nur, dass verschiedene “Marktmechanismen“ vom Sekretariat und den Mitgliedern der Konvention genutzt werden könnten: die Verweise auf diese “Marktmechanismen“ sind so häufig, dass man den Eindruck einer weiterbestehenden Absicht zur Auslöschung der freien Märkte gewinnt.

Wissen ist Macht:

Die Note des/der Vorsitzenden enthält viele Verweise auf eine Vielzahl von neuen wie bereits existierenden Verpflichtungen der Nationalstaaten, das Sekretariat mit Informationen in einer von diesem diktierten Art und Weise zu versorgen. Da erkennt man die Handschrift der EU.

Sie hat die Mitgliedstaaten in vier Stufen um deren Macht gebracht: anfänglich als reines Sekretariat zur Sicherung der Kohle- und Stahlversorgung für den Wiederaufbau Europas nach dem 2. Weltkrieg; dann als eine Registratur, die von den Mitgliedstaaten immer mehr Informationen einforderte; dann als Überprüfungsgremium, das den Mitgliedstaaten aufgrund der von ihnen übermittelten Informationen mitteilte, ob sie ihre Verpflichtungen aus den immer längeren und komplexeren Texten der Europäischen Verträge erfüllten; schließlich und letztendlich als oberste Gesetzgebungsautorität, der alle gewählten Parlamente einschließlich des Europa-„Parlamentes“ unterworfen sind.

Unter dem Cancun-Vorschlag folgt das Sekretariat dem Pfad, den ihm die Pest der EU-Vertreter zweifellos eifrig anempfohlen hat. Es maßt sich nun vielerlei Rechte an, nicht nur beim Einfordern von Informationen von den Nationalstaaten, es will sie auch aufgrund der von ihnen pflichtgemäß übermittelten Informationen zur Verantwortung ziehen, damit sie ihre internationalen Verpflichtungen unter der Klimawandelkonvention einhalten.

Propaganda:

Die Note des/der Vorsitzenden enthält an vielen Stellen die Vorstellung, dass die Völker der Welt mehr über den Klimawandel erfahren müssten. Auch das ist eine Parallele zur EU, die einen Propaganda-Fonds von etwa $250 Million pro Jahr verwaltet, nur um einem immer skeptischer werdenden Volk nahe zu bringen, wie wunderbar sie doch sei. Auch das IPCC gibt alljährlich Millionen für PR-Agenturen aus mit dem Auftrag, seine grauenerregende Botschaft über neue Wege weiter zu verbreiten, so dass jedermann sie versteht und sich ängstigt. Das Sekretariat erfreut sich schon einer unkritischen, ergebenen, wissenschaftlich unbedarften, in wirtschaftlichen Dingen rechenschwachen, oder einfach nur dummen Medienresonanz. Jetzt soll es auch noch einen Fonds erhalten, um das Spiel weiter zu treiben.

Der vom Prozess angerichtete Schaden:

Weil empfindsamere Nationalstaaten wie die USA, die Tschechische Republik, Japan, Kanada und Italien darauf bestanden haben, steht im Cancun-Ergebnis, dass der Prozess beträchtlichen wirtschaftlichen Schaden anrichtet. Das nennt die Note des/der Vorsitzenden feinsinnig “unerwünschte Nebenwirkungen der Einführung von klimasteuernden Maßnahmen“. Wie soll die Lösung aussehen? Die Behandlung der katastrophalen wirtschaftlichen Konsequenzen der heldenhaft wahnsinnigen Entscheidungen des Sekretariats soll in die Zuständigkeit des – ja, sie lesen richtig – des Sekretariats selbst fallen. Eine schon bewundernswürdige Unverfrorenheit!

Schaden für den Welthandel:

In dem Maße, wie das Vermögen und die Wirkungsreichweite des Sekretariats wachsen werden, reibt es sich selber an den anderen supranationalen Organisationen. Ganz besonders wird die Welthandelsorganisation WTO immer nervöser über die zahlreichen Vorschläge des Sekretariats, welche Beschränkungen des internationalen Handels darstellen. In mehreren Punkten drückt die Note des/der Vorsitzenden den “Entschluss” aus, dass die Politik des Sekretariats keine Handelsbeschränkungen erzeugen soll. Das ist aber nur eine Ansicht und noch dazu eine bezweifelbare.

Die Canute-Vorschrift:

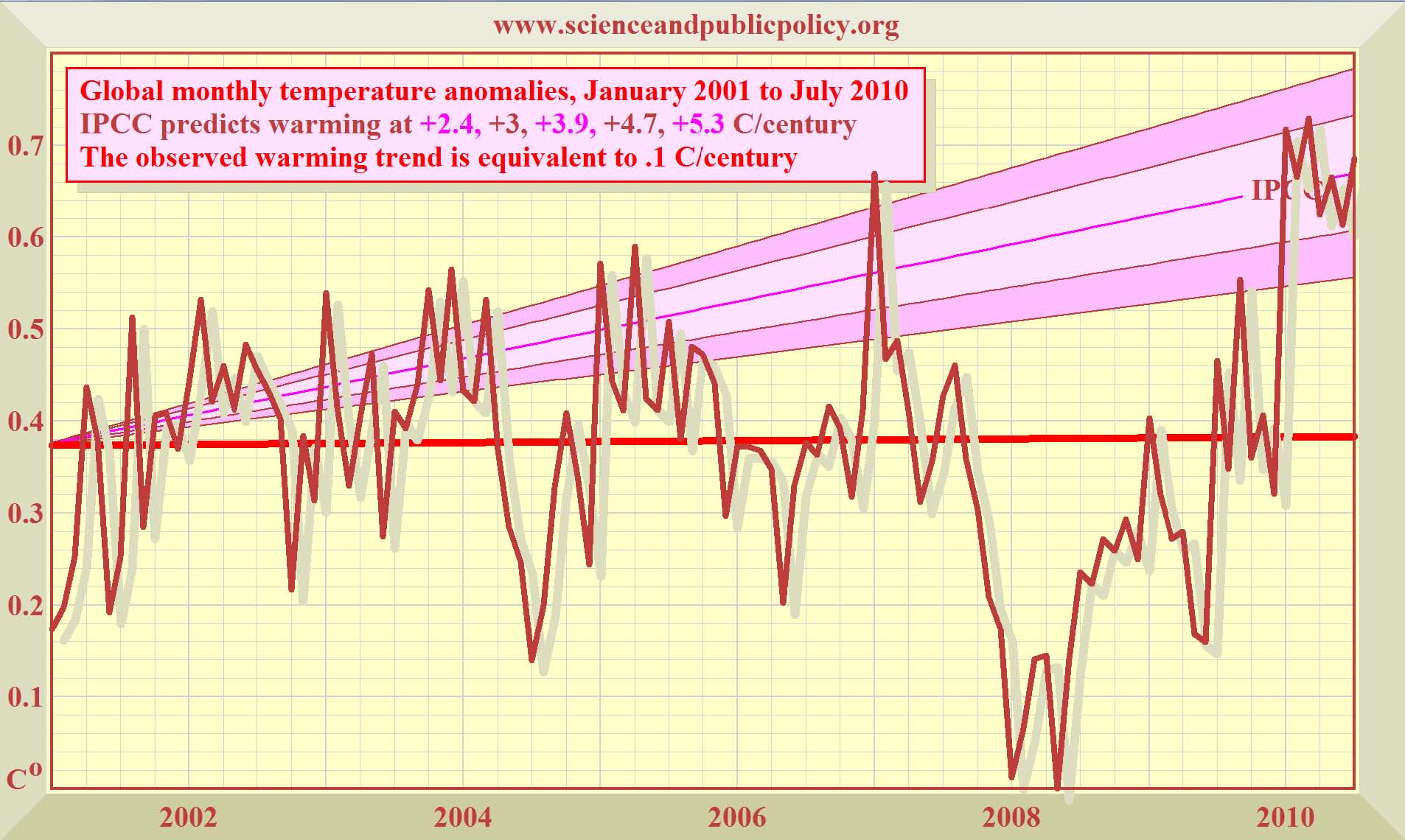

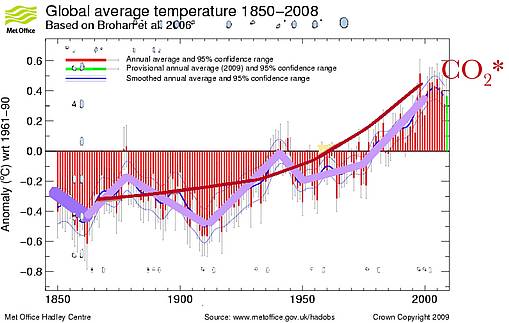

Die Konferenz hält die Entscheidung ihrer Vorgängerkonferenz von Kopenhagen 2009 aufrecht, “die Zunahme der globalen Durchschnittstemperatur unter 2 C Grad im Vergleich zur vorindustriellen Höhe zu halten“. Einfach so! Tatsächlich hat sich die Temperatur in Mittel-England, implizit damit auch weltweit, um 2,2 C Grad binnen 40 Jahren von 1695-1735 erhöht, als die Sonne aus ihrem 11.400-jährigen Aktivitätsminimum herauskam. Im 20. Jh. wurden noch einmal 0,74 C Grad zugelegt. Im 21. Jh. hat es keine Erwärmung mehr gegeben, wir stehen aber schon bei gut 2 C Grad über dem vorindustriellen Niveau.

Die Canute-Vorschrift [den Temperaturanstieg auf 2 C Grad begrenzen] demonstriert die Trennung zwischen dem Prozess und der Wirklichkeit. Sie wurde scherzhaft von einigen Delegierten so getauft, weil einst der gleichnamige dänische König im alten England schmerzhaft die Grenzen seiner und auch seiner Höflinge Macht erleben musste, als er beim Aufstellen seines Thrones am Strand dem Meer befahl, nicht mehr zu steigen. Doch die Flut kam wie gewöhnlich und machte die königlichen Beine nass.

Auslassungen:

Es gibt einige hochbedeutsame Auslassungen, die zusammengenommen die zentrale Absicht bestätigen, dass “der Prozess” nichts mehr mit dem Klima zu tun hat, selbst wenn das jemals so gewesen wäre. Das Ziel ist die Verstärkung der Macht und noch stärker die Bereicherung der internationalen politischen Klasse zum Schaden der Völker des Westens. „Klima” wird als Vorwand benutzt, um die Europäischen Union zu kopieren und dauerhaft das einzurichten, was einige Delegierte einen “transnationalen Perma-Sozialismus” nennen, der nicht mehr der Wählerzustimmung unterworfen ist. Hier folgen die bezeichnenden Auslassungen:

Wissenschaft:

Die Frage, ob diese weite Ausdehnung supranationaler Macht wissenschaftlich zu rechtfertigen ist, wird nicht mehr gestellt. Stattdessen gibt es eine frömmelnde Zustimmung zum abergläubischem Vertrauen in das IPCC an den Stellen, wo die Konferenz “anerkennt, dass tiefe Einschnitte bei den globalen [Treibhausgas-] Emissionen nötig sind, wie die Wissenschaft fordert und wie im Vierten Auswertebericht (AR4 IPCC) dokumentiert ist.”

Wirtschaft:

Es findet keine Beurteilung des Ausmaßes statt, wie kostenwirksam auch nur eine der vorgeschlagenen Aktionen zur Steurung der “globalen Erwärmung” durch die Verminderung von CO2-Emissionen oder zur Anpassung der Welt an den Klimawandel ist. Kein Wort wird auch bezeichnenderweise darüber verloren, wie die Kostenwirksamkeit beim Vergleich zwischen „Verminderung“ (mitigation) oder „Anpassung“ (adaptation) aussähe: schon bei der Strukturierung des IPCC war ja sorgfältig darauf geachtet worden, „Verminderung“ und „Anpassung“ in zwei gänzlich getrennten Bürokratien anzusiedeln, damit voneinander verschiedene Berichte erstellt würden, die aussagekräftige Vergleiche erschwerten. Obgleich jede ökonomische Analyse dieser Hauptfrage nach der Wirtschaftlichkeit – im Gegensatz zu der des inzwischen verrufenen Lord Stern – enthüllt, ist Vermeidung eine nutzlose Dummheit, und gezielte Anpassung an die Folgen eines vielleicht einmal stattfindenden „Klimawandels” ist um Größenordnungen billiger und kostenwirksamer. Trotzdem hält das Ergebnis der Cancun-Konferenz daran fest, dass Vermeidung wirtschaftlich ebenso nützlich ist wie Anpassung.

Kündigung:

Verträge haben Kündigungsklauseln, die bestimmen, was geschieht, wenn ein Vertrag endet. Nichts illustriert die Absicht zur Schaffung einer dauerhaften Weltregierung besser, als das Fehlen jeglicher Kündigungsregelungen im Cancun-Ergebnis. Der Prozess soll ewig sein, wie ein Diamant.

Demokratie:

Mit der Volkssouveränität wird es vorbei sein. Das Prinzip „keine Besteuerung ohne Volksvertretung“, das zur Gründung der Vereinigten Staaten führte, kann man vergessen. Die Vorkehrungen einer demokratischen Wahl durch die Völker der Welt dieses neuen allmächtigen, gesetzgebenden, Steuern erhebenden Weltregierungs-Sekretariats können in einem einzigen Wörtchen genannt werden: Keine.

Wie konnte dieser monströse Machttransfer von den einst stolzen, souveränen, demokratischen Nationen auf das korrupte, nicht gewählte Sekretariat geschehen? Die Geschichte beginnt bei Sir Maurice Strong, einem schwerreichen UNO-Bürokraten aus Kanada, der vor einem Vierteljahrhundert das IPCC nicht als wissenschaftlichen Ausschuss, sondern als intergouvernmentales politisches Gremium schuf, das dahin gebracht werden konnte, das langfristige UNO-Ziel der Auslöschung der nationalen Unabhängigkeiten und der Schaffung einer Weltregierung zu unterstützen. So haben es im vergangenen Mai auf einem UNO-Gipfel hohe UNO-Offizielle unter Ban Ki-Moons Leitung selbst wieder bestätigt.

Ernsthaft hat dieser Prozess 1988 begonnen, als das IPCC aufgestellt wurde. Kurz darauf erschien an einem besonders heißen, von Al Gore deswegen absichtlich ausgesuchten Junitag, James Hansen vor einem Kongress-Ausschuss in Washington und zeigte eine wild übertriebene Grafik mit einer vorhergesagten globalen Erwärmung für die künftigen 20 bis 30 Jahre. Hansen war einer von Al Gores politischen Weggefährten und finanziell von ihm begünstigt. Im Juni 2008 jedoch, dem 20. Jahrestag der Anhörung, war es global kühler als im Juni 1988. Die globale Erwärmung gab es nur halb so stark wie vorhergesagt.

Beim Rio-Erdgipfel 1992 durften Umweltaktivisten und Weltpolitiker ihre Schau abziehen. Aus jenem Gipfel kam die UN Framework Convention on Climate Change, UNFCCC, die von da an jährliche Konferenzen zum “Klimalwandel” abhielt.

Das Kyoto-Protokoll von 1997 verpflichtete seine Unterzeichner, die nationalen CO2-Emissionen auf die 1990er Höhen bis 2012 zurückzufahren. Die meisten werden das nicht schaffen. Der US-Senat unter dem Vorsitz von Al Gore stimmte mit 95:0 dafür, jeglichen Vertrag von der Kyoto-Art abzulehnen, der nur den Westen binden und den Entwicklungsländern wie z. B. China erlauben würde, CO2 ohne Begrenzung zu emittieren.

Bis zur Bali-Konferenz 2007 gab es ganz geringe Fortschritte: auf jener Konferenz aber wurde eine “road-map” gebastelt, die zu einem bindenden Vertrag auf der Kopenhagen-Konferenz 2009 führen sollte.

Hier ist ein Problem zu nennen. Die Verfassung der USA sieht vor, dass selbst die Präsidentenunterschrift unter einem Vertrag nicht gilt, solange über den Vertrag nicht im Senat debattiert, und zumindest eine Mehrheit von 67 von 100 Senatoren ihn ratifiziert hat.

Jedermann weiß inzwischen, dass nach dem Scheitern der Obama-Regierung mit dem Waxman/Markey-Emissionshandelsgesetz, wo 60 Senatoren mit Schmeicheleien und Drohungen zur Zustimmung gebracht werden sollten, kein Klimaschutzgesetz den Senat passieren wird.

Umso schlimmer, dass sich das Sekretariat nun mächtig übernommen hat. Es glaubt an seine eigene Propaganda, abgesehen von dem kleinen Ärgernis, dass nur ganz wenige öl- und kohlenstoffindustrie-finanzierte Skeptiker mit der Behauptung widersprechen, der „Klimawandel“ wäre gering und harmlos. So hatte das Sekretariat auf seiner eigenen Webseite einen 186-seitigen Entwurf für einen Kopenhagener Vertrag ins Netz gestellt mit dem Vorschlag, dass es sich in eine nicht gewählte Regierung verwandeln wollte mit der unbeschränkten Macht, den Signatarstaaten direkte Steuern aufzuerlegen, ohne parlamentarisches Mandat, ohne Möglichkeit, sich dagegen zu verwahren. Weiterhin, sich direkt in die Umweltpolitik der einzelnen Staaten einzumischen, alle freien Märkte weltweit wegzufegen, und sich selbst als alleinige Steuerungsbehörde für alle Märkte einzusetzen (Kopenhagener Vertragsentwurf, Annex 1, Artikel 36-38). Einige Zitate aus dem Entwurf machen klar, was die UNO anstrebt:

“Das Konzept der neuen vertragsgemäßen Einrichtung ruht auf drei Grundpfeilern:

Steuerung;

Fördermechanismus, Finanzmechanismus. … Die Steuerung wird von der Konferenz der Mitgliedstaaten der UNO Framework Convention on Climate Change (FCCC) bestimmt, dazu kommt die Unterstützung eines neuen Hilfsgremiums zur Anpassung, und eines Leitenden Ausschusses, der für die Verwaltung der neuen Gelder und der zugehörigen Vergabeprozesse und Vergabegremien verantwortlich ist. (Kopenhagener Vertragsentwurf v. 15. September 2009, Zi. 38).

Die drei zentralen Machtbefugnisse, die sich die UNO unter dem Deckmäntelchen der „Rettung der Erde“ anzumaßen hoffte, lauteten wie folgt:

“Steuerung” (orig. government):

Dieser Gebrauch des Wortes steht an erster Stelle, um eine Art Weltregierung in jedwedem internationalen Vertrag zu bezeichnen.

“Finanzmechanismus” (orig. financial mechanism):

Der “Finanzmechanismus” ist ein feinsinniger Ausdruck zur Umschreibung einer neue Machtbefugnis der UNO, nämlich den Signatarstaaten unbegrenzte Besteuerungen aufzuerlegen: Besteuerung ohne Volksvertretung, und das in globalem Umfang.

“Vergabemechanismus”(orig. facilitative mechanism):

Dieser Mechanismus hätte zum ersten Mal der UNO die Befugnis übertragen, die Vertragserfüllung direkt und notfalls mit Gewalt bei den Signatarstaaten zu erzwingen.

Der Vertragsentwurf beschreibt das so:

“… ein fazilitativer Mechanismus ist als Mittel der Wahl gedacht, um das Konzept, die Akzeptanz und Durchführung der Strategie zu ermöglichen, welcher die Marktgesetze und Regeln und diesbezüglichen Marktkräfte gehorchen sollen.”

In Kürze, es wäre eine neue Weltordnung geworden, mit einer “Regierung”, die über einen “Finanzmechanismus” in Form von unbegrenzten Rechten zur direkten Besteuerung aller Bürger der Welt verfügt hätte, und mit einem “Durchsetzungsmechanismus”, der die Regeln aller vormals freier Märkte unter die direkte Kontrolle der neuen UNO-“Steuerung” gebracht hätte, unterstützt von einer schon jetzt wuchernden Bürokratie.

An keiner einzigen Stelle auf den 186 Seiten des Vertragsentwurfs fanden sich die Worte “Demokratie”, “Wahlen”, “Abstimmung”.

Wie die EU schon gezeigt hat, beendet der Machttransfer von souveränen Demokratien auf supranationale Einheiten die Demokratie selbst. Auf supranationaler Ebene, in der UNO, der EU und in der vorgeschlagenen Weltregierung werden die Entscheidungen von Personen getroffen, die von uns Wählern nicht dafür bestimmt worden sind.

Die Offenlegung des Vertragsentwurfes in den internationalen Leitmedien führte zur Panik in der UNO. Sie gab den Vertragsentwurf auf, noch bevor die Kopenhagener Konferenz begonnen hatte. Stattdessen bewegt sich die UNO nun gesetzgeberisch in kleinen Schritten, ganz so wie die Europäische Union, mit einer Reihe von aufeinanderfolgenden jährlichen Vereinbarungen. Die letzte davon war das Kopenhagener Einverständnis (Copenhagen Accord). Jede dieser Vereinbarungen transferiert ein bisschen mehr Macht und Wohlstand von den einzelnen Staaten auf eine supranationale Bürokratie. Die vorläufig jüngste wurde in Cancun zum Abschluss gebracht.

Die Europäische Union, die selbst klammheimlich die Demokratie während des vergangenen halben Jh. durch eine Reihe von Verträgen ausgelöscht hat, indem sie in kleinen Schritten immer mehr Macht und Wohlstand von den Händen der gewählten Volksvertreter in die Hände von nicht Gewählten transferiert hat, hat dem Sekretariat geraten, so etwas auch auf globaler Ebene zu machen.

Nachdem sich das Sekretariat in Kopenhagen eine blutige Nase geholt hatte, legte es großen Wert darauf, dies in Cancun nicht noch einmal zu erleben. Deshalb erhielt es die Zustimmung der Deutschen Bundesregierung, 2010 in Bonn eine Reihe von Zusammentreffen abzuhalten, von denen einige für außenstehende Beobachter zugänglich waren, andere fanden in einem komfortablen Landschloss hinter verschlossenen Türen statt. Dort wurde die neue Art der Weltgesetzgebung heimlich zuerst ans Laufen gebracht.

Die chinesische Regierung gierte danach, mitzumischen, und sie stimmte vor einigen Wochen einer weiteren Sitzung in Tientsin zu. Der Zweck dieser fast ständigen internationalen Vergnügungsreisen (die nationale Delegierten amüsieren sich großartig auf unsere Kosten) war, sicherzustellen, dass fast alle Elemente der Cancuner Vereinbarung und vorher abgestimmt und unter Dach und Fach waren. Damit sollte das von vielen Journalisten unermüdlich vorhergesagte Mexikanische Patt verhindert werden.

Genau wegen dieser massiven und teuren Vorbereitung kann die Note des/der Vorsitzenden widerspiegeln, was schlussendlich herauskam und binnen weniger Tage ankündigt werden konnte. Das ist kein Versuchsballon: diese Note drückt aus, was das Sekretariat nun zu erreichen hofft.

Nach dem Kopenhagener Unfall gehen unsere zukünftigen grimmigen Herrscher keine Risiken mehr ein. Sie haben ihre Freunde in den Leitmedien überzeugt, die nun nicht mehr aus ihrem leichtfertigen Glaubensbekenntnis für die Kirche des Klimawandels herauskommen, dass sie die Geschichte vom geringen Erfolg von Cancun und vom nächsten Jahr in Durban herumtönen müssen. Sie müssen wie das Sekretariat darauf achten, ihr Gesicht nicht zu verlieren.

Noch zwei internationale Klimakonferenzen sind beabsichtigt, die letzte 2012 zum 20. Jahrestag des Erdgipfels, wieder in Rio, wo alles anfing. Man will das Sekretariat so mächtig machen, dass niemand – auch nicht der US-Senat – es wagen wird, den Vertrag von Rio nicht zu ratifizieren. Der beerdigt die Demokratie weltweit und bestätigt Lord Mandelsons jüngste Aussage, dass wir heute in einem post-demokratischen Zeitalter leben.

Nur über meine Leiche! Das Volk weiß am besten, was ihm nützt. Die Regierenden wissen auch, was gut für sie ist, sie wissen aber nicht immer, was für das Volk gut ist. Und sie müssen immer an den Wahlurnen in Schach gehalten werden.

Wenn es schon eine Weltregierung geben sollte (und mit dem Zusammenbruch der „Wissenschaft vom Klimawandel“ schwinden auch die Voraussetzungen für eine kleine privilegierte Minderheit, die Weltherrschaft zu erringen), dann wird es wesentlich sein, dass die Weltregierung eine gewählte ist, und dass, wie der Artikel 1, Abschnitt 1, der US-Verfassung fordert, „ALLE GESETZGEBENDE GEWALT“ beim gewählten Kongreß und dem Senat liegt, dass niemand Besteuerungsgesetze für die Welt machen darf oder der Welt Steuern auferlegen darf über das hinaus, was eine universell und geheim gewählte Weltregierung beschlossen hätte. [Vgl. Artikel 20, Deutsches Grundgesetz]

Wie können wir, das Volk, das Sekretariat besiegen und die geliebte Demokratie behalten? Ganz einfach, indem wir unsere gewählten Volksvertreter im Einzelnen über den Umfang, die Tragweite und Absichten der Cancun-Vereinbarung informieren.

Die Vereinbarung kann in den USA kein Vertrag werden, weil der US-Senat sie nun nach den Halbzeitwahlen nicht passieren lassen wird. Aber sie kann den Amerikanern immer noch auferlegt werden durch den schwer linkslastigen Obersten Gerichtshof, der überhaupt keine Anstalten mehr macht, juristisch unparteiisch zu sein, und der sehr wohl entscheiden könnten, dass die Cancun-Vereinbarung entgegen dem Willen des Kongresses Bestandteil des US-Rechts wird, weil sie internationales „Gewohnheitsrecht“ wäre.

Was kann man tun? Senden Sie diese Informationen an Ihre Volksvertreter. Es ist deren Macht, wie auch Ihre, die beschnitten werden soll; Ihre gemeinsame Demokratie, die untergehen wird, es sei denn, dieser blühende Unsinn würde gestoppt.

Viscount Monckton of Brenchley

Die Übersetzung besorgte dankenswerterweise Helmut Jäger EIKE

Den Originalartikel finden Sie hier. The Abdiction Of The West

Obertertia“. Auch wenn man – wie Prof. Bott – von der nicht nachzuweisenden Wasserdampfverstärkung ausgeht, bleiben läppische acht tausendstel Grad oder knapp neun tausendstel Grad Celsius. Wahrlich ein großer Unterschied !

Obertertia“. Auch wenn man – wie Prof. Bott – von der nicht nachzuweisenden Wasserdampfverstärkung ausgeht, bleiben läppische acht tausendstel Grad oder knapp neun tausendstel Grad Celsius. Wahrlich ein großer Unterschied !

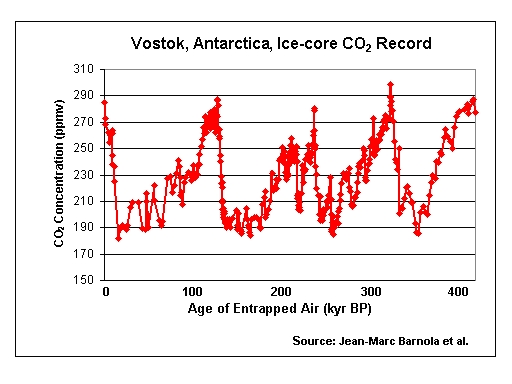

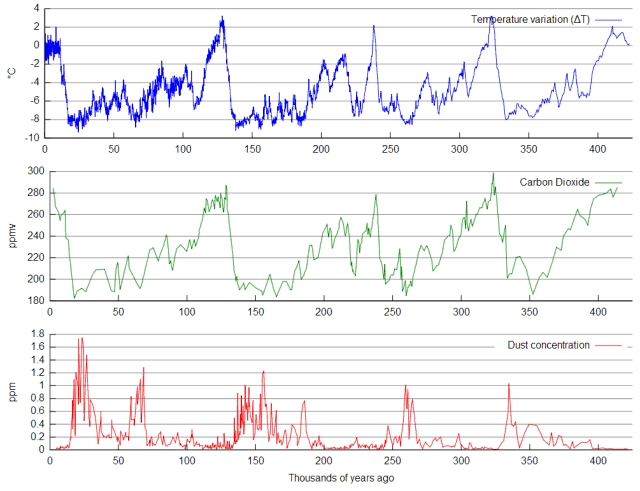

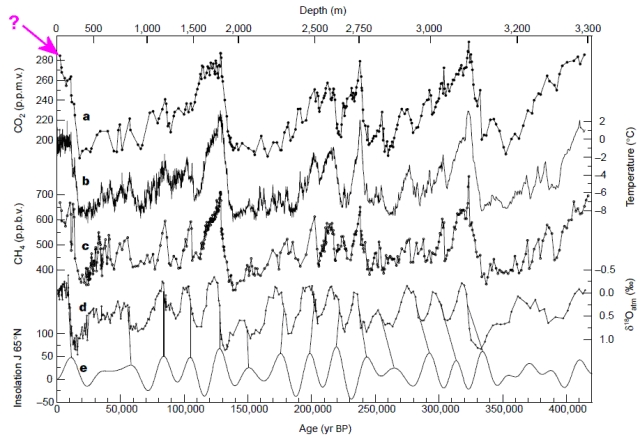

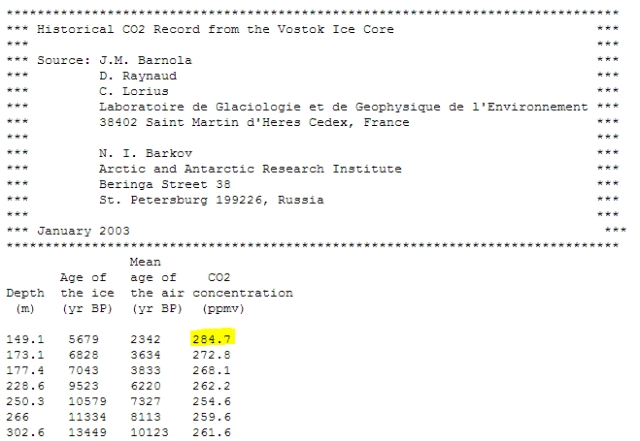

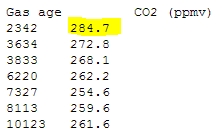

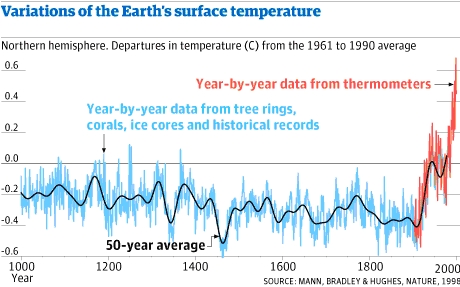

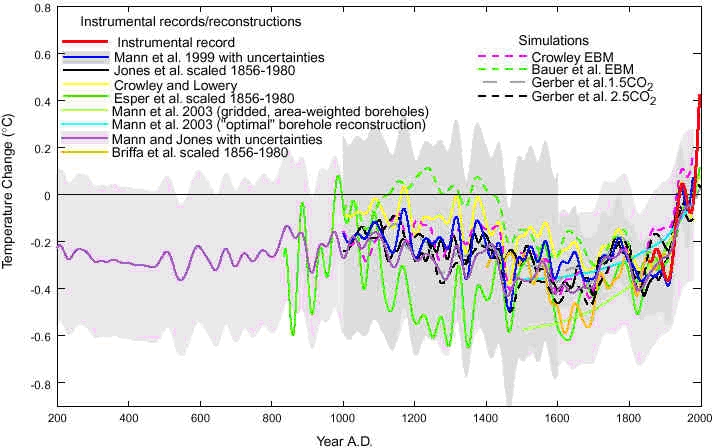

Abbildung 7: Verlauf von Proxydaten der Temperatur und der CO2 Konzentrationen aus Eisbohrkernmessungen für letzten 400.000 Jahre. Darin eingezeichnet die höher aufgelöste Graphik der letzen 8000 bis 22.000 Jahre. Deutlich ist die Nach-Eilung der CO2 Konzentration im Vergleich zu den Temperaturen zu erkennen.

Abbildung 7: Verlauf von Proxydaten der Temperatur und der CO2 Konzentrationen aus Eisbohrkernmessungen für letzten 400.000 Jahre. Darin eingezeichnet die höher aufgelöste Graphik der letzen 8000 bis 22.000 Jahre. Deutlich ist die Nach-Eilung der CO2 Konzentration im Vergleich zu den Temperaturen zu erkennen.

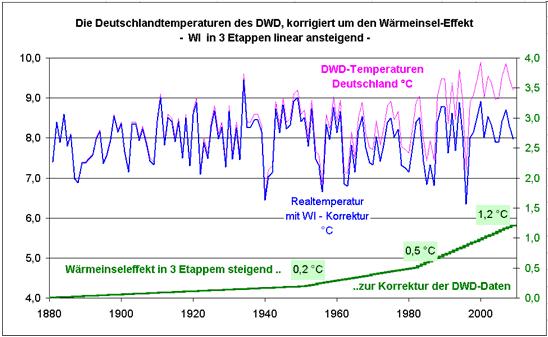

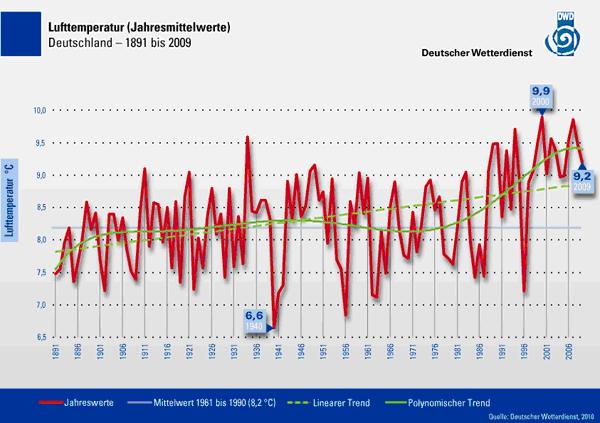

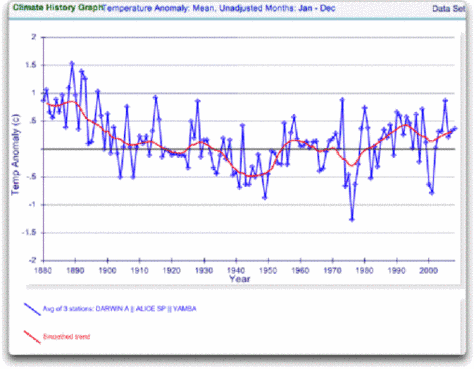

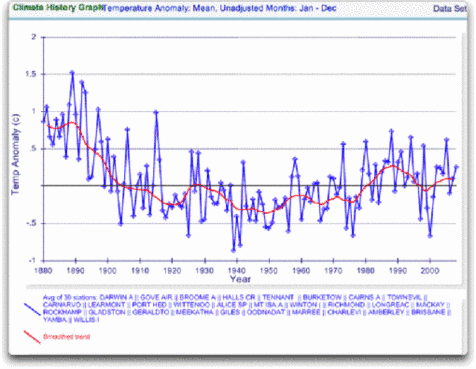

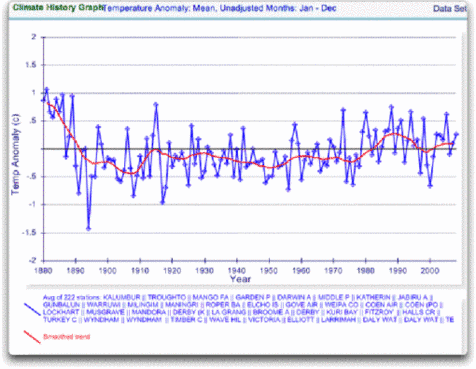

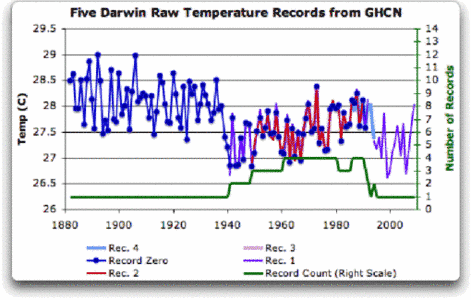

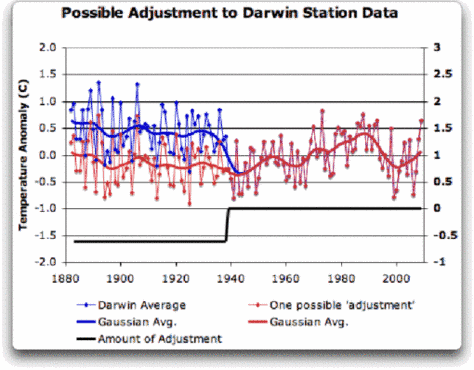

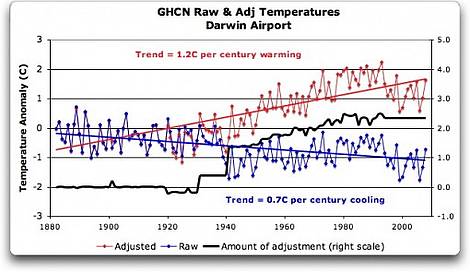

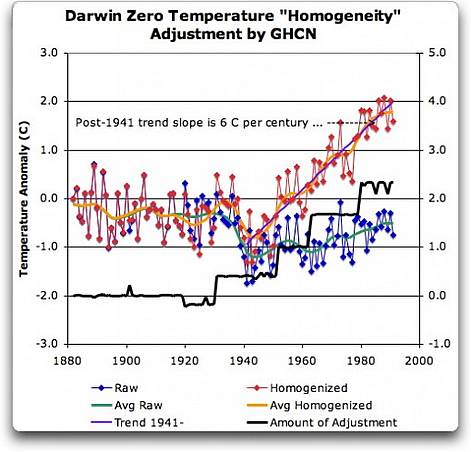

Prof. F.K. Ewert (EIKE), der über 800 weltweite Temperaturganglinien auf ihren absoluten Temperaturtrend hin untersucht hat, und dabei nur klärte: a) ist ein Trend vorhanden? Wenn ja? b) War er positiv oder negativ? Sein Ergebnis: Von 1990-2010 zeigten 50% aller Stationen weltweit keine Erwärmung oder Abkühlung, 28.8 % eine Erwärmung (ohne Stadterwärmungseffekt) und 16,4% eine Abkühlung. Die Arbeit betrachtete auch den gesamten Trend. Sein Ergebnis: Von 1880-2010 zeigten 74% aller Stationen weltweit keine Erwärmung oder Abkühlung, 5,1 % eine Erwärmung (ohne Stadterwärmungseffekt) und 3,8% eine Abkühlung

Prof. F.K. Ewert (EIKE), der über 800 weltweite Temperaturganglinien auf ihren absoluten Temperaturtrend hin untersucht hat, und dabei nur klärte: a) ist ein Trend vorhanden? Wenn ja? b) War er positiv oder negativ? Sein Ergebnis: Von 1990-2010 zeigten 50% aller Stationen weltweit keine Erwärmung oder Abkühlung, 28.8 % eine Erwärmung (ohne Stadterwärmungseffekt) und 16,4% eine Abkühlung. Die Arbeit betrachtete auch den gesamten Trend. Sein Ergebnis: Von 1880-2010 zeigten 74% aller Stationen weltweit keine Erwärmung oder Abkühlung, 5,1 % eine Erwärmung (ohne Stadterwärmungseffekt) und 3,8% eine Abkühlung

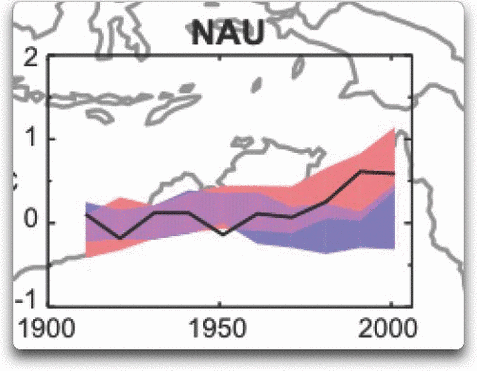

Abb. 4. GHCN Rohdaten. Alle Stationen bis 2000 im IPCC Gebiet.

Abb. 4. GHCN Rohdaten. Alle Stationen bis 2000 im IPCC Gebiet.

richter.c@zdf.de

richter.c@zdf.de Anlage.

Anlage. Ameling,

Ameling,  Haas Manuskript,

Haas Manuskript,  Peters,

Peters,