1. Der Wärmeinseleffekt (WI) als Antrieb der Temperaturen – eine Wertung der DWD-Temperaturmessstationen

2 . Was sind Temperaturmessungen auf Großflughäfen wert oder, wie das ZDF mit (bewusst?) falschen Temperaturaussagen die Öffentlichkeit täuscht und die Abkühlung in Deutschland verschleiert

Teil 1

Der Wärmeinseleffekt (WI) als Antrieb der Temperaturen – eine Wertung der DWD-Temperaturmessstationen

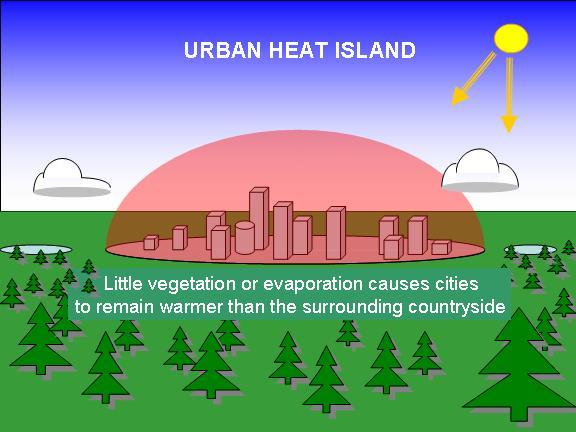

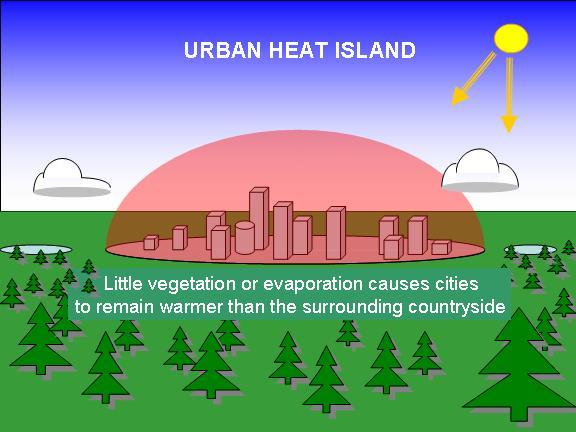

Die Abbildung zeigt anschaulich den Wärmeinseleffekt (WI) über städtischen Gebieten gegenüber Land. Wie noch gezeigt wird, ist der WI in der Fläche (Land) ebenfalls nicht zu vernachlässigen, da vielerorts landschaftliche Veränderungen wie Trockenlegung stattfanden oder landschaftliche Nutzflächen geschaffen wurden.

Im komplexen Wetter- und damit Klimageschehen, gibt es eine Vielzahl von Parametern, die es zu berücksichtigen gilt, sollen die Entscheidungsträger in Politik, Wirtschaft und Gesellschaft ein klares Bild erhalten, welches geeignet ist, die richtigen Entscheidungen dahingehend zu treffen, dass die Weichen für unser Land und unsere Gesellschaft weiter in Richtung Wohlstand und Zukunftssicherung gestellt werden. Eine Ausrichtung anhand eines einzigen Parameters, wie z.B. CO2 ist nicht nur grob fahrlässig, sondern zerstört auch die Perspektiven der nachfolgenden Gesellschaft, und damit das Wohl und die Zukunft unserer Kinder. Dass CO2 im Klimageschehen keine praktische Rolle spielt, hat EIKE schon in zahlreichen wissenschaftlich hinterlegten Artikeln dargelegt. Dass aber auch die vermeintlichen Beweise für eine postulierte anthropogene Erderwärmung, die Datenreihen, nicht das Halten, was der Betrachter erwartet – eine realistische Wiedergabe des Temperaturgeschehens der Gegenwart – wird über Climategate hinaus (EIKE berichtete darüber), der folgende Bericht darlegen.

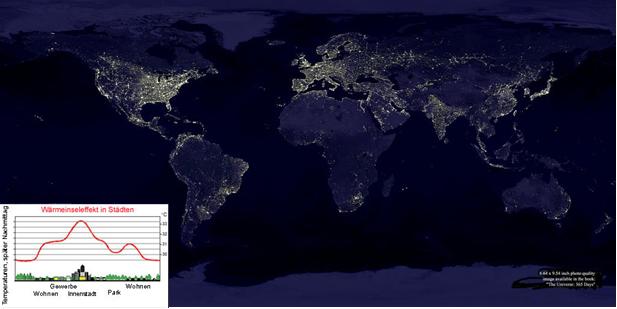

Ein wichtiger Parameter, der in Temperaturzeitreihen zu berücksichtigen ist und in den Datenreihen diverser Institude, wie Hadley, GISS, aber auch dem DWD nicht berücksichtigt wird, ist der Wärmeinseleffekt (WI). Der WI beschreibt, wie sich die Veränderungen in Landschaft, Verstädterung und Bevölkerungszunahme auf die Temperaturen auswirken und damit vergleichende Temperaturaussagen beeinflussen und der WI, aufgrund seiner höheren Spreizung in der Gegenwart als in der Vergangenheit aus aktuellen Temperaturdaten herausgefiltert werden muss, da ansonsten falsche, zu hohe Temperaturwerte für die Gegenwart wider gegeben werden. Zum WI oder Urban Heat Island Effect (UHI), wie er in englischsprachigen Ländern genannt wird, gib es zahlreiche wissenschaftliche Untersuchungen (http://scholar.google.de/scholar?q=Urban+heat+influences&hl=de&as_sdt=0&as_vis=1&oi=scholart) oder hier (http://www.appinsys.com/GlobalWarming/GW_Part3_UrbanHeat.htm). Diese beschränken sich meist auf den amerikanischen Raum, wo das Thema, nicht nur in der Wissenschaft, breit diskutiert wird. Die Abbildung 1 gibt einen Überblick über die Wärmeinseln weltweit.

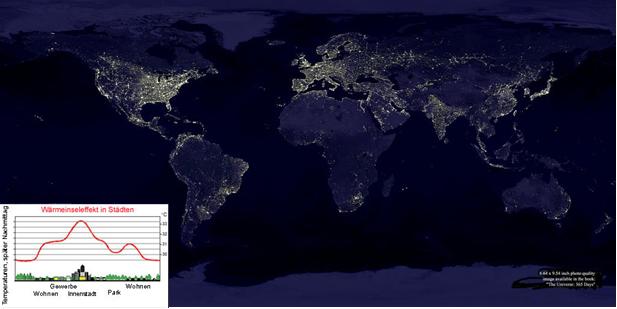

Abbildung 1 (Quelle: NASA) zeigt die Wärmeinseln weltweit, sowie deren Temperaturabhängigkeit (kleines Photo). “Es ist zu berücksichtigen, dass durch das Wachstum der Städte, der großflächigen Rodung von Wäldern und der Ausdehnung landwirtschaftlicher Produktionsflächen weiträumig Wärmeinseln geschaffen wurden, in deren Nähe die Messstationen heute deutlich höhere Lufttemperaturen registrieren.“ (Quelle: Uni Erlangen).

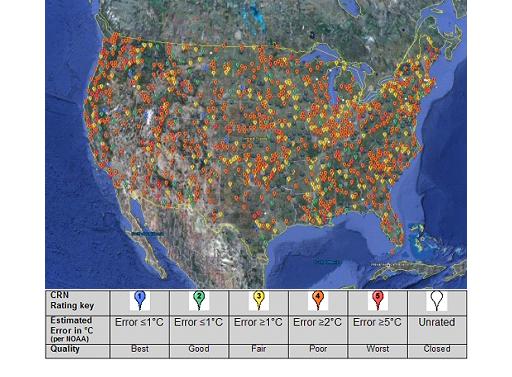

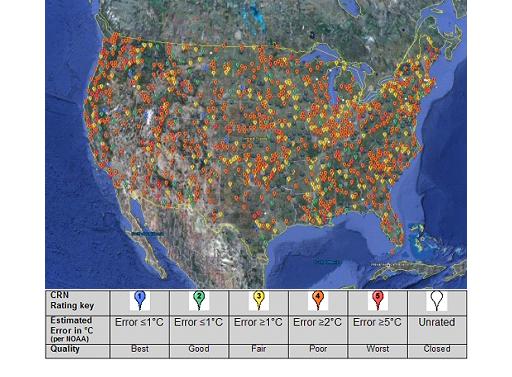

In den USA werden die Temperaturmessstationen des amtlichen Wetterdienstes einer unabhängigen Prüfung unterzogen, um deren Eignung, auch vor dem Hintergrund eines WI, zu ermitteln. 2009 fand eine abermalige Überprüfung der Temperaturmessstationen statt. Sage und schreibe ca. 61% der Messstationen zeigten ein Fehlerpotential von >2°C! Für eine Temperaturaussage, die von einer Erhöhung von Zehntel Grad Celsius pro Dekade ausgeht (IPCC-Prognosen), erübrigt sich die Aussage, dass solche Messstationen ungeeignet sind. Von insgesamt 1221 Messstationen, die das USHCN betreibt wurden 1003 überprüft. Es fand also keine Stichprobe, sondern mit 82% eine fast komplette Erfassung statt. Die Abbildung 2 gibt eine Übersicht der auditierten Messstationen und wie deren Bewertung ausfiel.

Abbildung 2 zeigt die Klassifizierung der über die USA verteilten Temperaturmessstationen. Die rote Farbe überwiegt eindeutig, Quelle: (http://www.surfacestations.org/).

Realitätsnahe Temperaturwerte geben Stationen wider, die abseits von Gebäuden, el. Anlagen oder sonstigen aktiven und passiven „Reflektoren“ platziert sind. Bei diesen Stationen fällt auf, dass keine nennenswerte Erwärmung über die letzten Jahrzehnte ausgewiesen wird, sondern lediglich ein schwacher Temperaturanstieg, wie er durch die gesteigerte Sonnenaktivität zum ausgehenden 20. Jahrhundert erklärt wird (Abbildung 3).

Abbildung 3 links zeigt die Messstation Orlando/Kalifornien. Deutlich ist zu sehen, dass die Temperaturen zu Beginn des 20. Jahrhunderts z.T. deutlich höher lagen als heute. Die Abbildung rechts (beide Abbildungen, Quelle: http://www.surfacestations.org/) zeigt eine ungenügende Station, die sich in unmittelbarer Nähe von aktiven Heizstrahlern befindet und einen starken Temperaturanstieg über die letzten Jahrzehnte ausweist.

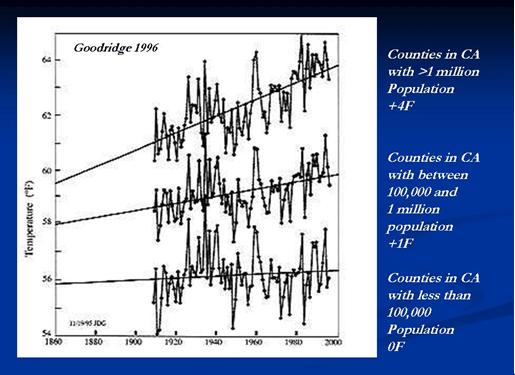

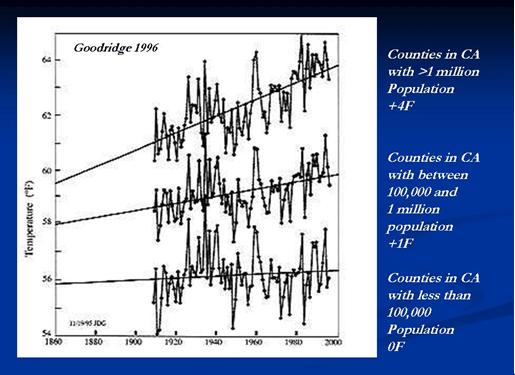

Die vermeintlich starke Erwärmung, besteht demnach aus Asphalt, Autos, Auspufföffnungen, Abfallanlagen, etc. Anhand der Abbildung 4 sind die Auswirkungen der Populationsdichte und der damit verbundenen Ausbreitung urbaner Besiedelung auf die Temperatur zu sehen, bzw. wie die Populationsdichte, also Städte ihr eigenes, deutlich wärmeres Temperaturprofil besitzen, welches mit der Ausbreitung und Technologisierung der Städte mit wächst, was nichts anderes bedeutet, als dass die höheren gemessenen Temperaturen zumindest teilweise auf dem WI beruhen, sowohl in den USA, als auch in Deutschland, wie noch gezeigt werden wird.

Abbildung 4 zeigt den WI nach Goodridge 1996 für Kalifornien. Deutlich ist erkennbar, dass mit zunehmender Einwohnerzahl die Temperaturanomalie immer schneller steigt. Dies ist nicht allein durch das Fehlen von Grünflächen/Bäume, die moderierend auf den Temperaturverlauf wirken zurückzuführen, indem sie Feuchtigkeit abgeben und damit Verdunstungskühlung erzeugen, sondern auf den zunehmenden Einsatz von Elektro- und Verbrennungsmaschinen oder Kühlanlagen, die entsprechend ihre Verlustwärme, bzw. Abwärme an die Umgebung abgeben, was die Temperaturen immer mehr ansteigen lässt.

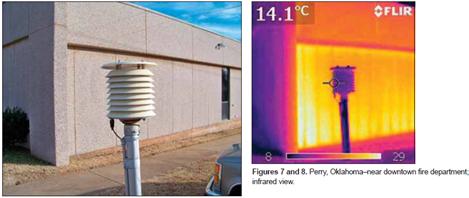

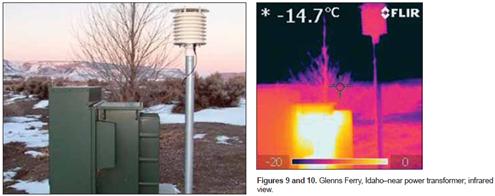

Vereinfacht gesagt, tritt folgendes ein, während z.B. vor 100 Jahren eine Messstation noch auf weiter, freier Flur angesiedelt war, wurde diese durch die Ausbreitung der Siedlungen eingeholt und liegt nun mitten in dieser Siedlung und deren Abwärme, was auf die Temperaturen nicht ohne Einwirkung bleiben kann. Ferner weiß jeder, dass es sowohl am Tag, als auch nachts, im Sommer wie im Winter, in Städten wärmer ist, als in der Umgebung. Bereits eine lokale Verschiebung der Messstationen zu städtischen Gebieten, würde also eine statistische Auswirkung in der Art bewirken, dass ein falsches Bild der tatsächlichen Temperaturwerte vorliegt, ein zu hohes. Die folgenden Abbildungen zeigen, wie durch das Aufstellen technischer Anlagen oder Gebäuden, der Temperaturgang der Messstation verfälscht wird und daher unbrauchbar für eine Langfristmittelwertaussage ist.

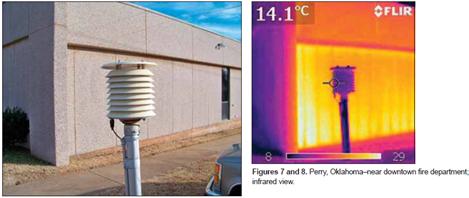

Abbildung 5 zeigt eine Temperaturmessstation in Perry, Oklahoma in unmittelbarer Nachbarschaft zur Feuerwehr. Dazu die Infrarotaufnahme, die zeigt, wie die Hauswand auf die Station rückkoppelt.

Abbildung 6 zeigt eine Temperaturmessstation in Glenns Ferry, Idaho in unmittelbarer Nähe einer Trafostation. Auch hier entlarvt die IR-Aufnahme, wie stark sich der Trafo erhitzt und auf die Station einwirkt.

Abbildung 7 zeigt eine Temperaturmessstation in Lampasas, Texas. Diese wurde in 2000 näher zu einer Radiostation positioniert, wodurch es einen deutlichen Temperatursprung gab (Datenreihe rechts, rote Linie).

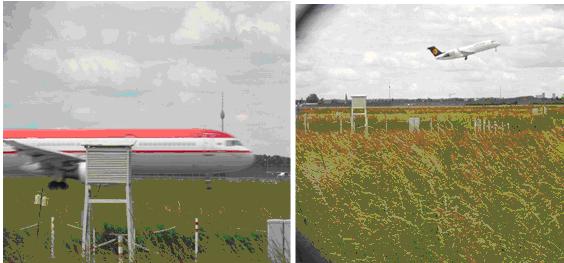

Problematisch ist weiter die Tatsache, dass zunehmend Messstationen auf Flughäfen in die Datenfindung einer Mittelwerttemperatur einbezogen werden. Ihr Anteil stieg von wenigen % in den 1930-Jahren auf über 40%. EIKE berichtete darüber (http://www.eike-klima-energie.eu/uploads/media/100420_GISS_METAR_DE.pdf). Ein eklatantes Beispiel, über den Wert dieser Messstationen zeigt Ihnen die Abbildung 8. Sie ist jedoch nicht die Ausnahme, wie wir am Beispiel der Wetterstation auf dem Frankfurter Flughafen zeigen werden.

Abbildung 8 zeigt die Temperaturmessstation auf dem Flughafen von Rom und dessen Lage zum Rollfeld.

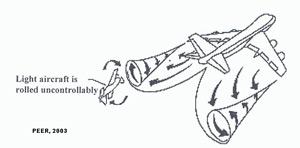

Es erübrigt sich jeder Kommentar zur Güte dieser Messstation. Auch wenn andere Messstationen auf Flughäfen nicht so eklatant falsch aufgestellt wurden, es bleibt die Tatsache, dass Verkehrsflugzeuge über ihre sehr heißen Abgase aus ihren Triebwerken, ihre nähere Umgebung erwärmen. Je höher das Flugaufkommen und dieses steigt bekanntlich von Jahr zu Jahr (von kleinen Rückgängen in Wirtschaftskrisen abgesehen), desto mehr Flugbewegungen, desto mehr Abwärme und desto stärkerer Einfluss des WI auf die örtlichen Temperaturen und dies alles vor dem Hintergrund, dass sich der Anteil der Flughafen-Messstationen im Datenerfassungsnetzwerk ständig erhöht und derzeit bei 41% liegt.

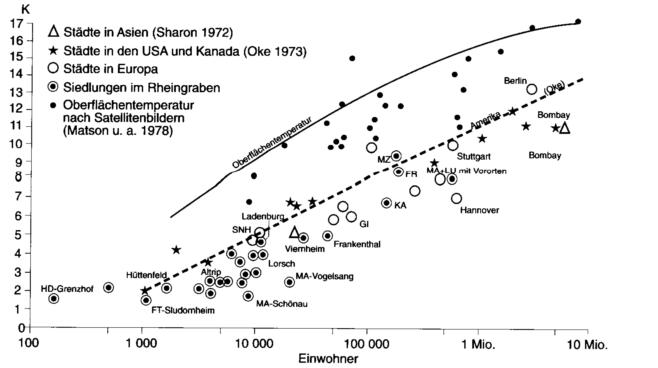

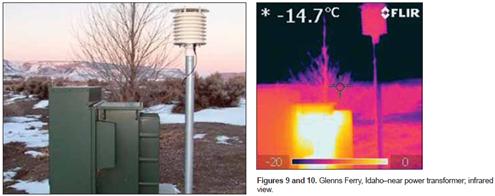

Dass der WI nicht auf die USA beschränkt ist, braucht nicht gesondert dargelegt zu werden, da physikalische Auswirkungen überall auf der Welt gleich sind. So zeigt denn die Abbildung 9, die wissenschaftlichen Untersuchungen zum Wärmeinseleffekt für Asien, Nordamerika, Europa und Deutschland (Rheingraben). Deutlich ist erkennbar, dass die Stadttemperatur deutlich von der Umgebungstemperatur Land abweicht, also verfälschte Werte liefert. Die Abbildung zeigt die Temperaturunterschiede von Städten gegenüber dem Umfeld.

Abbildung 9 zeigt den WI für Städte in Asien, USA, Europa und für Siedlungen im Rheingraben, Quelle: Christian-Dietrich Schönwiese, Klimatologie, Stuttgart, 2003.

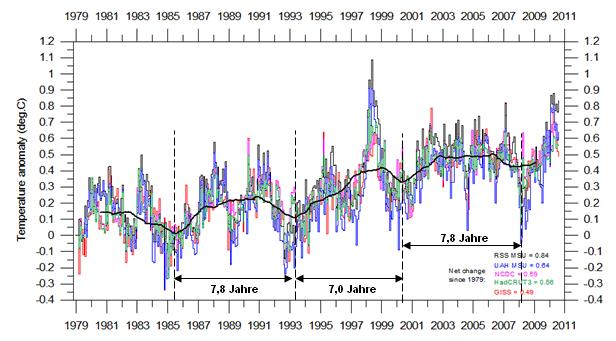

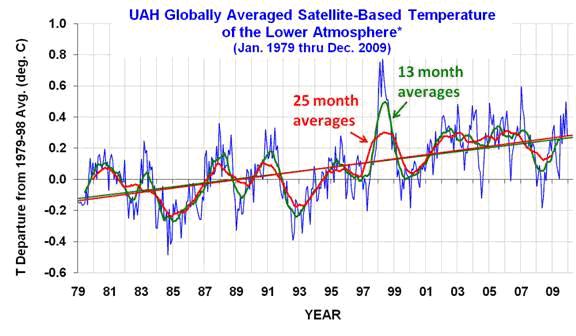

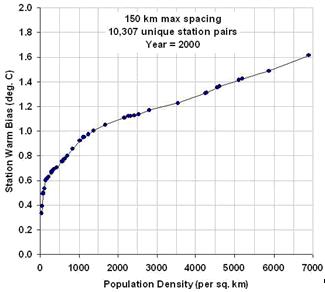

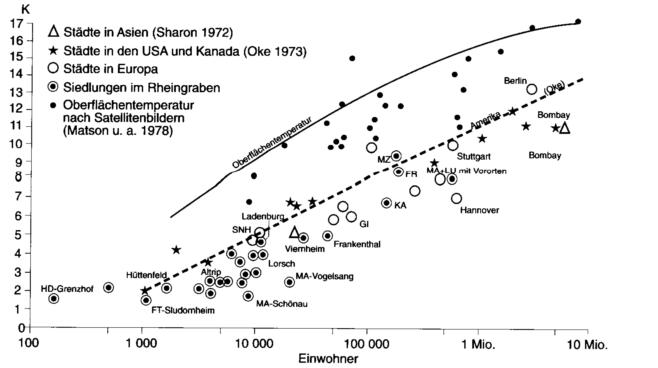

In seiner Veröffentlichung vom 03. März 2010 berichtet der bekannte Physiker und Klimawissenschaftler Roy Spencer, dass die Auswirkungen des Wärmeinseleffekts von der Besiedlungsdichte abhängen (Abbildung 10). Bei Änderungen von geringen Bevölkerungsdichten ist der WI proportional am stärksten, d.h. hier tritt die größte Erwärmung in Relation zur prozentualen Veränderung der Bevölkerungsdichte auf. Da im 20. Jahrhundert weit mehr kleinere Ansiedlungen in ihrer Bevölkerungsdichte zunahmen, als große Städte, die darüber hinaus noch einen geringeren prozentualen Erwärmungstrend beim Zuwachs der Besiedlung ausweisen, liegt hier ein weiterer Aspekt, warum die gemessenen Temperaturen ab der zweiten Hälfte des 20. Jahrhunderts zunahmen.

Abbildung 10 zeigt den WI-Temperaturantrieb in Abhängigkeit der Bevölkerungszunahme. Die Beziehung ist nicht linear, unterhalb von 1.500 Einwohner/km2 ist der WI-Anstieg ganz besonders ausgeprägt.

Wie sieht es nun mit dem WI in unserem Land aus? Nach unserem Kenntnisstand misst der DWD an 531 Stationen Lufttemperatur und- feuchte. Von den 531 Stationen sind die meisten sog. nebenamtliche Stationen, die nicht von DWD-Personal betreut werden. Der DWD gibt auf seiner Internetseite an, dass das Hauptamtliche Netz aus 182 Wetterwarten und Wetterstationen, 48 davon 24-stündig mit Personal besetzte Wetterwarten, darunter 16 Flugwetterwarten an internationalen Verkehrsflughäfen, 28 davon zeitweise mit Personal besetzte Wetterwarten, 106 davon vollautomatische hauptamtliche Wetterstationen incl. zwei unbemannte Feuerschiffe, zwei Leuchttürme und drei Bojen/Baken besteht (Stand: 10.06.2010). Abbildung 11 zeigt die Übersicht.

Abbildung 11 (Quelle: DWD) zeigt Lage und Art des Hauptamtlichen DWD-Messnetzes.

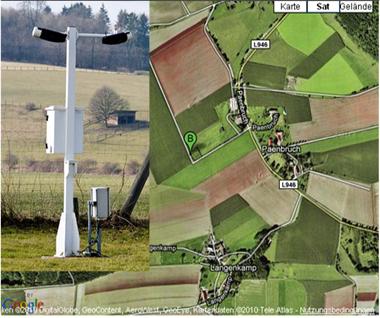

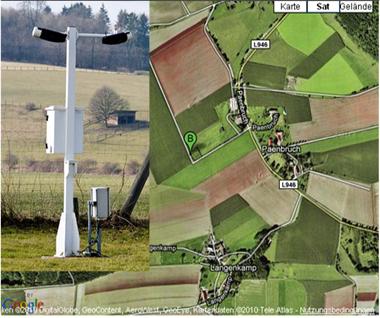

Sind alle Messstationen des DWD so aufgestellt, wie die Messstation in Abbildung 12, so wäre der WI sicherlich nur ein untergeordneter Parameter in Deutschland zur vergleichenden Temperaturaussage, sofern sich am Landschaftsbild nichts änderte. D.h. keine Waldrodung, bzw. Trockenlegung von Wiesen für Ackerland stattfand, da bekannt ist, dass Wald und Feuchtgebiete viel Wasser an ihre Umgebung abgeben und durch die dabei entstehende Verdunstungskühlung (Prinzip einer Klimaanlage) mildernd auf das Temperaturprofil wird. So stieg z.B. durch die weiträumige Trockenlegung des Rheingrabens um Karlsruhe das Temperaturprofil vergleichsweise stark an, was auf diesen Effekt, zumindest teilweise, zurückzuführen ist.

Abbildung 12 zeigt Lage und autom. Messstation des DWD in Lügde-Paenbruch.

Es braucht jedoch nicht lange gesucht zu werden, um eine gänzlich ungeeignete Messstation zur Mittelwertangabe der Temperaturen zu finden. Dies ist die im April 2009 (kein Aprilsscherz) in Betrieb genommene Wetterstation in Offenbach, Abbildung 13.

Abbildung 13 zeigt die DWD Wetterstation in Offenbach am Tag ihrer Einweihung. Gut zu sehen, dass sie in Mitten einer Häuserfront liegt, die aus einer dunklen Betäfelung besteht (also sehr wärmeabstrahlend ist – „Schwarzkörper“) und darüber hinaus noch gegenüber einer wärmeverspiegelten Glasfläche liegt. Dazu noch unter einer Betonüberdachung, die die Hitze staut. Diese Messstation taugt weder für eine Temperaturaussage, noch für eine sachgerechte Mittelwertbildung. Weiter ist es schon eigenartig, dass eine solche Messstation, die nur ein stark überhöhtes Temperaturprofil ausweisen kann, gerade im Kopenhagen-Jahr 2009 in Betrieb genommen wurde. Wir erinnern uns noch an die vollmundige Aussage von Prof. Rahmstorf und Kollegen, dass 2009 das zweitwärmste Jahr seit mehr als 130 Jahren gewesen sein soll. Sollten in die Berechnung Ergebnisse wie von dieser Station eingeflossen sein?

Die nächsten Abschnitte werden aufzeigen, dass der WI, den der DWD in seinen Mittelwerten der Temperatur weitgehend nicht berücksichtigt, also unbeachtet lässt, auch in Deutschland keine vernachlässigbare Größe darstellt. In persönlichen Mails (an Herrn Kowatsch), räumt der DWD für Städte wie Frankfurt zwar einen WI-Antrieb von 1°C ein, geht aber davon aus, dass dieser in der Fläche umgerechnet nicht mehr als 0,1°C liegt, was, wie gezeigt wird, eine Falschaussage ist.

Herr Müller-Westermeier vom DWD, Zitat: “Natürlich gibt es einen Wärmeinseleffekt in großen Städten. Er kann dort im Mittel auch etwa 1 Grad ausmachen. In Anbetracht des auch in Deutschland geringen Anteils dicht bebauter Gebiete an der Gesamtfläche ist das aber weniger als 0,1 Grad. Dieser Effekt ist auch nicht neu und hat sich in den letzten Jahrzehnten kaum verändert, so dass der Wärmeinseleffekt für irgendwelche Temperaturveränderungen in den letzten Jahren völlig ohne Belang ist.“ Zitat Ende.

Auf den Nenner gebracht, ist der WI die Aufheizung der Umgebung durch den Menschen. Feiner ausgedrückt durch sozio-ökonomische Einflüsse. Wie die Abbildung 9 zeigt, tritt er global auf und verursacht regional erhebliche Verzerrungen im Temperaturprofil und wirkt somit statistisch global als eine deutliche Erwärmung. Er ist keine allgemeine Temperaturerwärmung durch klimatische Veränderungen, sondern eine Zusatzerwärmung der Orte, die durch den Menschen besiedelt wurden. Die Auswirkungen der Zivilisation, wie Landschaftsveränderung und Technologisierung spielen dabei dominante Rollen. Er ist dem natürlichen Klimatrend überlagert und schwächt Kälteperioden ab, bzw. verstärkt Wärmeperioden. In beiden Fällen verfälscht er statistische Vergleiche, insbesondere, wenn vermehrt Stationen in städtischen Gebieten verwendet werden, erheblich. Siehe http://www.eike-klima-energie.eu/news-anzeige/cimategate-update-12-cru-jones-gibt-zu-nur-10-bis-20-der-weltflaeche-zeigten-erwaermung/?tx_ttnews[cat]=1&tx_ttnews[pS]=1262300400&tx_ttnews[pL]=2678399&tx_ttnews[arc]=1&tx_ttnews[pointer]=1 oder hier http://www.eike-klima-energie.eu/news-anzeige/in-erwartung-eines-us-amerikanischen-temperatur-gate/?tx_ttnews[cat]=1&tx_ttnews[pS]=1264978800&tx_ttnews[pL]=2419199&tx_ttnews[arc]=1

In den Städten ist der WI-Wert am größten (der DWD räumt, wie bereits erwähnt, in Städten 1°C ein, Mail an Herrn Kowatsch), auf dem Lande ist der WI kleiner, aber vorhanden. Die Wetterstationen messen diese Zusatzerwärmung zwangsläufig automatisch mit, vor allem, weil sie sich oft in bebauten Gebieten befinden. Da der WI keine sprunghafte, sich plötzlich ändernde Größe darstellt, wie z.B. Wetterereignisse, wird sein Einfluss nicht wahrgenommen und unterschätzt, was jedoch nicht als Entschuldigung für den DWD gesehen werden kann, den WI zu nicht zu berücksichtigen, wie wir noch zeigen werden.

Ein Beispiel vorweg: Der Jahresmittelwert betrug 2009 bei der Wetterstation am Flugplatz Heathrow bei London 11,9 Grad, bei der Ostalbwetterwarte in Neresheim im Süden Deutschlands nur 8,1 Grad, obwohl sich diese Station nicht außerhalb von Neresheim, sondern in einer Siedlung und dort an einem Südhang befindet. Ein Unterschied in den Mitteltemperaturen von fast 4°C, der durch die Insellage Großbritanniens und damit milde Winter allein nicht erklärbar ist, aber vor dem Hintergrund des WI in Städten und im speziellen auf Großflughäfen, wie wir noch zeigen werden. Wem die Ostalbwetterwarte zu speziell ist, in 2009 lag die Mitteltemperatur in Deutschland bei 9,2°C, was immer noch einen Unterschied von fast 3°C ausmacht. Worauf dieser große Unterschied wesentlich beruht, werden wir unter “Temperaturmessstationen auf Großflughäfen“ (Kapitel 2) zeigen. Übrigens lag laut Met Office (http://www.metoffice.gov.uk/climate/uk/datasets/Tmean/ranked/UK.txt) die Mitteltemperatur 2009 in Großbritannien bei 9,17°C. Gut 2,7°C Temperaturdifferenz zu London Heathrow. Dieser Differenzwert von ca. 2 ½ °C wird uns auch noch später, beim Flughafen Frankfurt Rhein-Main begegnen.

Dass Messdaten nicht WI-bereinigt werden, liegt nicht daran, dass es hierzu keine Verfahren gibt. Es gibt einfache Verfahren zur ungefähren Bestimmung des WI, die jeder selbst vornehmen kann. Jedoch gehört zu Ihrer Anwendung die genaue Kenntnis der Metadaten über der Zeit. Außerdem wurde bis heute kein standardisiertes, überall akzeptiertes und damit breit anwendbares Verfahren dafür entwickelt.

Beispiel (durchgeführt von Herrn Kowatsch):

Gemessen wird die Temperatur auf dem Schulhof nach einem vergleichbaren Verfahren. Die Schule selbst liegt am Ortsrand der Gemeinde Abtsgmünd. Anschließend begibt man sich mindestens 100 m entfernt auf eine Wiese, 10 Messungen ergeben den Durchschnittswert des WI für diesen Punkt, an diesem Tag und bei diesen bestimmten Tageswetterbedingungen. Die Messungen wurden ab Anfang Juni 2010 durchgeführt. Der Schulhof war stets wärmer als die Temperaturen 1m über dem Wiesengras. Stets konnte ein Durchschnitts-Wert für den WI bestimmt werden, der in der Größenordnung von einem Grad lag!

Korrekturverfahren für den WI werden jedoch bei den Wetterstationen selbst meist nicht angewendet. So kann es nicht verwundern, dass die einzelnen Leiter der Wetterstationen den speziellen Wärmeinseleffekt ihrer Station gar nicht kennen. Deshalb werden grundsätzlich die gemessenen Temperaturen ohne Korrekturen nach Offenbach zur Zentrale des Deutschen Wetterdienstes (DWD) weitergegeben und daraus die Mittelwerte für Deutschland errechnet. Und es ist leider nicht so, dass alle Stationen des DWD so aufgestellt sind, dass sie nicht durch WI-Fehler behaftet sind.

Der DWD geht bei der Aufstellung und Betrieb seiner Messstationen von folgenden Aufstelldingungen aus:

· Die Hütte/Screen stehe unbeschattet auf dem Messfeld

· Sie stehe in beachtlichem Abstand von Bäumen, Hecken und Gebäuden oder sonstigen Hindernissen (allg. Regel: Hindernisentfernung größer als zweifache Hindernishöhe)

· Bei DWD-Messnetzen besteht die Forderung, dass die Messfühler sich in 2 m Höhe über dem Boden befinden. International üblich sind aber auch: 1,5 bis 2 m, z.B. bei der “französischen Hütte“

· Die Türöffnung der Messhütte weise nach Norden

· Der Tritt vor der Hütte hat zur Vermeidung von unerwünschten Erschütterungen keinen Kontakt zum Aufbau (Gestell) der Thermometerhütte

· Es hat keine (unbekannte) Ortsveränderung über die Zeit stattgefunden

· Im Detail gelten die allgemeinen Aufstellbedingungen und Fehlerklassifizierungen des US Climate Reference Network Rating Guide

Wie sieht nun die Realität aus? Von den von uns überprüften DWD-Wetterstationen, sind für eine statistische Temperaturvergleichsmessung ca. 40% nicht geeignet. Insgesamt wurden 130 Stationen nach folgenden Kriterien überprüft, wobei mehrere hundert Photos ausgewertet wurden:

· Zu nahe an Gebäuen, also reflektierenden Flächen. Als „Faustformel“ gilt der doppelte Abstand der Messstation zur Gebäudehöhe (siehe oben)

· Verkehrsaufkommen, oder Parkplätze in unmittelbarer Nähe (Abwärme)

· Messstation in bevorzugt warmen Gebieten (z.B. Innenstadt)

· Messstation am Oberrand eines Steilhanges mit Sonnenlage (Aufwärme/Thermik verfälscht Ergebnis)

· Messstation wird abgeschattet. Befindet sich nicht auf freiem Gelände

Hier fünf Beispiele nicht geeigneter Stationen für eine statistische Zeitreihenbetrachtung.

Welche Faktoren bestimmen den WI? Wärmeabstrahlende technische Systeme wurden bereits gezeigt (Abbildung 5 – 7).

Allgemeine Gründe sind die Zunahme der Bevölkerung, die Zunahme des Wohlstandes und die damit bedingte zunehmende Bebauung und die Zunahme des Energieverbrauchs. Hier im Einzelnen:

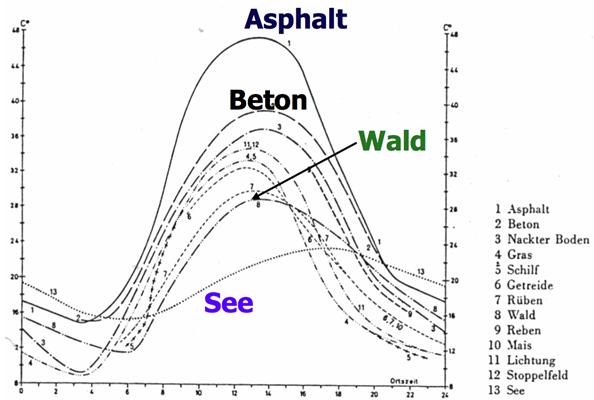

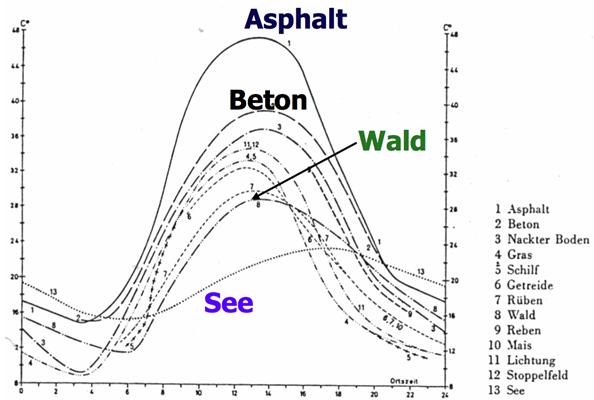

1) Bebauung durch Gebäude und Versiegelung der Landschaft

Abbildung 19 zeigt den Tagesgang der Temperatur an einem sommerlichen Strahlungstag in Bodenhöhe für verschiedene Böden, nach Fezer 1975. Es fällt nicht nur auf, dass über Beton und insbesondere Asphalt die Temperaturen z.B. sehr stark über denen des Waldbodens liegen, sondern, dass auch ein deutlicher Temperaturunterschied von mehreren °C zwischen Gras, Wald oder landwirtschaftlichen Flächen liegt. Messstationen, die ursprünglich auf freiem Feld standen und zwischenzeitlich in einer Gras, Hecken oder offenen Waldlandschft stehen (oder umgekehrt), weil sich das Landschaftsbild über die Jahrzehnte änderte, was nicht wirklich verwundern kann, geben somit deutlich veränderte Temperaturwerte wieder und verzerren jeglichen Temperaturvergleich. Die Gründe hierfür sind vielfältig:

– Im Sommer speichert der verwendete Feststoff die tagsüber von der Sonne eingestrahlte Wärme (spezifische Wärmekapazität der Stoffe) und gibt sie nachts ab, die Bebauung erwärmt somit die Umgebung.

– Wenn es regnet, fließt Regenwasser sofort ab und erzeugt keine Verdunstungskälte.

– Bäume und Pflanzen, die vor der Versiegelung der Landschaft angesiedelt waren, haben einen erheblichen Teil der Sonnenstrahlung für ihre Fotosynthese verwendet. Nur ein Teil der Sonnenstrahlung erreichte den Boden. Die Sonnenstrahlung wurde abgefangen, und in chemischer Form in den Pflanzen gespeichert. Die Versiegelung der Landschaft hält weltweit an, bedingt durch die Bevölkerungszunahme.

– Zunahme des Wohlstandes in Teilen der Welt, vor allem auf der Nordhalbkugel.

Je weiter ein Land im Norden liegt, desto größer ist der Energieanteil, der zur Heizung benötigt wird. Deshalb steigt auch der Wärmeinseleffekt der Siedlungen, je weiter man nach Norden kommt. Dies ist sicherlich ein Aspekt, warum die gemessene globale Erwärmung umso größer ist, je weiter man nach Norden kommt. Über weitere Gründe der „Norderwärmung“ hat EIKE bereits berichtet (http://www.eike-klima-energie.eu/klima-anzeige/giss-streicht-temperaturdaten-aus-der-arktis-und-daten-der-wassertemperatur-in-den-suedlichen-ozeanen-um-die-antarktis/?tx_ttnews[pointer]=3)

2) Umwandlung natürlicher Feucht- und Waldgebiete in Nutzflächen.

Auch die freie, unbebaute Landschaft hat gegenüber dem Deutschland vor 100 Jahren eine Erwärmung erfahren, die auf dem WI beruht. Es handelt sich dabei nicht um eine statistische Umlegung des WI aus der Bebauung auf die Gesamtfläche des Landes, wie der Deutsche Wetterdienst dies per Mail darlegt und eine genannte Schätzung von 0,1°C WI in der Gesamtfläche abgibt, sondern um einen realen, basierend auf Landschaftsumgestaltung, Wärmeinseleffekt.

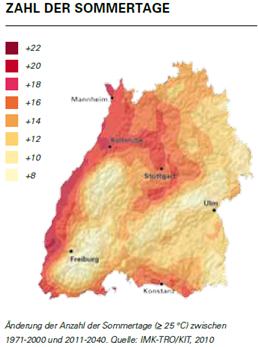

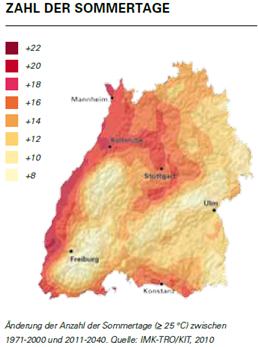

Besonders wird dies im Rheingraben sichtbar. In den letzten 50 Jahren wurden Flussauen und Feuchtwiesen trockengelegt, wodurch z.B. die Herbstnebeltage verschwanden und der der Sonnenschein dadurch automatisch zunahm. Die Bebauung hat sich zudem in den letzten 50 Jahren verdreifacht. Über den größeren WI nimmt die Zahl der heißen Tage (Sommertage, >25°C) in direkter Abhängigkeit zu. Ein weiteres Gebiet ist die Bodenseeregion, die touristisch erschlossen wurde und ebenfalls landwirtschaftlich großflächig genutzt wird. Nach den geschilderten Prämissen sollte sich in beiden Regionen ein vergleichsweise großer WI in der Fläche zeigen, was auch der Fall ist, wie Abbildung 20 belegt.

Abbildung 20 zeigt die Änderung in der Zahl der Sommertage in Baden-Württemberg, Quelle: “Klimawandel in Baden-Württemberg, Fakten – Folgen – Perspektiven“ (2010), Ministerium für Umwelt, Naturschutz und Verkehr, nach den Daten des Instituts für Meteorologie und Klimaforschung, Karlsruhe. Deutlich ist zu sehen, dass exakt in den Regionen, in denen eine große Landschaftsveränderung (großflächige Trockenlegung, Bebauung, etc.) vorgenommen wurde und damit ein hoher WI entstand, die prozentuale Änderung wegen des WI besonders stark ausfällt.

So speichern mehrjährige Pflanzen durch ihr tiefes und ausgedehntes Wurzelwerk bis zu 5-mal mehr Regenwasser (S.d.W. 11/07, “Erde und Umwelt“) als Nutzpflanzen wie Weizen, Mais, etc. Die entsprechenden Flächen (in Deutschland betrifft dies etwa 50% der gesamten Landesfläche) können also im Minimum nur noch 1/5 der üblichen Wassermenge aufnehmen. Es ist nämlich nicht vorrangig die vielerorts angeprangerte Flächenversiegelung durch Bebauung (beträgt ca. 6% der gesamten Landesfläche in Deutschland), die für das vermehrte Abfließen des Regenwassers verantwortlich ist!

Die Auswirkungen, die die Abholzung auf den Wasserhaushalt und damit auf den Feuchtegehalt der Atmosphäre und damit wiederum auf Niederschläge hat, wird an folgendem Beispiel des Instituts für Angewandte Geologie der Uni Erlangen transparent: “Der beträchtliche Wasserumsatz aufgrund der pflanzlichen Transpiration wird durch folgende Werte verdeutlicht: So gibt beispielsweise eine ausgewachsene Sonnenblume pro Tag über 1 Liter Wasser an die Atmosphäre ab. Bei gutem Grundwasseranschluss kann in einem trockenheißen Sommer eine große Birke zwischen 400 und 700 Liter pro Tag verdunsten und eine 100-jährige Buche sogar 9.000 Liter pro Tag. Ein Quadratkilometer Buchenhochwald verdunstet im Sommer jeden Tag etwa 2.000.000 Liter und im gesamten Jahr etwa 360.000.000 Liter. Umgerechnet auf je 100 g Blatt-Trockenmasse benötigt pro Vegetationsperiode eine Tanne 7 Liter Wasser, eine Buche jedoch 74 Liter. Aus den eben genannten Zahlen wird ersichtlich, welch entscheidende Bedeutung die Wälder und hier vor allem die Laubwälder für die Erhaltung eines eingespielten Klimaablaufes besitzen.“ (Quelle: http://www.angewandte-geologie.geol.uni-erlangen.de/klima1.htm).

In den Tropen ist dieser Wert noch höher, so dass durch die Abholzung der Wasserhaushalt aus dem Gleichgewicht gerät und damit auch die Temperaturen verändert werden, was zu regionalen Dürre- und Hitzeperioden führt.

Größere Waldbestände, auch Moore und Sumpfgebiete wirken ausgleichend auf die Temperaturen an der Erdoberfläche, bei einer Verringerung dieser Vegetationsflächen gestaltet sich das Witterungsgeschehen daher extremer.

Der WI der freien Fläche ist demnach eine reale Größe. Er beruht auf Landschaftsumgestaltungen, welche die physikalischen Eigenschaften der Landfläche verändert haben. Die Trockenlegung und Verdichtung der Landschaft von zig-tausenden von km2 in den letzten 100 Jahren in Deutschland, siehe hierzu Spektrum der Wissenschaft, 08/06, S. 80, “Schwerlast auf dem Acker“ als entscheidenden Faktor.

Abbildung 21 (Quelle: Spektrum der Wissenschaft, 08/06, “Schwerlast auf dem Acker“) zeigt die Faktoren der Bodenverdichtung. Wortlaut S.d.W.: “Einst erstklassige Ackerböden lassen heute pro Zeiteinheit höchstens noch ein Zehntel bis Hundertstel der Wassermenge versickern, die in einem ursprünglichen, lockeren Waldboden versickern würde. Selbst ein Tausendstel kommt vor.“ Der große Rest fließt ab! Er geht der Wärmeregulierung verloren.

Durch das schnellere Abfließen des Oberflächenwassers wird die Verdunstung in der freien Fläche entscheidend verringert. Feuchtwiesen, Tümpel, Weiher, Moore und nasse Talauen wurden in bäuerliche Leistungswiesen und Ackerland umgewandelt. Eine Trockenwiese heizt sich schneller auf als die zuvor dagewesene Feuchtwiese. Die Austrocknung des Waldes erfolgt von unten, nicht von oben.

Dieser Wärmeinseleffekt der freien Fläche wurde unseres Wissens bislang in der Literatur noch nirgends beschrieben oder berücksichtigt. Er ist jedoch, aus den bereits genannten Gründen, als nicht unerheblich einzustufen. In den letzten hundert Jahren ist die Weltbevölkerung von 1 auf ca. 6,7 Milliarden gestiegen. Die damit verbundene Versiegelung des Bodens behindert den Wärmetransport durch Verdunstung in die Atmosphäre. Das hat natürlich Auswirkung auf das regionale Klima und unter Umständen auch global, wenn man an die Rodung von Regenwäldern denkt.

Regionale Auswirkungen:

– Durch das entzogene Wasser wurde die Verdunstungskühlung erniedrigt.

– Die Nebeltage wurden weniger. Aus der feuchten Fläche bildete sich der Frühnebel, im Herbst. Vor allem im November waren die Talauen oft tagelang zu und die Sonnenstrahlung wurde wieder reflektiert. Weniger Sonne erreichte den Erdboden. In den letzten 10 Jahren sind aus meinem Heimatort (Kowatsch) die Nebeltage nahezu ganz verschwunden. Selbst im November lösen sich die Nebel spätestens am Nachmittag meist auf.

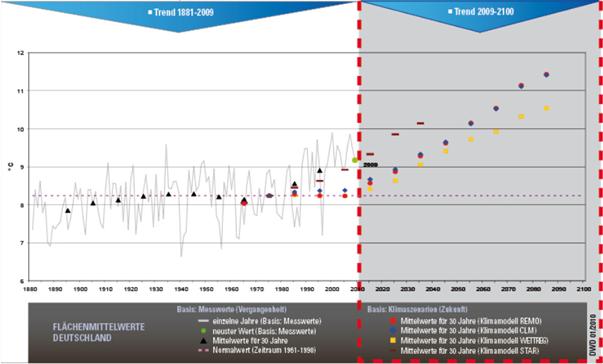

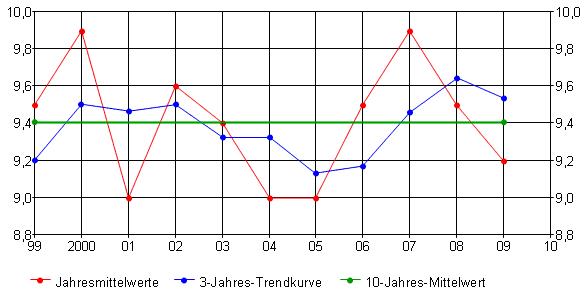

Vor diesem Hintergrund ist die Temperaturzeitreihe des DWD für Deutschland zu betrachten, Abbildung 22.

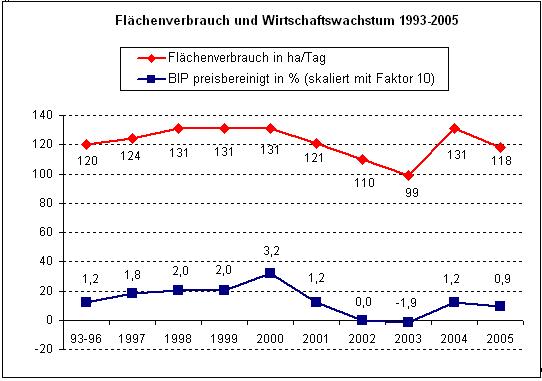

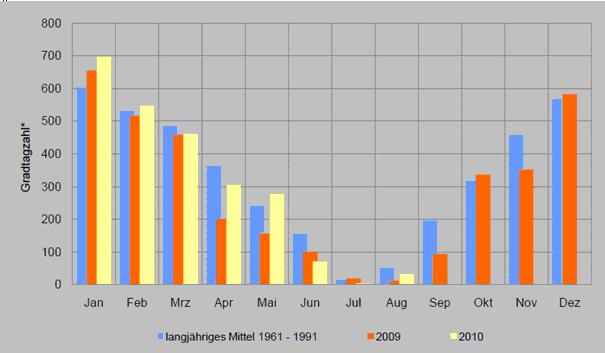

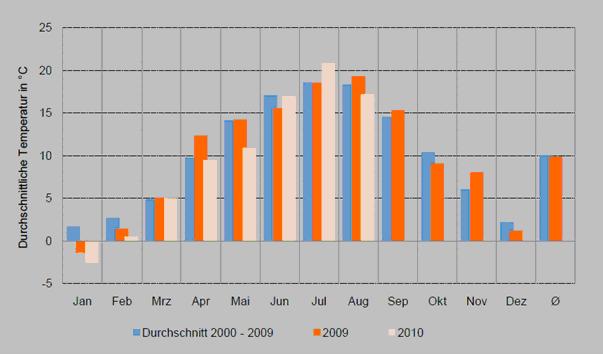

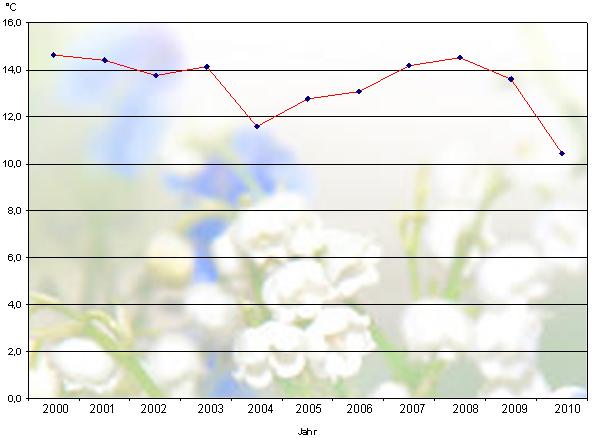

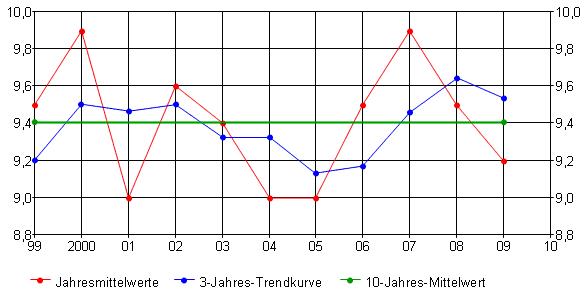

Abbildung 22 zeigt den Temperaturgang der Jahresmittelwerte*) in Deutschland von 1999 2009, Datenquelle: DWD. Dazu den 3-Jahres-Trend und den Dekadenmittelwert. Von einer Erwärmung in Deutschland ist nun wahrlich nichts zu sehen. Gleich viele Werte liegen unter, bzw. auf der Mittelwertlinie, wie über ihr. Derzeit fallen die Temperaturen und liegen unterhalb der Dekadenmittellinie, was auch für 2010 so bleiben wird. Nach den Temperaturzeitreihen des DWD ist es in Deutschland seit 10 Jahren um 0,7°C kälter geworden, gegenüber dem Maximalwert in 2000. Gegenüber dem Trend um gut 0,3°C. Anhand der Abbildung 3 (Teil 2, folgt in Kürze), die die Monatsmittelwerte bis August 2010 zum Vergleich 2009 zeigt, wird ersichtlich, dass in 2010 die Temperaturen weiter fallen werden!

*) Wir haben die Absolutwerte und nicht die Schwankungswerte, also die Anomalien dargestellt, weil wir uns an die Darstellung des DWD in seinen Jahresberichten halten möchten (siehe Abbildung 23 und 24), der ebenfalls die Absolutwerte wiedergibt.

Abbildung 22 zeigt weiter, dass ausgerechnet zum IPCC-Jahr 2007, als das IPCC politik- und medienwirksam seinen AR4 präsentierte, sich in Deutschland die Temperaturen von der globalen Temperaturentwicklung abkoppeln, siehe Abbildung 26, Teil 2. Während in 2006 und 2007 global die Temperaturen deutlich fallen, stiegen diese hingegen in Deutschland stark an. Gegenwärtig liegen die Deutschland-Temperaturen wieder auf dem Niveau der IPCC-Vorjahre. Erklären können wir Ihnen diese Diskrepanz zu den globalen Temperaturwerten nicht, da wir nicht wissen, welche Messstationen der DWD für die einzelnen Jahre zur Mittelwertbewertung herangezogen hat und welche Algorithmen er jeweils dabei verwendete.

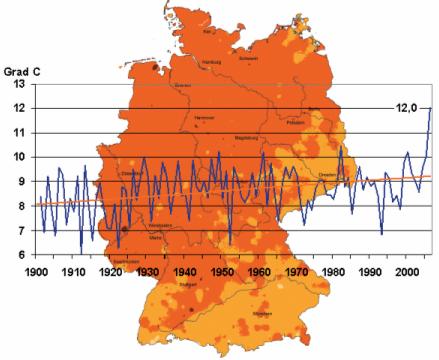

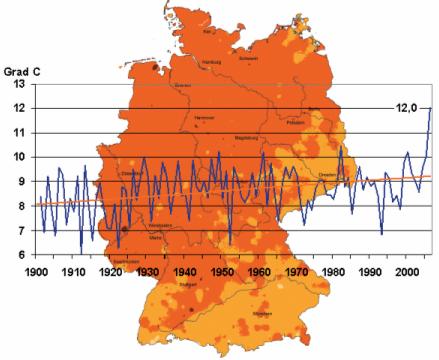

In 2007 waren die Informationsaussagen des DWD erklärungsbedürftig. So veröffentlichte er in seinem Jahresbericht 2006, welcher im April 2007 (kurz nach dem AR4 oder sollen wir sagen, passend zum AR4) präsentiert wurde, auf dem Titelblatt die folgende Abbildung.

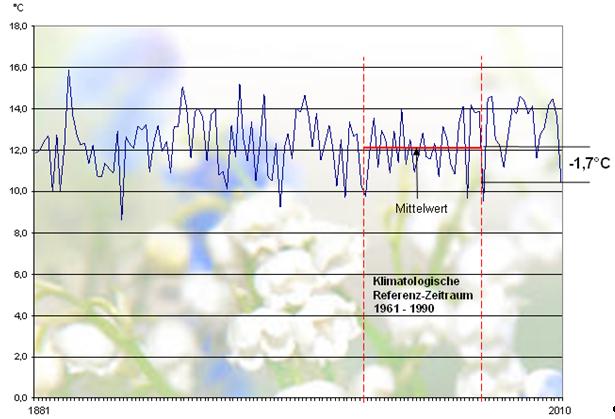

Abbildung 23 (Quelle: Jahresbericht 2006, DWD, Deckblatt) zeigt Deutschland, davor eine Temperaturkurve, die zur Gegenwart hin plötzlich sehr stark ansteigt und bei dem Temperaturwert von 12,0°C verharrt. Anmerkung: wie sich die Temperaturen in der Realität entwickelten, zeigt Abbildung 22. Die erklärungsbedürftige Abbildung vom Deckblatt wird im Jahresbericht an keiner Stelle auch nur ansatzweise kommentiert, nicht einmal erwähnt! Beim Betrachter wird indes leicht der Eindruck erweckt, dass die Temperaturen in Deutschland dabei sind, alle Rekorde zu brechen, was, wie die Abbildung 22 belegt, gegenteilig der Fall ist. Im Jahresbericht 2006 findet sich auf Seite 5 dann die korrekte und auch beschriebene Zeitreihe, die allerdings längst nicht so spektakulär aussieht (Abbildung 24).

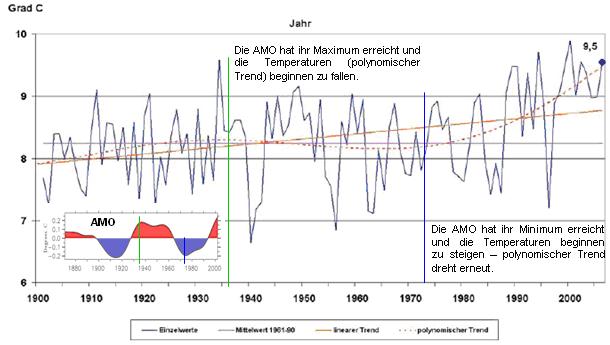

Abbildung 24 zeigt die Jahresmittelwerttemperatur*) in Deutschland von 1900 – 2006, Quelle: Jahresbericht 2006, DWD, Seite 5. 2006 lag die Temperatur im Mittel bei 9,5°C und damit 1,3K über dem klimatologischen Referenzzeitraum 1961 – 1990 von 8,2°C, wobei dieser Durchschnitt in einer Kälteperiode liegt (wir erinnern uns noch an die Aussagen aus Politik und Wissenschaft zur bevorstehenden Eiszeit in den 1970-Jahren) und damit vergleichsweise niedrige Referenzwerte liefert. Das Chart sieht lange nicht so spektakulär aus, wie Abbildung 23 (unkommentiert!) vom Titelblatt. Der Wert von 9,5°C deckt sich mit den Werten, die der DWD uns zur Verfügung stellte.

*) Die Kurve ist hinsichtlich der Absolutwerte wenig aussagefähig, da Deutschland heute andere Grenzen als 1900 hat (in der Fläche noch die Hälfte), Messorte sich änderten, der Wärmeinseleffekt einfließt u.v.m. Vor 1900 wurde darüber hinaus in Süddeutschland nicht nach Celsius, sondern nach Réamur gemessen.

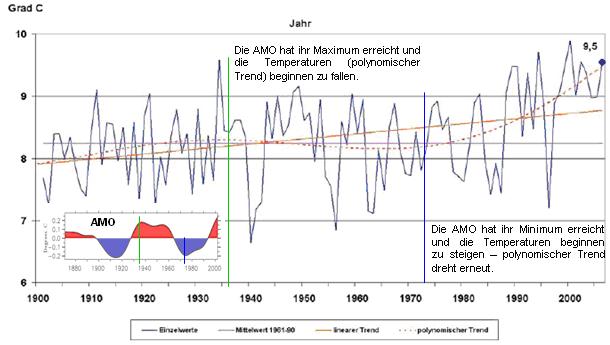

Als kleiner „Nachhilfeunterricht“ für den DWD haben wir die AMO-Zeitreihe (Atlantik Multidekaden Oszillation – gibt die Oberflächentemperatur im Nordatlantik wieder) von 1880 – 2000 hinzugefügt. Werden nun deren Schwankungen mit dem polynomischen Trend verglichen, den der DWD in seiner Abbildung zeigt, wird deutlich, dass dieser im Gleichklang mit der natürlichen AMO, die von der Sonne moderiert wird, ist. Fällt die AMO, so dreht der polynomische Trend und wird negativ. Steigt hingegen die AMO wieder an, dreht der polynomische Trend erneut und wird positiv.

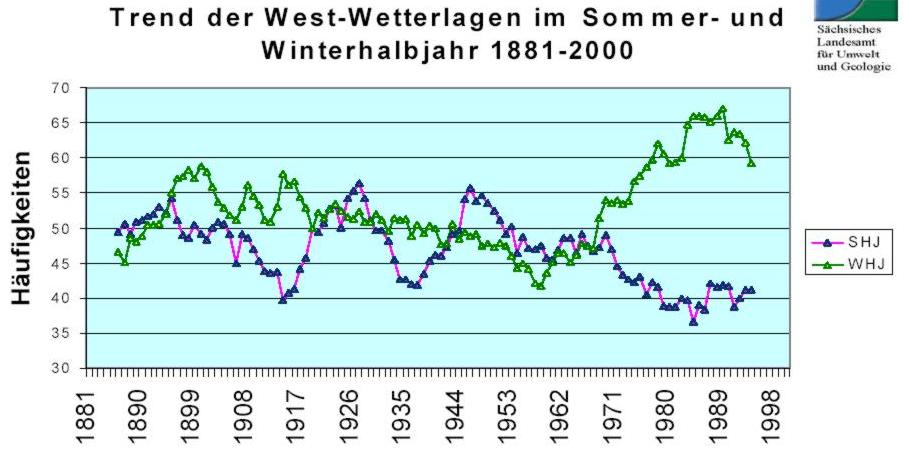

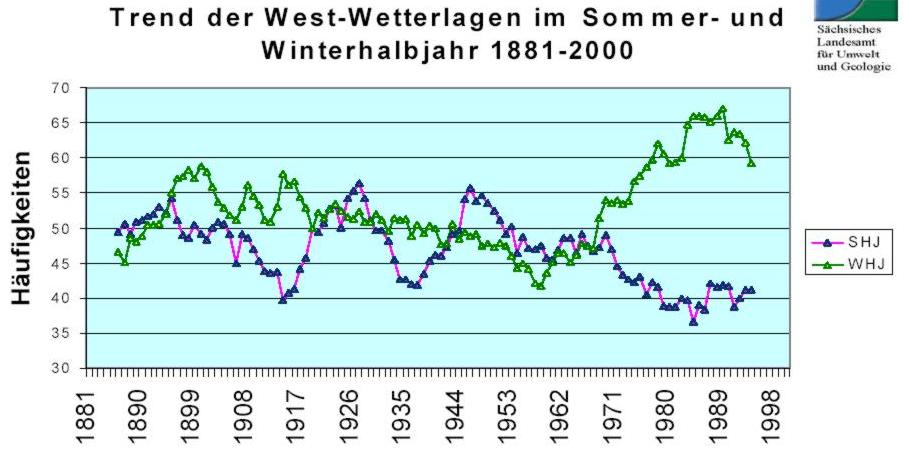

Es kann nun wirklich nicht verwundern, dass in Deutschland die Temperaturen von der Windströmung abhängen, insbesondere von der Westwindströmung vom Atlantik. Abbildung 25 zeigt deutlich, warum die Temperaturen in Deutschland in den 1970-Jahren zu steigen begannen.

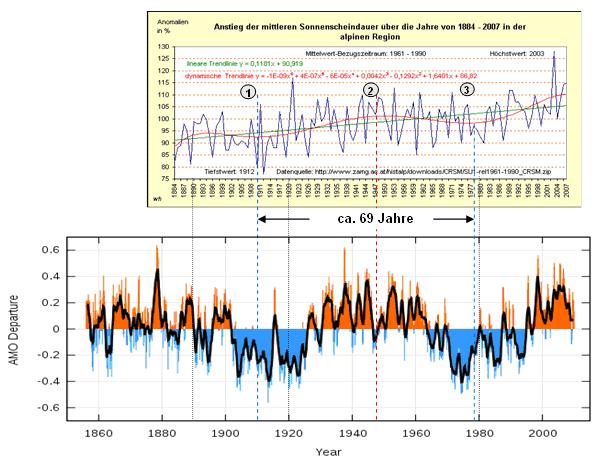

Abbildung 25, Quelle: Sächsisches Landesamt für Umwelt und Geologie, zeigt die West-Wetterlagen im Sommer- und Winterhalbjahr im Zeitraum von 1881 – 2000. Deutlich ist zu erkennen, dass seit Beginn der 1970-Jahre die West-Wetterlagen im Winter stark zunahmen (was wärmere Winter bedeutet) und im Sommer dagegen abnahmen (was trockenere und wärmere Sommer bedeutet). Zunahme der West-Wetterlagen im Winter und Abnahme der West-Wetterlagen im Sommer bewirken, dass in Deutschland die Temperaturen steigen. Im Winterhalbjahr mildere Winter und im Sommerhalbjahr mehr Sonne, wie Abbildung 26 zeigt.

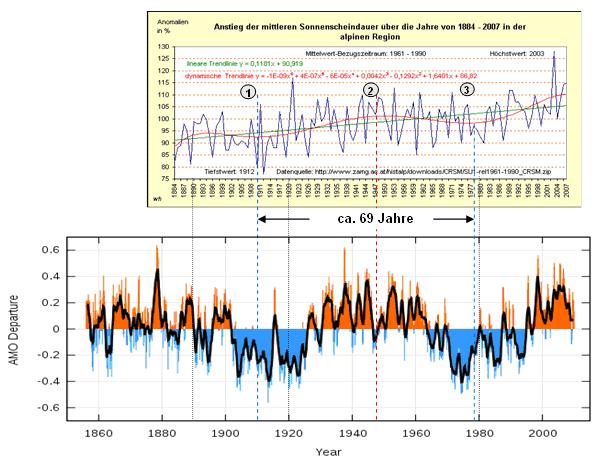

Abbildung 26 zeigt die mittlere Sonnenscheindauer in der alpinen Region, Quelle: (http://mitglied.multimania.de/nature2000/wkr128.htm). Der polynomische Trend stimmt mit dem der Abbildung 24 überein. Die Sonnenscheindauer begann in den 1970-Jahren zuzunehmen, bis zum Beginn des 21. Jahrhunderts, parallel zur Erwärmungsphase. Seitdem fällt die Sonnenscheindauer und es wird wieder kälter. Eigentlich triviale Zusammenhänge, die dem DWD offensichtlich als Erklärung des gegenwärtigen Temperaturniveaus nicht einfallen. Auch hier haben wir zum Vergleich die Zeitreihe der AMO, diesmal in feinerer Auflösung (Quelle: http://www.cdc.noaa.gov/Correlation/amon.us.long.data) angeführt. Es fällt auf, dass jeweils die minimale Sonnenscheindauer (Minwert des dynamischen Trends) exakt mitten in der AMO-Kaltphase liegt und der Maxwert mitten in der AMO-Warmphase! Darüber hinaus wird eine Periodendauer von ca. 69 Jahren ersichtlich. Diese Periodendauer stammt von der Sonne und wurde von dem Astrophysiker Dr. Landscheidt beschrieben. Sie basiert auf Drehimpulsänderungen (Bahndrehimpuls und Eigendrehimpuls) der Sonne, wodurch deren magnetische Aktivität (mit) gesteuert wird. Eine Vertiefung des Themas würde an dieser Stelle zu weit führen.

Nach diesem kleinen Exkurs und „Nachhilfeunterricht“ für den DWD, was unser Wetter und die AMO lenkt, zurück zum Wärmeinseleffekt, der von verschiedenen Faktoren, von denen wir bereits einige aufzählten, abhängt.

3) Anstieg des Energie- und Stromverbrauchs

– Die Anzahl der elektrischen Verbraucher in- und außerhalb der Gebäude hat sich in den letzten 50 Jahren ständig erhöht.

– Europa ist heller geworden. Aufgrund des Wohlstandes hat die Anzahl der Beleuchtungsquellen zugenommen, was beispielsweise aus dem Weltall gut erkennbar ist (Abbildung 1). Die Anzahl der Beleuchtungskörper und Straßenbeleuchtungen hat sich dabei in den letzten 40 Jahren vervielfacht. Jeder Beleuchtungskörper gibt Wärme an die Umgebung ab. Für das Ausgangsjahr der Temperaturzeitreihe, 1880 ist die Stromerzeugung mit Null ansetzen, also auch kein WI-Effekt vorhanden. Das gleiche gilt für die anfallende Abwärme im Straßenverkehr.

– Die Zunahme der Industrialisierung: Jeder Arbeitsprozess verschlingt Energie und erzeugt Wärmeabgabe.

Um Missverständnissen vorzubeugen. Hier geht es nicht darum, die Menschheit auf den Stand des 19. Jahrhunderts zurückzuwerfen, wie dies einige militante Klimaalarmisten mit sich tragen, sondern darum, aufzuzeigen, dass es nicht statthaft ist, unkommentiert Wetterdaten von vor hundert Jahren, mit denen von heute zu vergleichen.

Aus den genannten Gründen ist abzuleiten, dass der WI sich nicht auf Großstädte beschränkt wie der Deutsche Wetterdienst behauptet, sondern generell bei Messergebnissen zu berücksichtigen ist.

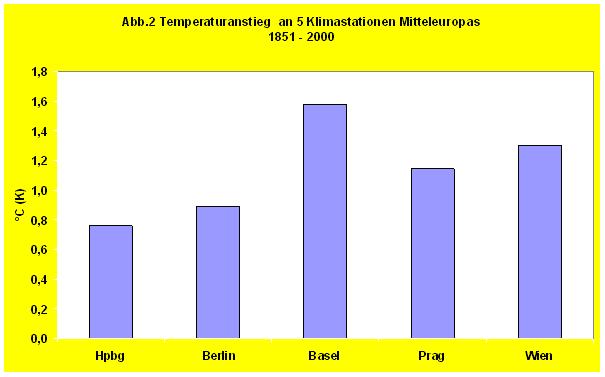

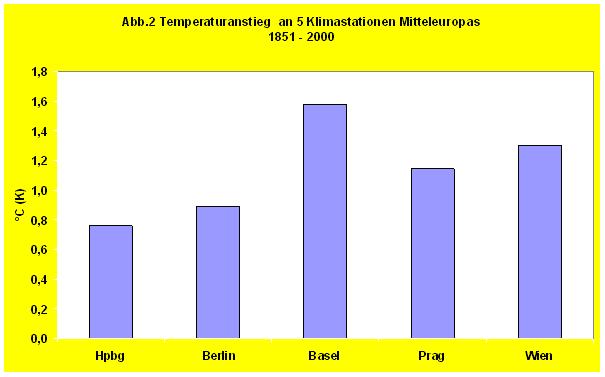

Eine wertvolle Arbeit zur Erfassung des WI in Mitteleuropa und somit auch in Deutschland hat unlängst der renommierte Professor für Meteorologie und Klimatologie, Horst Malberg in der “Berliner Wetterkarte“ (http://www.berliner-wetterkarte.de/) veröffentlicht, “Über scheinbare und tatsächliche Klimaerwärmung seit 1850“. Anhand von Vergleichen am Regressionsparameter, also dem Temperaturanstieg von einer Dekade zur nächsten, von 5 Messstationen (Hochenpeißenberg, Berlin-Dahlem, Prag, Basel und Wien) ermittelte er den WI. Die Station Hochenpeißenberg, auf einer Höhe von 1.000m diente dabei als Referenzstation.

Abbildung 27 (Quelle: Prof. Malberg) zeigt den Temperaturanstieg an 5 Temperaturmessstationen in Europa von 1851 – 2000, dem Jahr, als in Deutschland nach Angaben des DWD die höchsten Temperaturen im Betrachtungszeitraum auftraten. Wie gesehen, fallen seitdem die Temperaturen deutlich.

Während die Referenzstation Hohenpeißenberg (Hpbg) einen Anstieg von +0,76°C seit dem Ende der “Kleinen Eiszeit“, der kältesten Periode der letzten 2.000 Jahre, ausweist, liegt der Temperaturanstieg in den Städten zum Teil deutlich höher. In Basel beträgt er +1,58°C. Prof. Malberg: “Diese unterschiedliche Erwärmung innerhalb eines Klimabereichs lässt sich nicht mit den Auswirkungen eines übergeordneten Klimaantriebs erklären. Es ist die lokale Situation, es ist der Wärmeinsel-Effekt der wachsenden Städte, der die natürliche globale/regionale Erwärmung „anthropogen“ verstärkt hat. Damit täuschen die Temperaturreihen eine Erwärmung vor, die z. T. deutlich über der natürlichen Klimaerwärmung seit 1850 liegt.“

Wie wir Ihnen anhand des Teil 2 zeigen werden, liegt der WI noch höher, da zunehmend Temperaturstationen auf Flughäfen in die Datenreihen einfließen.

Fazit:

Der Wärmeinseleffekt (WI) steigt ständig mit der Veränderung der Landschaft und der Gesellschaft. Die Temperaturmessstationen des DWD sind für eine vergleichende Temperaturaussage zum Großteil nur bedingt, bzw. nicht geeignet, da der DWD zum einen, seine eigenen Vorgaben zum Betrieb und Aufstellung von Messhütten nicht einhält und zum anderen, der DWD den vorhandenen Wärmeinseleffekt, der für den derzeit noch höheren Temperaturwert im Vergleich zum Langfristmittel verantwortlich ist, weitgehend unberücksichtigt lässt.

Teil 2 in Kürze

Josef Kowatsch

Raimund Leistenschneider – EIKE