Es gab während der letzten Eiszeit und den 10 000 folgenden Jahren zahlreiche abrupte, kurzfristige Wärme- und Kältephasen, viel intensiver als die gegenwärtige Erwärmung/Abkühlung, von denen keine einzige mit Änderungen des CO2-gehaltes in der Atmosphäre erklärbar ist, geschahen sie doch vor dem starken Anstieg des CO2 um das Jahr 1945. Diese Studie dokumentiert die geologischen Beweise für diese plötzlichen Fluktuationen des Klimas, die eine bemerkenswerte Konsistenz über Dekaden, Jahrhunderte und Jahrtausende aufweisen.

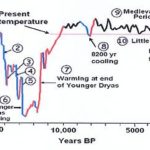

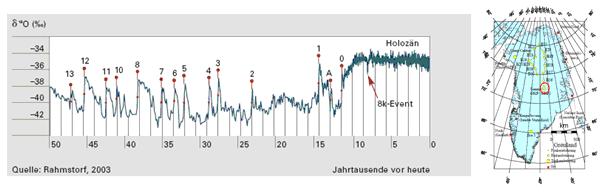

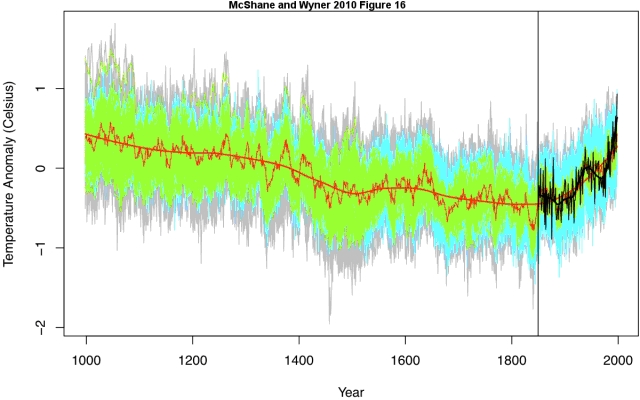

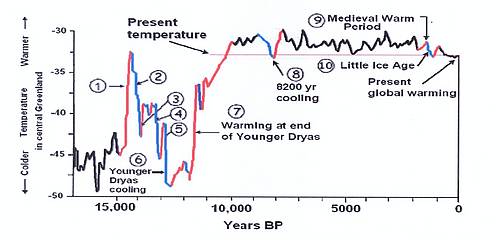

Eine der großen Überraschungen bei der Analyse von Sauerstoffisotopen in Eisbohrkernen aus Grönland und der Antarktis war die Erkenntnis von sehr plötzlichen Klimaänderungen in sehr kurzer Zeit. Die Aufzeichnungen aus den Eisbohrkernen zeigen, dass diese abrupten Klimaänderungen umfassend, sehr schnell und global synchron vor sich gingen. Klimaverschiebungen bis etwa zur Hälfte des Unterschieds zwischen Eis- und Zwischeneiszeiten ereigneten sich teils während nur weniger Jahrzehnte. Die Graphik in Abbildung 1 zeigt die Variation der Temperatur, abgeleitet aus Änderungen von Sauerstoffisotopen aus dem Eiskern GISP aus Grönland, dem weltweiten Standard für die Untersuchung vergangener Epochen der Klimaänderungen. Die Temperatur ist in Abhängigkeit von der Zeit aufgetragen, genauestens abgelesen aus den jährlichen Staubschichten im Eis. Perioden plötzlicher, intensiver Erwärmungen sind in rot dargestellt, solche mit Abkühlungen in blau. Zehn große, intensive Perioden abrupter Klimaänderungen zeigen sich während der letzten 15 000 Jahre, zusammen mit 60 anderen kleineren, aber ebenso plötzlichen Änderungen während der letzten 5000 Jahre.

Das Ausmaß und die Plötzlichkeit dieser klimatischen Fluktuationen sind erstaunlich. Immer wieder stieg oder fiel die Temperatur um 5 bis 10 K innerhalb eines Jahrhunderts oder weniger. Die Temperatur stieg um 5 K innerhalb von 30 Jahren und um 9 K in nur 40 Jahren während der abrupten Erwärmung vor etwa 11 500 Jahren.

Abbildung 1: Temperaturänderungen der letzten 17 000 Jahre aus Änderungen von Sauerstoffisotopen im GISP Eisbohrkern aus Grönland.

Die eingekreisten Nummern in der Abbildung beziehen sich auf die plötzlichen Klimaänderungen, die im Folgenden aufgelistet werden:

1. Vor 15 000 Jahren: eine plötzliche, intensive Klimaerwärmung um etwa 12 K verursachte das dramatische Abschmelzen riesiger kontinentaler Gletscherschilde aus der voran gegangenen Eiszeit in weiten Gebieten von Nordamerika, Europa und Asien.

2. Ein paar Jahrhunderte später fiel die Temperatur wieder um etwa 11 K, und die Gletscher kamen wieder.

3. Vor 14 000 Jahren stieg die Temperatur global rapide um etwa 4,5 K, und die Gletscher zogen sich zurück.

4. Vor 13 400 Jahren fiel die Temperatur um etwa 8 K, und die Gletscher stießen wieder vor.

5. Vor 13 200 Jahren gab es erneut einen starken Temperaturanstieg um etwa 5 K, verbunden mit einem starken Gletscherrückzug.

6. Vor 12 700 Jahren fiel die Temperatur in kürzester Zeit um etwa 8 K, gefolgt von einer 1000-jährigen Periode einer Rückkehr zur Eiszeit, dem jüngeren Dryas.

7. Vor 11 500 Jahren gab es einen genauso scharfen Temperaturanstieg um etwa 12 K, die das Ende der Kälteperiode des jüngeren Dryas markiert.

8. Vor 8200 Jahren unterbrach eine plötzliche Abkühlung die Warmzeit der vergangenen 10 000 Jahre und endete mit einer abrupten Erwärmung 150 Jahre später. Wie in der Abbildung gezeigt, liegt das Level der Temperatur nahezu während der gesamten vergangenen 10 000 Jahre über dem Level der gegenwärtigen Temperaturen, was darauf hindeutet, dass es die meiste Zeit während der letzten 10 000 Jahre wärmer war als heute.

9. Die Jahre 900 bis 1300 – Das mittelalterliche Klimaoptimum war eine Zeit globaler Erwärmung, in der die Temperaturen etwas höher lagen als heute.

10. Vom Jahr 1300 bis zum vergangenen Jahrhundert – die Kleine Eiszeit war eine Zeit kühleren Klimas, in der sich die Gletscher signifikant vorschoben und die zu großen Hungersnöten in Europa führte.

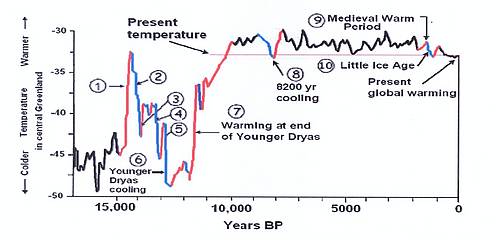

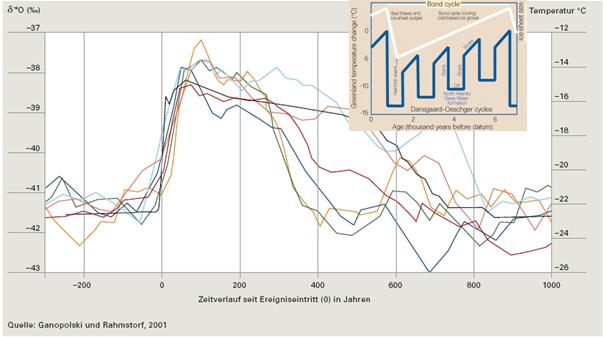

Die Kaltzeit des jüngeren Trias vor 12 800 bis 11 500 Jahren

Das dramatische Abschmelzen der kontinentalen Eisschilde in Nordamerika, Europa und Asien, das vor 15 000 Jahren einsetzte, wurde durch eine plötzliche Abkühlung vor 12 800 Jahren unterbrochen, welche die Welt zurück in eine Eiszeit katapultierte. Weltweit stellten die Gletscher ihr Zurückweichen ein, und kontinentale wie auch die alpinen Gletscher stießen wieder einmal vor. Die Periode des jüngeren Dryas dauerte 1300 Jahre und endete mit einer plötzlichen, abrupten Erwärmung vor 11 500 Jahren. Das Klima in Grönland erwärmte sich um etwa 5 K innerhalb von 30 und um etwa 7 K innerhalb von 40 Jahren.

Abbildung 2: Temperaturkurve abgeleitet aus Sauerstoffisotopen aus dem GISP Eiskern aus Grönland, die die Dauer und Intensität der Kaltzeit des jüngeren Dryas zeigt, die vor 12 800 Jahren begann und vor 11 500 Jahren zu Ende ging.

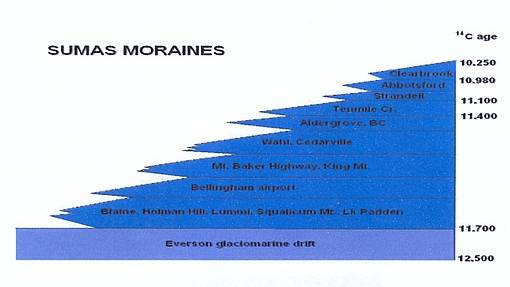

Während dieser Kaltzeit haben sich die Gletscher nicht nur signifikant ausgedehnt, sondern zeigten auch wiederholte Fluktuationen, mancherorts bis zu neun mal (Abbildung 3)

Abbildung 3: Neun Vorstöße und Rückzüge des Eisschildes der Kordilleren im Nordwesten der heutigen USA im Endstadium der letzten Eiszeit. Das Alter auf der rechten Seite des Diagramms stellen ‚Kohlenstoffisotop-Jahre [C14]‘ dar, die mit dem Zeitraum vor 11 500 bis etwa 13 000 Kalenderjahren korrespondieren.

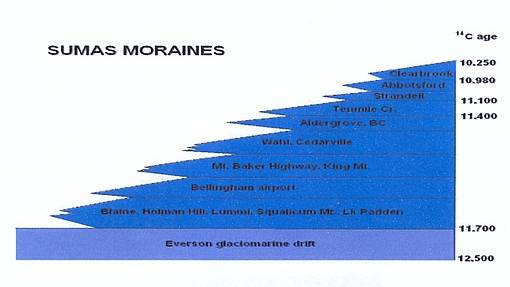

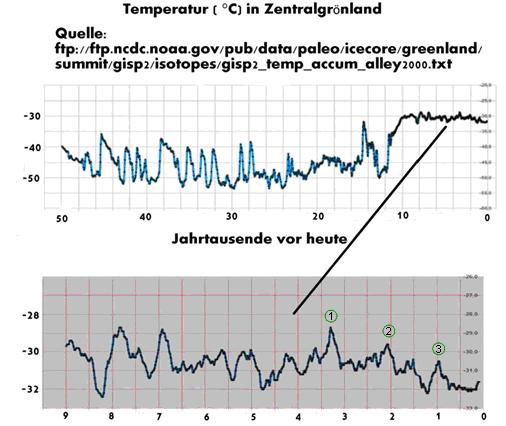

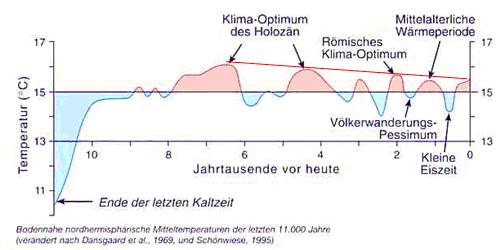

Das Klima im Holozän

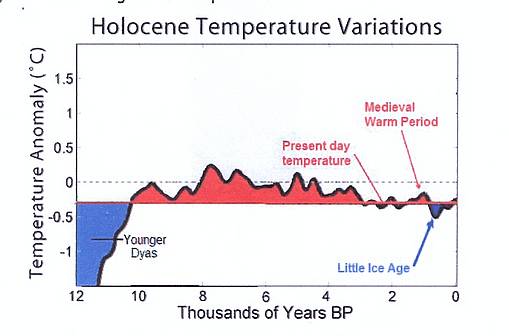

Die Temperaturen während des größten Teils der letzten 10 000 Jahre lagen um Einiges höher als heute, bis vor etwa 3000 Jahren (Abbildung 4). Während der letzten 700 Jahre kam die Erde aus der Kleinen Eiszeit und erwärmte sich allgemein mit alternierenden Perioden von Warm- und Kaltzeiten.

Abbildung 4: Die Temperaturen lag während der letzten 10 000 Jahre generell über den heutigen Werten, bis vor etwa 3000 Jahren.

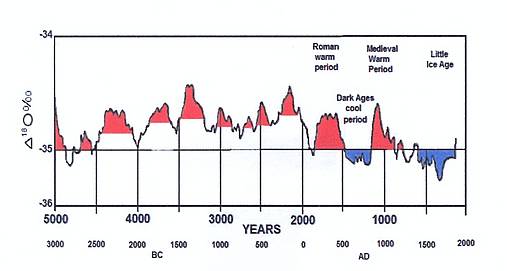

Klimafluktuationen während der letzten 5000 Jahre

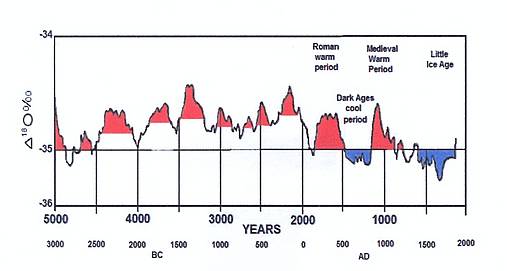

Abbildung 5: Klimaerwärmung und –abkühlung während der vergangenen 5000 Jahre. Rote Bereiche stehen für Erwärmung, blaue für Abkühlung. Quelle: Daten aus dem GISP Eiskern.

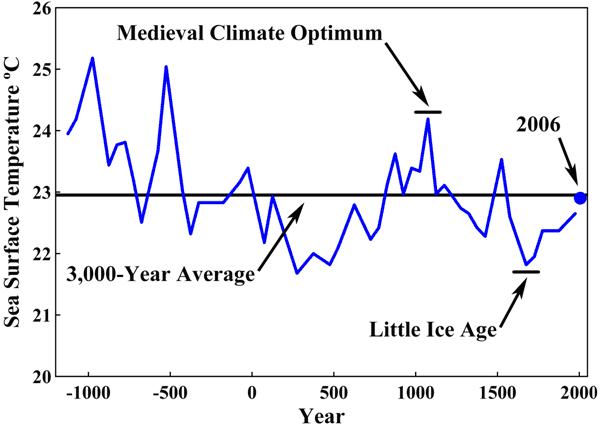

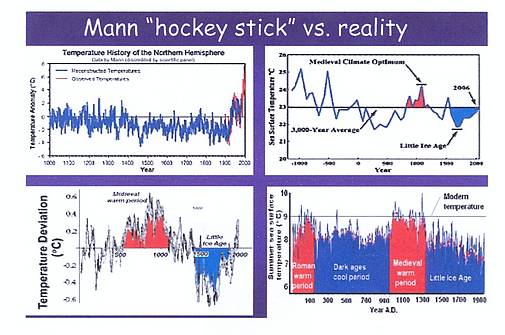

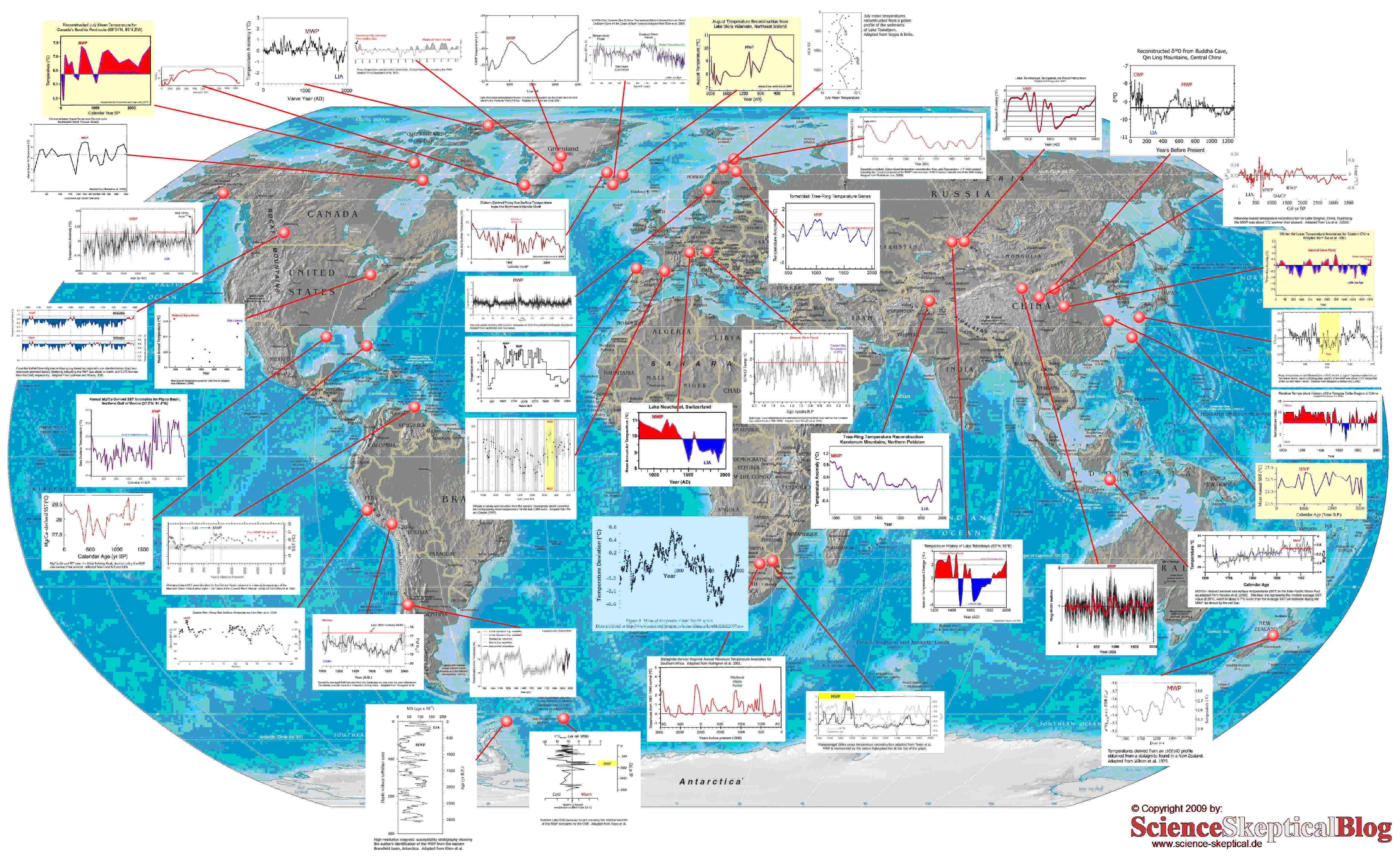

Das Mittelalterliche Klimaoptimum und die Kleine Eiszeit

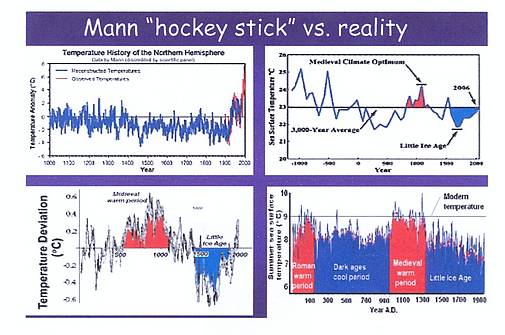

Sowohl das Mittelalterliche Klimaoptimum als auch die Kleine Eiszeit sind seit Langem bestätigt und dokumentiert mit eindeutigen geologischen Beweisen. Georef nennt 485 Studien zu diesem Klimaoptimum und 1413 zur Kleinen Eiszeit. Als Mann et al. 1998 behaupteten, dass es beide Perioden gar nicht gegeben und das Klima der letzten 1000 Jahre sich überhaupt nicht verändert hatte (der unsägliche Hockeyschläger), haben Geologen das folgerichtig nicht ernst genommen. Sie dachten, dass (1) die Baumringdaten, die sie für ihre Klimarekonstruktion nutzten, nicht klimasensitiv waren oder (2) die Daten in unzulässiger Weise bearbeitet wurden. Abbildung 6 zeigt einen Vergleich zwischen dem ‚Hockeyschläger‘ von Mann et al. Und drei Beispiele aus zahlreichen anderen, die belegen, wie gut die Temperaturänderungen des Mittelalterlichen Klimaoptimums und der Kleinen Eiszeit definiert sind.

Abbildung 6: Vergleich des Mann’schen Hockeyschlägers (1998; oben links) mit den Wassertemperaturen des Sargasso-Meeres, die aus dem Verhältnis von Isotopen in maritimen Organismen abgeleitet wurden (oben Links; Keigwin 1996), rekonstruierten Paläoklimatemperaturen ohne Baumringdaten (unten links; Loehle 2007) und Wassertemperaturen im Sommer bei Island (unten rechts; Sicre et al. 2008).

Wie die drei Beispiele in Abbildung 6 ebenso wie etwa 1900 andere Studien belegen, gab es das Mittelalterliche Klimaoptimum und die Kleine Eiszeit mit Sicherheit tatsächlich, und der Mann’sche ‚Hockeyschläger‘ ist unsinnig und ohne jeden glaubhaften Beweis.

Abfolge von Erwärmung und Abkühlung während der letzten 500 Jahre

Die Analyse der Sauerstoffisotope im GISP Eiskern von Grönland zeigt einen bemerkenswerten Wechsel von warmen und kalten Perioden. Die vertikalen blauen Linien im unteren Teil visualisieren die Zeiträume zwischen jeder Warm-/Kaltperiode. Im Mittel dauerte ein solcher Zeitraum 27 Jahre. Dies entspricht dem gleichen Zeitraum, wie im Pazifischen Ozean warme und kühle Perioden im Zuge der Pazifischen dekadischen Oszillation wechseln (siehe unten).

Abbildung 7: Die Temperaturänderungen nach dem GISP Eiskern von Grönland zeigen ein regelmäßiges Muster von alternierenden Erwärmungen und Abkühlungen mit einer Periode von 25 bis 30 Jahren während der letzten 500 Jahre. Dies ähnelt sehr stark dem Alternieren der Pazifischen dekadischen Oszillation.

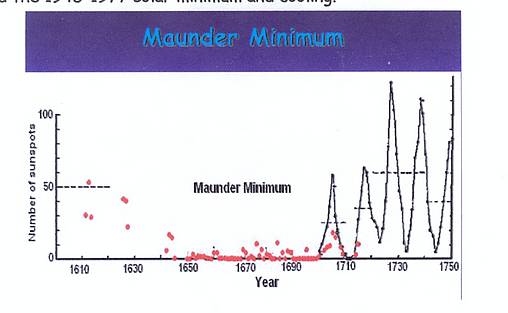

Der Vergleich von Warm-/Kaltzeiten mit solaren Veränderungen

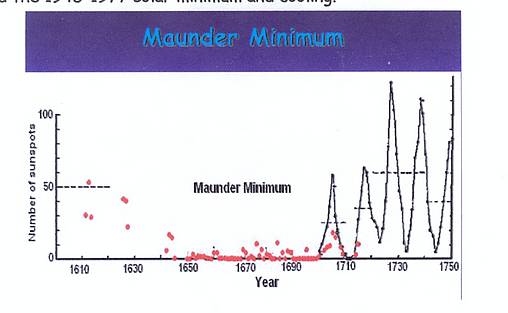

Die vielleicht bekannteste Verbindung zwischen einer Klimaänderung und solaren Veränderungen ist das solare Maunder-Minimum zu Beginn der Kleinen Eiszeit. In der Zeit zwischen den Jahren 1650 und 1700 wurden fast keine Sonnenflecken beobachtet (Abbildung 8), und das Klima wurde kalt, was zu massenhaften Hungersnöten wegen wiederholten Missernten in Europa führte.

Abbildung 9 zeigt den Zusammenhang vieler anderer solarer Minima mit einer Klimaabkühlung vor und nach dem Maunder-Minimum. Das Sporer-Minimum, das dem Maunder-Minimum vorausging, war ebenfalls eine Zeit der Abkühlung. Weitere Abkühlungen, die mit solaren Minima zusammenfielen, waren das Dalton-Minimum (1790 bis 1820), das Minimum von 1880 bis 1915 sowie das von 1945 bis 1977.

Abbildung 8: Sonnenflecken während des solaren Maunder-Minimums. Von 1650 bis 1700 wurden fast keine Sonnenflecken beobachtet, und die damit zusammenhängende Klimaabkühlung führte zu verheerenden Hungersnöten in Europa.

Abbildung 9: Zusammenhang zwischen solaren Veränderungen und klimatischer Abkühlung. Dem gut bekannten Maunder-Minimum sowie dem vorangegangenen Sporer-Minimum folgte das Dalton-Minimum (1790 bis 1820) sowie den solaren Minima von 1880 bis 1915 und von 1945 bis 1977. Alle solaren Minima waren mit Klimaabkühlung verbunden.

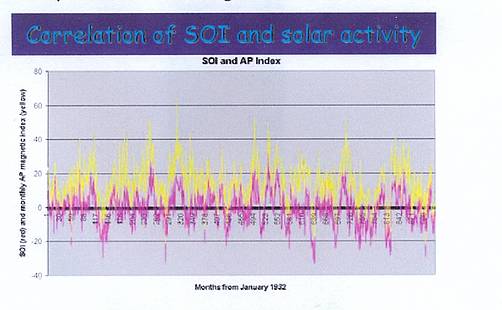

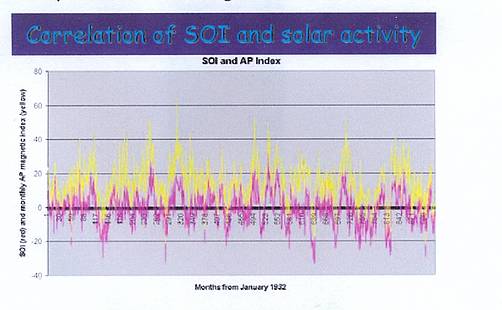

Den Zusammenhang zwischen solarer Aktivität und der Wassertemperatur in Ozeanen zeigt sehr gut Abbildung 10. Der Southern Oscillation Index SOI folgt nahezu exakt dem solaren magnetischen Index (AP) [?].

Abbildung 10: Zusammenhang zwischen dem SOI und solarer Aktivität.

Historische Fluktuationen

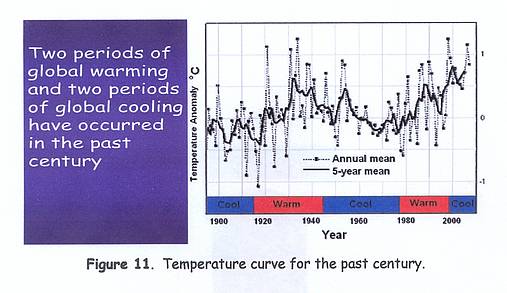

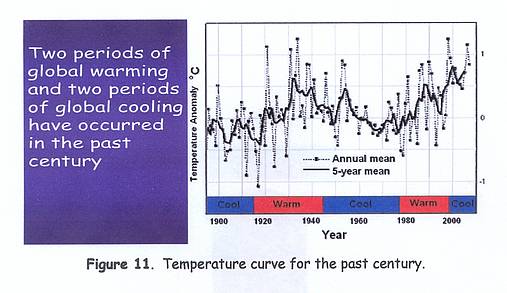

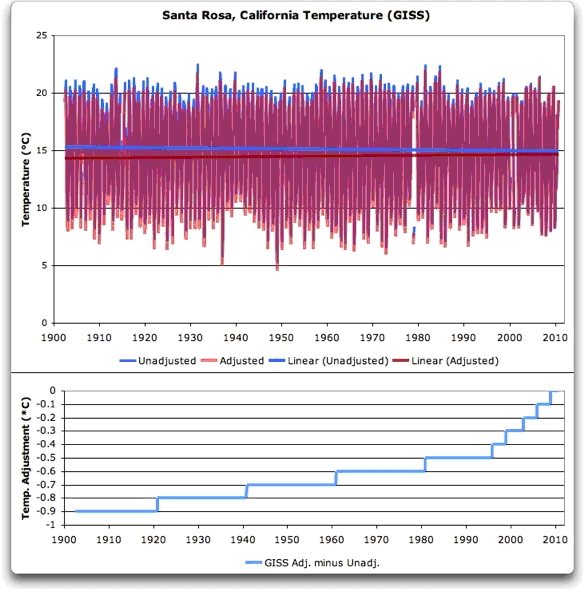

Die globale Erwärmung ist real, begann aber nicht 1945, als die CO2-Emissionen stark zunahmen. Im 20. Jahrhundert gab es zwei Perioden mit globaler Erwärmung (1915 bis 1945 und 1977 bis 1998) sowie zwei Perioden mit einer globalen Abkühlung, nämlich von 1880 bis 1915 und 1945 bis 1977. Die CO2-Emissionen begannen nach dem 2. Weltkrieg stark zu steigen, wurden aber von einer globalen Abkühlung anstatt einer Erwärmung der folgenden 30 Jahre begleitet. Die frühere Periode der Erwärmung von 1915 bis 1945 ereignete sich vor dem rasanten Anstieg des CO2 in der Atmosphäre.

Abbildung 11: Temperaturverlauf des vergangenen Jahrhunderts.

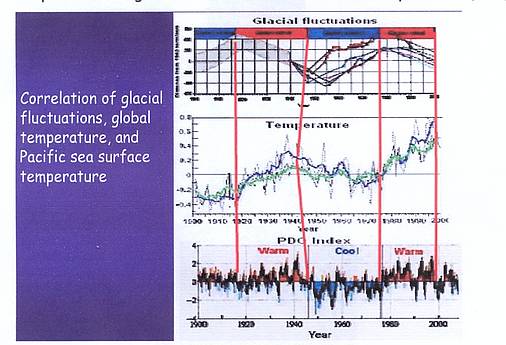

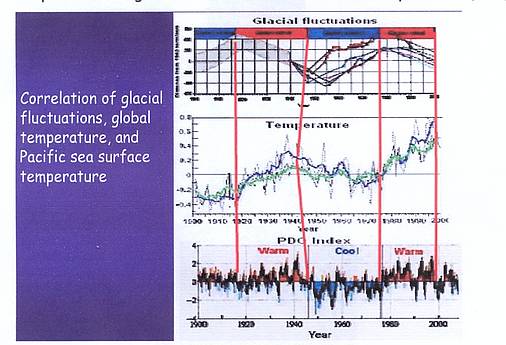

Während jeder der beiden Erwärmungsphasen zogen sich die alpinen Gletscher zurück, um in den beiden Perioden mit Abkühlung jeweils wieder vorzustoßen. Der zeitliche Verlauf der Gletschervorstöße und –rückzüge entspricht nahezu perfekt den globalen Temperaturänderungen und mit den Wassertemperaturen im Pazifik (PDO).

Abbildung 12: Zusammenhang zwischen den Fluktuationen der Gletscher auf dem Mt. Baker im US-Bundesstaat Washington mit der globalen Temperatur und der PDO.

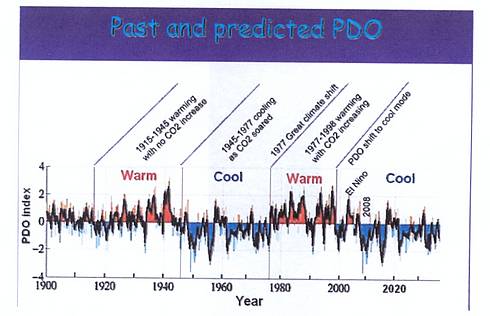

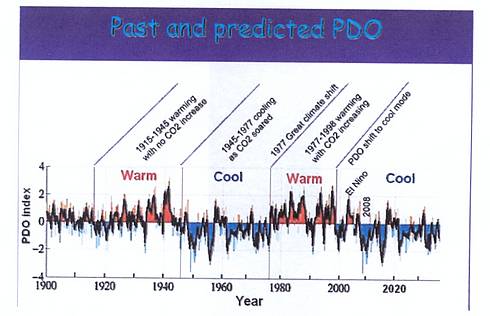

Die pazifische dekadische Oszillation PDO

Der Pazifische Ozean hat zwei Zustände (Modi), einen warmen und einen kalten, die regelmäßig wechseln in einem Zyklus, der etwa 25 bis 30 Jahre dauert. Dies ist bekannt unter dem Begriff Pazifische Dekadische Oszillation PDO. Befindet sich die PDO im Warmmodus, erwärmt sich das Klima, befindet sie sich im Kaltmodus, kühlt sich das Klima ab. Man weiß, dass Fluktuationen von Gletschern durch Klimaänderungen hervorgerufen werden, die wiederum durch die Wassertemperaturen (PDO) angetrieben werden, aber der zugrunde liegende Mechanismus der PDO ist noch nicht sicher verstanden. (Abbildung 13).

Abbildung 13: Gletschervorstöße und –rückzüge, die durch die Wassertemperatur der Ozeane beeinflusst werden. Es scheint Beweise dafür zu geben, dass die Temperatur der Ozeane durch die solare Variation beeinflusst werden, aber das muss noch näher untersucht werden.

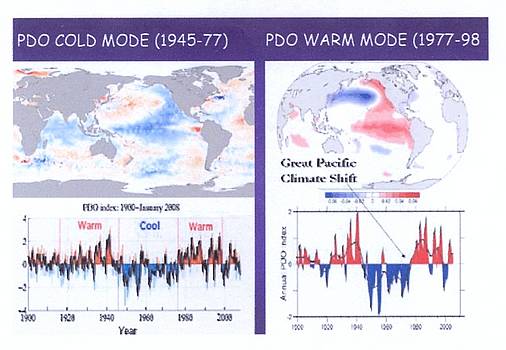

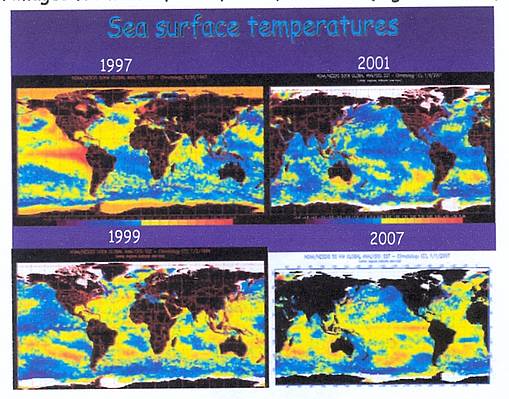

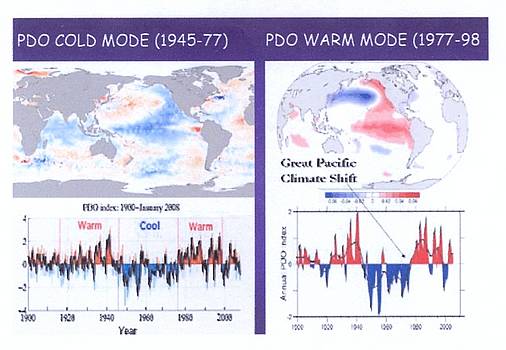

Beispiele für die beiden PDO – Zustände zeigt Abbildung 14. Im Kaltmodus der PDO sind die Temperaturen im Ostpazifik niedrig (dargestellt in blau). Dies war typisch für die globale Abkühlung von 1945 bis 1977. Der abrupte Wechsel vom kühlen in den warmen Modus innerhalb eines einzigen Jahres (1977) wurde „die große pazifische Klimaverschiebung“ genannt [Great Pacific Climate Shift]. Die Graphik im unteren Teil der Abbildung zeigt, wie der Wechsel zwischen den beiden Modi im vergangenen jahrhundert erfolgt war. Es zeigt sich eine direkte Korrelation zwischen dem Modus der PDO und der globalen Temperatur.

Abbildung 14: Beispiele für die Kaltphase der PDO (1945 bis 1977) und der Warmphase (1977 bis 1998).

Die Phasenänderung der PDO von warm nach kalt im Jahre 1999

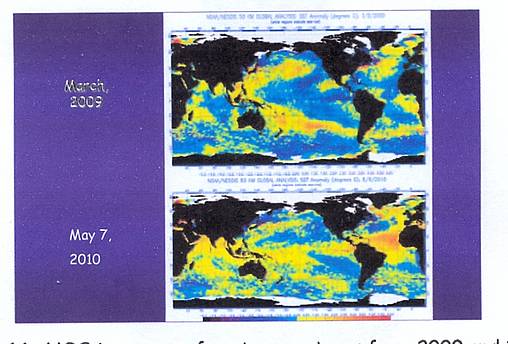

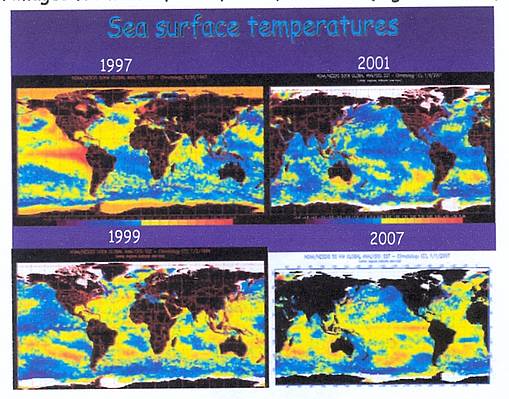

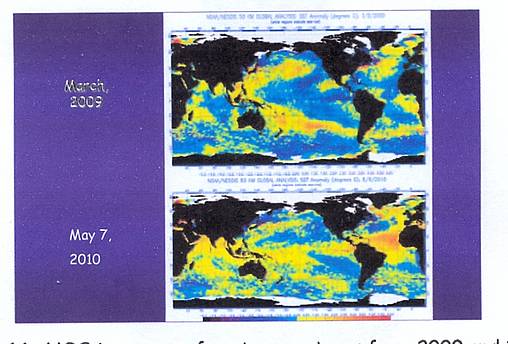

Die Wassertemperatur im Ostpazifik vor der nordamerikanischen Küste war warm im Jahre 1997 (Abbildung 15). 1999 ging die Warm- in die Kaltphase über und verharrte seitdem in diesem Zustand, wie die Teilbilder von 2001, 2007, 2009 und 2010 zeigen (Abbildungen 15 und 16).

Abbildung 15: NOAA – Satellitenbilder mit Aufnahmen, die zeigen, wie die PDO 1999 von der Warm- in die Kaltphase übergegangen war. Orange und gelbe Töne repräsentieren wärmeres und blaue Töne kühleres Wasser.

Abbildung 16: NOAA – Bilder der Wassertemperatur in 2009 und 2010.

Aussichten für die kommenden Jahrzehnte

Die Extrapolation des Verhaltens der PDO des ersten Jahrzehnts dieses Jahrhunderts für das restliche Jahrhundert zeigt interessante Verhältnisse. Die Warmphase von 1915 bis 1945, die Kaltphase von 1945 bis 1977, die Warmphase von 1977 bis 1998 und die erneute Änderung von warm nach kalt 1999 passen allesamt zu globalen Klimaänderungen und lassen mit hoher Wahrscheinlichkeit Folgendes vermuten:

-

Die PDO weist einen regelmäßigen Rhythmus auf mit einem Wechsel von warm nach kalt und umgekehrt alle 25 bis 30 Jahre.

-

Die PDO passte genau zu jeder einzelnen Klimaänderung im vorigen Jahrhundert und kann als ein Instrument zur Vorhersage (Prädiktor) genutzt werden.

-

Seit dem jüngsten Wechsel von warm nach kalt im Jahre 1999 lagen die Temperaturen nie mehr höher als 1998, dem Höhepunkt der letzten Warmphase.

-

Jedes Mal, wenn die PDO von einem Modus in den anderen gewechselt hatte, blieb sie in diesem Modus für 25 bis 30 Jahre. Daraus folgt, dass sie nach dem Wechsel in die Kaltphase 1999 zweifellos noch einige Jahrzehnte in der Kaltphase verharren wird (Abbildung 17).

-

Da die PDO also wohl noch mehrere Jahrzehnte in der Kaltphase verharrt, kann man genauso viele Jahrzehnte einer globalen Abkühlung erwarten.

Abbildung 17: Veränderungen der PDO im vergangenen Jahrhundert. Weil die PDO 1999 in die Kaltphase gewechselt hat, deutet die logische Extrapolation der Graphik darauf hin, dass sich die globale Abkühlung verstärkt und noch einige Jahrzehnte anhalten wird.

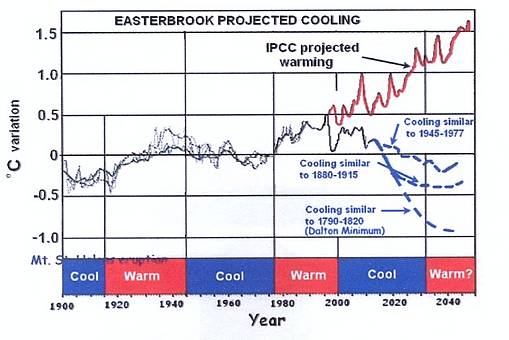

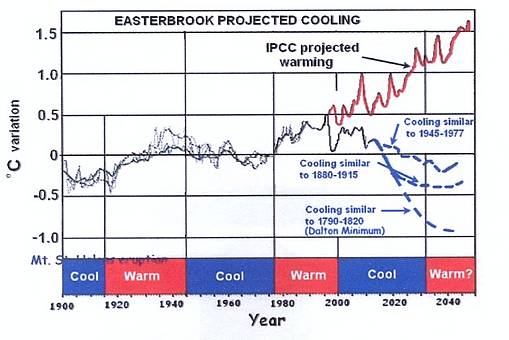

Im Jahre 2000 hat das IPCC eine globale Erwärmung um 0.5 K pro Jahrzehnt und eine globale Erwärmung um 5 K bis zum Jahr 2100 vorhergesagt. Die rote Linie in Abbildung 18 zeigt die Vorhersage des IPCC von 2000 bis 2050. Man beachte, im Jahre 2010 sollte es bereits 0.5 K wärmer sein als 2000. Dies war aber nicht so, und die Rechnungen des IPCC lagen schon bei der Berechnung der ersten 10 Jahre daneben.

Die blauen Kurven der angenommenen globalen Abkühlung in Abbildung 18 basieren auf den vergangenen Verhältnissen der PDO und auf dem Temperaturverlauf der letzten 500 Jahre. Drei mögliche Szenarien werden gezeigt: (1) globale Abkühlung ähnlich wie in den Jahren 1945 bis 1977, (2) globale Abkühlung ähnlich der Jahre 1880 bis 1915, (3) globale Abkühlung ähnlich dem Dalton-Minimum von 1790 bis 1820.

Abbildung 18: Angenommene Temperaturentwicklungen bis 2050. Die rote Kurve zeigt die IPCC-Rechnung aus dem Jahr 2000. Blaue Kurven zeigen den Temperaturverlauf basierend auf den Variationen der PDO im vergangenen Jahrhundert und dem Temperaturverlauf der letzten 500 Jahre.

Die Aussicht, dass die Temperatur bis auf ein Niveau ähnlich dem Dalton-Minimum zurückgehen könnte, basiert auf der kürzlichen Änderung der solaren Aktivität von einem solaren Großen Maximum zu einem solaren Minimum ähnlich wie im Dalton-Minimum. Der ungewöhnlich lange Sonnenzyklus 23 und dessen magnetischer Index lassen die Möglichkeit dass ein solches Minimum ähnlich wie zur Zeit des Dalton-Minimums sehr wahrscheinlich ist. Eine vierte Möglichkeit besteht darin, dass wir uns einem Minimum vom Typ des Maunder-Minimums nähern mit einer weiteren Kleinen Eiszeit. Die Zeit wird zeigen, welche Kurve der Realität entspricht.

Auswirkungen einer globalen Abkühlung

Dass die globale Erwärmung vorbei ist, zumindest für die nächsten Jahrzehnte, scheint eine Erleichterung zu sein. Die schlechte Nachricht ist jedoch, dass eine globale Abkühlung viel schlimmere Folgen für die Menschen hat als eine globale Erwärmung und ein Grund für noch größere Sorgen ist, und zwar aus folgenden Gründen:

- Einer jüngeren Studie zufolge kommen durch extreme Kälte doppelt so viele Menschen ums Leben wie durch extreme Hitze.

- Globale Abkühlung hat auf die Produktion von Nahrungsmitteln infolge kürzerer und kälterer Wachstumsphasen sowie schlechtes Wetter während der Ernte einen sehr negativen Effekt. Dies ist jetzt schon im Mittleren Westen der USA, in China, Indien und anderen Orten in der Welt der Fall. Am härtesten wird es die Staaten der sog. Dritten Welt treffen, die jetzt schon vielfach Hunger leiden.

- Zunahme des Energieverbrauchs pro Kopf, besonders zu Heizzwecken.

- Verschlechterung der Möglichkeiten, mit der Bevölkerungsexplosion umzugehen. Die Weltbevölkerung wird bis 2050 auf 9 Milliarden Menschen wachsen, eine Zunahme um 50%. Dies bedeutet eine substantielle Zunahme des Bedarfs an Nahrung und Energie, und zwar in einer Zeit, in der beides wegen des sich abkühlenden Klimas immer weniger zur Verfügung steht.

Schlussfolgerungen

Zahlreiche, abrupte, kurzlebige Warm- und Kaltphasen, viel intensiver als die gegenwärtige Erwärmung/Abkühlung, ereigneten sich während der letzten Eiszeit, von denen keine einzige durch Änderungen des atmosphärischen CO2-Gehaltes ausgelöst wurde.

Klimaänderungen in geologischen Aufzeichnungen zeigen ein regelmäßiges Muster von Erwärmung und Abkühlung mit einer Periode von 25 bis 30 Jahren während der letzten 500 Jahre.

Starke Korrelationen zwischen Änderungen der solaren Strahlung, der PDO, Gletschervorstößen und –rückzügen und das globale Klima gestatten es, ein konsistentes Muster in die Zukunft zu extrapolieren.

Die angenommene Abkühlung während der nächsten Jahrzehnte basiert auf Mustern der PDO im vorigen Jahrhundert und des Temperaturverlaufs der letzten 500 Jahre. Drei mögliche Szenarien lassen sich ableiten: (1) globale Abkühlung ähnlich wie in den Jahren 1945 bis 1977, (2) globale Abkühlung ähnlich der Jahre 1880 bis 1915, (3) globale Abkühlung ähnlich dem Dalton-Minimum von 1790 bis 1820.

Zu erwarten ist eine globale Abkühlung der nächsten 2 bis 3 Dekaden, die weit schlimmere Folgen haben wird als es eine globale Erwärmung je hätte.

Kommentar des Übersetzers zu diesem Text

Obwohl es sich hier eindeutig um eine hoch seriöse wissenschaftliche Studie handelt, so fehlt doch jede Wortschwurbelei. Die Aussagen sind allgemein verständlich, klar, präzise und werden auch noch schlüssig nachvollziehbar hergeleitet. Diese Studie sollte auch Nichtfachleuten gut verständlich sein.

Behandelt wird das Verhalten der PDO durch die Jahrhunderte, was dann in Beziehung gesetzt wird zur Klimaentwicklung. Die gerade begonnene Kaltphase der PDO sollte zu einer Abkühlung führen. Erst am Schluss kommt der Autor auf den zeitlichen Zusammenhang mit den sehr schwachen solaren Aktivitäten, die für sich allein in der Vergangenheit ja ebenfalls Kaltphasen des Klimas zur Folge hatten. Nun trifft also beides zusammen – für den Übersetzer ist dies der zentrale Punkt dieser Studie. Der Autor weist am Ende auch auf die negativen Folgen kälteren Klimas hin. Es ist eine Schande (a travesty!), dass weder Politik noch Medien diese Bedrohung auch nur ansatzweise ernst nehmen, und dass es immer noch Institutionen gibt, die das längst vielfach wissenschaftlich widerlegte Gespenst der globalen Erwärmung kolportieren!

Prof. Dr. Don Easterbrook

Übersetzt und kommentiert von Chris Frey EIKE

Abbildung 3

Abbildung 3