„Ein hochrangiger deutscher Politiker aus einer großen Volkspartei….„… und wenn es die Klimakatastrophe nicht gäbe, dann müsste man sie erfinden, um die Menschen dazu zu bringen, Dinge zu tun, die wir für richtig halten.“

(Die Grundidee dieses Satzes soll von Voltaire stammen: Wenn es keinen Gott gäbe, so müsste man ihn erfinden“; allerdings soll Voltaire auch gesagt haben: „Ja weniger Aberglaube, desto weniger Fanatismus, desto weniger Unheil“. Ich hoffe nur, dass unser Politiker dies auch wusste)

Meine Frau und ich haben in dreißig Ehejahren eine sehr nützliche Übereinkunft getroffen: Wenn wir Gefahr laufen, wegen Sachen, die wir uns unbedacht sagen, aneinander zu geraden, dann muss der, der gerade was Blödes vom Stapel gelassen hat, den Satz noch dreimal laut sagen – in aller Regel erkennen wir dann, was gerade schief läuft, müssen meist drüber lachen. Und alles ist gut.

Ich bat diesen Politiker, das auch zu tun – aber er verstand nicht, was ich damit wollte.

Meine Damen und Herren, das ist genau der Punkt.

Diese Aussage unseres Politikers ist so absolut zynisch, so demagogisch und offenbart – selbst wenn man sie nur einmal hört – einen höchst alarmierenden Sinn hinter all dem Gedöns von Erderwärmung, CO2 und anderen Katastrophen: arrogante Machtpolitik.

Eine zweite Sache hat mich dann aber völlig aus dem Häuschen gebracht. Nicht nur, dass ich eine Reihe bezeichnender Zitate von Journalisten aller Couleur, aus Presse, Fernsehen, Internet usw. vorzeigen könnte, die von „einer CO2-freien Welt“ (wortwörtlich!) als erstrebenswertes Ziel aller Anstrengungen schwätzen, nein, dieser gefährliche Unsinn wird per politisch sanktioniertem Lehrplan in den staatlichen Schulen auch unseren Kindern übergeholfen.

Ich habe mir die einschlägigen Unterrichtsmaterialen des sächsischen Kultusministeriums für Lehrer besorgt. Mit diesen verbindlichen Vorgaben sollen den Schülern in einer poppig aufgemachten Art und Weise die Gefährlichkeit des Giftgases CO2-vorgeführt werden. Die Zukunft unserer Erde und auch die der unmittelbaren Heimat wird in den düstersten Farben gemalt (Dürren, Seuchen, Hungersnöte, Naturkatastrophen, Kriege usw.) und es wird nützliche Handreichung gegeben, wie und mit welchen Argumenten gegen feindliche „Klimaskeptiker / Klimaleugner“ vorzugehen sei.

Doch, meine Damen und Herren,

was wissen wir tatsächlich?

Was müssen wir tatsächlich tun?

Nun, zunächst sollten wir uns immer vor Augen führen, dass das „Teufelsgas“ CO2 einerseits ein Spurengas ist (also wie schon der Name sagt, nur in geringen Spuren vorkommt) und andererseits ein für uns äußerst wichtiges Gas darstellt: Die Existenz der gesamten Pflanzen- und Tierwelt – auch die des Menschen – hängt nämlich vom Vorhandensein dieses „Killergases“ ab. Es ist (in den vorkommenden Spuren-Konzentrationen) also weder gefährlich noch giftig. Eine CO2-freie Atmosphäre würde uns töten. Eine „CO2-freie Zukunft“ müssen wir unbedingt verhindern!

Die Frage ist, wie groß muss und darf der Anteil dieses Gasen in der Atmosphäre sein und was ist „normal“?

Die beschämende Antwort auf diese Frage ist: Wir wissen es nicht.

Gehen wir dem weiter nach, so sehen wir, dass Messungen, die nicht in die eine oder anderer Richtung „zurechtgebogen“ sind, ganz unterschiedliche Konzentrationen in der Vergangenheit und heute belegen. Grundsätzlich muss natürlich beim Vergleich von Daten geklärt werden: wie man misst und wie vergleichbar die Messmethoden und wie groß ihre Fehlerbandbereiten sind.

Dennoch, aus seriösen Recherchen erkennt man leicht: in der Atmosphäre (also in „Freier Umgebung“ – hier drinnen werden wir sicher schon bei 4000 ppm sein…) scheinen Konzentrationen von 250 bis über 1400 ppm in der erdgeschichtlichen Vergangenheit, in historischer, vorindustrieller Zeit und auch heute keine ungewöhnlichen Zahlen zu sein. Selbst in den letzten 200 Jahren schwankten die gemessenen Werte zwischen 450 und 290 ppm.

Man misst heute im Observatorium auf dem Vulkan Mauna Loa rund 380 ppm (die berühmte, seit Mitte der 50-iger Jahre ansteigernde Kurve).

Die nächste und wie mir scheint, die grundlegendste Frage ist, beeinflusst diese im ppm (Part per Million) Bereich liegende CO2-Konzentration die Temperatur der Erdatmosphäre? Auch hier zeigen verschiedene direkte Messungen …

(ach übrigens, wer weiß, seit wann es überhaupt Thermometer und eine richtige Grad-Skala gibt? – seit Fahrenheit 1715)

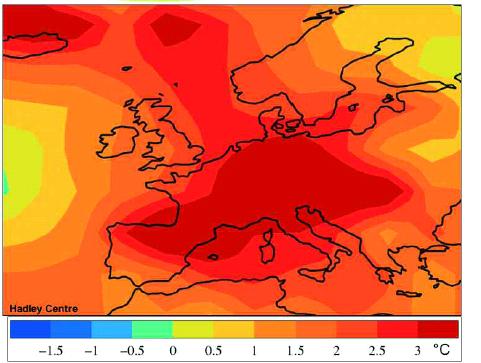

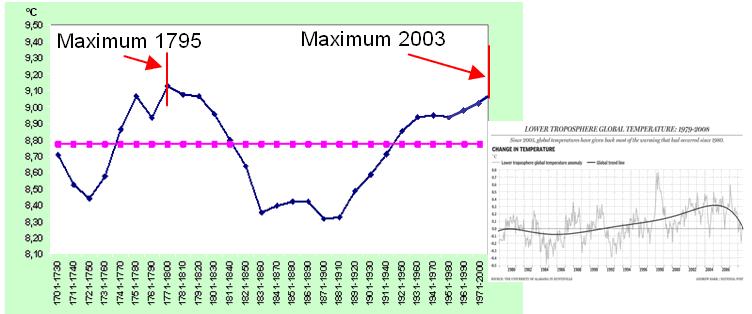

… und indirekte Temperaturermittlungen, dass es z.B. vor 3600 Jahren rund 1 grad wärmer war, als heute, dafür 200 Jahre später (vor 3400) 1,5 grad kälter. Was immerhin einen Temperatursturz von 2,5 grad in 200 Jahren bedeutete – und zu dieser Zeit gab´s nur ganz wenige Menschen und keine Autos und vor allem keine Klima-Rettungsaktion.

Um solche Temperatur-Schwankungen zu erklären, wird gewöhnlich mit dem sogenannten Treibhauseffekt argumentiert und wenn man die damit zusammenhängenden Veröffentlichungen auf der „Klimaschützer“-Seite durchforstet, scheint alles völlig klar zu sein.

Die tatsächliche Antwort auf diese Frage ist aber ebenso überraschend und beschämend, wenn man die ganze Literatur durchkämmt, wie die zur Normal-Konzentration von CO2: wir wissen es nicht.

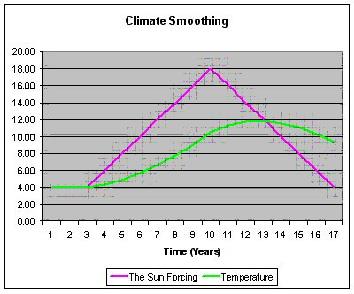

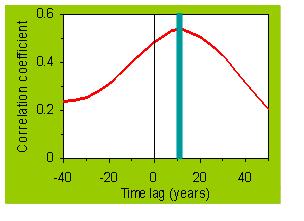

Wir wissen nicht genau, wie CO2 als „Klimagas“ im komplexen System der Atmosphäre insgesamt wirkt. Und es existiert kein wissenschaftlich verifizierbarer und falsifizierbarer Zusammenhang zwischen CO2-Gehalt und Temperatur. Das, was wir aufstellen sind Korrelationsvermutungen – und die können auch z.B. so gedeutet werden, dass die CO2-Konzentration in der Atmosphäre der Temperatur folgt und nicht umgekehrt.

Mich als gelernter Experimentalphysiker verwundert dabei besonders, dass mir trotz intensiver Recherche und Anfragen an ein paar meiner Physiker-Kollegen bislang kein ernstzunehmendes Experiment zur Wirkung des CO2 als „Treibhausgas“ bekannt geworden ist.

Aber verdammt, viele Leute scheinen doch ganz genau zu wissen, dass das Klima über kurz oder lang kollabieren wird, wenn wir nichts dagegen tun: sprich das weitere „Einblasen“ von CO2 in die Atmosphäre, koste es, was es wolle, unterbinden. Wozu denn sonst die gewaltigen Ausgaben für Klimaforschung, die großen und teuren Klimakonferenzen, die heiß umkämpften politischen Vereinbarungen, die dringenden Appelle usw.

Woher kommt die Mär von den 2 grad, die wir dem Klima noch zubilligen und die sich z.B. auch unsere Diplomphysikerin Merkel als Grenzziel setzt?

Tja,

auch das beruht nicht auf gesichertem Wissen. Es ist allenfalls eine Annahme.

Allerdings wissen wir genau, wer sie verbreitet und wer sie als politisches Programm aufgenommen hat und wer nun seine Volkswirtschaft und seine Steuerzahler dafür bluten lässt und wer damit schon jetzt steinreich geworden ist.

Alle, aber auch wirklich alle diese „Vorhersehungen“, oh, Verzeihung, „Vorhersagen“ sind Ergebnisse von Computer-Modellen, basierend auf komplexen, chaotischen Systemen, basierend auf dem nicht genauen Wissen über Treibhauseffekte und auf immer noch nicht genau bekannten CO2- und anderen Gas-Kreisläufen (Wasserdampf) im Boden, im Ozean und in der Atmosphäre.

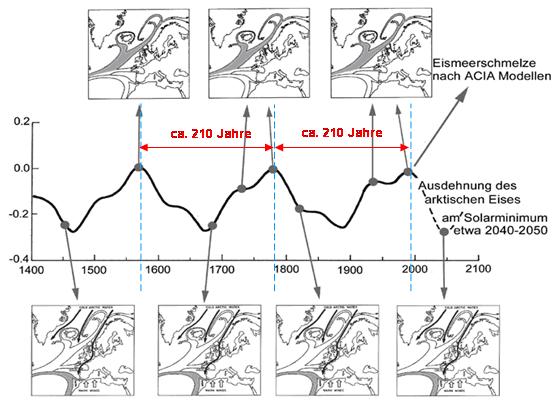

Allerdings ist völlig klar: Wetter (lokales, globales und damit auch Klima – im strengen statistischen Sinne) unterliegt einer ständigen Veränderung. Und diese Veränderung findet mal schnell und mal langsam statt. Das kann man ohne großartige Messungen und Computerprogramme in und an der Natur (Pflanzenwelt, Tierwelt, Landwirtschaft, Seefahrt, Handelstraßen usw.) sehen, erleben, und nachvollziehen. Eigentlich wäre es sogar äußerst merkwürdig, wenn das nicht geschähe. Das Problem ist nur: aus unerfindlichen Gründen sind die heute lebenden Menschen auf „Statik“ getrimmt und jede (natürliche) Veränderung wird deshalb als Bedrohung aufgefasst. Früher freuten sich die Leute, wenn es wärmer wurde – heute haben sie davor panische Angst.

Liebe Freunde,

Nichtwissen, kann durch Wissen ersetzt werden, indem man misst, forscht, nachdenkt und rechnet.

Das ist Sinn der exakten Naturwissenschaften.

Aber leider gibt es auch eine bittere Erkenntnis, die im Lauf der langen Geschichte menschlicher Kultur immer wieder gewonnen werden musste:

Nichtwissen wird durch Halbwissen, durch „Konsens“ von Laien und letztlich durch Glauben ersetzt, was dazu führt, dass nur noch das gemessen wird, was die Priester voraussagen. Die „treuen“ Forscher beforschen eifrig die Wahrheit der reinen Lehre ihrer Religion und das damit nicht konforme Denken wird erst ausgegrenzt, dann verpönt und schließlich unter Strafe gestellt und geahndet – Ungläubige werden identifiziert, zu Ketzern erklärt. Im Mittelalter wurde so was in Europa unter dem Jubel der Masse auf Scheiterhaufen verbrannt.

Ich habe den merkwürdigen Eindruck, dass wir ohne auf diese Lehre aus unserer Vergangenheit zu achten, heutzutage feste dabei sind, diesen alten Holzweg neu zu beschreiten. Und Alle machen mit. Oder zumindest fast Alle.

Ja es ist ganz lustig, da machen sogar die mit, die es eigentlich aus eigenem Verständnis nicht tun sollten.

Da stellen sich z.B. bedeutende Wirtschaftsunternehmen, deren aktenkundiger Geschäftszweck die profitable Produktion und der steigende Absatz von Energie ist, an die Spitze von Energie-Einsparungsaktionen.

Da ist ungefähr so, als ob Volkswagen anstelle einer Abwrackprämie eine „Auto-Vermeidungsprämie“ fordern würde.

OK, das war nicht fair. Also Spaß beiseite, kommen wir auf unseren Politiker vom Anfang zurück.

Ich fragte ihn weiter, was denn das Richtige sei, was „unseren Menschen“ beigebracht werden müsse, was sie aus Unkenntnis denn nicht verstünden?

Nun, er rückte mit der Forderung nach Umweltschutz raus. Und letztlich warf er das Menetekel der Erschöpfung aller fossilen Energieträger, Gas, Kohle, Erdöl in die Wagschale seiner Argumente, beklagte das mangelnde Bewusstsein der „Verbraucher“ was den Einsatz von Energie betrifft und die mangelnde Energieeffizienz der heutigen Technik.

Hm. Dagegen kann man ja nun wahrlich nichts sagen!

Umweltschutz ist immer gut, Energieeffizienz auch.

Doch fangen wir nochmals von Vorne an.

Die Erde ist ein relativ offenes System und gleichzeitig auch ein relativ geschlossenes.

Offen, was die energetische Wechselwirkung mit dem Kosmos, insbesondere mit unserer Sonne betrifft, geschlossen, was den Kreislauf von mit Masse behafteten Stoffen betrifft.

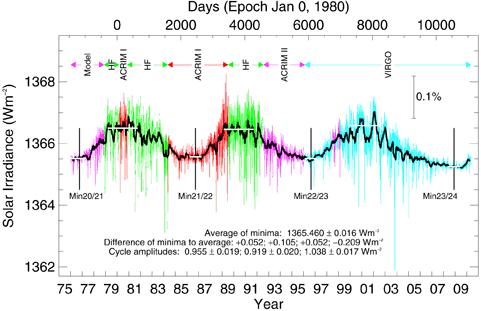

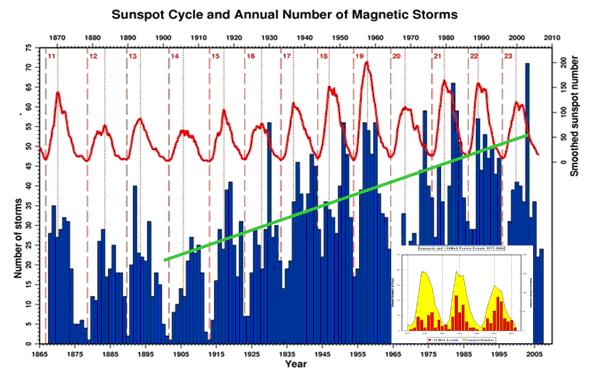

Insofern werden wir unentwegt mit einer (im Vergleich zu unserem Verbrauch) riesiger Menge an Energie „bombardiert“, die auch praktisch gleichzeitig unseren Planeten fast wieder vollständig verlässt. Das, was zeitweilig als Rest hier bleibt, heizt einerseits den Planeten und dessen Atmosphäre auf das uns heute bekannt Maß als Gleichgewichtszustand auf. Andererseits speichern Gesteine, Wasser, Luft, Pflanzen und Tiere die ankommende Sonnenenergie in ganz verschiedenen Formen und Zeiträumen.

So weiß man, dass Kohle gespeicherte Sonnenenergie in Form verrotteter Pflanzen ist. Bei Erdöl und Gas weiß man es – und das ist auch wiederum ganz verblüffend – nicht so ganz genau. Ja natürlich, in der Schule lernt man, dass dies auch nur Produkte aus Pflanzen- und Tierresten sind. Aber auch hier werden durchaus ernste Zweifel angemeldet. Und mir ist bekann, dass Ölfirmen in Tiefen bohren, in denen die „biologische“ Entstehungstheorie große Mühe hat, die gefundenen Vorkommen zu begründen.

Auch der heute meist verwendete Brennstoff für unsere Atomkraftwerke ist nichts anderes als ein Energiespeicher – allerdings stammt dessen Energiegehalt aus ganz frühen Anfängen des Sonnensystems, bzw. des uns bekannten Kosmos.

Egal. Dem vernünftigen Menschen leuchtet ein: Wenn der Tagebau leer ist, ist er leer und neue Kohle kommt da nicht wieder rein – jedenfalls nicht zu unseren Lebzeiten. Kurz die Endlichkeit fossiler Energieträger ist zumindest ein richtiger Denkansatz, wenngleich die Zeiträume bis zur Erschöpfung nicht kurz sein werden, wie immer mal wieder panisch gewarnt – aber das ist prinzipiell unwichtig.

Das Problem, vor dem wir hier stehen ist, dass die Stoffkreisläufe (der Kohlenstoff-Kreislauf), die zur Bildung von Kohlenstoff-Reserven in Form fossiler Träger führen, in riesigen Zeiträumen stattfinden, angetrieben durch die Sonnenenergie. Wir aber greifen mit unserer Energiegewinnung und den damit verbundenen Stoff- und Energiewandelungsprozessen nur in einem klitzekleinen Zeit-Ausschnitt massiv ein. Wir erzeugen damit diskontinuierlich Prozess-Produkte in Spitzenkonzentrationen, die uns in den kurzen Zeitspannen ihrer Freisetzung, gemessen am langen Zeitraum ihrer Entstehung eben Probleme bereiten.

Kurz: Wenn wir davon ausgehen, dass die wirkliche Herausforderung nicht das sich völlig unabhängig von der Tätigkeit des Menschen ständig durch kosmische Kräfte verändernde Wetter (hier als statistische Größe Klima genannt) ist, sondern die umweltschonende Bereitstellung von Energie für die zivilisatorische und kulturelle Entwicklung der gesamten Menschheit auf der Erde, dann sind wir wieder völlig beieinander.

Wir können das Klima nicht schützen und das Wetter (Temperatur, Luftdruck, Luftfeuchte, Wolken, Niederschlag usw.) wahrscheinlich global auch nicht beeinflussen, ganz sicher aber die Umwelt. Und Beides sind völlig verschiedene Sachen.

Ein Freund sagte mir vor kurzem mit Blick auf diese unsägliche CO2-Hysterie: wir haben kein CO2-, sondern ein C-Problem: Wir verfeuern derzeit kostbare und vielleicht tatsächlich endliche, sehr billige und gut verfügbare C-Träger, die wir viel besser für Chemieindustrie und Pharmaherstellung verwenden könnten. Das ist – bei dieser Gelegenheit gesagt, auch wahr und ein bisschen beschämend, wenn uns außer Verbrennung nichts Besseres für diesen Schatz einfällt.

Also dreht sich alles um eine zukunftsfähige, die Umwelt nicht negativ beeinflussende, weltweite, unsere Kohlenstofflager schonende, ausreichend große Energieproduktion.

Energie, die wir dringend benötigen.

Energie, deren Verbrauch nicht deswegen steigen wird, weil die „armen Länder“ auch eben nur mal so viel konsumieren wollen wie wir, sondern weil sich das Kulturniveau aller Menschen anheben und auf hohem Niveau über die ganze Erde hinweg ausgleichen wird.

Es ist gerade die Energieproduktion, die wir nicht mehr „abstellen“ können, weil sie der Antrieb und die Grundlage für unsere zivilisatorische Entwicklung geworden ist. Energie sinnvoll einzusetzen ist die eine Seite, d.h. alle Entwicklungen, die energieeffizientere Technologien (Produktion, Verkehr, Logistik und Verbrauch) zum Ziel haben, sind richtig im ethischen Sinn und dies ist sicher auch eine große Chance für viele mittelständische Unternehmen.

Aber es geht auch um alternative Energieproduktion, um Energietransport und Speicherung, um den zukünftigen Energiehunger der Weltbevölkerung zu stillen. Und dieser „Hunger“ darf nicht als negative Forderung verstanden werden, sondern als Herausforderung an Wissenschaft und Technik.

Denn dieser „Energie-Hunger“ ist der messbare Ausdruck unserer kulturellen Fortentwicklung. So, wie der Hunger eines menschlichen Individuums nach energiereicher Nahrung Ausdruck des Energieverbrauchs seines Körpers und insbesondere seines Gehirns ist.

Kommen wir noch kurz auf die scheinbare Lösung des Energieproblems durch Kernfusion.

Wahrscheinlich werden wir in wenigen Jahren in der Lage sein, ein solches Kraftwerk zu bauen und in Betrieb zu nehmen. Es würde eine riesengroße Menge an Elektroenergie produzieren. Aber es löst zwei Probleme nicht: den verlustreichen Transport von Elektroenergie über große Entfernungen und die Aufheizung der Erde – nicht durch atmosphärische Spurengase – sondern durch tatsächliche Aufheizung des Mantels infolge einer Energieproduktion zusätzlich zur (gespeicherten oder ständig einfallenden) Sonnenenergie, mit der unsere Erde im Gleichgewicht steht, auch wenn wir sie in Energie-Umwandlungsprozesse einbeziehen und Arbeit verrichten lassen. Außerdem würden nur wenige Kraftwerke an zentralen Stellen nötig und finanziell möglich sein.

Wer garantiert dann bei der heutigen politischen Weltlage die Durchleitung und den sicheren Betrieb?

Also vergessen Sie die Kernfusion. Lassen Sie sich von der Sonne „erleuchten“.

Hier hat die Natur nur leider ein großes Problem für uns parat: die Energiedichte ist sehr klein – zu klein für die heutige Technologie der Sonnenenergiegewinnung. Und zu allem Verdruss gibt es sowohl Tag und Nacht und Wolken, Sturm und Windstille. Da Wind und fließendes Wasser, aber auch Pflanzen ja auch nichts Anderes als Energie-Träger der Sonnenenergie sind, ist bei allen diesen Sachen die Herausforderung gleich und mit heutigen technischen Mitteln ist nur die Wasserkraft sinnvoll im Sinne von Aufwand und Nutzen und kontinuierlicher Verfügbarkeit im Vergleich zu Kohle, Erdöl, Gas und Uran.

Anstatt also Milliarden und aber Milliarden zu verschwenden, um 100-Watt-Glühlampen zu verbieten und CO2-Abgase in Bergbaustollen zu verstecken, anstatt teure Silizium-Platten auf Scheunendächern zu entsorgen und Landschaften mit hässlichen Windmühlen zu verschandeln, deren Existenz allein von der gewaltigen Subventionierung durch den Steuerzahler abhängt, muss es eine Rückkehr zur wissenschaftlichen und ingenieurtechnischen sowie zur wirtschaftlichen und letztlich politischen Vernunft geben.

Es muss tatsächlich alles daran getan werden, die auf die Erde einfallende Sonnenenergie als praktisch unerschöpfliche und riesige Energiequelle „anzuzapfen“. Aber leider scheinen eben die heute eingesetzten Technologien dafür nur bedingt geeignet zu sein.

In diesem Zusammenhang muss auch Alles auf den Prüfstand, was mit dem heutigen Energie-System in Verbindung steht und was Ideen für die Zukunft liefern könnte. Zum Beispiel halte ich es für sehr angebracht darüber nachzudenken, ob es nicht besser wäre, statt der kontinuierlichen, zentralen Energieerzeugung eine verbrauchsabhängige, also variable, dezentrale Erzeugung „vor Ort“ zu bevorzugen.

Dies würde ganz andere Denkansätze und Technologien bei Erzeugung, Transport und Speicherung ermöglichen. Also werden wir auch die Frage stellen: ja, muss es denn Strom sein, den wir zentral erzeugen und über Drähte transportieren, ohne ihn wirklich sinnvoll speichern zu können, oder könnte man mit dem Energieträger Gas (Wasserstoff) nicht viel besser auskommen und umgehen?

Aber alle diese Fragen können nur beantwortet werden, wenn wir nicht mit Demagogie, nicht mit einem machtpolitisch motivierten Schwindel, nicht mit einer wissenschaftlichen Fälschung argumentieren. Und wir sollten uns auch volkswirtschaftlich nicht in die Tasche lügen.

Denn eines ist sicher: es wird herauskommen!

Es wird herauskommen – und der Verdacht des Betruges keimt bereits -, dass die natürlichen und permanenten Veränderungen des Klimas nicht wesentlich von unserem CO2-Eintrag abhängig sind und dass alle darauf bauenden Argumente und Folgerungen falsch sind.

Dies wird die Glaubwürdigkeit der Naturwissenschaft und der Politik dermaßen massiv untergraben, dass notwendige und richtige Ansätze zur Revolution der Energiesysteme nicht mehr ernst genommen werden. Und dann, meine Freunde, dann haben wir ein richtiges Problem!

Im Gegensatz zu meinem Politiker, der mir die Stichworte für diesen Vortrag geliefert hat, glaube ich nämlich fest daran, dass nur mit der Wahrheit und nur mit ihr und nur, wenn wir uns als vernünftige Wesen auch vernünftig über die großen Fragen streiten und einigen, nachhaltig die Existenz und Entwicklung unserer Zivilisation geschützt werden kann.

Insofern freue ich mich auf die durch hocheffiziente Photosynthese-Werke gestützte, flexible Wasserstoff-Energiewirtschaft der Zukunft, die das Wort „Knappheit“ nicht mehr kennt.

Prof. Dr. Knut Löschke Leipzig

Der Vortrag erschien in leicht gekürzter Form zuerst bei der Partei der Vernunft