Genauso sträuben sie sich dagegen zu akzeptieren, dass die Temperatur vor zweitausend Jahren während der römischen Warmperiode RWP ebenfalls höher lag als heute, weil die CO2-Konzentration damals noch geringer war. Folgerichtig sprechen die Alarmisten nicht einmal von der römischen Warmperiode. Und selbst wenn, sie lehnen es ab, die Möglichkeit auch nur zu erwägen, dass diese frühen Warmzeiten global auftraten. Mit Bezug auf die MWP – von der sie hin und wieder sprechen, wenn auch verächtlich – behaupten sie stattdessen, dass es sich dabei um ein rein lokales Phänomen handelt, das auf die Gebiete rings um den Nordatlantik beschränkt war. In dieser Zusammenfassung untersuchen wir diese Zusammenhänge bzgl. der römischen Warmperiode RWP auf der anderen Seite der Nordhemisphäre, in Asien.

Wir beginnen mit der Arbeit von Ma et al. (2003), die mit einem Stalagmiten aus der Jingdong-Höhle etwa 90 km nordöstlich von Peking arbeiteten. Sie wollten die Klimageschichte der vergangenen 3000 Jahre in 100-Jahres-Schritten auf der Basis von ?18O-Daten abschätzen, dem Verhältnis zwischen Magnesium und Strontium (Mg/Sr) und der Fest-flüssig-Verteilung von Magnesium. Sie fanden heraus, dass im Zeitraum von vor 200 bis 500 Jahren „die Temperatur etwa 1.2°C niedriger lag als heute, was sehr gut zur sog. kleinen Eiszeit in Mitteleuropa passt.“ Davor, in den Jahren 700 bis 1000 n. Chr. hat es eine gleich große Abweichung zum Wärmeren gegeben mit dem Höhepunkt um das Jahr 900, was, wie sie sagen, „gut mit der MWP in Europa korrespondiert“. Dieser Wärmeperiode ging die Kaltphase des sog. „Dunklen Zeitalters (dark ages)“ voraus, die wiederum der römischen Warmperiode folgte. Der Stalagmit zeigt, dass es vor dieser RWP viel kälter war.

Zu ähnlichen Ergebnissen kamen Xu et al. (2002) , die die Variationen von ?18O in der Zellulose von Pflanzen untersuchten. Hierzu verwendeten sie Bohrkerne von Torfablagerungen am nordöstlichen Rand des Quinghai-tibetischen Plateaus in China. Sie fanden drei Kaltphasen um die Jahre 500, 700 und 900 während der Kälteperiode des Dunklen Zeitalters, die dem Abklingen der RWP folgten. [Im vorigen Absatz war da von der MWP schon um das Jahr 900 die Rede. Dies ist kein Widerspruch, wenn man bedeckt, dass die Anpassung von Pflanzen an ein anderes Klima einige Zeit dauert. A. d. Übers.] Danach, für die Jahre 1100 bis 1300, berichten sie, dass „der ?18O-Anteil aus Hongyuan in der Torfcellulose zugenommen hatte, was mit der MWP korrespondiert. Abschließend weisen sie auf drei weitere Kaltphasen in den Jahren 1370 – 1400, 1550 – 1660 und 1780 – 1880 hin, die die kleine Eiszeit spiegeln, nach der die aktuelle Erwärmung einsetzte. [Sollte hier nicht nochmals auf die ca. 100jährige Verzögerung bei den Pflanzen explizit hingewiesen werden, weil die Herren NF und NB sofort schreien werden, dass die Kleine Eiszeit ca von 1650 – 1780 dauerte und nicht 100 Jahre später war?]

In einer wesentlich breiter angelegten Studie benutzten Yang et al. (2002) neun verschiedene Proxydatenreihen aus Torf, Sedimenten in Gewässern, Eisbohrkernen, Baumringen und anderen, um einen eindeutigen Temperaturverlauf in ganz China zu erhalten, der die vergangenen zweitausend Jahre umfasst. Diese aus vielen Einzeluntersuchungen gewonnene Reihe zeigt fünf verschiedene Klimaepochen: eine Warmzeit in den Jahren 1 bis 240 (das Ende der RWP), ein kaltes Intervall in den Jahren 240 bis 800 (die Kaltzeit des Dunklen Zeitalters), eine Wiederkehr zu einer Warnzeit von 800 bis 1100 (was die mittelalterliche Warmperiode umfasst), eine weitere Kaltzeit zwischen 1400 und 1820 (die Kleine Eiszeit) und – schließlich – die jüngste Warmphase (Current Warm Period CWP), deren Erwärmung in der ersten Hälfte des 19. Jahrhunderts begann. Von größter Signifikanz war jedoch die Tatsache, dass die Studie von Yang et al eindeutig zeigte, dass die höchste Temperatur der letzten zwei Jahrtausende im zweiten und dritten Jahrhundert beobachtet wurden, also während der späten römischen Warmphase.

Eine andere breit angelegte Studie in einem großen Gebiet von China wurde von Ge et al. (2003) veröffentlicht. Sie werteten 200 verschiedene Datensätze phänologischer und meteorologischer Art aus einer ganzen Anzahl historischer Chroniken aus, von denen viele durch Gong und Chen (1980), Man (1990), Sheng (1990) sowie Wen und Wen (1996) beschrieben wurden. Damit wollten sie eine 2000-jährige Geschichte des Temperaturverlaufs in den Winterhalbjahren (Oktober bis April) in einem Gebiet in China erstellen, das zwischen 27° und 40° nördlicher Breite sowie 107° und 120° östlicher Länge liegt. Daraus konnten sie folgern, dass „sich seit Christi Geburt das Klima mit einer Rate um etwa 0.17°C pro Jahrhundert abkühlte“. Gut dazu passt, dass dies die Zeit war, in der die RWP zu Ende ging und in die Kaltzeit des Dunklen Zeitalters überging. Sie weisen außerdem darauf hin, dass um das Jahr 490 die Temperatur etwa 1°C niedriger lag als gegenwärtig (d. h. bezogen auf das Mittel der Periode 1951 – 1980).

Sie fahren fort: “Danach folgte eine warme Periode von 570 bis 1310 mit einem Erwärmungstrend von etwa 0.04°C pro Jahrhundert. Auf dem Höhepunkt dieser Erwärmung lag die Temperatur um 0.3 bis 0.6°C höher als gegenwärtig bezogen auf einen Zeitraum von 30 Jahren, jedoch über 0.9°C wärmer bezogen auf einen Zeitraum von 10 Jahren.“ Dieses Ergebnis spricht sehr für sich selbst: während der mittelalterlichen Warmphase war es in diesem großen Gebiet von China wärmer als jemals in modernen Zeiten in einem ähnlichen Zeitraum.

Ge et al. stellten weiterhin fest, dass „nach dem Jahr 1310 die Temperatur rasch mit einer Rate von 1.0°C pro Jahrhundert zurück ging; die mittlere Temperatur der vier Kaltzeiten lag um etwa 0.6 – 0.9°C niedriger als gegenwärtig; auf dem Tiefpunkt dieser Kaltphase bis 1.1°C niedriger.“ Hierbei handelte es sich natürlich um die Kleine Eiszeit, und es scheint so, als ob sich die Welt immer noch in der Phase der Erholung daraus befindet. In diesem Zusammenhang stellen die Autoren fest, dass „die Temperatur während des 20. Jahrhunderts rasch gestiegen ist, besonders im Zeitraum 1981 – 1999, und dass die mittlere Temperatur derzeit um 0.5°C über dem Wert der Periode 1951 – 1980 liegt.“ Nichtsdestotrotz betonen Ge et al., dass die Temperatur während der MWP noch höher lagen, und das für mehrere Perioden von 10 bzw. 30 Jahren.

In einer weiteren Regionalstudie verwendeten Bao et al. (2003) bereits ausgewertete Proxydaten (?18O aus Eisbohrkernen sowie aus Torfzellulose, Baumringdaten, Kohlenstoffisotopen aus Baumringen, dem gesamten organischen Kohlenstoffgehalt, Wassertemperaturen in Binnenseen, Gletscheränderungen, Methangehalt in Eisbohrkernen, magnetischen Parametern, Pollenablagerungen und Sedimenten), die sie aus zwanzig bereits veröffentlichten Studien gewannen. Daraus wollten sie einen 2000-jährigen Temperaturverlauf in den nordöstlichen, südlichen und westlichen Gebieten des Tibetischen Plateaus ableiten. Nun, was fanden sie heraus?

Die Temperaturverläufe in allen drei Gebieten des Tibetischen Plateaus unterschieden sich alle signifikant. Jedoch hatten sie alle eine wichtige Gemeinsamkeit: Es gab mehr als nur eine 50-Jahre-Periode, in der die Temperatur in allen drei Gebieten höher lag als in der jüngsten 50-Jahr-Periode. Im nordöstlichen Sektor des Tibetischen Plateaus traten diese Zeiträume maximaler Erwärmung während der Mittelalterlichen Warmperiode auf, während sie im östlichen Sektor zur Zeit der Römischen Warmperiode auftraten. Im südlichen Sektor lag die Temperatur in beiden Warmphasen höher. Fazit: für alle drei Sektoren des Tibetischen Plateaus gilt, dass an den jüngsten relativ hohen Temperaturen nichts Ungewöhnliches ist.

Hinsichtlich des gesamten Plateaus ergibt sich so ziemlich das gleiche Bild: es gab nichts Außergewöhnliches in der jüngsten Vergangenheit. Für die gesamte Region ergibt sich jedoch, dass es in nur einer früheren 50-Jahr-Periode wärmer als zuletzt war, und zwar gegen Ende der römischen Warmperiode, also vor etwa 1850 Jahren.

Ein anderer wichtiger Beitrag zur Geschichte der römischen Warmperiode stammt von Bao et al. (2004). Sie sammelten und analysierten zahlreiche Proxydaten aus Eisbohrkernen, Baumringen, Fluss- und Seesedimenten, studierten aber auch historische Aufzeichnungen. Dies ermöglichte es ihnen, den Klimaverlauf während der Han-Dynastien (206 vor bis 220 nach Christus) im Vergleich zum Klima der letzten zwei Jahrtausende zu ermitteln. Sie schreiben, dass ihre Analysen „starke, eindeutige Beweise für eine relativ warme und feuchte Periode“ im gleichen Zeitintervall wie die römische Warmperiode zeigten. Tatsächlich stellten sie fest, dass die Temperaturen in diesem Zeitraum höher lagen als heute. Außerdem beschreiben sie, dass diese Warmperiode auch in Zentral- und Westchina aufgetreten war. Danach gab es eine „rapide Abkühlung“ (Zhu, 1973; Hameed and Gong, 1993; Yan et al., 1991, 1993; Shi and Zhang, 1996; Ge et al., 2002). Wir stellen zusätzlich fest, dass historische Chroniken von einer „abrupten Klimaänderung von warmen und feuchten Bedingungen zu kühlerem und trockenerem Klima um das Jahr 280 n. C.“ berichten (Zhang et al., 1994). Sie fügen die Feststellung hinzu, dass „drei verschiedene Methoden, den Temperaturverlauf der letzten 2000 Jahre zu ermitteln, eine offensichtliche Warmphase im Zeitraum 0 bis 240 n. C. ergaben (Yang et al., 2002), und dass eine Rekonstruktion der Sommertemperatur der letzten 2650 Jahre aus einem Stalagmiten der Shihua-Höhle nahe Peking (Tan et al., 2003) zeigte, dass die Temperatur in der Zeit der RWP über dem Mittelwert der gesamten Temperaturreihe lag.“

In einer Zusammenfassung ihrer Forschungsergebnisse erklären Bao et al., dass „die warmen und feuchten Bedingungen während der westlichen und östlichen Han-Dynastien [i. e. die RWP] offensichtlich Landwirtschaft im großen Stil sowie einen sozialen und gesellschaftlichen Boom ermöglichten. Hiervon zeugen noch die berühmten Ruinenstätten Loulan, Niya und Keriya“. Pflanzenrückstände von Walnussbäumen, Reis, Gerste, bestimmten Gräsern und Weizenkörnern, die in dem Gebiet gefunden wurden, deuten darauf hin, dass die Wasser- und Temperaturbedingungen zur Zeit der RWP in diesem Teil von Asien „geeignet für den Reisanbau und allgemein viel besser als heute waren.“

Feng and Hu (2005) ermittelten dekadenweise den Temperaturverlauf der letzten zwei Jahrtausende aus Eisbohrkernen und Baumringdaten an fünf verschiedenen Stellen auf dem Tibetischen Plateau. Dabei zeigte sich, dass an zwei Stellen die Temperatur im späten 20. Jahrhundert am höchsten lag verglichen mit den letzten 2000 Jahren. An den drei anderen Stellen (Baumringdaten aus Dulan und dem südlichen tibetischen Plateau, Eisbohrkern aus Guilya) war das jedoch nicht der Fall! Beispielsweise zeigen die Daten aus Guilya, dass es dort in den ersten beiden Jahrhunderten des Zeitraumes (zeitgleich mit der RWP) wärmer war als während der letzten zwei Jahrzehnte des 20. Jahrhunderts. Im südlichen tibetischen Plateau war es während eines ganzen weiteren Jahrhunderts zu Anfang dieser Reihe und während zweier Jahrhunderte zur Zeit der MWP signifikant wärmer als heute.

Wei et al. (2004) untersuchten an einer bestimmten Korallenart (Porites lutea) vor der Küste der Leizhou-Halbinsel im nördlichen Teil des Südchinesischen Meeres mit hoch auflösenden Messgeräten das Strontium/Kalzium-Verhältnis, während sie deren Alter mit Hilfe der Uran-Thorium- Methode ermittelten. Die Abhängigkeit des Mischungsverhältnisses zwischen Strontium und Kalium von der Temperatur wurde an einer lebenden Koralle der Gattung Porites lutea festgestellt, indem man dieses Verhältnis zur Wassertemperatur in Beziehung setzte, die an der nahe gelegenen meteorologischen Station Haikou im Zeitraum von 1989 bis 2000 gemessen wurde. Mit diesen Methoden konnte ermittelt werden, dass eine der Korallen aus der Zeit 489 – 500 stammte, also mitten in der Kaltphase des Dunklen Zeitalters, während die andere aus der Zeit 539 – 530 v. C. stammte, also aus der Zeit der RWP. Aus der ersteren schlossen Wei et al., dass die Wassertemperatur zur Zeit der DACP (Dark Ages Cold Period; Periode des Dunklen Zeitalters) etwa 2.0°C unter der der letzten Dekade des 20. Jahrhunderts lag. In der Zeit der RWP zeigte die zweite Koralle, dass die Wassertemperatur etwa gleich derjenigen in der Periode 1989 – 2000 war, wie sie an der Station Haikou gemessen worden war.

[Der folgende Absatz beschreibt dieses Verfahren mit anderen Worten noch einmal. Daher wird er hier nur zusammengefasst wiedergegeben. A. d. Übers.] In einer anderen Studie mit dem gleichen Verfahren kamen Yu et al. (2005) zu dem Ergebnis, dass das Verhältnis zwischen Strontium und Kalzium “ein ideales und verlässliches Thermometer” darstellt. Zusammen mit einer genauen Altersbestimmung ergibt sich, dass die Wassertemperatur während der RWP ähnlich derjenigen wie in den 1990er – 2000er Jahren war, der wärmsten Dekade des vergangenen Jahrhunderts. Und weiter: „Während der Eastern Zhou-Dynastie (770 – 256 v. C.) war es so warm, dass die Flüsse in der heutigen Provinz Shangdong (35-38°N) den ganzen Winter über in den Jahren 698, 590 und 545 v. C. nicht zugefroren waren.“

In verschiedenen anderen Studien in ganz Asien, die sich mit diesem Zeitrahmen befassen, konnte ebenfalls nachgewiesen werden, dass das Klima über die Jahrtausende variierte und dass es eine signifikante Römische Warmperiode gab. Diese Studien schließen ein diejenige von (1) Ji et al. (2005), in der ein Bohrkern aus Sedimenten aus dem Qinghai-See im Nordosten des tibetischen Plateaus spektroskopisch untersucht wurde, um eine hoch aufgelöste Analyse der asiatischen Monsunereignisse über einen Zeitraum von 18.000 Jahren zu gewinnen. (2) Beweise wurden auch gefunden von Matul et al. (2007) , die die historische Mikroflora sowie Sporen- und Pollenablagerungen aus verschiedenen Bohrkernen von Sedimenten an 21 Stellen auf dem Schelf der Laptev-See untersuchten, aus einem Gebiet, das vom Delta der Lena bis zum Seegebiet zwischen 130° und 134° östl. Länge sowie 71° bis 78° nördl. Breite reicht. Diese Bohrkerne hat eine russisch-französische Expedition mit dem Forschungsschiff Yakov Smimitsky im Jahre 1991 abgestochen.

(3) Bhattacharyya et al. (2007) rekonstruierten den Verlauf von Wärme und Feuchtigkeit während der letzten 1800 Jahre in der Region um den Paradise – See im nordöstlichen Himalaja aus Sedimenten mit Pollenablagerungen und der Anreicherung mit dem Kohlenstoffisotop ?13C. Sie konnten eine Periode „warmen und feuchten Klimas, ähnlich den gegenwärtigen Bedingungen“ um das Jahr 240 n. C. identifizieren, also am Ende der RWP. Eine weitere, sogar wärmere Periode fand sich um das Jahr 985, was sehr gut mit der MWP korreliert.

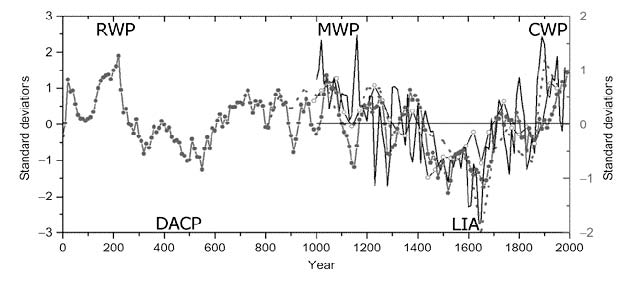

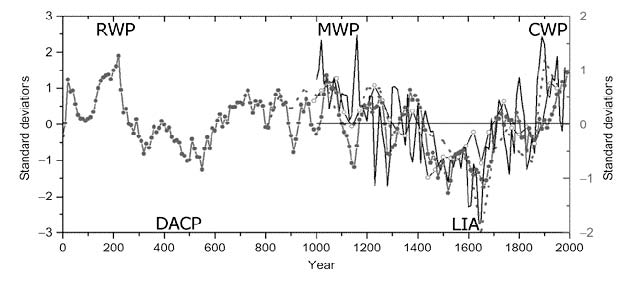

Die jüngste Studie von Yang et al. (2009) analysierte Proxydatenreihen hinsichtlich des Verlaufs von Temperatur und Niederschlag im ariden Zentralasien während der letzten 2000 Jahre. Sie konzentrierten sich auf das Verhältnis zwischen Temperatur und Niederschlag in verschiedenen Zeiträumen von Jahren bis Jahrhunderten. Hinsichtlich der Temperatur ergab sich, dass „die interessantesten Phänomene die Existenz der MWP und der Kleinen Eiszeit (Little Ice Age LIA) waren“, die sich beide in der Abbildung unten spiegeln. Auch die davor liegende RWP und die Kaltzeit des Dunklen Zeitalters DACP zeichnen sich ab, ebenso wie die kürzliche bis in das 20 Jahrhundert reichende Erwärmung, die wir die Gegenwärtige Warmperiode (Current Warm Period CWP) nennen wollen. Hinsichtlich des Niederschlags stellen die fünf Forscher fest, dass die MWP „mit ungewöhnlicher Trockenheit verbunden war, während die LIA mit extrem feuchten Bedingungen zusammen fiel.“

Darstellung verschiedener standardisierter Temperaturverläufe im ariden Zentralasien

Nach Yang et al. (2009)

Wieder einmal haben wir also ein ganzes Bündel an Beweisen für die natürliche, nicht durch CO2 verursachte Klimavariation im Zeitraum von Jahrtausenden, die Asien – und die übrige Welt gleichermaßen – in die römische Warmperiode, die Kaltzeit der dunklen Zeitalter, die mittelalterliche Warmperiode und die kleine Eiszeit hinein und dann wieder heraus geführt hat. Und diese große Anzahl realer Beobachtungen und Fakten liefert alle Gründe für die Annahme, dass die natürliche Klimavariation unseren Planeten 1) in die gegenwärtige Warmphase geführt hat und uns 2) sehr wahrscheinlich auch wieder daraus heraus führt, und zwar in einer nicht allzu fernen Zukunft.

Der Artikel erschien auf der Homepage des CO2 Science Institutes der Idso´s.

Alle Hervorhebungen im Original, außer den Anmerkungen des Übersetzers.

Ein Artikel zum Thema erschien im Spiegel am 23.5.2005, Sie finden ein Kopie davon im Anhang

Übersetzer: Chris Frey

Literatur

Bao, Y., Brauning, A. and Yafeng, S. 2003. Late Holocene temperature fluctuations on the Tibetan Plateau. Quaternary Science Reviews 22: 2335-2344.

Bao, Y., Braeuning, A., Yafeng, S. and Fahu, C. 2004. Evidence for a late Holocene warm and humid climate period and environmental characteristics in the arid zones of northwest China during 2.2 ~ 1.8 kyr B.P. Journal of Geophysical Research 109: 10.1029/2003JD003787.

Bhattacharyya, A., Sharma, J., Shah, S.K. and Chaudhary, V. 2007. Climatic changes during the last 1800 yrs BP from Paradise Lake, Sela Pass, Arunachal Pradesh, Northeast Himalaya. Current Science 93: 983-987.

Chu, G., Sun, Q., Li, S., Zheng, M., Jia, X., Lu, C., Liu, J. and Liu, T. 2005. Long-chain alkenone distributions and temperature dependence in lacustrine surface sediments from China. Geochimica et Cosmochimica Acta 69: 4985-5003.

Feng, S. and Hu, Q. 2005. Regulation of Tibetan Plateau heating on variation of Indian summer monsoon in the last two millennia. Geophysical Research Letters 32: 10.1029/2004GL021246.

Ge, Q., Zheng, J., Fang, X., Man, Z., Zhang, X., Zhang, P. and Wang, W.-C. 2003. Winter half-year temperature reconstruction for the middle and lower reaches of the Yellow River and Yangtze River, China, during the past 2000 years. The Holocene 13: 933-940.

Ge, Q., Zheng, J.Y., Man, Z.M., Fang, X.Q. and Zhang, P.Y. 2002. Reconstruction and analysis on the series of winter-half-year temperature changes over the past 2000 years in eastern China. Earth Science Frontiers 9: 169-181.

Gong, G. and Chen, E. 1980. On the variation of the growing season and agriculture. Scientia Atmospherica Sinica 4: 24-29.

Hameed, S. and Gong, G.F. 1993. Temperature variation in China during historical times. In: Climate Change and Its Impact. (Y. Zhang et al., Eds.) China Meteorology, Beijing, China, pp. 57-69.

Ji, J., Shen, J., Balsam, W., Chen, J., Liu, L. and Liu, X. 2005. Asian monsoon oscillations in the northeastern Qinghai-Tibet Plateau since the late glacial as interpreted from visible reflectance of Qinghai Lake sediments. Earth and Planetary Science Letters 233: 61-70.

Liu, Z., Henderson, A.C.G. and Huang, Y. 2006. Alkenone-based reconstruction of late-Holocene surface temperature and salinity changes in Lake Qinghai, China. Geophysical Research Letters 33: 10.1029/2006GL026151.

Ma, Z., Li, H., Xia, M., Ku, T., Peng, Z., Chen, Y. and Zhang, Z. 2003. Paleotemperature changes over the past 3000 years in eastern Beijing, China: A reconstruction based on Mg/Sr records in a stalagmite. Chinese Science Bulletin 48: 395-400.

Man, Z. 1990. Study on the cold/warm stages of Tang Dynasty and the characteristics of each cold/warm stage. Historical Geography 8: 1-15.

Mann, M.E. and Jones, P.D. 2003. Global surface temperatures over the past two millennia. Geophysical Research Letters 30: 10.1029/2003GL017814.

Matul, A.G., Khusid, T.A., Mukhina, V.V., Chekhovskaya, M.P. and Safarova, S.A. 2007. Recent and late Holocene environments on the southeastern shelf of the Laptev Sea as inferred from microfossil data. Oceanology 47: 80-90.

Prahl, F.G., Muehlhausen, L.A. and Zahnle, D.L. 1988. Further evaluation of long-chain alkenones as indicators of paleoceanographic conditions. Geochimica et Cosmochimica Acta 52: 2303-2310.

Sheng, F. 1990. A preliminary exploration of the warmth and coldness in Henan Province in the historical period. Historical Geography 7: 160-170.

Shi, Y. and Zhang, P.Y. (Eds.) Climatic Variation in Historical Time in China. Shandong Science and Technology, Jinan, China.

Wei, G., Yu, K. and Zhao, J. 2004. Sea surface temperature variations recorded on coralline Sr/Ca ratios during Mid-Late Holocene in Leizhou Peninsula. Chinese Science Bulletin 49: 1876-1881.

Wen, H. and Wen, H. 1996. Winter-Half-Year Cold/Warm Change in Historical Period of China. Science Press, Beijing, China.

Xu, H., Hong, Y., Lin, Q., Hong, B., Jiang, H. and Zhu, Y. 2002. Temperature variations in the past 6000 years inferred from ?18O of peat cellulose from Hongyuan, China. Chinese Science Bulletin 47: 1578-1584.

Yan, Z.W., Ye, D.Z. and Wang, C. 1991. Climatic jumps in the flood/drought historical chronology of central China. Climate Dynamics 6: 153-160.

Yan, Z.W., Li, Z.Y. and Wang, C. 1993. Analysis on climatic jump in historical times on decade-century timescales. Sci. Atmos. Sin. 17: 663-672.

Yang, B., Braeuning, A., Johnson, K.R. and Yafeng, S. 2002. General characteristics of temperature variation in China during the last two millennia. Geophysical Research Letters 29: 10.1029/2001GL014485.

Yang, B., Wang, J., Brauning, A., Dong, Z. and Esper, J. 2009. Late Holocene climatic and environmental changes in arid central Asia. Quaternary International 194: 68-78.

Yu, K.-F., Zhao, J.-X, Wei, G.-J., Cheng, X.-R., Chen, T.-G., Felis, T., Wang, P.-X. and Liu, T-.S. 2005. ?18O, Sr/Ca and Mg/Ca records of Porites lutea corals from Leizhou Peninsula, northern South China Sea, and their applicability as paleoclimatic indicators. Palaeogeography, Palaeoclimatology, Palaeoecology 218: 57-73.

Zhang, P.Y., Wang, Z., Liu, X.L. and Zhang, S.H. 1994. Climatic evolution in China during the recent 2000 years. Sci. China Ser. B. 24: 998-1008.

Zhu, K.Z. 1973. A preliminary study on the climatic fluctuations during the last 5,000 years in China. Sci. Sin. 16: 226-256.

Zink, K.G., Leythaeuser, D., Melkonian, M. and Schwark, L. 2001. Temperature dependency of long-chain alkenone distributions in recent to fossil limnic sediments and in lake waters. Geochimica et Cosmochimica Acta 65: 253-265.

Last updated 12 May 2010

Printer Friendly Version

Gefunden auf: http://www.co2science.org/subject/r/summaries/rwpasia.php

Related Files