Treibhauseffekt oder adiabatische Theorie der Erderwämung? (I)

EIKE möchte den Lesern die Arbeit eines russischen Forschers vorstellen bzw. zur Kenntnis und Diskussion stellen, der bei einer Erhöhung von Treibhauskonzentrationen in der Atmosphäre von einer globalen Abkühlung ausgeht. Warum auch immer fand diese Betrachtungsweise in der westlichen Fachwelt wenig Aufmerksamkeit, die sich weder ernsthaft kritisch oder ebenso ernsthaft befürwortend damit auseinandersetzte.

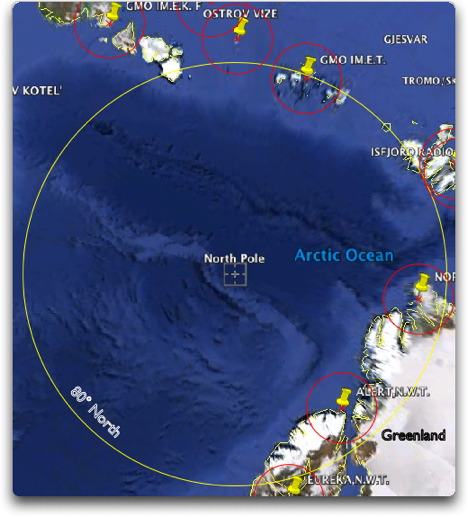

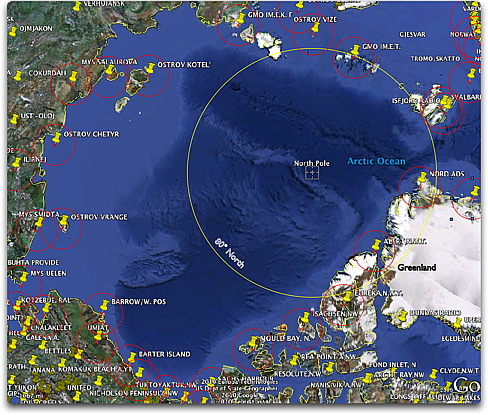

Oleg Sorochtin kann auf ein langes Forscherleben zurückblicken. Er war Teilnehmer an mehreren Arktis- und Antarktisexpeditionen und zahlreichen ozeanologischen Expeditionen. Als Geophysiker und Mitarbeiter bzw. späterer Direktor des Instituts für Ozeanologie an der sowjetischen / russischen Akademie der Wissenschaften beschäftigte er sich näher mit der Tektonik ozeanischer Platten. In dieser Hinsicht ist er Autor vieler wissenschaftlicher Arbeiten, die die Evolution der Hydrosphäre und Atmosphäre innerhalb der Erdgeschichte u. a. im Zusammenhang mit Ausgasungsprozessen aus dem Erdinneren sowie dem oberen Erdmantel abhandeln.

Als studierter Geophysiker verfügt Sorochtin von Hause aus über ein solides mathematisch-physikalisches Wissen. Er ist Prof. Dr. d. math.-phys. Wiss. (nach russischer Nomenklatur akademischer Grade) und ordentliches Mitglied der Russischen Akademie der Naturwissenschaften.

Anhand der Lektüre des vorgestellten Artikels wird ersichtlich, welcher Denkrichtung Sorochtin angehört, die nicht untypisch für einen großen Teil von Geowissenschaftlern ist, in sofern, dass Änderungen des Erdklimas hauptsächlich auf geogene und kosmische, weniger auf anthropogene Ursachen zurückgeführt werden.

Im hier vorgestellten Artikel erläutert Sorochtin die „adiabatische Theorie des Treibhauseffektes“, die im Einzelnen so neu nicht erscheint. Sorochtin meint hier, dass die mittlere Temperatur auf jedem Niveau einer hinreichend dichten Troposphäre eines Planeten (mit Drücken über 200 mbar) eindeutig von der Intensität der Sonneneinstrahlung, dem Luftdruck auf bestimmten Höhenniveau, der Wärmekapazität der Troposphäre, der Feuchtigkeit der Luft und ihrer Fähigkeit Infrarotstrahlung zu absorbieren bestimmt wird. Jedoch je intensiver die Absorption von Infrarotstrahlung durch die Troposphäre ist, um so geringer erweist sich die Temperatur auf der Planetenoberfläche. Diese auf den ersten Blick paradox erscheinende Schlussfolgerung erklärt Sorochtin damit, dass dabei der Temperaturgradient in der Troposphäre kleiner wird und sich gleichzeitig die Intensität des Wärmeaustrags aus der Troposphäre in die Stratosphäre erhöht. Diese Gesetzmäßigkeit, so Sorochtin, erlaube es, eine Reihe prognostischer Berechnungen durchzuführen. Auf diese Weise sinke beispielsweise bei einer virtuellen Auswechselung der Erdatmosphäre gegen eine reine CO2-Atmosphäre bei gleichem Druck von 1 atm die Temperatur in Bodennähe um fast 2 °C. Sorochtin folgert danach, dass eine Anreicherung der Erdatmosphäre mit Kohlendioxid, unabhängig von seiner Fähigkeit Infrarotstrahlung absorbieren zu können, nicht zu einer Erhöhung, sondern ausschließlich zu einer Minderung sowohl des Treibhauseffektes als auch der mittleren Oberflächentemperatur eines Planeten. Sorochtin glaubt, dies mit einer in sich schlüssigen Beweiskette (bei einer ersten Betrachtung erscheint dies auch so) bewiesen zu haben.

In einer zweiten weitaus kürzeren Rubrik äußert sich Sorochtin über die Genese von Ozonlöchern. Hier sind für den Leser Ausführungen über die geogene Herkunft von Fluorkohlenwasserstoffen und anderen Gasen möglicherweise neu.

Der vorliegende Artikel wurde dem russischsprachigen Internet entnommen (http://fiz.1september.ru/articlef.php?ID=200501111) und enthält die Kernaussage unten genannter Publikationen. In so weit stellt die vorliegende Abhandlung eine Ergänzung bzw. Modifikation u. g. Artikel dar.

Weitere Quellen (russ. z. T. eng.) aus dem Internet:

http://www.scgis.ru/russian/cp1251/dgggms/1-98/par_eff.htm#p2

(Sorochtin, O.G.; Uschakow, S.A.: Die Natur des Treibhauseffektes…)

Die Kernaussage wurde in der Arbeit

Sorokhtin O.G., Ushakov S.A. Adiabatic theory of greenhouse effect of atmosphere. Bulletin MGU, ser. 5, Geographic, 1996, ?5, p. 27-37.

formuliert.

Die Veröffentlichungen

Sorokhtin O.G. Greenhouse effect atmospheres in a geological history of the Earth. – Dokl. AN USSR, 1990, v. 315, ? 3, p. 587-592.

Sorokhtin O.G., Ushakov S.A. Global evolution of the Earth.-M.: Isdat. MGU, 1991. – 446 pp.

sind Vorläufer der o. g. Arbeit von 1996. Sie sind allesamt im Verlag der Staatlichen Moskauer Universität in russischer Sprache als Mitteilung o. ä. erschienen. Sehr wahrscheinlich liegen sie, wie leider sehr oft der Fall, nur zum Teil in englischer Übersetzung vor.

Spätere Publikationen in englischsprachigen Zeitschriften lediglich unter der Mitautorschaft von Sorochtin beispielsweise von 2008 (Chilingar et. al) haben höchstens nur randlich mit den fast ausschließlich die adiabatische Theorie abhandelnden Artikel zu tun.

Dr. B. Hartmann für EIKE

Den vollständigen Artikel finden Sie als pdf im Anhang