Wie ein fehlendes M die Temperaturen nach oben treibt: Es ist schlimmer als gedacht

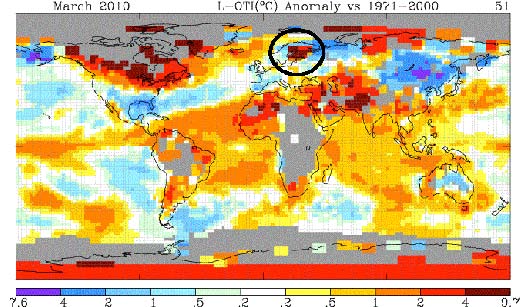

In meinem letzten Beitrag haben wir über eine merkwürdige Temperatur-Anomalie gesprochen, die Jean S. in den GISS-Daten vom März gefunden und an Climate Audit geschickt hatte.

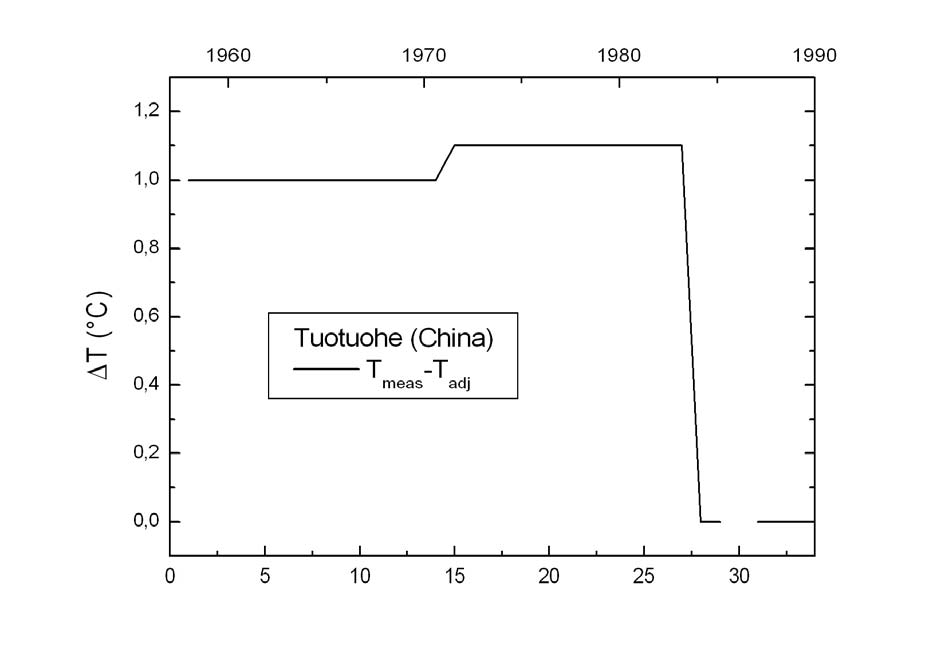

Diese Anomalie über Finnland hat eine interessante Signatur und die vom GISS auf seiner Webseite veröffentlichte Korrektur bestätigt, was ich seit einigen Monaten suche.

Die Daten für den Zeitraum zwischen dem 13. und 15.4. beruhten auf Daten, die am 12.4. heruntergeladen worden waren und die einige Stationsmeldungen enthielten, bei denen das negative Vorzeichen verloren gegangen sein könnte.

Ich machte mir einige Arbeit vom vergangenen Dezember bis Januar und weil bei GISS die Bestätigung "negative Vorzeichen fehlen" aufgestempelt wurde, kann ich jetzt zeigen, dass fehlende negative Vorzeichen kein gelegentliches Ereignis sind, sie fehlen mit Regelmäßigkeit und die Auswirkung ist sehr ausgeprägt, wenn das geschieht. Das zielt ins Herz der Datensammlungs-Integrität und beruht auf einfachem menschlichen Irrtum. Der Fehler liegt nicht beim GISS (obwohl man dort eine neue Qualitätssicherung braucht) sondern meist bei NOAA/NCDC, die die GHCN verwalten und die auch bessere Qualitätssicherung brauchen. Der Fehler entsteht am Flughafen, wahrscheinlich bei jemand, der im Kontrollturm sitzt. Leser, die Piloten sind, werden das verstehen, wenn sie sehen, worüber ich spreche.

Ich habe den Fehler überall in der Welt entdeckt. Lesen Sie bitte weiter, und haben Sie Geduld. Da muss eine Menge von Einzelheiten besprochen werden, um die Angelegenheit ordentlich zu behandeln. Ich muss ganz von vorne in der Kette der Klimadaten anfangen, da, wo sie entstehen, und mich nach oben arbeiten.

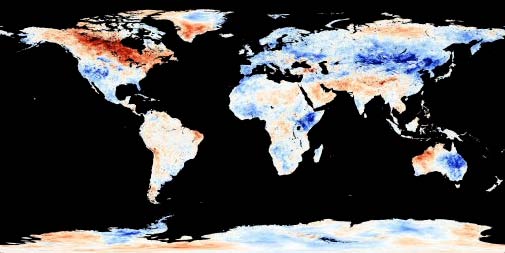

Zuerst eine Erläuterung zur Entstehung des Fehlers und zu den Unterschieden zwischen den Boden- und den Satelliten-Messdaten. Ich sollte erwähnen, dass im Satellitenbild von der Erdbeobachtung der NASA (NEO) der gleiche Fehler nicht auftaucht, wie in der GISTEMP-Karte oben.

NASA NEO March 1-31 2010 day satellite measured temp anomaly – click for larger image

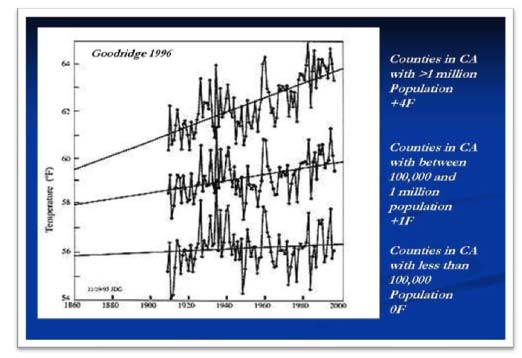

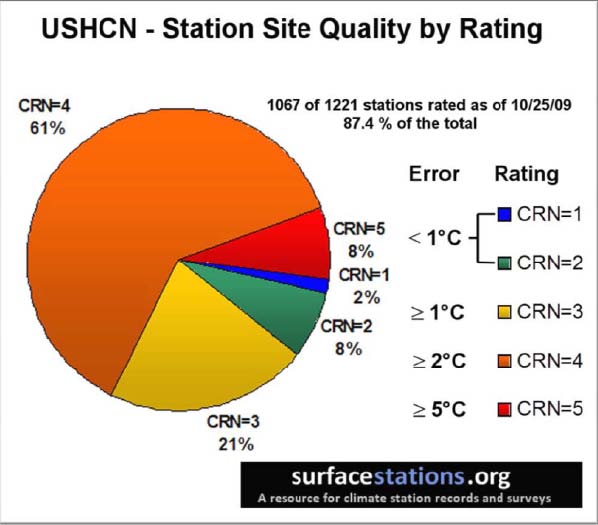

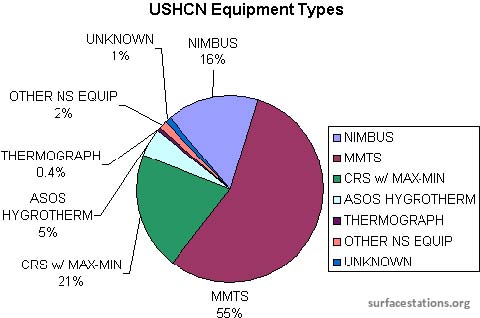

Warum? Vielleicht wegen besserer Sensoren, aber meist hat es mit einer unterschiedlichen Datensammlungsmethode zu tun. Bei den Bodendatensätzen, einschließlich der Land- und Meeresdaten, wird fast jeder Datenpunkt von einer menschlichen Hand angefasst, sogar die von automatischen Flughafensensoren erfassten Flughafendaten werden manchmal manuell umgeschrieben (oft in Drittwelt- und technologisch unterentwickelten Ländern.). Bei den Bodenmessdaten sind Tausende von Sensoren über die Erde verteilt, von unterschiedlicher Konstruktion, in unterschiedlicher Umgebung, von vielen unterschiedlichen Personen bedient mit unterschiedlichen Mess- und Meldestandards. Die Präzision, Genauigkeit und Kalibrierung des weitverbreiteten Bodenmess-Netzwerks ist unterschiedlich, besonders wenn eine breite Mischung von Instrumentenarten vorliegt. So unterscheidet sich auch die Ausstattung im Netzwerk der US – Klimatologie-Geschichte erheblich.

Von Satelliten werden die Daten von einem einzigen Punkt aus gemessen mit einem einzigen Sensortyp, der an Bord mit Hilfe einer Präzisionsquelle kalibriert wird. An Bord sind redundante Platin-Widerstand-Thermometer (PRTs) auf die Satelliten-Radiometer gesetzt. Die PRTs werden einzeln in einem Laboratorium kalibriert, bevor sie in den Messinstrumenten installiert werden. Die Satellitendaten werden automatisch gemessen und gesendet. Im Gegensatz zu den Bodentemperaturmessungen geschieht kein menschlicher Eingriff beim Datenerfassen und beim Übermitteln. Die Satellitendatenerfassung ist viel homogener als der Mischmasch bei den Bodendaten.

Ich meine, dass man sicher sagen kann, dass das Risiko menschlicher Fehler bei den Bodenrohdaten mindestens um eine Größenordnung höher ist (vielleicht sogar um mehrere) als die Fehlermöglichkeit bei den Satellitenrohdaten. Die Verarbeitung nach der Erfassung ist ein weiterer Punkt, doch im Rahmen dieses Aufsatzes konzentriere ich mich nur auf die Rohdatenerfassung und Übertragung.

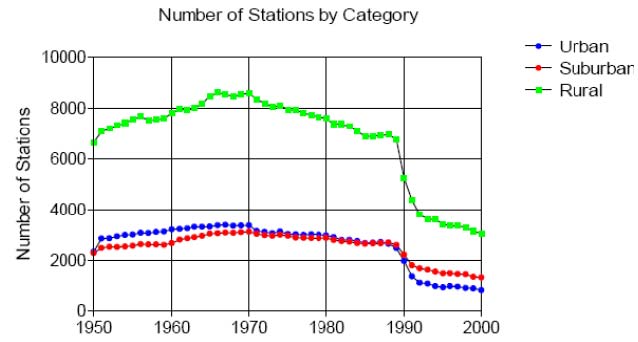

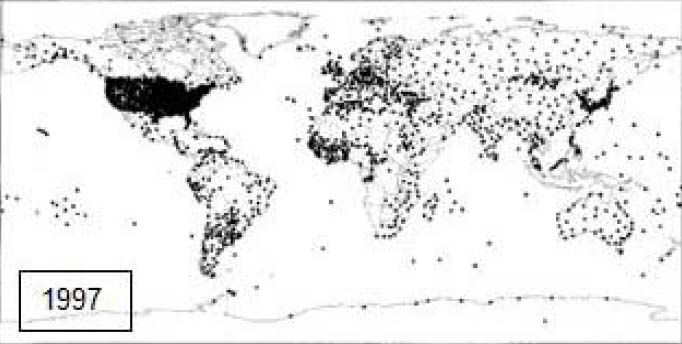

Wie schon im jüngst aktualisierten Kompendium über die Probleme mit den Bodenmessdaten von Joe D’Aleo und mir erwähnt, gibt es eine Tendenz beim Globalen Historischen Klimatologischen Netzwerk (GHCN), sich bei den Klimadaten immer mehr auf Flughäfen zu verlassen. Das ist meiner Meinung nach ein riesiger Fehler, weil zusätzlich zu unseren Problemen, wie E.M. Smith (auch bekannt als "Chiefio") berichtet, in GISS (GISS benutzt GHCN) weltweit eine kompletter Übergang zu Flughafenwetterdaten als Klimadatenquelle erfolgt ist. Er sagte mir in einer Email vom 20. Jan. 2010:

Sehen Sie hier nach:

AGW GIStemp Measure Jet Age Airport Growth

Das ist eine recht gute Beschreibung der Probleme mit den Daten. Wir haben eine globale Darstellung für GHCN mit Stand von August. Mehr Einzelheiten stehen im Link, aber ich denke, Sie möchten über den "Jetzt"-Zustand etwas erfahren…..

Rest siehe pdf Anhang (20 Seiten) sowie Schluß unten

………………………………………..

………………………………………..

………………………………………..

Fehlendes "M" – Sofortige Polartemperaturverstärkung?

Man hat gesagt, dass sich die Signatur der globalen Erwärmung an den Polen zuerst zeigen wird. Die Polartemperaturverstärkung (polar amplification) wird definiert als:

"Die Polartemperaturverstärkung (stärkere Temperaturzunahme in der Arktis im Vergleich zur gesamten Erde) ist das Ergebnis der zusammenkommenden Rückkopplungen und anderer Prozesse." Dies gilt nicht für die Antarktis, weil das südliche Meer als Wärmesenke wirkt. Weit verbreitet ist diese Behauptung: "Klimamodelle sagen allgemein eine Verstärkung der Erwärmung in den Polregionen voraus", z. B. Doran et al. Jedoch sagen die Klimamodelle Temperaturverstärkung für die Arktis, aber nur gemäßigte Erwärmung für die Antarktis voraus.

Interessanterweise hat der METAR-Codierfehler sein größtes Ausmaß an den Polen, weil die Unterschiede durch das Fehlen des Minuszeichens mit kälter werdender Temperatur größer werden. Heureka! NWT (North Western Territories) ist ein großartiges Beispiel, weil durch ein einziges fehlendes "M" die Temperatur von -43 Grad F auf +43 Grad F springt.

Am Äquator wird man keine METAR-Kodierfehler finden, weil die Temperatur dort niemals unter 0 Grad C fällt. Niemand wird dies dort codieren. In mittleren Breiten kann es vorkommen, aber eher jahreszeitlich bedingt und mit nicht so großem Unterschied.

Ein Beispiel:

Durch Änderung von M05/M08 auf 05/M08 wird die Temperatur von -5 Grad C auf +5 Grad C gesetzt, doch an Orten wie Boston, Chicago oder Denver, usw. kann eine +5 Grad C – Temperatur leicht in jedem Wintermonat vorkommen, in dem auch -5 Grad C. vorkommen. Deshalb verschwindet der Fehler im Rauschen des "Wetters" und wird wahrscheinlich niemals bemerkt. Aber er schiebt den Temperaturdurchschnitt ein wenig nach oben, wenn er nicht korrigiert wird.

Aber in der Arktis und der Antarktis macht das fehlende M in einer M20/M25 METAR-Meldung einen Unterschied von 40 Grad C aus, wenn da +20 Grad C stehen. Und es scheint wenig wahrscheinlich, dass wir einen Wintermonat in Sibirien oder auf Antarktika erleben, der normalerweise bis auf 20 Grad C hochgeht, daher wird der Fehler nicht im Wetterrauschen untergehen, sondern wird zu einem starken Signal, wenn er nicht korrigiert wird.

Die Neigung zur Bestätigung der Fehler aus der Erwartungshaltung der Polartemperaturverstärkung heraus mag der Grund sein, warum bis dato niemand darauf hingewiesen hat. Darüber hinaus scheinen sich die Organisationen, die aus Bodentemperaturen abgeleitete Klimadaten präsentieren (GISS, CRU), nur mit monatlichen und jährlichen Durchschnitten zu beschäftigen. Tägliche oder stündliche Daten werden nicht präsentiert, soviel ich weiß, und wenn auf diese Zeiträume bezogene Fehler passieren, werden sie nicht bemerkt.

Seit das NASA GISS zugegeben hat, dass fehlende Minuszeichen zur heißen Anomalie über Finnland im März beigetragen haben, und anhand der vielen METAR-Codierfehler Vorkommnisse, die ich für andere Stationen auf der Erde nachgewiesen habe, scheint der Schluss vertretbar zu sein, dass unsere METAR-Daten von kalten Orten durch Codierfehler verfälscht sein könnten, die aus dem System herrühren.

Die gezeigten Daten zwischen dem 13. und 15. 4. beruhen auf Daten, die am 12. 4. heruntergeladen wurden. Darin enthalten sind einige Stationsmeldungen von Finnland, wo das Minuszeichen unter den Tisch gefallen sein kann.

4/15/10 http://data.giss.nasa.gov/gistemp/

Dieses verflixte fehlende M, oder ein zusätzliches Leerzeichen, oder nur ein "-", wenn ein "M" gemeint ist (das ist der grundlegenden mathematischen Vorstellung zuwider), alles zusammen scheinen eine Rolle zu spielen beim menschlichen Irrtum, der zu den Datenfehlern in unserer globalen Oberflächentemperatur beiträgt. Um die Größe des Problems zu bestimmen, ist eine umfassende Überprüfung aller Daten nötig, von unten nach oben, von deren Entstehung bis zu den [daraus erzeugten] Ergebnissen. Bei NOAA/ NCDC muss angefangen werden, weil die für die Qualitätssicherung der Daten verantwortlich ist.

Man sagt, dass "der Mensch die globale Erwärmung verursacht". Ich meine, genauer wäre die Aussage: "Menschliche Fehler erzeugen die globale Erwärmung".

Anmerkung: In diesem Beitrag habe ich die Fehler vorgeführt. In einem folgenden Beitrag hoffe ich, Datenanalysen mit den Zahlen durchzuführen, um zu sehen, welche Auswirkung die Fehler tatsächlich haben. Natürlich ist jeder willkommen, der das machen will, Links auf Grafiken und Tabellen zu liefern.

– Anthony [Watts]. den Originalartikel finden Sie hier

Die angekündigten weiteren Beiträge von Watts dazu sind

(2) http://wattsupwiththat.com/2010/04/22/dial-m-for-mangled-wikipedia-and-environment-canada-caught-with-temperature-data-errors/

und

(3) http://wattsupwiththat.com/2010/04/24/inside-the-eureka-weather-station/

Die Übersetzung besorgte in dankenswerterweise und bewährter Manier Helmut Jäger für EIKE.