In Erwartung eines US-amerikanischen „Temperatur-Gate“?

Unsere Studie über das Frisieren von Daten durch die U.S.-Regierungsbehörde, die mit der Sammlung von Temperatur-Informationen beauftragt ist, ruft unangenehme Fragen hervor.

Man hat uns zwanzig Jahre lang immer wieder gesagt (vielleicht ist „eingetrichtert“ das bessere Wort), dass eine globale Erwärmung stattfindet. Durch Climategate mit nachfolgenden Geständnisse und der Distanzierung von Wissenschaftlern des CRU [Climate Research Unit der brit. East Anglia Universität], der Penn-Staatsuniversität, der Arizona-Staatsuniversität, des IPCC und anderer Stellen erfahren wir nun, dass ganz wenig von den sachlichen Inhalten ihrer „fachbegutachteten“ Veröffentlichungen stimmt. Die mittelalterliche Warmperiode hat es gegeben, es war wärmer als heute, die Meere haben nicht die Tiefebenen überflutet und das Eismeer wird sich vermutlich nicht in ein Sommermeer verwandeln. Natürlich haben die vorherrschenden Massenmedien nur wenig davon berichtet, vor allem in den USA, und Präsident Obama scheint kaum informiert zu sein. Aber jetzt wird die Geschichte vom Klimawandel interessanter, weil Amerika ein eigenes kleines „Gate“ hat. Ich möchte es ATG nennen für „Amerikanisches Temperatur-Gate“.

Das Nationale Klimadatenzentrum (NCDC) des U.S. Wetterdienstes teilt auf der Grundlage seiner „justierten Daten“ mit, dass für den Zeitraum vom letzten Jahrzehnt des 19. Jh. bis 2006 die Temperaturen in den kontinentalen USA mit einer Rate von 0.69 °C/Jh. angestiegen sind (hier zu sehen). Das Klimadatenzentrum kommt zu dieser Schlussfolgerung aufgrund des Frisierens der Rohdaten einer Teilmenge von Wetterstationen auf dem Kontinent, ausgewählt aus einem Gitternetz bestehend aus Zellen mit Kantenlängen von 2,5 Grad Breite und 3,5 Grad Länge. (Näheres hier und hier). Am meisten wird hinterfragt, gerade erst von D’Aleo and Watts, ob der vom Klimadatenzentrum gemeldete Anstieg korrekt ist. Vielleicht ist dieser Wert auf die bevorzugte Verwendung (Über-Selektion) von Wetterstationen in städtischem Umfeld zurückzuführen oder aufgrund anderer Kriterien, z. B. das Auslassen von Stationen in höheren Lagen für die jüngere Vergangenheit bei gleichzeitigem Einbezug für die ältere Vergangenheit.

Wir beschäftigen uns hier nun mit einem Aspekt, dem Wärme-Insel-Effekt, [engl.] abgekürzt UHI-E [Urban Heat Island Effect].

Wir haben zwei Teilmengen von Wetterstationen aus der Klimadaten-Hauptliste ausgewählt (48 pro Teilmenge mit je einer Station aus den südlicheren 48 Staaten). Die Stationen in der ersten Teilmenge waren in ländlichen (rurale) Umgebungen gelegen, das ist die ländliche Datenserie. Die Stationen der anderen Teilmenge waren in städtischen (urbane) Umgebungen, das ist die städtische Datenserie. Die Längen- und Breiten-Koordinaten aus der NCDC-Liste wurden benutzt, um mit dem Computer „über die Stationen zu fliegen“ und mit Hilfe einer GPS-Kartensoftware die ländliche und städtische Charakteristik zu bestätigen. Die Rohdaten und die „justierten“ Temperaturdaten wurden in eine Tabellenkalkulationsliste eingetragen und untersucht. Die Rohdaten sind die jährlichen gemessenen Durchschnittstemperaturen. Die „justierten“ Daten sind die jährlichen Durchschnittstemperaturen des NCDC, die aus den Rohdaten abgeleitet wurden, indem „korrigierende“ Annahmen in Bezug auf die Tageszeit, die Art der Messgeräte usw. angesetzt wurden, und indem für Stationen ohne Daten die Temperaturdaten geschätzt wurden, auf der Basis von vorliegenden Messungen anderer Stationen mit der gleichen geographischen Breite und/oder aus der gleichen Region. (Für ein tiefer gehendes Verständnis der Protokolle des NCDC bei der Konversion von Rohdaten in justierte Daten siehe hier.) Die Ergebnisse sind in der folgenden Tabelle zusammengefasst. Die Tabellenwerte zeigen, dass der vom NCDC angegebene Temperaturanstieg von 0.65 °C/Jh. auf einer Über-Selektion von Stationen aus städtischer Umgebung beruht.

|

Station Set

|

°C/Century, 11-Year Average Based on the Use of

|

|

|

Raw Data

|

Adjusted Data

|

|

|

Rural (48)

|

0.11

|

0.58

|

|

Urban (48)

|

0.72

|

0.72

|

|

Rural + Urban (96)

|

0.47

|

0.65

|

Die Tabellenwerte erlauben vier wichtige Aussagen:

1) Die Anstiegsrate bei den gemessenen Rohdaten ist in ländlichen Gebieten klein, (wenn überhaupt vorhanden, dann tatsächlich sind es nur 0.11°C/Jh!)

2) Es gibt in der Tat einen Wärmeinsel-Effekt bei den Rohdaten aus den städtischen Gebieten mit einer Zunahme von 0,72 °C/Jh. Das bedeutet, dass der Mensch die Erwärmung in den städtischen Gebieten verursacht hat. Das sollte aber niemanden überraschen. Weil aber der ländliche Wert nur 15 % des städtischen Wertes beträgt, kann der Wärmeinsel-Effekt keine Erwärmung in den ländlichen Gegenden verursacht haben und kann keineswegs für eine globale Erwärmung stehen, , außer dass die zusammengefassten städtischen und ländlichen Werte einen höheren durchschnittlichen Anstieg ergeben, als die ländlichen Werte für sich allein.

3) Die Summe aus ländlichen und städtischen Werten bei den justierten Daten ist 0.65 °C/Jh. Das ist immer noch weniger als die vom NCDC veröffentlichen 0.69 °C/Jh. Daher benutzt die NCDC vermutlich mehr städtische als ländliche Stationen.

4) Und das ergibt den „Temperatur-Gate-Effekt“: Das Frisieren der Daten durch das NCDC – „Justierung“ genannt – hat einen Anstieg in den ländlichen Gebieten erzeugt. Aus einem Rohwert von 0.11°C/Jh. wurde ein "justierter" Wert von 0.58 °C/Jh. Bei den städtischen Werten ergibt das hingegen keine Änderung. Das heißt, durch die Art der Behandlung der ländlichen Daten durch das NCDS erzwingt diese, dass der ländliche Wert dem städtischen ähnlicher wird. Das ist das genaue Gegenteil von jeglicher vernünftigen Beurteilung, angesichts der Zunahme an Ausdehnung und Aktivität in städtischen Gebieten. Es sei denn man will täuschen.

Die Kritik an der Behandlung der historischen Daten für die kontinentalen Vereinigten Staaten durch das NCDC ist die gleiche, wie in einem kürzlich veröffentlichten russischen Papier über die Behandlung der historischen Daten aus Russland im HadCRUT [Hadley Climate Research Unit Temperature, UK]. Eine Zusammenfassung der Argumente kann man hier lesen.

Die vollständige Studie finden Sie im Anhang bzw. können Sie hier abrufen.

UPDATE von Anthony Watts: Ein Leser fragte, warum die Divergence 1960 beginnt. Stadtwachstum könnte eine Ursache sein. Aber weil das Paper die NCDC Anpassungen zum Thema hat, ist die untere Grafik von NOAA vergleichbar passend.

http://www.ncdc.noaa.gov/img/climate/research/ushcn/ts.ushcn_anom25_diffs_urb-raw_pg.gif

Edward R. Long ist promovierter Physiker. Er ist pensionierte NASA-Wissenschaftler und Berater für Raumfahrt-Strahlungsphysik und für Energie- und Klimafragen beim Commonwealth of Virginia. [Offizielle Informationsstelle des U.S. Bundesstaates Virgina]

Der Artikel erschien im "American Thinker" und wurde dankenswerter Weise von Helmut Jäger für EIKE übersetzt.

weitere Details siehe auch hier

Related Files

Star-TV-Journalist Ederer schreibt offenen Brief an FDP MdB Kauch zur Klimapolitk der FDP!

Während in bedeutenden Publikationen in aller Welt (New York Times, Londoner Times, Die Welt) von Climategate geschrieben wird, der Institutsleiter des CRU, Phil Jones zurücktreten muss, höre ich von Ihnen gar nichts. Die Manipulation der Hockeystick-Kurve durch falsche Berechnungen der Baumrinden ist für mich dabei zwar ein signifikanter aber nicht der entscheidende Skandal. Die Weigerung des CRU, dem Freedom of Information Act folge zu leisten, ist politisch viel schwerwiegender. Dadurch wird deutlich, dass sich hier eine Organisation das Recht nimmt, jenseits von Gesetzen und gebotener Transparenz politische Entscheidungen zu provozieren, die dann als UN- Beschluss völkerrechtlich verbindlich erklärt werden sollen. Gott sei Dank ist das in Kopenhagen schief gegangen.

Ich habe von Ihnen noch nicht einmal einen Nebensatz gehört, dass die Versuche in Kopenhagen, die Staaten zu CO2-Emmissionen zu verpflichten, die international überwacht werden sollen und die das Recht beinhaltenden in die nationale Wirtschafts-, Finanz- und Umweltpolitik einzugreifen, massive Bedrohung der freiheitlichen Wirtschafts- und Gesellschaftsordnung darstellt. Dies kann doch eine liberale, der Freiheit verpflichtende Partei nicht akzeptieren.

Was auffällt ist, dass Sie bei Veranstaltungen von Wissenschaftlern, die zu anderen Ergebnissen als die IPCC und PIK- Gruppe kommen, nie anwesend sind- im Gegensatz von anderen FDP-Abgeordneten. Selbst wenn die Friedrich Naumann-Stiftung solche Seminare mitgestaltet, sind Sie nie dabei. Das bedeutet doch, dass Sie darauf verzichten, sich umfassend zu informieren. Sie betonen in Ihren Stellungnahmen, dass Sie von Bali bis Kopenhagen an den Klimakonferenzen teilnehmen, was aber nichts anderes bedeutet, als dass Sie sich zufrieden damit geben, sich einseitig zu informieren.

Abgesehen davon, dass Sie damit zu den vielen parteipolitisch einäugigen Abgeordneten zählen, die mir im Laufe meiner Berichterstattung begegnet sind, und die durch Anpassung an eine allgemein gültige Linie es bis in Ministerien geschafft haben, ist es in Ihrem Falle auch noch taktisch voll daneben.

Angenommen, die Geschichte mit den Treibhausgasen stimmt und die Beschränkung der Erderwärmung um 2 Grad wäre wirklich zum Überleben der Menschheit entscheidend: Dann gibt es doch nur eine Partei, die man wählen muss: Die Grünen. Sie haben das schon immer gesagt. Sie richten Ihre ganze Politik danach aus- kompromisslos. Und das ist auch richtig: Wenn es um die Rettung der Welt geht, kann man keine Kompromisse machen- dann geht es um alles oder nichts- Lebensstandart der westlichen Welt hin, Arbeitsplätze her. Warum soll ich dann irgendeine Nachahmerpartei wählen. So was Rotgrünes wie die SPD, oder wie der Schöpfungserhaltungspartei Schwarzgrün? Die Grüngelben oder Gelbgrünen braucht dann ganz bestimmt niemand. Wo ist übrigens deren Wählerpotential?

In Internetforen und bei Veranstaltungen treffe ich aber auf sehr viel FDP Mitglieder und Sympathisanten, die nicht an den „Weltklimarat“ glauben. Es sind dies eigenständig denkende Menschen. Sie gehören nicht unbedingt zu den Besserverdienenden, aber zu den besser Gebildeten- und dieser Bevölkerungskreis ist entsetzt über die Klimapolitik der FDP. Bei der letzten Wahl haben sich schon einige enthalten- aber da ging es um die Verhinderung der schwarzroten Regierung, das war wichtiger als das Klima. Sie können sicher sein: Jetzt wo die FDP mitregiert und Herr Röttgen die selben Reden hält, wie einst Trittin und Sie dann im Parlament auch die CO2-Reduktion um 40% predigen- werden Sie diese Wähler verlieren, sogar wenn sie FDP-Mitglied sind. Sie bleiben einfach zu Hause oder warten auf eine Partei der Vernunft.

Was mich mindestens so irritiert, wie Ihr bedenkenloses Mitläufertum bei der CO2-Debatte und den daraus konstruierten Katastrophenszenarien, ist die von Ihnen und von Horst Meierhofer auf dem letzten Parteitag durchgesetzte Unterstützung des EEG. Wie kann eine Partei der Marktwirtschaft einen solchen massiven Eingriff in den Markt mittragen? Hier wird auf brutale Art und Weise umverteilt: Von den Massen der mittleren und kleinen Einkommen auf die Besserverdienenden, die sich Solardächer und Windkraftanlagen leisten können.

Natürlich brauchen wir eine Energiepolitik, die uns unabhängiger macht von den Gasfeldern Russlands und den Ölfeldern im Nahen Osten. Natürlich ist Energieeffizienz ein Wettbewerbsvorteil und selbstverständlich brauchen wir mehr Markt und Deregulierung in unserer Stromversorgung: Das EEG aber erfüllt davon nicht eine einzige Bedingung. Es hat zu Subventionsorgien in der Solarindustrie geführt und zu erheblichen Verwerfungen im ländlichen Raum, wo die Interessen der Windkraftbesitzer mit den Opfern der Windkraftanlagen brutal aufeinanderprallen. Aber alles was Ihnen dazu einfällt, ist den Subventionswahnsinn, der mit den Windkraftparks in der Nordsee und Desertec verbunden ist, als zukunftsträchtig anzupreisen.

Der Verdacht liegt nahe, dass Sie hier Interessen der Versicherungswirtschaft und der großen Konzerne, wie Siemens vertreten. Die Münchner Rück hat überall Ihre Finger mit dabei und manipuliert mit unsauberen Daten die öffentliche Diskussion. Haben Sie nicht mitbekommen, dass sich der Sprecher Al Gore`s für die falschen Katastrophenszenarien entschuldigt (New York Times) die leider von der Münchner Rück übernommen wurden und wissenschaftlich nicht haltbar sind? Haben Sie nicht verfolgt, wie die Münchner Rück und der von Ihr subventionierte Gutmenschenverein „German watch“ sich umgekehrt wieder auf genau diese Daten beruft und als Quelle Al Gore angibt?

Wessen Geschäft also betreiben Sie und Horst Meierhofer. Als Prof. Fred Singer in Huckelrieden einen Vortrag hielt, ist Herr Meierhofer vorher abgereist. Ich habe nicht feststellen können, dass er sich später für die Inhalte dieses Vortrages interessiert hätte. Am 4. Dezember wäre in Berlin wieder dazu Gelegenheit gewesen. Also…

Fazit:

1. Aus rein taktischen Gründen ist Ihre Klimapolitik für die FDP schädlich.

Eine wissenschaftliche Untersuchung über das Wählerklientel der FDP und seine Haltung zur menschengemachten Klimakatastrophe könnte hier Aufschluss geben. Meiner Beobachtung nach verschrecken Sie diese Wähler. Die Wahl in Nordrhein-Westfalen wird Rückschlüsse zulassen, ob die heute geführte Klimadebatte den Grünen oder der FDP zu Gute kommt. Wir werden ja sehen, ob es im Mai nicht doch zu einer schwarzgrünen Koalition kommt.

2. Ihre Folgerungen aus der Klimahysterie widersprechen diamentral einer freiheitlichen marktwirtschaftlich organisierten Gesellschaft. Ihre Vorschläge und die von Ihnen mit initiierten Parteitagsbeschlüsse strotzen von Dirigismus, Subventionen, Bevormundung der Bürger und Vorteilsgewährung der Mächtigen.

Da ich keine Alternative zur westlichen freiheitlichen Industriegesellschaft und ihrer Erhaltung und Weiterentwicklung sehe, werde ich, wo immer ich kann, auf diese Widersprüche Ihrer Politik aufmerksam machen.

Diesen Brief stelle ich jedem zur Verfügung, der sich dafür interessiert.

Hochachtungsvoll

Günter Ederer

17.2.2010

Januar 2010 zu warm? Merkwürdige Berechnungsmethoden des GISS (Goddard Institute of Space Sciences) für die Durchschnittstemperaturen der Welt im Januar 10

Wie kommt das?

Schauen wir uns die beiden Graphiken doch einmal genauer an. Wir sehen in der "wärmeren" Graphik, dass es dort fast keine grauen Flächen gibt. Zu grauen Flächen heißt es in der Erläuterung zur Graphik:

Note: Gray areas signify missing data.

Hier also gibt es keine Daten!

Man beachte: wählt man den kleineren Gültigkeitsradius für gemessene Temperaturen von 1200 KM auf 250 KM, dann werden die vielen Flächen sichtbar, die grau sind, also ohne jede Messstation. Und, fatal, sofort verändern sich die durchschnittlichen Temperaturen gravierend – und zwar: nach unten!!

Warum ist das so?

Bedeutet dies nicht, dass ganz erhebliche Flächen, wo überhaupt nicht gemessen wurde, mit einer "angenommenen" Temperatur versehen werden? Also z.B. Gebiete in Alaska oder der Antarktis werden durch die Wahl des Gültigkeitsradiuses für Temperaturen aus einer (weit abgelegenen – Radius 1200 KM!!) Messstation pauschal abgedeckt, obwohl dort nie gemessen wurde?

Wer legt die Legitimation für die Festlegung eines Radiuses fest oder erfolgt diese Festlegung willkürlich?

Wie würden die Daten aussehen, wenn der Radius nur noch 1, 10, 30 oder 50 KM betragen würde? Diese Wahl hat man nämlich nicht. Voreingestellt ist der Radius 1200 KM und zur Auswahl wurde nur noch 250 KM zugelassen. Eine Messstation, die Gültigkeit für 250 KM Umfeld hat, kann ich mir kaum vorstellen.

Fazit: Wenn ich hier nun "zufällig" Messstationen mit wärmeren oder kälteren Temperaturen in die Auswahl für den Radius genommen habe, dann würden sich für sehr grosse Regionen Temperaturen ergeben, die in der Realität so nicht abzubilden wären. Dazu muss man wissen, dass massgeblicher Faktor für die Berechnung der globalen Temperatur die Fläche (KM²) ist. Fläche ist erstmal neutral. Bekommt aber durch das "Überstülpen" einer "angenommenen" Temperatur die entscheidende Bedeutung. Das "Glätten" (smoothing) oder Gleichmachen von Flächen, die ohne jede reale Messung einfach nur grau wäre (also ohne Berücksichtigung bleiben müsste), ist aus mathematischer Sicht schlicht und einfach das Verfälschen von Daten und damit Ergebnissen, um eine vermutete Aussage visuell und statistisch belegen zu können. Wäre das nicht gewollt, gäbe es die Auswahl eines beliebigen Radiuses. Dieser Radius ist ein klassisch variabler Faktor, der nicht nur butterweich ist, sondern sogar fiktiv und reine Spekulation, da er nichts, aber auch gar nichts mit der Realität und den Echtdaten zu tun hat.

Anhand dieser einfachen Analyse wird deutlich, wie wesentlich es ist, die wissenschaftlich neutralen und korrekten Messstationen als Datenquelle zu nutzen, da Daten jeder "akzeptierten" Messstation für einige tausend "grauen" KM² zur Gültigkeit erklärt werden. So kommt jeglicher Auswahl von Messstationen eine ganz besondere Bedeutung zu.

Ein Übrigens habe ich dann auch noch:

In der Antarktis sehen wir selbst in der 2. Graphik, erstaulich viele eingefärbte Flächen. Bei einem Radius von 250 KM, den ich gewählt habe, müssten also in der Antarktis zig Messstationen Echtdaten liefern, immer gleichwarme übrigens, wie man sehen kann (siehe "Bodensockel"). Hat jemand eine Vermutung, wieviele Messstationen in der gesamten Antarktis real vorhanden sind? Das Alfred Wegener Institut hat EINE. Wer noch? Keiner? Tatsächlich niemand?

Dann wäre diese eine gemessene Temperatur für wieviel Fläche der Erde gültig? Mag jemand rechnen?

Ich lasse mich gern eines Besseren belehren. Gern stelle ich einen weiteren solcher Graphik-Vergleiche hier in das Forum, wenn es gewünscht wird.

Analytische Grüsse,

Blogger KlimaAutist

Quelle: Wetter Online

2. internationale Klimakonferenz in Berlin. Vorträge als Video abrufbar!

Prof. Patzelt 1. Teil

Prof. Patzelt 2. Teil

Prof. Singer 1. Teil

Prof. Singer 2. Teil

Dr. Svensmark 1.Teil

Dr. Svensmark 2.Teil

Dr. Svensmark 3.Teil

Prof. Lüdecke 1. Teil

Prof. Lüdecke 2. Teil

Prof. Lüdecke 3. Teil

Dr. Motl 1. Teil

Dr. Motl 2. Teil

Dr. Motl 3. Teil

Prof. Mörner 1. Teil

Prof. Mörner 2. Teil

Lord Monckton 1. Teil

Lord Monckton 2. Teil

Lord Monckton 3. Teil

Prof. Kerber 1. Teil

Prof. Kerber 2. Teil

Prof. Kerber 3. Teil

Dr. Holger Thuß EIKE Präsident

Sehen Sie auch die Vorträge als pdf Dokumente im Anhang

Related Files

Messungen der Oberflächentemperaturen: Eine politisch betriebene Täuschung?

Video: Hier sehen Sie Teil 1 des von John Coleman mit Joe Dáleo geführten 15 minütigen Interviews. Klicken Sie in das Bild (oder hier) werden Sie zu Teil 2 geführt.

Die von den Autoren durchgeführten Untersuchungen beweisen, dass der Vorwurf der Datenmanipulation berechtigt ist. Joseph D’Aleo & Anthony Watts haben ihre Beweise gründlich recherchiert und in der Darstellung mit Grafiken dokumentiert. Der Bericht enthält viele Links zu einschlägigen Datensätzen und Grafiken. Die Links müssen im Original der Publikation geöffnet werden; falls gewünscht, kann die vollständige Publikation per e-Mail zugesandt werden. Beispiel für ein Link: ‚here’ auf Seite 14 öffnet das Portal GISS Surface Temperature Analysis, Station Data, in der eine Weltkarte erscheint. Beim Klick auf ein Land erscheint eine Tabelle, in der die dort eingetragenen Stationen aufgelistet sind; beim Anklicken einer Station öffnet sich ihre Temperaturganglinie.

Die Manipulation wurde auf unterschiedliche Weise vorgenommen, beispielsweise bei der Berechnung der Durchschnittstemperatur einer Region durch das Weglassen der Daten von Stationen auf ‚kalten Standorten’ oder das unsachgemäße Einrichten von Stationen auf ‚warmen Standorten’. Beide Arten der Manipulation täuschen eine wärmere Temperatur vor.

Von den ca. 6000 Stationen wurden ab den späten 1980er und in den frühen 1990er Jahren die Daten von ca. 4500 Stationen bei der Berechnung der Durchschnittstemperaturen nicht mehr berücksichtigt – sie wurden ‚ausgesondert’. Stationen, die in ländlichen Gegenden, höheren geographischen Breiten und größerer Höhe liegen, wurde als ‚kältere Stationen’, zu Gunsten ‚wärmerer Stationen’ ‚ausgesondert’. Heute sind es sogar nur knapp 1100! Die Autoren sprechen auch vom ‚verschwinden’. Aus dieser ‚Aussonderung’ ergeben sich wärmere Mittelwerte. Aus der Studie geht nicht hervor, ob die Stationen still gelegt wurden, oder ob die Messungen andauerten und die Daten geliefert wurden, dann aber später von den Bearbeitern nicht berücksichtigt worden sind.

Stationen in den Städten und Vorstädten wurden oft nicht so eingerichtet, wie es nach WMO-Standard vorgeschrieben ist. Dieser sieht vor, dass die Stationen auf Grasland und mindestens 100 m von jeder Bebauung und Bepflanzung von Bäumen und Büschen einzurichten sind. Bei der Auswahl der Standorte wurden diese Standards oft nicht eingehalten, so dass Stationen beispielsweise an Hauswänden neben hohen Büschen und Bäumen eingerichtet, also in einer wärmeren Umgebung.

In diesem Auszug beschränkt sich die Behandlung aus Platz- und Zeitgründen vorrangig auf die überproportionale Aussonderung der Daten von kalten Stationen. Die Auswirkungen von unsachgemäß eingerichteten Stationen wird nur kurz behandelt, die unbeeinflussten Datensätze anderer Institutionen werden mit Grafiken zusammengefasst dokumentiert. Die Komplexe ‚Homogenisierung der Daten’ und ‚Fallstudien’, die zum Beweis der Hauptthese dieser Studie erörtert werden, werden nicht behandelt. Soweit der Bearbeiter eigene Ergebnisse einbringt oder Folgerungen ableitet, sind sie kursiv geschrieben. Dies geschieht in den Kapiteln

2.9 und 5: Vergleich mit Ergebnissen des Bearbeiters und Schlussbemerkung.

Wegen Zeitmangels ist nur eine sinngemäße Übersetzung des Textes möglich. Das Titelblatt, das Inhaltsverzeichnis, die Zusammenfassung für Politiker und die Lebensläufe der Autoren wurden im englischsprachigen Original übernommen, letztere wurden in das Titelblatt hineinkopiert. Die Zusammenfassung für Politiker wird ebenfalls sinngemäß übersetzt und beigefügt.

Die Autoren verzichten im Inhaltsverzeichnis und im Text auf eine Nummerierung der Kapitel. Wegen einer besseren Übersichtlichkeit werden die für diesen Extrakt ausgewählten Komplexe nummeriert, und zwar wie folgt:

1. Aussonderung von Stationen

2. Einfluss der Aussonderung auf die Durchschnittstemperaturen

2.1 USA

2.2 Russland

2.3 Kanada

2.4 China

2.5 Europa

2.6 Afrika

2.7 Südamerika

2.8 Australien und Neuseeland

2.9 Vergleich mit Ergebnissen des Bearbeiters

3. Regelwidrig angelegte Stationen

4. Unbeeinflusste Temperaturganglinien

4.1 USA

4.2 Australien

4.3 England

5. Schlußbemerkung

Im Text werden Originalabbildungen aus der Studie verwendet (Bild 1 bis 21); außerdem werden 2 Anlagen mit insgesamt 29 Temperaturganglinien aus Berichten des Bearbeiters beigefügt.

Text auszugweise:

Zusammenfassung für Politiker

1. Temperaturmessungen der Vor-Satelliten-Zeit (1850-1980) wurden so weitgehend, systematisch und gleichgerichtet gefälscht, dass nicht glaubwürdig behauptet werden kann, es habe im 20. Jahrhundert eine deutliche globale Erwärmung gegeben.

2. Alle mittels Temperaturmessungen an der Oberfläche erhaltenen Datensätze offenbaren sehr ernste Probleme, die sie für die Bestimmung genauer Langzeittrends der Temperatur nutzlos machen.

3. Alle Probleme verursachen eine Unsymmetrie der Daten, die beobachtete Erwärmung wird dadurch sowohl regional als auch global stark übertrieben.

4. Die mittels Temperaturmessungen an der Oberfläche erhaltenen Daten sind bedenklich beeinträchtigt, denn mehr als drei Viertel der ursprünglich existierenden 6000 Stationen werden nicht mehr berücksichtigt (wörtlich: berichten nicht mehr).

5. Es hat eine schlimme Verzerrung statt gefunden, höher und nördlicher und ländlich gelegene Stationen auszusondern, was zu einer weiteren ernsten Übertreibung der Erwärmung führt.

6. Die Belastung infolge Verstädterung, Änderungen der Landbenutzung, Auswahl untauglicher Standorte und unzureichende Eichung der Instrumente verstärkt außerdem die Erwärmung.

7. Zahlreiche erfolgreich begutachtete Veröffentlichungen haben in den letzten Jahren gezeigt, dass die beobachtete Langzeit-Erwärmung allein zu 30-50% durch solche Belastungen verursacht wird.

8. ‚Kirschen-pflücken’ bei der Auswahl der Beobachtungsstandorte kombiniert mit der Interpolation von Daten für fehlende Netzzellen mögen die Erwärmung im 20. Jahrhundert um mehr als 50 – 20 % verzerren.

9. Für die Ozeane fehlen Daten, und die Unsicherheiten sind beträchtlich. Eine umfassende Erfassung ist erst seit 2003 verfügbar, sie zeigt keine Erwärmung.

10. Satellitenmessungen sind eine Alternative zu den Erdstationen um weltweit Berichte zur Temperatur der unteren Troposphäre zu erhalten. Ihre Resultate weichen zunehmend von denen der Erdstationen ab. Sie bestätigen die in den Berichten zum Ausdruck kommende Warm-Verschiebung der Oberflächentemperaturen.

11. NOA und NASA, zusammen mit CRU, waren die treibenden Kräfte hinter dem systematischen Hochjubeln der weltweiten Erwärmung im 20. Jahrhundert.

12. Mittels Korrekturen wurden alte Berichte modifiziert, um zyklische Veränderungen so zu verschleiern, dass sie ohne weiteres als natürlich verursacht erscheinen, beispielsweise durch mehrdekadige Wechsel der Ozeane oder der Sonne.

13. Weltweit sind die terrestrisch gewonnenen Datensätze ernsthaft beschädigt; sie sind nicht mehr vertrauenswürdig, um Klimatrends zu beurteilen Modellprognosen rechtswirksam zu bestätigen.

14. Eine gründliche Bewertung der terrestrischen Temperaturdaten von CRU, GISS und NCDC ist erforderlich. Sie muss durch Klimawissenschaftler erfolgen, die unabhängig sind und kein eigenes Interesse am Ergebnis der Auswertungen haben.

15. Für das Vertrauen in die weltweiten Daten durch das UNIPCC und das US GCRP/CCSP ist eine vollständige Untersuchung und Rechenschaftslegung erforderlich.

Prof. Dr. Friedrich Karl Ewert EIKE

Lesen Sie den ganzen Text siehe Anlage. Die Originaldatei finden Sie hier

Dazu ausführliche Interviews (in Englisch) hier und hier und hier

Related Files

Klimadebatte: Taktischer Rückzug nach Debakel!

Jahrelang hatten Skeptiker diese Daten zu sehen verlangt, und nun entpuppt sich der Wissenschaftler im Zentrum dieser Kontroverse als zerstreuter Professor. Es ist wie in einem schlechten Science-fiction Film: Die Welt droht unterzugehen, und der Forscher, der sie retten könnte, verschludert die entscheidenden Unterlagen, mit denen er die bösen Skeptiker im Dienste finsterer Kapitalisten hätte ruhigstellen können. Gespannt wartet das Publikum jetzt darauf, was der etwas in die Jahre gekommene jugendliche Held Al Gore tun wird, um den Untergang doch noch abzuwenden. Ein weiterer Oscar ist ihm dabei bestimmt sicher.

Die Skeptiker haben in diesen Tagen gut lachen. Sie haben jedoch allenfalls eine Schlacht gewonnen – den Krieg jedoch längst noch nicht. Manche Alarmisten schwenken derzeit eine weiße Flagge – nicht jedoch, um zu kapitulieren, sondern um einen „Waffenstillstand“ zu fordern. Exakt dieses Wort taucht im Titel eines aktuellen Beitrags von Roger Harrabin auf, Umweltanalyst der „BBC“. Der Redakteur meint darin, dass beide Seiten „Gemeinsamkeiten“ finden könnten und stellt außerdem fest, dass es „beim Klimathema immer um Risiko und Unwägbarkeiten geht – nicht um unumstößliche Fakten“. Politiker sollten daher ihre Argumente „im Rahmen von Risiko und Unsicherheit formulieren“.

Doch genau hier liegt der Hund der Debatte begraben. Denn wenn in Sachen Klima die Risiken und Unwägbarkeiten groß sind, dann ist Demokratie das denkbar falscheste Vehikel, um Entscheidungen über die angemessenen Maßnahmen zu treffen. Risiken abzuwägen ist eine individuelle Entscheidung. Wenn jemand erkannt zu haben meint, dass die Welt einer baldigen Katastrophe entgegensteuert, und eine Möglichkeit zu sehen meint, diese abzuwenden, dann kann er nicht warten, bis sich demokratische Mehrheiten dafür finden. Er sieht sich dann moralisch verpflichtet, Diktator zu werden und für die Folgen seiner Handlungen die Gesamtverantwortung zu übernehmen. Dies ist die unter Alarmisten seit dem Scheitern der Kopenhagen-Konferenz mehr oder weniger offen diskutierte Handlungsvariante.

Es gibt aber noch eine andere Möglichkeit, Risiken auf der Basis von Individualentscheidungen zu begegnen. Diese Variante ist weder demokratisch noch diktatorisch, sondern marktwirtschaftlich. Und sie ist genau richtig für Situationen wie diese, wo Veränderungen größtenteils relativ langsam, teilweise jedoch auch sprunghaft und in den allermeisten Fällen in völlig unvorhersehbaren Richtungen verlaufen – können. Im marktwirtschaftlichen Szenario würden Individuen Versicherungen gegen Klimarisiken abschließen – oder auch nicht, je nachdem, wie sie ihre Lage persönlich einschätzen. Oder wie die Versicherungen die Lage einschätzen. Diese können auch genossenschaftlich organisiert sein. Wenn Individuen dort, wo sie sind, keine ausreichende Versicherung bekommen, die sie sich leisten können, dann können sie entweder auf Glück setzen oder wegziehen. In einer Welt eines realen Klimawandels werden manche Landstriche vorübergehend unbewohnbar, andere dagegen werden erstmals überhaupt bewohn- und bewirtschaftbar.

Solches Ansinnen ist für die allermeisten Klima-Alarmisten jedoch ein Sakrileg. Ihr Ziel ist eine global gesteuerte Wirtschaft und Menschheit. Wobei hier nicht die Wissenschaftler gemeint sind, sondern die Politiker und Funktionäre. Ein herbeigeredeter Klimawandel ist nur ihr Vorwand für Machtausweitung und für den zweiten Versuch eines real existierenden Sozialismus, diesmal weltweit. Ein deutlicher Indikator dafür ist die argumentative Rückzugslinie der Fußtruppen. In etlichen Diskussionen taucht immer wieder dieses eine Mem auf: Es gibt zu viele Menschen auf der Welt. In höflichen Kreisen wird das nicht erwähnt, aber die Häufigkeit, mit der dieses Argument derzeit in den Foren auftaucht, zeigt, dass diese Überzeugung weit verbreitet ist. Das ist auch nicht weiter überraschend, denn sie stimmt – unter einer entscheidenden Bedingung: Dass Sozialismus herrscht. Die gegenwärtige Verwirrung im Alarmistenlager bringt die wahren Beweggründe an den Tag. Wer offen über Bevölkerungsreduzierung redet, ist zwar schlau genug, die versteckte Agenda hinter dem Klimathema zu erkennen, aber nicht schlau genug, sie zu verschweigen. So wie Fußtruppen nun mal sind.

Eine sozialistische Welt wäre ganz gewiss nicht in der Lage, auch nur eine einzige Milliarde Menschen zu ernähren, zu behausen und zu bekleiden. Eine kapitalistische Welt hingegen wäre – man beachte den Konjunktiv – in der Lage, weit mehr als die heutigen sechs oder sieben Milliarden zu versorgen. Wieviel genau kann keiner sagen – das hängt vom Stand der wissenschaftlichen und technischen Entwicklung ab – und die nur im Kapitalismus gedeihen. Der Markt würde die Preissignale setzen, die die jeweils gegenwärtigen Grenzen des Wachstums markieren würden. Keine Zentralkommission wäre nötig. Knappheiten würden ganz von alleine durch die Preise widergespiegelt. Diese würden den Menschen als Wegweiser dafür dienen, was sie tun müssen, um diese Knappheiten zu vermeiden – zum Beispiel durch niedrigere Geburtenraten oder Wegzug aus unwirtlichen Gegenden. Oder zu überwinden – zum Beispiel durch Erschließung neuer Rohstoffquellen oder die Erfindung neuer Prozesse der Müllverarbeitung oder -nutzung.

Doch das kommt den Alarmisten nicht in den Sinn. Nicht weil sie etwas gegen den Kapitalismus haben – das haben sie dank ihrer Lehrer und den Massenmedien ohnehin – sondern weil ihre Einstellung auf einem Glaubenskonstrukt fußt, das mit dem Kapitalismus schlicht unvereinbar ist. Es ist der Glaube daran, dass die Realität heute, und wie sie in Zukunft sein wird, in ihrer objektiven Ganzheit erfassbar ist. Dieser prinzipielle Glaube ist die Grundlage für die Überzeugung, dass es den Menschen möglich ist, die für sie perfekte, fehlerfreie, makellos gerechte Welt zu gestalten. Man muss nur das richtige Bewusstsein haben. Wer es nicht hat, stört nur und muss aus dem Weg geschafft werden.

Kapitalismus fußt auf dem gegenteiligen Glauben, nämlich dass die Welt in ihrer Gänze nicht objektiv erfassbar ist, schon gar nicht, wie sie in Zukunft aussehen wird. Auf dieser Grundlage ist der einzige Weg zum Glück nicht die Gestaltung nach dem, und individuelle Anpassung an den, Masterplan, sondern ein riesiges Entdeckungsverfahren nach dem Prinzip von Versuch und Irrtum. Im Kapitalismus nutzen Individuen das Preissystem, um in all dieser Unübersichtlichkeit mit dem Rest der Welt zu kommunizieren. Und je mehr Menschen es im Kapitalismus gibt, desto mehr Arbeitsteilung ist möglich, desto mehr Information wird kommuniziert, desto leichter wird es, Knappheiten zu vermeiden oder sie zu überwinden. Im Sozialismus wird diese – wie auch andere – Kommunikation unterdrückt, damit der Masterplan zur Herstellung der angeblich besten aller Welten ungestört verwirklicht werden kann.

Die gegenwärtige Frontverschiebung in der Klimadebatte hat die hässliche ideologische Grundlage, die wahre Natur der Alarmisten sichtbarer gemacht. Damit ist schon viel gewonnen. Aber ihre Bataillone sind noch immer sehr stark, sowohl personell als auch finanziell und vor allem in den Medien. Ihre Moral ist zwar angeschlagen, aber noch lange nicht gebrochen. Ihr Glaubenskonstrukt ist noch vollständig intakt. Und das Klimathema ist zu wertvoll für sie, zu praktisch im Hinblick auf das Ziel eines weltweiten Sozialismus, als dass sie es leichtfertig aufgeben werden. Langfristig können die Skeptiker in diesem Kampf also nur dann siegen, wenn sie den Krieg um die Köpfe und Herzen der Menschen gewinnen, was im Streit um das richtige Messen und die richtige Interpretation wissenschaftlicher Fakten schnell mal übersehen werden kann.

Was werden die nächsten Schritte der Alarmisten sein? Vermutlich werden sie zunächst einmal abwarten, ob es in nächster Zeit wieder ein paar ungewöhnlich warme Jahre gibt. Dann können die medialen Kanonen wieder fröhlich Untergangsstimmung verbreiten – in der Hoffnung, dass bis dahin das jetzige Debakel in der Bevölkerung vergessen sein wird und die neuen Medien des Internet entweder nicht an Bedeutung gewonnen haben oder wirksam zensiert werden können. Falls die Natur nicht mitspielt, können sie eine taktische Konzession vornehmen und das „Hockey-Team“ in Gänze opfern, sie also der fehlerhaften Arbeit bezichtigen. Es wäre nicht das erste Mal, dass Sozialisten ihre Helfershelfer ihrem Schicksal überließen oder gar ans Messer lieferten, um die Gesamtbewegung zu schützen. Dann wäre die menschengemachte Klimakatastrophe nicht mehr „unmittelbar bevorstehend“, sondern nur noch „unabwendbar, wenn nichts geschieht“. Wenn das nicht hilft, bleibt eigentlich nur noch das Fallenlassen jeglicher Vorwände und der offene Schritt in die diktatorische Weltregierung, wie Brian Micklethwait in einer Analyse feststellt. „Wie im Fall der EU werden sie schlicht verkünden, dass ihre Herrschaft unvermeidlich ist, und dass nur Dummköpfe darauf beharren würden, sie in Frage zu stellen.“ Dies wäre jedoch, schließt Micklethwait seine Überlegungen ab, eine hochriskante Taktik, denn: „Diese Leute wollen nicht wirklich verkünden, dass sie die unanfechtbare Weltherrschaft besitzen, solange und bis das nicht tatsächlich der Fall ist.“

Solange zumindest gibt es noch eine Chance für die Freiheit.

mit Dank an Robert Grözinger von eigentümlich frei

Sie auch den neuen Artikel von Edgar Gärtner ebenfalls in eigentümlich frei

Internet:

„BBC“-Interview mit Professor Phil Jones

Roger Harrabin: Climate ‚Armistice‘

Brian Micklethwait: Climategate and the retreat from Immeditate

Offizielle Aussage, dass die wissenschaftliche Basis im IPCC Report korrekt sei, ist nicht haltbar!

Die Verteidiger (und hier) des IPCC führen ins Feld, dass die meisten dieser Fehler von geringer Bedeutung wären und auf den Bericht der 2. Arbeitsgruppe (WG II, impacts, adaptation and vulnerability) begrenzt wären, welcher von Vertretern verschiedener regionaler Interessen verfasst wurde, und dass er nicht so viel harte Fakten (hard science) enthielte, wie der Report der Arbeitsgruppe 1 (WG I, The Physical Science Basis). Weiter sagen die IPCC Verteidiger, dass keine (oder praktisch keine) Probleme solcher Art mit dem Report der Arbeitsgruppe 1, der wissenschaftlichen Basis des Klimawandels, aufgetaucht wären.

Tatsächlich basiert der Bericht der Arbeitsgruppe 1 auf einem Prozess der, wie die Klimagate E-Mails eindrucksvoll beweisen, eben verhindert, dass eine umfassende Übersicht über den Stand der Klimaforschung entsteht. Stattdessen ist es mehr eine Art “Beurteilung” über den Zustand der Klimaforschung, eine Beurteilung die hauptsächlich die vorgefasste Meinung des IPCC widerspiegelt, welche dann von einigen ausgewählten Elite-Autoren in den jeweiligen Kapiteln verkündet wird. Das Endergebnis dieser “Beurteilung” ist dann, dass Beweise hervorgehoben werden, welche die vorgefasste Meinung unterstützen, und solche die dieser widersprechen ignoriert oder sogar verunglimpft werden.

![]() Prominenteste Beispiele für ein solches Vorgehen waren dieUnstimmigkeiten bei den Klimarekostruktionen aus Baumringen , das Verschweigen von Widersprüchen zwischen Rekonstruktionen und aktuellen Messungen (“Hide the Decline“) oder die Affäre um die CRU Daten zur Globaltemperatur, die einfach verschwunden sind. Eine gute Übersicht über diese und zahlreiche weitere Beispiele hat vor kurzem das Science & Public Policy Institute (SPPI) in einem Bericht für die amerikanischen Umweltschutzbehörde (EPA) zusammengefasst.

Prominenteste Beispiele für ein solches Vorgehen waren dieUnstimmigkeiten bei den Klimarekostruktionen aus Baumringen , das Verschweigen von Widersprüchen zwischen Rekonstruktionen und aktuellen Messungen (“Hide the Decline“) oder die Affäre um die CRU Daten zur Globaltemperatur, die einfach verschwunden sind. Eine gute Übersicht über diese und zahlreiche weitere Beispiele hat vor kurzem das Science & Public Policy Institute (SPPI) in einem Bericht für die amerikanischen Umweltschutzbehörde (EPA) zusammengefasst.

Zweifelhafte Quelle sollte Entwicklung in der Antarktis kleinreden

Und jetzt wurde noch ein weiterer Fall bekannt, bei dem das IPCC bei der Auswahl von Quellen offensichtlich nur nach einem Kriterium vorgegangen ist. Und dieses Kriterium war nicht saubere wissenschaftliche Arbeit, sondern die Unterstützung der hauseigenen Agenda, die aktuelle Erwärmung in einem möglichst dramatischen Licht dastehen zu lassen. Und zwar in diesem Fall bei der Beurteilung der Eisentwicklung in der Antarktis.

Während in der Presse hauptsächlich von dem Rückgang der Eisbedeckung der Arktis, welcher in den letzten 30 Jahren beobachtet wurde, berichtet wird, findet die Tatsache, dass die Eisbedeckung in der Antarktis im gleichen Zeitraum zugenommen hat, nur wenig bis gar keine Beachtung. Und ohne Zweifel ist der Mangel an Presseberichten auch Resultat dessen, wie das IPCC dieses Thema behandelt.

Im IPCC AR4 wird die Situation in Kapitel 4 (WGI, “Observations: Changes in Snow, Ice, and Frozen Ground” (S. 351)) folgendermaßen beschrieben:

Als Beispiel wird eine aktualisierte Version der Analyse von Comiso (2003), die den Zeitraum von November 1978 bis Dezember 2005 umfasst, in Abbildung 4.8. gezeigt. Gezeigt werden die Anomalien der Jährlichen Eisausdehnung. Man sieht einen signifikant abnehmenden Trend beim arktischen Seeeis von –33 ± 7,4 × 103 km2 Jahr–1 (entsprechend –2,7 ± 0,6% pro Dekade), wohingegen die Ergebnisse der Antarktis einen leicht positiven Trend von 5,6 ± 9,2 × 103 km2 Jahr–1 (0,47 ± 0,8% pro Dekade) zeigen, welcher statistisch nicht signifikant ist.

As an example, an updated version of the analysis done by Comiso (2003), spanning the period from November 1978 through December 2005, is shown in Figure 4.8. The annual mean ice extent anomalies are shown. There is a significant decreasing trend in arctic sea ice extent of –33 ± 7.4 × 103 km2 yr–1(equivalent to –2.7 ± 0.6% per decade), whereas the Antarctic results show a small positive trend of 5.6 ± 9.2 × 103 km2 yr–1 (0.47 ± 0.8% per decade), which is not statistically significant.

Nur das IPCC sieht keinen statistisch signifikanten Anstieg

Man beachte, dass das IPCC die Zunahme der Eisfläche in der Antarktis als statistisch nicht signifikant ansieht, womit ein guter Grund vorhanden ist, diesen Anstieg herunterzuspielen. Und so schreibt das IPCC auch dann in der Zusammenfassung con Kapitel 4 (Executive Summary S. 339):

Satellitendaten zeigen eine Fortführung der Abnahme von 2,7 ± 0,6% pro Dekade bei der arktischen Eisausdehnung seit 1978 an. Der Rückgang der Sommerausdehnung ist stärker als im Winter, mit einem Sommerminimum, dass mit 7,4 ± 2,4% pro Dekade seit 1979 zurückgeht. Andere Daten zeigen an, dass der Rückgang im Sommer um 1970 begann. Ähnliche Untersuchungen für die Antarktis zeigen stärkere unterjährige Schwankungen aber keinen beständigen Trend.

Satellite data indicate a continuation of the 2.7 ± 0.6% per decade decline in annual mean arctic sea ice extent since 1978. The decline for summer extent is larger than for winter, with the summer minimum declining at a rate of 7.4 ± 2.4% per decade since 1979. Other data indicate that the summer decline began around 1970. Similar observations in the Antarctic reveal larger interannual variability but no consistent trends.

In der “Zusammenfassung für politische Entscheidungsträger” (Summary For Policymakers) werden daraus zwei gesonderte Punkte:

Satellitendaten seit 1978 zeigen, dass die die jährliche arktische Eisausdehnung um 2,7 [2,1 bis 3,3]% pro Dekade geschrumpft ist, mit einem stärkerem dekadischen Rückgang im Sommer von 7,4 [5.bis 9,8]%. Diese Werte sind konsistent mit denen im 3. Zustandsbericht (TAR {4.4}).

Satellite data since 1978 show that annual average arctic sea ice extent has shrunk by 2.7 [2.1 to 3.3]% per decade, with larger decreases in summer of 7.4 [5.0 to 9.8]% per decade. These values are consistent with those reported in the TAR. {4.4}

und

Die Eisausdehnung in der Antarktis zeigt weiterhin unterjährige Schwankungen und lokale Veränderungen, aber keine statistisch signifikanten Durchschnittstrends, konsistent mit dem Fehlen einer Erwärmung, welche sich in den atmosphärischen Temperaturen in der Region widerspiegelt {3.2, 4.4}

Antarctic sea ice extent continues to show interannual variability and localised changes but no statistically significant average trends, consistent with the lack of warming reflected in atmospheric temperatures averaged across the region. {3.2, 4.4}

“Zeigt weiterhin…keine statistisch signifikanten Durchschnittstrends”? Weiterhin?

Lesen Sie hier, was im dritten Zustandsbericht des IPCC (TAR, 2001) zu der Eisentwicklung in der Antarktis stand (Kapitel 2, S. 125):

Über den Zeitraum von 1979 bis 1996, zeigte die Antarktis (Cavalieri et al., 1997; Parkinson et al., 1999) einen schwachen Anstieg von 1,3 ± 0,2%/Dekade.

Over the period 1979 to 1996, the Antarctic (Cavalieri et al., 1997; Parkinson et al., 1999) shows a weak increase of 1.3 ± 0.2%/decade.

Beachten Sie hierbei, dass dies ein statistisch signifikanter Anstieg ist. In der Zusammenfasung des IPCC TAR, Kapitel 3 findet sich folgende Beurteilung:

…Satellitendaten zeigen an, dass die Eisausdehnung in der Antarktis, nach einem möglichen Rückgang Mitte der 1970er Jahre, seit 1978 stabil war oder sogar zugenommen hat

…Satellite data indicate that after a possible initial decrease in the mid-1970s, Antarctic sea-ice extent has stayed almost stable or even increased since 1978.

IPCC 2007 widerspricht IPCC 2001

Fassen wir also zusammen: Die Behauptung im 4. Zustandsbericht (IPCC AR4), dass die Trends der Eisentwicklung in der Antarktis “weiterhin…keine statistisch signifikanten Durchschnittstrends” zeigen, steht in direktem Widerspruch zu den Aussagen im 3. Zustandsbericht (TAR).

Interessanterweise enthielt der AR4 keine Quellenangaben zu früheren Studien, die gezeigt haben, dass das Eis in der Antarktis statistisch signifikant zugenommen hatte. Im AR4 gab es keinen Bezug auf die TAR-Quellen, weder Cavalieri et al., 1997, oder Parkinson et al., 1999, noch enthielt der AR4 einen Hinweis auf Zwally et al., 2002, in dem gefunden wurde:

Der abgeleitete 20jährige Trend der Seeeis-Ausdehnung ist 11,18 ± 4,19 x 103 km2Jahr-1 oder 0,98 ± 0,37% pro Dekade für die gesamte antarktische Eisbedeckung, und somit signifikant positiv.

The derived 20 year trend in sea ice extent from the monthly deviations is 11.18 ± 4.19 x 103 km2yr-1 or 0.98 ± 0.37% (decade)-1 for the entire Antarctic sea ice cover, which is significantly positive.

Die Autoren zitieren in ihrem Artikel eine weitere Studie, welche ebenfalls einen statistisch signifikanten Anstieg der antarktischen Eisbedeckung, für den Zeitraum von 1978 bis 1996, gefunden hatte:

Eine aktuelle Analyse des Trends beim Antarktischen Seeeis von 1978–1996 von Watkins und Simmonds [2000] fans einen signifikanten Anstieg bei der Eisausdehnung und Eisfläche, ähnlich den Ergebnissen dieser Studie.

Also, a recent analysis of Antarctic sea ice trends for 1978–1996 by Watkins and Simmonds [2000] foundsignificant increases in both Antarctic sea ice extent and ice area, similar to the results in this paper.

Auch die Arbeit von Watkins und Simmonds tauchte nirgends im 4. Sachstandsbericht des IPCC auf.

“Überarbeitete” Lehrbücher statt wissenschaftlicher Studien

Welche wissenschaftlichen Ergebnisse wurden also von den Autoren des IPCC AR4 zitiert, um ihre “Abschätzung” zu belegen, dass sich das Eis in der Antarktis eben nicht statistisch signifikant ausgedehnt hatte? Die Antwort ist “eine aktualisierte Version der Analyse von Comiso (2003)”. Nur ist “Comiso (2003)” keine begutachtete wissenschaftliche Studie, sondern ein Kapitel in einem Lehrbuch.

Comiso, J.C., 2003: Large scale characteristics and variability of the global sea ice cover. In: Sea Ice – An Introduction to its Physics, Biology, Chemistry, and Geology [Thomas, D. and G.S. Dieckmann (eds.)]. Blackwell Science, Oxford, UK, pp. 112–142.

Und das IPCC zitierte nicht einmal, was in diesem Kapitel steht, sondern stattdessen eine “aktualisierte Version der Analyse”, die in diesem Kapitel gezeigt wurde.

Anhand dieser “aktualisierten Version” berichtete das IPCC nun, dass die Zunahme der Eisbedeckung der Antarktis nur halb so groß ist, wie in der wissenschaftlich begutachteten Literatur beschrieben.

Und noch weitere Punkte verdienen es, beachtet zu werden

1.) Josef Comiso (der Autor des oben erwähnten Buch-Kapitels) war beisteuernder Autor (Contributing Author) von Kapitel 4 im 4. Sachstandbericht des IPCC. Wahrscheinlich haben sich die Hauptautoren des Kapitels einfach direkt an Comiso gewandt, welcher dann eine (nicht wissenschaftlich begutachtete) “aktualisierte Version” des Kapitels zur Verfügung gestellt hat (wie praktisch…).

und 2.) Comiso hat im Jahr 2008 eine Folgestudie veröffentlicht. In dieser Arbeit wird die Betrachtung im Vergleich zum IPCC-Report um nur ein Jahr erweitert (2006 anstatt 2005). Und wie schon im IPCC-TAR wird auch in dieser Arbeit ein signifikanter Anstieg der Eisbedeckung in der Antarktis gefunden, mit ganz ähnlichen Zuwachsraten wie im TAR:

Mit dem Update auf das Jahr 2006 ist ein leichter Anstieg von Eisfläche und Ausdehnung zu sehen von 0,9 ± 0,2 und 1,7 ± 0,3% pro Dekade.

When updated to 2006, the trends in ice extent and area …in the Antarctic remains slight but positive at 0.9 ± 0.2 and 1.7 ± 0.3% per decade.

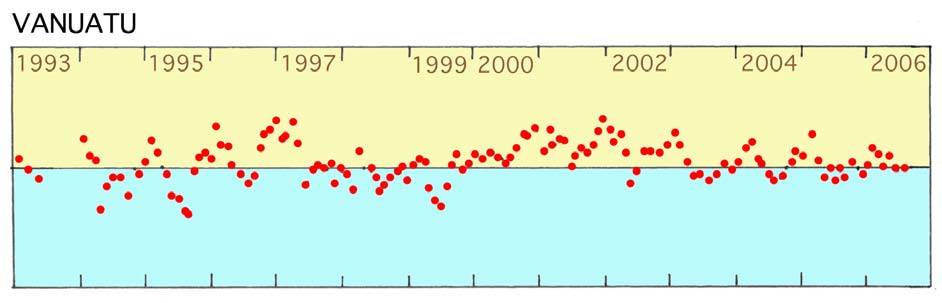

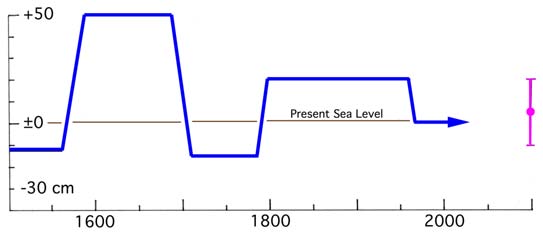

Trend der arktischen Eisausdehnung von November 1978 bis Dezember 2006 nach Comiso und Nishio 2008

Und nur für den Fall, dass es noch weiterer Belege bedarf, in einer aktuellen Arbeit von Turner et al. (bei der Comiso als Co-Autor fungierte) wird geschlossen:

Basierend auf einer neuen Analyse der Satellitendaten konnten wir zeigen, dass die jährliche durchschnittliche Ausdehnung des Seeeises in der Antarktis seit den späten 1970ern statistisch signifikant mit einer Rate von 0,97% pro Dekade zugenommen hat.

Based on a new analysis of passive microwave satellite data, we demonstrate that the annual mean extent of Antarctic sea ice has increased at a statistically significant rate of 0.97% dec-1 since the late 1970s.

Diese Anstiegsrate war also annähernd zweimal so groß wie der Wert, den das IPCC (aus der nicht wissenschaftlich begutachteten Quelle) in seinen 4. Sachstandbericht aufgenommen hat.

Einzig das IPCC sieht keinen statistisch signifikanten Anstieg

Es hat sich also gezeigt, dass die wissenschaftliche Literatur, sowohl jene, die zum Zeitpunkt der Publikation des 4. Sachstandberichtes bekannt war, als auch solche, die seitdem veröffentlicht wurde, einen signifikanten Anstieg der Eisbedeckung des Meeres um die Antarktis gefunden hat. Nur im AR4 des IPCC wurde irgendwie “befunden”, dass dieser Anstieg nicht nur halb so groß, wie in der wissenschaftlichen Literatur beschrieben war, sondern zudem noch statistisch nicht signifikant. Das ermöglichte es dem IPCC, die Zunahme des Eises in der Antarktis sowohl in der wissenschaftlichen Zusammenfassung, als auch in der “Zusammenfassung für politische Entscheidungsträger” herunterzuspielen.

Warum dies gemacht wurde muss einen nicht weiter wundern. Schließlich schreibt das IPCC in seiner “Summary for Policymakers” doch selbst:

Das Seeeis wird nach den Vorhersagen sämtlicher SRES Szenarien schrumpfen, sowohl in der Arktis, als auch in der Antarktis

Sea ice is projected to shrink in both the Arctic and Antarctic under all SRES scenarios

Und wenn sich die Natur nun partout nicht an die Vorhersagen halten will, dann muss eben die Realität an die Szenarien angepasst werden.

Rudolf Kipp EIKE (der Artikel erschien zuerst auf ScienceSceptical)

Quelle: World Climate Report – Another IPCC Error: Antarctic Sea Ice Increase Underestimated by 50%

ÄHNLICHE BEITRÄGE (BETA):

Status der Klimaforschung 2010? Der Hochschullehrer em. Arthur Rörsch bittet den niederländischen KNAW-Präsidenten Robbert Dijkgraaf um eine gründliche Qualitätsbeurteilung !

Bei der öffentlichen Debatte und auch bei der darauf folgenden Meinungsänderung in der Politik geht es aber am Kern der Problematik vorbei, die durch Climagate schärfer in das Scheinwerferlicht gerückt worden ist : Die Klimauntersuchungen, die im vergangenen Vierteljahrhundert unter der Flagge des IPCC gemacht wurden, sind in hohem Maße von der Politik gesteuert worden (advocacy research). Daher kann von ihrem ersten Auftreten an die IPCC nicht als wissenschaftlich zusammenarbeitender Verband angesehen werden.

Vor allem Arthur Rörsch hat wiederholt auf den Umstand hingewiesen, dass es sich um ein vermeintlich mit wissenschaftlichen Aussagen operierendes UN-Organ handelt, dem auf nationalem Niveau durch die Behördenorganisationen (in den Niederlanden durch das PCCC gekoppelt) nahtlos gefolgt wird.

Rörsch hat deswegen im Januar zusammen mit Bas van Geel und Noor van Andel den KNAW-Präsidenten Robbert Dijkgraaf gebeten, eine unabhängige Kommission ins Leben zu rufen, die sich mit dieser Problematik befassen sollte.

Rörsch wiederholt nun (in dem angehängten Brief) diese Bitte und fügt weitere ausgearbeitete Argumente in der ausführlichen Nota: "The state of climate research 2010. A general view on the social infrastructure of climatology research"hinzu. Den kompletten Text finden Sie auf der Seite Actueel Document auf der Webseite der Zeitschrift Spil: http://www.platteland-in-perspectief.nl.

Arthur Rörsch weiß, wovon er spricht und schreibt:

Schon seit 2003 arbeitet er an einer kritischen Analyse der Berichte zu Klimaveränderungen. Ende des vorigen Jahres publizierte er seinen soundsovielten außergewöhnlich erhellenden Artikel in Spil 263-264 / 2009 – Nummer 5. Darin präsentierte er eine Alternative zu der AGW-Annahme, die davon ausgeht, dass der Anstieg der CO2-Konzentration in der Atmosphäre einen signifikanten Effekt auf den irdischen Treibhauseffekt hat.

Die alternative Vision von Rörsch basiert auf den klassischen klimatologischen Erkenntnissen, die davon ausgehen, dass normale Wettererscheinungen eine regulierende Funktion bei der Handhabung der weltweit registrierten Mitteltemperatur ausüben. Untersuchungen dazu und eine sorgfältige Wertung der Wahrnehmungen werden mit aller Wahrscheinlichkeit zu besseren Einsichten führen.

Qualitätsprobleme, international und national

In einem folgenden in Spil 265-266 / 2010 – Nummer 1 erschienenen Artikel argumentiert Arthur Rörsch noch schärfer: Er beurteilt die heutigen Kenntnisse über die Funktionen des irdischen Treibhauseffekts wissenschaftlich als unter dem Niveau. Essentielle naturwissenschaftliche und meteorologische Erkenntnisse wurden unter den Teppich gekehrt, um an dem in den achtziger Jahren begonnenen Weg einer politisch gesteuerten Wissenschaft festhalten zu können. Diese Feststellung trifft nicht nur auf die international mächtige IPCC zu, sondern auch auf die folgsamen national aktiven „Klimaexperten“, bei denen eine unzureichende wissenschaftliche Qualität zu kritisieren ist.

Auf der Basis seiner heutigen Erkenntnisse kommt Rörsch zu dem Schluss, dass die Evaluationstudien, auf deren Grundlage die CO2-Hypothese des Intergovernmental Panel on Climate Change (IPCC) bis heute die Richtung der Beschlüsse der politischen Entscheidungsorgane vorgibt, höchstwahrscheinlich unrichtig sind.

Neue unabhängig ausgeführte Analysen stehen bereit, nun nachdem mit dem Climagate die ersten Zweifel an der Qualität der Evalutionsuntersuchungen auf internationalem Niveau gekommen sind.

Wieder auf dem Weg zur Wahrheitsfindung

Die Wahrheitsfindung ist ein wesentlicher Aspekt der wissenschaftlichen Untersuchungen

Die Anwendung von Resultaten der wissenschaftlichen Untersuchungen hat für das Zusammenleben unverkennbar eine große Bedeutung. Aber die beiden Aspekte sollten nicht untereinander in Streit liegen. In der Vergangenheit haben sich verstärkt Zweifel an der Unabhängigkeit der klimatologischen Untersuchungen herausgestellt. Es ist daher nötig geworden, das Ausgangsmaterial für die Alarm-Botschaften des IPCC kritisch zu überprüfen.

Problematisch ist die Erscheinung, dass viele ein blindes Vertrauen in die Veröffentlichungen von bekannten Untersuchern in wissenschaftlichen Zeitschriften setzen. Dieses Vertrauen steht im Gegensatz zu der westlichen wissenschaftlichen Arbeit , die dem Spruch im Wappen der British Royal Society folgt: Nullius addictus jurare in verba magistra, frei übersetzt: Glaube nicht alles,was der Große Meister sagt!

Der Streit um die Wissenschaft in der Soziobiologie

Die Politisierung der Wissenschaft und das Verfahren von advocacy research sind auch in anderen Disziplinen der heutigen Klimatologie wahrzunehmen.

Vor einem Jahrzehnt beschrieb Ullica Segerstrale diese Erscheinung bezogen auf die Soziobiologie in ihrem Buch: Defenders of the Truth: The battle for Science in the Sociobiology (Oxford University Press, 2000). Auch dort verdrängte die advocacy research die objektive Ausübung der Wissenschaft.

Segerstrale behandelt die Spannung zwischen wissenschaftlicher Wahrheit und der gesellschaftlichen Einstellung. Hier geht es mehr um die Spannung zwischen bisherigen Paradigmen und der Ideologie, die heutzutage als ‚politische Korrektheit’ beschrieben wird, Der Schluss daraus ist, dass die Macht in wesentlichem Umfang bestimmt, wer der Gewinner in einer wissenschaftlichen Debatte wird.

Kein Mittel wird gescheut, um den Gewinn sicherzustellen: Hexenjagd, Fehlen einer kritischen Einstellung, unerwünschte Unterbrechungen bei Vorträgen, Verkündigung von Halbwahrheiten durch ‚Experten’, vorsätzliche Fehlinterpretationen, beleidigender Sprachgebrauch, Schmähungen, Furcht vor Tatsachen und Unterdrückung der Wahrheitsfindung,

Bestellung einer unabhängigen Beurteilungskommission

In der so genannten Klimadebatte sind solche Vorgänge festzustellen. Es ist daher von großer wissenschaftlicher und gesellschaftlicher Bedeutung, dass jetzt eine tief greifende Untersuchung zur Qualität der Evaluationstudien zu den Klimaveränderungen vorgenommen und anschliessend publiziert wird. Mit Eile sollte eine unabhängige Beurteilungskommission tätig werden und untersuchen, wie Teile der Klimatologie auf Abwege geraten konnte, Eine Institution wie die Koninklijke Akademie van Wetenschappen (KNAW) sollte die Verantwortung dafür übernehmen.

Vor allem zwei Fragen sollten dabei beantwortet werden:

Zuerst sollten die Verkünder der IPCC-Doktrin gefragt werden, wie Qualität ihrer Einsichten zum irdischen Treibhauseffekt ist.

Zum zweiten sollte festgestellt werden, wie in wissenschaftlichen Kreisen über den advocacy research geurteilt wird und hier vor allem darüber, warum nur ein einziges Paradignum eine Rolle bei den wissenschaftlichen Untersuchungen gespielt hat.

Rörsch sagt es noch nicht so deutlich, aber er lässt durchblicken, dass er vom allgemeinen wissenschaftlichen Gesichtspunkt wenig Respekt vor denen hat, die sich auf nationalem Niveau als ‚Klimaexperten’ profiliert haben.

Dokumentation

Diverse Artikel von Prof. Arthur Rörsch, unter denen sich der erwähnte Bericht befindet, finden Sie unter Actueel Document auf der Webseite:

http://www.platteland-in-perspectief.nl.

Sie finden dort auch kritische Artikel von anderen Autoren zur Klimaveränderung, so von Bas van Geel, Dick Thoenes und Marcel Crok.

Schule-Bildung-Klimawandel-CO2: Der Mensch zerstört das CO2-Gleichgewicht der Erde!

und weiter:

Gefunden und zusammengestellt von CS EIKE

Klimawandel Statement von William Happer – Cyrus Fogg Bracket Professor für Physik an der Princeton University!

Frau Vorsitzende und Mitglieder, ich danke für die Gelegenheit, vor dem Ausschuss für Umwelt und Öffentliche Bauvorhaben zum Klimawandel auszusagen. Mein Name ist William Happer, und ich bin der Cyrus Fogg Bracket Professor für Physik an der Princeton University. Ich bin kein Klimatologe, aber ich glaube nicht, dass irgendwer der anderen Zeugen dies ist. Ich arbeite in den verwandten Feldern der Atom-, Molekular- und optischen Physik. Ich habe mein Arbeitsleben dem Studium der Wechselwirkung von sichtbarer und infraroter Strahlung mit Gasen gewidmet, – eines der wichtigsten physikalischen Phänomene des Treibhauseffekts. Ich habe über 200 Beiträge – überprüft von anderen Wissenschaftlern – in wissenschaftlichen Zeitschriften veröffentlicht. Ich bin Mitglied in einer Anzahl von professionellen Organisationen, die amerikanische Physikalische Gesellschaft und die Nationale Akademie der Wissenschaften eingeschlossen. Ich habe eine umfangreiche Beratertätigkeit für die US- Regierung und Industrie ausgeübt. Ich war von 1990 bis 1993 Direktor des Forschungsinstituts für Energie (DOE). Dort habe ich auch alle Arbeiten von DOE zum Klimawandel überwacht. Ich bin hierher gekommen als besorgter Bürger, um meine persönlichen Ansichten und solche vieler, wie ich, zur US-Politik des Klimawandels zu äußern. Dies sind weder offizielle Ansichten meines Hauptarbeitgebers, der Princeton University, noch von irgendeiner anderen Organisation, mit der ich verbunden bin.

Lassen sie mich klar feststellen, wo ich wahrscheinlich mit den anderen Zeugen übereinstimme. Über die vergangenen 200 Jahre hatten wir eine Periode genereller globaler Erwärmung. Zwischendurch gab jedoch Perioden ohne Erwärmung, wie z.B. in den vergangenen 10 Jahren. Es gab sogar Perioden mit deutlicher Abkühlung, wie von 1940 bis 1970. Die atmosphärische Konzentration von Kohlendioxid (CO2) stieg von 280 auf 380 ppm (Anteile pro Million) in den letzten hundert Jahren. Die Verbrennung von fossilen Brennstoffen – wie Kohle, Öl und Naturgas – hat zu dem Anstieg von CO2 in der Atmosphäre beigetragen. Und ansteigende Konzentrationen von CO2 in der Atmosphäre werden letztendlich eine Erwärmung der Erdoberfläche bewirken. Die entscheidende Frage ist: Werden die summarische Wirkung der Erwärmung und sonstige Wirkungen des CO2 gut oder schlecht für die Menschheit sein?

Ich glaube, dass die Zunahme von CO2 kein Grund für Alarm ist und sogar gut sein wird für die Menschheit. Ich sage voraus, dass zukünftige Historiker auf diese Periode zurückblicken werden, ähnlich wie wir jetzt auf die Zeit vor der Verabschiedung der 18. Berichtigung der US-Verfassung, um „die Fertigung, den Verkauf und den Transport von berauschenden Flüssigkeiten“ zu verhindern. Zu dieser Zeit schien die 18. Berichtigung genau das richtige zu sein, was man tun konnte, – wer wollte schon im Bund mit dem dämonischen Rum sein? Dies war die 1917er Version, den Planet zu retten. Mehr als die Hälfte der Staaten verabschiedete Verbotsgesetze, bevor die 18. Berichtigung ratifiziert wurde. Nur ein Staat, Rhode Island, stimmte gegen die 18. Berichtigung. Zwei Staaten, Illinois und Indiana, kamen nicht zur Abstimmung und der Rest stimmte zu. Es gab viele nachdenkliche Leute, einschließlich die Mehrheit der Rhode-Isländer, die dachten, dass das Verbot mehr Schaden als Gutes anrichten würde. Aber sie wurden durch die Enthaltsamkeits-Bewegung vollständig ausgeschaltet, deren Motive und Methoden vieles gemeinsam hatte mit der Bewegung, den Klimawandel zu stoppen. Tief aufrichtige Leute dachten, sie würden die Menschheit von dem Übel des Alkohols retten, ähnlich wie viele Leute jetzt ernsthaft denken, sie retten die Menschheit vor dem Übel des CO2. Das Verbot war ein Fehler und unser Land hat sich noch nicht voll von dem Schaden erholt, der angerichtet wurde. Institutionen, wie die organisierte Kriminalität, entwickelten sich in dieser Zeit. Drastische Begrenzungen des CO2 werden in ähnlicher Weise Schaden für unser Land bringen.

Aber wie steht es mit den erschreckenden Auswirkungen der ansteigenden CO2-Konzentration, von der wir hören? Mit einem Satz: Diese sind wild übertrieben, gerade wie die vorgegebenen Vorteile des Alkoholverbots wild übertrieben waren. Lassen Sie mich nun der Wissenschaft zuwenden und versuchen, zu erklären, warum ich und viele Wissenschaftler wie ich von der zunehmenden CO2 Konzentration nicht alarmiert sind.

Das Klima der Erde ist wirklich stark vom Treibhauseffekt beeinflusst, obwohl die Physik nicht dieselbe ist wie die, die sich in wirklich verglasten Treibhäusern abspielt. Ohne Treibhauserwärmung würde die Erde viel zu kalt sein, um die gegenwärtige Fülle des Lebens aufrecht zu erhalten. Jedoch geht mindestens 90 % der Treibhauserwärmung auf Wasserdampf und Wolken zurück. Kohlendioxid ist eine geringe Einflussgröße. In der wissenschaftlichen Gemeinschaft wird der direkten Auswirkung einer Verdoppelung der CO2-Konzentration nur untergeordnete Bedeutung beigemessen, da sie maximal zu einem Anstieg der Erdtemperatur in der Größenordnung von einem Grad führen kann. Eine weitere Zunahme von CO2 wird weniger direkte Erwärmung verursachen, weil wir bereits so viel CO2 in der Atmosphäre haben, dass dieses bereits den größten Teil der Infrarotstrahlung zurückhält. Es ist ähnlich, wie wenn man eine zusätzliche Skimütze auf den Kopf setzt, wenn bereits eine schöne warme darunter ist, man aber stattdessen nur einen Windschutz trägt. Um wirklich wärmer zu werden, muss man eine wärmere Jacke haben. Das IPCC denkt, dass diese zusätzliche Jacke Wasserdampf und Wolken sind.

Da der Großteil des Treibhauseffekts für die Erde auf Wasserdampf und Wolken zurückgeht, müsste zusätzliches CO2 die Wasserkonzentration entscheidend ansteigen lassen, um zu den erschreckenden Szenarien zu führen, die als Gerüchte im Umlauf sind. Der geläufige Ausdruck hierfür ist „positive Rückkopplung“ . Mit jedem weiteren Jahr untergraben die experimentellen Beobachtungen die Behauptung einer großen positiven Rückkopplung durch Wasserdampf. Stattdessen legen die Beobachtungen nahe, dass die Rückkopplung um Null liegt oder sogar negativ ist. Das bedeutet, Wasserdampf und Wolken dürften in Wirklichkeit den geringen globalen Erwärmungseffekt, der von CO2 ausgeht, weiter verringern und nicht vergrößern. Der Beweis kommt von Satellitenmessungen der Infrarotstrahlung, die von der Erde in den Weltraum geht, von Messungen des Sonnenlichts, das von Wolken reflektiert wird und von Messungen der Erdoberflächentemperatur oder der Troposphäre, der etwa 10 km dicken Schicht der Atmosphäre über der Erdoberfläche, die mit bewegter Luft und Wolken gefüllt ist, von unten erwärmt von der Erdoberfläche und von oben durch die Strahlung in den Weltraum gekühlt.

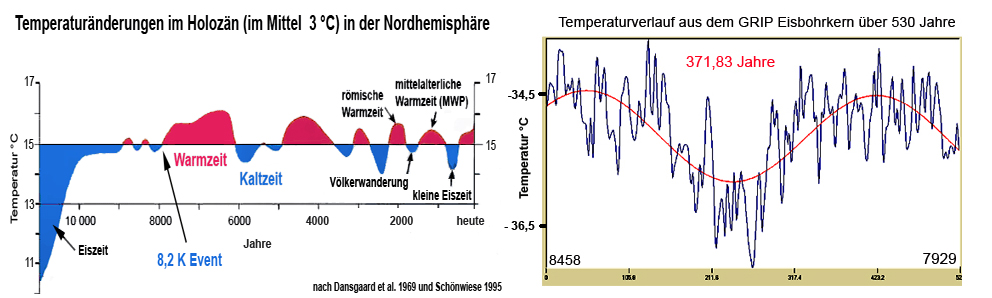

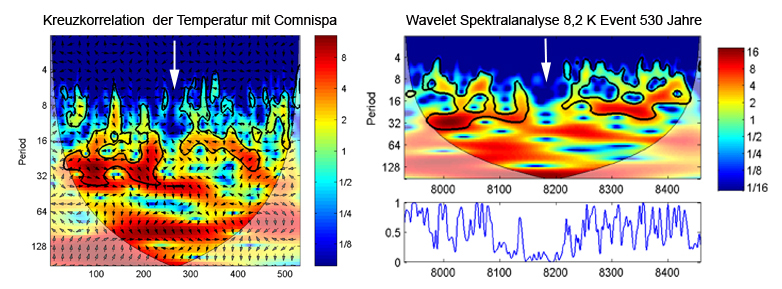

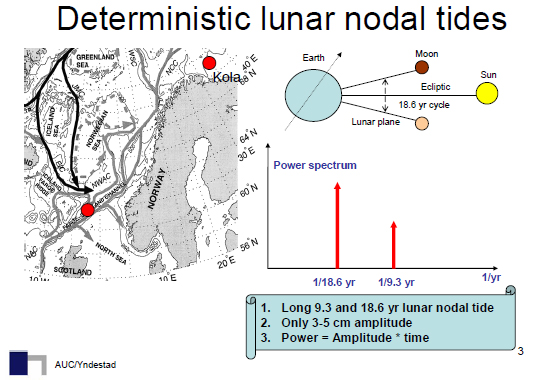

Aber das Klima erwärmt sich doch und das CO2 steigt an. Beweist dies nicht, dass CO2 die Erwärmung infolge des Treibhauseffekts verursacht? Nein! Die gegenwärtige warme Periode begann ungefähr 1800 am Ende der Kleinen Eiszeit, lange vor einem nennenswerten Anstieg des CO2. Während der 10.000 Jahre seit dem Ende der letzten Eiszeit gab es einige Male ähnliche und sogar stärkere Erwärmungen. Diese früheren Erwärmungen haben eindeutig nichts mit der Verbrennung von fossilen Brennstoffen zu tun. Die gegenwärtige Erwärmung scheint weitgehend auf natürliche Ursachen zurückzugehen und nicht auf die zunehmende Konzentration des Kohlendioxids. Während der vergangenen 10 Jahre fand keine globale Erwärmung statt, tatsächlich sogar eine leichte Abkühlung. Dies entspricht überhaupt nicht dem, was von den IPCC-Modellen vorhergesagt wurde.

Das Klima hat sich in der Vergangenheit vielmals geändert ohne menschlichen Einfluss. Es sei daran erinnert, dass die Römer um das Jahr 100 in England Weintrauben anbauten. Die Wikinger Siedler waren mit kleinen Farmen in Grönland für einige Jahrhunderte während des mittelalterlichen Klima-Optimums um 1100 erfolgreich. In der Vergangenheit haben die Menschen immer einen Drang gehabt, das Klima zu kontrollieren, so ist es keine Überraschung, dass wir heutzutage wieder dabei sind. Z.B. führte der Bischof von Genf im Juni 1644 eine Schar von Gläubigen zur Frontseite eines Gletschers, der sich jeden Tag „um mehr als einen Musketenschuss“ bewegte. Der Gletscher würde bald einen Ort zerstören. Der Bischof und seine Schar beteten zum Gletscher und es wird gesagt, der Gletscher wurde gestoppt. Die armen Wikinger hatten lange davor Grönland aufgegeben, wo die vordringenden Gletscher und das kalte Klima sich weniger empfänglich für Gebete erwiesen. Manchmal geriet die Besessenheit, das Klima zu kontrollieren, ein wenig außer Kontrolle, wie in dem Azteken-Staat. Dort haben die lokalen, wissenschaftlich/religiösen herrschenden Kreise des Jahres 1500 lang zuvor angekündigt, dass die Debatte vorüber sei und dass mindestens 20.000 Opfer pro Jahr notwendig seien, damit sich die Sonne weiterhin bewegt, der Regen fällt und der Klimawandel gestoppt wird. Die weit verbreitete Unzufriedenheit der Menschen, aus deren Reihen leider die Opfer stammten, spielte eine wichtige Rolle zum Erfolg der Eroberung von Mexiko durch die Spanier.

Das Auftreten von Klimavariationen in der Vergangenheit war lange eine Schwierigkeit für die, die behaupten, dass jeder Klimawandel auf die Menschheit zurückgehe und durch sie selbst kontrollierbar sei. Als ich ein Schuljunge war, zeigten meine Bücher zur Erdwissenschaft eine bedeutende „Mittelalterliche Warmperiode“ zu der Zeit, als die Wikinger Grönland besiedelten, gefolgt von einer widrigen „Kleinen Eiszeit“, die sie vertrieben. So war ich überrascht, als ich in dem dritten Weltklimabericht des IPCC die berühmte „Hockey Schläger Kurve“ sah. Ich wollte kaum meinen Augen trauen. Beide, die Kleine Eiszeit und die Mittelalterliche Warmperiode, waren verschwunden, und die kürzlich überprüfte Temperatur der Welt seit dem Jahr 1000 verlief absolut flach bis auf die letzten 100 Jahre, als sie wie das Blatt eines Hockey-Schlägers hochschoss. Die Hockey-Schläger-Kurve war keinesfalls ein verstecktes Detail, sondern wurde in die Welt hinausposaunt als Beweis, dass das Ende nahe sei. Wir wissen heute, dass diese Hockey-Schläger –Kurve nichts mit der Realität zu tun hat. Sie war das Ergebnis einer inkorrekten Handhabung von Temperatur-Proxies und einer inkorrekten statistischen Analyse. Es gab wirklich eine Kleine Eiszeit und es gab wirklich eine Mittelalterliche Warmperiode, in der es so warm oder wärmer war als heute. Ich erwähne den Hockey-Schläger als ein besonders klares Beispiel, dass die IPCC-Zusammenfassungen für Politiker keine unparteilichen Aussagen zu Tatsachen des Klimawandels sind. Es ist eine Schande, da viele der IPCC-Kapitel recht gut sind. Die ganze Hockey-Schläger-Episode erinnert mich an das Motto von Orwells Informationsministerium in der Novelle „1984“: „Der, der die Gegenwart kontrolliert, kontrolliert das Vergangene. Der, der das Vergangene kontrolliert, kontrolliert die Zukunft“. Das IPCC hat keinen ernsten Versuch unternommen, die natürlichen Variationen der Erdtemperatur der Vergangenheit zu modellieren. Was auch immer diese großen vergangenen Variationen verursachte, sie gehen nicht auf Menschen zurück, die Kohle und Öl verbrannten. Wenn man die Vergangenheit nicht modellieren kann, deren Realitäten man ja kennt, wie will man die Zukunft modellieren können?

Vielen von uns ist bewusst, dass wir in einer relativ kurzen Zwischeneiszeit leben, zwischen Zeitintervallen von etwa hunderttausend Jahren mit großen kontinentalen Gletscherausdehnungen über einen Grossteil der Landoberfläche der nördlichen Hemisphäre. Wir betrachten Eiskerne von Grönland und dem antarktischen Eispanzer. Man kann daraus die Temperaturen in der Vergangenheit und die atmosphärische Konzentration von CO2 abschätzen. Al Gore zeigt gern Temperaturkurven und CO2-Konzentrationen der zurückliegenden huntertausenden von Jahren, und dass, sobald CO2 ansteigt die Temperatur ebenfalls ansteigt. Beweist dies nicht, dass die Temperatur vom CO2 bestimmt wird? Absolut nicht! Wenn man diese Aufzeichnungen genau ansieht, findet man, dass zuerst die Temperatur ansteigt und dann die CO2-Konzentration in der Atmosphäre ansteigt. Es gibt einen Verzug zwischen dem Temperaturanstieg und dem CO2-Anstieg von ungefähr 800 Jahren. Dieses wirft ernste Zweifel auf das CO2 als den Klimatreiber wegen des fundamentalen Konzepts der Kausalität. Eine Ursache muss der Wirkung vorangehen. Zum Beispiel: Ich höre, dass mein Ofen am Morgen um 6.00 Uhr anspringt. Etwa um 7 Uhr bemerke ich, dass mein Haus warm ist und ich zu viele Decken auf meinem Bett habe. Es ist Zeit, aufzustehen. Es wird mir niemals einfallen, anzunehmen, dass der Ofen um 6.00 Uhr Gas zu verbrennen beginnt, weil das Haus um 7.00 Uhr warm wurde. Temperatur und das Verbrennen von Gas hängen zusammen, gerade wie die Temperatur und die Konzentration vom CO2 in der Atmosphäre. Aber dasjenige, das sich zuerst ändert, ist die Ursache. Im Falle der Eiskerne ist die Ursache des ansteigenden CO2 mit Sicherheit die Erwärmung der Ozeane. Die Ozeane geben, wenn sie sich aufwärmen, gelöstes CO2 frei, gerade wie ein Glas Bier, dessen Schaumkrone in einem warmen Raum schnell flach wird. Wenn nicht CO2, was verursacht dann die Erwärmung am Ende der kalten Periode der Eiszeiten? Dies ist eine wichtige Frage und einer der Gründe, dass ich die Klimaforschung stark unterstütze.

Ich höre dauernd über die „Verschmutzung durch CO2“ oder über „Vergiftung der Atmosphäre“ mit CO2 oder über die Minimierung unseres „Kohlenstoff-Fußabdrucks“. Dies erinnert mich an eine andere Erklärung von Orwell, die es wert ist, zu erwähnen: „Aber wenn Gedanken die Sprache korrumpieren, kann die Sprache auch die Gedanken korrumpieren“. CO2 ist kein Schadstoff und kein Gift und wir sollten die Sprache nicht korrumpieren, indem wir in Zusammenhang mit CO2 von „Schadstoff“ und „Gift“ sprechen, sondern diese Begriffe nur in ihrer ursprünglichen Bedeutung verwenden. Unser ausgestoßener Atem enthält ungefähr 4 % CO2. Dies sind 40.000 Teile pro Million oder ungefähr 100mal mehr als die gegenwärtige atmosphärische Konzentration. CO2 ist absolut entscheidend für das Leben auf der Erde. Kommerzielle Treibhausbetreiber benutzen CO2 oft als Dünger, um die Gesundheit und die Wachstumsrate ihrer Pflanzen zu verbessern. Pflanzen und unsere eigenen Primaten-Vorfahren entwickelten sich, als die atmosphärische CO2-Konzentration ungefähr 1.000 ppm betrug, eine Höhe, die wir wahrscheinlich durch Verbrennen fossiler Brennstoffe nicht erreichen, und die weit über unserer gegenwärtigen Konzentration von ungefähr 380 ppm liegt. Wir versuchen, die CO2-Konzentration in unseren (US-) Unterseebooten auf 8.000 ppm zu begrenzen. Dies ist 20mal so hoch wie die gegenwärtige atmosphärische Konzentration. Wenige ungünstige Auswirkungen werden selbst bei höherer Konzentration nicht beobachtet.

Wir sind uns im Klaren, dass die „Grüne Revolution“ den Getreide-Ertrag weltweit gesteigert hat. Ein Teil dieser wundervollen Entwicklung geht auf verbesserte Getreidearten, besseren Gebrauch von Mineraldüngern, Herbiziden usw. zurück, aber ein nicht geringer Teil des gesteigerten Ertrags geht auf den Anstieg des CO2 in der Atmosphäre zurück. Die Pflanzen bilden durch Photosynthese mehr Kohlehydrate, wenn sie mehr CO2 haben. Die Pflanzen sind auch toleranter gegenüber Trockenheit, wenn mehr CO2 vorhanden ist, weil sie nicht so viel Luft „inhalieren“ (und dabei Wasser abgeben) müssen, um das CO2 für die Photosynthese zu bekommen. Die Pflanzen verringern die Zahl von Luftporen in ihren Blatt-Oberflächen als Antwort auf die ansteigende Konzentration des CO2 in der Atmosphäre. Sie sind an wechselnde Werte angepasst und bevorzugen höhere als die, die wir gegenwärtig haben. Wenn wir wirklich unsere heutigen CO2-Konzentrationen von ungefähr 400 ppm auf 270 ppm absenken, was der Wert wenige Jahrhunderte zuvor war, würden wir einige der Vergünstigungen der „Grünen Revolution“ verlieren. Die Getreide-Erträge werden mit zunehmender CO2-Konzentration ansteigen, da wir von der optimalen Konzentration für das Pflanzenwachstum weit entfernt sind. Kommerziellen Treibhausbetreibern wird geraten, genug CO2 zuzufügen, um etwa 1000 ppm im Umfeld der Pflanzen zu halten. In der Tat, Wirtschaftlichkeitsstudien, wie die von Robert Mendelsohn von der Yale-Universität, sagen voraus, dass eine moderate Erwärmung einen generellen Nutzen für die Menschheit hat wegen der höheren landwirtschaftlichen Erträge und vieler anderer Gründe.

Ich erinnere mich daran, dass ich als Junge gezwungen war, Voltaires Novelle „Candide“ zu lesen. Rufen Sie sich ins Gedächtnis, dass Dr. Pangloss wiederholt dem jungen Candide versicherte, er lebe in der „besten aller möglichen Welten“, vermutlich auch mit den besten aller möglichen CO2-Konzentrationen. Dass wir lebten oder leben mit der besten aller CO2- Konzentrationen scheint eine stillschweigende Annahme in der IPCC-Zusammenfassung für Politiker zu sein. Enorme Anstrengungen und Phantasie sollen zeigen, dass ansteigende Konzentrationen von CO2 katastrophal sind. Städte werden erst geflutet durch einen Anstieg des Meeresspiegels, der 10 oder mehr mal größer sein müsste, als selbst IPCC vorhersagt. Es komme zu einer Massenauslöschung von Arten, Milliarden von Menschen werden sterben, auf dem Kipppunkt werde der Planet zur Wüste werden, wird behauptet. Vor einigen Monaten las ich, dass die globale Erwärmung zu einer verheerenden Epidemie von Nierensteinen führen werde. Wenn man all die Krankheiten, die der globalen Erwärmung zugeschrieben werden, aufschreibt, füllt man ein sehr dickes Buch.

Große Aufmerksamkeit wird tropischen Krankheiten gewidmet. Malaria und Gelbfieber vernichten die Bevölkerung in den gemäßigten Klimazonen wegen des Verbrennens von fossilen Brennstoffen und der nachfolgenden Erwärmung der Erde. Viele Menschen, die aktuell an tropischen Krankheiten arbeiten, und ganz besonders Dr. Paul Reiter, ein Spezialist für Tropenkrankheiten (am Institut Pasteur in Paris), haben betont, wie dummlich diese Behauptungen sind. Vielleicht kann ich einige wenige Details aus der Geschichte hinzufügen, um diesen Punkt zu erläutern. Eine der ersten militärischen Ausgaben des „Continental Congress“ im Jahr 1775 waren $ 300,–, um Chinin für die Armee zu kaufen und damit die Auswirkungen der Malaria zu lindern. Der „Continental Congress“ zog von der Hauptstadt der Vereinigten Staaten, Philadelphia, in meine Heimatstadt Princeton/New Jersey im Sommer 1783 aus 2 Gründen um. Der erste Grund war, dass der „Congress“ vielen Soldaten aus dem revolutionären Krieg ihre versprochenen Gehälter nicht bezahlt hat und verdrossene Veteranen die Straßen von Philadelphia auf und ab wanderten. Zweitens gab es Ausbrüche von Malaria in den Städten so weit nördlich wie Boston. Der „Congress“ wusste, dass man weniger wahrscheinlich Malaria in Princeton als in Philadelphia bekam. 1793 war es nicht nur Malaria sondern ein schrecklicher Ausbruch von Gelbfieber in Philadelphia. Viele tausend Menschen starben in der Stadt mit einer Bevölkerung von 50.000. Und ich sollte darauf hinweisen, dass Philadelphia ein wenig kälter war als heute, denn die Kleine Eiszeit kam gerade zum Ende. Die tropischen Krankheiten und andere Krankheiten zu kontrollieren, hat weniger mit der Temperatur zu tun, sondern alles mit den Faktoren, die die Ausbreitung verursachen, – ganz besonders mit den Moskitos im Fall von Malaria und Gelbfieber.

Viele der erschreckenden Szenarien zur globalen Erwärmung kommen von ausgedehnten Computer-Rechnungen: „Allgemeine[DrAG1] Zirkulationsmodelle“, die versuchen, das Verhalten des Erdklimas darzustellen, wenn mehr CO2 der Atmosphäre zugefügt wird. Es ist wahr, dass die Klima-Modelle zunehmend fähigere und teurere Computer benutzen. Aber ihre Vorhersagen waren nicht sehr gut. Z.B. hat keiner von diesen die fehlende Erwärmung, die wir in den letzten 10 Jahren hatten, vorhergesagt. Alle Modelle nehmen an, dass die Wasserdampf-Rückkopplung positiv ist, während die Satelliten-Beobachtungen andeuten, dass die Rückkopplung (auf eine erhöhte CO2-Konzentration) null oder negativ ist.