Wer kennt sie nicht, die Meldungen und Hiobsbotschaften über die alpinen Gletscherrückgänge, wodurch ganze Ökosysteme vom Untergang bedroht wären, die Wasserversorgung von abertausenden von Menschen in Frage gestellt wird und dem Touristikzweig der Wirtschaft, den Garaus machen würde. Meist wird als Vergleich des Gletscherrückgangs die Gletscherausdehnung von 1850, oder 1970 herangezogen (wenn, wie bei den Himalaya-Gletschern traurige Gewissheit wurde, nicht gänzlich schlampig gearbeitet wird). Dies nicht ohne Grund. 1850 lag am Ende der kältesten Epoche der letzten 2.000 Jahre, die in der Wissenschaft unter dem Namen “Kleine Eiszeit“ bekannt ist. Sie begann im 15. Jahrhundert und dauerte bis zur Mitte des 19. Jahrhunderts. Für unser kulturelles Leben hat sie eine Vielzahl von Highlights in der Dichtung (Fallersleben), Malerei (Bruegel) und Musik hervorgebracht. So verdankt die Außergewöhnlichkeit der Stradivarigeige der “Kleinen Eiszeit“ ihre Existenz. Aufgrund der kalten Jahreszeiten hatte das Holz eine andere Wachstumscharakteristik, was ihm andere Eigenschaften verlieh und den Musikinstrumenten ihre Einzigartigkeit gab. Da heute dieses Holz nicht mehr in der gleichen Art wächst, lässt sich eine Stradivarigeige auch nicht nachbauen.

Die Abbildung 1 zeigt exemplarisch zwei Gemälde, in denen die Künstler die Kleine Eiszeit festhielten.

„Winterlandschaft“, Pieter Bruegel der Ältere 1565 und rechts, A. Hondius, Thames-1677, London Museum

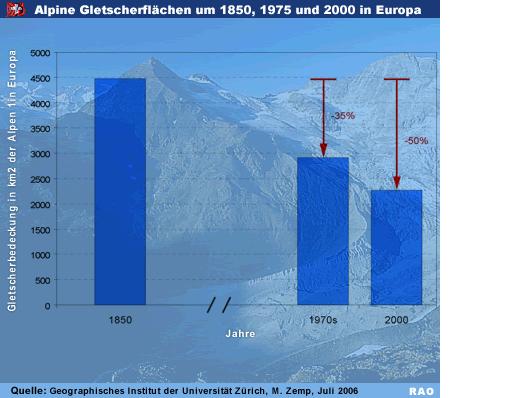

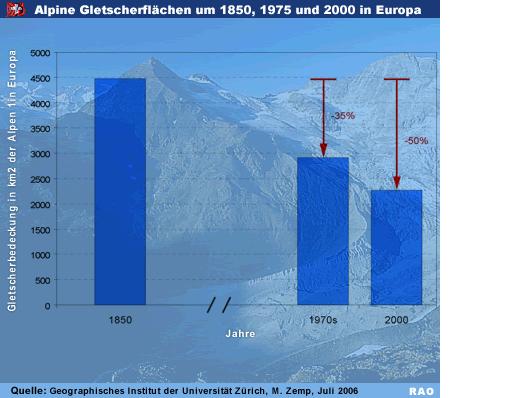

Zurück zur Gegenwart, die folgende Abbildung zeigt den alpinen Gletscherrückgang, bezogen auf die Vergleichsjahre 1850 und 1970. Es ist schon bemerkenswert, mit welchen Tricks vorgegangen wird, um eine überproportionale Gletscherschmelze zu belegen. Wie bereits geschildert, lag 1850 maximale Eisentwicklung für die letzten Jahrtausende vor und auch 1970 lag in einer Kaltphase mit ausgiebiger Gletscherentwicklung, wie die Abbildung 3 belegt. Die Älteren unserer Leser kennen noch aus den 1970-Jahren den wissenschaftlichen und politischen Wirbel um die anstehende drohende Eiszeit. Sie haben richtig gehört, damals glaubte Politik, Wissenschaft und Medien (http://www.mcculloughsite.net/stingray/photos/the_cooling_world_newsweek_2-thumb-500×646.jpg) nicht an eine drohende Erwärmung, sondern an eine drohende Eiszeit für die nächsten Jahrzehnte und teilweise die selben Wissenschaftler, die heute die Tageszeitungen mit ihren Horrorszenarien schmücken, warnten damals vor der drohenden Eiszeit.

Die Abbildung 2 zeigt den prozentualen alpinen Gletscherrückgang für die Jahre 1970 und 2000, bezogen auf das Jahr 1850, Quelle: Geographisches Institut der Universität Zürich, Dr. Michael Zemp, 2006.

Anmerkung:

Vielfach wird angenommen, dass die heutigen Gletscher der Alpen oder Skandinaviens Überbleibsel der letzten Eiszeit sind. Dies ist aber falsch. Europa war auf dem Höhepunkt der Nacheiszeit (Holozän) vor ca. 7.000 Jahren völlig eisfrei. Die meisten europäischen Gletscher sind erst danach entstanden und somit ziemlich jung und höchstens 6.000 Jahre alt. Ihr Umfang schwankte in den letzten Jahrtausenden zudem stark.

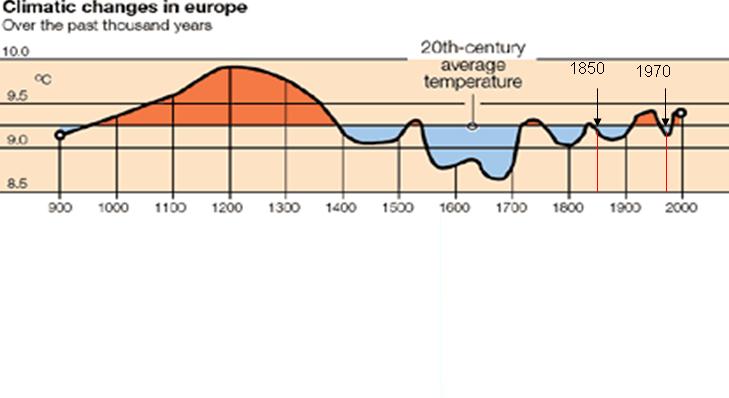

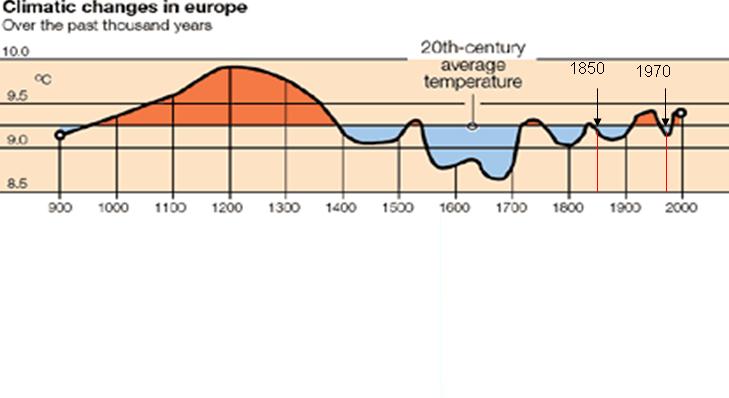

Und dazu die Temperaturentwicklung der letzten 1.100 Jahre.

Die Abbildung 3 zeigt den Temperaturverlauf der letzten 1.100 Jahre, ergänzt nach Sunday Telegraph (Lord Christopher Monckton) vom 05.11.2006.

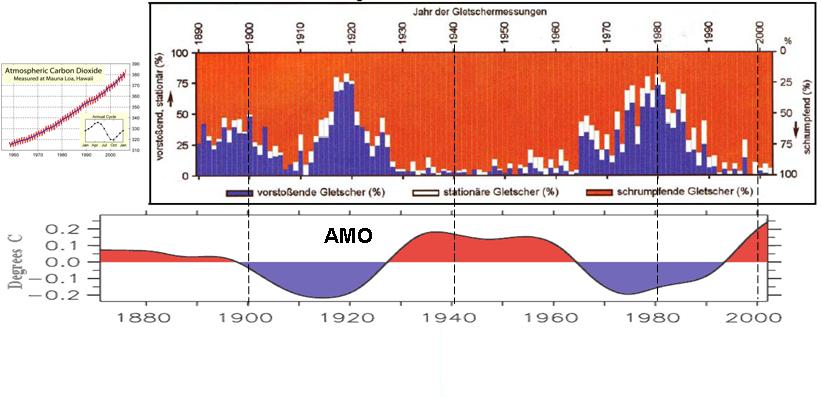

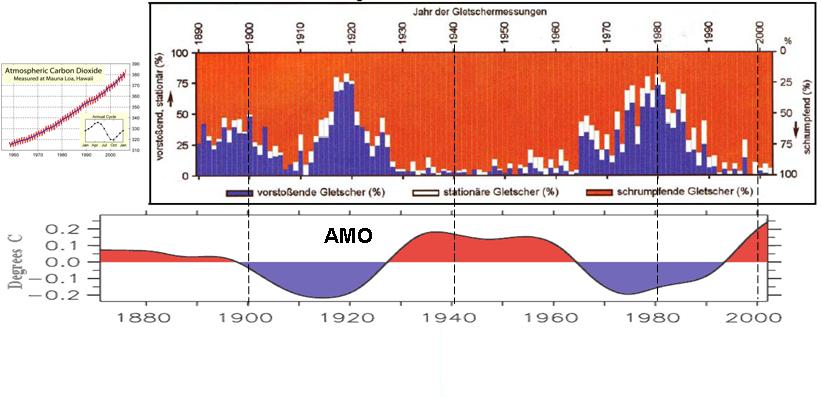

Die Schwankungen der Temperatur lassen erwarten, dass auch die alpine Gletscherentwicklung zyklischen, natürlichen Schwankungen unterliegt und genau dies, hat der Gletscherforscher, Prof. Slupetzky (Uni Salzburg) durch seine Untersuchungen der österreichischen Gletscher herausgefunden, was die Abbildung 4 belegt. Zu dessen Untersuchungsergebnis habe ich Ihnen die zyklischen Schwankungen der AMO (Atlantic Multidecadal Oscillation), einer Schwankung der atlantischen Oberflächentemperaturen, durch die unser Wetter in Mitteleuropa maßgeblich bestimmt wird, weil sie u.a. die Verdunstungsrate über dem Atlantik und den Energietransport bestimmt, aufgetragen, sowie die atmosphärische CO2-Entwicklung nach Mauna Loa.

Die Abbildung 4 zeigt die zyklische Entwicklung der österreichischen Gletscher von 1890 – 2002. Es ist gut erkennbar, dass der derzeitige Rückzug auf einen längeren Eisvorstoß*) folgt und das es in den Jahren von 1930 bis in die 1960-Jahre, ähnlich geringe Eisbedeckungen gab, wie heute. Der Gletscherzyklus zeigt weiter sehr starke Ähnlichkeiten mit der AMO und keine mit einem CO2-Atmosphärenpegel (kleines Bild).

*) Bevor hier anhand einzelner Gletscher eingewendet wird, diese wären seit 100 Jahren kontinuierlich geschrumpft – alpine Gletscher werden in vier Kategorien eingeteilt:

A: >10 km

B: 5 bis <10 km

C: 1 bis 5 km

D < 1km

Die Gletscher Kategorie D sind relativ stationär. Es gibt zwar Jahre, in denen sie Verluste erleiden, sie stoßen aber immer wieder vor und behalten ihre Größe bei. Würden die IPCC-Vorhersagen zutreffen, müsste sie zuerst verschwinden. Es ist deshalb auch unsinnig, von einem alpinen Gletschersterben zu sprechen. Dieses findet nicht statt.

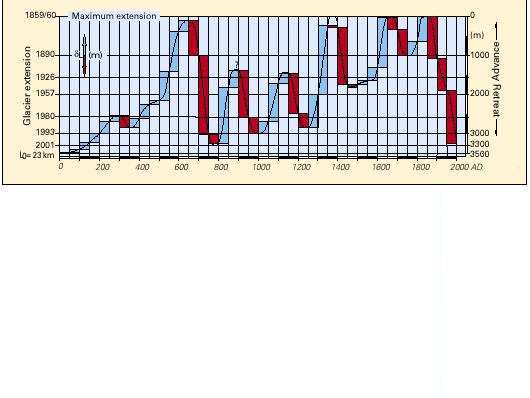

Gletscher der Kategorie A, wie z.B. der sehr gut untersuchte Großer Aletsch in der Schweiz, folgen auf Grund Ihrer Größen- also Massenträgheit zeitverzögert Warm- bzw. Kaltphasen („glätten“ sozusagen Dekaden-Warm-, bzw. Kaltphasen) und zeigen somit seit Beginn der wärmeren Periode ab dem Ende der Kleinen Eiszeit um 1850 eine schrumpfende Tendenz, während die massenärmeren Gletscher Temperaturentwicklungen schneller folgen. Aber auch bei Gletschern der Kategorie A ist der Gletscherschwund im 20. Jahrhundert nichts Außergewöhnliches, wie die Untersuchungen von Wilfried Haeberli und Hanspeter Holzhauser (Uni Zürich) zeigen.

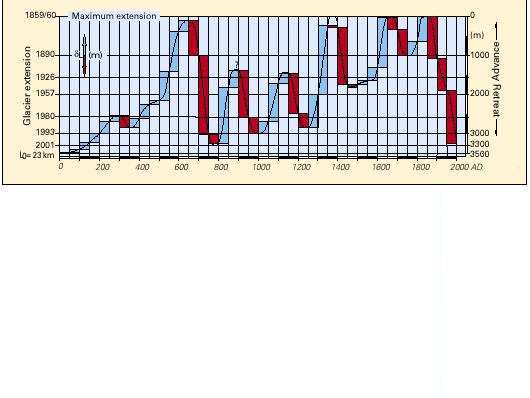

Die Abbildung 5 zeigt die Gletscherentwicklung Großer Aletsch für die letzten 2.000 Jahre. Erklärung: Rote Balken stehen für Rückzug und blaue für Vorstoß. Unten = Rückzug, Oben = Vorstoß. Die rechte Skala zeigt die Gletscherbewegung in Metern und die linke die zugehörigen Jahreszahlen des aktuellen Gletscherrückgangs. Geglättet wurde über 50 Jahre. Deutlich ist zu erkennen, dass es Zyklen gibt, in denen der Gletscher wächst und schrumpft. So gab es in den letzten 2.000 Jahren drei in etwa gleich starke Minima: Heute, im 8. und im 1. Jahrhundert (dieses gar noch stärker als heute). Der heutige Rückzug begann um 1850.

Zurück zur Abbildung 4

Da die AMO in direkter Weise von der Sonnenaktivität abhängt, ist es nicht verwunderlich, dass die alpine Gletscherentwicklung der Intensität der Sonneneinstrahlung folgt. Zu diesem Ergebnis kamen Forscher der ETH Zürich, die die Arbeiten von Prof. Slupetzky, 2005 untermauern (http://www.ethlife.ethz.ch/archive_articles/091214_gletscherschwund_su). “Rasante Gletscherschmelze in den 1940ern“. Die Untersuchungen zeigen, dass in den 1940-Jahren die Schweizer Gletscher stärker schmolzen, als dies gegenwärtig der Fall ist. Als Datenquelle dienten den Forschern die seit fast 100 Jahren (die Messungen begannen im Jahr 1914) vorliegenden durchgehenden Messungen an den Gletschern, Claridenfirn, Großer Aletsch und dem Silvretta.

In ihrer Studie geben die Forscher der Sonneneinstrahlung den maßgeblichen Anteil am Gletscherrückgang. Dabei dienten ihnen die seit 1934 vorliegenden Messungen der Sonneneinstrahlung in Davos. Während die ETH-Wissenschaftler die verstärkte Sonneneinstrahlung auf die alpinen Gletscher auf die geringere Aerosolkonzentration der Atmosphäre zurückführen (Aerosole reflektieren direkt das Sonnenlicht, bzw. dienen über chemische Reaktionen als Kondensationskeime für Wassertropfen und beeinflussen somit maßgeblich die Wolkenbildung), sind direkte solare Aktivitätssteigerungen und damit verbundener geänderter Wetterlagen und höherer Temperaturen ebenso ausschlaggebend für die Periode der Gletscherrückgänge, die die vorherige Abbildung zeigt.

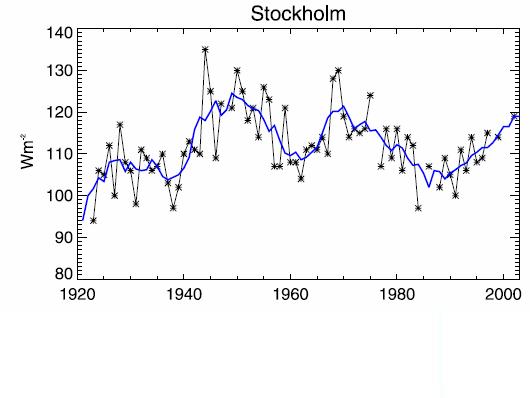

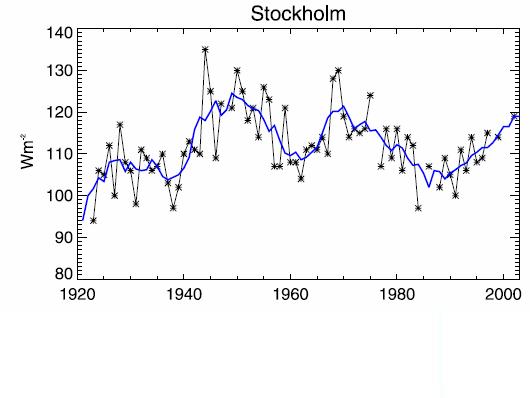

Die ETH-Forscher ermittelten eine um 18 W/m2 höhere solare Einstrahlung als in den vergangenen 10 Jahren bis heute, was, angesichts dem Strahlungsantrieb von ca. 1,5 W/m2, welcher das IPCC dem CO2 in seinen Klimamodellen zubilligt, ganz enorm ist. Die erhöhte Sonneneinstrahlung in den 1940-Jahren deckt sich mit den Messungen der Globalstrahlung auf der “Säkularstation Potsdam Telegrafenberg“ und in Stockholm. Es war demnach in weiteren Teilen Europas eine erhöhte Solarstrahlung zu messen.

Die Abbildung 6 (http://wattsupwiththat.com/2009/06/) zeigt die bodennahe solare Einstrahlung in Stockholm seit 1923. Die blaue Linie die geglättete 5-Jahreskurve.

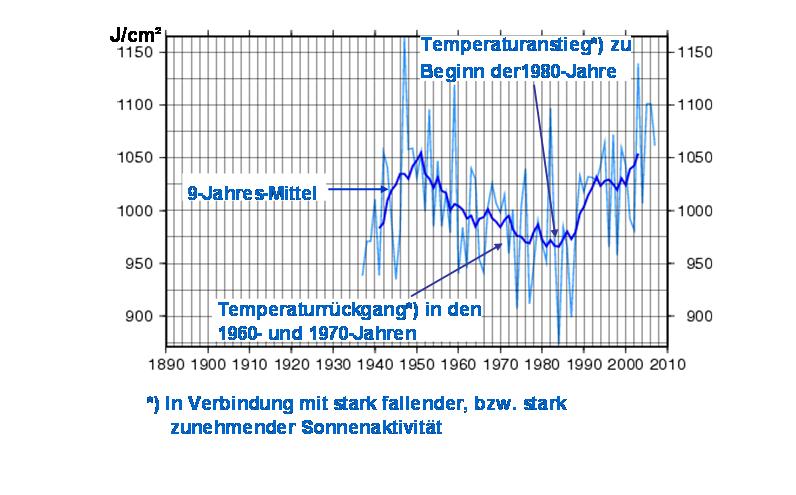

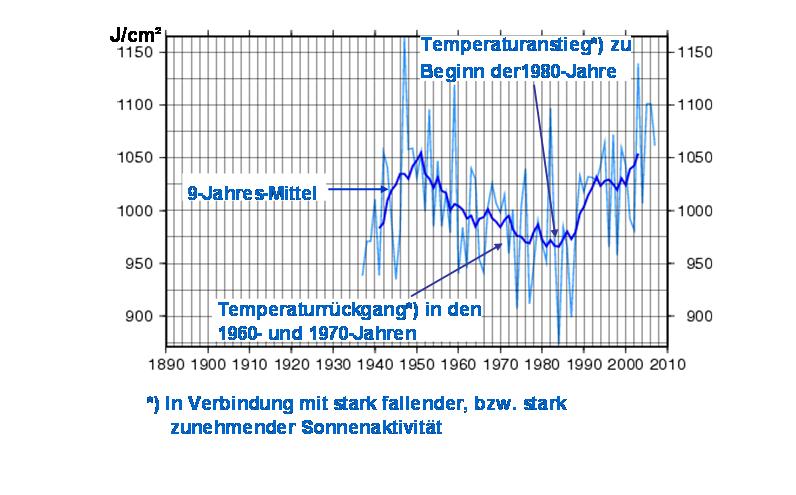

Die Abbildung 7 zeigt die Änderung der Globalstrahlung auf der “Säkularstation Potsdam Telegrafenberg“ seit 1940. Der Rückgang ist verbunden mit der Phase des Global Cooling und der Wiederanstieg in den 1980-Jahren mit dem Anstieg der bodennahen Temperaturen. Seit 1980, dem Zeitpunkt, als die Temperaturen zu steigen begannen, ist demnach ein 10%iger-Anstieg der Globalstrahlung zu verzeichnen.

Anhand der Abbildung 8 möchte ich Ihnen die solare Aktivität im Vergleichzeitraum, sowie die Durchlässigkeit der Atmosphäre zeigen.

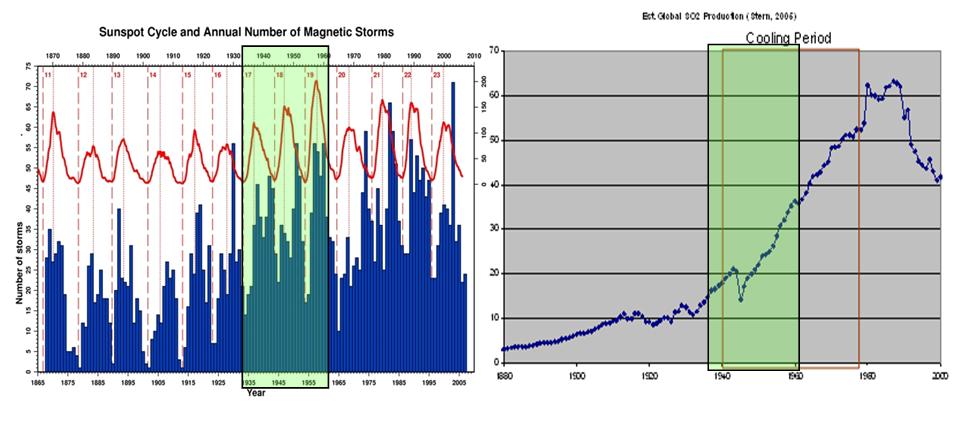

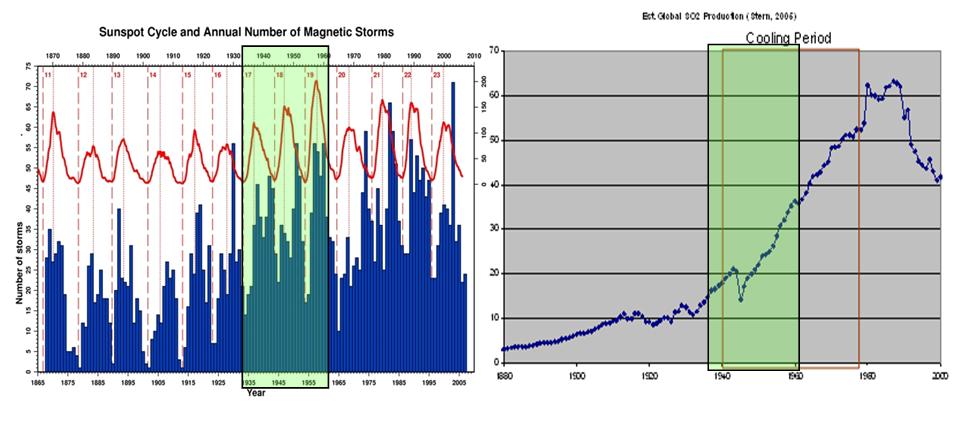

Die Abbildung 8 links, Quelle: British Geological Survey, zeigt die magnetische- und Fleckenaktivität der Sonne im Zeitraum von 1867 – 2007. Im Zeitraum von 1930 – 1960 (grün hinterlegt) ist ein deutlicher Anstieg in der magnetischen, als auch in der Fleckenaktivität der Sonne erkennbar, was mit dem Zeitraum der positiven AMO und des mit ihr in Verbindung stehenden Gletscherrückgangs (Abbildung 4, übereinstimmt. Die Abbildung 8 rechts zeigt den SO2-Aerosolgehalt in der Atmosphäre im Zeitraum von 1880 bis 2000, Quelle: David Ian Stern, Australian National University, Centre for Resource and Environmental Studies.

Für die atmosphärische Aerosolentwicklung ist der atmosphärische Schwefeldioxid-, bzw. Sulfat-Gehalt (bildet sich über Wasser und SO2) wesentlich. Der unter dem Begriff “Global Cooling“ bekannte Temperaturrückgang durch zusätzliche Partikel in der Atmosphäre basiert auf SO2 und Rußpartikel. Den Einfluss von SO2 auf die globalen Temperaturen zeigen die Auswirkungen des Vulkanausbruchs Pinatubo in 1991, durch den große Mengen SO2 in die Atmosphäre gelangten, wodurch die globalen Temperaturen für 2 Jahre um ca. 0,6°C zurückgingen.

In der Abbildung 8 rechts ist darüber hinaus die Epoche des Global Cooling (rot umrundet) festgehalten – Anstieg der Aerosolpartikel (vorrangig SO2 und Rußpartikel) mit deutlich zurückgehender Sonnenaktivität – einem schwachen solaren 20. Zyklus. Auch in der Phase des Global Cooling, die Prof. Stern in die Zeitspanne von 1940 – 1980 definierte, wurde der Abkühlung durch die beiden starken solaren Zyklen 18 und 19, gegen Ende der 1940- und 1950-Jahre gegen gewirkt, wie die Abbildung 9 zeigt.

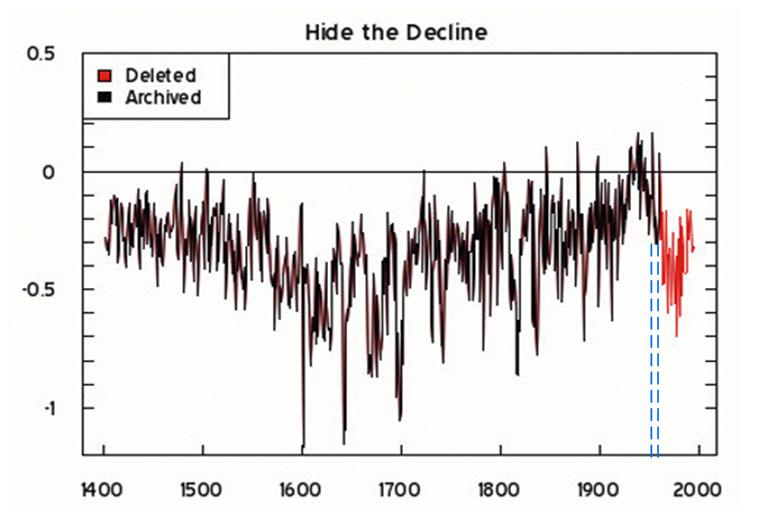

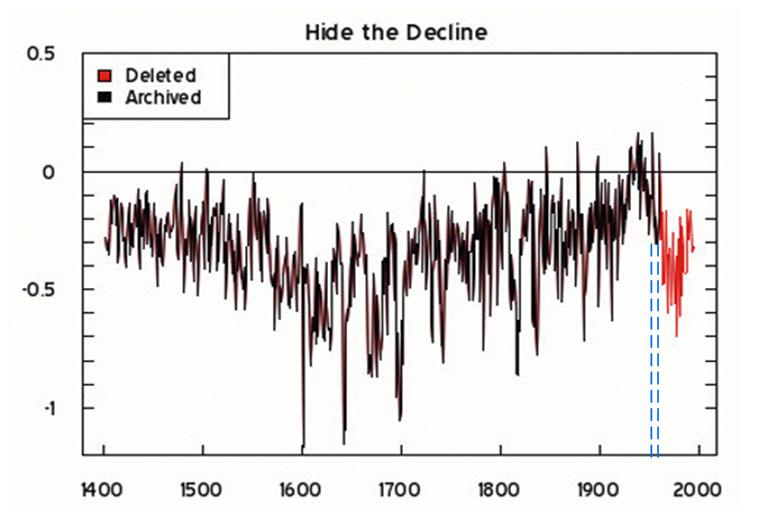

Die Abbildung 9 zeigt die aus Baumringdaten rekonstruierte Tempe

raturkurve bis zum Ende des 20. Jahrhunderts, nach den Daten von Briffa, in der archivierten und publizierten (abgeschnittenen) Version (schwarz) und der komplette Datensatz (rot). Es ist die Temperaturreihe, die durch die Manipulationen von Jones (Climategate) Berühmtheit erlangte. Hier in der ungekürzten Fassung. Man erkennt deutlich den Temperaturrückgang, der versteckt werden sollte, Quelle: Rudolf Kipp – EIKE. Deutlich ist erkennbar, dass die starken solaren Zyklen 18 und 19 (blaue Linien, vgl. mit Abbildung 7 links) einen Temperaturpeak nach oben auslösten und dem um ca. 1940 beginnenden Rückgang der Temperaturen entgegenwirkten.

Auch hier, wie beim Temperaturanstieg mit der verbundenen Gletscherschmelze, setzte der Temperaturrückgang erst in Verbindung mit der Sonnenaktivität ein und zwar mit der deutlich nachlassenden Sonnenaktivität im 20. Sonnenzyklus, als in den 1970-Jahren das Gespenst der drohenden Eiszeit umherging und dieselben Forscher, die seinerzeit grandios danebenlagen, wie z.B. Prof. Stephen Schneider (Schneider S. & Rasool S., „Atmospheric Carbon Dioxide and Aerosols – Effects of Large Increases on Global Climate“, Science, vol.173, 9 July 1971, p.138-141), heute einer der einflussreichsten IPCC-Leadautoren, die passend zur solaren Temperaturentwicklung, wieder die abenteuerlichsten Hypothesen aufstellen, diesmal in Verbindung mit anthropogenen Treibhausgasen, die eine Erwärmung herbeiführen würden. Seinerzeit gingen die Herren der These nach, es gäbe eine globale Abkühlung – es drohe eine kommende Eiszeit!

Erst als die solare Aktivität in den 1960-Jahren zurückging und in den 1970-Jahren niedrig blieb, „rauschten“ die Temperaturen deutlich in den Keller, um mit Beginn der solaren Aktivität um 1980 (hoher 21. Sonnenzyklus), erneut anzusteigen. Wie wir heute wissen, dauerte der Temperaturanstieg bis ca. 2003, synchron zur solaren Aktivität. In 2003 hatte der Hauptsonnenzyklus, der im Mittel 208-jährige de Vries/Suess-Zyklus sein Maximum (http://wetterjournal.wordpress.com/2009/07/14/). Die Presse war seinerzeit voll mit Meldungen über sog. Hitzetote.

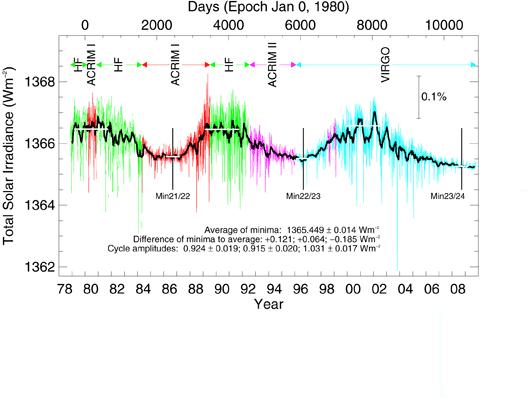

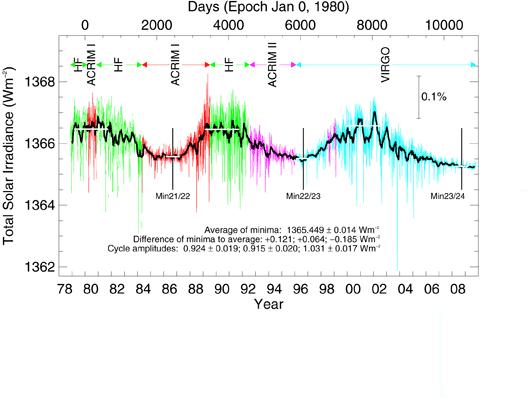

Einige werden einwenden, dass anhand einschlägiger Sonnenaktivitätskurven die Sonnenaktivität in den letzten 30 Jahren nicht zugenommen hätte. Dies ist jedoch falsch. So meldete z.B. die Max Planck-Gesellschaft in 2004 “Sonne seit über 8.000 Jahren nicht mehr so aktiv wie heute.“ Für die solare Aktivität wird international meist der sog. TSI (Total Solar Irradiance) herangezogen (Abbildung 10).

Die Abbildung 10 zeigt den TSI im Zeitraum 1979 bis Januar 2010 (Quelle: http://www.pmodwrc.ch/pmod.php?topic=tsi/composite/SolarConstant). In der Zeile oben sind die verschiedenen Messsysteme, mit denen der TSI aufgenommen wird (wurde) genannt. So steht z.B. ACRIM für Active Cavity Radiometer Irradiance Monitor. Es ist zu sehen, dass im Messbereich des TSI keine Aktivitätssteigerung der Sonne im Betrachtungszeitraum erkennbar ist, wohl aber in der Abbildung 11 und der Abbildung 8 links.

Beim TSI handelt es sich denn auch um eine Mogelpackung, bzw. um eine irreführende Bezeichnung, da das Messsystem des Satelliten, mit dem der TSI aufgenommen wird, lediglich den Wellenlängenbereich des solaren Energiespektrums von 200 nm – 2.000 nm, also UVB – Infrarot aufnimmt (dafür sensibilisiert ist). Von “Tatal“ kann also keine Rede sein! Der überwiegende spektrale Sonnenanteil wird gar nicht aufgezeichnet, insbesondere nicht der Anteil, der zwischen solarem Minimum und solarem Maximum am meisten variiert. So variiert die solare Aktivität im sichtbarem Bereich lediglich um <1%, im UVB-Bereich (205 nm) um ca. 7%, bei 150 nm bereits um 15%, im EVU (<150 nm) sogar um 35% und im Röntgenbereich gar um das 100-fache. Über die kosmische Strahlung*) (Svensmark-Effekt) und die Stratosphäre, übt die Sonne jedoch auch in dem nicht aufgezeichneten Energiebereich indirekt, bzw. direkt Einfluss auf das irdische Wettergeschehen und somit auf das Klima.

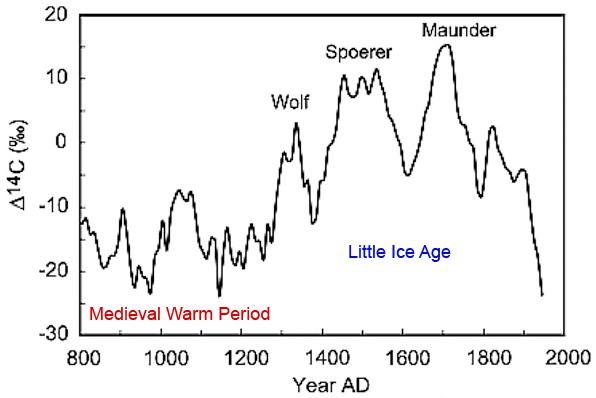

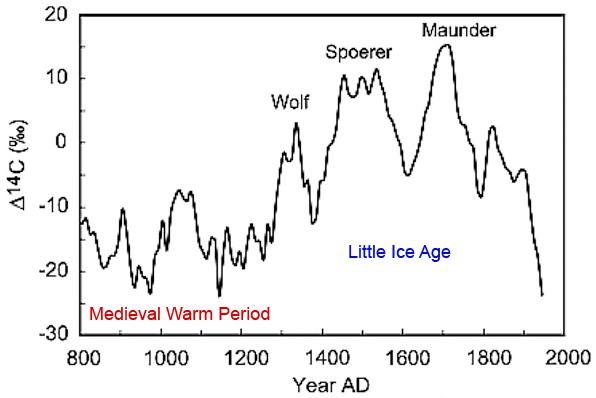

*) Die solare Aktivität im Hauptsonnenzyklus, dem de Vries/Suess-Zyklus lässt sich denn auch nicht im TSI erkennen, sondern am 14C-Gehalt der Pflanzen (Abbildung 11).

Die Abbildung 11 zeigt über die letzten 1.200 Jahre den de Vries/Suess-Zyklus und die mittelalterliche Warmperiode, sowie die Kleine Eiszeit mit dem Wolf- Spörer- und Maunder-Minimum, Quelle: (http://www.co2science.org/articles/V11/N23/EDIT.php).

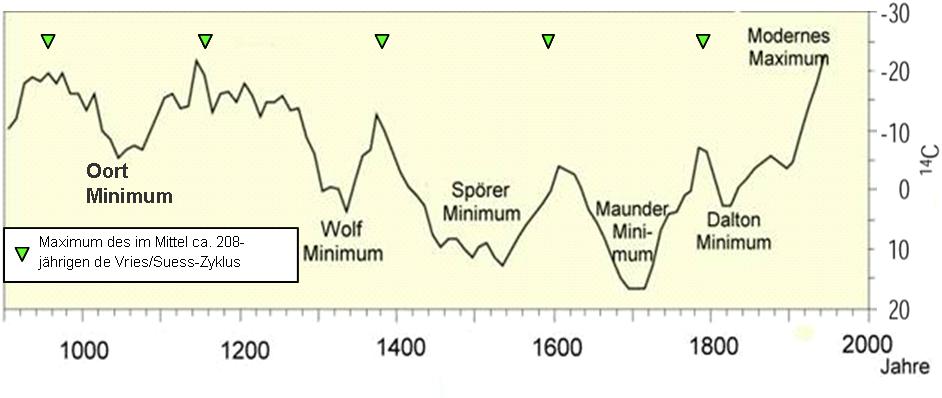

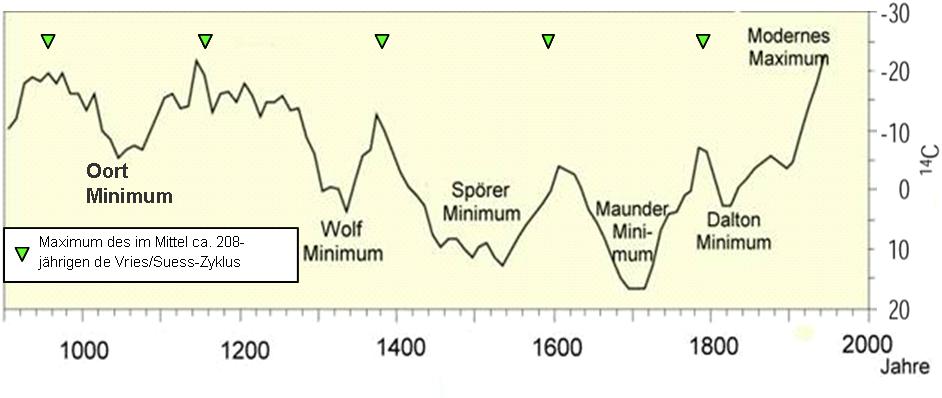

In der Abbildung 12 habe ich Ihnen die Maxima im de Vries/Suess-Zyklus zu der aus 14C gewonnenen Proxy-Temperaturkurve eingetragen.

Die Abbildung 12 zeigt die Kälteperioden der letzten 1.100 Jahre (ergänzt nach Quelle: United States Geological Survey). Die Maxima der Warmperioden fallen jeweils mit dem Maximum des de Vries/Suess-Zyklus zusammen und die Kälteperioden, wie z.B. das Spörer Minimum mit dessen Minimum.

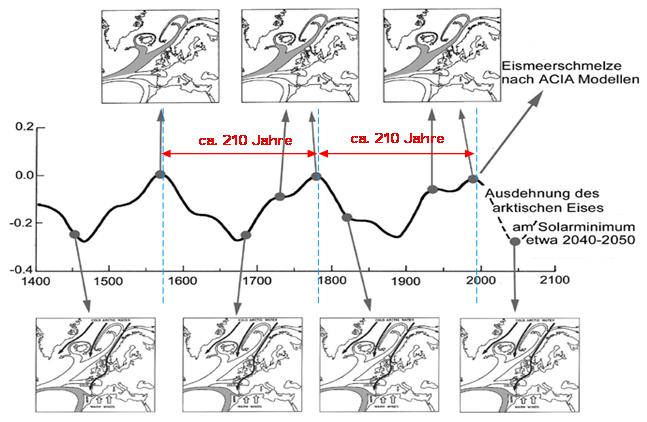

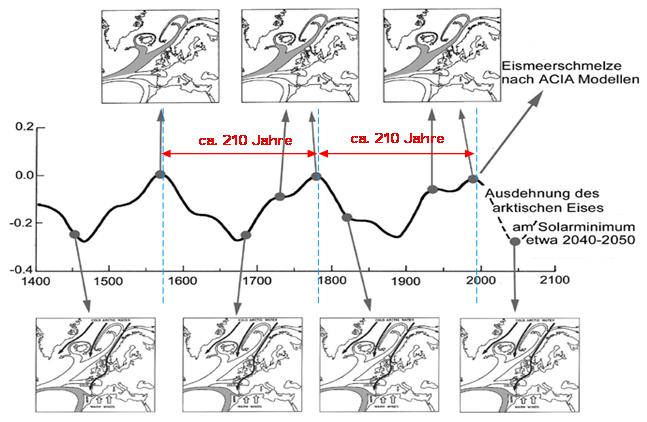

Nicht nur die Gletscherentwicklung der Alpen, sondern auch die arktische Eisbedeckung wird durch den Hauptsonnenzyklus, den de Vries/Suess-Zyklus moderiert, wie die Abbildung 13 zeigt.

Natürliche Schwankungen auf die Meeresströmungen im Nordatlantik und somit auf den Golfstrom, zeigt die Abbildung 13, Quelle: Dr. Axel Mörner, “Keine Gefahr eines globalen Meeresspiegelanstiegs“ (http://www.solidaritaet.com/fusion/2008/1/fus0801-klima.pdf). Zu sehen ist die arktische Eisentwicklung in Verbindung mit den vorherrschenden Meeresströmungen in Relation zum Hauptsonnenzyklus (de Vries/Suess-Zyklus). Sowohl die arktische Eisbedeckung, als auch das Muster der Meeresströmungen folgt dem im Mittel 208-jährigen de Vries/Suess-Zyklus. Bei Sonnenminima erlebten Nordwesteuropa, der Nordatlantik und die Arktis Kaltphasen.

Hohe solare Aktivität, verbunden mit geringer Aerosolbildung (klare Luft) sind demnach die Ursachen für den starken Gletscherrückgang in den 1940-Jahren. Da die Gletscher im Zeitraum davor wuchsen und die Luft noch klarer war, bleibt für den Gletscherrückgang in den 1940-Jahren einzig (in Bezug der davor herrschenden Gletscherausdehnung) die starke solare Aktivität übrig, sowie wir dies bis zu den letzten Jahren ebenfalls hatten.

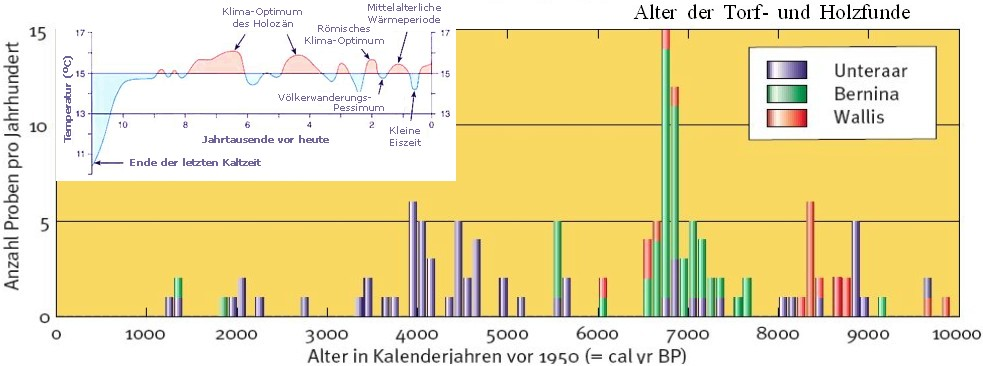

Wie bereits eingangs erwähnt, waren die Alpen in früheren Jahren weitgehend eisfrei. Dies belegen Holzfunde in heutigen Gletscherregionen der Alpen von Dr. Christian Schlüchter. Dr. Schlüchter ist Professor für Quartär- und Umweltgeologie an der Universität Bern und Lehrbeauftragter der ETH Zürich.

Er fand in den Hochflutablagerungen eines Gletscherbaches im unmittelbaren Vorfeld des Unteraargletschers im Berner Oberland 30 bis 60 Zentimeter dicke Holzstücke und Überbleibsel eines Moors. Baumreste wurden einem Arvenstamm (alpenländischer Nadelbaum) zugeordnet und auf 4.920 ± 60 Jahre vor heute datiert. Die Moorreste datieren auf 2.100 ± 50 Jahre vor heute. Die Fundstücke sind außergewöhnlich, da es Bäume und insbesondere ein Moor nur an Stellen gegeben haben kann, wo kein dauerhaftes Eis vorhanden ist und die Baumgrenze deutlich höher lag als heute. Aus den vorgenommenen Datierungen ergab sich, dass in den letzten Jahrtausenden etwas mehr als 50% der Zeitspanne die Gletscher deutlich kürzer als waren als heute.

Prof. Schlüchter: “Vor 1900 bis 2300 Jahren lagen die Gletscherzungen mindestens 300 Meter höher als heute. So wurden in der Römerzeit die Gletscher kaum als solche erlebt, aus dem einfachen Grund, weil sie weitab von den damals benutzten Alpenübergängen lagen und somit auch nicht als Hindernis empfunden wurden.“ Dies erklärt auch, warum in den sonst sehr detaillierten Beschreibungen der römischen Chronisten kaum ein Wort über die Gletscher zu finden ist. Als Hannibal 218 v.Chr. mit seinen Kriegselefanten (im Winter!!) die Alpen überquerte und ins römische Kernland einfiel, waren die Alpenpässe weitgehend eisfrei. Es war die Zeit des römischen Klimaoptimums. Die Abbildung 14 links zeigt, wie es nach Rekonstruktionen seinerzeit dort ausgesehen hat.

Die Abbildung 14 links zeigt den Sustenpass (Passhöhe 2.224 ü. d. M.), wie er nach den Untersuchungen von Schlüchter zur Römerzeit vor etwa 2.000 Jahren ausgesehen hat. Der Steigletscher hat sich auf die Höhe der Tierberglihütte (2.795 m) zurückgezogen, die Baumgrenze lag deutlich höher als heute. Quelle „Die Alpen“/ Zeichnung Atelier Thomas Richner nach Vorlage Christoph Schlüchter. Kopiert aus ETH-Zürich, “Grüne Alpen statt ewiges Eis“, 14.02.2005 (http://archiv.ethlife.ethz.ch/articles/tages/gruenealpen.html). Die rechte Abbildung zeigt den Gletscher um 1993 und seine Ausdehnung 1856 (nach der “Kleinen Eiszeit“) und 1922.

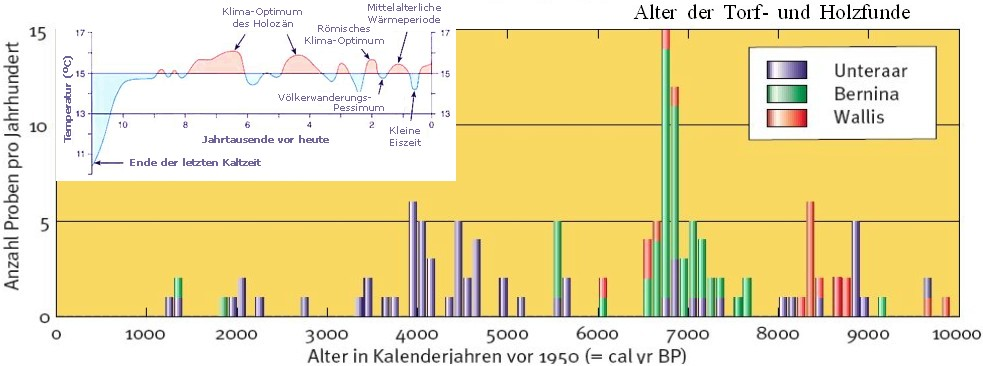

Anhand der Abbildung 15 wird deutlich, dass die Torf- und Holzfunde mit der Temperaturentwicklung im Holozän (bezeichnet die Zeitspanne seit ca. 11.000 Jahren, kleine Abbildung) synchron verlaufen und es Zeiten gab, in denen es wesentlich wärmer war als heute, Quelle: (http://klimakatastrophe.files.wordpress.com/2008/09/gletscherfunde2.jpg) nach Joerin et al. 2006 (Uni Bern).

Die beiden folgenden Bilder in der Abbildung 16 zeigen, wie ein Alpendorf im 19. Jahrhundert von sich ausbreitenden Eismassen begraben wird, dass Klima davor also zyklisch milder war (vgl. mit Abbildung 4), Quelle: ZDF, „Klima – Das Risiko“, Joachim Bublath, 22.10.2003 (http://www.solarresearch.org/zdf_bublath_20031022.htm).

Zusammenfassend ist festzustellen, dass der heutige Gletscherrückgang in den Alpen nichts Außergewöhnliches darstellt und die Gletscherentwicklung zyklischen Phasen unterliegt, die von der Sonne gesteuert werden. Ein Einfluss von Treibhausgasen wie z.B. CO2 oder menschliche Einflüsse sind nicht vorhanden.

Raimund Leistenschneider – EIKE

Related Files