Die Themen Umweltschutz, Klima und Energie beherrschen die Schlagzeilen in der Presse. Ich möchte mich als Ingenieur pragmatisch mit diesen Themen befassen. Der Inhalt reicht eigentlich für mindestens 3 große Vortragstagungen über mehrere Tage aus, bei der hunderte von Wissenschaftlern und Experten über ihre Erfahrungen berichten würden. Ich habe mir überlegt, wie ich dieses Problem lösen kann. Ich möchte es so versuchen. Ich berichte nur über Fakten die weder wissenschaftlich noch ingenieurtechnisch widerlegbar sind, möchte Sie dabei aber bitten, und ich will versuchen, hierfür die Grundlagen zu legen, sich Ihre eigenen Gedanken zu machen, um diese extrem komplizierten und komplexe Fragen sich selbst beantworten oder eine Meinung bilden zu können. Alle nachfolgenden Themen sind technisch und vor allem wirtschaftlich eng miteinander verbunden. Wer diese Fragen einseitig, also nur unter Berücksichtigung einzelner Themen, zu beurteilen versucht, macht zwangsläufig schwere Fehler, die zu vollständig falschen Beurteilungen führen.

Nun zum 1. Themenkreis, Umweltschutz,

der eine extreme Bedeutung in der Bevölkerung erlangt hat. Für Ingenieure war dieser Begriff nicht neu. Anlagen dieser Art waren und wurden seit Jahrzehnten gebaut:

– Abgasreinigungsanlagen zur Reinhaltung der Luft

Zur Abscheidung von:

– Staub, Feinstaub, Aerosolen durch Elektro-, Schlauch- oder Spezialfilter;

– Schwefeloxide In Nass- oder Trockenreinigungsanlagen;

– Stickoxide durch Katalysatoren;

– Dioxide durch Aktivkoks –Aktivkohlefilter;

Es war nur eine Frage des kostenmäßigen Aufwandes, denn alle Maßnahmen müssen ja letztlich von der Bevölkerung bezahlt werden. Diese Maßnahmen-Investitionen führten zu einer Verschlechterung des Wirkungsgrades bei Kraftwerken um etwa 2 – 4%. Die Investitionskosten lagen bei mehreren hundert Millionen.

Die politische Bedeutung des Umweltschutzes kam mit den „Grünen“ auf. Sie ist im Prinzip auch richtig, nur sollte alles sachlich mit fachlichen Überlegungen und nicht populistisch behandelt werden. Joschka Fischer postulierte vor etwa 30 Jahren, und damit machte er die „Grünen“ stark, dass in 10 Jahren kein Blatt mehr auf den Bäumen sei, wenn die Rauchgase der Kraftwerke nicht entschwefelt würden. Stichwort: Saurer Regen. Damit hat er die Grundlage zur „Antienergiepolitik“, die bis heute dauert, gelegt. Die Rauchgase der Kraftwerke wurden also entschwefelt und dann auch entstickt, also die Stickoxide und dann auch die Dioxine abgeschieden. Dies muss von den Stromkunden bezahlt werden. Ob die Entschwefelung gerechtfertigt war, sei dahingestellt. Auch heute ist der Waldboden sauer, das hat nun nichts mehr mit dem Schwefelgehalt aus den Rauchgasen von Kraftwerken zu tun, sondern mit einem seit Jahrtausenden ablaufenden Vorgang in der Natur. Abfallholz, Blätter usw. vermodern im Wald. Dabei wird Humus erzeugt, der den Waldboden düngt, das ist nun wirklich nichts Neues. Nur bei der Vermoderung entsteht auch CO2, dieses löst sich im Regenwasser und führt zum „sauren“ Waldboden. Sprudelwasser hat in etwa den gleichen ph-Wert. Der Einfluss der zusätzlichen Schwefelsäure aus Abgasen kann nur geschätzt werden. Niemand hat das je errechnet, kann er auch nicht. Meiner Meinung nach liegt er weit unter 1%, es könnten aber auch nur promille sein, oder promille von promillen.

Dann ein Wort zur Müllentsorgung. Seit über 100 Jahre wird oder wurde der Müll überwiegend in Verbrennungsanlagen entsorgt, eine Technik, in der Deutschland weltweit führend war. Dann kamen die Abgase in Verruf. Wir entwickelten neuartige bessere Rauchgasreinigungstechniken. Letztlich eine „Gasmaske“ mittels Aktivkoks, also des gleichen Materials, das in Gasmasken enthalten ist. Ich hatte diese Idee Herrn Umweltminister Matthiesen vorgeschlagen, der dies sofort in Herten verwirklichen ließ. Ergebnis ist, dass das Rauchgas sauberer ist als die angesaugte Verbrennungsluft. Die Verbrennung ist heute immer noch die billigste und sauberste Müllentsorgung, aber der Widerstand der „Umweltschützer“ gegen diese Technik hat nicht nachgelassen. Das Ergebnis ersehen Sie in Ihren ständig steigenden Entsorgungskosten. Vor kurzem entsorgten, gegen hohe Gebühren, sogar Überseeische Länder ihren Abfall in deutschen Verbrennungsanlagen, die alle mit dieser Technik ausgerüstet sind. Dies zeigt den weltweit hohen Standard unserer Müllverbrennungsanlagen. Das Wort Müll oder Abfall wird jetzt durch die Bezeichnung Biomüll oder Bioreststoffe durch Umweltschützer ersetzt , die Anlagentechnik ist die gleiche. Wir hoffen, dass jetzt endlich Vernunft einkehrt, zum finanziellen Vorteil der Bürger.

Nächstes Thema: Kraft-Wärmekopplung, also die kombinierte Erzeugung von Strom mit Nutzung der Abwärme. Diese Technik wurde nun wirklich nicht von den Umweltpolitikern erfunden. Sie wird seit über hundert Jahren allen Hochschulen gelehrt. Grund für die Anwendung war aber bei den vielen hundert Anlagen, die in der Zeit gebaut wurden, als die Politiker diese Technik noch nicht als politisierendes populistisches Argument erkannt hatten, stets die Frage der Wirtschaftlichkeit. Diese konnte in Modellrechnungen auf etwa 1% Genauigkeit berechnet werden. Die Abwärme kann aber nur dann genutzt werden, wenn Abnehmer, also Käufer, dafür vorhanden sind. Das ist aber, abgesehen von der Abwärmeverwertung in wärmeverbrauchenden Industriebetrieben, nur zu Heizzwecken möglich. Im Sommer wird nicht geheizt, dann fehlen diese Abnehmer. Noch in den 50-etwa 80iger Jahren wurde jährlich in Deutschland etwa 100-150 Anlagen dieser Art gebaut. Heute nur noch vereinzelt, trotz der Subventionierung. Es lohnt sich einfach aus wirtschaftlichen Gründen nicht. Bei Müllverbrennungsanlagen, oder neu, den Bioabfall- und Bioreststoffverbrennungsanlagen macht diese Technik wirklich Sinn, denn die Erlöse aus Strom- und Abwärmeverkauf mindern die Entsorgungskosten, doch auch hier sind „Umweltexperten“ aus nicht mehr nachvollziehbaren Gründen dagegen.

Bei der Abwärmeverwertung geht ein Teil der Energie des Dampfes, die sonst zur Stromerzeugung genutzt wird, verloren. Abwärme auf Umweltniveau ist wertlos. Nur eine Nutzung/ Entspannung des erzeugten Dampfes bis auf den absoluten Nullpunkt, also 0 grad Kelvin oder -273grad C ermöglicht einen 100%igen Wirkungsgrad bei der Stromerzeugung. Dieses thermodynamische Gesetz ist ein Naturgesetz, es kann von Ingenieuren nicht beeinflusst werden. Alle diese Fakten werden in der politischen Diskussion nicht erwähnt. Wenn solche Anlagen mit Steuergeldern subventioniert werden, ist das nach meiner Ansicht Geldverschwendung.

Aber wir Ingenieure haben mit Ideologen so unsere Probleme:

– Wenn wir sagen, das Problem ist technisch lösbar, so wird es meist von den Umweltschützern in Frage gestellt. Ständig werden neue unrealistische, ja illusionistische Gegenthesen verbreitet. Selbst der Nachweis, dass es technisch geht, wird nicht akzeptiert.

– Wenn wir aber sagen, das geht auf Grund von physikalischen und thermodynamischen Natur/Grundgesetzen nicht, dann wird das als Verweigerungshaltung interpretiert.

– Das gleiche gilt für Forderungen nach Entwicklungen neuer Technologien, die seit vielen Jahrzehnten untersucht werden, leider ohne Erfolg, und bei denen sich auch keine erfolgversprechenden Lösungen abzeichnen.

– Vor allem aber Fragen der Kosten und der Wirtschaftlichkeit werden völlig falsch beurteilt, ja meist gar nicht in Betracht gezogen. All dies hängt in der politischen Diskussion aber nun mit dem Thema Klimaschutz und Erderwärmung durch CO2 zusammen. Ich möchte ausdrücklich betonen, um alle etwaigen Missverständnisse zu vermeiden, dass Maßnahmen zur Einsparung von Energie richtig und erforderlich sind, wenn sie bezahlbar sind. Dies war eine meiner wesentlichen Aufgaben und Ziele während meiner ganzen beruflichen Tätigkeit.

Und damit wären wir beim 2.Thema.

Frage ist, kann CO2 einen nennenswerten Einfluss auf das Klima auf dem Planeten Erde haben? Diese Frage ist fast zu einer existenziellen Glaubensfrage mutiert. In den USA haben ca. 34.000 Wissenschaftler Herrn Obama aufgefordert, das Thema CO2 aufzugeben, da CO2 keinen nennenswerten Einfluss auf das Weltklima haben kann. Diese These widerspricht aber den politischen Bestrebungen der „Antienergie Lobby“. Ich habe mir auch Gedanken darüber gemacht, und diese in einer Arbeit unter dem Thema „Klimafakten“ ausgearbeitet.

Wichtigste Grundlage bei meiner Ausarbeitung ist das unter der Regie von Herrn S. Gabriel in Niedersachsen von drei wissenschaftlichen Instituten erarbeitete und herausgegebene Werke „Klimafakten“, -ISBN 3-510-95872-1-. Ich habe es dabei, sie können es gerne einsehen. Für mich das beste Werk und vor allem auch fundierteste, ja sogar spannend zu lesende Werk mit dieser Thematik, das erschienen ist.

Hier steht in der Einleitung:

– „Es ist schwierig oder gar unmöglich, zwischen natürlicher Klimaentwicklung und einer durch den Menschen beeinflussten Klimaschwankung zu unterscheiden. Es bleibt festzuhalten, dass sich zahlreiche äußere Einflussgrößen des Klimas bislang nicht mit hinreichender Genauigkeit fassen lassen. Auch die komplexen internen Prozessabläufe, die das Klima sowie dessen Zustände beeinflussen, sind nicht hinreichend entschlüsselt“.

In einem Bericht der amerikanischen National Academy of Sciences (NAS) steht:

– „ Unsere Kenntnis der Mechanismen des Klimawechsels sind so bruchstückhaft wie unsere Daten. Nicht nur sind die grundlegenden wissenschaftlichen Fragen großenteils unbeantwortet, sondern in vielen Fällen wissen wir nicht einmal genug, um die entscheidenden Fragen zu stellen“.

Ähnliche Formulierungen und Vorbehalte finden sich auch im IPCC – Bericht, der Grundlage für alle Klimakonferenzen ist. Diese sind ehrlichen, überzeugenden Darlegungen, die in dem Werk „Klimafakten“ detailliert begründet werden, mit eingehender Beschreibung der wesentlichen Einflussfaktoren auf das Klima.

Die wesentlichsten sind u.a.:

– Temperatur der Luft; Temperatur der Atmosphäre;

– Niederschläge; Verdunstung; Luftfeuchtigkeit;

– Wind; Bewölkung; Nebel;

– Strahlungshaushalt; Sonneneinstrahlung; kosmische Strahlung;

– Wasserzirkulation;

– Wärmetransport in und durch die Meeresströmungen in den Ozeanen;

– Wärmeaustausch zwischen Atmosphäre, Land und Ozeanen;

– Präzessionskreis der Erdrotationsachse;

– das Heiße innere der Erde und der Ozeane; Vulkantätigkeiten;

– mineralogische Zusammensetzung der Erdkruste; Gasschichten und Gashüllen in der Atmosphäre;

– die Oberfläche des Planeten Erde mit Eiskammern und Wüstengebieten; Verwitterung;

– Wärmeabstrahlung ins Weltall, und letztlich Einflüsse aus dem gesamten Weltall.

Diese wesentlichen in dem Werk einzeln beschriebenen Faktoren können noch beliebig erweitert werde, doch die NAS hat ja gesagt, dass wir noch nicht einmal wissen, welche Faktoren das sein könnten. Dass deutsche „Wissenschaftler“ verschiedener ÖKO-Institute, vor allem die Herren Prof. Schellnhuber und Rahmstorf dies alles wissen wollen, erscheint mir persönlich mehr als dubios. Auch die umfassendsten Modellrechnungen mit den größten Rechnern und Rechenprogrammen können diese Fragen nicht beantworten. Die größten und modernsten Computer rechnen nur das aus, was mit den einzelnen Faktoren in die Programme eingegeben wird. Hier hat jeder ausreichende Variationsmöglichkeiten.

Hierzu noch ein Zitat aus „Klimafakten“:

– „Die Klimamodelle, auf deren Vorausberechnung sich die ganzen „Global Warming“ Theorie stützen, sind grob falsch, unter anderem deshalb, weil der Einfluss der Wolken und vieler anderer, auch von der Sonne kommender Effekte völlig unzureichend berücksichtigt sind. Das stärkste Treibhausgas ist nicht CO2 sondern Wasserdampf. Rund 2/3 des gesamten sogenannten Treibhauseffektes der Erdatmosphäre wird vom Wasserdampf verursacht“.

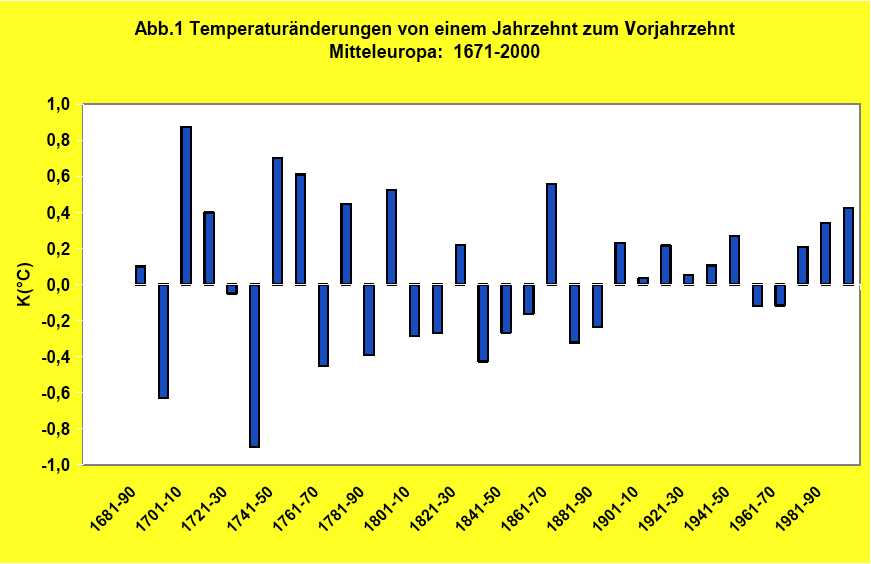

Bei der Beurteilung des Klimas muss vor allem beachtet werden, dass keine regionalen Betrachtungen angestellt werden dürfen, sondern nur globale. Alle regionalen Beobachtungen führen bei einer Klimadiskussion zu grundlegend falschen Schlüssen.

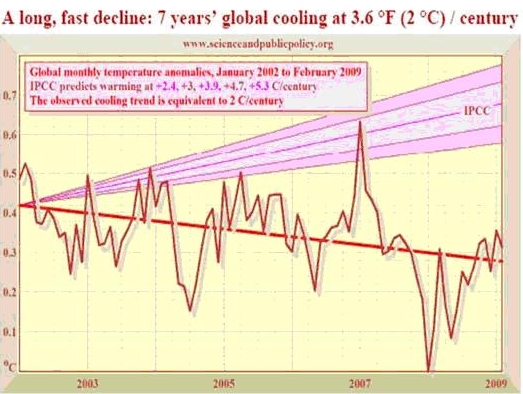

Die USA-NASA- messen seit 1979 mittels Satelliten die globale Temperaturverteilung auf dem gesamten Globus.

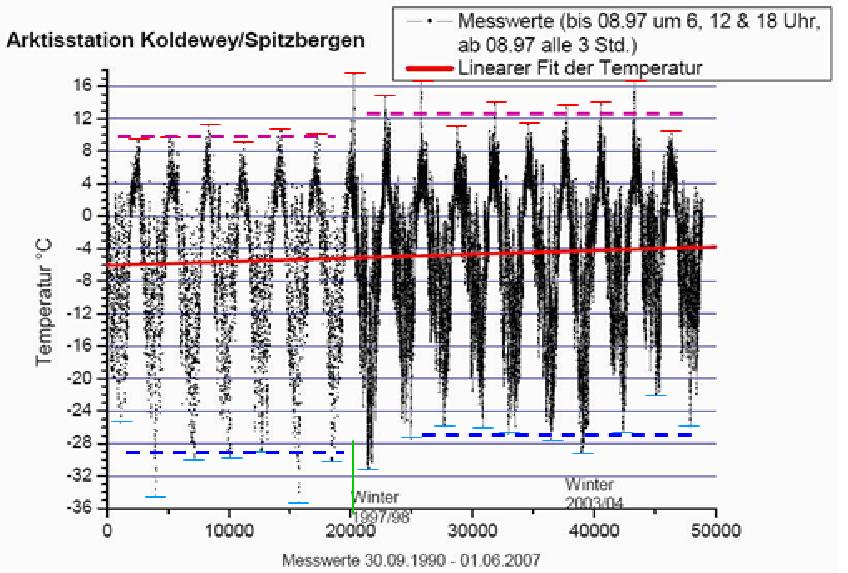

Danach wurde von 1979 bis 1986 eine niedrigere mittlere Temperatur bis -0,1 grad C gemessen. Danach stieg die Temperatur bis 2005 auf + 0,3 grad C an. Seitdem vermindert sie wieder und erreichte 2008 die gleiche mittlere Temperatur wie 1979. 2009 liegt sie bisher bei -0,1 gradC.

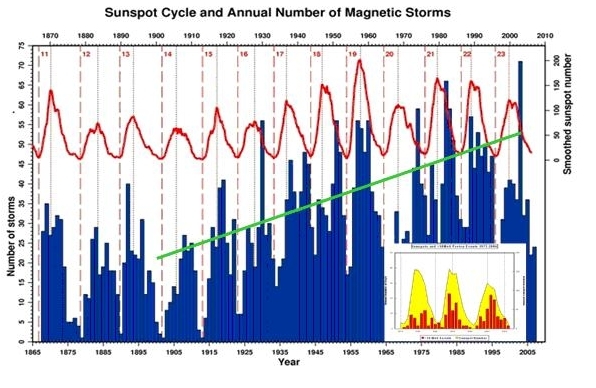

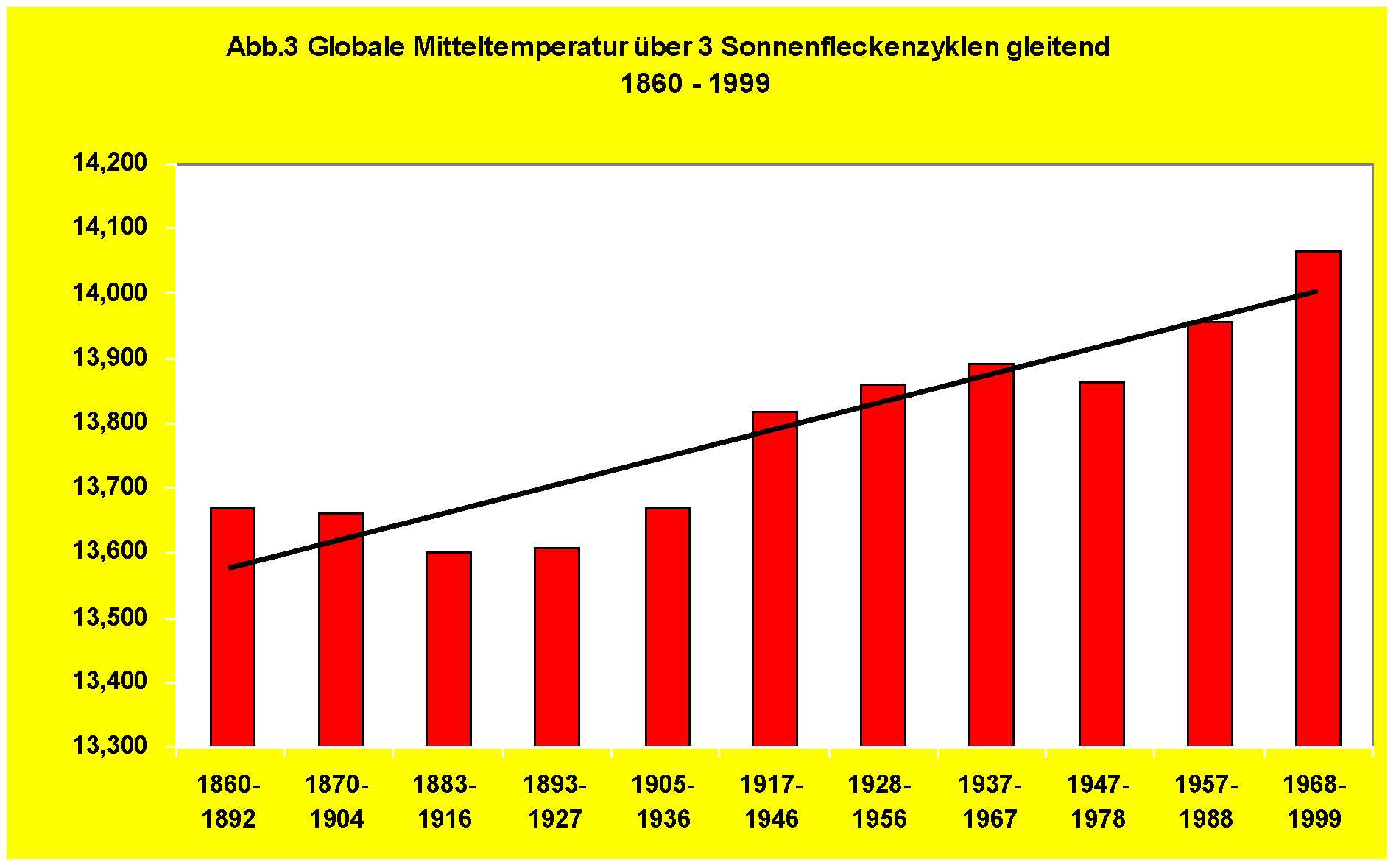

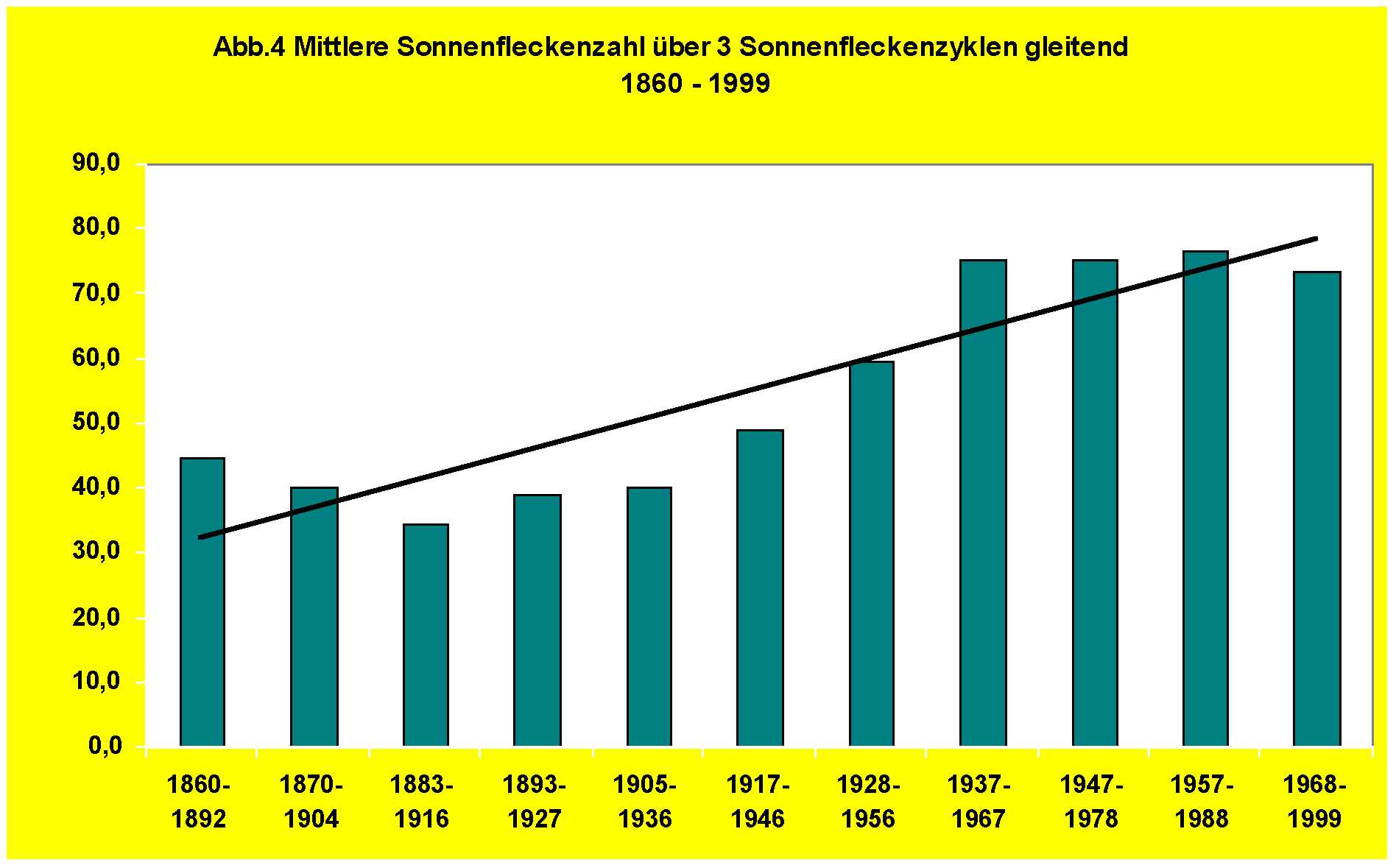

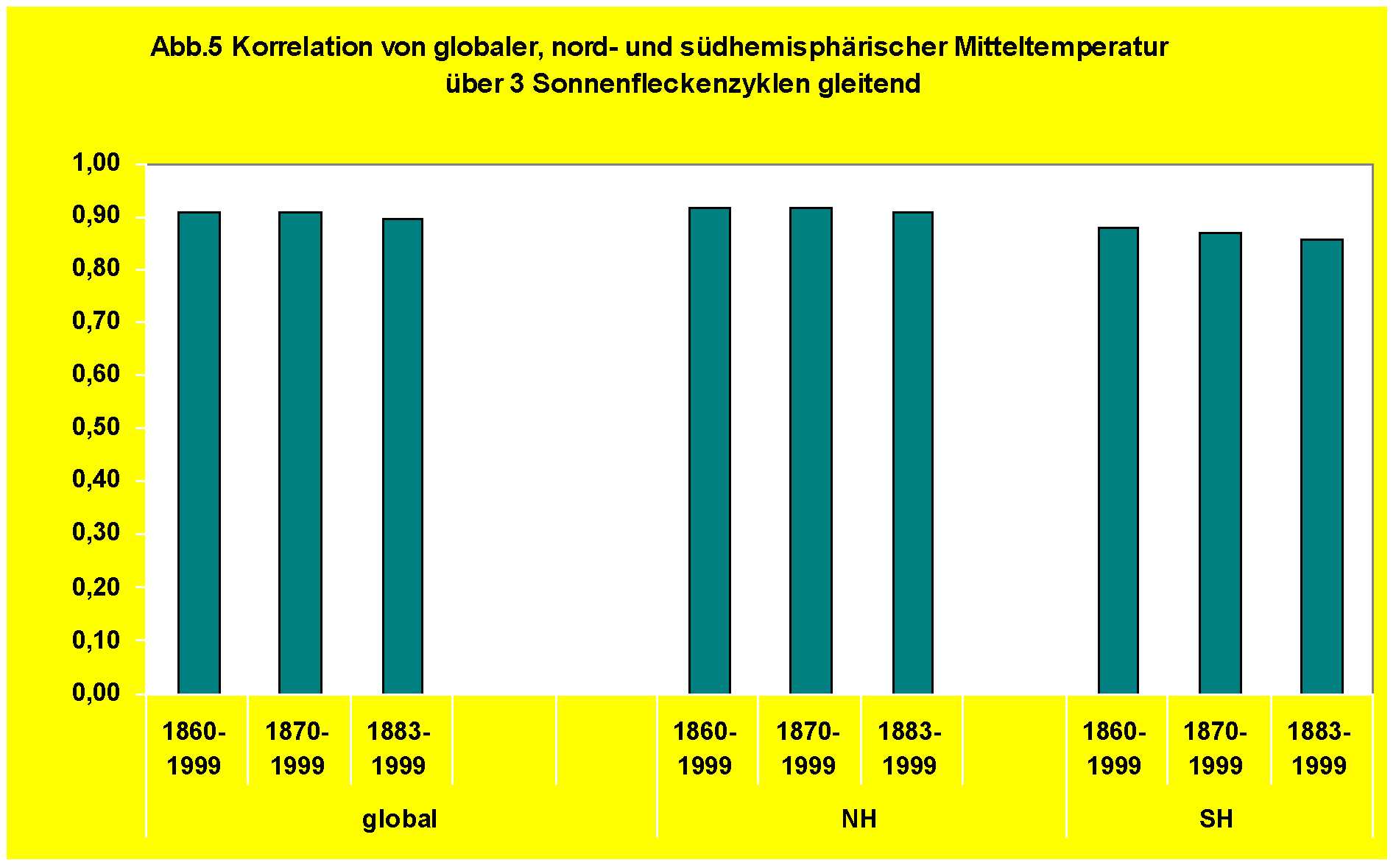

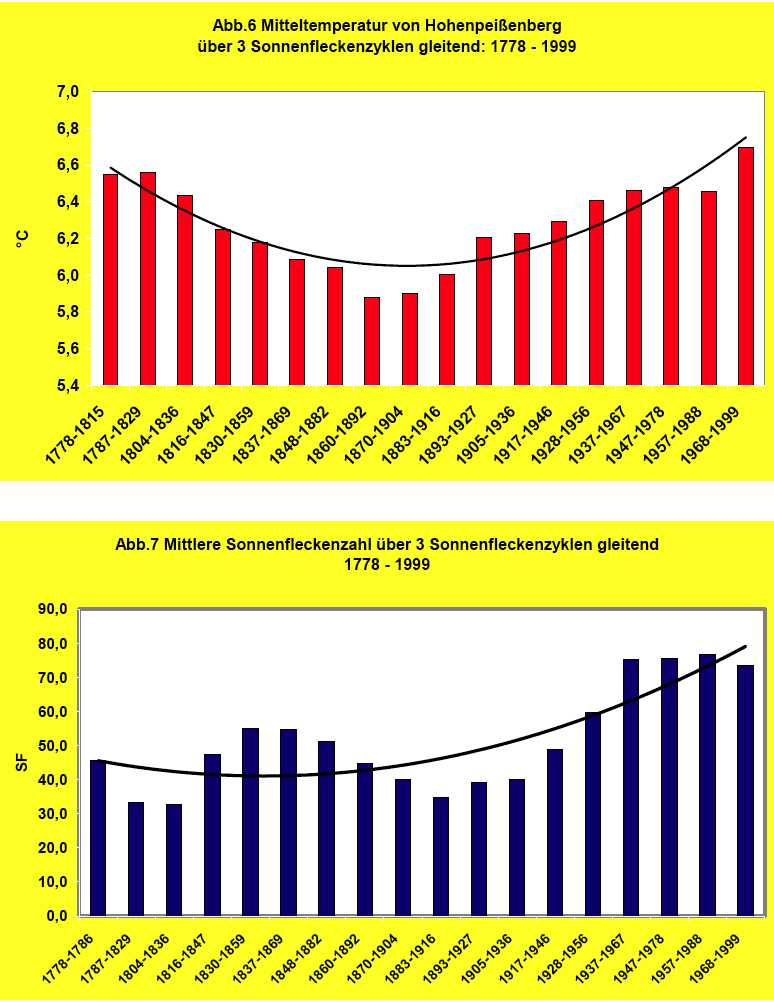

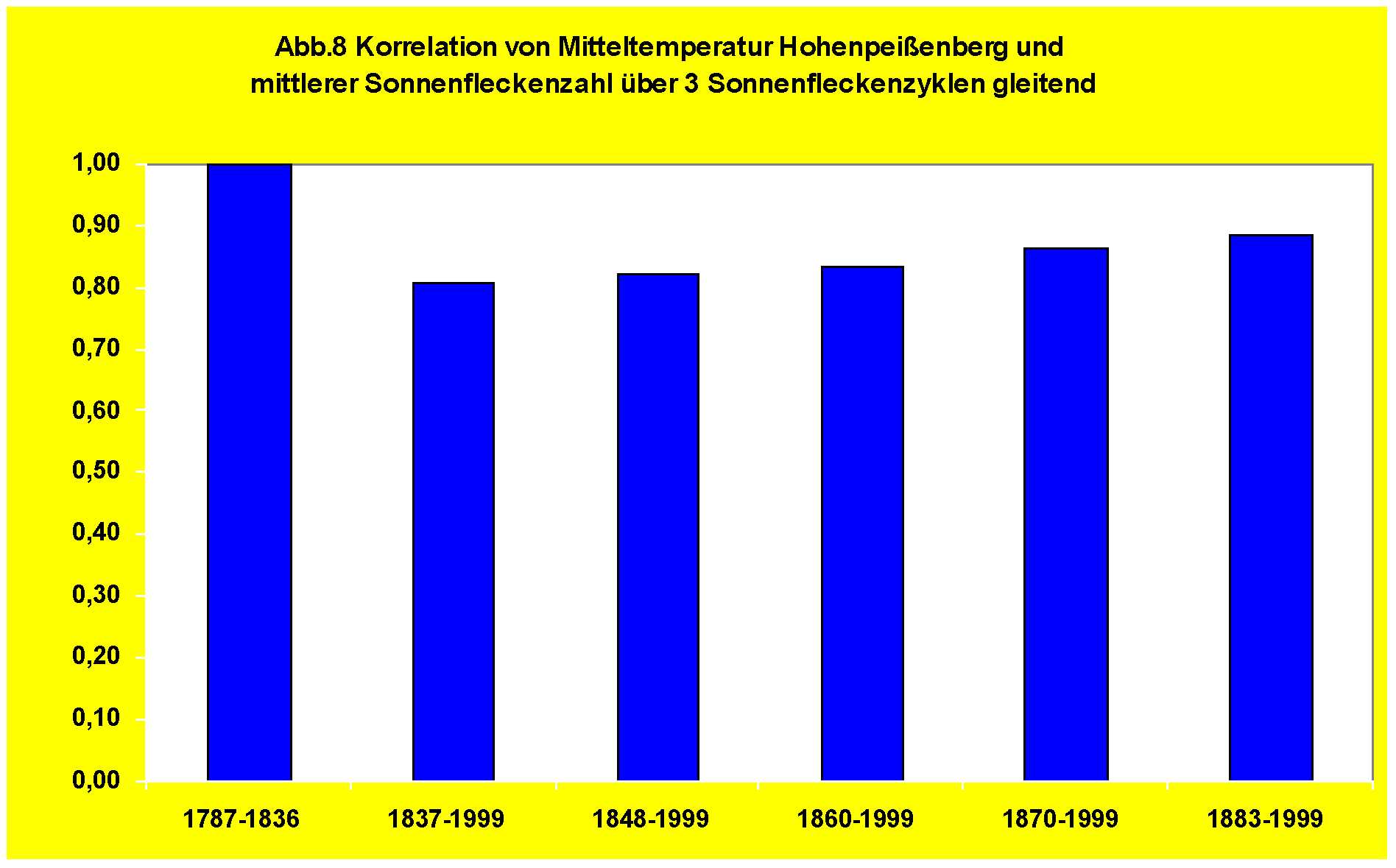

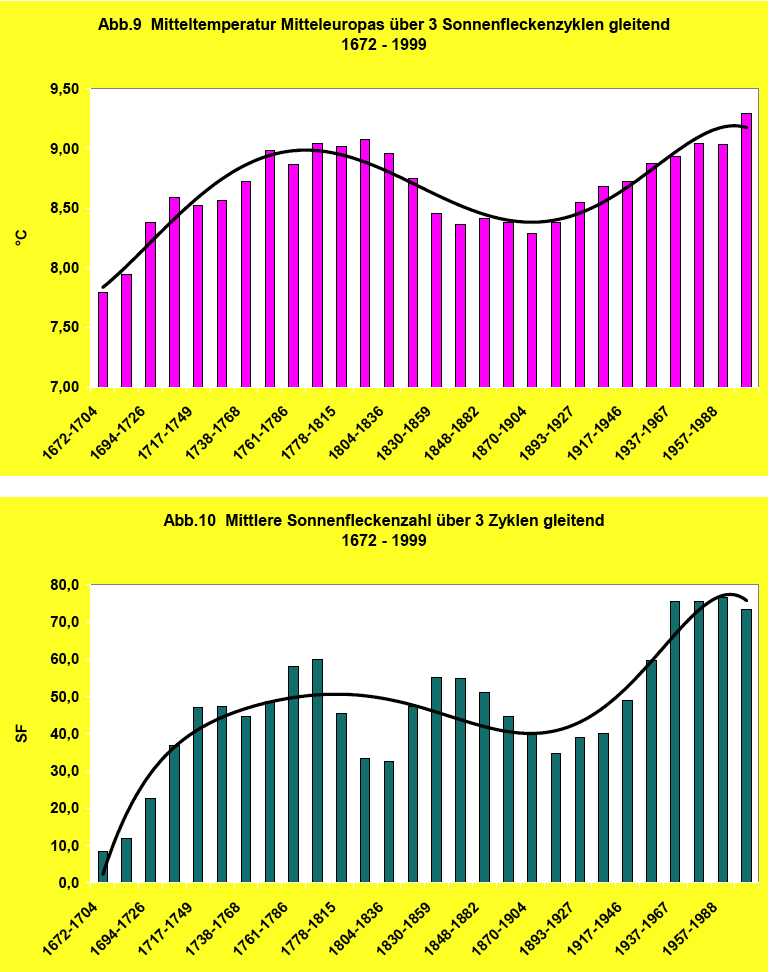

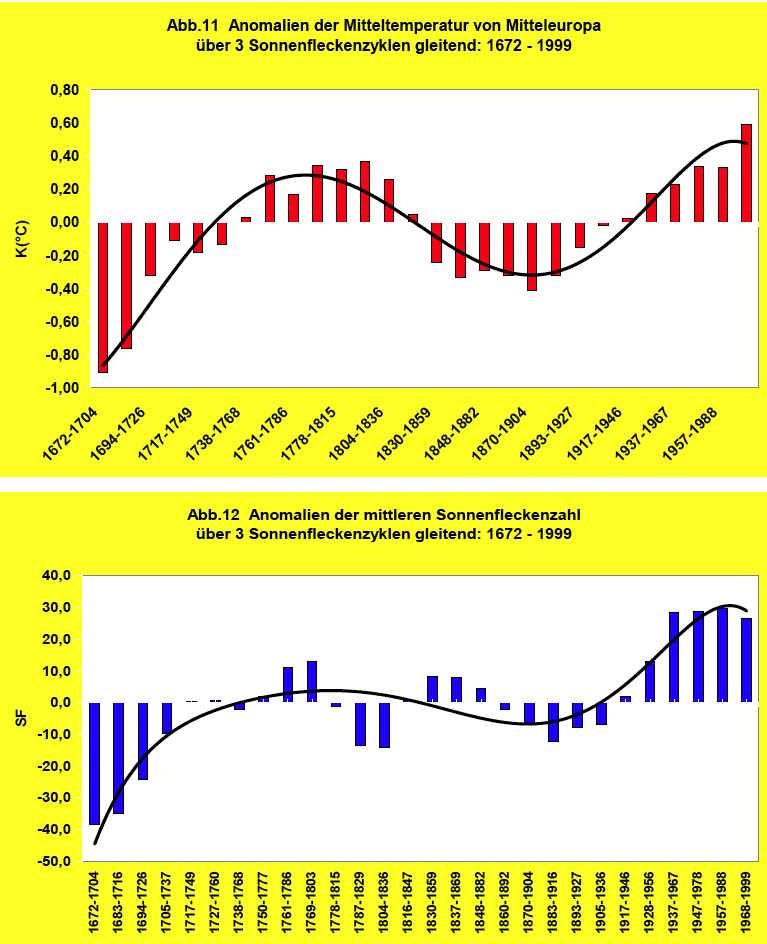

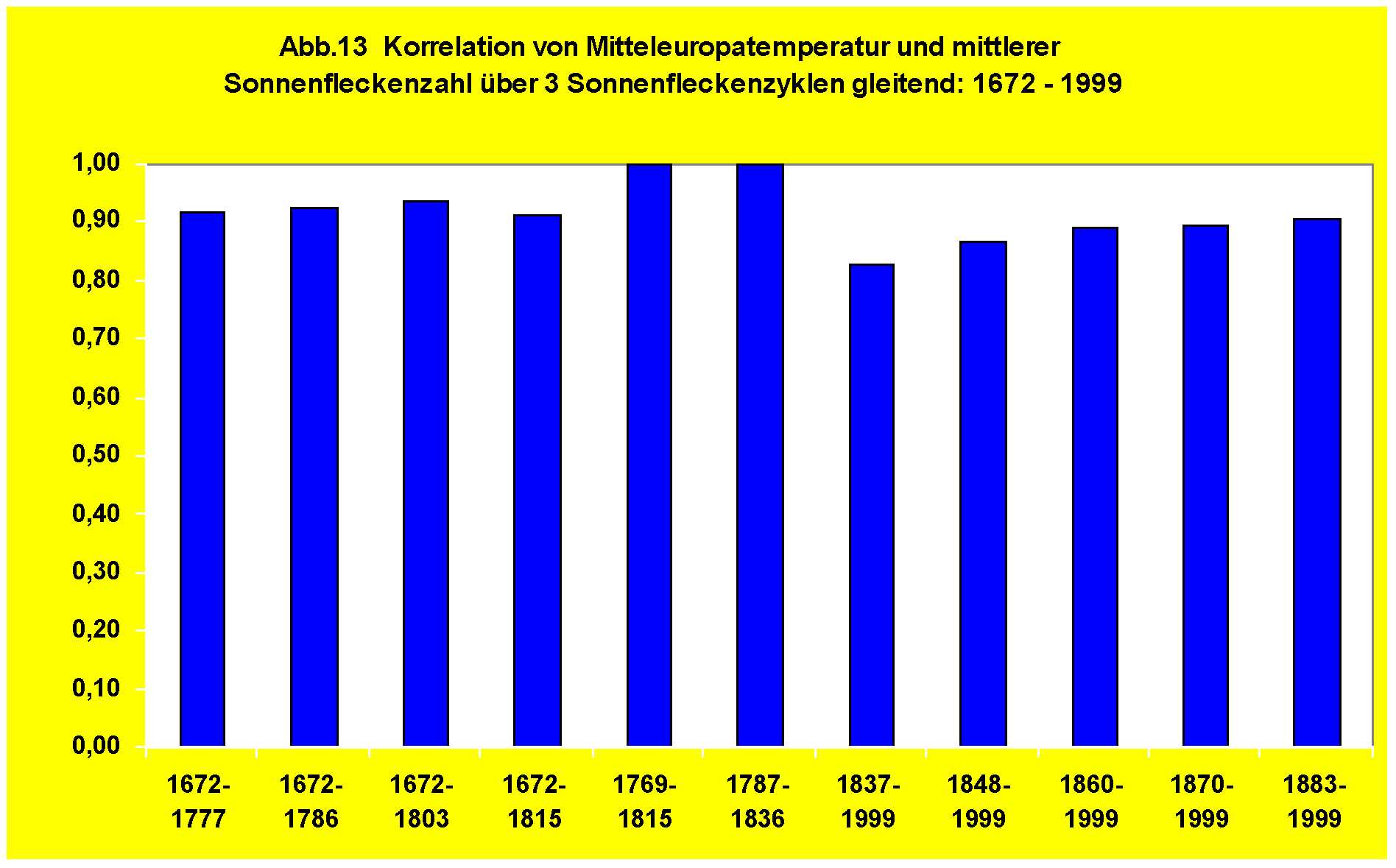

Prof. Menzel, Rektor der Fachhochschule Ruhr, früher Dortmund, stellte in einem Vortrag Anfang diese Jahres die These auf, dass für Klimaschwankungen vor allem die Sonnenstrahlung –Sonnenflecken- verantwortlich sein könnten. Er ermittelte auf Grund seiner Beobachtungen und Berechnungen, dass z.Zt. die mittlere globale Temperatur weiter sinkt, wir also vor einer „neuen kurzen Eiszeit“ stehen. Er sagt wörtlich, dass er sich als Wissenschaftler schäme, wenn Professoren deutscher Klimainstitute, die nur Halbwahrheiten publizieren, als Wissenschaftler bezeichnet würden, dann wolle er keiner mehr sein. Meine Frage: ich möchte wissen, welcher und wie viele Politiker, die über diese Dinge oft rein populistisch reden, dieses Werk das, unter der ministeriellen Regie von Herrn Gabriel entstanden, gelesen haben?

Doch nun einige Worte zur Funktion des CO2 in der Atmosphäre.

CO2 ist ein Gas, das bei allen Verbrennungs- und Atmungsvorgängen entsteht.

Zusammengefasst:

– CO2 ist ein Spurengas, das in der Atmosphäre mit einem Anteil von 380ppm oder 0,038 % enthalten ist;

– Es entsteht bei allen Verbrennungsvorgängen, also von Holz, Kohle, Erdöl, Erdgas, kohlenstoffhaltigen Abfallstoffen usw.

– Ferner durch Atmung von Menschen und Tieren und bei der Vermoderung von holzartigen Abfällen in der Natur, sowie bei Vulkanausbrüchen über der Erde und im Meeresboden.

– Zwischen CO2 aus Verbrennungsprozessen und durch Atmung der Menschen besteht chemisch und damit auch hinsichtlich einer eventuellen Auswirkung auf das Klima kein Unterschied;

– CO2 ist der beste Pflanzendünger, die Land- und vor allem Forstwirtschaft haben hierdurch bedeutende Vorteile;

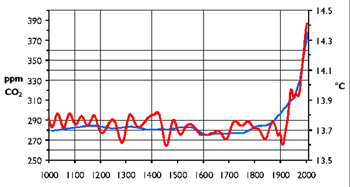

– Wissenschaftliche Untersuchung im Eis der Polargegenden habe zweifelsfrei gezeigt, dass eine Erhöhung des CO2-Gehaltes in der Atmosphäre stets Folge aber nie Ursache einer Erwärmungsphase war;

– Es gibt keinen einzigen wissenschaftlichen Beweis, dass CO2 einen Einfluss auf das Klima hat;

Daraus folgt:

– Ohne CO2 ist der Planet Erde unbewohnbar, Sauerstoff und Kohlendioxid sind die wichtigsten Gase in der Luft, die Menschen, Tiere und Pflanzen zum Atmen benötigen.

Hier eine kurze Modellrechnung, die jeder sofort ohne Rechenprogramm nachvollziehen kann:

– Die Menschen atmen im Schnitt bei normaler Belastung etwa 320kg CO2/Jahr aus;

– Der CO2-Ausstoss der Tiere wird in etwa in der gleichen Größenordnung angenommen;

– Hochgerechnet auf 82 Millionen Einwohner der BRD sind dies ca. 30 Millionen toCo2/Jahr;

– Der gesamte anthropogene CO2-Ausstoß der BRD beträgt ca. 870 Millionen toCo2/Jahr;

– Der gesamte weltweite CO2-Ausstoss beträgt ca. 28,2 Milliarden to/Jahr;

– Damit beträgt der Anteil der BRD weltweit 3,1%;

– Es ist das Ziel der Bundesregierung, diesen Ausstoß in den nächsten 10 Jahren um 20%, also um ca. 200 Millionen to zu senken;

– Die CO2- Produktion allein in China beträgt ca.3,5 Milliarden toCO2/Jahr, diese steigert sich in diesem Entwicklungsland um ca. 10%/Jahr, also um ca. 350 Millionen to;

– Damit produziert allein China pro Jahr etwa doppelt so viel CO2 zusätzlich, wie die BRD in 10 Jahren einsparen will;

– Ähnliche Steigerungsraten haben die anderen großen Entwicklungsländer Indien, Brasilien, alle asiatischen Staaten usw.;

Es ist leicht zu erkennen, dass die Zielsetzung der BRD völlig wirkungslos bleiben wird, wenn das CO2 überhaupt eine klimarelevante Bedeutung hätte, denn wir haben wissenschaftlich gesehen keine begründbare globale Erwärmung, sondern lediglich die seit Jahrtausenden vorkommenden periodischen Temperaturschwankungen. CO2 spielt dabei keine erkennbare Rolle. CO2 als „schmutziges Gas“ oder gar „Giftgas“ zu bezeichnen, wie öfter von Presse und Politikern zu hören, ist ein Zeichen von fehlender Bildung.

Alle CO2 – Theorien basieren nur auf Rechenmodellen, hierzu muss man folgendes wissen:

– Die Zahl der unbestimmten Faktoren ist das Maß der Ungenauigkeit der Rechnung;- ein mathematischer Grundsatz;

– Jedes Institut kann beim derzeitigen Erkenntnisstand der Klimaforschung die Faktoren in die Rechenprogramme so eingeben, dass das Ergebnis herauskommt, das man vorher habe will;

– Die ganze „Klimaphilosophie“ beruht auf solchen Modellrechnungen;

Herr Dr. Dittrich, früher Entwicklungschef bei Thyssen, hat die Modellrechnungen des Potsdamer ÖKO-Institutes mit dessen eigenen Programmen nachgerechnet und hat in mehreren Beiträgen, nachgewiesen, dass in diese Berechnungen völlig falsche Werte eingesetzt worden sind. Die Bundesregierung kennt diese Ausarbeitungen, Herr Gabriel, ist informiert, ein erbetener Besprechungstermin konnte bis heute nicht vereinbart werden.

Nun zum 3. Themenkreis, der Erzeugung elektrischer Energie.

Hierzu folgende Thesen als Grundlage zur Beurteilung:

– Elektrische Energie, also Strom, wird in Kraftwerken durch Verbrennung von kohlenstoffhaltigen Brennstoffen verschiedener Art, vor allem durch Steinkohle, Braunkohle, Erdgas und Erdöl.

– Dabei entsteht durch die Verbrennung des Kohlenstoffs CO2, das ist verbrennungstechnisch nicht vermeidbar;

– Aus den erzeugten Verbrennungsgasen, die Temperaturen von ca. 1.500 grad C haben, wird Dampf mit hohen Drücken und Temperaturen erzeugt. Dieser Dampf wird in Dampfturbinen, die Generatoren antreiben, zur Stromerzeugung genutzt;

– Aller erzeugte Strom, auch der aus Windkraftanlagen, wird praktisch in gleichartigen Generatoren erzeugt, nach identischem physikalischen Prozess;

– Nach Einspeisung des Stroms in die Strom-Übertragungsnetze kann nicht mehr unterschieden werden, in welchen Anlage der Strom erzeugt worden ist;

– Weiter wird Strom in geringerer Menge in Erdgas/Erdöl-Gasturbinen, Dieselmotoren, Wasserturbinen, Windturbinen, die alle Generatoren antreiben, und in Solaranlagen erzeugt.

Bei der Stromerzeugung müssen folgende Kernfragen beachtet werden, sie müssen die Grundlage jeder Energiepolitik sein:

– Die Stromerzeugung ist der einzige Produktionsprozess in der Wirtschaft, bei dem die Nachfrage unmittelbar und in Sekunden die Höhe der Produktion bestimmt;

– Die Speicherung von Strom zum Ausgleich von Belastungsschwankungen ist nur bedingt und mit hohen Kosten und Wirkungsgradverlusten möglich, also aus wirtschaftlichen Gründen nur in geringem Umfang machbar;

– Die Entwicklung von Speichermöglichkeiten, vor allem von Batterien, ist seit Beginn der Stromerzeugung vor mehr als 140 Jahren Schwerpunkt aller weltweiten Forschungsarbeiten. Alle Anstrengungen sind de facto erfolglos geblieben. Es zeichnet sich auch leider kein technisch und wirtschaftlich erfolgversprechender Durchbruch an;

– Alle Stromerzeugungsanlagen müssen daher regelbar sein, das heißt, sich den Schwankungen in den Übertragungsnetzen anpassen können;

– Auf Grund des Gesetzes, dass die Stromversorgung für alle Abnehmer gesichert sein muss, muss die installierte Kraftwerksleistung in der Lage sein, die Stromversorgung auch bei den höchsten Belastungsspitzen sicherzustellen, die Kraftwerke müssen aber auch im Teillastbereich betreibbar sein;

– Alle konventionellen Kraftwerke sind hierzu in der Lage;

– Die Anlagen mit „Erneuerbaren Energien“ können dies nicht, sie erzeugen nur Strom, wenn der Wind weht und die Sonne scheint;

– Der in diesen Anlagen erzeugte Strom muss von den großen Kraftwerksbetreibern aber auf Grund des EEG-Gesetzes immer abgenommen und gekauft werden. Dadurch müssen zwangsläufig bestehende und am Netz befindliche Kraftwerke im Teillastbereich unwirtschaftlichen Strom produzieren. Die hierdurch entstehenden Kosten werden den Stromabnehmern durch höhere Preis verrechnet.

Die Kosten der Stromerzeugung bis zur Einspeisung in die Übertragungsnetze in den verschiedenen Anlagen sind in etwa folgende:

– Wasserkraftwerke: ca. 4,3 cent/kwh;

– Kernkraftwerke: ca. 2,65 cent/kwh:

– Braunkohlekraftwerke: ca. 2,40 cent/kwh;

– Steinkohlekraftwerke: ca. 3,35 cent/ kwh;

– Erdölkraftwerke: ca. 4 – 5 cent/kwh;

– Erdgaskraftwerke: ca. 4,90 cent/kwh;

– Windkraftwerke: ca. 10 – 16 cent/kwh;

– Solaranlagen: ca. 40 – 60 cent/ kwk;

Als Ingenieur war ich 40 Jahre lang bemüht, meist die Wirkungsgarde von Stromerzeugungsanlagen um wenige 1/10 % zu verbessern. Dass Politiker heute einen Verteuerungsfaktor von 5 – 30, also um 500% bis zu 3.000% für „machbar“, also der Bevölkerung für zumutbar, halten, darüber soll sich jeder seine eignen Gedanken machen.

Die Erzeugungskosten des Stroms aus „Erneuerbaren Energien“, also aus Wind- und Sonnenanlagen, können so lange nicht wirtschaftlich werden, bis es wirtschaftliche Speichermöglichkeiten gibt, und diese sind seit hundert Jahren nicht in Sicht und werden in den nächsten Jahrzehnten auch nicht zur Verfügung stehen. Daher werden sie für diesen Zeitraum auch nicht wirtschaftlich werden können, alle anderen Aussagen sind illusionistisch.

Noch einmal die Kostenproblematik dieser Anlagen:

– Auf Grund des EEG-Gesetzes, muss der in Anlagen mit Kraft-Wärmekopplung, in Wind- und Sonnenanlagen teuer erzeugte Strom von den Energieversorgern zu hohen Preisen abgenommen werden und bezahlt werden;

– Die Kosten werden in die Strompreise für alle Verbraucher eingerechnet , der Strom wird also verteuert;

– Nach Ansicht von Politikern sind dies keine Subventionen;

– Zusätzlich werden die Investitionskosten von „Erneuerbaren Energie“ aus Steuermitteln mit Milliardenbeträgen hoch subventioniert;

Aus diesen Überlegungen heraus, und weil die weltweiten Reserven an den Edelenergien Öl und Gas irgendwann einmal enden oder sehr teuer werden, werden weltweit neue Kernkraftwerke geplant und gebaut. Diese These wird weltweit als richtig angesehen wird, nur nicht in Deutschland. Eine gesicherte Versorgung der Welt ohne Stromerzeugung aus Kernkraftwerken ist auf Dauer unmöglich, also eine Illusion. Vor allem die Staaten, die über die größten eigenen fossilen Energie-Rohstoffe verfügen, wollen Kernkraftwerke bauen. Nur nicht Deutschland, das rohstoffärmste Land der Welt. Dass elektrische Energie in Kraftwerken mit Verbrennung von kohlenstoffhaltigen Medien erzeugt wird, dürfte bekannt sein. Es sind feste und flüssige Brennstoffe. Die Energiepolitik der 50iger bis etwa 80iger Jahre ging von dem Grundsatz aus, in Großkraftwerken möglichst nur feste Brennstoffe, also Kohle/Braunkohle zu verbrennen. Die flüssigen und gasförmigen „Edelbrennstoffe“ Öl und Gas sollten überwiegend zur Nutzung in kleineren Anlagen, also Haushalten und Kraftfahrzeugen, sowie als Grundstoffe für chemische und verfahrenstechnische Prozesse dienen, da die Vorkommen dieser Brennstoffe auf der Erde endlich sind und gestreckt werden sollen. Weiter wurde damals schon mit großen Preissteigerungen bei einer Verknappung gerechnet.

Bei einem Vortrag am 19.Juni 2009 in der Düsseldorfer Akademie der Wissenschaft des Landes NRW hat Herr Prof. Dr. Carl Friederich von Weizäcker in einem umfassenden Vortrag nachgewiesen, dass die Energieversorgung der Welt ohne Nutzung der Kernkraft auf Dauer unmöglich ist.

Für die BRD ergeben sich aus dieser Aussage folgende Probleme:

– Wenn in Deutschland keine neuen Kernkraftwerke gebaut werden, dann tun es unsere Nachbarn an unseren Grenzen. Die dann zwangsläufig höheren Stromkosten gehen voll zu Lasten der Deutschen Verbraucher;

– Wegen des hohen Anteils an Strom aus Kernkraftwerken liegen die Strompreise in Frankreich in allen Tarifgruppen bei etwa 50% der deutschen Tarife;

– Z.Zt. sind weltweit etwa 400 Kernkraftwerke in der Planung. Für jedes dieser Kernkraftwerke werden ca. 3 Milliarden Euro investiert, das sind 1,2 Billiarden Euro;

– Die deutschen Kraftwerksbauer hatten einen Anteil von etwa 20% am Weltmarkt, damit gehen der deutschen Wirtschaft rund 240 Milliarden Aufträge verloren, mit den entsprechenden Arbeitsplatzverlusten;

Die in Deutschland in Betrieb befindlichen Kernkraftwerke, auch die älteren Anlagen, sind unzweifelhaft mit die besten und sichersten weltweit. In allen Betriebsjahren ist nicht ein einziger Unfall mit Strahlungsfolgeschäden erfolgt, weder beim Bedienungspersonal und schon gar nicht in der Bevölkerung. Diese sicheren Anlagen sollen jetzt, da weltweit ca. 400 neue Kernkraftwerke in Planung sind, stillgelegt werden. Einen größeren volkswirtschaftlichen Unsinn kann man nicht erdenken.

Zur Beurteilung der nuklearen Probleme bei Störungen in Kernkraftwerken hat die Internationale Atomenergiebehörde Beurteilungskriterien festgelegt. Dies beinhalten 8 Störungsstufen die folgende Aspekte berücksichtigen: Radiologische Auswirkungen außerhalb der Anlage; Radiologische Auswirkungen innerhalb der Anlage; Beeinträchtigung von Sicherheitsvorkehrungen. Diese werden charakterisiert nach Unfällen, Störfällen und Störungen.

In den letzen 15 Jahren traten in allen deutschen Kernkraftwerken 2198 sogenannte meldepflichtige Ereignisse ein. Hiervon betrafen 3 die Stufe 3, 98% die Stufe 0. Selbst die Störungen im KKW Krümel wurde mit der Stufe 0 beurteilt. Wenn Politiker und die Presse auf „Ereignisse in KKW“ hinweisen, dann sollten sie auch den Gefährdungsgrad nach dieser international gültigen Skala erwähnen.

In den 60iger Jahren wurde mit der Entwicklung der Hochtemperatur-Reaktortechnik begonnen. Hieran war ich als Ingenieur in führender Position bei BBC/Krupp beteiligt. Die Ausarbeitung eines Vortrages, den ich kürzlich im KKW Biblis der RWE gehalten habe, „Die Technik der Hochtemperaturreaktoren“ können Sie gerne einsehen, wer möchte, möge mir bitte seine e-mail Adresse geben, ich schicke ihn dann zu. Eine Graphitkugel, diese sieht genau so aus, wie ein Brennelement, habe ich Ihnen mitgebracht. Ich kann den 20 seitigen Vortrag, er hat in Biblis eine Stunde gedauert, Ihnen hier nicht vortragen. Mir wurde der Vorwurf gemacht, dass ich die Technik so genau beschrieben hätte, dass er praktisch eine Bauanleitung für diese Reaktoren sein könnte.

Ich möchte daher nur kurz auf die Vorteile dieser Technik eingehen: Die Idee stammt von Prof. Dr. Rudolf Schulten, als er junger Physiker und Ingenieur bei BBC war.

Grundlagen seiner Überlegungen waren:

– Kugelförmige Brennelemente wegen der gute Handhabbarkeit im Reaktor;

– Umwälzung, also Beladung des Reaktors während des Betriebes;

– Graphit als Hauptwerkstoff für die Brennelemente und Reaktoreinbauten;

– Helium als Kühlmittel;

– aus Uran 235 und Thorium 232 als Brennstoff mit der Möglichkeit, neuen Brennstoff zu erbrüten;

– Hohe Temperaturen und Drücke bei der Dampferzeugung mit der Möglichkeit, hohe thermodynamische Wirkungsgrade zu erzielen und die Hochtemperaturwärme zur Anwendung in chemischen Prozessen mit dem Ziel, aus Bio-Massen flüssigen Brennstoff zu erzeugen.

– Die Möglichkeit, neuen nuklearen Brennstoff zu erbrüten. Dadurch ist die Versorgung von Kernkraftwerken mit nuklearem Brennstoff auf hunderte von Jahren gesichert.

– eine inhärente Sicherheit des Systems durch Vermeidung einer Kernschmelze- „GAU“- auch bei kompletten Ausfall der Reaktorkühlung – Ursache des Unfalls in Tschernobyl- zu vermeiden.

Dies wurde 1967 bei der Inbetriebnahme des AVR Reaktors in Jülich erprobt. Der 1. GAU fand also nicht in Tschernobyl, sondern in Jülich statt. Hier flog der Reaktor nicht in die Luft, sondern kühlte sich langsam von alleine ab. Dieser Vorgang wurde 1977 und dann auch in China wiederholt, mit dem gleichen Ergebnis. Nach dem genannten AVR, der 1966 mit einer Leistung von 15 MW in Betrieb ging und praktisch störungsfrei bis 1989 lief, wurde ab 1970 der THTR in Schmehausen gebaut, hier mit einer Leistung von 300 MW. Dieser Reaktor wurde nach 16.000 Betriebsstunden 1989 aus politischen Gründen stillgelegt.

Nun wird diese HTR Entwicklung in China und SA mit unserem know how weitergeführt, mit dem zu vermutenden Ergebnis, dass wir später für unser know how, mit dem wir in den 60iger bis 80iger Jahren weltweit konkurrenzloser Spitzenreiter waren, Lizenzgebühren bezahlen müssen.

Bei der Ausarbeitung meines Vortrages habe ich mir die Frage gestellt, ob wir diese Spitzenstellung mit den bei uns vorhandenen Kenntnissen und Betriebserfahrungen nochmals erreichen können. Meine Schlussfolgerung nach Durcharbeitung vieler Unterlagen ist, wir können es in etwa 2 Jahren wieder sein. Während des Betriebes beider Kernkraftwerke ist keine einziger nennenswerter Unfall mit „Strahlenfolgen“ aufgetreten, weder beim Betriebspersonal noch in der Umgebung.

Die Betriebserfahrungen mit beiden Reaktoren zeigen:

– HTR – Kraftwerke können im elektrischen Verbundnetz regelungstechnisch einwandfrei eingesetzt werden;

– Die Anlagen sind sicherheitstechnisch problemlos zu betreiben;

– Die Bestrahlungsdosis des Personals ist bei Betrieb und selbst bei Reparaturarbeiten am offenen Primärteil sehr gering;

– Sicherheitstechnisch begründete Betriebseinschränkungen oder sicherheitstechnisch relevante Schäden hat es bei beiden Anlage nicht gegeben;

– Die Gesamtanlage und alle Anlageteile konnten im großtechnischen Einsatz erprobt werden;

– Die Sicherheitstechnik ist soweit entwickelt, dass selbst bei einer größten überhaupt denkbaren Störung keine Gefahr für das Bedienungspersonal oder die Bevölkerung gegeben ist. Selbst dann ist eine Evakuierung der Bevölkerung im engen Umkreis der Anlage nicht erforderlich.

Preiswerte Energie ist die Grundlage jedes wirtschaftlichen Fortschritts. Dass Strom aus Kernkraftwerken billiger ist, zeigt und Frankreich. Hier liegen die vergleichbaren Stromtarife für alle Abnehmer bei etwa 50% der Tarife in Deutschland.

Herr Werhahn hat diese Technik als „Grüne Atomkraftwerke“ bezeichnet. Eine treffende Formulierung, denn alle Argumente der Umweltschützer gegen Atomkraftwerke treffen hier nicht zu.

Ich sehe in dieser Technik die wohl einzige Chance, dass sich Deutschland von Primärenergieimporten unabhängiger machen kann.

Zur Beurteilung der Frage der Gefährdung bzw. Strahlenbelastung der Bevölkerung durch Kernkraftwerke sollten auch folgende Kriterien berücksichtigt werden:

– Seit Millionen von Jahren wird alles Leben auf der Erde durch die Sonne und aus der Erdkruste heraus radiologisch belastet;

– die Frage, ob die Erde überhaupt bewohnbar ist ohne diese Strahlungen ist ungeklärt;

– In Deutschland ist die Strahlung im Feldberggebiet im Schwarzwald mit 1.800 mrem oder 18 mSv am höchsten. Es ist kein Fall einer Strahlenschädigung bekannt.

– Die mittlere Kollektivdosis während der Betriebszeit des von den Gegnern „geschmähten“ THTR-300 betrug 45 Personen mSv/Jahr, bei Reparaturen am offenen Kern lag sie zeitweise bei zulässigen 100 mSv;

– Beim AVR lag die Strahlenbelastung zum Zeitpunkte der Stilllegung bei 0,39 mSv/Jahr für das Betriebspersonal, also weit niedriger, als an „Land“;

– Durch das Unglück in Tschernobyl (Stufe 7) wurde die Umgebung des THTR in Schmehausen mit nuklearen Niederschlägen in Höhe von 50.000 Becquerel (Bq) belastet;

– Das Öko-Institut in Freiburg behauptet in einer Pressekampagne gegen den THTR, dass diese Belastung vom THTR durch eine unbeabsichtigte Freisetzung leicht radiologisch belasteten Heliumgases hervorgerufen wurde. Diese Behauptung war falsch, der zusätzlich radiologische Niederschlag lag nur bei 0,1 Bq. Ein Beweis, welchen Wahrheitsgehalt die „Horrormeldungen“ solcher Institute haben.

– Der HTR ist weltweit der einzige „katastrophenfreie Reaktor“.

Nun noch einige Bemerkungen zur Frage der Endlagerung, primär am Beispiel des THTR-300:

– Die hochstrahlenden Brennelemente sind nach Stilllegung und Abzug aus dem Reaktorkern in Aahaus eingelagert worden;

– Alle anderen strahlenden Anlageteile und Komponenten lagen innerhalb des Spannbetonbehälters, der auch die Funktion der Strahlenabschirmung hatte. Außerhalb dieses Behälters lagen keine noch strahlenden Anlageteile;

– Der Sekundärteil wurde verkauft, da völlig unbelastet, und ist heute noch in Betrieb;

– Das drucklose Containment, die Luftführungswand, wurde beibehalten;

– Alle Durchdringungen durch Spannbetonbehälter und Containment wurde gasdicht verschweißt, mit verhältnismäßig geringem Kostenaufwand;

– Der Raum zwischen Spannbetonbehälter und dem Containment ist radioaktiv völlig unbelastet und kann ohne Schutzbekleidung und sogar ohne Strahlendosis-Mess-Plakette betreten werden;

– Ein sichererer Einschluss von hochstrahlende Teilen und damit sicherere Zwischen/Endlagerung ist nicht denkbar;

Daraus folgt, dass eine sichere Endlagerung strahlender Reaktorkomponenten nach Betriebsende oder von während des Betriebes ausgetauschten Komponenten technisch realisierbar ist, zu relativ geringen Kosten. Allerdings müssen ideologische, unrealistische Vorstellungen und Forderungen vermieden werden. Der Beweis, einer sicheren Lagerung liegt in Schmehausen seit nunmehr 20 Jahren vor. Niemanden stört diese Anlage, aber auch niemand will dies zur Kenntnis nehmen, denn dann würde ja zugegeben, dass das Problem der Endlagerung einwandfrei lösbar ist. Dann wäre aber auch die politische Diskussion beendet, und das wollen Politiker, die gegen die Kerntechnik sind, und auch die KKW-Gegner nicht zugeben.

Zum Schluss nochmals einige Kernsätze zu den sogenannten „Erneuerbaren Energien“, vor allem Sonne und Wind:

– Die Verfügbarkeit dieser Anlagen liegt bei 1.000 bis 1.500 Stunden im Jahresdurchschnitt;

– Die Jahresverfügbarkeit aller konventionellen Anlage einschließlich der KKW liegt bei max. 8.760 Stunden im Jahr, im Durchschnitt, wegen des erforderlichen Teillastbetriebes, bei etwa 65-70%;

– Die Behauptung und Zielsetzung, dass „erneuerbare Energien“ in Zukunft zu 100% die Stromversorgung sicherstellen können, ist barer Unsinn. Die erforderlichen Speicherkapazitäten sind gar nicht realisierbar, weder technisch und schon überhaupt nicht wirtschaftlich.

– Wenn diese unrealistischen Vorstellungen von Politiker realisiert würden, würde der Strompreis bei geschätzten 5 – 10 Euro/Kwh liegen;

– Ohne Kernkraftwerke sind die sozialen Sicherungssysteme der BRD auf Dauer nicht finanzierbar.

– Diese Politik ist also die denkbar unsozialste Politik, die überhaupt denkbar ist.

Wenn die Finanzkrise mit ihren Auswirkungen auf die gesamtwirtschaftliche Entwicklung und die dabei entstehenden Steuerausfälle zu einer realistischen und gesamtwirtschaftlich vernünftig durchdachten Umwelt-, Energie- und Klimapolitik führen würde, wären ihre Nachwirkungen zum Vorteil für die Wirtschaft, denn das, was weltweit, aber vor allem in Deutschland, denn hier sind wir weltweit einsame Spitze, durch eine solche Politik an Finanzmitteln eingespart werden könnte, würde alle Verluste, die durch die Finanzkrise entstanden sind, vor allem die Steuerausfälle, in wenigen Jahren egalisieren.

Herr Hans Werner Sinn hat ein Buch herausgegeben, „Das grüne Paradoxon“. Es ist ein beachtenswertes Buch.

Wolfgang Clement hat den Begriff der „Deutschland AG“ im internationalen Wettbewerb geprägt und in einem Vortrag gefordert, den Weg zur „Deindustriealisierung in Deutschland endlich zu verlassen. Dieser Weg zur „Deindustriealisierung“ führt zwangsläufig zur „Destabilisierung“ der Deutschen Wirtschafts- und Sozialpolitik. Die Folgen dieser Politik sind leicht zu erahnen, ja heute bereits offen zu erkennen.

Altkanzler Helmut Schmidt hat dies erkannt. Er schreibt in der Einleitung seines Buches „Außer Dienst“:

„Salus publica supreme lex“.

Welche Politiker handeln noch danach?

Dr.-Ing. Urban Cleve Dortmund

Related Files

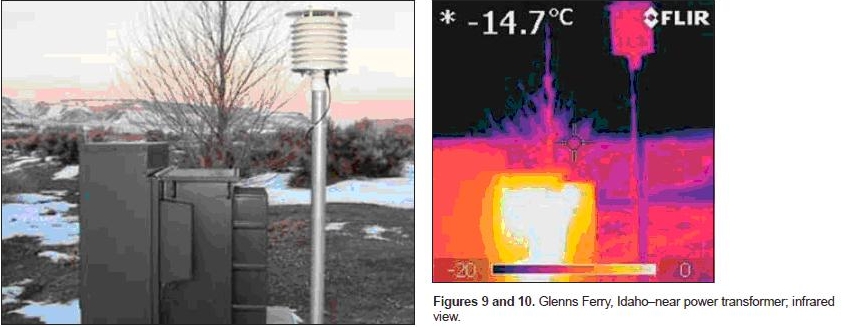

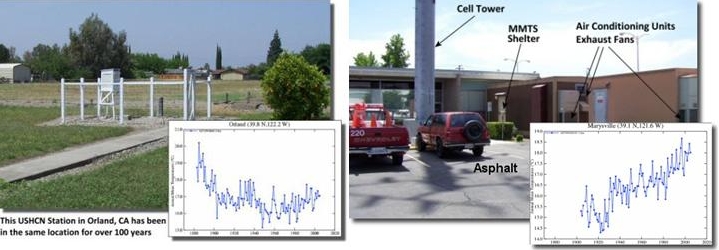

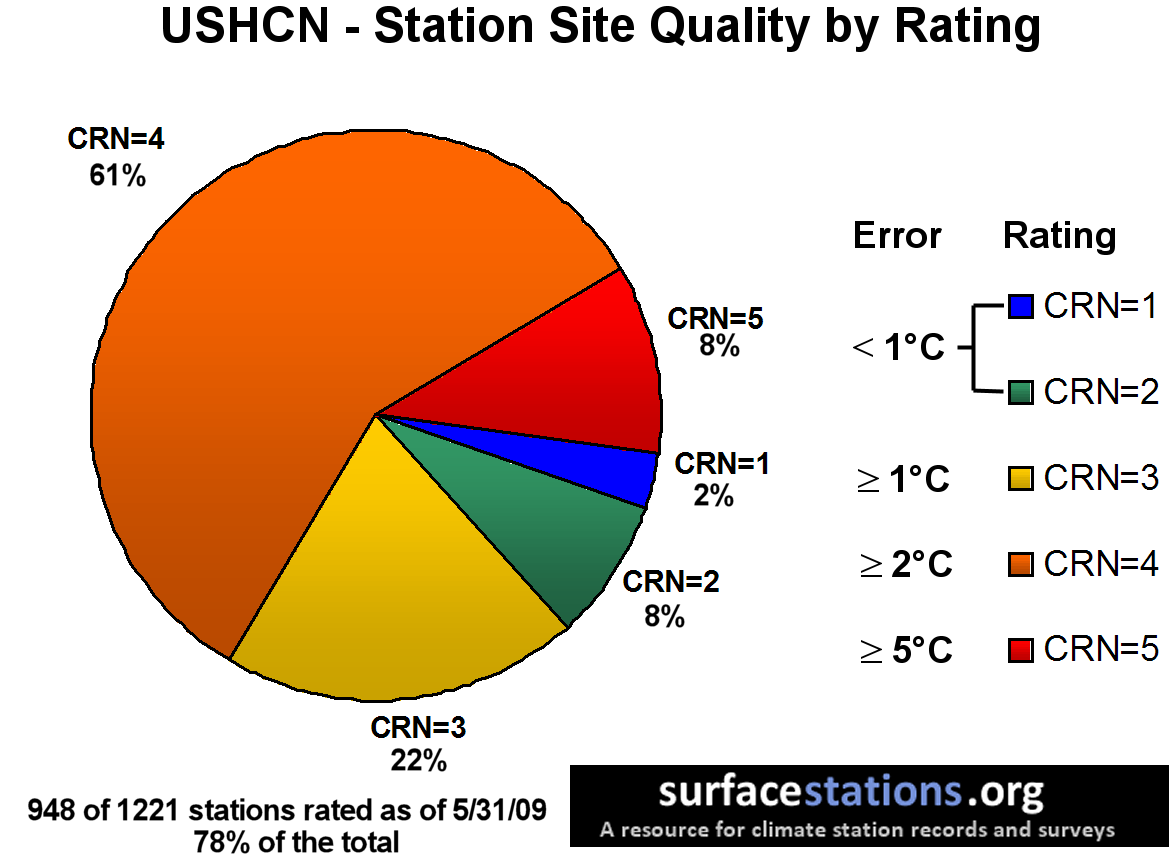

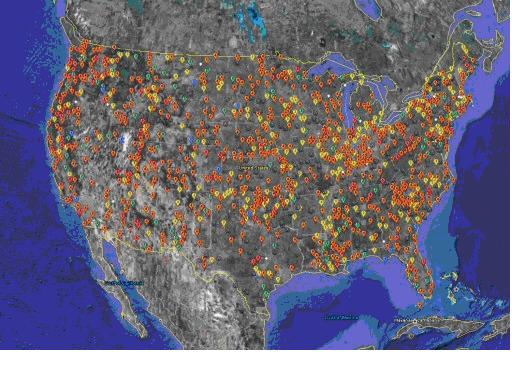

Die Abbildung 2 zeigt die Klassifizierung der über den USA verteilten Temperaturmessstationen. Die rote Farbe überwiegt eindeutig. Es wurden 82% aller Temperaturmessstationen erfasst, wobei nur 10% der Stationen einen Fehlerwert von <1°C aufweisen.

Die Abbildung 2 zeigt die Klassifizierung der über den USA verteilten Temperaturmessstationen. Die rote Farbe überwiegt eindeutig. Es wurden 82% aller Temperaturmessstationen erfasst, wobei nur 10% der Stationen einen Fehlerwert von <1°C aufweisen.