Gorleben hat schon unendlich viel Geld gekostet und Zeit verbraucht, was Minister Gabriel nicht davon abhielt, es jetzt für „politisch tot“ zu erklären, um gleichzeitig die Suche nach einem neuen Standort anzumahnen. Bei einem neuen Standort würde alles von vorne anfangen, und nach weiteren 20 Jahren würde sich auch der neue irgendwann als politisch ungeeignet herausstellen, und wieder hätte man Milliarden nutzlos ausgegeben. Im Oktober 2006 (Heft 39) berichtete Der Spiegel, Minister Gabriel beabsichtige, mehrere Standorte alternativ zu untersuchen, um den ‚bestgeeigneten’ zu finden. Bei diesem Konzept blieben Finanzen und Logik gleichermaßen auf der Strecke: Für Gorleben und Konrad wurden bereits 2,1 Mrd. € ausgegeben, und wie viele Standorte man auch untersuchte, man wüsste nie, dass nicht ein anderer noch besser ist! Ein Standort muss geeignet sein, mehr lässt sich weder bezahlen noch nachweisen.

Bei der letzten großen Protestaktion gegen Castor-Transporte erklärte Claudia Roth in einem Radiointerview genau, warum Gorleben ungeeignet sei: Die Grube Asse hätte als Pilotanlage versagt und das beweise, dass auch Gorleben nicht geeignet sei. Aus fachlichen Gründen ist diese Gleichsetzung nicht nur falsch sondern auch dumm, wie im folgenden gezeigt werden soll.

Unbestreitbar ist Asse als Pilotanlage falsch betrieben worden, und es ist auch keine Entschuldigung, dass man zur Zeit der Einlagerung vor Jahrzehnten noch nicht wissen konnte, welche Brisanz dieser Komplex einmal haben würde. Das Verhalten des Salzes war schließlich bekannt. Das grundsätzliche Problem der Asse ist nicht der Umstand, dass man die Fässer nicht ordnungsgemäß in Reih’ und Glied aufgestellt hat – das hätte das heutige Problem nicht verhindert –, sondern dass man sie in ausgebeutete und aufgelassene Strebe eingelagert hat, die sich zu nahe am Rande des Salzstockes befinden, und dass diese Einlagerungskammern nicht anschließend dicht abgeschlossen wurden. Ihre randnahe Lage ergab sich aus dem Umstand, dass sich dort die Salzarten befanden, die man gewinnen wollte. Warum verursachen die randnahe Lage und das Offenlassen das Problem? Die Kenntnis einiger Fakten kann helfen, die Gründe für das Problem zu verstehen.

Bildung der Salzstöcke

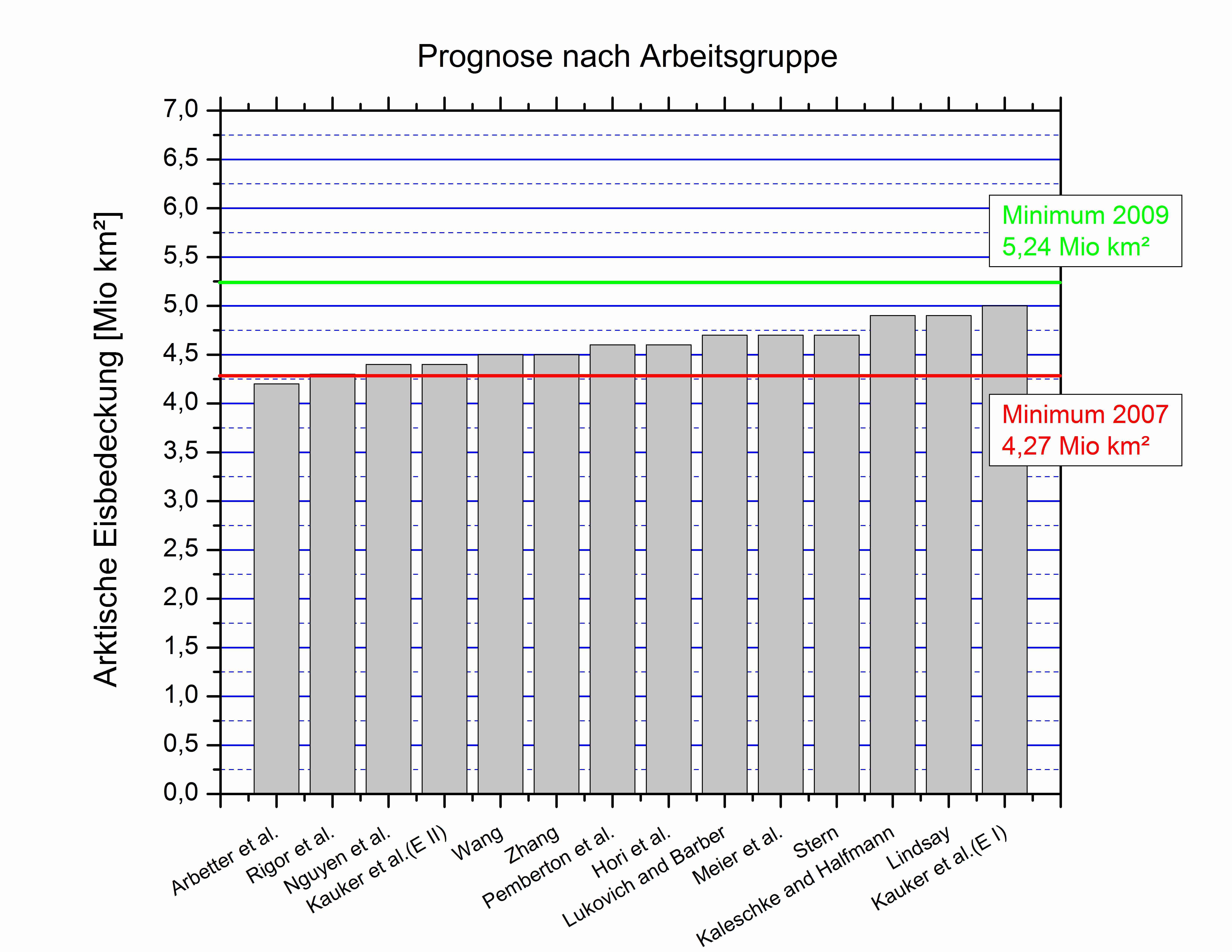

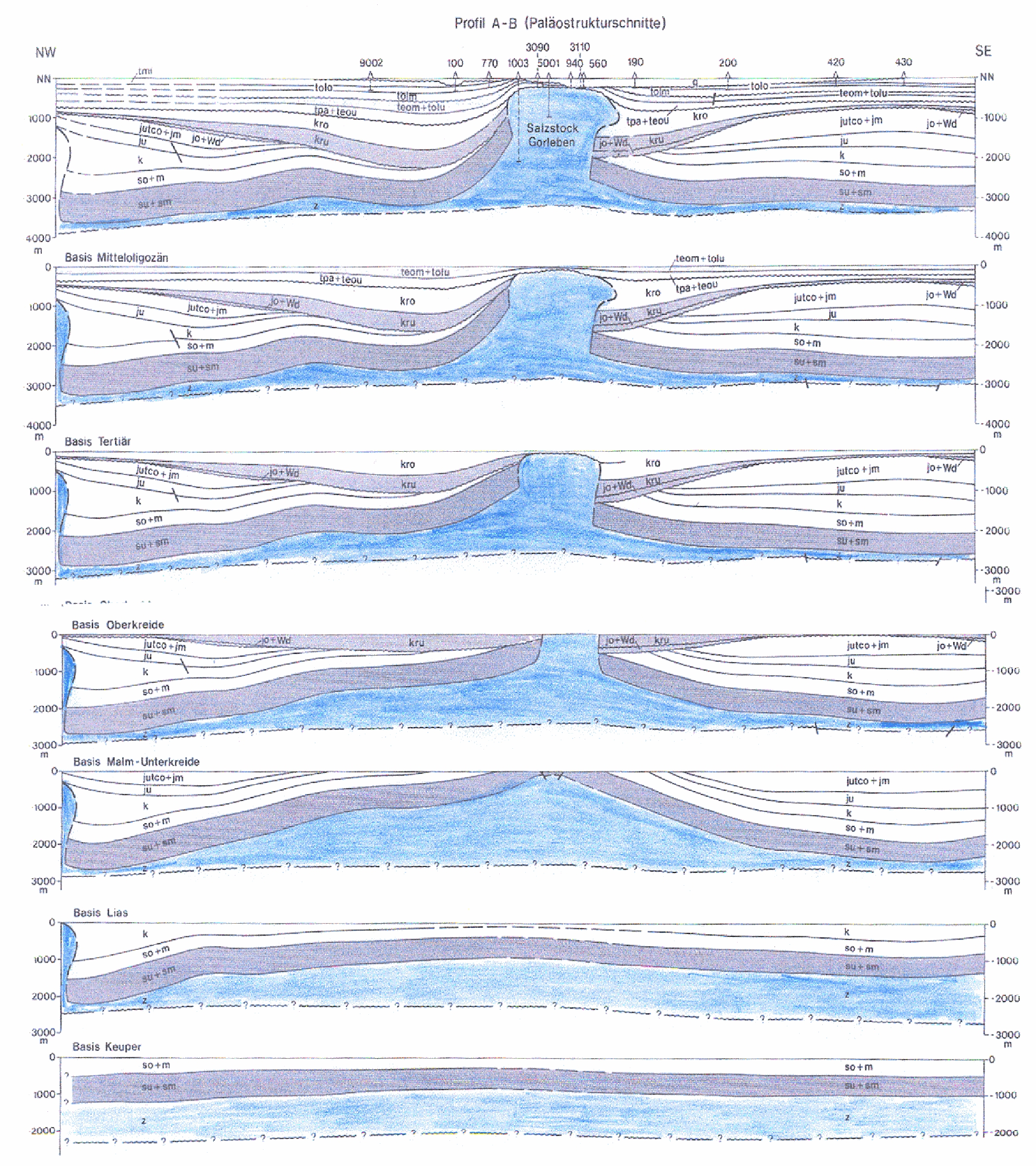

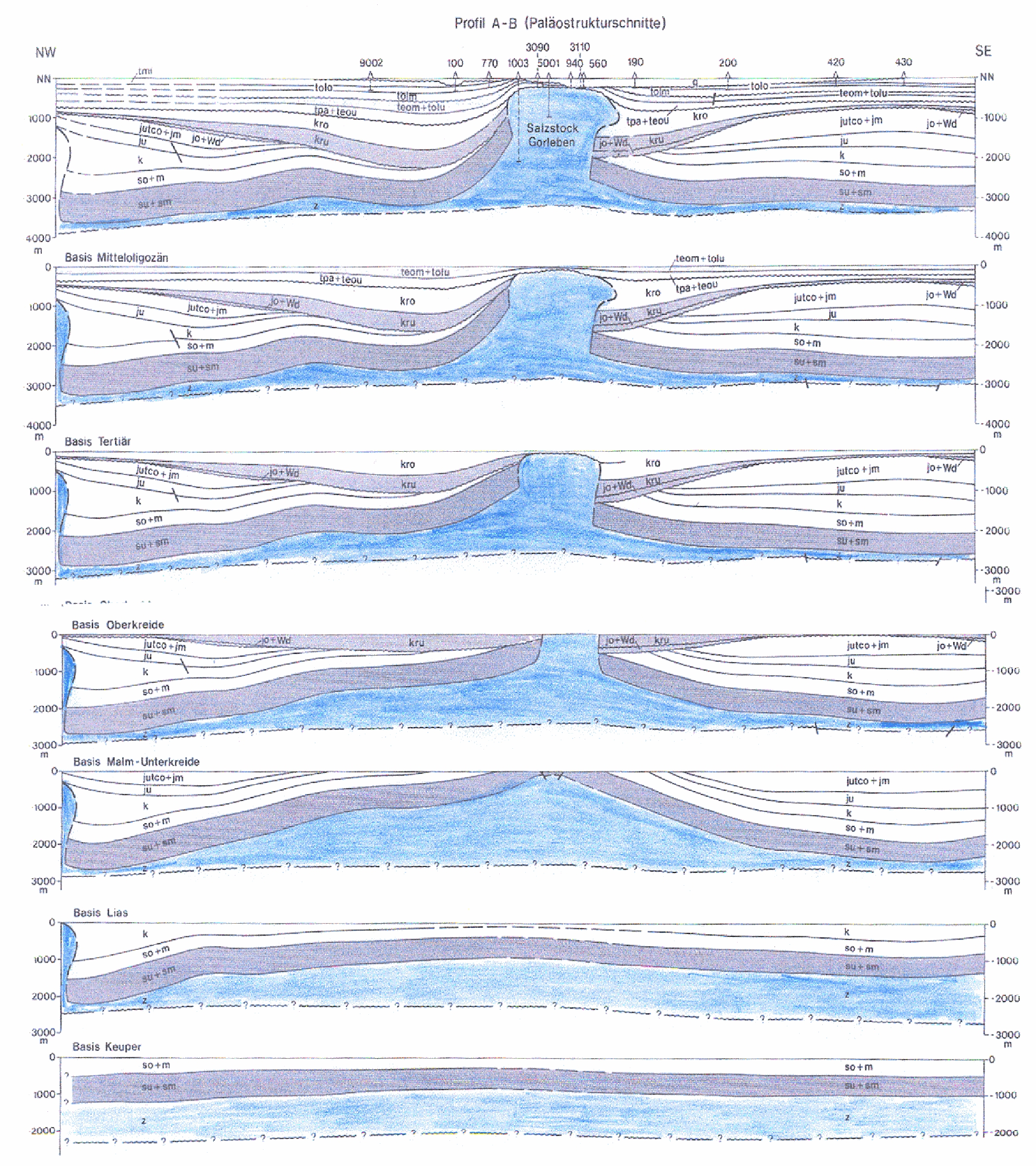

Bis vor ca. 240 Millionen Jahren war Mitteleuropa über einen Zeitraum von ca. 10 Millionen Jahren von einem flachen Meer bedeckt. Dieses ‚Zechstein-Meer’ war nach Nordwesten mit dem Ozean verbunden, und da warmes Klima herrschte, verdunstete aus dem Zechstein-Meer viel Wasser. Frisches Ozean-Wasser floss nach und vergrößerte mit seiner gelösten Salzfracht die Salzkonzentration des Meeres soweit, dass das Salz auskristallisierte und als mehrere hundert Meter mächtiger Stapel horizontal abgelagert wurde. Als diese Periode zu Ende ging, war im Raume Hannover sogar eine Schicht von etwa 1200 m Salz abgelagert worden. In den darauffolgenden geologischen Perioden wurden über dem Salz bis zu 1500 m jüngere Sedimente abgelagert. Ihr Gewicht konnte das Salz nicht aushalten – und musste es auch nicht, denn es kann sich unter Auflast langsam bruchlos verformen und sehr langsam ‚fließen’ – viskoplastisch wird dieses Verhalten genannt. Salz ist außerdem leichter als die jüngeren Sedimente. Wegen beider Eigenschaften ist es in Jahrmillionen in die Bereiche mit geringerer Auflast gewandert und dort in die überlagernden Schichten eingepresst worden. Die Abbildung 1 illustriert mit 8 parallelen Schnitten diese Entwicklung in den aufeinanderfolgenden geologischen Epochen an Beispiel des Salzstockes Gorleben.

Abbildung 1: Zeitliche Entwicklung eines Salzstockes durch Salzaufstieg (Quelle: Bundesanstalt für Geowissenschaften und Rohstoffe – BGR)

|

|

|

Das aufsteigende Salz hat die umgebenden Gesteine seitlich verdrängt und ist pilzartig als ‚Salzstock’ aufgestiegen. Dieser Aufstieg geht zu Ende, wenn der größte Teil des ursprünglichen Salzlagers ausgewandert und in den Salzstock eingepresst worden ist. Unter der norddeutschen Tiefebene existieren viele solcher Salzstöcke, und jeder hat seine eigene Geometrie und innere Struktur. Im allgemeinen sind sie bis zu 3000 m tief und wenige bis viele Kilometer lang, bei einer Breite bis zu einem Kilometer. |

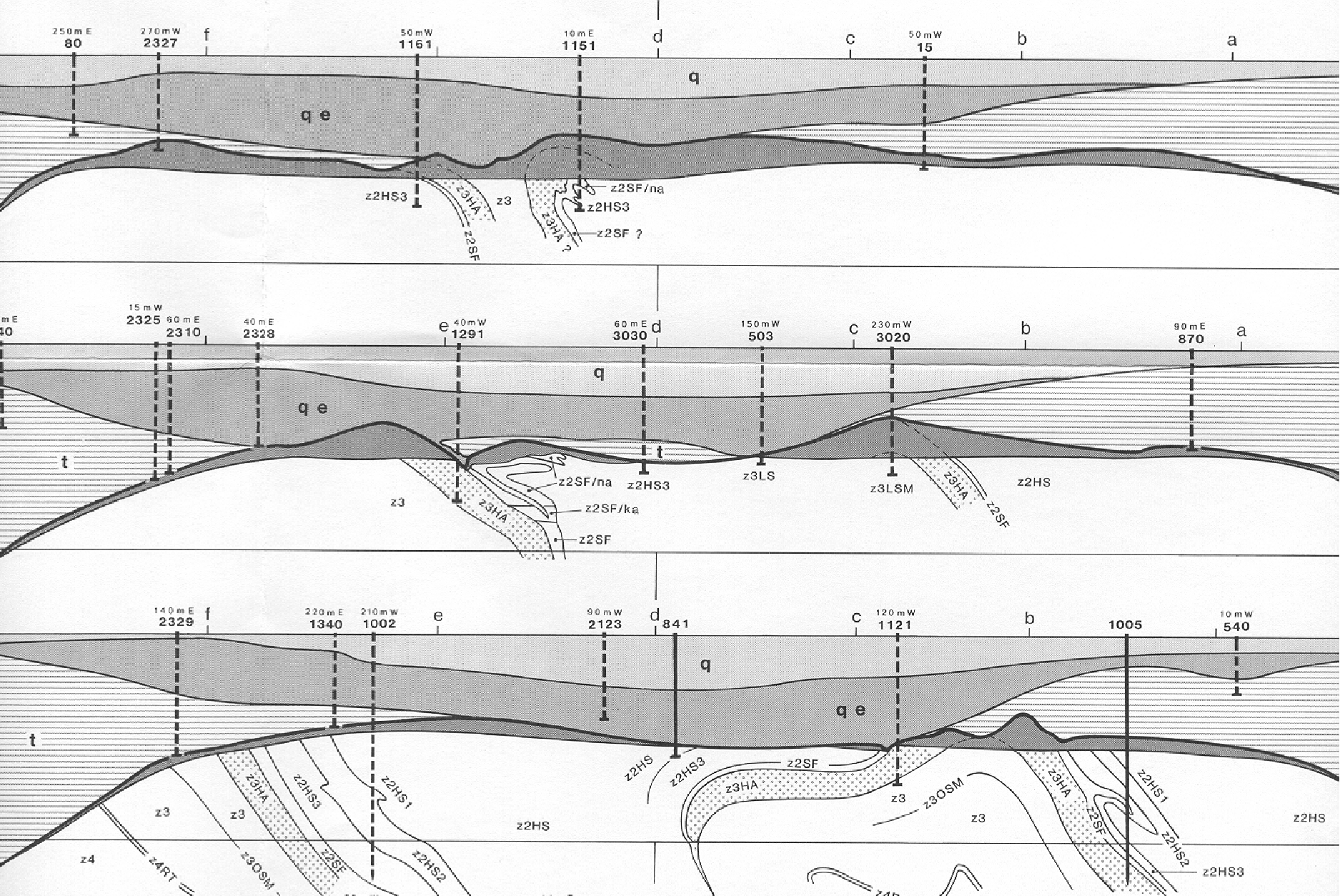

Beim Salzstock Gorleben begann dieser Aufstieg schon bald nach der Ablagerung der Sedimente in der ‚Buntsandsteinzeit’ etwa ab 240 Millionen Jahren und setzte sich in der Folgezeit fort. Zu Beginn der Tertiärzeit, also vor 65 Millionen Jahren, reichte der Salzstock bis an die Oberfläche. Im Alttertiär ging der Aufstieg zu Ende, weil in der Region die für die Abwanderung des Salzes verfügbare Menge weitgehend ausgepresst war, also aufgestiegen ist. Danach wurde der Salzstock im Jungtertiär und im darauf folgenden Quartär von bis zu 160 m Sedimenten überlagert (Abbildung 2). In dieser Zeit, also seit etwa 23 Millionen Jahren, ist der Salzstock nur noch um ca. 0,03/a mm aufgestiegen, also um 3 mm in 100 Jahren. Er ist seitdem praktisch stabil. Viermal wurde er in den Eiszeiten der letzten 650.000 Jahre für jeweils Zehntausende von Jahren von mächtigen Gletschern belastet. Die Sedimente wurden verdichtet, der Salzstock blieb erhalten.

Abbildung 2: Überlagerung des Salzstockes von Gorleben nach dem Auslaufen des Salsaufstieges im Jungtertiär und Quartär (Quelle: Bundesanstalt für Geowissenschaften und Rohstoffe – BGR)

Dichtigkeit der Salzstöcke

Die Salze liegen in kristallisierter Form vor. Die Grenzflächen zwischen den Kristallen sind geschlossen; sie bleiben es, wenn sich die Salzkörper sehr langsam verformen. Wie alle Kristalle, sind Salzkristalle jedoch spaltbar und deshalb können sie oder Grenzflächen zwischen ihnen bei großen Drücken aufgepresst werden.

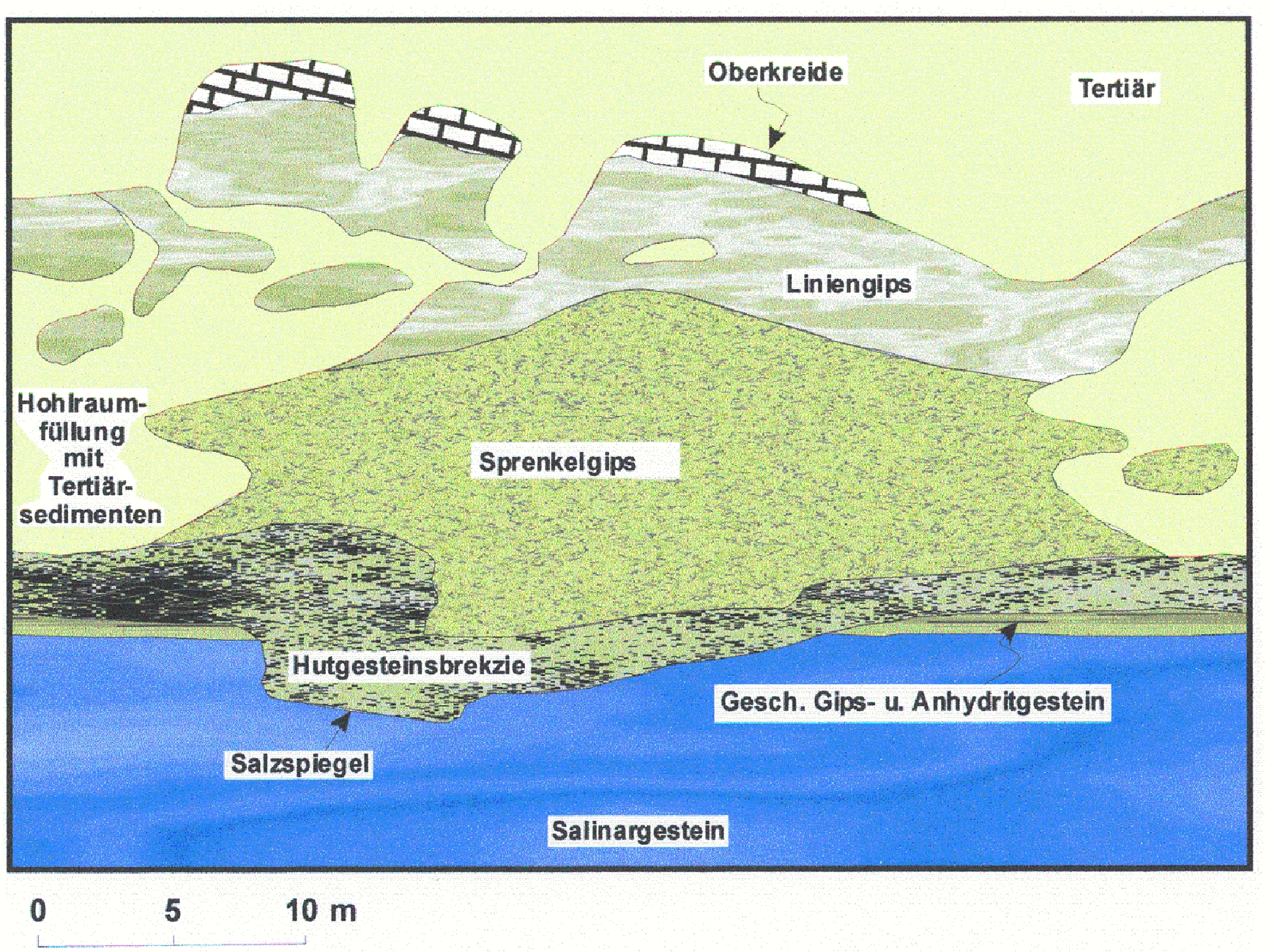

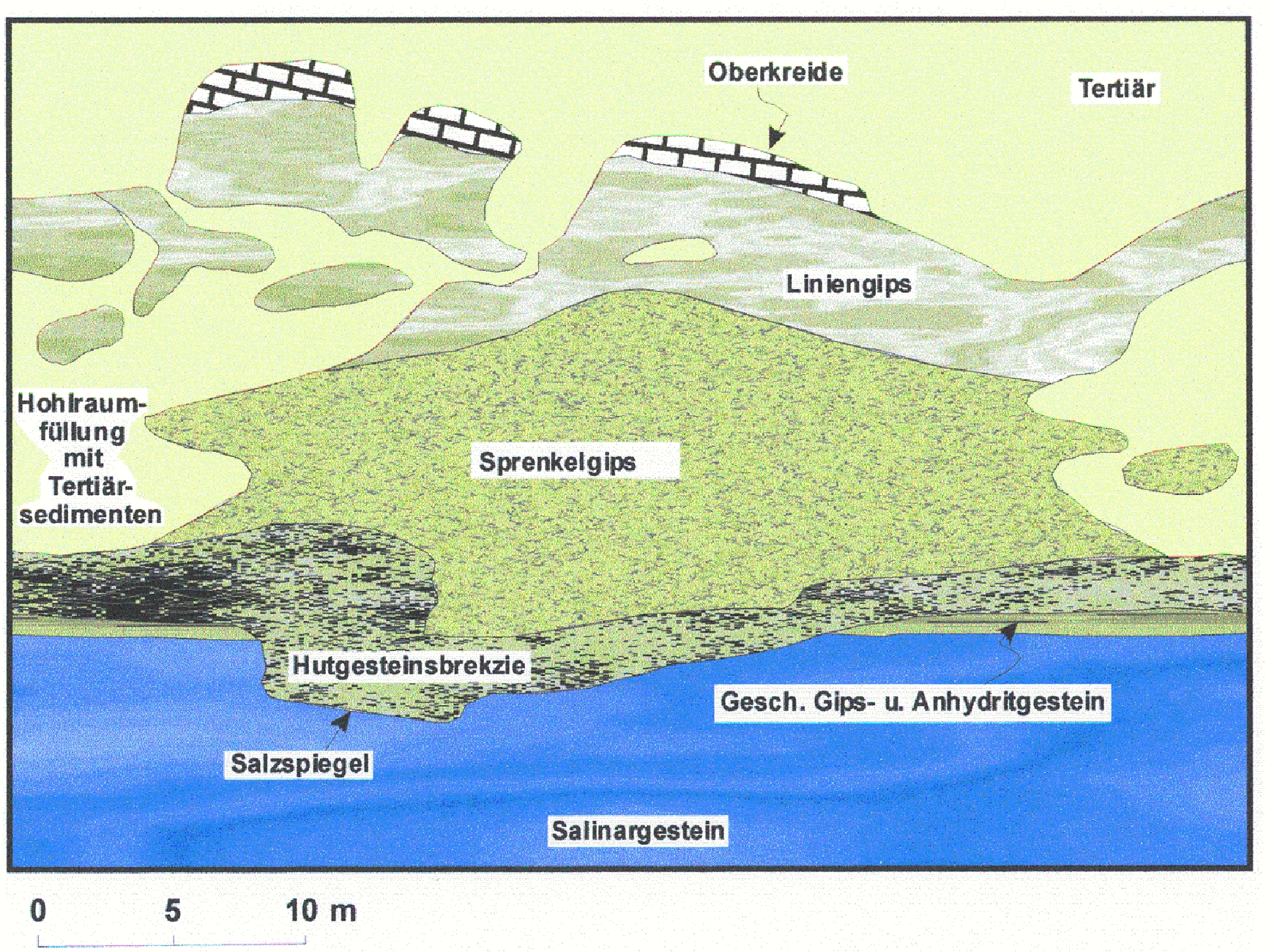

Die Gesteinsschichten in der Umgebung der Salzstöcke enthalten Grundwasser. An den Kontaktflächen der Salzstöcke wird deshalb solange Salz abgelöst, bis das Wasser gesättigt ist. Ob das viel ist und ständig erfolgt, oder wenig und dann stagniert, wird von der Geschwindigkeit bestimmt, mit der sich das Grundwasser erneuern kann. Erfolgt der Grundwasseraustausch wegen ungünstiger hydrogeologischer Verhältnisse schnell, löst das Grundwasser den Salzstock auf – er verschwindet, und es bleiben nur noch die unlöslichen Reste zurück – sog. ‚Restbrekzien’ (Abbildung 3). Salzstöcke sind deswegen entweder nicht mehr vorhanden oder sie sind dicht, denn das den Salzstock umgebende stagnierende Grundwasser ist mit Salz gesättigt und kann deshalb kein weiteres Salz aufnehmen. Das salzgesättigte Wasser ist außerdem schwerer und fließt nicht nach oben. Ein noch existierender Salzstock beweist folglich, dass keine Grundwassererneuerung statt findet, und der Salzstock erhalten bleibt. Diese Gesetzmäßigkeiten sprechen dafür, dass die Salzstöcke auch in Zukunft so bleiben wie sie in den letzten Jahrmillionen waren, anderenfalls gäbe es sie nicht mehr.

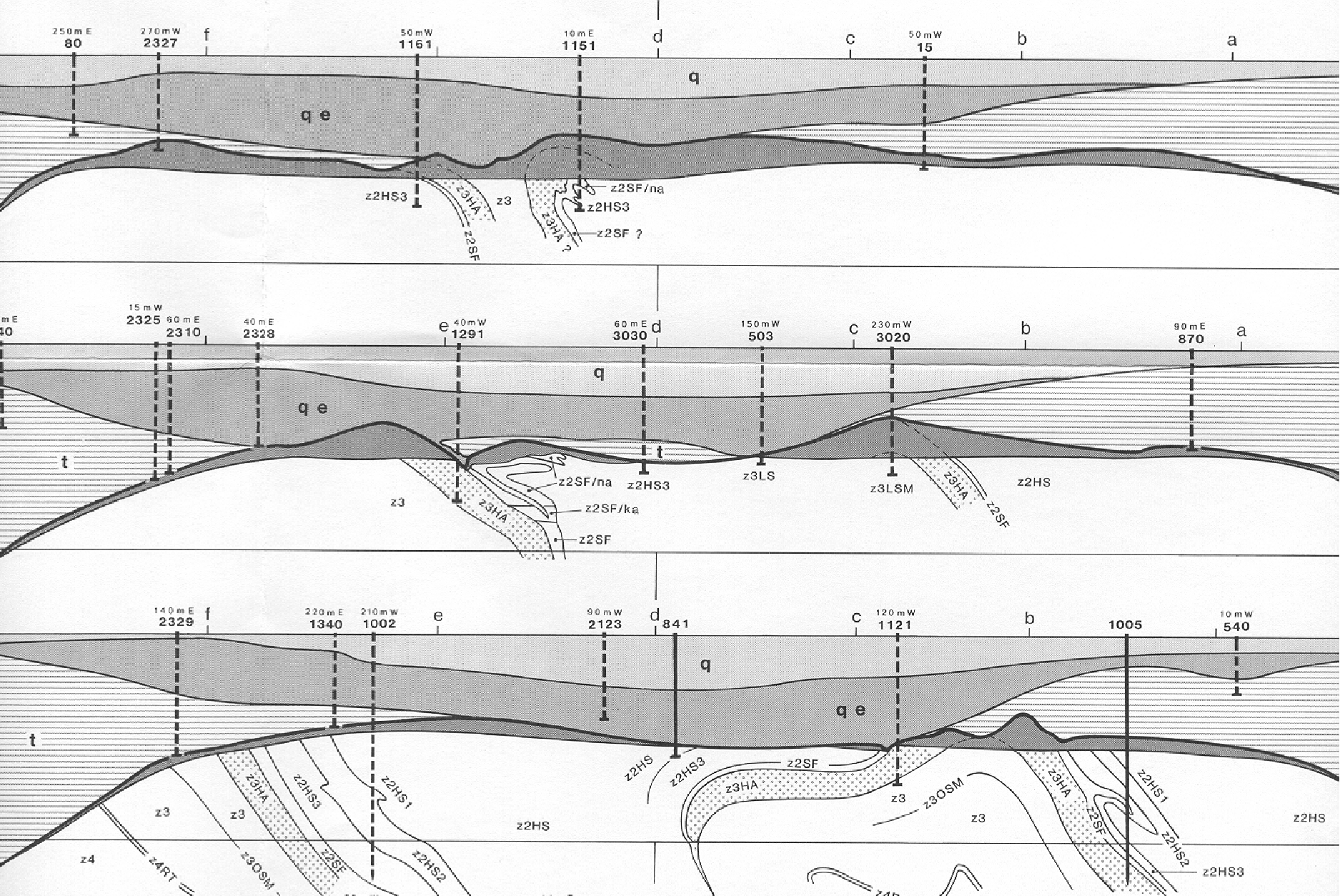

Eine besondere Situation liegt über den Salzstöcken vor: Analog zum seitlichen Außenrand der Salzstöcke hat sich das dort vorhandene Grundwasser mit gelöstem Salz gesättigt, unlösliche Gesteinspartien sind als Restbrekzie erhalten geblieben. Bei schnellem Wasseraustausch wäre der Salzstock in der geologischen Vergangenheit zur Tiefe hin abgelaugt worden und würde nicht mehr existieren. Er existiert noch, weil wegen günstiger hydrogeologischer Gegebenheiten kein Wasseraustausch statt fand, oder so gering war, dass er wirkungslos blieb. Abbildung 3 zeigt die Restbreckzie über dem Salzstock Gorleben. Ihre geringe Mächtigkeit von einigen zehn Metern beweist, dass die Ablaugung unerheblich geblieben ist, und das wird auch zukünftig nicht anders ein.

Abbildung 3: Restbrekzie über dem Salzstock Gorleben (Ausschnitt) (Quelle: Bundesanstalt für Geowissenschaften und Rohstoffe – BGR)

Problem der Asse

In der Tiefe der Einlagerungskammern von ca. 500 m herrscht im Nachbargestein ein Wasserdruck von ca. 50 bar. Für den Salzstockrand ergibt sich daraus ein sehr großer Wasserdruck, der auf die stehen gebliebene Salzbarriere zwischen Außenrand und Einlagerungskammer einwirkt. Er bewirkt, dass einzelne Grenzflächen zwischen den Salzkristallen aufgepresst werden und Grundwasser von außen in die Einlagerungskammern einsickern kann. Von 12 m³ pro Tag ist die Rede, das sind 500 l/h bzw. 8,3 l/min bzw. 0,13 l/sec, also je Minute ungefähr ein Wassereimer voll. Selbstverständlich ist das nicht akzeptabel. Aber es ist kein Wassereinbruch, denn dann handelte es sich um viele Kubikmeter pro Sekunde.

Die Einsickerung von Grundwasser aus dem Nachbargestein wäre vermieden worden, hätte man die Kammern im Inneren des Salzstockes angeordnet, also weit genug vom Rand entfernt, und wären sie nach ihrer Füllung verschlossen worden. Das kann man heute noch tun. Eine solche Sanierung wäre die einfachste und vermutlich preiswerteste Lösung. Das jedenfalls ist die Lehre aus dem Fall Asse. Falsch ist, wenn von manchen das Zurücksickern der Salzlauge in das Nachbargestein befürchtet wird. Sowenig wie aus einem abgetauchten U-Boot Wasser durch ein Loch in der Schweißnaht gegen den Wasserdruck nach außen fließen kann, sickert infiltrierte Lauge freiwillig gegen den Außendruck zurück ins Nachbargestein, und damit in den Wasserkreislauf.

Gorleben

Am 2.9.2009 zitierte Alexandra Jacobson in der Neuen Westfälischen Jochen Stay mit der Erkenntnis, “Dass Gorleben ungeeignet sei, weil der Salzstock direkten Kontakt zum Oberflächenwasser habe, sei zum Glück nun auch einer breiteren Öffentlichkeit bekannt geworden“. Diese Tatsache ist richtig, widerlegt aber die Folgerung, die Herr Stay für sich ableitet oder die für den Leser beabsichtigt ist. Sie beweist vielmehr, dass das Grundwasser den Salzstock nicht auflöst, denn auch hier wirken die zuvor beschriebenen Gesetzmäßigkeiten: sie garantieren, dass der Salzstock auch in Zukunft so bleibt wie er in den letzten Jahrmillionen war.

Rein zufällig (!) vor der Wahl ist kürzlich bekannt geworden, dass Kanzler Kohl seinerzeit eine Beurteilung der Physikalisch-Technischen Bundesanstalt modifiziert haben wollte, die 1983 wegen einer angeblich unzureichenden Mächtigkeit von tonigen Sedimenten über zentralen Bereichen des Salzstockes eine Kontamination der Biosphäre für möglich hielt. Tatsächlich spielt die Mächtigkeit der tonigen Schichten als Teil der jungen Sedimenten keine Rolle: Auch tonige Sedimente sind durchlässig, wenn auch sehr viel weniger als sandige. Selbst sehr große Durchlässigkeitsunterschiede sind für diese Prozesse unerheblich, denn die Durchlässigkeitsunterschiede werden durch die langen Zeiträume kompensiert, und über dem Salzstock sind die jungen Sedimente ohnehin mit salzgesättigtem Grundwasser gefüllt. Das wäre auch bei anderen Mächtigkeiten der tonigen Sedimente nicht anders gewesen, und diese Gegebenheiten werden auch künftig vorliegen, weshalb eine Kontaminationsgefahr ausgeschlossen werden kann. Als Mitglieder einer früheren Niedersächsischen Landesregierung haben die Minister Gabriel und Trittin das noch ebenso positiv beurteilt.

Folgerungen

Claudia Roths Beurteilung ist fachlich falsch. Warum ist sie auch dumm? Die wissenschaftlich-technische Entwicklung ist das Ergebnis von Versuch und Irrtum, was sicher auch Frau Roth weiß. Ohne diese dem Menschen eigene Vorgehensweise wäre unsere durchschnittliche Lebenserwartung kaum höher als 30 Jahre, und es herrschte noch mittelalterliches Handwerk, hätte man bei Fehlschlägen aufgegeben. Bekanntlich hat man sich um Verbesserungen bemüht und war dabei erfolgreich. Deshalb kommen wir heute schneller von A nach B als zur Postkutschenzeit – und auch Frau Roth wird darauf nicht verzichten wollen. Warum sollte man nach soviel Investitionen, das, was man im Fall Asse gelernt hat, nicht auch in Gorleben anwenden? Ein vernünftiger Grund für einen solchen Verzicht ist nicht zu erkennen.

Der tatsächliche Grund ist klar: Da ‚Anti-Atom’ für viele die Existenzgrundlage ist und/oder Wählerstimmen verspricht, kommt vor Wahlen jedes vermeintliche Argument gegen Asse, Gorleben, Krümmel etc. wie gerufen, mag es auch noch so falsch und nicht selten sogar ziemlich albern sein – „löchrig wie Schweizer Käse“ – , wobei auch dieser Vergleich falsch ist, denn seine Löcher sind nicht miteinander verbunden! Eigentlich sollten sich in Demokratien wahlkämpfende Führungskräfte schämen, mit plumper Bauernfängerei auf Stimmenfang zu gehen. Es ist schon atemberaubend, mit welcher Sicherheit sich Politiker zu Sachverhalten äußern, von denen sie erkennbar keine Ahnung haben, wenn sie damit nur Wählerstimmen gewinnen können.

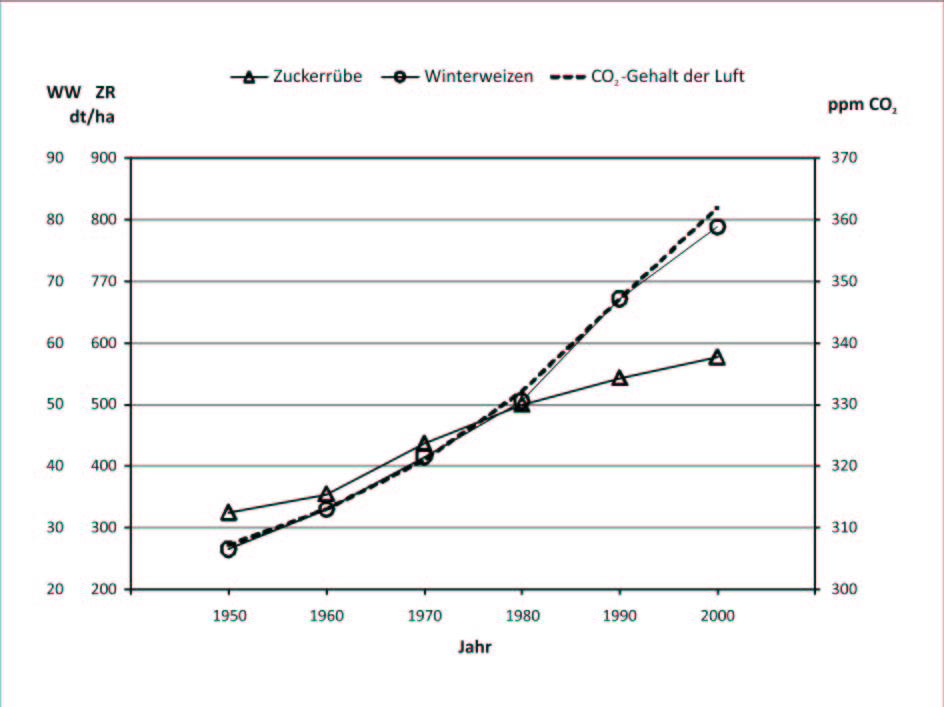

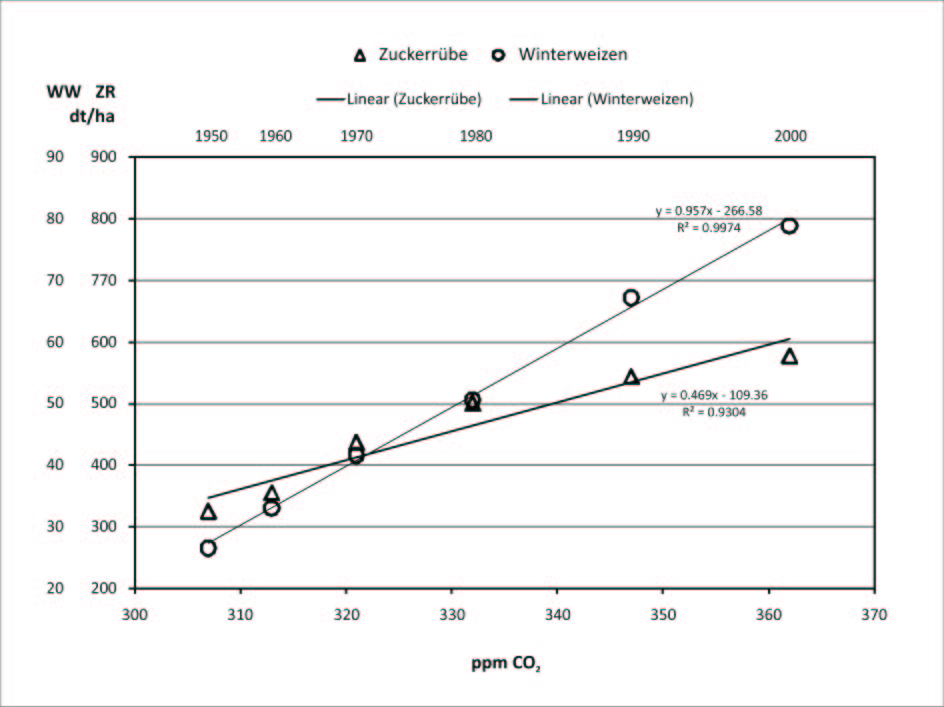

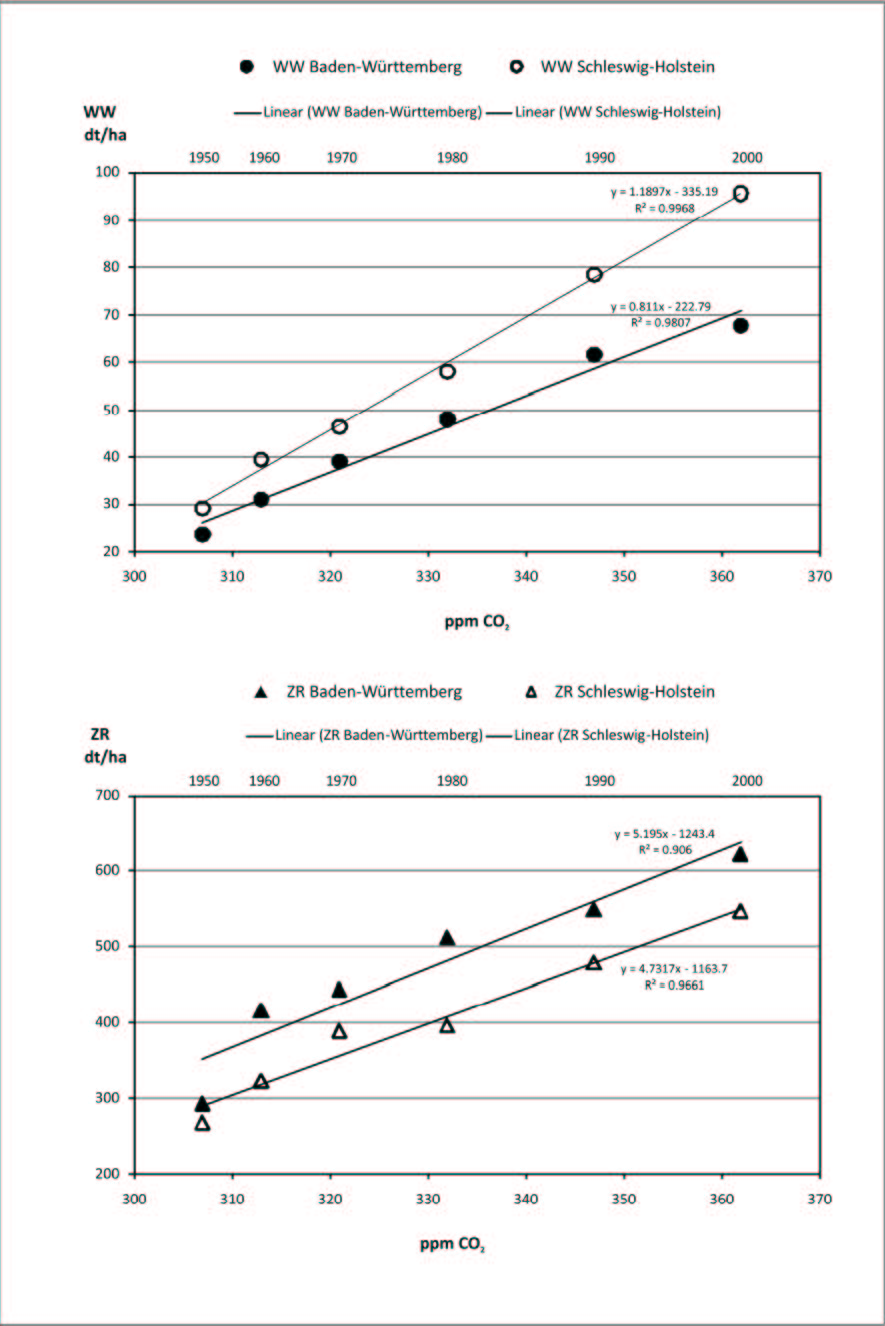

Allerdings sind solche Politiker leider in ‚bester’ Gesellschaft, wenn man bedenkt, welchen Blödsinn man selbst in renommierten Zeitungen lesen kann: So wird im Spiegel CO2 schon mal als giftig bezeichnet, obwohl es mit Wasser die Grundlage unserer Nahrungskette ist. Nach dem Zeit-Dossier von Roland Kirbach (10.9.2009) „…könnte der …Salzstock Asse einstürzen und 126000 Tonnen Atommüll freisetzen.“ Das wirkt dramatisch, und ist ja wohl auch so beabsichtigt, hat aber mit der Realität nichts zu tun. Wenn Häuser wegen Erdbeben oder das Stadtarchiv in Köln wegen Baufehler einstürzen, suchen wir tagelang – und oft vergeblich – nach Verschütteten, und das nur wenige Meter unter der Erdoberfläche. Sollte das Bergwerk Asse denn wirklich einstürzen, was sehr wahrscheinlich überhaupt nicht oder zumindest noch nicht so schnell geschehen wird, würde der Atommüll nicht freigesetzt, sondern in 500 m Tiefe begraben und dabei mit vielen hundert Metern Salz überdeckt.

Der Salzstock von Gorleben ist sachlich geeignet, darf es aber aus politischen Gründen nicht sein, denn er eignet sich vorzüglich immer wieder zur Stimmungsmache und beeinflusst Wahlentscheidungen – und wie wirksam das funktioniert, wissen wir aus bitterer Erfahrung.

Gegenwärtig befinden sich auf der Welt 443 Atomkraftwerke im Betrieb, sind 47 im Bau und 81 in der Planung. Deutschland ist von Ländern umgeben, die Atomkraftwerke betreiben; Frankreich gewinnt sogar 78% seines Stromes auf diese Weise. Wer dezidiert die Atomkraft für unverantwortbar hält, weil sie nach seiner Meinung eine Gefahr für die Menschheit darstellt, und wer den Mut hat zu glauben, nur er wüsste trotz unserer bitteren Erfahrung mit deutscher Hybris schon wieder den richtigen Weg, müsste doch eigentlich versuchen, die anderen Länder, die das Gegenteil praktizieren, von ihrem falschen Weg abzubringen. Was nutzt uns Anti-Atom, wenn weltweit und vor allem in den Nachbarländern Atomkraftwerke betrieben werden, Atomunfälle wirken schließlich global. Da man weiß, dass sich die anderen Länder nicht von uns belehren lassen, geschieht das nicht. Man ist ja, beispielsweise in Frankreich, auch sicher nicht der Meinung, dass die eigenen Fachleute und die Politiker dumm und verantwortungslos sind. Unsere diesbezügliche – vernünftige – Zurückhaltung beweist aber auch, was wirklich mit der Ausstiegs- und Anti-Atom-Politik gemeint ist: Angst zu machen, um Wählerstimmen zu gewinnen. Und das ist wirklich verantwortungslos!

Apropos Gorleben: Nach seinem Beispiel wird in New Mexico seit Jahrzehnten ein Salzstock als Endlager betrieben.

Dipl.-Geologe Prof. Dr. Friedrich-Karl Ewert, EIKE

Related Files

![]() Quelle (englisch, externer Link)

Quelle (englisch, externer Link)